Dic

21

¿Estaremos aquí cuando el Sol se convierta en Gigante Roja

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La Humanidad como mujeres y hombres verdaderos lleva en este planeta unos 200.000/300.000 años

La Humanidad como Homo sapiens (mujeres y hombres verdaderos modernos) lleva en este planeta unos 200.000 a 300.000 años, emergiendo en África, aunque el linaje humano (género Homo) es mucho más antiguo, con millones de años de evolución desde ancestros comunes con chimpancés, y los primeros homínidos bípedos aparecieron hace 6-7 millones de años.

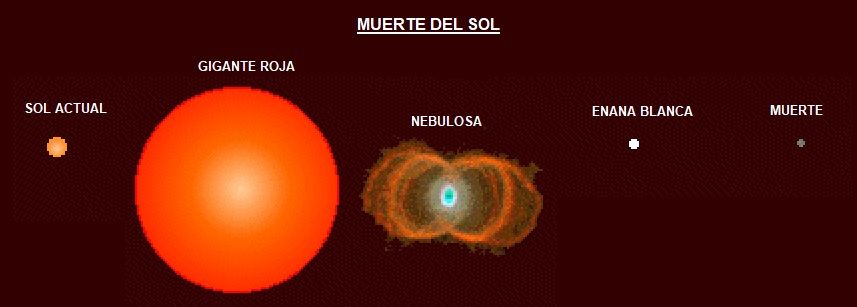

De todas las maneras, unos millones de años, comparados con los 4.500/5.000 millones en los que la Tierra sería una Gigante roja primero, y una Nebulosa Planetaria y Enana Blanca después, es un trecho considerablemente mayor, y, en este punto, nos tendríamos que preguntar:

¿Estará la Humanidad aquí para entonces, no nos habremos extinguido mucho antes?

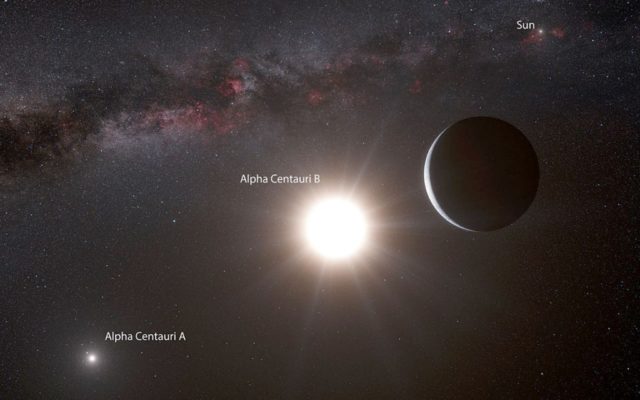

De todas las maneras, si nuestra especie sigue por aquí, mucho antes de que e4so llegue, y, de que llegue también la visita de Andrómeda para fusionarse con la Vía Láctea, deberíamos de haber conquistado los conocimientos necesarios para poder evitar la extinción de la especie, y, tener naves como ciudades de grande, en las que (como el nuevo Arca de Noe), llevara todo lo necesario para instalarnos en otro lugar muy lejano.

Expedición a un planeta de masa terrestre alrededor de la estrella más cercana al Sol. El nuevo mundo, denominado con el insulso nombre de Alfa Centauri Bb (a 4,36 años luz de la Tierra), que podría ser el destino de misión salvadora de la que nos hablan, y, que para entonces (se supone), tendríamos otros medios para poder alcanzarlo en mucho menos Tiempo del que ahora podríamos.

Claro que La fusión de la Vía Láctea y la Galaxia de Andrómeda está calculada para ocurrir en un periodo de aproximadamente 4.000 a 5.000 millones de años, aunque investigaciones recientes sugieren que podría retrasarse o incluso ser menos segura debido a la influencia de otras galaxias del grupo, con un acercamiento significativo en unos 3.870 millones de años y la fusión final en unos 5.860 millones de años.

De todas las maneras, lo cierto es que se producirá “casi” en el mismo Tiempo en el que el Sol se convertirá en Gigante Roja, y, si es así (como parece), de poco serviría huir a alfa Centauri que también (como todo el Sistema solar), estaría afectada por la fusión de galaxias.

esto nos lleva al problema de tener que buscar acomodo a la Humanidad, ¡En otra galaxia!

Aparte de Andrómeda, la galaxia espiral más cercana y similar a la Vía Láctea es NGC 6744, una hermana casi gemela que se encuentra a unos 25/30 millones de años luz, y, si ya nos costaría viajar a Alfa Centauri a 4,36 años luz, ¿Cómo llegar a esta galaxia mucho más distante? , ya que, aunque la galaxia más próxima en el Grupo Local es la Enana del Can Mayor, una galaxia satélite, está en proceso de ser absorbida.

Así las cosas:

A la Vía Láctea le quedan 4000 millones de años de vida. Algunos dicen que al Sol no le afectará la fusión. sin embargo, es dudoso que en acontecimiento de tal índole dejen las cosas como están.

Y, por otra parte, el acontecimiento se junta al de la “muerte del Sol que será una Gigante Roja.

La humanidad, a través de la ciencia y la exploración espacial, tratará de buscar la manera de escapar de la Tierra antes de que el sol se convierta en una estrella Gigante roja en unos miles de millones de años, un proceso que primero hará inhabitable nuestro planeta (en 1000 millones de años) al evaporar los océanos, y luego posiblemente engullirá a la Tierra, aunque hay teorías sobre si podría salvarse en una órbita más lejana o si deberíamos buscar nuevos hogares en las lunas de Júpiter o Saturno, pero la extinción de la humanidad por autodestrucción o causas naturales es una posibilidad real mucho antes de ese fin estelar.

- En 1000 millones de años: La Tierra se volverá inhabitable debido al aumento de la luminosidad solar, evaporando los océanos y creando un horno abrasador.

- Migración a Marte o más allá: La tecnología actual no permitiría un viaje masivo, pero se buscan colonias en Marte y se planean estrategias para buscar un Hogar.

- Supervivencia en las lunas de Júpiter/Saturno: Las lunas heladas (como Europa o Encélado) podrían derretirse y volverse habitables por el calor de la gigante roja, ofreciendo una alternativa para el agua y la vida.

- Modificación de la órbita terrestre: Algunos estudios sugieren que podríamos modificar la órbita de la Tierra para que se aleje del Sol y sobreviva, aunque esto no resolvería la falta de agua y la inhabilidad.

Realidad Actual:- Extinción Humana: Es muy probable que la humanidad se extinga mucho antes de este cataclismo cósmico debido a problemas propios (autodestrucción, agotamiento de recursos) o eventos naturales, como el aumento gradual del Sol que ya está haciendo inhabitable la Tierra en los próximos mil millones de años.

- La Tierra sobrevive (quizás): Hay evidencia de planetas rocosos que han sobrevivido a la fase de gigante roja de sus estrellas, sugiriendo que la Tierra podría no ser completamente destruida, aunque sí inhabitable.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F4e1%2Fafa%2F36e%2F4e1afa36ec513728557273a66079d377.jpg)

Así las cosas, Para salvar a la humanidad de la primera fase de la transformación del sol en Gigante roja (en unos mil millones de años), la única opción real es la colonización interestelar, estableciéndose en otros sistemas estelares, ya que la Tierra será inhabitable o tragada por el Sol; esto requeriría avances monumentales en propulsión, soporte vital y terra-formación para construir naves generacionales o ciudades flotantes en el espacio, un proyecto que exige una cooperación global sin precedentes y décadas/siglos de desarrollo tecnológico para asegurar nuestra supervivencia a largo plazo más allá de la Tierra.

No trato de dar un disgustos a las fiestas de Navidad y rebajar la euforia de estos días. Sin embargo, no podemos negar que nuestra especie lo tiene muy crudo para conseguir solucionar los problemas que se avecinan. Naves como ciudades de miles de kilómetros cuadrados, que como nuevas Arcas nos lleve a lugar seguro y nos salve de la extinción.

¿Lo conseguiremos?

La tarea no será nada fácil (si es que, para cuando todo eso vaya a suceder, seguimos por aquí), los medios requeridos en tecnología, en cooperación humana, en conocimientos que en el presente ni podemos imaginar… ¡Nos parecen inalcanzables!

Claro que, hace algunos miles de años, un tal Empédocles imaginó que todo estaba hecho de cuatro elementos: Aire, Fuego, Tierra y Agua.

Otro pensador de aquellos lejanos tiempos, nos hablaba del á-tomo, la parte más pequeña de la que estaba formada la materia.

Ellos fueron los precursores de mucho de lo que hoy podemos saber, nos señalaron el camino a seguir, y, gracias a ellos, pudimos llegar a saber realmente que los elementos se formaban en las estrellas, y, de parte de ellos estamos constituidos.

La otra idea de lo muy pequeño que formaba la materia, nos trajo al Modelo Estándar y al LHC, para confirmarlo.

¿Quién puede saber si, para el tiempo que está por venir, y, antes de que lleguen sucesos inevitables y de una extinción segura, podremos haber logrado los medios materiales, tecnológicos y del necesario consenso mundial humano, para hacerle frente a tales peligros que, si no pueden salvarlo todo, si podrían hacerlo con lo necesario para que la especie no quede extinguida.

Como el Principio del Universo (uno de ellos), es el de la Incertidumbre, no podemos saber si toda esta preocupación es estéril, debido a que, antes de que todo eso llegue (miles de millones de años), la Humanidad seguirá por aquí.

Emilio Silvera V.

Dic

21

¡Somos parte del Universo! ¿La parte que piensa?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

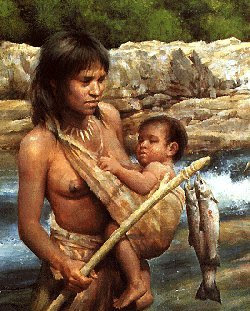

Una buena nutrición cerebral es esencial para la evolución del mismo

Los ladrillos del cerebro: Es evidente que el estímulo para la expansión evolutiva del cerebro obedeció a diversas necesidades de adaptación como puede ser el incremento de la complejidad social de los grupos de homínidos y de sus relaciones interpersonales, así como la necesidad de pensar para buscar soluciones a problemas surgidos por la implantación de sociedades más modernas cada vez. Estas y otras muchas razones fueron las claves para que la selección natural incrementara ese prodigioso universo que es el cerebro humano.

Claro que, para levantar cualquier edificio, además de un estímulo para hacerlo se necesitan los ladrillos específicos con las que construirlo y la energía con la que mantenerlo funcionando. La evolución rápida del cerebro no solo requirió alimentos de una elevada densidad energética y abundantes proteínas, vitaminas y minerales; el crecimiento del cerebro necesitó de otro elemento fundamental:

Un aporte adecuado de ácidos grasos poliinsaturados de larga cadena, que son componentes fundamentales de las membranas de las neuronas, las células que hacen funcionar nuestro cerebro.

Hoy sabemos que incluir en los alimentos que tomamos productos con ácidos grasos poliinsaturados omega-3 pueden reducir la mortandad y los ingresos hospitalarios por enfermedades vasculares de pacientes con problemas cardíacos. En ciertos territorios de la Tierra, en los que dichos productos eran abundantes de manera natural, sus habitantes se vieron beneficiados de ello.

Nuestro organismo, como ya he señalado, es incapaz de sintetizar en el hígado suficiente cantidad de estos ácidos grasos; tiene que conseguirlos mediante la alimentación. Estos ácidos grasos son abundantes en los animales y en especial en los alimentos de origen acuático (peces, moluscos, crustáceos). Por ello, algunos especialistas consideran que la evolución del cerebro no pudo ocurrir en cualquier parte del mundo y, por lo tanto, requirió un entorno donde existiera una abundancia de estos ácidos grasos en la dieta: un entorno acuático.

El cerebro humano contiene 600 gramos de estos lípidos tan especiales imprescindibles para su función. Entre estos lípidos destacan los ácidos grasos araquidónico (AA, 20:4 W-6) y docosahexaenoico (D H A, 22:6 W-3); entre los dos constituyen el noventa por 100 de todos los ácidos grasos poliinsaturados de larga cadena en el cerebro humano y en el resto de los mamíferos.

Son la forma más sencilla de lípido (grasas) presentes en el organismo y una fuente importante de energía.

Son los núcleos de las grasas y le dan las características físicas y biológicas. Pueden ser saturados o insaturados y pueden estar formados por una estructura química de cadena larga o corta. También son un componente importante de las membranas de las células donde contribuyen a la fluidez y el funcionamiento correcto de las membranas.

Función energética:

Los ácidos grasos son moléculas muy energéticas y necesarias en todos los procesos celulares en presencia de oxígeno, ya que por su contenido en hidrógenos pueden oxidarse en mayor medida que los glúcidos u otros compuestos orgánicos que no están reducidos.

Una buena provisión de estos ácidos grasos es tan importante que cualquier deficiencia dentro del útero o durante la infancia puede producir fallos en el desarrollo cerebral. El entorno geográfico del este de África donde evolucionaron nuestros ancestros proporcionó una fuente única nutricional, abundante de estos ácidos grasos esenciales para el desarrollo cerebral. Esta es otra de las circunstancias extraordinarias que favoreció nuestra evolución.

Las evidencias fósiles indican que el género Homo surgió en un entorno ecológico único, como es el formado por los numerosos lagos que llenan las depresiones del valle del Rift, el cual, en conjunto y desde un punto de vista geológico, es considerado un “proto-océano”. El área geográfica formada por el mar Rojo, el golfo de Adén y los grandes lagos del Rift forman lo que en geología se conoce como “océano fallido”. Son grandes lagos algunos de una gran profundidad (el lago Malwi tiene 1.500 metros y el lago Tanganika 600 m.) y de una enorme extensión (el lago Victoria, de casi 70.000 km2, es el mayor lago tropical del mundo). Se llenaban, como hacen hoy, del agua de los numerosos ríos que desembocan en ellos; por eso sus niveles varían según las condiciones climatológicas regionales y estaciónales.

Islote del Lago Victoria

Muchos de estos lagos son alcalinos debido al intenso volcanismo de la zona. Son abundantes en peces, moluscos y crustáceos que tienen proporciones de lípidos poliinsaturados de larga cadena muy similares a los que componen el cerebro humano. Este entorno, en el que la especie Homo evolucionó durante al menos dos millones de años, proporcionó a nuestros ancestros una excelente fuente de proteínas de elevada calidad biológica y de ácidos grasos poliinsaturados de larga cadena, una combinación ideal para hacer crecer el cerebro.

Ésta es otra de las razones en las que se apoyan algunos para sugerir que nuestros antecesores se adaptaron durante algunos cientos de miles de años a un entorno litoral, posiblemente una vida lacustre, en el “océano fallido” de los grandes lagos africanos y que nuestra abundante capa de grasa subcutánea es la prueba de esta circunstancia de nuestra evolución.

La realidad es que este entorno lacustre proporcionó abundantes alimentos procedentes del agua, ricos en proteínas de buena calidad y en ácidos grasos poliinsaturados. Estos alimentos completaban la carroña incierta o la caza casi imposible. Durante cientos de miles de años evolucionaron los homínidos en este entorno entre la sabana ardiente y las extensiones interminables de aguas someras por las que vagaban los clanes de nuestros antepasados chapoteando a lo largo de kilómetros en busca de alimento. Este entorno único no solo garantizó los nutrientes necesarios para desarrollar el cerebro, sino que aceleró numerosos cambios evolutivos que confluirían en el Homo sapiens.

Comenzaron a “fabricar” armas rudimentarias para cazar y defenderse

Nuestra especie es muy homogénea en sus características: somos muy similares a pesar de lo que pudiera parecer a causa de las diferencias del color en la piel o en los rasgos faciales de las diferentes poblaciones. Tanto los datos de la genética homo los de la pale-antropología muestran que los seres humanos, como especie, procedemos de un grupo pequeño de antepasados que vivían en África hace unos cuatrocientos mil años.

Hemos logrado determinar con precisión nuestros orígenes como especie mediante precisos análisis genéticos; por ejemplo, los estudios llevados a cabo sobre los genes de las mitocondrias pertenecientes a individuos de todas las poblaciones del mundo y de todas las razas.

Estudiando el A D N mitocondrial de miles de personas se ha llegado a formular la llamada “Teoría de la Eva Negra”, según la cual todos nosotros, los Homo sapiens, procedemos de una hembra que vivió en algún lugar de África hace ahora unos tres cientos mil años.

Otros estudios se han realizado mediante el análisis del polimorfismo del cromosoma Y.

Teoría de “La Eva Mitocondrial” o ”Eva Negra”

Pero tanto unos estudios como otros han dado el resultado similar. Los estudios del material genético del cromosoma Y confirman que la Humanidad tuvo un antepasado varón que vivió en África hace unos doscientos mil años. Seria la “Teoría del Adán Negro”. Estudios del Gen de la hemoglobina ratifican que todas las poblaciones humanas modernas derivan de una población ancestral africana de hace unos doscientos mil años compuesta por unos seiscientos individuos.

Cráneo de Kabwe el fósil KNM-ER

Los hallazgos paleo-antropológicos ratifican el origen único y africano de nuestra especie. Se han encontrado en diversa regiones de África algunos fósiles, de características humanas modernas, con una antigüedad de entre tres cientos mil y cien mil años; estos incluyen: el cráneo de kabwe (en Zambia), de 1.285 c.c.; el fósil KNM-ER-3834 del lago Turkan, en Kenia, de casi litro y medio; los fósiles encontrados en los yacimientos de Border Cave y Klassies River Mouth, de África del sur; y los esqueletos y cráneos encontrados en los enterramientos de la Cueva de Qafzeh y del abrigo de Skhul, ambos en Israel y datados en unos cien mil años.

En 1.968 se descubrieron en Dordoña el cráneo y el esqueleto de uno de nuestros antepasados, al que se denominó Hombre de Cro-Magnon. Hoy sabemos que hace unos cuarenta mil años aparecieron en Europa unos inmigrantes de origen africano, que eran los primeros representantes de la especie Homo sapiens sapiens que alcanzaban estos territorios. Llegaron con unas armas terribles e innovadoras, conocían el modo de dominar el fuego y poseían una compleja organización social; y por lo que se refiere a las otras especies de homínidos que habitaban por aquel entonces Europa, concretamente los Homo neandertales, al parecer, los eliminaron por completo.

Los cromañones poseían las características de los pobladores de las regiones próximas al ecuador: poco macizos, muy altos y de brazos y piernas largas; sus huesos eran muy livianos por aumento del canal medular, dentro de la diáfisis. Los huesos que formaban las paredes del cráneo eran más finos, que los de sus predecesores. Habían sufrido una reducción de la masa muscular. El desarrollo de armas que podían matar a distancia con eficacia y sin requerir gran esfuerzo, como los propulsores, las hondas y, más tarde, el arco y las flechas, hicieron innecesarias una excesiva robustez. En general, eran muy parecidos a nosotros y, hasta tal punto es así que, si cogiéramos a uno de estos individuos, lo lleváramos a la peluquería, le pusiéramos un buen traje, y lo sacáramos de paseo, se confundiría con el resto de la gente sin llamar a atención.

Llegados a este punto, no merece la pena relatar aquí las costumbres y forma de vida de esas poblaciones que, en tantos y tantos escritos hemos podido leer y conocemos perfectamente. El objeto de todo esto era esbozar un perfil de lo que fuimos, de manera que dejemos ante nosotros la evolución por la que hemos pasado hasta llegar aquí, y, a partir de ahora, pensar en la evolución que nos queda hasta convertirnos en los seres del futuro que, seguramente, regirán en el Universo.

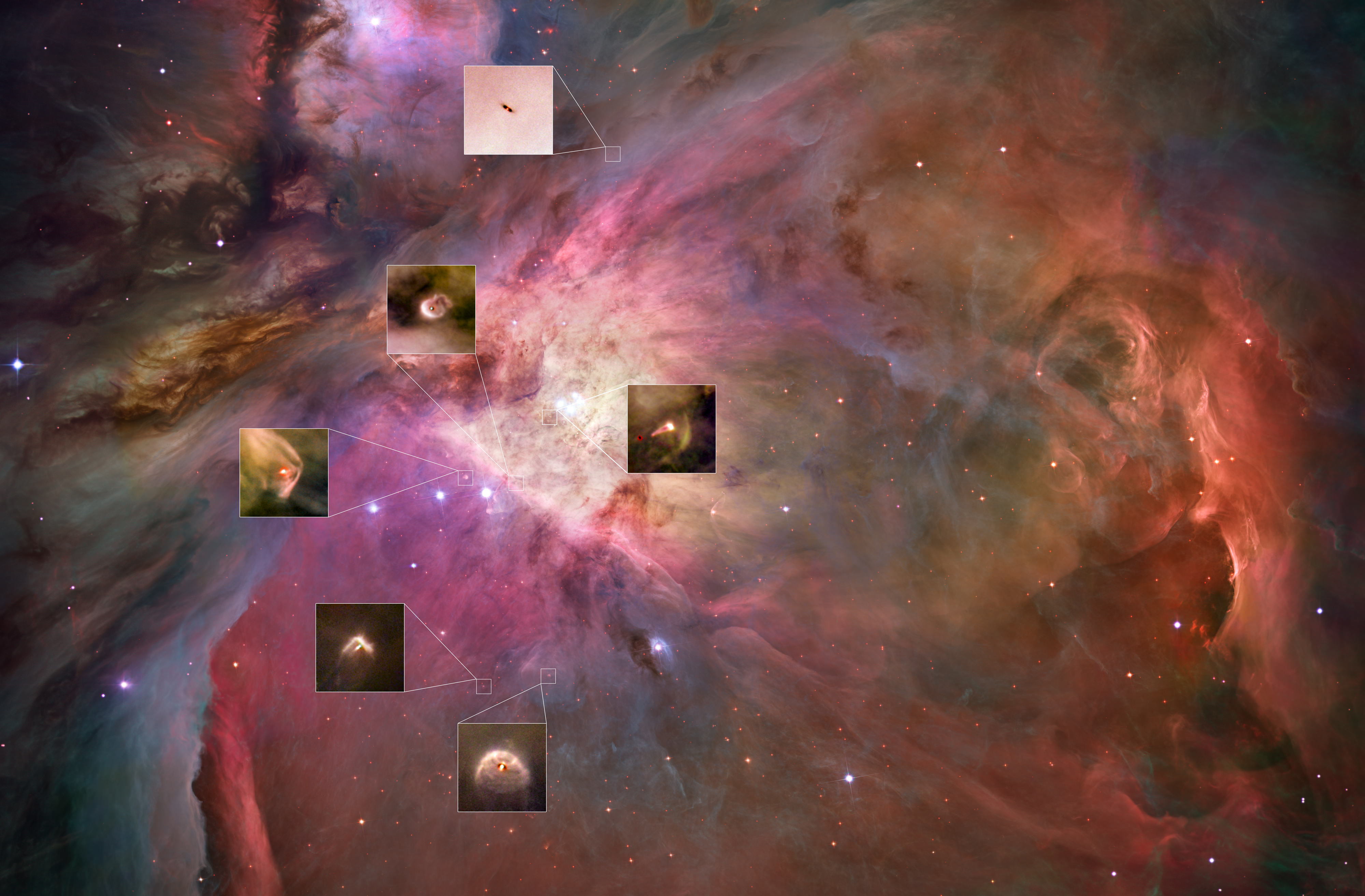

Formación de nuevos sistemas planetarios en Orión

Hemos sido capaces de detectar otros sistemas solares que están en formación en Nebulosas lejanas y sabemos de lo que existe en el universo profundo. Es curioso cómo el universo tiene la curiosa propiedad de hacer que los seres vivos piensen que sus inusuales propiedades son poco propicias para la vida, para la existencia de vida, cuando de hecho, es todo lo contrario; las propiedades del universo son esenciales para la vida. Lo que ocurre es que en el fondo tenemos miedo; nos sentimos muy pequeños ante la enorme extensión y tamaño del universo que nos acoge. Sabemos aún muy poco sobre sus misterios, nuestras capacidades son limitadas y al nivel de nuestra tecnología actual estamos soportando el peso de una gran ignorancia sobre muchas cuestiones que necesitamos conocer. Y, aunque parezca que estamos muy lejos de esas imágenes de arriba de tiempos remotos, en realidad, no estamos tan lejos de aquello y, nuestras mentes tienen gravados aquellos momentos del pasado que siguen con nosotros. Y, aunque el tiempo del universo no es como nuestro tiempo (mucho más corto y efímero), algo sí hemos podido aprender.

Nuestros corazones están dentro de la materia y, en cuanto se les da una oportunidad surgen y sienten

Ahora tenemos otra manera de mirar el universo y, cuando contemplamos el cielo cuajado de estrellas, sí sabemos lo que estamos viendo y lo que, en cada una de esas estrellas está pasando. Esta nueva manera de mirar el universo nos da nuevas ideas, no todo el espacio son agujeros negros, estrellas de neutrones, galaxias y desconocidos planetas; la verdad es que casi todo el universo está vacío y sólo en algunas regiones tiene agrupaciones de materia en forma de estrellas y otros objetos estelares y cosmológicos; muchas de sus propiedades y características más sorprendentes (su inmenso tamaño y su enorme edad, la soledad y oscuridad del espacio) son condiciones necesarias para que existan observadores inteligentes como nosotros.

Y… otros seres conscientes

No debería sorprendernos la vida extraterrestre (si miramos nuestra propia historia, tendremos que coincidir en el hecho cierto de que, lo mismo que pasó aquí, en la Tierra, pudo haber pasado en otros planetas que como en el nuestro, tuvieron las condiciones para el surgir de la vida), si existe, pudiera ser tan rara y lejana para nosotros como en realidad nos ocurre aquí mismo en la Tierra, donde compartimos hábitat con otros seres vivos con los que hemos sido incapaces de comunicarnos, a pesar de que esas formas de vida, como la nuestra, están basadas también en el carbono. Algunos bioquímicos dicen que no se puede descartar formas de vida inteligente basadas en otros elementos, como por ejemplo, el silicio. Por mi parte, tengo la sensación, conociendo las propiedades del Carbono y las del Silicio que, será difícil encontrar esas clases de vida, aunque…no descarto nada.

De todas las maneras, pensar que somos la única parte pensante que existe en el Universo…

¡Es adjudicarnos una importancia de la que carecemos.

Emilio Silvera V.

Dic

21

¿La velocidad de la luz? Esencial para que el Universo sea el que es

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Si tienes tiempo, dedica un poco a oír lo que nos narran en este video que, nos habla de la importancia de la velocidad de c

Pequeños cambios en esa Constante universal (y en otras), lo cambia todo. El Universo es una sincronía de sucesos en el tiempo que se repiten debido a que las leyes de la naturaleza son las mismas en todas las regiones del universo (por lejos que estén), no varían con el paso del tiempo, y, gracias a este principio de perdurabilidad, se mantiene la dinámica que está asegurada por la invariabilidad de las constantes universales.

La sincronicidad se refiere a la aparición de dos o más eventos que, aunque no tienen una relación causal evidente, son percibidos como conectados de manera significativa por el observador. Este fenómeno desafía la explicación lógica y sugiere la existencia de un orden más profundo en el universo.

Las Constantes universales son un grupo reducido de constantes fundamentales (como la velocidad de la luz , la constante de Planck h, la constante gravitacional , que definen la física, y un conjunto más amplio (alrededor de 25 a 30) de constantes empíricas en el Modelo Estándar de partículas, que describen las fuerzas y partículas del universo. El número depende de si contamos las que definen las unidades del Sistema Internacional (como la constante de Boltzmann , la carga elemental del electrón e, y las que describen el universo en su conjunto, como la constante de estructura fina (α).

El valor de α es aproximadamente 1/137, es un número adimensional fundamental en física que mide la intensidad de la interacción electromagnética entre partículas cargadas y la luz, relacionando la carga del electrón (), la velocidad de la luz (c), y la constante de Planck (h), en la fórmula:

Este “número mágico” (137.035…) describe la separación (estructura fina) de las líneas espectrales atómicas y es crucial en la electrodinámica cuántica (QED).

-

- Adimensional: No tiene unidades (metros, segundos, etc.) y es un número puro, por lo que su valor es universal.

- Intensidad Electromagnética: Cuantifica qué tan fuerte es la interacción entre un electrón y un fotón (luz).

- Origen: Fue introducida por Arnold Sommerfeld para explicar las desviaciones relativistas en los espectros atómicos.

- Valor Actual: Se ha medido con gran precisión, siendo aproximadamente 1/137.035999…

. - Misterio: Su valor exacto (137) sigue siendo un enigma, ya que no se puede derivar de la teoría actual, y físicos como Richard Feynman lo consideraban un número fundamental y misterioso.

- Determina la probabilidad de que un electrón emita o absorba un fotón.

- Aparece en cálculos de la electrodinámica cuántica (QED) y describe fenómenos como el desdoblamiento de las líneas espectrales del hidrógeno.

-

- Velocidad de la luz (): En relatividad y electromagnetismo.

- Constante de Planck (ℎ): En mecánica cuántica.

- Constante Gravitacional (): En gravedad.

- Constante de Boltzmann (): Conecta energía y temperatura.

- Carga elemental (): Carga del protón/electrón.

- Constante de Avogadro (): Relaciona cantidad de sustancia con partículas.

- Además de las anteriores, el Modelo Estándar de partículas (que describe las partículas y fuerzas fundamentales, excepto la gravedad) requiere unas 24 constantes adicionales para fijar sus parámetros, como masas de partículas, ángulos de mezcla, y parámetros de la fuerza débil.

Todo esto junto con otras maravillas que están presentes en nuestro Universo, son las que hacen posible la presencia de la Vida. Si la carga del electrón, o la masa del protón, variaran aunque solo fuese una diez milésima parte… ¡Los átomos no se podrían formar, la materia no existiría y nosotros tampoco.

Se habla del Ajuste Fino del Universo para la posibilidad de la presencia de la Vida, y, lo cierto es que, en estas constantes y en esas cuatro leyes fundamentales, es donde realmente está ese Ajuste Fino del que hablan. Por eso precisamente, sabiendo que todo el Universo está regido por esas leyes y esas constantes que son las que reinan en todas sus regiones, es por lo que, aplicando la lógica, debemos pensar que en todas partes ocurren las mismas cosas, que la vida no es un privilegio de la Tierra, que existen miles de millones de planetas en los que pido surgir , surge y seguirá surgiendo la Vida que, según creo, estará, como en la Tierra basada en el Carbono.

El Universo que conocemos no es completo, esconde muchos secretos que tratamos de desvelar, es mucho más lo que nos queda por saber que lo que sabemos pero, los individuos de nuestra especie (los humanos), son engreídos por naturaleza, como lo demuestra aquellos físicos de hace más de 150 años que decían que, salvo un par de detalles, ya lo sabíamos todo sobre el universo y su Naturaleza. Lo que hemos avanzado desde entonces en el conocimiento de la Física del macro y del micro universo, nos ha demostrado que, nuestra ignorancia sigue siendo grande, y, si lo reconocemos, será un gran paso para seguir avanzando, ya que, si creemos saberlo toso… ¿Para que seguir buscando?

Emilio Silvera V.

ç

Dic

21

¿El Misterio? Persistirá como el Tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

Tras un largo y penoso caminar por el planeta Tierra …

Los habitantes de este mundo, hemos conseguido construir un cuadro plausible del Universo, de la Naturaleza que tratamos de comprender. Hemos llegado a ser conscientes de que, en ella, en la Naturaleza, están todas las respuestas que buscamos y, nosotros mismos no hemos llegado a conocernos por ese mismo hecho de que, formando parte de la Naturaleza, y, también, somos parte del enigma que tratamos de desvelar.

Parece que ahora estamos entrando en la edad adulta, quiero significar que después de siglos y milenios de esporádicos esfuerzos, finalmente hemos llegado a comprender algunos de los hechos fundamentales del Universo, conocimiento que, presumiblemente, es un requisito de la más modesta pretensión de nuestra madurez cosmológica.

Sabemos, por ejemplo, dónde estamos, que vivimos en un planeta que gira alrededor de una estrella situada en el borde de la Galaxia espiral a la que llamamos Vía Láctea, cuya posición ha sido determinada con respecto a varios cúmulos vecinos que, en conjunto, albergan a unas cuarenta mil galaxias extendidas a través de un billón de años-luz cúbicos de espacio.

También sabemos más o menos, cuando hemos entrado en escena, hace unos cinco mil millones de años que se formaron el Sol yn los planetas de nuestro Sistema Solar , en un Universo en expansión que probablemente tiene una edad entre dos y cuatro veces mayor. Hemos determinado los mecanismos básicos de la evolución de la Tierra, hallado prueba también de evolución química a escala cósmica y hemos podido aprender suficiente física como para comprender e investigar la Naturaleza en una amplia gama de escalas desde los Quarks saltarines en el “mundo” microscópico hasta el vals de las galaxias.

Los sumerios eran un pueblo del sur de Mesopotamia cuya civilización floreció entre el 4100 y el 1750 a.C. Su nombre proviene de la región que, con frecuencia (e incorrectamente) se considera un país. Sumer nunca fue una entidad política cohesionada, sino una región de ciudades estado, cada cual con su propio rey.

En este pueblo se empleó por primera vez la ingeniería hidráulica, la astronomía, las matemáticas, la química, la medicina o la farmacopea, inventaron sus habitantes la enseñanza, la legislación, o la literatura.

Las dos primeras civilizaciones que surgieron en la historia fueron: La civilización mesopotámica, en un lugar llamado Mesopotamia (hoy Irak), entre los ríos Tigres y Éufrates. La civilización egipcia, en Egipto, alrededor del río Nilo.

Los sumerios inventaron jeroglíficos pictóricos que más tarde dieron lugar a la escritura cuneiforme propiamente dicha, y su lengua, junto con la del Antiguo Egipto, compiten por el crédito de ser la lengua más tempranamente documentada.

Mesopotamia es la civilización urbana alfabetizada más antigua del mundo , y los sumerios, que establecieron la civilización, establecieron las reglas básicas.,

Hace casi cinco mil años y más de mil antes de que se redactara la Biblia, los sumerios ofrecieron testimonio escrito del primer Job, del primer Moisés, el primer esbozo del paraíso, la primera resurrección de una divinidad y, cómo no, el primer diluvio universal.

La civilización babilónica fue una cultura antigua del Cercano Oriente que existió entre 2100 y 538 a. C. Los babilonios conquistaron a los pueblos vecinos y, dos veces en su historia, lograron construir un imperio y controlar toda la región.

Inventaron el sistema sexagesimal que creó un minuto de 60 segundos, una hora de 60 minutos y un círculo de 360 grados, así como la escritura cuneiforme que durante 3 mil años sería adaptada a unos doce idiomas.

Babilonia se fundó en algún momento antes del reinado de Sargón de Acad (el Grande, 2334-2279 a.C.) y parece haber sido una ciudad portuaria menor en el río Éufrates hasta el ascenso de Hammurabi quien reinó de 1792 a 1750 a.C. y la convirtió en la capital de su Imperio babilónico.

La civilización China es la más antigua del mundo, tiene una historia de más de 3,500 años. Su nombre “zhong guo” significa “país del centro” o “el reino central”; ellos creían que su país era el centro geográfico del mundo y que eran la única cultura civilizada.

China posee una cultura milenaria con una gran capacidad de invención. Algunos de los inventos de la ciencia china han supuesto cambios importantes en otras culturas. Veamos algunos de ellos. El papel apareció en el año 105 de nuestra era.

La cultura china era estable, impidiendo guerras y rebeliones que surgían de diferentes sistemas de creencias . Los grandes ríos de China ayudaron al comercio, las barreras naturales, la bebida, la siembra y el transporte. Muchos inventos en la antigua China la hicieron poderosa y cambiaron el resto del mundo, trayendo la civilización.

Las siete dinastias Chinas:

- Dinastía conquistadora.

- Dinastía Liang posterior.

- Dinastía Liao.

- Dinastía Qi del Sur.

- Dinastía Shun.

- Dinastía Zhou Oriental.

- Dinastía Zhou Tardía.

La cultura china era estable, impidiendo guerras y rebeliones que surgían de diferentes sistemas de creencias . Los grandes ríos de China ayudaron al comercio, las barreras naturales, la bebida, la siembra y el transporte. Muchos inventos en la antigua China la hicieron poderosa y cambiaron el resto del mundo, trayendo la civilización.

El Tiempo inexorable nunca dejó de fluir y mientras eso pasaba, nuestra especie evolucionaba, aprendía al observar los cielos y cómo y por qué pasaban las cosas. Hay realizaciones humanas de las que, en verdad, podemos sentirnos orgullosos. Aquellos habitantes de Sumer y Babilonia, de Egipto o China y también de la India y otros pueblos que dejaron una gran herencia de saber a los Griegos que pusieron al mundo occidental en el camino de la ciencia, nuestra medición del pasado se ha profundizado desde unos pocos miles de años a más de diez mil millones de años, y la del espacio se ha extendido desde un cielo de techo bajo no mucho mayor que la distancia que nos separa de la Luna hasta el radio de más de diez mil millones de años-luz del universo observable.

Tenemos razones para esperar que nuestra época sea recordada (si por ventura queda alguien para recordarlo) por sus contribuciones al supremo tesoro intelectual de toda la Humanidad unida al contexto del Universo en su conjunto por unos conocimientos que, aunque no suficiente, sí son los necesarios para saber dónde estamos y, ahora, debemos buscar la respuesta a esa pregunta: ¿Hacia dónde vamos?

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fd1c%2Fb60%2F633%2Fd1cb60633b738916a9a7eab75c82cf6a.jpg)

Claro que…, ¡el futuro es incierto!

Como en la física, en el mundo y en nuestras vidas, también está presente el principio de incertidumbre y, de ninguna manera, podemos saber del mañana. Sin embargo, cuanto más sabemos del universo, tanto más claramente comprendemos lo poco que sabemos de él. La vastedad del Universo nos lleva a poder comprender algunas estructuras cósmicas y mecanismos que se producen y repiten como, el caso de la destrucción que nos lleva a la construcción. Es decir, una estrella masiva vieja explota y siembre el Caos y la destrucción en una extensa región del espacio, y, es precisamente ese hecho el que posibilita que, nuevas estrellas y nuevos mundos surjan a la vida. Sin embargo, la grandeza, la lejanía, esa inmensidad que se nos escapa a nuestra comprensión terrestre, nunca nos dejará comprender el universo en detalle y, siendo así, siempre tendremos secretos que desvelar y misterios que resolver.

Si añadimos a todo eso que, si poseyésemos un atlas de nuestra propia Galaxia y que dedicase una sola página a cada sistema estelar de la Vía Láctea (de modo que el Sol y sus planetas estuviesen comprimidos en una página), tal atlas tendría más de diez mil millones de volúmenes de diez mil páginas cada uno. Se necesitaría una biblioteca del tamaño de la de Harvard para alojar el Atlas, y solamente ojearlo al ritmo de una página por segundo nos llevaría más de diez mil años. Añádanse los detalles de la cartografía planetaria, la potencial biología extraterrestre, las sutilezas de los principios científicos involucrados y las dimensiones históricas del cambio, y se nos hará claro que nunca aprenderemos más que una diminuta fracción de la historia de nuestra Galaxia solamente, y hay cien mil millones de galaxias más.

Sabiendo todo todo esto, siendo consciente de que, realmente, es así, tendremos que convenir con el físico Lewis Thomas cuando dijo: “El mayor de todos los logros de la ciencia del siglo XX ha sido el descubrimiento de la ignorancia humana”.

La ignorancia, como todo en el Universo, es relativa. Nuestra ignorancia, por supuesto, siempre ha estado con nosotros, y siempre seguirá estando, es una compañera con la que cargamos toda nuestra vida y que nos pesa. Algunos procuramos que pese lo menos posible para hacer más llevadero el viaje. Lo nuevo está en nuestras consciencias y de ellas, ha surgido nuestro despertar al comprender de sus abismales dimensiones, y es eso más que otro cosa, lo que señala la madurez de nuestra especie. El espacio puede tener un horizonte y el tiempo un final pero la aventura del aprendizaje siempre será interminable y eterno, quizá (no me he parado a pensarlo) pueda ser esa la única forma de eternidad que pueda existir.

¿Explicarlo todo? ¡Nunca podremos! La Naturaleza siempre irá por delante de nosotros

La dificultad de explicarlo todo no se debe a nuestra debilidad mental, sino a la estructura misma del universo. En los últimos siglos hemos descubierto que la trama del cosmos puede abordarse en varios niveles diferentes. Mientras no se descubre el siguiente nivel, lo que ocurre en el anterior no se puede explicar, sólo puede describirse. En consecuencia, para el último nivel que se conoce en cada momento nunca hay explicaciones, sólo puede haber descripciones.

La Ciencia es intrínsicamente abierta y exploratoria, y comete errores todos los días. En verdad, ese será siempre su destino, de acuerdo con la lógica esencial del segundo teorema de incompletitud de Kurt Gödel. El teorema demuestra que la plena validez de cualquier sistema, inclusive un sistema científico, no puede demostrarse dentro del sistema. Es decir, tiene que haber algo fuera del marco de cualquier teoría para poder comprobarla. La lección que podemos haber aprendido es que, no hay ni habrá nunca una descripción científica completa y comprensiva del universo cuya validez pueda demostrarse.

No es que pertenezcamos al Universo, formamos parte de él

Y, a todo esto, debemos alegrarnos de que así sea, de que no podamos comprender el Universo en toda su inmensa dimensión y diversidad. Nuestras mentes necesitan que así sea y, tendrán, de esa manera, el escenario perfecto para seguir creciendo a medida que busca todas esas respuestas que nos faltan y, lo bueno del caso es que, cada respuesta que encontramos, viene acompañada de un montón de nuevas preguntas y, de esa manera, esa historia interminable de nuestra aventura del saber…llegará hasta la eternidad de nuestro tiempo que, necesariamente, no tiene por que ser el tiempo del universo.

Emilio Silvera V.

Dic

21

¡¡Atentos a los fenómenos naturales!!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (0)

Comments (0)

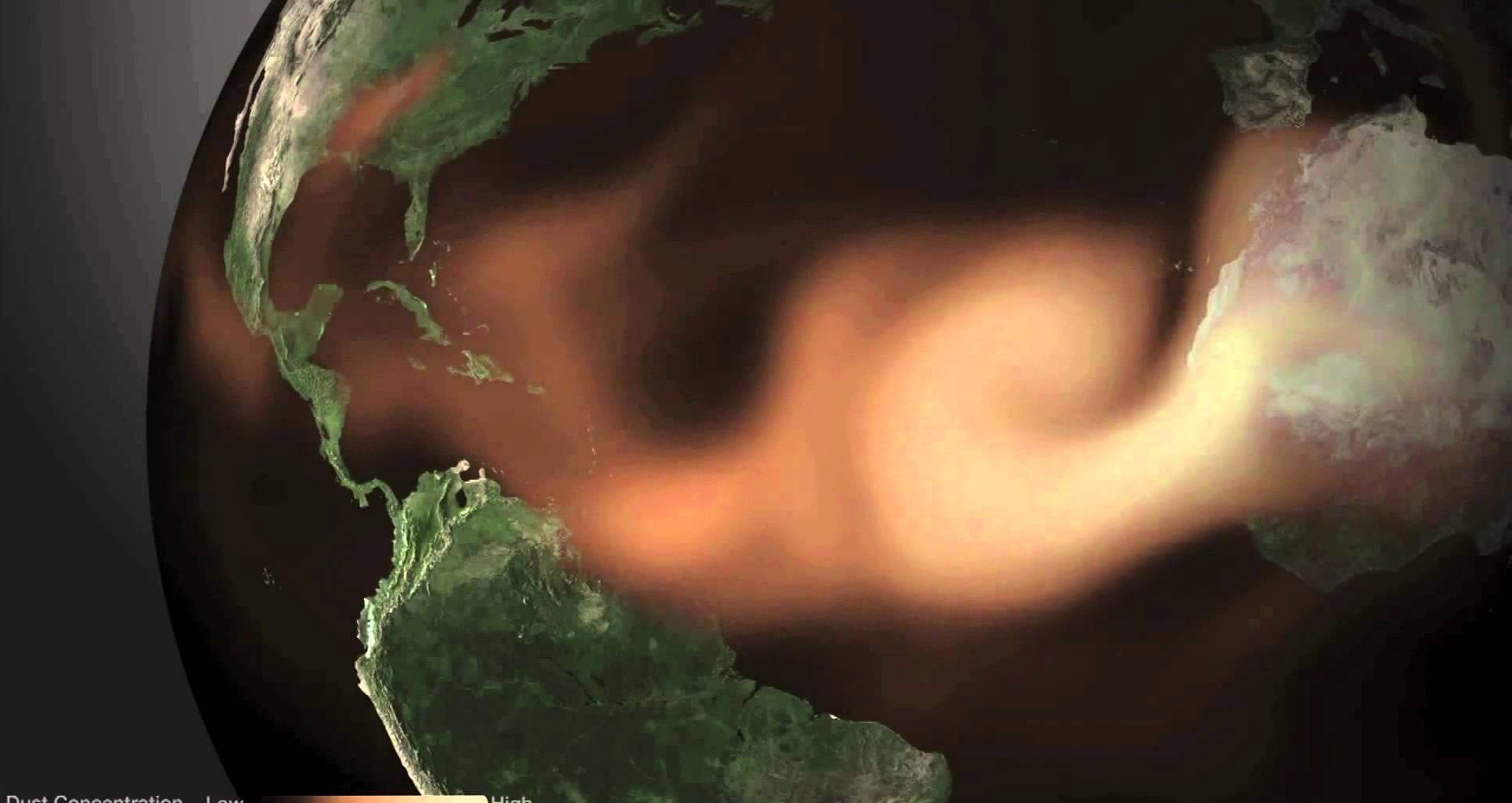

¡Nuestras Mentes! ¿Estarán predestinadas?

Los científicos del Caribe están preocupados con las ráfagas de arena venidas desde el Sahara que, también llega al Amazona y fertiliza la Selva lo mismo que nutre los Océanos. La Tierra se vale de éstos fenómenos para mantener activas sus distintas regiones, y, los terremotos, la actividad volcánica, huracanes y demás actividad Natural, aunque de momento nos pudieran parecer negativas, lo cierto es que, a la larga no lo son.

De manera periódica se produce una bruma causada por nubes de polvo sahariano que llegan desde el norte de África. Los científicos dicen que estas nubes pueden incrementar la incidencia del asma y cambiar el patrón de los huracanes

“Es parte de un fenómeno que se conoce como esparcimiento de Rayleigh y que nos habla de cómo interacciona la luz del Sol con la atmósfera de la Tierra.

Sol tiene todos los colores pero éstos no se comportan de la misma manera cuando atraviesan la atmósfera de la Tierra.

Los colores más azules se esparcen mas fácilmente que los colores más rojizos. Por eso de día el cielo se ve azul, porque la luz azul que viene en los rayos del Sol es esparcida por las moléculas del aire formando ese cielo azul que nos llega de todas las direcciones.

La distancia que la luz del Sol está atravesando en la atmósfera es mucho mayor cuando el Sol se está poniendo que a mediodía.

La luz que nos llega del Sol cuando está en el horizonte no tiene ya nada de luz azul, nada de luz amarilla, nada de luz verde, prácticamente tiene sólo luz roja. Por eso vemos más rojo.

En esos días, los amaneceres y atardeceres podrían verse en tono rojizo en los países del Caribe, pero el bello espectáculo podría traer un mensaje poco alentador, ya que se trata de una tormenta de arena proveniente del Sahara conteniendo material biológico y químico potencialmente dañino para la salud. Sin embargo, ese material sahariano es bueno como nutriente de la riqueza vegetal y de los océanos a los que sirve como nutriente.

Desde África recorre miles de kilómetros para llegar a distintas partes del mundo

Como cada año, partículas infinitamente pequeñas recorrieron miles de kilómetros desde el desierto del Sahara hacia el Caribe. A simple vista solo provocan atardeceres más intensos y algo de bruma en las mañanas, pero ahora los científicos saben que también pueden incrementar la incidencia del asma y cambiar el patrón de los huracanes.

solo provocan atardeceres más intensos y algo de bruma en las mañanas, pero ahora los científicos saben que también pueden incrementar la incidencia del asma y cambiar el patrón de los huracanes.

Inusualmente grande, la cobertura de polvo que llega cada año y descarga material sobre las Antillas y llega hasta Yucatán e incluso Wyoming, en el centro de Estados Unidos, según la NASA.

Aunque el fenómeno existe desde que hay arena en el desierto, los científicos están cada vez más preocupados por sus efectos, mientras buscan comunicarse para compartir investigaciones y tratan de desentrañar muchos misterios sobre estas nubes.

investigaciones y tratan de desentrañar muchos misterios sobre estas nubes.

Finalmente se llegó a la conclusión de que, aunque pueda causar algún daño, a la larga es un proceso beneficioso en muchos sentidos ¿Es sabia la Naturaleza?

Son muchas partes del mundo las afectadas por el fenómeno. Así pudimos ver la Giralda de Sevilla

“Es un tema de gran envergadura y sumo interés

y de importancia para la salud”, manifestó a la AP el toxicólogo de la Universidad de Puerto Rico en Mayagüez Braulio Jiménez-Vélez. “La inhalación de partículas contaminadas se puede asociar con varias enfermedades respiratorias, alergias, asma, enfermedades cardiovasculares”, agregó.

En casos extremos podría inducir cáncer de pulmón, pero los científicos aseguran que aún falta mucho por estudiar.

Este año hubo dos alertas en Puerto Rico por nubes del Sahara por lo cual las autoridades hicieron un llamado a las personas que sufren de alergias y asma para que eviten actividades al aire libre. En República Dominicana se dieron a conocer alertas más suaves.

Esta tormenta cruza por encima de Las Islas Canarias camino de otros lugares. El 70% de dichas tormentas se originan en el Norte de África.

En Cuba los meteorólogos recordaron al público que el fenómeno es anual y se mostraron precavidos, mientras en México fue tratado como una “curiosidad meteorológica”.

El fenómeno es parecido a las gigantescas tormentas de polvo que pintan el cielo de amarillo en las metrópolis asiáticas y que pueden llegar a la costa del Pacífico estadounidense, aunque sus nubes son más polvorientas todavía .

.

Este fenómeno fue estudiado por el naturalista Charles Darwin a mediados del siglo XIX y es, aseguran los expertos, un ejemplo de cómo la acción humana está distorsionando un fenómeno natural.

- La nube de polvo proveniente del desierto de África trae consigo nutrientes que fertilizan la Amazonía y benefician los océanos.

Varios científicos consultados por AP en Cuba, Puerto Rico, México y Estados Unidos indicaron que los compuestos detectados en el polvo incluyen entre otros hierro, arsénico, mercurio, virus, bacterias, hongos, fertilizantes, pesticidas y hasta compuestos fecales.

científicos consultados por AP en Cuba, Puerto Rico, México y Estados Unidos indicaron que los compuestos detectados en el polvo incluyen entre otros hierro, arsénico, mercurio, virus, bacterias, hongos, fertilizantes, pesticidas y hasta compuestos fecales.

La mayor parte del polvo atmosférico en todo el mundo tiene trazas químicas y material biológico, pero las cantidades son por lo general pequeñas como para constituir un riesgo.

Joseph M. Prospero, profesor emérito de la Universidad de Miami, aseguró que algunas muestras tomadas en Barbados contenían niveles elevados de arsénico y cadmio, pero no eran peligrosos.

emérito de la Universidad de Miami, aseguró que algunas muestras tomadas en Barbados contenían niveles elevados de arsénico y cadmio, pero no eran peligrosos.

“Ha sido extremadamente difícil vincular la composición de la partícula específica a efectos en la salud “, dijo Prospero, autor de un artículo sobre el tema que se publicará en septiembre en el boletín de la Sociedad Americana de Meteorología. “No se puede decir qué efecto tiene todo este polvo, pero sí hay motivos para cierta preocupación”.

El fenómeno es seguido de cerca por el Instituto de Meteorología de Cuba.

por el Instituto de Meteorología de Cuba.

Además hay que tener en cuenta que este proceso genera otros efectos sobre los territorios al sur del Sahara, el incremento de la sequía produce un gran stress en los bosques y plantaciones que propician la ocurrencia de incendios forestales cada vez más frecuentes y devastadores con sus correspondientes consecuencias.

que este proceso genera otros efectos sobre los territorios al sur del Sahara, el incremento de la sequía produce un gran stress en los bosques y plantaciones que propician la ocurrencia de incendios forestales cada vez más frecuentes y devastadores con sus correspondientes consecuencias.

“Hemos hecho un estudio amplio de muchos años del comportamiento del polvo”, comentó a la AP el experto cubano Eugenio Mojena, del Instituto de Meteorología.

Mojena indicó que el mecanismo de la nube es “sencillo”: bajo las condiciones extremas de sequía del norte de África, las tormentas del Sahara levantan partículas súper finas y los vientos Alisios las trasladan.

extremas de sequía del norte de África, las tormentas del Sahara levantan partículas súper finas y los vientos Alisios las trasladan.

A veces habréis oído decir: “El Aleteo de las alas de una mariposa en Singapur, puede provocar una tormenta en las Antillas”. Es una metáfora bastante cierta en la realidad si la trasladamos a hechos concretos.

El polvo del Sahara afecta a diversas zonas situadas a cientos de kilómetros del lugar en el que se produce la tor5menta

“El Polvo del Sahara está compuesto por arena y aerosoles dispersos – los cuales contienen además de material mineral, bacterias, hongos y virus-, que se generan en tormentas que se forman al Occidente de África.Este fenómeno meteorológico puede provocar disminución en las lluvias sobre las regiones en las que se mueve en grandes cantidades, de hecho, podría inhibir la formación de ciclones tropicales.”

Los expertos coinciden además en la incidencia que tiene en los ecosistemas, por ejemplo los corales que se afectan con el aumento de algas “abonadas” por el hierro de la nube, un aspecto de interés económico para unos países que viven del turismo de playa.

económico para unos países que viven del turismo de playa.

“El polvo actual no es el mismo que medía Darwin, no tenía DDT, no tenía pesticidas, ni herbicidas”, manifestó Mojena.

no es el mismo que medía Darwin, no tenía DDT, no tenía pesticidas, ni herbicidas”, manifestó Mojena.

Las nubes también pueden complicar el tráfico aéreo, reduciendo la visibilidad, explicó Jason Dunion, investigador de la Administración Nacional Oceánica y Atmosférica de Estados Unidos, pero no lo suficiente como para obligar a las desviaciones de los vuelos comerciales o cerrar aeropuertos.

La tormenta de arena provoca la paralización del tráfico aéreo en muchas regiones del mundo

Omar Torres, investigador especializado en física atmosférica de la NASA, explicó que los estudios por satélite comenzaron en 1980 y no muestran aumento de las emisiones de polvo del Sahara fuera de la variabilidad estacional normal, aunque admitió que las emisiones son más altas que los niveles de 1960.

por satélite comenzaron en 1980 y no muestran aumento de las emisiones de polvo del Sahara fuera de la variabilidad estacional normal, aunque admitió que las emisiones son más altas que los niveles de 1960.

En esta ocasión, advirtió Torres, la nube de comienzos de agosto llegó hasta el centro de los Estados Unidos.

“El avance de este año hasta llegar a Wyoming (Estados Unidos) fue totalmente inesperado. Nunca he visto nada como eso en los últimos años”, expresó Torres.

hasta llegar a Wyoming (Estados Unidos) fue totalmente inesperado. Nunca he visto nada como eso en los últimos años”, expresó Torres.

Por otra parte, lo cierto es que, las tormentas de arena del Sahara son una fuente importante de minerales escasos para las plantas de la pluvisilva amazónica. Nunca llueve a gusto de todos y, como dicen que la Naturaleza es “sabia”… ¿quién sabe por qué hace muchas de las cosas que hace?

de minerales escasos para las plantas de la pluvisilva amazónica. Nunca llueve a gusto de todos y, como dicen que la Naturaleza es “sabia”… ¿quién sabe por qué hace muchas de las cosas que hace?

En los últimos años, además, los científicos han estado descubriendo el papel que juegan las nubes del Sahara en la formación –o desintegración– de los huracanes, cuya mayor intensidad debido al cambio climático preocupa a los países del Caribe.

–o desintegración– de los huracanes, cuya mayor intensidad debido al cambio climático preocupa a los países del Caribe.

La nube del desierto tiene un efecto “trascendental para la inhibición de los de ciclones tropicales”, manifestó a la AP el experto del Servicio Meteorológico Nacional de la Comisión Nacional del Agua de México, Juan Antonio Palma Solís.

Pero incluso con todo lo que hoy sabemos del fenómeno gracias al desarrollo de la tecnología satelital, los científicos coincidieron en la necesidad de compartir más sus trabajos y coordinarlos regionalmente. “Estamos en un planeta que no deja de moverse… hay que meterle investigación”, señaló Palma.

más sus trabajos y coordinarlos regionalmente. “Estamos en un planeta que no deja de moverse… hay que meterle investigación”, señaló Palma.

Los científicos que estudian las tormentas de arena saben desde hace tiempo que la arena del Sahara puede viajar a través del Atlántico hasta América. Sin embargo, la arena asiática tiene que viajar mucho más lejos para llegar al mismo destino. En Abril del 2001, los investigadores observaron con sorpresa como la arena de una tormenta asiática cruzó el Pacífico alcanzando lugares tan lejanos cómo los Grandes Lagos e incluso Maryland.

del 2001, los investigadores observaron con sorpresa como la arena de una tormenta asiática cruzó el Pacífico alcanzando lugares tan lejanos cómo los Grandes Lagos e incluso Maryland.

Otros desastres de la Naturaleza también nos asola y están los tornados solares que, no sólo producen las bellas auroras, algunos de inmensa virulencia asolan nuestros ingenios artificiales que nos comunican los datos de múltiples fenómenos, o, son enlaces para todo el mundo en las comunicaciones, y, cuando llegan esos fuertes “vientos solares”…

Vientos solares con un diámetro en el que cabrían varias Tierras

Conocemos por las noticias la violencia y la capacidad destructiva que puede tener un tornado. Ahora imagine que ese tornado es cinco veces más grande que la Tierra y que está compuesto por un material tan ardiente como el que debe de dar forma al peor de los infiernos. Ese fenómeno es real. Se produce sobre la superficie del Sol, generado por las emisiones magnéticas. Científicos de la Universidad de Aberystwyth (Reino Unido) pudieron filmarlo en septiembre de 2011 y ahora lo han dado a conocer. Resulta apabullante.

Todos conocemos la devastación que producen los tornados en EE.UU. Centenares de edificios y dos escuelas fueron destruidas por un tornado con vientos de hasta 320 km/h que azotó Oklahoma, la cifra de muertos aún no es oficial, pues algunos manejaron 51 El servicio meteorológico nacional de Estados Unidos calificó la fuerza del tornado como EF-4 en la escala de magnitud de estos fenómenos, es equivalente a un huracán de categoría 5. Los tornados suelen afectar las planicies de Oklahoma, situadas en el llamado “Corredor de Tornados”. La localidad de Moore ya había sido destruida en parte en mayo de 1999, cuando un potente tornado mató a 41 personas.

El tsunami fue producido a causa de un terremoto de 9 grados Ritcher con una duración de 6 minutos, en el que fue seguido por el tsunami, una ola gigantesca que llegó a medir 40,5 metros de altura, algo realmente impresionante. El terremoto del cual se creó el tsunami fue el más potente sufrido en Japón hasta la actualidad y el quinto más potente del mundo medidos hasta la fecha. Este tsunami dejó cientos de víctimas mortales, emergencia nuclear y un numero increíble de desaparecidos incluyendo gente que iba en barcos y en trenes. Sin duda la fuerza de la naturaleza es incomparable a la que el hombre puede crear artificialmente.

puede crear artificialmente.

Si hablamos de Terremotos, aunque han sido muchos en el mundo conocido, siempre recordamos el de San Francisco. A las 5:12 am. del miércoles 18 de abril de 1906, la mayoría de los habitantes en San Francisco, California, EE.UU. estaban dormidos. Pero estaban a punto de despertar muy repentinamente. La tierra se sacudió violentamente, era un terremoto. Duró cerca de un minuto, pero hizo mucho daño. Edificios derribados. Personas atrapadas debajo de escombros. Se rompieron conductos de agua y gasolina. Y poco después de que la sacudida terminara, comenzaron incendios en la ciudad. Los fuegos estaban fuera de control y los incendios duraron tres días. El terremoto ocurrió cuando hubo un movimiento precipitado a lo largo de la falla de San Andreas. Esta gran falla de transformación está en California. Es el límite entre dos de las placas tectónicas de la Tierra.

de un minuto, pero hizo mucho daño. Edificios derribados. Personas atrapadas debajo de escombros. Se rompieron conductos de agua y gasolina. Y poco después de que la sacudida terminara, comenzaron incendios en la ciudad. Los fuegos estaban fuera de control y los incendios duraron tres días. El terremoto ocurrió cuando hubo un movimiento precipitado a lo largo de la falla de San Andreas. Esta gran falla de transformación está en California. Es el límite entre dos de las placas tectónicas de la Tierra.

Imagen de la Falla de San Andrés tomada de Wikipedia con el texto que la acompaña

“La falla de San Andrés (en inglés: San Andreas Fault) está situada en una gran depresión del terreno en un área límite transformante, con desplazamiento derecho entre la placa Norteamericana y la placa del Pacífico. Esta falla transformante es famosa por producir grandes y devastadores terremotos. Tiene una longitud de aproximadamente 1,286 km y pasa a través del estado de California, en Estados Unidos, y de Baja California en México. El sistema está compuesto por numerosas fallas o segmentos. El sistema de fallas de San Andrés termina en el golfo de California.

El lunes 19 de septiembre de 2011, una serie de temblores se sintieron en Guatemala, El Salvador y Honduras, el lugar más afectado fue Santa Rosa, departamento de Guatemala, con 3 muertos y 12 desaparecidos. El Domingo 4 de abril de 2010 el Terremoto de Baja California de 7,2 grados en la escala de Richter con epicentro localizado en el poblado Guadalupe Victoria azotó fuertemente a la región de Baja California y Sonora dejando un saldo de 4 personas muertas y 182 heridos, el sismo se hizo sentir en varias ciudades de México y Estados Unidos como Los Angeles en California, Salinas, San Diego, Calexico, Moreno y otra más, además en México se sintió con mayor intensidad en Mexicali, San Luis Rio Colorado, Ensenada, Tijuana, Tecate y en poblaciones como el Golfo de Santa Clara en Sonora, este es considerado por expertos sismólogos como un pequeño paso de lo que puede ser el comienzo de la actividad sísmica que originara el The Big One, un sismo de dimensiones catastróficas que se predice afectará el área de una manera nunca antes imaginada en menos de 30 años según expertos.”

Aquí lo dejo porque la lista es muy amplia.

¿Qué podemos decir de los Volcanes y de los cientos de miles de muertos que han provocado sus erupciones cuando la Tierra explota y expulsa el magma hacia el exterior al haber alcanzado sus entrañas el nivel máximo soportable y tiene que arrojar la materia ardiente para aliviar y regularizar de nuevo alcanzando una regularidad soportable.

Volcán Tambora:

82000 muertos aproximadamente en 1815

Fisura Volcánica Laki:

39350 muertos en 1783

Volcán Krakatoa:

36417 muertos en 1883

Monte Pelée:

30121 muertos en 1902.

El Santa Elena (Washington– EE·.UU.) que produjo una erupción catastrófico en 1980

El Volc´sn Chabeland en las Islas Aleutian en Alaska, sus nubes alcanzan los 6000 m

Tendráimos que prestar más atención a la Tectónica de Placas continentales que, en su actividad son las que producen todos esos fenómenos a los que antes hacíamos referencia. Aunque después se han realizado otras. Hay una prueba experimental directa de la tectónica de placas. A mediados de la década de los ochenta, astrónomos de Europa y Estados Unidos dirigieron sus radiotelescopios hacia el mismo púlsar y luego midieron las diferencias en el tiempo de llegada de las ondas de radio.

experimental directa de la tectónica de placas. A mediados de la década de los ochenta, astrónomos de Europa y Estados Unidos dirigieron sus radiotelescopios hacia el mismo púlsar y luego midieron las diferencias en el tiempo de llegada de las ondas de radio.

directa de que Europa se aleja de Estados Unidos, como los teóricos de la tectónica de placas han estado diciendo todo el tiempo.

directa de que Europa se aleja de Estados Unidos, como los teóricos de la tectónica de placas han estado diciendo todo el tiempo.Todos estos fenómenos naturales hacen cambiar el mundo. Los grandes accidentes de la superficie terrestre (el fondo marino, los continentes y sus cordilleras) han sido generados por el imparable movimiento de los rígidos bloques de la litosfera. Las grandes placas oceánicas divergen en las crestas dorsales oceánicas, donde surge el magma creando nueva corteza basáltica, que se desliza a lo largo de fallas hasta que finalmente chocan con los bordes continentales donde se hunden en profundas fosas, zonas de subducción, para ser recicladas en el manto. Aunque el recorrido entre la dorsal y la fosa se completa en 107 años, algunas zonas continentales permanecen muy estables, estando cubiertas por rocas cuya edad es casi

marino, los continentes y sus cordilleras) han sido generados por el imparable movimiento de los rígidos bloques de la litosfera. Las grandes placas oceánicas divergen en las crestas dorsales oceánicas, donde surge el magma creando nueva corteza basáltica, que se desliza a lo largo de fallas hasta que finalmente chocan con los bordes continentales donde se hunden en profundas fosas, zonas de subducción, para ser recicladas en el manto. Aunque el recorrido entre la dorsal y la fosa se completa en 107 años, algunas zonas continentales permanecen muy estables, estando cubiertas por rocas cuya edad es casi veinte veces la edad de las más antiguas cortezas marinas, que a su vez, datan de unos doscientos millones de años.

veinte veces la edad de las más antiguas cortezas marinas, que a su vez, datan de unos doscientos millones de años.

Movimientos divergentes: cuando dos placas se separan una de la otra, generalmente desde las dorsales oceánicas.

Dondequiera que choquen las relativamente rápidas placas tectónicas oceánicas con las enormes placas continentales, se forman cadenas montañosas en continua elevación. Los ejemplos más espectaculares se subducción y formación montañosa son, respectivamente, la placa del Pacífico sumergiéndose en las profundas fosas del Asia oriental, y el Himalaya, que se eleva por el choque de las placas índica y euroasiática.

montañosa son, respectivamente, la placa del Pacífico sumergiéndose en las profundas fosas del Asia oriental, y el Himalaya, que se eleva por el choque de las placas índica y euroasiática.

El Himalaya es una cordillera en el continente asiático. Se extiende por los países de Bután, China, Nepal e India.

En otras zonas de la litosfera, la afloración de rocas calientes del manto debilita inicialmente y agrietan posteriormente la corteza continental, hasta que finalmente, formando nueva corteza oceánica, separan los continentes. Ejemplos de diversos estadios de este proceso son el Mar Rojo, el golfo de Adén y las fracturas del Valle del Rift, en el este de África.

La zona es conocida como el Gran Valle del Rift y corresponde a la fractura geológica producida por la fricción entre la Placa Africana y la Placa Arábiga. Vista desde Google Maps, son una serie de estrías de entre 3.000 y casi 5.000 kilómetros de longitud. Comenzó a formarse hace más de 30 millones de años, y previsiblemente será el punto de separación entre los continentes africano y asiático.

desde Google Maps, son una serie de estrías de entre 3.000 y casi 5.000 kilómetros de longitud. Comenzó a formarse hace más de 30 millones de años, y previsiblemente será el punto de separación entre los continentes africano y asiático.

Este proceso de separación continental parece ser bastante regular. Se observan periodos de formación montañosa por compresión en el intervalo de cuatrocientos a quinientos millones de años, a los que sigue, unos cien millones de años más tarde, un resurgir de la rotura. Esta secuencia se repite en un ciclo super-continental en el que se alterna la separación de grandes zonas continentales con su agrupamiento.

montañosa por compresión en el intervalo de cuatrocientos a quinientos millones de años, a los que sigue, unos cien millones de años más tarde, un resurgir de la rotura. Esta secuencia se repite en un ciclo super-continental en el que se alterna la separación de grandes zonas continentales con su agrupamiento.

Las plumas de magma que perforan la litosfera también crean focos calientes duraderos que están asociados a los volcanes. Las islas Hawai y la cadena de montañas oceánicas que se extienden desde ellas hasta Kamchatka constituyen la manifestación más espectacular de focos calientes que surgen en medio de la veloz placa del Pacífico, entre los que actualmente se encuentran los ríos continuos de lava del volcán Kilauea y la lenta creación de la futura isla hawaiana de Loihi.

Las enormes plumas de magma que afloran desde las capas profundas del mano han dado origen a grandes superficies de lava, la mayor de las cuales es la meseta oceánica de Ontong Java , que cubre dos millones de kilómetros cuadrados, y la meseta del Decán y la siberiana, que son las mayores formaciones basálticas continentales. La generación de estas extensas formaciones afecta de manera importante a la composición de la atmósfera debido a las grandes emisiones de CO2 y SO2 que las acompañan, y que causan elevaciones de la temperatura troposférica y lluvias ácidas, con los consiguientes efectos cruciales en la biota.

, que cubre dos millones de kilómetros cuadrados, y la meseta del Decán y la siberiana, que son las mayores formaciones basálticas continentales. La generación de estas extensas formaciones afecta de manera importante a la composición de la atmósfera debido a las grandes emisiones de CO2 y SO2 que las acompañan, y que causan elevaciones de la temperatura troposférica y lluvias ácidas, con los consiguientes efectos cruciales en la biota.

En nuestro mundo podemos admirar grandes maravillas naturales

Los procesos energéticos de la geotectónica terrestre son complejos. Incluso resulta todavía incierta la contribución relativa de las fuerzas involucradas en el movimiento de las placas tectónicas. Las dos fuerzas más importantes están asociadas a la convección del material caliente del manto y al hundimiento de las zonas frías, con flotabilidad negativa, de la litosfera oceánica en las zonas de subducción. Este último proceso es debido a diferencias de densidad, máxima a una profundidad de doscientos o trescientos kilómetros, que generan un momento de fuerzas en el manto viscoso responsable de la principal fuerza convectiva.

fuerza convectiva.

la distribución de los cinturones sísmicos y volcánicos, que coinciden con la situación de las fosas y dorsales oceánicas, han permitido mostrar una superficie terrestre fragmentada en placas litosféricas. A partir de profundos estudios se estableció la hipótesis de la expansión del fondo oceánico, que, resumidamente, afirmaba que continuamente se está formando suelo oceánico en las dorsales oceánicas

se estableció la hipótesis de la expansión del fondo oceánico, que, resumidamente, afirmaba que continuamente se está formando suelo oceánico en las dorsales oceánicas

Las velocidades de las placas, al ser estudiadas, se observa que las que cuentan con una mayor proporción de sus bordes en zonas de subducción se mueven a velocidades de 60 a 90 kilómetros por millón de años, mientras que la velocidad de las placas en las que no hay hundimiento de bloques es inferior a 40 kilómetros por millón de años.

Sin embargo, la contribución de la emisión de material del manto no es despreciable, ya que la considerable energía potencial gravitatoria de extensas zonas de rocas calientes hace que se genere nueva corteza marina en las dorsales oceánicas con una velocidad que es, al menos, tres veces superior a la velocidad con que se genera en los planos abisales.

a la velocidad con que se genera en los planos abisales.

La primera en Chile y la segunda al Sur de Portugal casi en la frontera con España

La combinación de ese “tirar” a lo largo de las zonas de subducción y de “empujar” en las dorsales da lugar a velocidades, para las placas más rápidas, de aproximadamente 20 cm/año durante cortos periodos de tiempo. Entre estas placas que se mueven rápidamente se encuentran no sólo los pequeños bloques como Nazca y Cocos, sino también la enorme placa del Pacífico, lo cual indica que la fuerza de arrastre del manto, proporcional al área y a la velocidad, debe ser relativamente pequeña.

La mayor parte del flujo de calor que se ha medido en la Tierra debe atribuirse a la formación de nueva litosfera oceánica. Lo cierto es que, de todos estos fenómenos naturales que no son deseados por ninguno de nosotros por los destrozos que causan, lo cierto es que, sin ellos, la vida no se renovaría y tampoco podría surgir la sabia nueva. La Naturaleza es sabia y hace lo que tiene que hacer, aunque ello sea !La destrucción de la construcción!

de nueva litosfera oceánica. Lo cierto es que, de todos estos fenómenos naturales que no son deseados por ninguno de nosotros por los destrozos que causan, lo cierto es que, sin ellos, la vida no se renovaría y tampoco podría surgir la sabia nueva. La Naturaleza es sabia y hace lo que tiene que hacer, aunque ello sea !La destrucción de la construcción!

Emilio Silvera Vázquez

El presente trabajo

, en su mayor parte (salvo algunos añadidos) corresponde al redactor de ciencia Seth Borenstein en Washington y los corresponsales Peter Orsi en La Habana y Dánica Coto en Puerto Rico que contribuyeron con este reportaje.

Totales: 83.638.157

Totales: 83.638.157 Conectados: 52

Conectados: 52

:format(jpg)/f.elconfidencial.com%2Foriginal%2F726%2F83b%2F684%2F72683b6846d344addae55d788d146213.jpg)