Abr

30

¡La Tierra! Tenemos que seguir conociéndola

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Naturaleza...El Universo ~

Clasificado en La Naturaleza...El Universo ~

Comments (2)

Comments (2)

La Tierra, nuestro hogar

La humanidad es parte de un vasto universo evolutivo. La Tierra, nuestro hogar, está viva con una comunidad singular de vida. Las fuerzas de la naturaleza promueven a que la existencia sea una aventura exigente e incierta, pero la Tierra ha brindado las condiciones esenciales para la evolución de la vida. Sin embargo, el planeta nos impone sus propias reglas y, de vez en cuando, nos avisa de que, su presencia, no es inamovible ni estática, sino que, por el contrario se mueve y evoluciona como todo en el Universo y, un ejemplo muy vivo está en los…

Los volcanes

La unívoca asociación de los volcanes activos con las zonas de subducción de las grandes placas tectónicas permite localizar casi todas las erupciones recientes alrededor del océano Pacífico y, sobre todo, en América central, Sudamérica, Filipinas, Japón y Kamchatka. Una categoría menos común incluye los volcanes asociados a los puntos calientes, donde las placas tectónicas se ven atravesadas por flujos magmáticos procedentes del manto, a la cual pertenecen los volcanes de Hawai y África central.

El Vesubio: En Italia, se encuentra ubicado uno de los volcanes que más devastación ha causado en la historia. Hace varios siglos, este volcán hizo erupción destruyendo Pompeya y Herculano, matando a 25 mil personas. Según los registros, mucha gente fue petrificada viva.

Las erupciones históricas más conocidas son las Théra, en Grecia (alrededor del 1.500 a. C.), del Vesubio en Italia (79 a. C.) y del Cracatoa (1.883 d. C.) en Indonesia, y el del monte St. Helens en el estado de Washington en 1.980. Éste último caso es la erupción volcánica mejor estudiada hasta la fecha. Se conoce, no solamente el volumen de los depósitos expulsados (0’18 Km3) y de lava (0’5 Km3), sino también un detallado desglose de la energía relacionada con la erupción.

Los flujos de calor dominan en el proceso: la energía térmica de los productos expulsados, las avalanchas, los chorros de agua, los flujos piroplásticos y las nubes de ceniza, dan un total de 1’66 EJ, cerca de veinte veces la energía cinética total de la erupción.

Etna: Ubicado en Italia, es el más alto y activo volcán de Europa. Su erupción más violenta fue en 1669 donde destruyó varios pueblos cercanos. El 12 de mayo de este año, el volcán arrojó grandes cantidades de lava, por lo que las autoridades decidieron cerrar el aeropuerto internacional de Catania.

El 18 de mayo de 1.980, el volcán del monte St. Helens desarrolló, durante nueve horas de erupción, una energía total de 1’7 EJ, lo que equivale a una potencia media de 52 TW, es decir, unas cinco veces el consumo anual mundial de energía en el sector primario en los primeros años noventa. Aún más potentes fueron las de Bezymyannyi, Kamchatka, en 1.956 (3’9 EJ), y la de Sakurajima, Japón, en 1.914 (4’6 EJ). La mayor erupción que tuvo lugar en el siglo XIX fue la del volcán Tambora, en 1.815, que liberó más de 80 EJ de energía (basado en los depósitos de cenizas) que es un orden de magnitud superior a los anteriormente mencionados. Pero incluso la más potente erupción conocida es irrelevante comparada con las sucedieron hace varios vientos de miles de años, y que a su vez, son pequeñas comparadas con las erupciones magmáticas más antiguas.

Cuando Yellowstone estalle

Debajo del parque de Yellowstone, una monstruosa pluma de roca caliente levanta la tierra y la hace temblar. Las pasadas erupciones tuvieron una potencia comparable a la de mil montes Saint Helens. El futuro es imprevisible. Cuando la Naturaleza se enfada… nosotros a temblar.

A veces estornuda y nos arrasa un huracán. O a veces carraspea un poco y nos graniza que da miedo. O incluso se estira un poco y nos sacuden los terremotos. Pero nada es tan temible como si un día la tierra decidiera encender una de sus “pipas”. Sólo el humo de su tabaco nos mataría. Este gráfico del National Geographic sobre Yellowstone nos puede dar una idea real de las dimensiones de una de esas “pipas”. Me gustó mucho cuando lo ví en papel. Pero también se puede encontrar en la red. Aquí está un enlace por si a alguien le interesa pasar a mirar…:

http://www.nationalgeographic.com.es/2009/10/29/cuando_yellowstone_estalle.html

Entre las cerca de diez calderas jóvenes, enormes cráteres formados en las gigantescas erupciones que se produjeron en el último millón de años, están la de Yellowstone (formada hace 600.000 años, con un diámetro de 70 Km y 1.000 m3 de material expulsado, principalmente piedra pómez y cenizas), y la de Toba (situada en el noroeste de Sumatra, formada hace 75.000 años, de casi 100 Km de anchura y con más de 2.000 m3 de material eyectado).

Un prolongado periodo de erupciones volcánicas que empezó hace 66 millones de años – varios cientos de millones de años de cataclismos que lanzaron a la atmósfera enormes cantidades de cenizas y produjeron dos millones de Km3 de lava, creando la inmensa Decan Traps de la India – parece ser la causa, al menos tan plausible como la colisión de la Tierra con un asteroide, de la masiva extinción que se produjo en la frontera del cretácico y el terciario.

Erupción del Monte Santa Helena en EEUU

Aunque las erupciones históricas han supuesto una considerable pérdida en vidas humanas (cerca de 250.000 desde 1.700), pérdidas materiales enormes y han sido una de las causas más importantes de los cambios climáticos temporales, ninguna de estas consecuencias está claramente correlacionada con la energía total liberada en las mismas. Las emisiones térmicas son casi siempre dominantes, de una a tres órdenes de magnitud mayores que todos los demás flujos de energía, y se dividen en varias clases de flujos diferentes. En algunas erupciones, la mayor parte de la energía térmica liberada está asociada con la emisión de nubes de cenizas que se elevan hasta la estratosfera; así las cenizas de la erupción del monte St. Helens se elevaron a 20 Km, y otras hasta los 30 Km, e incluso más, con cambios atmosféricos locales y espectaculares puestas de Sol y uno o dos años con temperaturas más bajas de las habituales en algunas regiones. En Nueva Inglaterra, por ejemplo, no hubo verano en 1.816.

En otras erupciones, la mayor parte de la energía térmica es transportada por las corrientes piroclásticas. Estas corrientes se forman por explosión y están compuestas por partículas volcánicas, cuyos tamaños varían entre los μm y varios metros, y gases calientes. Alcanzan temperaturas cercanas a los 1.000º C, se propagan a velocidades de hasta 300 m/s y se extienden a distancias de cientos de kilómetros del lugar de origen.

En la erupción del monte Pelée, isla de Martinica en 1.902, estas nubes incandescentes acabaron con la vida de 28.000 personas. En las erupciones de los volcanes hawaianos, el principal flujo de calor está predominantemente asociado a la emisión de lavas que se desplazan lentamente; así, en la erupción del Mauna Loa en 1.950, con una energía liberada de magnitud parecida a la del monte St. Helens, no se produjeron desplazamientos de lodos, avalanchas ni nubes de cenizas.

Siendo espectaculares y a veces devastadoras, las erupciones volcánicas representan una fracción muy pequeña de la energía térmica que mueve la geotectónica terrestre. Suponiendo que en total aflora 1 Km3/año de lava continental y que las erupciones oceánicas contribuyen con otros 4 Km3/año, el calor global perdido anualmente está cerca de los 800 GW, lo cual representa solamente el 2 por ciento del flujo geotérmico terrestre global. La grandiosidad de estos fenómenos está enmascarada en ámbitos de límites regionales, que a nivel global son casi insignificantes.

Los volcanes son una manifestación en superficie de la energía interna de la Tierra. La temperatura y la presión se incrementan a medida que nos acercamos al centro de la Tierra, alcanzándose temperaturas de 5000 ºC en el núcleo. El efecto combinado de la temperatura y la presión a distintas profundidades provoca un comportamiento diferente de los materiales que se estructuran en varias capas:

• La corteza, fría y muy rígida, es la capa externa.

• El manto, con temperaturas superiores a los 1000 ºC, presenta un comportamiento semirrígido. En los niveles superiores es donde se originan los magmas por fusión parcial de las rocas que allí se encuentran. En el manto inferior (Astenosfera), los materiales se mueven lentamente debido a las corrientes de convección originadas por las diferencias de temperatura entre la parte superior y el núcleo, provocando el movimiento de las placas tectónicas.

• El núcleo es la parte más interna y más densa de la Tierra. Se encuentra a una temperatura próxima a los 5000 ºC. Debido a esta elevada temperatura, los materiales se comportan como un líquido (núcleo externo); sin embargo, en la zona más profunda se encuentran en forma sólida debido a la elevadísima presión que soportan.

La actual estructura interna de la Tierra se ha ido formando a medida que el planeta ha ido envejeciendo y enfriándose. Inicialmente, toda la superficie estaba constituida por materiales fundidos, que han ido solidificándose en el transcurso de miles de millones de años. La actividad volcánica actual es sólo un resto de este proceso. Si nos paráramos un momento para estudiar a fondo los mecanismos que se producen en nuestro planeta que se comporta como si de un ser vivo se tratara (de alguna manera lo es), veríamos con asombro como todo lo que ocurre tiene su por qué y sus consecuencias que, no siempre son tan destructuras como en un principio nos pudiera parecer.

Más peligros que los volcanes podríamos llegar a ser… ¡Nosotros mismos! Si no tenemos cuidado y vigilamos hacia donde vamos y sopesamos los peligros de las fuerzas que podemos manejar.

emilio silvera

Abr

28

Pequeñas Galaxias y Materia Oscura

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Analizando la luz de las galaxias pequeñas y de brillo débil que orbitan a la Vía Láctea, un equipo de científicos cree haber descubierto la masa mínima para las galaxias en el universo: 10 millones de veces la masa del Sol. Esta masa podría ser el “bloque de construcción” más pequeño conocido de la sustancia misteriosa e invisible denominada materia oscura. Las estrellas que se forman dentro de estos bloques se agrupan y se convierten en galaxias.

¿Filametos de materia oscura? ¿Dónde?

Los científicos saben muy poco sobre las propiedades microscópicas de la materia oscura aunque constituye aproximadamente las cinco sextas partes de toda la materia en el universo (bueno, al menos eso es lo que se cree antes de haberlo demostrado).

Abr

24

Física = A conocer la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

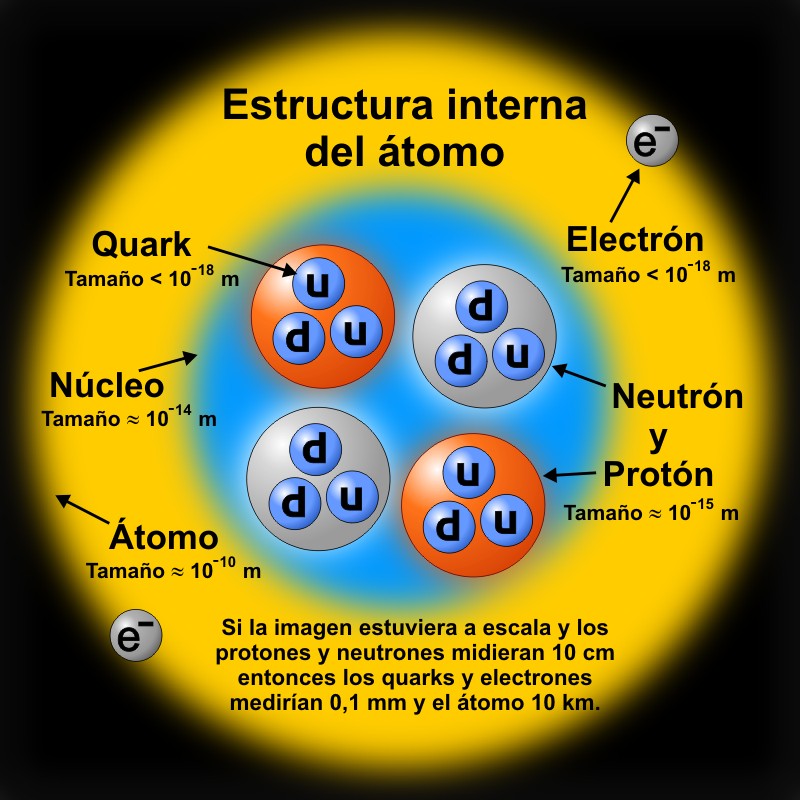

Hasta el descubrimiento del electrón por J. J. Thomson en 1.897, se pensaba que los átomos eran los constituyentes fundamentales de la materia, como había postulado 400 años a. de C. Demócrito de Abdera. Pero el hallazgo de Thomson, junto al de Rutherford del núcleo atómico y del protón en 1.911, hizo evidente que los átomos no eran elementales, en el sentido de que tienen estructura interna.

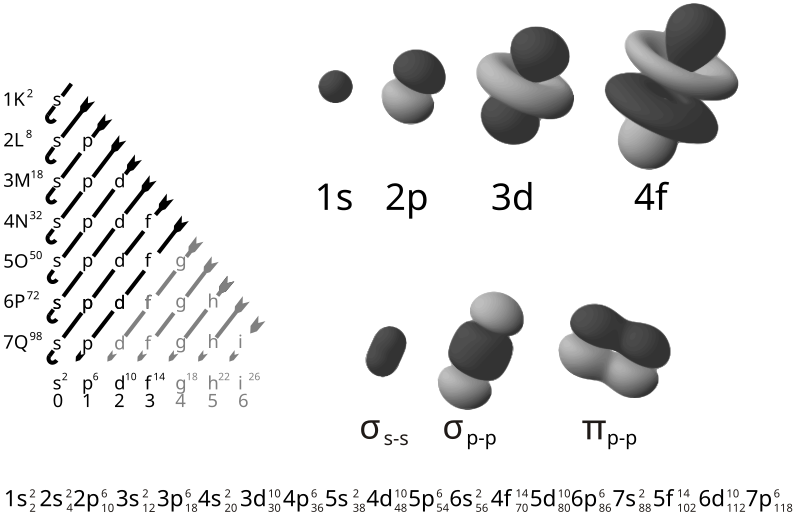

Orbitales atómicos y moleculares. El esquema de la izquierda es la regla de Madelung para determinar la secuencia energética de orbitales. El resultado es la secuencia inferior de la imagen. Hay que tener en cuenta que los orbitales son función de tres variables, la distancia al núcleo, r y dos ángulos. Las imágenes sólo representan la componente angular del orbital.

La mecánica cuántica establece que un electrón no existe como un único punto, sino que se extiende alrededor del núcleo en una nube se conoce como un orbita … Las esferas azuladas de la imagen que parecen inmersas en una nube muestran dos modelos orbitales de los electrones de un átomo de carbono … unas estructuras que ya habíamos visto en las ilustraciones de miles de libros de química …, pero ahora se trata de imágenes reales …

Estructura interna de una molécula de pentaceno, de 1,4 nanómetros de longitud. Abajo, modelo de la misma (los átomos grises son de carbono y los blancos de hidrógeno).- IBM

¡El Átomo! La parte más pequeña de un elemento.

Modelo planetario del átomo

Todo el mundo conoce la imagen del átomo formada por varios electrones dando vueltas a un núcleo como planetas orbitando alrededor del Sol. Esta figura la creó en 1904 un físico japonés llamado Hantaro Nagaoka y aunque constituye la percepción más común del átomo, está equivocada.

Según la mecánica cuántica, las partículas elementales tienen una apariencia un tanto borrosa. Los electrones se parecen más bien a aspas de un ventilador que gira. Es decir, el electrón no ocupa una órbita definida, sino una nube o zona del espacio donde existe la probabilidad de encontrarlos.

El descubrimiento de Chadwick del neutrón en 1.932 completó el modelo atómico basado en el núcleo atómico consistente en protones y neutrones rodeados de un número suficiente de electrones como para equilibrar la carga nuclear. Sin embargo, no explicaba la gran estabilidad del núcleo, que claramente no podía mantenerse unido por una interacción electromagnética, pues el neutrón no tiene carga eléctrica.En 1.935, Yukawa sugirió que la fuerza de intercambio que lo mantenía junto estaba mediada por partículas de vida corta, llamadas mesones, que saltaban de un protón a un neutrón y hacia atrás de nuevo. Este concepto dio lugar al descubrimiento de las interacciones fuertes y de las interacciones débiles, dando un total de cuatro interacciones fundamentales.

El núcleo atómico, la verdadera materia, es sólo el 99,99%del átomo, el resto son espacios vacíos.

También dio lugar al descubrimiento de unas 200 partículas “elementales” de vida corta, algunas de las cuales eran claramente más elementales que las otras. En la clasificación actual existen dos clases principales de partículas que interaccionan con la interacción fuerte y tienen una estructura interna compleja.

| Leptones: | Electrón, muón, tau y sus neutrinos, que interaccionan tanto con las interacciones electromagnéticas como con la interacción débil y que no tienen estructura interna aparente. | |

| Hadrones: | Bariones: | Protones, neutrones, lambda, signa, omega. |

| Mesones: | Piones, kaones, etc. | |

La estructura hadrónica está basada ahora en el concepto de quarks de Murray Gell-Mann, introducido en 1.964. Este modelo nos dice que los hadrones están divididos en bariones (que se desintegran en protones) y mesones, que se desintegran en leptones y fotones.

De las estructuras atómicas unidas pasamos a las estructuras moleculares.

Los bariones están formados por tres quarks y los mesones por dos quarks (un quark y un antiquark). En la teoría quark, por tanto, las únicas partículas elementales realmente, son los leptones y los quarks. Al contrario que los electrones y protones, que poseen cargas exactamente iguales en valor absoluto pero de signos opuestos (positiva el protón y negativa el electrón), los quark tienen cargas que son fracciones de la carga electrónica (+ 2/3 ó -1/3 de la carga electrónica).

Las colisiones electrón-positrón producen numerosos tipos de partículas que se desintegran según diferentes modos de cadena.

Los quarks aparecen en seis variedades distintas que generalmente se escriben mediante las letras u, d, c, s, t y b que responden a los nombres de up, down, charmed, strange, top y bottom.

El protón, siendo un barión, está constituido por tres quarks, uud (2/3 + 2/3 – 1/3 = 1) y el neutrón por udd (2/3 – 1/3 -1/3 = 0), para cada variedad de quark existen los equivalentes antiquarks, que tienen valores exactos al quark pero con signos opuestos en su carga eléctrica.

No todos los físicos están aún convencidos de la existencia de los Quarks. Sin embargo, en los experimentos realizados al más alto nivel en los modernos aceleradores, parece que las señales recibidas sobre su real existencia son inequívocas.

Para evitar conflictos con el principio de exclusión de Pauli, se han añadido conceptos de carga de color a las seis variedades de quarks, cuya explicación al resultar compleja obviamos por no ser fundamental en la meta que aquí perseguimos.

Las interacciones fuertes entre quarks se pueden entender por el intercambio de ocho partículas sin carga y sin masa en reposo, llamadas gluones (porque pegan a los quarks juntos). Aunque los gluones, como los fotones que realizan una función similar entre los leptones, no tienen carga eléctrica, sí que tienen una carga de color (también aquí nos paramos para no enredar demasiado y confundir al lector).

Podemos imaginar a los Quarks, confinados dentro de los protones y neutrones nadando en una sopa de Gluones. La fuerza nuclear fuerte es la más potente de todas las interacciones fundamentales y hace que, al contrario de las otras fuerzas, la distancia entre quarks la aumente. Es como un mueblle de acero que cuando más se estira más resistencia opone.

La teoría quark completamente elaborada esta ahora bien establecida por evidencias experimentales, pero como ni los quarks ni los gluones han sido identificados nunca en experimentos, la teoría no se puede decir que haya sido directamente verificada. Los quarks individuales pueden tener la curiosa propiedad de ser mucho más masivos que los hadrones que usualmente forman (debido a la enorme energía potencial que tendrían cuando se separan), y algunos teóricos creen que es, en consecuencia, imposible desde un punto de vista fundamental, que existan aislados. Sin embargo, algunos experimentales han anunciado resultados consistentes con la presencia de cargas fraccionarias, que tendrían los quarks no ligados y en estados libres.

Lo que resulta de la teoría conocida como cromodinámica cuántica es que en la propiedad de libertad asintótica obliga a que las interacciones entre los quarks se hagan más débiles a medida que la distancia entre ellos se hace menor y tienda a cero. De forma inversa, la atracción entre quarks es mayor a medida que la distancia entre ellos es mayor y la hipótesis del confinamiento de los quarks obliga a que estos no puedan escapar uno del otro; lo impiden los gluones, los bosones intermediarios de la fuerza nuclear fuerte que es la única fuerza que crece con la distancia, al contrario que las otras fuerzas que con el alejamiento se debilitan. Es posible que a muy altas temperaturas, como las existentes en el universo primitivo, los quarks pudieran estar libres. Esta temperatura a la que esto ocurre es conocida como temperatura de desconfinamiento.

A muy altas temperaturas, como al principio del Universo, podría ser posible “ver” a los Quarks en libertad, antes de que se unieran para formar protones y neutrones.

Es necesario que ahora se explique aquí lo que son las interacciones, o fuerzas fundamentales:

Como pueden haber deducido, me estoy refiriendo a cualquiera de los cuatro tipos diferentes de interacciones que pueden ocurrir entre los cuerpos.Estas interacciones pueden tener lugar incluso cuando los cuerpos no están en contacto físico y juntas pueden explicar todas las fuerzas que se observan en el universo.

Viene de lejos el deseo de muchos físicos que han tratado de unificar en una teoría o modelo a las cuatro fuerzas, que pudieran expresarse mediante un conjunto de ecuaciones. Einstein se pasó los últimos años de su vida intentándolo, pero igual que otros antes y después de él, aún no se ha conseguido dicha teoría unificadora de los cuatro interacciones fundamentales del universo. Se han hecho progresos en la unificación de interacciones electromagnéticas y débiles.

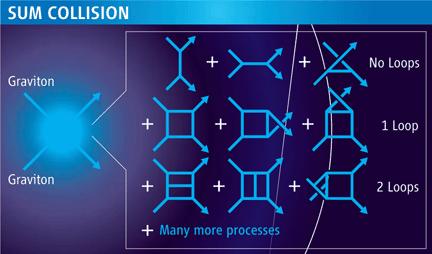

Antes, cuando hablamos de la relatividad general, ya se adelantó el concepto de la fuerza gravitatoria, unas 1040 veces más débil que la fuerza electromagnética. Es la más débil de todas las fuerzas y sólo actúa entre los cuerpos que tienen masa. Es siempre atractiva y pierde intensidad a medida que las distancias entre los cuerpos se agrandan. Como ya se ha dicho, su cuanto de gravitación, el gravitón, es también un concepto útil en algunos contextos. En la escala atómica, esta fuerza es despreciablemente débil, pero a escala cosmológica, donde las masas son enormes, es inmensamente importante para mantener a los componentes del universo juntos. De hecho, sin esta fuerza no existiría el Sistema Solar ni las galaxias, y seguramente, nosotros tampoco estaríamos aquí. Es la fuerza que tira de nuestros pies y los mantiene firmemente asentados a la superficie del planeta. Aunque la teoría clásica de la gravedad fue la que nos dejó Isaac Newton, la teoría macroscópica bien definida y sin fisuras de la gravitación universal es la relatividad general de Einstein, mucho más completa y profunda.

Experimental y teóricamente se busca esa teoría cuántica de la gravedad pero… Nadie la sabe encontrar y, dicen que sólo en la Teoría de Cuerdas está implícita esa teoría que acogería sin pronblemas de infinitos a la relaticidad de Eintein y la cuántioca de Planck.

Por el momento, no hay una teoría cuántica de la interacción gravitatoria satisfactoria. Es posible que la teoría de supercuerdas pueda dar una teoría cuántica de la gravitación consistente, además de unificar la gravedad con los demás interacciones fundamentales sin que surjan los dichosos e indeseados infinitos.

La interacción débil, que es unas 1010 veces menor que la interacción y electromagnética, ocurre entre leptones y en la desintegración de los hadrones. Es responsable de la desintegración beta de las partículas y núcleos. En el modelo actual, la interacción débil se entiende como una fuerza mediada por el intercambio de partículas virtuales, llamadas bosones vectoriales intermediarios, que para esta fuerza son las partículas W+, W– y Z0.Las interacciones débiles son descritas por la teoría electrodébil, que las unifica con las interacciones electromagnéticas.

La teoría electrodébil es una teoría gauge de éxito que fue propuesta en 1.967 por Steven Weinberg y Abdus Salam, conocida como modelo WS.También Sheldon Glashow, propuso otra similar.

Cuando descomponemos la materia hasta sus más profundos componentes, aparecen nuevas partículas que nos facilitan conocer mucho mejor, el mundo que nos rodea y los componentesdel Universo en su más infinitesimal representación.

La interacción electromagnética es la responsable de las fuerzas que controlan la estructura atómica, reacciones químicas y todos los fenómenos electromagnéticos. Puede explicar las fuerzas entre las partículas cargadas, pero al contrario que las interacciones gravitacionales, pueden ser tanto atractivas como repulsivas. Algunas partículas neutras se desintegran por interacciones electromagnéticas. La interacción se puede interpretar tanto como un modelo clásico de fuerzas (ley de Coulomb) como por el intercambio de unos fotones virtuales. Igual que en las interacciones gravitatorias, el hecho de que las interacciones electromagnéticas sean de largo alcance significa que tiene una teoría clásica bien definida dadas por las ecuaciones de Maxwell. La teoría cuántica de las interacciones electromagnéticas se describe con la electrodinámica cuántica, que es una forma sencilla de teoría gauge.

El electromagnetismo está presente en todas partes.

La interacción fuerte es unas 102 veces mayor que la interacción electromagnética y, como ya se dijo antes, aparece sólo entre los hadrones y es la responsable de las fuerzas entre nucleones que confiere a los núcleos de los átomos su gran estabilidad. Actúa a muy corta distancia dentro del núcleo (10-15 metros) y se puede interpretar como una interacción mediada por intercambio de mesones virtuales. Está descrita por una teoría gauge llamada cromodinámica cuántica.

El núcleo atómico es la parte central de un átomo tiene carga positiva, y concentra más del 99.99% de la masa total del átomo. Esta fuerza es la responsable de mantener unidos a los nucleones (protón y neutrón) que coexisten en el núcleo atómico venciendo a la repulsión electromagnética entre los protones que poseen carga eléctrica del mismo signo (positiva) y haciendo que los neutrones, que no tienen carga eléctrica, permanezcan unidos entre sí y también a los protones.

Me he referido a una teoría gauge que son teorías cuánticas de campo creadas para explicar las interacciones fundamentales. Una teoría gauge requiere un grupo de simetría para los campos y las potenciales (el grupo gauge). En el caso de la electrodinámica, el grupo es abeliano, mientras que las teorías gauge para las interacciones fuertes y débiles utilizan grupos no abelianos. Las teorías gauge no abelianas son conocidas como teorías de Yang-Mills. Esta diferencia explica por qué la electrodinámica cuántica es una teoría mucho más simple que la cromodinámica cuántica, que describe las interacciones fuertes, y la teoría electrodébil que unifica la fuerza débil con la electromagnética. En el caso de la gravedad cuántica, el grupo gauge es mucho más complicado que los anteriores necesarios para la fuerza fuerte y electrodébil.

En las teorías gauge, las interacciones entre partículas se pueden explicar por el intercambio de partículas (bosones vectoriales intermediarios o bosones gante), como los gluones, fotones y los W y Z.

El físico Enrico Fermi, refiriéndose al gran número de partículas existentes, dijo: “Si tuviera que saber el nombre de todas las partículas, me habría hecho botánico.“

emilio silvera

Abr

24

Cosas de Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

Uno de los lectores nos enlaza con la Revista online de ciencia, tecnología, historia, salud y medio ambiente que arriba reseño como título y en la que se ha publicado un interesante artículo que demuestra que, cada día, los físicos modernos profundizan más y más y en los secretos de la mecánica cuántica que, como podemos ver al leer el trabajo aquí expuesto, cada día van siendo desvelados más y más y, si la técnica continúa avanzando, la observación y el experimento avanzan como lo están haciendo y, vamos ganando en la capacidad de efectuar mediciones cada vez más precisas, es posible, sólo posible, que algún día en el futuro podamos saber algo más sobre ese minsterioso “universo” cuántico que rige las leyes de lo muy pequeño. Aquí os dejo el artículo que, de seguro, será interesante para muchos.

Ciencia

Tenemos que cambiar la desigualdad de Heisenberg

By Octavio Ortega ⋅ enero 25, 2012

Ahí estaban casi todos. ¡Qué personajes!

En general se acepta que con ocasión del Congreso Solvay de 1927 se estableció una interpretación coherente de las ecuaciones y los principios de la mecánica cuántica. Sin embargo, un cuidadoso estudio de las comunicaciones de este congreso muestra que hubo muchos desacuerdos y diferencias entre los físicos de la época sobre el contenido físico de la teoría cuántica.

Disponemos en este momento de la interpretación probabilística de la función de onda de un sistema físico, dada por Max Born, y las famosas desigualdades de Heisenberg. Pero en retrospectiva, ahora parece que incluso para el joven Werner Heisenberg, el significado de estas desigualdades no era bien entendido. En términos más generales, se puede incluso decir que la vaguedad que aún prevalecía en la mente de la época persiste en muchas presentaciones elementales de la física cuántica que se hacen a los estudiantes universitarios de primer año. Esto se traduce en general por generar contrasentidos de dificultad suplementaria al aprendizaje de la física cuántica.

Las desigualdades de Heisenberg son un buen ejemplo. A menudo el estudiante que comienza a estudiar Física, engañado por el nombre de “relaciones de incertidumbre” que a veces se utiliza para referirse a estas desigualdades, piensa que existe de hecho una posición y una velocidad de una partícula cuántica, pero las leyes de la física nos permiten conocer, con una precisión infinita, estas dos variables al mismo tiempo.

Pero no se trata de…

Estas desigualdades reflejan dos cosas.

Abr

21

¡Hacia el planeta rojo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (3)

Comments (3)

http://www.youtube.com/watch?v=XRCIzZHpFtY&feature=player_embedded

Spirit, MER-A (Mars Exploration Rover — A), is a robotic rover on Mars, active from 2004 to 2010. It was one of two rovers of NASA’s ongoing Mars Exploration Rover Mission. It landed successfully on Mars at 04:35 Ground UTC on January 4, 2004, three weeks before its twin, Opportunity (MER-B), landed on the other side of the planet. Its name was chosen through a NASA-sponsored student essay competition. The rover became stuck in late 2009, and its last communication with Earth was sent on March 22, 2010.

The rover completed its planned 90-sol mission. Aided by cleaning events that resulted in higher power from its solar panels, Spirit went on to function effectively over twenty times longer than NASA planners expected following mission completion. Spirit also logged 7.73 km (4.8 mi) of driving instead of the planned 600 m (0.4 mi), allowing more extensive geological analysis of Martian rocks and planetary surface features. Initial scientific results from the first phase of the mission (the 90-sol prime mission) were published in a special issue of the journal Science.

Que os agrade el viaje que la Curiosity hizo a Marte, el amigo Tom Wood facilitó en Ciencia Kanija el enlace y aquí os lo dejo.

Una demostración del ingenio de nuestra especie que, si nos dejan tiempo… ¿Qué no podremos hacer?

Buen fin de semana.

emilio silvera

Totales: 74.825.176

Totales: 74.825.176 Conectados: 59

Conectados: 59