Abr

12

¡Noticia! ¿Una nueva física por “debajo” del cero absoluto?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (2)

Comments (2)

Lo que es normal en invierno para muchas personas, hasta ahora ha sido imposible en la física: Una temperatura por debajo de cero. Para mucha gente, las temperaturas bajo cero en la escala Celsius (grados centígrados) sólo son sorprendentes en verano. En la escala absoluta de temperatura, llamada también escala Kelvin y usada por los físicos, no es posible descender por debajo de cero, al menos no en el sentido de que algo esté más frío que cero grados kelvin.

Según el significado físico de temperatura, la temperatura de un gas está determinada por el movimiento caótico de sus partículas. Cuanto más frío esté el gas, más lentamente se mueven sus partículas. A cero grados Kelvin (273 grados centígrados bajo cero), las partículas dejan de moverse y desaparece todo ese desorden. Por tanto, nada puede estar más frío que cero grados en la escala Kelvin.

Edificio principal de la Universidad de Múnich

Sin embargo, unos físicos en la Universidad Ludwig-Maximilian de Múnich, y el Instituto Max Planck de Óptica Cuántica en Garching, ambas instituciones en Alemania, han creado ahora en el laboratorio un gas atómico que llega a alcanzar valores negativos en la escala Kelvin, siguiendo las definiciones convencionales adoptadas. Estas temperaturas absolutas negativas tienen varias implicaciones aparentemente absurdas: Aunque los átomos en el gas se atraen entre sí y producen una presión negativa, el gas no se colapsa, una conducta también postulada en la cosmología para el efecto principal de la energía oscura.

Con la ayuda de temperaturas absolutas negativas, se podría, hipotéticamente hablando, crear motores térmicos capaces de proezas imposibles en el mundo físico conocido, como por ejemplo un motor de combustión con una eficiencia termodinámica superior al 100 por cien.

Para convertir al agua en vapor, hay que suministrar energía. A medida que el agua se calienta, las moléculas de agua incrementan su energía cinética y en promedio se mueven cada vez más rápido. Sin embargo, las moléculas individuales poseen energías cinéticas distintas, desde muy lentas hasta muy rápidas. Los estados de baja energía son más comunes que los de alta energía, es decir, sólo unas pocas partículas se mueven con mucha rapidez. En física, esta distribución se conoce como Distribución de Boltzmann. El equipo de físicos de Ulrich Schneider e Immanuel Bloch ha dado ahora con un gas en el que esta distribución está invertida: muchas partículas poseen energías altas, y sólo unas pocas tienen energías bajas. Esta inversión de la distribución de energía implica que las partículas han asumido, al menos en ese aspecto, una temperatura absoluta negativa.

![A una temperatura absoluta negativa, la distribución de energía de las partículas se invierte en comparación con lo que ocurre a una temperatura positiva. (Imagen: © LMU / MPG Munich) [Img #12313]](http://noticiasdelaciencia.com/upload/img/periodico/img_12313.jpg)

La Distribución de Boltzmann invertida es el sello distintivo de la temperatura absoluta negativa, y esto es lo que Schneider y Bloch han logrado. Sin embargo, el gas no está más frío que cero grados Kelvin, sino más caliente, otra aparente paradoja.

Como mejor se puede ilustrar el significado de una temperatura absoluta negativa es con esferas que ruedan en un paisaje en el que los valles representan una energía potencial baja, y las colinas una energía potencial alta. Cuanto más rápido se muevan las esferas, mayor es su energía cinética: Si se parte de temperaturas positivas y se aumenta la energía total de las esferas calentándolas, esas esferas se moverán cada vez más hacia regiones de alta energía. Si fuera posible calentar las esferas hasta una temperatura infinita, las probabilidades de que estuvieran en algún punto del paisaje serían la mismas para cualquier punto, independientemente de la energía potencial. Si en esa situación se pudiera añadir aún más energía y por tanto calentar aún más las esferas, éstas se reunirían preferentemente en estados de alta energía, y estarían aún más calientes que una temperatura infinita. La distribución de Boltzmann se invertiría, y la temperatura sería por tanto negativa. A primera vista, puede parecer extraño que una temperatura absoluta negativa sea más caliente que una positiva. Sin embargo, esto es simplemente una consecuencia de la definición histórica de Temperatura Absoluta; si estuviera definida de manera diferente, esta contradicción aparente no existiría.

La temperatura en el espacio exterior, según todas las mediciones de satélites de microondas, es de -270,43ºC (2,72 Kelvin) y los átomos y moléculas se mueven más despacio que cuando están en un medio más caliente.

Esta inversión de la población de estados de energía no es posible en el agua o en cualquier otro sistema natural, ya que el sistema tendría que absorber una cantidad infinita de energía, algo imposible. Sin embargo, si existiera un límite superior para la energía de las partículas, como sería el caso de la cima de la colina en el símil del paisaje de energías potenciales, la situación sería completamente diferente. El equipo de Bloch y Schneider parece que ha dado ahora con un sistema de gas atómico de ese tipo, caracterizado por un límite superior de energía. Este aparente logro es fruto de su trabajo en el laboratorio, siguiendo las propuestas teóricas de Allard Mosk y Achim Rosch.

Hipotéticamente, la existencia de materia a temperaturas absolutas negativas tiene toda una serie de implicaciones sorprendentes, de entre las que destaca la ya citada de un motor de combustión con una eficiencia superior al 100 por cien. Sin embargo, esto no significa que se viole la ley de conservación de la energía. Lo que ocurriría es que el motor no sólo podría absorber energía de un medio más caliente, sino también de uno más frío.

El logro de los físicos de Múnich también podría ser interesante para la cosmología, ya que la conducta termodinámica de la temperatura negativa presenta semejanzas con la llamada energía oscura. Los cosmólogos consideran que la energía oscura es la fuerza misteriosa que acelera la expansión del universo, cuando parece lógico que el cosmos debería contraerse por la atracción gravitatoria entre todas las acumulaciones de masa del cosmos.

Existe un fenómeno similar en la nube atómica creada en el laboratorio de Múnich: El experimento se basa en el hecho de que los átomos en el gas no se repelen entre sí como en un gas convencional, sino que sus interacciones son de atracción. Esto significa que los átomos ejercen una presión negativa en vez de una positiva. Como consecuencia, la nube de átomos “quiere” contraerse y debería colapsarse, tal como cabría esperar que pasara con el universo bajo el efecto de la gravedad. Pero debido a la temperatura negativa de la nube de átomos, esto no sucede.

Fuente: NCYT Amazings

Abr

12

Universo, Teorías, las Estrellas, y…¡tantas cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (3)

Comments (3)

Einstein tuvo pronto que modificar ligeramente sus ecuaciones de universo, pues estas no eran compatibles con la ley de la conservación de la energía. Esto constriñó a Einstein a modificar sus ecuaciones de Universo, que adquirieron su forma definitiva tras la publicación en 1915 del artículo Aplicación de la teoría de la relatividad general al campo gravitatorio:

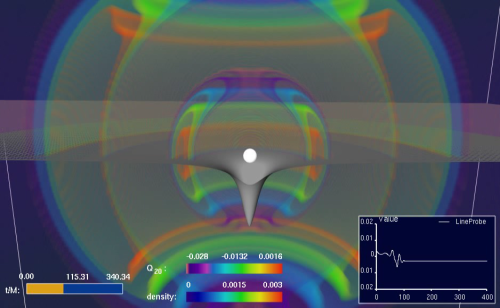

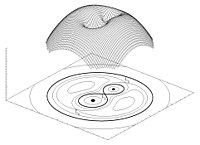

En la imagen se reproducen las ondas gravitatorias emitidas por una estrella durante su colapso. En las ecuaciones de Einstein se descubre el misterioso proceso que ocurre en las estrellas al final de sus vidas y de como se convierten en agujeros negros.

¿Qué sería de la cosmología actual sin la ecuación de Einstein de la Relatividad General? Es la ecuación de Einstein donde el tensor energía-momento mide el contenido de materia-energía, mientras que es el Tensor de curvatura de Riemann contraído el que nos dice la cantidad de curvatura presente en el hiperespacio. La cosmología estaría 100 años atrás sin esta ecuación.

Abr

12

¡Conocer el Universo! Ese antiguo deseo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (1)

Comments (1)

Hemos podido llegar a saber que la vida está estrechamente ligada a las estrellas y a “los mundos” y, aunque solo tengamos una muestra de ella que se ha dado en el planeta que llamamos Tierra… Todos los indicios apuntan a que muchos otros mundos también, como el nuestro, podrá albergar la vida ¡de tántas formas diferentes! Claro que, para empezar ni sabemos como pudo comenzar todo esto.

“En Cosmología, las condiciones “iniciales” raramente son absolutamente iniciales, pues nadie sabe como calcular el estado de la materia y el espacio-tiempo antes del Tiempo de Planck, que culminó alrededor de 10-43 de segundo Después del Comienzo del Tiempo.”

El tiempo de Planck es una unidad de tiempo considerada como el intervalo temporal más pequeño que puede ser medido. Se denota mediante el símbolo tP. En cosmología, el tiempo de Planck representa el instante de tiempo más antiguo en el que las leyes de la física pueden ser utilizadas para estudiar la naturaleza y evolución del Universo. Se determina como combinación de otras constantes físicas en la forma siguiente:

5.39124(27) × 10−43 segundos

5.39124(27) × 10−43 segundos

Llegados a este punto, me remito al párrafo segundo de este trabajo, en él se deja claro que, nada sabemos de ese instante primero anterior al Tp. Qué habría allí entonces, qué sustancias dieron lugar a la materia y, de dónde salieron las fuerzas fundamentales que hoy conocemos. Esas cuatro fuerzzas que definen nuestro universo (Electromagnetismo Fuerzas nucleares débil y fuerte y la Gravedad), dicen que al principio sólo fue una sóla fuerza. Entonces todo era simetría que se rompió para desgajarse esas cuatro fuerzas conocidas y, según dicen algunos, en otras que no pudieron desplegarse y quedaron compactadas en el límite de Planck.

El período entre 10-43 s -la era de Planck- y 300.000 años después del comienzo del tiempo. Durante este periodo, la expansión del universo estaba dominada por los efectos de la radiación o de las partículas rápidas (a altas energías todas las partículas se comportan como la radiación). De hecho, la era leptónica y la era hadrónica son ambas subdivisiones de la era de radiación.

Es verdaderamente encomiable la pertinaz insistencia del ser humano por saber, y, en el ámbito de la Astronomía, desde los más remotos “tiempos” que podamos recordar o de los que tenemos alguna razón, nuestra especie ha estado interesada en saber, el origen de los objetos celestes, los mecanismos que rigen sus movimientos y las fuerzas que están presentes para que todo eso ocurra tal como lo hemos podido comprobar.

La mayoría de los cosmólogos interpretan esta “singularidad” como una indicación de que la relatividad general de Einstein deja de ser válida en el universo muy primitivo (no existía materia), y el comienzo mismo debe ser estudiado utilizando una teoría de cosmología cuántica.

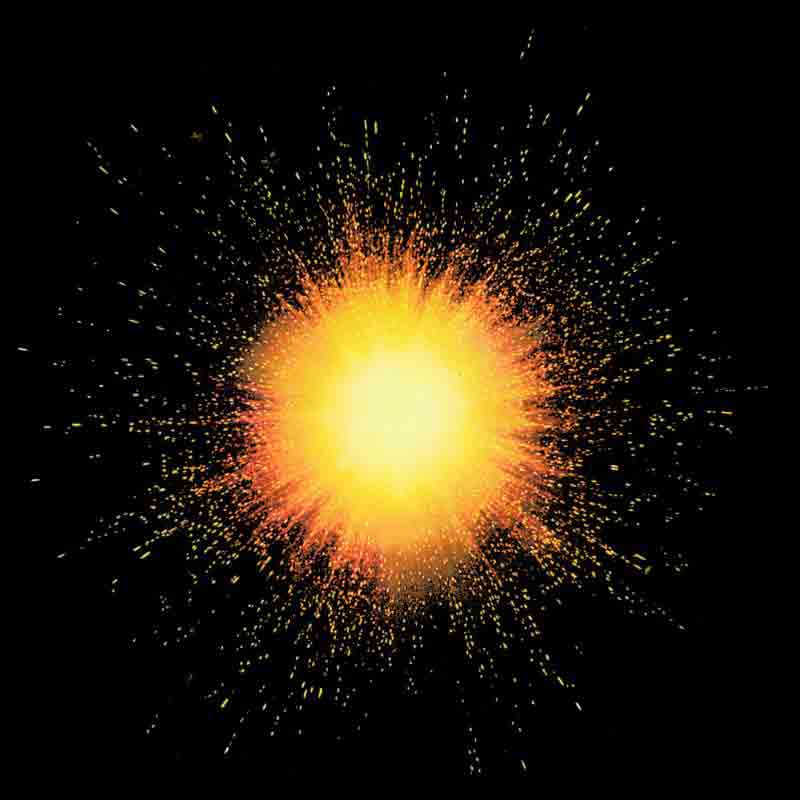

Es posible que bajo el Sol no encontremos nada nuevo; sin embargo, el estudio del cosmos ha sido y lo continúa siendo una apabullante caja de sorpresas. Hasta los años 20, los científicos preferían creer que el espacio era infinito y eterno. Se coincidía en la vaga noción de que éramos únicos en un universo hueco e insondable. Pero, como ya lo hemos mencionado en trabajos precedentes, la historia empieza a cambiar cuando el matemático ruso Alexander Friedmann en 1922, desafiando las afirmaciones de Albert Einstein de que el universo era estático, publicó un ensayo en el cual demostraba un error en los cálculos de Einstein y que las propias ecuaciones de éste permitían la descripción de un universo que evoluciona. En 1927 el sacerdote belga y físico teórico George Lemaître aprecia los estudios de Friedmann y galvanizó a los cosmólogos con su propuesta de que un «átomo primigenio», denso y muy caliente estalló en forma similar a la bola de fuego del Big Bang para crear el actual universo. En los años ’20, el astrónomo Edwin Hubble y otros colegas suyos con sus observaciones demostraron que el universo se estaba expandiendo; todas las galaxias se alejaban unas de otras, incrementando el espacio entre ellas y sus vecinas.

Aunque Lemaître, «el padre de la teoría del Big Bang», diese el primer paso, su versión moderna se debe a George Gamow y a sus alumnos Ralph Alpher y Robert Herman. En los años 40, calcularon la síntesis de los elementos químicos de la explosión primordial y, al hacerlo, trasladaron la idea del Big Bang del campo de las hipótesis al terreno de la ciencia de observación. Alpher y Herman estimaron que el espacio debería estar actualmente bañado por un mar de energía electromagnética que, en términos del cuerpo negro, estimaron que ésta debía bordear los 5° K por encima del cero absoluto, lo que informaron en una carta enviada a la revista científica Nature en 1948. La estimación sobre la existencia de la energía electromagnética quedó confirmada cuando, dieciocho años después, Penzias y Wilson lograron identificarla, calculando que esta comportaba una temperatura de 2,7°K.

La teoría del Big Bang es capaz de explicar la expansión del universo, la existencia de una radiación de fondo cósmica y la abundancia de núcleos ligeros como el helio, el helio-3, el deuterio y el litio-7, cuya formación se predice que ocurrió alrededor de un segundo después del Big Bang, cuando la temperatura reinante era de 1010 K.

La demostración hecha por Hubble, como la comprobación de la temperatura de la radiación de fondo que realizaron Penzias y Wilson, dieron cabida para que desde la década de los 50 surgiera una aceptación mayoritariamente generalizada de la hipótesis de que el universo había tenido su comienzo en la explosión de un átomo primigenio (Big Bang); que las enormes densidades y las altas temperaturas al principio del tiempo y del espacio pudieron haber borrado la distinción entre materia y energía (Big Squeeze), y que de ese guiso materia energía se habría generado la energía radiante. Luego, mientras el universo comenzaba a expandirse y a enfriarse, la primera materia en emerger lo habría hecho en forma de partículas elementales: protones, neutrones y electrones constituyendo lo que se ha llamado «ylem», un término tomado de Aristóteles, para esta materia primordial. Posteriormente, a medida que se enfriaba y se hacía menos denso el «ylem» y se reducía la radiación de alta energía, los neutrones existentes empezaron a combinarse con protones, formándose los núcleos atómicos. Los protones solitarios atraían a los electrones para crear átomos de hidrógeno, y los núcleos más pesados reunían también sus complementos más grandes de electrones. El Big Squeeze pudo haber sido el crisol de todos los elementos observados hoy en el universo. En esto hay que consignar que diferentes investigaciones de laboratorio han concluido que lo inmediatamente anterior descrito ocurrió dentro de los primeros minutos de la expansión cósmica donde se constituyó un proceso igual que la alquimia: En el ylem, una sustancia era transformada en otra.

Pero esta cuestión del ylem, también dio cabida a la idea de un universo pulsante. Pero junto con ganar la aceptación generalizada de los que hacen ciencia la hipótesis del Big Bang como descripción del origen del universo, también ha sabido gozar en los años, desde la presentación de sus enunciados, de serios grupos de científicos retractores, a los que en el pasado se les llamó «malditos» y que ahora son distinguidos como heterodoxos.

Es indudable que por mucho que nos adentremos en el Big Bang, hay siempre materia presente. ¿Cómo comprender, pues, el punto mismo del origen? ¿De dónde procede la materia del universo? ¿Hay fallas en las leyes de la física que nos impulsen a remplazarlas o a adoptar una actitud mística?

La primera hipótesis competidora a la del Big Bang apareció, casi paralelamente, con la publicación de los enunciados de ésta y sus puertas fueron abiertas, prácticamente, por algunas dificultades que el Big Bang presentaba para explicar hechos que eran observados.

La materia salió de ese clima de enormes temperaturas ahora inimaginables y, durante varias etapas o eras (de la radiación, de la materia, hadrónica y bariónica… llegamos al momento presente habiendo descubierto muchos de los secretos que, el Universo guardaba celosamente para que, nosotros, los pudiéramos desvelar con algunas dificultades.

Una de esas dificultades, y que de la cual los propios autores estaban conscientes, es la que tiene que ver con la síntesis de los elementos. Gamow y su ayudante Ralph Alpher en su exploración de la síntesis de los elementos se encontraron con un importante obstáculo a explicar por la hipótesis que habían presentado. Por mucho que lo intentaran, no podían explicar la creación de elementos más pesados que el helio-4, un isótopo muy estable que se niega a aceptar a dar partículas, y así generar átomos sin peso. De todas maneras, en el momento en que fue creado el helio-4 –a los pocos minutos del comienzo de la expansión–, el cocimiento cósmico de partículas tenía que haberse hecho tan tenue que las colisiones no debieron producirse tan frecuentes como para generar los elementos más pesados.

Otro problema que presentaba la hipótesis de Gamow y que aún sigue siendo un tema permeable en la actualidad, pese a que en el pasado ya fue soslayada, es la que tiene que ver con la edad del universo. Aparece este problema cuando la expansión observada del universo fue utilizada para estimar la cantidad de tiempo que había transcurrido desde el momento de su “nacimiento”. La edad a la cual se concluía era significativamente inferior a la que se había logrado establecer por los geólogos para la Tierra haciendo uso de los isótopos de plomo para datar las rocas.

Mucho es lo que hemos tenido que estudiar y obervar para ir conociendo el Universo que nos acoge y, desde luego, la materia que lo puebla y cómo se conforman los átomos de esas partículas que hemos sabido clasificar por familias y cuyos nombres han llegado a ser tan familiares que, decir protón, neutrón o electrón es algo cotidiano y hasta amigable.

A pesar de su ínfima dimensión, los nucleones se unen a los electrones para formar los átomos y, estos a su vez, son los que forman la materia que conforman las Galaxias del Universo y todos los demos objetos que podemos observar.

Miremos ahora al revés. La masa del universo está concentrada casi por entero en los nucleones que contiene. Los nucleones son partículas diminutas y hacen falta 6×1023 de ellas para formar una masa equivalente a un gramo.

Pues bien, si 6×2023 nucleones hacen 1 g, y si hay 2×1055 g en el universo, entonces el número total de nucleones en el universo podría ser de 6×1023×2×1055 ó 12×1078, que de manera más convencional se escribiría 1,2×1079.

Los astrónomos opinan que el 90 por 100 de los átomos de universo son hidrógeno, el 9 por 100 helio y el 1 por 100 elementos más complejos. Una muestra de 100 gramos, o mejor 100 átomos, consistiría entonces en 90 átomos de hidrógeno, 9 de helio y 1 de oxígeno (por ejemplo). Los núcleos de los átomos de hidrógeno contendrían 1 nucleón cada uno: 1 protón. Los núcleos de los átomos de helio contendrían 4 nucleones cada uno: 2 protones y 2 neutrones. El núcleo del átomo de oxígeno contendría 16 nucleones: 8 protones y 8 neutrones. Los 100 átomos juntos contendrían, por tanto, 145 nucleones: 116 protones y 26 neutrones.

Existe una diferencia entre estos dos tipos de nucleones. El neutrón no tiene carga eléctrica y no es preciso considerar ninguna partícula que lo acompañe. Pero el protón tiene una carga eléctrica positiva, y como el universo es, según creemos, eléctricamente neutro en su conjunto, tiene que existir un electrón (con carga eléctrica negativa) por cada protób, creando así el equilibrio existente.

La grandeza de nuestro Universo tiene su origen en las minúsculas partículas que conforman la materia, en las interacciones fundamentales que rigen las leyes y, en las constantes universales que indican cómo deben ser las cosas: la velocidad de la luz, la masa del electrón, la constante de estructura fina… De las demás partículas, las únicas que existen en cantidades importantes en el universo son los fotones, los neutrinos y posiblemente los gravitones, pero son partículas sin masa.

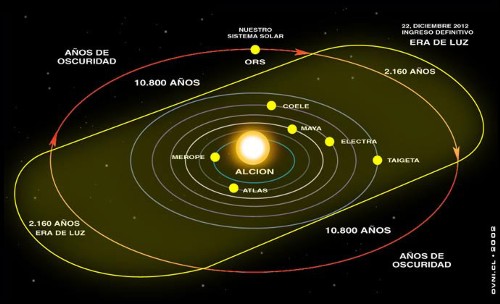

Una historia que circula por Internet desde hace muchos años cuenta que nuestro Sol forma parte de las Pléyades, que son un grupo de estrellas muy jóvenes que se encuentran a 450 años luz de la Tierra y que pertenecen a la constelación de Tauro. Este grupo de estrellas gira alrededor de Alcyon, la estrella más grande del grupo. El Sol tardaría 24.000 años en completar una órbita completa alrededor de Alcyon. Alrededor de esta estrella existiría un anillo de fotones que sería atravesado dos veces por el Sol en cada órbita, tardando cada vez 2000 años. Durante estos 2.000 años nuestro planeta estará continuamente bajo una iluminación omnidireccional permanente, que no producirá sombras. Los efectos de esta radiación fotónica serían entre otros el de la aparición de una nueva glaciación, disminución de la velocidad de rotación de la Tierra y cambio del eje de rotación.

Nadie sabe de dónde vino la sustancia del universo, no siempre la ciencia puede dar respuesta a todo, es la manera de regular los sistemas para obtener respuestas tras el duro trabajo del estudio, la investigación y el experimento. Hasta el momento nos falta información para contestar, no sólo esa pregunta, sino muchas otras que, como ¿qué es y de dónde sale la “materia oscura”? -si es que realmente existe-, ¿qué es realmente una singularidad? -si es que eso existe-, ¿dónde están los bosones de higgs? -si realmente están-, y, tantas otras preguntas sin respuestas…¡de momento!

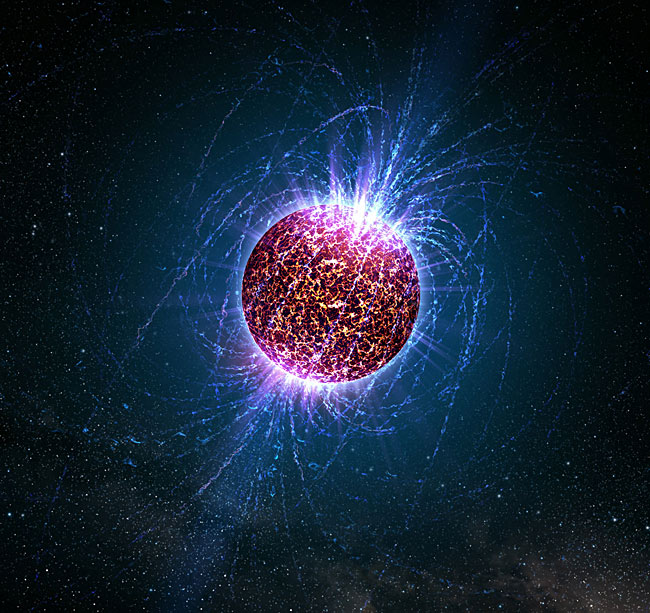

Claro que, nuestra imaginación no tiene límites y hasta hemos pensado en la posible existencia de la materia extraña. La Hipótesis de estrella de Quarks (EQs) podrían responder a muchos interrogantes surgidos a partir de observaciones astrofísicas que no coinciden con los modelos canónicos teóricos de las Estrellas de Neutrones ( ENs ). Decimos que son hipotéticas porque se conjetura que estarían formadas por Materia Extraña ( ME ). La comunidad astrofísica espera evidencias observacionales que permitan diferenciarlas de las ENs, ya que podrían explicar un conjunto de observaciones astronómicas que aún resultan una incógnita. Es sabido que una EN es el remanente del colapso de una estrella masiva. El colapso de la estrella, la supernova, da lugar a un núcleo compacto hiperdenso de hierro y otros metales pesados que sigue comprimiéndose y calentándose. Su densidad continúa aumentando, dando lugar a una “neutronización“ (recombinación de electrones con protones que resultan en neutrones) y el gas degenerado de neutrones frena el colapso del remanente.

Una EQ, a diferencia de una EN, no se originaría necesariamente de una evolución estelar después del agotamiento del combustible nuclear de una estrella normal. Sería, probablemente, producto de la transición de fase hadrón-quark a altísima densidad. La Cromodinámica Cuántica (CDC), la Teoría de las Interacciones Fuertes que ocurren dentro de los nucleones (protones y neutrones), concibe teóricamente la idea de la transición de fase hadrón-quark a temperaturas y/ o densidades extremadamente altas con el consecuente desconfinamiento de quarks y gluones, que formarían una especie de “sopa “. Sin embargo, los quarks libres no se han encontrado aún, en uno u otro límite, en ningún experimento terrestre.

La “sopa“ que mencionamos antes, se conoce como Plasma Quark-Gluón ( PQG ). En el límite de altas temperaturas, el PQG está tratando de obtenerse en el laboratorio y existen fuertes indicios de que se logre con éxito experimentos de altas energías como el Colisionador Relativista de Iones Pesados (conocido por sus siglas en ingles como RHIC) de Brookhaven, New York.

Por otro lado, se espera que a través de observaciones astronómicas se compruebe que la transición a altas densidades se hubiese producido en el interior de alguna EN. Esto se debe a que los valores de densidades estimados para que dicha transición tuviese lugar coinciden con densidades del orden de (3 exp. – 12) ρ0 (siendo ρ0 ̃ 0, 17 fmˉ ³ la densidad de equilibrio nuclear) que son típicas del interior de las ENs. Los cálculos basados en diferentes ecuaciones de estado de la materia nuclear muestran estos resultados, por lo que sería razonable que el núcleo de las ENs estuviese formado por materia de quarks.

Recientemente, la relación entre campo magnéticos y materia densa está atrayendo la atención de los astrofísicos, especialmente después de las observaciones de emisiones peculiares de pulsares anómalos de rayos X, que se interpretan como ENs en rotación, y de emisiones de radiación γ de baja energía de los llamados repetidores de rayos γ suaves ( SGRs – soƒt gamma-ray repeaters ). El motor central de esas radiaciones podría ser un campo magnético mayor que 4 x 10¹³ Gauss, que es el campo crítico previsto por la Electrodinámica Cuántica.

Muchas observaciones astronómicas indirectas sólo se explicarían a través de la existencia de campos magnéticos muy intensos en los núcleos de ENs en EQs, de manera que el papel que juega el campo magnético en la ME aún constituye un problema abierto y de sumo interés en la Astrofísica.

En particular, en un trabajo reciente, se ha analizado la ME considerando neutralidad de carga, equilibrio β y conservación del número bariónico. En dicho trabajo se obtuvo una cota superior para el valor del campo magnético que determina una transición de fase cuya explicación requiere ser estudiada en profundidad ya que sería independiente de la interacción fuerte entre los quarks. También se ha comprobado que la presencia de de campos magnéticos intensos favorece la estabilidad de la ME.

Por otro lado, estudios teóricos han demostrado que si la materia es suficientemente densa, la materia de quark deconfinada podría estar en un estado superconductor de color. Este estado estaría formado por pares de quarks, análogos a los pares de Cooper (constituidos por electrones) existentes en los superconductores ordinarios.

Los quarks, a diferencia de los electrones, poseen grados de libertad asociados con el color, el sabor y el espín. Por este motivo, dependiendo del rango de densidades en el cual estamos trabajando, algunos patrones de apareamiento pueden verse favorecidos generando la aparición de distintas fases superconductoras de color. Según estudios teóricos, la fase superconductora más favorecida a densidades extremadamente altas sería la Color Flavor Locked (CFL), en la cual los quarks u, d y s poseen igual momento de Fermi, y en el apareamiento participan los tres colores y las dos proyecciones de espín de cada uno de ellos. Estudios recientes sobre la fase CFL han incluido los efectos de campos magnéticos intensos, obteniendo que bajo determinadas condiciones el gas superconductor, que corresponde a la separación entre bandas de energía en el espectro fermiónico, crece con la intensidad del campo. A esta fase se la llama Magnetic Color Flavor Locked (MCFL).

Son muchos los misterios quen contiene el Universo y, nosotros, debemos recorrer los caminos para desvelarlos. Estamos siempre a la búsqueda de ¿cuerdas? ¿bosones que proporcionan la masa a las otras partículas? ¿energías de punto cero? ¿matería de quarks?

En la superconductividad electromagnética usual, un campo magnético suficientemente fuerte destruye el estado superconductor. Para la superconductividad de color no existe aún un consenso de cómo, la presencia del campo magnético, podría afectar al apareamiento entre los quarks.

En este trabajo describiremos brevemente la materia extraña, con el objetivo de explicar su formación en el interior de una EN y entender la composición y características de una EQ. Posteriormente, utilizaremos el modelo fenomenológico de bag del Massachussets Institute of Technology (MIT) para encontrar las ecuaciones de estado de la ME en condiciones determinadas, comprobando la estabilidad de la misma, frente a la materia de quarks ordinaria formada sólo por quarks u y d. Presentaremos, además, algunas candidatas posibles a EQs según observaciones astrofísicas. Por último, trataremos de entender la superconductividad de color y la influencia del campo magnético intenso en las fases superconductoras.

Uno de los mayores logros alcanzados por los físicos en el último siglo, fue la construcción del Modelo Estándar en la física de partículas elementales. Este modelo sostiene que la materia en el Universo está compuesta por fermiones, divididos en quarks y leptones, que interactúan a través de los llamados bosones de calibre: el fotón (interacción electromagnética), los bosones W± y Zº (interacción débil), y 8 tipos de gluones (interacción fuerte). Junto con los bosones de calibre, existen tres generaciones de fermiones: ( v e, e ), u, d ); ( vµ, µ ), ( c, s ) ; ( v….); y sus respectivas antipartículas. Cada “ sabor “ de los quark, up ( u ), down ( d ), charme ( c ), strange ( s , top ( t ) y bottom ( b), tiene tres colores ( el color y el sabor son números cuánticos ). La partícula que aún no ha sido descubierta experimentalmente es el boson de Higgs, que cabe suponer sería responsable del origen de la masa de las partículas.

En 1971 A.R. Bodmer propuso que la ME es más estable que el Fe, que es el más estable de todos los núcleos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el estado más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el estado más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios no se halla en contradicción con la mayor estabilidad que presenta la ME. Esto se debe a que la conversión de un núcleo atómico en ME, requiere que se transformen quarks u y d en quarks extraños s. La probabilidad de que esto ocurra involucra una transición débil que hace que los núcleos con peso atómico A ≥ 6 sean estables por más de 10 exp60. Años. De manera que si la hipótesis de la ME fuera correcta, estaríamos en presencia del estado más estable de la materia hadrónica y para su formación se necesitaría un ambiente rico en quarks s o la formación de un PQG, Como ya mencionamos, podríamos alcanzar dicho estado en las colisiones de iones pesados relativistas, segundos después del Big Bang en el Universo primordial y en el interior de las Ens.

¿Se podría dar la Formación de Materia Extraña en una Estrella de Neutrones?

Inmediatamente después de la transición de fase hadrónquark en el interior de la estrella, no existe una configuración de equilibrio químico entre los quarks. Esto puede entenderse de la siguiente forma: en el punto de transición, la materia bariónica predominante son los quarks u y d con una pequeña cantidad de electrones. Así, la densidad del quark d es aproximadamente dos veces la densidad del quark u, Nd ~ 2Nu, debido al hecho de que la materia en las estrellas compactas es eléctricamente neutra. Por el principio de exclusión de Pauli, sería energéticamente más favorable para los quarks d decaer en quarks s hasta restablecer el equilibrio entre sabores vía interacciones débiles. Dado que la densidad bariónica de la materia de quarks en el interior de la estrella sería ~ 5ρ0, los potenciales químicos de los quarks deberían ser grandes respecto de las masas. Esto implicaría que las densidades de los quarks fueran prácticamente iguales. De esta forma, la configuración más estable en el interior de la EN, sería un núcleo de ME con una densidad bariónica Nb = Ni ( i= u , d, s ). Si el interior de una EN estuviese compuesto por ME, cabe entonces preguntarnos: ¿podría transformarse una EN en una EQ?

EQs: Formación y características:

Para los astrónomos ha quedado bien establecido que el remanente estelar después de la explosión de una supernova podría resultar ser una Enana Blanca, una En o un Agujero Negro, dependiendo de la masa de la estrella de origen. Observaciones astronómicas recientes sugieren un remanente aún más exótico: las EQs. La idea de la existencia de estas estrellas apareció en 1969, cinco años después de la predicción de Gell- Mann de la existencia de los quarks. En el año 1984, Farhi y Jaffe, basándose en el modelo de bag del MIT, mostraron en sus cálculos que la energía por barión de la ME era menor que la del núcleo atómico más estable, el Fe. Esto daba mayor solidez a la hipótesis de Bodmer- Witten e inmediatamente se comenzaron a desarrollar modelos teóricos de Eqs. En el año 2002, el Observatorio de Rayos X Chandra, de la NASA, reportó el descubrimiento de dos estrellas candidatas a ser Eqs.

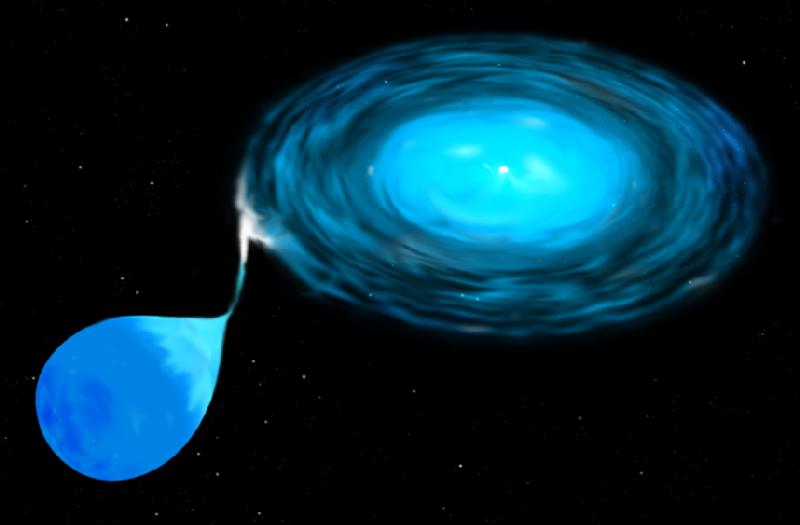

Para que una EN se transforme en una EQ pura, necesitamos algún mecanismo mediante el cual su densidad aumente cada vez más. Pensemos, por ejemplo, que la EN forma parte de un sistema binario. Para considerar que dos estrellas están en un sistema binario, debe analizarse su proximidad comparando el tamaño de las mismas con el radio del lóbulo de Roche, que es la región que define el campo de la acción gravitatoria de una estrella sobre otra.

Si el radio de cada estrella es menor que el lóbulo de Roche, las estrellas están desconectadas. Por el contrario, si una de ellas llena el lóbulo de Roche, el sistema es semiconectado y la materia puede fluir a través del punto de Lagrange interno. El potencial gravitatorio de un sistema binario se consume la masa de la estrella compañera. Cuando la masa de la EN alcanza el valor de ~2 M (M corresponde a la masa solar), sufre un colapso gravitatorio, pudiéndose transformar en una EQ.

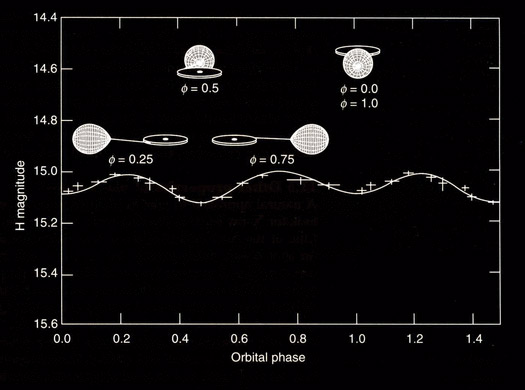

¿Podría el colapso de una supernova dar origen a la formación de una EQ? Esta pregunta nos conduce a otra hipótesis teórica acerca de la formación de la EN, hay conservación del momento angular. La proto-estrella de neutrones tiene una fracción pequeña de su radio original, que era el de la supernova, por lo que su momento de inercia se reduce bruscamente. Como resultado, la EN se forma con una altísima velocidad de rotación que disminuye gradualmente. Los períodos de rotación se hacen cada vez más largos debido a la pérdida de energía rotacional por la emisión de vientos de electrones y positrones y de la radiación bipolar electromagnética. Cuando la alta frecuencia de rotación o el campo electromagnético alcanzan un valor crítico, la EN se transforma en un pulsar que emite pulsos del orden de los milisegundos. Debido a la enorme fuerza centrífuga en estos objetos, la estructura interna se modifica, pudiendo alcanzar una densidad crítica por encima de la que corresponde a la transición de fase hadrón-quark. En estas condiciones, la fase de materia nuclear relativamente incomprensible se convertiría en la fase de ME, más comprensible, cuyo resultado final sería la aparición de una EQ.

La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos. Todas estas propiedades dependen de una única ecuación de estado para la materia densa de quarks que aún no ha sido completamente establecida. Sin embargo, existe un rango de valores aceptados para las cantidades antes mencionadas, con base en datos observacionales recientes, que marcarían importantes diferencias entre las posibles Eqs y los demás objetos compactos.

Un rasgo característico de las Eqs es que la materia no se mantendría unida por la atracción gravitacional, como ocurre en las Ens, sino que sería consecuencia directa de la interacción fuerte entre los quarks. En este caso, la estrella se dice autoligada. Esto implica una diferencia sustancial entre las ecuaciones de estado para las dos clases de estrellas. Las correcciones perturbativas a la ecuación de estado de la materia de quarks y los efectos de superconductividad de color complican aun más este punto. Otra característica para poder diferenciar las Eqs de las Ens es la relación entre su masa M y el radio R. Mientras que para una EQ, M ~ R³. De acuerdo con esta relación, las Eqs tendrían radios más pequeños que los que usualmente se le atribuyen a las Ens. Además, las Eqs violarían el llamado límite de Eddington. Arthur Eddington (1882-1994) observó que las fuerzas debido a la radiación y a la gravitación de las estrellas normales dependían del inverso del cuadrado de la distancia. Supuso, entonces, que ambas fuerzas podían estar relacionadas de algún modo, compensándose para que la estrella fuera más estable. Para estrellas de altísima masa, la presión de radiación es la dominante frente a la gravitatoria. Sin embargo, debería existir una presión de radiación máxima para la cual la fuerza expansiva debido a la radiación se equilibrara con la gravedad local. Para una estrella normal, el límite de Eddington está dado por una ecuación que omito para no hacer más complejo el tema.

Para cualquier valor de radiación que supere este límite, no habrá equilibrio hidrostático, causando la pérdida de masa de la estrella normal. El mecanismo de emisión en una EQ produciría luminosidades por encima de dicho límite. Una posible explicación a este hecho sería que la EQ es autoligada y por lo tanto su superficie alcanzaría temperaturas altísimas con la consecuente emisión térmica.

Por otro lado, una alternativa para explicar algunas observaciones de destellos de rayos γ, sería suponer que las emisiones provienen de Eqs con radios R ~ 6 km, valores demasiados pequeños si pensáramos que los destellos provienen de ENs.

En esta última parte, hemos presentado algunas características de las Eqs que las diferenciarían de las Ens. Futuras evidencias experimentales y observacionales nos permitirían saber si las Eqs realmente existen en la naturaleza.

¡El Universo! ¡Es tan grande y maravilloso! ¡Nos queda tanto por descubrir!

emilio silvera

Muchas han sido las fuentes consultadas entre las que cabría destacar la Revista de la RSEF.

Totales: 75.460.635

Totales: 75.460.635 Conectados: 38

Conectados: 38