Jul

18

Átomos, sustancias, elementos, química…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Química ~

Clasificado en Química ~

Comments (3)

Comments (3)

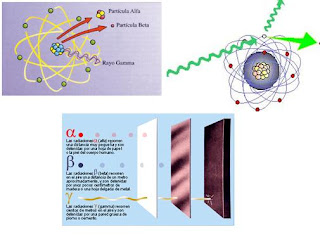

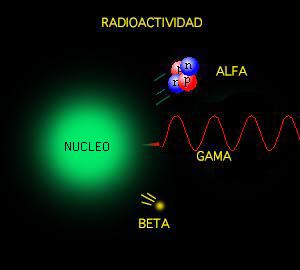

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Los electrones volantes constitutivos de esta última radiación son, individualmente, partículas beta. Así mismo, se descubrió que los rayos alfa estaban formados por partículas, que fueron llamadas partículas alfa. Como ya sabemos, alfa y beta son las primeras letras del alfabeto griego y se escriben con los gráficos α y β.

Entretanto, el químico francés Paul Ulrico Villard descubría una tercera forma de emisión radiactiva, a la que dio el nombre de rayos gamma, es decir, la tercera letra del alfabeto griego (γ). Pronto se identificó como una radiación análoga a los rayos X, aunque de menor longitud de onda.

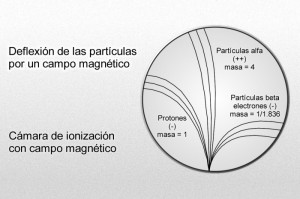

Mediante sus experimentos, Rutherford comprobó que un campo magnético desviaba las partículas alfa con mucho menos fuerza que las partículas beta. Por añadidura, las desviaba en dirección opuesta, lo cual significaba que la partícula alfa tenía una carga positiva, es decir, contraria a la negativa del electrón. La intensidad de tal desviación permitió calcular que la partícula alfa tenía como mínimo una masa dos veces mayor que la del hidrogenión, cuya carga positiva era la más pequeña conocida hasta entonces.

En 1.909, Rutherford pudo aislar las partículas alfa. Puso material radiactivo en un tubo de vidrio fino rodeado por vidrio grueso, e hizo el vacío entre ambas superficies. Las partículas alfa pudieron atravesar la pared fina, pero no la gruesa, lo que dio lugar a que las partículas quedaran aprisionadas entre ambas, y Rutherford recurrió entonces a la descarga eléctrica para excitar las partículas alfa, hasta llevarlas a la incandescencia. Entonces mostraron los rayos espectrales del helio.

Hay pruebas de que laspartículas alfa producidas por sustancias radiactivas en el suelo constituyen el origen del helio en los pozos de gas natural. Si la partícula alfa es helio, su masa debe ser cuatro veces mayor que la del hidrógeno. Ello significa que la carga positiva de éste último equivale a dos unidades, tomando como unidad la carga del hidrogenión.

Más tarde, Rutherford identificó otra partícula positiva en el átomo. A decir verdad, había sido detectada y reconocida ya muchos años antes. En 1.886, el físico alemán Eugen Goldstein, empleando un tubo catódico con un cátodo perforado, descubrió una nueva radiación que fluía por los orificios del cátodo en dirección opuesta a la de los rayos catódicos. La denominó rayos canales.

Part of Astronomy that study physical and chemical characteristics of heavenly bodies. Astrophysics is the most important part of Astronomy at the present time owing to advance of modern physics. Doppler- Fizeau´s effect, Zeeman´s effect, quantum theories and thermonuclear reactions applied to study of heavenly bodies have permitted to discover the solar magnetic field, study stellar radiations and their processes of nuclear fusion, and determine radial velocity of stars, etc. Electromagnetic radiation of heavenly bodies permits to make spectrum analysis of themselves, and they are the principal fountain of information in this part of Astronomy

En 1.902, esta radiación sirvió para detectar por vez primera el efecto Doppler-Fizeau respecto a las ondas luminosas de origen terrestre. El físico alemán de nombre Johannes Stara orientó un espectroscopio de tal forma que los rayos cayeron sobre éste, revelando la desviación hacia el violeta. Por estos trabajos se le otorgó el premio Nobel de Física en 1.919.

Puesto que los rayos canales se mueven en dirección opuesta a los rayos catódicos de carga negativa, Thomson propuso que se diera a esta radiación el nombre de rayos positivos. Entonces se comprobó que las partículas de rayos positivos podían atravesar fácilmente la materia. De aquí que fuesen considerados, por su volumen, mucho más pequeños que los iones corrientes o átomos. La desviación determinada, en su caso, por un campo magnético, puso de relieve que la más ínfima de estas partículas tenía carga y masa similares a los del hidrogenión, suponiendo que este ión contuviese la misma unidad posible de carga positiva.

Por consiguiente se dedujo que la partícula del rayo positivo era la partícula positiva elemental, o sea, el elemento contrapuesto al electrón; Rutherford lo llamó protón (del neutro griego proton, “lo primero”).

Desde luego, el protón y el electrón llevan cargas eléctricas iguales, aunque opuestas; ahora bien, la masa del protón, referida al electrón, es 1.836 veces mayor (como señalo en el gráfico anterior).

Parecía probable pues que el átomo estuviese compuesto por protones y electrones, cuyas cargas se equilibraran entre sí. También parecía claro que los protones se hallaban en el interior del átomo y no se desprendían, como ocurría fácilmente con los electrones. Pero entonces se planteó el gran interrogante: ¿cuál era la estructura de esas partículas en el átomo?

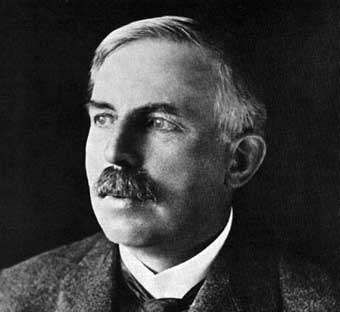

El núcleo atómico

El propio Rutherford empezó a vislumbrar la respuesta. Entre 1.906 y 1.908 (hace ahora un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos. En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina metálica.

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

Desde entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

Con tres electrones, el litio es el elemento sólido más ligero

Hay un tercer elemento, el litio, cuyo átomo tiene tres electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el número de electrones atómicos dentro de la formación iónica, pero en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El número de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. Como es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó esta idea general. Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por número enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal, y ello dio lugar a una interesante historia.

Isótopos; construcción de bloques uniforme,

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

Hacia principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

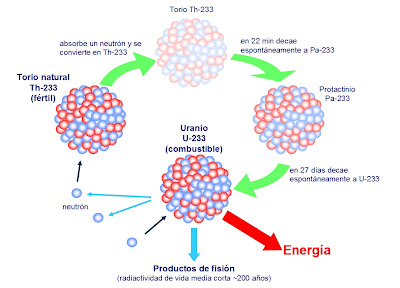

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que durante la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

El material radiactivo llega a producir mutaciones.

Varios químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

Hay que huir de los desechos radiactivos que causan la actividad del hombre

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907 los químicos americanos Herbert Newby McCoy y W. H. Ross descubrieron que el radiotorio (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el radio D, el mismo que el plomo, tanto que a veces era llamado radioplomo. De todo lo cual se infirió que tales sustancias eran en realidad variedades de mismo elemento: el radiotorio, una forma de torio; el radioplomo, un miembro de una familia de plomos; y así sucesivamente.

En 1.913, Soddy esclareció esta idea y le dio más amplitud. Demostró que cuando un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el radiotorio descendía en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas uranio X y uranio Y, es decir, que los tres serían variedades del elemento 90. Así mismo, el radio D, el radio B, el torio B y el actinio B compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el nombre de isótopos (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nobel de Química.

El modelo protón–electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula alfa de un núcleo, se reducía en dos unidades la carga positiva de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al número atómico, y por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de los elementos. ¡Maravilloso!

¿Cómo se explica que cuando el torio se descompone en radiotorio después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta, y más tarde una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque en cierto modo, esto no afecta al resultado).

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía el número atómico 90, es decir, el mismo de antes.

El torio en estado natural

Así pues, el radiotorio, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de un átomo están sujetas al número de sus electrones planetarios, el torio y el radiotorio tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228 respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o número másico. Así, el torio corriente se denomina torio 232, y el radiotorio, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones: plomo 210 (radio D), plomo 214 (radio B), plomo 212 (torio B) y plomo 211 (actinio B).

Se descubrió que la noción de isótopo podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206, la del torio en plomo 208 y la del actinio en plomo 207. cada uno de estos era un isótopo estable y corriente del plomo, pero los tres plomos diferían por su peso atómico.

Mediante un dispositivo inventado por cierto ayudante de J. J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo número de masa era 20, y otra con 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo cada diez. Más tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.

distintos isótopos

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas (el peso atómico) era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la proporción de cuatro a uno. En 1.922 se le otorgó el premio Nobel de Química.

En el discurso pronunciado al recibir el premio, Aston predijo la posibilidad de aprovechar la energía almacenada en el núcleo atómico, vislumbrando ya las futuras y nefastas bombas y centrales nucleares. Allá por 1.935, el físico canadiense Arthur Jeffrey Dempster empleó el instrumento de Aston para avanzar sensiblemente en esa dirección; demostró que 993 de cada 1.000 átomos de uranio eran de uranio 238 (no válido para combustible nuclear). Y muy pronto se haría evidente el profundo significado de tal descubrimiento.

Sí, sólo el 7 por 1000 del uranio existente en la Tierra, es combustible nuclear, es decir, Uranio 235. El resto, es Uranio 238 que hay que reciclarlo en un Acelerador Generador para convertirlo en Plutonio 239 que nos sirva como combustible nuclaer de fisión.

Así, después de estar siguiendo huellas falsas durantes un siglo, se reivindicó definitivamente la teoría de Prout. Los elementos estaban constituidos por bloques estructurales uniformes; si no átomos de hidrógeno, sí, por lo menos, unidades con masa de hidrógeno.

¿Qué no será capaz de inventar el hombre para descubrir los misterios de la naturaleza?

emilio silvera

Jul

17

¿La singularidad de la que surgió todo? ¿Será cierto eso?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

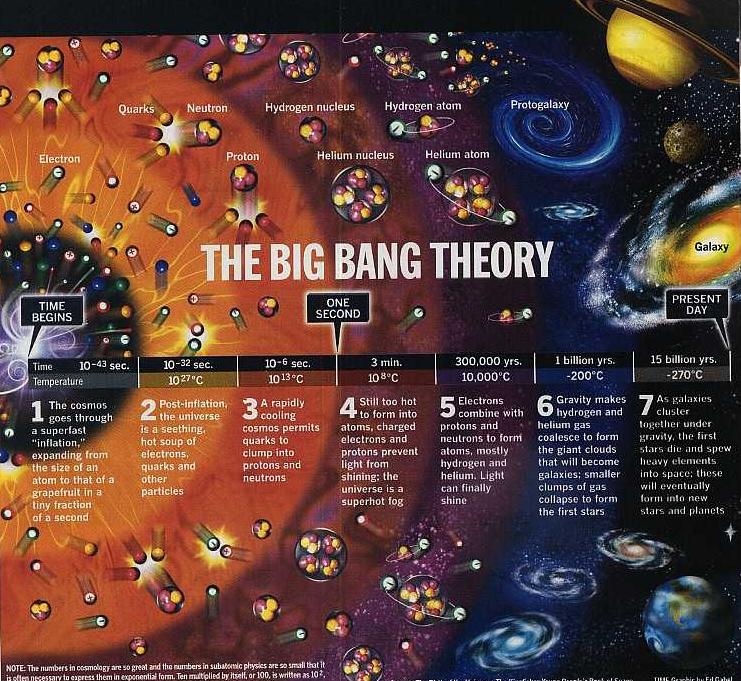

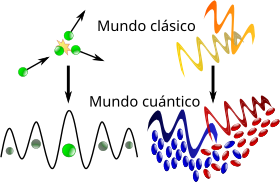

El Tiempo, el Universo, el Inicio de todo.

Se han llevado a cabo muchos modelos y las distintas teorías que circulan por ahí nos hablan de muchas cuestiones. Sin embargo, la relatividad general predice que tiene que haber una singularidad en el pasado, y cerca de esa singularidad la curvatura (del espacio) debe de ser muy alta; la relatividad clásica se anula, y habrá que tomar en cuenta los efectos cuánticos. A fin de comprender las condiciones iniciales del universo, debemos dirigirnos a la mecánica cuántica, y el estado cuántico del universo determinará las condiciones del universo clásico.

En realidad, lo que allí surgió fue una descripción de evolución cósmica de una extraña belleza. Todas las líneas del universo divergen de la singularidad de la génesis, como las líneas de longitud proceden del polo norte en el globo terráqueo.

Algunos dicen que la pregunta de cuándo empezó el tiempo o cuándo terminará no tiene ningún sentido: “Si es correcta la afirmación de que el espacio-tiempo es finito pero limitado -dijo Hawkins en una ocasión-, el Big Bang es más bien como el polo norte de la Tierra. Preguntar qué ocurre antes del Big Bang es como preguntas que ocurre en la superficie de la Tierra dos kilómetros al norte del Polo norte. Es una pregunta sin sentido.”

El tiempo imaginario, en opinión de Hawkins, era el tiempo de antaño y el tiempo futuro, y el tiempo que nosotros conocemos no es más que la sombra de la simetría rota del tiempo original. Cuando una calculadora contesta “error” si se le pregunta el valor de la raíz cuadrada de -1, nos está diciendo, a su modo, que ella pertenece a este universo, y no sabe como indagar en el universo como era antes del momento de la génesis. Y este es el estado de la ciencia, hasta que tengamos las herramientas para explorar el régimen muy diferente que prevalecía cuando empezó el tiempo.

Postrados ante el tiempo inexorable que pasa, nada podemos hacer por detenerlo, estamos supeditados a su transcurrir y, el que se nos ha concedido, debe ser aprovechado para SABER, esa simple pabra que nos liberará y nos separá del resto de las criaturas de la Tierra a las que, de4 alguna manera, deberíamos tratar de entender. ¿Sabemos acaso si piensa una Ballena?

Otro enfoque cuántico de la génesis, defendida por John Wheeler, subraya la cuantización del espacio mismo. Así como la materia y la energía están hechas de cuántos, afirma esta línea de razonamiento, también el espacio debe ser cuantizado en sus cimientos. A Wheeler le gustaba comparar el espacio cuántico con el mar: contemplado desde una órbita, la superficie del océano parece lisa, pero si salimos en un bote de remos a recorrer la superficie, “vemos la espuma y las olas que rompen. Y con esta espuma es como describimos la estructura del espacio y las escalas más pequeñas”.

Nunca podremos escapar de las voraces faces del Tiempo, y de la misma manera, tampoco podremos hacerlo de la Singularidad de un agujero negro si osamos traspasar el Horizonte de sucesos.

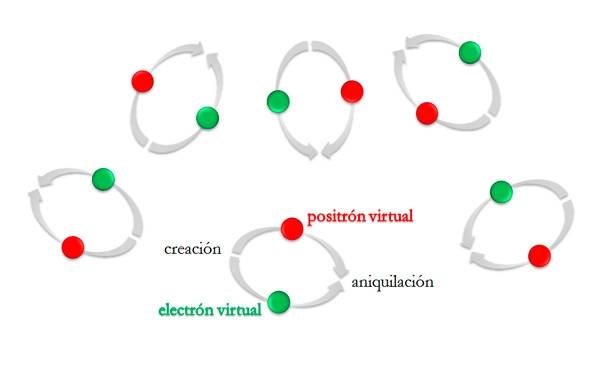

En el universo actual, la estructura espumosa del espacio se manifiesta en la constante aparición de partículas virtuales. En el universo muy primitivo -lo cual significa antes del Tiempo de Planck-, el espacio habría sido un mar encrespado, realmente, y su flujo cuántico zarandeado por las tempestades quizá dominó todas las interacciones. ¿Cómo nos orientaremos aquí?

Wheeler, un estadista mayor que aprendió ciencia de Einstein y Bohr, y a su vez educó a toda una generación de físicos, pensaba que la respuesta estaba en la geometría del espacio-tiempo. “¿Qué más hay allí con lo cual construir una partícula, excepto la geometría misma?” preguntaba. Wheeler comparó el flujo cuántico del universo primitivo con un complicado nudo marinero, de tal tipo que parece imposible de desenredar, pero que se logra si uno encuentra el cabo de la cuerda y le da un tirón del modo adecuado. En la analogía, el nudo es la geometría hiperdimensional del universo original, la cuerda enredada el universo que habitamos hoy.

J. Wheeler

Penrose había dicho: “No creo que pueda alcanzarse nunca una verdadera comprensión de la naturaleza de las partículas elementales sin una simultánea comprensión más profunda de la naturaleza del mismo espacio-tiempo.” Para Wheeler, esto era verdad con respeto al universo como un todo:

“El espacio es un continuo.” En décadas pasadas, esto se suponía desde el comienzo cuando se preguntaba: “¿Por qué el espacio tiene tres dimensiones? Hoy, en cambio, preguntamos: “¿Cómo logra el mundo dar la impresión de que tiene tres dimensiones?” ¿Cómo puede haber algo semejante en un continuo espaciotemporal excepto en los libros? ?De qué modo podemos considerar el espacio y la “dimensionalidad”, si no es como palabras próximas para designar un soporte, un sustrato, una “pregeometría”, que no tiene ninguna propiedad tal como la dimensión.

La geometría del espaciotiempo está determinada por la materia

Así lo demostró Riemann y otros

Para responder a tales preguntas, argüía Wheeler, la ciencia tendría que elevarse por encima de sí misma en un nuevo ámbito, “un mundo de leyes sin leyes”, en el que, como enseña el principio cuántico de indeterminación, la respuesta depende de la pregunta formulada. Wheeler recordaba haber participado en un juego de veinte preguntas. Dejaba pasar un período en el que la respuesta era acordada por los otros jugadores, luego volvía y empezaba a hacer preguntas. Las respuestas llegaban cada vez más lentamente, hasta que Wheeler finalmente conjeturó “Nube” y se le dijo, con regocijo general, que tenía razón. Cuando sus amigos dejaron de reírse, le explicaron que le habían jugado una treta: en un principio, no había habido ninguna respuesta correcta; sus amigos habían convenido formular sus respuestas de modo que cada una fuera compatible con las respuestas dadas a sus preguntas anteriores. ¿”Cual es el simbolismo de la historia”?, pregunto Wheeler.

El mundo, creíamos antaño, existe “allí fuera”, independiente de todo acto de observación. Pensábamos que el electrón, dentro del átomo, tenía en cada momento una posición definida y un momento definido. Yo, al entrar en la habitación, pensé que había una palabra definida. En realidad. En realidad la palabra fue elaborada paso a paso mediante las preguntas que yo hacía, lo mismo que la información sobre el electrón es producida por el experimento que el observador opta por hacer; esto es, por el tipo de equipo de registro que instala. Si yo hubiera hecho preguntas diferentes habría terminado con una palabra diferente, como el experimentador habría terminado con una historia diferente de las acciones del electrón…En el juego ninguna palabra es una palabra hasta que recibe realidad por la selección de preguntas planteadas y respuestas recibidas.

Algún día tendremos en nuestras manos los secretos de la física cuántica que es, tanto como decir, que conocemos por fín la materia y sus interacciones, es decir, las fuerzas que intervienen para que sean posibles todos los cambios de fase que producen elevaciones el nivel de complejidad hasta llegar a la fase química-biológica que conduce, de manera irremediable, a la vida.

En el mundo real de la física cuántica, ningún fenómeno es un fenómeno hasta que es un fenómeno registrado.

Nos queda, pues, una imagen de la génesis como un castillo silencioso e insustancial, donde nuestros ojos que arrojan ondas homéricas innovadoras y las únicas voces son las nuestras. Después de anunciarlo y de hacer nuestros deberes científicos de manera reverente y diligente, planteamos lo mejor que podemos la pregunta de cómo se formó la creación. Llega la respuesta, resonando a través de cámaras abovedas donde se encuentran la mente y el Cosmos. Es un Eco, que aún, no hemos sabido descifrar.

Lástima que el gráfico de arriba no esté centrado para poder ver las complejidades que nos podemos encontrar en cualquiera de las cosas que deseamos comprender, nada resulta fácil y, por supuesto, su dificultad nos lleva a unos beneficios directamente proporcionales a las mismas, de ahí, la importancia de saber.

A base de estas pequeñas parcelas del pensamiento podemos ir avanzando por el camino de la Ciencia que nos lleva hacia lugares donde encontramos las respuestas deseadas y, desde luego, necesarias para poder continuar preguntando. El conocimiento siempre es parcial, los triunfos limitados. Dado que la Naturaleza es “infinita” y tiene por ello, infinidad de cuestiones que debemos resolver, la única manera que tenemos de hacerlo es ir cumpliendo etapas a medida que nuestras mentes evolucionan al compás de los nuevos descubrimientos que nos abren la perspectiva de otros nuevos horizontes hacia los que dirigirnos para poder encontrar aquello que buscamos.

¿Quién le hubiera dicho a E. Rutherford que el átomo era, en realidad, un conjunto conformado en un 99% de espacio vacío y que, su núcleo era, en realidad, 1/100 000 veces más pequeño que el resto? Y, como aquello se descubrió por casualidad como otros tantos secretos del Universo, en los que buscando una cosa nos encontramos con otra muy diferente, los hechos nos marcan la pauta y dejan al descubierto que, posiblemente, sea la misma Naturaleza la que nos lleve y guie hacia el lugar que debemos observar. Es decir, colabora con nosotros en nuestra andadura a la conquista del saber, nos pone delante las cuestiones que no siempre sabemos comprender y, no siempre sabemos “ver”.

Sin embargo, nuestras mentes evolucionan y las conquistas parciales que se van consiguiendo, se unifican en más amplias teorías que posibilitan llegar a regiones desconocidas de la Naturaleza en el ámbito de la Materia, de la Biología, la Química y, por supuesto, de las estrellas y Galaxias que pueblan nuestro Universo que, por grande y extenso que pueda ser, es, al fin y al cabo nuestra casa. Tan grande y descomunal que tiene cientos de miles de compartimentos, habitaciones y trasteros que, estando llenos de auténticas maravillas, por nuestra juventud, aún no hemos podido buscar los medios para poder llegar hasta ellos y comprobar de qué se trata y que es lo que nos puede decir que nosotros no sepamos.

En cualquier región de nuestro Universo existen misterios, secretos que debemos desvelar. Las respuestas son llaves que nos permiten abrir puertas cerradas que nos llevarán más allá, a lugares fantásticos donde otras puertas cerradas nos esperan para que, tratemos de abrirlas y poder ver, las maravillas que allí permanecen escondidas.

La Historia, desde Babilonia y los Sumerios, ha seguido igual: Una Humanidad que busca incansable las respuestas y, para ello, mirando al cielo y a la tierra, ha tratado siempre de responder a los fenómenos observados y que, para ellos, no tenían explicación.

Muchas han sido las preguntas que encontraron la adecuada respuesta, y, muchas son las preguntas que están a la espera de que puedan ser contestadas. Investigaciones y experimentos de todo tipo y en los ámbitos más dispares, observaciones con sofisticados aparatos tecnológicos, investigación de la materia en sus más íntimas propiedades, hemos llegado a poder clasificar de manera automática los espectros estelares mediante el uso de técnicas de I.A. sobre Archivos Astronómicos, o, aplicar el efecto de microlente en Cuásares, aprendido a detectar muones en el experimento CMS del LHC, se ha podido aplicar la Mecánica Cuántica relativista a la óptica, hemos sabido fabricar robot que buscan objetivos en entornos inciertos, en lo que se conoce como estrategia de memotaxis mediante la implantación robótica, y, un sinfín de caminos más que estamos recorriendo ahora mismo en muchos campos y, no digamos de las investigaciones en Física de materiales o de fluidos o de hiperconductividad, o, por otra parte esos experimentos y estudios de bosones y fermiones tratando de cambias sus propiedades burlando el Principio de exclusión de Pauli de manera tal que, los fermiones se comporten como bosones y estos como fermiones (sería el futuro de los ordenadores cuánticos de millones de respuestas por segundo).

¿Nos suplirán un día? No puedo contestar a esa pregunta pero, me resisto a admitir que ellos, llegarán a tener sentimientos.

No siempre, la Ciencia, está asentada sobre bases firmes y creencias ciertas, ni los hombres que la forjaron resultan ser los titulares de los méritos que la Sociedad les arroga. ¿Es Edward Lorenz, en realidad, el Padre de la Teoría del Caos? Bueno, como esa pregunta podríamos plantearnos miles y, si nos ponemos a investigar, podremos encontrar que no todos los “descubridores” lo fueron al cien por ciento, sino que, tomaron de otros ideas que, finalmente, posibilitaron la conformación de teorías consistentes que nos llevaron hacia adelante en el largo camino del saber.

Resulta que, los conocimientos, también están cuantizados. Nadie los puede poseer todos.

¡Menos mal! es un gran alivio que así sea, ya que, el saber compartido parece más democrático y, además nos da la sensación de más seguridad. ?Os imaginais alguien con todos los conocimientos del mundo? Si es verdad que el Poder Corrompe, que efecto causaría poseer todos los conocimientos.

emilio silvera

Jul

17

Tenemos que saber, ¡sabremos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Biologia ~

Clasificado en Biologia ~

Comments (1)

Comments (1)

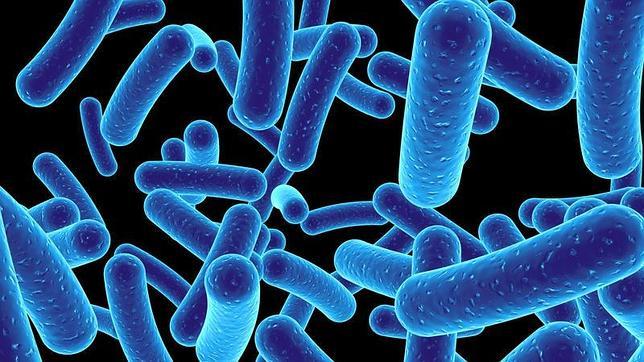

Descubren 200 microbios desconocidos que conviven con nosotros

Investigadores han desarrollado una nueva técnica genética que permite identificar microorganismos imposibles de cultivar en laboratorio

Los microbios están en todas partes, en cualquier lugar de mundo al que vayamos (incluso los más extremos), en cualquier objeto que tengamos en la mano e incluso en nuestro interior. A pesar de su presencia constante, su estudio es muy complicado, por lo que ha sido difícil establecer cuántos tipos de estos microorganismos existen, cómo viven y qué vínculos crean en el árbol de la vida. Sin embargo, una nueva técnica para analizar el ADN en células individuales ha permitido a científicos del Joint Genome Institute en Walnut Creek (California) conocer 200 nuevos microbios de nueve ambientes diferentes, desde respiraderos hidrotermales a minas subterráneas de oro o el interior de un reactor que se utiliza para degradar los subproductos de plástico. Ninguno de esos organismos había sido secuenciado antes ni cultivado en laboratorio, según informa la revista Nature.

«Es una investigación asombrosa», dice Norman Pace, microbiólogo del Joint Genome Institute. La secuenciación de una sola célula permite a los científicos descifrar el genoma de esa célula mediante la amplificación de su ADN mil millones de veces, abriendo el camino para el estudio de la «materia oscura microbiana». Lotes de microorganismos que viven en un entorno común, pero que son difíciles o imposibles de cultivar en el laboratorio.

El equipo intentó explorar esta «materia oscura» mediante la selección de una gama muy diversa de microbios y la secuenciación de una porción de sus genomas (que puede variar desde menos del 10% a más del 90%, dependiendo de la célula). Las secuencias aclaran las relaciones de los microbios entre sí y con otras especies y revelan que algunos límites convencionales entre los reinos de la vida no son tan rígidos como se pensaba.

Qué comió y cómo sobrevivió

El repertorio de genes en cada célula indica lo que comió el microbio y la forma en que sobrevivió en su entorno. Muchos de los microbios utilizan hidrógeno como fuente de alimento y algunos azufre para conseguir energía.

«El trabajo es un hito», dice a la web de Science el ecólogo microbiano Jack Gilbert, de la Universidad de Chicago en Illinois, que no participó en el trabajo. El investigador desarrolla modelos computacionales que describen cómo las comunidades microbianas responden a diferentes condiciones. A su juicio, tener una mejor idea de la naturaleza de los diversos microbios y cómo se relacionan entre sí «es muy importante».

Mientras tanto, el equipo espera que otros investigadores utilicen la información del genoma para encontrar la manera de hacer crecer algunos de estos microbios en laboratorio y poder estudiarlos más a fondo. Los investigadores tienen un largo camino por recorrer: Se calcula que necesitan secuenciar 16.000 genomas para cubrir la mitad del árbol genealógico microbiano en profundidad. Lo que han hecho hasta la fecha, «solo es una gota de agua en un balde».

Jul

17

¿Cuerdas cósmicas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cosmología ~

Clasificado en Cosmología ~

Comments (4)

Comments (4)

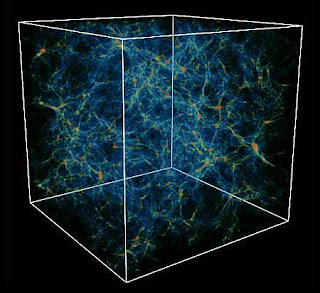

Aunque no todas si son muchas las GUT y teorías de supersimetría las que predicen la formación de cuerdas en la congelación del segundo 10-35 despues del comienzo del tiempo, cuando la fuerza fuerte se congeló y el universo se infló. Las cuerdas se deben considerar como un subproducto del proceso mismo de congelación. Es cierto que aunque las diversas teorías no predicen cuerdas idénticas, sí predicen cuerdas con las mismas propiedades generales. En primer lugar las cuerdas son extremadamente masivas y también extremadamente delgadas; la anchura de una cuerda es mucho menor que la anchura de un protón1. Las cuerdas no llevan carga eléctrica, así que no interaccionan con la radiación como las partículas ordinarias. Aparecen en todas las formas; largas lineas ondulantes, lazos vibrantes, espirales tridimensionales, etc. Sí, con esas propiedades podrían un candidato perfecto para la “materia oscura”. Ejercen una atracción gravitatoria, pero no pueden ser rotas por la presión de la radiación en los inicios del Universo.

1. El espesor estimado de una cuerda es de 10-30 centímetros, comparados con los 10-13 de un protón. Además de ser la más larga, y posiblemente la más vieja estructura del universo conocido, una cuerda cósmica sería también la más delgada: su diámetro sería 100.000.000.000.000.000 veces más pequeño que el de un protón.. Y cada cuerda sería terriblemente inquieta, algo así como un látigo agitándose por el espacio casi a la velocidad de la luz. Las curvas vibrarían como enloquecidas bandas de goma, emitiendo una corriente continua de ondas gravitacionales: rizos en la misma tela del espacio-tiempo. ¿Qué pasaría si una cuerda cósmica tropezara con un planeta? Al ser tan delgada, podría traspasarlo sin tropezar con un solo núcleo atómico. Pero de todos modos, su intenso campo gravitatorio causaría el caos.

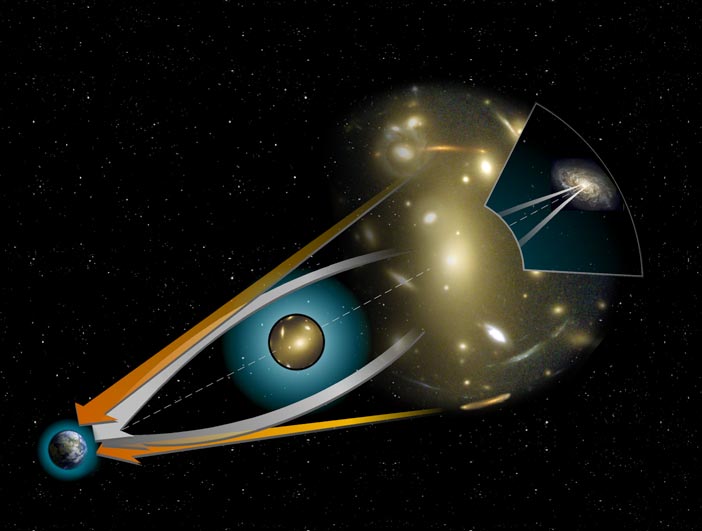

Simulación del efecto de lente generado por una cuerda cósmica. Crédito: PhysicsWorld.com

Por tanto, cuando observásemos un objeto con una cuerda cósmica en la trayectoria de nuestra mirada, deberíamos ver este objeto dos veces, con una separación entre ambas imágenes del orden del defecto de ángulo del cono generado por la curvatura del espaciotiempo. Esta doble imagen sería característica de la presencia de una cuerda cósmica, pues otros cuerpos, como estrellas o agujeros negros, curvan el espaciotiempo de manera distinta, generando al menos cuatro imágenes deformadas. Por tanto, una observación de este fenómeno no podría dar lugar a un falso positivo.

En este sentido, el nombre de cuerda cósmica está justificado debido a que son impresionantemente pesadas, pasando a ser objetos macroscópicos aun cuando su efecto es pequeño. Una cuerda de seis kilómetros de longitud cuya separación entre ambas geodésicas es de apenas 4 segundos de arco tendría ¡la masa de la Tierra!. Evidentemente, cuerdas de este calibre no se espera que existan en la naturaleza, por lo que los defectos de ángulo esperados son aún menores y, por tanto, muy difíciles de medir.

Y esta es una de las razones de que todavía no se haya encontrado ninguna cuerda de este tipo. Si bien en los últimos años han surgido muchas imágenes candidatas a estar formadas por un efecto de lente de este tipo, la mayoría han resultado ser dos cuerpos distintos pero muy similares entre sí. Pese a ello, los astrofísicos y los teóricos de cuerdas no puerden la esperanza de encontrar en los próximos años, y gracias a telescopios cada vez más potentes, como el GTC; evidencias directas de la existencia de este tipo de cuerdas; evidencias que no sólo nos indicarían que las teorías de cuerdas van por buen camino, si no que el modelo del Big Bang es un modelo acertado.

Esquema del trazado de rayos para el efecto de lente gravitatoria de una cuerda cósmica

Las cuerdas cósmicas, desde el momento de su formación en el segundo 10-35, constituyen un entorno masivo, apelmazado, contra el que se desarrolla la evolución de las partículas, núcleos y átomos. Como no son afectadas por la presión de la radiación,como el plasma, pueden servir como núcleos de condensación -las semillas- para la formación de galaxias, cúmulos galácticos y supercúmulos, siempre que puedan sobrevivir lo necesario para hacerlo.

Neil Turok, titular de la cátedra de Física Matemática en el Departamento de Matemáticas Aplicadas y Física Teórica de la Universidad de Cambridge. Es coautor, con Paul Steinhardt, de Universo Infinito: Más allá del Big Bang. El principal portavoz de la idea de las cuerda cósmica es Niel Turok, un joven físico teórico que trabaja en el Imperial College de Londres y pasa muicho tiempo en EE UU haciendo un periplo por diversas Universidades. Ha hecho del desciframiento de la conducta de las cuerdas cósmicas el trabajo de su vida (al menos por el momento) y, se aplica en las complejas ecuaciones de la teoría de campos cuánticos que describen dichas cuerdas. Su enfoque es admirable por su integridad:

En lugar de seguir el camino normal desarrollando la conducta de las cuerdas y dejando a otros hallar el efecto que las cuerdas tienen sobre el problema de las galaxias, Turok y los jovenes que le rodean han decidido aprender cosmología. Dicha decisión no es frecuenta y por inusual, ha llamado la atención que se quieran especializar de manera específica en otro campo distinto al suyo para poder hacer y comprender mejor su trabajo. Y, otra curiosidad es que, el más duro crítico de las cuerdas cósmicas, P.J.E. Peebles, de Princeton, haya estado actuando como su tutor, lo cual, es tan significativo que se podría alorar como uno de los gestos más desinteresados y de alta calidad que en la Física se pueda haber producido.

Una de las virtudes de esta teoría es que puede observarse por la observación. Aunque las cuerdas en sí son invisibles, sus efectos no tienen por qué serlo. La idea de las supercuerdas nació de la física de partículas, más que en el campo de la cosmología (a pesar del nombre, la cuerdas cósmicas no tienen nada que ver con la teoría de las “supercuerdas”, que mantiene que las partículas elementales tienen forma de cuerda). Surgió en la década de los sesenta cuando los físicos comenzaron a entrelazar las tres fuerzas no gravitacionales – electromagnetismo y fuerzas nucleares fuertes y débiles – en una teoría unificada.

En 1976, el concepto de las cuerdas se había hecho un poco más tangible, gracias a Tom Kibble. Kibble estudiaba las consecuencias cosmológicas de las grande teorías unificadas. Estaba particularmente interesado en las condiciones del 10^-35 segundo después del Big Bang, cuando las temperaturas en el cosmos embrionario bajaron más de billones de billones de grados. Ese fue el momento en que las fuerzas y las partículas se diferenciaron unas de otras.

El misterioso “universo” de los campos cuánticos

A los cosmólogos les gusta visualizar esta revolucionaria transición como una especie de “cristalización”: el espacio, en un principio saturado de energía, cambió a la forma más vacía y más fría que rodea actualmente nuestro planeta. Pero la cristalización fue, probablemente, imperfecta. En el cosmos recién nacido podría haberse estropeado con defectos y grietas, a medida que se enfriaba rápidamente y se hinchaba.

Otras cuerdas están en La Teoría M de E. Witten que nos explica muy bien las implicaciones de las cuerdas en el contexto del Universo, y, ademas, lleva implícita la Gravedad Cuántica que tantos físicos buscan desde hace mucho tiempo para explicar cuestiones que hasta el momento carecen de ella. Sin embargo, estas son otras cuerdas que, implicadas en las profundidades de la materia, nos podría explicar otras muchas cosas a diferente nivel de lo que la cuerda cósmica pretende explicar.

Turok nos dice:

“Durante los últimos diez años he estado trabajando principalmente en la cuestión de cómo empezó el universo – o no comenzar. ¿Qué sucedió en el Big Bang? Para mí, esto parece ser una de las cuestiones más fundamentales de la ciencia, porque todo lo que sabemos de salir de la Gran Explosión. Ya se trate de partículas o los planetas o las estrellas o, en última instancia, incluso la vida misma.

En los últimos años, la búsqueda de las leyes fundamentales de la naturaleza nos ha obligado a pensar en el Big Bang, mucho más profundamente. De acuerdo con nuestras mejores teorías – la teoría de cuerdas y la teoría M – todos los detalles de las leyes de la física son en realidad determinada por la estructura del universo, en concreto, por la disposición de pequeñas enrollada dimensiones extra del espacio. Este es un cuadro muy hermoso: la física de partículas en sí es ahora más que otro aspecto de la cosmología. Pero si se quiere entender por qué las dimensiones extra están dispuestos como están, hay que entender el Big Bang porque ahí es donde todo proviene.

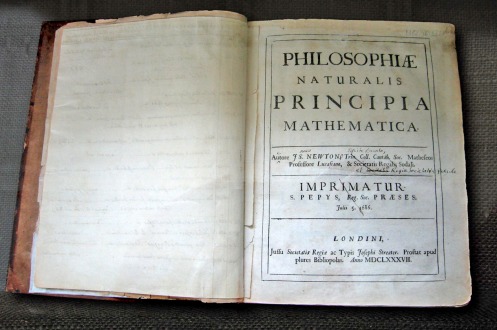

De alguna manera, hasta hace muy poco, la física fundamental se había llevado bien sin realmente hacer frente a ese problema. Ya en la década de 1920, Einstein, Friedmann y Lemaitre – los fundadores de la moderna cosmología – di cuenta que había una singularidad en el Big Bang. Que de alguna manera, cuando se traza el universo de nuevo, todo lo que salió mal unos 14 millones de años. Al salir mal, me refiero a todas las leyes de la física dejan: dan infinitos y resultados sin sentido. El mismo Einstein no interpretó esto como el principio de los tiempos, que acaba de decir, bueno, mi teoría falla. La mayoría de las teorías fallan en algún régimen, y entonces usted necesita una teoría mejor. La teoría de Isaac Newton falla cuando las partículas se muevan muy rápido, sino que no logra describir eso. Necesita relatividad. Del mismo modo, Einstein dijo, necesitamos una mejor teoría de la gravedad que la mía.

Pero en la década de 1960, cuando la evidencia observacional para el Big Bang se hizo muy fuerte, los físicos de alguna manera saltó a la conclusión de que debe haber sido el principio del tiempo. No estoy seguro de por qué lo hicieron, pero tal vez se debió a Fred Hoyle – el principal impulsor de la rival de estado estacionario teoría – que parece haber ridiculizado con éxito la teoría del Big Bang, diciendo que no tenía sentido porque implicaba un principio de los tiempos y que sonaba absurdo.

A continuación, el Big Bang fue confirmado por la observación. Y creo que todo el mundo acaba de comprar argumento de Hoyle y dijo, bueno, el Big Bang es cierto, el tiempo está bien, así que debe de haber comenzado. Así que nos metimos en esta forma de pensar: que de alguna manera el tiempo comenzó y que el proceso o evento, en el que se inició no es descriptible por la física. Eso es muy triste. Todo lo que vemos a nuestro alrededor se basa por completo en ese caso, y sin embargo ese es el caso de que no se puede describir. Eso es básicamente donde estaban las cosas en la cosmología, y la gente se preocupa más preguntas para los próximos 20 años.”

Para algunos, no parece que pueda caber la menor duda en el sentido de que, fueron las cuerdas cósmicas las que posibilitaron que se puedieran formar las grandes estructuras del universo surviendo de semilla o núcleo sobre el que se fueron adhiriendo inmensas porcianes de materia que conformarían el objeto final.

Es posible que las cuerdas cósmicas nos den una visión particularmente atractiva del universo y nos hace pensar en que, en el núcleo de cada galaxia hay una cuerda cósmica que, como el esqueleto de nuestros cuerpos, es la que la mantiene firme tal como la podemos contemplar y hace posible su existencia. Sin embargo, la teoría nos dice que las cuerdas cósmicas (como todo en el universo), tienen un tiempo de vida que una vez cumplido, desaparecen.

Está claro que la cuerda cósmica tal y como la presenta la teoría, es todo energía. Cuando comienza a despedir ondas gravitatorias, el proceso sigue hasta que la cuerda se ha radiado a si misma simplemente fuera de la existencia. Cuando su energía se agota, no queda nada. Por tanto sería posible utilizar las proporciones de pérdida de energía que predice la teoría de la relatividad general para calcular cuanto tiempo durará la energía almacenada en cualquier cuerda cósmica.

De hecho hubo un período de nervios cuando en cierto tiempo pareció que la cuerda cósmica tendrían una vida demasiado corta para poder realizar su trabajo de formar las galaxias, que romperían los anillos y se radiarian así misma fuera de la existencia antes que la materia y la radiación y la materia ordinaria se desparejaran. Sin embargo, los nuevos cálculos parecen mostrar ahora que los anillos capaces de formar las semillas de las galaxias durarían lo suficiente para llevar a cabo su función.

Claro que estas teorías de cuerdas, como tantas otras antes que ella, también han desarrollado una gran avalancha de excepticismo que es mostrado por algunos en esos momentos de la última cerveza en charlas distendidas entre compañeros físicos y cosmólogos que están unidos por esa curiocidad por saber si, en realidad, esas cuerdas han existido alguna vez. Y, esos excepticos, en verdad, no eran más duros en las críticas a las teorías de los demás que con las suyas propias.

Pero claro, nunca se debe decir que no. Hay maneras de comprobar las evidencias, al menos dos. Una, la llamada lente gravitatoria, se apoya en los efectos que las cuerdas cósmicas tendrían sobre la luz de las galaxias distantes. El otro método, algo más indirecto, implica la búsqueda de ondas gravitatorias despedidas por las cuerdas al comienzo de la vida del Universo.

La lente gravitacional es el Efecto en el que los rayos de luz son doblados por el campo gravitacional de un objeto masivo (en este caso serían las cuerdas cósmicas las responsables), también las galaxias y los agujeros negros producen el efecto de Lente gravitacional.

Las ondas gravitatorias están siendo buscadas por varios programas y proyectos construídos para tal fin, como LIGO y otros, y, hasta el momento, no parece que se haya tenido muchos resultados a pesar de que, la teoría nos dice que las cuerdas cósmicas emitían una gran cantidad de radiación gravitatoria en los primeros días del Universo. Sin embargo, sí se ha localizado la radiación cósmica del fondeo de microondas y las ondas gravitacionales no.

Está claro que la idea de la cuerda cósmica es sugestiva y nos podría explicar (por fín) como se pudieron formar las galaxias. La gran masa de la cuerda apunta a que debieron ser creadas muy pronro en la vida del Universo, probablemente mucho antes que la materia ordinaria cuando las temperaturas eran muy altas y había disponible mucha energía para formar objetos exóticos.

Si en verdad estuvieron allí, no lo podemos saber a ciencia cierta, y, se trabaja en la búsqueda de pruebas irrefutables que nos confirmen su presencia y su trabajo y contibución en la formación de las grandes estructuras del Universo.

Las grandes estructuras de nuestro Universo se pudieron haber formado a partir de unas semillas (cuerdas cósmicas) de gran densidad que atraían a la materia ordinaria para formarlas, y, de esa manera, pudieron haberse formado las galaxias y estrellas del cielo. De momento, ninguna explicación mejor que esa nos puede aclarar esa incognita que persiste desde siempre y que, en no pocas ocasiones, produce verguenza a los cosmólogos que, en realidad, no saben qué contestar a una simple pregunta:

¿Cómo se formaron las galaxias?

emilio silvera

Jul

17

Como Observadores del Universo… ¡Queremos saber!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (5)

Comments (5)

La Mars Phoenix

La historia de los ingenios espaciales que hemos enviado al espacio para suplir nuestras carencias, y poder saber de ahí fuera aunque sea de segunda mano, va adquiriendo ya un considerable volumen. Como otras tantas, la Mars Phoenix dejó de existir en la superficie de Marte, pero antes nos ha dejado una gran cantidad de datos y descubrimientos de los que, algunos, aún no han salido a la luz. Entre sus objetivos estaba buscar algún rastro de vida pasada o presente en el planeta hermano. La NASA y la ESA están trabajando ya en una nueva generación de proyectos que podrían usar esa tecnología de nuevo cuño. Sin embargo, lo más seguro es que, finalmente, dado el alto coste de estas misiones, se fusionen en un Proyecto verdaderamente global.

Mars Phoenix

Tal y como está la economía mundial los grandes proyectos espaciales tendrán que llevarse a cabo en conjunto. Sería una colaboración entre todos los expertos de renombre que hay en la Tierra para buscar la prueba de que no estamos solos en el Universo -Gaia en su conjunto buscando otras Gaias- El Proyecto de la Agencia Espacial Europea se conoce como el proyecto Darwin, pero también se denomina de una manera más prosaica, Interferómetro Espacial de Infrarrojos (IRSI = Infrared Space Interferometer); equivalente al de la NASA denominado Terrestrial Planet Zinder (TPF). Los dos proyectos funcionarán según los mismos principios.

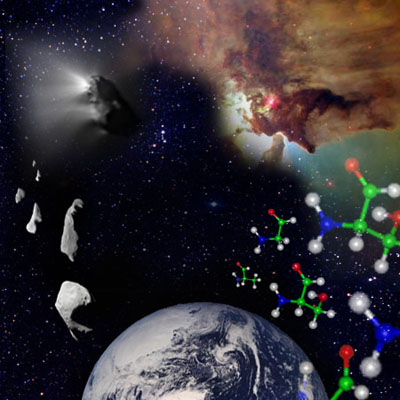

Más de cien moléculas diferentes han sido identificadas hasta hoy en las densas nubes de gas y polvo del medio interestelar y, algunas de ellas, son esenciales para la la formación de estructuras básicas para la vida. Entre otras muchas, han detectado la presencia de naftaleno en el medio interestelar en dirección a la estrella Cernis52, en la constelación de Perseo. Esta molécula está formada por dos anillos de átomos de carbono en forma hexagonal rodeados por átomos de hidrógen. También han sido detectadas moléculas de azúcares en algunas nebulosas gigantes conocidas como nubes moleculares.

De estas moléculas, ochenta y tres contienen carbono, entre las que se encuentran el ácido cianhídrico HCN, el amoníaco NH3 y el formaldehído H2CO. Moléculas precursoras que generalmente conducen a los aminoácidos. Para verificar que la síntesis de aminoácidos en las condiciones del medio interestelar es posible, una mezcla de hielo de agua, amoníaco, metanol, monóxido y dióxido de carbono ha sido irradiada en el Laboratorio de Astrofísica de Leyde en Holanda, en condiciones que imitan a las del medio interestelar (vacío impulsado de 10-7 mbar, y temperatura de -261°C).

Pero, ¿es fácil localizar planetas como la Tierra?

Por sorprendente que pueda parecer, especialmente después de ver las imágenes de la Tierra tomadas desde el espacio, en las cuales ésta aparece como una brillante bola azul y blanca sobre un fondo oscuro, la luz visible no ofrece las mejores perspectivas para detectar directamente otros planetas similares a la Tierra. Esto es así por dos razones:

En primer lugar, la luz visible que se recibe desde un planeta como la Tierra es en esencia el reflejo de la luz procedente de su estrella progenitora, por lo que no sólo es relativamente débil, sino que resulta muy difícil de captar a distancias astronómicas sobre el fondo iluminado por el resplandor de dicha estrella.

En segundo lugar, del tipo de la Tierra alcanzan en realidad su brillo máximo en la parte de rayos infrarrojos del espectro electromagnético, por el modo en que la energía absorbida procedente del Sol vuelve a irradiarse en la zona de infrarrojos de dicho espectro, con longitudes de onda más largas que las de la luz visible.

En una longitud de onda de unas pocas micras, la Tierra es el planeta más brillante del Sistema solar y destacaría como un objeto impactante si se utilaza cualquier telescopio de infrarrojos suficientemente sensible situado en nuestra proximidad estelar. El problema es que, dado que la radiación de infrarrojos es absorbida por los propios gases de la atmósfera terrestre, como el dióxido de carbono y el vapor de agua, que son lo que nos interesa descubrir, el telescopio que se utilice para buscar otros planetas como la Tierra tendrá que ser colocado en las profundidades del espacio, lejos de cualquier fuente potencial de contaminación. También tendrá que ser muy sensible, lo que significa muy grande. De ahí que estemos hablando de un proyecto internacional muy caro que tardará décadas en llevarse a buen puerto haciéndolo una realidad, y, mientras tanto, en la exploración espacial nos encontramos con extraños objetos y figuras como los de la imagen siguiente.

Anillos gigantes espaciales: Los anillos parecen de joyas pero son de agujeros negros

Esta imagen conjunta de Arp 147, una pareja de galaxias interactuando localizada a unos 430 millones de años luz de la Tierra mostrada en rayos X desde el observatorio Chandra de la NASA (en rosa), y los datos ópticos del Telescopio Espacial Hubble (rojo, verde, azul). Lo ha producido el Instituto de Ciencias del Telescopio Espacial en Baltimore. Arp 147 contiene remanente de una galaxia espiral (derecha) que chocó con la galaxia elíptica (izquierda).

La explosión produjo una enorme onda expansiva de formación estelar que se muestra como un gran anillo azul que contiene abundancia de estrellas masivas jóvenes que, en pocos millones de años, explotarán en supernovas dejando atrás estrellas de neutrones y agujeros negros que, con su enormes masas, tirarán del material de las estrellas compaleras ahí presentes.

Esta imagen compuesta de Arp 147, una pareja de galaxias interactuando localizada a unos 430 millones de años luz de la Tierra mostrada en rayosLa sola presencia de gases como el dióxido de carbono y el vapor de agua no es suficiente como un signo de vida, pero sí de la existencia de planetas del tipo de la Tierra en el sentido de que tendrían una atmósfera como Venus y Marte, mientras que, en particular, la presencia de agua indicaría la probabilidad de que existiera un lugar adecuado para la vida.

Hasta hoy, se han identificado nás de 500 planetas extrasolares gigantes. A principios de abril del 2007 se detectó por primera vez vapor de agua en la atmósfera de un exoplaneta (HD209458b). También en abril del 2007, el VLT (Telescopio Muy Grande) en Chile detectó un planeta con un tamaño 5 veces el de la Tierra próximo a la estrella enana Gliese 581, donde se garantiza una temperatura de entre 0 y 40º Centígrados, ¡lo que permite la presencia de agua!. ¡Sólo está a 20,5 años luz!.

Un pequeño número de exoplanetas han sido descubiertos con la ayuda del método de los tránsitos, que consiste en detectar la sombra de un planeta cuando en su órbita pasa por delante de su estrella y provoca un minieclipse. Medimos entonces la débil y pasajera ocultación de la estrella provocada por el paso del planeta.

La búsqueda de vida en los planetas extrasolares puede hacerse sólo por el análisis espectral de sus manifestaciones, singularidades en la atmósfera y/o un mensaje electromagnético “inteligente” de una civilización avanzada extraterrena. La atmósfera terrestre alberga un 21 % de oxígeno mientras que las atmósferas de otros planetas del sistema solar presentan sólo rastros. El oxígeno en la atmósfera terrestre es una singularidad por dos motivos: Es superabundante con relación a la corteza terrestre y debería normalmente desaparecer por recombinación con los minerales. Su presencia permanente está ligada a la existencia de vida intensa en la superficie de la tierra y no dejaría de llamar la atención a cualquier extraterrestre que observara la Tierra en busca de vida. La presencia de grandes cantidades de oxígeno atmosférico se revelaría por la raya característica del oxígeno a 760 nm con la ayuda de un espectrofotometro en espectro visible del planeta. Por razones prácticas, es más fácil buscar la firma del ozono O3, en el espectro infrarrojo a 9,6 μm. En la hipótesis, extremadamente seductora, de que el oxígeno atmosférico extraterreno sería puesto en evidencia, los escépticos no dejarían de hacer ver que el oxígeno puede ser producido por mecanismos químicos no biológicos. Sea lo que sea, la presencia simultánea de ozono (oxígeno, al fin y al cabo), de vapor de agua y de dióxido de carbono aparece hoy como una firma convincente de una vida planetaria que explota ampliamente la fotosíntesis. Dos proyectos actuales de estudio, se refieren a la búsqueda de exoplanetas de tipo terrestre. El proyecto americano TPF (Terrestrial Planet Finder, -buscador de planetas terrestres) y el proyecto europeo Darwin / IRSI (Infrared Space Interferometer,-Interferómetro espacial infrarrojo).

Este último consiste en colocar una flota de seis telescopios espaciales que serán acoplados en el espacio para analizar las atmósferas planetarias por interferometría y buscar desde allí las singularidades debidas una actividad biológica.

En realidad, cuando se estudian de forma detenida y pormenorizada los mecanismos del Universo, podemos ver la profunda sencillez sobre la que este se asienta. Los objetos más complejos del Universo conocido son los seres vivos, como, por ejemplo, nosotros mismos. Sin embargo, el origen de todo que comenzó en las estrellas, sigue su curso en las Nebulosas donde ya están presentes los materiales de la vida.

La Nebulosa Rosetta es difusa con un 1º de longitud situada en Monoceros, en torno a un cúmulo de estrellas de magnitud 5, NGC 2244. La Nebulosa se llama así porque se asemeja a un rosetón. Las partes más brillantes de la Nebulosa tienen sus propios números NGC: 2237, 2238, 2239 y 2246. El cúmulo de estrellas asociado, consistente en estrellas de magnitud 6 y más débiles, se extiende sobre aproximadamente un 1/2º. La Nebulosa y el cúmulo se encuentran a 5 500 a.l. Todas las Nebulosas pertenecen a una Galaxia en la que se hayan todos los sistemas complejos.

Estos sistemas complejos están hechos de las materias primas más comunes que existen en Galaxias como la Vía Láctea o cualquier otra. En forma de aminoácidos estas materias primas se ensamblan de manera natural, dando lugar a sistemas autoorganizadores donde unas causas subyacentes muy sencillas pueden producir complejidad en la superficie, como en el caso del tigre y sus manchas. Finalmente, con el fin de detectar la presencia de esta complejidad máxima de unos sistemas universales no necesitamos ninguna prueba sofisticada para distinguir la materia viva de la materia “inerte”, si no únicamente las técnicas más sencillas (aunque asistidas por tecnologías altamente avanzadas) para identificar la presencia de uno de los compuestos más simples del universo: El oxígeno.

Caos y Conplejidad que lleva a la simetría y el equilibrio

El caos y la complejidad se combinan para hacer del universo un lugar muy ordenado que es justo el entorno adecuado para formas vivas como nosotros mismos. Como dijo Stuart Kauffman, “en el universo estamos en nuestra propia casa”. Sin embargo, no es que el universo se haya diseñado así para beneficiarnos a nosotros. Por el contrario, lo que sucede es que estamos hechos a imagen y semejanza del universo.

Planteémonos una simple pregunta: Dadas las condiciones que imperaban en la Tierra hace cuatro mil millones de años, ¿qué probabilidades había de que surgiera la vida?

No basta con responder que “la vida era inevitable, puesto que nosotros estamos aquí “. Obviamente, la vida sí se inició: nuestra existencia lo demuestra. Pero ¿tenía que iniciarse? En otras palabras, ¿era inevitable que emergiera la vida a partir de un combinado químico y radiado por la energía interestelar y después de millones de años?

El Origen de la Vida.

En los trabajos que venimos dejando aquí nos va quedandoclaro que las dudas, son más abudantes que las certezas.

Nadie conoce una respuesta exacta a esta pregunta del origen de la vida, según todos los indicios y datos con los que hoy contamos, parece ser un accidente químico con una alta probabilidad de reproducirse en otros lugares del Universo que sean poseedores de las condiciones especiales o parecidas a las que están presentes en nuestro planeta.

Pero la vida, no consiste solo en ADN, genes y replicación. Es cierto que, en un sentido biológico estricto, la vida está simplemente ocupada en replicar genes. Pero el ADN es inútil por sí sólo. Debe construir una célula, con todas sus sustancias químicas especializadas, para llevar a cabo realmente el proceso de replicación. En las denominadas formas de vida superior debe construir un organismo completo para que tenga todos los requisitos exigidos para que pueda replicarse. Desde la perspectiva de un genoma, un organismo es una manera indirecta de copiar ADN.

Es probable que, como ocurre aquí en la Tierra, las formas de vida más abundantes en el espacio exterior, sean las Bacterias y demás dominios del mundo microscópico de la vida, y, más difícil será encontrar seres inteligentes como nosotros…sin descartar su existencia. Simplemente se trata de hacer unas sencillas cuentas. La vida en la Tierra está presente desde hace unos 4.000 millones de años pero, nosotros, sólo tenemos una antigüedad de unos escasos tres millones de años. La Evolución es lenta y se ha necesitado mucho tiempo para que podamos estar aquí, de la misma manera, ocurrirá en esos mundos perdidos por el espacio y, si están en sus fases primeras, la posible vida existente en ellos…será bacteriana.

El mar Precámbrico. El mar en el que posiblemente vivieron hace 3.500 millones de años las primeras bacterias era un lugar desértico en el que durante muchos millones de años sólo proliferaron arqueas y bacterias. Algunas de ellas dejaron rastros fósiles en forma de estromatolitos, unas formaciones en las que las bacterias provocaban la concreción de carbonatos y a la vez quedaban englobadas en ellos. Para comparar esta recreación de un mar de la época.

Un novedocódigo genético de una célula viva.

Sería muy laborioso y complejo explicar aquí de manera completa todos y cada uno de los pasos necesarios y códigos que deben estar presentes para formar cualquier clase de vida. Sin embargo, es necesario dejar constancia aquí de que los elementos necesarios para el surgir de la vida sólo se pueden fabricar en el núcleo de las estrellas (ya se mencionó antes) y en las explosiones de supernovas que pueblan el universo para formar nebulosas que son los semilleros de nuevas estrellas y planetas y también de la vida.

El surgir de la vida en nuestro Universo puede ser menos especial de lo que nosotros pensamos, y, en cualquier lugar o región del Cosmos pueden estar presentes formas de vida en condiciones que para nosotros podría ser como las del infierno.

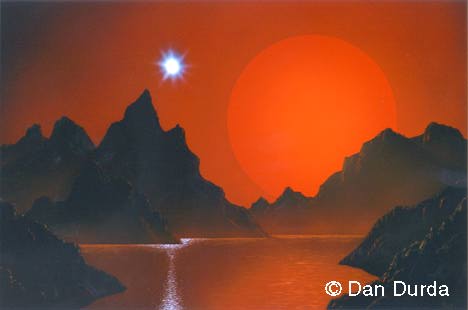

¿Cómo sería vivir en un planeta alumbrado por una Gigante Roja?

Hace varias décadas, los biólogos quedaron sorprendidos al descubrir bacterias que vivían confortablemente a temperaturas de setenta grados Celsius. Estos microbios peculiares se encontraban en pilas de abonos orgánicos, silos e inclusos en sistemas domésticos de agua caliente y fueron bautizados como termófilos.

Resultados de la búsqueda

El término termófilo se aplica a organismos vivos que pueden soportar temperaturas imposibles y vivir en lugares de aguas calientes y sulfurosas, en terrenos de alto índice de salinidad o de Ph no apto para seres vivos, así como en lugares y situaciones que, se podrían, sin lugar a ninguna duda, comparar con otros existentes en el espacio exterior, planetas y lunas sin atmósfera o de atmósfera reducida o demasiado densas.

Resultó que esto era sólo el principio. A finales de los años setenta la nave sumergible Alvin, perteneciente al Woods Hole Océano Graphic Institute, fue utilizada para explorar el fondo del mar a lo largo de la Grieta de las Galápagos en el océano Pacífico. Este accidente geológico, a unos dos kilómetros y medio bajo la superficie, tiene interés para los geólogos como un ejemplo primordial de las chimeneas volcánicas submarinas conocidas como “húmeros negros “. Cerca de un humero negro, el agua del mar puede alcanzar temperaturas tan altas como trescientos cincuenta grados Celsius, muy por encima del punto de ebullición normal. Esto es posible debido a la inmensa presión que hay en dicha profundidad.

Lugares como este permitieron la proliferación de pequeños seres vivos que, al calor de sus emisiones de gases tóxicos (de los que se alimentaban) salieron adelante y se expandieron de una manera bastante prolífica. Se cree que en lugares como este pudieron surgir algunos especímes que evolucionaron hacia otros niveles.

Una expedición dirigida por científicos del Centro Nacional de Oceanografía en Southampton (Reino Unido) ha descubierto las chimeneas volcánicas submarinas más profundas del mundo, conocidas como ‘fumarolas negras’, de unos 5,000 metros de profundidad en la depresión de Cayman, en el Caribe, revela un artículo publicado en Sciencie.com

Los investigadores utilizaron un vehículo controlado por control remoto de inmersión profunda y descubrieron delgadas espirales de minerales de cobre y hierro en el manto marino, erupciones de agua lo suficientemente calientes para derretir el plomo y unos 800 metros más profundas que las observadas con anterioridad.

Para asombro de los científicos implicados en el proyecto Alvin la región en torno a los húmeros negros de las Galápagos y otros lugares de las profundidades marinas resultó estar rebosante de vida. Entre los moradores más exóticos de las profundidades había cangrejos y gusanos tubulares gigantes. También había bacterias termófilas ya familiares en la periferia de los húmeros negros. Lo más notable de todo, sin embargo, eran algunos microbios hasta entonces desconocidos que vivían muy cerca de las aguas abrasadoras a temperaturas de hasta ciento diez grados Celsius. Ningún científico había imaginado nunca seriamente que una forma de vida pudiera soportar calor tan extremo.

Las lombrices tubulares gigantes, o como les llama la wikipedia gusanos de tubo gigantes son unas bonitas lombrices que viven en los fondos del Océano Pacífico y cuyo nombre científico es Riftia Pachyptila, suena bien.

Estos interesantes invertebrados suelen vivir a una profundidad de 5000 pies (1500 metros), lo cual es una barbaridad. Su tamaño puede llegar hasta cerca de 3 metros, por eso las llaman gigantes. Imaginen ir a pescar con una lombriz de este tamaño…

¿Que comen estos bichos?

Esta parte es la más interesante. Las lombrices tubulares gigantes viven en auténticos hornos submarinos. Se situan justo en chimeneas submarinas por las que salen a temperaturas altísimas, gases y minerales de muy alta toxicidad para la mayoría de las especies. Digamos que viven encima de pequeños volcanes.

La comida favorita de estas lombrices es el azufre, no necesita oxígeno para nada. Se basta, en concreto, con el sulfuro de hidrógeno que sale de las chimeneas termales. Sale hirviendo así que las lombrices tienen que sorber con cuidado. Usan esas plumas rojas para captar el sulfuro. Las plumas, tienen ese color debido a la hemoglobina, esa sustancia que tambien nosotros tenemos en la sangre y nos ayuda a transportar el oxígeno. A ellas les ayuda a transportar azufre, lo cual nos mataría a nosotros enseguida.

Igualmente se han encontrado formas de vida en lugares de gélidas temperaturas y en las profundidades de la tierra. Así mismo, la NASA ha estado en un pueblo de Huelva para estudiar aguas con un PH imposible para la vida y cargada de metales pesados que, sin embargo, estaba rebosante de vida. El proyecto de estos estudios se denomina P-TINTO, ya que, las aguas a las que nos referimos son precisamente las del Río Tinto, llenas de extremófilos.

Los extremófilos suelen ser procariotas como las bacterias, que son los seres con vida independiente más simples, pero también pueden ser eucariotas. De estos pequeños seres podríamos aprender muchísimas cosas que nos serían de gran valor para conocer, qué podríamos hacer en especiales circunstancias. La Naturaleza que tiene todas las respuestas nos la ofrece y, por nuestra parte, sólo podemos prestar atención.

Variedad increíble

Hay extremófilos para casi cualquier situación adversa del entorno: los acidófilosson aquellos que viven en entornos altamente ácidos, mientras que los alcalófilosson los que viven en lugares con un alto pH.

La anterior reseña viene a confirmarla enorme posibilidad de la existencia de vida en cualquier parte del universo que está regido por mecanismos iguales en cualquiera de sus regiones, por muchos años luz que nos separen de ellas. En comentarios anteriores dejamos claro que las Galaxias son lugares de autorregulación, y, podríamos considerarlos como organismos vivos que se regeneran así mismos de manera automática luchando contra la entropía del caos de donde vuelve a resurgir los materiales básicos para el nacimiento de nuevas estrellas y planetas donde surgirá alguna clase de vida.

La idea de que la vida puede tener una historia se remonta a poco más de dos siglos. Anteriormente, se consideraba que las especies habían sido creadas de una vez para siempre. La vida no tenía más historia que el Universo. Sólo nosotros, los seres humanos, teníamos una historia. Todo lo demás, el Sol y las estrellas, continentes y océanos, plantas y animales, formaban la infraestructura inmutable creada para servir como fondo y soporte de la aventura humana. Los fósiles fueron los primeros en sugerir que esta idea podía estar equivocada.

Durante cerca de tres mil millones de años, la vida habría sido visible sólo a través de sus efectos en el ambiente y, a veces , por la presencia de colonias, tales como los extremófilos que asociaban billones de individuos microscópicos en formaciones que podrían haber pasado por rocas si no fuera por su superficie pegajosa y por sus colores cambiantes.

Los hongos, como nosotros, son eucariotas

Toda la panoplia de plantas, hongos y animales que en la actualidad cubre el globo terrestre con su esplendor no existía. Sólo había organismos unicelulares, que empezaron con casi toda seguridad con bacterias. Esa palabra, “bacteria”, para la mayoría de nosotros evoca espectros de peste, enfermedades, difteria y tuberculosis, además de todos los azotes del pasado hasta que llegó Pasteur. Sin embargo, las bacterias patógenas son sólo una pequeña minoría, el resto, colabora con nosotros en llevar la vida hacia delante, y, de hecho, sin ellas, no podríamos vivir. Ellas, reciclan el mundo de las plantas y animales muertos y aseguran que se renueve el carbono, el nitrógeno y otros elementos bioquímicos.

Por todas estas razones, podemos esperar que, en mundos que creemos muertos y carentes de vida, ellas (las bacterias) estén allí. Están relacionadas con las primeras formas de vida, las bacterias han estado ahí desde hace cerca de 4.000 millones de años, y, durante gran parte de ese tiempo, no fueron acompañadas por ninguna otra forma de vida.

Pero, ¿No estamos hablando del Universo? ¡Claro que sí! Hablamos del Universo y, ahora, de la forma más evolucionada que en él existe: Los seres pensantes y conscientes de SER, nosotros los humanos que, de momento, somos los únicos seres inteligentes conocidos del Inmenso Universo. Sin embargo, pensar que estamos solos, sería un terrible y lamentable error que, seguramente, nos traería consecuencias de difícil solución.

Sí, esta cueva es terrestre pero, ¿por qué no habría una igual en Marte? Y, si es así (que es posible que lo sea), ¿Por qué no habría allí alguna clase de vida? Hay que pensar seriamente en la posibilidad de la vida extraterrestre que, incluso en nuestra propia Galaxia, podría ser muy abundante. Lo único que necesitamos es ¡Tiempo!

Tiempo para poder avanzar en el conocimiento que nos lleve, por ejemplo, a obtener energía del aire como ya se dice por ahí. Ya hemos contaminado bastante. Cuando eso llegue, estaremos preparados para dar el salto hacia las estrellas, y, allí, nos esperan sorpresas que ahora, ni podemos sospechar. Nos seguiremos sorprendiendo de los hallazgos que haremos por el Universo pero, cada vez, las sorpresas serán menos a medida que el conocimiento esté con nosotros y comprendamos los mecanismos que hacen posibles tantas maravillas.

En todo el Universo siempre es lo mismo, rigen las mismas leyes, las mismas fuerzas y constantes de las que tantas veces hemos cpomentado aquí. El Universo es inmenso, para nuestro propio contexto casi infinito. Sabemos del espacio y del tiempo y, sobre todo que la materia (al menos de la que estamos hechos nosotros y los mundos) siempre resulta estar hecha de la misma cosa, aunque conforme diferentes objetos inanimados o vivos…Todo es:

Quarks y Leptones

| Nucleones |

| Núcleos |

| Átomos |

| Moléculas |

| Sustancias |

| Cuerpos |

| Planetas (Vida) |

| Estrellas |

| Galaxias |

| Cúmulos de galaxias |

emilio silvera

Totales: 83.324.475

Totales: 83.324.475 Conectados: 76

Conectados: 76