Jul

5

Enigmas de la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Imagen: Phys Org

Imagen: Phys OrgEl problema de si las constantes físicas son constantes se las trae. Aparte del trabalenguas terminológico arrastra tras de sí unas profundas consecuencias conceptuales. Lo primero, uno de los pilares fundamentales de la relatividad especial es el postulado de que las leyes de la física son las mismas con independencia del observador. Esto fue una generalización de lo que ya se sabía cuando se comenzó a estudiar el campo electromagnético, pero todo lo que sabemos en la actualidad nos lleva a concluir que este postulado es bastante razonable.

En alguna ocasión se explicó aquí el desdoblamiento de las líneas espectrales del hidrógeno, lo que se ha dado en llamar alfa (α). León Lederman (premio Nobel de Física), nos dice que se denota por esa letra griega y que al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). Sigue diciéndonos: “No prestéis atención a la ecuación. Lo interesante es esto: cuando se meten los números conocidos de la carga del electrón, e‾ la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 número puro.

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundobrana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

Las fuerzas fundamentales

| Tipo de Fuerza | Alcance en m | Fuerza relativa | Función |

| Nuclear fuerte | <3×10-15 | 1041 | Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

| Nuclear débil | < 10-15 | 1028 | Es responsable de la energía radiactiva producida de manera natural. Portadoras W y Z– |

| Electromagnetismo | Infinito | 1039 | Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

| Gravitación | Infinito | 1 | Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies pegados a la superficie de la Tierra. La transporta el gravitón. |

Jul

5

¡Qué historias! ¡qué cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

A veces, escalar niveles más altos puede resultar penoso y, para algunos, un esfuerzo que les puede sobrepasar, pero si queremos conseguir alguna cosa, tendremos que pagar el precio. Nada, absolutamente nada en este mundo, se nos regala, todo tenemos que pagarlo de una u otra manera.

La escena me recuerda al viejo Sísifo que fue condenado a subir una gran piedra hasta la cúspide de la montaña y, cuando le faltaba un escaso margen para la llegada, cansado por el enorme esfuerzo realizado, no podía evitar que la gran piedra rodara montaña abajo obligándole así, a comenzar de nuevo. Lo mismo nos ocurre a nosotros en la vida cuando intentamos algo que no llega a salir como pensábamos, sin embargo, más que un fracaso, son sucesos que nos esnseñan la dureza de la vida. El que es poco luchador y se rinde, suele culpar al destino, o, a “su mala suerte”. Algunos, cuando han estado al borde de la derrota, han visto pasar por su lado el resplandor de la felicidad en forma de Amor, y, tan acontecimiento les cambió, algo dentro de ellos saltó y les abrió nuevos horizontes, otras formas de ver las cosas y, sobre todo, más capacidad para sufrir cuando la ocasión así lo requiere. Hay que pensar en el premio, nunca en el esfuerzo que exige lograrlo.

Alguna vez os hablé aquí de Gesner, aquel personaje que tenía una obsesión filológica. Os hablé de su libro de 158 páginas Mitridates, u observaciones sobre las diferencias existentes entre las lenguas que han estado o están en uso en las diversas naciones del mundo entero (1555), él intentó hacer con las lenguas lo que estaba haciendo con los animales y las plantas. Tomando como base su tradducción del padrenuestro. Gesner describió y comparó “la totalidad de las cientos treinta lenguas del mundo”. Por primera vez, se incluyó un vocabulario del lenguje Gitano.

Fotografo: James King. Ilustrador: Conrad Gester. Derechos © Australian Museum Research Library

Conrad Gesner (26/03/1516 – 13/12/1565), naturalista suizo, filólogo y bibliógrafo. Desde 1537 profesor de Lausana en 1541 un médico en Zurich, donde murió de la peste. El autor de Historias de animales (es decir, 1-5, 1551 a 1587) – la primera enciclopedia de zoología en el tiempo. Con base principalmente de la clasificación de Aristóteles, Gesner describió los animales en este orden: los animales de cuatro vivípara y ovípara, aves, peces y acuáticos, las serpientes y los insectos. Cada volumen de la materia se organiza en orden alfabético de los nombres de los animales y algunas formas conexas se agrupan en torno a un modelo único de un animal. Gessner trabajo desempeñado un papel importante en la difusión y sistematización de los conocimientos zoológicos. Durante más de 100 años, ha reimpreso varias veces y traducida. Gessner también ha recogido y estudiado las plantas. Ha publicado obras sobre filología. El autor de la primera colección de Trabajo bibliográfico universal Universal (1545-1555). Por ultimo, como arriba mencionamos, hizo un meritorio trabajo sobre las lenguas que se hablaban en el mundo.

No es de extrañar que en el libro se note la influencia heterogénea de quienes trabajaron en el. Los pasajes eruditos de Gesner, la posible ordenación básica de Wotton, las líricas…

La obra de Gesner se asocia con la de Aldrovandi, que también realizó una enciclopedia sobre animales. En cierto sentido, Aldrovandi es un Gesner llevado hasta el límite, pero hay un cambio de escenario, el Barroco italiano. Ulises Aldrovandi (1552-1605), nacido en Bolonia de una noble familia, viajó a través de Francia y España. estudiando en Padua y Bolonia, y en esta última fue nombrado profesor de medicina. Su cátedra y su posición como director del jardín botánico le sirvieron para enseñar sobre historia natural. El museo de curiosidades de Aldrovandi fue uno de los mayores de la época, con miles de pinturas, grabados, especímenes, un herbario y minerales. El pretendía realizar un teatro di natura, una representación de todo el mundo natural en un pequeño gabinete que reprodujera el macrocosmos y el microcosmos. Su teatro de la naturaleza contenía ocho mil ilustraciones, once mil animales, frutas y minerales, sy iete mil plantas disecadas. Tres de sus obras sobre animales fueron escritas por él, los tres volúmenes de Ornithologia (Bolonia, 1599, 1600, 1603), De animalibus insectis (1602), y, probablemente, De reliquis animalibus exanguis (editada póstumamente en 1606). El resto de su obra fue editada por su discípulo Cornelius Uterverius, y, tras su muerte, por Bartolomeo Ambrosino. Al igual que en Gesner, los relatos aldrovandinos de animales son un tesoro de resúmenes, anotaciones y paráfrasis procedentes de todo el ámbito del conocimiento. La masa de estos materiales está ordenada en varias categorías, muchas de las cuales fueron usadas por Gesner. La historia natural de Alrovandi ha sido definida como emblemática, y como resultado cada animal se convierte en el centro de múltiples asociaciones textuales y visuales.

Lástima que muchas de estas obras llegaran a nosotros muy deterioradas, o, no llegaron

El Monte Pilatus es una montaña que se encuentra en el macizo de los Alpes suizos, cerca de la ciudad de Lucerna, en Suiza. El punto más alto culmina a 2.137 msnm. En él, Gesner pudo experimentar la maravillosa sensación y experiencia de haber ascendido a una montaña y, en ella, poder descubrir las mil maravillas que allí están y que, desde ella, podemos admirar.

“Si deseais ampliar vuestro campo de visión, sirigid la mirada a vuestro alrededor y contemplad todas las cosas que hay a lo largo y a lo ancho. No faltan atalayas y riscor, desde donde os parecerá que tenéis la cabeza en las nubes. Si, por otra parte, preferís reducir la visión, podeis mirar los prados y los verdes bosques, o adentraros en ellos; y si quereis reducir más, podeis observar los oscuros valles, las sombrías rocas y grandes bocas de las negras cavernas… En verdad, en ningún otro lugar se encuentra tal variedad en tan reducido espacio como en las montañas, en las cuales… en un solo día se puede contemplar y sentir las cuatro estaciones del año, verano, otoño, primavera e invierno. Además, desde los picos más altos de las montañas, la cúpula entera de nuestro cielo se tenderá audazmente abierta ante nuestra mirada, y podreis presenciar la salida y la puesta de las constelaciones sin ningún estorbo, y comprobaréis que el Sol se pone mucho después y sale mucho antes.”

Descripción: La hoja helada de Orión

Credit & Copyright: Masahiro Miyasaka

NASA: Algunas veces, se puede decir el cielo nocturno es arte. Tomada sobre Japón a principios de mes, una vista del cielo fue fotografiada detrás de una hoja helada. El reflejo de los cristales de hielo en la fría hoja imita el brillo de las estrellas de fondo.

El particular cielo de fondo en esta exposición de 78 segundos realizada con un gran ángulo, sin embargo, puede parecer un tanto interesante y familiar.

En la izquierda, sin dificultad de encontrar , aparece el rastro de un meteoro. Por debajo y a la derecha del meteoro aparece un gran y largo rastro dejado por un aeroplano. La brillantes estrellas de la izquierda es Sirius, la más brillante estrella en el cielo nocturno. A la derecha de Sirius aparece la constelación de Orión, incluyendo las tres estrellas alineadas del Cinturón, con la roja gigante Betelgeuse.

El brillante camino de luz de la derecha es el grupo abierto de estrellas Pléyades. En similares vistas la constelación de Orión puede ser encontrada en el hemisferio norte al menos en los siguientes meses,.sin embargo podrías tendrás que probar con tu propia hoja.

Descripción: Orión desde el Spitzer

Credit: NASA, JPL-Caltech, J. Stauffer (SSC/Caltech)

NASA. Pocas vistas cósmicas excitan la imaginación como la Nebulosa de Orión, una inmensa matrona de 1.500 años luz. Extendiéndose 40 años luz sobre la región, esta nueva imagen en infrarrojos desde el Telescopio Espacial Spitzer se construyó con datos destinados a monitorizar el brillo de las jóvenes estrellas de la nebulosa, muchas de las cuales están formadas por polvo que componen discos de formación de planetas.

Las jóvenes estrellas de Orión son sólo tienen un millón de años de antigüedad, pocos comparados con los 4.6 billones (americanos) de años de nuestro Sol.

Verdaderamente, tener una visión del cielo desde una atalaya que nos permita observaciones tan maravillosas como las que arriba podemos ver, es una maravilla que, nos funde de manera más profunda con el Universo del que formamos parte, y, el amigo Gesner, así presintió que sería.

Claro que, la Humanidad, aún no ha podido vencer aquellos temores primitivos, en la mayoría de las personas (salvo excepciones), quedan las reminiscencias de aquel temor ancestral a lo desconocido, al peligro que esconde, a… ¿qué nos podremos encontrar allí?

En realidad, el objetivo perseguido con toda esta historia es simple: Hacer ver a quien esto lea que, cualquier empresa que nos podamos proponer, cualquier logro que nos propongamos alcanzar, siempre nos exigirá esa parte nuestra que no todos están disopuestos a dar: Sacrificio y, no en pocas ocasiones, tener que vencer ese miedo que todos tenemos.

emilio silvera

Jul

5

¿Puede ser el vacío superconductor?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

No podemos perder de vista la Física de metales a muy bajas temperaturas. A estas temperaturas, los “fenómenos cuánticos” dan lugar a efectos muy sorprendentes, que se describen con teorías cuánticas de campos, exactamente iguales a las que se utilizan en la Física de Partículas elementales. La Física de Partículas elementales no tiene nada que ver con la Física de Bajas Temperaturas, pero las matemáticas son muy parecidas.

En algunos materiales, el “campo” que se hace importante a temperaturas muy bajas podría ser el que describe como los átomos oscilan alrededor de sus posiciones de equilibrio, o el que describe a los electrones en este tipo de material. A temperaturas muy bajas nos encontramos con los “cuantos” de esos campos. Por ejemplo, el “fonón” es el cuanto del sonido. Su comportamiento recuerda al fotón, el cuanto de la luz, salvo que los números son muy diferentes: los fonones se propagan con la velocidad del sonido, a cientos o quizá miles de metros por segundo, y los fotones lo hacen a la velocidad de la luz que es de 299.792.458 m por segundo, ¡un millón de veces más deprisa! Las partículas elementales en las que estamos interesados generalmente tienen velocidades cercanas a la luz.

Uno de los “fenómenos cuánticos” más espectaculares que tienen lugar en los materiales muy fríos es la llamada superconductividad, fenómeno consistente en el hecho de que la resistencia que presenta ese material al paso de la corriente eléctrica se hace cero. Una de las consecuencias de este estado es que el material no admite la más mínima diferencia de potencial eléctrico, porque ésta sería inmediatamente neutralizada por una corriente eléctrica “ideal”. El material tampoco admite la presencia de campos magnéticos porque, de acuerdo con las ecuaciones de Maxwell, la creación del campo magnético está asociada con una corriente eléctrica inducida, que al no encontrar resistencia neutralizaría completamente el campo magnético. Por tanto, en el interior de un superconductor no se puede crear ni un campo eléctrico ni magnético. Esta situación sólo cambia si las corrientes inducidas son muy elevadas, como ocurre cuando se somete el superconductor a los campos de imanes muy potentes y que perturban el material. No siendo capaz de resistir una fuerza tan brutal, pierde la superconductividad y se rinde permitiendo la existencia de un campo magnético en su interior.

Jul

4

La Naturaleza, también tiene sus normas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Simetrías ~

Clasificado en Simetrías ~

Comments (0)

Comments (0)

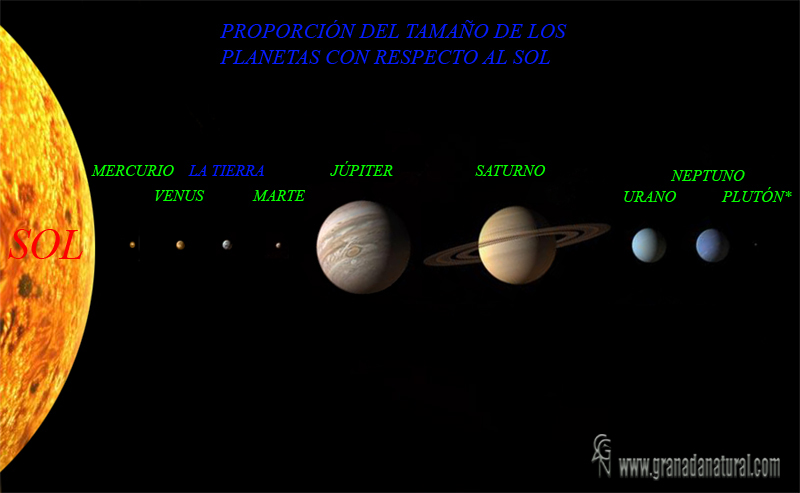

La simetría esférica de los planetas y de otros cuerpos celestes

La bella simetría de las hojas arbóreas y de los arbustos

La simetría es una propiedad universal tanto en la vida corriente, desde un punto de vista matemático como desde el quehacer de la Física Teórica. En realidad, lo que observamos en la vida corriente es siempre lo repetitivo, lo simétrico, lo que se puede relacionar entre sí por tener algo común.

En un sentido dinámico, la simetría podemos entenderla como lo que se repite, lo reiterativo, lo que tiende a ser igual. Es decir, los objetos que, por mantener la misma geometría, son representativos de otros objetos. En el Caos matemático encontramos esta concepción de la simetría en el mundo los fractales. Sin embargo, la simetría es mucho más.

La simetría está presente en múltiples manisfetaciones de la Naturaleza

Cuando miro en mi diccionario de Física la palabra Simetría, lo que me dice es: “Conjunto de invariancias de un sistema. Al aplicar una transformación de simetría sobre un sistema, el sistema queda inalterado, la simetría es estudiada matemáticamente usando teoría de grupos. Algunas de las simetrías son directamente físicas. Algunos ejemplos son las reflexiones y las rotaciones en las moléculas y las translaciones en las redes cristalinas. Las simetrías pueden ser discretas (es decir, cuando hay un número finito de transformaciones de simetría), como el conjunto de rotaciones de una molécula octaédrica, o continuas (es decir, cuando no hay número finito), como el conjunto de rotaciones de un átomo o núcleo. Existen simetrías más generales y abstractas, como la invariancia CTP y las simetrías asociadas a las teorías gauge.”

También podemos hablar de simetría rota y de supersimetrías. Durante los últimos tiempos, los Físicos han elevado los principios de simetría al más alto nivel en la escala de lo que podemos entender por una explicación. Cuando encontramos una Ley propuesta de la Naturaleza, una pregunta se nos viene a la mente: ¿por qué esta ley? ¿Por qué la realatividad especial y la general? ¿Por qué el electromagnetismo de Maxwell? ¿Por qué las teorías de Yang-Mills de las fuerzas nucleares fuerte y débil? Claro que, una respuesta de importancia es que, las teorías hacen predicciones que han sido repetidamente conformadas con precisos experimentos, con diversidad de científicos y lugares y que, siempre, en todos los casos, dieron el mismo resultado. Esto, por supuesto, es la base de la confianza esencial que los físicos tienen en esas teorías.

Todo se repite en la naturaleza que, de manera simétrica, construye una y otra vez las mismas cosas

Las ideas de simetría son esenciales para esa intuición. Se presiente que es correcto que ningún lugar del Universo es especial comparado con cualquier otro lugar del Universo, así que los físicos tienen la confianza de que la simetría de traslación debería estar entre las simetrías de las leyes de la Naturaleza. Se presiente que es correcto que ningún movimiento a velocidad constante es especial comparado con cualquier otro. De modo que los físicos tienen confianza en que la relatividad especial, al abrazar plenamente la simetría entre todos los observadores con velocidad constante, es una parte esencial de las leyes de la Naturaleza.

Los hongos atómicos también guardan cierta simetría

Así que las simetrías de la Naturaleza no son meras consecuencias de las leyes de la Naturaleza. Desde nuestra perspectiva moderna, las simetrías son la base de la que manan las leyes y, siendo así (que lo es), cuando un físico observa una simetría, agudiza su atención, ya que, allí, en aquel lugar, podría encontrarse alguna ley de la Naturaleza que siguiendo aquella presencia, se podría descubrir.

Más allá de su papel en dar forma a las leyes que gobiernan las fuerzas de la Naturaleza, las ideas de simetría son vitales para el propio concepto del tiempo. Nadie ha sabido encontrar todavía definición fundamental y definitiva del tiempo. Sin embargo, es indudable que el papel del tiempo en la constitución del cosmos es llevar una especie de registro de los sucesos y acontecimientos que en el universo ocureren: Nace una estrella, se forma una nueva galaxia, explota una supernova, muere una estrella masiva y surge un agujero negro…

Reconocemos el transcurrir del tiempo al mirar y ver que las cosas, no son iguales hoy a como lo fueron ayer. Con el transcurrir del tiempo todo cambia y nada permanece. ¿Será el tiempo otra simetría? Debe serlo, ya que, ningún cambio le afecta y, su transcrrir queda inalterado por mucho camino que pudiera haber recorrido y, eso, lo hace diferente de todo lo demás: Todo cambia excepto el tiempo que, es simétrico e inalterable, ajeno a los sucesos del mundo y del universo mismo.

Así, tenemos que llegar a la conclusión de que, el concepto de simetría es, para los Físicos, indispensable como punto de referencia en el descubrimiento de las teorías que más tarde, llegan a convertirse en leyes de la Naturaleza al comprobarse que son inalterables: Otra vez la Simetría. El desarrollo de la moderna teoría cosmológica, por ejemplo, tiene mucho que ver con la simetría. El significado del Tiempo, su aplicabilidad al universo en su conjunto, la forma global del espacio, e incluso el marco subyacente de la relatividad especial, todo descansa sobre fundamentos de simetría.

He leído por alguna parte que: “Combina topología con simetría y añade una pizca de mecánica cuántica. ¿El resultado? Una potente y nueva Teoría del Todo. La topología es el estudio de la forma, en particular de las propiedades que se conservan cuando se estira, comprime y retuerce una forma, pero no cuando se desgarra o raja. En el pasado, la topología era poco más que una diversión para los matemáticos, que hacían garabatos buscando la diferencia entre las rosquillas y empanadillas. Pero esto empieza a cambiar. En los últimos años, los físicos han empezado a usar la topología para explicar algunos de los misterios más importantes de las fronteras de la física.”

Durante el último siglo un concepto muy importante en Física, sobre todo en Mecánica Cuántica, ha sido y es el de simetría. Uno de los resultados más bonitos de la Física dice que allá donde hay una simetría hay una cantidad conservada. Es lo que se llama teorema de Noether. De este modo, las leyes de la Física pueden ser iguales bajo una u otra simetría y para cada uno de esos casos se conservará algo. Así por ejemplo, la simetría de traslación temporal corresponde a una cantidad conservada: la energía. También ocurre que las leyes de la física son las mismas bajo unas transformaciones de rotación en el espacio tridimensional y eso significa que se conserva el momento angular.

Allí donde veámos presente la simetría, debemos prestar atención, ya que, podría ser el indicio de que algo importante se podría derivar de esa simetría presente que, en física, como hemos comentado, es un principio de gran importancia.

Jul

4

Siempre hemos estado haciéndonos preguntas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (5)

Comments (5)

¿Cuántas veces y desde cuándo nos hemos preguntado por el origen del Universo? ¡Desde siempre! Desde que tuvimos uso de razón, es una vieja y notaria pregunta que la curiosidad que siempre hemos tenido, hizo que se pudiera en marcha la actividad humana en esa dirección de saber sobre el Sol y la Luna y las estrellas del cielo. Con certeza no podemos saberlo, ya que, nuestra especie no tiene ningún certificado de nacimiento y eso, amigos míos, nos ha obligado a investigar sobre nuestros orígenes nosotros solos, y al hacerlo hemos hallado necesario profundizar en el origen del “mundo” que nos acoge y del que, ineludiblemente, formamos parte. La falta de conocimientos nos llevó hacia el terreno de la especulación que, como observadores, podíamos deducir de lo que observamos y pudimos deducir más sobre nosotros mismos que sobre el universo que pretendíamos describir.

Está claro que lo mismo que una ola no puede explicar todo el Mar, tampoco la Nebulosa remanente de supernova que arriba contemplamos podría explicar el inmenso Universo que, al tener tan inimaginables dimensiones, nunca podremos contemplar en una Imagen completa, sólo a trozos, y captado parcialmente por extensas regiones e incluso objetos individuales, podremos contemplar, la ingente naturaleza de lo que todo lo contiene y abarca. El Universo es el espacio-tiempo, es la materia y todos los objetos que con ella se formaron se seguirán formando en el tiempo sin fin, también está conformado por las fuerzas fundamentales que todo lo rigen y que, para completar el cuadro, están acompañadas por unas constantes que hace de él, que sea el universo que conocemos con una velocidad finita para la luz, con una carga determinada para el electrón y, también, con una masa predeterminada para el protón. Si cualquiera de estos números: la velocidad de la luz, la carga del electrón i la masa del protón, variara sólo una diezmillonésima, el universo no sería tal como lo conocemos y, nosotros, tampoco podríamos haber llegado aquí.

Y, aunque no lo parezca, también la Imagen de arriba es posible que exista debido a que, las constantes y leyes de la Naturaleza así lo permiten al hacer posible que nuestro Universo sea tal como lo conocemos. Y, habiéndonos dedicado al estudio de todo lo que veíamos, haciéndonos preguntas del por qué de las cosas, hemos podido llegar a saber que el Universo está regido por números que hemos podido descubrir y que llamamos leyes y constantes.

Y, para eso, el recorrido que hemos tenido que hacer ha durado muchos miles de millones de años (considerándolo desde el surgir de la vida primigenia) y algunos cientos de miles de años (si partimos desde que en el mundo aparecieron los primeros hombres verdaderos) cuando mirando a los cielos, nos preguntábamos por qué brillaban las estrellas.

En aquellos tiempos remotos en los que, ninguna luz artificial (exceptuando alguna eventual hoguera), podía contaminar lumínicamente el lugar, nuestros ancestros podían mirar hacia lo alto y ver, maravillados como, ingentes cantidades de puntos luminosos de distintos y hermosos colores, titilaban temblorosos como queriéndoles decir alguna cosa.

Allí, en aquellas épocas remotas, nacieron los mitos de la creación y aquellos pueblos desataron su imaginación para crear “a su manera” una justificación de todo aquello que no llegaban a comprender, así que, las maravillas que observaban las hacían depender y las relacionaban con sus vidas cotidianas. Los sumerios que vivían en una confluencia de ríos, consebían la creación como resultado de una lucha en el barro entre dioses. Los Mayas, obsesionados por los juegos de balón, conjeturaban que su creador se transformaba en un balón solar cada vez que el planeta Venus desaparecía detrás del Sol. El pescador tahitiano hablaba de un dios pesacador que arrastró sus islas desde el fondo del océano; los antepasados de los samurais japoneses formaron sus islas de gotas de sangre que caían desde una hoja de espada cósmica. Para los griegos amantes de la lógica, la creación fue obra de los elementos; para Tales de Mileto, el Universo originalmente fue agua; para Anaxímedes (también de Mileto), fue aire; para Heráclito, fuego. En la fecundas islas hawaianas, la génesis fue manejada por un grupo de espíritus hábiles en embriología y el desarrollo de niños. Los bosquimanos de África se apiñaban alrededor del fuego, observaban como las chispas ascendían en el cielo nocturno y recitaban estas palabras:

Apareció la muchacha; puso las manos en las cenizas de madera; lanzó las cenizas al cielo. Dijo: “Las cenizas de la madera deben convertirse en la Vía Láctea. Deben quedar blancas a lo largo del cielo, para que las estrellas puedan estar fuera de la Vía Láctea, y la Vía Láctea ser la Vía Láctea, aunque eran cenizas de madera.”

Claro que, aquellos tiempos pasaron y el advenimiento de la Cienca y la tecnología ha logrado mejoras en la complejidad de la teorización cosmogónica, al menos en lo relativo a lo que precedió, si no a la simple realidad (si la hay) del gran Cosmos profundo (si hay cosmos). Pero la ciencia en modo alguno ha liberado el problema de la creación ni de su vieja maraña de presuposiciones y deseos humanos, si acaso, las hemos cambiado por otras nuevas que, más avanzadas tampoco explican esa creación de una manera firme, inamovible y autoconsistente si hablamos científicamente.

La cuestión de cómo empezó en el universo es, en el mejor de los casos, escurridiza, y cuando vamos de caza tras ella, con nuestro carcaj lleno de quaks, leptones, tensores de e4spacios curvos y probabilidades cuánticas, sólo tenemos una justificación marginalmente mayor de nuestra audacia de la que tenían aquellos sumerios, tahitianos y griegos. Pero, ¿nos diferenciamos mucho de ellos? Si hablamos de “materia oscura y otras cuestiones que no conocemos”, no creo que la diferencia sea tan abismal y, lo único que nos separan son los instrumentos modernos que tenemos para medir y ver y, de alguna manera, la forma de calcular sobre las leyes fundamentales y las constantes universales.

El éxito alcanzado por la Física desde finales del siglo XIX hasta esta primera década del siglo XXI no sólo ha transformado nuestra concepción del espacio-tiempo, sino que ha llegado a poner en nuestras mentes una nueva percepción de la Naturaleza: la vieja posición central que asignábamos a la materia ha cedido su lugar a los principios de simetría, algunos de ellos ocultos a la vista en el estado actual del Universo.

Está claro que los físicos, cada día más ambiciosos en su “querer saber” y su “querer descubrir”, buscan sin descanso nuevos caminos que les lleve a desvelar ocultas maravillas que tienen su hábitat natural en lo más profundo de la Naturaleza misma de la que no sabemos, aún, entender todas sus voces.

Son muchos los obstáculos que se encuentran en ese camino que nos lleva inexorable hacia esa soñada teoría final. Los científicos discrepan de los filósofos que no siempre, están de acuerdo con el hecho de que se pueda llegar a esa teoría última que lo pueda explicar todo, y, la firme creencia de que el Universo siempre tendrá secretos para nosotros, es una constante de la filosofía que la Ciencia, no deja de combatir. Por otra parte, se define nuestro carácter inquieto cuando no habiénso sido capaces de saber sobre aquel comienzo, ya estamos intentando exponer una teoría final. ?No será como comenzar la casa por el tejado?

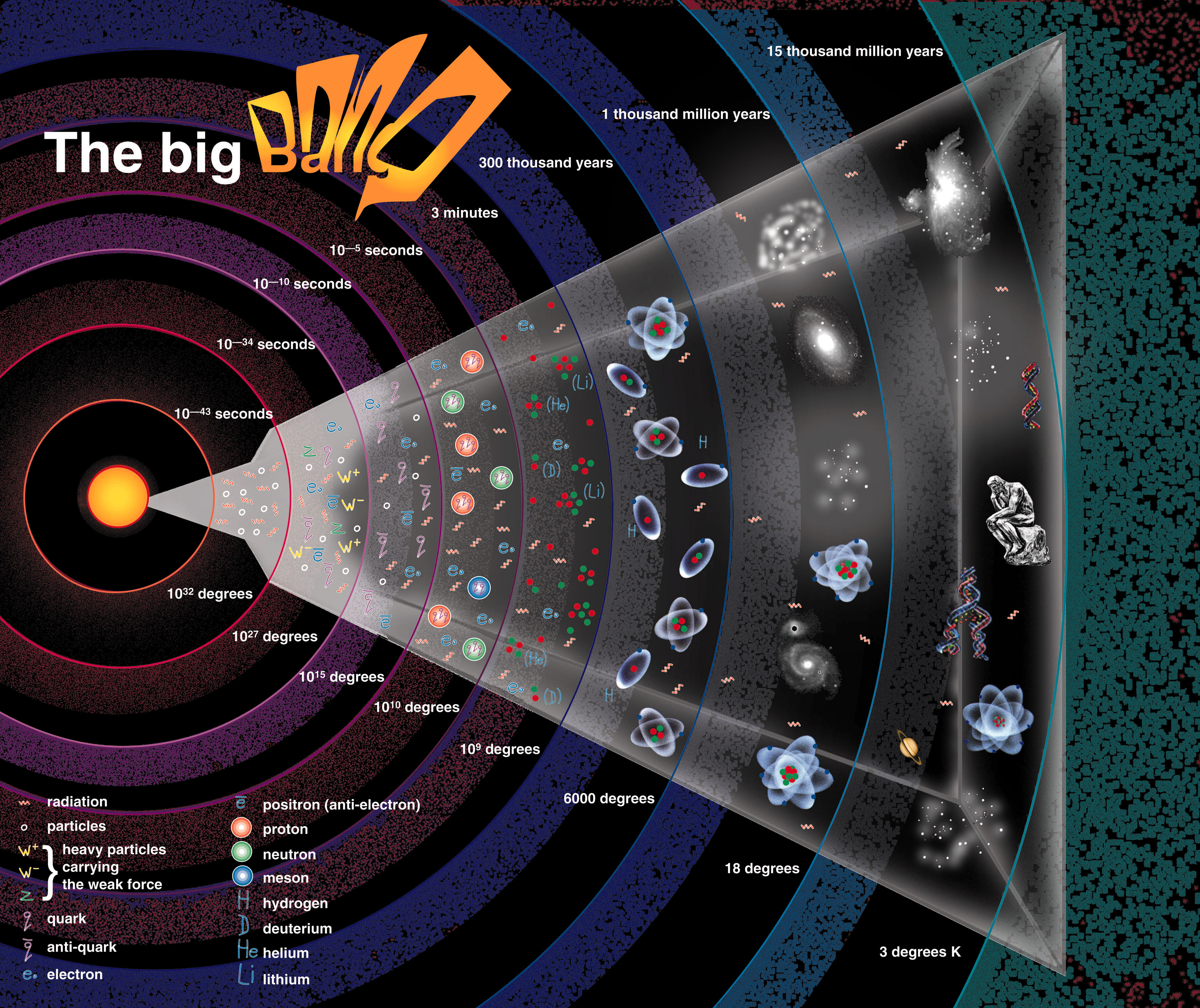

Según todos los indicios encontrados, hemos llegado a conjeturar que el Universo surgió de algo que hemos llamado Big Bang, no podemos explicar el comienzo mismo de aquel suceso, las matemáticas se niegan a entrar en ese esponioso terreno y, hemos partido desde un tiempo posterior, y, sin embargo sabemos que, en aquellas fracciones de segundo, pasaron muchas cosas y todas ellas importantes, ya que, todo lo que luego pasó fue consecuencia de aquellas primeras.

Así, estamos embarcados en una enorme aventura intelectual que eleva al ser humano a la categoría más alta que en el Universo pueda. La Física de altas energías nos llevan a conocer las entrañas de la materia y nos cuenta como se producen esas interacciones en el corazón de los átomos y aunque no sabemos cómo puedan ser las leyes finales ni cuanto será el tiempo que tardaremos en encontrar las pistas que nos guíen por el camino correcto, lo cierto es que, el progreso continúa y cada vez se construyen aceleradores más potentes y sofisticados y telescopios más modernos y con mayor capacidad para transportarnos hacia regiones profundas del Universo en las que podemos contemplar galaxias situadas muy cerca de ese comienzo que llamamos Big Bang.

Podrá esa teoría final explicarnos la expansión del Universo, la Gravedad cuántica, qué son las fluctuaciones de vacío y qué relación puedem tener con los agujeros negros, si existe finalmente la “materia oscurta”, o, si la Fuerza de Gravedad es tal como nos la describió Einstein o se guarda alguna última carta en la maga, o, su en verdad, existen más dimensiones de las que podemos ver, o, si nuestra realidad percibida es la auténtica realidad, o, si…

Como no podía ser de otra manera dado nuestro carácter siempre dispuesto a la controversia y nuestras mentes de pensamientos diversos, la propia idea de una teoría final nos ha llevado a la más profunda discrepancia entre unos y otros. Por una parte, están los partidarios de esa teoría que nos podrá hablar de un Universo de más altas dimensiones, donde la relatividad general de Einstein y la mecánica cuántica de Planck, conviven en la soñada concordia que muchos físicos han soñado y, por la otra, están aquellos que discrepando de los primeros se agarran al pensamiento de la imposibilidad de conseguir una teoría de esas características y, ellos hablan de física-ficción.

Lo cierto es que, a pesar de lo que digan los detractores de estas ideas avanzadas (no pocas veces por envidia y por el simple hecho de que ellos no tienen la capacidad de entender los nuevos conceptos y sus complejas matemáticas), la Física prosigue su camino y, cuando lleguemos a alguna parte, lo cierto será que, no hemos llegado a ningún final sino que, por el contrario, estaremos en el principio de algo nuevo. Cada vez que hacemos un descubrimiento que nos trae nuevos conocimientos, sólo hemos conseguido una llave para poder abrir otras puertas que permanecen cerradas. Es decir, podremos plantear nuevas preguntas al estar posibilitados con esos nuevos conocimientos. Cuando desconocemos algo, no podemos preguntar sobre ello.

http://www.moebio.conesfera/esfera.htm

Posiblemente, no consigamos nunca desconplejificar lo que el Universo es. La Naturaleza es “sabia”, sabe que nosotros los humanos necesitamos de la curiosidad para tener un incentivo y seguir buscando. Si llegamos a esa teoría final que tiene todas las respuestas… ¿No caeremos en un mar depresivo mental? ¿Nada que buscar, nada que averiguar, ningún misterio que resolver?…

¡Mal suena eso!

emilio silvera

Totales: 75.611.056

Totales: 75.611.056 Conectados: 48

Conectados: 48