Jul

26

¡El conocimiento! No todos lo podemos tener

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y los pensamientos ~

Clasificado en El Universo y los pensamientos ~

Comments (3)

Comments (3)

El conocimiento es tener noción de saber, es inteligencia para adquirirlo.

El problema filosófico de las cuestiones relacionadas con el conocimiento, es decir, la forma del conocimiento de la realidad, las posibilidades existentes de que ese conocimiento responda exactamente a lo que ésta es en sí, no constituyó una preocupación fundamental para los filósofos hasta la llegada de Kant que, en el siglo XVIII, suscitó en gran escala estas dificultades. Con anterioridad a Kant, el problema se reducía al sujeto que conoce y objeto conocido, se fijaban fundamentalmente en el segundo de ellas, y la filosofía moderna, por el contrario, está centrada en el sujeto cognoscente.

La inquietud por este problema comienza con Descartes, Leibniz, Locke, Berkeley, Hume que influyó decisivamente en Kant en quien el problema a esta cuestión, como ya he comentado antes, en alguna parte de este mismo trabajo, la cuestión se formuló así: todo conocimiento arranca o nace de nuestras experiencias sensoriales, es decir, los datos que nos suministran nuestros cinco sentidos, pero no todo en él procede de estos datos. Dicho de otra manera, hay en nosotros dos fuentes o potencias distintas que nos capacitan para conocer, y son la sensibilidad (los sentidos) y el entendimiento o inteligencia. Ésta no puede elaborar ninguna idea sin los sentidos, pero también éstos son inútiles sin la ayuda del entendimiento. Es como un conjunto simétrico, algo perfectamente acoplado para formar un todo.

Me viene a la memoria en este punto la explicación que me dio una vez mi hija María, cuando por curiosidad le pregunté: ¿Qué es el contrapunto?

“Es la concordancia armónica de dos o más voces cada una con su línea melódica, de cuya superposición resulta la armonía de la obra musical.

Se aplica además el arte de conducir las voces con cierta independencia, sin incurrir en falta contra las reglas de la armonía. El contrapunto severo se atiene estrictamente a ellas, mientras que el libre admite cierta soltura, siempre que no incurra en desarmonía y cacofonía. En el doble las voces pueden ser intercambiadas. Los métodos empleados son la imitación de un motivo, el canon y la fuga, y estos últimos son complicados entre lanzamientos del motivo de la melodía.

La palabra contrapunto la utilizó por primera vez Philippe de Vitro, teórico del siglo XIV.

El contrapunto es la técnica compositiva por la cual, sobre una melodía dada, se construye un conjunto de una o varias contramelodías o contrapuntos, consiguiendo que, finalmente todo sea un conjunto armonioso.”

Cuando puse por primera vez esta pagina os contaba:

Mi hija María, estudia música desde los 8 años. Es pianista profesional, se ha licenciado en el Clave, instrumento parecido al piano con el que se toca la música antigüa, también toca el Órgano y se licenció en Pedagogía musical al mismo tiempo que estudiaba Clave, en el Real Conservatorio Superior de Música de Madrid,ha estado haciendo un Master en la Universidad dee Sevillla de Profesorado Musical y, como todos los jovenes de hoy en España, está a la espera de oportunidades y, mientras tantos, realiza algunos proyectos musicales que la puedan llevar hacia el futuro mejor soñado.

Aunque lo mío es la física y otras ramas del conocimiento, de vez en cuando recurro a María para preguntarle algunas cuestiones bajo el punto de vista musical que, no en pocas ocasiones, coincide con temas científicos. La respuesta que me dio sobre el contrapunto es aplicable a un sin fin de cuestiones y problemas científicos y cotidianos: buscar la armonía en la diferencia.

Podríamos aplicar el arte de combinar los sonidos de las voces humanas o los instrumentos, o de unos y otros a la vez para causar un efecto estético, a nuestra vida social y sobre todo a la política, procurando que unos y otros, voces discordantes y pensamientos distintos, guiados por una regla de ética y moral, pudieran reflejar un comportamiento estético.

La Música (como la Poesía y la Física) enaltece al ser humano, nos eleva y nos hace mejores. Una música que nos llega y es capaz de despertar nuestros sentimientos, nos puede transportar muy lejos, allí donde encontraremos el amor y la felicidad que, en este mundo nuestro, está escondida. En lo que se refiere a la Física, cuando podemos llegar a comprender cómo funciona el “mundo” no podemos dejar de asombrarnos ante tanta sencillez y, sin embargo, tánta maravilla. La poesía, es algo que sale del “Alma”, que trasciende a lo material para llevarnos a ese mundo mágico de la realidad soñada.

El término “música” procede del griego mousiké a través de la adaptación latina música. En el mundo griego se designaban con este nombre todas las ramas del arte que eran presididas por las Musas. Pitágoras fue el teórico musical más importante de la antigüedad.

Formuló el concepto de armonía y a partir de sus análisis sobre la naturaleza del sonido se creó el cálculo pitagórico de intervalos y las escalas modales, cuya importancia fue decisiva en el desarrollo de la música medieval.

Los principios teóricos de los griegos se transmitieron a la música litúrgica cristiana a través de autores como San Agustín, Boecio y Casiodoro. Durante los primeros siglos del cristianismo, la música se circunscribió al ámbito religioso, concretamente al canto litúrgico, cuyo fundamento está constituido por la síntesis entre el sistema modal griego y ciertas influencias de la tradición judía.

Como veo que esto se me va de las manos y puedo terminar este trabajo escribiendo una historia de la música, mejor lo dejo y me dedico a lo que en realidad me debo: el pensamiento y la búsqueda del saber, dado que, lo único cierto, es nuestra ignorancia.

emilio silvera

Jul

25

Los misterios de la Física cuántica, las partículas subatómicas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (6)

Comments (6)

Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida medio, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, ksi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales manera de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

Lo que resulta de una colisión de haces de partículas en el LHC

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

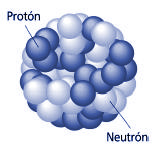

Masa atómica

Una de las formas como los científicos miden el tamaño de algo es a través de su masa. Los científicos pueden incluso medir cosas muy minúsculas como los átomos. Una medida del tamaño de un átomo es su “masa atómica”. Casi toda la masa de un átomo (más del 99%) está en su núcleo, de manera que la “masa atómica” es realmente una medida del tamaño del núcleo de un átomo.

Los protones son practicamente del mismo tamaño que los neutrones, y ambos son mucho más grandes que los electrones. Un protón tiene una masa aproximadamente 1.836 veces mayor que la masa del electrón, pero las masas de los protones y neutrones se diferencian menos de uno por ciento. Un protón tiene una masa de 1.6726 x 10-24gramos. Los protones tienen una carga eléctrica positiva, conocida a veces como carga elemental, carga fundamental o carga de +1. Los electrones tienen una carga del mismo valor pero de polaridad opuesta, -1. La carga fundamental tiene un valor de 1.602 x 10-19 coulombios.

Núcleo atómico

El núcleo de un átomo contiene protones y neutrones. Cada elemento (como el carbono, oxígeno o el oro) tiene diferente número de protones en sus átomos. Los científicos tienen un nombre especial para el número de protones en un átomo. Lo llaman “número atómico”.

¿Por qué es importante el número atómico? Los átomos normales tienen el mismo número de electrones que protones. El número de electrones es lo que hace que cada elemento se comporte de cierta manera en reacciones químicas. De manera que el número atómico, que es el número de protones y electrones, es lo que hace que un elemento sea diferente a otro.

Hace algunos años ya que los físicos se preguntaban: ¿Podrían los protones ser puntos? Y, tratándo de saberlo, comenzaron a golpear los protones con otros protones de una energía muy baja (al principio) con el objeto de explorar la fuerza electromagnética entre los dos objetos cargados.

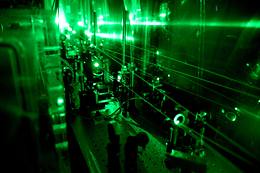

El Acelerador Lineal de Stanford. El SLAC, ubicado al sur de San Francisco, acelera electrones y positrones a lo largo de sus 2 millas de longitud (algo mas de tres kilómetros), hacia varios blancos, anillos y detectores ubicados en su finalización. Este acelerador hace colisionar electrones y positrones, estudiando las partículas resultantes de estas colisiones. Construido originalmente en 1962, se ha ido ampliando y mejorando para seguir siendo uno de los centros de investigación de física de partículas mas avanzados del mundo. El Centro ha ganado el premio Nobel en tres ocasiones.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (materia), es aún limitado.

Generalmente las llamamos partículas elementales pero, lo cierto es que, algunas son más elementales que otras. Los físicos experimentadores hicieron un buen trabajo en aquellos antiguos aceleradores de partículas por despejar la incognita y saber, de una vez por todas, de qué estava hecha la materia.

Los núcleos de los átomos están formados por protones y neutrones, alrededor de los cuales orbitan los electrones. Estos tres elementos (protones, neutrones y electrones) constituyen prácticamente toda la materia de la Tierra. Mientras que el electrón se considera como una partícula “sin tamaño”, el protón, que está compuesto de quarks, es un objeto con tamaño específico. Hasta ahora, sólo dos métodos se han utilizado para medir su radio. Basándose en el estudio de las interacciones entre un protón y un electrón, ambos métodos se centran en las colisiones entre uno y otro o sobre el átomo de hidrógeno (constituido por un electrón y un protón). El valor obtenido y que es el utilizado por los físicos, es 0,877 (+ / – 0,007) femtómetros.

Si los físicos experimentales de la década de los 60 hubieran podido tener a su disposición el moderno LHC… ¿Dónde estaríamos ahora?

La interacción fuerte es cien veces más intensa que la fuerza eléctrica de Coulomb, pero, al contrario que ésta, su alcance no es en absoluto infinito. Se extiende sólo hasta una distancia de unos 10-13 centímetros, y luego cae deprisa a cero. Al incrementar la energía de colisión, los experimentos desenterraron más y más detalles desconocidos de la interacción fuerte. A medida que aumenta la energía, la longitud de onda de los protones (acordémonos de De Broglie y Schrödinger) se encoge. Y, como se pudo ver, cuanto menor sea la longitud de onda , más detalles cabe discernir en la partícula que se estudie.

Robert Hofstadter, de la Universidad de Stantanford, tomó en los años cincuenta algunas de las mejores “imágenes” del protón. En vez de un haz de protones, la “luz” que utilizó fue un haz de electrones de 800 MeV que apuntó a un pequeño recipiente de hidrógeno líquido. Los electrones bombardearon los protones del hidrógeno y el resultado fue un patrón de dispersión, el de los electrones que salían en una variedad de direcciones con respecto a su movimiento original. No era muy diferente a lo que hizo Rutherford. Al contrario que el protón, el electrón no responde a la interacción nuclear fuerte. Responde sólo a la carga eléctrica del protón, y por ello los científicos de Stanford pudieron explorar la forma de la distribución de carga del protón. Y esto, de hecho, reveló el tamaño del protón. Claramente no era un punto.

Se midió que el radio del protón era de 2,8 x 10-13 centímetros; la carga se acumula en el centro, y se desvanece en los bordes de lo que llamamos el protón. Los experimentos se repitieron muchas veces y los resultados, siempre fueron parecidos al hacerlos con haces de muones, que también ignoran la interacción fuerte al ser leptones como los electrones. (Medidas más precisas llevadas a cabo en nuestro tiempo, han podido detectar, diminutos cambios en el radio del protón que tienen enormes implicaciones. El protón parece ser 0,00000000000003 milímetros más pequeño de lo que los investigadores habían pensado anteriormente, de hecho, y según han comentados los físicos del equipo que hizo el trabajo, las nuevas medidas podrían indicar que hay un hueco en las teorías existentes de la mecánica cuántica y algo falla en alguna parte.)

La imágen tomada en el SLAC, nos choca, todos tenemos en la mente las del LHC

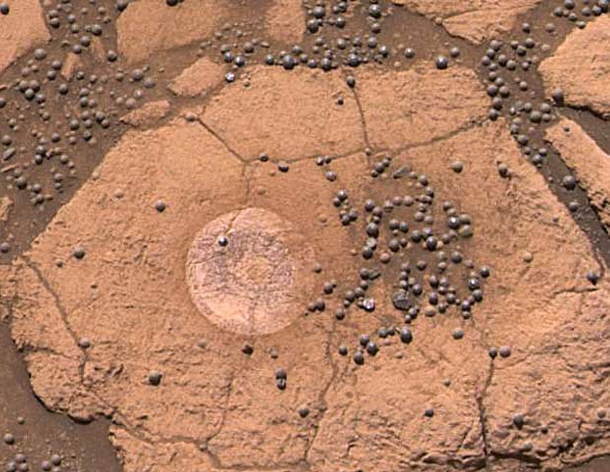

Pero sigamos con la historia. Hallá por el año 1968, los físicos del Centro del Acelerador Lineal Stanford (SLAC), bombarderon los protones con electrones de mucha energía -de 8 a 15 GeV- y obtuvieron un conjunto muy diferente de patrones de dispersión. A esta “luz dura”, el protón presentaba un aspecto completamente distinto. Los electrones de energía relativamente baja que empleó Hofstadter podían ver sólo un protón “borroso”, una distribución regular de carga que hacía que el electrón pareciése una bolita musgosa. Los electrones del SLAC pudieron sondear con mayor dureza y dieron con algunos “personajillos” que “correteaban” dentro del protón. Aquella fue la primera indicación de la existencia real de los Quarks.

Hablando de partículas y de física cuántica nos podríamos llevar muchos días, meses y años y escribir todo lo que hasta el momento se ha descubierto en este campo sería una tarea imposible en un lugar como éste en el que los trabajos, son indicativos y particularmente sencillos para que, los lectores visitantes, tengan una sencilla idea de los temas que se comentan, así que, en relaciòn a éste, aquí lo dejamos.

emilio silvera

Jul

25

El Universo y la Consciencia ¿Cómo pudo evolucionar tánto la materia?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (3)

Comments (3)

Sí, siempre hemos pensado en esa relación

Cuántas veces habremos dicho aquí que, estamos hechos de “energía pura” fabricada en las estrellas y nuestras mentes evolucionan formando parte de un universo en constante expansión del que, sin que nos demos cuenta, recibimos continuos mensajes que nos mantiene conectados a esa fuerza invisible que nos hace pensar para descubrir su fuente.

En algún momento breve he tenido la sensación de tener en mi mente la solución a un pensamiento continuado sobre un problema científico que me preocupa y quisiera conocer. La sensación de ese saber, de tener esa respuesta deseada, es fugaz, pasa con la misma rapidez que llegó. Me deja inquieto y decepcionado, estaba a mi alcance y no se dejó atrapar. Me ocurre con cierta frecuencia con distintos temas que me rondan por la cabeza. Sin embargo, esa luz fugaz del saber aparece y se va sin dejar rastro en mi mente que me permita, a partir de una simple huella, llegar al fondo de la cuestión origen del fenómeno. El espacio-tiempo, la materia contenida en el Universo con la fuerza gravitatoria que genera, el electromagnetismo y, nuestras mentes, que tienen conocimiento de que todo esto sucede.

De manera que nuestro consciente (sentimos, pensamos, queremos obrar con conocimiento de lo que hacemos), es el elemento racional de nuestra personalidad humana que controla y reprime los impulsos del inconsciente, para desarrollar la capacidad de adaptación al mundo exterior. Al ser conscientes, entendemos y aplicamos nuestra razón natural para clasificar los conocimientos que adquirimos mediante la experiencia y el estudio que aplicamos a la realidad del mundo que nos rodea.

La mente humana es una maravilla. Esas sensaciones que antes he mencionado y que en mí, llegan y se van sin dejar huellas, son las mismas que sintieron Galileo, Kepler, Newton, Planck o Einstein, lo único diferente es que en ellos la sensación no fue tan fugaz; se quedó el tiempo suficiente en sus mentes como para que pudieran digerir el mensaje y comunicar al mundo lo que les había transmitido. Así, a fogonazos de luz del saber, avanza la Humanidad.

Nadie ha podido explicar nunca como llegan esos fogonazos de luz del conocimiento a unas pocas mentes elegidas.

El cerebro se cuenta entre los objetos más complicados del universo y es sin duda una de las estructuras más notables que haya producido la evolución. Hace mucho tiempo, cuando aún no se conocía la neurociencia, se sabía ya que el cerebro es necesario para la percepción, los sentimientos y los pensamientos.

¿Cuantas veces nos habremos hecho esa pregunta?

En tanto que es objeto y sistema, el cerebro humano es muy especial: su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo y con el mundo… no se parece a nada que la conciencia conozca. Su carácter único hace que el ofrecer una imagen del cerebro se convierta en un reto extraordinario. Aunque todavía estamos lejos de ofrecer una imagen completa del cerebro, sí podemos ofrecer retazos y datos parciales de algunos de sus complicados mecanismos. Sin embargo, carecemos de información para generar una teoría satisfactoria de la conciencia.

El reto que tenemos por delante consiste en adoptar la forma correcta en que se deben leer los contenidos de todas esas páginas que contienen la secuenciación de las 3.000 millones de letras de ADN, y comprender el modo de cómo funcionan juntas las distintas partes para encausar la salud y la enfermedad humanas.

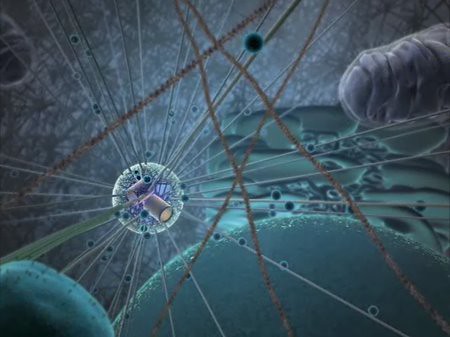

Cien mil millones de neuronas y, la escalera del ADN que va, desde nuestro mundo hasta lo más profundo del Universo

La consecuencia más importante de todo esto es que se ha abierto la puerta a un alentador y enorme (aunque complejo) paisaje biológico nuevo. Su exploración necesitará de pensamientos creativos y nuevas ideas. Hace 30 años todo esto era un sueño; nadie se atrevía a pensar siquiera con que este logro sería posible algún día, ¡secuenciar 3.000 millones de grafos de ADN!

Sin embargo aquí viene la contradicción o paradoja: ¡el cerebro que aún no conocemos lo ha hecho posible!

La genómica es una auténtica promesa para nuestra salud pero necesitaremos algunos saltos cuánticos en la velocidad y la eficacia de la secuenciación del ADN. Está claro sin embargo que dadas todas las dimensiones del ser humano, que incluyen aspectos tanto materiales como espirituales, será necesario mucho, mucho, mucho tiempo para llegar a conocer por completo todos los aspectos complejos encerrados en nuestro interior.

En nosotros conviven dos partes bien diferenciadas: Cuerpo y Mente

El adelanto que se producirá en las próximas décadas estará y será más visible en el aspecto biológico y la curación de enfermedades como el Alzheimer, Cáncer, Sida…, y, otras muchas queasolan nuestro mundo. El conocimento de la psique, de nuestra propia conciencia, será mucho más lento.

¿Será posible que algún día tengamos un conocimiento completo de nosotros mismos? Tal conocimiento nos proporcionaría luz sobre lo que convierte en “únicos” a los seres humanos. Al decir únicos me refiero al hecho diferenciador de la conciencia y, desde luego, lo circunscribo al planeta Tierra, ya que referido a todo el Universo seguro que no somos “tan únicos”.

Es cierto que, las enfermedades de la mente son las más complejas

Casi todas las enfermedades que nos aquejan están y tienen su origen en los genes. Otras dolencias están relacionadas con el entorno en el que vivimos, la forma de vida elegida por nosotros mismos (tabaco, alcohol, droga, etc), y una parte de los trastornos que padecemos (los más difíciles de curar), están situados en nuestras mentes, las más desconocidas.

Así que si el conocimiento sobre el genoma está en el buen camino y según todos los indicios, algún día podremos tener las respuestas que aún nos falta. El problema más serio está en ese gran desconocido que llamamos cerebro y que es el responsable de dirigir y ordenar todos y cada uno de los movimientos que se generan en el resto de nuestro cuerpo. Allí, en el cerebro, está la central eléctrica que lo pone todo en marcha, ¿pero de qué mecanismos se vale? ¿Nos muestra la realidad de la Naturaleza? Precisamente esa es la explicación que nadie ha podido dar.

¿Cómo, a partir de células microscópicas llegamos aquí?

¿Qué es la realidad?, ¿Como la definimos?, ¿Cuántas realidades hay?, ¿Cada uno de nosotros tiene su propia realidad?¿Qué realidad nos transmite el Universo en nuestro mundo, será distinta a realidades de otros mundos? ¿Es una realidad la cuántica? ¿Existen realidades que no podemos percibir? La realidad va en función de la percepción que se tenga de ella, y esta forma parte de la Conciencia. Nuestra conciencia actual es un condicionamiento de nuestra visión del mundo actual y colectivo, es la que nos enseñaron nuestros padres, maestros, la sociedad, gobierno y religiones. A esta manera de ver y entender el mundo, pertenece el antiguo paradigma. Y, como nos diría Tom Wood, necesitamos nuevos paradigmas para poder entender la “realidad” de la Naturaleza.

Es cierto que, algunas veces, cuando profundamente pensamos en todos estos conceptos, llegamos a la conclusión de que la realidad no existe, y, si entramos en el mundo de la filosófía podríamos argumentar que nunca nadie ha podido “ver” un pensamiento y, sin embargo, ¿cuántos generamos durante nuestras vidas?

Si es cierto que estamos conectados con el Universo, tendríamos que esforzarnos en comprender como funciona la propia Naturaleza para tratar, en lo posible, de imitarla. Siempre se oyó decir: ¡La Naturaleza es sabia!

Si es cierto que estamos conectados con el Universo, tendríamos que esforzarnos en comprender como funciona la propia Naturaleza para tratar, en lo posible, de imitarla. Siempre se oyó decir: ¡La Naturaleza es sabia!

Y, lo cierto es, amigos míos que, si nos fijamos detenidamente en cómo funciona ésta, veremos que todo tiene un principio, una ley que sigue las reglas impuestas para que, el bien general sea el fin pèrseguido.

Todo lo que ocurre tiene una explicación que va encaminada a la consecución de unos propósitos que son los que rigen en todas las fuerzas fundamentales de nuestro Universo.

Sin la fuerza nuclaear fuerte, no tendríamos átomos que juntos formaran moléculas y éstas se juntaran para constituirse en materia.

Claro que, esa sabiduría de la Naturaleza a la que antes me refería, nos debería llevar hasta propósitos superiores, incluso de una célula podríamos aprender: Cada Célula del cuerpo acuerda trabajar por el bien del Todo; el Bienestar individual es secundario. Si es preciso, morirá para proteger al cuerpo (Lo que ocurre con frecuencia). La vida de cualquier célula es muchísimo más breve que la nuestra. Las celulas de la piel mueren por cientos cada hora, al igual que las inmunológicas que combaten los microbios invasores. El egoísmo resulta inconcebible, incluso cuando la supervivencia de las células está en juego.

¿Por qué no hacemos nosotros lo mismo? ¿Acaso no hemos finalizado nuestro proceso de Humanización, o, por el contrario, simplemente se trata de que somos así. Seres egoistas en los que prima lo individual y el YO, contra el NOSOTROS, como “Ente” principal? Hay una cuestión que me da algo de esperanza: Cuando hablamos de nuestros hijos, de nuestro ser Amado… El Yo se queda detrás y prevalecen esos valores, esos sentimientos que, en realidad, son los que nos ditinguen y nos hacen grandes.

¡Nosotros y el Universo!

A veces me gusta pensar que nuestros cuerpos carecen de edad y nuestras mentes de tiempo. Una vez que identificados con esa realidad, que es congruente con la visión cuántica del universo, entraremos en el nuevo paradigma, y nuestras conciencias, sé expandirán, cósmica y cuánticamente en fractales radiales exponenciales y dimensionales que formaran un todo con el Universo al que pertenecemos.

Al mirar por el microscopio electrónico, (Microcosmos) vemos como las partículas cuánticas se mueven, (virtualmente) a la velocidad de la luz, y si miramos al cielo y observamos las Estrellas, veremos la inmutabilidad del Macrocosmos. Cada uno habita en una realidad que se encuentra mas allá de todo cambio. En lo más profundo de nosotros, sin que lo sepan nuestros sentidos externos tridimensionales o físicos, existe un intimo núcleo del ser, un campo de inmortalidad, que crea la personalidad, él yo y el cuerpo. Este ser es nuestro estado esencial, es nuestra esencia (¿Alma?), es quien realmente somos. ¿Somos, después de todo “Almas Etéreas” en este inmutable escenario cósmico que se repite una y otra vez?

Una galaxia es simplemente una parte pequeña del universo, nuestro planeta es una mínima fracción infinitesimal de esa galaxia, y nosotros mismos podríamos ser -en relación a la inmensidad del cosmos- como una ínfima colonia de seres pensantes e inteligentes. Sin embargo, todo forma parte de lo mismo, y aunque nos pueda dar la sensación engañosa de una cierta autonomía y libertad, lo cierto es que todos y todo está interconectado y el funcionamiento de una cosa incide directamente en las otras y, nosotros, no somos ninguna excepción.

Está claro que en lo más profundo de esta consciencia ¡que no conocemos!, se encuentran todas las respuestas planteadas o requeridas mediante preguntas que nadie ha contestado. Para poder llegar a esos conocimientos tan profundamente escondidos dentro de nosotros, debemos observar la Naturaleza que, habiendo logrado traernos hasta aquí, a partir de la materia “inerte”, es la que contiene todos y cada uno de los datos que nos dirán lo que somos, de dónde venimos y hacia dónde vamos.

En corriente que en muchas oportunidades mencione y los ponga en un plano de estrecha relación, el Universo y la Mente-consciencia- , en realidad, aunque no siempre lo consiga, lo que trato de hacer ver es que todo ello es la misma cosa: universo-galaxia-mente. Nada es independiente en un sentido global, sino que son partes de un todo y están estrechamente relacionados.

Lo cierto es que creamos nuestra propia realidad, dentro de otra realidad más grande que resulta ser el UNIVERSO del que sólo somos una parte…, que seguramente, no será la más importante.

emilio silvera

Jul

25

¡La Materia! ¿Qué será en realidad? Algunos apuntan a las...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Aunque de extraña y atípica figura, también, esta galaxia, está hecha de materia

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que, incluso en ocasiones, alcanza la consciencia de SER.

Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

¡Parece que la materia está viva!

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y también su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Josepth John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

(“Aunque no se trata propiamente de la imagen real de un electrón, un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida cuenta que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¡No por pequeño, se es insignificante!

Recordémoslo, todo lo grande está hecho de cosas pequeñas.

Louis de Broglie

En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm. De longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

Joseph Weber

El interferómetro funciona enviando un haz de luz que se separa en dos haces; éstos se envían en direcciones diferentes a unos espejos donde se reflejan de regreso, entonces los haces al combinarse presentarán interferencia.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es 0, su carga es 0, y su espín de 2. Como el fotón, no tiene antipartícula, ellos mismos hacen las dos versiones.

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones.

¿Espuma cuántica? Si profundizamos mucho en la materia…

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de este mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

“Una investigación ha llevado a pensar que, la materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interior de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

Eso permitirá a los físicos someter a prueba a la QCD y buscar sus efectos más allá de la física conocida. Por ahora, los cálculos demuestran que la QCD describe partículas basadas en quarks de forma precisa, y que la mayor parte de nuestra masa viene de quarks virtuales y gluones que burbujean en el vacío cuántico.

Se cree que el campo de Higgs hace también su pequeña contribución, dando masa a los quarks individuales, así como a los electrones y a otras varias partículas. El campo de Higgs también crea masa a partir del vacío cuántico, en forma de bosones virtuales de Higgs. De modo que si el LHC confirma la existencia del bosón de Higgs, eso significará que toda la realidad es virtual.”

De todo lo anterior, no poemos obtener una respuesta cierta y científicamente probada de que todo eso sea así, más bien, los resultados indican que todo eso “podría ser así”, lo que ocurre es que, los científicos, a veces se dejan llevar por las emociones.

Ya nos gustaría saber cómo es, ese vacío cuántico y qué pasa allí

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven. Hace un par de días que hablamos de ello.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío tiene una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultraalto.

No puedo dejar de referirme al vaciotheta (vació θ) que, es el estado de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs). En el vacío theta hay un número infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una funciónn de Bloch en un cristal.

Se puede derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel entre estados queda completamente suprimido.

Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que para campos gauge puros, pero no está completamente suprimido.

emilio silvera

* Dualidad onda partícula en el comportamiento del electrón, por ejemplo.

* Teorema de Bloch: relativo a la M.C. de los Cristales, que estable que la función de ondas Ψ (π)=exp (ik’π) U (π).

Jul

25

¡La flecha del Tiempo! siempre hacia el futuro incierto

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (1)

Comments (1)

Lo que le pueda ocurrir a nuestra civilización, además de estar supeditada al destino de nuestro planeta, de nuestro Sol y de nuestro Sistema Solar y la Galaxia, en parte, también está en manos de los propios individuos que la forman y que, con sensibilidades distintas y muchas veces dispares, hace impredecibles los acontecimientos que puedan provocar individuos que participan con el poder individual de ese parcial “libre albedrío” del que podemos disponer. Nuestro planeta dispone de condiciones especiales que hizo posible el surgir de las distintas Civilizaciones que lo han habitado desde tiempos inmemoriales.

Muchos son los planetas que, por una u otra razón, no reunen esas condiciones y, algunos, están en las cercanis de su estrella haciendo imposible que en ellos, pueda surgir la vida. Bueno, al menos las formas de vida que aquí conocemos. ¿Será como el de arriba nuestro mundo, cuando el Sol se convierta en una gigante roja?. ¿Habremos sido capaces de escapar hacia otros mundos, antes de que eso pase?

El Tiempo es como una escalera que, a medida que la subimos, sus peldaños se va destruyendo a nuestras espaldas. Nunca podremos regresar al pasado. La flecha del tiempo, sólo sabe correr hacia el futuro incierto. El Universo sólo marcha en una dirección: ¡El Futuro!Y, como el sabio nos dijo: “Todo estado presente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro.” Nos dice que lo que pasó ayer es lo que tenemos hoy, y, lo que hoy pase será determinante para el mañana.

Siempre hemos sabido especular con lo que pudo ser o con lo que podrá ser si… Lo que la mayoría de las veces, es el signo de cómo queremos ocultar nuestra ignorancia. Bien es cierto que sabemos muchas cosas pero también es cierto que son más numerosas las que no sabemos, y, debemos aprovechar al máximo lo poco que sabemos para determinar, dentro de lo posible, el devenir del mundo, de ese futuro incierto que la Humanidad desconoce.

Por mucho que sondeemos en nuestras mentes, nunca podremos saber lo que mañana pasará, el futuro no existe, es algo que está por llegar y, aunque podemos formular teorías de lo que será…, nunca tendremos la capacidad de predecir el mañana. Hasta donde podemos saber, la Naturaleza pueda cambiar, de un momento a otro, el futuro de nuestro mundo y, como consecuencia el nuestro también. ¿Quién puede predecir que antes de que finalice esta década, no caerá un meteorito sobre nosotros?

Lo que tenga que pasar…, ¡pasará! Y ese destino está escrito por la propia Naturaleza que nosotros, no conocemos. Cuando se formó el Universo, quedaron escritas las leyes que lo rigen y las fuerzas que lo gobiernan, su dinámica, el ritmo al que transcurre el tiempo y crece el espacio, y todo ello, sometido a principios y energías que, en la mayoría de los casos se escapan a nuestro actual conocimiento.

Las galaxias se alejan las unas de las otras de manera que al final, estaremos sólos y el frío será el principal factor para que la vida, no pueda estar presente en un Universo que, según todos los indicios, será asolado por una congelación general, el cero absoluto de los -273 ºC impedirá que los átomos tengan actividad y, cuando eso ocurra… ¿Podremos solucionarlo de alguna manera… ? Bueno, al menos tengamos la esperanza de que podamos, si existen, huir a otros universos.

Nuca podremos tener la Galaxia en nuestras manos

Como he dicho tántas veces, creo firmemente que, de alguna manera, nuestras mentes, están conectadas con el cosmos del que formamos parte. Estamos aquí y nos parece de lo más natural, nunca nos paramos a pensar en cómo fue eso posible, en cómo surgió aquella “chispa” que encendió la lumbre para la llegada de aquella primera célula replicante que, a partir de la materia “inerte”, evolucionada hizo posible el salto descomunal hacia seres conscientes. ¿cómo fue posible tal maravilla? Sabemos que pensar que, el material del que estamos hecho (Nitrógeno, Carbono, etc.), se fabricó en las estrellas a partir del elemento más simple, el Hidrógeno que, evolucionado a materiales más complejos llegaron hasta nuestra región en el espacio en forma de Nebulosa después de una explosión supernova y, con el tiempo, se formó el Sistema Solar primitivo para constituirse, en una pequeña parte en el Planeta Tierra en el que, bajo ciertas condiciones atmosféricas, presencia de agua y de radiación cósmica…, y un sin fin de parámetros más, dio lugar al nacimiento de aquella primera célula capaz de reproducirse que evolucionó hasta nosotros.

En tanto que objeto y sistema, el cerebro humano es muy especial: su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo y con el mundo, no se parece a nada que la conciencia conozca. Su carácter “único” hace que el ofrecer una imagen del cerebro se convierta en un reto extraordinario. Aunque todavía estamos lejos de ofrecer una imagen completa del cerebro, si podemos ofrecer retazos y datos parciales de algunos de sus complicados mecanismos. Sin embargo, carecemos de información para generar una teoría satisfactoria de la conciencia.

A lo largo del tiempo, han sido muchas mentes las que han recibido destellos que la llevaron a intuir primero y desvelar después, secretos bien escondidos de la Naturaleza. Y, debemos aprovechar esos destellos que, periódicamente, les llegan a algunos de nosotros para tratar, dentro de lo que se pueda, de preservar a la Humanidad de ese futuro incierto.

Esos destellos que los ojos de todas las Mentes no ven y que, las conexiones signóticas no piueden agarrar, lo mismo que llegan se van hacia el infinito… de un limbo desconocido donde yacen los pensamientos perdidos que, más tarde, algún otro cerebro recuperará y, la Humanidad, dará un nuevo salto en el saber del mundo.

En algún momento breve, ¿quién no ha tenido esa sensación de tener la solución a un problema científico que le preocupa y quisiera resolver?. La sensación de ese saber, de tener esa respuesta deseada, es fugaz, pasa con la misma rapidez que llegó. Nos deja inquietos y decepcionados, estaba a nuestro alcance y no se dejó atrapar. A mí me ocurre con cierta frecuencia con distintos temas que me rondan por la cabeza. Sin embargo, esa luz fugaz del saber aparece y se va sin dejar un rastro en mi mente que me permita, a partir de esa simple huella, llegar al fondo de la cuestión origen del fenómeno.

Millones de conexiones transportan los pensamientos que más tarde, son convertidos en realidad. El cerebro se cuenta entre los objetos más complicados del universo y es sin duda una de las estructuras más notables que haya producido la evolución. Hace mucho tiempo, cuando aún no se conocía la neurociencia, se sabía ya que el cerebro es necesario para la percepción, los sentimientos y los pensamientos.

En tanto que es objeto y sistema, el cerebro humano es muy especial: su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo y con el mundo… no se parece a nada que la conciencia conozca. Su carácter único hace que el ofrecer una imagen del cerebro se convierta en un reto extraordinario. Aunque todavía estamos lejos de ofrecer una imagen completa del cerebro, sí podemos ofrecer retazos y datos parciales de algunos de sus complicados mecanismos. Sin embargo, carecemos de información para generar una teoría satisfactoria de la conciencia. Estamos tratando de algo que pesa poco más de 1 kg –aproximadamente- y que contiene unos cien mil millones de células nerviosas o neuronas, generando continuamente emociones, ideas y pensamientos… y, también sentimientos que no siempre podemos explicar. ¡Increíble! ¡grandioso! Pero, ¿sabemos encausarlo? Bueno, en eso estamos.

Los circuitos y conexiones cerebrales generan números que sobrepasan el número de estrellas en las galaxias. Estamos tratando de algo que pesa poco más de 1 Kg – aproximadamente – y que contiene unos cien mil millones de células nerviosas o neuronas, generando continuamente emociones y pensamientos.

La consecuencia más importante de todo esto es que se ha abierto la puerta a un alentador y enorme (aunque complejo) paisaje biológico nuevo.Su exploración necesitará de pensamientos creativos y nuevas ideas. Hace 40 años, todo esto era un sueño, nadie se atrevía a pensar siquiera con que este logro sería posible algún día ¡secuenciar 3000 millones de grafos de A D N! Sin embargo, aquí viene la contradicción o paradoja, el cerebro ¡que aún no conocemos!, lo ha hecho posible. La genómica es una auténtica promesa para nuestra salud, pero necesitaremos algunos saltos cuánticos en la velocidad y la eficacia de la secuenciación del A D N.

Sí, finalmente veremos que todo, sin excpción, está realcionado. Algo de razón yace en el “Efecto Mariposa”

Está claro sin embargo que, dadas todas las dimensiones del ser humano, que incluyen aspectos tanto materiales como espirituales, será necesario mucho, mucho, mucho tiempo, para llegar a conocer por completo todos los aspectos complejos encerrados en nuestro interior que, si no me equivoco viene a ser como un extracto del Universo mismo, de la Naturaleza que, en nosotros, se elevó a su máxima expresión. ¿De qué estamos hechos? ¡De polvo de estrellas!

Si, en el polvo de las estrellas se esconde el secreto de la Vida

El adelanto que se producirá en las próximas décadas será muy visible en el aspecto biológico, la vida media d elas personas dará un gran salto y, cumplir un siglo, será entonces lo cotidiano. La Astronomía estará tan adelantada que, ni los agujeros negros, ni “la materia oscura”, serán problemas por resolver. Se habrá llegado más lejos que nunca y, nuestras bases marcianas serán el lugar de salida para misiones más lejanas y ambiciosas. La Física, que habrá hecho posible muchas de esas cuestiones, tendrá Modelos que nos dirán muchas de las cosas que ahora desconocemos, sabremos, por fín, lo que es la materia y, también por fín, habremos podido profundizar más en la compleja y extraña mecánica cuántica.

Salvando las distancias, esta misma escena se podría estar dándo ahora mismo, en miles y cientos de miles de mundos que, como el nuestro, haya podido estar situado en la zona habitable de una estrella que le proporcione los elementos necesarios para la vida, sobre todo, su luz y su calor.

emilio silvera

Totales: 74.379.585

Totales: 74.379.585 Conectados: 22

Conectados: 22