Ago

19

¡¡Titán!! ¿Qué sorpresas nos espera?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

El misterio de las olas perdidas en Titán

22 de julio de 2013: Uno de los descubrimientos más sorprendentes de los últimos 10 años es lo mucho que se parece el paisaje de la luna Titán, del planeta Saturno, a nuestro planeta Tierra. Al igual que nuestro planeta azul, la superficie de Titán está salpicada con lagos y mares, tiene canales de ríos, islas, lodo, nubes de lluvia y, tal vez, hasta arcoíris. La gigantesca luna es indudablemente húmeda.

El “agua” de Titán, sin embargo, no es H2O. Con una temperatura en la superficie que está por debajo de los 143o C (290o F) bajo cero, Titán es demasiado fría como para tener agua líquida. En cambio, los investigadores creen que el líquido que esculpe a Titán es una mezcla desconocida de metano, etano y otros hidrocarburos difíciles de congelar.

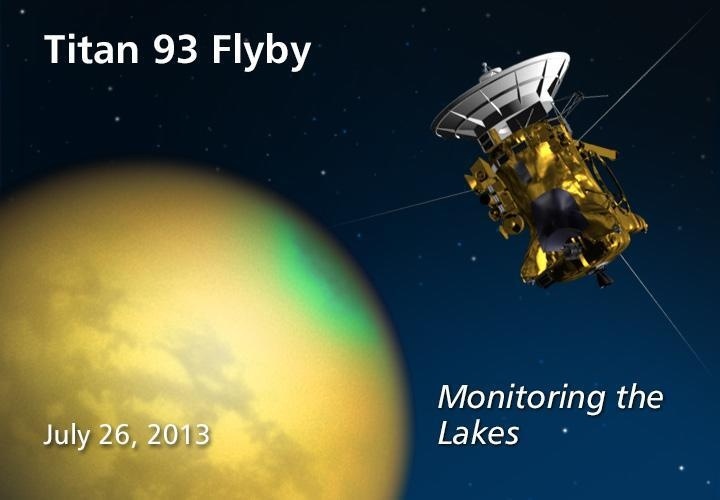

La idea de que Titán es un mundo húmedo, con “agua” alienígena que le es propia, está ampliamente aceptada por los científicos planetarios. No hay otro modo de explicar las observaciones: la sonda Cassini, de la NASA, ha sobrevolado a Titán más de noventa veces desde el año 2004, enviándole pulsos de radar y construyendo mapas de sus lagos y mares. La sonda Huygens, de la Agencia Espacial Europea, se posó sobre la superficie de Titán usando un paracaídas en el año 2005; descendió a través de nubes húmedas y cayó de hecho sobre suelo mojado.

Sin embargo, algo sigue inquietando a Alex Hayes, quien es un científico planetario del equipo de radar de la misión Cassini, en la Universidad Cornell.

“Pero si Titán es tan húmeda”, se pregunta, “¿dónde están las olas?”

Aquí en la Tierra, los cuerpos de agua raramente están quietos. La brisa que sopla sobre sus superficies causa la formación de olas, que se levantan y rompen; las gotas de lluvia que caen sobre la superficie de los mares también proveen oleaje. Y, sin embargo, de acuerdo con los datos proporcionados por la sonda Cassini, en Titán los lagos están bizarramente quietos, sin acción del oleaje notoria hasta escalas milimétricas.

“Sabemos que hay viento en Titán”, dice Hayes. “Las magníficas dunas de arena en la luna son la prueba”.

Añada a esto la baja gravedad de Titán (apenas un séptimo de la de la Tierra) que ofrece muy poca resistencia al movimiento de las olas, y entonces se tiene un verdadero rompecabezas.

Los investigadores han jugado con varias posibles explicaciones. Tal vez los lagos están congelados. Hayes piensa, sin embargo, que esto es poco probable “debido a que hemos visto evidencia de precipitaciones pluviales y temperaturas en la superficie, las cuales se encuentran muy por encima del punto de fusión del metano”. O tal vez los lagos están cubiertos por una sustancia parecida a la brea, que apacigua el oleaje. “No podemos descartar eso todavía”, añade.

La respuesta podría estar en los resultados de un estudio que Hayes y sus colaboradores publicaron en la edición electrónica, de julio de 2013, de la revista científica Icarus. Teniendo en cuenta la gravedad de Titán, la baja viscosidad de los hidrocarburos líquidos, la densidad de la atmósfera de Titán y otros factores, ellos calcularon qué tan rápidamente debería soplar el viento en Titán para levantar olas: el resultado es que una brisa muy leve, de apenas 1,7 a 3,5 km por hora (1 a 2 millas por hora) podría ser suficiente.

Y esto es lo que sugiere una tercera posibilidad: los vientos no han soplado lo suficientemente fuerte. Desde que Cassini llegó a Saturno, en 2004, el hemisferio norte de Titán (donde se encuentran la mayoría de los lagos) ha estado bajo el yugo del invierno. El aire frío y pesado apenas se mueve, así que mucho menos alcanza el umbral necesario para formar olas.

Pero ahora viene el cambio de estación. En agosto del año 2009, el Sol cruzó el ecuador de Titán, moviéndose hacia el norte. Ya se aproxima el verano, trayendo consigo luz, calor y vientos a la zona de los lagos de Titán.

“De acuerdo con los modelos climáticos, los vientos deberán incrementarse conforme se aproxime el solsticio, en 2017, y deberían ser lo suficientemente fuertes como para levantar olas”, dice el científico.

Si las olas aparecen, la sonda Cassini deberá ser capaz de detectarlas. Los pulsos reflejados de radar que provienen de superficies con oleaje pueden decir muchas cosas a los investigadores. Las dimensiones de las olas, por ejemplo, podrían revelar la viscosidad del líquido que yace a mayor profundidad y, por lo tanto, su composición química. También, la rapidez de las olas podría ayudar a dar seguimiento a los cambios de velocidad de los vientos que soplan sobre ellas, dando de esta manera una medición independiente de los modelos climáticos de Titán.

Fuente: NASA

Ago

19

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (3)

Comments (3)

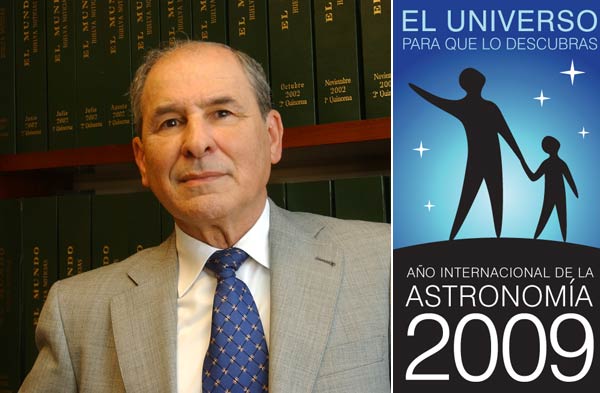

Lo cierto es que, en su momento, ya desde el inicio del año 2.009 en el que se celebró el Año Internacional de la Astronomía, en muchos de mis artículos publicados en la colaboración que con la Organización Internacioón tuve el honor de prestar, se hablaba de todos esos interesantes temas que, el universo nos presenta y que, inciden en el saber de la Naturaleza y del Mundo que nos acoge que, como nosotros… ¡También es Universo!

LA QUÍMICA DE LAS ESTRELLAS

Los cambios se estaban produciendo a una velocidad cada vez mayor. Al siglo de Newton también pertenecieron, entre otros, el matemático Fermat; Römer, quien midió la velocidad de la luz; Grimaldi, que estudió la difracción; Torricelli, que demostró la existencia del vacío; Pascal y Boyle, que definieron la física de los fluidos…La precisión de los telescopios y los relojes aumentó notablemente, y con ella el número de astrónomos deseosos de establecer con exactitud la posición de las estrellas y compilar catálogos estelares cada vez más completos para comprender la Vía Láctea.

La naturaleza de los cuerpos celestes quedaba fuera de su interés: aunque se pudiera determinar la forma, la distancia, las dimensiones y los movimientos de los objetos celestes, comprender su composición no estaba a su alcance. A principios del siglo XIX, William Herschel (1738-1822), dedujo la forma de la Galaxia, construyó el mayor telescopio del mundo y descubrió Urano. Creía firmemente que el Sol estaba habitado.

Hasta llegar a conocer nuestra situación astronómica…

Al cabo de pocos años, nacía la Astrofísica, que a diferencia de la Astronomía (ya llamada -“clásica o de posición”-), se basaba en pruebas de laboratorio. Comparando la luz emitida por sustancias incandescentes con la recogida de las estrellas se sentaban las bases de lo imposible: descubrir la composición química y la estructura y el funcionamiento de los cuerpos celestes. Estaba mal vista por los astrónomos “serios” y se desarrolló gracias a físicos y químicos que inventaron nuevos instrumentos de análisis a partir de las demostraciones de Newton sobre la estructura de la luz.

En 1814, Joseph Fraunhofer (1787-1826) realizó observaciones básicas sobre las líneas que Wollaston había visto en el espectro solar: sumaban más de 600 y eran iguales a las de los espectros de la Luna y de los planetas; también los espectros de Póux, Capella y Porción son muy similares, mientras que los de Sirio y Cástor no lo son. Al perfeccionar el espectroscopio con la invención de la retícula de difracción (más potente y versátil que el prisma de cristal), Fraunhofer observó en el espectro solar las dos líneas del sodio: así se inició el análisis espectral de las fuentes celestes.

Mientras, en el laboratorio, John Herschel observó por primera vez la equivalencia entre los cuerpos y las sustancias que los producen, Anders J. Anhström (1814-1868) describía el espectro de los gases incandescentes y los espectros de absorción y Jean Foucault (1819-1874) comparó los espectros de laboratorio y los de fuentes celestes. Gustav Kirchhoff (1824-1887) formalizó las observaciones en una sencilla ley que cambió la forma de estudiar el cielo; “La relación entre el poder de emisión y de absorción para una longitud de onda igual es constante en todos los cuerpos que se hallan a la misma temperatura”. En 1859, esta ley empírica, que relacionaba la exploración del cielo con la física atómica, permitía penetrar en la química y la estructura de los cuerpos celestes y las estrellas. De hecho, basta el espectro de una estrella para conocer su composición. Y, con la espectroscopia, Kirchhoff y Robert Bunsen (1811-1899) demostraron que en el Sol había muchos metales.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado. La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

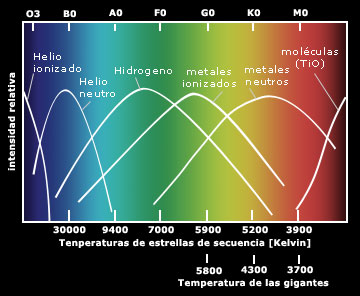

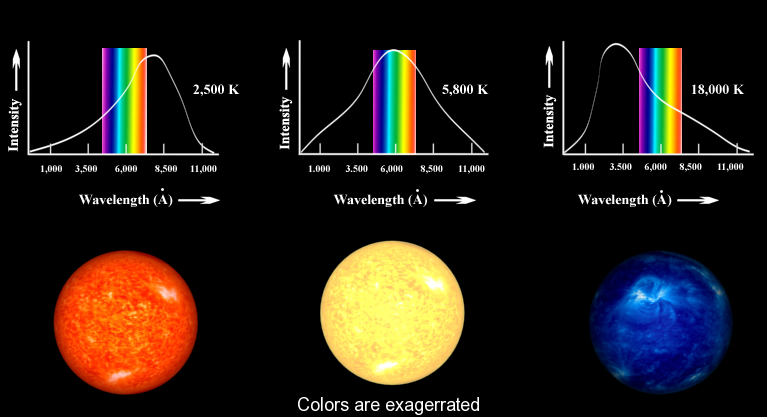

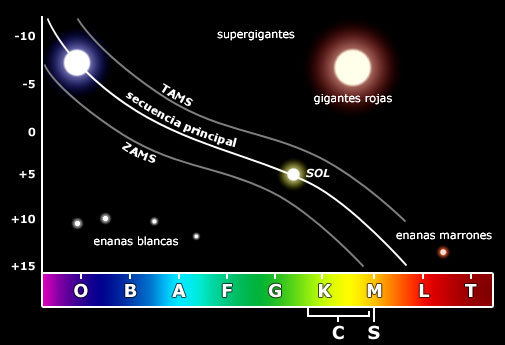

EL DIAGRAMA HR: EL CAMINO HACIA EL FUTURO

El padre Ángelo Secchi (1818-1878) fue el primero en afirmar que muchos espectros estelares poseen características comunes, una afirmación refrendada hoy día con abundantes datos. Secchi clasificó las estrellas en cinco tipos, en función del aspecto general de los espectros. La teoría elegida era correcta: el paso del color blanco azulado al rojo oscuro indica una progresiva disminución de la temperatura, y la temperatura es el parámetro principal que determina la apariencia de un espectro estelar.

Más tarde, otros descubrimientos permitieron avanzar en Astrofísica: Johan Balmer (1825-1898) demostró que la regularidad en las longitudes de onda de las líneas del espectro del hidrógeno podía resumirse en una sencilla expresión matemática; Pieter Zeeman (1865-1943) descubrió que un campo magnético de intensidad relativa influye en las líneas espectrales de una fuente subdividiéndolas en un número de líneas proporcional a su intensidad, parámetro que nos permite medir los campos magnéticos de las estrellas.

En otros descubrimientos empíricos la teoría surgió tras comprender la estructura del átomo, del núcleo atómico y de las partículas elementales. Los datos recogidos se acumularon hasta que la física y la química dispusieron de instrumentos suficientes para elaborar hipótesis y teorías exhaustivas. Gracias a dichos progresos pudimos asistir a asociaciones como Faraday y su concepto de “campo” como “estado” del espacio en torno a una “fuente”; Mendeleiev y su tabla de elementos químicos; Maxwell y su teoría electromagnética; Becquerel y su descubrimiento de la radiactividad; las investigaciones de Pierre y Marie Curie; Rutherford y Soddy y sus experimentos con los rayos Alfa, Beta y Gamma; y los estudios sobre el cuerpo negro que condujeron a Planck a determinar su constante universal; Einstein y su trabajo sobre la cuantización de la energía para explicar el efecto fotoeléctrico, Bohr y su modelo cuántico del átomo; la teoría de la relatividad especial de Einstein que relaciona la masa con la energía en una ecuación simple…Todos fueron descubrimientos que permitieron explicar la energía estelar y la vida de las estrellas, elaborar una escala de tiempos mucho más amplia de lo que jamás se había imaginado y elaborar hipótesis sobre la evolución del Universo.

En 1911, Ejnar Hertzsprung (1873-1967) realizó un gráfico en el que comparaba el “color” con las “magnitudes absolutas” de las estrellas y dedujo la relación entre ambos parámetros. En 1913, Henry Russell (1877-1957) realizó otro gráfico usando la clase espectral en lugar del color y llegó a idénticas conclusiones.

El Diagrama de Hertzsprung-Russell (diagrama HR) indica que el color, es decir, la temperatura, y el espectro están relacionados, así como el tipo espectral está ligado a la luminosidad. Y debido a que esta también depende de las dimensiones de la estrella, a partir de los espectros puede extraerse información precisa sobre las dimensiones reales de las estrellas observadas. Ya solo faltaba una explicación de causa-efecto que relacionara las observaciones entre si en un cuadro general de las leyes.

El progreso de la física y de la química resolvió esta situación, pues, entre otros avances, los cálculos del modelo atómico de Bohr reprodujeron las frecuencias de las líneas del hidrógeno de Balmer. Por fin, la Astrofísica había dado con la clave interpretativa de los espectros, y las energías de unión atómica podían explicar el origen de la radiación estelar, así como la razón de la enorme energía producida por el Sol.

Las líneas espectrales dependen del número de átomos que las generan, de la temperatura del gas, su presión, la composición química y el estado de ionización. De esta forma pueden determinarse la presencia relativa de los elementos en las atmósferas estelares, método que hoy también permite hallar diferencias químicas muy pequeñas, relacionadas con las edades de las estrellas. Así, se descubrió que la composición química de las estrellas era casi uniforme: 90 por ciento de hidrógeno y 9 por ciento de helio (en masa, 71% y 27%, respectivamente). El resto se compone de todos los elementos conocidos en la Tierra.

Así mismo, el desarrollo de la Física ha permitido perfeccionar los modelos teóricos y explicare de forma coherente que es y como funciona una estrella. Dichos modelos sugirieron nuevas observaciones con las que se descubrieron tipos de estrellas desconocidas: las novas, las supernovas, los púlsares con periodos o tiempos que separan los pulsos, muy breves…También se descubrió que las estrellas evolucionan, que se forman grupos que luego se disgregan por las fuerzas de marea galácticas.

La Radioastronomía, una nueva rama de la Astronomía, aportó más datos sobre nuestra Galaxia, permitió reconstruir la estructura de la Vía Láctea y superar los límites de la Astronomía óptica.

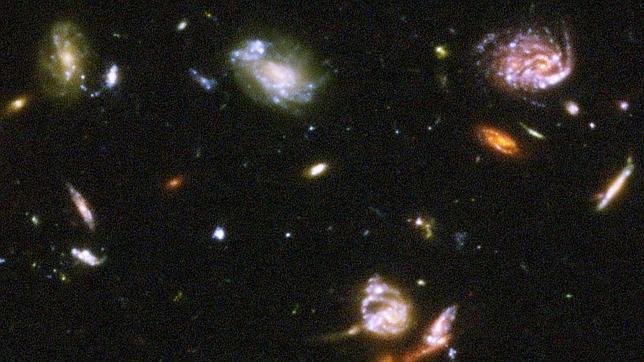

Se estaban abriendo nuevos campos de estudio: los cuerpos galácticos, los cúmulos globulares, las nebulosas, los movimientos de la galaxia y sus características se estudiaron con ayuda de instrumentos cada vez más sofisticados. Y cuanto más se observaba más numerosos eran los objetos desconocidos descubiertos y más profusas las preguntas. Se descubrieron nuevos y distintos tipos de galaxias fuera de la nuestra; examinando el efecto Doppler, se supo que todas se alejaban de nosotros y, lo que es más, que cuanto más lejanas están más rápidamente se alejan.

El Telescopio Hubble nos muestra esta imagen del Universo Profundo

Acabábamos de descubrir que el Universo no terminaba en los límites de la Vía Láctea, sino que se había ampliado hasta el “infinito”, con galaxias y objetos cada vez más extraños. Sólo en el horizonte del Hubble se contabilizan 500 millones de galaxias. Y los descubrimientos continúan: desde el centro galáctico se observa un chorro de materia que se eleva más de 3.000 a.l. perpendicular al plano galáctico; se observan objetos como Alfa Cygni, que emite una energía radial equivalente a diez millones de veces la emitida por una galaxia como Andrómeda; se estudian los cuásares, que a veces parecen mas cercanos de lo que sugieren las mediciones del efecto Doppler; se habla de efectos de perspectiva que podrían falsear las conclusiones… Y nos asalta una batería de hipótesis, observaciones, nuevas hipótesis, nuevas observaciones, dudas…

Todavía no se ha hallado una respuesta cierta y global. Un número cada vez mayor de investigadores está buscándola en miles de direcciones. De esta forma se elaboran nuevos modelos de estrellas, galaxias y objetos celestes que quizá sólo la fantasía matemática de los investigadores consiga concretar: nacen los agujeros negros, los universos de espuma, las cadenas…

Encontrsar Grafeno en el espacio ya no es una sorpresa, toparnos de bruces con océanos de metano… ¡tampoco!, hallar colonias de bacterias vivienda a muchos kilómetros de altura no es una niovedad, saber que en las estrellas se fabrican los materiales aptos para hacer posible la química de la vida… nos maravilla pero ya, no es causa de asombro. Cada día damos un paso más hacia el saber del “mundo”, de la Naturaleza, del Universo en fin.

En la actualidad, el número de investigadores centrados en problemas relacionados con la evolución estelar, la Astrofísica y las teorías cosmogenéticas es tan elevado que ya no tiene sentido hablar de uno en particular, ni de un único hilo de investigación. Al igual que ocurre con otras ramas científicas las Astronomía se ha convertido en un trabajo de equipo a escala internacional que avanza sin cesar en una concatenación de innovaciones, inventos, nuevos instrumentos, interpretaciones cada vez más elaboradas y, a menudo más difíciles de entender incluso para los investigadores que avanzan con infinidad de caminos paralelos. Es una situación que ya vaticinaba Bacon en tiempos de Galileo.

Hasta la Astronomía se ha hiperespecializado y, por ejemplo, quienes estudian problemas particulares de la física de las estrellas pueden desconocerlo todo sobre planetas y galaxias. También el lenguaje es cada vez más técnico, y los términos, capaces de resumir itinerarios de investigación, son complejos de traducir al lenguaje común. Así, mientras la divulgación avanza a duras penas entre una jungla de similitudes y silogismos, las informaciones que proceden de otras disciplinas son aceptadas por los científicos y los resultados de cada cual se convierten en instrumentos para todos.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado. La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

Las investigaciones sobre planetas, estrellas, materia interestelar, galaxias y Universo van paralelas, como si fueran disciplinas independientes, pero en continua osmosis. Y mientras la información sobre el Sol y los cuerpos del Sistema solar es más completa, detallada y fiable, y las hipótesis sobre nuestra Galaxia hallan confirmación, el Universo que empezamos a distinguir más allá de nuestros limites no se pareced a lo que hace un siglo se daba por sentado. Y mientras los modelos matemáticos dibujan uno o mil universos cada más abstractos y complejos, que tienen más que ver con la filosofía que con la observación, vale la pena recordar como empezó nuestro conocimiento hace miles de años.

Otros nos indicaron la dirección a seguir pero, la dureza del camino…, esa, la tuvimos que hacer nosotros. Es decir, en cada época y lugar, los que estuvieron, miraron hacia atrás para ver lo que hicieron sus ancestros y, con aquellas enseñanzas, tener la guía del camino a seguir, o, por el contrario, si los resultados no fueron biuenos, rechazarlos. Lo cierto es que, al igual que nosotros, los que vengan detrás partirán con alguna ventaja aunque tengan que hacer su propio recorrido que, ni mucho menos tienen el camino despejado y, la niebla d ela ignorancia sigue siendo espesa, auunque algo más suave que la que nosotros nos encontramos.

Ahora, amigos, después de este breve repaso por una pequeña parte de la Historia de la Astronomía, al menos tendréis una idea más cercana del recorrido que, la Humanidad, ha tenido que realizar para conocer mejor el Universo.

Los datos aquí reseñados tienen su origen en diversas fuentes que, de aquí y de allá, han sido tomadas para recomponer un mensaje que les lleve a todos algunos mensajes de como ocurrieron los acontecimientos en el pasado para que fuera posible nuestro presente.

emilio silvera

Ago

19

Partículas “bellas” de materia y antimateria

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

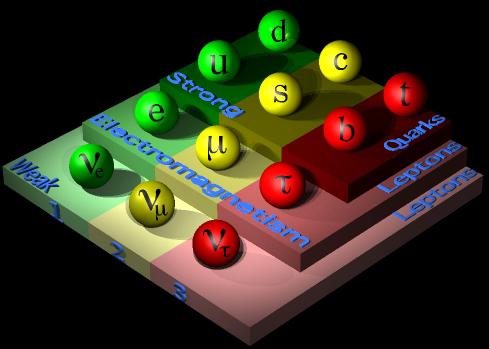

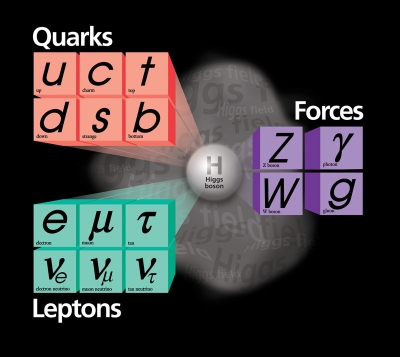

¿Cuántas generaciones de partículas existen? El modelo estándar no predice el número de generaciones de fermiones (quarks y leptones). Hoy conocemos tres generaciones, pero podrían existir más. Una cuarta generación dentro del modelo estándar estaría formada por dos quarks pesados y

y dos leptones pesados

y

. Cualquier otra opción implicaría física más allá del modelo estándar. En este caso SM4 sustituiría a SM3, como SM3 sustituyó a SM2 en los 1970. (Fuente Francis (th)E mule Science’s News).

Pero hablemos de partículas “bellas” de materia y antimateria. Así se titula un magnifico artículo de Don Alberto Ruiz Jimeno, miembro del Grupo de Altas Energías del Instituto de Física Moderna Universidad de Cantabria y Jefe del Grupo de Altas Energías. En él nos dice que:

El resultado procede del análisis de CDF de miles de millones de colisiones de protones y antiprotones producidos en el colisionador Tevatron del Fermilab. De acuerdo con la Teoría de la Relatividad de Einstein, energía es igual a masa, por lo que esas colisiones de alta energía pueden lanzar a la existencia a partículas subatómicas masivas no vistas en nuestro mundo cotidiano. Los físicos intentan entonces identificar esas partículas estudiando las combinaciones de partículas más familiares en las que decaen.

“Nuevos bariones constituidos por tres Quarks, como los protones, pero conteniendo el quarks b (“belleza”) han sido observado en el experimento CDF del Acelerador del Tevatrón de protones y antiprotones. Por otra parte (nos dice), se ha observado por primera vez la oscilación de los mesones B, entre materia y antimateria. Dado que el artículo puede tener un alto interés para ustedes, he creído positivo transcribirlo aquí para gozo del personal que, con estos nuevos conocimientos (como me pasó a mí), podrán aumentar los suyos.

La física de partículas elementales tiene por objeto el estudio de los constituyentes más elementales de la materia y de las fuerzas fundamentales que rigen su comportamiento. La dinámica de estos bloques fundamentales viene formulada por la mecánica cuántica relativista.

El denominado Modelo Estándar establece que los bloques elementales de la materia tienen un momento magnético intrínseco (spín) de valor ½, denominándose fermiones por verificar las leyes de la estadística cuántica que formularon Fermi y Dirac a comienzos del siglo XX. A su vez, las fuerzas fundamentales vienen determinadas por el intercambio de cuantos de energía, con spin 1 (salvo el hipotético gravitón que tendría spin 2), llamado bosones al verificar las leyes estadísticas cuántica establecidas por Bose y Einstein, en el mismo siglo XX.

Los Bosones de interacción son el fotón, causante de la interacción electromagnética; los bosones vectoriales W+, W– y Z0, causantes de la interacción nuclear débil; los ocho tipos de Gluones que confinan a los Quarks en hadrones (como el protón o el neutrón) a causa de la interacción fuerte nuclear, y el gravitón u onda gravitacional que explicaría la interacción gravitatoria. La fuerza gravitacional es despreciable a escala subatómica, pero es la dominante a grandes escalas. Su portador aún no ha sido observado; de hecho, su existencia requeriría una teoría cuántica de la gravitación, que aún no ha sido formulada.

Los fermiones de materia se denominan quarks o leptones, siendo los primeros los que están sometidos a los cuatro tipos de interacciones y los segundos los que no están sometidos a la interacción nuclear fuerte; en cualquiera de los casos, la interacción electromagnética solo afecta a las partículas que poseen carga eléctrica y la interacción gravitatoria a las que poseen masa.

Los quarks son de seis tipos o sabores, así como los leptones. Unos y otros se clasifican en familias o generaciones, siendo la más ligera la constituida por los quarks y los leptones electrón y neutrino electrónico. Los nucleones, protón y neutrón, tienen la estructura de quarks, respectivamente uud y udd. Los átomos tienen un núcleo interno constituido por nucleones y electrones orbitando en torno al mismo.

El resto de quarks y leptones constituyen materia exótica, siendo producidos en los aceleradores de partículas y en la radiación cósmica, pero formaban parte de la materia original del Universo primitivo. Los quarks pueden tener, además, tres tipos de carga fuerte o “color”.

Además existen otros doce sabores correspondientes a la antimateria, en forma de anti-quarks y anti-leptones, con las mismas masas que los quarks y leptones correspondientes, pero con sus cargas invertidas. No se ha observado antimateria en el Universo actual, pero el Universo primigenio tenía igual cantidad de materia que de antimateria. Toda la antimateria actual es producida en los choques de partículas aceleradas, como consecuencia de la transformación de energía en pares materia-antimateria.

La ecuación cuántica relativista que gobierna el comportamiento de los fermiones es la ecuación de Dirac, debida al famoso físico inglés. Las soluciones de dicha ecuación incluyen las denominadas partículas de antimateria, que poseen la misma masa que la partícula correspondiente, pero tienen todas sus “cargas” internas, como la carga eléctrica, con el signo opuesto. Así por cada quark tenemos un antiquark y por cada leptón un antileptón. Cuando un fermión y su correspondiente antifermión se encuentran se aniquilan mutuamente, convirtiéndose en energía y, a la viceversa, si tenemos energía superior a la suma de las masas de fermión y antifermión, puede convertirse en un par fermión-antifermión.

El 7 de agosto de 1912, el físico austriaco Victor Franz Hess descubrió esta potentísima fuente de energía llegada del espacio, lo que años después le supuso el premio Nobel ABC.ES / MADRID V.F. SOCIETY Víctor F. Hess, en un globo entre 1911 y 1912.

La historia de la Física de Partículas debe mucho al descubrimiento de los rayos cósmicos, realizada por el físico austríaco Francis Hess, en 1912, y apodados como tales por el físico americano Robert Millikan, en 1925. Los experimentos de Hess, utilizando globos aerostáticos, concluyeron que la cantidad de radiación crecía por encima de los 2000 metros de altura y la fuente de los mismos eran el Sol y otras fuentes procedentes del firmamento.

A partir de esa fecha y hasta mediados del siglo XX, gracias a los experimentos con rayos cósmicos, el número de tipos diferentes de partículas observadas, que previamente se reducían al protón y el electrón, se multiplicó, creándose un auténtico caos que obligó a pensar en esquemas de clasificación de las mismas.

Esquema de un sincrotrón

El sincrotrón es un tipo deacelerador de partículas. Se diferencia de otros aceleradores en que las partículas se mantienen en una órbita cerrada. Los primeros sincrotrones se derivaron del ciclotron. que usa un campo magnético constante para curvar la trayectoria de las partículas, aceleradas mediante un campo eléctrico también constante, mientras que en el sincrotrón ambos campos varían. La velocidad máxima a la que las partículas se pueden acelerar está dada por el punto en que la radiación sincrotrón emitida por las partículas al girar es igual a la energía suministrada. Los sincrotrones también se utilizan para mantener las partículas circulando a una energía fija; en este casos reciben el nombre de «anillos de almacenamiento».

En 1947, los físicos del Laboratorio Lawrence Berkeley, de California, construyeron el primer gran acelerador, un ciclotrón, comenzando la era de los grandes aceleradores de partículas, que continuaron descubriendo nuevos tipos de las mismas, de modo que, en 1960, había cientos de tipos de partículas observadas, sin que hubiera, aún, un esquema de clasificación adecuado. Este fue desarrollado durante la década de 1960, en la que el análisis de las colisiones de partículas, y las propiedades de los diferentes tipos de interacción observadas, establecieron la base para la construcción del Modelo Estándar.

Sí, las fuerzas fundamentales, o, interaciones… ¡Están presentes en todas partes por el Universo! Son las que marcan el ritmo

Las leyes que rigen el comportamiento de las interacciones fundamentales y sus propiedades de simetría permitieron establecer un marco de clasificación de los hadrones (partículas compuestas por quarks, como es el caso del protón) que pueden ser de dos tipos: Bariones, si en su constitución tenemos tres quarks, o mesones, si si están constituidos de un quark y un antiquark.

En realidad, la dinámica de los hadrones está determinada, esencialmente, por la interacción nuclear fuerte, de modo que los quarks constituyentes son los quarks de “valencia”, en analogía con los electrones de valencia de los átomos (los que fijan sus propiedasdes químicas). En la dinámica de la interacción fuerte nuclear hay un continuo intercambio de Gluones entre los quarks y reacciones de producción y aniliquilación de quarks y antiquarks mediante Gluones.

Esta dinámica es debida a la existencia de una propiedad intrínseca de los quarks que denominamos “color”, que es intercambiada en las reacciones de Quarks y Gluones. Los hadrones son, globalmente, neutros de color (como los átomos son neutros de carga eléctrica) y es tan fuerte y característica la interacción que los quarks están confinados en unas dimensiones especiales inferiores al tamaño de los núcleos de los átomos, siendo paradójicamente casi libres en el interior de los hadrones (libertad asintótica de los quarks).

La fuerza nuclear fuerte es la más potente de la Naturaleza y mantiene el núcleo de los átomos unidos

El Modelo Estándar ha sido comprobado desde su desarrollo formal, a mediados de 1960, y sus parámetros han sido medidos con extraordinaria precisión, gracias al desarrollo de experimentos muy potentes, entre los que destacan los realizados en el acelerador LEP (“Large Electrón Positrón”) del CERN ( Centro Europeo de Física de Partículas, en Ginebra), durante la última década del siglo XX, y del Tevatrón del Laboratorio Fermilab (Chicago, USA), aún en funcionamiento.

A continuación viene una referencia al LHC que, a estas alturas está sobrepasada por conocer todos nosotros lo que ha pasó en su inauguración y sus primeras pruebas. Así que, no me parece oportuno plasmar aquí esa referencia que conoceremos de primera mano cuando sucedieron los hechos y toda la prensa los publicó.

emilio silvera

Ago

19

Nuevos materiales, nuevos procesos, nuevos dispositivos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

En los últimos años se han desarrollado materiales que, debido a su estructura nanométrica, presentan nuevas propiedades, y por tanto tienen aplicaciones en campos tan diversos como son la transmisión de información mediante luz, el almacenamiento de datos, la generación y el transporte de energía eléctrica, la síntesis de catalizadores, la elaboración de textiles más resistentes, o la implantación de nuevos implantes óseos.

El gran número de nuevos materiales y dispositivos demostradores que se han desarrollado en estos años ha sido fruto, por un lado del desarrollo de sofisticadas técnicas de síntesis, caracterización y manipulación que se han puesto a punto y, por otro, del gran avance en los métodos de computación en la nanoescala (técnicas ab-initio, dinámica molecular, etc.) que se han probado en las grandes instalaciones dedicadas al cálculo científico de altas prestaciones. Es precisamente la combinación de experimentos punteros con métodos teóricos precisos un elemento esencial para comprender un gran número de procesos y mecanismos que operan en la nanoescala. En concreto, una de las aportaciones teóricas más importantes al desarrollo de la Nanotecnología ha llegado de la mano de la Teoría de Funcionales de la Densidad (DFT, en sus siglas en inglés) por la que en 1998 Walter Kohn recibió el Premio Nobel en Química, compartido con John A. Pople, “padre” de la Química Cuántica. Con respecto al desarrollo experimental, cabe resaltar el alto grado de desarrollo de las técnicas SPM para ver y manipular la materia a escala nanométrica en multitud de ambientes diferentes (ultra alto vacío, humedad controlada, celdas catalíticas, temperaturas variables,…). Esta capacidad nos ha permitido diseñar nuevos experimentos con los que comprender el comportamiento de nuevos materiales y dispositivos. Dado la gran variedad de materiales y sus aplicaciones, es imposible en un artículo presentar una visión completa de la situación de la Nanotecnología, por lo que nos vamos a limitar a presentar algunos ejemplos que ilustran el estado actual de este campo.

Hacia la electrónica molecular

Debido a su tamaño nanométrico, las estructuras moleculares pueden poner de manifiesto nuevas propiedades electrónicas. Sin embargo, la necesidad de poder producir estructuras nanométricas de forma masiva, tal y como requieren las aplicaciones industriales hace que la manipulación individual de nano-objetos como las moléculas pase a un segundo plano, requiriéndose alternativas más útiles para incorporar la Nanotecnología a los procesos de fabricación. Por esta razón, en los últimos años se están estudiando profusamente las condiciones de formación y las propiedades de capas autoensambladas de diferentes moléculas orgánicas sobre superficies. En estos casos la superficie no sólo proporciona un soporte, sino que posee un papel activo en la formación de diferentes patrones moleculares en dos dimensiones. Así, la posibilidad de generar sistemas autoensamblados de moléculas con propiedades bien definidas y dirigidas hacia la realización de funciones concretas abre un camino para cambiar desde el imperante paradigma del silicio en la electrónica hacia otro basado en la electrónica molecular. Este nuevo paradigma será mucho más rico por la gran diversidad de componentes moleculares que pueden entrar en juego. Entre los componentes prometedores para la Nanotecnología, que están relacionados con las moléculas orgánicas, y que habrá que tener en cuenta en el futuro de la microelectrónica, estarán los fullerenos, los nanotubos de carbono y el grafeno, de los que hablamos a continuación.

Los fullerenos o “bucky-balls”

Con este nombre se denomina al conjunto de distintas moléculas cerradas sobre sí mismas con formulación. El más conocido, por lo estable y abundante en naturaleza es el llamado Cn. El más conocido, por lo estable y abundante en la Naturaleza es el llamado C60, que está formado por 12 pentágonos y 20 exágonos, dispuestos como en un balón de futbol. Las aplicaciones Nanotecnológicas que se pueden derivar del uso de esta molécula están todavía en fase de estudio y son muy variadas. Sin embargo, aunque actualmente no existen aplicaciones concretas ya se han sintetizado más de mil nuevas moléculas basadas en fullereno y hay más de cien patentes internacionales registradas. El carácter rectificador de los fullerenos les hace atractivos para su uso en electrónica molecular.

La formación de este tipo de estructuras se produce más fácilmente de lo que podemos imaginar, pues son uno de los principales integrantes de la carbonilla y se generan abundantemente en cualquier combustión. Sin embargo, a día de hoy uno de los principales problemas para su utilización es el de conseguir una síntesis controlada de fullereno. Esto requiere complicadas técnicas, tales como la vaporización del grafito o la pirolisis láser, que normalmente producen exclusivamente los fullerenos más estables. Recientemente se ha propuesto un nuevo método para conseguirlo basado en principios “nano”. Se trata de partir de una molécula precursora sintetizada de forma tal que sea como un fullereno abierto, con los enlaces rotos saturados por hidrógeno. Esta molécula se puede plegar sobre sí misma mediante una transformación topológica de manera que de lugar a un fullereno. Se trata de partir de una estructura plana (un recortable) para posteriormente ensamblar un objeto en tres dimensiones. Este plegado se consigue mediante un proceso des-hidrogenación catalizada por una superficie. Una vez que la molécula plana ha perdido estos hidrógenos se cierran sobre sí misma de forma expontánea formando un fullereno.

Este proceso se ha podido seguir, entre otras técnicas, mediante imágenes de microscopía túnel in-situ. Los mecanismos existentes en el proceso se pueden entender gracias a los cálculos ab-initio que apoyan la investigación experimental. Esta combinación pone de manifiesto como una molécula plana de carbono sin hidrógeno se pliega expontáneamente. La belleza de este nuevo método de síntesis reside en que si se sintetizan moléculas precursoras planas con diferentes topologías se pueden conseguir moléculas cerradas de diferentes formas, tamaños e incluso que contengan átomos diferentes al Carbono. Así se ha sintetizado por primera vez la molécula C57 N3 sobre una superficie.

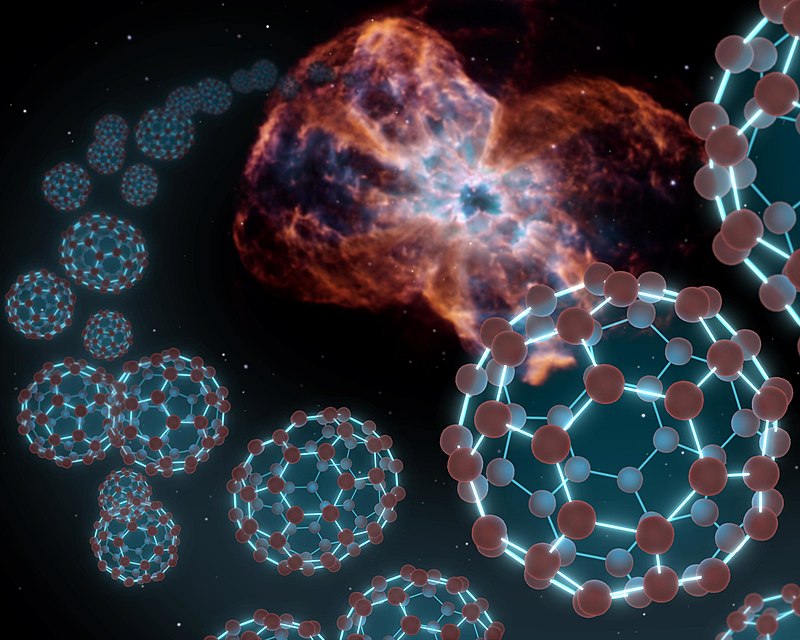

¡La Naturaleza! La NASA encontró fulerenos esféricos o buxkybolas en la nebulosa Tc1 a 6.000 años-luz. Posiblemente sean una de las moléculas más bellas que podamos encontrar, es una de las formas más estables del carbono, y sus 60 átomos se distribuyen formando 20 hexágonos y 12 pentágonos que ofrecen una forma idéntica al clásico balón de fútbol.

Nanotubos de Carbono

Si el descubrimiento del C60 fue un hito importante para la Nanotecnología, el de los llamados Nanotubos de Carbono lo ha superado con creces. Los Nanotubos de Carbono, unas diez mil veces más finos que un cabello, presentan excelentes propiedades físicas y su fabricación resulta relativamente económica. Un cable fabricado de Nanotubos de Carbono resultaría diez veces más ligero que uno de acero con el mismo diámetro pero sería ¡cien veces más resistente! A estas impresionantes propiedades mecánicas se le añaden unas interesantes propiedades eléctricas, puesto que pueden ser tanto conductores como aislantes, según la topología que presenten.

Un Nanotubo de Carbono se obtiene mediante el plegado sobre sí mismo de un plano atómico de grafito (enrollándolo). Según como se pliegue el plano grafítico se obtiene un Nanotubo que puede conducir la corriente eléctrica, ser semiconductor o ser aislante. En el primer caso, los Nanotubos de Carbono son muy buenos conductores a temperatura ambiente, pudiendo transportar elevadas densidades de corriente. En el segundo presentan propiedades rectificadoras. Por otra parte, si inducimos defectos en la estructura podemos generar moléculas semiconductoras y así formar diodos o transistores. Es decir, tenemos todos los elementos en nuestras manos para construir nanocircuitos basados en Carbono.

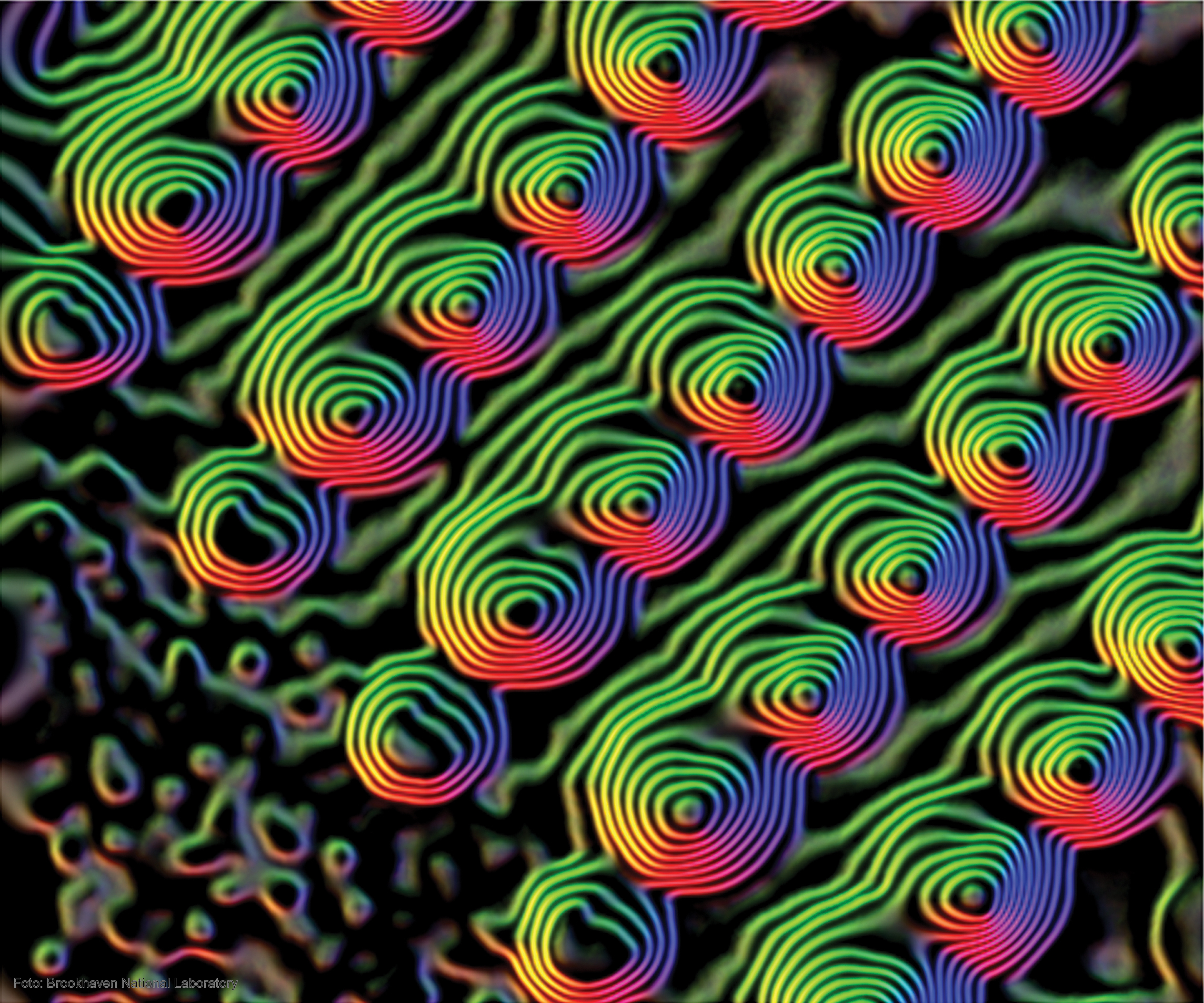

Grafeno

A un solo plano atómico de grafito se le llama grafeno, y éste, a diferencia del grafito, es difícil de obtener. Recientemente, mediante cálculos teóricos, se han realizado predicciones acerca de las importantes propiedades electrónicas que podría tener este material. Entre ellas una altísima movilidad electrónica y una baja resistividad, de manera que estos planos atómicos podrían ser los futuros sustitutos del silicio en los dispositivos electrónicos. Ahora bien, al día de hoy, estas propuestas provienen esencialmente de cálculos teóricos y, por tanto, antes de que el grafeno pase a sustituir al silicio en la electrónica del futuro, es necesario verificar las predicciones teóricas en el laboratorio. Actualmente, éste es un campo muy activo de investigación, y muchos grupos están trabajando en la obtención de capas de grafeno soportadas sobre diferentes materiales, como polímeros o aislantes, para poder determinar sus propiedades eléctricas y comprobar las predicciones teóricas.

El estudio de grafeno sobre metales de transición es un campo muy activo de investigación ya que las capas de grafeno crecen de manera fácil, muy controladas y con un bajo número de defectos sobre estas superficies. Además el grafeno sobre un substrato forma patrones conocidos como redes de Moiré, en las que la periodicidad atómica de las dos redes cristalinas (substrato y grafeno), coincide cada dos-tres nm, dando lugar a deformaciones de la capa de grafeno, que se reflejan como prominencias en la imagen STM.

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.

En el siguiente hablaremos de las Nanopartículas y la fuente de estos conocimientos aparece publicada en…

Editadas por la RSEF.

Publica: emilio silvera

Ago

19

Nuevos Materiales, nuevos procesos, nuevos dispositivos. II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Una investigación ha desarrollado una nueva estructura cuántica capaz de emitir fotones individuales de color rojo. El avance, que se publica en la revista Nature Materials, se basa en el confinamiento cuántico que se genera en cada uno de los puntos y que les permite modular la energía de la luz que emiten.

En este trabajo han participado investigadores de la Universidad de Zaragoza, el Institut de Recerca en Energia de Catalunya (IREC), la Universidad de Barcelona y del Instituto de Ciencia de Materiales de Barcelona del CSIC. El investigador Jordi Arbiol de este último explica:

“El resultado final son hilos unidimensionales, de tamaño nanométrico, compatibles con la tecnología electrónica actual, que permitirían crear dispositivos a mayor escala con un control total de la emisión de luz, fotón a fotón”.

Pero centrémonos en el trabajo que aquí se prenta hoy y que comienza hablando de los…

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.” Veamos que pasa con las Nanopartículas.

Nanopartículas

Quizás, junto a los nanotubos de carbono, las nanopartículas representan los materiales que tienen una repercución tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas representan los materiales que tienen una repercusión tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas, debido a su pequeño tamaño, pueden convertirse en diminutos dispositivos capaces de realizar otras funciones, como transportar un medicamento específico por el torrente sanguíneo sin obstruirlo. Para lograr esto, las nanopartículas deben ser el soporte de capas de moléculas autoensambladas que confieren una funcionalidad adicional a las mismas.

Como su propio nombre indica, el término “nanopartícula” designa una agrupación de átomos o moléculas que dan lugar a una partícula con dimensiones nanométricas. Es decir, que su tamaño está comprendido entre 1 y 100 nm. Dependiendo de cuáles sean los átomos o moléculas que se agrupan se originarán diferentes tipos de nanopartículas. Así, por ejemplo, tendremos nanopartículas de oro, de plata o nanopartículas magnéticas si están formadas por átomos de Fe o Co. Su pequeño tamaño hace que la relación superficie/volumen crezca y por tanto que estas estructuras tengan unas propiedades características y esencialmente distintas a las que presenta el material en volumen.

Una estrategia para la formación de nanopartículas es recubrirlas con distintas capas de manera tal que cada una aporte funcionalidades diferentes al sistema. Así, por ejemplo, recientemente se han descrito nanopartículas cuyo interior está formado por un material magnético, como el Co, seguido de una capa intermedia de SiO2 que aporta estabilidad al sistema y finalmente una superficie de oro.

El tamaño final de la nanopartícula es de 3 nm, y esta estructura laminar hace que tengan un núcleo magnético que posibilite su guiado, y una superficie de oro que facilite el autoensamblado de moléculas orgánicas o biológicas para diferentes aplicaciones. Entre éstas destaca su uso como biosensores. Para ello se inmoviliza material biológico, como ácido desoxirribonucleico (ADN) o el llamado ácido nucléico péptidico (PNA, del inglés peptide nucleic acid), que siendo un ácido nucléico artificial, presenta un “esqueleto” molecular formado por enlaces peptidicos y una estructura de bases nucleicas exactamente igual a la del ADN. El PNA puede reconocer cadenas complementarias de ADN, incluso con mayor eficiencia para la hibridación que la que representa el ADN para reconocer su hebra complementaria. Por este motivo, el PNA se ha propuesto como sonda para la fabricación de biosensores altamente eficientes. Estas macromoléculas unidas a superficies o nanopartículas son capaces de detectar diferentes analítos de interés, particularmente otars moléculas biológicas.

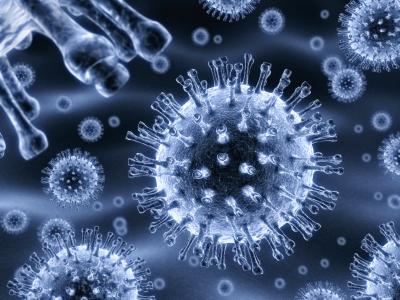

Sin embargo, el concepto de nanopartícula debe concebirse en un sentido más amplio ya que no sólo puede estar basada en un núcleo inorgánico, pudiéndose sintetizar nanopartículas poliméricas. Yendo un poco más allá una cápsida vírica puede entenderse como una nanopartícula formada por una carcasa proteica. Esta cápsida vírica tiene dimensiones nanométricas y, en muchos casos, burla con facilidad las membranas celulares. Por esta razón este tipo de “nanopartículas” se proponen para su uso en nanomedicina, y son el objeto de estudios básicos en los que las herramientas como los microscopios de fuerzas atómicas juegan un papel esencial. En particular, estas herramientas nos permiten caracterizar las propiedades mecánicas y las condiciones de ruptura de cápsidas víricas así como la forma en la que dichas cápsidas se comportan ante, por ejemplo, cambios controlados de humedad.

En un discurso recientemente impartido en la Universidad Europea de Madrid, William F. Clinton, ex-Presidente de los EE.UU, afirmó que ” el cometido del siglo XXI será salvar al mundo del cambio climático, regenerar la economía y crear empleo. El futuro más allá será la Nanotecnología y la biotecnología”. El propio W.F. Clinton fue el impulsor de la Iniciativa Nacional de Nanotecnología durante su mandato, convirtiendo durante los últimos 10 años a EE.UU en el líder mundial en la generación de conocimientos básicos y aplicados en el ámbito de la Nanotecnología.

Nadie pone en duda las afirmaciones de W.F. Clinton sobre el papel de la Nanotecnología en nuestro futuro a medio y largo plazo, por lo uqe es imperativo estar suficientemente preparados para construir este nuevo paradigma científico. En el caso concreto de España, las dos últimas ediciones del Plan Nacional de I+D+I han encumbrado las investigaciones en Nanociencia y Nanotecnología a la categoría de Acción Estratégica. En la actualidad se están poniendo en marcha varios centros dedicados a Nanotecnología. Dichas iniciativas son producto, por lo general, de costosos impulsos puntuales, locales, dirigidos por científicos con iniciativa, pero no son fruto de una actuación de conjunto, planificada siguiendo una estrategia quiada por unos objetivos ambiciosos, en los que impere la coordinación y el uso eficiente de los recursos. La actual coyuntura económica no invita al optimismo a este respecto, por lo que sería necesario poner en marcha iniciativas que promuevan la adquisición de infraestructuras, la formación de técnicos, la coordinación entre centros emergentes, etc.

Otro punto sobre el que no hay que descuidarse tiene que ver con la formación, en todos los niveles educativos, en Nanotecnología. En este sentido son numerosas las universidades españolas que ofrecen cursos de master y/o doctorado con contenidos relacionados con la Nanotecnología. Sin embargo, muchos de estos cursos tienen pocos estudiantes inscritos, al igual que ocurre con muchos estudios de grado relacionados con las ciencias básicas. La tarea de fascinar y atraer a nuestros jóvenes hacia la ciencia debe comenzar mucho antes. En este sentido, los conceptos inherentes a la Nanotecnología deben formar parte del conocimiento que debe llegar a los estudiantes de educación secundaria, como ocurre en países como Alemania, Finlandia, Taiwán, Japón, EE.UU., etc. Además, la Nanotecnología es una materia que causa cierta fascinación a los adolescentes por lo que puede ser un buen punto de partida para incentivar las vocaciones científicas. Esta ha sido una de las principales razones por las que los autores de este artículo junto con otros investigadores (Carlos Briones del Centro de Astrobiología y Elena Casero de la Universidad Autónoma de Madrid) accedieron a la petición de la Fundación Española de Ciencia y Tecnología (FECyT) para escribir una Unidad Didáctica de Ciencia y Tecnología. Dicho libro ya se encuentra en todos los institutos españoles de educación secundaria y bachillerato, y se puede descargar desde la web de la FECyT. Esperemos que esta pequeña contribución, junto con otras de mayor calado que deben promoverse desde las diversas administraciones públicas, permita tomar la senda que nos lleve a medio plazo hacia la tan ansiada sociedad basada en el conocimiento.

Fuente: Revista Española de Física. Volumen 23 Nº 4 de 2009

Los Autores:

D. José Ángel Martín Gago, del Instituto de Ciencia de Materiales de Madrid, Concejo Superior de Investigaciones científicas, Centro de Astrobiología /CSIC/INTA), Instituto Nacional de Técnica Aerpespacial, y, D. Pedro A. Serena Domingo, del Instituo de Ciencia y Materiales de Madrid y del Consejo Superior de Investigaciones Científicas.

Totales: 75.725.432

Totales: 75.725.432 Conectados: 61

Conectados: 61