Sep

10

¡El centro de las galaxias! Allí habitan inmensos agujeros negros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Agujeros negros ~

Clasificado en Agujeros negros ~

Comments (5)

Comments (5)

Inmensos chorros de radiación Gamma han sido descubiertos recientemente provenientes del Centro galáctico, que, como decimos más arriba, es un lugar de enorme turbulencias. Y, si todo eso es así (que lo es), nos podríamos plantear algunas preguntas: ¿Qué futuro nos espera? ¿Debemos preocuparnos de que el Agujero Negro Gigante que habita en el Centro de nuestra Galaxia engulla algún día la Tierra?

Bueno, no es difícil realizar algunos cálculos para saberlo. El agujero negro central de nuestra Galaxia (si es que finalmente existe y las observaciones realizadas por los astrónomos expertos coinciden con sus estimaciones) tiene una masa de alrededor 3 millones de veces la masa del Sol, y por lo tanto tiene una circunferencia de alrededor de 50 millones de kilómetros, o 200 segundos-luz, aproximadamente una décima parte de la circunferencia de la órbita de la Tierra en torno al Sol. Esto es algo minúsculo comparado con el tamaño de la propia Galaxia.

Nuestra Tierra, junto con el Sol y el conjunto de los demás planetas del Sistema planetario en el que estamos ubicados, está orbitando en torno al Centro de la Galaxia en una órbita con una circunferencia de 200.000 años-luz, alrededor de 30.000 millones de veces mayor que la circunferencia del agujero. Si el agujero llegara a engullir finalmente la mayor parte de la masa de la Galaxia, su circunferencia se expandiría sólo en aproximadamente 1 año-luz, todavía 200.000 veces más pequeño que la circunferencia de nuestra órbita.

Por supuesto, en los aproximadamente 10¹⁸ años (100 millones de veces la edad actual del Universo) que serían necesarios para que nuestro agujero negro central se tragase una gran fracción de la masa de nuestra Galaxia, la órbita de la Tierra y el Sol habría cambiado de forma substancial. No es posible predecir los detalles de dichos cambios, puesto que no conocemos suficientemente bien las posiciones y movimientos de todas las demás estrellas que pueden encontrar el Sol y la Tierra durante 10¹⁸ años.

Por lo tanto, no podemos predecir si la Tierra y el Sol se desviarían finalmente hacia el interior del Agujero Negro central de la Galaxia o si serán expulsados de la Galaxia. Sin embargo, podemos estar seguros de que, si la Tierra fuese finalmente engullida, su muerte está aproximadamente 10¹⁸ años en el futuro, tan lejanas que otras muchas catástrofes acabarán probablemente con la Tierra y la Humanidad mucho antes.

Sí, uno de esos probables sucesos ha sido estudiado y un grupo de investigadores de la NASA acaba de calcular cómo se producirá exactamente la titánica colisión entre la Vía Láctea, nuestra galaxia, y su vecina más cercana, Andrómeda. El acontecimiento, que tendrá lugar dentro de 4.000 millones de años, cambiará para siempre el aspecto del cielo y, de paso, la historia de nuestro Sol y su sistema de planetas. Estas conclusiones se publicaron en tres estudios diferentes en Astrophysical Journal.

La técnica de la interferometría de muy larga base a longitudes de onda milimétricas (mm-VLBI) ha permitido obtener imágenes de los motores centrales de las galaxias activas con una resolución angular de decenas de microsegundos de arco. Para aquellos objetos más cercanos (M87, SgrA) se obtienen resoluciones lineales del orden de las decenas de Radios de Schwarzschild, lo que permite estudiar con detalle único la vecindad de los agujeros negros supermasivos.

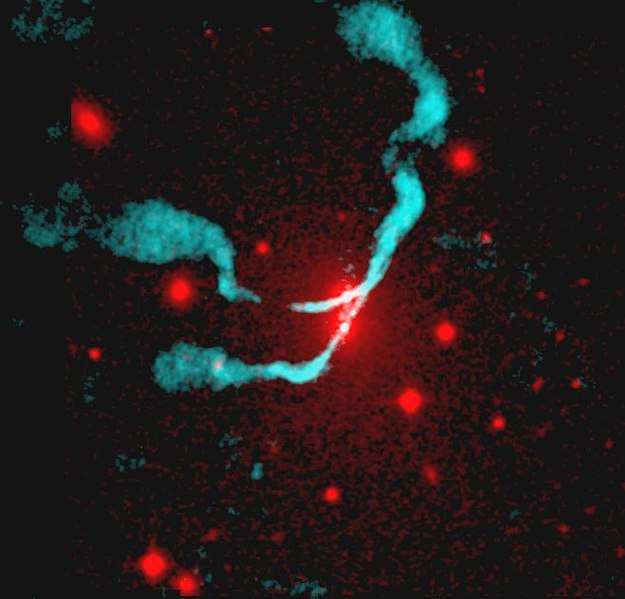

Radiogalaxia 3C 75 en longitud de onda visible y radiofrecuencia.

En el Universo existen objetos exóticos, de extraños comportamientos y que generan inemnsas energías. Por ejemplo, una radiogalaxia es un emisor inusualmente intenso de ondas de radio. La emisión de una radiogalaxias puede ser de hasta 1038 vatios, un millón de veces mayor que la de una galaxia normal como la nuestra. La radiogalaxia tienen un núcleo de radio compacto coincidente con el núcleo de la galaxia visible, un par de chorros que emergen del núcleo en direcciones opuestas, u un par de lóbulos lejos de los confines visibles de la galaxia. La galaxia resulta ser casi siempre una gigante elíptica, que pudiera ser el resultado de la colisión o la fusión de dos o más galaxias más pequeñas. La fuente de la energía de la radiogalaxia se sospecha que es un agujero negro masivo situado en el núcleo galáctico desde donde energen los chorros, enviando enegía a los lóbulos. Algunas radiogalaxias notables son la que arriba podeis contemplar, 3C 75.

Ahí podeís contemplar la misma imagen pero más nítida de la potente fuente de radio 3C 75 en la que parece que dos agujeros negros gigantes están girando el uno alrededor del otro para potenciar la gigantesca fuente de radio. Rodeados por el gas que emite rayos X a varios millones de grados y expulsando chorros de partículas relativistas, esos agujeros negros supermasivos que parecen estar juntos, en realidad, están separados por 25.000 años-luz. La imagen captada por los ingenios de la NASA, está situada en el cúmulo de galaxias Abell 400, se encuentran a unos 300 millones de años-luz de distancia. Los astrónomos dicen que estos dos agujeros negros supermasivos están irremediabklemente ligados por la gravedad y forman un sistema binario. Estas fusiones cósmicas espectaculares son objetos, según se cree, de intensas fuentes de ondas gravitacionales. El gas caliente sale dispado en chorros que corren a 1200 kilómetros por segundo.

¿Hasta que punto son comunes los agujeros negros gigantes? Los datos acumulados gradualmente y tomados cada vez con tecnologías más avanzadas y fiables, sugieren que tales agujeros habitan no sólo en los núcleos de la mayoría de los cuásares y radiogalaxias, sino también en los núcleos de la mayoría de las galaxias normales (no radiogalaxias) y galaxias grandes tales como la Vía Láctea y Andrómeda, e incluso en los núcleos de algunas pequeñas galaxias tales como la compañera enana de Andromeda, M32. En las galaxias normales como las nombradas, el agujero negro (en contra de lo que creen muchos) no está rodeado por ningún disco de acreción, o solamente lo está por un tenue disco quer derrama sólo cantidades modestas de energía.

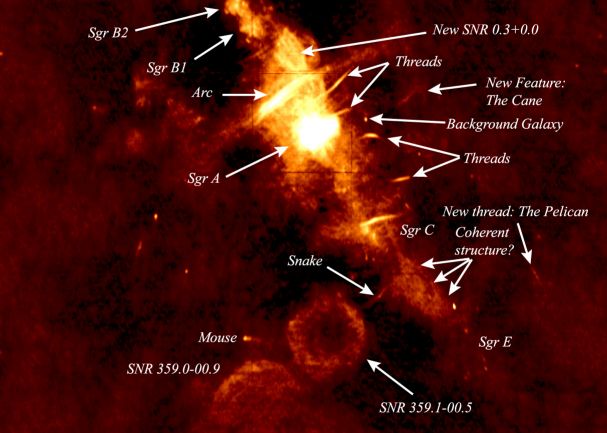

El centro de la Vía Láctea es un lugar misterioso y…, muy peligroso

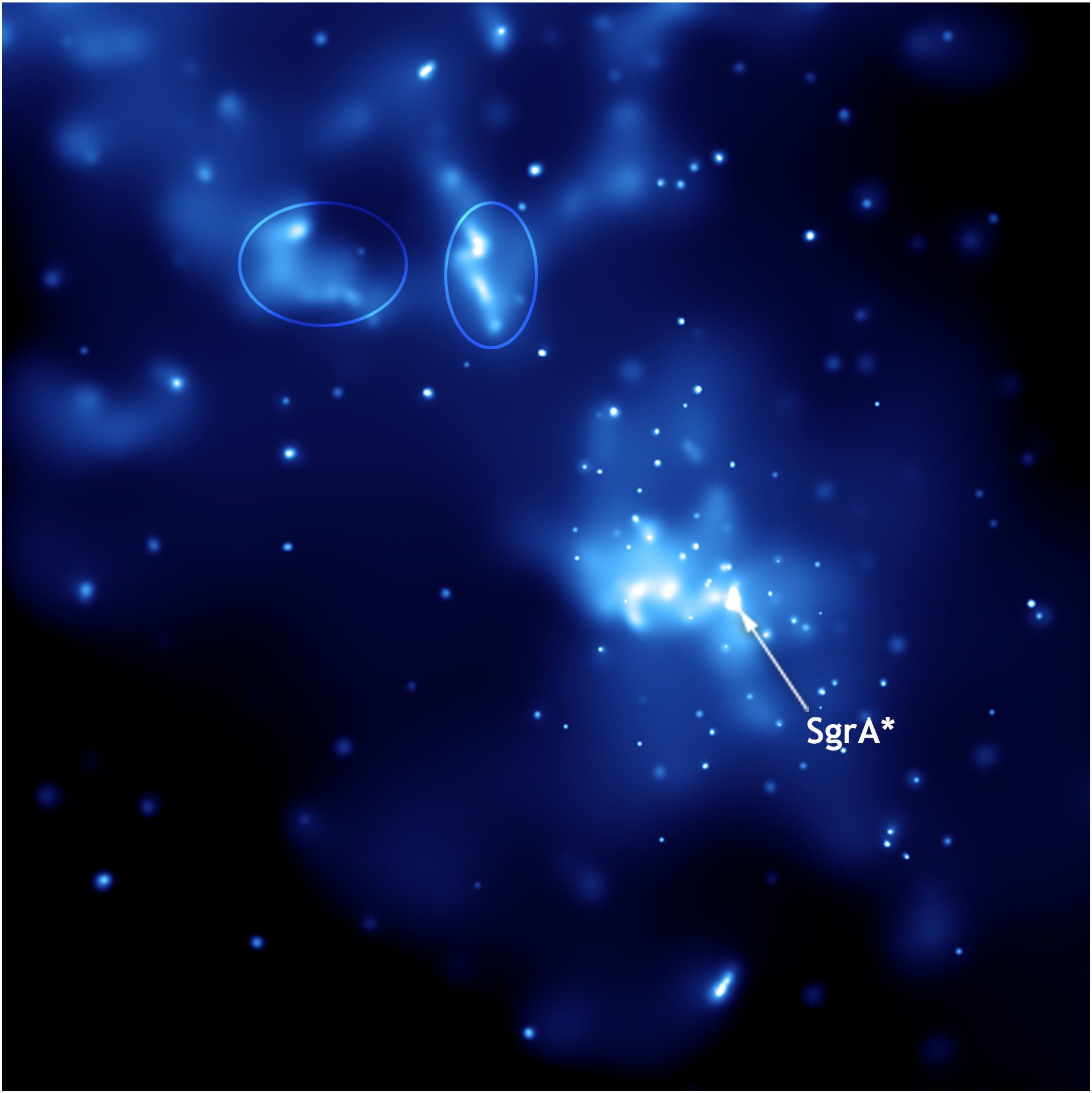

El centro de la Vía Láctea es una región turbulenta y dinámica, con cúmulos estelares brillantes, nubes de gas caliente y campos magnéticos monstruosos. Todos ellos parecen centrados en torno a un objeto pequeño y denso conocido como Sagitario A* (Sgr A*). Las observaciones de estrellas en órbita alrededor de ese punto sugieren que es un agujero negro supermasivo. Hay poco gas entrando en espiral en Sagitario A*, quizás porque las explosiones de estrellas han expulsado la mayor parte del gas y el polvo del núcleo de la Vía Láctea. Aunque Sgr A*es, con mucho, el agujero negro supermasivo más cercano, sigue siendo relativamente difícil de estudiar, porque se halla detrás de muchas nubes espesas de polvo interestelar, que absorben la luz visible. Los astrónomos utilizan los rayos-X, ondas de radio y otras longitudes de onda para estudiar el núcleo de la Vía Láctea.

Al sintonizar hacia el centro de la Vía Láctea, los radioastrónomos exploran un lugar complejo y misterioso donde está SgrA que…¡Esconde un Agujero Negro descomunal! Las observaciones astronómicas utilizando la técnica de Interferometría de muy larga base, a longitudes de onda milimétricas proporcionan una resolución angular única en Astronomía. De este modo, observando a 86 GHz se consigue una resolución angular del orden de 40 microsegundos de arco, lo que supone una resolución lineal de 1 año-luz para una fuente con un corrimiento al rojo z = 1, de 10 días-luz para una fuente con un corrimiento al rojo de z = 0,01 y de 10 minutos-luz (1 Unidad Astronómica) para una fuente situada a una distancia de 8 Kpc (1 parcec = 3,26 años-luz), la distancia de nuestro centro galáctico. Debemos resaltar que con la técnica de mm-VLBI disfrutamos de una doble ventaja: por un lado alcanzamos una resolución de decenas de microsegundos de arco, proporcionando imágenes muy detalladas de las regiones emisoras y, por otro, podemos estudiar aquellas regiones que son parcialmente opacas a longitudes de onda más larga.

Las galaxias activas tienen nucleos que brillan tanto, que pueden llegar a ser más luminosos que las galaxias que los alberga. Estas galaxias activas se caracterizan porque en sus núcleos ocurren procesos no-térmicos que liberan enormes cantidades de energía que parece provenir de una región muy pequeña y brillante situada en el corazón de la galaxia.

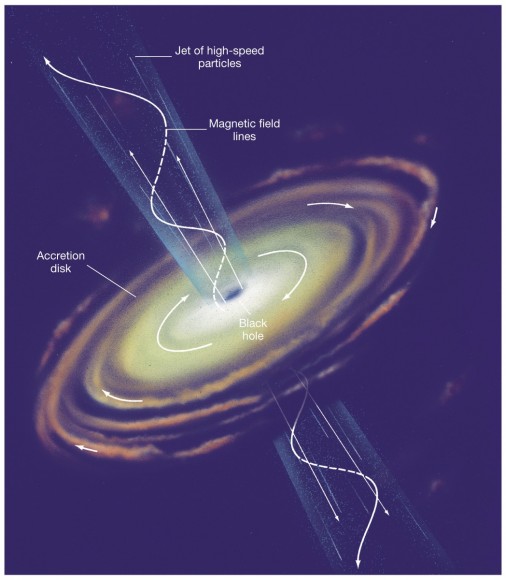

Son muchos los indicios que favorecen la hipótesis de que tales objetos son agujeros negros muy masivos (del orden de 100-1000 millones de veces la masa del Sol), con un tamaño de 1 minuto-luz o varios días-luz. La enorme fuerza gravitatoria que ejercen estos agujeros negros atrae el gas y las estrellas de las inmediaciones, formando el denominado disco de acrecimiento que está en rotación diferencial en torno al objeto masivo.

El modelo de “Agujero Negro + disco de acreción” es el más satisfactorio hoy día para explicar las propiedades de los núcleos activos de galaxias. Un aspecto muy destacado en la morfología de las regiones compactas de los núcleos activos es la presencia de una intensa emisión radio en forma de chorros (los denominados Jets relativistas), que están formados por un plasma de partículas relativistas que emanan del núcleo central y viajan hasta distancias de varios megaparsec.

Jet relativista de un AGN. Creditos: Pearson Education, Inc., Upper Saddle River, New Jersey

Estos Jets son los aceleradores de partículas más energéticos del Cosmos. Sin embargo, todavía se desconoce como se generan, aceleran y coliman, si bien a través de simulaciones magnetohidrodinámicas se conoce que el campo magnético juega un papel fundamental en estos procesos. La técnica de mm-VLBI proporciona imágenes directas y nítidas de las regiones nucleares de las galaxias activas y acotan tanto el tamaño de los núcleos como la anchura de los chorros en la vecindad del agujero negro supermasivo. De hecho, las resoluciones angulares proporcionadas por mm-VLBI corresponderían a escalas lineales del orden de miles, centenares y decenas de Radios de Schwarzschild dependiendo de la distancia y la masa del agujero negro.

Existen algunos casos espectaculares, las imágenes obtenidas con mm-VLBI trazán los chorros relativistas a escalas del subparsec, cartografiando los motores centrales de las fuentes compactas con una resolución lineal tal que nos permite acercarnos a la última órbita estable en torno al agujero negro supermasivo. Podemos mencionar algunos casos espectaculares que han dejado asombrados a propiso y extraños.

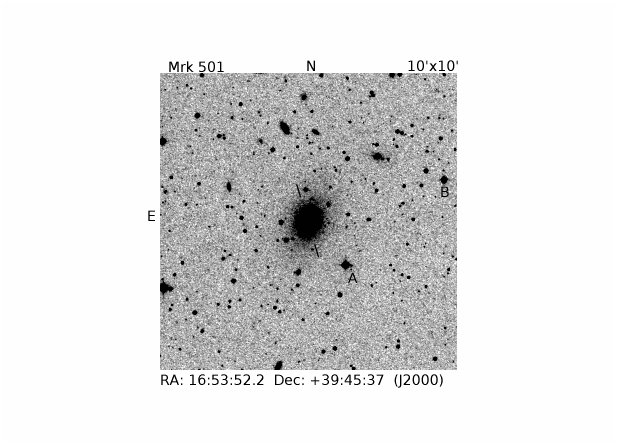

Mrk 501: Es una radiogalaxia situada a un corrimiento al rojo de z = 0.oo34. La masa del agujero negro central es del orden de mil millones de masas solares, por lo que el tamaño del radio de Schwarzschild es de 0,12 días-luz. Las observaciones con mm-VLBI a 86 GHz, muestra que su núcleo es muy compacto. El tamaño del núcleo de la radiofuente se puede establecer en 0,03 pc.

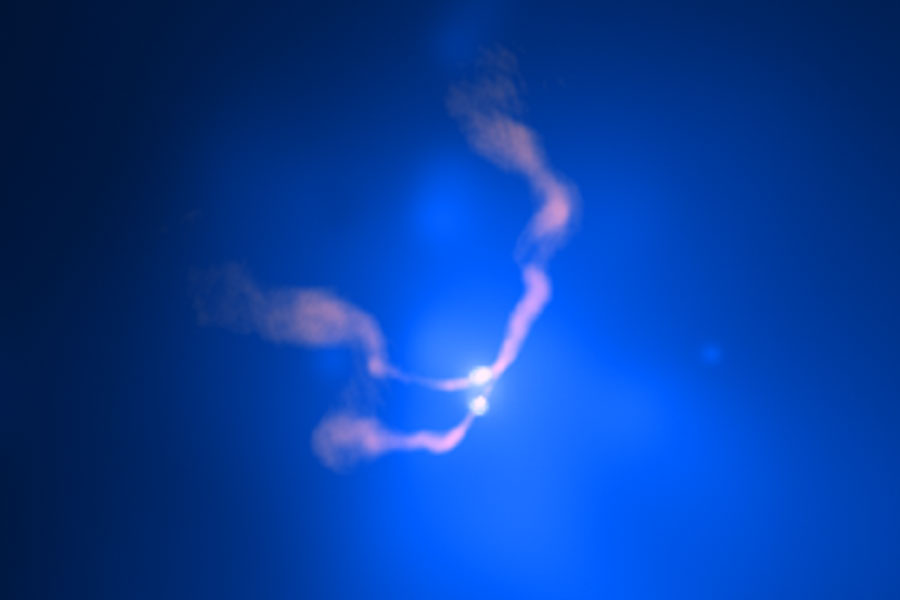

Vista tomada por el Telescopio Hubble del chorro de materia de la M87

M87: La galaxia M87 está situada a la una distancia de 16,75 Mpc tiene un agujero negro situado en la región nuclear con una masa del orden de los 3.000 millones de masas solares, lo que implica que el tamaño del Radio de Schwarzschild es de 0,34 días-luz, Las observaciones interferométricas a 45 y 43 GHz han mostrado la presencia de un chorro relativista, en la que se observan dos fenómenos muy relevantes: i) en la base del jet, el ángulo de apertura es muy grande, lo que indicaría que el chorro vuelve a recolimarse a una cierta distancia del Agujero Negro central; ii) el chorro presenta fuerte emisión en sus bordes (fenómeno conocido como “edge brightening”, mientras que presenta emisión muy débil en su interior. Todo esto lleva consigo una serie de implicaciones y parámetros de tipo técnicos que no son al caso destacar aquí.

Las observaciones de VLBI a longitudes de onda centimétricas han mostrado que SgrA, la radiofuente compacta en el centro de nuestra Galaxia, tiene un tamaño angular que escala con la longitud de onda al cuadrado, resultado que se interpreta físicamente considerando que la estructura que detectamos para SgrA no es su estructura intrínseca sino la imagen resultado de la interacción de su emisión de radio con sus electrones interestelares de la región interna de la Galaxia (lo que técnicamente se conoce como el “disco de scattering”. Las observaciones con mm-VLBI a 86 GHz han permitido determinar por primera vez el tamaño intrínseco de SgrA que ha resultado ser de 1,01 Unidades Astronómicas.

Considerando que SgrA se encuentra a una distancia de 8 Kpc y que su masa es de 4 millones de masas solares, este tamaño lineal corresponde a 12,6 Radios de Schwarzschild. Con todo esto, vengo a decir que estamos ya en la misma vecindad de los agujeros negros y, lo único que tenemos que despejar es la incognita que nos pueda crear el efecto del que nos habla la Relatividad General cuando establece que la raqdiación proveniente de una superficie esférica a una cierta distancia del agujero negro, sufriría un proceso de lente gravitacional amplificadora dandonos un tamaño mayor que el real. Así, cualquier objeto emisor con un tamaño intrínseco inferior a 1,5 Radios de Schwarzschild tendría un diámetro aparente mayor que 5,2 R de Schwarzschild.

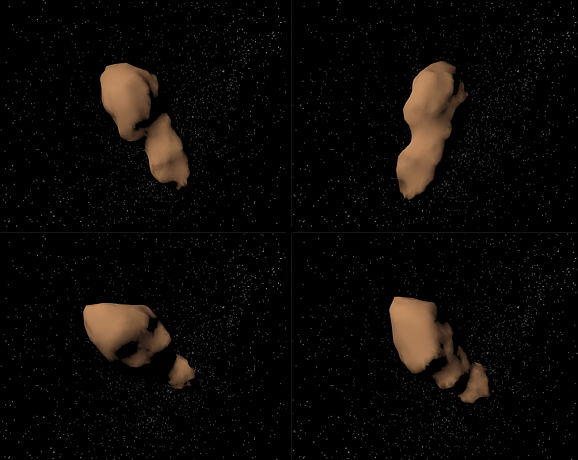

Simulaciones de la nube de polvo y gas G2 en su órbita alrededor del agujero negro SgrA*en el centro de la Vía Láctea. Foto cortesía de M. Schartmann y Calcada L. / European Southern Observatory y el Max-Planck-Institut für Physik Extraterrestre.

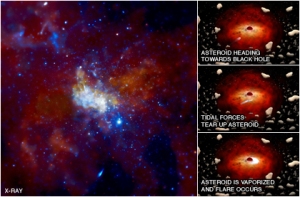

Esta imagen tomada por el Observatorio de Rayos X Chandra de la NASA muestra el centro de nuestra galaxia , con un agujero negro supermasivo conocido como Sagitario A * (Sgr A *, para abreviar) en el centro. Usando observaciones intermitentes durante varios años, Chandra ha detectado estallidos de rayos X aproximadamente una vez al día provenientes de Sgr A *. Las erupciones también se han visto en datos infrarrojos por el VLT de ESO en Chile.

El nuevo estudio proporciona una posible explicación para las erupciones misteriosas. La hipótesis es que hay una nube en torno a Sgr A * que contiene cientos de miles de millones de asteroides y cometas, que han sido despojadas de sus estrellas madre. El panel de la izquierda es una imagen que contiene casi un millón de segundos de observaciones de la región alrededor del agujero negro, el rojo representa baja energía de rayos X, el verde la energía media de rayos X, y azul, la gama más alta.

¡Es todo tan complejo! Lo cierto es que sin salir de nuestra propia Galaxia, la Vía Láctea, podemos observar todos los sorprendentes objetos que imaginarnos podamos y, en ella están presentes energías violentas que, ¡menos mal!, nos quedan algo lejos y desde nuestra zona tranquila en el Brazo de Orión, podemos emplear nuestros ingenios tecnológicos para saber de todos esos suscesos provocados por Radiogalaxias, agujeros negros gigantes, explosiones de supernovas y otros misteriosos brotes de inmensas energías que aún, no hemos sabido a qué fuente corresponden.

emilio silvera

Sep

10

Desde el pasado pero, ¡siempre hacia el futuro!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Ciencia ~

Clasificado en La Ciencia ~

Comments (4)

Comments (4)

![[IMG]](http://static.hsw.com.br/gif/synchrotron-1.jpg)

Imagem cedida por Diamond Light Source

Acelerador de partículas construido en las instalaciones del Diamond Ligth Source en Oxfordshire (Inglaterra). Llamado la Fuente luminosa de diamante, el Diamond synchrotron comenzó a funcionar en enero de 2007. La luz que puede generar este artefacto es 100 mil millones de veces más brillante que un rayo X estándar médico.

Un acelerador de partículas (como todos sabemos) es, a grandes rasgos, una máquina que mediante campos electromagnéticos acelera partículas hasta que alcanzan velocidades inimaginables. Luego, por ejemplo, hacen chocar estas partículas y así se consigue saber de qué está formada la materia en sus partes más diminutas (mucho más diminutas que un átomo). Eso es lo que hace el LHC.

Sin embargo, en el caso de este acelerador, los científicos esperaban usar la luz del Diamond synchrotron para “leer” los textos antiguos que han sufrido el daño significativo. Porque los potentes rayos X permitirán hacerlo sin ni siquiera abrir el libro. El synchrotron emite un rayo X tan poderoso que, al incidir en una voluta, permite producir una imagen de 3-D del texto.

La técnica ya había sido aplicada satisfactoriamente en textos escritos con la tinta de hierro, que los escribanos comenzaron a usar en el siglo XII. Algunas de las tintas hechas con extractos vegetales y sales de hierro utilizadas en el Siglo XII deterioran el tipo de pergamino utilizado, imposibilitando la lectura de documentos valiosos. Simplemente he querido incluir esta introducción para que os hagais una idea de hasta donde puede llegar nuestro ingenio.

(ilustración de un nano robot)

Si hablamos de nuevos inventos en los campos más diversos, nos podríamos sorprender de lo que se ha conseguido en los últimos años que, desde una “mano robótica” capaz de realizar toda clase de movimientos, “El sexto sentido”, una interfaz gestual portable que permite la interacción entre los gestos y los movimientos naturales del cuerpo humano con una computadora, o, un Implantes de retina, que devuelve la visión a pacientes con degeneración macular y ceguera mediante implantes microelectrónicos. Entre los últimos inventos dedestaca una variedad de plástico hecha con orina de cerdo y lentes de contacto biónicos. Se inventa un proceso capaz de cultivar parte de un corazón humano a partir de células madre, una máquina que puede imprimir una novela completa de 300 páginas en tan solo 3 minutos y por un costo ínfimo, una batería que funciona con cualquier solución azucarada y enzimas de digestión de glucosa capaz de extraer electrones que crean electricidad…

Las nuevas tecnologías y los inventos que se están produciendo en el diglo XXI, harían abrir la boca por el asombro a los filósofos naturalistas del pasado que trataban de profundizar en el conocimiento de la Naturaleza. Ellos fueron los que pusieron las primeras piedras del Edificio que hoy, llamamos Ciencia.

Corazones e Hígados artificiales, el guante de braille para ciegos, o, yendo más allá…

Un “Diente telefónico”. Se trata de un minúsculo implante que se coloca en el diente molar y que mediante un complejo sistema de señales y vibraciones permite recibir llamadas telefónicas. Tejido artificial nanotecnológico, Parche hormonal anticonceptivo, o, esa invención que hace posible que con una pequeña gota nos permite descubrir si en una bebida se ha vertido alguna de las llamadas “drogas del depredador” como las GHB o la Ketamina. Estas drogas suelen utilizarse por violadores y secuestradores pues facilitan dicho crimen al desinhibir a la víctima. El “Motor a nanoescala”, lo suficientemente pequeño como para viajar en la espalda de un virus. Un dispositivo que administra medicamentos a través de ondas sonoras que sustituyen las inyecciones, siendo igual de efectivas. Plástico inteligente capaz de modificar su estructura ante la exposición de determinadas longitudes de onda. Un dispositivo móvil creado por Aqua Sciences que permite beber agua del aire. ¿Os imaginais lo que supondrá eso en la travesía de un desierto? INSCENTINEL inventa un sistema de entrenamiento para que abejas sean capaces de detectar bombas y explosivos.

Las cosas no llegaron por arte de magia… ¡muchas ideas hicieron falta!

Ahora miramos a nuestro alrededor y todo lo que vemos que ocurre nos parece lo normal, que las cosas son así. Sin embargo, habría que pensar -por ejemplo, en el ámbito de la física de partículas- que, el diluvio de estructuras subnucleares que desencadenó “el acelerador” de partículas, fue tan sorprende como los objetos celestes que descubrió el telescopio de Galileo. Lo mismo que pasó con la revolución galileana, con la venida de los aceleradores de partículas, la Humanidad adquirió unos conocimientos nuevos e insospechados acerca de cómo era el mundo, la naturaleza de la materia.

Que en este caso de los aceleradores se refería al “espacio interior” en lugar de al “espacio exterior” no los hacía menos profundos ni menos importantes. El descubrimiento de los microbios y del universo biológico invisible por Pasteur fue un descubrimiento similar y, ya puestos, haremos notar que pocos se acuerdan ya de Demócrito, aquel filósofo sontiente que, tomó prestado de los antiguos hindúes, la idea del á-tomo, la expresión “más pequeña de la materia” que era “indivisible”.

Ahora sabemos que Demócrito estaba equivocado y que el átomo, sí se puede dividir. Sin embargo, él señaló un camino y, junto a Empédocles, el que hablaba de “elementos” como agua, aire, fuego y tierra, para significar que eran los componentes, en la debida proporción de todo lo que existía…, junto a otros muchos, nos han traído hasta aquí. Así que, los inventos que antes se mencionaban, no han llegado porque sí, ha sido un largo camino, mucha curiosidad y mucho trabajo y, no lo olvidemos: ¡Observar, Imaginar y Experimentar!

Nos dimos cuenta y estaba claro que la búsqueda de la menor de las partículas requería que se expandiese la capacidad del ojo humano: primero lupas, después microscopios y, finalmente… ¡Aceleradores! que, utilizando energías inimaginables ( 14 TeV), nos llevaría hasta las entrañas de la materia que tratamos de conocer.

Todos estos experimentos en los aceleradores han posibilitado muchos de los avances que hoy día conocemos en los distintos campos del saber humano. Generalmente, cuando se habla de aceleradores de partículas, todos piensan en el Bosón de Higgs y cosas por el estilo. Sin embargo, las realidades prácticas de dichos ingenios van mucho más allá.

“La “gran ciencia” (big science) genera tecnología, tecnología punta, genera industria, mucha industria, genera riqueza. Los grandes aceleradores de partículas, como el LHC del CERN, son ejemplos perfectos de ello. La tecnología de aceleradores de partículas ha permitido desarrollar dispositivos de implantación iónica que se utilizan para la fabricación de mejores semiconductores, para la fabricación prótesis de rodilla más duraderas, para la fabricación de neumáticos menos contaminantes, para el desarrollo de nuevas terapias contra el cáncer. Esto último gracias a que lo último de lo último en superimanes superconductores está en los grandes aceleradores. Esta tecnología ha permitido desarrollar y permitirá mejorar los potentes imanes necesarios en el diagnóstico clínico (como en resonancia magnética nuclear) y para terapias contra el cáncer basadas en haces de protones. Nos lo cuenta Elizabeth Clements, en “Particle physics benefits: Adding it up,” Symmetry, dec. 2008″ (Francis (th)E mule Science’s News).

Beneficios de la investigación básica en Física de Partículas: La tecnología desarrollada en los aceleradores de partículas tiene beneficios indirectos para la Medicina, la Informática, la industria o el medio ambiente. Los imanes superconductores que se usan para acelerar las partículas han sido fundamentales para desarrollar técnicas de diagnóstico por imagen como la resonancia magnética. Los detectores usados para identificar las partículas son la base de los PET, la tomografía por emisión de positrones (antipartícula del electrón). Y muchos hospitales utilizan haces de partículas como terapia contra el cáncer.

Con velocidades 10.000 mayor que una conexión típica, “The Grid” podrá enviar un catálogo completo de información desde Gran Bretaña a Japón en menos de 2 segundos. Esta red, creada en el centro de física de partículas CERN, puede proveer el poder necesario para transmitir imágenes holográficas; permitir juegos en línea con cientos de miles de personas, y ofrecer una telefonía de alta definición en video al precio de una llamada local

Así, la World Wide Web (WWW), el ‘lenguaje’ en el que se basa Internet, fue creado en el CERN para compartir información entre científicos ubicados alrededor del mundo, y las grandes cantidades de datos que se producen motivan el desarrollo de una red de computación global distribuida llamada GRID. Los haces de partículas producidos en aceleradores tipo sincrotrón o las fuentes de espalación de neutrones, instrumentos creados para comprobar la naturaleza de la materia, tienen aplicaciones industriales en la determinación de las propiedades de nuevos materiales, así como para caracterizar estructuras biológicas o nuevos fármacos. Otras aplicaciones de la Física de Partículas son la fabricación de paneles solares, esterilización de recipientes para alimentos o reutilización de residuos nucleares, entre otros muchos campos.

Tambien en el campo de la Astronomía, el LHC, nos puede ayudar a comprender cosas que ignoramos. Nos henmos preguntado sobre la existencia de estrellas de Quarks-Gluones, y, sobre el tema, algo nos ha dicho ya el Acelerador Europeo de Partículas que trata de llegar hasta “la materia oscura” y algunos otros enigmas que nos traen de cabeza.

No es extraño encontrarnos una mañana al echar una mirada a la prensa del día, con noticias como éstas:

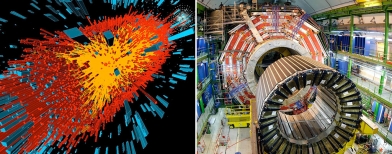

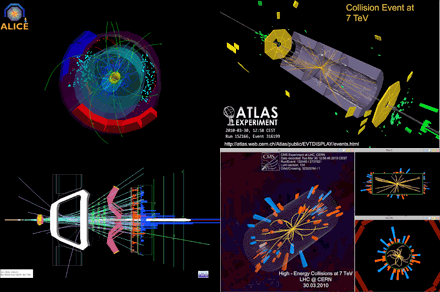

Colisión de iones pesados registrada por el experimento ALICE. (Imagen: CERN.)

El acelerador europeo ha obtenido plasma de quarks-gluones, el primer estado de la materia tras el Big Bang.

“No todo son bosones de Higgs en las instalaciones del CERN. Aún hay muchas preguntas sobre el universo y sus partículas que se pueden responder a base de colisiones de alta energía. Y en eso, elLHC es el mejor. Un grupo de investigadores del consorcio europeo ha realizado nuevas mediciones de la que creen que es el primer tipo de materia que hubo durante los instantes iniciales del universo. El plasma de quarks-gluones.

Los quarks y los gluones son, respectivamente, los ladrillos y el cemento de la materia ordinaria. Durante los primeros momentos tras el Big Bang, sin embargo, no estaban unidos constituyendo partículas —como protones o neutrones— sino que se movían libremente en estado de plasma. A base de colisionar iones de plomo —que es un átomo muy pesado— a velocidades cercanas a las de la luz, el LHC pudo recrear durante pequeños lapsos de tiempo las que se creen fueron las condiciones de los primeros momentos del universo.

El plasma de quarks-gluones es extremo y efímero. Por eso los investigadores han tenido que analizar los resultados de más de mil millones de colisiones para obtener resultados significativos.”

Evento de colisión de 7 TeV visto por el detector LHCb. El experimento del LHCb en el LHC estará bien ubicado para explorar el misterio de la antimateria. Crédito: LHC, CERN. Ya sabéis que, durante muchos años, la ausencia de antimateria en el Universo ha atormentado a los físicos de partículas y a los cosmólogos: mientras que el Big Bang debería haber creado cantidades iguales de materia y antimateria, no observamos ninguna antimateria primordial hoy en día. ¿Dónde ha ido? Los experimentos del LHC tienen el potencial de dar a conocer los procesos naturales que podrían ser la clave para resolver esta paradoja.

Cada vez que la materia es creada a partir de energía pura, se genera la misma cantidad de partículas y antipartículas. Por el contrario, cuando la materia y la antimateria se encuentran, se aniquilan mutuamente y producen luz. La antimateria se produce habitualmente cuando los rayos cósmicos chocan contra la atmósfera de la Tierra, y la aniquilación de materia y antimateria se observa durante los experimentos de física en los aceleradores de partículas.

Equipos de físicos en todo el mundo siguen analizando datos. Aquellas primeras colisiones de protones a la alta energía prevista de 7 Teraelectronvoltios (TeV), una potencia jamás alcanzada en ningún acelerador antes, nos puede traer noticias largamente esperadas y desvelar misterios, contestar a preguntas planteadas y, en definitiva, decirnos cómo es la Naturaleza allí, donde el ojo humano no puede llegar pero, si la inteligencia.

Lo cierto es que, todos tenemos que convenir en el hecho cierto de que, el LHC es el mayor experimento físico de la historia de la Ciencia y que, de seguro, nos dará la oportunidad de comprender muchas cuestiones que antes se nos aparecían oscuras e indistinguibles entre la bruma de esa lejanía infinitesimal de la cuántica. Ahora, tenemos una herramienta capaz de llevarnos hasta aquellos primeros momentos en los que se construyó la historia del universo y, si podemos, de esta manera “estar allí”, veremos, con nuestros propios ojos lo que pasó y por qué pasó de esa manera.

Toda esta larga exposición de temas, de alguna manerta conectados, viene al caso para dejar claro que, aquellos detractores del LHC, no llevaban la razón y, sus protestas no tenían un contenido científico. El Acelerador de Partículas que llamamos abreviadamente LHC, nos ha dado y nos seguirá dando, muchos beneficios para toda la Humanidad.

emilio silvera

Sep

10

De cómo llegamos hasta los Quarks

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Ahora todos hablamos del LHC. Sin embargo, la historia de los aceleradores no comenzó con éste moderno y complejo conglomerado de sofisticadas estructuras que hacen posible que visitemos lugares muy lejanos en el corazón de la materia. Tendríamos que recordar al acelerador lineal también llamado LINAC (linear accelerator) es un tipo de acelerador que le proporciona a la partícula subatómica cargada pequeños incrementos de energía cuando pasa a través de una secuencia de campos eléctricos alternos.

Mientras que el generador de Van de Graaff proporciona energía a la partícula en una sola etapa, el acelerador lineal y el ciclotrón proporcionan energía a la partícula en pequeñas cantidades que se van sumando. El acelerador lineal, fue propuesto en 1924 por el físico sueco Gustaf Ising. El ingeniero noruego Rolf Wideröe construyó la primera máquina de esta clase, que aceleraba iones de potasio hasta una energía de 50.000 eV.

Durante la Segunda Guerra Mundial se construyeron potentes osciladores de radio frecuencia, necesarios para los radares de la época. Después se usaron para crear aceleradores lineales para protones que trabajaban a una frecuencia de 200 MHz, mientras que los aceleradores de electrones trabajan a una frecuencia de 3000 MHz.

El acelerador lineal de protones diseñado por el físico Luis Alvarez en 1946, tenía 875 m de largo y aceleraba protones hasta alcanzar una energía de 800 MeV (800 millones). El acelerador lineal de la universidad de Stanford es el más largo entre los aceleradores de electrones, mide 3.2 km de longitud y proporciona una energía de 50 GeV (50 billones). En la industria y en la medicina se usan pequeños aceleradores lineales, bien sea de protones o de electrones.

El SLAC, ubicado al sur de San Francisco, acelera electrones y positrones a lo largo de algo más de tres kilómetros hacia varios blancos, anillos y detectores ubicados en su finalización. Este acelerador hace colisionar electrones y positrones, estudiando las partículas resultantes de estas colisiones. Construido originalmente en 1962, se ha ido ampliando y mejorando para seguir siendo uno de los centros de investigación de física de partículas mas avanzados del mundo. El centro ha ganado el premio nobel en tres ocasiones. Y, una vez recordada de manera breve la historia, pasaremos directamente al tema que en realidad nos ha tríado aquí: ¡El descubrimiento de los Quarks!

Ahora los medios con los que cuentan los físicos del LHC son inmensamente más eficaces y están más adelantados que aquellos viejos aceleradores que, sin embargo, fueron los pioneros y los que hicieron posible adquirir conocimientos que nos han traído hasta el moderno LHC.

En 1967 se emprendió una serie de experimentos de dispersión mediante los nuevos haces de electrones del SLAC. El objetivo era estudiar más incisivamente la estructura del protón. Entra el electrón de gran energía, golpea un protón en un blanco de hidrógeno y sale un electrón de energía mucho menor, pero en una dirección que forma un ángulo grande con respecto a su camino original. La estructura puntual dentro del protón actúa, en cierto sentido, como el núcleo con las partículas alfa de Rutherford. Pero el problema era aquí más sutíl.

Richard Edward Taylor

“Richard Edward Taylor fue uno de los veintidós científicos que trabajó intensamente en el acelerador lineal de Stanford (SLAC), en una serie de pruebas experimentales que vinieron a demostrar que los protones y los neutrones son poseedores de una estructura interna, lo que a su vez confirma las predicciones teóricas del neoyorquino Murray Gell-Mann (1929- ), acerca de la existencia de los denominados quarks.

Junto con sus colegas de Stanford junto con Jerome I. Friedman y Henry W. Kendall -con los que luego habría de compartir el Nobel-, Taylor investigó sobre la estructura interna de la materia, en su mínima expresión, para lo que partió del modelo teórico de los quarks, postulado por Gell-Mann y -de forma independiente- G. Zweig. Tras sus descubrimientos experimentales en el acelerado lineal de Stanford, Taylor perfeccionó dicho modelo añadiéndole la existencia de unas subpartículas desconocidas hasta entonces, que luego fueron denominadas leptones; además, introdujo en el modelo teórico de Gell-Mann otras partículas no estructurales, sino de intercambio de fuerza, a las que en Stanford comenzaron a llamar bosones.”

Richard Feynman

Los dos últimos párrafos los he tomado prestados de www.mcnbiografias.com., que es lo que se explica de este tema en casi todas partes. Sin embargo, pocos cuentan que, el equipo de Stanford, dirigido por el físico del SLAC por Richard Taylor y los otros dos físicos del MIT, Jerome Friedman y Henry Kendall, tuvieron la gran suerte de que, Richard Feynman y James Bjorken, metieran sus narices en el proyecto llevados por la curiosidad y como habían prestado su energía y su imaginación a las interacciones fuertes y se preguntaban: ¿que habrá dentro del protón?

Amnos, Feynman y Bjorken visitaban con frecuencia Stanford desde su base en el Cal Tech, en Pasadena. Bjorken, teórico de Stanford, estaba muy interesado en el proyecto experimental y en las reglas que regían unos datos aparentemente incompletos. Estas reglas, razonaba Bjorken, serían indicadoras de las leyes básicas (dentro de la “caja negra”) que controlaba la estructura de los hadrones.

No estaría mal echar una mirada hacia atrás en el tiempo y recordar, en este momento, a Demócrito que, con sus postulados, de alguna manera venía a echar un poco de luz sobre el asunto, dado que él decía que para determinar si algo era un á-tomo habría que ver si era indivisible. En el modelo de los quarks, el protón, en realidad, un conglomerado pegajoso de tres quarks que se mueven rápidamente. Pero como esos quarks están siempre ineludiblemente encadenados los unos a los otros, experimentalmente el protón aparece indivisible.

Acordémonos aquí de que Boscovich decía que, una partícula elemental, o un “á-tomo”, tiene que ser puntual. Y, desde luego, esa prueba, no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus datos a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

Precisamente por eso era tan conveniente fue tan conveniente para Richard Edward Taylor y su equipo, tener a dos de los mejores teóricos del mundo en el equipo aportando su ingenio, agudeza e intuición en todas las fases del proceso experimental. El resultado fue que los datos indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

En 1990 Taylor, Friedman y Kendall recogieron su premio Nobel por haber establecido la realidad de los quarks. Sin embargo, a mí lo que siempre me ha llamado más la atención es el hecho cierto de que, este descubrimiento como otros muchos (el caso del positrón de Dirac, por ejemplo), han sido posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

A todo esto, una buena pregunta sería: ¿cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la respuesta tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

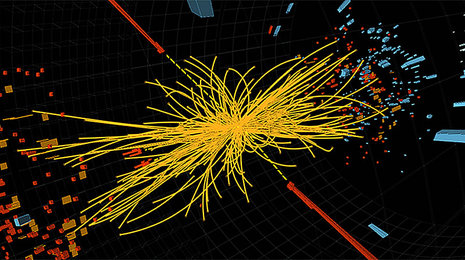

Este es, el resultado ahora de la colisión de protones en el LHC

Lo cierto es que, en su momento, la teoría de los Quarks hizo muchos conversos, especialmente a medida que los teóricos que escrutaban los datos fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La palabra de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

Así, cuando el intento de separar a los Quarks es demasiado intenso, la energía se vuelve lo bastante grande para crear un par de quark-anti-quark, y ya tenemos cuatro quarks, o dos mesones. Es como intentar conseguir un cabo de cuerda. Se corta y… ¡ya tenemos dos!

¿Cuerdas? Me parece que estoy confundiendo el principal objetivo de este trabajo y, me quiero situar en el tiempo futuro que va, desde los quarks de Gell-Mann hasta las cuerdas de Veneziano y John Schwarz y más tarde Witten. Esto de la Física, a veces te juega malas pasadas y sus complejos caminos te llevan a confundir conceptos y momentos que, en realidad, y de manera individualizada, todos han tenido su propio tiempo y lugar.

¿Cuántas veces no habré pensado, en la posibilidad de tomar el elixir de la sabiduría para poder comprenderlo todo? Sin embargo, esa pósima mágica no existe y, si queremos saber, el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirácomo es, y como se comporta la Naturaleza y, si de camino podemos llegar a saber, por qué lo hace así…¡mucho mejor!

emilio silvera

Totales: 75.296.284

Totales: 75.296.284 Conectados: 10

Conectados: 10