Sep

13

En el comienzo de todo ¿Cómo sería en realidad?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

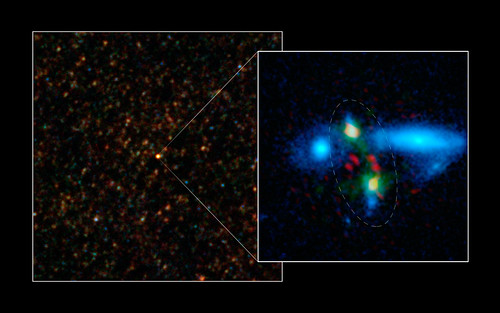

¡El Universo primitivo!

Es ahí, en lo que creemos que fue el Universo primitivo, donde reside el estudio de una cosmología en un tiempo muy poco después del supuesto Big Bang. Las teorías del universo primitivo han dado lugar a interacciones muy beneficiosas entre la cosmología y la teoría de partículas elementales. Especialmente, la Teoría de Grab Unificación. Debido a que en el Universo primitivo había unas temperaturas muy altas, muchas de las simetrías rotas en las teorías gauge se vuelven simetrías no rotas a esas temperaturas. A medida que el universo se enfrío después de la gran explosión se piensa que hubo una secuencia de transiciones de estados de simetría rota.

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, no hay núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen de nuevo rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo es más denso que las orcas (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, ahora pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la mayor parte de la materia como sino existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo del lector en el tiempo que le lleve leer esta frase. Y en el tiempo en que usted haya leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

De esa manera, oleadas de neutrinos liberados en un segundo después del big bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si estos neutrinos “cósmicos” (como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas) pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo.

A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Todo esto llegaría más tarde con la evolución de aquellas estrellas primeras

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el trabajo de contarlos, hallaremos que por cada mil millones de antiquarks existen mil millones y un quark. Esta asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo.

La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. Ahora hay bastante energía ambiente para permitir la creación y el mantenimiento de gran número de bosones W y Z.

Nuestras mentes supo llegar a poder discurrir cuestiones profundamente escondidas por la Naturaleza y, desentrañamos sus secretos para saber cómo era el mundo en el que estamos inmersos y que, como nosotros mismos, forma parte de ese universo físico que tratamos de desvelar para conocer el por qué de las cosas, de la materia, las estrellas y galaxías y, ¿por qué no? También de nosotros mismos.

Pues bien, estas partículas W y Z – las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil – son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, en el futuro, será la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

Sí, se formaron las primeras estrellas y galaxias

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las condiciones cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interacioban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 15.000 y 18.000 millones de años, cunado la perfecta simetría que, se pensaba, caracterizó el Universo, se hizo añicos para dar lugar a los simetrías rotas que hallamos a nuestro alrededor y que, nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que ahora, sea posible que, alguien como yo esté contando lo que pasó.

Lo cierto es que no sabemos que pudo pasar antes del Tiempo de Planck

Pero hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo bebé. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada.

Del otro lado de esa puerta está la época de Plank, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

Si miramos las imágenes de arriba, podemos ver una célula de nuestro cerebro que se compara con una imagen del universo y ambas, nos parecen la misma cosa o, al menos, cosas muy aproximadas en su estructura y ramificaciones. No parece más que llevásemos un universo en nuestras mentes y, en realidad, aunque sea en pequeñito, así parece ser. Todo cuanto existe, como en el Universo ocurre, está también en nuestras mentes aunque… ¡de otra manera!

Finalmente podríamos decir que estamos formando parte de algo grande y que nos encontramos en una encrucijada de caminos a tomar: El del conocimiento y el de la destrucción. No hemos llegado a comprender de manera cierta nuestra presencia aquí, en tan imenso panorama formado por un Universo lleno de estrellas y galaxias y de mundos y de fuerzas y energías y de espacio-tiempo “infinito” y, dentro de toda esa vorágine, estamos nosotros, unos seres apenas llegados que, en nuestra ilimitada egolotria, nos creemos los señores del Universo cuando no somos más que unos seres desvalidos a merced de las circunstancias naturales y del azar.

Bueno, puede que así sea pero, mientras tomamos conciencia de todo ello, sigamos aprendiendo cosas del Universo, de la Naturaleza, de la Materia y, de nosotros mismos que, al fín y al cabo, Universo somos.

emilio silvera

Sep

13

Abrir caminos no siempre ha sido fácil

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (3)

Comments (3)

En otros comentarios he hablando de los viajes de Marco Polo. Sigamos con otros aventureros de épocas pasadas.

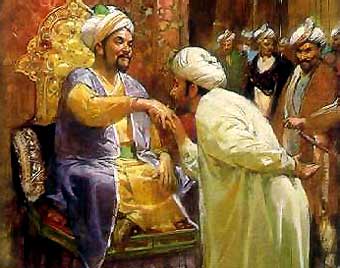

Ibn Battuta (1304-entre 1368 y 1377) figura desde siempre en la nómina de “galácticos” del mundo musulmán. Su crónica viajera, Rihla (título original, Regalo de curiosos sobre peregrinas cosas de ciudades y viajes maravillosos), supone el más alto exponente del género en una cultura en gran medida en el contacto y ósmosis con gentes y paisajes absolutamente dispares. Además de la reverencia que le otorga el mundo islámico como héroe, aventurero y sabio, modernamente en Occidente se ha enriquecido su fama con la fascinación que ejerce la patria chica de Ibn Battuta, Tánger.

Fue un gran viajero de la Edad Media fue el árabe Ibn Battuta, que partió de su casa de Tánger en 1.325 con el objetivo, en primera instancia, de Peregrinar a la Meca. No obstante, una vez alcanzada su meta, Ibn Battuta decidió ir más lejos.

El más famoso de los viajeros árabes. Viajó a lo largo de la costa oriental de África y llegó luego a Asia Menor, antes de adentrarse en Asia central en dirección a Afganistán y la India, país en el que fue muy bien recibido (era un cadí), como hombre culto y educado.

Ibn Battuta vivió durante siete años en la India, y como ya le ocurriera a Marco Polo, se convirtió en embajador del gobernante del país, el Sultán de Deli, en cuyo nombre realizó un viaje a China. Durante el camino tuvo muchas aventuras, fue asaltado, robado y abordonado por los bandidos que lo dieron por muerto, pero finalmente consiguió llegar a China en 1.346 o 1.347.

En los puertos chinos, Ibn Battuta encontró a muchos musulmanes, a los que en ningún sitio sorprendió su llegada. Tras regresar a su hogar, el siguiente viaje que realizó fue a España; luego partió para África Occidental y llegó hasta el río Níger, donde una vez más fue bien acogido, en esta ocasión por musulmanes negros. El relato de sus viajes se convirtió en la base de los estudios geográficos, astronómicos y marítimos en los centros de aprendizaje musulmanes de Córdoba y Toledo. Estas tradiciones contribuyeron en forma importante a las ideas que inspiraron los viajes de Colón.

Ibn Battuta es recibido por Mohammed ibn Tughliq

Sep

13

Biología, estrellas, unidades naturales…, !Universo¡

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Alquimia estelar ~

Clasificado en Alquimia estelar ~

Comments (0)

Comments (0)

¿Es viejo el universo? Todos los cáculos nos llevan a una edad de 13.700 millones de años que, comparado con el tiempo en el que nosotros hicimos acto de presencia en él, es menos que un simple parpadeo de ojos. Sin embargo, a veces nos sentimos los amos del mundo y del Universo mismo, lo que en realidad, es un simple espejismo, una ilusión que se forja en nuestras mentes que, jóvenes e inmaduras… Aún no comprenden, como son las cosas.

Cuando tenemos que operar con la edad y el tamaño del universo lo hacemos generalmente utilizando medidas de tiempo y espacio. Son tan inmensas las distancias y tan descomunal el tiempo que está presente en el ámbito del Universo que, hemos inventado unidades especiales para poder hablar de ellas sin tener que escribir cantidades tan grandes con los números y, el año-luz, la Unidad Astronómica, el Parsec, Kiloparsec o Gigaparsec son palabras que expresan medidas antropomórficas y extraordinarias que se pierden en el espacio-tiempo.

¿Por qué medir la edad del universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor del astro rey, el Sol? ¿Por qué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque queremos saber en qué lugar estamos, porque es conveniente y porque desde siempre hemos tratado de saber, lo que el universo es. Por otra parte, también en el ámbito de lo muy pequeño hemos tenido que inventar unidades que, esta vez, han querido significar lo que dice la Naturaleza y no el hombre.

Ésta es una situación en donde resulta especialmente apropiado utilizar las unidades “naturales”; la masa, longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física para ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

El joven Planck

Mientras que Stoney había visto en la elección de unidades prácticas una manera de cortar el nudo gordiano de la subjetividad, Planck utilizaba sus unidades especiales para sustentar una base no antropomórfica para la física y que, por consiguiente, podría describirse como “unidades naturales”.

De acuerdo con su perspectiva universal, en 1.899 Planck propuso que se construyeran unidades naturales de masa, longitud y tiempo a partir de las constantes más fundamentales de la naturaleza: la constante de gravitación G, la velocidad de la luz c y la constante de acción h, que ahora lleva el nombre de Planck. La constante de Planck determina la mínima unidad de cambio posible en que pueda alterarse la energía, y que llamó “cuanto”. Las unidades de Planck son las únicas combinaciones de dichas constantes que pueden formarse en dimensiones de masa, longitud, tiempo y temperatura. Sus valores no difieren mucho de los de Stoney que figuran en el trabajo siguiente de hoy:

| Mp = | (hc/G)½ = | 5’56 × 10-5 gramos |

| Lp = | (Gh/c3) ½ = | 4’13 × 10-33 centímetros |

| Tp = | (Gh/c5) ½ = | 1’38 × 10-43 segundos |

| Temp.p = | K-1 (hc5/G) ½ = | 3’5 × 1032 ºKelvin |

Estas formulaciones con la masa, la longitud, el tiempo y la temperatura de Planck incorporan la G (constante de gravitación), la h (la constante de Planck) y la c, la velocidad de la luz. La de la temperatura incorpora además, la K de los grados Kelvin. La constante de Planck racionalizada (la más utilizada por los físicos), se representa por ћ que es igual a h/2π que vale del orden de 1’054589×10-34 Julios segundo.

En las unidades de Planck, una vez más, vemos un contraste entre la pequeña, pero no escandalosamente reducida unidad natural de la masa y las unidades naturales fantásticamente extremas del tiempo, longitud y temperatura. Estas cantidades tenían una significación sobrehumana para Planck. Entraban en La Base de la realidad física:

“Estas cantidades conservarán su significado natural mientras la Ley de Gravitación y la de Propagación de la luz en el vacío y los dos principios de la termodinámica sigan siendo válidos; por lo tanto, siempre deben encontrarse iguales cuando sean medidas por las inteligencias más diversas con los métodos más diversos.”

¿Quién sabe cómo serán?

En sus palabras finales Planck alude a la idea de observadores en otro lugar del universo que definen y entienden estas cantidades de la misma manera que nosotros. Lo cierto es que estas unidades, al tener su origen en la Naturaleza y no ser invenciones de los seres humanos, de la misma manera que nosotros y, posiblemente por distintos caminos, seres de otros mundos también las hallarán y serán idénticas a las nuestras. De entrada había algo muy sorprendente en las unidades de Planck, como lo había también en las de Stoney. Entrelazaban la gravedad con las constantes que gobiernan la electricidad y el magnetismo. Planck nos decía:

“La creciente distancia entre la imagen del mundo físico y el mundo de los sentidos no significa otra cosa que una aproximación progresiva al mundo real.”

Sí, Planck tenía razón, el mundo de los sentidos cada vez están más cerca de ese mundo real que perseguimos. Sabemos que nuestra realidad no es la realidad del mundo y, poco a poco, con descubrimientos como estos de las Unidades de Stoney-Planck, nos vamos acercando a la comprensión de esa Naturaleza creadora que permitió aquí nuestra presencia y que ahora, nosotros tratamos de saber.

Podemos ver que Max Planck apelaba a la existencia de constantes universales de la naturaleza como prueba de una realidad física al margen y completamente diferentes de las mentes humanas. Al respecto decía:

“Estos…números, las denominadas “constantes universales” son en cierto sentido los ladrillos inmutables del edificio de la física teórica. Deberíamos preguntar:

¿Cuál es el significado real de estas constantes?”

Claro que, nosotros, simplemente somos un misterio más de los muchos que en el Universo son. Sin embargo y a diferencias de los otros, tenemos la ventaja de ser conscientes con la facultad de pensar y, además, tenemos una insaciable curiosidad. Un fallo que a menudio tenemos ha sido caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

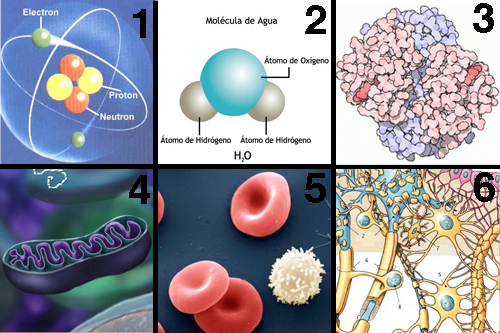

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene. Y, creemos saber que…

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones, el universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser. Pero, pese a la enorme edad del universo en “tics” de Tiempos de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

¿Por qué nuestro universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el tiempo en el universo el proceso de formación de estrellas se frena.

Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo.

La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos y el vulcanismo parará su actividad al ser frenado el planeta geológicamente y carecerán de muchos de los movimientos internos que impulsan la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre las atmósferas de los planetas en órbitas a su alrededor y, a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagar infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra, habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la Luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución. Cuando comento este tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrolló la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros en comparación, llevamos aquí tres días y, desde luego, ¡la que hemos formado!

Y no podemos tener la menor duda, mientras que estemos aquí, seguiremos pretendiendo y queriendo saber sobre los secretos de la Naturaleza que, al fin y al cabo, puede ser nuestra salvación. Ya saben ustedes: ¡Saber es poder!

emilio silvera

Sep

12

Dos verdades incompatibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

El “universo” de lo muy pequeño y el de lo muy grande… ¡Parecen incompatibles y, sin embargo…

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde hace décadas. El problema es el siguiente:

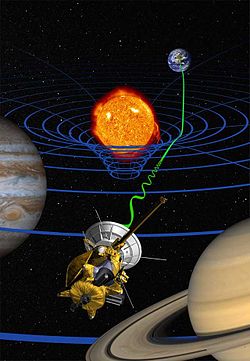

Existen dos pilares fundamentales en los cuales se apoya toda la física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del universo a una escala máxima: estrellas, galaxias, cúmulos (o clusters) de galaxias, y aún más allá, hasta la inmensa expansión del propio universo.

El otro pilar es la mecánica cuántica, que en un primer momento vislumbro Max Planck y posteriormente fue desarrollada por W. Heisemberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros, que nos ofrece un marco teórico para comprender el universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las predicciones que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: tal como se formulan actualmente, la relatividad general y la mecánica cuántica no pueden ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizados por la física durante el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota; la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

Así que si tú, lector, no has oído nunca previamente hablar de este feroz antagonismo, te puedes preguntar a que será debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de neutrones y agujeros negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado; las dos teorías no pueden estar juntas. Durante más de medio siglo, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo.

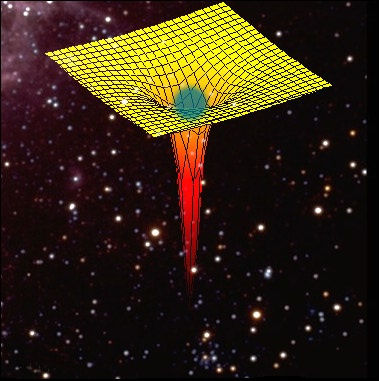

No obstante, el universo puede ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el momento del Bing Bang, la totalidad del universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, cuando se combinan, empiezan a agitarse, a traquetear y a tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del universo envueltos en el misterio, no se puede evitar sentir que la hostilidad entre la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

¿Puede ser creíble que para conocer el universo en su conjunto tengamos que dividirlo en dos y conocer cada parte por separado? Las cosas grandes una ley, las cosas pequeñas otra.

No creo que eso pueda ser así. Mi opinión es que aún no hemos encontrado la llave que abre la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique de una vez por todas las dos teorías más importantes de la física: mecánica cuántica + relatividad general.

La teoría de supercuerdas ha venido a darme la razón. Los intensos trabajos de investigación llevada a cabo durante los últimos 20 años demuestran que puede ser posible la unificación de las dos teorías cuántica y relativista a través de nuevas y profundas matemáticas topológicas que han tomado la dirección de nuevos planteamientos más avanzados y modernos, que pueden explicar la materia en su nivel básico para resolver la tensión existente entre las dos teorías.

En esta nueva teoría de supercuerdas se trabaja en 10, 11 ó en 26 dimensiones, se amplía el espacio ahora muy reducido y se consigue con ello, no sólo el hecho de que la mecánica cuántica y la relatividad general no se rechacen, sino que por el contrario, se necesitan la una a la otra para que esta nueva teoría tenga sentido. Según la teoría de supercuerdas, el matrimonio de las leyes de lo muy grande y las leyes de lo muy pequeño no sólo es feliz, sino inevitable.

Esto es sólo una parte de las buenas noticias, porque además, la teoría de las supercuerdas (abreviando teoría de cuerdas) hace que esta unión avance dando un paso de gigante. Durante 30 años, Einstein se dedicó por entero a buscar esta teoría de unificación de las dos teorías, no lo consiguió y murió en el empeño; la explicación de su fracaso reside en que en aquel tiempo, las matemáticas de la teoría de supercuerdas eran aún desconocidas. Sin embargo, hay una curiosa coincidencia en todo esto, me explico:

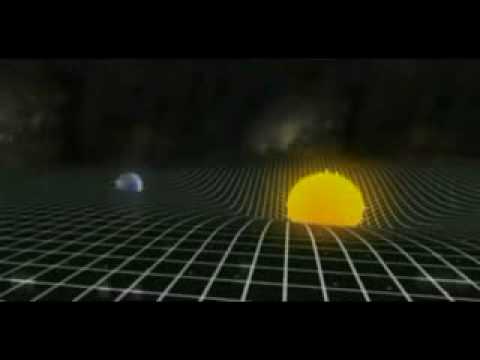

Tensor de curvatura de Einstein: ecuación

Representación de la curvatura dada por la ecuación de campo de Einstein sobre el plano de la eclíptica de una estrella esférica: Dicha ecuación relaciona la presencia de materia con la curvatura adquirida por el espacio-tiempo

Cuando los físicos trabajan con las matemáticas de la nueva teoría de supercuerdas, Einstein, sin que nadie le llame, allí aparece y se hace presente por medio de las ecuaciones de campo de la relatividad general que, como por arte de magia, surgen de la nada y se hacen presentes en la nueva teoría que todo lo unifica y también todo lo explica; posee el poder demostrar que todos los sorprendentes sucesos que se producen en nuestro universo (desde la frenética danza de una partícula subatómica que se llama quark hasta el majestuoso baile de las galaxias o de las estrellas binarias bailando un valls, la bola de fuego del Big Bang y los agujeros negros) todo está comprendido dentro de un gran principio físico en una ecuación magistral.

Esta nueva teoría requiere conceptos nuevos y matemáticas muy avanzados y nos exige cambiar nuestra manera actual de entender el espacio, el tiempo y la materia. Llevará cierto tiempo adaptarse a ella hasta instalarnos en un nivel en el que resulte cómodo su manejo y su entendimiento. No obstante, vista en su propio contexto, la teoría de cuerdas emerge como un producto impresionante pero natural, a partir de los descubrimientos revolucionarios que se han realizado en la física del último siglo. De hecho, gracias a esta nueva y magnifica teoría, veremos que el conflicto a que antes me refería existente entre la mecánica cuántica y la relatividad general no es realmente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que fueron resueltos como consecuencia de una revisión radical de nuestra manera de entender el universo.

El primero de estos conceptos conflictivos, que ya se había detectado nada menos que a finales del siglo XIX, está referido a las desconcertantes propiedades del movimiento de la luz.

Isaac Newton y sus leyes del movimiento nos decía que si alguien pudiera correr a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, y las leyes del electromagnetismo de Maxwell decían que esto era totalmente imposible. Einstein, en 1.905, vino a solucionar el problema con su teoría de la relatividad especial y a partir de ahí le dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que, según esta teoría, no se pueden considerar separadamente y como conceptos fijos e inamovibles para todos, sino que por el contrario, el espacio-tiempo era una estructura maleable cuya forma y modo de presentarse dependían del estado de movimiento del observador que lo esté midiendo.

El escenario creado por el desarrollo de la relatividad especial construyó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones de Einstein es que ningún objeto (de hecho, ninguna influencia o perturbación de ninguna clase) puede viajar a una velocidad superior a la de la luz. Einstein amplió su teoría en 1915 – relatividad general – y perfeccionó la teoría de la gravitación de Newton, ofreciendo un nuevo concepto de la gravedad que estaba producida por la presencia de grandes masas, tales como planetas o estrellas, que curvaban el espacio y distorsionaban el tiempo.

Tales distorsiones en la estructura del espacio y el tiempo transmiten la fuerza de la gravedad de un lugar a otro. La luna no se escapa y se mantiene ahí, a 400.000 Km de distancia de la Tierra, porque está influenciada por la fuerza de gravedad que ambos objetos crean y los mantiene unidos por esa cuerda invisible que tira de la una hacia la otra y viceversa. Igualmente ocurre con el Sol y la Tierra que, separados por 150 millones de kilómetros, están influidos por esa fuerza gravitatoria que hace girar a la Tierra (y a los demás planetas del Sistema Solar) alrededor del Sol.

Así las cosas, no podemos ya pensar que el espacio y el tiempo sean un telón de fondo inerte en el que se desarrollan los sucesos del universo, al contrario; según la relatividad especial y la relatividad general, son actores que desempeñan un papel íntimamente ligado al desarrollo de los sucesos.

El descubrimiento de la relatividad general, aunque resuelve un conflicto, nos lleva a otro. Durante tres décadas desde 1.900, en que Max Planck publicó su trabajo sobre la absorción o emisión de energía de manera discontinua y mediante paquetes discretos a los que él llamo cuantos, los físicos desarrollaron la mecánica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Así que el tercer conflicto estaba servido, la incompatibilidad manifiesta entre relatividad general y mecánica cuántica.

La forma geométrica ligeramente curvada del espacio que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica, lo cual era sin duda alguna el problema central de la física moderna.

Las dos grandes teorías de la física, la relatividad general y la mecánica cuántica, infalibles y perfectas por separado, no funcionaban cuando tratábamos de unirlas resulta algo incomprensible, y, de todo ello podemos deducir que, el problema radica en que debemos saber como desarrolar nuevas teorías que modernicen a las ya existentes que, siendo buenas herramientas, también nos resultan incompletas para lo que, en realidad, necesitamos.

emilio silvera

Sep

12

¡El Universo! ¿Será igual en todas parts?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El hombre en el Universo, Hacia el futuro ~

Clasificado en El hombre en el Universo, Hacia el futuro ~

Comments (0)

Comments (0)

La vieron caer y corrieron hasta el lugar.La escena era la que se podía esperar despuès de la caída de una nave en plena montana. Los pocos testigos que por el lugar estaban, llamaron a las autoridades que enviaron, de inmendio, a personal especializado en este tipo de investigaciones.

“Mira, un trazo de la nave caída, ¿de qué materiales estará hecha? ¡Nunca he visto algo así! ¿De dónde vendrán estos seres, de qué estará conformado su mundo?” Esto preguntaba uno de los investigadores al otro que con él, recogía muestras dequella extraña nave caída y que, según el seguimiento hecho en su acercamiento a la Tierra, venía de más allá de los confines del Sistema Solar y, quién sabe de dónde pudieron partir. Sin embargo, el material que recogían, debería ser el mismo que está repartido por todo el Universo.

Lo único que puede diferir, es la forma en que se utilice, el tratamiento que se le pueda dar, y, sobre todo el poseer el conocimiento y la tecnología necesarios para poder obtener, el máximo resultado de las propiedades que dicha materia encierra. Porque, en última instancia ¿es en verdad inerte la materia?

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránidos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobre pasando a la emisión de partículas alfa.

¡Parece que la materia está viva!

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas. El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lentos, que significa “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54) x 10-31kg la primera y, 1,602 177 33 (49) x 10-19 culombios, la segunda, y también su radio clásico: no se ha descubierto aún ninguna partícula que sea menos cursiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora para poder construir conjuntos tan bellos como el que abajo podemos admirar.

¡No por pequeño, se es insignificante!

Recordémoslo, todo lo grande está hecho de cosas pequeñas. En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones. Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de o, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm. De longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es o, su carga es o, y su espín de 2. Como el fotón, no tiene antipartícula, ellos mismos hacen las dos versiones.

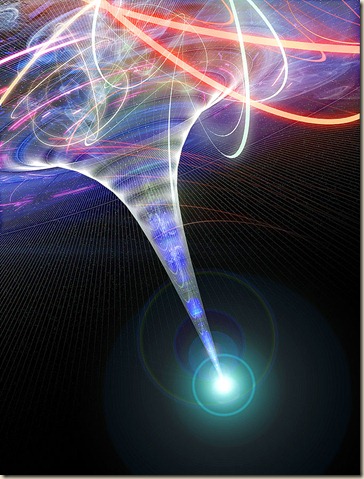

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones.

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transportan de este mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10 ^ – 43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61 × 10 ^ – 66 cm2) juega un papel clave en la entropía de un agujero negro.

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven.

Andamos a la caza del vacío, del gravitón, de las ondas gravitatorias…

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10 ^-2 pascales, mientras que un alto vacío tiene una presión de 10 ^-2 – 10 ^-7 pascales. Por debajo de 10 ^-7 pascales se conoce como un vacío ultraalto.

De ese “vacío” nos queda muchísimo por aprender. Al parecer, todos los indicios nos dicen que está abarrotado de cosas, y, si es así, no es lo que podemos llamar con propiedad vacío, ese extraño lugar es otra cosa, pero, ¿qué cosa es?

Antes se denominaba éter fluminigero (creo) a toda esa inmensa región. Más tarde, nuevas teorías vino a desechar su existencia. Pasó el tiempo y llegaron nuevas ideas y nuevos modelos, y, se llegó a la conclusión de que el Universo entero estaba permeado por “algo” que algunos llamaron los océanos de Higgs. Ahí, se tiene la esperanza de encontrar al esquivo Bosón que le da la masa a las demás partículas, y, el LHC del CERN, es el encargado de la búsqueda para que el Modelo Estándard de la Física de Partículas se afiance más.

Andamos un poco a ciegas, la niebla de nuestra ignorancia nos hace caminar alargando la mano para evitar darnos un mamporro. Pero a pesar de todo, seguimos adelante y, es más la fuerza que nos empuja, la curiosidad que nos aliente que, los posibles peligros que tales aventuras puedan conllever.

Está claro que, dentro del Universo, existen “rincones” en los que no podemos sospechar las maravillas que esconden, ni nuestra avezada imaginación, puede hacerse una idea firme de lo que allí pueda existir. Incansables seguimos la búsqueda, a cada nuevo descubrimiento nuestro corazón se acelera, nuestra curiosidad aumenta, nuestras ganas de seguir avanzando van creciendo y, no pocas veces, el físico que, apasionado está inmerso en uno de esos trabajos de búsqueda e investigación, pasa las horas sin sentir el paso del tiempo, ni come ni duerme y su mente, sólo tiene puesto los sentidos en ese final soñado en el que, al fín, aparece el tesoro perseguido que, en la mayor parte de las veces, es una nueva partícula, un parámetro hasta ahora desconocido en los comportamientos de la materia, un nuevo principio, o, en definitiva, un nuevo descubrimiento que nos llevará un poco más lejos.

Encontrar nuevas respuestas no dará la opción de plantear nuevas preguntas.

Totales: 75.036.734

Totales: 75.036.734 Conectados: 104

Conectados: 104