Sep

9

¡La Humanidad! ¡Cuántas historias!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Historia para mirar ~

Clasificado en Historia para mirar ~

Comments (0)

Comments (0)

¡Qué historias!:

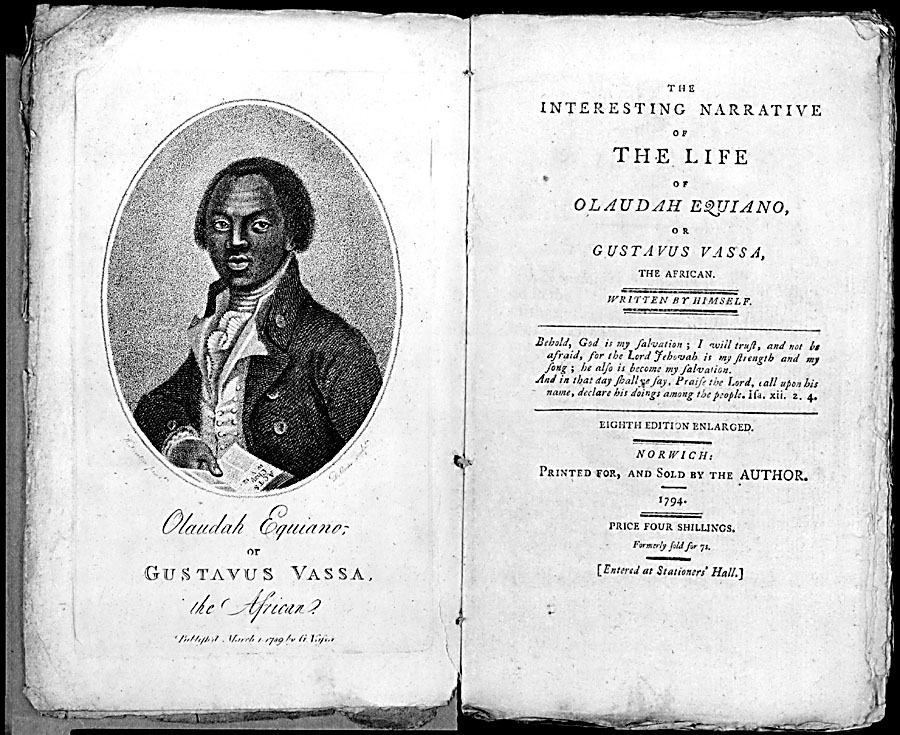

GUSTAVUS VASSA, la voz de veinte millones de esclavos.

CHARLES DARWIN, el naturalista que dinamitó el dogma religioso.

HENRY M. STANLEY, el aventurero que le arrancó a África sus secretos.

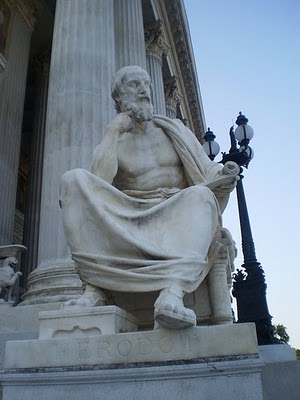

HERÓDOTO, el viaje como aprendizaje de la tolerancia.

MARCO POLO, el inventario del mercader.

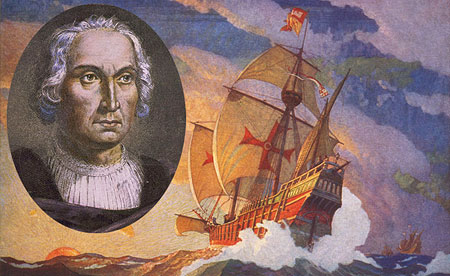

CRISTÓBAL COLÓN, la fiebre del oro.

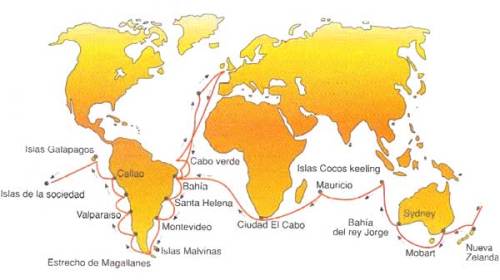

PIGAFETTA, cronista de la primera vuelta al mundo.

Muchos más serían los nombres que podríamos poner aquí en representación de aquellos viajeros, aventureros, comerciantes, o, que simplemente querina descubrir nuevas tierras y conocer a nuevos pueblos para aprender de sus cultiuras. La historia de la Humanidad es la historia de los desplazamientos y de los viajes.

Ningún pueblo ha ocupado desde el principio el territorio en el que hoy se asienta y donde ha colocado sus fronteras. Ninguna gran cultura es producto de una evolución exclusivamente interna. Por el contrario, la historia de la civilización es la del contacto entre unos pueblos y otros. Los avances tecnológicos y sociales se deben, fundamentalmente, a la incorporación de elementos externos con los que se entra en contacto gracias a un viaje. Es imposible imaginar el devenir de la Humanidad si las sociedades no hubieran enviado a sus marinos y exploradores a tomar contacto con otras culturas, bien para comerciar con ellas, bien para conquistarlas e incorporar aquellos elementos nuevos que ayudaban a mejorar su calidad de vida, bien por humana curiosidad y deseo de conocimiento.

De todos aquellos viajes quedaron escritos y relatos

El propósito de las páginas que siguen es presentar algunos derroteros de la Historia de la Humanidad como consecuencia de los contactos entre culturas facilitados por los grandes viajeros: exploradores, comerciantes, científicos, guerreros, visionarios o, con mucha frecuencia, todo a la vez. Aunque la meta es ambiciosa no se presentan listados exhaustivos de todos los aventureros que se echaron el petate al hombro y se lanzaron a la conquista y descubrimiento de nuevos mundos, sino tan sólo de aquéllos que fueron los más afortunados, brillantes o representativos de su época.

Nos dejaron muchas pruebas de sus correrías por el mundo de la cultura

De los griegos, pueblo viajero, y culto, por excelencia, ninguno más significativo que Heródoto, un intelectual de la costa jonia que recorrió casi todo el mundo conocido y dejó un fresco imprescindible para conocer el escenario clásico en su monumental y enciclopédica Historia, redactada en el siglo V a.C.

Los romanos ampliaron su espacio geográfico unificando todos los pueblos ribereños del Mediterráneo bajo su órbita y añadiéndoles la Galia (Francia) y parte de Gran Bretaña, pero su Imperio no rebasó demasiado los límites ya conocidos de antemano y cuando colapsó, en el siglo IV de la era cristiana, los márgenes de su mapamundi no iban mucho más lejos del entrevisto por los griegos.

La expansión del Islam a partir del siglo VII, que unificó política y espiritualmente la ribera sur del Mediterráneo y lo que ahora conocemos como Oriente Medio, dejó en manos de los musulmanes el espacio entre Europa y Extremo Oriente. Dueños de las rutas entre ambos mundos, los grandes viajeros de la Edad Media fueron árabes.

Ninguno como el tangerino Ibn Battuta viajó tanto y ninguno dejó una obra de la magnitud de su rihla (relato de viaje), en la que expone la relación de sus desplazamientos por todo el mundo musulmán, en cuyo recorrido entretejió la historia de su vida y retrató un momento de gran esplendor de la cultura islámica.

Ibn Battuta

Este fue otro gran viajero de la Edad Media fue el árabe Ibn Battuta, que partió de su casa de Tánger en 1.325 con el objetivo, en primera instancia, de Peregrinar a la Meca. No obstante, una vez alcanzada su meta, Ibn Battuta decidió ir más lejos. Viajó a lo largo de la costa oriental de África y llegó luego a Asia Menor, antes de adentrarse en Asia Central en dirección a Afganistán y la India, país en el que fue muy bien recibido (era un cadí), como hombre culto y educado.

Ibn Battuta vivió durante siete años en la India, y como ya le ocurriera a Marco Polo, se convirtió en embajador del gobernante del país, el Sultán de Deli, en cuyo nombre realizó un viaje a China. Durante el camino tuvo muchas aventuras, fue asaltado, robado y abordonado por los bandidos que lo dieron por muerto, pero finalmente consiguió llegar a China en 1.346 o 1.347.

En los puertos chinos, Ibn Battuta encontró a muchos musulmanes, a los que en ningún sentido sorprendió su llegada. Tras regresar a su hogar, el siguiente viaje que realizó fue a España; luego partió para África Occidental y llegó hasta el río Níger, donde una vez más fue bien acogido, en esta ocasión por musulmanes negros. El relato de sus viajes se convirtió en la base de los estudios geográficos, astronómicos y marítimos en los centros de aprendizaje musulmanes de Córdoba y Toledo. Estas tradiciones contribuyeron en forma importante a las ideas que inspiraron los viajes de Colón.

En el año 1666 fallecía en Beijing el jesuita Johann Adam Schall von Bell. Miembro de una saga de misioneros jesuitas que se adentraron en China y entre los que destacó Mateo Ricci. Sus éxitos eran debidos a su interés por la civilización china y a su adaptación a ella.

Los cristianos, entretanto, se esforzaban en llegar a China para acceder a sus legendarias riquezas por caminos terrestres de los que oían hablar en los territorios de Tierra Santa ganados por las armas a los musulmanes en las Cruzadas. De ese empeño por salvar la barrera musulmana y comerciar con el otro confín del mundo conocido no hay cronista más representativo y exitoso que el veneciano Marco Polo. A él le tocó despertar la imaginación y la codicia de generaciones de marinos que, como Colón, buscaron rutas para llegar a Asia. Antes de que el genovés descubriera involuntariamente América, los portugueses habían logrado el hito de alcanzar la India rodeando a África para burlar el tapón islámico rodeándolo por mar. Vasco de Gama fue el responsable de esa hazaña, que orientó el expansionismo

portugués por derroteros que dejaron a Castilla las manos libres para avanzar hacia el Oeste en busca del Este. Nadie, sin embargo, como el citado Colón, encarna tanto el espíritu viajero y el éxito, pues a él le tocó descubrir un continente cuya colonización, para bien y para mal, transformó completamente el mundo, su percepción, el desigual reparto de la riqueza en el Globo y la internacionalización definitiva e imparable de la Historia con mayúscula. No en balde, el almirante está considerado por muchos como el hombre más decisivo de la historia de la Humanidad, no tanto por su carácter -pues era ambicioso y despiadado-, como por las consecuencias de su hallazgo, que él fue incapaz de comprender del todo antes de su muerte.

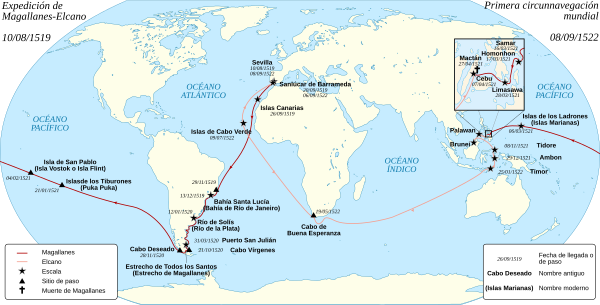

Poco después que él, un portugués, Magallanes, y un español, Elcano, capitanearon la primera expedición que daba la vuelta al mundo. El mapa plano de la Antigüedad, el mundo de Heródoto, con un centro geográfico y una periferia misteriosa y dramática, se curvaba y se convertía en esfera. En un mundo esférico no hay centro, los márgenes se tocan, los monstruos desaparecen de las esquinas del papel, los blancos se cubren de letras y de lugares conocidos.

La Historia se globalizaba por excelencia. Un viajero de la expedición, Pigafetta, escribió de aquel periplo un dramático y bello relato. Hay una excepción en la norma anterior. Un gran espacio permaneció aún durante muchos siglos en blanco, África.

Sin embargo, por paradójico que resulte, los hombres y mujeres más viajeros de los siglos XVI al XIX, ambos incluidos, fueron los africanos. Más de veinte millones de ellos, según los cálculos más optimistas, salieron encadenados de sus hogares para no regresar jamás y cruzaron el Atlántico para ser la mano de obra de las minas y las plantaciones en el Nuevo Mundo. Ni uno de cada cien mil logró dejar el testimonio de sus experiencias y la escasa literatura autobiográfica de esclavos negros estuvo casi siempre dictada por la voz de un blanco, que cuidaba de la corrección política del contenido de la denuncia. Pero hubo un africano excepcional, por su personalidad, por su genio, por su inteligencia y por su suerte.

Fue Olaudah Equiano, un esclavo que tras mil peripecias logró comprar su libertad; se embarcó como marino libremente contratado; escribió la historia de sus viajes, que era la misma que la de su vida, y fue uno de los líderes del movimiento abolicionista en el siglo XVIII. También conocido como Gustavus Vassa, el esclavo negro que conoció las costas de África, las plantaciones de las Antillas, el Sur de Estados Unidos, los icebergs de Groenlandia, la Costa Azul, el carnaval de Oporto y los minaretes de Esmirna antes de hacerse modestamente rico, famoso y respetado en los salones de Londres, es la voz de esos veinte millones de africanos sin voz. Su viaje, que le llevó de las cadenas a la primera fila de la lucha por la libertad, es mucho más importante de lo que reconocen los manuales y la mayoría de las síntesis eurocéntricas de Historia.

Otros viajeros del XVIII —el británico capitán Cook, el francés Bougainville— acabaron de peinar el Pacífico culminando la exploración de Australia y encontrando islas y archipiélagos cuyos pacíficos habitantes contribuyeron a forjar el mito del buen salvaje que tanto influyó en los filósofos de la Ilustración.

En 1831, un buque, el Beagle, partía de Plymouth con un pasajero excepcional a bordo, un joven de 22 años llamado Charles Darwin. En los siguientes cinco años, el biólogo observaría la naturaleza con ojos nuevos y, a base de comparar las variaciones formales en individuos de las mismas especies, llegaría a la decisiva formulación de la teoría de la evolución, que no sólo conmocionó al mundo de las ciencias naturales, sino a la mismísima base de las creencias espirituales. Porque la teoría de la evolución puso en tela de juicio las interpretaciones literales de la Biblia, que se revelaron obsoletas. Un viaje devenía así herramienta trascendental para la propia concepción del hecho mismo de la vida. El África de la que procedía Equiano dejó también de ser un mapa mudo en el siglo XIX. Acabada la trata de negros, que había paralizado el desarrollo del continente al Sur del Sáhara, las potencias europeas decidieron, en un sonrojante alarde de cinismo, ocupar la región para acabar con la esclavitud y llevar a sus oscuros habitantes las luces de la cristiandad.

Descubierto y generalizado el uso de la quinina para combatir la malaria, que había sido el arma biológica de África frente a los invasores, los europeos se lanzaron a explorar el interior del continente en una carrera que tuvo tanto de deportiva y elitista como de imperialista. De todos los grandes exploradores de África, dos obresalen de forma excepcional: el misionero Livingstone y el mercenario Stanley. Pero es el segundo el que mejor encarna al colonizador brutal del momento. Fue un explorador por encargo, que labró un inmenso predio al rey belga Leopoldo II, el Estado libre del Congo, donde se vivió una de las páginas más vergonzosas de la colonización

europea de África negra.

Con Stanley se cierra el ciclo de grandes viajeros cuyas hazañas cambiaron sin lugar a dudas el mundo, no siempre para bien. Estos son los hombres que protagonizan las páginas que siguen. Entre los grandes viajeros hubo también mujeres, pero en menor cantidad y con una mentalidad distinta, menos depredadora y más tolerante. Ellas merecen un libro aparte.

La antigua Grecia es la cuna de la civilización occidental.

Debemos a los griegos conceptos trascendentales como la filosofía, la oratoria, la política, la democracia y un canon de belleza que no ha perdido vigencia. Ellos fueron los creadores de la cultura urbana, inventores del teatro y sus géneros incombustibles, como la comedia y la tragedia. Su impronta y sus pautas marcaron el mundo de forma definitiva y somos sus eternos deudores. No se debe restar importancia al lado genial de la personalidad del mundo griego pero, sin duda, en su descomunal aportación a la historia de la civilización, influyó decisivamente el espacio físico que los pueblos de habla griega ocuparon, y su carácter viajero.

Los griegos florecieron en una encrucijada cultural enla que confluían influencias procedentes de Egipto, de Mesopotamia, de las colonias fenicias del Mediterráneo y de los contactos de sus naves con los pueblos bárbaros que moraban al Norte, más allá de los confines. Establecidos en una costa recortada y caprichosa, siempre cerca del mar, y sobre centenares de islas, sus navíos llevaron a los griegos a entrar en contacto con otras culturas cuyas creencias, valores y sistemas políticos eran muy diferentes.

Esa exposición prolongada a otros mundos introdujo la semilla que definió la cultura griega y que constituye su mayor legado: la cultura de la duda. Frente a pueblos aislados, como los egipcios —cultura extática por excelencia, encerrada entre el desierto y el mar y asida a las angostas riberas del Nilo—, que permanecieron mirándose el ombligo durante milenios, los griegos sacaron partido de su roce constante con el otro. Partido y una conclusión: que quizás sus creencias pudieran estar erradas. ¿Qué es la filosofía, que nació en la ciudad jonia de Mileto en el siglo VI a.C., sino la puesta en cuestión del mito, del relato religioso que explica el mundo de forma mágica, atribuyéndolo a la voluntad de los dioses? Al apuntar a otras explicaciones distintas para comprender el mundo que las difundidas por los sacerdotes, al cuestionar el mito y al dudar de las apariencias, al apelar a la razón, los griegos estaban sembrando la semilla del progreso. Y no hubieran podido plantar esa semilla si no hubieran entrado en contacto con sistemas de valores alternativos.

La vocación viajera; su espacio geográfico, en un cruce de caminos entre el Imperio persa en Oriente, el mundo egipcio en el Sur y las oportunidades que ofrecía la expansión hacia Occidente son algunas de las explicaciones del éxito de la fórmula griega. Pues bien, quien mejor plasmó por escrito ese relativismo cultural, que resulta ser intelectualmente dinamizador, frente a las culturas estáticas y autocomplacientes, como la egipcia, fue Heródoto, el más exitoso viajero griego de toda la Antigüedad.

La famosa tumba en Halicarnaso, actual ciudad de Bodrum

Nació en la ciudad de Halicarnaso, la actual Bodrum en Turquía, y su vida trascurrió a lo largo del siglo V a.C. del gran siglo de Pericles y del esplendor ateniense. Halicarnaso era una colonia doria en Asia Menor y, en su juventud, Heródoto participó en luchas políticas contra el tirano local que le acabaron empujando al exilio. Su temprana lucha política se reflejó en su obra, tanto en su deseo de conocer como en su defensa política de la democracia, el sistema ideal de gobierno de la polis, una institución que también vivió su edad de oro en ese momento y que es la cuna del concepto moderno de la civilización; de la ciudad como espacio de encuentro; de la asamblea como depositaria de la legitimidad de las leyes; y del diálogo, el debate y la razón como instrumentos para convencer en lugar de cómo armas para vencer.

Se saben pocos detalles de su vida. Desconocemos la fecha exacta de su nacimiento y la de su muere. No se sabe siquiera dónde acabó sus días, aunque se cree que pudo ser en una colonia griega de Sicilia. Su obra sin embargo, es una referencia clave de la cultura universal. Heródoto fue autor de la Historia, “investigación” en griego, un monumental trabajo en nueve libros, en los que describió los conocimientos

que los griegos tenían del mundo y los acontecimientos pasados que ayudaban a comprender su presente.

La obra de Heródoto es paradigma de la curiosidad y su manera de trabajar, exponiendo lo que ha visto personalmente y diferenciándolo de lo que le han contado, le ha hecho pasar a la posteridad como padre de la Historia, pero también del periodismo y como autor del mejor relato de viajes de la Antigüedad, aunque no fuera el único.

No da detalles personales, ni de su vida privada familiar, ni de cómo y con quién viajaba, ni precisa fechas de sus desplazamientos, pero se movería probablemente con grupos de comerciantes griegos que se desplazaban por el mundo conocido. No sólo recorrió las costas de su Jonia natal, en la parte griega de Asia Menor, sino el Mar Negro, las islas de Egeo, la ciudad de Tiro, Mesopotamia —al menos hasta Babilonia—, Egipto y la ciudad de Cirene en el norte de Libia, sin excluir las colonias griegas en el sur de Italia y Sicilia. Como todos los viajeros, no estaba familiarizado con la mayor parte de las lenguas de los extranjeros y dependía de intérpretes locales, a lo que se deben muchas de las inexactitudes que se detectan en su obra.

Es el gran cronista de la Antigüedad, aunque curiosamente ignorara o descartara algunos datos geográficos que los fenicios conocían con mucha anterioridad, como las islas Británicas —a las que los fenicios bautizaron como del estaño—, o del propio océano Atlántico, de cuya existencia duda. En otros casos, sin embargo, aporta datos que nadie había certificado hasta él, como que el Caspio era un mar cerrado cuyas medidas da con bastante aproximación.

Con todos los datos de que disponía, llenó el mapa conocido, pero no pudo superar las dificultades materiales de su tiempo para tener una idea global del conjunto y en su geografía mental coexisten los hechos con los mitos, lo visto con lo supuesto. No se desprende de una visión del mundo como un espacio con tres círculos o niveles: un centro ordenado donde se desarrolla la civilización, el espacio poblado por los griegos; una periferia bárbara, que quiere comprender y asimilar y por la que muestra admiración, y una frontera final exterior, donde todo era posible, hollada por seres mitológicos, situaciones meteorológicas extremas y riquezas deseables, pero casi imposibles de alcanzar. Los nueves volúmenes de su Historia dedican espacio a todos los lugares visitados por él. Lo hacen en función de lo sorprendido e interesado que se muestra ante cada uno de ellos. La mítica ciudad de Babilonia le fascina y deja de ella una descripción muy acertada:

“En Asia hay muchas ciudades realmente grandes, pero la más digna de mención, también la más poderosa, que después de la destrucción de Nínive se convirtió en la capital del país, fue Babilonia”, escribió.

Las ciudades de la antigua Mesopotamia. La ciudad de Babilonia es una de las más occidentales.

Pero fue Egipto el espacio que más le asombró y al que más páginas dedicó en su trabajo. Fue Heródoto quien definió a Egipto, que ocupa el libro segundo de su obra, como “don del Nilo”, una definición que sigue siendo lugar común en la actualidad y que da medida de la importancia de la crecida del gran río para regular el ritmo de vida del país. El mundo egipcio le fascinó sobremanera por su exotismo y su milenaria antigüedad, que empequeñece a los griegos. “Los egipcios dicen de sí mismos que ellos fueron los

que empezaron a aplicar nombres a los doce dioses y que los griegos los tomaron de ellos. Fueron ellos los primeros que dedicaron imágenes, altares y templos a los dioses y también los primeros que grabaron figuras de seres vivientes en la piedra”. En cierto sentido, podemos considerar a Heródoto como autor también de la primera guía turística de Egipto. “Los más religiosos de todos los hombres”, en sus palabras, le deslumbraron por sus costumbres funerarias, por sus creencias religiosas, por los monumentos que erigieron, como las Pirámides o los colosos y por su fauna.

Aquellos aniamles despertaron su curiosidad

Dedica muchas páginas a describir a los hipopótamos, los cocodrilos, los ibis y otros animales extraños. Incluso a los que no ha visto, como el ave fénix: “Yo la he visto solamente en pinturas, pues acude a ellos muy de tarde en tarde, sólo cada quinientos años, según dicen los de Heliópolis…” “Según”, esa es la palabra que le sirve para distanciarse de aquello que no ha visto, sino que le han contado.

Lo que sí vio personalmente fueron las distintas formas de embalsamar los cadáveres. Las describe con certera precisión, con una frescura increíble, cuando relata cómo los

embalsamadores tienen comercios donde muestran modelos madera —algo así como los modernos maniquíes— queles sirven para explicar a los clientes, los deudos del reciénfinado, los modelos de embalsamamiento y los costes decada sistema. Los más seguros y duraderos, con más garantíade eternidad, los más caros, como en cualquier oficio.Con su recurso al “según” o al “me han contado”, Heródoto distingue entre lo visto —los animales, los monumentos, las costumbres— y lo oído —la Historia, el mito— en un ejercicio de honestidad y rigor intelectual ejemplares.

Así, la descripción de Egipto se divide en dos parte y cuando aborda la segunda, advierte: “Hasta aquí he tratado de mi visión personal, de mi parecer y de lo que resulta de mis investigaciones; a partir de ahora expondré la historia de Egipto tal como la he oído.” En el otro confín, los escitas, los pueblos que se extienden al Norte y Este del mar Negro, hacia las llanuras de Asia, despiertan su imaginación y curiosidad casi con la misma intensidad que los egipcios. Pero estos pueblos más atrasados cultural y tecnológicamente no tienen grandes monumentos ni ciudades dignas de tal nombre. Lo que le atrae de ellos son sus costumbres. Sobre todo, las relacionadas con la muerte y los hábitos sexuales. Heródoto conoció también Libia, al menos la ciudad costera de Cirene, pero no viajó hacia el Sur y su descripción del mundo que ocultaban las ardientes arenas es “de oídas” y se limita a enumerar oasis mal localizados.

La principal lección de Heródoto no es, sin embargo, la precisión geográfica, sino su apertura de mente. A base de comparar los valores de unos y otros pueblos visitados, las dispares creencias de las culturas que pueblan el mundo conocido, llega a una actitud relativista, y por tanto tolerante y no excluyente. El viaje, en sus manos, es un instrumento de conocimiento, de perfeccionamiento interior, de investigación para comprendernos a nosotros mismos, a través de las diferencias que mantenemos con otros, y de ampliar miras. El viaje es un arma contra la intransigencia y un tributo a la tolerancia. Ello hace de Heródoto un brillante exponente del mundo clásico y convierte a su obra en un hito, pues el suyo es el primer texto que muestra el valor del viaje como herramienta de reflexión social y, por lo tanto, instrumento para modelar voluntariamente la Historia.

Tenía Herodoto una gran imaginación y, se tomaba licencias…

Ese empeño participativo, ese intento de escribir para transformar la realidad, es el arranque confeso de su trabajo. Éstas son las primeras líneas de su Historia: “En lo que sigue, Heródoto de Halicarnaso expone el resultado de sus investigaciones para evitar que, con el tiempo, caiga en el olvido lo ocurrido entre los hombres…” No fue el único viajero griego que dejó testimonio escrito de sus desplazamientos, no fue el único viajero griego que hizo lo que podemos llamar simplificadamente literatura de viaje, como hemos señalado. Unos lo habían hecho antes que él, Escílax de Carianda recorrió las costas del Índico y Aristeas de Proconeso se había asomado a las brumas del Norte. Otros lo hicieron después, como el marsellés Piteas, que circunnavegó las islas británicas, llegó a la mítica Tule, probablemente en la actual Noruega, y bordeó las costas de Germania.

Pero en lo esencial, con el añadido del Mediterráneo occidental, el mundo de Heródoto, el mundo ribereño del mare nostrum, como lo bautizarían los romanos, es el escenario en que se va a dilucidar la historia de Occidente durante los siglos siguientes, cuyo gran protagonista político es el Imperio romano.

No fueron los romanos grandes exploradores, aunque sí muy viajeros. Pero no hay entre ellos un Heródoto. Su mundo consolidó un espacio unificado políticamente entorno al Mediterráneo, cuyo límite al Norte fueron los ríos Rhin y Danubio y los bosques de Germania; al Oeste, el Atlántico, infranqueable para la navegación de la época; al Sur, el desierto del Sáhara, que aislaba la franja colonizada y romanizada del África negra; al Este, los partos en Mesopotamia y Persia, les taponaban el paso a la India y China, aunque hubo relaciones comerciales con el Decán, como atestiguan las monedas romanas halladas allí y aún cabe la posibilidad de que marinos romanos llegaran a China, si se han de creer crónicas chinas que mencionan la llegada de emisarios del emperador An-Tun, que algunos historiadores sostienen que se trataba de Antonino.

Pero en lo esencial, con las salvedades hechas, el mundo de Heródoto es el escenario geográfico que se mantiene conocido sin ampliaciones significativas hasta el fin del Imperio romano, casi mil años después. Cuando los bárbaros desbordaron el limes, la frontera romana, y se adueñaron del Imperio, la representación del mundo seguía siendo básicamente la misma: un centro ordenado en torno al Mediterráneo, un segundo círculo habitado por pueblos bárbaros y una periferia salvaje, extrema, temible y poblada de seres fantásticos y monstruosos. Hasta que, en la Baja Edad Media, algunos viajeros cristianos lograron llegar a China atravesando el corazón de Asia, los europeos tendrían poco que añadir a esta imagen.

Publicado por emilio silvera para el deleite y el saber de todos los que curiosos, se asomen por aqui.

Para leer más:

• Heródoto: Historia (edición de Manuel Balasch), Cátedra, Madrid, 1999.

• F. Javier Gómez Espelosín: El descubrimiento del mundo. Geografía y

viajeros en la antigua Grecia, Madrid, Akal, 2000.

• R. Kapuscinski: Viajes con Heródoto, Barcelona, Anagrama, 2006.

Sep

9

Todo, cuando lo llegamos a conocer, tiene su historia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astrofísica ~

Clasificado en Astrofísica ~

Comments (0)

Comments (0)

“Alnitak, Alnilam, y Mintaka son las brillantes estrellas azuladas de este a oeste (de izquierda a derecha) a lo largo de la diagonal de esta maravillosa vista cósmica. Por otro nombre conocidas como el Cinturón de Orión, estas tres estrellas azules supergigantes son mucho más calientes y masivas que el sol.

Nacidas de las bien estudiadas nubes interestelares de Orión, se encuentran a unos 1.500 años luz. De hecho, las nubes de gas y polvo que vagan por esta región son de lo más enigmático, y algunas tienen formas sorprendentemente familiares, incluyendo la oscura nebulosa Cabeza de Caballo y la nebulosa Llama, cerca de Alnitak, abajo a la izquierda.

La famosa nebulosa Orión misma se extiende al fondo de este campo de estrellas que abarca unos impresionantes 4,4 x 3,5 grados del cielo.

La imagen en color fue realizada a partir de placas fotográficas en blanco y negro digitalizadas, grabadas a través de filtros astronómicos rojos y azules, con un canal verde sintetizado por ordenador. Las placas fueron tomadas usando el telescopio Samuel Oschin, un instrumento de observación de campo amplio en el observatorio Palomar, entre 1987 y 1991.”

La Nubulosa de Orión, se podría decir que es “nuestra Nebulosa”, la que está en nuestro Barrio, en las cercanías de casa

Fuente: Astronomía Picture of The Day

Sep

9

Buscando respuestas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Las fuerzas que podemos sentir en la vida cotidiana, es decir, la Gravedad y el electromagnetismo, aumentan con la cercanía: así, cuando más cerca está un clavo de un imán o una manzana del suelo, más se verán atraídos. Por el contrario, la interacción fuerte disminuye cuanto más cerca y juntas están las partículas en el interior de los átomos, aumentando cuando las partículas se alejan las unas de las otras.

El descubrimiento de esta extraña propiedad, llamada libertad asintótica, supuso toda una revolución teórica en los años 70 (se publicó en 1.973), pero ya plenamente respaldada por los experimentos en los aceleradores de partículas, aconsejó, a la Academia, conceder 30 años más tarde, el Premio Nobel de Física a sus autores.

Franck Wilczek, unos de los tres autores de la teoría que, cuando le comunicaron la concesión del Nobel comentó:

“Ha sido un gran alivio. He estado pensando en ello durante mucho tiempo. No estaba claro que fuera un adelanto en aquel momento. La teoría que propusimos era descabellada en muchos aspectos y tuvimos que dar muchas explicaciones”, reconoció el investigador.”

Tanto Wilczek como Politzer eran aun aspirantes a doctores en 1.973, cuando publicaron su descubrimiento en Physical Review letters. Junto a su informe, la misma revista incluyó el trabajo de David Gross, que unido al de los dos estudiantes dio lugar a la celebrada teoría de la Cromodinámica Cuántica (QCD).

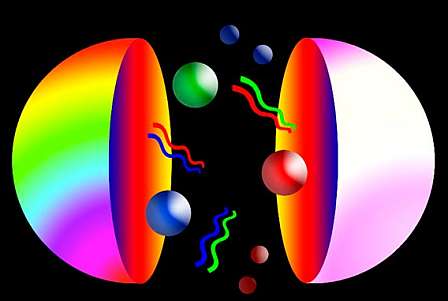

Los quarks vienen en seis diferentes ‘sabores’ y poseen una carga de color

Siguiendo una arraigada costumbre de la Física de partículas, los investigadores emplearon nombres comunes y desenfadados para señalar sus nuevos descubrimientos y llamaron “colores” a las intrincadas propiedades de los quarks.

Por ello, su teoría es conocida en la actualidad por el nombre de Cromodinámica (cromo significa “color” en griego), a pesar de que no tienen nada que ver con lo que entendemos y llamamos color en nuestra vida cotidiana, sino con el modo en que los componentes del núcleo atómico permanecen unidos. En este sentido, resulta mucho más intuitiva, aunque no menos divertida, la denominación de las partículas que hacen posible la interacción fuerte, llamadas gluones (glue es “pegamento” en inglés).

Al igual que en la teoría electromagnética, las partículas pueden tener carga positiva o negativa, los componentes más diminutos del núcleo atómico pueden ser rojos, verdes o azules. Además, de manera análoga a como las cargas opuestas se atraen en el mundo de la electricidad y el magnetismo, también los quarks de distinto color se agrupan en tripletes para formar protones y neutrones del núcleo atómico.

Pero estas no son las únicas similitudes, ni siquiera las más profundas, que existen entre las distintas fuerzas que rigen el Universo. De hecho, los científicos esperan que, en última instancia, todas las interacciones conocidas sean en realidad la manifestación variada de una sola fuerza que rige y gobierna todo el cosmos.

Según la Academia Sueca, el trabajo premiando a estos tres Físicos, “constituye un paso importante dentro del esfuerzo para alcanzar la descripción unificada de todas las fuerzas de la Naturaleza”. Lo que llamamos teoría del todo.

Según Frank Wilczek, que ahora pertenece al Instituto Tecnológico de Massachussets (MIT), su descubrimiento “reivindica la idea de que es posible comprender a la Naturaleza racionalmente”. El físico también recordó que “fue una labor arraigada en el trabajo experimental, más que en la intuición”.

Sabemos que los quarks -hasta el momento-, son las partículas más elementales del núcleo atómico donde forman protones y neutrones. La interacción fuerte entre los quarks que forman el protón es tan intensa que los mantiene permanentemente confinados en su interior, en una región ínfima. Y, allí, la fuerza crece con la distancia, si los quarks tratan de separarse, la fuerza aumenta (confinamiento de los quarks), si los quarks están juntos los unos a los otros, la fuerza decrece (libertad asintótica de los quarks). Nadie ha sido capaz de arrancar un quak libre fuera del protón.

Con aceleradores de partículas a muy altas energías, es posible investigar el comportamiento de los quarks a distancias muchos más pequeñas que el tamaño del protón.

Así, aquel trabajo acreedor al Nobel demostró que la fuerza nuclear fuerte actúa como un muelle de acero, si lo estiramos (los quarks se separan), la fuerza aumenta, si lo dejamos en reposo, en su estado natural, los anillos juntos (los quarks unidos), la fuerza es pequeña.

Así que la Cromodinámica Cuántica (QCD) describe rigurosamente la interacción fuerte entre los quarks y, en el desarrollo de esta teoría, como se ha dicho, jugaron un papel fundamental los tres ganadores del Nobel de Física de 2004.

Trabajos y estudios realizados en el acelerador LEP del CERN durante la década de los 90 hicieron posible medir con mucha precisión la intensidad de la interacción fuerte en las desintegraciones de las partículas z y t, es decir a energías de 91 y 1,8 Gev, los resultados obtenidos están en perfecto acuerdo con las predicciones de ACD, proporcionando una verificación muy significativa de libertad asintótica.

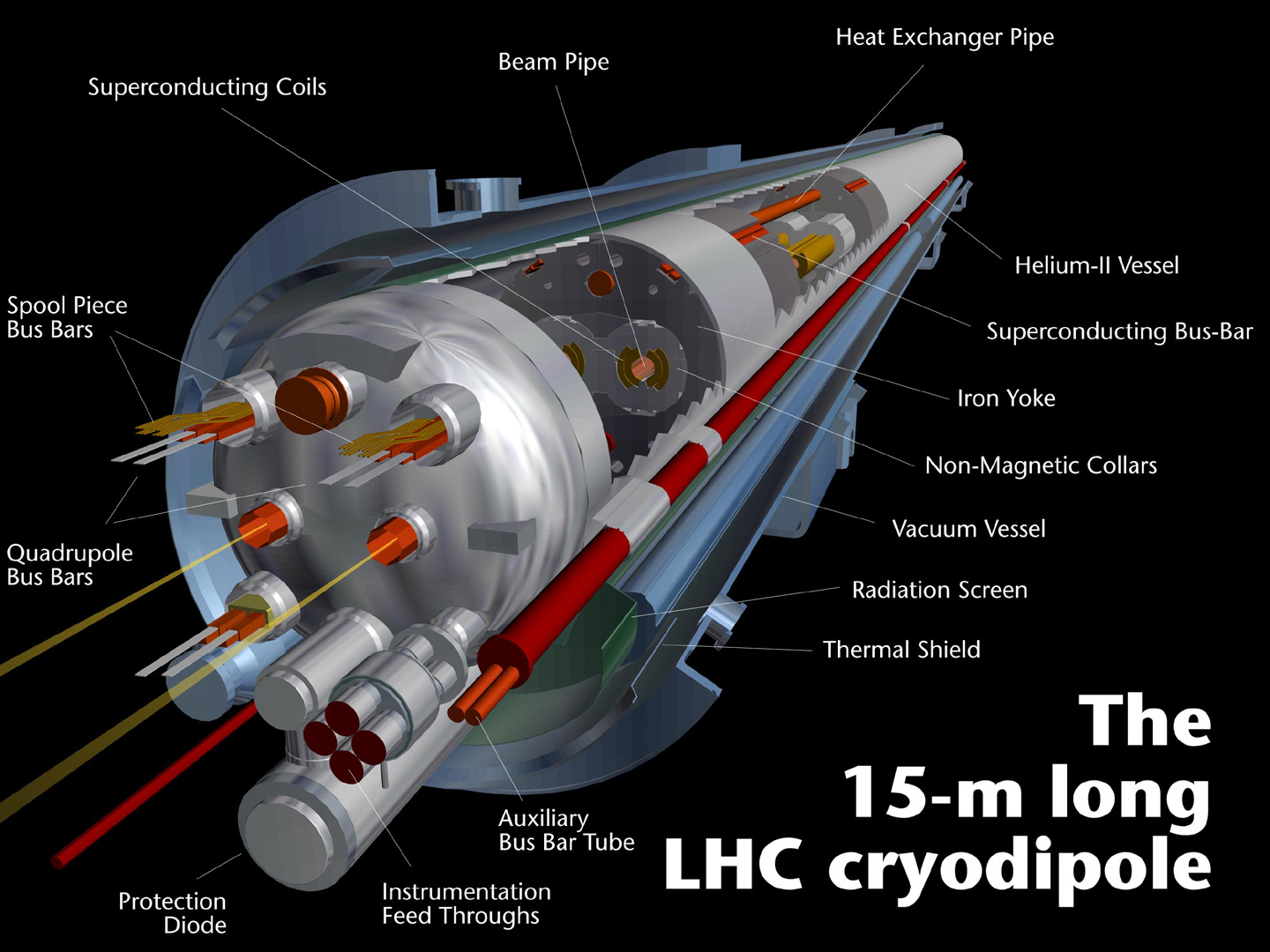

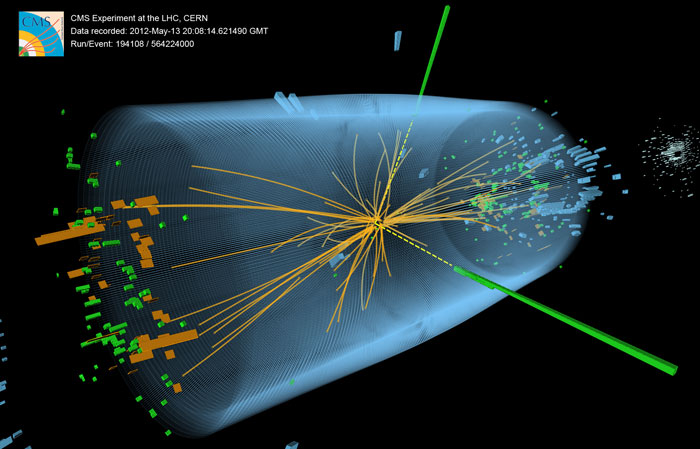

Mini Big Bang a 100 metros bajo tierra

Simular el nacimiento del Universo no resulta nada sencillo. Primero hay que excavar un túnel subterráneo de 100 metros de profundidad, en cuyo interior se debe construir un anillo metálico de 27 kilómetros enfriado por imanes superconductores cuya función es mantener una temperatura bastante fresca, nada menos que 271 grados bajo cero.

A continuación, hay que añadir a la ecuación dos puñados de protones, lanzados al vacío de este tubo subterráneo en direcciones opuestas, y a una velocidad inimaginable que prácticamente debe rozar la velocidad de la luz en el vacío. Es solo entonces cuando los múltiples colisiones de partículas que se produzcan en el interior del anillo producirán condiciones que existían inmediatamente después del Big Bang, ese descomunal estallido cósmico que dio el pistoletazo de salida para el surgimiento de nuestro mundo y de la vida inteligente a partir de esta materia inerte creada y evolucionada después en las estrellas.

Así, en el corazón de la cordillera del Jura, justo en la frontera entre Francia y Suiza, el Centro Europeo de Investigaciones Nucleares (CERN), está intentando llegar más lejos de lo que nunca se logró llegar. Se trata de conseguir encontrar la fuente creadora de la masa, y, según una teoría que existe desde hace décadas, el secreto está en una partícula, un Bosón que lleva el nombre del físico teórico que predijo su existencia: ¡El Bosón de Higgs! que, si realmente existe, dará consistencia a uno de los parámetros aleatorios que conforman en el modelo estándar y, si por el contrario, no se llega a encontrar, nos dará la opción de buscar en otra dirección. Ya sabéis que los físicos del CERN han declarado en rueda de prensa que han encontrado una partícula que lleva todas las papeletas para ser el famoso Bosón.

¿Lo será en realidad?

Este acelerador tan largamente esperado comenzó a funcionar hace unos años y han sido realizadas algunas pruebas de cuyos resultados, tenemos respuestas parciales y, el principal objetivo de encontrar el Bosón de Higgs, aún no se ha producido. Las partículas que se inyectan en su interior colisionan -aproximadamente- seiscientos millones de veces por segundo, desencadenando la mayor cantidad de energía jamás observada en las condiciones de un laboratorio, y, aunque aún estará muy alejada de la energía necesaria para comprobar la existencia de las cuerdas vibrantes (1019 GeV), lo cierto es que, disponer de 14 TeV en el ámbito de los aceleradores de partículas, ha sido el sueño de los físicos durante décadas.

Ahora descubrirán nuevas partículas antes desconocidas, se sondearan distancias infinitesimales en las entrañas de la materia, se recogeran datos asombrosos y también, tendremos algunas respuestas a preguntas planteadas que no pudimos contestar, y, no sería de extrañar que, en ese “universo” profundo de altas energías, también podamos “ver” la sombra de esa materia “perdida” y, seguramente, alguna inesperada aparición. El LHC producirá tantos datos que, si apilamos los CD generados con ellos y los pusiéramos unos encima de otros, la pila alcanzaría más de 20 kilómetros de altura. Muchísimos físicos repartidos por todo el mundo están ahora mismo, tratando de desvelar toda esa información y, los resultados, pueden ser alucinantes.

El trabajo que se lleva a cabo en el CERN constituye una contribución muy importante al conocimiento de la Humanidad para comprender el mundo que nos rodea. Algunos han criticado la inversión que supone llevar a cabo proyectos como este del LHC, sin embargo, si conocieran la contribución que en el CERN y el FERMILAB se han podido hacer en favor de la Humanidad…, ¡se estarían calladitos!

La pregunta clave: ¿De qué estará conformada realmente la materia de nuestro Universo?

Si lo miramos detenidamnete, nos pueden parecer increíbles los logros de conocimientos que nuestra especie ha podido conquistar al desvelar, secretos de la Naturaleza que estaban profundamente escondidos. Todo ese saber nos ha permitido construir maravillas tecnológicas que, como el Hubble o el LHC, nos llevan hasta los confines del Universo lejano y también, hasta los confines del corazón de la materia.

Por ejemplo: Con el Hubble hemos captado imágenes de Galaxias situadas a tántas distancias como unos pocos cientos de millones de años después del Big Bang, o, explosiones supernovas. En los sistemas criogénicos del LHC, se debe mantener ese inimaginable frío de 271 grados bajo cero y los campos electromagnéticos deben asegurar que la aceleración de los haces de partículas recorran los 27 km del anillo subterráneo a un 99,99% de la velocidad de la luz.

Tocando la creación

Cada segundo, un protón da 11.245 vueltas al anillo del LHC. Teniendo en cuenta que cada haz de estas partículas tendrá una duración de 10 horas, se estima que recorrerá un total de 10.000 millones de kilómetros (suficiente para llegar a Neptuno y volver). La energía requerida por el haz de protones al viajar por el acelerador es el equivalente a un coche viajando a 1 .600 km/h por el carril rápido de una autopista imposible, o la cantidad de energía almacenada en los imanes superconductores que mantendrán la temperatura a -271° sería suficiente para derretir 50 toneladas de cobre.

El LHC está dividido en 8 sectores de 3,3 km cada uno, y,en ellos, se llevan a cabo las colisiones que simulan -en miniatura-, las condiciones del Big Bang. El Bosón de Higgs, el tesoro más deseado, será el premio. Una partícula que predice el modelo teórico actual de la Física, pero para el que hasta el momento, no existen evidencias y, aquel anuncio del hallazgo de una partícula nueva que tenían que estudiar…, es sospechoso y huele a excusa, ya que, de momento, no se encontró nada del dichoso Bosón del físico escocés que propuso su existencia en 1.964 y cuya existencia parece crucial para comprender cómo la materia adquiere su masa.

Recuerdo las declaraciones de John Ellis, uno de los investigadores del CERN que, en la puesta en marcha dijo:

“Si no encontramos la partícula de Higgs, esto supondría que todos los que nos dedicamos a la Física teórica llevamos 35 años diciendo tonterías”.

Esperémos que no sea así, y que en el LHC se pueda encontrar las respuestas durante tanto tiempo esperadas. Sin embargo, la cosa no resultará fácil. Por otra parte, tendremos que recordar que no siempre se pudo verificar lo que los teóricos predijeron. El caso de Dirac y el positrón, el neutrino de Pauli y otros, son los casos que nos llevan a tener esperanzas en la intuición humana.

emilio silvera

Sep

9

Un Rumor del saber del mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (6)

Comments (6)

Los pensadores del Renacimiento creían que todo el Universo era un modelo de la idea divina y que el hombre era “un creador que venía después del creador divino”. Esta concepción era el concepto de belleza, una forma de armonía que reflejaba las intenciones de la divinidad. ¡Cuánta ignorancia! que, por otra parte, debemos comprender en aquel contexto.

Leonardo Da Vince y Miguel Ángel Buonarroti

Lo que era placentero para los ojos, el oído y la mente era bueno, moralmente valioso en sí mismo. Más aún: revelaba parte del plan “divino” para la Humanidad, pues evidenciaba la relación de las partes con el todo.

Este ideal renacentista de belleza respaldaba la noción de que ésta tenía dos funciones, noción aplicable a todas las disciplinas. En un nivel, la arquitectura, las artes visuales, la música y los aspectos formales de las artes literarias y dramáticas informaban a la mente; en segundo nivel, la complacían mediante el decoro, el estilo y la simetría en la Pintura y la escultura. De esta forma se estableció una asociación entre belleza e ilustración. También esto era lo que entonces significaba la sabiduría.

Filósofos,artistas y pensadores del renacimiento se plantearon retomar cánones de belleza establecidos pr las culturas clásicas dela antigüedad

El fin perseguido era el deseo de universalidad personal, la consecución de conocimientos universales, la conjunción de disciplinas diferentes como ramas del todo, del saber profundo que abarcaba desde el núcleo las distintas esferas del conocimiento universales, la conjunción de disciplinas diferentes como ramas del todo, del saber profundo que abarcaba desde el núcleo las distintas esferas del conocimiento como partes de ese todo.

Sep

8

¿Cambiaremos en el futuro?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Es bueno recordar lo que pasó ~

Clasificado en Es bueno recordar lo que pasó ~

Comments (1)

Comments (1)

Quiero recordar que fue Tomás Moro el primero que mencionó la palabra utopía, él la acuño queriendo significar y referirse a “lo que no es”, algo que queremos y deseamos pero que, las circunstancias actuales no lo permiten, un sueño de futuro, una esperanza que en el presente, es imposible de realizar y si la queremos, tendremos que luchar por conseguirla. Cuando decimos que algo es utópico nos estamos refiriendo a una cosa, un estado de cosas que sería deseable pero que, las circunstancias actuales no permiten y tenemos que tratar de cambiarlas para hacerla realidad. Es como el sueño de hoy que se realizará en el futuro sólo si ponemos los medios para ello.

Él, Bartolomé de Las Casas, cuando fue consciente del trato injusto que los españoles daban a los Indios nativos, comenzó una lucha en su defensa que se convirtió en la utopía que aún perdura en algunos lugares de nuestro planeta: Hacer dignos a todos los seres humanos y respetar sus derechos que continuamente estamos vulnerando. Si miramos en cualquier sitio, del personaje nos dirán:

“Bartolomé de las Casas O.P. (24 de agosto de 1474 o 14841 – 17 de julio de 1566) fue un encomendero español y luego fraile dominico, cronista, filósofo, teólogo, jurista, “Procurador y protector universal de todos los indios”, obispo de Chiapas en el Virreinato de Nueva España -actual México-, escritor y el principal apologista de los indios.”

Algunos, bien intencionados chocaban con la realidad cruda y descarnada de los hombres miserables y faltos de moral que sólo querían enriquecerse

Las Historias que se pueden contar de la llegada de los españoles a aquellas tierras, no siempre son edificantes y, lo cierto es que trastornaron la vida de aquellos sencillos seres que, en su entorno y a su manera, eran felices. Incluso después de ser ordenado, hacia 1512, Las Casas siguió sin percibir la injusticia que con los indios se estaba cometiendo. Sin embargo, un día de 1514, mientras preparaba en su finca de Cuba el sermón del domingo de Pentecostés que iba a proniunciar en la nueva colonia de Sancti Spiritus, fue súbitamente iluminado:

“Aquel que sacrifica una cosa obtenida injustamente -leyó en el Eclesiastés- hace una oferta ridícula, y los presentes de los hombres injustos no son aceptados”

Al cabo de unos días, repitiendo la experiencia de San Pablo, era un hombre distinto. Completamente convencido de “que todo lo que se ha hecho a los indios hasta ahora es injusto y tiránico”, decidió a los cuarenta años dedicar su vida a “la justicia de esos pueblos indios y a censurar el robo, la maldad y la injusticia cometida con ellos.

¡Cuántas barbaridades cometidas en el nombre de Dios!

Nella fantasia – Sarah Brightman – Concert Vaticano

emilio silvera

Totales: 75.136.431

Totales: 75.136.431 Conectados: 48

Conectados: 48