Sep

3

¡La Física! Que nos dice como es la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (10)

Comments (10)

Hay una anécdota que se cuenta y que ilustra la dificultad de muchos para reconciliar el trabajo de Eddington sobre las constantes fundamentales con sus monumentales contribuciones a la relatividad general y a la astrofísica. La historia la contaba Sam Goudsmit referente a él mismo y al físico holandés Kramers:

Samuel Abraham Goudsmit, George Uhlenbeck y Hendrik Kramers

“El gran Arthur Eddington dio una conferencia sobre su derivación de la constante de estructura fina a partir de una teoría fundamental. Goudsmit y Kramers estaban entre la audiencia. Goudsmit entendió poco pero reconoció que era un absurdo inverosímil. Kramers entendió mucho y reconoció que era un completo absurdo. Tras la discusión, Goudsmit se acercó a su viejo amigo y mentor Kramers y le preguntó: ¿Todos los físicos se vuelven locos cuando se hacen mayores? Tengo miedo. Kramers respondió, “No Sam, no tienes que asustarte. Un genio como Eddington quizá puede volverse loco pero un tipo como tú sólo se hace cada vez más tonto”.

Sep

3

Los seres vivos del planeta, están a merced de la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (2)

Comments (2)

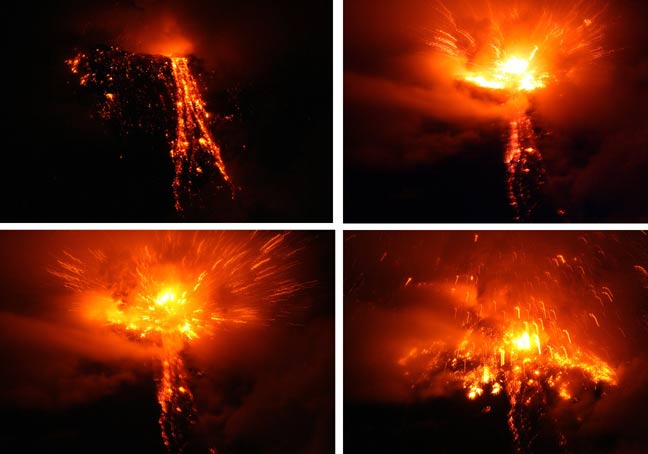

Las erupciones volcánicas

Con más frecuencia de lo que nos gustaría, en las noticias, nos comunican sucesos de erupciones volcánicas en distintos lugares de la Tierra con la consiguiente evacuación de personas para evitar muertes innecesarias. El Caos y la destrucción que nos puede dar la variedad de colores, olores y sabores que, junto con la belleza destruida o construida cambia el paisaje del lugar donde puedan ocurrir acontecimientos como este. Así ha venido ocurriendo desde que el mundo es mundo.

Los volcanes han existido desde los inicios de la Tierra hace 4.500 millones de años. Si bien las erupciones volcánicas pueden destruir la flora y la fauna en su entorno, la lava enriquece el suelo con variados minerales. La mayor parte de los volcanes están situados a lo largo de los límites activos de las placas continentales. Los volcanes submarinos se hallan en regiones donde tienen lugar nueva formación de corteza terrestre, como en la dorsal oceánica. Estos volcanes pueden formar islas.

Los volcanes terrestres se encuentran, por lo general, en zonas de subducción, que se hallan especialmente en el Océano Pacifico. Los volcanes situados en las regiones costeras están distribuidos como una “sarta de perlas” y constituyen el anillo de fuego del Pacífico., en el que se encuentran más del 80% de los volcanes actuales. Además, los “puntos calientes” donde la fusión interna de la corteza crea magma, producen volcanes que son independientes de las placas continentales y sus limites. Un ejemplo de de este grupo lo constituyen los volcanes de Hawai.

Sep

2

En Física hablamos de masa, inercia…, ¡de tántas cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Cuando hablamos de masa, nos estamos refiriendo a la medida de la inercia de un cuerpo, es decir, su resistencia a la aceleración. Todos sabemos la inmensa cantidad de combustible que se necesita para enviar al espacio exterior a esos transbordadores que llevan suministros y astronáutas al espacio exterior para el mantenimeinto de la Estación Espacial Internacional. El esfuerzo, es vencer la masa que se quiere transportar hasta que esta, alcanzando los 11 km/s de velocidad, pueda escapar de la fuerza de gravedad de la Tierra y poder así, cumplir con su cometido.

De acuerdo con las leyes de Newton del movimiento, si dos masas distintas, m1 y m2, son hechas colisionar en ausencia de cualquier otra fuerza, ambas experimentaran la misma fuerza de colisión. Si los dos cuerpos adquieren aceleraciones a1 y a2, como resultado de la colisión, entonces m1 a1 = m2 a2. Esta ecuación permite comparar dos masas. Si una de las masas se considera como una masa estándar, la masa de todas las demás puede ser medida comparándola con esta masa estándar. El cuerpo utilizado para este fin es un cilíndro de un kilógramo de una aleación de platino iridio. llamado el estándar internacional de masa. La masa definida de esta forma es llamada masa inercial del cuerpo.

Las masas también se pueden definir midiendo la fuerza gravitacional que producen. Por tanto, de acuerdo con la ley de gravitación de Newton, mg = Fd2 / MG, donde M es la masa de un cuerpo estándar situado a una distancia d del cuerpo de masa mg; F es la fuerza gravitacional entre ellos, y G es la constante gravitacional. La masa definida de esta forma es la masa gravitacional. En el siglo XIX, Roland Eötvös (1848-1919) demostró experimentalmente que las masas inerciales y gravitatorias son indistinguibles, es decir, m1 = mg.

Aunque la masa se define formalmente utilizando el concepto de inercia, es medida habitualmente por gravitación. El peso (W) de un cuerpo es la fuerza con la que un cuerpo es atraído gravitacionalmente a la Tierra, corregido por el efecto de la rotación, y es igual al producto de la masa del cuerpo y la aceleración en caída libre (g), es decir, W = mg.

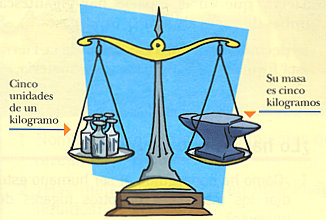

Kilogramo patrón.

El kilogramo (unidad de masa) tiene su patrón en: la masa de un cilindro fabricado en 1880, compuesto de una aleación de platino-iridio (90 % platino – 10 % iridio), creado y guardado en unas condiciones exactas, y que se guarda en la Oficina Internacional de Pesos y Medidas en Sevres, cerca de París.

|

| Una balaza mide solo cantidad de masa. |

La masa es la única unidad que tiene este patrón, además de estar en Sevres, hay copias en otros países que cada cierto tiempo se reúnen para ser regladas y ver si han perdido masa con respecto a la original.

No olvidemos que medir es comparar algo con un patrón definido universalmente.

¿Y el peso?

De nuevo, atención a lo siguiente: la masa (la cantidad de materia) de cada cuerpo es atraída por la fuerza de gravedad de la Tierra. Esa fuerza de atracción hace que el cuerpo (la masa) tenga un peso, que se cuantifica con una unidad diferente: el Newton (N).

La UNIDAD DE MEDIDA DEL PESO ES EL NEWTON (N)

Entonces, el peso es la fuerza que ejerce la gravedad sobre una masa y ambas magnitudes son proporcionales entre sí, pero no iguales, pues están vinculadas por el factor aceleración de la gravedad.

En el lenguaje común, el peso y la masa son frecuentemente usados como sinónimos; sin embargo, para fines científicos son muy diferentes. La masa es medida en kilogramos; el peso, siendo una fuerza, es medido en newtons (símbolo N. Unidad del SI de la fuerza, siendo la fuerza requerida para comunicar a una masa de un kilogramo una aceleración de 1 m s –2). Es más, el peso depende de donde sea medido, porque el valor de g es distintos en diferentes puntos de la superficie de la Tierra. La masa, por el contrario, es constante donde quiera que se mida, sujeta a la teoría especial de la relatividad. De acuerdo con esta teoría, publicada por Albert Einstein en 1905, la masa de un cuerpo es una medida de su contenido total de energía.

Por tanto, si la energía del cuerpo crece, por ejemplo, por un aumento de su energía cinética o temperatura, entonces su masa también crece. De acuerdo con esta ley, un aumento de energía ΔE está acompañado de un aumento de masa Δm, en conformidad con la ecuación de masa-energía Δm = ΔE/c2, donde c es la velocidad de la luz. Por tanto, si un kilo de agua se eleva de temperatura en 100 K, su energía interna aumentará en 4 x 10 –12 kg. Este es, por supuesto, un incremento despreciable y la ecuación de masa-energía es sólo significativa para energías extremadamente altas. Por ejemplo, la masa de un electrón es siete veces mayor si se mueve con relación a un observador al 99% de la velocidad de la luz.

Ya sabemos que, se ha comprobado una y mil veces que, la teoría de Einstein de la relatividad especial es cierta en el sentido de que, al ser la velocidad de la luz el límite de velocidad del Universo, nada puede ir más rápido que la luz, cuando un cuerpo viaja a velocidades cercanas a la de la luz, a medida que se acerca a ella, puede ver como su masa aumenta, ya que, la energía de movimiento se convierte en masa al no poder conseguir su objetivo de marchar más rápido que la luz.

En los anillos enterrados en las entrañas de la Tierra, haces de partículas son lanzadas a la velocidad de la luz para que colisionen y, su peso aumenta conforme se van acercando a ese límite marcado por el universo.

La masa relativista de un cuerpo medida por un observador (un físico del LHC que mide el aumento de masa de los protones a medida que adquieren velocidad en el acelerador de partículas del CERN) con respecto al cual este cuerpo se mueve. De acuerdo con la teoría de Einstein, la masa m de un cuerpo moviendose a velocidad v está dada por m = m0/√ (1 – v2 / c2), donde m0 es su masa en reposo y c es la velocidad de la luz. La masa relativista solo difiere significativamente de la masa en reposo si su velocidad es una fracción apreciable de la velocidad de la luz. Si v = c/2, por ejemplo, la masa relativista es un 15% mayor que la masa en reposo.

Según las consecuencias obtenidas en el proyecto Manhattan, lo que sí es seguro es que, una pequeña fracción de materia, contiene una gran cantidad de energía. Según nos decía Asimov: “…un sólo gramo de materia se podría convertir en energía eléctrica que bastaría para mantener luciendo continuamente una bombilla de 100 vatios durante unos 28.200 años. O bien, la energía que representa un sólo gramo de materia es equivalente a la que se obtendría de quemar unos 32 millones de litros de gasolina”.

Una cosa si que nos puede quedar muy clara: Aunque sabemos algunas cosas sobre la masa y lo que entendemos por la energía, no podemos decir que, al día de hoy, “sepamos de verdad”, lo que la masa y la energía son.

Seguiremos aprendiendo.

emilio silvera

Sep

2

Abundancia Cósmica de los Elementos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Formación de elementos ~

Clasificado en Formación de elementos ~

Comments (4)

Comments (4)

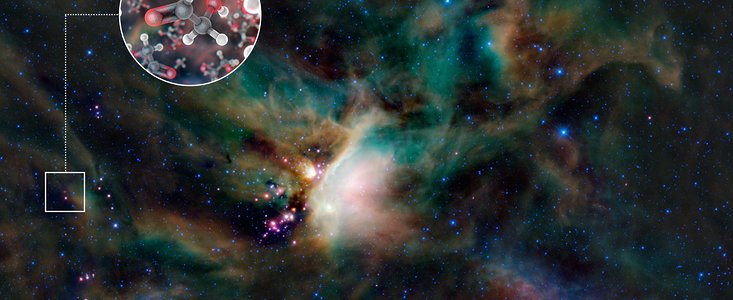

Se encuentran elementos esenciales para la vida alrededor de una estrella joven. Usando el radiotelescopio ALMA (Atacama Large Millimeter/submillimeter Array), un grupo de astrónomos detectó moléculas de azúcar presentes en el gas que rodea a una estrella joven, similar al sol. Esta es la primera vez que se ha descubierto azúcar en el espacio alrededor de una estrella de estas características. Tal hallazgo demuestra que los elementos esenciales para la vida se encuentran en el momento y lugar adecuados para poder existir en los planetas que se forman alrededor de la estrella.

La abundancia, distribución y comportamiento de los elementos químicos en el Cosmos es uno de los tópicos clásicos de la astrofísica y la cosmoquímica. En geoquímica es también importante realizar este estudio ya que:

– Una de las principales finalidades de la Geoquímica es establecer las leyes que rigen el comportamiento, distribución, proporciones relativas y relaciones entre los distintos elementos químicos.

– Los datos de abundancias de elementos e isótopos en los distintos tipos de estrellas nos van a servir para establecer hipótesis del origen de los elementos.

– Los datos de composición del Sol y las estrellas nos permiten establecer hipótesis sobre el origen y evolución de las estrellas. Cualquier hipótesis que explique el origen del Sistema Solar debe explicar también el origen de la Tierra, como planeta de dicho Sistema Solar.

– Las distintas capas de la Tierra presentan abundancias diferentes de elementos. El conocer la abundancia cósmica nos permite tener un punto de referencia común. Así, sabiendo cuales son las concentraciones normales de los elementos en el cosmos las diferencias con las abundancia en la Tierra nos pueden proporcionar hipótesis de los procesos geoquímicos que actuaron sobre la Tierra originando migraciones y acumulaciones de los distintos elementos, que modificaron sus proporciones y abundancias respecto al Cosmos.

La tabla periódica de los elementos es un arreglo sumamente ingenioso que permite presentar de manera lógica y estructurada las más simples sustancias de las que se compone todo: absolutamente todo lo que conocemos. Todos los elementos que conocemos, e incluso con lo que todavía no nos hemos encontrado, tienen un lugar preciso en ella, cuya posición nos permite conocer muchas de sus características. Ese grupo de casi cien ingredientes permite crear cualquier cosa. Pero no siempre fue así.

Me gusta la Gran Nebulosa de Orión. Hay ahí tántas cosas, nos cuenta tántas historias…

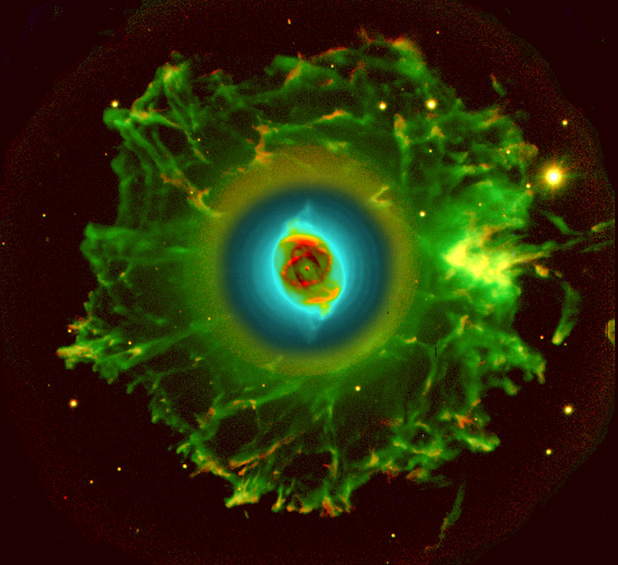

FUENTES DE DATOS DE ABUNDANCIAS COSMICAS DE LOS ELEMENTOS. Estos datos deben obtenerse a partir del estudio de la materia cósmica. La materia cósmica comprende: Gas interestelar, de muy baja densidad (10-24 g/cm3) y Nébulas gaseosas o nubes de gas interestelar y polvo.

Las nébulas gaseosas se producen cuando una porción del medio interestelar está sujeta a radiación por una estrella brillante y muy caliente, hasta tal punto se ioniza que se vuelve fluorescente y emite un espectro de línea brillante (que se estudian por métodos espectroscopios). Por ejemplo las nébulas de “Orión” y “Trifidos”. Las ventajas de estas nébulas difusas para el estudio de las abundancias son:

![[Espada+de+Orion.jpg]](http://4.bp.blogspot.com/_hfB00NeNnmw/Sdv45L0CS1I/AAAAAAAAAms/31O1WKtM1Nc/s1600/Espada%2Bde%2BOrion.jpg)

‑ Su uniformidad de composición.

‑ El que todas sus partes sean accesibles a la observación, al contrario de lo que ocurre en las estrellas.

También tiene desventajas:

‑ Solo se observan las líneas de los elementos más abundantes.

‑ Cada elemento se observa solo en uno o pocos estadios de ionización aunque puede existir en muchos.

‑ La mayoría de las nébulas exhiben una estructura filamentosa o estratiforme es decir que ni la D ni la T son uniformes de un punto a otro. A partir del medio interestelar (gas interestelar y nébulas gaseosas) se están formando continuamente nuevas estrellas.

Las estrellas se forman a partir del gas y el polvo de las Nebulosas

En las estrellas podemos encontrar muchas respuestas de cómo se forman los elementos que conocemos. Primero fue en el hipotético big bang donde se formaron los elementos más simples: Hidrógeno, Helio y Litio. Pasados muchos millones de años se formaron las primeras estrellas y, en ellas, se formaron elementos más complejos como el Carbono, Nitrógeno y Oxígeno. Los elementos más pesados se tuvieron que formar en temperaturas mucho más altas, en presencia de energías inmensas como las explosiones de las estrellas moribundas que, a medida que se van acercando a su final forman materiales como: Sodio, Magnesio, Aluminio, Silicio, Azufre, Cloro, Argón, Potasio, Titanio, Hierro, Cobalto, Niquel, Cobre, Cinc, Plomo, Torio…Uranio. La evolución cósmica de los elementos supone la formación de núcleos simples en el big bang y la posterior fusión de estos núcleos ligeros para formar núcleos más pesados y complejos en el interior de las estrellas y en la transición de fase de las explosiones supernovas.

Sir Fred Hoyle

No me parece justo hablar de los elementos sin mencionar a Fred Hoyle y su inmensa aportación al conocimiento de cómo se producían en las estrellas. Él era temible y sus críticas de la teoría del big bang hizo época por su mordacidad. Hoyle condenó la teoría por considerarla epistemológicamente estéril, ya que parecía poner una limitación temporal inviolable a la indagación científica: el big bang era una muralla de fuego, más allá de la cual la ciencia de la çepoca no sabía como investigar. Él no concebía y juzgó “sumamente objetable que las leyes de la física nos condujeran a una situación en la que se nos prohíbe calcular que ocurrió en cierto momento del tiermpo”. En aquel momento, no estaba falto de razón.

Pero no es ese el motivo de mencionarlo aquí, Hoyle tenía un dominio de la física nuclear nunca superado entre los astrónomos de su generación, había empezado a trabajar en la cuestión de las reacciones de la fusión estelar a mediado de los cuarenta. Pero había publicado poco, debido a una batalla continua con los “arbitros”, colegas anónimos que leían los artículos y los examinaban para establecer su exactitud, cuya hostilidad a las ideas más innovadoras de Hoyle hizo que éste dejara de presentar sus trabajos a los periódicos. Hoyle tuvo que pagar un precio por su rebeldía, cuando, en 1951, mientras él, permanecía obstinadamente entre bastidores, Ernest Opik y Edwin Sepeter hallaron la síntesis en las estrellas de átomos desde el Berilio hasta el Carbono. Lamentando la oportunidad perdida, Hoyle rompió entonces su silencio y en un artículo de 1954 demostró como las estrellas gigantes rojas podían corvertir Carbono en Oxígeno 16.

El Sol, dentro de 5.000 millones de años, será una Gigante roja primero y una enana blanca después

Pero, sigamos con la historia de Hoyle. Quedaba aún el obstáculo insuperable del hierro. El hierro es el más estable de todos los elementos; fusionar núcleos de hierro para formar nucleos de un elemento más pesado consume energía en vez de liberarla; ¿cómo, pues, podían las estrellas efectuar la fusión del hierro y seguir brillando? Hoyle pensó que las supernovas podían realizar la tarea, que el extraordinario calor de una estrella en explosión podía servir para forjar los elementos más pesados que el hierro, si el de una estrella ordinaria no podía. Pero no lo pudo probar.

Luego, en 1956, el tema de la producción estelar de elementos recibió nuevo ímpetu cuando el astrónomo norteamerciano Paul Merril identificó las reveladoras líneas del Tecnecio 99 en los espectros de las estrellas S. El Tecnecio 99 es más pesado que el hierro. También es un elemento inestable, con una vida media de sólo 200.000 años. Si los átomos de Tecnecio que Merril detectó se hubiesen originado hace miles de millones de años en el big bang, se habrían desintegrado desde entonces y quedarían hoy muy pocos de ellos en las estrellas S o en otras cualesquiera. Sin embargo, allí estaban. Evidentemente, las estrellas sabían como construir elementos más allá del hierro, aunque los astrofísicos no lo supiesen.

Estrella muy evolcuionada que se transforma en otra cosa

Las estrellas de tecnecio son estrellas cuyo espectro revela la presencia del elemento tecnecio. Las primeras estrellas de este tipo fueron descubiertas en 1952, proporcionando la primera prueba directa de la nucleosíntesis estelar, es decir, la fabricación de elementos más pesados a partir de otros más ligeros en el interior de las estrellas. Como los isótopos más estables de tecnecio tienen una vida media de sólo un millón de años, la única explicación para la presencia de este elemento en el interior de las estrellas es que haya sido creado en un pasado relativamente reciente. Se ha observado tecnecio en algunas estrellas M, estrellas MS, estrellas MC, estrellas S, y estrellas C.

Estimulado por el descubrimiento de Merril, Hoyle reanudó sus investigaciones sobre la nucleosíntesis estelar. Era una tarea que se tomó muy en serio. De niño, mientras se ocultaba en lo alto de una muralla de piedra jugando al escondite, miró hacia lo alto, a las estrellas, y resolvió descubrior qué eran, y el astrofísico adulto nunca olvidó su compromiso juvenil. Cuando visitó el California Institute Of Technology, Hoyle estuvo en compañía de Willy Fowler, un miembro residetente de la facultad con un conocimiento enciclopédico de la física nuclear, y Geoffrey y Margaret Burbidge, un talentoso equipo de marido y mujer que, como Hoyle, eran excépticos ingleses en la relativo al big bang.

Hubo un cambio cuando Geoffrey Burbidge, examinando datos a los que recientemente se había eximido de las normas de seguridad de una prueba atómica en el atolón Bikini, observó que la vida media de uno de los elementos radiactivos producidos por la explosión, el californio 254, era de 55 días. Esto sonó familiar: 55 días era justamente el período que tardó en consumirse una supernova que estaba estudiando Walter Baade. El californio es uno de los elementos más pesados; si fuese creado en el intenso calor de estrellas en explosión, entonces, suguramente los elementos situados entr el hierro y el californio -que comprenden, a fin de cuentas, la mayoría de la Tabla Periódica- también podrían formarse allí. Pero ¿cómo?.

Nucleosíntesis estelar

Las estrellas que son unas ocho veces más masivas que el Sol representan sólo una fracción muy pequeña de las estrellas en una galaxia espiral típica. A pesar de su escasez, estas estrellas juegan un papel importante en la creación de átomos complejos y su dispersión en el espacio.

Elementos necesarios como carbono, oxígeno, nitrógeno, y otros útiles, como el hierro y el aluminio. Elementos como este último, que se cocinan en estas estrellas masivas en la profundidad de sus núcleos estelares, puede ser gradualmente dragado hasta la superficie estelar y hacia el exterior a través de los vientos estelares que soplan impulsando los fotones. O este material enriquecido puede ser tirado hacia afuera cuando la estrella agota su combustible termonuclear y explota. Este proceso de dispersión, vital para la existencia del Universo material y la vida misma, puede ser efectivamente estudiado mediante la medición de las peculiares emisiones radiactivas que produce este material. Las líneas de emisión de rayos gamma del aluminio, que son especialmente de larga duración, son particularmente apreciadas por los astrónomos como un indicador de todo este proceso. El gráfico anterior muestra el cambio predicho en la cantidad de un isótopo particular de aluminio, Al26, para una región de la Vía Láctea, que es particularmente rica en estrellas masivas. La franja amarilla es la abundancia de Al26 para esta región según lo determinado por el laboratorio de rayos gamma INTEGRAL. La coincidencia entre la abundancia observada y la predicha por el modelo re-asegura a los astrónomos de nuestra comprensión de los delicados lazos entre la evolución estelar y la evolución química galáctica.

Pero sigamos con la historia recorrida por Hoyle y sus amigos. Felizmente, la naturaleza proporcionó una piedra Rosetta con la cual Hoyle y sus colaboradores podían someter a prueba sus ideas, en la forma de curva cósmica de la abundancia. Ésta era un gráfico del peso de los diversos átomos -unas ciento veinte especies de núcleos, cuando se tomaban en cuanta los isótopos- en función de su abundancia relativa en el universo, establecido por el estudio de las rocas de la Tierra, meteoritos que han caido en la Tierra desde el espacio exterior y los espectros del Sol y las estrellas.

Supernova que calcina a un planeta cercano. Ahí, en esa explosión se producen transiciones de fase que producen materiales pesados y complejos. En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica que es: H, He, (Li, Be, B) C, N, O… Fe.

¿Apreciáis la maravilla?

Las estrellas brillan en el cielo para hacer posible que nosotros estemos aquí descubriendo los enigmas del universo y… de la vida inteligente. Esos materiales para la vida sólo se pudieron fabricar el las estrellas, en sus hornos nucleares y en las explosiones supernovas al final de sus vidas. Esa era la meta de Hoyle, llegar a comprender el proceso y, a poder demostrarlo.

“El problema de la síntesis de elementos -escribieron- está estrechamente ligado al problema de la evolcuión estelar.” La curva de abundancia cósmica de elementos que mostraba las cantidades relativas de las diversas clases de átomos en el universo a gran escala. Pone ciertos límites a la teoría de cómo se formaron los elementos, y, en ella aparecen por orden creciente:

Como reseñamos antes la lista sería Hidrógeno, Helio, Carbono, Litio, Berilio, Boro, Oxígeno, Neón, Silicio, Azufre, Hierro (damos un salto), Plomo, Torio y Uranio. Las diferencias de abundancias que aparecen en los gráficos de los estudios realizados son grandes -hay, por ejemplo, dos millones de átomos de níquel por cada cuatro átomos de plata y cincuenta de tunsgteno en la Via Láctea- y por consiguiente la curva e abundancia presenta una serie de picos dentados más accidentados que que la Cordillera de los Andes. Los picos altos corresponden al Hidrógeno y al Helio, los átomos creados en el big bang -más del p6 por ciento de la materia visible del universo- y había picos menores pero aún claros para el Carbono, el Oxígeno, el Hierro y el Plamo. La acentuada claridad de la curva ponía límites definidos a toda teoría de la síntesis de elementos en las estrellas. Todo lo que era necesario hacer -aunque dificultoso) era identificar los procesos por los cuales las estrellas habían llegado preferentemente a formar algunos de los elementos en cantidades mucho mayores que otros. Aquí estaba escrita la genealogía de los átomos, como en algún jeroglífico aún no traducido: “La historia de la materia éscribió Hoyle, Fwler y los Burbidge_…está oculta en la distribuciíon de la anundancia de elementos”

En el Big Bang: Hidrógeno, Helio, Litio.

En las estrellas de la serie principal: Carbono, Nitrógeno, Oxígeno.

En las estrellas moribundas: Sodio, Magnesio, Aluminio, Silicio, Azufre, Cloro, Argón, Potasio, Titanio, Hierro, Cobalto, Níquel, Cobre, Cinc, Plomo, Torio y Uranio.

Como habeis podido comprobar, nada sucede por que sí, todo tiene una explicación satisfactoria de lo que, algunas veces, decimos que son misterios escondidos de la Naturaleza y, sin embargo, simplemente se trata de que, nuestra ignorancia, no nos deja llegar a esos niveles del saber que son necesarios para poder explicar algunos fenómenos naturales que, exigen años de estudios, observaciones, experimentos y, también, mucha imaginación.

En la imagen de arriba se refleja el proceso Triple Alpha descubierto por Hoyle:

Amigos míos, son las 5,53 h., me siento algo cansado de teclear y me parece que con los datos aquí expuestos podéis tener una idea bastante buena de la formación de elementos en el cosmos y de cómo las estrellas son las máquinas creadoras de la materia cada vez más compleja y, el Universo, nos muestra de qué mecanismos se vale para poder traer elementos que más tarde formarán parte de los planetas, de los objetos en ellos presentes y, de la Vida.

emilio silvera

Sep

2

Nuevas ideas, ideas viejas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

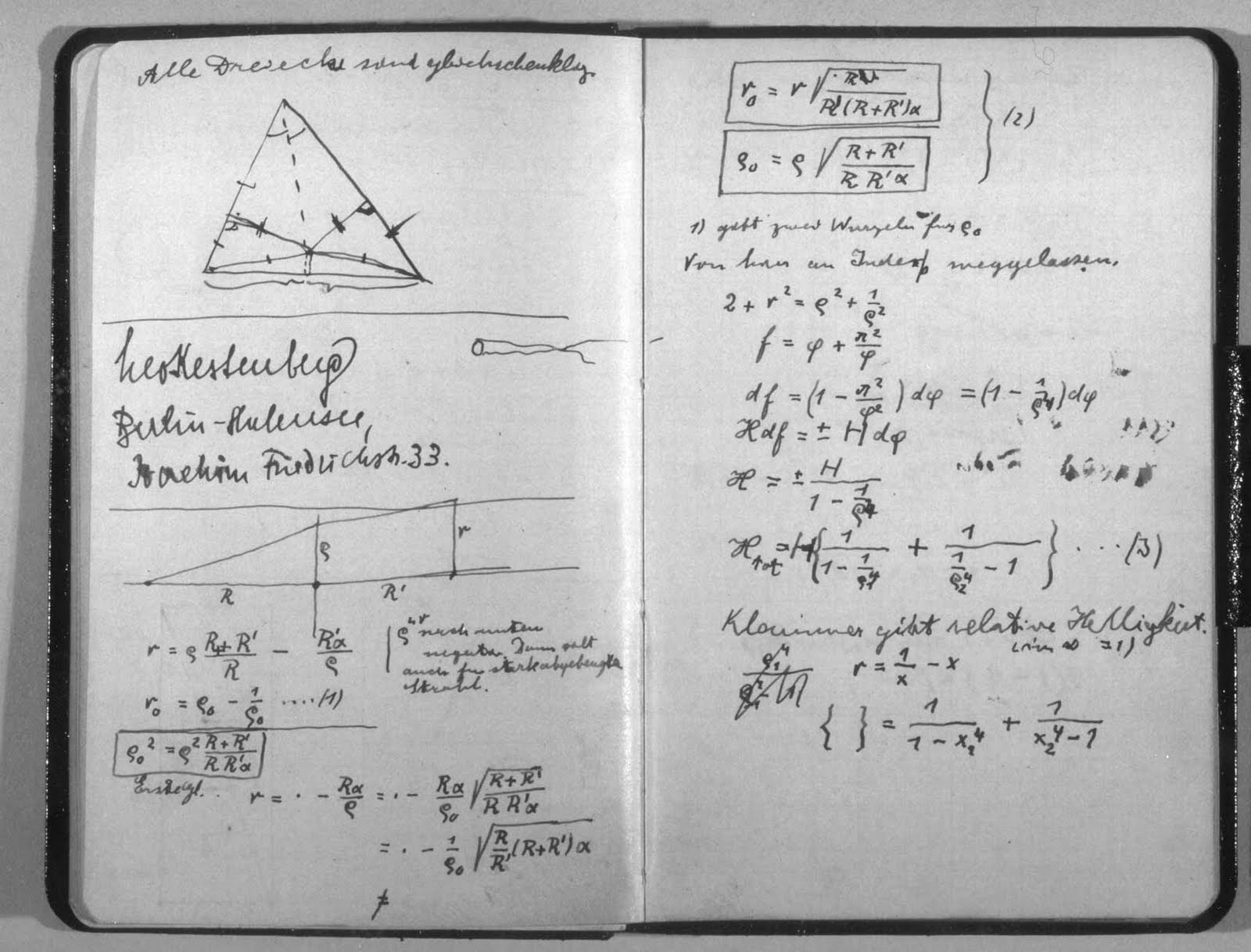

Manuscrito de Einstein con la fórmula de la Teoría de la Relatividad. Cuando esto se dio a conocer al mundo, muchos miraron excépcicos la fórmula y las implicaciones que de ella se podrían derivar, aquello podría cambiar lo firmemente establecido: ¡sacrilegio! ¿qué será de la Física si hacemos caso a lo que diga cualquiera?

Siempre ha sido así, el Status Institucional establecido, bien acomodado en los sillones de las academias y corporaciones, hacen la señal de la cruz, como para espantar al diablo, cada vez que aparecen nuevas ideas que, en realidad, les aterra, toda vez que les puede remover de sus asientos y prebendas, ya que, generalmente, dejan al descubierto que todo lo que predomina, está asentado en una falsa base de criterios y teorías que no siempre, son las correctas ni pueden ser demostradas y, mientras tanto eso ocurre, ellos, ¡a vivir que son dos días!

En el trabajo “No siempre la Física se puede explicar con palabras”, el amigo Tom Vood nos deja el siguiente comentario que, al parecerme de interés aquí os lo inserrto para que todos, podais pensar en lo que aquí expone: Creo que sí, deben ser divulgadas.

!”Te dejo una entre muchas “revelaciones” reciente, calentitas solo para ti; que no quisiera que se divulgaran. Pero le dejo a su responsabilidad, si borrarlas, si usted cree que debo seguir como guerrillero de la ciencia o debe ser conocidas estas ideas por toda la comunidad científica. Disculpa, pero no logro discernir eso. Pero como admiras tanto a Einstein y yo soy tan tonto, te la insinúo por arribita: (Según el modelo de la interacción Luz-Luz).

http://www.emiliosilveravazquez.com/blog/2012/05/31/acercarse-a-la-velocidad-de-la-luz-trae-consecuencias/

¿Sabes por que las energíasmasas (partículas, o electromagnéticos confinados) no pueden superar la velocidad de la luz?

Bueno Einstein se moriría por explicárselo; a pesar de que para los modernos físicos esas preguntas ilegales no se le hacen a la física; recuerda el famoso: ¡no preguntes y calcula! Como diciendo, no eres físico, sino físico-matemático. O lo que no se, o no me puedo explicar, no lo puedes preguntar, es de mal gusto hacerlo, o de ignorantes. ¡Que daño Dios!

Bueno, pues una partícula según mi modelo es energíacampo confinada o electromagnético confinado en forma de energíamasa y por lo tanto cuando alcanza la velocidad de la luz, ocurre la ruptura de simetría que lo regresa a ser de nuevo energíacampo.

Más riguroso: Si una energíamasa alcanza la velocidad de la luz, se convierte en energíacampo.

De aquí se extraen miles de corolarios:

-Las energíasmasas (partículas) si alcanzan la velocidad de la luz, solo que una vez que la alcanzan, se rompe su topología de confinación, de energíasmasas y se liberan de nuevo como energíascampos. Algo que nunca dejaron de ser. Es que eso nunca las cinco física anteriores lo prohibían; por algo era. Mi modelo no mutila, incorpora,… Son los físicos, los que al no tener un buen modelo, medio que lo veían implícito así en la teoría; que eso no podía suceder. Pero si sucede, solo que nunca pueden sostenerse así.

Tom parece tener en sus manos las respuesto pero… se les escapa entre los dedos

-Nunca una energíamasa (partícula con masa) podrá superar la velocidad de la luz. La conclusión Eisteniana que nadie se ha podido explicar. Vez que fácil es todo, una vez que se va ha la física.

-La velocidad de la luz no es una barrera, la barrera es la ley que confina la energíacampo, en forma de energíamasa. Esa topología, geometría; o relaciona geometrías/energía.

-Toda aniquilación, desintegración y explosión tipo Big Bang (odio, o no creo lo del Big Bang) de los cuerpos del macrocosmo, es por la misma causa.

-De esto se extrae (del modelo también) la ley universal permitibilidad máxima de energía por unidad de espaciotiempo… El VICEVERSA; porque si no todo fuera energíascampos y la naturaleza no ocurre así: Toda energíacampo (luz,…) se confina como energíamasa, cuando su velocidad se hace cero.

-O lo que es lo mismo, ninguna partícula sin masa puede llegar a alcanzar el estado de reposo. Otra cosa que ningún modelo ha explicado, aunque es evidente que es un principio natural. Como todo lo que les explico. ¡Total, si eso es ilegal para el establishment!

De aquí se infieren muchas preguntas, conclusiones, paradojas, o explicaciones más racionales, a muchas cosas que decimos explicadas o que no hemos explicado todavía.

también nosotros estamos inmersos en un campo de energía-masa

La energíascampos (ustedes siempre piensen en la luz como yo al principio, para que no se pierdan) nunca puede estar en reposo (que la energía no puede estar en reposo es conocido, por eso es energía), pero como si existen circunstancias físicas muy especiales, donde esta puede ir disminuyendo su velocidad hasta que sea cero; la naturaleza resuelve esta paradoja, confinando las energíascampos, en diferentes topologías que donde se conserva como energíascampos (mas fácil verlo si piensan en luz); pero exteriormente se manifiesta como un ente, que puede estar en reposo o moverse como un todo; como lo que llamamos partículas con masa ( para mi energíasmasas).

Otra idea que puede ayudarlos a digerir esto: la energíacampo oscila, están acotadas entre la velocidad cero y la velocidad “c”. Esa oscilación, tipo superficie de agua hirviente, es lo que ocurre en la superficie de un agujero negro. Otra revelación de la riqueza física que despliega el modelo.

Te explico mejor: Cuando una energíacampo (luz) cae en un campo tan intenso como el de un agujero negro, su velocidad comienza a disminuir, llegado al “horizonte” (concepto que hay que ampliar) donde su velocidad seria cero; según mi modelo se confina como una energíamasa y trataría de moverse como un todo. Y aquí pueden ocurrir varias cosas que no te he explicado. Según la geometría que adopte la confinación, podrá ser un fermión izquierdo o derecho (una partícula o una antipartícula); así que puede ocurrir aniquilación…

También podría ocurrir que esa partícula (o energíamasa) alcance la velocidad de la luz; es decir regrese ha ser energíacampo, ya te explique por que. Ahora, la gravitación es energíacampo también, y aquí ocurre que ella penetra a la partícula (el mismo proceso de la aniquilación, todo es lo mismo, hay una regularidad natural entre el micromundo y el macromundo, que nadie ve), satura la estabilidad de su topología, y esta se desintegra (aquí tienes la explicación de todos los procesos de desintegración y con el, los tiempos de vida). Pero desintegración en mi razonamientos, en el modelo; es decaer en otra topología de menor energía y cuando esas topologías estables, quedan agotadas por las leyes naturales, que los físicos llamamos de conservación (carga, spin, Isoespin, CP, CPT,…); no le queda otro remedio a la energíamasa; que volver ha ser una energíacampo.

Estaría bien que Tom pudiera, por fín, atrapar su teoría Luz-Luz (débil-fuerte) para asombrar al mundo

Bueno espero haberte complacido en algo, “tuvisteis la exclusividad”, lo dejo ahí porque para que lo digieran y porque tengo muchos problemas que resolver. Tampoco tengo tiempo de leer lo que escribí (como ya es costumbre); pero ustedes son inteligentes como para no crucificarme, así que corrígeme ha tus Dones. Pueden divulgar a su antojo, como siempre les digo, “mi física de café con leche”. Tómense su tiempo para digerirlo, para acostumbrarse a estas nuevas concepciones físicas, esto párese merecerlo, parece novedoso.

Gracias amigo, te agradecemos las revelaciones que, si al fin se abren camino, nos podrían llevar a terrenos más cercanos a la realidad física del mundo. Daríamos un paso adelante en la comprensión del Universo y, como pasa siempre que obtenemos alguna nueva respuesta…¡Podríamos seguir planteando neuvas preguntas! que por cierto, ahora no podemos hacer por no tener ese conocimiento que tú tratas de entregar al mundo.

Sigamos con la Gravedad Cuántica

La física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Todos hemos oido hablar de la incompatibilidad de las dos teorías que sustentan hoy por hoy toda la Física y que, todosm también sabemos que, son teorías incompletas que necesitan de una reunificación en un todo poderoso que todo lo puesda explicar.

Durante el siglo XX, la física se fundamentó, en general, sobre dos grandes pilares: la mecánica cuántica y la teoría de relatividad. Sin embargo, a pesar de los enormes éxitos logrados por cada una de ellas, las dos aparecen ser incompatibles. Esta embarazosa contradicción, en el corazón mismo de física teórica, se ha transformado en uno de los grandes desafíos permanentes en la ciencia.

La teoría de la relatividad general da cuenta a la perfección de la gravitación. Por su parte, la aplicación a la gravedad de la mecánica cuántica requiere de un modelo específico de gravedad cuántica. A primera vista, parecería que la construcción de una teoría de gravedad cuántica no sería más problemático que lo que resultó la teoría de la electrodinámica cuántica (EDC), que ya lleva más de medio siglo con aplicaciones más que satisfactorias.

En lo medular, la EDC describe la fuerza electromagnética en términos de los cambios que experimentan las llamadas partículas virtuales, que son emitidas y rápidamente absorbidas de nuevo; el principio de incertidumbre de Heisenberg nos dice que ellas no tienen que conservar la energía y el movimiento. Así la repulsión electrostática entre dos electrones puede ser considerada como la emisión, por parte de un electrón, de fotones virtuales y que luego son absorbidos por el otro.

La misma mecánica, pero a través de los cambios de la partícula virtual de la gravedad el «gravitón» (el quantum del campo gravitacional), podría considerarse para estimar la atracción gravitacional entre dos cuerpos. Pero gravitones nunca se han visto. La gravedad es tan débil que puede obviarse a escala molecular, donde los efectos cuánticos son importantes. Ahora, si los cambios que podrían realizarse en los gravitones sólo se producen en la interacción entre dos puntos de masa, es posible, entonces, que en los cuerpos masivos se ignore los efectos cuánticos. El principio de incertidumbre de Heisenberg nos señala que no podemos medir simultáneamente la posición y la velocidad de una partícula subatómica, pero esta indeterminación es imperceptible para los planetas, las estrellas o las galaxias.

Sí, pero, ¿qué me dices del gravitón?

Pero el principal obstáculo, sin embargo, es la cantidad de complicados procesos que implica examinar un gran número de gravitones. La gravedad se diferencia crucialmente del electromagnetismo al no ser lineal. Esta inlinealidad surge porque la gravedad posee la energía, y ésta tiene la masa, que gravita. En el lenguaje cuántico, esto implica que gravitones interactúan recíprocamente con otro gravitones, a diferencia de los fotones, que interactúan sólo con cargas y corrientes eléctricas y no con otros fotones. Ahora, como los gravitones interactúan el uno con el otro, las partículas de materia son rodeadas por complejas redes de gravitones virtuales que forman «lazos cerrados», muy semejante a «árboles bifurcados».

En la teoría de campo cuántica, los lazos cerrados son un signo de problema; ellos normalmente producen respuestas infinitas en los cálculos de procesos físicos. En EDC, tales lazos ocurren cuando un electrón emite y absorbe de nuevo su propio fotón. En ese caso, los infinitos son soslayados a través de un procedimiento matemático conocido como renormalización. Si éste es hecho correctamente, se obtienen razonables respuestas. La QED es lo que se llama una teoría renormalizable porque todos los infinitos pueden ser soslayados sistemáticamente; en efecto, solo un conjunto de operaciones matemáticas es suficiente para eliminar los infinitos.

Parece que aquí puede estar la solución

Lamentablemente, tal procedimiento sistemático no es operativo cuando la mecánica cuántica es aplicada a la relatividad general; la teoría es, por lo tanto, «no-renormalizable». Cada proceso que implique progresivamente más lazos cerrados de gravitones introduce nuevas variantes de términos infinitos. Lo anterior, coarta la investigación para muchísimos fenómenos de interés, y sugiere que puede que haya básicamente algo que esté errado en la relatividad general, en la mecánica cuántica, o en ambas.

Pero miremos más allá del problema de renormalización, ¿qué pasaría si nos remontáramos a un momento en que todo lo que podemos ver, y hasta lo que hay más allá de nuestro «horizonte» de 13.000 millones de años luz, estaba comprimido hasta un volumen menor que el de un núcleo atómico? A estas densidades descomunales, que se dieron durante los primeros 10-43 segundos del universo (lo que se conoce como «tiempo de Planck»), tanto los efectos cuánticos como la gravedad habrían sido importantes. ¿Qué pasa cuando los efectos cuánticos convulsionan todo un universo?

Por ello, la física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Algunos teóricos creen que ya es tiempo de explorar las leyes físicas que prevalecían en el tiempo de Planck, y han propuesto algunas hipótesis interesantes. Sin embargo, no hay consenso sobre qué ideas hay que descartar. Lo que es seguro es que debemos rechazar nuestras queridas concepciones del espacio y el tiempo basadas en el sentido común: el espaciotiempo a muy pequeña escala podría tener una estructura caótica, espumosa, sin ninguna flecha temporal bien definida; puede que haya una generación y fusión continua de agujeros negros primores y minúsculos. La actividad podría ser lo bastante violenta para generar nuevos dominios espaciotemporales que evolucionarían como universos independientes. Eventos más tardíos (en particular la fase inflacionaria que se describe en el capítulo XVI) podrían haber borrado cualquier rastro de la era cuántica inicial. El único lugar donde podrían observarse efectos cuántico-gravitatorios sería cerca de las singularidades centrales de los agujeros negros (de donde ninguna señal puede escapar). Una teoría sin consecuencias evidentes fuera de estos dominios tan exóticos e inaccesibles no es verificable. Para que se la tome en serio debe estar íntimamente insertada o, en su efecto, articulada en alguna teoría con fundamento empírico, o bien debe percibirse como una conclusión inevitable y convincente.

Durante las últimas décadas, varias tentativas han sido hechas para buscarle una solución al problema de la no-renormalización de la gravedad cuántica y caminar hacia la unificación de todas las fuerzas. La aproximación más esperanzadora para alcanzar ese viejo anhelo de los físicos es la teoría de las «supercuerdas», que ya anteriormente vimos.

Sin embargo, recordemos aquí que en la teoría de las supercuerdas se presume una escala natural energética determinada por la energía de Planck, alrededor de unos 1019 GeV. Esto es 1017 veces más alto que los tipos de energías que pueden ser producidos en los aceleradores de partículas más grandes, lo que imposibilita contrastar con la teoría la existencia misma de las supercuerdas. No obstante, los teóricos esperan que a escala de energía accesible tanto la física, la relatividad general, el electromagnetismo, las fuerzas nucleares débiles y fuertes, las partículas subatómicas surjan de la teoría de las supercuerdas como una aproximación. Así, se espera conseguir con ese modelo de cuerdas no sólo una ajustada descripción de la gravedad cuántica, sino que también intentar con ella la anhelada unificación de las fuerzas.

Lamentablemente, no hay un único límite de baja energía para la teoría de las supercuerdas como tampoco un sólo modelo de la teoría. Por un tiempo, lo anterior pareció como una barrera infranqueable, pero en años recientes, y a través de una mayor abstractación matemática, se ha construido un nuevo modelo de supercuerdas conocido como «la teoría M» que amalgama dentro de ella otras teorías de supercuerdas.

Por ahora, es demasiado pronto para pronunciarse si la teoría M es finalmente el medio que reconciliará la gravitación y la mecánica cuántica, pero sí debería poder cumplir con algunas expectativas, como ser las de explicar algunos hechos básicos sobre el mundo físico. Por ejemplo, el espaciotiempo de cuatro dimensional tendría que surgir de la teoría, más bien que ser insertado en ella. Las fuerzas y las partículas de naturaleza también deberían ser descritas, preferentemente incluyendo sus propiedades claves, como fuerzas de interacción y masas. Sin embargo, a no ser que la teoría M, o una variante futura, pueda ser proyectada a la baja energía de los laboratorio de física para poder ser contrastada, corre el riesgo de empezar a ser olvidada y finalmente archivada como uno más de los muchos y elegantes ejercicios matemáticos que se han elaborado para la física en los últimos tiempos.

Cuerdas o filamentos vibrantes en el corazón de la materia

Si la teoría de supercuerda es una pérdida de tiempo o no, ello está por verse. Por ahora, el desafío más duro a superar por la teoría es entender por qué el espacio de 9 dimensiones más el tiempo se «comprime» bajo el aspecto de nuestro espacio habitual tetradimensional (el tiempo más las tres dimensiones espaciales), en vez de hacerlo en tres o cinco dimensiones, y ver cómo sucede esto. Aún hay un espacio infranqueable entre la teoría de supercuerdas y los fenómenos observables. La teoría de supercuerdas plantea problemas demasiado difíciles ahora mismo para los matemáticos. En este aspecto, es muy diferente de la mayor parte de teorías físicas: normalmente, el aparato matemático de las teorías se desarrolla antes que éstas. Por ejemplo, Einstein utilizó conceptos geométricos desarrollados en el siglo XIX, no tuvo que partir de cero para construir las matemáticas que necesitaba.

Por su parte, los físicos cuerdistas se acorralan en lo que es fácil de comprobar, es difícil de calcular y lo que es fácil de calcular, es difícil comprobar. En consecuencia, pareciera que el camino que se está siguiendo es pretender desarrollar la teoría más y más, y hacer cálculos cada vez más difíciles de manera de poder predecir cosas que sean fáciles de observar. ¿El camino tendrá tiempo y final? Nadie tiene por ahora la respuesta.

El físico Eugene Wigner escribió un célebre artículo sobre este particular que llevaba por título «La irrazonable efectividad de la matemática en las ciencias físicas». También es un hecho notable que el mundo exterior muestre tantas estructuras susceptibles de descripción en «lenguaje» matemático (sobre todo cuando tales estructuras se alejan mucho de las experiencias cotidianas que moldearon la evolución de nuestros cerebros). Edward Witten, el principal experto en supercuerdas, describe dicha teoría como «una física del siglo XXI que cayó en el siglo XX». Sin embargo, sería más extraordinario que seres humanos de cualquier siglo llegaran a desarrollar una teoría tan «final» y general como pretenden ser las supercuerdas.

Salvo mejor parecer

Totales: 71.763.114

Totales: 71.763.114 Conectados: 38

Conectados: 38