Oct

15

¡La Física Cuántica! ¿Llegaremos a comprenderla?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Es realmente maravilloso que podamos haber llegado, en el extremo de las escalas, hasta esos mundos fantáscitos que nos proporcionan los “universos” de lo muy pequeño y de lo muy grande. Lo más cotidiano para nosotros es lo que se encuentra en el macro mundo, lo que se interrelaciona directamente con nosotros, lo que podemos ver y tocar. Sin embargo, ahí está ese otro “mundo” que se nos escapa a los sentidos pero que es, tan real como el otro. Es el espacio que describe la mecánica cuántica y que nos habla de maravillas y procesos asombrosos que son, tan reales como los que contemplamos a nuestro alrededor.

No podemos ver todo lo que existe. Sin embargo, no por estar fuera de nuestra visión deja de existir, ahí está formando parte de ese otro mundo que se nos escapa, al que nuestras percepciones directas, nuestros sentidos, no pueden llegar pero que henmos podido alcanzar a “ver” mediante los ingenios que hemos podido inventar para acceder, de manera indirecta, a ese espacio que se escapa de nosotros por su pequeñez y que, no por ello deja de tener una gran importancia para nosotros y para todo el mundo que nos rodea, de hecho, de esas “pequeñas cositas” resulta estar hecho el Universo. He leído por ahí:

“La mayor parte de la gente desconoce que la mecánica cuántica, es decir, el modelo teórico y  práctico dominante hoy día en el ámbito de la ciencia, ha demostrado la interrelación entre el pensamiento y la realidad. Que cuando creemos que podemos, en realidad, podemos. Sorprendentes experimentos en los laboratorios más adelantados del mundo corroboran esta creencia.

práctico dominante hoy día en el ámbito de la ciencia, ha demostrado la interrelación entre el pensamiento y la realidad. Que cuando creemos que podemos, en realidad, podemos. Sorprendentes experimentos en los laboratorios más adelantados del mundo corroboran esta creencia.

El estudio sobre el cerebro ha avanzado mucho en las últimas décadas mediante las tomografías.

Conectando electrodos a este órgano, se determina donde se produce cada una de las actividades de la mente. La fórmula es bien sencilla: se mide la actividad eléctrica mientras se produce una actividad mental, ya sea racional, como emocional, espiritual o sentimental y así se sabe a qué área corresponde esa facultad.

Estos experimentos en neurología han comprobado algo aparentemente descabellado: cuando vemos un determinado objeto aparece actividad en ciertas partes de nuestro cerebro…. pero cuando se exhorta al sujeto a que cierre los ojos y lo imagine, la actividad cerebral es ¡idéntica! Entonces, si el cerebro refleja la misma actividad cuando “ve” que cuando “siente”, llega la gran pregunta: ¿cuál es la Realidad?

“La solución es que el cerebro no hace diferencias entre lo que ve y lo que imagina porque las mismas redes neuronales están implicadas; para el cerebro, es tan real lo que ve como lo que siente”, afirma el bioquímico y doctor en medicina quiropráctica, Joe Dispenza en el libro “¿y tú qué sabes?”. En otras palabras, que fabricamos nuestra realidad desde la forma en que procesamos nuestras experiencias, es decir, mediante nuestras emociones.”

La mecánica cuántica que conocemos en nuestros días se ha conseguido gracias a la suma de muchos esfuerzos y sería preciso entrar en la historia pasada de esta disciplina que investiga como es el mundo, como funciona la Naturaleza, para saber como se llegó a moldear esos conocimientos que nos llevan al “universo” de lo infinitesimal, de los objetos más pequeños pero que, sin ellos, no podrían existir los más grandes. Ninguna duda nos puede caber ya sobre el hecho cierto de que, la mecánica cuántica, es una de las ramas principales de la Física y está entre uno de los más grandes avances del pasado siglo XX en lo que al conocimiento humano del mundo se refiere. Nos explica el comportamiento de la materia-energía y, de hecho, sin esos conocimientos hubiera sido imposible alcanzar el nivel tecnológico del que hoy podemos disfrutar.

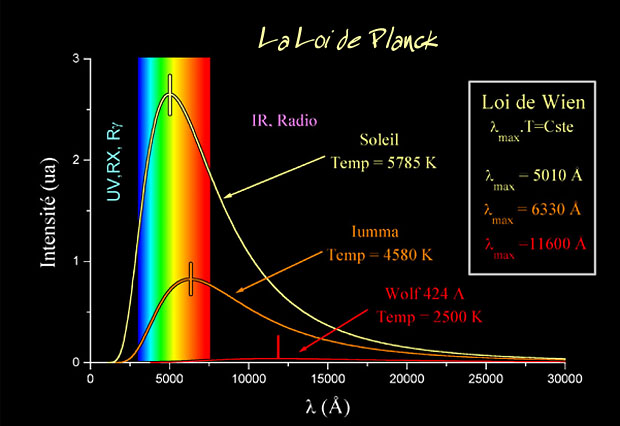

Un día de 1900, Max Planck escribió un artículo de ocho páginas que cambió el mundo de la física. En él nos habló del cuanto, unos pequeños paquetes de energía que eran emitidos por los cuerpoos calientes y, dejó sembrada la semilla de un árbol que no ha dejado de crecer desde entonces. Más tarde llegó Einstein que inspirado en aquel trabajo de Planck, fue un poco más allá y realizó aquel famoso trabajo conocido del Efecto fotoeléctrico. Desde entonces, los físicos no dejaron de ampliar y desarrollar las bases de nuestros conocimientos actuales.

La estructura de las fuerzas familiares como la Gravedad y el magnetismo fueron desarrolladas relativamente temprano. Todos conocemos la historia de Newton y sus trabajos y que, mucho después, dejó perfeccionado Einstein en relación a la fuerza gravitatoria. Las fuerzas electromagnéticas se determinaron también bastante pronto pero, no fue hasta 1927 cuando Dirac realizaría los primeros cálculos cuánticos de interacción de la radiación con la materia y en los años cuarenta y cincuenta gracias a los trabajos de, entre otros, Schwinger y Feynman, se construyó una teoría (electrodinámica cuántica) compatible con los principios básicos de la relatividad y la mecánica cuántica y con una capacidad predictiva asombrosa. Se han conseguido comprender éstos fenómenos, podríamos decir que al nivel de un acuerdo entre los cálculos teóricos y los resultados experimentales de más de diez cifras decimales, y, tal cosa, amigos míos, es un inmenso logro de la mente humana.

No podríamos comprender el macrocosmos sin haber descubierto antes que, en realidad, está fuertemente ligado al microcosmos, a la física subnuclear, ese mundo de lo muy pequeño que, cuando se profundiza en él, nos habla del futuro dinámico del universo y se comienza a ver con claridad como aquellas cuestiones antes no resultas, están ahí, ante nuestros ojos y para que nuestras mentes la puedan entender gracias a la dinámica activa de ese ámbito que resulta ser el campo de las partículas elementales y las fuerzas que con ellas actúan.

Las interacciones débiles y las interacciones fuertes, por su profunda lejanía, tardaron en ser comprendidas. Está claro que, el corto alcance en el que se desarrollan imposibilitaron bastante su hallazgo. Antes, los físicos no tenían acceso al mundo subatómico al que más tarde pudieron entrar de la mano de los microscopios electrónicos, los grandes aceleradores y otros ingenios de increíble alcance y precisición. Así que, a diferencia de lo que pasó con la Gravedad y el electromagnetismo, no se partía de una teoría clásica bien establecida, de manera que se tuvo que construir directamente, una teoría cuántica y relativista de ambas interacciones: la interacción nuclear débil y la interacción nuclear fuerte.

La empresa de comprender aquellas interacciones fue ardua y se tuvo que esperar hasta los año setenta para encontrar las teorías correctas y completas. En estos años se produjeron, primero la demostración por el holandés Gerard ´t Hooft, culminando los trabajos de su mentor, el también holandés, Martinus Veltman, de la autoconsistencia (llamada, por motivos técnicos, renormalización) de las teorías propuestas fenomenológicamente por Glashow, Wienberg y Salam para interacciones débiles; y segundo, el descubrimiento de la propiedad de libertad asintótica (por Gross, Wilczek y Plotzer) de las interacciones fuertes. Ambos grupos consiguieron el Nobel, pero los tres últimos no vieron premiados sus esfuerzos hasta 30 años después, en 2004, cuando se había comprobado de manera suficiente la veracidad de sus predicciones sobre la libertad de los Quarks en su confinamiento, cuando éstos, están juntos y los Gluones, se comportan como si no estuvieran allí, sólo actúan cuando tratan de separse.

En 1973, Wilczek, un estudiante graduado trabajando con David Gross en la Universidad de Princeton, descubrió la libertad asintótica que afirma que mientras más próximos estén los quarks menor es la interacción fuerte entre ellos; cuando los quarks están extremadamente próximos la interacción nuclear entre ellos es tan débil que se comportan casi como partículas libres.

Estosd avances hicieron posible obtener teorías consistentes con la relatividad y la mecánica cuántica de ambos tipos de interacciones; teorías que, además han superado con éxito las muchas confrontaciones experimentales que han sido realizadas hasta nuestros días. Aunque no hay ni cálculos teóricos, ni resultados experimentales tan exactos como en el caso de la electrodinámica cuántica, es cierto que el nivel de precisión de los cálculos con interacciones débiles llegan a cuatro y más cifras significativas y, para interacciones fuertes, estamos alcanzando el nivel del uno por ciento.

La Interacción gravitatoria que se deja notar en las grandes estructructuras se hace presente y se deja sentir, podemos ver como funciona y cuáles son sus consecuencia. Sin embargo, en el mundo de lo muy pequeño, esta interacción, continúa siendo la cenicienta en lo que se refiere a la comprensión de la estructura microscópica y la incidencia que la interacción gravitatoria pueda tener ahí y, curiosamente, es la interacción que se conoce desde hace mucho tiempo y sabemos, perfectamente de su funcionamiento en ese ámbito de lo muy grande pero, hace mutis por el foro cuando nos acercamos al mundo de las partículas, de la mecánica cuántica. Por eso se habla tanto de que necesitamos una teoría cuántica de la gravedad.

No tenemos información alguna de la fuerza de Gravedad a nivel experimental sobre la interacción gravitatoria a cortas distancias, donde sólo se puede llegar a través de inmensas energías. A lo más que hemos podido llegar es a experimentos del tipo realizado por Eötvös, midiendo la interacción gravitatoria entre dos cuerpos a distancias del orden del centímetro: las interacciones gravitatorias entre partículas elementales (quarks, electrones o incluso núcleos) es tan minúscula que son pocas las esperanzas de poderlas medir…por ahora ni en muchom tiempo futuro, y, siendo así (que lo es), nos tenemos que dedicar a emitir conjeturas y a especular con lo que podría ser.

En el siglo XIX se consiguió uno e los logros más impresionantes que nunca pudo alcanzar la Humanidad. ¡La comprensión de los fenómenos electromagnéticos. Comprensión en la que participaron (como casi siempre) muchos científicos, entre los que podemos destacar a dos británicos: el inglés Muchael Faraday, responsable de una buena parte de la investigación y de los conceptos experimentales (de él es el concepto de campo que tan importante sería para la Física), y, el escocés James Clerk Maxwell al que le debemos la síntesis teórica que condensó en unas pocas ecuaciones fundamentales, de las propiedades de las interacciones electromagnéticas a nivel clásico, esto es, macroscópico.

Los fenómenos electromagnéticos tal y como se entendían a finales del siglo XIX, se suponían debidos a la fuerza que una carga eléctrica ejerce sobre otra: tanto si las cargas son estáticas (y entonces la fuerza viene dada por la conocida ley de Coulomb) como si están en movimiento, situación en la que se generan campos magnéticos. Las vibraciones de estos campos electromagnéticos se suponían propagándose por el éter (el “éter luminífero”) y la luz se identificaba como un caso particular de estas vibraciones electromagnéticas. La corriente eléctrica se interpretaba como una especie de fluido: recuérdese que, todavía en 1896, Lord Kelvin defendía esta naturaleza continua de la electricidad.

Lo que supuso el descubrimiento de la luz eléctrica para la Humanidad, aunque ahora lo podamos ver como cosa trivial y cotidiana, en realidad vino a cambiar el mundo que se vio de pronto, sacado bruscamente de la penunmbra para sumergirse en la más maravillosa claridad del día artificial. Aquello supuso un cambio enorme para muchos de los ámbitos sociales en las ciudades y, no digamos, más tarde, en el de los hospitales, laboratorios y también en el más cotidiano mundo doméstico.

Está claro que la luz es algo tan importante enn nuestras vidas que, sin ella, nos encontramos desamparados, desnudos y, si nos referimos a la natural, la que nos manda el Sol, la cosa sería más grave ya que, sin ella, no podríamos estar aquí. De todo esto, como de cualquiera de los temas de Física que pudiéramos escoger al azar, nos podríamos estar hablando durante años…¡es tan fascinante! ¡son tan maravillosos! todos esos conocimientos que, de alguna manera, nos acercan a que podamos comprender en funcionamiento del mundo y nos cuentan el por qué ocurren las cosas de la, manera en que la vemos que pasan. Muchas son las historias que se podrían contar de todos estos sucesos que, por el camino de los descubrimientos tuvimos que recorrer.

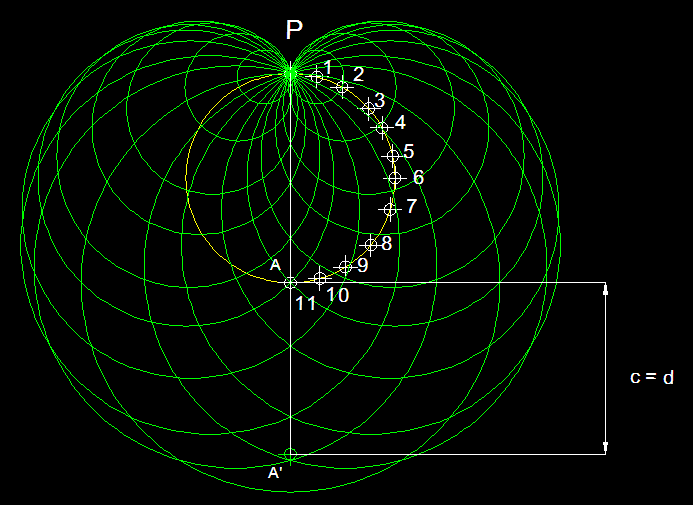

La teoría cuántica, recordémoslo, afirma que para todo objeto existe una función de onda que mide la probabilidad de encontrar dicho objeto en un cierto punto del espacio y del tiempo. La teoría cuántica afirma también que nunca se conoce realmente el estado de una partícula hasta que se haya hecho una observación. Antes de que haya una medida, la partícula puede estar en uno de entre una diversidad de estados, descritos por la función de onda de Schrödinger. Por consiguiente, antes de que pueda hacerse una observación o medida, no se puede conocer realmente el estado de la partícula. De hecho, la partícula existe en un estado ultramundano, una suma de todos los estados posibles, hasta que se hace una medida.

Cuando esta idea fue propuesta por primera vez por Niels Bohr y Werner Heisemberg, Einstein se revolvió contra ella. “¿Existe la luna sólo porque la mira un ratón?“, le gustaba preguntar. Según la teoría cuántica, en su más estricta interpretación, la Luna, antes de que sea observada, no existe realmente tal como la conocemos.

“La Luna puede estar, de hecho, en uno cualquiera de entre un número infinito de estados, incluyendo el estado de estar en el cielo, de estar explotando, o de no estar allí en absoluto. Es el proceso de medida que consiste en mirarla el que decide que la Luna está girando realmente alrededor de la Tierra“.

Decía Einstein con ironía.

Edwin Schrödinger, autor de la ecuación con su función de onda, se disgustó con estas interpretaciones de su ecuación. Para demostrar lo absurdo de la situación creada, Schrödinger colocó un gato imaginario en una caja cerrada. El gato estaba frente a una pistola, que está conectada a un contador Geiger, que a su vez está conectado a un fragmento de uranio. El átomo de uranio es inestable y sufrirá una desintegración radiactiva. Si se desintegra un núcleo de uranio, será detectado por el contador Geiger que entonces disparará la pistola, cuya bala matará al gato.

Para decidir si el gato está vivo o muerto, debemos abrir la caja y observar al gato. Sin embargo, ¿cuál es el estado del gato antes de que abramos la caja? Según la teoría cuántica, sólo podemos afirmar que el gato está descrito por una función de onda que describe la suma de un gato muerto y un gato vivo.

Para Schrödinger, la idea de pensar en gatos que no están ni muertos ni vivos era el colmo del absurdo, pero la confirmación experimental de la mecánica cuántica nos lleva inevitablemente a esta conclusión. Hasta el momento, todos los experimentos han verificado, favorablemente, la teoría cuántica.

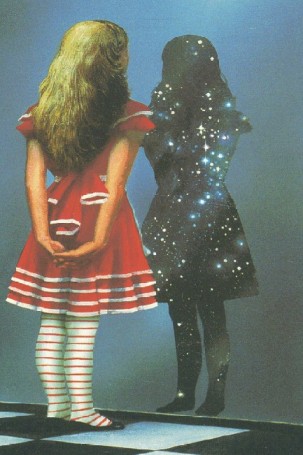

La paradoja del gato de Schrödinger es tan extraña que uno recuerda a menudo la reacción de Alicia al ver desaparecer el gato de Cheshire en el centro del cuento de Lewis Carroll: “Allí me verás“, dijo el Gato, y desapareció, lo que no sorprendió a Alicia que ya estaba acostumbrada a observar cosas extrañas en aquel lugar fantástico. Igualmente, los físicos durante años se han acostumbrados a ver cosas “extrañas” en la mecánica cuántica.

La Mecánica cuántica, es , más fascinante el el Pais de las Maravillas de Alicia

Existen varias maneras de abordar esta dificultad de lo incomprensible en mecánica cuántica. En primer lugar, podemos suponer que Dios existe. Puesto que todas las “observaciones” implican un observador, entonces debe haber alguna “conciencia” en el universo. Algunos físicos como el premio Nobel Eugene Wigner, han insistido en que la teoría cuántica prueba la existencia de algún tipo de conciencia cósmica universal.

La segunda forma de tratar la paradoja es la preferida por la gran mayoría de los físicos en activo: ignorar el problema.

El físico Richard Feynman dijo en cierta ocasión: “Creo que es justo decir que nadie comprende la mecánica cuántica. No siga diciéndose a sí mismo, si puede evitarlo, “¿pero cómo puede ser así?” porque usted se meterá “hasta el fondo” en un callejón sin salida del que nadie ha escapado. Nadie sabe como puede ser eso“. De hecho, a menudo se ha dicho que de todas las teorías propuestas en el siglo XX, la más absurda es la teoría cuántica. Algunos dicen que la única cosa que la teoría tiene a su favor es que “es indudablemente correcta”.

¿Siempre será parte del misterio?

Sin embargo, existe una tercera forma de tratar esta paradoja, denominada teoría de los muchos universos. Esta teoría (como el principio antrópico) no gozó de mucho favor en la última década, pero está siendo revitalizada por la función de onda del universo de Stephen Hawking.

Pero, bueno… ¿cómo he llegado hasta aquí? Es cierto que… ¡Los senderos de la Física te pueden llevar a tántos sitios…!

emilio silvera

Oct

15

¡La Física! Siempre nos sorprende

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (2)

Comments (2)

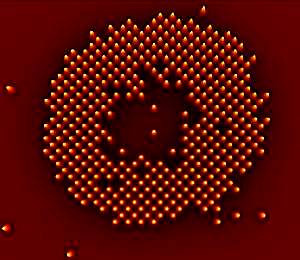

Las veloces computadoras cuánticas hechas con átomos atrapados por haces de luz pueden estar un poco más cerca, gracias a las primeras imágenes de átomos individuales obtenidas en una de estas grillas.

La velocidad de las computadoras cuánticas tiene que ver con el hecho de que sus componentes pueden ocupar una serie de estados en lugar de sólo dos como ocurre en una computadora binaria. Ciertos algoritmos especiales podrían explotar estos estados cuánticos para resolver problemas que derrotarían a una computadora convencional.

Una candidata a computadora de este tipo es la llamada “rejilla óptica”, en la que haces de rayos láser estratégicamente ubicados hacen que los átomos ultrafríos se coloquen en forma de grilla, como si fueran huevos en su envase de cartón. Pero antes de que uno pudiera leer o escribir sobre estos átomos, algo indispensable si la rejilla fuera a actuar como una computadora cuántica, haría falta determinar las posiciones exactas de los mismos.

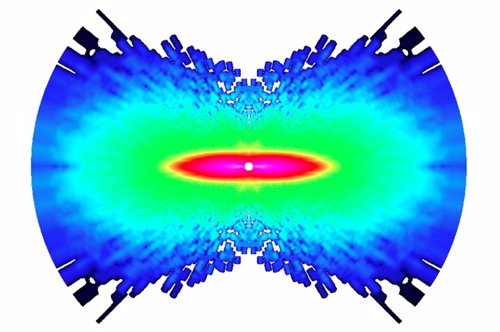

Ahora dos equipos de investigadores, uno conducido por Stefan Kuhr del Instituto Max Planck de Óptica Cuántica de Garching, Alemania, y el otro por Markus Greiner de la Universidad de Harvard, han dado el primer paso al obtener imágenes de átomos individuales de rubidio en una rejilla óptica. Este es un reto no sólo porque los átomos son pequeños, sino también porque los fotones de los átomos cercanos pueden interferir unos con otros, enturbiando cualquier patrón.

Para superar esto, los equipos estudiaron el patrón de luz de un solo átomo. Luego crearon un algoritmo capaz de generar una combinación de este patrón a partir de diferentes disposiciones de una grilla de átomos. Cotejando estas simulaciones con el modelo real observado, el algoritmo podía determinar cuál era la distribución de los átomos.

Cada átomo en la grilla actúa como un bit cuántico. Kuhr dice que la rejilla óptica tiene muchos más de estos “qubits” que otros sistemas enfocados en la computación cuántica, por lo que puede ofrecer mayor velocidad.

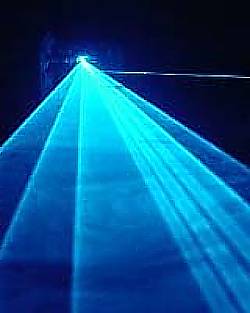

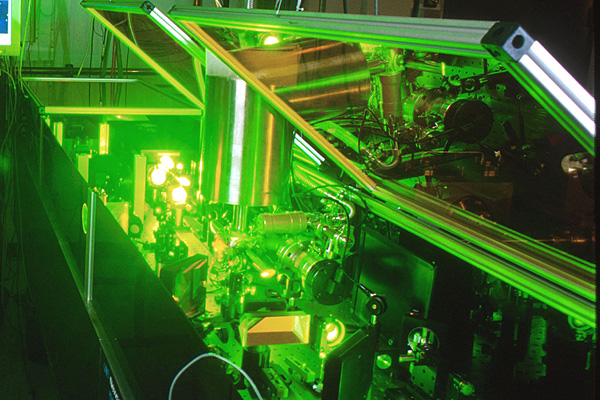

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

El principio de incertidumbre de la mecánica cuántica implica que el espacio nunca puede estar realmente vacío. En cambio, las fluctuaciones aleatorias causan el nacimiento de un caldero hirviente de partículas, como electrones y sus homólogos de antimateria, los positrones.

Las llamadas “partículas virtuales” normalmente se aniquilan entre sí demasiado rápido para que las veamos. Pero los físicos predijeron en los años 30 que un campo eléctrico muy fuerte transformaría las partículas virtuales en reales, y entonces las podríamos observar. El campo las impulsa en direcciones opuestas, porque tienen cargas eléctricas que se oponen, y las separándolos de modo que no puede destruirse mutuamente.

Los láseres son ideales para esta tarea, porque su luz posee campos eléctricos fuertes. En 1997, los físicos del Stanford Linear Accelerator Center (SLAC), en Menlo Park, California, utilizaron luz láser para crear unas pocas parejas de electrón-positrón. Ahora, nuevos cálculos indican que los láser de nueva generación serán capaces de crear pares por millones.

Reacción en cadena

En el experimento de SLAC, sólo se creó un par electrón-positrón a la vez. Pero con los láseres más potentes, es probable que se produzca una reacción en cadena.

El primer par es acelerado a gran velocidad por el láser, haciendo que emita luz. Esta luz, junto con la del láser, genera aún más pares, dice Alexander Fedotov de la Dirección Nacional de Investigaciones Nucleares de la Universidad de Moscú y sus colegas en un estudio que aparecerá en Physical Review Letters.

“Surgirá una gran cantidad de partículas del vacío”, dice John Kirk del Instituto Max Planck de Física Nuclear en Heidelberg, Alemania, que no participó en el estudio.

En los láseres que pueden concentrar cerca de 1026 vatios en un centímetro cuadrado, esta reacción desatada debería convertir de manera eficiente la luz del láser en millones de pares de electrones positrones, calcula el equipo.

Fábrica de antimateria

Ese nivel de intensidad lo podría alcanzar un láser que será construido por el proyecto Extreme Light Infrastructure en Europa. La primera versión del láser se podría construir en 2015, pero podría llevar un año más completar las actualizaciones necesarias para llegar a 1026 vatios por centímetro cuadrado, dice el coautor del estudio Georg Korn del Instituto Max Planck de Óptica Cuántica en Garching , Alemania.

La capacidad de generar una gran cantidad de positrones podría ser útil para los colisionadores de partículas, como el propuesto del Colisionador Lineal Internacional, que impactará electrones y positrones, dice Kirk McDonald de la Universidad de Princeton en Nueva Jersey.

Pero Pisin Chen, de la Universidad Nacional de Taiwan en Taipei, dice que el costo de los poderosos láseres puede hacer que este método sea más caro que el alternativo. En la actualidad, la manera estándar de crear una gran cantidad de positrones es disparar un haz de electrones de alta energía a una pieza de metal, para producir pares electrón-positrón.

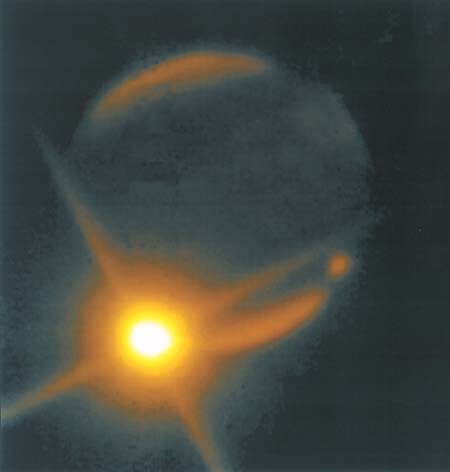

La materia supera a la antimateria en un experimento que imita a la creación

El desequilibrio en el acelerador de partículas de Illinois podría presagiar grandes avances en Física

Menos de una billonésima de segundo después del Big Bang ocurrió otro evento tumultuoso. Aunque el Cosmos nació con partes iguales de materia y antimateria, que se destruyeron una a la otra al entrar en contacto, de alguna forma la materia comenzó a predominar. Los físicos han descubierto una nueva pista sobre la causa de este desequilibrio fortuito, que condujo a la existencia de galaxias, planetas y personas.

Circunferencia de 4 kilómetros de diámetro del Acelerador de Partículas del Laboratorio Fermi de Chicago

El nuevo hallazgo se basa en ocho años de estudio de la desintegración de partículas de vida corta, llamadas mesones B, que se produce durante las colisiones de alta energía en el acelerador de partículas Tevatrón del Laboratorio Fermi (Fermilab), ubicado en Batavia, Illinois. Los científicos del experimento DZero del Tevatrón han descubierto que los mesones B, cuando se desintegran, producen cerca del 1 % más de pares de muones (una versión pesada del electrón) que de pares de sus antipartículas, los antimuones. Los físicos se refieren a este fenómeno como una violación CP.

El desequilibrio, reportado el 14 de mayo en un seminario del Fermilab y publicado en Internet el 18 de mayo, podría servir para entender cómo fue que la materia superó a la antimateria en el Universo. También aumenta las posibilidades de que el hadrones” target=”_blank”>Gran Colisionador de Hadrones, el acelerador de Suiza que sustituyó al Tevatrón como el colisionador de partículas más poderoso del mundo, encuentre nuevas partículas elementales o una nueva física.

“Aunque pequeño, este excedente del 1 % es 50 veces más grande que la asimetría entre materia y antimateria prevista para la desintegración de mesones B por el modelo estándar de la Física de Partículas”, señala el portavoz del DZero, Stefan Söldner-Rembold, de la Universidad de Manchester en Inglaterra.

“Se nos puso la piel de gallina”, cuenta Söldner-Rembold acerca del momento en el que él y los 500 colaboradores del DZero comprendieron lo que habían descubierto. “Estábamos muy contentos porque significa que hay una nueva Física más allá del modelo estándar que tiene que estar a nuestro alcance para que la asimetría sea tan grande”.

“Aunque hay una probabilidad de menos del 0,1 % de que los resultados del DZero sean una casualidad, de acuerdo con las normas de la Física de Partículas hay que considerarlos como indicios aún por confirmar”, advierte el teórico Yuval Grossman de la Universidad de Cornell. Söldner-Rembold señala que los hallazgos del DZero son similares a una asimetría en la producción de materia-antimateria descubierta hace un año por otro experimento llevado a cabo en el Tevatrón, el CDF, pero los nuevos resultados tienen una precisión mayor.

“Las teorías que podrían explicar las observaciones del DZero incluyen la supersimetría, que supone que cada partícula elemental en el modelo estándar de la Física de Partículas tiene una superpareja más pesada todavía por descubrir”, explica la teórica del Fermilab Marcela Carena, que no pertenece al equipo descubridor. “Otras teorías posibles incluyen un modelo en el que la gravedad y otras fuerzas operan en otras dimensiones ocultas, y la noción de que hay una cuarta familia de quarks más allá de las tres generaciones (arriba y abajo, encanto y extraño, y cima y fondo) que sirven como bloques de construcción de los núcleos atómicos y otras partículas.

“En los modelos que consideran una cuarta familia de quarks, la presencia de quarks nuevos y pesados y su interacción con las tres familias conocidas podrían dar lugar a un desequilibrio mayor entre materia y antimateria que el que se encuentra en el modelo estándar”, señala Carena. Y agrega: “En la teoría de la supersimetría, las superparejas pesadas jugarían un rol similar al de los quarks pesados, creando interacciones que podrían favorecer la producción de materia sobre la antimateria”.

No siempre la física lo puede explicar todo. Sin embargo… ¡Lo va consiguiendo!

En la teoría de las dimensiones extra, nuevas partículas mensajeras (portadoras de fuerzas previamente desconocidas) se moverían en dimensiones ocultas. Estas partículas transportadoras podrían alterar la carga y otra propiedad, llamada “sabor”, de las partículas elementales, causando el desequilibrio adicional entre materia y antimateria.

Carena añade: “Sin embargo, es difícil encontrar una teoría que pueda explicar esta asimetría sin contradecir otros resultados experimentales”.

La materia superó a la antimateria en el comienzo

Ulrich Nierste, de la Universidad de Karlsruhe en Alemania, advierte: “La conexión del resultado del DZero con el excedente de materia que existe en el Universo es vaga. Si bien el hallazgo insinúa una nueva fuente de asimetría en las propiedades del mesón B y de su antipartícula, el proceso que creó más partículas que antipartículas en el Universo primitivo podría involucrar un mecanismo físico muy diferente”.

“Sin embargo”, dice Carena, “hace falta alguna nueva fuente de asimetría para explicar el desequilibrio que hay entre la materia y la antimateria en el Universo, y, por lo tanto, nuestra existencia”. En cualquiera de los modelos propuestos “el Gran Colisionador de Hadrones debería ser la ventana directa para observar nuevas partículas”.

Uno de los experimentos más pequeños del Colisionador, diseñado para estudiar los mesones B, podría confirmar los hallazgos del DZero dentro de uno o dos años”, dice Yuval Grossman. Y agrega: “Los experimentos más grandes podrían entonces buscar nuevas partículas que serían el origen del desequilibrio cósmico entre materia y antimateria y determinar sus masas”.

El experimento Beauty (Belleza) es la matriz de investigación para la creación de antimateria. El choque de dos protones contra otro a la velocidad de la luz, ha tenido como resultado una partícula con 5 veces más masa que sus protones originales. A esa exótica partícula se le ha llamado B+ y está compuesta por un quark b-anti y un quark u. La partícula B+ se desintegra a una altísima velocidad pero le da tiempo a recorrer ¡¡2 mm!! antes de desintegrarse en dos partículas, el mesón J / ? y el Kaon K+. Esta distancia, comparada con los minúsculos tamaños que estamos tratando, es una auténtica pasada. Hemos tenido antimateria pura moviéndose a lo largo de dos extensos milímetros de “nuestro” espacio. Impresionante.

Lo revolucionario sin embargo es que de esta forma, los investigadores habrían demostrado la teoría de Albert Einstein. “Sí, podemos crear masa a partir de energía usando la famosa fórmula de Einstein, E=mc2, dicen los responsables del CERN. Aunque también hay que destacar que la confirmación de que existe la antimateria plantea muchas preguntas de difícil resolución puesto que esa sustancia no existe en nuestro universo. “Ya que la desaparición de antimateria primordial no puede ser explicada por el modelo tradicional, tendremos que comenzar a pensar en algo nuevo”, afirman los investigadores. “Los científicos están evaluando diferentes posibilidades pero, dado que sólo podemos observar un 4% de la energía y materia total del universo, podemos inferir que la respuesta al misterio de la antimateria se encuentra en la parte desconocida del mismo”, concluyen.

Como podéis ver, las preguntas son muchas y, las respuestas, son más escasas. Sin embargo, no dejamos de insistir y buscar con todos medios a nuestro alcance para saber sobre la Naturaleza no ya de la materia y la antimateria, sino sobre los muchos enigmas que tenemos planteados y a los que no sabemos dar una adecuada explicación. Parece que a lo lejos vemos una luz cegadora que nos inyecta la esperanza necesaria para seguir la búsqueda y tratar de llegar al corazón de todos esos secretos que el Universo esconde.

Hay cosas que… más que sorprendentes son… ¡Inclreibles! He leído por ahí que…

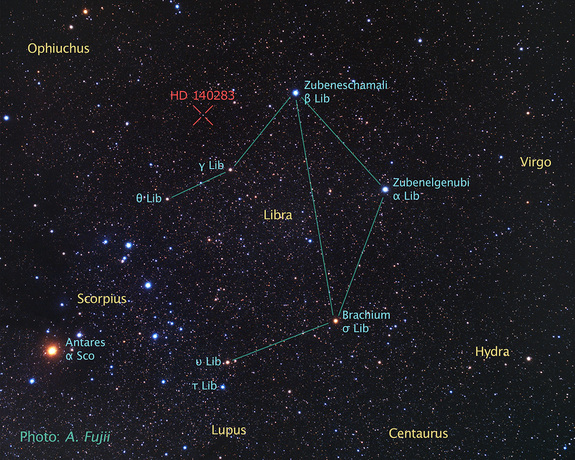

“Un grupo de astrónomos, usando datos del telescopio espacial Hubble, ha determinado la edad de la que es la estrella más vieja cuya edad puede medirse con precisión. El resultado ha sido que la edad de la estrella es de 14.500 ± 800 millones de años, mayor que la estimación de la edad del universo, unos 13.800 millones de años. La estrella en cuestión (HD 140283), también llamada “estrella Matusalén,” una gigante roja que se encuentra a una distancia de 190,1 años luz en la constelación de Libra (distancia medida con precisión mediante la técnica de paralaje). En el año 2000 se dató su edad en 16.000 millones de años. Sin embargo, existen algunas cuestiones que podrían aclarar la extrema edad de esta estrella. Nuevos modelos sobre la difusión de helio en el núcleo indican que la penetración del mismo podría ser mayor de la que se piensa, lo que provocaría un menor ritmo de combustión. También la relación oxígeno-hierro en esta estrella es anómala, demasiado grande, por lo que se cree que futuras observaciones que puedan determinar con mayor grado de precisión la abundancia de oxígeno podrían reducir nuevamente la estimación de la edad de la estrella.”

Oct

15

La Naturaleza a veces resulta extraña e incomprensible

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Curiosidades ~

Clasificado en Curiosidades ~

Comments (0)

Comments (0)

En matemáticas se pueden trazar líneas precisas y concretas que dividan en dos clases entes de naturaleza matemática. Una estructura geométrica se puede suporponer o no a su imagen especular. Una estructura asimétrica puede tener una lateralidad a la derecha o bien a la izquierda. Immanuel Kant, el gran filósofo germano del siglo XVIII, fue el primer pensador eminente que encontró un significado filosófico profundo a las reflexiones especulares. A Kant le parcía enigmático y misterioso que un objeto asimétrico pueda existir en cualquiera de sus dos imágenes frente a un espejo. Parece magia que, poniendo algunas cosas ante un espejo y mirando esa imagen especular, las cosas puedan parecer tan diferentes y, sin embargo, así resultan ser.

Cualquier número entero positivo es par o impar, y no hay ninguno de tales números para el cual su situación a este respecto ofrezca la menor duda. Pero en el mundo, si exceptuamos el nivel subatómico de la teoría cuántica, las lineas divisortias son casi siempre difusas. El alquitrán, ¿es sólido o líquido?. Lo cierto es que, la mayoría de las propiedades físicas se “mueven” en un espectro continuo que hace que vayan cambiando de manera imperceptible de un extremo a otro del mismo.

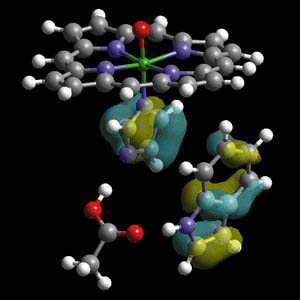

La palabra quiral fue introducida por William Thomson (Lord Kelvin) en 1894 para designar objetos que no son superponibles con su imagen especular. Aplicado a la química orgánica, podemos decir que una molécula es quiral cuando ella y su imagen en un espejo no son superponibles.

La quiralidad está a menudo asociada a la presencia de carbonos asimétricos. Un carbono asimétrico es aquel que se une a cuatro sustituyentes diferentes. Un ejemplo de carbono asimétrico lo tenemos en la molécula de Bromocloroyodometano. El carbono está unido a bromo, cloro, yodo e hidrógeno, cuatro sustituyentes diferentes que lo convierten en quiral o asimétrico. La molécula y su imagen en un espejo son diferentes, ningún giro permite superponerlas. La relación entre una molécula y su imagen especular no superponible es de enantiómeros.

En estos dibujos podemos ver la molécula de Bromocloroyodometano y su enantiómero reflejado en el espejo. Una vez para hacer la prueba, puse en encima de una mesa unos modelos tridimensionales de los poliedros enantiamorfos y delante de ellos puse un espejo que reflejaba la figura especular que de dicha puesta en escena resultaba. Las dos escenas (la real y la especualr) eran exactamente iguales en lo que hace referencia a sus propiedades geométricas. A cada una de las aristas de cada una de las figuras le corresponde una de la misma longitud en la otra. Todo ángulo de una estaba emparejado al duplicado suyo de la otra. Ninguna medida o inspección de cualquiera de ellas reveló ni una sola característica geométrica que no tuviera la otra. En ese sentido, son figuras congruentes idénticas. ¡Pero, evidentemente, no eran idénticas!

Cuando nos ponemos delante del espejo podemos comprobar que en él, aparecen cosas sorprendentes en cuanto a que no se pueden superponer las figuras del modelo con la figura especular. Una simple mano abierta y puesta delante del espejo resulta totalmente diferente en un lado y en el otro de la superficie especular. Puedes ponerte delante del espejo y levantar ambos brazos a media altura con las dos manos abiertas y, de manera sorprendente verás que, la figura que aparece en el espejo muestra tu mano y brazo derecho como izquierdo y el izquierdo como derecho.

La propiedad de las manos, conocida por los químicos como quiralidad, es una característica que poseen muchas moléculas cuya disposición de los átomos no es completamente simétrica. Una molécula quiral se presenta en dos formas que son más bien como un par de guantes. Dos guantes, uno diestro y otro zurdo, son esencialmente idénticos, con los mismos componentes básicos, cuatro dedos y un pulgar, y la misma función de mantener las manos cómodas y protegidas. Pero, evidentemente, no son exactamente iguales: no se puede girar o voltear un guante de un tipo para que se superponga perfectamente en el otro. Pero si lo miras en un espejo, un guante de la mano izquierda se convierte en uno de la mano derecha.

¿Por qué la biología utiliza sólo una de las dos formas especulares de la imagen en la que las moléculas más complejas pueden existir? La última respuesta dada a esta pregunta afecta al campo de la astrofísica, la física de partículas y la bioquímica. La conclusión del último estudio dice que las explosiones estelares conocidas como supernovas son las culpables de que se produzca este fenómeno.

La Naturaleza, como siempre he dicho aquí, tiene muchos misterios que no hemos llegado a comprender. El paso del tiempo convierte en líquido, gas o sólido algunos materiales y, a otros, los deforma hasta perder su estructura original para convertirlos en lo que antes no eran. Nada permanece, todo cambia. Sea cual fuere la línea de división, habrá algunos casos en los que no podamos definirla y, en otros, habrá objetos tan próximos a ella que el lenguaje ordinario no será lo suficientemente preciso como para poder afirmar a qué lado pertenece. Y, la propiedad de la vida, está, precisamente, en uno de esos continuos.

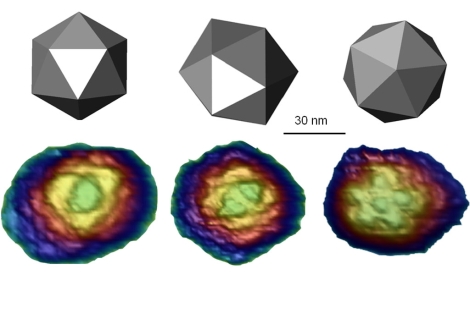

Para porbar esto basta que consideremos los virus: son las estructuras biológicas más pequeñas que se conocen con la propiedad de poder “comer” (absorber sustancias situadas en sus proximidades), crecer y fabricar copias exactas de sí mismas.

Son mucho más pequeños que una bacteria (en realidad, algunos virus infectan las bacterias) y pasan sin dificultad a través de un filtro de porcelana fina que, aunque a nosotros nos parezca que está completamente sellada y su superficie es totalmente hermética y lisa, para ellos, tan “infinitamente” pequeños, ofrece miles de huecos por los que poder colarse.

Nuevas grabaciones en vídeo de un virus que infecta a las células sugiere que los virus se expanden mucho más rápido de lo que pensábamos. El descubrimiento de este mecanismo permitirá crear nuevos fármacos para hacer frente a algunos virus. En la punta de un alfiler caben millones de ellos. De hecho, los virus tienen el tamaño de una décima de micrómetro (diezmillonésima parte del metro).

El mundo de lo muy pequeño es fascinante y, por ejemplo, si hablamos de átomos, se necesitarían aproximadamente una cantidad para nosotros inconmensurable de átomos (602.300.000.000.000.000.000.000) para lograr un solo gramo de materia. Fijáos que hablamos de lo pequeño que pueden llegar a ser los virus y, sin embargo, el Hidrógeno con un sólo protón es el átomo más ligero y su masa es 400.000 veces menor que la masa de un virus, como antes dije, el organismo vivo más pequelo que se conoce. El virus más diminuto conocido mide unos o,00000002 m; su tamaño es 2.000 veces mayor que el del átomo. Y, en la punta del algiler que antes mencionamos cabrían 60.000.000.000 (sesenta mil millones) de átomos.

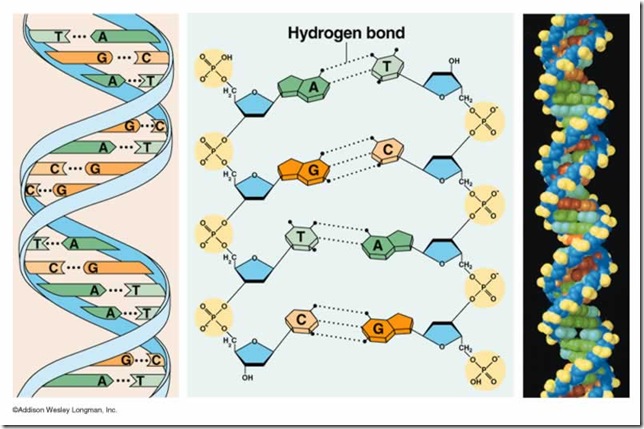

Los virus son nanomáquinas enormemente dañinas pero que están formados por una sencillísima estructura. Tanto es así que se puede decir que son entidades biológicas a caballo entre la materia inerte y la materia viva. Básicamente constan de una envuelta externa llamada ‘cápsida’, formada por proteínas, que se encarga de preservar el ADN en el interior. Los virus no presentan ninguna función metabólica, y consiguen reproducirse parasitando la maquinaria molecular de una célula huésped. El interés por estudiar en profundidad los virus no sólo proviene de la motivación por erradicar las enfermedades que estos producen, sino también de su estudio como materiales. Las cápsidas de los virus son extraordinariamente resistentes.

Como los virus son menores que la longitud de onda de la luz, no pueden observarse con un microscopio luminoso ordinario, pero los bioquímicos disponen de métodos ingeniosos que les permiten deducir su estructura, ya que pueden verlos mediante bombardeos con rayos X u otras partículas elementales.

En ralidad, se puede decir que un cristal “crece”, pero lo hace de un modo ciertamente trivial. Cuando se encuentra en una solución que contiene un compuesto semejante a él, dicho compuesto se irá depositando sobre su superficie; a medida que esto ocurre, el cristal se va haciendo mayor, pero el virus, igual que todos los seres vivos, crece de una manera más asombrosa: toma elementos de su entorno, los sintetiza en compuestos que no están presentes en el mismo y hace que se combinen unos con otros de tal manera que lleguen a dar una estructura compleja, réplica del propio virus.

Los virus sólo se multiplican en células vivientes. La célula huésped debe proporcionar la energía y la maquinaria de síntesis, también los precursores de bajo peso molecular para la síntesis de las proteínas virales y de los ácidos nucleicos. El ácido nucleico viral transporta la especificidad genética para cifrar todas las macromoléculas específicas virales en una forma altamente organizada.

El poder que tienen los virus de infectar, e incluso matar, un organismo, se debe precisamente a esto. Invade las células del organismo anfitrión, detiene su funcionamiento y lo sustituye, por decirlo de alguna manera, por otros nuevos. Ordena a la célula que deje de hacer lo que normalmente hace para que comience a fabricar las sustancias necesarias para crear copias de sí mismo, es decir, del virus invasor.

El primer virus que se descubrió, y uno de los más estudiados, es el virus sencillo que produce la “enfermedad del mosaico” en la planta del tabaco. Cristaliza en forma de barras finas que pueden observarse a través del microsopio electrónico. Recientemente se ha descubierto que cada barra es, en realidad, una estructura helicoidal orientada a la derecha, formada por unas 2.000 moléculas idénticas de proteína, cada una de las cuales contiene más de 150 subunidades de aminoácidos.

Oct

15

¡Definir la Ciencia! ?Y sus curiosidades?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Ciencia ~

Clasificado en La Ciencia ~

Comments (3)

Comments (3)

Para lo que este simple comentario trata de reflejar, bastaría decir que la Ciencia es un estudio lógico y sistemático de la Naturaleza y del mundo físico que abarca todo el Universo y todo lo que dentro de él está presente. Generalmente incluye tanto experimento como teorías que son verificadas por aquellos.

’El túnel de la ciencia’, en el Museo de Artes e Historia del Forum Cultural de Guanajuato. México

La ciencia (del Latín scientia “conocimiento”) es el conjunto de conocimientos sistemáticamente estructurados, y susceptibles de ser articulados unos con otros hasta formar un todo en un entendimiento “general” de la Naturaleza del Universo.

Aunque la definición pueda resultar algo floja, es, sin embargo un compendio general de lo que entendemos por ciencia. Más arriba escribo “generalmente” en cursiva, porque si planteáramos una exigencia absoluta de experimentos, tendríamos que excluir la Astronomía, la más antigua de todas las ciencias, ya que no es posible recrear nuevas estrellas o galaxias en Laboratorio, ni escenificar la creación del sistema solar. Sin embargo, en Astronomía las observaciones son a menudo tan valiosas como los mismos experimentos. El Cometa Halley regresa con una regularidad sorprendente; el Sol sale cada mañana.

El filósofo Karl Popper añadió el requisito de la “refutación” La Ciencia es refutable; la Religión no lo es. Una Teoría o una Ley científica nunca pueden ser demostradas de manera absoluta; de ahí que sea posible refutarlas. Por ejemplo, Newton dijo que la fuerza es igual al producto de la masa por la aceleración (D = ma). No podemos demostrar que todos los objetos de todas las galaxias obedecen esta ley o que todos los objetos obedecerán siempre esta Ley. Sin embargo, para demostrar la falsedad de esta Ley bastaría un solo experimento. (Albert Einstein y varios expertos en física cuántica han demostrado que algunos de los conceptos de Newton son erróneos.) Por lo tanto, los científicos deben proponer sólo teorías que puedan ser refutadas, tal como afirmó Popper. Estas Teorías han de ser comprobables. No existe tal requisito en el caso de la Religión.

La Mente Humana está en conexión con el Universo

Dicho esto, sigue habiendo problemas con la definición. La Astrología, por ejemplo, es refutable. Si nuestros astrólogos nos dicen que nos encontraremos con una guapa extranjera el martes, esto puede comprobarse. Por otra parte, la teoría de las supercuerdas, planteada por algunos físicos como la “teoría del todo”, requeriría un acelerador de partículas con un diámetro de diez años-luz para poder refutarla. La mayor parte de la Biología evolutiva tampoco puede comprobarse experimentalmente. No se puede reproducir la evolución de una especie, ni recrear los dinosaurios comenzando con un animal unicelular. Si aplicamos la regla de la refutación demasiado estrictamente, tendremos que incluir la astrología en el campo de la ciencia y excluir la biología evolutiva, la teoría de cuerdas e incluso quizá la Astronomía.

En consecuencia, es mejor que no nos tomemos demasiado en serio lo de la “refutación” del filósofo de la Ciencia, ya que, de otro modo, podríamos vernos obligados a excluir toda la Ciencia de los antiguos griegos. Estos no sólo eludían el experimento, sino que abominaban de ellos, confiando en que la razón estaba por encima de la evidencia empírica.

Yo, sí he llegado a tener mi propia definición de la Ciencia: “Es el estudio que nos lleva, a través de la observación y el experimento, a la verdadera realidad de la Naturaleza, y, para ello, utilizamos nuestra imaginación para construir modelos y teorías que nos acerquen a esa verdad que presentimos y tratamos de desvelar”.

Los que bebemos de la Ciencia, sentimos que “lo divino” se aleja más y más. Sin embargo, no podemos dejar de sentir que, de alguna manera, algo superior nos vigila, yo lo achaco a ese miedo ancestral que, desde siempre, hemos tenido por lo desconocido y que, inmerso en una profunda ignorancia, no pocas veces hemos querido explicar mediante causas “divinas”, y, sin embargo, cuando, finalmente, hemos dado con las respuestas, estas eran de este mundo y, siempre, eran respuestas lógicas que la Naturaleza nos ofrecía y que no sabíamos compreneder.“ ¿El Creador? Es el Universo con sus complejos sistemas de ritmos y energías el que nos lleva hacia ese futuro que deseamos alcanzar. No existe ningún creador.

Bueno, la definición que de la Ciencia hago y reseño encima de la imagen de arrina, no será perfecta pero, para cumplir los objetivos propuestos es válida y suficiente aunque (como es el caso) le falten algunos matices.

Aquí, en esta página, siempre nos hemos limitado a aquellas disciplinas más estrictas: La Física, La Astronomía, La Cosmología, La Geología, La Química y La Tecnología, Sin olvidar las matemáticas, ya que son indispensables para la Ciencia y están ineludiblemente conexionada con todas ellas que, de una u otra manera, las necesita para poder expresar, en su más alto grado, lo más profundo que esa Ciencia nos quiere decir. Es decir, las matemáticas son el lenguaje del que se vale la Ciencia para decir al mundo lo que realmente son en cada una de sus vertientes. He dejado aparte y sin querer tratar de ellas, las disciplinas más ligeras –La Antropología, La Agronomía, La Psicología, La Medicina y otras del mismo estilo o parecidas- para otros momentos.

Algo que nunca he tomado en consideración ha sido el pragmatismo de la Ciencia o la motivación de los científicos. Estas cuestiones se han utilizado a menudo para desacreditar las Ciencias no occidentales: sí es un trabajo bien hecho, pero no es “puro”, o, a la inversa, no resulta práctico. En cuanto a la motivación, muchos descubrimientos científicos fueron impulsados por la religión: los matemáticos árabes perfeccionaron el álgebra en parte para facilitar las leyes islámicas de la herencia, del mismo modo que los védicos de la India resolvieron raíces cuadradas para construir los altares de los sacrificios con unas dimensiones adecuadas. En estos casos la Ciencia estuvo al servicio de la religión, pero no obstante era Ciencia.

La ley de los epónimos de Stigler, formulada por el experto en estadística Stephen Stigler, afirma que ningún descubrimiento científico lleva el nombre de su descubridor original. El periodista Jim Holt indica que la propia Ley Stigler confirma lo que dice, ya que Stigler admite que la Ley que lleva su nombre fue descubierta por otra persona, concretamente por Robert K. Merton, un especialista en Sociología de la Ciencia.

El área del cuadrado construido sobre la hipotenusa de un triángulo rectángulo, es igual a la suma de las áreas de los cuadrados construidos sobre los catetos.

Entre todos los casos en que se cumple la Ley de Stigler, el más famoso es el del Teorema de Pitágoras (a²+ b² = c², donde a y b son los lados perpendiculares y c es la hipotenusa). Jakob Bronowski escribe lo siguiente:

“Hasta la fecha, el Teorema de Pitágoras sigue siendo el teorema más importante de todas las matemáticas. Esta afirmación puede parecer atrevida y extraordinaria, pero no es extravagante, ya que lo que el teorema de Pitágoras establece es una caracterización fundamental del espacio en que nos movemos y es en este teorema donde dicha caracterización se expresa por primera vez traducida a números. Además, el encaje exacto de los números describe las leyes exactas que rigen el universo. De hecho, se ha propuesto que los números correspondientes a las dimensiones de los triángulos rectángulos sean mensajes que podrían enviarse (de hecho se ha hecho) a planetas de otros sistemas estelares a modo de test, para comprobar si estos planetas tienen ocupación debida a seres dotados de vida racional.

La placa con el mensaje que llevan la Pioneer 10 y 11

Claro que el problema está en que, no fue Pitágoras el primero que propuso “su” teorema. Los hindúes, los egipcios y los babilonios utilizaban “tríos de números pitagóricos” para determinar ángulos rectos en la construcción de edificios. Un trío de números pitagóricos es un conjunto de tres números que representan las dimensiones de los lados de un triángulo rectángulo. El trío más habitual es 3 : 4 : 5 (3² + 4² = 5² o 9 + 16 = 25). Pitágoras “inventó” este teorema hacia el año 550 a. C. Los Babilonios, según todos los indicios, ya habían catalogado quizá cientos de tríos antes del año 2000 a. C., en una época muy anterior a la de Pitágoras. Uno de los tríos que hallaron los babilonios tienen unos números tan enormes como: 3.367 : 3.456 : 4.825.”

El ojo humano tiene sus limitaciones para ver, sin embargo, la imaginación no tiene barreras y, a lo largo de la historia de la Humanidad se han dado pruebas de lo lejos que pueden llegar nuestros pensamientos.Los Babilonios, egipcios e Hindúes le dejaron un campo sembrado a Pitágoras que, en realidad, sólo tuvo que recoger la abundante cosecha. Él sí supo “ver”.

Ahí están y existen indicios de que los babilonios utilizaron diversas técnicas algebraicas derivadas de la fórmula a² + b² = c². Lo que puede reconocerse como un logro de Pitágoras, que impresionó a muchos, fue la elaboración de una demostración geométrica del teorema… El área del cuadrado construido sobre la hipotenusa de un triángulo rectángulo, es igual a la suma de las áreas de los cuadrados construidos sobre los catetos.

Fue Euclides quien proclamó dos siglos más tardes la idea de que la demostración podía ser algo más importante que el propio teorema. Por consiguiente, las matemáticas no occidentales han quedado consideradas como unas matemáticas de segunda categoría debido a que se apoyan sobre una base empírica y no sobre demostraciones.

Ambos métodos son útiles. La Geometría euclidiana que aprendimos la mayoría de nosotros es axiomática. Parte de un axioma, es decir, una ley que se supone cierta, y los teoremas se deducen razonando de manera descendente a partir de ahí. Es deductiva y axiomática. Siglos más tarde, al-Hazin en Oriente y Galileo en Occidente contribuyeron a popularizar un método inductivo y empírico para la Ciencia, algo más parecido a lo que los babilonios, los egipcios y los hindúes habían utilizado. No se parte de suposiciones sino de datos y mediciones, para luego razonar de forma ascendente hacia verdades que recubren los datos conocidos. Lo que actualmente llamamos Ciencia es una materia que en su mayor parte es empírica. Cuando Isaac Newton recopiló datos relativos al paso de los cometas, a las lunas de Júpiter y de Saturno y a las mareas que se producían en el estudio del río Támesis para elaborar una gran síntesis en los Principia, estaba trabajando de una manera empírica e inductiva.

Las matemáticas son ligeramente diferentes, pero muchos matemáticos ven la necesidad de realizar tanto trabajos basados en las demostraciones como trabajos basados en las observaciones empíricas. Un caso puntero que podemos mencionar es el del gran matemático indio Srinivasa Ramanujan, cuyos “cuadernos perdidos” de anotaciones contienen el germen de la teoría de las supercuerdas y cuyos trabajos han sido utilizados para calcular el número π hasta millones de dígitos en su parte decimal.

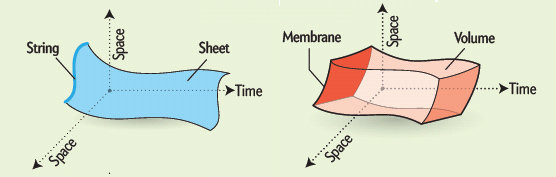

Uno de los secretos más profundos de la teoría de cuerdas, que aún no es bien comprendido, es por qué está definida sólo en diez, once y veintiséis dimensiones. Es ahí, donde la Teoría se hace fuerte y nos facilita la posibilidad de continuar su desarrollo.

Si calculamos cómo se rompen y se vuelven a juntar las cuerdas en el espacio N-dimensional, constantemente descubrimos que pululan términos absurdos que destruyen las maravillosas propiedades de la teoría. Afortunadamente, estos términos indeseados aparecen multiplicados por (N-10). Por consiguiente, para hacer que desaparezcan estas anomalías, no tenemos otra elección cuántica que fijar N = 10. La teoría de cuerdas, de hecho, es la única teoría cuántica conocida que exige completamente que la dimensión del espacio-tiempo esté fijada en un número único, el diez.

Por desgracia, los teóricos de cuerdas están, por el momento, completamente perdidos para explicar por qué se discriminan las diez dimensiones. La respuesta está en las profundidades de las matemáticas, en un área denominada funciones modulares (¿Las de Ramanujan?).

Al manipular los diagramas de lazos de Kikkawa, Sakita y Virasoro creados por cuerdas en interacción, allí están esas extrañas funciones modulares en las que el número 10 aparecen en los lugares más extraños.

Estas funciones modulares son tan misteriosas como el hombre que las investigó, el místico del este. Quizá si entendiéramos mejor el trabajo de este genio indio, comprenderíamos por qué vivimos en nuestro universo actual.

Una partícula, una cuerda abierta y

una cerrada, describiendo sus órbitas en el

espacio-tiempo 4D.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total aislamiento en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas entre oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina (como ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

El número 24 aparece repetidamente en la obra de Ramanujan. Este es un ejemplo de lo que las matemáticas llaman números mágicos, que aparecen continuamente donde menos se les esperan por razones que nadie entiende. Milagrosamente, la función de Ramanujan aparece también en la teoría de cuerdas. El número 24 que aparece en la función de Ramanujan es también el origen de las cancelaciones milagrosas que se dan en la teoría de cuerdas. En la teoría de cuerdas, cada uno de los veinticuatro modos de la función de Ramanujan corresponde a una vibración física de la cuerda. Cuando quiera que la cuerda ejecuta sus movimientos complejos en el espacio-tiempo dividiéndose y recombinándose, deben satisfacerse un gran número de identidades matemáticas altamente perfeccionadas. Estas son precisamente las entidades matemáticas descubiertas por Ramanujan. Puesto que los físicos añaden dos dimensiones más cuando cuentan el número total de vibraciones que aparecen en una teoría relativista, ello significa que el espacio-tiempo debe tener 24 + 2 = 26 dimensiones espacio-temporales.

Una interacción general entre cuerdas se puede representar como la suma de interacciones más “elementales”, empezando con el diagrama árbol que representa la interacción con la mayor probabilidad de ocurrir, seguida por las correcciones perturbativas, es decir, por los demás diagramas de la serie infinita. Como puede observarse en dicha figura, las superficies que representan las interacciones no se vuelven increiblemente complicadas como los digramas de partículas, ya que sólo hay que agregarle agujeros a una superficie dada.

Para comprender este misterioso factor de dos (que añaden los físicos), consideramos un rayo de luz que tiene dos modos físicos de vibración. La luz polarizada puede vibrar, por ejemplo, o bien horizontal o bien verticalmente. Sin embargo, un campo de Maxwell relativista Aµ tiene cuatro componentes, donde µ = 1, 2, 3, 4. Se nos permite sustraer dos de estas cuatro componentes utilizando la simetría gauge de las ecuaciones de Maxwell. Puesto que 4 – 2 = 2, los cuatro campos de Maxwell originales se han reducido a dos. Análogamente, una cuerda relativista vibra en 26 dimensiones. Sin embargo, dos de estos modos vibracionales pueden ser eliminados cuando rompemos la simetría de la cuerda, quedándonos con 24 modos vibracionales que son las que aparecen en la función de Ramanujan.

Ramanujan en Cambridge

Con tan solo doce años dominaba la trigonometría; unos años después se hizo con una copia del libro de George Carr <<A sinopsis of Elementary Results in Pure and Applied Mathematics>>. El libro contenía una lista de los 4.400 resultados clásicos de la matemática, pero sin demostraciones, así es que Ramanujan lo asumió como un reto. Durante los siguientes años se dedicó a fondo en este libro, y comenzó a llenar su libreta de resultados e ideas que no aparecían en el libro original. Al igual que Euler poseía un talento y una intuición excepcional, esto hacía que jugase y trasformarse las fórmulas hasta conseguir nuevas perspectivas.

Cuando se generaliza la función de Ramanujan, el 24 queda reemplazado por el número 8. Por lo tanto, el número crítico para la supercuerda es 8+2=10. Este es el origen de la décima dimensión que exige la teoría. La cuerda vibra en diez dimensiones porque requiere estas funciones de Ramanujan generalizadas para permanecer auto consistente. Dicho de otra manera, los físicos no tienen la menor idea de por qué 10 y 26 dimensiones se seleccionan como dimensión de la cuerda. Es como si hubiera algún tipo de numerología profunda que se manifestara en estas funciones que nadie comprende. Son precisamente estos números mágicos que aparecen en las funciones modulares elípticas los que determinan que la dimensión del espacio-tiempo sea diez.

En el análisis final, el origen de la teoría decadimensional es tan misterioso como el propio Ramanujan. Si alguien preguntara a cualquier físico del mundo por qué la naturaleza debería existir en diez dimensiones, estaría obligado a responder “no lo sé”. Se sabe en términos difusos, por qué debe seleccionarse alguna dimensión del espacio tiempo (de lo contrario la cuerda no puede vibrar de una forma cuánticamente autoconsistente), pero no sabemos por qué se seleccionan estos números concretos.

Quizá la respuesta a todo esto esté esperando a ser descubierta cuando alguien (algún genio matemático como Perelman) sea capaz de entender el contenido de los cuadernos perdidos de Ramanujan.

Está claro que, este simple comentario no explica lo que la Ciencia es y, desde luego, tendríamos que ir a una complejidad mucho más profunda y elevada para poder hablar de algunas ramas de la Ciencia que requieren de un nivel de comprensión de la Naturaleza que, de ninguna manera poseo. ¿Cómo he terminado este trabajo como lo he hecho? Empecé con una intención y, por el camino, como si tuviera vida propia, los pensamientos te llevan por otros senderos que, nunca habías pensado recorrer. ¡Qué cosas!

emilio silvera

Totales: 75.374.088

Totales: 75.374.088 Conectados: 58

Conectados: 58