Oct

22

Recordemos la Misión Cassini Huygens

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (13)

Comments (13)

La misión Cassini servirá (ha servido) para responder a preguntas fundamentales sobre la evolución de los planetas a través de un amplio estudio de Saturno, su famoso sistema de anillos, su magnetosfera, de Titán y otras lunas heladas.

El sistema de Saturno representa un laboratorio sin igual en donde los científicos pueden buscar respuestas a muchas de las preguntas fundamentales sobre la física, química y evolución de los planetas, así como las condiciones en las que tuvo lugar el nacimiento de la vida.

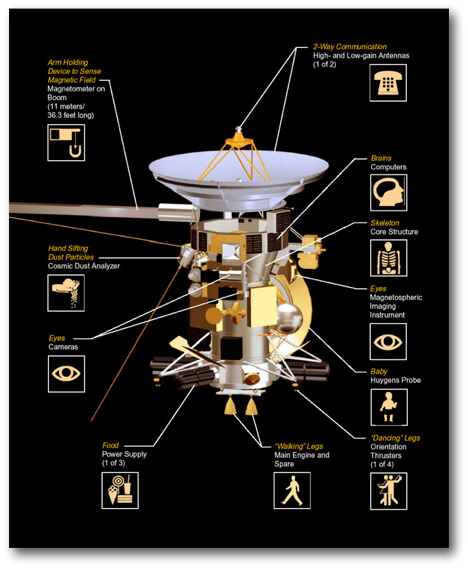

Diseño de la misión Cassini-Huygens-Crédito: ESA

Saturno puede contener una buena parte de la nube de gases primordiales no atrapados por el Sol. Con 31 lunas conocidas y un sistema de anillos que apenas podría caber entre la Tierra y la Luna, Saturno puede considerarse el equivalente a un sistema solar en miniatura. Se piensa que su mayor satélite natural, Titán, puede poseer compuestos orgánicos, los cuales podrían ser importantes para la química que dio lugar a la vida en la Tierra. Aunque es muy fría para poder albergar la vida, Titán puede ser un congelador que nos muestre cómo la Tierra podría haber sido en el pasado.

Oct

22

Riemann y Euclides

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (26)

Comments (26)

La ruptura decisiva con la geometría euclidiana llegó cuando Gauss pidió a su discípulo Riemann que preparara una presentación oral sobre los “fundamentos de la geometría”. Gauss estaba muy interesado en ver si su discípulo podía desarrollar una alternativa a la geometría de Euclides.

Riemann desarrolló su teoría de dimensiones más altas.

Finalmente, cuando hizo su presentación oral en 1.854, la recepción fue entusiasta. Visto en retrospectiva, esta fue, sin discusión, una de las conferencias públicas más importantes en la historia de las matemáticas. Rápidamente se entendió por toda Europa la noticia de que Riemann había roto definitivamente los límites de la geometría de Euclides que había regido las matemáticas durante dos milenios.

Riemann creó su tensor métrico para que, a partir de ese momento, otros dispusieran de una poderosa herramienta que les hacía posible expresarse, a partir del famoso teorema de Pitágoras (uno de los grandes descubrimientos de los griegos en matemáticas que establece la relación entre las longitudes de los tres lados de un triángulo rectángulo: afirma que la suma de los cuadrados de los lados menores es igual al cuadrado del lado mayor, la hipotenusa; es decir, si a y b son los longitudes de los dos catetos, y c es la longitud de la hipotenusa, entonces a2 + b2 = c2. El teorema de Pitágoras, por supuesto, es la base de toda la arquitectura; toda estructura construida en este planeta está basada en él. Claro que, es una herramienta para utilizar en un mundo tridimensional).

Oct

22

Reflexionando un poco

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Divagando ~

Clasificado en Divagando ~

Comments (1)

Comments (1)

En el pensamiento de Popper queda reflejada una realidad irrefutable, nadie sabrá nunca todo sobre todo. Siempre será más lo que no sabemos que lo podamos saber, por mucho que esto sea.

Hablando por mí, puedo decir que tras muchos años de estudio y de interesarme por la ciencia, podría hablar en cualquier momento de cómo se formó el universo, como surgieron los primeros quarks para formar protones y neutrones que, a su vez, se unieron par formar los núcleos y después, al ser rodeadas por electrones atraídos por la carga positiva del núcleo, formaron los átomos que unidos forman la materia de la que están hechos todas las cosas, desde una estrella a un simple árbol, el océano o nosotros mismos.

También puedo explicar cómo al enfriarse el universo primitivo, se rompió la simetría y surgieron las cuatro fuerzas fundamentales de la naturaleza (fuerza nuclear fuerte, nuclear débil, electromagnetismo y gravedad) que hace que el universo sea como lo conocemos.

Podría contarles como nacen y mueren las estrellas para que, de ellas, surjan enanas blancas, estrellas de neutrones o agujeros negros.

Tengo la posibilidad de comentar, o simplemente pensar, los complejas circunstancias que coincidieron en nuestro planeta para que, a partir de materia inerte, surgiera la vida orgánica que basada en el carbono, pudo alcan-zar la inteligencia necesaria para ser conciente de su SER.

Oct

21

Buscando la Gravedad cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (4)

Comments (4)

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

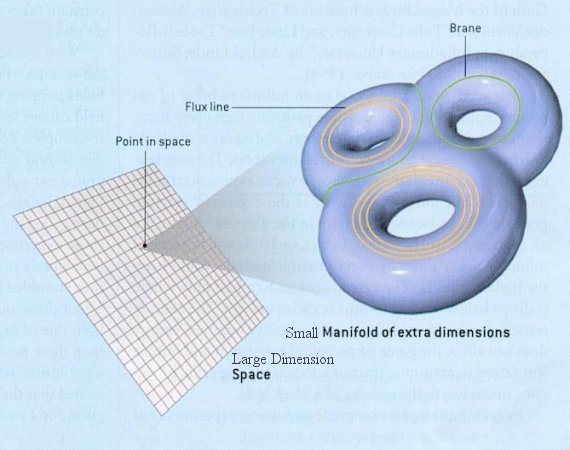

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verlas?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la f´çisica de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

¿Acaso las partículas circulan por el campo de Higgs y se ven frenadas por éste que les adosa la masa?

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

En cuanto a nuestra comprensión del universo a gran escala (galaxias, el Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado.

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo.

emilio silvera

Oct

20

¡El futuro incierto!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en el futuro ~

Clasificado en el futuro ~

Comments (8)

Comments (8)

A mí, particularmente, me da mucho miedo un futuro en el que las máquinas sean imprescindibles. En este mismo momento ya casi lo son. ¿Qué haríamos sin ordenadores que mediante sus programas dirigen fábricas, llevan todo el movimiento de las Bolsas del mundo y de los bancos, dirigen los satélites del espacio, llevan a cabo complicadas operaciones quirúrgicas y montan y ensamblan elaborados mecanismos industriales? El mundo quedaría paralizado.

Pienso en un mundo mucho más avanzado, dentro de 500 – 1.000 años. ¿Qué habrá pasado con los robots?, máquinas cada vez más perfectas que llegaron a autofabricarse y repararse. ¿Cómo evolucionarán a partir de esos procesadores inteligentes de la nanotecnología? ¿Llegarán algún día a pensar por sí mismos? Ahí puede estar uno de los grandes peligros de la Humanidad.

La invención del robot (del checo, robota, trabajo) se debe al esfuerzo de las sociedades humanas por liberarse de las labores más ingratas y penosas a que se ven obligados algunos de sus individuos. En un principio, la apariencia de los robots sólo atendía a las razones prácticas de las funciones que cada modelo tenía que desempeñar, o sea, su morfología estaba aconsejada por criterios funcionales y prácticos.

Una vez superada la primera fase, el hombre trata de fabricar robots que cada vez sean más semejantes a su creador, y aunque las primeras figuras han sido algo groseras y poco hábiles en sus movimientos, poco a poco se va perfeccionando la imitación de los humanos.

Un robot se diferencia fundamentalmente de una máquina por su capacidad para funcionar de modo automático sin la acción permanente del hombre. Los primeros robots se mostraron especialmente válidos para llevar a cabo aquellos trabajos sencillos y repetitivos que resultaban tediosos y pesados al hombre (al Ser Humano mejor). También son ideales para el trabajo en el que se está expuesto a cierto peligro o se trabaja con materiales peligrosos en lugares nocivos para los seres vivos

Nuevas generaciones de robots que…, ¿comienzan a ser peligrosos?

Las máquinas del futuro nos pueden superar. Hemos comenzado a inventar robots que, cada vez son más sofisticados y tienen más prestaciones y, de seguir por ese camino, de no poner unas reglas claras, precisas u rígidas sobre el límite…las cosas podrían salir mal.

Una de las condiciones esenciales que debe tener una máquina-robot para ser considerada como tal es la posibilidad de ser programada para hacer tareas diversas según las necesidades y la acción que de ellos se requieran en cada situación. Y, si llegan a poseer la potestad de pensar por sí mismas, de repentizar soluciones no programadas, de sentir y ser conscientes…¡malo!

Dentro de algunas decenas de años, por ejemplo, no será necesario que ningún astronauta salga al espacio exterior para reparar estaciones espaciales o telescopios como hacen ahora, con riesgo de sus vidas, con el Hubble.

El miedo a los robots del futuro que antes citaba está relacionado con el hecho de que la robótica es el estudio de los problemas relacionados con el diseño, aplicación, control y sistemas sensoriales de los robots.

Ya van quedando muy viejos aquellos robots de primera generación (en realidad brazos mecánicos), muy utilizados en labores de menos precisión de la industria automovilística. Hoy día, los robots que se fabrican, están provistos de sofisticados sistemas “inteligentes” que son capaces de detectar elementos e incluso formas de vida rudimentarias. El proyecto de la NASA en el río Tinto es un ejemplo de ello; allí han utilizado pequeños robots capaces de comunicar datos científicos de los hallazgos en el fondo de un río. Actúan mediante programas informáticos complejos o no, que hacen el trabajo requerido.

Supermáquinas que pueden desarrollar trabajos imposibles

Las necesidades de la industria aeronáutica, poco a poco, han ido exigiendo sistemas de mayor precisión, capaces de tomar decisiones adecuadas en un entorno predefinido en función de las condiciones particulares de un momento dado. Estos ingenios, llamados de segunda generación, poseen instrumentos propios y programación informática dotada de medios de autocorrección frente a estímulos externos variables.

Los sensores utilizados por los sistemas robóticas de segunda generación son, con frecuencia, equipos de cámaras electrónicas digitales que convierten la imagen luminosa recibida desde el exterior en impulsos eléctricos que se comparan con patrones almacenados en un pequeño núcleo de memoria informática. Así mismo, disponen de instrumentos táctiles de alta sensibilidad y de detección de pesos y tensiones.

Incluso en otros planetas a millones de distancia de la Tierra, realizan los trabajos programados

Los robots de tercera generación emplean avanzados métodos informáticos, los llamados sistemas de inteligencia artificial, y procedimientos de percepción multisensorial (estoy leyendo una maravillosa tesis doctoral de un ingeniero de materiales – hijo de un buen amigo – que es fascinante, y me está abriendo la mente a nuevos campos y nuevos conceptos en el ámbito de la inteligencia artificial. Su nombre es A. Mora Fernández, y tiene la suerte de ser, además, un físico teórico matemático, con lo cual, según lo que puedo deducir de su trabajo, le espera grandes empresas y mi deseo personal es que triunfe en ese complejo mundo de fascinantes perspectivas al que pertenece).

Estos ingenios de tercera generación adoptan algunas características del comportamiento humano al contar con la capacidad para percibir la realidad del entorno desde varias perspectivas y utilizar programas que rigen su propia actuación de modo inteligente. Conscientes de su situación espacial, los robots de tercera generación comprenden directamente el lenguaje humano y lo utilizan para comunicarse con las personas.

Los Androides del futuro. ¿Tendrán autonomía de pensamiento?

La ciencia robótica, basándose en avanzados principios de la electrónica y la mecánica, busca en la constitución y modo de funcionamiento del cuerpo y del cerebro humano los fundamentos con los que diseñar androides de posibilidades físicas e intelectivas semejantes a los del ser humano.

Nada de esto es ciencia ficción; es lo que hoy mismo ocurre en el campo de la robótica. Aún no podemos hablar de robots con cerebros positrónicos capaces de pensar por sí mismos y tomar decisiones que no le han sido implantados expresamente para responder a ciertas situaciones, pero todo llegará. Ya tienen velocidad, flexibilidad, precisión y número de grados de libertad. ¿Qué hasta donde llegarán? ¡Me da miedo pensar en ello!

Pronto nos costará distinguirlos

Mecánicamente, el robot ya supera al ser humano; hace la misma tarea, con la misma velocidad y precisión o más que aquél, y tiene la ventaja de que no se cansa, puede continuar indefinidamente desempeñando la tarea en lugares que para nosotros serían imposibles por sus condiciones extremas.

Menos mal que, de momento al menos, el cerebro del ser humano no puede ser superado por un robot, ¿pero será para siempre así? Creo que el hombre es un ser que, llevado por sus ambiciones, es capaz de cometer actos que van encaminados a lograr la propia destrucción y, en el campo de la robótica, si no se tiene un exquisito cuidado, podemos tener un buen ejemplo.

Antes de dotar a estas máquinas de autonomía de obrar y de pensar, debemos sopesar las consecuencias y evitar, por todos los medios, que un robot pueda disponer como un ser humano del libre albedrío, como artificial que es, siempre debe estar limitado y tener barreras infranqueables que le impidan acciones contrarias al bienestar de sus creadores o del entorno.

Es muy importante que los sistemas sensoriales de los robots estén supeditados a los límites y reglas requeridas por los sistemas de control diseñados, precisamente, para evitar problemas como los que antes mencionaba de robots tan avanzados y libre pensadores e inteligentes que, en un momento dado, puedan decidir suplantar a la Humanidad a la que, de seguir así, podrían llegar a superar.

Esta simpática imagen ya ha sido superada

Pensemos en las ventajas que tendrían sobre los humanos una especie de robots tan inteligentes que ni sufrirían el paso del tiempo ni les afectaría estar en el vacío o espacio exterior, o podrían tranquilamente, al margen de las condiciones físicas y geológicas de un planeta, colonizarlo fácilmente, aunque no dispusiera de atmósfera, ya que ellos no la necesitarían y, sin embargo, podrían instalarse y explotar los recursos de cualquier mundo sin excepción. ¡Menuda ventaja nos llevarían! Además, lo mismo que nosotros nos reproducimos, los robots se fabricarán unos a otros. Ni las famosas tres leyes de Asimos me tranquilizan… ¿Las recuerdan?

- Ningún robot puede dañar a un ser humano,

- ni permitir con su inacción que un ser humano sufra daño…

Pero, ¿quién puede asegurar que con los complejos y sofisticados sensores y elementos tecnológicos avanzados con los que serán dotados los robots del futuro, éstos no pensarán y decidirán por su cuenta? ¡Creo que nadie está en situación de asegurar nada! La amenaza está ahí, en el futuro, y el evitarla sólo depende de nosotros, los creadores. ¡Es tanta nuestra ignorancia!

Ciertamente hemos imaginado mundos futuros en los que, no parece que las tres leyes de la robótica puedan preservar la integridad física de los humanos. Si los robots alcanzan ese nivel autónomo de pensamiento… Sería, ¡la rebelión de las máquinas! tantas veces vista en la ficción del cine.

¿Que puede impedir que en el futuro los robots tengan conciencia de ser, o, incluso, sentimientos?

Parece mentira que, alguna vez, lleguen a sentir…llorar o reir

Mirando a mi alrededor, de manera clara y precisa, puedo comprobar que el mundo biológico está compuesto por una variedad de seres que, siendo iguales en su origen, son totalmente distintos en sus formas y en sus mentes, y, de la misma manera, al igual que en nuestro planeta Tierra, pasará en otros situados en regiones remotas del espacio. Y, pensando en nuestras vidas, podemos llegar a preguntarnos si todo ésto tiene algún sentido. ¿Para qué tanto esfuerzo y trabajo? ¿No será que estamos preparando el terreno para “seres” artificiales que, mejor dotados que nosotros para salir al espacio exterior, serán los que suplanten a la Humanidad y cumplan finalmente los sueños de ésta, que harán suyos?.

¡Qué lastima! Si ese fuera nuestro destino. ¡Fabricar a una especie artificial para que cumpliera nuestros deseos! Lo cierto es que, nosotros los humanos, no estamos físicamente preparados para viajar a las estrellas, y, de hacerlo, necesitaríamos dotarnos de tanta seguridad que, los costes, serían impensables. Naves como ciudades que nos transportaran muy lejos, y, pensando en que estamos supeditamos a la velocidad de la luz, estas naves-ciudades estarían preparadas para mantener a generaciones.

Ciudades que surcan el hiperespacio

Nuestro futuro es muy incierto, y, como podemos ver cada día, estamos supeditados a los caprichos de la Naturaleza. Conceptualmente, la biología generalmente va a la saga de la física. Si bien es cierto que las ideas de Darwin sobre la evolución han desplazado la concesión trasnochada y, ¿por qué no?, anti-ilustrada de la creación espacial, pero es cierto que bien entrado el siglo XX, muchos biólogos todavía pensaban instintivamente que los seres humanos representaban la culminación de la evolución, y que nuestra especie no era simplemente el centro del desarrollo evolutivo sino, en realidad, su razón de ser. Y, tales pensamientos, nos pueden dar una idea muy clara del nivel de sabiduría del que podemos presumir.

Ahora sabemos que nuestra contribución al árbol genealógico de la vida es tan periférica y minúscula como la de la Tierra en el Universo. El árbol, tal como lo podemos ver hoy, es realmente frondoso. Desde que surgió la vida en la Tierra, probablemente haya producido cientos de miles de millones, quizás billones, de ramitas, donde cada ramita representa una especie, y Homo sapiens es sólo una más entre ellas. En pocas palabras, nuestra especie ha sido tan cabalmente “periferalizada” por la biología como lo ha sido por la cosmología. Sólo somos una de las formas de vida que habita el Universo y, no es seguro que seámos la más inteligente.

Una vez que hemos comprendido que no somos “los elegidos” y que, estamos en este Mundo, una infinitesimal fracción de una Galaxia de entre cientos de miles de millones de ellas, podemos ser conscientes de que, la humildad será nuestra mejor elección para no equivocarnos y llevarnos decepciones que, en otro caso, serían de consecuencias muy graves. Muchas pueden ser las criaturas que, habitantes de otros mundos, nos pueden superar en inteligencia y conocimientos y, seguramente por eso, porque en nuestro fuero interno algo nos dice que es así, nos estamos preparando para ese futuro que irremediablemente llegará, y, lo único que podemos hacer es crear réplicas de nosotros mismos que, aunque artificiales, puedan representarnos de alguna manera en ese futuro incierto.

No podemos saber lo que vendrá. ¡Es tan grande el Universo!

Ese encuentro maravilloso que tantas veces hemos imaginado, es posible que no lo sea tanto. No podemos saber las criaturas que pueden estar presentes en otros mundos y con qué medios puedan contar. Siempre se me hizo cuesta arriba el hecho de que, algún día del futuro, los robots fabricados por nosotros, podrían adquirir la supremacía del planeta. Sin embargo, alguna vez he pensado también que, quizás, sea la única manera de poder hacer frente a lo que vendrá.

Hemos oído en no pocas ocasiones que la realidad supera a la imaginación, y, desde luego, simplemente con ver todo lo que existe en el Universo, podemos dar fe de tal afirmación. ¿Quién iba a pensar hace 150 años en la existencia de Agujeros Negros o Estrellas de Neutrones? Y, de la misma manera que aquí en la Tierra surgieron cientos de miles de especies y formas de vida a lo largo de su historia, ¿qué prohíbe que en otros mundos surgieran también especies de vida que ni podemos imaginar? ¿Y, la Naturaleza? En Japón hemos visto estos días de lo que es capaz y, desde luego nada puede ser descartado.

Cualquier cosa puede ser posible, ¡es tan frágil la línea que nos separa del Caos!

Es cierto, nuestras limitaciones son enormes, enorme es también nuestra ignorancia y, si somos conscientes de ello, habremos dado un gran paso para hacer frente a lo que pueda venir. Al menos no nos cogerá desprevenido y, el suceso es menos doloroso cuando se espera.

Sí, es verdad, que a veces, confundimos la ilusión y la euforia del momento con la realidad. Sin embargo, nada más lejos de ser cierto. Vivimos en una falsa seguridad cotidiana que nos hace no pensar en lo que puede llegar: Un accidente, una enfermedad, un meteorito caído del cielo, un terremoto, o, incluso una estrella enana marrón que choque con la Luna y dé al traste con nuestra tranquila vida en este planeta.

El destino, ¡tiene tántas bifurcaciones! Parece un laberinto de espejos que lo hace incierto.

Así que, ilusos y tranquilos -de otra manera sería horrible la vida-, en estos últimos años hemos sido capaces de determinar los genes responsables de las más variadas manifestaciones de nuestra existencia: susceptibilidad a la obesidad, diferentes tipos de tumores, esquizofrenia, depresión o la mayor o menor capacidad para danza y ritmo. Y, con sorpresa para algunos, se ha podido saber que nuestra secuencia genética sólo difiere un 0’5% de nuestros parientes cercanos neandertales o que tampoco estamos muy lejos, genéticamente hablando, de algunos equinodermos que divergieron de nuestra rama evolutiva hace ahora 500 millones de años.

También, al mismo tiempo, hemos construido ingenios que enviados a otros mundos, situados a millones de kilómetros del nuestro, nos mandan imágenes que podemos contemplar tranquilamente sentados en el salón de nuestras casas. Y, paralelamente, se trabaja en cerebros artificiales espintrónicos y, más adelante, positrónicos que ocuparan cuerpos perfectos de robots que, aunque artificiales, algún día llegarán a pensar y sentir. ¿Serán nuestros sucesores? ¿Serán los que finalmente realizarán nuestros sueños de viajar a las estrellas?

Sin embargo, y a pesar de tantas proezas, si en algo sigue la ciencia gateando en la oscuridad, es precisamente en el total desconocimiento de la parte más compleja y delicada de nuestro cuerpo: ¡el Cerebro! ¡Si tuviéramos tiempo!

emilio silvera

Totales: 75.729.185

Totales: 75.729.185 Conectados: 50

Conectados: 50