Oct

13

Rumores del saber del mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

Sellos con caracteres en la escritura del Indo, actualmente en poder del Museo Británico.

La india continúa siendo el candidato con más posibilidades para albergar el honor del nacimiento de la escritura. Tradicionalmente se consideraba que la civilización más antigua de la región era la que tenía su enclave en el valle del Indo, cuyas capitales, Harappa y Mohenjo-Daro se remontan a unos 3.000 años a. de C., los indicios y pruebas allí encontrados desplazan a Mesopotamia con la cuna de la escritura.

No soy ningún experto en este tema, sin embargo, si dependiera de mí, dejaría la respuesta en el aire y no descartaría tan rápidamente a Mesopotamia.

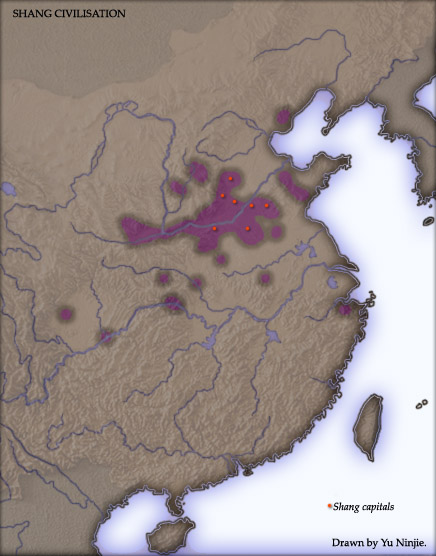

Este mapa muestra las zonas en las que se han encontrado vestigios arqueológicos de la civilización shang, en la que fueron encontrados pergaminos y otros objetos que tenían los signos de la escritura incipiente surgida en China en tiempos muy remotos del pasado. La historia de la escritura no está nada clara y no se saber con exactitud donde pudo surgir el primer alfabeto.

Por otra parte, ¿Qué se sabe de China? (Egipto es algo aparte).

El alfabeto más antiguo hasta ahora encontrado fue descubierto en una excavación realizada en Ras Shamra (Cabeza de hinojo), cerca de Alejandreta, extremo nororiental del Mediterráneo, entre Siria y Asia Menor. Allí, donde la colina que domina un pequeño puerto, se encontraba un asentamiento que en la antigüedad recibía el nombre de Ugarit.

♙Paleta de Narmer en Hieracómpolis (Antiguo Egipto), ca. 3100 a. C.

Tanto en Mesopotamia como en Egipto el saber leer y escribir era algo muy apreciado, Shulgi, un rey sumerio de 2.100 a. C., se jactaba de que:

“De joven estudié el arte de la escriba en la Casa de las Tablillas, con las tablillas de Sumer y Acad; nadie de noble cuna puede escribir una tablilla como yo puedo.”

Los escribas eran formados en Ur desde por lo menos el segundo del tercer milenio a. de C. El rey Shulgi fundó dos escuelas, acaso las primeras del mundo, en Nippur y Ur.

Después de todo esto, algunos miles de años más tarde, llegó la idea de ciencia (scientia significaba originalmente conocimientos). Por lo general, se cree que este ámbito de la actividad humana, sin duda muy provechoso, nació en Jonia, que entonces abarcaba la franja occidental de Asia Menor (la moderna Turquía) y las islas ubicadas frente a ella. Según Edwin Schrödinger, hay tres razones principales por las que la ciencia haya comenzado allí:

En primer lugar, la región no pertenecía a ningún estado poderoso, que normalmente se mostraban hostiles hacia el pensamiento libre.

En segundo lugar, Jonia era un pueblo de marineros, ubicado entre Oriente y Occidente, y con sólidos vínculos comerciales.

El intercambio mercantil ha sido siempre el principal motor para intercambiar ideas entre pueblos diferentes, y que surgían de la necesidad de resolver problemas prácticos.

Aquí mismo, en nuestra región, tenemos una muestra de ello, nos visitaron griegos, fenicios y otros pueblos que, no solo comerciaron con nosotros, sino que nos trajeron técnicas artesanales, de navegación, y un fin de ideas sobre otros aspectos de la vida en sociedad. (Huelva y Cádiz).

En tercer lugar, la región no estaba “infestada de sacerdotes”; no había, como en Babilonia o Egipto, una casta sacerdotal hereditaria y privilegiada con un interés personal en el mantenimiento del statu quo.

Al comparar los orígenes de la ciencia en la antigua Grecia y la antigua China, Geoffrey Lloyd y Nathan Sivin sostienen que los filósofos y científicos griegos gozaron de menos patrocinio que sus contemporáneos chinos, a quienes el emperador empleaba. Sin embargo, esto hizo que los científicos chinos fueran parcos en sus opiniones que se aferraban a lo ya conocido y eran menos dados, que sus colegas griegos a adoptar nuevos conceptos:

Tenían mucho más que perder, y rara vez discutían como hacían éstos. En lugar de ello, los pensadores chinos invariablemente incorporaban las nuevas ideas en teorías existentes, con lo que producían una “cascada” de significados; de esta manera las naciones nuevas tenían que enfrentarse abiertamente con las ya existentes.

En Grecia, lo que había en realidad era una “competición de sabiduría”, bastante similar a los que celebraban en el deporte mismo que por aquel entonces se consideraba como una forma de sabiduría del dominio del cuerpo.

Los jonios comprendieron que el mundo era algo que podía ser comprendido, si uno se tomaba la molestia de observarlo de forma adecuada. No era un patio de recreo donde los dioses manejaban arbitrariamente el destino de los humanos según su estado de ánimo del momento, animados por las pasiones de amor, de ira o por un deseo de venganza, más humano que divino. Este descubrimiento dejó asombrados a los jonios: se trataba, como subrayó Schrödinger, de algo “completamente nuevo” que dejaba inservibles creencias ancestrales.

Los babilonios y los egipcios sabían mucho sobre las órbitas de los cuerpos celestes, consideradas secretos religiosos.

Encontramos al primer científico verdadero, Tales de Mileto, sabio de una ciudad de la costa jónica, en el siglo VI a. de C. Tales, aunque no fue el primero, especuló sobre el origen del Universo y la naturaleza, sin embargo sí fue el primero que expresó sus ideas en términos lógicos, dejando a un lado la mitología, y, además, fue el primero en descubrir la verdadera importancia del agua para la existencia de la vida.

En Egipto aprendió matemáticas y astronomía babilónica para poder predecir un eclipse total de Sol en el año 585 a. de C., eclipse que ocurrió a su debido momento el día correspondiente a nuestro 29 de mayo (dos siglos más tarde, Aristóteles consideraría que este acontecimiento marcaba el inicio de la filosofía griega), sin embargo, Tales es recordado más a menudo por una pregunta que formuló: ¿de qué esta hecho el mundo? Él, equivocado, se respondió a sí mismo, diciendo que el mundo estaba hecho de agua, y, aunque no acertó, si cambió el concepto de que el mundo estaba hecho por los dioses. Este cambio marcó un hito en la historia del pensamiento, aunque entonces, afectara a un número muy reducido de personas.

El sucesor inmediato de Tales, otro jónico llamado Anaximandro, abundo en exponer nuevas ideas que, aunque no todas acertadas, si hicieron pensar a los cultos de su tiempo, aunque sólo fuera para rebatirlas. Anaximandro lanzó la idea de que la realidad última del Universo no podía ser una sustancia tangible (una idea que no estaba tan lejos de la verdad, como se descubriría mucho más tarde).

Todas las ideas profundas que surgieron por aquella época, eran sometidas a un debate cuyo final era el avance de los conocimientos de toda la humanidad.

Empédocles, con sus elementos; Demócrito, con su átomo; Pitágoras, con su teorema; Euclides, y su geometría axiomática; Heráclito, que intuyó que la órbita de los planetas eran todas “errantes”; Leucipo, que como Demócrito creyó que el mundo estaba compuesto por infinidad de diminutos átomos que se movían de forma aleatoria en un “vacío infinito”; Anaxágoras de Clazómene, creyó en los argumentos de los atomistas y en la existencia de una partícula fundamental; Homero, que en su Iliada y Odisea nos habló de plagas y ofreció con cuidadosa descripción el tratamiento de las heridas, evidenciando del saber especializado en este campo; Hipócrates de Cos, meticuloso observador que separó la medicina de la filosofía. Fue famoso por su juramento cuya principal característica estaba en la de colocar al paciente siempre en primer lugar, lo más importante.

El nacimiento de la reflexión jónica, lo que algunos estudiosos llaman el positivismo jónico o la ilustración jónica, ocurrió de forma dual: la ciencia y la filosofía. Tales, Anaximandro y Anaxímenes, fueron los primeros filósofos y también los primeros científicos.

Tanto la ciencia como la filosofía provienen de la idea de que existía un cosmos que era lógico, parte de un orden natural que podía, dado el tiempo necesario, ser entendido.

O sea, lo mismo que digo yo, ahora, más de 2.500 año después.

Parménides, nacido hacia el año 515 a. de C. en Elea, (la actual Velia) en Italia meridional, entonces parte de la Magna Grecia, quien inventó el primer método “filosófico” en el sentido en que hoy entendemos el término. Parménides prefería resolver las cosas a través de procesos mentales, es decir, mediante el pensamiento puro, lo que denominaba el noema. Al creer que ésta era una alternativa variable y viable a la observación científica, creó una división en al vida mental que se ha mantenido hasta nuestros días. Era conocido como sofista, término que significa básicamente hombre sabio (sophos) o amante de la sabiduría (philo-sophos). Hoy el término moderno, filósofo, oculta su carácter práctico de los sofistas de la Grecia antigua.

El estudioso de los clásicos Michael Grant, dice que los sofistas fueron la primera forma de educación superior (al menos en el mundo de occidente) al convertirse en maestros que viajaban de un lado a otro impartiendo clases a cambio de unos honorarios. Las materias que enseñaban eran variadas y lo mismo daban clase de retórica (para discípulos futuros políticos, de asambleas del pueblo que, admiraban a los buenos oradores), la matemática, la lógica y la astronomía.

Los sofistas eran expertos en defender puntos de vista distintos y ello hizo con el tiempo, que prevaleciera el método de que una buena preparación nos puede llevar a la razón mediante la confrontación de ideas dispares.

“El Hombre es la medida de todas las cosas” decía Protágoras

El más famoso de los sofistas griegos fue Protágoras, nacido en Abdera, Tracia, hacia el año 490 a. de C., y, fallecido después de 421 o 411 a. de C. su escepticismo le hizo famoso. Él fue el que dijo: “el hombre es la medida de todas las cosas”.

Así fue como nació la Filosofía, pero los tres grandes filósofos griegos por excelencia fueron Sócrates, Platón y Aristóteles. Platón es el ejemplo de todas las ventajas y debilidades de la aproximación al mundo desde el “pensamiento puro”. Defendió la inmortalidad del Alma. Con gran ingenio, Platón consideró también la matematización de la Naturaleza. El cosmos, sostuvo, que a partir del caos fue creado y su orden es todo el Universo.

emilio silvera

Fuente principal: Ideas de Peter Watson

Oct

13

¡Qué historias!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (1)

Comments (1)

—¿Qués es un ser humano?

—¡La perfección imperfecta!

En alguna ocasión me he referido a los orígenes de la escritura (una cuestión muy polémica sobre uno de los pasos más importantes de la Humanidad), y, propiamente reconocida como tal, tiene más de un candidato, y en éste momento, son al menos tres. Para hablaros un poco de algunas hazañas del ser humano por este mundo, acudo a la obra de Peter Watson, Ideas, que hace un magistral recorrido por muchos de nuestros logros, y, aquí, en dos partes, os dejo una muestra.

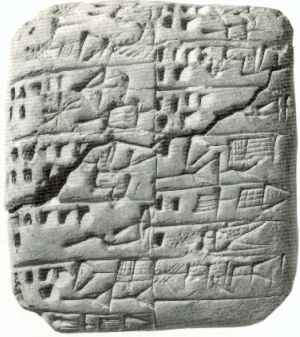

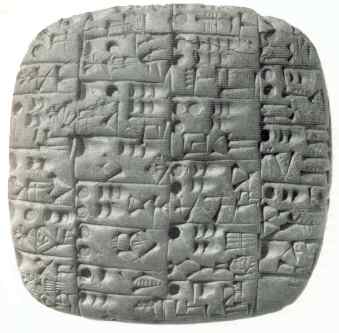

Durante muchos años se dio como seguro que la escritura cuneiforme de Mesopotamia era la más antigua. Había, sin embargo, un inconveniente. El cuneiforme se compone de signos más o menos abstractos, y son muchos los que opinan que la primera escritura estaba relacionada con vínculos más fuertes e incuestionables con la pintura y los pictogramas, signos que son en parte dibujos de objetos y en parte símbolos.

Tablilla Sumeria

En ese punto, hay que referirse a la obra de la arqueóloga Denise Schamndt-Besserat que, a finales de la década de los sesenta, esta investigadora advirtió que por todo Oriente Próximo se habían encontrado miles de “objetos de arcilla bastante prosaicos” que la mayoría de los arqueólogos habían considerados insignificantes.

Ella, pensaba lo contrario: que dichos objetos podían haber conformado un antiguo sistema que los estudiosos habían pasado por alto. Visitó y estudió varias colecciones de estos “especimenes”, como los llamaba, en Oriente Próximo, el norte de África, Europa y América.

En el curso de sus estudios, descubrió que aquellos especimenes tenían, algunas veces, formas geométricas (esferas, tetraedros, cilindros) mientras que otras tenían forma de animales, herramientas o embarcaciones. Además comprendió que se trataba de los primeros objetos de arcilla endurecidos por el fuego: fueran lo que fueran, su fabricación había requerido mucho trabajo y esfuerzo, y, desde luego, no eran prosaicos.

Tablilla de Ur

Esta etapa silábica es conocida en sus comienzos por un grupo de textos de Ur correspondiente a la época de las dinastías I y II de Sumer (2800 a. C.). En esos textos encontramos el primer uso identificable de elementos fonéticos y de gramática, y en la medida en la que se puede identificar el uso de sílabas en la escritura cuneiforme, podemos conocer el lenguaje sumerio. La tablilla, procedente de Ur, c. 2900-2600 a. C., describe una entrega de cebada y comida a un templo

Tablilla de Shuruppak

Los primeros ejemplos de tablillas cuneiformes ya muestran un desarrollo progresivo en la forma de los signos y en la flexibilidad de su uso. Por ejemplo, la tablilla lateral procedente de Shuruppak, Fara, (2600 a. C.) registra cifras de trabajadores. De allí, según la literatura sumeria, procede el héroe del Diluvio, Ziusudra.

La escritura pictográfica proto-sumeria de las tablillas de Uruk y Jemdet Nasr, está escrita dentro de rectángulos o cuadrados dispuestos aleatoriamente. Los rectángulos están puestos en filas a ser leídos de derecha a izquierda y cuando una fila se termina, comienza otra debajo.

Tablilla con el poema Enuma Elish

“…la partió en dos partes, como una concha; la mitad la puso arriba y la denominó cielo. El construyó estancias para los grandes dioses. Fijando su apariencia astral como constelaciones. Designando las zonas, determinó el año.”

Finalmente, Dense tropezó con una descripción de una tablilla ahuecada encontrada en Nazi, un yacimiento del segundo milenio a. de C. al norte de Irak. La inscripción cuneiforme decía: “Cuentas que representan ganado pequeño: veinte ovejas, seis borregas, ocho carneros adultos…” y así sucesivamente.

Cuando se abrió la tablilla, se encontraron dentro cuarenta y nueve cuentas, exactamente el número de animales escrito en la lista.

Para Schmandt-Besserat, aquello fue “como una piedra Rosetta”. Durante los siguientes quince años examinó más de diez especímenes y concluyó que estos constituían un sistema primitivo de contabilidad y, en particular, uno que conduciría a la invención de la escritura.

Según el historiador H.W.F.Saggs, “ninguna invención ha sido más importante para el progreso humano que la escritura”. Por su parte, Petr Charvát la llamó “la invención de las invenciones”.

Por tanto tenemos aquí otra idea capital que poner junto a la agricultura como “la más grandiosa de todos los tiempos”. Pero, no podemos pararnos ahí. Los sumerios inventaron también el carro, un hecho básico para la historia del progreso de la humanidad. La cuestión es que si hacemos una lista de los logros que este formidable pueblo realizó antes que cualquier otro, sería difícil saber cuando parar.

En 1946, el erudito estadounidense Samuel Noah Kramer empezó a dar a conocer sus traducciones de las tablillas de arcilla sumerias, en las que identificó no menos de veintisiete “primeros históricos” logros conseguidos, descubiertos o registrados por primera vez por los antiguos iraquíes. Entre ellos tenemos las primeras escuelas, el primer historiador, la primera farmacopea, los rimeros relojes, el primer arco arquitectónico, el primer código jurídico, la primera biblioteca, el primer calendario agrícola y el primer congreso bicameral. Los sumerios fueron los rimeros que utilizaron los jardines para proporcionar sombra y frescor, los primeros en recoger proverbios y fábulas y los primeros en tener literatura épica y canciones de amor.

Toda la historia de Sumeria está embebida en el misterio

La razón para tan extraordinaria explosión de creatividad no es difícil de encontrar: la civilización, lo que hoy reconocemos como tal, sólo apareció después de que el hombre antiguo hubiera empezado a vivir en ciudades. Las ciudades era el entorno más competitivo y experimental que cualquier otro que las hubiera precedido. La ciudad era la cuna de la cultura, el lugar en el que nació casi la totalidad de nuestras ideas más preciadas. Allí se podía mostrar a otros las cosas que éramos capaces de realizar en todos los ámbitos: trabajo, arte, etc.

En algún momento a finales del cuarto milenio a. de C., la gente empezó a vivir en grandes ciudades. El cambio transformó la experiencia humana, pues las nuevas condiciones de vida exigían que hombres y mujeres cooperaran de formas hasta entonces inéditas. Fue este estrecho contacto, este nuevo estilo de cohabitación frente a frente, lo que explica la proliferación de nuevas ideas encaminadas a satisfacer necesidades, ocio, y en definitiva: mejor forma de vida.

Muestra de cerámica encontrada en la “Casa Incendiada” TT6 en Tell Arpachiyah, norte de Irak, periodo Halaf, alrededor del 4500 a. C. Tell Brak alguna vez había sido un importante pueblo en una importante ruta de comercio que conectaba a la Mesopotamia con el Mediterráneo. El enorme montículo que marcaba el lugar estaba cerca de Chagar Bazar.

De acuerdo con la investigación publicada a finales de 2.004, los primeros centros urbanos fueron Tell Brak y Tell Hamourak al norte de Mesopotamia, en la actual frontera entre Irak y Siria, que se remontaría al año 4.000 a. de C. Pero estos asentamientos eran relativamente pequeños (Hamourak tenía doce hectáreas) y las primeras ciudades propiamente dichas emergieron más al sur hacia 3.400 a. de C. Entre las ciudades de Mesopotamia se incluyen (el orden cronológico es aproximado) Eridu, Uruk, Ur, Umma, Lagash y Shuruppak.

Uruk, por ejemplo, tenía una población fija de unos cincuenta mil habitantes. El origen más obvio de éstas grandes ciudades hay que buscarlo en la seguridad. Sin embargo, hay otras grandes ciudades de la antigüedad -especialmente en países de África occidental como Malí- que nunca levantaron murallas. En el mismo Uruk (que significa área amurallada). Las murallas no se construyeron hasta mucho después de estar, en buena medida construida, aproximadamente hacia el año 2.900 a. de C.

Las especiales condiciones dinásticas reinantes en Mesopotamia, donde la irrigación pudo mejorar de forma sustancial los cultivos y donde había suficiente agua disponible, hizo del lugar un paraíso y las ciudades crecieron en aquellos lugares donde relativamente cerca, tenían piedra, madera, minerales, metales y en definitiva, materias primas.

En aquellos tiempos y en aquellos lugares la Humanidad fue creando su verdadera historia de seres modernos que miraban las estrellas del cielo y se hacían preguntas, que observaban la Naturaleza y de ella aprendían y que, en fin, idearon mil y una maravillas para que, muchos miles de años más tarde, nosotros, nos pudiéramos aprovechar de todas aquellas proezas de la mente humana.

En realidad, todavía no sabemos con certeza dónde surgió por primera vez el cero, y el concepto de nada, de vacío, y si llegaron los mayas de manera independiente. Algunos sitúan la aparición del cero en China. No obstante, nadie discute la influencia india, y todo aparece indicar que fueron ellos los primeros que emplearon a la vez los tres nuevos elementos en que se funda nuestro actual Sistema numérico:

- una base decimal,

- una notación posicionad y cifras para diez, y

- sólo diez, numerales. Y esto ya establecido en 876.

En algún momento se dio por hecho que el cero provenía originalmente de la letra griega omicrón, la inicial de la palabra ouden, que significa “vacío”. Claro que el paso del Tiempo distorsiona los hechos y, cuando se profundiza y se hallan vestigios del pasado… Los logros de estas ciudades y Ciudades-Estados fueron asombrosos y perduraron unos veintiséis siglos. Introdujeron un extraordinario número de las innovaciones que contribuyeron a crear el mundo que hoy conocemos.

emilio silvera

Fuente: De la Obra Ideas de Peter Watson.

Oct

13

No todo es lo que parece a primera vista

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Otros mundos ~

Clasificado en Otros mundos ~

Comments (0)

Comments (0)

La Tierra es conocida popularmente como el planeta azul, pero resulta que no es el más azul de los planetas. La NASA descubrió hace unos años un planeta (arriba está su imagen) de auténtico color azul, situado fuera de los límites del sistema solar cuyo color es mucho más intenso que el del nuestro.

El hallazgo fue posible gracias al potente espectrógrafo del telescopio Hubble. El planeta, que lleva el tan poco exótico nombre de HD 187933b, está a 63 años luz, y fue descubierto hace ocho años. Su hermoso aspecto a primera vista nos podría llevar a confundirlo con un planeta amable y acogedor cuando, en realidad, es todo lo contrario.

Ese bonito color, sin embargo, no delata la existencia de grandes océanos como en La Tierra. HD 187933b es un planeta torturado e inhóspito. La relativa proximidad a su estrella (4,6 millones de kilómetros) hace que su órbita esté siempre bloqueada. En otras palabras, una cara está siempre orientada al sol. Las mediciones de los astrónomos calculan que la atmósfera de la cara iluminada está a unos 1.000 grados centígrados, mientras que la cara oculta baja a unos 800.

La diferencia de temperatura provoca salvajes vientos de 7.200 kilómetros por hora. Se cree que estas condiciones provocan la cristalización del silicio en la atmósfera provocando que, literalmente, lluevan trozos de cristal. Este hecho es el responsable, según la NASA, del singular color del planeta.

Los astrónomos seguirán estudiando la fascinante climatología de este infierno azul por los valiosos datos que ofrece para interpretar el comportamiento del clima en otros planetas. (NASA)

Oct

13

¡La curiosidad! Nos lleva al conocimiento de las cosas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Queriendo saber ~

Clasificado en Queriendo saber ~

Comments (0)

Comments (0)

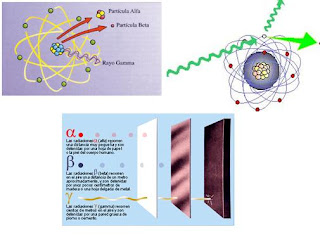

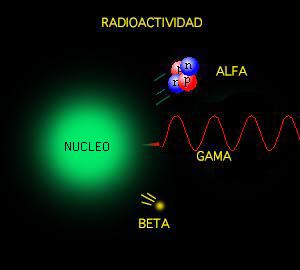

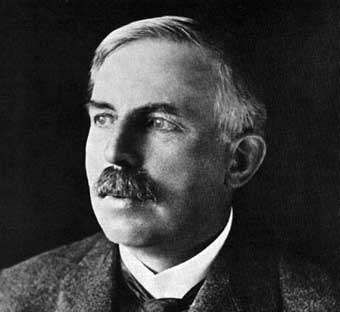

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Los electrones volantes constitutivos de esta última radiación son, individualmente, partículas beta. Así mismo, se descubrió que los rayos alfa estaban formados por partículas, que fueron llamadas partículas alfa. Como ya sabemos, alfa y beta son las primeras letras del alfabeto griego y se escriben con los gráficos α y β.

Entretanto, el químico francés Paul Ulrico Villard descubría una tercera forma de emisión radiactiva, a la que dio el nombre de rayos gamma, es decir, la tercera letra del alfabeto griego (γ). Pronto se identificó como una radiación análoga a los rayos X, aunque de menor longitud de onda.

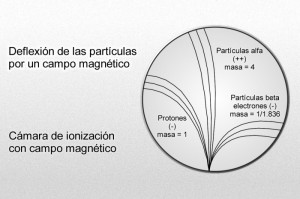

Mediante sus experimentos, Rutherford comprobó que un campo magnético desviaba las partículas alfa con mucho menos fuerza que las partículas beta. Por añadidura, las desviaba en dirección opuesta, lo cual significaba que la partícula alfa tenía una carga positiva, es decir, contraria a la negativa del electrón. La intensidad de tal desviación permitió calcular que la partícula alfa tenía como mínimo una masa dos veces mayor que la del hidrogenión, cuya carga positiva era la más pequeña conocida hasta entonces.

En 1.909, Rutherford pudo aislar las partículas alfa. Puso material radiactivo en un tubo de vidrio fino rodeado por vidrio grueso, e hizo el vacío entre ambas superficies. Las partículas alfa pudieron atravesar la pared fina, pero no la gruesa, lo que dio lugar a que las partículas quedaran aprisionadas entre ambas, y Rutherford recurrió entonces a la descarga eléctrica para excitar las partículas alfa, hasta llevarlas a la incandescencia. Entonces mostraron los rayos espectrales del helio.

Hay pruebas de que laspartículas alfa producidas por sustancias radiactivas en el suelo constituyen el origen del helio en los pozos de gas natural. Si la partícula alfa es helio, su masa debe ser cuatro veces mayor que la del hidrógeno. Ello significa que la carga positiva de éste último equivale a dos unidades, tomando como unidad la carga del hidrogenión.

Más tarde, Rutherford identificó otra partícula positiva en el átomo. A decir verdad, había sido detectada y reconocida ya muchos años antes. En 1.886, el físico alemán Eugen Goldstein, empleando un tubo catódico con un cátodo perforado, descubrió una nueva radiación que fluía por los orificios del cátodo en dirección opuesta a la de los rayos catódicos. La denominó rayos canales.

Part of Astronomy that study physical and chemical characteristics of heavenly bodies. Astrophysics is the most important part of Astronomy at the present time owing to advance of modern physics. Doppler- Fizeau´s effect, Zeeman´s effect, quantum theories and thermonuclear reactions applied to study of heavenly bodies have permitted to discover the solar magnetic field, study stellar radiations and their processes of nuclear fusion, and determine radial velocity of stars, etc. Electromagnetic radiation of heavenly bodies permits to make spectrum analysis of themselves, and they are the principal fountain of information in this part of Astronomy

En 1.902, esta radiación sirvió para detectar por vez primera el efecto Doppler-Fizeau respecto a las ondas luminosas de origen terrestre. El físico alemán de nombre Johannes Stara orientó un espectroscopio de tal forma que los rayos cayeron sobre éste, revelando la desviación hacia el violeta. Por estos trabajos se le otorgó el premio Nobel de Física en 1.919.

Puesto que los rayos canales se mueven en dirección opuesta a los rayos catódicos de carga negativa, Thomson propuso que se diera a esta radiación el nombre de rayos positivos. Entonces se comprobó que las partículas de rayos positivos podían atravesar fácilmente la materia. De aquí que fuesen considerados, por su volumen, mucho más pequeños que los iones corrientes o átomos. La desviación determinada, en su caso, por un campo magnético, puso de relieve que la más ínfima de estas partículas tenía carga y masa similares a los del hidrogenión, suponiendo que este ión contuviese la misma unidad posible de carga positiva.

Por consiguiente se dedujo que la partícula del rayo positivo era la partícula positiva elemental, o sea, el elemento contrapuesto al electrón; Rutherford lo llamó protón (del neutro griego proton, “lo primero”).

Desde luego, el protón y el electrón llevan cargas eléctricas iguales, aunque opuestas; ahora bien, la masa del protón, referida al electrón, es 1.836 veces mayor (como señalo en el gráfico anterior).

Parecía probable pues que el átomo estuviese compuesto por protones y electrones, cuyas cargas se equilibraran entre sí. También parecía claro que los protones se hallaban en el interior del átomo y no se desprendían, como ocurría fácilmente con los electrones. Pero entonces se planteó el gran interrogante: ¿cuál era la estructura de esas partículas en el átomo?

El núcleo atómico

El propio Rutherford empezó a vislumbrar la respuesta. Entre 1.906 y 1.908 (hace ahora un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos. En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina metálica.

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

Desde entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

Con tres electrones, el litio es el elemento sólido más ligero

Hay un tercer elemento, el litio, cuyo átomo tiene tres electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el número de electrones atómicos dentro de la formación iónica, pero en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El número de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. Como es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó esta idea general. Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por número enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal, y ello dio lugar a una interesante historia.

Isótopos; construcción de bloques uniforme,

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

Hacia principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

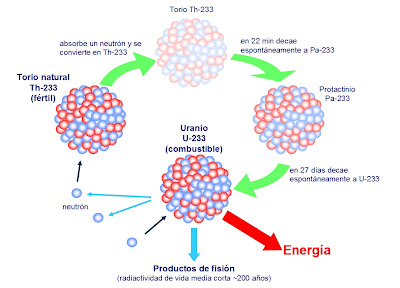

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que durante la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

El material radiactivo llega a producir mutaciones.

Varios químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

Hay que huir de los desechos radiactivos que causan la actividad del hombre

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907 los químicos americanos Herbert Newby McCoy y W. H. Ross descubrieron que el radiotorio (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el radio D, el mismo que el plomo, tanto que a veces era llamado radioplomo. De todo lo cual se infirió que tales sustancias eran en realidad variedades de mismo elemento: el radiotorio, una forma de torio; el radioplomo, un miembro de una familia de plomos; y así sucesivamente.

En 1.913, Soddy esclareció esta idea y le dio más amplitud. Demostró que cuando un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el radiotorio descendía en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas uranio X y uranio Y, es decir, que los tres serían variedades del elemento 90. Así mismo, el radio D, el radio B, el torio B y el actinio B compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el nombre de isótopos (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nobel de Química.

El modelo protón–electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula alfa de un núcleo, se reducía en dos unidades la carga positiva de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al número atómico, y por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de los elementos. ¡Maravilloso!

¿Cómo se explica que cuando el torio se descompone en radiotorio después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta, y más tarde una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque en cierto modo, esto no afecta al resultado).

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía el número atómico 90, es decir, el mismo de antes.

El torio en estado natural

Así pues, el radiotorio, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de un átomo están sujetas al número de sus electrones planetarios, el torio y el radiotorio tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228 respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o número másico. Así, el torio corriente se denomina torio 232, y el radiotorio, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones: plomo 210 (radio D), plomo 214 (radio B), plomo 212 (torio B) y plomo 211 (actinio B).

Se descubrió que la noción de isótopo podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206, la del torio en plomo 208 y la del actinio en plomo 207. cada uno de estos era un isótopo estable y corriente del plomo, pero los tres plomos diferían por su peso atómico.

Mediante un dispositivo inventado por cierto ayudante de J. J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo número de masa era 20, y otra con 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo cada diez. Más tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.

distintos isótopos

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas (el peso atómico) era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la proporción de cuatro a uno. En 1.922 se le otorgó el premio Nobel de Química.

En el discurso pronunciado al recibir el premio, Aston predijo la posibilidad de aprovechar la energía almacenada en el núcleo atómico, vislumbrando ya las futuras y nefastas bombas y centrales nucleares. Allá por 1.935, el físico canadiense Arthur Jeffrey Dempster empleó el instrumento de Aston para avanzar sensiblemente en esa dirección; demostró que 993 de cada 1.000 átomos de uranio eran de uranio 238 (no válido para combustible nuclear). Y muy pronto se haría evidente el profundo significado de tal descubrimiento.

Sí, sólo el 7 por 1000 del uranio existente en la Tierra, es combustible nuclear, es decir, Uranio 235. El resto, es Uranio 238 que hay que reciclarlo en un Acelerador Generador para convertirlo en Plutonio 239 que nos sirva como combustible nuclaer de fisión.

Así, después de estar siguiendo huellas falsas durantes un siglo, se reivindicó definitivamente la teoría de Prout. Los elementos estaban constituidos por bloques estructurales uniformes; si no átomos de hidrógeno, sí, por lo menos, unidades con masa de hidrógeno.

¿Qué no será capaz de inventar el hombre para descubrir los misterios de la naturaleza?

emilio silvera

Oct

12

¿Qué hacemos aquí? ¿Por qué nos comportamos así?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡Qué mundo este nuestro! ~

Clasificado en ¡Qué mundo este nuestro! ~

Comments (1)

Comments (1)

Si miramos hacia atrás en el Tiempo, si repasamos la Historia de la Humanidad, podremos ver que a lo largo de toda ella los seres humanos hemos tenido que trabajar duramente para poder satisfacer nuestras necesidades materiales. En los primeros milenios de esa larga andadura, no éramos muy conscientes de ello, simplemente actuábamos guiados por la necesidad y la intuición, el instinto. Sin embargo, pasaron los años y evolucionamos hasta el punto de que fuímos conscientes de que, además de buscar soluciones a los problemas, había “algo más”.

El Tiempo inexorable pasó y las mentes de aquellos seres primitivos crecieron para llegar a ser conscientes de que, “ese algo más” estaba presente en ellos y era diferente a la necesidad de comer o dormir, o, de cualquiera de las funciones físicas que el cuerpo les exigia. ¿Que podría ser “ese algo más” que, desde entonces ha sido inseparable compañero de los pensamientos del ser Humano. Esa consciencia nos llevó a preguntarnos por el sentido de la Vida. ¿Quiénes éramos? ¿Quién soy como individuo?

El hombre filósofo ha pensado en ello profundamente y, aunque ha dado algunas respuestas, ninguna ha llegado a ser satisfactoria ni ha llenado ese vacío que todos llevamos dentro, en el que se esconde un “ente” desconocido y misterioso que no sabemos quien es, y, lo paradógico es que resulta que somos nosotros mismos, nuestro YO desconocido que, residiendo en nuestro interior, no se deja “ver” del todo y esconde celosamente secretos que, siendo nuestros, no podemos desvelar.

Antes habiendo nombrado el largo camino recorrido por la Humanidad, en el camino, hemos tenido que soportar grandes sufrimientos y dolor, algunos esporádicos momentos de efímera felicidad, nos hemos topado con el bien y con el mal y, también, hemos podido conocer dónde está la inteligencia y la más ciega ignorancia, hemos sabido de la irreversibilidad de la muerte como último viaje y, sin embargo, algo nos dice que puede haber mucho más.

La Ciencia nos dice que más allá de la muerte no habrá nada y que, lo que somos ha quedado aquí, plasmado en nuestros descendientes que seguirán el camino con las experiencias pasadas, la historia aprendida, lo que de sus propias vidas puedan obtener y al compás que marquen los avances tecnológicos de su tiempo. Tendrán, como todos hemos tenido, momento felices y amargos, y, para conseguir objetivos la herramienta será el duro trabajo y la inteligencia que cada cual posea.

Preguntar dónde reside la auténtica felicidad no puede dar como resultado una respuesta general, toda vez que, cada cual, tiene su propio concepto de lo que es la felicidad y, lo que para unos es más que suficiente, para otros no es nada. Lo cierto es que, según los grandes maestros filósofos del mundo, la felicidad reside en las pequeñas cosas: Esa sonrisa del niño, ver a la familia unidad y en armonía, conseguir los logros propuestos, una taza de café en buena compañía, una caricia, una mirada… ¡Son tantas las pequeñas cosas que nos proporcionan felicidad!

Si miramos en el pasado, algunas de las respuestas que buscamos podríamos encontrar, pero…

Si miramos el futuro, nada de lo que buscamos estaría allí

Debemos mirar mejor… ¡Dentro de nosotros mismos! Que siendo como somos Naturaleza, tenemos todas las respuestas y, para llegar a ellas tendremos que avanzar en la evolución del Ser que llevamos dentro y que, estándo conectado con el Universo, forma parte de él. En nuestras mentes está escrito todo aquello que queremos y necesitamos saber: ¿Quiénes somos? ¿Hacia donde vamos? ¿Si la muerte es el último camino o hay más después de ella? ?Por qué tenemos que sufrir dolor? ¿Si vale la pena tan largo y doloroso recorrido? Y, sobre todo, podríamos saber si alguna vez, finalizará ese largo proceso de humanización que nos hace Ser y Sentir, nos posibilita ver más allá de lo que nuestros ojos desnudos nos pueden permitir.

Particularmente tengo la impresión de que en pleno siglo XXI, la Humanidad está más perdida que la Atlantida, aquella mítica ciudad, aquel Imperio de sabiduría y riqueza que nunca pudimos encontrar y que, según las leyendas, nos hablan de grandes Tesoros y de grandes conocimientos. Se dice:

“Que era una tierra ubérrima, bendecida por una vegetación exuberante y por la existencia de valiosos yacimientos minerales, entre ellos los de plata y de oro. Su pueblo gozaba de un alto nivel científico y cultural. En el mismo de ese reino isleño, sobre la cima de una pequeña colina, se ataban un palacio y un templo, en torno a los cuales se extendía la gran dad, que media 19 kilómetros de largo. Alrededor de la colina, un amplio o —en realidad, un canal— permitía el paso de barcos de vela. Alrededor de urbe, otras vías de agua formaban círculos concéntricos; el canal que rodeada la ciudadela se comunicaba con el mar abierto a través de un amplio sistema de muelles y puertos, que exportaban los valiosos productos del país a todo mundo conocido entonces. “

Si miramos a nuestro alrededor, si vemos lo que tenekos que estar soportando, si nos fijamos en la involución que a pesar de todo estamos padeciendo, podríamos sentir nostalgia de aquellos Tiempos pasados en los que, la Humanidad, a pesar de no conocer la Mecánica cuántica ni la Relatividad General, no tenía problemas de paro ni tampoco se producían desahucios que, de alguna manera, vienen a denigrarnos y resulta ser la mayor humillación por la que pasar pueda un ser Humano. No tener un trabajo es denigrante, no tener una Vivienda digna es bochornoso. ¿Cómo hemos podido retroceder tanto?

No debemos consentir que nos quiten la dignidad, ese don tan preciado del Ser Humano que la hace no avergonzarse de sí mismo. Un hombre tiene que poder mantener a su familia y ofrecerle lo más básico: Casa, vestido y alimento. El trabajo del hombre lo dignifica y hace posible que se siente satisfecho de sí mismo, sin importarle el esfuerzo y sacrificio que para lograrlo tenga que hacer. Es su realización como persona.

En palabras de Max Scheler:

“En la Historia de más de diez mil años somos nosotros la primera época en la que el hombre se ha convertido para sí mismo en radical y universalmente en un ser problematico: el hombre ya bo sabe lo que lo es y se da cuenta de que no lo sabe”

Claro que, lo cierto es que no lo hemos sabido nunca y, en algunos momentos de lucides hemos podido tener algún atisbo de “conocernos” pero, como la ráfaga efímera de luz que viaja por el espacio, tan rápido como vienen se van, esos pensamientos que no podemos retener para poder conquistar esa sabiduría necesaria que nos lleve a comprender quiénes somos y hacia donde vamos, toda vez que, de dónde venimos… ¡Tenemos una buena idea!

El hombre hace ya mucho tiempo que se planteó la pregunta sobre el sentido de la Vida

Civilizaciones muu antiguas Sumerios, Babilónicos, Egipcios, Hindúes, Chinos, Persas, Griegos y otros que llegaron después ya tenían inplantada en sus Sociedades una amplia escuela filosófica en la que esa pregunta: ¡El Sentido de la Vida!, siempre estuvo presente y todos los grandes pensadores la quisieraon responder sin lograrlo… ¡del todo!

La Sociedad Científico-Técnica que tenemos hoy, está llena de ambigüedades debido a que el Ser Humano no ha podido alcanzar -todavía- ese nivel de conocimiento que sería necesario para dominar todos los sercretos de la Naturaleza. El Universo es muy grande y vasto en su propia concepción, no podemos llegar a sus límites y, de la misma manera, estamos confinados en un pequño mundo desde el que tratamos de saber lo que pueda haber más allá y, para ello, nos valemos de “sentidos” artificiales” como microsopios y telescopios que nos hablen de lo pequeño y de lo grande pero, seguimos muy retrasados en el conocimiento mayor: ¡Nosotros mismos! Y, la Cienda que camina muy poco a poco, por el momento no nos ha podido decir ni quiénes somos ni hacia donde vamos.

Si bien la crisis de Identidad aparece con más fuerza y presencia durante la adolescencia, resurge también en distintos momentos de la vida de un individuo. La inestabilidad emocional que acompaña este momento vital, es una de sus principales características. Quizás por cuestiones que quedaron pendientes en la infancia o en la etapa puberal o que se presentaron difusas a lo largo de la vida, la construcción de un Yo débil y sin raíces, provoca la imposibilidad de crear relaciones sanas y positivas para el individuo. Sin embargo, dicha crisis identitaria puede tener su origen también en situaciones como la que hoy estamos viviendo en la que, el hombre, llega a dudar de sí mismo al verse abocado a una situación límite en la que, impotente, contempla como su vida de desmorona a su alredor.

Debemos reaccionar, y, salir de la actual situación en la que nos metieron los políticos de turno y los muchos desaprensivos que forman la Sociedad: Me refiero a Banqueros, Sindicatos y Patronales que, junto a otras Instituciones sólo han supuesto la ruina de todos los demás para su beneficio propio. Esa es, amigos míos, la realidad que hoy tenemos en nuestro tecnológico mundo.

¿Qué futuro le espera a la Juventud? ¿Por qué no pagan los cumplables? Y, si por casualiodad, aparece una Jueza Justiciera… ¡La quieren linchar!

emilio silvera

Totales: 75.659.788

Totales: 75.659.788 Conectados: 46

Conectados: 46