Oct

12

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El futuro tecnológico ~

Clasificado en El futuro tecnológico ~

Comments (0)

Comments (0)

Han pasado ya casi cincuenta años desde que Richard Feynman dictara su famosa plática There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un nuevo campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se puede hacer pero no se ha hecho debido a que somos demasiado grandes para hacerlo-.

Desde entonces se ha estado buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Hoy día se estima el mercado de la nanotecnología en cientos de billones de dólares. Nuestro país también ha apoyado esta iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se tiene poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitantes, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo menos una de sus

dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque también existen sistemas nanoestructurados de dimensiones mayores como son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados también materiales en bulto.

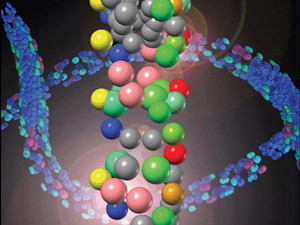

Para tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide entre 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden entre 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

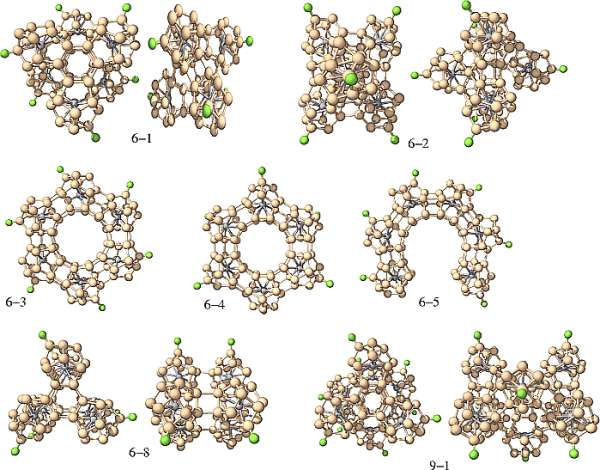

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les puede agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. Cuando el superátomo es de tipo anión (tiene carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, como el potasio”, que tiene un solo electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más para completar su último nivel energético.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología para su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de unos cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria automotriz y aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es, la Nanofotónica

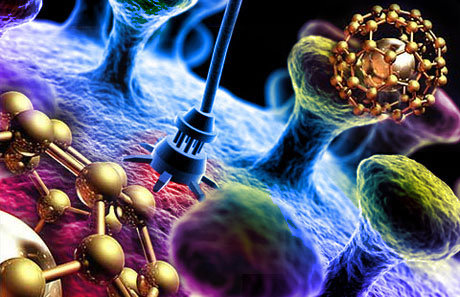

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que ahora, serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar datos por medios ahora desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi parte, estimo que esta división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se puede hablar propiamente de nanofotónica, de igual manera que se puede hablar de nanoelectrónica o de nanomagnetismo.

Cuando sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. Cada una de ellas produce fenómenos de especial interés cuando interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

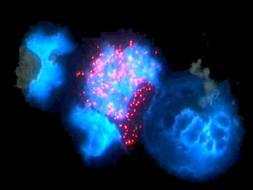

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas para ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en forma dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por hacer. En el CIO, durante los últimos 6 años hemos estado trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores también llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce como confinamiento cuántico, que no es más que la localización de los electrones en un espacio bien definido, es como poner un electrón en una caja. Mientras que para tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así como la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan entre uno y diez nanómetros.

Con frecuencia se les describe como átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. Entre las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad para poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en este caso cada nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien para la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia. Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, para la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y como consecuencia requieren altas energías de bombeo o luz en el UV para obtener emisión que en general es débil, aunque cuando se combina en forma adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices para soportar iones de tierras raras que son muy buenos emisores de luz. En este caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que puede producir una mejora en la eficiencia de emisión.

Entre los nanocristales mas estudiados se encuentran algunos silicatos como Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, cuando se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica para producir láseres conocida como YAG, o YAP para la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado para la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el cáncer de piel. Este mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en forma acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con esta fuente solo se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula desde 10 a 90 nm.

Lo curioso es que en todo, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños pero con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son entre 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En este caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

Como resultado de la interacción entre la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas como plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la forma de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda esta centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta para el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones bien establecidas es la espectroscopia Raman de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo hasta 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

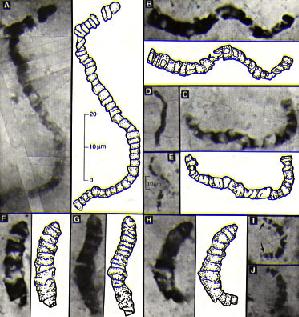

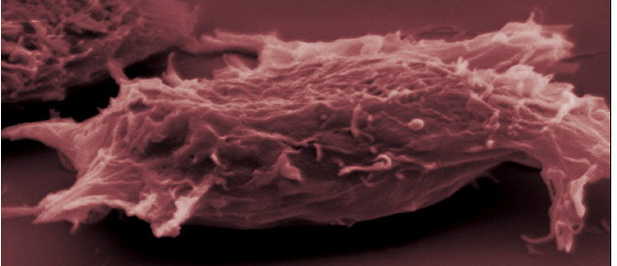

Célula cancerígena

Células modificadas y célula cancerigena que la nanofotónica podrá modificar e incluso regenerar en el fiuturo.

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos para la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas para el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡El futuro está aquí!

emilio silvera

Oct

12

¡Los Elementos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Alquimia estelar ~

Clasificado en Alquimia estelar ~

Comments (6)

Comments (6)

Ya he escrito en otras ocasiones sobre el gran astrofísico Fred Hoyle , que tenía un dominio de la física nuclear no superado entre los astrónomos, hombre de espíritu independiente, que por pura energía intelectual se había abierto camino desde los grises valles textiles del norte de Inglaterra hasta llegar a ser un distinguido profesor de Cambridgue. Hoyle era individualista hasta el punto de la iconoclasia, y tam combativo como si hubiese ganado luchando su título de sir. Sus clases eran carismáticas, con acento de clase obrera que parecía ahondar sus credenciales eruditas acumuladas, y era igualmente eficaz con la palabra escrita; publicaba penetrante artículos especializados, fascinantes obras de divulgación ciantífica y animadas narraciones de ciencia-ficción en la que encontraba una puerta de escape para exponer ideas avanzadas que, científicamente, no estaban contrastadas.

SIR FRED HOYLE

Su burla era temible y sus críticas de la teoría del big bang hizo época por su mordacidad. Hoyle condenó la teoría por considerarla epistemológicamente estéril, ya que parecía poner una limitación temporal inviolable a la indagación científica: el big bang era una muralla de fuego, más allá de la cual la ciencia de la çepoca no sabía como investigar. Él no concebía y juzgó “sumamente objetable que las leyes de la física nos condujeran a una situación en la que se nos prohíbe calcular que ocurrió en cierto momento del tiermpo”. En aquel momento, no estaba falto de razón.

Oct

11

Retazos de historia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Curiosidades ~

Clasificado en Curiosidades ~

Comments (0)

Comments (0)

Icono conmemorativo del Primer Concilio de Nicea que se celebró en el año 325 en Nicea (actualmente Iznik), ciudad de Asia Menor, en el territorio de la actual Turquía, y de la que recibe el nombre por el que es conocido, Concilio de Nicea I. Fue convocado por el emperador Constantino I el Grande, por consejo del obispo San Osio de Córdoba.

Los cristianos calculaban la edad del mundo consultando las cronologías bíblicas de los nacimientos y muertes de los seres humanos, agregando los “engendrados”, como decían ellos. Este fue el método de Eusebio que presidió el Concilio de Nicea convocado por el emperador Constantino en 325 d. C. para definir la doctrina cristiana, y quien estableció que habían pasado 3.184 años entre Adan y Abraham; de san Agustin de Hipona, que calculó la fecha de la Creación en alrededor del 5500 a.C.; de Kepler, que la fechó en 3993 a.C.; y de Newton, que llegó a una fecha sólo cinco años anterior a la de Kepler. Su apoteosis llegó en el siglo XVII, cuando James Ussher, obispo de Armagh, Irlanda, llegó a la conclusión de que “el comienzo del tiempo… se produjo al comienzo de la noche que precedió al día 23 de octubre del año… 4004 a.C.”.

Pasado el tiempo, la exactitud de Ussher le convirtió en el blanco de las burlas de muchos eruditos modernos, pero, a pesar de todos sus absurdos, su enfoque -y, más en general, el enfoque cristiano de la historiografía- hizo más para estimular la investigación científica del pasado que el altanero pesimismo de los griegos. Al difundir la idea de que el universo tuvo un comienzo en erl tiempo y que, por lo tanto, la edad de la Tierra era finita y medible, los cronólogos cristianos montaron sin saberlo el escenario para la época de estudio científico de la cronología que siguió.

Georges Louis Leclerc, Conde de Buffon (Montbard, 7 de septiembre de 1707 – París, 16 de abril de 1788) fue un naturalista, botánico, matemático, biólogo, cosmólogo y escritor francés.

Claro que, la diferencia estaba en que los científicos no estudiaban las Escrituras, sino las piedras. Así fué como el naturalista que arriba podeis ver, expresaba el credo de los geólogos en 1778:

““Así como en la historia civil consultamos documentos, estudiamos medallones y desciframos antiguas inscripciones, a fin de establecer las épocas de las revoluciones humanas y fijar las fechas de los sucesos morales, así también en la historia natural debemos excavar los archivos del mundo, extraer antiguas reliquias de las entrañas de la tierra [y] reunir sus fragmentos… Este es el único modo de fijar ciertos puntos en la inmensidad del espacio, y colocar una serie de mojones en el camino eterno del tiempo.”

Abraham Gottlob Werner (científico alemán)

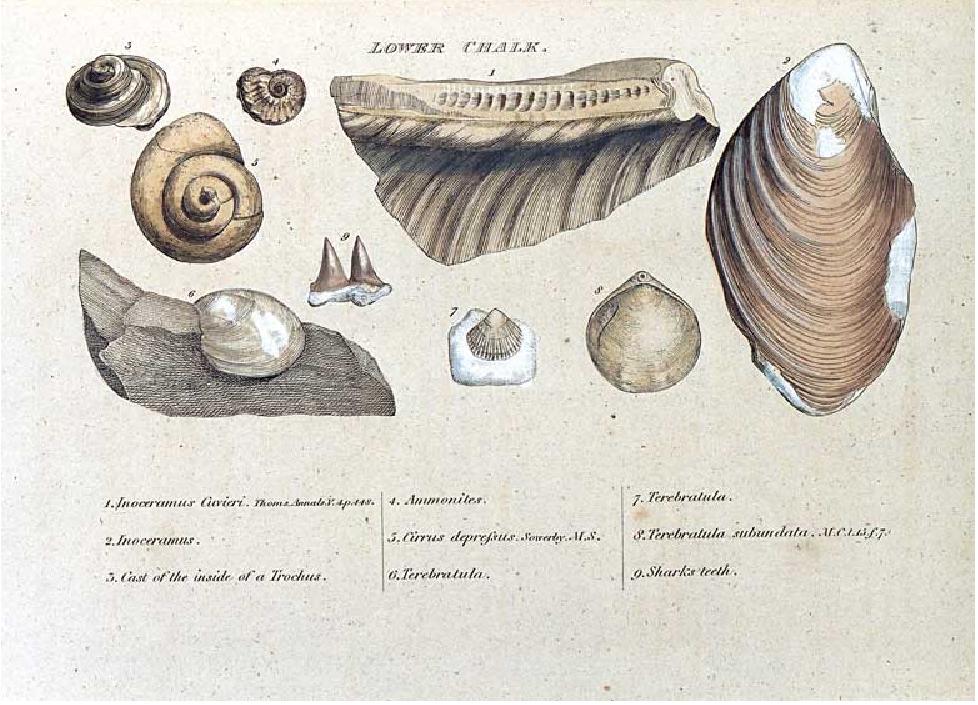

Entre los primeros que aprendieron a leer el lenguaje de las piedras estaban Abraham Gottlob, un geólo alemán, y William Smith, un inglés inspector de canales e ingeniero asesor que colaboró en la excavación del canal del carbón de Somersetshire en 1793, Werner observó que los mismos estratos podían hallarse en el mismo orden en lugares muy alejados unos de otros, lo cual indicaba que el mecanismo que los había formado había operado a gran escala. Esto implicaba que los estratos locales podían brindar elementos de juicio sobre cómo había cambiado el planeta como un todo. Smith, por su parte, observó que los estratos -dispuestos, según sus palabras, como “rebanadas de pan con mantequilla”- no sólo podían ser identificados por su composición total, sino también por las diversas clases de fósiles que contenían.

¿Son los fósiles un exponente universal de la evolución? ¿Cuál es el verdadero mensaje del registro estratigráfico de la tierra y de los fósiles incorporados en el mismo? El registro fósil podría ser la piedra de toque de la teoría de la evolución.

Grabado de la histórica monografía de William Smith, 1815, que dio impulso a la práctica de la correlación de estratos por los fósiles que contienen.

A partir de aquí la búsqueda de huellas del pasado se convirtió en una actividad desaforada y el registro fósil pronto empezó a ofrecer testimonio de seres que ya no se encontraban en el mundo actual. La ausencia de sus equivalentes vivos era un reto a los defensores de la versión bíblica de la historia, que afirmaba, basándose en las Escrituras, que todos los animales fueron creados al mismo tiempo y que ninguna especie se había extinguido desde entonces. A medida que pasaron los años se exploraron cada vez más profundamente las soledades del mundo y las listas de las especies que faltabn era cada vez más larga; George Cuvier, el zoólogo francés que fundó la ciencia de la paleontología, en 1801 había identificado veintitres especies de animales extinguidos en el registro fósil, y la palabra “extinguido” empezó a sonar como una campana que toca a muerto en la literatura científica y las salas universitarias. Ha seguido tocando a muerto desde entonces, y hoy se admite que el 99 por 100 de todas las especies que han vivído sobre la Tierra han desaparecido.

Casi igualmente problemática para los interpretes cristianos de la historia de la Tierra fue la desconcertante variedad de especies vivientes que los biólogos descubrían en sus laboratorios y los naturalistas al explorar las junglas de África, América del Sul y el sureste de Asia. Algunas, como los escarabajos subtropicales gigantes que mordieron al joven Darwin, eran dañinas; sus beneficios para la humanidad, para la que decía que Dios había hecho el mundo, no era evidente. Muchas eran las minúsculas que sólo podían ser detectadas con un microscopio; su papel en el plam de Dios no había sido previsto. Otras eran instintivamente inquietantes, y ninguna más que el orangután, cuyo nombre deriva de la voz malaya que significa “hombre salvaje”, y cuya mirada cálida yn casi íntima, al provenir de una especie muy cercana a la humana en la reserva genética de los primates, parecía burlarse de la pretensión de esta última de ser única.

Si se creía que ninguno de estos seres aparecía en las listas de pasajeros del Arca de Noé… ¿Qué hacían aquí? La ortodoxia religiosa se refugió temperalmente en el concepto de una “gran cadena del ser”. Éste sostenía que la jerarquía de los seres vivos, desde los más elementales microorganismos hasta los monos superiores y las grandes ballenas, habían sido creados por Dios simultáneamente, y que todos juntos formaban una maravillosa estructura, una montaña mágica, con los seres humanos en – o cerca de – su cúspide.

Es difícil sobrestimar la importancia de la gran cadena del ser en el pensamiento del siglo XVIII; figuraba en la estructura de la mayoría de las hipótesis científicas de la época. Pero la cadena no era más fuerte que su eslabón más débil; su mismo carácter completo era una prueba de la perfección de Dios y, por consiguiente, no podía haber ningún “eslabón perdido”. (El término adoptado luego por los evolucionistas proviene de aquí.) Como escribió John Locke:

“En todo el mundo corpóreo visible no vemos simas o abismos. Toda la escala descendente a partir de nosotros es muy gradual, es una serie continua que en cada paso difiere muy poco del anterior. Hay peces que tienen alas y no son extraños al aire, y hay algunos pájaros que son habitantes del agua, cuya sangre es tan fría como la de los peces… Cuando consideramos el poder y la sabiduría infinitos del Hacedor, tenemos razones para pensar que es propio de la magnifica armonía del universo, y al gran designio e infinita bondad de su arquitecto, que las especies de seres asciendan, en suaves transiciones, desde nosotros hacia su infinita perfección, como vemos que desdcienden gradualmente a partir de nosotros.”

Ellos reinaron en nuestro mundo durante unos 150 millones de años. Nosotros hemos llegado aquí, como aquel que dice, antes de ayer pero, “racionales” al fin y al cabo, queremos dolucidar todo lo que, desde los comienzos, pudo pasar y, para ello, el mejor camino será el de la ciencia, ya que, la religión, no puede emitir veredictos fehacientes y, en lugar de basarse en las pruebas, lo hace en la fe que, desde luego, no ofrece ninguna garantía de que lo que afirma, sea lo que en realidad se ajuste a la historia que buscamos saber. Ya sabeis, aquel obispo decía que… “el comienzo del tiempo… se produjo al comienzo de la noche que precedió al día 23 de octubre del año… 4004 a.C.”.

Bueno, no me río pero no por falta de ganas sino por respeto hacia la persona que emitió aquellas palabras y, en consideración al tiempo y al contexto donde las mismas fueron pronunciadas. Lo penoso es que ahora, después de pasados algunos siglos, existan personas que siguen erre que erre insistiendo en los mismos errores. Parece que el tiempo no pasa para ellos y se aferran a unos argumentos “divinos” de trasnochados pensamientos que, alejados de la realidad científica sólo nos pueden conducir hacia la confusión.

emilio silvera

Oct

11

Seguimos preguntando por el origen de la vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Biologia ~

Clasificado en Biologia ~

Comments (0)

Comments (0)

Está bien asentado hoy el conocimiento de que, la Tierra y la Luna, al igual que el resto del Sistema solar, se formó hace ahora unos cuatro mil quinientos millones de años. En algún momento de los primeros mil millones de años de la existencia de la Tierra, la vida hizo su aparición sobre la superficie de nuestro planeta. La Ciencia no ha podido saber nunca cómo sucedió porque hemos perdido el registro de aquellos primeros años. Muchas de las rocas más viejas de la Tierra han sido eliminadas por los vientos y las aguas y empujadas por las corrienteías de las intensas lluvias hacia los océanos. Por otra parte, la lava de las frecuentes erupciones volcánicas cubrieron la mayor parte de las evidencias de vida en el pasado. Sobre la Tierra no quedan vestigios de esos mil primeros millones de años de su historia. Aquel período mágico en el que pudo surgir la vida que, no fue, precisamente de manera expontánea, sino que, se debió a complejos procesos bioquímicos que dieron lugar a una especie de protoplasma de la vida, a partir del cual, surgieron las primeras células vivas replicantes.

La célula viva es un sistema dinámico, en cambio constante en el cual las sustancias químicas se tornan ordenados por un tiempo en estructuras microscópicas, tan solo para disolverse nuevamente cuando otras moléculas se juntan para formar los mismos tipos de estructuras nuevamente, o para sustituirlas nuevamente en la misma estructura. Las organelas de las cuales las células están hechas no son más estáticas que la llama de una vela. En cualquier instante, la vela exhibe un patrón dinámico de casamientos y divorcios químicos, de procesos que producen energía y procesos que la consumen, de estructuras formándose y estructuras desapareciendo. La vida es proceso no una cosa.

¿Cómo ese proceso ordenado llegó a existir? Una vez que la célula es una entidad altamente ordenada y no aleatoria (evitando, la torpe regularidad de un cristal), se puede pensar en ella como un sistema que contiene información1. La información es un ingrediente que adicionado, trae a la vida lo que serían átomos no vivos. ¿Cómo – nos preguntamos-la información puede ser introducida sin una inteligencia creativa sobrenatural? Este es el problema que la Ciencia aún tiene que responderse, lo que colocaría a Dios en la categoría de completamente desempleado.

![]()

La vida, seguramente, fue el resultado de los mismos procesos químicos y físicos que formaron los océanos y la corteza continental de nuestro planeta. Sin embargo, la vida es distinta porque puede experimentar evolución darwiniana. La selección natural ha desempeñado un pepel fundamental en la evolución de plantas y animales durante los primeros tiempos de la historia de nuestro planeta, pero también dirigió la evolución química que hizo posible la propia vida. A grandes rasgos entendemos cómo pueden haber evolucionado las moléculas a partir de precursores simples presentes en la Tierra joven. Sin embargo, sigue siendo un misterio cómo las proteínas, los ácidos nucleicos y las membranas llegaron a interaccionar de forma tan compleja.

Según todos los indicios, en los primeros años del planeta, los continentes que hoy conocemos estaban todos unidos formando la denominada Pangea. El movimiento de las placas tectónicas terrestres logró que estos se separaran y, con el transcurso de millones de años, llegaron a adquirir la moderna forma que hoy conocemos. En todo ese transcurrir y, mientras tanto, una serie de condiciones nuevas aparecieron para hacer posible el surgir de la vida.

Distribución de los continentes hace 260 millones durante el Pérmico. El supercontinente con forma de “C” es Pangea; dentro de la C se localizan los océanos Paleo-Tetis al norte y Tetis al sur; separando ambos océanos se sitúa el continente Cimmeria; cerrando la “C” al noreste se sitúan los microcontinentes de China del Norte y China del Sur; mientras que el resto del globo está ocupado por el océano Panthalassa.

Microfósiles de sedimentos marinos. “Microfósil” es un término descriptivo que se aplica al hablar de plantas o animales fosilizados cuyo tamaño es menor de aquel que puede llegar a ser analizado por el ojo humano. Normalmente se utilizan dos rasgos diagnósticos para diferenciar microfósiles de eucariotas y procariotas.

A partir de todos los fragmentos que la ciencia ha podido ir acumulando, ¿qué tipo de planeta podemos recomponer y qué porcesos tuvieron que darse para que, la vida, tal como la conocemos pudiera surgir? Sin temor a equivocarnos podemos afirmar que, cuando se formó el mar de Warrawoona la Tierra ya era un planeta biológico. Además, las mediciones de isótopos de carbono indican que ya podía haber comenzado la gran liberación ecológica de la fotosíntesis. No podemos tener la certeza si entre los microorganismos de aquel entonces había cianobacterias reproductoras de oxígeno, pero la presencia de cualquier tipo de organismo fotosintético en el océano de Warrawoona es de por sí muy informativa, pues nos permite colocar un punto de calibración en el árbol de la vida.

Los estromatolitos forman parte del registro fósil y son los responsables del oxígeno de la Tierra

Son la evidencia de vida más antigua que se conoce en la Tierra. Las rocas ígneas más antiguas de la Tierra están en Groenlandia y tienen 3800 millones de años. Los estromatolitos más antiguos son de Warrawoona, Australia y tienen unos 3500 millones de años (Precámbricos – Arqueanos). La edad de la Tierra como planeta acrecionado se calcula en 4500 millones de años. La teoría dice que, dadas las condiciones en esa época, los primeros habitantes de la Tierra debieron ser organismos unicelulares, procariontes, y anaerobios. Por tanto, los estromatolitos forman parte del registro fósil más importante de la vida microbiológica temprana. Pero además, vida microscópica fototrófica.

En la nueva concepción de la evolución microbiana que simboliza el árbol, los organismos fotosintéticos aparecen relativamente tarde y se diversifican mucho después del origen de la vida y de la divergencia de los principales dominios de la biología. Si la materia orgánica de Warrawoona es producto de la fotosíntesis, hay que concluir que para entonces la evolución de la vida ya debía llevar en marcha un buen tiempo.

Las observaciones geológicas indican que hace tres mil quinientos millones de años la atmósfera de la Tierra contenía nitrógeno, dióxido de carbono y vapor de agua, pero muy poco oxígeno libre. La mayoría de las inferencias acerca de ambientes antiguos se realizan a partir de pistas sutiles que nos proporcionan la geoquímica; la signatura sedimentaria del oxígeno, sin embargo, es muy llamativa: bandas de color rojo vivo en rocas con silex ricos en hermatita (Fe2 O3), un mineral de óxido de hierro.

En esta imagen que nos enseña un paisaje que me es muy familiar, podemos ver una excavación al aire libre, en las Minas de Rio Tinto (Huelva) nos deja al descubierto los estratos en distintas capas a lo largo de miles de millones de años. El mineral de óxido de hierro está presente formando el llamado hierro en bandas (FHB) no se forman en los acéanos actuales. De hecho, salvo una importante excepción, no se acumulan desde hace 1.850 millones de años. Durante la primera mitad de la historia de la Tierra, en cambio, las FHB fueron un componente común en los sedimentos marinos..

La razón por la cual las FHB no se forman en la actualidad es que el hierro que llega a los océanos se encuentra de inmediato con el oxígeno y precipita en forma de óxido de hierro; en consecuencia, la concentración de hierro en el agua de mar de los océanos actuales es extraordinariamente baja. En los mares del eón Arcaico, las FHB de las sucesiones sedimentarias debieron formarse por reacción del hierro con el oxígeno, ayudadas quizá por bacterias. Alternativamente, es posible que el hierro fuese oxidado por la radiación ultravioleta ya que ésta, al no existir un escudo de ozono eficaz, penetraba hasta la superficie del océano. Todo esto nos lleva a saber que, en el pasado, la atmósfera y los océanos contenían mucho menos oxígeno que en la actualidad.

Todavía los expertos de la NASA, se preguntan como pudieron hallar múltiples formas de vida en estas aguas de Rio Tinto, cargadas de elementos pesados con un PH imposible para la vida, y, sin embargo, ahí están. Ricamente instaladas en un entorno imposible que nada le tiene que envidiar a cualquier paraje marciano.

En la actualidad, nuestros conocimientos de la vida y ambientes arcaicos son a un tiempo frustrantes y emocionantes: frustrantes por las pocas certezas que tenemos y, sólo muchas hipótesis a partir de los datos dispersos que se van obteniendo, emocionante porque sabemos algo, por poco que esto pueda ser, es estimulante contar con un punto de partida que nos permita continuar en el estudio y la observación, seguir experimentando para que, algún día, sepamos a ciencia cierta, de donde pudo venir la vida.

Es verdad que las rocas más antiguas que podemos identificar nos indican la presencia de organismos complejos ¿qué clase de células vivían en aquellos tiempos aún más lejanos? En última instancia, ¡cuál será el verdadero origen de la vida?

La microflora se presenta de muchas maneras

Ademas de las cianobacterias, la microflora puede incluir algas (verdes y diatomeas), hongos, crustaceos, insectos, esporas, polen, rodofitas, fragmentos y sedimentos de todo tipo. La variedad biologica de cada comunidad estromatolitica dependerá de condiciones ambientales e hidrológicas: hipersalino, dulceacuicola, intermareales, submareales, fuertes corrientes, moderadas nulas, calidos, templado, altitud (afecta a la exposicion de la luz uv). En la superficie, es rugosa, porosa y cubierta por mucilago, filamentos, etc. Las particulas de carbonato van quedadonde atrapadas, hasta que la cementacion por crecimiento de cristales, forma una capa mas, de esta forma la estructura aumenta de tamaño.

La Tierra es el tercer planeta del Sistema Solar. Esta situación orbital y sus características de masa la convierten en un planeta privilegiado, con una temperatura media de unos 15º C, agua en forma líquida y una atmósfera densa que pudo evolucionar, con oxígeno y otros ingredientes, condiciones imprescindibles para el desarrollo de la vida.

La creencia general es que hace unos 4.600 millones de años la corteza de la Tierra comenzó a consolidarse y las erupciones de los volcanes empezaron a formar la atmósfera, el vapor de agua y los océanos. El progresivo enfriamiento del agua y de la atmósfera permitió el nacimiento de la vida, iniciada en el mar en forma de bacterias y algas, de las que derivamos todos los seres vivos que habitamos hoy nuestro planeta tras un largo proceso de evolución biólogica.

Aun los organismos más simples son máquinas moleculares extraordinariamente sofisticadas. Las primeras formas de vida tenían que ser muchísimo más sencillas. Nedcesitamos encontrar una familia de moléculas lo bastante simples como para formarse por procesos químicos y lo bastante complejas como para servir de cimiento a la evolución de las células vivas. Una molécula capaz de contener información y estructura suficientes como para replicarse a sí mismas y, al cabo, para dirigir la síntesis de otros componentes que puedan canalizar la replicación con una eficiencia cada vez mayor.

ESTRUCTURA DE LA CELULA BACTERIANA

Unas moléculas, en fin, que pudieran iniciar una trayectoria evolutiva que permitiera a la vida emanciparse de los procesos físicos que le dieron nacimiento, sintetizando las moléculas necesarias para el crecimiento en lugar de incorporarlas de su entorno y captando energía química o solar para alimentar el funcionamiento de la célula.

El descubrimiento de las enzimas de ARN, o ribosomas, realizado de forma independiente y aproximadamente al mismo tiempo por el bioquímico de Yale Sidney Altman, tuvo un efecto catalítico sobre el pensamiento acerca del origen de la vida.

Los enzimas de ARN (llamadas “ribozimas” o “aptazimas”) son moléculas de ARN capaces de autorreplicarse a temperatura constante en ausencia de proteínas. Utilizan la llamada replicación cruzada, en la que dos enzimas se catalizan el uno al otro de forma mutua. Este proceso permite entender cómo surgió la vida, pero los biotecnólogos las usan para algo mucho más prosaico. Estos enzimas de ARN pueden ser utilizados para detectar una gran variedad de compuestos, incluyendo muchos relevantes en diagnóstico médico. El compuesto orgánico se liga al aptazima, que se replica exponencialmente, amplificando exponencialmente la concentración del compuesto hasta permitir que sea fácilmente detectado.

En palabras del filósofo de la biología Iris Fry, esta extraordinaria molécula se alzó como “el huevo y la gallina al mismo tiempo” en el rompecabezas del orgien de la vida. La vida, esa misteriosa complejidad que surgió a partir de la “materia inerte” que, bajo ciertas y complejas condiciones, dio lugar a que lo sencillo se conviertiera en complejo, a que lo inerte pudiera despertar hasta los pensamientos.

Sabemos que, en ciertas condiciones prebióticas, los aminoácidos se forman fácilmente, así quedó demostrado por Stanley Miller en su gamoso experimento. Como los ácidos nucléicos, pueden unirse para formar péptidos, las cadenas de aminoácidos que se pliegan para formar proteínas funcionales.

Hay teorías para todos los gustos, y, el afamado Freeman Dyson, un renombrado físico que ha pensado profundamente sobre el origen de la vida, sugiere que en realidad la vida comenzó en dos ocasiones, una por la vía del ARN y otra vez por vía de las proteínas. Las células con proteínas y ácidos nucleicos interactivos habrían surgido más tarde en función protobiológica. Y, está claro que, la innovación por alianzas es uno de los principales temas de la evolución.

En el árbol de la vida, nosotros (“tan importantes”), sólo somos una pequeña ramita.

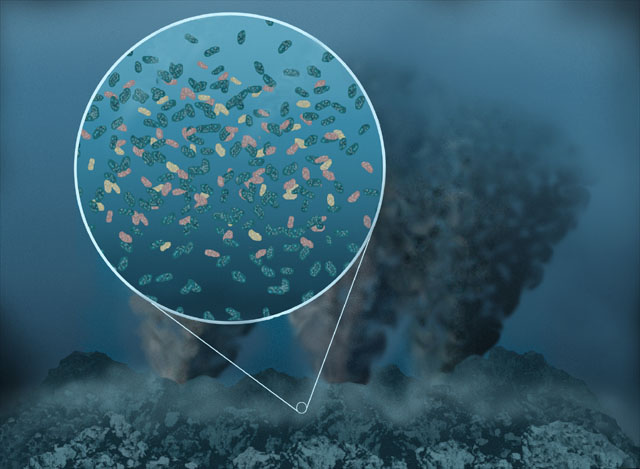

Hay muchos procesos que son de una importancia extrema en la vida de nuestro planeta y, dado que los organismos fotosintéticos (o quimiosinteéticos) no pueden fraccionar isótopos de carbono en más de unas treinta parte por 1.000, necesitamos invocar la participación de otros metabolismos para poder explicar los resultados de las mediciones que se han realizado. Los candidatos más probables son bacterias que se alimentan de metano en los sedimentos. Estas bacterias obtienen tanto el carbono como la energía del gas natural (CH4) y, al igual que los organismos fotosintéticos, son selectivos con los isótopos. A causa de su preferencia química por el 12CH4 frente al 13CH4, los microbios que se alimentan de metano fraccionan los isótopos de carbono en unas veinte o veijnticinco partes por 1.000 en los ambientes donde el metano es abundante. ¿Habeis pensado en la posibilidad de que esos organismos fotosintéticos estén presentes en Titán? ¡El fetín está servido!

La fotosíntesis anoxigénica se da en los organismos que utiliza la energía de la luz del sol, dióxido de carbono (sustrato a reducir) y sulfuro de hidrógeno (en lugar del agua) como dador de electrones que se oxida, se fabrican glúcidos y se libera azufre a el medio acuoso donde habitan o se aloja en el interior de la bacteria.

Otra característica es que los organismos fotosinteticos anoxigénicos contienen bacterioclorofila, un tipo de clorofila exclusiva de los foto-organotrofos, usan longitudes de onda de luz que no son absorbidas por las plantas. Estas bacterias contienen también carotenoides, pigmentos encargados de la absorción de la energía de la luz y posterior transmisión a la bacterioclorofila. El color de estos pigmentos dan el nombre a estas bacterias: bacterias púrpuras del azufre y bacterias verdes del azufre. En las cianobacterias los pigmentos captadores de luz son las ficobilinas, por lo tanto se les nombra, bacterias azules.

Cualquiera de estas imágenes de arriba nos cuenta una larga y compleja historia de cómo se pudieron formar cada uno de los ahí representados, y, en cualquiera de sus fases, formas y colores, es toda una gran obra de la Ingenieria de la Naturaleza que, al fin y al cabo, es la única fuente de la que debemos beber para saciar nuestra sed de sabiduría y alejar la ignorancia que nos abruma.

No pocas veces he dejado aquí constancia de que, el Universo, en todas sus regiones, por muy alejadas que estén, se rige por unas leyes que están presentes en todas parte por igual, y, así lo confirman mil observaciones y mil proyectos que a tal efecto se han llevado a buen término. Por ejemplo, mediaciones precisas de isótopos de azufre en muestras de Marte traídas a la Tierra por meteoritos demuestran que muy pronto en la historia del planeta vecino el ciclo del azufre estaba dominado por procesos atmosféricos que producían un fraccionamiento independiente de la masa.

Valles en Marte. (ESA) La región de Valles Marineris, que tiene una longitud de 4.000 kilómetros y una anchura de 600 kilómetros, es el sistema de cañones más grande conocido en el sistema solar, con profundidades que llegan a los diez kilómetros.

Basándose es ente descubrimiento del fraccionamiento independiente de la masa, se dirigió la atención sobre las rocas terrestres más antiguas. Para sorpresas de muchos geoquímicos, lo que se hayó fue que el yeso y la pirita de las sucesiones sedimentarias más antiguas de la Tierra también como en Marte, han dejado constancias del fraccionamiento independiente de la masa de los isótopos de azufre. Al igual que en Marte, en la Tierra primitiva la química del azufre se encontraba al parecer influenciada por procesos fotoquímicos que sólo pueden producirse en una atmósfera pobre en oxígeno. La etapa del oxígeno comenzó en nuestra atmósfera a comienzos del eón Ptoterozoico. En suma, todos los caminos de la biogeoquímica llevan al mismo sitio, es decir, lo que pasa aquí pudo pasar allí y, al decir allí, quiero decir en cualquier planeta de cualquier galaxia. Las leyes fundamentales de la Naturaleza son, las mismas en todas partes. No existen sitios privilegiados.

Es difícil imaginarse hoy una Tierra sin oxígeno

Dos equipos independientes de investigadores descubrieron que el oxígeno gaseoso apareció en la atmósfera terrestre unos 100 millones de años antes del evento de la gran oxidación de hace 2400 millones de años. Es decir, cuando cambió la antigua atmósfera y el planeta se equipo con la que hoy conocemos.

El oxígeno es un gas muy reactivo, no existe de manera libre durante un largo período de tiempo, pues forma óxidos o reacciona con otras sustancias de manera rápida. Si está presente en la atmósfera es porque las plantas lo reponen continuamente. Antes de la invención de la fotosíntesis y durante muchos cientos de millones de años no había oxígeno libre en la Tierra.

En los estratos geológicos se pueden encontrar pruebas de la existencia de un momento en el que se produjo una gran oxidación mineral, prueba de que el oxígeno se encontraba ya libre en la atmósfera terrestre por primera vez y en gran cantidad. A este hecho se le ha denominado evento de gran oxidación, o GOE en sus siglas en inglés, y fue un hecho dramático en la historia de la Tierra. Este oxígeno permitió más tarde la aparición de vida animal compleja. Los geólogos creían que durante el GOE los niveles de oxígeno subieron rápidamente desde niveles prácticamente despreciables.

El mundo bacteriano es fascinante

Con estas bacterias es posible obtener dos tipos de celdas microbianas o baterías. Unas llamadas celdas de sedimento emplean el lodo donde habitan estos microorganismos; ahí, se produce energía simplemente conectando un electrodo en la parte donde, a cierta profundidad, no hay oxígeno, con otro electrodo que se encuentre en presencia de oxígeno.

¿Cómo respondió la vida a la revolución del oxígeno? Podemos imaginar, un “holocausto de oxígeno” que habría llevado a la muerte y la extinción a innumerables linajes de microorganismos anaeróbicos. Pero hace dos mil doscientos millones de años los ambientes anóxicos no desaparecieron; simplemente, quedaron relegados bajo una capa oxigenada de agua y sedimentos superficiales.

Aquello permitió a la Tierra dar cobijo a una diversidad biológica sin precedentes. Los microorganismos anaeróbicos mantuvieron un papel esencial en el funcionamiento de los ecosistemas, igual que en la actualidad.

En la primera fase de cualquier ejercicio aeróbico, el oxígeno se combina con la glucosa procedente del glucógeno. Al cabo de unos minutos, cuando el cuerpo nota que escasea el azúcar, empieza a descomponer las grasas. Entonces disminuye un poco el rendimiento, mientras el cuerpo se adapta al cambio de origen de su energía. Superado este punto, se vuelve a los niveles y sensaciones normales, pero se queman grasas en lugar de glucosa.

De otro lado, los organismos que utilizan, o al menos toleran el oxígeno se expandieron enormemente. La respiración aeróbica se convirtió en una de las formas principales de metabolismo en las bacterias, y las bacteria quimiosintéticas que obtienen energía de la reacción entre oxígeno e hidrógeno o iones metálicos se diversificaron a lo largo de la frontera entre ambientes ricos en oxígeno y ambientes pobres en oxígeno. Desde ese momento, la Tierra comenzó a convertirse en nuestro mundo.

Nuestro mundo, rico en agua líquida que cubre el 71% de la superficie del planeta, y, su atmósfera con un 78% (en volumen) de Nitrógeno, un 21 de Oxígeno y un 0,9 de Argón, además de dióxido de carbono, hidrógeno y otros gases en cantidades mucho menores que, permiten que nuestros organismos encuentren el medio indóneo para poder vivir. Otros muchos factores presentes en la Tierra contribuyen a que nuestra presencia aquí sea posible.

Las algas verdeazuladas también son llamadas bacterias verdeazuladas porque carecen de membrana nuclear como las bacterias. Sólo existe un equivalente del núcleo, el centroplasma, que está rodeado sin límite preciso por el cromatoplasma periférico coloreado. El hecho de que éstas se clasifiquen como algas en vez de bacterias es porque liberan oxígeno realizando una fotosíntesis similar a la de las plantas superiores. Ciertas formas tienen vida independiente, pero la mayoría se agrega en colonias o forma filamentos. Su color varía desde verdeazulado hasta rojo o púrpura dependiendo de la proporción de dos pigmentos fotosintéticos especiales: la ficocianina (azul) y la ficoeritrina (rojo), que ocultan el color verde de la clorofila.

Mientras que las plantas superiores presentan dos clases de clorofila llamadas A y B, las algas verdeazuladas contienen sólo la de tipo A, pero ésta no se encuentra en los cloroplastos, sino que se distribuye por toda la célula. Se reproducen por esporas o por fragmentación de los filamentos pluricelulares. Las algas verdeazuladas se encuentran en hábitats diversos de todo el mundo. Abundan en la corteza de los árboles, rocas y suelos húmedos donde realizan la fijación de nitrógeno. Algunas coexisten en simbiosis con hongos para formar líquenes. Cuando hace calor, algunas especies forman extensas y, a veces, tóxicas floraciones en la superficie de charcas y en las costas. En aguas tropicales poco profundas, las matas de algas llegan a constituir unas formaciones curvadas llamadas estromatolitos, cuyos fósiles se han encontrado en rocas formadas durante el precámbrico, hace más de 3.000 millones de años. Esto sugiere el papel tan importante que desempeñaron estos organismos cambiando la atmósfera primitiva, rica en dióxido de carbono, por la mezcla oxigenada que existe actualmente. Ciertas especies viven en la superficie de los estanques formando las “flores de agua”.

Sin descanso se habla de quer nosotros, con nuestro comportamiento estamos cambiando la atmósfera de la Tierra, que contaminamos y que, de seguir así, podemos acabar con la vida placentera en el planeta. Tal exageración queda anulada por la realidad de los hechos.

Gigantescas ciudades son una buena muestra de nuestra presencia aquí, y, ¿qué duda nos puede caber? Nuestro morfología nos ha convertido en el ser vivo dominante en el planeta. Sin embargo, no somos los que más hemos incidido en sus condiciones. Si se estudia la larga historia de la vida en la Tierra, podremos ver que una inmensa cantidad de especies han interactuado con la biosfera para modificar, en mayor o menor medida los ecosistemas del mundo. En realidad, la especie que cambió el planeta de manera radical, la que en verdad modificó la Tierra hasta traerla a lo que hoy es, creando una biosfera nueva a la que todas las especies se tuvieron que adaptar (también nosotros), esa especie que, aunque diminuta en su individualidad forma un gigantesco grupo, no son otras que las cianobacterias.

De esa manera, si el oxígeno trajo consigo un cambio revolucionario, las heroínas de la revolución fueron las cianobacterias. Fósiles extraordinarimente bien conservados en síles de Siberia de mil quinientos millones de años de edad demuestran que las bacterias verdeazuladas se diversificaron tempranamente y se han mantenido hasta la actualidad sin alterar de manera sustancial su forma. La capacidad de cambiar con rapidez, pero persistir indefinidamente, compendia la evolución bacteriana.

Las cianobacterias comparten con algunas otras bacterias la habilidad de tomar el N2 del aire, donde es el gas más abundante, y reducirlo a amonio (NH4), una forma que todas las células pueden aprovechar. Los autótrofos que no pueden fijar el N2, tienen que tomar nitrato (NO3-), que es una sustancia escasa. Esto les ocurre por ejemplo a las plantas. Algunas cianobacteria son simbiontes de plantas acuáticas, como los helechos del género Azolla, a las que suministran nitrógeno. Dada su abundancia en distintos ambientes las cianobacterias son importantes para la circulación de nutrientes, incorporando nitrógeno a la cadena alimentaria, en la que participan como productores primarios o como descomponedores.

La resistencia general de las bacterias a la extinción es bien conocida. Las bacterias poseen tamaños poblacionales inmensos y pueden reproducirse rápidamente: no importa que por la mañana nos lavemos los dientes meticulosamente; a media tarde, las bacterias que hayan sobrevivido al cepillo se habrán multiplicado hasta el extremo de recubrir nuevamente el interior de la boca. Además, las bacterias saben habérselas muy bien con medios cambiantes. El aire, por ejemplo, está lleno de bacterias; un plato de leche colocado en el alfeizar de la ventana no tarda en fermentar. Lo que es más, las bacterias son muy buenas a la hora de resistir perturbaciojnes ambientales. Aunque la mayoría crece especialmente bien dentro de unos márgenes ambientales estrechos, son capaces de tolerar condiciones extremas, al menos durante un tiempo.

Si miramos el tiempo que llevan aquí, como se pueden adaptar a condiciones que, ni en sueños podríamos hacerlo nosotros, y, sobre todo, si pensamos en la diversidad y en la inmensa cantidad y en que están ocupando (prácticamente) todas las reguiones del planeta, tendremos que convenir que, es necesario saber cuanto más mejor de ellas y, es necesario que nos sumerjamos en los reinos de las pequeñas criaturas que, de una u otra forma, serán nuestra salvación o, podrían provocar nuestra extinción.

Algunos creen que, también, en lugares como este, pueden estar presentes esos pequeños seres. En lugares donde abundan los mundos… ¿Qué seres habrá? Ahí, en la imagen de arriba, están presentes todos y cada uno de los elementos necesarios para la vida, y, simplemente con que uno sólo de entre una infinidad de planetas se encuentre dentro de la zona habitable de su estrella, podría contener un sin fin de formas de vida que, como aquí en la Tierra, hayan evolucionado y, ¿quién sabe? hasta es posible que esa clase de vida, pueda haber logrado alcanzar los pensamientos, la imaginación, la facultad de ser conscientes.

De todas las maneras…, seguimos sin saber, a ciencia cierta, como pudo surgir las vida. Sólo tenemos vestigios que nos acercan a esa posible fuente, y, son muchas, las zonas oscuras que no dejan ver lo que allí ocurrió, lo que hizo la evolución o dejó de hacer y, las condiciones primigenias que posibilitaron que en este pequeño planeta rocoso, emergieran formas de vida que evolucionadas han podido salir al exterior para ver lo que hay fuera.

Esporas del espacio que pueden llevar la vida a diversos mundos

Acodémonos de la panspermia o llegada de vida desde fuera de la Tierra. La idea está muy extendida a pesar de que no existe la menor evidencia científica a su favor. Ni se ha encontrado vida fuera de nuestro planeta ni hay indicios de que alguno de los organismos de la Tierra procedan de otros mundos. Sin embargo…¡Ahí queda eso!

emilio silvera

Oct

11

¡Cosas del Universo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (0)

Comments (0)

El brillo de las estrellas (la luz y el calor) es el resultadode la conversión de masa en energía (E = mc2), por medio de reaccionesnucleares, las enormes temperaturas de millones de grados de su núcleo, hace posible que los protones de los átomos del hidrógeno se fusionen y se conviertan en átomos de helio. Por cada kilogramo de hidrógeno quemado de esta manera, se convierten en energía aproximadamente siete gramos de masa. De acuerdo con la famosa ecuación de Einstein (arriba reseñada),los siete gramos equivalen a una energía de 6’3 × 1014 julios. Las reacciones nucleares no sólo aportan la luz y el calor de las estrellas, sino que también producen elementos pesados, más complejos que el hidrógeno y el helio que, posteriormente, son distribuidos por el universo, cuando al final de la estrella, esta explota en supernova, lanzando sus capas exteriores al espacio que de esta forma, deja “sembrado” de estos materiales el espacio interestelar.

A partir de una Nebulosa como ésta se pudo formar el Sistema Solar

La variedad de estrellas es grande y para los estudiosos fascinantes. Tal diversidad es debida a la evolución que desde su formación tiene cada tipo de estrella en función de su masa y de los gases y polvo cósmico que la forman y los que se crean en su núcleo (horno solar) a miles de millones de grados de temperatura capaces de transformar materiales simples como el hidrógeno hacia una gama más compleja y pesada que, finalmente, mediante la explosión de supernova (más temperatura), arroja al espacio materiales que, a su vez, forman nuevas estrellas de 2ª y 3ª generación con materiales complejos. La vida en nuestro planeta pudo surgir gracias a que en la Tierra había abundancia de estos materiales creados en las estrellas. Podemos decir, sin temor a equivocarnos que nosotros mismos estamos hechos del material creado en alguna estrella que posiblemente, hace miles de millones de años explotó como supernova sembrando toda la región de materiales complejos que formaron nuestro Sistema solar.

Einstein hizo más que cualquier otro científico por crear la imagen moderna de las leyes de la naturaleza. Desempeñó un papel principal en la creación de la perspectiva correcta sobre el carácter atómico y cuántico del mundo material a pequeña escala, demostró que la velocidad de la luz introducía una relatividad en la visión del espacio de cada observador, y encontró por sí solo la teoría de la gravedad que sustituyó la imagen clásica creada por Isaac Newton más de dos siglos antes que él. Su famosa fórmula de E = mc2 es una fórmula milagrosa, es lo que los físicos definen como la auténtica belleza. Decir mucho con pocos signos y, desde luego, nunca ningún físico dijo tanto con tan poco. En esa reducida expresión de E = mc2, está contenido uno de los mensajes de mayor calado del universo: masa y energía, son la misma cosa.

Claro que, la maraña de misterios y profundos secretos que el niverso esconde son muchos, y, ni siquiera sabemos lo que, en realidad, significa alfa (α) esa constante que reconocemos cuando aparece el número 137. ¿Por qué alfa es igual a 1 partido por 137? Esperemos que algún día aparezca alguien que, con la intuición, el talento y el ingenio de Galileo, Newton o Einstein, nos pueda por fin aclarar el misterioso número y las verdades que encierra. Menos perturbador sería que la relación de todos estos importantes conceptos (e-, h y c) hubieran resultado ser 1 ó 3 o un múltiplo de pi… pero ¿137?

Arnold Sommerfeld percibió que la velocidad de los electrones en el átomo de hidrógeno es una fracción considerable de la velocidad de la luz, así que había que tratarlos conforme a la teoría de la relatividad. Vio que donde la teoría de Bohr predecía una órbita, la nueva teoría predecía dos muy próximas. Esto explica el desdoblamiento de las líneas. Al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). No prestéis atención a la ecuación. Lo interesante es esto: cuando se meten los números conocidos de la carga del electrón, e-, la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 número puro. Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

Las branas no son otra cosa que univeros paralelos, y el nuestro sería simplemente el eco de un golpe entre dos de ellos, una pequeña superposición de dos universos mucho mayores que han rasgado el espacio-tiempo y ha dado la posibilidad de que salga éste nuestro. Y, podrían existir megauniversos que, al interaccionar, crearían realidades como esta nuestra. Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundobrana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

Independientemente de cómo pudiera haber surgido nuestro Universo, lo que está claro es que, pensar siquiera en que, dependiendo de la región en la que nos encontremos, habrá distintos leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar como Einstein y creer que en cualquier parte del universo rigen las mismas leyes físicas, hasta que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sea cual fueren las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte de nuestro universo por muy remota que se encuentre; los elementos primordiales que lo formaron fueron siempre los mismos. Y, los sucesos acaecidos en el Universo, también han sido los mismos en cualquier lugar que podamos mirar.

Y, si todo eso es así (que lo es), no debemos extrañarnos de que, ¡la Vida! prolifere por esos mundos perdidos en sistemas planetarios remotos. No lo podemos saber pero, posiblemente, la vida presente en el Universo estará basada, como la nuestra, en el Carbono, es químicamente lo más probable. Sin embargo, la morfología de los seres que por ahí fuera puedan estar, será parecida y también muy diferente a la nuestras, hasta tal punto que, algunos/nas se asombrarían de encontrarse con ellas.

Quarks… Leptones… Hadrones… Materia… Que interaccionan con las cuatro fuerzas fundamentales naturales por todos los rincones del Universo para producir todos los objetos que podemos observar tanto aquí en el planeta Tierra, como en nuestro entorno del Sistema solar, o, en el más lejano y remoto confín del Universo que nos puede acercar los más modernos telescopios. Siempre se ve lo mismo: Galaxias, estrellas, Nebulosas y la formación de nuevos sistemas planetarios, que traeran nuevos mundos, y todo esos estarán acompañados de algunos objetos más exóticos y llamativos de propiedades increíbles.

Durante la década de 1.920, cuando Eddington empezó su búsqueda para explicar las constantes de la naturaleza, no se conocían bien las fuerzas débil y fuerte de la naturaleza. Las únicas constantes dimensionales de la física que sí se conocían e interpretaban con confianza eran las que definían la gravedad y las fuerzas electromagnéticas. Eddington las dispuso en tres puros números adimensionales. Utilizando los valores experimentales de la época, tomó la razón entre las masas del protón y del electrón:

mpr/me ≈ 1840

La inversa de la constante de estructura fina

2πhc/e2 ≈ 137

Y la razón entre la fuerza gravitatoria y la fuerza electromagnética entre un electrón y un protón,

e2/Gmpr me ≈ 1040

A estas añadió su número cosmológico, NEdd ≈ 1080. A estos cuatro números los llamó “las constantes últimas”, y la explicación de sus valores era el mayor desafío de la ciencia teórica: “¿Son estas cuatro constantes irreducibles, o una unificación posterior de la física que pueda demostrar que una o todas ellas podrían ser prescindibles? ¿Podrían haber sido diferentes de lo que realmente son?… Surge la pregunta de si las razones anteriores pueden ser asignadas arbitrariamente o si son inevitables. En el primer caso, sólo podemos aprender sus valores por medida; en el segundo caso es posible encontrarlos por la teoría… Creo que ahora domina ampliamente la opinión de que las (cuatro anteriores) constantes… no son arbitrarias, sino que finalmente se les encontrará una explicación teórica; aunque también he oído expresar lo contrario.”

Siguiendo con su especulación Eddington pensaba que el número de constantes inexplicadas era un indicio útil del hueco que había que cerrar antes de que se descubriese una teoría verdaderamente unificada de todas las fuerzas de la naturaleza. En cuanto a si esta teoría final contenía una constante o ninguna, tendríamos que esperar y ver: “Nuestro conocimiento actual de 4 constantes en lugar de 1 indica meramente la cantidad de unificación de teoría que aún queda por conseguir. Quizá resulte que la constante que permanezca no sea arbitraria, pero de eso no tengo conocimiento.” Eddington, como Max Planck, Einstein y Galileo, y Newton antes que ellos, era simplemente un adelantado a su tiempo; comprendía y veía cosas que sus coetáneos no podían percibir.

emilio silvera

Totales: 75.650.161

Totales: 75.650.161 Conectados: 45

Conectados: 45