Mar

13

¡Conocer la Naturaleza! No será nada fácil

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de . Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

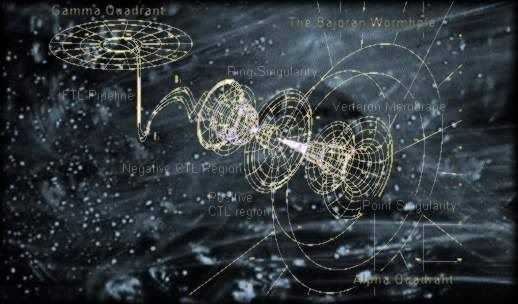

Por el , la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la de agujeros negros.

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad de Einstein? Afortunadamente, hay una respuesta y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el de constante de estructura fina”

Lederman

Este guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros!

emilio silvera

Mar

13

¡Marte! ¡Aún desata la imaginación de algunos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (1)

Comments (1)

El “Gran cañón” de Marte es mucho más largo y profundo que el del Colorado

Todos hemos visto, en más de una ocasión, del planeta Marte de regiones dispares y de variado contenido. Marte, el cuarto planeta desde el Sol, aparece marcadamente rojizo cuando se observa a simple vista. Tiene una delgada atmósfera compuesta (en volumen) por alrededor del 95% de dióxido de carbono, 2,7% de Nitrógeno, 1,6% de Argón, 0,1% de Oxígeno, 0,1% de monóxido de carbono y pequeñas trazas variables de vapor de agua. La presión atmosférica en la superficie es de unos 6 mbar. Las temperaturas superficiales pueden variar entre 0 y -125ºC, siendo la media de -50ºC. Es relativamente común la presencia de nubes blancas de vapor de agua condensada o de dióxido de carbono, particularmente cerca del terminador y en latitudes polares.

Existen dos casquetes de hielo de agua permanentes en los polos, que nunca se funden. En invierno éstos aumentan de tamaño al convertirse en casquetes de dióxido de carbono congelado hasta alcanzar los 60º de longitud. Ocurren esporádicamente tormentas de polvo que llegan a cubrir la totalidad del planeta con una neblina amarilla, oscureciendo los accidentes superficiales más .

Recientes de la NASA muestran engañosas “sombras de árboles” sobre la superficie de las dunas en Marte, que en realidad son caminos de arena, según publicaron numerosos periódicos británicos. Un vídeo circulante en Internet muestra imágenes de supuesta vida en Marte tras un retoque digital. Ver para creer.

La superficie de Marte es basalto volcánico con un alto contenido en hierro y, su oxidación, es la responsable de su color característico rojo oxido. El accidente oscuro más prominente, Syrtis Major, dirigida hacia el Este con una inclinación menor que 1º. Existen muchas áreas de dunas de arena rodeando las más grandes los casquetes polares y constituyendo los mayores de dunas del Sistema Solar.

Escenarios increíbles, tormentas de polvo, radiación y… ¡misterio!

En el pasado existió una intensa actividad volcánica en Marte. Tharsis Montes es la mayor región volcánica, estando Olympus Mons en el Noroeste, y la vasta estructura colapsada Alba Patera, en el Norte. Juntas, estas áreas volcánicas constituyen casi el 10% de la superficie del planeta. Hoy no hay volcanes activos en Marte, aunque en el pasado produjeron llanuras de lava que se extendieron cientos de kilómetros.

Hay distribuidos cráteres de impacto a lo largo de todo Marte, aunque existe una altiplanicie casi completamente cubierta de cráteres, similar a las altiplanicies de la Luna, que cubre casi la mitad de la superficie del , principalmente en el hemisferio Sur. Muchos de los cráteres de impacto más recientes, conocidos como cráteres de terraplén, tienen grandes pendientes en los bordes de su mantos de proyecciones, sugiriendo que la superficie estaba húmeda o llena de barro cuando se produjo el impacto.

Las cuencas de impacto más grandes mejor conservadas son Argyre y Hellas.

Esta es una de la parte de Marte con el Sino Sabaus y de Regio Deucalionis. El cráter a la derecha inferior es Flaugergues, y el doble cráter en la parte inferior izquierda es Wislicenus. Esta imagen fue tomada por el Mariner 6 en 1969. En esta imagen pueden encontrarse muchas características que sugieren ríos Marcianos, e incluso la salida de una llanura central. Se recomienda ver esta imagen en alta resolución. (Cortesía de la NASA/JPL)

(282K GIF)

Internamente, Marte probablemente tiene una litosfera de cientos de kilómetros de grosor, una astenosfera rocosa y un núcleo metálico de aproximadamente la mitad del diámetro del planeta. Marte no posee un magnético importante. Tiene dos pequeños satélites, Phobos y Deimos. Su diámetro ecuatorial es de 6 794 Km, su período de rotación axial (sidéreo) es de 24,623 horas, su densidad media es de 3,94 g/cm3, y, si consideramos que la masa de la = 1, la de Marte es de 0,11, el volumen de Tierra = 1, el de Marte = 0,15. La velocidad de escape es de 5,02 Km/s. Su distancia al Sol es de 1,524 UA.

Pero veamos otros aspectos del planeta Marte que, durante décadas impactó en la imaginación de hombres como Giovanni Virginio Schiaparelli, Percival Lowell y Willian Henry Pickering que, a finales del siglo XIX y principio del XX, insistían en despejar las dudas sobre si existían realmente los Canales que hiucieron famosos estos personajes de leyenda. Más tarde, hace veinticinco años algo curioso sucedió en las cercanías del planeta Marte. La nave Vikingo 1 de NASA se encontraba volando alrededor del planeta, tomando fotografías de posibles lugares para el aterrizaje de la nave hermana Vikingo 2, cuando descubrió, sobre la superficie, una figura en sombras muy semejante a una cara humana. Una cabeza enorme de unos tres kilómetros de extremo a extremo parecía estar devolviendo la mirada a la cámara desde una región del Planeta Rojo conocida como Cidonia.

Imagínense la sorpresa de los controladores de la misión en el Laboratorio de Propulsión a Chorro, cuando la cara apareció en sus consolas. Sin , la sorpresa duró poco tiempo. Los científicos fácilmente concluyeron que ésta era solo otra meseta Marciana, muy común en los alrededores de Cidonia, solo que esta tenía sombras extrañas que la hacían aparecer como un Faraón Egipcio.

Crédito: NASA.

Pero, amigos míos, la nave Mars Global Surveyor consiguió abrir a la ciencia un nuevo horizonte en Marte. De alguna forma, el hombre, debe abordar de nuevo desde el principio la de la vida en aquel planeta, lleno de secretos que sólo ahora empiezan a desvelarse después de más de un siglo de trepidantes debates entre astrónomos y aficionados.

La nave encontró inequívocos signos de la presencia de agua líquida en el planeta, algo que los científicos llevaban décadas tratando de confirmar. Es conocido que el agua líquida es el requisito para la vida tal como la conocemos nosotros, y si en el planeta rojo existe ese preciado elixir, como se ha podido comprobar mediante las investigaciones de la NASA, las posibilidades de que Marte sea un mundo vivo siguen plenamente vigentes.

Nombrar aquí a todos los personajes que, de una u otra manera, han intervenido en la esperanza de encontrar vida en el planeta hermano, sería algo tedioso, pero no puedo dejar atrás al astrónomo más destacado de la historia reciente, Carl Sagan fue quien mantuvo siempre la esperanza en un Marte vivo, aunque su muerte ni siquiera le concedió la de asistir a las siguientes misiones de la NASA en el planeta rojo, que en contraposición al balance de las Viking han permitido reabrir claramente las esperanzas de hallar vida allí, si no en el presente, tal vez si en el pasado.

El examen de las rocas marcianas realizado por la Mars Pathfinder y su juguetón todoterreno Sojourner confirmó lo que ya tenían claro muchos expertos: el agua había pasado por allí, probablemente hace muchos millones de años, tal como revelan las huellas dejadas por gigantescas corrientes en las zonas de aterrizaje.

Estudiando el terreno en muchas de las regiones del planeta, de manera clara y precisa, se puede comprobar la presencia de agua que, al parecer, brota desde el subsuelo. Es preciso no perder de el carácter altamente volcánico de Marte que, hace mucho tiempo tuvo una gran actividad de importantes erupciones y, la enorme cantidad de lava que corría por inmensas zonas del planeta, entre otras cosas, debieron oradar el terreno abriendo enormes galerias subterráneas que, en la actualidad, al estar situadas en las profundidades del planeta, deben tener una temperatura mayor que en la superficie, están resguardadas de la radiación, y, si el agua corre por allí, no sería nada extraña que, colonias de bacterias, hongos y líquenes estuvieran bien asentadas a ese nivel interior.

Tenemos que convenir que Marte, sigue siendo uno de los planetas más misteriosos del Sistema Solar, y, desde luego, es un buen aspirante para signos de vida presente, o, en último caso, del pasado. Nada puede negar la posibilidad de la existencia de agua líquida que pueda subsistir de forma permanente bajo la protección del suelo marciano, y si existen oasis en el subsuelo no puede descartarse en absoluto que Marte albergue sus propios ecosistemas subterráneos, lejos de la mortífera radiación ultravioleta que lelgan desde el Sol y de la que los seres vivos no pueden protegerse en la superficie al no haber una atmósfera lo suficientemente densa.

Cualquiera, hasta un profano, que observe algunas de las fotografías obtenidas en la sima Candor o de Ophir Chasma, ambas en Valles Marineris, tendrá ante sus ojos la prueba de que la historia de Marte no nos habla de un planeta estéril. Valles Marineris es, de hecho, el más entramado de cañones fluviales de todo el Sistema Solar, ya que tiene una longitud de 4.100 Km, una anchura aproximada a los 500 y puntos en los que la profundidad, alcanzan los 4 km. Aunque en sus agrestes formas parecen haber intervenido los movimientos internos de la corteza marciana, se da por hecho que fue el agua el principal agente que modeló lo que podríamos considerar como uno de los más bellos y extensos “parques naturales” de todo el Sistema Solar.

A mí, todos estos escenarios me hacen imaginar…¡tantas !

Está claro que, hoy en día sabemos de los océanos y mares que, hace millones de años adornaban el planeta Marte, y, sus de hoy, claramente nos hablan de las correntías de cantarinos torrentes fluviales que, corriente abajo, oradaban las superficie del planeta dejando la huella de su presencia allí.

Valles Marineris y otros lugares del planeta tienen las pruebas de lo que Marte, en epasado fue. Puede ser que Lowell se equivocara sobre la existencia de unos canales construídos por la mano de seres inteligentes en aquel planeta. Él concibió “los canales” como obras de ingenieria de una civilización inteligente para transportar el agua, pero quizá no lo estuviera en lo más , es decir, en su convicción sobre la existencia de vida en Marte. Es algo que no sabemos aún pero que, probablemente, no tardaremos mucho en saber.

Una fotografía de la sonda Explorer Spirit, misión de la Nasa que está en Marte, reveló una extraña figura humanoide en medio del terreno rojizo del planeta, que los científicos intentan explicar. Una foto sorprendente de la Nasa, perteneciente a su misión de la Mars Explorer Spirit, causó conmoción al revelar una figura inequívocamente humanoide caminando cerca de una rocosa del planeta. Según los escépticos, se trata de una caprichosa formación de las rocas, pero de todos modos la fotografía no deja de asustar y, de camino, despierta la imaginación de lo que podría ser.

De Marte, el planeta misterioso que sueños y pensamientos pudo en nuestras jóvenes mentes, es el enigma que todos queremos desvelar. Si cerramos los ojos y nos imaginamos aquel planeta con océanos, mares, ríos y lagos que, con sus altos volcanes (uno de ellos tiene la friolera de más de 20 Km de altura) y sus bellos paisajes, con una atmósfera como la de la Tierra, en verdad, sería un planeta digno de ser visitado, o, ¿por qué no? para asentar allí la residencia.

¿Qué, el a Marte os haya gustado?

emilio silvera

Mar

13

Rumores del saber del Mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

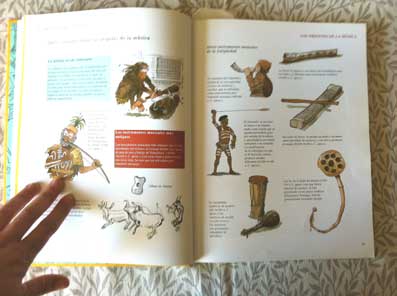

Aproximadamente entre 1.580 y 1.589, algunos caballeros empezaron a reunirse de forma regular en casa del conde dei Bardi en Florencia. Este grupo, conocido como la camerana estaba compuesto por el célebre flautista Vincenzo Galilei (padre del astrónomo Galileo Galilei), Jacobo Peri y Giulio Caccini, también músicos, a los que se sumaba el Poeta Octavio Rinuccini.

Durante el de sus conversaciones, principalmente dedicadas al teatro clásico, surgió la idea de que las obras clásicas podían notarse “de forma declamatoria”. Fue así como más adelante nacería la opera. En términos muy amplios, podemos afirmar que en el largo siglo que va de 1.470 a 1.590 aparecen los principales elementos de la música moderna en un proceso análogo al que se observa en la pintura.

Los desarrollos en este pueden dividirse en tres grupos:

En primer lugar, se dieron una serie de avances técnicos, tanto para instrumentos como para voces, que permitieron la evolución de los tipos de sonido que escuchamos hoy.

En segundo lugar, se desarrollaron diversos géneros musicales, lo que condujo a la forma de la música tal y como la conocemos en la actualidad.

Y, en tercer lugar, tenemos el surgimiento de los primeros compositores de música moderan, los primeros músicos famosos cuyos nombres recordamos.

Jean Ockeghem

Entre los avances técnicos, podemos señalar para el principio de “imitación”, una innovación de la escuela de música flamenca, cuyos principales representantes fuera Jean Ockeghem (c. 1430-1.495) y Jacob Obrecht (c. 1430-1505). Sin embargo, durante el siglo XV y buena parte del XVI, la música flamenca fue ganando prestigio no sólo en Europa septentrional sino también en Italia.

En la corte en Roma, en la Catedral de San Marcos en Venecia, en Florencia y en Milán, los músicos flamencos eran los más solicitados. En este contexto, el término “imitación” designa la costumbre de que en una obra polifónica las voces no canten juntas sino una después de otra, cada una repitiendo lo dicho por la anterior. Este recurso tenía un gran poder expresivo y se ha mantenido vigente hasta el día de hoy en todos los géneros musicales.

Por la misma época, se introdujeron las masas corales que reunían gran cantidad de voces. En partículas el coro papal adquirió mucha importancia, si bien fue en Venecia donde el flamenco Willaert (c. 1.480-1.562) introdujo el coro doble, en el que dos cuerpos cocales se yuxta ponían continuamente uno a , algo que tenía una fuerza dramática aún mayor.

También fue en Venecia donde se dieron los primeros pasos hacia la orquestación, la idea de designar instrumentos específicos para cada parte de la composición. Esto se relaciona con el hecho de que fue también en esta ciudad donde se inició la impresión de partituras hacia 1.501, con lo que los intérpretes pudieron llevar las ideas musicales “no en la cabeza, sino en su equipaje”.

Venecia dos músicos extraordinarios:

Andrea Gabriela y su sobrino Giovanni. Fueron ellos quienes perfeccionaron el equilibrio de los coros, con grupos de instrumentos de cuerda y de viento, en galerías corales opuestas que hacían avanzar y retroceder la melodía y que tenían por dos grandes órganos.

Yehudi Menuhin considera que este momento de la música “marca el auténtico comienzo de la música instrumental independiente” y, en particular, de un elemento que sería de vital importancia a lo largo de la era moderna: la disonancia suspendida.

Esta disonancia, planeada de forma deliberada, llama la atención sobre sí y exige ser resuelta (al menos hasta Schönberg, en 1.907), lo que subrayó el carácter emocional de la música y propició el desarrollo de la técnica de la modulación, el libre movimiento de un tono a otro sin el cual había sido imposible el movimiento romántico en la música.

Los siglos XV y XVI también fueron testigos del aumento del de instrumentos disponibles y, en un sentido rudimentario, de los comienzos de la orquesta. Inicialmente, tuvo una gran importancia la difusión del arco desde Asia, a través del Islam y Bizancio, donde hacia el siglo X el Rabat y la luna se tocaban con arcos de una o dos cuerdas.

En Europa, el arco musical, descendiente directo del arco de caza, apareció primero en España y Sicilia, pero se difundió con rapidez hacia el norte del continente. el sonido producido al puntear las cuerdas se desvanecía con rapidez, se descubrió que las notas emitidas por las cuerdas al vibrar podían prolongarse mucho tiempo frotando un arco sobre ellas.

El segundo acontecimiento decisivo para la evolución de la música occidental fueron las cruzadas de los siglos XII y XIII. Los nuevos instrumentos encontrados en Oriente Próximo se difundieron velozmente, en particular el antecesor del violín, que aparece por primera vez en ilustraciones bizantinas del siglo XI, cuando tenía muchas formas diferentes (ovalada, elíptica, rectangular) y ya contaba con una parte estrecha para permitir que los movimientos del arco fueran más flexibles.

Otros instrumentos eran el rebec y el gittern, precursora de la guitarra, un enorme instrumento hecho a partir de un de madera sólida.

Los instrumentos de cuerda provistos de teclado aparecen inicialmente en la primera mitad del siglo XV, quizá como desarrollo de un instrumento misterioso, el checker, del que no se conserva ningún ejemplar, por lo que solo lo conocemos a través de ilustraciones. También existía un primitivo clavicordio, denominado monocordio (quizá inventado por Pitágoras), y un antiguo clavicémbalo, un instrumento alargado, a partir del cual evolucionaron la espineta y el virginal, de tamaño más pequeño.

Para el siglo XVI el laúd, la guitarra, la viola y el violín, se habían hecho muy populares a medida que se difundía el gusto por la música cromática. Carlos IX, rey de Francia entre 1.560 y 1.574, ordenó la construcción de treinta y instrumentos a Andrea Amati, el famoso fabricante de Cremona, y especificó que doce debían ser violines grandes, doce violines pequeños, seis violas y ocho bajos.

Entre los instrumentos de viento, el se había utilizado desde la época de los romanos, si bien desde el siglo X en adelante había pasado a ser instrumento exclusivo de la Iglesia.

En este la importación más significativa de Oriente fue la bombarda, que deriva de la surna persa, un instrumento de doble lengüeta con agujeros para los dedos y pabellón amplio. El oboe moderno probablemente fue inventado a mediados del siglo XVII por un miembro de la familia Hotteterre, y se introdujo en la corte francesa. Se consideraba un complemento de los violes, aunque también contribuía al continuo.

Entre las diversas formas musicales surgidas desde el siglo XI destacar el madrigal, la sonata, las formas corales, el concierto, el oratorio y la ópera.

Con la maduración del madrigal, el liderazgo musical pasó de los flamencos a los italianos, y en particular a Roma y Venecia, si bien no se debe olvidar la contribución de los franceses al crear la chanson, conocida en otros lugares como canzon francese. La chanson era una forma despreocupada y alegre, que con frecuencia proponía “cancioncillas de amor” sentimentales y nostálgicas, según las palabras de Alfred Einstein, en las que la voz pretendía imitar el canto de las aves, y partir de ella surgiría finalmente la sonata.

Los principales exponentes del madrigal y de la chanson/ fueron Giovanni Pierluigi da Palestrina (1.525-1.594) y Orlando di Lasso (1.532-1.594). En Roma, Palestrina fue maestro di capella de la iglesia de San Pedro desde 1.571. Compuso noventa y cuatro misas y ciento cuarenta madrigales. Fundamentalmente fue un compositor religioso.

Orlando di Lasso.

Lasso, por su parte, fue un maestro del madrigal y del motete, que celebró en sus obras el amor en esta vida y esta tierra. La del estilo y la excelencia instrumental condujo en su momento a la aparición del virtuoso, particularmente en los teclados y las maderas. En ello también observamos un proceso similar al que tuvo lugar en la pintura: el surgimiento del músico como artista respetado por derecho propio.

Al evolucionar, la canzon francese se dividió en dos tipos: la sonata para instrumentos de viento y la canzona para los de cuerda. Mientras la primera daría lugar al concierto (y más tarde a la sinfonía), la segunda evolucionaría en la sonata de cámara. Los humanistas que en Florencia dieron origen a la ópera estaban convencidos de que la primera función de la música era intensificar el impacto emocional de la hablada. Inicialmente, el nuevo discurso musical se denominó recitativo: el texto se recitaba o declamaba sobre un fondo musical compuesto principalmente por una serie de acordes con disonancias ocasionales con que producir efectos dramáticos. No obstante, desde el principio existió una estructura armónica, lo que se denomina música “vertical” en oposición a la meramente “horizontal”.

El primer gran compositor de óperas fue Claudio Monteverdi (1.567-1.643). Su Orfeo, escrito para violas y violines y estrenado en Mantua en 1.607, supuso un significativo avance respecto de las óperas presentadas antes en Florencia. Aunque Monteverdi poseía un don original para la armonía que le permitió introducir también algunas disonancias andaces, la característica de su música es s gran calidad expresiva, como por ejemplo, Ariadna, o su famoso Lamento de Ariadna, la primera aria o perística que se convirtió en canción popular y fue “tatareada y silbada por toda Italia”

De aquel fenómeno musical surgieron grandes teatros de ópera en toda Europa, si bien hasta 1.637 estos fueron lugares privados, dominio exclusivo de la nobleza. Sólo después de esa fecha encontramos, de nuevo en Venecia, asistentes a la ópera que pagan por su asistencia a las salas. En el siglo XVII la ciudad contaba con dieciséis teatros de ópera, cuatro de los cuales abrían todas las noches.

Dejaré aquí esta pequeña que se ocupa de la música en varias vertientes y que ha sido una variante para exponer otra parte (otro rumor), del saber que forma el conocimiento de la Humanidad.

Ciertamente amigos, hay un lugar y un momento para cada cosa. Ahora insertamos aquí una breve historia sobre temas de la música y, de la misma manera, en otro culquier momento y dependiendo del estado de ánimo, podría pasar, por ejemplo, con esas ecuaciones en las que mucha gente ven la identidad de Eular y, aunque para algunos pueda parecer frío y sin mucho sentido, para otros pueden llevar ese inmenso mensaje que enaltece el intelecto y podrán encontrar en ellas la y, el poderlas comprender y poder pensar en todo la grandeza del mensaje, poder transmutarse hacia fantásticas situaciones de actividades placenteras.

Identidad de Euler. ¿? ¡Ya lo creo que sí!

¡Son tántas las cosas que nos eleva! Dicen que la música amansa a las fieras y, desde luego, es un dicho bastante cercano -aunque en forma de metáfora- a la verdad, la música cambia y enaltece el espíritu, te transporta a otros mundos sin salir de este. De la misma manera, otras actividades y saberes de la Humanidad nos pueden elevar hasta niveles de comprensión de la Naturaleza que, de otra manera, nunca jamás habríamos pensado que fuera posible y, las matemáticas, son la llave de ese otro mundo mágico.

La fórmula que arriba vemos es de L. Euler, un matemático al que hay que hacerle un apartado especial. Siendo un caso especial de la fórmula (cuando  =

=  ), lo que se conoce como la identidad de Euler:

), lo que se conoce como la identidad de Euler:

Esta fórmula fue calificada por Richard Feynman como «la fórmula más reseñable en matemáticas», porque relaciona las principales operaciones algebraicas con las importantes constantes 0, 1,  ,

,  y π, mediante la relación binaria más importante. En 1988, los lectores de la revista especializada Mathematical Inteligencer votaron la fórmula como «la más bella fórmula matemática de la historia».En total, Euler fue el responsable del descubrimiento de tres de las cinco primeras fórmulas del resultado de la encuesta.

y π, mediante la relación binaria más importante. En 1988, los lectores de la revista especializada Mathematical Inteligencer votaron la fórmula como «la más bella fórmula matemática de la historia».En total, Euler fue el responsable del descubrimiento de tres de las cinco primeras fórmulas del resultado de la encuesta.

Música y Matemáticas, de alguna manera, están relacionadas y ambas tienen ese algo mágico que no por abstractas y complejas nos deja de fascinar. Tanto la una como la otra parecen que no son de este mundo pero, lo cierto es que tienen un poder innegable en este mundo nuestro cuando están presentes en nuestras mentes que se ven transportadas a ese “otro universo fascinante” donde lo inmaterial nos habla de lo material. ¿Cómo es posible que unos sonidos bien atemperados que forman una agradable melodía tenga tánta influencia en nosotros? ¿Qué tienen las matemáticas que hacen posible expresar con ellas la propia Naturaleza? Como decía el experto: “Una parte de las matemáticas estudia los números, sus patrones y formas y estos elementos son inherentes a la ciencia, la composición y la ejecución de la música.”

Se le adjudica a Pitágoras el descubrimiento de las leyes de los intervalos musicales regulares, es decir, las relaciones aritméticas de la escala musical. Diógenes Laercio le atribuye la invención del monocordio, un instrumento musical de una sola cuerda. Ilustra la ley según la cual «la altura del sonido es inversamente proporcional a la longitud de la cuerda». Los principios de la música fueron sin duda tan importantes para el sistema pitagórico como los principios matemáticos mismos, o las nociones sobre «números». La expresión de la Naturaleza en términos matemáticos -como las proporciones y las razones- es una idea clave dentro de la filosofía desarrollada por los pitagóricos. «Estos filósofos notaron que todos los modos de la armonía musical y las relaciones que la componen se resuelven con números proporcionales».

La afinación pitagórica es una gama musical construida sobre intervalos de quintas perfectas de razón 3/2. Las frecuencias pitagóricas de la nota «Do» son las siguientes: 1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048…

Para los pitagóricos la música poseía además un valor ético y medicinal, «[Pitágoras] hacía comenzar la educación por la música, por medio de ciertas melodías y ritmos, gracias a los cuales sanaba los rasgos de carácter y las pasiones de los hombres, atraía la armonía entre las facultades del alma». La idea del orden y de que las relaciones de armonía regulan incluso todo el universo, se encuentran presentes en todo el sistema pitagórico. La armonía del cuerpo y la armonía del cosmos eran vistas por igual, dentro de un sistema unificador. Platón dirá que música y astronomía son «ciencias hermanas» (cf. «la música planetaria» o “armonía de las esferass).

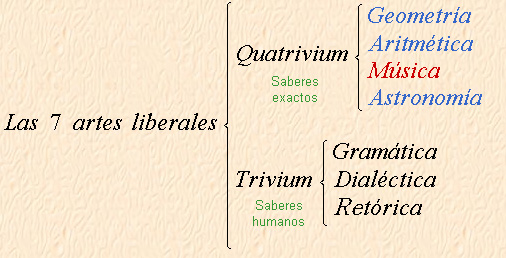

Las siete artes las dividían en “saberes exactos” (Quatrivium o Matemáticas) y “saberes humanos” (Trivium).

Cuando damos un repaso a los hechos del pasado y contemplamos admirados el discurrir de la mente humana en múltiples campos que hoy, hemos centrado -muy de pasada- en la música y las matemáticas que tienen una cierta relación innegable, nos damos cuenta de que hay algo más allá de lo simplemente material. ¿Cómo podríamos explicar la grandeza de la Música y de las matemáticas?

Me gustaría poder pero… ¡Mi pobre intelecto no me deja!

emilio silvera

Mar

13

Desde el pasado, pasando por el presente y… ¡Hacia el futuro!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (0)

Comments (0)

![[IMG]](http://static.hsw.com.br/gif/synchrotron-1.jpg)

Imagem cedida por Diamond Light Source

Acelerador de partículas construido en las instalaciones del Diamond Ligth Source en Oxfordshire (Inglaterra). Llamado la Fuente luminosa de diamante, el Diamond synchrotron comenzó a funcionar en enero de 2007. La luz que generar este artefacto es 100 mil millones de veces más brillante que un rayo X estándar médico.

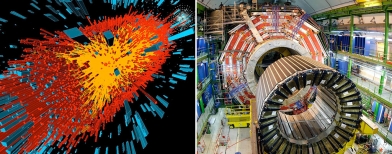

Un acelerador de partículas (como todos sabemos) es, a grandes rasgos, una máquina que mediante campos electromagnéticos acelera partículas hasta que alcanzan velocidades inimaginables. Luego, por ejemplo, hacen chocar estas partículas y así se consigue saber de qué está formada la materia en sus partes más diminutas (mucho más diminutas que un átomo). Eso es lo que hace el LHC.

Sin embargo, en el caso de este acelerador, los científicos esperaban usar la luz del Diamond synchrotron “leer” los textos antiguos que han sufrido el daño significativo. Porque los potentes rayos X permitirán hacerlo sin ni siquiera abrir el libro. El synchrotron emite un rayo X tan poderoso que, al incidir en una voluta, permite producir una imagen de 3-D del texto.

La técnica ya había sido aplicada satisfactoriamente en textos escritos con la tinta de hierro, que los escribanos comenzaron a usar en el siglo XII. Algunas de las tintas hechas con extractos vegetales y sales de hierro utilizadas en el Siglo XII deterioran el de pergamino utilizado, imposibilitando la lectura de documentos valiosos. Simplemente he querido incluir esta introducción para que os hagais una idea de hasta donde puede llegar nuestro ingenio.

(ilustración de un nano robot)

Si hablamos de nuevos inventos en los campos más diversos, nos podríamos sorprender de lo que se ha conseguido en los últimos años que, una “mano robótica” capaz de realizar toda clase de movimientos, “El sexto sentido”, una interfaz gestual portable que permite la interacción los gestos y los movimientos naturales del cuerpo humano con una computadora, o, un Implantes de retina, que devuelve la visión a pacientes con degeneración macular y ceguera mediante implantes microelectrónicos. Entre los últimos inventos dedestaca una variedad de plástico hecha con orina de cerdo y lentes de biónicos. Se inventa un proceso capaz de cultivar parte de un corazón humano a partir de células madre, una máquina que puede imprimir una novela completa de 300 páginas en tan solo 3 minutos y por un costo ínfimo, una batería que funciona con cualquier solución azucarada y enzimas de digestión de glucosa capaz de extraer electrones que crean electricidad…

Las nuevas tecnologías y los inventos que se están produciendo en el diglo XXI, harían abrir la boca por el asombro a los filósofos naturalistas del pasado que trataban de profundizar en el conocimiento de la Naturaleza. Ellos fueron los que pusieron las primeras piedras del Edificio que hoy, llamamos Ciencia.

Corazones e Hígados artificiales, el guante de braille ciegos, o, yendo más allá…

Un “Diente telefónico”. Se trata de un minúsculo implante que se coloca en el diente molar y que mediante un complejo sistema de señales y vibraciones permite recibir llamadas telefónicas. Tejido artificial nanotecnológico, Parche hormonal anticonceptivo, o, esa invención que hace posible que con una pequeña gota nos permite si en una bebida se ha vertido alguna de las llamadas “drogas del depredador” como las GHB o la Ketamina. Estas drogas suelen utilizarse por violadores y secuestradores pues facilitan dicho crimen al desinhibir a la víctima. El “Motor a nanoescala”, lo suficientemente pequeño como para viajar en la espalda de un virus. Un dispositivo que administra medicamentos a través de ondas sonoras que sustituyen las inyecciones, siendo igual de efectivas. Plástico inteligente capaz de modificar su estructura ante la exposición de determinadas longitudes de onda. Un dispositivo móvil creado por Aqua Sciences que permite beber agua del aire. ¿Os imaginais lo que supondrá eso en la travesía de un desierto? INSCENTINEL inventa un sistema de entrenamiento que abejas sean capaces de detectar bombas y explosivos.

Las cosas no llegaron por arte de magia… ¡muchas ideas hicieron falta!

miramos a nuestro alrededor y todo lo que vemos que ocurre nos parece lo normal, que las cosas son así. Sin embargo, habría que pensar -por ejemplo, en el ámbito de la física de partículas- que, el diluvio de estructuras subnucleares que desencadenó “el acelerador” de partículas, fue tan sorprende los objetos celestes que descubrió el telescopio de Galileo. Lo mismo que pasó con la revolución galileana, con la venida de los aceleradores de partículas, la Humanidad adquirió unos conocimientos nuevos e insospechados acerca de cómo era el mundo, la naturaleza de la materia.

Que en caso de los aceleradores se refería al “espacio interior” en lugar de al “espacio exterior” no los hacía menos profundos ni menos importantes. El descubrimiento de los microbios y del universo biológico invisible por Pasteur fue un descubrimiento similar y, ya puestos, haremos notar que pocos se acuerdan ya de Demócrito, aquel filósofo sontiente que, tomó prestado de los antiguos hindúes, la idea del á-tomo, la expresión “más pequeña de la materia” que era “indivisible”.

sabemos que Demócrito estaba equivocado y que el átomo, sí se puede dividir. Sin embargo, él señaló un camino y, junto a Empédocles, el que hablaba de “elementos” como agua, aire, fuego y tierra, para significar que eran los componentes, en la debida proporción de todo lo que existía…, junto a otros muchos, nos han traído hasta aquí. Así que, los inventos que antes se mencionaban, no han llegado porque sí, ha sido un largo camino, mucha curiosidad y mucho y, no lo olvidemos: ¡Observar, Imaginar y Experimentar!

Nos dimos y estaba claro que la búsqueda de la menor de las partículas requería que se expandiese la capacidad del ojo humano: primero lupas, después microscopios y, finalmente… ¡Aceleradores! que, utilizando energías inimaginables ( 14 TeV), nos llevaría hasta las entrañas de la materia que tratamos de conocer.

Todos estos experimentos en los aceleradores han posibilitado muchos de los avances que hoy día conocemos en los distintos campos del saber humano. Generalmente, cuando se habla de aceleradores de partículas, todos piensan en el Bosón de Higgs y cosas por el estilo. Sin embargo, las realidades prácticas de dichos ingenios van mucho más allá.

“La “gran ciencia” (big science) genera tecnología, tecnología punta, genera industria, mucha industria, genera riqueza. Los grandes aceleradores de partículas, como el LHC del CERN, son ejemplos perfectos de ello. La tecnología de aceleradores de partículas ha permitido desarrollar dispositivos de implantación iónica que se utilizan para la fabricación de mejores semiconductores, para la fabricación prótesis de rodilla más duraderas, para la fabricación de menos contaminantes, para el desarrollo de nuevas terapias contra el cáncer. Esto último gracias a que lo último de lo último en superimanes superconductores está en los grandes aceleradores. Esta tecnología ha permitido desarrollar y permitirá mejorar los potentes imanes necesarios en el diagnóstico clínico (como en resonancia magnética nuclear) y para terapias contra el cáncer basadas en haces de protones. Nos lo Elizabeth Clements, en “Particle physics benefits: Adding it up,” Symmetry, dec. 2008″ (Francis (th)E mule Science’s News).

Beneficios de la investigación básica en Física de Partículas: La tecnología desarrollada en los aceleradores de partículas tiene beneficios indirectos para la Medicina, la Informática, la industria o el . Los imanes superconductores que se usan para acelerar las partículas han sido fundamentales para desarrollar técnicas de diagnóstico por imagen como la resonancia magnética. Los detectores usados para identificar las partículas son la base de los PET, la tomografía por emisión de positrones (antipartícula del electrón). Y muchos hospitales utilizan haces de partículas terapia contra el cáncer.

Con velocidades 10.000 mayor que una conexión típica, “The Grid” podrá enviar un catálogo completo de información Gran Bretaña a Japón en menos de 2 segundos. Esta red, creada en el centro de física de partículas CERN, puede proveer el poder necesario para transmitir imágenes holográficas; permitir juegos en línea con cientos de miles de personas, y ofrecer una telefonía de alta definición en video al precio de una llamada local

Así, la World Wide Web (WWW), el ‘lenguaje’ en el que se basa Internet, fue creado en el CERN para compartir información entre científicos ubicados alrededor del mundo, y las grandes cantidades de que se producen motivan el desarrollo de una red de computación global distribuida llamada GRID. Los haces de partículas producidos en aceleradores tipo sincrotrón o las fuentes de espalación de neutrones, instrumentos creados para comprobar la naturaleza de la materia, tienen aplicaciones industriales en la determinación de las propiedades de nuevos materiales, así como para caracterizar estructuras biológicas o nuevos fármacos. Otras aplicaciones de la Física de Partículas son la fabricación de , esterilización de recipientes para alimentos o reutilización de residuos nucleares, entre otros muchos campos.

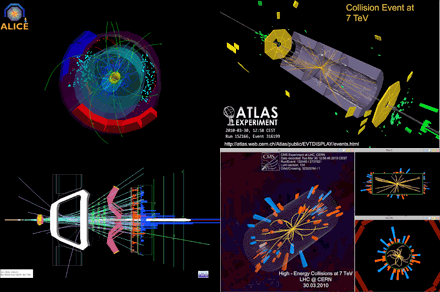

Tambien en el campo de la Astronomía, el LHC, nos ayudar a comprender cosas que ignoramos. Nos henmos preguntado sobre la existencia de estrellas de Quarks-Gluones, y, sobre el tema, algo nos ha dicho ya el Acelerador Europeo de Partículas que trata de llegar hasta “la materia oscura” y algunos otros enigmas que nos traen de cabeza.

No es extraño encontrarnos una mañana al echar una mirada a la prensa del día, con noticias como éstas:

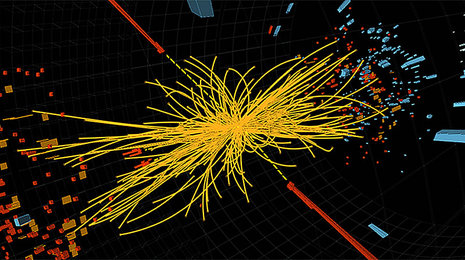

Colisión de iones pesados registrada por el experimento ALICE. (Imagen: CERN.)

El acelerador europeo ha obtenido plasma de quarks–gluones, el primer estado de la materia tras el Big Bang.

“No todo son bosones de Higgs en las instalaciones del CERN. Aún hay muchas preguntas sobre el universo y sus partículas que se pueden responder a de colisiones de alta energía. Y en eso, elLHC es el mejor. Un grupo de investigadores del consorcio europeo ha realizado nuevas mediciones de la que creen que es el primer tipo de materia que hubo durante los instantes iniciales del universo. El plasma de quarks–gluones.

Los quarks y los gluones son, respectivamente, los ladrillos y el cemento de la materia ordinaria. Durante los primeros momentos tras el Big Bang, sin embargo, no estaban unidos constituyendo partículas —como protones o neutrones— sino que se movían libremente en estado de plasma. A base de colisionar iones de plomo —que es un átomo muy pesado— a velocidades cercanas a las de la luz, el LHC pudo recrear durante pequeños lapsos de tiempo las que se creen fueron las de los primeros momentos del universo.

El plasma de quarks–gluones es extremo y efímero. Por eso los investigadores han tenido que analizar los de más de mil millones de colisiones para obtener resultados significativos.”

Evento de colisión de 7 TeV visto por el detector LHCb. El experimento del LHCb en el LHC estará bien ubicado para explorar el misterio de la antimateria. Crédito: LHC, CERN. Ya sabéis que, durante muchos años, la ausencia de antimateria en el Universo ha atormentado a los físicos de partículas y a los cosmólogos: mientras que el Big Bang debería haber cantidades iguales de materia y antimateria, no observamos ninguna antimateria primordial hoy en día. ¿Dónde ha ido? Los experimentos del LHC tienen el potencial de dar a conocer los procesos naturales que podrían ser la clave para resolver esta paradoja.

Cada vez que la materia es creada a partir de energía pura, se genera la misma cantidad de partículas y antipartículas. Por el contrario, cuando la materia y la antimateria se encuentran, se aniquilan mutuamente y producen luz. La antimateria se produce habitualmente cuando los rayos cósmicos chocan contra la atmósfera de la Tierra, y la aniquilación de materia y antimateria se observa durante los experimentos de física en los aceleradores de partículas.

Equipos de físicos en todo el mundo siguen analizando . Aquellas primeras colisiones de protones a la alta energía prevista de 7 Teraelectronvoltios (TeV), una potencia jamás alcanzada en ningún acelerador antes, nos puede traer noticias largamente esperadas y desvelar misterios, contestar a preguntas planteadas y, en definitiva, decirnos cómo es la Naturaleza allí, donde el ojo humano no puede llegar pero, si la inteligencia.

Lo cierto es que, todos tenemos que convenir en el hecho cierto de que, el LHC es el mayor experimento físico de la historia de la Ciencia y que, de seguro, nos dará la de comprender muchas cuestiones que antes se nos aparecían oscuras e indistinguibles entre la bruma de esa lejanía infinitesimal de la cuántica. Ahora, tenemos una herramienta capaz de llevarnos hasta aquellos primeros momentos en los que se construyó la historia del universo y, si podemos, de esta manera “estar allí”, veremos, con nuestros propios ojos lo que pasó y por qué pasó de esa manera.

Toda esta larga exposición de temas, de alguna manerta conectados, viene al caso para dejar claro que, aquellos detractores del LHC, no llevaban la razón y, sus protestas no tenían un científico. El Acelerador de Partículas que llamamos abreviadamente LHC, nos ha dado y nos seguirá dando, muchos beneficios para toda la Humanidad.

emilio silvera

Totales: 75.597.929

Totales: 75.597.929 Conectados: 54

Conectados: 54