Mar

14

No siempre hablamos de lo que comprendemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

¡La Física! Lo que busca la física fundamental es reducir las leyes de la naturaleza a una teoría final sencilla que lo explique todo. El físico y premio Nobel Steven Weinberg señala que las reglas fundamentales son lo más satisfactorio (al menos él). Las leyes básicas de Isaac Newton, que predicen el comportamiento de los planetas, son más satisfactorias, por ejemplo, que un almanaque en el que se indique la posición de todos los planetas en cada . Weinberg nos dice que la Física no puede explicarlo todo, matizando que sólo puede explicar los sucesos relacionándolos con otros sucesos y con las reglas existentes.

Por ejemplo, las órbitas de los planetas son el resultado de unas reglas, pero las distancias de los planetas al Sol son accidentales, y no son consecuencia de ley fundamental alguna. Claro que, las leyes podrían ser fruto de casualidades. Lo que sí es cierto es que los físicos están más interesados por descubrir las reglas que por los sucesos que dichas reglas determinan, y más por los hechos que son independientes del tiempo; por ejemplo, les interesa más la masa del electrón que un tornado que se pueda producir en un lugar determinado.

La ciencia, como nos dice Weinberg, no puede explicarlo todo y, sin embargo, algunos físicos tienen la sensación de que nos estamos acercando a “una explicación del mundo” y, algún día, aunando todos los esfuerzos de muchos, las ideas de las mejores mentes que han sido, y las nuevas que llegarán, podremos, al fín, construir esa Teoría final tan largamente soñada que, para que sea convincente, deberá también, incluirnos a nosotros. Pero, paradógicamente y a pesar de estos pensamientos, existen hechos que los contradicen, por ejemplo, conocemos toda la física fundamental de la molécula de agua desde hace 7 decenas de años, pero todavía no hay nadie que pueda explicar por qué el agua hierve a los 100 ºC. ¿Qué ocurre? ¿Somos acaso demasiado tontos? Bueno, me atrevería a pronosticar que seguiremos siendo “demasiado tontos” incluso los físicos consigan (por fin) esa teoría final que nos pueda dar una “explicación del mundo”. Siempre seguiremos siendo aprendices de la naturaleza que, sabia ella, nos esconde sus secretos para que persista el misterio.

¿Qué sería de nosotros si lo supiéramos todo?

La explicación que dan los físicos actualmente sobre la subestructura de la materia se llama “el modelo estándar”. En este modelo están incluídas las doce partículas elementales y las tres fuerzas que, cuando se mezclan y se encajan, sirven para construir todo lo que hay en el universo, desde un redondo pan de pueblo hecho en un horno de leña, hasta las más complejas galaxias, y puede explicar todos los mecanismos de acción, es decir, la mecánica del mundo.

Entre las partículas figuran los seis Quarks famosos: arriba, abajo, extraño, encanto, fondo y . Las otras seis partículas son Leptones: el electrón y sus dos parientes más pesados, el muón y el tau y los tres neutrinos a ellos asociados. Las tres fuerzas son la electromagnética, la fuerza nuclear fuerte (que mantiene unidos a los quarks) y la fuerza nuclear débil (responsable de la radioactividasd). Hay una cuarta fuerza: la Gravedad que, aunque tan importante como las demás, nadie ha sabido como encajarla en el modelo estándar. Todas las partículas y fuerzas de este modelo son cuánticas; es decir, siguen las reglas de la mecánica cuántica. Aún no existe una teoría de la gravedad cuántica.

En realidad, la región que denominamos Gravedad cuántica nos lleva y comprende preguntas sobre el origen del universo observable que nadie ha sabido contestar. Nos lleva a complejos procesos cuánticos situados en las épocas más cercanas imaginables en un espacio-tiempo clásico, es decir, en lo que se conoce como Tiempo de Planck a 10-43 segundos del supuesto big bang, cuando reinaba una temperatura del orden de 10 x 1031 K. Pero, como hemos dicho, al no existir una teoría autoconsistente de la Gravedad cuántica, lo único que podemos hacer (como en tantas otras áreas de la Ciencia) es especular.

El Modelo Estándar no es, ni mucho , satisfactorio. Los científicos piensan que no sólo es incompleto, sino que es demasiado complicado y, desde hace mucho tiempo, buscan, incansables, otro modelo más sencillo y completo que explique mejor las cosas y que, además, no tenga (como tiene el modelo actual) una veintena de parámetros aleatorios y necesarios para que cuadren las cuentas…, un ejemplo: el bosón de Higgs necesario para dar masa a las partículas.

¡La masa! ese gran problema. Todas las partículas masa diferentes pero nadie sabe de donde salen sus valores. No existe fórmula alguna que diga, por ejemplo, que el quark extraño debería pesar el (o lo que sea) del quark arriba, o que el electrón deba tener 1/200 (u otra proporción) de la masa del muón. Las masas son de todo tipo y es preciso “ponerlas a mano”, como se suele decir: cada una ha de ser medida experimental e individualmente. En realidad, ¿por qué han de tener masa las partículas? ¿de dónde viene la masa?

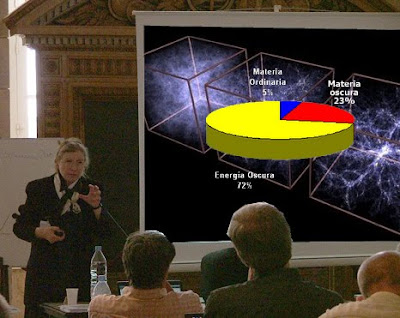

No puedo evitarlo ni tampoco me puedo quedar callado, he asistido a alguna conferencia sobre la materia y, el ponente de turno se agarra a la “materia oscura” para justificar lo que no sabe, si al final hay debate, entro en escena para discutir sobre la existencia de esa “materia fantasma” que quiere tapar nuestra enorme ignorancia.

Pero, sigamos con el de la masa. Para resolverlo, muchos expertos en física de partículas creen actualmente en algo que llaman “campo de Higgs”. Se trata de un campo misterioso, invisible y etéreo que está permeando todo el espacio (¿habrán vuelto al antiguo éter pero cambiándole el nombre?). que la materia parezca pesada, como cuando tratamos de correr por el fondo de la piscina llena de agua pero que el agua no se pudiera ver. Si pudiéramos encontrar ese campo, o más bien la partícula la partícula que se cree es la manifestación de ese campo (llamada el bosón de Higgs), avanzaríamos un largo trecho hacia el conocimiento del universo.

Aquí, en este imponente artilugio inventiva de nuestras mentes, se quiere dar respuesta a una serie de interrogantes que se espera solucionar con este experimento:

• Qué es la masa.

• El origen de la masa de las partículas

• El origen de la masa para los bariones.

• El número exacto de partículas del átomo.

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el de Higgs se descubrió hace ya muchos siglos en la antigua India, con el nopmbre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

El pensamiento Hindú tendrçia que ser mejor estudiado

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

emilio silvera

Mar

14

¡El Universo! ¡Qué Maravilla!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (2)

Comments (2)

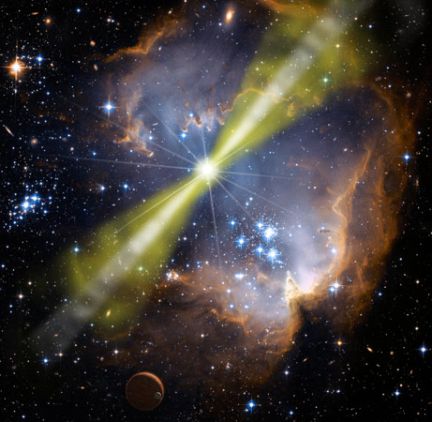

El Cúmulo Copo de Nieve en la Nebulosa del Cono, es como tántas otras Nebulosas, el resultado de la explosión de una estrella al final de sus días. Las estrellas nunca quieren morir del todo y, cuando lo hacen al finalizar sus ciclos de fusión, se convierten en otros objetos distintos y, sus materiales sobrantes son dejados esparcidos por grandes regiones del espacio interestelar, en de bellas nebulosas de las que surgen nuevas estrellas, nuevos mundos y… -seguramente- nuevas formas de vida.

sabemos que el Universo está constituito de innumerables galaxias que forman cúmulos que, a su vez, se juntan en supercúmulos. Estas galaxias están abarrotadas de estrellas y las estrellas, no pocas veces, están acompañadas de planetas que forman sistemas planetarios. Nosotros, los humanos, hemos realizado profundas observaciones que, con nuestros modernos ingenios, nos han podido llevar hasta el espacio profundo, allí donde habitan galaxias que nacieron hace ahora doce mil millones de años.

Arriba podemos contemplar una especie de incubadora estelar que todos conocemos como la Gran Nebulosa de Orión, una familiar imagen que está cerca de “nuestro barrio” dentro de la Galaxia Vía Láctea y conocida como M42 con sus resplandecientes nubes y sus jóvenes y masivas estrellas nuevas que radian en el ultravioleta ionizando la región que toma ese familiar tono azulado.

Situada en el borde de un complejo de nubes moleculares gigantes, esta cautivadora nebulosa -laboratorio espacial- es una pequeña fracción de la inmensa cantidad de material interestelar en nuestra vecindad galáctica.El campo de la imagen se extiende cerca de 75 años-luz a la distancia estimada a la Nebulosa de Orión de 1.500 años-luz. Es una de las Nebulosas más estudiada por los Astrónomos y astrofísicos debido a su enorme capacidad de crear nuevas estrellas y estar en ella presentes procesos de transmutación de elementos y una vertiginosa actividad que es la mejor muestra del comportamiento de la materia en estos lugares.

Sin salir de nuestra región, nos valos al barrio vecino que conocemos Cinturón de Orón donde destacan las estrellas azuladas Alnitak, Alnilam y Mintaka, estrellas supermasivas y muy calientes que forman el Cinturón del Cazador. Ahí podemos ver, abajo a la izquierda la famosa Nebulosa oscura Cabeza de Caballo.

Del Brazo de Orión, la región que nos acoge y en la que se encuentra situado nuestro Sistema solar, al no poderlo tomar fuera y tenerlo tan cerca (de hecho estamos en él inmersos), no podemos tener una imagen las que hemos captado de otros lugares y regiones más alejadas. También conocido como “brazo local” que es alternativo al Brazo de Orión de nuestra Galaxia, así se define algunas veces al Brazo espiral que contiene a nuestro Sol.

Cuando hablamos de brazo espiral nos estamos refiriendo a una estructura curvada en el disco de las galaxias espirales (y de algunas irregulares) donde se concentran las estrellas jóvenes, las nebulosas (regiones H II) y el polvo. Algunas galaxias tienen un patrón bien definido de dos brazos espirales, mientras que otras pueden tener tres o cuatro brazos, estando en ocasiones fragmentados. Los brazos son visibles por la reciente formación de estrellas brillantes, masivas y de corta vida en ellos. actividad de formación de estrellas es periódica, correspondiendo al movimiento a través del disco de una onda de densidad gravitatoria y de fuertes vientos estelares.

Nuestra curiosidad nos ha llevado, mediante la observación y estudio del cielo, desde tiempos inmemoriales, a saber de las estrellas, de cómo se forman, viven y mueren y, de las formas que adoptan al final de sus vidas, en qué se convierten cuando llega ese momento final y a dónde va a parar la masa de las capas exteriores que eyectan con violencia al espacio interestelar para formar nuevas nebulosas. De la estrella original, según sus masas, nos quedará una enana blanca, una estrella de neutrones y, un agujero negro. También, en encuentros atípicos o sucesos inesperados, pueden crearse estrellas por fusión que las transforman en otras diferentes de lo que en su origen fueron.

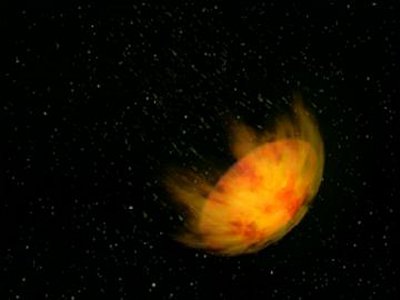

Uno de los acontecimientos más increíbles que podríamos contemplar en el Universo sería, cómo se un Agujero negro que, lo mismo es el resultado de la muerte de una estrella masiva que implosiona y se contrae más y más hasta que desaparece de nuestra vista, o, también, se podría formar en otros sucesos como, por ejemplo, la fusión de dos estrellas de neutrones.

La formación de un agujero negro es una de las manifestaciones más grandes de las que tenenmos constancia con la Gravedad. La estrella, en caso gigante y muy masiva, llega a su final por haber agotado todo su combustible nuclear de fusión y, queda a merced de la fuerza de gravedad que genera su propia masa que, entonces, comienza a contraerse sobre sí misma más y más hasta llegar a convertirse en una singularidad, es decir, un punto matemático en el que ciertas cantidades físicas pueden alcanzar valores infinitos de temperatura y densidad. Por ejemplo, de acuerdo con la relatividad general, la curvatura del espacio-tiempo se infinita en un agujero negro en el que, el espacio y el tiempo…¡dejan de existir!

Es tan fuerte la Gravedad generada que nada la puede frenar. Muchas veces hemos hablado aquí de la estabilidad de una estrella que se debe a la igualdad de dos fuerzas antagómicas: por un lado, la fuerza de fusión y de radiación de una estrella que la impulsa a expandirse y que sólo puede ser frenada por aquella otra fuerza que emite la misma masa estelar, la Gravedad. Las dos se ven compensadas y, de esa manera, la estrella vive miles de millones de años.

Las estrellas implosionan y se contraen sobre sí mismas cuando la fusión finaliza en sus núcleos por falta de combustible nuclear, tales el hidrógeno, helio, berilio, Carbono, Oxígeno… Entonces, el proceso de contracción no es igual en todas ellas, sino que, está reglado en función de la masa que estrella pueda tener. En una estrella como nuestro Sol, cuando comienza a contraerse está obligando a la masa a que ocupe un espacio cada vez menor.

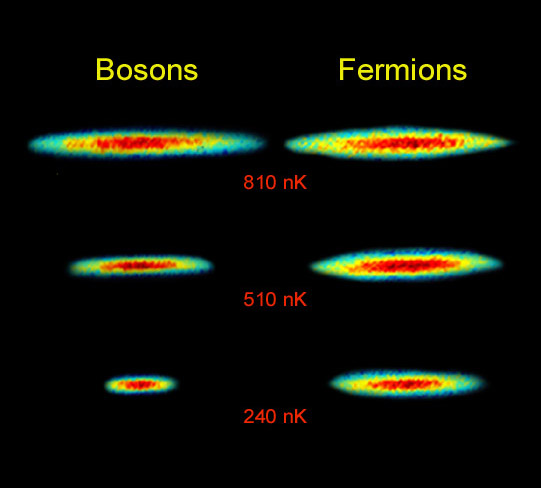

La masa, la materia, como sabemos está formada por partículas subatómicas que, cada una de ellas tienen sus propias singularidades, y, por ejemplo, el electrón, es una partícula que, siendo de la familia de los leptones es, además, un fermión que obedece a la estadística de Fermi-Dirac y está sometido al Principio de exclusión de Pauli que es un principio de la mecánica cuántica aplicable sólo a los fermiones y no a los bosones, y, en virtud del cual dos partículas idénticas en un sistema, como por ejemplo electrones en un átomo o quarks en un hadrón, no pueden poseer un conjunto idénticos de números cuánticos. (esto es, en el mismo estado cuántico de partícula individual) en el mismo sistema cuántico ligado (El origen de Principio se encuentra en el teorema de espín-estadística de la teoría relativista).

Toda la explicación anterior está encaminada a que, podáis comprender el por qué, se forman las estrellas enanas blancas y de neutrones debido al Principio de exclusión de Pauli. Sabemos que la materia, en su mayor parte son espacios vacíos , si la fuerza de Gravedad va comprimiendo la masa de una estrella más y más, lo que está haciendo es que va juntando, cada vez más, a las partículas que conforman esa materia. Así, los electrones se ven más juntos cada vez y, llega un momento, en el que sienten una especie de “claustrofobia”, su condición de fermiones, no les permite estar tan juntos y, entonces, se degeneran y comienzan a moverse a velocidades relativista. Tal suceso, es de tal magnitud que, la Gravedad que estaba comprimiendo la nasa de la estrella, se ve frenada y se alcanza una estabilidad que finaliza dejando una estrella enana blanca estable.

Pero, ¿qué pasaría si la estrella en vez de tener la masa de nuestro Sol, tiene varias veces su masa? Entonces, ni la degeneración de los electrones frenar la fuerza gravitatoria que sigue comprimiendo la masa de la estrella y fusiona electrones con protones para formar neutrones. Los neutrones, que son fermiones, se ven comprimidos hasta tal punto que, también se degeneran y, ellos, sí son capaces de frenar la fuerza gravitatoria quedando esa masa estabilizada como estrella de Neutrones.

Como el niño que no deja de hacer preguntas, nosotros, llegados a este punto también, podríamos preguntar: ¿Qué ocurriría si la estrella es muy masiva? Entonces amigos míos, el Principio de Excliusión de Pauli haría mutis por el foro, impotente ante la descomunal fuerza gravitatoria desatada y, ni la degeneración de electrones y neutrones podría frenarla. La masa se vería comprimida más y más hasta convertirse en un agujero negro de donde, ni la luz puede escapar.

los mecanismos del Universo son muchos y los sucesos que podemos contemplar son asombrosos. Por ejmplo, si una inocente estrella está situada cerca de una enana blanca de gran densidad, se vería atraída por ella y “vería” , poco a poco, le robaría su masa hasta que, finalmente, la engulliría en su totalidad.

Si eso ocurre tal y como vemos en la imagen, ¿qué pasaría entonces? Sencillamente que, la estrella enana blanca pasaría a transformarse en una estrella de neutrones, ya que, la masa que a pasado a engrosar su entidad, es demasiado poder quedar estable como enana blanca y, de nuevo la gravedad hace que electrones y protones se fundan para formar neutrones que, degenerados, estabilizan la nueva estrella.

Sí, hemos llegado a ser conscientes de nuestro entorno y hemos podido crear ingenios que nos hablan y muestran las lejanas regiones del Universo. Ahora podemos hablar de las tremendas energías presentes en el espacio cosmológico y sabemos por qué se generan y cuáles son sus consecuencias. Conocemos de la importancia del Sol para la vida en la Tierra, hemos observado el Sistema solar al que pertenecemos dentro una inmensa galaxia de estrellas y, sobre todo, hemos llegado a comprender que, la Vida en nuestro planeta, no ser un privilegio, sino cosa cotidiana repartida por todo el universo infinito.

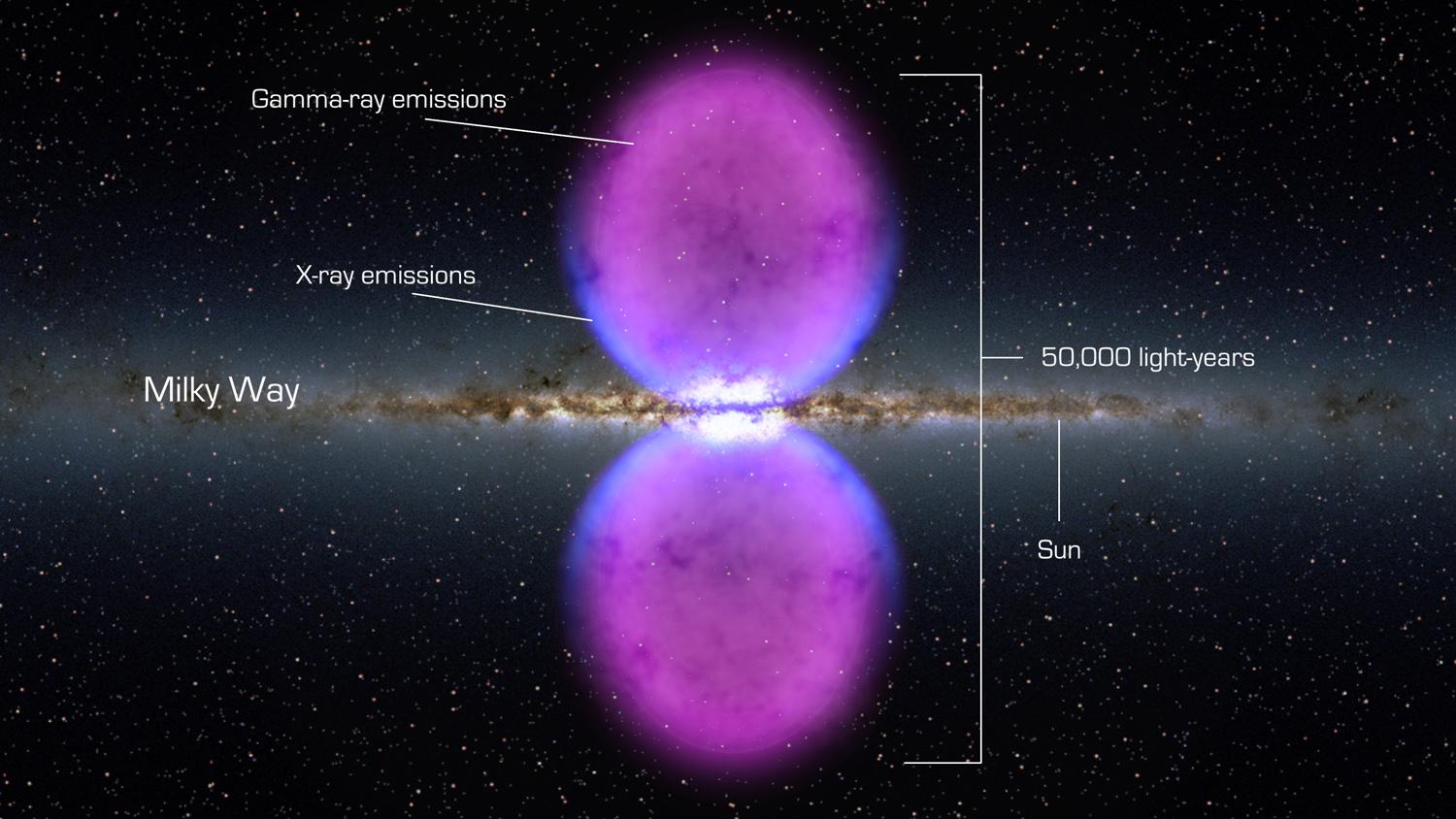

El Telescopio Espacial Fermi, de Rayos Gamma de la NASA ha descubierto y nos enseña una estructura nunca vista en el centro de nuestra galaxía la Vía Láctea. La estructura se extiende a 50.000 años luz y puede ser el remanente de una erupción de un agujero negro de enorme tamaño en el centro de nuestra Galaxia.

El desarrollo de la ciencia su frontera superior en el desarrollo de tecnologías que hacen posible el conocimiento de nuestro universo. Satélites, telescopios, radio telescopios, sondas espaciales, naves, cohetes y transbordadores son el fruto de la investigación de muchos profesionales de diversas áreas del conocimiento que están llevando a toda la Humanidad hacia el futuro.

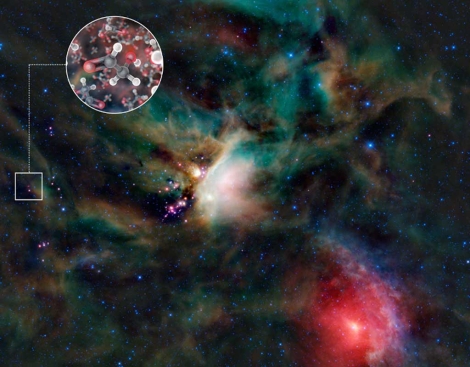

Con el radiotelescopio ALMA, ubicado en el desierto de Atacama (Chile), a 5.000 metros de altura, los científicos lograron captar moléculas de glicolaldehído en el gas que rodea la estrella binaria joven IRAS 16293-2422, con una masa similar a la del Sol y ubicada a 400 luz de la Tierra.

El glicolaldehído ya se había divisado en el espacio interestelar anteriormente, esta es la primera vez que se localiza tan cerca de una estrella de este , a distancias equivalentes a las que separan Urano del Sol en nuestro propio sistema solar.

“En el disco de gas y polvo que rodea a esta estrella de formación reciente encontramos glicolaldehído, un azúcar simple que no es muy distinto al que ponemos en el café”, señaló Jes Jørgensen, del Instituto Niels Bohr de Dinamarca y autor principal del estudio.

Voyager I y II en su viaje sin fin, sobrepasaron los límites del Sistema Solar ¿Leerá alguien su mensaje?

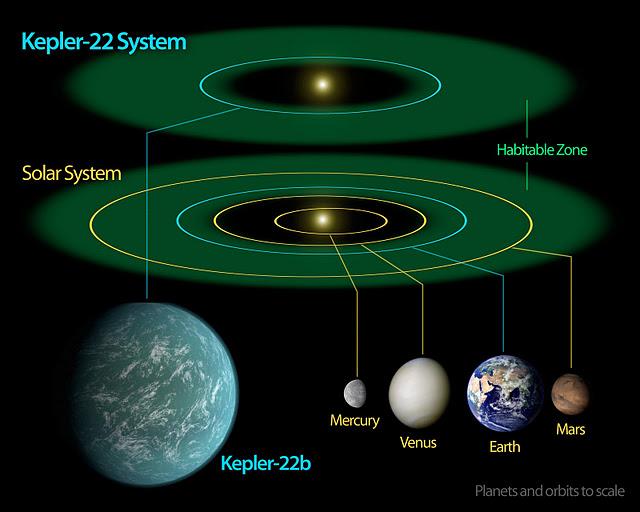

El observatorio espacial Kepler encontró en el sistema planetario Kepler-22, a 600 años luz, el primer planeta situado en la llamada “zona habitable”, un área en la que, por su distancia a su sol, haber agua líquida, según anunció este lunes la NASA en una rueda de prensa. Los científicos del Centro de Investigación Ames de la NASA anunciaron además que Kepler ha identificado 1.000 nuevos “candidatos” a planeta, diez de los cuales tienen un tamaño similar al de la Tierra y orbitan en la zona habitable de la estrella de su sistema solar, esto es, ni demasiado cerca ni demasiado lejos de una estrella.

El planeta, Kepler-22b, es el más pequeño hallado por la sonda espacial orbitando en la “zona habitable” -aquella donde las temperaturas permiten la vida- de una estrella similar a la de la Tierra. 55 planetas son aún más grandes que Júpiter, el más grande de nuestro sistema solar Es más grande que la Tierra y todavía no se ha determinado si es rocoso, gaseoso o líquido, , según dijo la subdirectora del equipo científico del Centro Ames, Natalie Batalha, “estamos vez más cerca de encontrar un planeta parecido a la Tierra”.

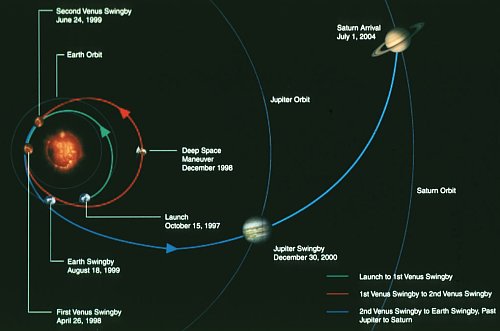

Esta escena es del día en que, en 1997, fue lanzada la Misión Cassini-Huygens hacia el vecino Saturno. ¿Qué podemos comentar de esa misión que nos llevó al más grande de los asombros, al podernos mostrar imágenesa nunca vistas?

Imágenes tomadas por Cassini a su paso por Júpiter

La misión Cassini a Saturno y Huygens a Titán, es una de las misiones más ambiciosas el momento jamás llevado a cabo. Todos sabemos ahora de su alta rentabilidad y de los muchos logros conseguidos. Gracias a misión sabemos de mucho más sobre el planeta hermano y de su gran satélite Titán del que hemos podido comprobar que es una “pequeña Tierra” con sus océanos de metano y su densa atmósfera inusual en cuerpos tan pequeños.

¡El ingenio humano!

La masa de la sonda Cassini es tan grande que no fue posible emplear un vehículo de lanzamiento que la dirigiese directamente a Saturno. Para alcanzar este planeta fueron necesarias cuatro asistencias gravitacionales; de esta forma, Cassini empleó una trayectoria interplanetaria que la llevaría a Venus en dos ocasiones, posteriormente hacia la Tierra y después hacia Júpiter. Después de sobrevolar Venus en dos ocasiones a una altitud de 284 Km, el 26 de abril de 1998 y a 600 Km, el 24 de junio de 1999, el vehículo se aproximó a la Tierra, acercándose a 1171 Km de su superficie el 18 de agosto de 1999. Gracias a estas tres asistencias gravitacionales, Cassini adquirió el momento suficiente para dirigirse al Sistema Solar externo. La cuarta y última asistencia se llevaría a cabo en Júpiter, el 30 de diciembre de 2000, sobrevolándolo a una distancia de 9.723.890 Km, e impulsándose hacia Saturno.

La masa de la sonda Cassini es tan grande que no fue posible emplear un vehículo de lanzamiento que la dirigiese directamente a Saturno. Para alcanzar este planeta fueron necesarias cuatro asistencias gravitacionales; de esta forma, Cassini empleó una trayectoria interplanetaria que la llevaría a Venus en dos ocasiones, posteriormente hacia la Tierra y después hacia Júpiter. Después de sobrevolar Venus en dos ocasiones a una altitud de 284 Km, el 26 de abril de 1998 y a 600 Km, el 24 de junio de 1999, el vehículo se aproximó a la Tierra, acercándose a 1171 Km de su superficie el 18 de agosto de 1999. Gracias a estas tres asistencias gravitacionales, Cassini adquirió el momento suficiente para dirigirse al Sistema Solar externo. La cuarta y última asistencia se llevaría a cabo en Júpiter, el 30 de diciembre de 2000, sobrevolándolo a una distancia de 9.723.890 Km, e impulsándose hacia Saturno.

¿Os dais cuenta de la asombrosa imaginación y los conocimientos que son necesarios para llevar a cabo todo este conglomerado de datos?

Cassini llevó a cabo un plan de vuelo de baja actividad durante el cuakl sólo se realizaron las actividades de navegación e ingenieria imprescindibles, maniobras de chequeo o corrección de trayectoria. Los instrumentos científicos fueron desconectados permanentemente, salvo en el transcurso de unas pocas actividades de mantenimiento. Estas incluían sólo un chequeo de todo su instrumento cuando la sonda estaba cerca de la Tierra, así como la calibración del magnetómetro. Las comprobaciones sobre el estado de la sonda Huygens se llevaron a cabo cada seis meses, mientras que las observaciones científicas se realizaron cuando el vehículo se aproximó a Venus, la Tierra y Júpiter.

El sobrevuelo de Júpiter significó una buena para las sondas Cassini y Galileo de cara a estudiar varios aspectos de este planeta y su medio circundante desde octubre de 2000 hasta marzo de 2001, es decir, antes, durante y después de la máxima aproximación a Júpiter, el 30 de diciembre de 2000. Las observaciones científicas contaron con la ventaja de disponer de dos sondas espaciales en las cercanías del planeta al mismo tiempo. Algunos de los objetivos llevados a cabo conjuntamente por la Cassini y la Galileo incluyeron el estudio de la magnetosfera y los efectos del viento solar en ésta, así como la obtención de datos sobre las auroras en Júpiter.

Durante este sobrevuelo, la mayor parte de los instrumentos del orbitador Cassini fueron conectados, calibrados y trabajaron recogiendo información. Este estudio conjunto sirvió buena práctica para comprobar el funcionamiento del instrumental de la sonda tres antes de su llegada a Saturno.

Llegada a Saturno

Después de un viaje de casi siete años y más de 3500 millones de kilómetros recorridos, la sonda Cassini llegará a Saturno el día 1 de julio de 2004.

La fase más crítica de la misión –además del lanzamiento– es la inserción orbital del vehículo en torno al planeta. Cuando el vehículo alcance el planeta, la sonda pondrá en marcha su motor principal durante 96 minutos a las 04:36 T.U., con la finalidad de reducir su velocidad y permitir que la gravedad de Saturno la capture como un satélite del planeta. Atravesando el hueco entre los anillos F y G, Cassini se aproximará al planeta para iniciar así la primera de sus 76 órbitas que completará durante su misión principal de cuatro años.

Todos hemos podido admirar las imágenes y sabido de los datos científicos que la Cassini ha podido enviar a la Tierra que, todos podamos saber mucho más del planeta Saturno y de su entorno. Imágenes inolvidables y de increíble belleza forman parte ya de la historia de la misión.

La misión de la sonda Huygens

La sonda Huygens viajó junto a la Cassini hacia Saturno. Anclada a ésta y alimentada eléctricamente por un cable umbilical, Huygens ha permanecido durante el viaje de siete años en modo inactivo, sólo puesta en marcha seis meses para realizar chequeos de tres horas de duración de su instrumental y de sus sistemas ingenieriles.

20 días antes de alcanzar la atmósfera alta de Titán, Huygens fue eyectada por Cassini. Esto ocurrió el 24 de diciembre de 2004. Tras cortar su cable umbilical y abrir sus anclajes, Huygens se separó de su nave madre y voló en solitario hacia Titán, con una trayectoria balística, girando a 7 revoluciones por minuto para estabilizarse. Varios temporizadores automáticos conectarán los sistemas de la sonda espacial antes de que ésta alcance la atmósfera superior de Titán.

20 días antes de alcanzar la atmósfera alta de Titán, Huygens fue eyectada por Cassini. Esto ocurrió el 24 de diciembre de 2004. Tras cortar su cable umbilical y abrir sus anclajes, Huygens se separó de su nave madre y voló en solitario hacia Titán, con una trayectoria balística, girando a 7 revoluciones por minuto para estabilizarse. Varios temporizadores automáticos conectarán los sistemas de la sonda espacial antes de que ésta alcance la atmósfera superior de Titán.

Dos días después de la eyección de la sonda, Cassini realizará una maniobra de desviación, de manera que ésta puedo seguir a la Huygens penetró en la atmósfera de Titán. Esta maniobra servió también establecer la geometría requerida entre el orbitador con Huygens, así como las comunicaciones de radio durante el descenso.

Dos días después de la eyección de la sonda, Cassini realizará una maniobra de desviación, de manera que ésta puedo seguir a la Huygens penetró en la atmósfera de Titán. Esta maniobra servió también establecer la geometría requerida entre el orbitador con Huygens, así como las comunicaciones de radio durante el descenso.

Huygens porta dos transmisores de microondas en la banda S y dos antenas, las cuales enviarán simultáneamente la información recogida el orbitador Cassini. Una de ellas emitirá con un retraso de seis segundos respecto a la otra, para evitar cualquier pérdida de información si tuviesen lugar problemas con las comunicaciones.

El descenso de Huygens tuvo lugar el 15 de enero de 2005. La sonda entró en la atmósfera de Titán a una velocidad de 20.000 Km/h. Este vehículo ha sido diseñado tanto para soportar el extremo frío del espacio (temperaturas de –200°C) como el intenso calor que se encontrará durante su entrada atmosférica (más de 12000°C).

El descenso de Huygens tuvo lugar el 15 de enero de 2005. La sonda entró en la atmósfera de Titán a una velocidad de 20.000 Km/h. Este vehículo ha sido diseñado tanto para soportar el extremo frío del espacio (temperaturas de –200°C) como el intenso calor que se encontrará durante su entrada atmosférica (más de 12000°C).

Los paracaídas que transporta Huygens frenaron más la sonda, de tal modo que ésta puedo llevar a cabo un amplio programa de observaciones científicas al tiempo que desciende hacia la superficie de Titán. Cuando la velocidad de la sonda descendido hasta los 1400 Km/h, se desprendió su cubierta mediante un paracaídas piloto. Acto seguido se desplegó otro paracaídas de 8.3 metros de diámetro que frenó aún más el vehículo, permitiendo la eyección del decelerador y del escudo térmico.

la primera parte del descenso, el de los instrumentos situados a bordo de la sonda Huygens será dirigido por un sistema temporizador, pero en los últimos 10 a 20 Km, será un altímetro radar quien medirá la altura a la que se encuentra el vehículo y controlará el instrumental científico.

Durante el descenso, el instrumento de estructura atmosférica de Huygens medió las propiedades físicas de la atmósfera. El cromatógrafo de gases y el espectrómetro de masas determinarán la composición química de la atmósfera en función de la altitud. El colector de aerosoles y el pirolizador capturarán partículas de aerosol –las finas partículas líquidas o sólidas suspendidas en la atmósfera–, las calentará y enviará el vapor resultante al espectrómetro y el cromatógrafo su análisis.

El sistema de imagen de descenso y el radiómetro espectral trabajarán en la toma de imágenes de formaciones nubosas y de la superficie de Titán, determinando además la visibilidad en la atmósfera de este mundo. Según se vaya aproximando a la superficie, el instrumento encenderá un sistema de iluminación brillante que para medir la reflectividad superficial. Paralelamente a ello, la señal emitida por la sonda Huygens será recogida por el experimento Doppler de la Cassini, con lo cual se podrán determinar los vientos, ráfagas y turbulencias de la atmósfera. Cuando la sonda sea empujada por el viento, la frecuencia de su señal de radio variará ligeramente –en lo que se conoce como efecto Doppler, similar a la variación de la frecuencia del silbido de un tren que percibimos cuando éste pasa por delante de nosotros. Estos cambios en la frecuencia se emplearán para deducir la velocidad del viento que ha experimentado la sonda.

Pequeños mundos muy cercanos a nosotros y que nos podrían dar buenas sorpresas

La misión principal de la sonda Cassini tenía previsto que finalizaría el 30 de junio de 2008, cuatro años después de su llegada a Saturno y 33 días después de su último sobrevuelo a Titán, el cual tuvo lugar el 28 de mayo de 2008. Este sobrevuelo estaba diseñado para posicionar a la sonda de cara a un nuevo acercamiento a dicho satélite el 31 de julio de 2008, ofreciendo la de proceder con más sobrevuelos durante la misión extendida, si es que los recursos disponibles la permiten. No hay ningún factor en la misión principal que impida una misión extendida. Lo cierto es que, Cassini sigue ahí y, como otros ingenios espaciales enviados al espacio, continúan más allá de la misión en principio previstas enviando datos e imagénes que nos acercan al saber del mundo que nos rodea y nos dice cómo y por qué funciona así la Naturaleza.

Me he extendido más de lo previsto en este y, no puedo seguir nombranbdo otras misiones que, como las enviadas a Marte, tan buenos réditos de conocimiento nos han suministrado. Ya habrá lugar más adelante para continuar profiundizando en todo lo que hicimos y, también, ¿cómo no? en lo mucho nos queda por hacer.

No podemos negar que, escenas la que arriba contemplamos, no sea algo cotidiano en el devenir de la Humanidad. El futuro que nos aguarda puede ser algo maravilloso y de asombrosos descubrimientos que nos llevaran lejos, hacia otros mundos, otras estrellas… ¡otras amistades!

Pero todo eso amigo míos, sólo podrá ser posible gracias al conocimiento y al hecho de ser conscientes de nuestras limitaciones. No debemos nunca querer superar a la Naturaleza, simplemente debemos aprender de ella.

emilio silvera

Mar

14

Bosques y Praderas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Naturaleza ~

Clasificado en Naturaleza ~

Comments (3)

Comments (3)

Desde tiempos inmemoriales, la Humanidad ha venido esquilmando, sin saber administrarla, la materia prima que la Naturaleza le ofrecía su sustento y, han sido devastadas cientos de miles de hectareas de bosque persiguiendo objetivos diversos pero, sin pensar en el futuro.

Los bosques almacenan la mayor parte de la fitomasa terrestre, entre tres cuartos y nueve décimos del total. La razón de tanta incertidumbre en estimación se debe a la rápida deforestación tropical, la falta de una clasificación uniforme de los bosques y a su alta variabilidad.

Quema de Bosques en el Sur de México para uso agrario

Los bosques cerrados (en contraste con los bosques abiertos) se pueden definir como ecosistemas cuya cubierta ocupa entre el 20 y el 40 por ciento del suelo. Nuestro escaso conocimiento de los bosques tropicales implica que tengamos que extrapolar almacenamientos típicos de un inadecuado de terrenos bien estudiados. El mejor inventario disponible establece que, a principios de los noventa, el área total de bosques cerrados era de aproximadamente 25 millones de Km2, dos quintas partes de los cuales estaban situados en los trópicos. La superficie total de todos los bosques es aproximadamente el doble; almacenan cerca de nueve décimas partes de la fitomasa del planeta y están casi equitativamente repartidos entre los biomas tropicales, templaros y boreales.

En el bosque tropical se encuentra el máximo almacenamiento medio de fitomasa. Desde el aire, las copas de los árboles muestran una decepcionante uniformidad, vistas desde aviones a reacción y de un rojo intenso en las imágenes con falso color de los satélites. Desde el suelo umbrío, frecuentemente con escasa maleza, se elevan los troncos de los árboles, rectos, otros delgados, algunos enormes y también apuntalados; luego un revoltijo de ramas superpuestas, lianas y epifitos. Un claro del bosque o la orilla de una corriente muestran la estructura en capas de esta selva.

Los bosques tropicales más espesos de la Amazonia albergan en cada hectárea casi 100.000 plantas de más de seiscientas especies vegetales diferentes. Pero al menos tres cuartas partes de la fitomasa almacenada (unas 600 toneladas por hectárea) se encuentran en las copas de pocos cientos de árboles que sobresalen.

Debido a la alta biodiversidad de la selva, ningún árbol almacena más de un pequeño porcentaje de toda la fitomasa. Ésta es una estrategia evasiva que ha incrementado las posibilidades de supervivencia en un ambiente rebosante de predadores de semillas y agentes patógenos. Otras defensas activas son sus finas cortezas o la simbiosis con hormigas guardianas.

Por el contrario, en los bosques templados y en los boreales domina una sola especie de árbol, y sin embargo, su almacenamiento de fitomasa supera a los bosques tropicales más espesos. Los máximos del planeta se dan en las costas del noroeste del océano Pacífico, donde los bosques de secuoyas pueden llegar a almacenar, por encima del suelo, 3.500 toneladas de fitomasa por hectárea, lo que representa una cantidad cinco veces mayor que en la Amazonia central. Estos árboles son los seres vivos más altos (más de 100 metros) y más pesados (más de 300 toneladas) del planeta (las ballenas azules adultas pesan alrededor de las 100 tonelas).

En todos los bosques, los tejidos leñosos por encima del nivel del suelo (tronco, corteza, ramas) contienen la mayor de la fitomasa (70 – 80 por ciento) del árbol; las raíces almacenan entre el 10 y el 35 por ciento, las acículas un 1’5 – 8 por ciento y las hojas sólo el 1 – 2 por ciento.

El tronco cortado en la forma tradicional su comercialización contiene solamente la mitad de toda la fitomasa, mientras que los troncos demasiados delgados, el tocón, ramas, corteza, artículos y hojas suman la otra mitad.

En un buen bosque en crecimiento, templado o boreal, se obtienen entre 85 y 100 m3/ha (35 – 50 t/ha en seco, dependiendo de la clase de árbol); en los bosques tropicales pueden llegar 180 m3/ha. Con los nuevos métodos de corta, para obtener pulpa se utiliza todo el árbol (a menudo hasta el tocón), recuperándose prácticamente toda la fitomasa.

producir un kilogramo de fitomasa nueva, los árboles tropicales requieren hasta 12 g de nitrógeno, mientras que un bosque de coníferas necesita menos de 4 g. Los bosques templados, con unas tasas relativamente altas de crecimiento y un uso económico de los nutrientes, son productores relativamente eficientes de fitomasa.

Todas la civilizaciones preindustriales cortaron madera, no sólo material de construcción indispensable, sino también como combustible, bien quemado directamente o transformándolo previamente en carbón. La contribución de los bosques a la energía global primaria ha ido declinando según ha aumentado el consumo de combustibles fósiles, pero su presencia ha seguido creciendo, tanto como suministradores de madera y pulpa como por su función de albergues de alta biodiversidad y por sus servicios como ecosistemas insustituibles.

El ámbito de las praderas

La extensión global de las praderas ha cambiado profundamente desde la mitad del siglo XIX. El principal motivo de cambio es el de transformar las praderas en tierras de cultivo, lo que ha provocado la disminución, en superficie, de este bioma, pero por otra parte, según avanza la deforestación han surgido praderas secundarias.

Aunque la extensión de las praderas es casi igual a la de los bosques cerrados, la diferencia sus respectivos promedios de fitomasa almacenada sobre el nivel del suelo por unidad de superficie (20 t/ha en hierba, 250 t/ha en fitomasa leñosa) es de un orden de magnitud. Hay, sin embargo, más fitomasa en las praderas de lo que parece a simple vista, porque salvo en las hierbas altas tropicales, la fitomasa subterránea es varias veces mayor que en los árboles en lo que se refiere a los brotes en su cubierta.

La cantidad de fitomasa contenida en los renuevos está comprendida entre de 1 t/ha, en regiones semidesérticas, hasta más de 20 t/ha en algunas praderas tropicales. Si se incluyen los tallos secos, la fitomasa aérea llega a alcanzar las 35 t/ha. En regiones con clima semihúmedo tropical, y en climas templados con irrigación natural, las mayores acumulaciones de fitomasa se encuentran en los renuevos. En general, es indiscutible la correlación entre la cantidad de fitomasa y la de lluvia, aunque esta relación pierde importancia en condiciones de humedad elevadas.

Los valores extremos de la cantidad de fitomasa subterránea global varía entre menos de 0’5 t/ha en los trópicos, hasta casi 50 t/ha en las praderas templadas (media de 20 t/ha). Con cerca de 10 t/ha al año, la productividad media de las praderas templadas iguala la de los bosques en latitudes medias.

Una gran cantidad de herbívoros se alimentan de las praderas. Solamente las hojas tiernas tienen un alto contenido en proteínas y son relativamente digestibles. Los tallos y los troncos son peores en ambos aspectos, pero componen la mayor parte de la de algunas especies que comparten las praderas con otros animales. En la estación seca del Serengueti, la dieta de los ñus se compone aproximadamente de un 20 por ciento de hojas y un 30 por ciento de tallos, mientras que para las cebras los correspondientes valores son de menos del 1 por ciento y de más del 50 por ciento respectivamente.

Una sola especie numerosa de invertebrados puede consumir una pequeña fracción de la producción anual de fitomasa, y el consumo total de todos los invertebrados está comprendido entre el 10 y el 20 por ciento. Los ungulados consumen el 60 por ciento de la producción de fitomasa aérea de las fértiles praderas del este de África. Algunas hierbas se adaptan para evitar su excesivo consumo incorporando a su composición sustancias que disminuyen su digestibilidad, y compuestos tóxicos; otras reaccionan con un rápido crecimiento cuando son dañadas por los animales que pastan.

En el Serengueti, donde las praderas sirven de alimento a la mayor concentración de grandes herbívoros del mundo, así como a muchos otros animales de menos tamaño y a numerosos invertebrados, un moderado consumo de hierba aumenta la producción de la misma hasta el doble de la que se produce en terrenos donde no se pace. El césped es la prueba más asequible de la productividad, no siempre deseada, de la pradera.

emilio silvera

Mar

13

¡Conocer la Naturaleza! No será nada fácil

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de . Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

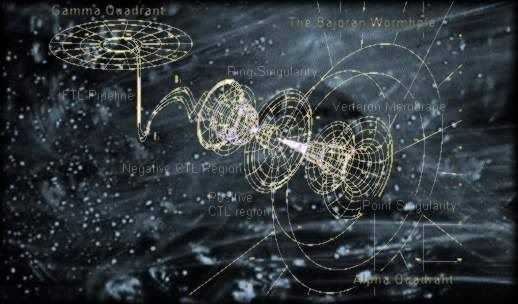

Por el , la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la de agujeros negros.

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad de Einstein? Afortunadamente, hay una respuesta y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el de constante de estructura fina”

Lederman

Este guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros!

emilio silvera

Mar

13

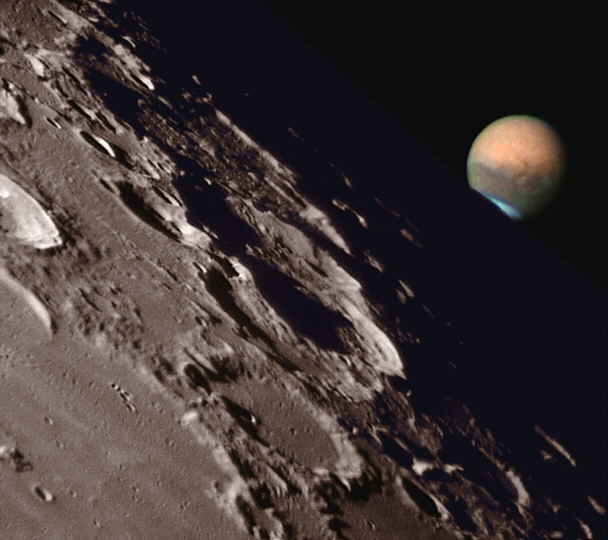

¡Marte! ¡Aún desata la imaginación de algunos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (1)

Comments (1)

El “Gran cañón” de Marte es mucho más largo y profundo que el del Colorado

Todos hemos visto, en más de una ocasión, del planeta Marte de regiones dispares y de variado contenido. Marte, el cuarto planeta desde el Sol, aparece marcadamente rojizo cuando se observa a simple vista. Tiene una delgada atmósfera compuesta (en volumen) por alrededor del 95% de dióxido de carbono, 2,7% de Nitrógeno, 1,6% de Argón, 0,1% de Oxígeno, 0,1% de monóxido de carbono y pequeñas trazas variables de vapor de agua. La presión atmosférica en la superficie es de unos 6 mbar. Las temperaturas superficiales pueden variar entre 0 y -125ºC, siendo la media de -50ºC. Es relativamente común la presencia de nubes blancas de vapor de agua condensada o de dióxido de carbono, particularmente cerca del terminador y en latitudes polares.

Existen dos casquetes de hielo de agua permanentes en los polos, que nunca se funden. En invierno éstos aumentan de tamaño al convertirse en casquetes de dióxido de carbono congelado hasta alcanzar los 60º de longitud. Ocurren esporádicamente tormentas de polvo que llegan a cubrir la totalidad del planeta con una neblina amarilla, oscureciendo los accidentes superficiales más .

Recientes de la NASA muestran engañosas “sombras de árboles” sobre la superficie de las dunas en Marte, que en realidad son caminos de arena, según publicaron numerosos periódicos británicos. Un vídeo circulante en Internet muestra imágenes de supuesta vida en Marte tras un retoque digital. Ver para creer.

La superficie de Marte es basalto volcánico con un alto contenido en hierro y, su oxidación, es la responsable de su color característico rojo oxido. El accidente oscuro más prominente, Syrtis Major, dirigida hacia el Este con una inclinación menor que 1º. Existen muchas áreas de dunas de arena rodeando las más grandes los casquetes polares y constituyendo los mayores de dunas del Sistema Solar.

Escenarios increíbles, tormentas de polvo, radiación y… ¡misterio!

En el pasado existió una intensa actividad volcánica en Marte. Tharsis Montes es la mayor región volcánica, estando Olympus Mons en el Noroeste, y la vasta estructura colapsada Alba Patera, en el Norte. Juntas, estas áreas volcánicas constituyen casi el 10% de la superficie del planeta. Hoy no hay volcanes activos en Marte, aunque en el pasado produjeron llanuras de lava que se extendieron cientos de kilómetros.

Hay distribuidos cráteres de impacto a lo largo de todo Marte, aunque existe una altiplanicie casi completamente cubierta de cráteres, similar a las altiplanicies de la Luna, que cubre casi la mitad de la superficie del , principalmente en el hemisferio Sur. Muchos de los cráteres de impacto más recientes, conocidos como cráteres de terraplén, tienen grandes pendientes en los bordes de su mantos de proyecciones, sugiriendo que la superficie estaba húmeda o llena de barro cuando se produjo el impacto.

Las cuencas de impacto más grandes mejor conservadas son Argyre y Hellas.

Esta es una de la parte de Marte con el Sino Sabaus y de Regio Deucalionis. El cráter a la derecha inferior es Flaugergues, y el doble cráter en la parte inferior izquierda es Wislicenus. Esta imagen fue tomada por el Mariner 6 en 1969. En esta imagen pueden encontrarse muchas características que sugieren ríos Marcianos, e incluso la salida de una llanura central. Se recomienda ver esta imagen en alta resolución. (Cortesía de la NASA/JPL)

(282K GIF)

Internamente, Marte probablemente tiene una litosfera de cientos de kilómetros de grosor, una astenosfera rocosa y un núcleo metálico de aproximadamente la mitad del diámetro del planeta. Marte no posee un magnético importante. Tiene dos pequeños satélites, Phobos y Deimos. Su diámetro ecuatorial es de 6 794 Km, su período de rotación axial (sidéreo) es de 24,623 horas, su densidad media es de 3,94 g/cm3, y, si consideramos que la masa de la = 1, la de Marte es de 0,11, el volumen de Tierra = 1, el de Marte = 0,15. La velocidad de escape es de 5,02 Km/s. Su distancia al Sol es de 1,524 UA.

Pero veamos otros aspectos del planeta Marte que, durante décadas impactó en la imaginación de hombres como Giovanni Virginio Schiaparelli, Percival Lowell y Willian Henry Pickering que, a finales del siglo XIX y principio del XX, insistían en despejar las dudas sobre si existían realmente los Canales que hiucieron famosos estos personajes de leyenda. Más tarde, hace veinticinco años algo curioso sucedió en las cercanías del planeta Marte. La nave Vikingo 1 de NASA se encontraba volando alrededor del planeta, tomando fotografías de posibles lugares para el aterrizaje de la nave hermana Vikingo 2, cuando descubrió, sobre la superficie, una figura en sombras muy semejante a una cara humana. Una cabeza enorme de unos tres kilómetros de extremo a extremo parecía estar devolviendo la mirada a la cámara desde una región del Planeta Rojo conocida como Cidonia.

Imagínense la sorpresa de los controladores de la misión en el Laboratorio de Propulsión a Chorro, cuando la cara apareció en sus consolas. Sin , la sorpresa duró poco tiempo. Los científicos fácilmente concluyeron que ésta era solo otra meseta Marciana, muy común en los alrededores de Cidonia, solo que esta tenía sombras extrañas que la hacían aparecer como un Faraón Egipcio.

Crédito: NASA.

Pero, amigos míos, la nave Mars Global Surveyor consiguió abrir a la ciencia un nuevo horizonte en Marte. De alguna forma, el hombre, debe abordar de nuevo desde el principio la de la vida en aquel planeta, lleno de secretos que sólo ahora empiezan a desvelarse después de más de un siglo de trepidantes debates entre astrónomos y aficionados.

La nave encontró inequívocos signos de la presencia de agua líquida en el planeta, algo que los científicos llevaban décadas tratando de confirmar. Es conocido que el agua líquida es el requisito para la vida tal como la conocemos nosotros, y si en el planeta rojo existe ese preciado elixir, como se ha podido comprobar mediante las investigaciones de la NASA, las posibilidades de que Marte sea un mundo vivo siguen plenamente vigentes.

Nombrar aquí a todos los personajes que, de una u otra manera, han intervenido en la esperanza de encontrar vida en el planeta hermano, sería algo tedioso, pero no puedo dejar atrás al astrónomo más destacado de la historia reciente, Carl Sagan fue quien mantuvo siempre la esperanza en un Marte vivo, aunque su muerte ni siquiera le concedió la de asistir a las siguientes misiones de la NASA en el planeta rojo, que en contraposición al balance de las Viking han permitido reabrir claramente las esperanzas de hallar vida allí, si no en el presente, tal vez si en el pasado.

El examen de las rocas marcianas realizado por la Mars Pathfinder y su juguetón todoterreno Sojourner confirmó lo que ya tenían claro muchos expertos: el agua había pasado por allí, probablemente hace muchos millones de años, tal como revelan las huellas dejadas por gigantescas corrientes en las zonas de aterrizaje.

Estudiando el terreno en muchas de las regiones del planeta, de manera clara y precisa, se puede comprobar la presencia de agua que, al parecer, brota desde el subsuelo. Es preciso no perder de el carácter altamente volcánico de Marte que, hace mucho tiempo tuvo una gran actividad de importantes erupciones y, la enorme cantidad de lava que corría por inmensas zonas del planeta, entre otras cosas, debieron oradar el terreno abriendo enormes galerias subterráneas que, en la actualidad, al estar situadas en las profundidades del planeta, deben tener una temperatura mayor que en la superficie, están resguardadas de la radiación, y, si el agua corre por allí, no sería nada extraña que, colonias de bacterias, hongos y líquenes estuvieran bien asentadas a ese nivel interior.

Tenemos que convenir que Marte, sigue siendo uno de los planetas más misteriosos del Sistema Solar, y, desde luego, es un buen aspirante para signos de vida presente, o, en último caso, del pasado. Nada puede negar la posibilidad de la existencia de agua líquida que pueda subsistir de forma permanente bajo la protección del suelo marciano, y si existen oasis en el subsuelo no puede descartarse en absoluto que Marte albergue sus propios ecosistemas subterráneos, lejos de la mortífera radiación ultravioleta que lelgan desde el Sol y de la que los seres vivos no pueden protegerse en la superficie al no haber una atmósfera lo suficientemente densa.

Cualquiera, hasta un profano, que observe algunas de las fotografías obtenidas en la sima Candor o de Ophir Chasma, ambas en Valles Marineris, tendrá ante sus ojos la prueba de que la historia de Marte no nos habla de un planeta estéril. Valles Marineris es, de hecho, el más entramado de cañones fluviales de todo el Sistema Solar, ya que tiene una longitud de 4.100 Km, una anchura aproximada a los 500 y puntos en los que la profundidad, alcanzan los 4 km. Aunque en sus agrestes formas parecen haber intervenido los movimientos internos de la corteza marciana, se da por hecho que fue el agua el principal agente que modeló lo que podríamos considerar como uno de los más bellos y extensos “parques naturales” de todo el Sistema Solar.

A mí, todos estos escenarios me hacen imaginar…¡tantas !

Está claro que, hoy en día sabemos de los océanos y mares que, hace millones de años adornaban el planeta Marte, y, sus de hoy, claramente nos hablan de las correntías de cantarinos torrentes fluviales que, corriente abajo, oradaban las superficie del planeta dejando la huella de su presencia allí.

Valles Marineris y otros lugares del planeta tienen las pruebas de lo que Marte, en epasado fue. Puede ser que Lowell se equivocara sobre la existencia de unos canales construídos por la mano de seres inteligentes en aquel planeta. Él concibió “los canales” como obras de ingenieria de una civilización inteligente para transportar el agua, pero quizá no lo estuviera en lo más , es decir, en su convicción sobre la existencia de vida en Marte. Es algo que no sabemos aún pero que, probablemente, no tardaremos mucho en saber.

Una fotografía de la sonda Explorer Spirit, misión de la Nasa que está en Marte, reveló una extraña figura humanoide en medio del terreno rojizo del planeta, que los científicos intentan explicar. Una foto sorprendente de la Nasa, perteneciente a su misión de la Mars Explorer Spirit, causó conmoción al revelar una figura inequívocamente humanoide caminando cerca de una rocosa del planeta. Según los escépticos, se trata de una caprichosa formación de las rocas, pero de todos modos la fotografía no deja de asustar y, de camino, despierta la imaginación de lo que podría ser.

De Marte, el planeta misterioso que sueños y pensamientos pudo en nuestras jóvenes mentes, es el enigma que todos queremos desvelar. Si cerramos los ojos y nos imaginamos aquel planeta con océanos, mares, ríos y lagos que, con sus altos volcanes (uno de ellos tiene la friolera de más de 20 Km de altura) y sus bellos paisajes, con una atmósfera como la de la Tierra, en verdad, sería un planeta digno de ser visitado, o, ¿por qué no? para asentar allí la residencia.

¿Qué, el a Marte os haya gustado?

emilio silvera

Totales: 75.184.466

Totales: 75.184.466 Conectados: 41

Conectados: 41