Mar

12

¡Las estrellas! Mucho más que faros luminosos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Descubrir y aprender ~

Clasificado en Descubrir y aprender ~

Comments (0)

Comments (0)

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

Como podemos ver, amigos míos, la vida, como tantas veces vengo diciendo aquí, pulula por todo el Universo en la inmensa familia galáctica compuesta por más de ciento veinticinco mil millones y, de ese descomunal, nos podríamos preguntar: ¿Cuántos mundos situados en las zonas habitables de sus estrellas habrá y, de entre todos esos innumerables mundos, cuántos albergaran la vida?

El Universo es igual en todas sus regiones donde ocurren las mismas cosas y, si es así (que lo es)… ¡La vida andará rondando por miles de millones de planetas que, sin embargo, ¡están tan lejos! que, se nos hacen inalcazables en esta era primitiva de los viajes espaciales y del conocimiento profundo de nuevas tecnologías que nos pudieran posibilitar burlar, el ahora muro infranqueable de la velocidad de la luz.

Las estrellas mueren y se convierten en supernovas que dejan sembrado el interestelar de bellas Nebulosas y, en estas, han sido detectados muchas de las moléculas necesarias para el surgir de la vida. Muchos serán los mundos que estén habitados por formas de vida que, como aquí en la Tierra, será diversa y abundante al haber recorrido los mismos caminos evolutivos que nosotros recorrimos.

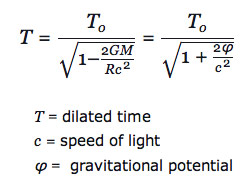

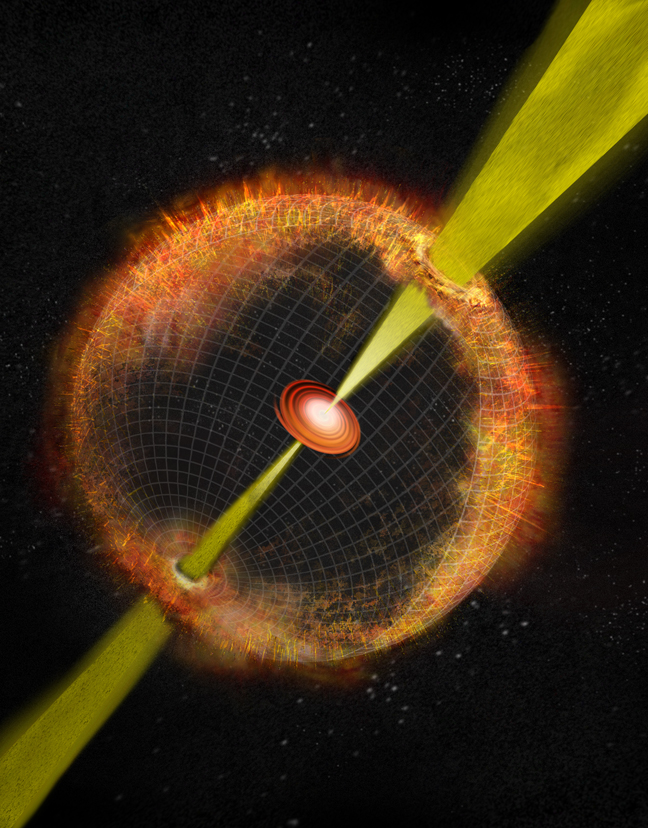

En el universo existen numerosas estrellas cuyas masas son inmensamente mayores que las del Sol, debido a lo cual, la fuerza gravitotoria en su superficie es considerablemente más intensa que sobre la Tierra o sobre el Sol. La enorme cantidad de materia de una de esas estrellas causa una presión inimaginablemente alta en su interior, pero como las tenperaturasd en el interior de las estrellas es también altísima, se produce una presión contraria que evita que la estrella se colapse. La estrella, sin embargo, pierde calor continuamente. Al proncipio de su vida, en las estrellas se producen todo tipo de reacciones nucleares que mantienen su temperatura alta y que incluso la pueden elevar, pero antes o después el combustible nuclear se acaba. Cuanto más pesada sea la estrella, mayor es la presión y la temperatura, y más rápidamente se consume su combustible. La contrapresión disminuye progresivamente y la estrella se va colapsando bajo la presión de su propia masa que emana una fuerza gravitatoria grandiosa. según dismunye el tamaño de la estrella, la fuerza gravitatoria aumenta hasta que finalmente se produce una implosión -un colapso repentino y completo- que no puede ser evitado por más tiempo.

Especialmente intrigante es la apariencia de una estrella en implosión observada desde un de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas de Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica.

Por mucho tiempo que uno espere, si uno está en reposo fuera de la estrella (es decir, en reposo en el de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Este era el mensaje inequívoco de Oppenheimer y Snyder.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Oppenheimer

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

De estrella masiva a Agujero Negro

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

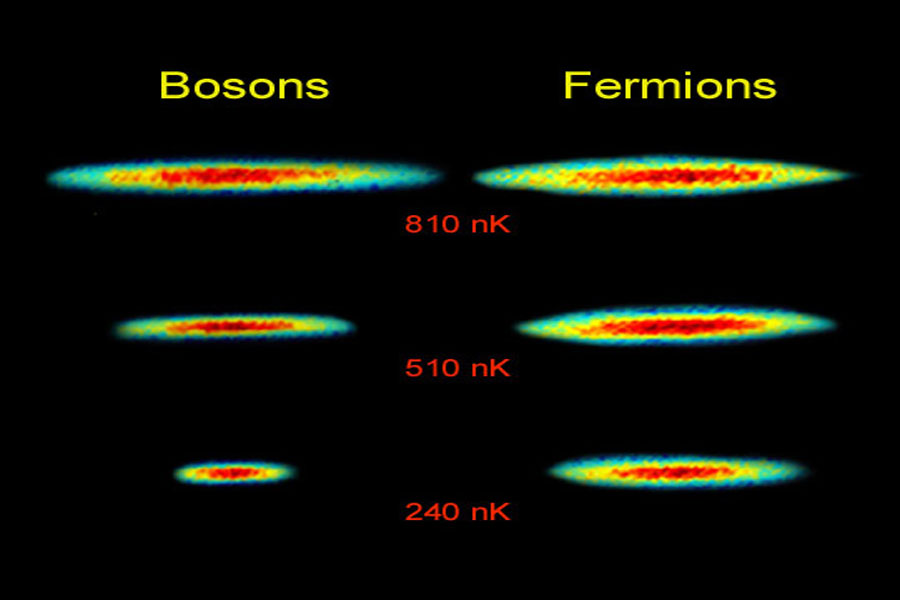

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

Zeta Ophiuchi una estrella fugitiva

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta , en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera 24 kilómetros por segundo, hacia la zona superior izquierda de la imagen.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja qu el WISE puede ver. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las infrarrojas como esta son importantes para arrojar nueva luz sobre la región.

¿Cuál es la razón por la que la materia no se colapsa sobre sí misma? El principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el . Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca en el centro de una Nebulosa planetaria.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra convertida en un agujero negro.

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

Mar

12

EL UNIVERSO, COMETA LLENO DE GALAXIAS

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

http://universounificado.wix.com/gravitacion

Aquí dejamos (arriba), el nuevo enlace al libro de Don José Germán Vidal Palencia, un mexicano enamorado de la Física que os regala sus pensamientos al contar las cosas que ocurren en ese “mundo” infinitesimal de las partículas elementales y las fuerzas que con ellas interaccionan. Él comienza con una sencilla explicación y nos dice:

“Del artículo Electrón, Protón, Origen Descubierto

Según este estudio, sería, en el momento exacto en que se

formaron las partículas elementales configurando el estado

atómico más simple, el hidrógeno, cuando se produjo el Big

Bang. Se descubre además, que nuestro Universo material se

mueve a través del espacio,… ¡Como un cometa lleno de

galaxias!”

El autor nos sigue diciendo:

“Ha sido la explicación necesaria sobre el posible origen de las partículas elementales electrón y protón, lo que llevaría a descubrir cómo serían los procesos por medio de los cuales la energía del Universo iría cambiando a través de los tiempos, hasta que se transformó en átomos. Según este estudio, sería, en el momento exacto en que se formaron las partículas elementales configurando el estado atómico más simple, el hidrógeno, cuando se produjo el Big Bang.

Esta gran explosión se llegaría a producir, porque el Universo evolucionaría hasta llegar un momento en que la energía electromagnética en formación, estaría alcanzando su característica conocida de alta velocidad cuando viaja a través del espacio, ocurriendo paralelo a ello, la formación masiva de átomos de hidrógeno, en un momento exacto, crítico y específico.

Un universo de gas hidrógeno establecido de improviso en un lugar reducido, moviéndose a velocidades cercanas a la de la luz con espacios inmensos a sus alrededores, no podía menos que explotar masivamente, debido a las altas presiones y temperaturas generadas por la acumulación de gases. A partir de ahí, se estaría iniciando la formación de la materia en sus diferentes modalidades atómicas. Faltaría decir, que la evolución del Universo desde entonces sería moviéndose globalmente como lo hace un cometa común, arrastrando consigo todo su contenido galáctico, lo que hasta la fecha debe estar ocurriendo.

Como colofón de esta investigación, al final se describen importantes descubrimientos relacionados con la mecánica de espacio-tiempo y la fuerza de la gravedad, misma que ya puede ser cuantificada gracias a que las magnitudes físicas de nuestra Luna, quedan determinadas como patrón de medida gravitacional y espacio-tiempo en el Universo.”

Ya sabéis, si quereis entrar en ese mundo misterioso de las partículas elementales y de las fuerzas que con ellas interaccionan, estais a tiempo de hacer un fantástico viaje y, simplemente tenéis que pulsar en el enlace http://universounificado.wix.com/gravitacion

¡Que lo disfrutéis!

Mar

11

¿Por qué tienen “lunas” los planetas y, cómo y por qué…?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Naturaleza...El Universo ~

Clasificado en La Naturaleza...El Universo ~

Comments (27)

Comments (27)

A veces nos hemos prguntado por la presencia de esos pequeños mundos alrededor de los planetas y, nos ha llamado la diversidad de características que cada uno tiene y los define pero, sobre todo, nos hemos preguntado por qué están allí. Y, en a los planetas mayores como Júpiter -al menos en relación a sus cuatro lunas mayores- la respuesta que se nos viene a la mente sería:

Júpiter debe poseer estas lunas por idénticas razones por las que el Sol posee sus planetas. En un esquema menor, la situación debió ser la misma. Las grandes lunas de Júpiter son casi tan grandes como planetas, o, al menos, parecen planetas pequeños y, se formarían alrededor del planeta gigante del solar como Mercurio, Venus, la Tierra y Marte lo hicieron alrededor de la estrella que nos alumbra, creciendo a partir de fragmentos de materia planetaria que orbitaban el planeta. De hecho, el propio Júpiter parece un sistema solar en miniatura. La única diferencia está en que Júpiter, al no tener la masa suficiente, no pudio llegar a ser estrella y se quedó en planeta grande.

¿Qué “luna” será esta? ¿Tendrá que ver algo con el planeta Marte?

Es posible que las pequeñas lunas del solar tengan un origen diferente. Incluímos aquí las dos lunas de Marte, Phobos y Deimos -simples trozos de roca en forma de patata, de unos quince kilómetros de diámetro-, lo mismo que docenas de pequeñas lunas que giran alrededor de Júpiter y de los demás planetas gigantes.

Quizá, todas esas pequeñas lunas no son otra cosa que que asteroides capturados y atraídos por las grandes masas de esos planetas que generan una fuerte atracción gravitatoria que los hizo apartarse de sus trayectorias normales quedando “prisioneros” del gigante. Sin embargo, pueden pasar relativamente de planetas como Marte y seguir, tranquilamente su viaje hacia los confines del Universo. El que Marte los pueda “enganchar”, posiblemente sea debido a que Phobos y Deimos pasaron a la distancia precisa: Ni tan cerca como para chocar con el planeta ni tan lejos como para poder evadir la fuerza de Gravedad.

Así que, ya sólo nos queda saber el origen de la luna de la Tierra. No creo que ninguna de esas explicaciones nos sirva ni sean satisfactorias al caso. Nuestra Luna no puede ser un planeta en el “ solar” terrestre, porque la Tierra es demasiado pequeña para poder tener su propia familia de planetas. Y además nuestra Luna está formada por materiales muy diferentes a los de los asteroides, lo que nos dice que no se trata de una captura realizada a partir del Cinturón de Asteroides. De hecho, no se ha dado todavía ninguna explicación suficientemente fiable del origen de la Luna.

A escala cósmica, el misterio de nuestra Luna es de importancia, y además es un misterio provocado. Harold Urey, el padre de la ciencia lunar, estudió el problema y se rindió diciendo:

“Es más simular que la Luna no está en el cielo que explicar cómo ha conseguido estar ahí”

Teorías son muchas y muy variadas pero… Ni la captura de la Luna solitaria y viajera por la la fuerza de gravedad de la Tierra, ni una binaria -la Tierra y la Luna se formaron juntas-, o, la ficción -la Luna es en su origen parte de la Tierra- que, al ser golpeada por un cuerpo de grandes dimensiones, desgajo una parte de su superficie y, junto con otra parte del propio cuerpo invasor (que continuó su camino tan riocamente), quedaron orbitando la Tierra hasta juntarse y formar la Luna.

Hemos podido llegar a descubrir muchas curiosidades que rodean a nuestra Luna y, los modernos telescopios y aparatos de medición nos han dicho que: La Luna se aleja de nosotros describiendo un círculo espiral a razón de 2,5 centímetros cada año y, también hemos llegado a que el día, se alarga un segundo cada cincuenta mil años pero, de dónde vino la Luna… ¡Nadie lo sabe!

Uno de los diez hijos de Darwin llegó a suponer que el ritmo de separación de la Tierra y la Luna, podía dar lugar a imaginar que hace 50 millones de años, la Luna estaba a tan sólo unos 9.000 km de la Tierra en comparación con el promedio de 380.000 km y que el día, tenía una duración de apenas 5 horas.

Como podréis ver, siempre nos gustó especular.

Lo cierto es que hemos llegado a conocer muy bien la Luna y sabemos también, de qué materiales está formada y, en comparación con la Tierra, la Luna presenta una gran pobreza de elementos siderófilos (literalmente, adictos al hierro), que se adhieren con prontitud al hierro. Porque en comparación con la Tierra la Luna tiene una gran escacez de estos componentes; de hecho sólo posee una cuarta parte del hierro que se esperaría en cualquier material rocoso del Sistema solar.

El conocimiento que tenemos de la composición de la Luna se basa, por una parte, en los análisis in situ que realizaron los astronautas del programa Apolo y en los exhaustivos que se han hecho de los casi 400 kilos de rocas lunares que trajeron. Hay que tener en cuenta que los astronautas tocaron únicamente seis puntos de la Luna. Por otra parte, los miles de fotografías de la Luna que se han hecho permiten extrapolar la información obtenida en esos seis muestreos para lograr una aproximación de lo que sería un estudio global, con todos los errores que esta generalización conlleva. Con todo, los geólogos han agrupado los componentes de la Luna en cuatro grandes categorías en función de su origen.

Con la excepción de los elementos implantados por el viento solar (hidrógeno, carbono, nitrógeno y gases nobles), las principales concentraciones de interés, a partir de fuentes extralunares, son las de los elementos denominados siderófilos, como el hierro, el cobre, el níquel, etcétera. La mayor parte de ellos procede de cuerpos meteoríticos que han impactado sobre la superficie lunar, y no es raro que, aunque en algunos casos existan desviaciones de la norma, sus pautas de concentración en el regolito sean similares a las de los meteoritos condríticos. Las concentraciones que podrían tener mayor interés de tecnológica se encontrarían en los restos de meteoritos de grandes dimensiones.

Las concentraciones de elementos mayoritarios son, salvo para el titanio (abundante) y el sodio (muy escaso), similares a las terrestres a excepci´çon del hierro que es sólo una cuarta parte del que encontramos en nuestro planeta. En cuanto a los elementos traza incompatibles, destacan los altos valores en tierras raras de los basaltos de tipo KREEP. Las concentraciones de elementos menores más para su utilización in situ son las del fósforo, cromo y manganeso. El cromo muestra una mayor abundancia en las rocas lunares que en sus homólogas terrestres. El manganeso en las rocas lunares llega al 0,25%.

Lo único cierto es que, lo mismo que le pasó a Harold Urey que estudió muy a fondo el problema, nadie ha sabido hasta el momento dar una explicación creíble del origen de la Luna que, está muy de nosotros pero, sin embargo, no conocemos de dónde vino o cómo pudo llegar aquí. De todo lo demás sobre ella, hemos aprendido con el tiempo y, de la misma manera, esperémos que, algún día, alguien nos diga ¡y nos demuestre! su origen.

Claro que satélites naturales en nuestro propio sistema solar son muchos y, algunos, son fascinantes por lo que en ellos podríamos encontrar.

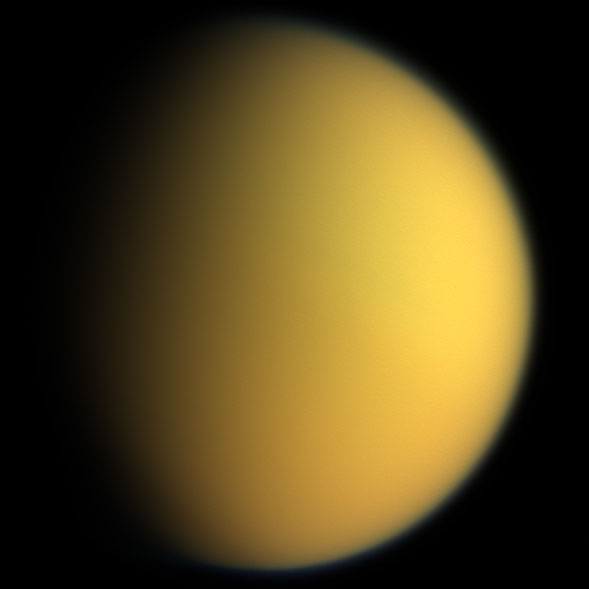

Titán en color natural (sonda Cassini-Huygens 2005)

Titán es el mayor de los satélites de Saturno, siendo el único del Sistema Solar que posee una atmósfera importante. Según los disponibles su atmósfera podría estar compuesta principalmente de nitrógeno, pero hasta un 6% puede ser metano y compuestos complejos de hidrocarburos. En el año 2005, la sonda espacial Cassini-Huygens descendió en paracaídas por la atmósfera de Titán y aterrizó en su helada superficie para algunos de sus secretos.

¡Sigamos soñando con la realidad! En este presente que ya es futuro.

Las sondas espaciales Cassini-Huygens nos han posibilitado para contemplar imágenes del espacio exterior que nunca habríamos imaginado ver. Fijaos en el lejano Sol que alumbra el océano de metano de la Luna Titan de Saturno, mientras que el planeta, contempla asombrado tanto belleza.

emilio silvera

Mar

11

Ya podemos “viajar” desde el núcleo atómico hasta las...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

El propio Rutherford empezó a vislumbrar la respuesta a la que arriba hacemos. Entre 1.906 y 1.908 (hace más de un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos.

En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de por fuerza muchos millones de átomos al atravesar la lámina metálica

Era lógico , pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

Átomo de hidrógeno, núcleo y electrón.

Desde entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es , una partícula subatómica portadora de dos unidades de carga positiva.

Hay un tercer elemento, el litio, cuyo átomo tiene electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el de electrones atómicos dentro de la iónica, pero en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. Como es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó esta idea . Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo , si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema , y ello dio lugar a una interesante historia.

Los tres isótopos naturales del carbono: carbono-12 (6 protones y 6 neutrones), carbono-13 (6 protones y 7 neutrones) y carbono-14 (6 protones y 8 neutrones). En los tres casos es carbono, tiene el aspecto de carbono y se comporta químicamente como carbono, por tener seis protones (y forma parte de nuestro organismo, por ejemplo). Sin embargo, sus propiedades físicas varían. Por ejemplo, mientras que el carbono-12 y el carbono-13 son estables, el carbono-14 es inestable y radioactivo: emite radiación beta, uno de sus neutrones “extras” se transforma así en un protón y el núcleo se convierte en nitrógeno-14 (que tiene 7 protones y 7 neutrones), con el aspecto y las propiedades del nitrógeno (por tener 7 protones). Dado que la mitad de la masa del carbono-14 pasa a ser nitrógeno-14 cada 5.730 años aproximadamente (más o menos lo que llevamos de civilización humana), la presencia de este isótopo natural resulta especialmente útil para la datación precisa de objetos históricos.

Isótopos; construcción de bloques uniformes

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

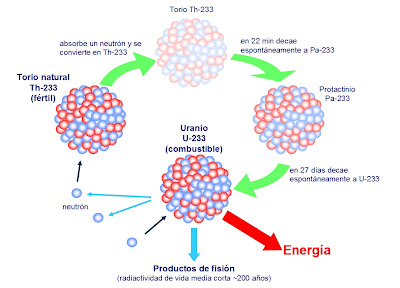

El Uranio 235 que es el único que de manera natural es apto para la fisión nuclear, es escaso, sólo el 7 por 1.000 es uranio 235, el , es uranio 238 que, no es combustible nuclear y, como la madera mojada, no arde. Sin embargo, si se bombardea con neutrones lentos del uranio 235, resulta que se convierte en Plutonio 239 que sí, es combustible nuclear válido. ¡Qué no idearemos para los objetivos!

El Uranio es muy radiactivo y si está enriquecido… ¡Ya sabemos las consecuencias!

Hacia principios de siglo se hizo una de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se extraer de él repetidas veces uranio activo X. Para decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el , emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que durante la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

El Radón, uno de los llamados gases nobles, es incoloro, inodoro e insípido, además de –para nuestro mal- radioactivo. Suele presentarse según el tipo de suelos de determinadas zonas y con la descomposición de uranio, concentrándose en la superficie y siendo “arrastrado” en y por el aire que respiramos, y es en grandes cantidades es un gas perjudicial para la salud… y que anticipa terremotos.

químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como A, B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907 los químicos americanos Herbert Newby McCoy y W. H. Ross descubrieron que el radiotorio (uno entre los varios de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el D, el mismo que el plomo, tanto que a veces era llamado radioplomo. De todo lo cual se infirió que tales sustancias eran en realidad variedades de mismo elemento: el radiotorio, una forma de torio; el radioplomo, un miembro de una familia de plomos; y así sucesivamente.

En 1.913, Soddy esclareció esta idea y le dio más amplitud. Demostró que cuando un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente . Con arreglo a tal norma, el radiotorio descendía en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas uranio X y uranio Y, es decir, que los tres serían variedades del elemento 90. Así mismo, el radio D, el radio B, el torio B y el actinio B compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el de isótopos (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nobel de Química.

El modelo protón–electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula alfa de un núcleo, se reducía en dos unidades la carga positiva de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al atómico, y por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de los elementos. ¡Maravilloso!

¿Cómo se explica que cuando el torio se descompone en radiotorio después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta, y más tarde una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este , aunque en cierto modo, esto no afecta al resultado).

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía el atómico 90, es decir, el mismo de antes.

Así pues, el radiotorio, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de un átomo están sujetas al de sus electrones planetarios, el torio y el radiotorio tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228 respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o número másico. Así, el torio corriente se denomina torio 232, y el radiotorio, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones: plomo 210 (radio D), plomo 214 (radio B), plomo 212 (torio B) y plomo 211 (actinio B).

Se descubrió que la noción de isótopo podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206, la del torio en plomo 208 y la del actinio en plomo 207. cada uno de estos era un isótopo estable y corriente del plomo, pero los tres plomos diferían por su peso atómico.

Mediante un dispositivo inventado por cierto ayudante de J. J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo de masa era 20, y otra con 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo cada diez. Más tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban el elemento en su estado natural. Cada átomo individual tenía un másico entero, pero el promedio de sus masas (el peso atómico) era un número fraccionario.

Aston procedió a que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la proporción de cuatro a uno. En 1.922 se le otorgó el premio Nobel de Química.

Sabiendo todo lo anteriormente explicado, hemos llegado a comprender cómo parte de la Astronomía que estudia las características físicas y químicas de los cuerpos celestes, la astrofísica es la parte más de la astronomía en la actualidad debido a que, al avanzar la física moderna: Efecto Doppler-Fizeau, el efecto Zeeman, las teorías cuánticas y las reacciones termonucleares aplicadas al estudio de los cuerpos celestes han permitido descubrir que el magnético solar, el estudio de las radiaciones estelares y sus procesos de fusión nuclear, y determinar la velocidad radial de las estrellas, etc. La radiación electromagnética de los cuerpos celestes permite realizar análisis de los espectros que nos dicen de qué están hechas las estrellas y los demás cuerpos del espacio interestelar y, de esa manera, hemos ido conociendo la materia y sus secretos que cada vez, van siendo menos.

emilio silvera

Mar

10

¿Cómo será el futuro? Me gustaría conocerlo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en el futuro ~

Clasificado en el futuro ~

Comments (2)

Comments (2)

Lo cierto es que, cada vez que ha salido alguien, que como el precursor de la ciencia ficción, el entrañable Julio Verne, nos hablaba de viajes imposibles y de mundos insólitos, nadie pudo creer, en aquellos momentos, que todas aquellas “fantasías” serían una realidad en el futuro más o menos lejano. Todo lo que él imagino hace tiempo que se hizo realidad y, en algunos casos, aquellas realidades fantásticas, han sido sobrepasadas como podemos contemplar, en nuestras vidas cotidianas. Ingenios espaciales surcan los espacios siderales y, otros, lo hacen por el misterioso oceánico como fue predicho hace ahora más de un siglo.

Ahora, los profetas modernos resultan ser Físicos que nos hablan de sucesos cuánticos que no llegamos a comprender y que, son ¡tan extraños! que nos resultan poco familiares y como venidos de “otro mundo”, aunque en realidad, son fenómenos que ocurren en las profundidades de la materia.

Cada vez van siendo menor los visionarios y más los estudiosos científicos, tanto teóricos como experimentadores que, en todos los , nos llevan, sin que nos demós cuenta, hacia el futuro que, ¡puede ser de tántas maneras! Precisamente por eso, será bueno que nuestras mentes, no se resignen a que estémos confinados aquí, en esta nave espacial que llamamos Tierra y que surca el espacio interestelar a muy buena velocidad aunque no todos sean conscientes de ello.

Ascensor Espacial Erkki Halkka

Los avances que veremos en este mismo siglo, en todos los ámbitos del saber humano, serán sorprendentes y cambiaran nuestras vidas, nuestra Sociedad para el próximo siglo, será ya muy diferentes a ésta que conocemos. Nuestras propias vidas darán un salto cuantitativo y cualitativo en su período de duración y en su calidad de bienestar, podremos vivir un siglo y medio y tendremos menos enfermedades que ahora. las posibles innovaciones tecnológicas en tan dispares como la salud, la economía, la demografía, la energía, la robótica, el espacio, las telecomunicaciones y los transportes, darán un vuelco a nuestra forma de vida y entraremos en otra fase del futuro que viene y del pasado que dejamos atrás.

Estos serán los materiales con los que se construi´ra ese ascensor “imposible” que nos llevará 500 Km lejos de la Tierra, hacia las Estaciones Espaciales con las que se podrá acoplar, sin ninguno de los riesgos que conllevan los transbordadores actuales impulsados por Hidrógeno líquido de combustión, es decir, los pasajeros van montados sobre una bomba volante y, al mejor fallo…

Los ascensores espaciales eran hasta hace muy poco materia de ficción pura, pues ningún material conocido podía soportar la enorme tensión producida por su propio peso. Actualmente ciertos materiales comienzan a parecer viables como materia prima: los expertos en nuevos materiales consideran que teóricamente los nanotubos de carbono pueden soportar la tensión presente en un ascensor espacial.3 Debido a este avance en la resistencia de los nuevos materiales, varias agencias están estudiando la viabilidad de un futuro ascensor espacial:

En Estados Unidos, un ingeniero de la NASA llamado Bradley C. ha elaborado un proyecto preliminar que también están estudiando científicos de la NASA.3 Edwards afirma que ya existe la tecnología necesaria, que se necesitarían 20 años para construirlo y que su costo sería 10 veces menor que el de la Estación Espacial Internacional. El ascensor espacial de Edwards no se parece a los presentes en las obras de ficción, al ser mucho más modesto y a la vez innovador en lo que concierne a su eventual método de construcción.

Este sería el del recorrido y estaría preparado para conectar con bases espaciales. Ahora nos parece un suelo paero hace tiempo ya que se está trabajando, de manera muy seria, en su construcción en un futuro próximo y, desde luego, conseguirlo será un buen logro.

Existen algunos tratamientos con células madre, pero la mayoría todavía se encuentran en una etapa experimental. Investigaciones médicas, anticipan que un día con el uso de la tecnología, derivada de investigaciones para las células madre adultas y embrionarias, se podrá tratar el cáncer, diabetes, heridas en la espina dorsal y daño en los músculos, como también se podrán tratar otras enfermedades. Se les presupone un destino lleno de , que van desde patologías neurodegenerativas, como la enfermedad de Alzheimer o de Parkinson, hasta la fabricación de tejidos y órganos destinados al trasplante, pasando por la diabetes y los trastornos cardíacos.

En un futuro se espera utilizar células madre de cordón umbilical en terapia génica: podemos así tratar enfermedades causadas por la deficiencia o defecto de un determinado gen, introduciendo un determinado gen en la proliferación de las células madre In Vitro y trasplantar tales células en el paciente receptor. El uso de otros tipos de células como portadores de genes buenos en pacientes con enfermedades causadas por deficiencias o déficits genéticos, está siendo testeado a clínico. El primer trasplante de órgano bioartificial en humanos, por su parte, confían en que pueda ver la luz dentro de “unos cinco o diez años”.

La bioinformática o la biotecnología consiste en la aplicación de tecnología informática en el análisis de biológicos . Los principales esfuerzos de investigación en estos incluyen el alineamiento de secuencias , la predicción de genes , predicción de la expresión génica y modelado de la evolución . Algunos ejemplos son el diseño de organismos para producir antibióticos , el desarrollo de vacunas más seguras y nuevos fármacos, los diagnósticos moleculares, las terapias regenerativas y el desarrollo de la ingeniería genética para curar enfermedades a través de la manipulación génica . Veamos algunas de ellas…

Formas nuevas de comunicarse y de adquirir datos

La fusión, energía limpia y barata y, todo, inagotable

Y mientras el mundo está pendiente de la crisis económica internacional, científicos e ingenieros trabajan intensamente en lo que podría ser la solución a los problemas energéticos del futuro. La clave es “fusión”. Al contrario que la tradicional energía nuclear, la energía de fusión es limpia y no contamina y, sus resifuos, es el Helio fácilmente aprovechable. El Proyecto ITER sigue adelante.

La ciencia de la está avanzando a pasos agigantados. Los últimos avances en medicina que se dieron en estos diez o quince años pasados han sido sorprendentes, y podemos esperar un salto muy grande en la medicina dentro de los próximos años.

Algunos descubrimientos todavía no están al alcance de los pacientes, a pesar de que ya se han revelado como grandes avances científicos son necesarios muchos estudios y pruebas antes de que se puedan . No perdamos de vista en este ámbito del saber humano, ni la genética ni las nuevas nanotecnologías, lo que llaman el ojo biónico, la sangre artificial…

Cambiaran nuestras ciudades y nuestras Sociedades serán diferentes, los nuevos conocimientos llegarán también, a la vida cotidiana del habitat humano y a su forma de , de viajar, e, incluso los alimentos del futuro no muy lejano, nos harán recordar con cierta nostalgia, estos que ahora criticamos.

Los modernos celulares irán insertados en el brazo

Cualquier será controlada por mecanimos informáticos

Este programa va más allá de los avances actuales para revelar la tecnología e inventos que nos permitirán ver a través de las paredes, viajar en el tiempo y en el espacio y colonizar planetas distantes. La tecnología inteligente que llevará ayudantes robóticos a los hogares, ciudades enteras a la Internet, y sistemas de entretenimiento que harán los sueños realidad en forma . Sí, virtual hoy pero… ¿Y mañana?

¡Tantas galaxias y estrellas, tantos mundos, tantas maravillas! Si no podemos en un futuro más o menos lejano, visitarlas, ¿Para qué tanta diversidad y tanta belleza? Si están , por algo será y, nosotros, aunque parezca que somos una ínfima cuestión en tan vasto Universo, seguramente serémos, unos privilegiados llamados a realizar grandes cosas. A pesar de nuestras muchas faltas y carencias…¡Lo estamos logrando!

Ya hemos dado los primeros y, nuestros ingenios espaciales tecnológicos robotizados, han realizado para nosotros las tareas que, de momento nos están vedadas pero, demslé tiempo al tiempo y, sin duda alguna, en ese futuro soñado, estaremos en las estrellas y en esos otros mundos que presentimos hermanos de la Tierra y que podrán acoger a la Humanidad que, dentro de otros cincuenta años, llegará a la cifra de 8.000 millones de seres y, nuestro planeta, no puede con todo.

El futuro convive ya con nosotros y, al tenerlo tan cercano, no le atención a esos muchos cambios que con nosotros conviven. Lo cierto es que debe ser así, de otra manera, los cambios tan bruscos que se están produciendo, nos traumatizaría y, sin embargo, lo tomamos -unas veces por comprenderlos y otras por ignorarlos- con toda la normalidad. Esa es la manera en la que se desenvuelve el mundo de nuestra especie.

¿Cómo no podemos predecir que le puede pasar a la Tierra en el futuro?, mejor será ir “preparando las maletas” que, como decía mi padre, un viejo marinero curtido en mil tempestades: ¡”Más vale un por si acaso, que un yo creí”!

emilio silvera

Totales: 72.920.972

Totales: 72.920.972 Conectados: 44

Conectados: 44