Abr

13

La Inmensidad del Universo y, la “pequeñez” de los seres...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. Según toos los datos que tenenos la edad de la Tierra data de hace unos 4.500 millones de años, y, los primeros signos de vida que han podido ser localizados fosilizados en rocas antiguas, tienen unos 3.800 millones de años, es decir, cuando la Tierra era muy joven ya apareció en ella la vida.

El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el Hidrógeno, Nitrógeno, Oxígeno, CARBONO, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

La imagen del cielo de Canarias nos puede servir para mostrar una atmósfera acogedora para la vida

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Es cierto que la realidad puede ser mucho más imaginativa de lo que nosotros podamos imaginar. ¿Habrá mundos con formas de vida basadas en el Silicio? Aunque me cuesta creerlo, tambie´n me cuesta negarlo toda bvez que, la Naturaleza nos ha demostrado, muchas veces ya, que puede realizar cosas que anosotros, nos parecen imposibles y, sin embargo, ahí está el salto cuántico… Por ejemplo.

Los biólogos, por ejemplo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Para nosotros ha pasado mucho tiempo, y, sin embargo, para el Universo ha sido solo un instante

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

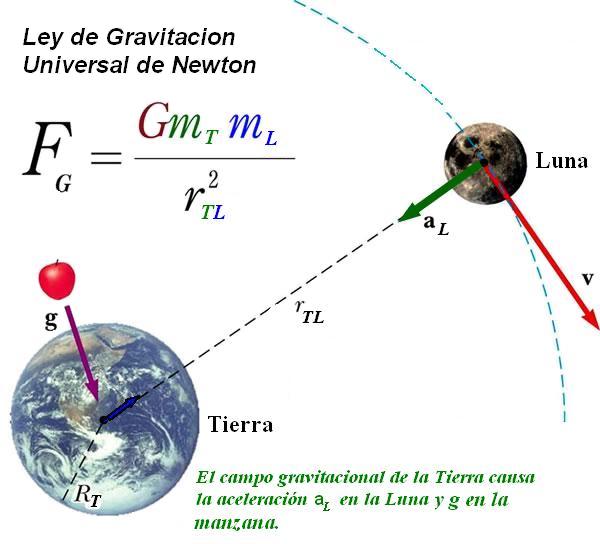

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN PUEDEN VERSE AFECTADOS DE MANERA ADVERSA. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, n se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

Las constantes de la naturaleza ¡son intocables!

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más. De todas las maneras, nsootros somos una parte esencial del universo: La que siente y observa, la que genera ideas y llega a ser consciente de que es, ¡parte del universo que trata de comprender!

emilio silvera

Abr

13

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

Llegará un día en el que, podremos entrar en una inmensa habitación en la que, previa elección de la programación adecuada, todo se transformará en un “mundo fisciticio” que, lo mismo podrá ser una playa luminosa con arena dorada por el un Sol que, una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena miuestra de ese ingenio humano que, de vez en cuando vemos florecer.

Siendo m la masa en reposo del electrón, c la velocidad de la luz, p el operador de momento,  la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

Las primeras observaciones realizadas por Planck | ESA y Axel Mellinger.

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante. Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

Radiación blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

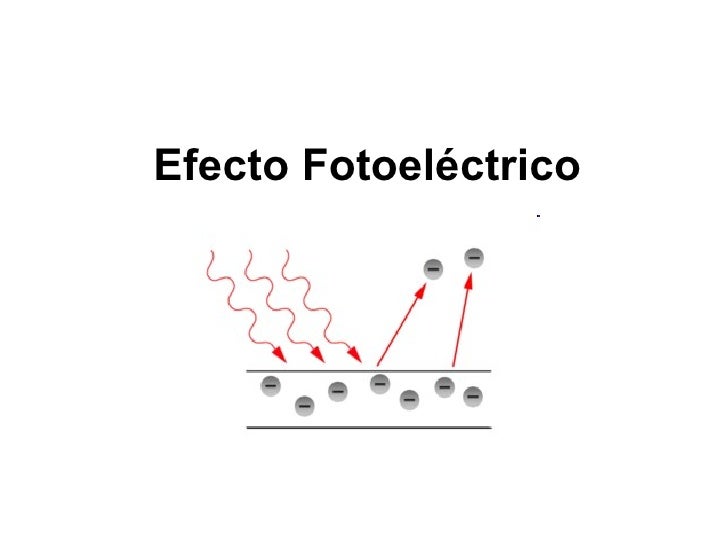

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -“i” (amperios)- será cero. No hay efecto fotoeléctrico.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

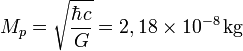

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos  segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construído por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar exitosamente al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están discretizadas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

emilio silvera

Abr

13

¡La Naturaleza! ¿Quién puede pararla?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (1)

Comments (1)

Hay fenómenos de la Naturaleza que, a nivel local, son devastodores y producen estragos materiales acompañados de pérdida de vidas. Hay zonas del mundo que son más propensas a sufrir estos fenómenos y, la gente que tienen allí sus habitats, padecen los efectos de estas imprevistas acciones naturales. Arriba podemos contemplar una vista aérea de Puerto Príncipe. Tras el terremoto de Haití en 2010, la ciudad quedó destruida.

Los terremotos

La inmensa mayoría de los terremotos se originan en los procesos geotectónicos a gran escala que crean, hacen chocar y hunden en las zonas de subducción, las placas oceánicas. No menos del 95 por ciento de todos los terremotos se concentran a lo largo de los bordes de las placas y cerca de nueve décimas partes de éstos se localizan en el cinturón Circum-Pacífico, donde las placas, que son relativamente rápidas, están colisionando o deslizándose contra las placas continentales más pesadas. La mayor parte del resto de terremotos están asociados a los puntos calientes, generalmente señalados por volcanes en actividad.

Cuando el epicentro se produce en la costa, las consecuencias también pueden ser devastadoras al crearse un Tsunami que arrasará la ciudad

En conjunto, los terremotos representan una fracción muy pequeña de la energía liberada por los procesos tectónicos de la Tierra. Desde 1.900, en los mayores terremotos se han liberado anualmente una energía media cercana a los 450 PJ, que no supone más del 0’03 por ciento del flujo total de calor terrestre. La liberación anual de energía sísmica de todos los terremotos que se han medido alcanza unos 300 GW, que sumada a la energía de esfuerzo invertida en deformaciones irreversibles y al calor generado por fricción a lo largo de las fallas, daría un total próximo a 1 TW, lo cual representa solamente un 2’5 por ciento del flujo de calor global.

Pero este recuento total nos dice poco de la liberación de energía y de la potencia de un solo terremoto. Aunque la mayoría son tan débiles que pasan desapercibidos para las personas, cada año se producen terremotos terriblemente destructivos, que durante el siglo XX han causado más víctimas mortales que las inundaciones, ciclones y erupciones volcánicas juntas.

En el sur de la Península Ibérica se encuentra sobre un área de subducción entre la placa Euroasiática y la placa Africana, estando en medio la placa del Mar de Alborán, concentrando el mayor índice de terremotos. Además, concretamente las zonas de mayor riesgo son las provincias de Málaga, Almería, Granada y Murcia aunque también en el Pirineo, entre Navarra y Huesca.

Los terremotos más devastadores de nuestra Península fue el de Lisboa en 1755. No obstante, en España han habido muchos otros seísmos de gran importancia: En Málaga, Arenas del Rey, Sevilla, Jaén, Grabada Y Huelva y, el último de Lorca en 2011.

La energía de estos terremotos se puede calcular a partir de la energía cinética de las ondas sísmicas generadas por la energía liberada en el esfuerzo de la deformación del suelo, pero rara vez se realizan estos cálculos directamente. Lo más frecuente es deducir la energía del terremoto a partir de la medida de su magnitud o de su momento. La medida típica de la magnitud de un terremoto fue establecida por Charles Richter en 1.935, como el logaritmo decimal de la máxima amplitud (en micrómetros) registrada con un sismómetro de tensión estándar (Word-Anderson) a 100 Km de distancia del epicentro del temblor.

Desde que en 1.942, Richter publicó la primera correlación entre la magnitud de energía sísmica liberada en un temblor, su trabajo (como por otra parte, es de lógica) ha sufrido numerosas modificaciones. La conversión sigue la forma estándar log10 E = a + bM, donde E es la energía liberada en forma de ondas sísmicas (en ergios), M es la magnitud de Richter, y a y b son los coeficientes empíricos que varían entre 6’1 – 13’5 y 1’2 – 2 respectivamente. Otras conversiones alternativas permiten obtener la energía liberada a partir del momento del terremoto, que se define como el producto de la rigidez por el desplazamiento medio de la falla y por la superficie media desplazada.

Los mayores terremotos registrados tienen magnitudes Richter comprendidas entre 8 y 8’9, con liberación de energía sísmica entre 48 PJ y 1’41 EJ. Todos hemos oído en alguna ocasión algún comentario sobre el terremoto de San Francisco de 1.906, donde los cálculos basados en tres métodos utilizados en el esfuerzo dieron valores tan distintos como 9’40 y 175 PJ, y con método cinético se obtuvo 2’5 PJ.

Los terremotos, por ser a la vez de breve duración y estar limitados espacialmente, desarrollan potencias y densidades de potencia extraordinariamente altas. La potencia de un temblor de magnitud 8 en la escala de Richter que durase solamente medio minuto, sería de 1’6 PW, y si toda esta potencia estuviera repartida uniformemente en un área de 80 Km de radio, la densidad de potencia sería tan elevada como 80 KW/m2.

Obviamente, tales flujos pueden ser terriblemente destructivos, pero ni las pérdidas de vidas humanas ni los daños materiales que ocasionan los temblores están correlacionados de una manera sencilla con la energía liberada. La densidad de población o de industrias, así como la calidad de las construcciones, constituyen un factor muchísimo más importante para determinar la mortandad o el impacto económico de los mismo. Por ejemplo, el coste en vidas humanas del gran terremoto japonés que en 1.923 arrasó Tokio, donde existía una alta densidad de casas de madera, fue unas 200 veces más elevado que el terremoto de San Francisco de 1.906 en el que se liberó cuatro veces más energía. También aquí salen perdiendo, como siempre, los pobres.

Por otra parte, no podemos olvidar que la superficie del globo terrestre está dominada por las aguas, y los seres humanos viven en la Tierra seca. Sin embargo, vienen los tsunamis. La predicción de estas catástrofes continúa siendo imposible. Se tienen datos, se localizan las zonas de más frecuencia, y conocen las fallas de desgarre y las inversas, los ciclos, etc., pero el conocimiento es aún escaso para prevenir dónde y cuándo se producirán temblores.

Las olas sísmicas que se pueden provocar por terremotos submarinos se propagan durante miles de kilómetros a velocidades de 550 – 720 Km/h, perdiendo en su viaje muy poca potencia. Estas olas, prácticamente invisibles en el mar, se levantan hasta una altura de 10 metros en agua poco profundas y pueden llegar a golpear las costas con intensidades de potencia en superficie vertical de hasta 200 – 500 MW/m2, y con impactos horizontales de intensidad y potencia entre 10 – 100 MW/m2. Son, pues, mucho más potentes que los ciclones tropicales y causan grandes daños tanto materiales como en pérdida de vidas humanas.

La NASA proporcionó esta asombrosa imagen del Volcan Sarychev en las Islas Kuriles, Rusia.

Los volcanes

La unívoca asociación de los volcanes activos con las zonas de subducción de las grandes placas tectónicas permite localizar casi todas las erupciones recientes alrededor del océano Pacífico y, sobre todo, en América central, Sudamérica, Filipinas, Japón y Kamchatka. Una categoría menos común incluye los volcanes asociados a los puntos calientes, donde las placas tectónicas se ven atravesadas por flujos magmáticos procedentes del manto, a la cual pertenecen los volcanes de Hawai y África central.

Las erupciones históricas más conocidas son las Théra, en Grecia (alrededor del 1.500 a. C.), del Vesubio en Italia (79 a. C.) y del Cracatoa (1.883 d. C.) en Indonesia, y el del monte St. Helens en el estado de Washington en 1.980. Éste último caso es la erupción volcánica mejor estudiada hasta la fecha. Se conoce, no solamente el volumen de los depósitos expulsados (0’18 Km3) y de lava (0’5 Km3), sino también un detallado desglose de la energía relacionada con la erupción.

El Servicio Nacional de Geología y Minería de Chile (SERNAGEOMIN) a través de su Observatorio Volcanológico de los Andes del Sur (OVDAS), informó hace instantes que “observaciones realizadas por Los flujos de calor dominan en el proceso: la energía térmica de los productos expulsados, las avalanchas, los chorros de agua, los flujos piroplásticos y las nubes de ceniza, dan un total de 1’66 EJ, cerca de veinte veces la energía cinética total de la erupción.

El 18 de mayo de 1.980, el volcán del monte St. Helens desarrolló, durante nueve horas de erupción, una energía total de 1’7 EJ, lo que equivale a una potencia media de 52 TW, es decir, unas cinco veces el consumo anual mundial de energía en el sector primario en los primeros años noventa. Aún más potentes fueron las de Bezymyannyi, Kamchatka, en 1.956 (3’9 EJ), y la de Sakurajima, Japón, en 1.914 (4’6 EJ). La mayor erupción que tuvo lugar en el siglo XIX fue la del volcán Tambora, en 1.815, que liberó más de 80 EJ de energía (basado en los depósitos de cenizas) que es un orden de magnitud superior a los anteriormente mencionados. Pero incluso la más potente erupción conocida es irrelevante comparada con las sucedieron hace varios vientos de miles de años, y que a su vez, son pequeñas comparadas con las erupciones magmáticas más antiguas.

Entre las cerca de diez calderas jóvenes, enormes cráteres formados en las gigantescas erupciones que se produjeron en el último millón de años, están la de Yellowstone (formada hace 600.000 años, con un diámetro de 70 Km y 1.000 m3 de material expulsado, principalmente piedra pómez y cenizas), y la de Toba (situada en el noroeste de Sumatra, formada hace 75.000 años, de casi 100 Km de anchura y con más de 2.000 m3 de material eyectado).

Un prolongado periodo de erupciones volcánicas que empezó hace 66 millones de años – varios cientos de millones de años de cataclismos que lanzaron a la atmósfera enormes cantidades de cenizas y produjeron dos millones de Km3 de lava, creando la inmensa Decan Traps de la India – parece ser la causa, al menos tan plausible como la colisión de la Tierra con un asteroide, de la masiva extinción que se produjo en la frontera del cretácico y el terciario.

Las cenizas de la erupción del monte St. Helens se elevaron a 20 Kms., y, otras incluso más

Aunque las erupciones históricas han supuesto una considerable pérdida en vidas humanas (cerca de 250.000 desde 1.700), pérdidas materiales enormes y han sido una de las causas más importantes de los cambios climáticos temporales, ninguna de estas consecuencias está claramente correlacionada con la energía total liberada en las mismas. Las emisiones térmicas son casi siempre dominantes, de una a tres órdenes de magnitud mayores que todos los demás flujos de energía, y se dividen en varias clases de flujos diferentes. En algunas erupciones, la mayor parte de la energía térmica liberada está asociada con la emisión de nubes de cenizas que se elevan hasta la estratosfera; así las cenizas de la erupción del monte St. Helens se elevaron a 20 Km, y otras hasta los 30 Km, e incluso más, con cambios atmosféricos locales y espectaculares puestas de Sol y uno o dos años con temperaturas más bajas de las habituales en algunas regiones. En Nueva Inglaterra, por ejemplo, no hubo verano en 1.816.

En otras erupciones, la mayor parte de la energía térmica es transportada por las corrientes piroclásticas. Estas corrientes se forman por explosión y están compuestas por partículas volcánicas, cuyos tamaños varían entre los μm y varios metros, y gases calientes. Alcanzan temperaturas cercanas a los 1.000º C, se propagan a velocidades de hasta 300 m/s y se extienden a distancias de cientos de kilómetros del lugar de origen.

En la erupción del monte Pelée, isla de Martinica en 1.902, estas nubes incandescentes acabaron con la vida de 28.000 personas. En las erupciones de los volcanes hawaianos, el principal flujo de calor está predominantemente asociado a la emisión de lavas que se desplazan lentamente; así, en la erupción del Mauna Loa en 1.950, con una energía liberada de magnitud parecida a la del monte St. Helens, no se produjeron desplazamientos de lodos, avalanchas ni nubes de cenizas.

Siendo espectaculares y a veces devastadoras, las erupciones volcánicas representan una fracción muy pequeña de la energía térmica que mueve la geotectónica terrestre. Suponiendo que en total aflora 1 Km3/año de lava continental y que las erupciones oceánicas contribuyen con otros 4 Km3/año, el calor global perdido anualmente está cerca de los 800 GW, lo cual representa solamente el 2 por ciento del flujo geotérmico terrestre global. La grandiosidad de estos fenómenos está enmascarada en ámbitos de límites regionales, que a nivel global son casi insignificantes.

Mientras que en uno de estos lugares la catástrofe se avecina, en el otro, la vida transcurre dentro de lo cotidiano, nada enturbia el desarrollo normal de nuestras vidas.

Todo esto nos viene a corroborar que, cuando la Naturaleza se despereza… ¡Nosotros a temblar! Son fuerzas y mecanismos de los que se vale el planeta para reciclarse y recomponerse, es la destrucción de la creación, toda vez que, a partir de estas inmensas catástrofes, siempre comienzan y surgen nuevas formas de vida allí donde todo era debastación.

emilio silvera

Totales: 75.354.201

Totales: 75.354.201 Conectados: 58

Conectados: 58