Abr

15

¡Los materiales para la vida!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Alquimia estelar ~

Clasificado en Alquimia estelar ~

Comments (2)

Comments (2)

¡La Física! Cuando se asocia a otras disciplinas ha dado siempre un resultado espectacular y, en el caso de la Astronomía, cuando se juntó con la Física, surgió esa otra disciplina que llamamos Astrofísica. La Astrofísica es esa nueva rama de la Astronomía que estudia los procesos físicos y químicos en los que intervienen los fenómenos astronómicos. La Astrofísica se ocupa de la estructura y evolución estelar (incluyendo la generación y transporte de energía en las estrellas), las propiedades del medio interestelar y sus interacciones en sus sistemas estelares y la estructura y dinámica de los sistemas de estrellas (como cúmulos y galaxias) y sistemas de galaxias. Se sigue con la Cosmología que estudia la naturaleza, el origen y la evolución del universo. Existen varias teorías sobre el origen y evolución del universo (big bang, teoría del estacionario, etc.

Las estrellas, como todo en el Universo, no son inmutables y, con el paso del Tiempo, cambian para convertirse en objetos diferenters de los que, en un principio eran. Por el largo trayecto de sus vidas, transforman los materiales simples en materiales complejos sobre los que se producen procesos biológico-químicos que, en algunos casos, pueden llegar la vida.

Una de las cosas que siempre me han llamado poderosamente la atención, han sido las estrellas y las transformaciones que, dentro de ellas y los procesos que en su interior se procesan, dan lugar a las transiciones de materiales sencillos hacia materiales más complejos y, finalmente, cuando al final de sus vidas expulsan las capas exteriores al espacio interestelar dejando una extensa región del espacio interestelar sembrada de diversas sustancias que, siguiendo los procesos naturales e interacciones con todo lo que en el lugar está presente, da lugar a procesos químicos que transforman esas sustancias primeras en otras más complejas, sustancias orgánicas simples como, hidrocarburos y derivados que, finalmente, llegan a ser los materiales necesarios para que, mediante la química-biológica del espacio, den lugar a moléculas y sustancias que son las propicias para posible el surgir de la vida.

La Química de los Carbohidratos es una parte de la Química Orgánica que ha tenido cierta entidad propia los comienzos del siglo XX, probablemente debido a la importancia química, biológica (inicialmente como sustancias de reserva energética) e industrial (industrias alimentaria y del papel) de estas sustancias. Ya muy avanzada la segunda mitad del siglo XX han ocurrido dos hechos que han potenciado a la Química de Carbohidratos como una de las áreas con más desarrollo dentro de la Química Orgánica actual.

Todos los animales, plantas y microbios están compuestos fundamentalmente, por las denominadas sustancias orgánicas. Sin ellas, la vida no tiene explicación (al menos que sepamos). De manera, en el primer período del origen de la vida tuvieron que formarse dichas sustancias, o sea, surgimiento de la materia prima que más tarde serviría para la formación de los seres vivos.

La característica principal que diferencia a las sustancias orgánicas de las inorgánicas, es que en el contenido de las primeras se encuentra como elemento fundamental el Carbono.

En las sustancias orgánicas, el carbono se combina con otros elementos: hidrógeno y oxígeno (ambos elementos juntos forman agua), nitrógeno ( se encuentra en grandes cantidades en el aire, azufre, fósforo, etc. Las distintas sustancias orgánicas no son más que las diferentes combinaciones de los elementos mencionados, pero en todas ellas, como elemento básico, siempre está el Carbono.

En el primer nivel (abajo) están los productores, o sea las plantas maíz, frijol, papaya, cupesí, mora, yuca, árboles, hierbas, lianas, etc., que producen hojas, frutas, raíces, semillas, que comen varios animales y la gente.

En el segundo nivel están los primeros consumidores, que comen hierbas, hojas (herbívoros) y frutas (frugívoros). Estos primeros consumidores incluyen a insectos hormigas, aves como loros y mamíferos como ratones, urina, chanchos, chivas, vacas.

En el tercer nivel están los segundos consumidores (carnívoros), es decir los que se comen a los animales del segundo nivel: por ejemplo el oso bandera come hormigas, el jausi come insectos y la culebra come ratones.

Nosotros, los humanos, somos omnívoros, es decir comemos de todo: plantas y animales. Algunos de los carnívoros comen, a veces, plantas también, los perros. Otros, como el chancho, comen muchas plantas y a veces también carne.

Las sustancias orgánicas más sencillas y elementales son los llamados hidrocarburos o composiciones donde se combinan el Oxígeno y el Hidrógeno. El petróleo natural y otros derivados suyos, como la gasolina, el keroseno, etc., son mezcolanzas de varios hidrocarburos. Con todas estas sustancias como base, los químicos obtienen sin problemas, por síntesis, gran cantidad de combinados orgánicos, en ocasiones muy complejos y otras veces iguales a los que tomamos directamente los seres vivos, como azúcares, grasas, aceites esenciales y otros. Debemos preguntarnos como llegaron a formarse en nuestro planeta las sustancias orgánicas. Está claro que, para los iniciados en estos temas, la cosa parecer de una complejidad inalcanzable, nada menos que llegar a comprender ¡el origen primario de las sustancias orgánicas!

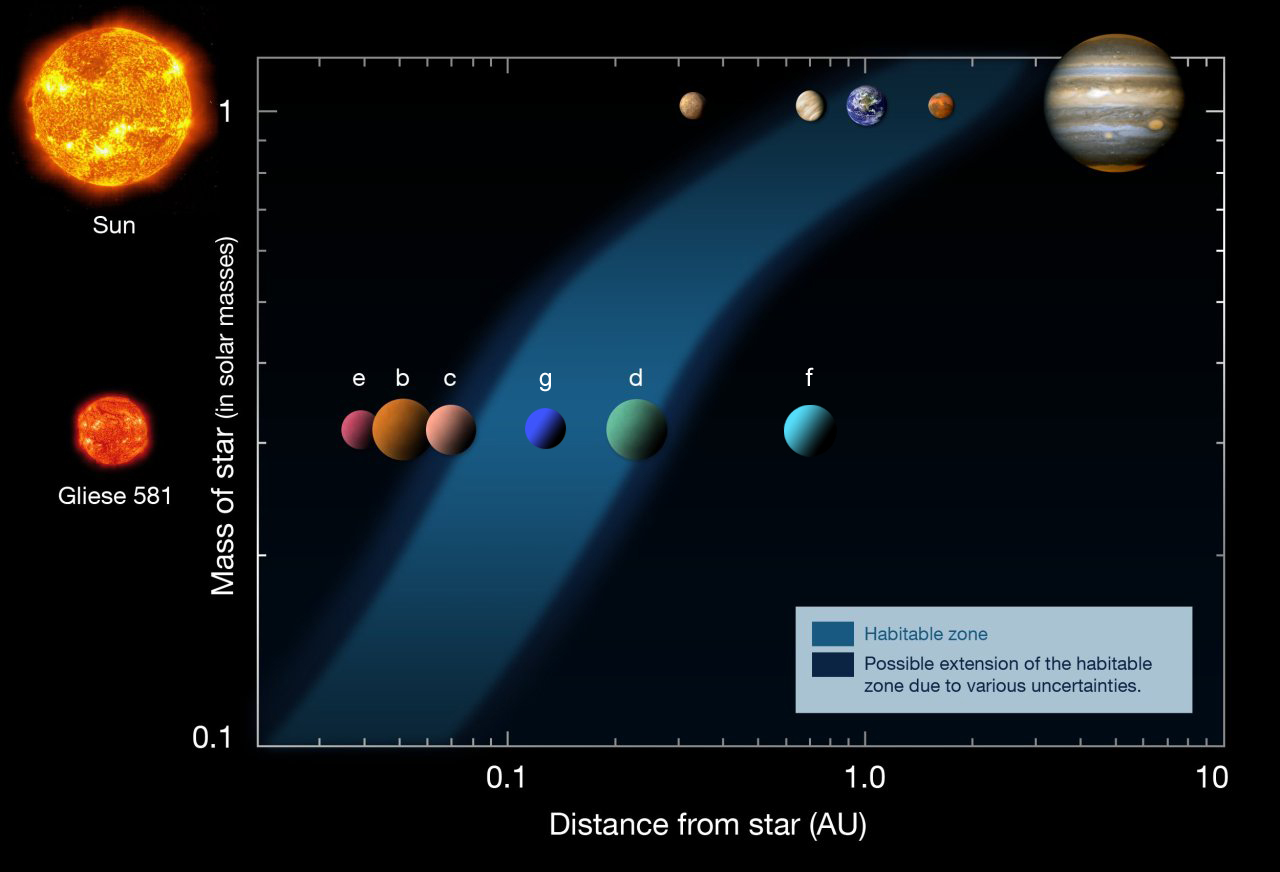

Es nuestro planeta y el único habitado (que se sepa hasta el momento). Está en la ecosfera, un espacio que rodea al Sol y que tiene las condiciones necesarias para que exista vida. Claro que, ¡son tantos los mundos! Cómo vamos a ser nosotros nos únicos que poblemos el Universo? ¡Que despercidicio de espacio!

La observación directa de la Naturaleza que nos rodea nos puede facilitar las respuestas que necesitamos. En realidad, si comprobamos todas las sustancias orgánicas propias de nuestro mundo en relación a los seres vivos podemos ver que, todas, son producidas hoy día en la Tierra por efecto de la función activa y vital de los organismos.

Las plantas verdes absorben el carbono inorgánico del aire, en calidad de anhídrido carbónico, y con la energía de la luz crean, a partir de éste, sustancias orgánicas necesarias para ellas. Los animales, los hongos, también las bacterias y el resto de organismos, los de color verde, se alimentan de animales o vegetales vivos o descomponiendo estos mismos, una vez muertos, pueden proveerse de las sustancias orgánicas que necesitan. Con esto, podemos ver como todo el mundo actual de los seres vivos depende de los dos hechos análogos de fotosíntesis y quimiosíntesis, aplicados en las líneas anteriores.

Incluso las sustancias orgánicas que se encuentran bajo tierra la turba, la hulla o el petróleo, han surgido, básicamente, por efecto de la acción de diferentes organismos que en un tiempo remoto se encontraban en el planeta Tierra y que con el transcurrir de los siglos quedaron ocultos bajo la maciza corteza terrestre.

Todo esto fue causa de que muchos científicos de finales del siglo XIX y principios del XX, afirmaran que era imposible que las sustancias orgánicas produjeran en la Tierra, de natural, solamente mediante un proceso biogenético, o sea, con la única intervención de los organismos. Esta opinión predominante entre los científicos de hace algunas décadas, constituyó un obstáculo considerable para hallar una respuesta a la cuestión del origen de la vida.

Para tratar cuestión era indispensable saber cómo llegaron a constituirse las sustancias orgánicas; pero ocurría que éstas sólo podían ser sintetizadas por organismos vivos. Sin embargo, únicamente podemos llegar a esta síntesis si nuestras observaciones no van más allá de los límites del planeta Tierra. Si traspasamos esa frontera nos encontraremos con que en diferentes cuerpos celestes de nuestra Galaxia se están creando sustancias orgánicas de manera abiogenética, es decir, en un ambiente que excluye cualquier posibilidad de que existan seres orgánicos en aquel lugar.

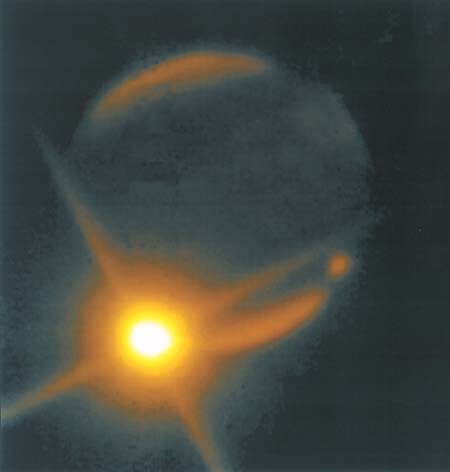

Estrella de carbono (estrella gigante roja)

Con un espectroscopio podemos estudiar la fórmula química de las atmósferas estelares, y en ocasiones casi con la misma exactitud que si tuviéramos alguna muestra de éstas en el Laboratorio. El Carbono, por ejemplo, se manifiesta ya en las atmósferas de las estrellas O, que son las que están a mayor temperatura, y su increíble brillo es lo que las diferencia de los demás astros (Ya os hablé aquí de R. Lepori, la estrella carmesí, o, también conocida como la Gota de Sangre, una estrella de Carbono de increíble belleza).

En la superficie de las estrellas de Carbono existe una temperatura que oscila los 20.000 y los 28.000 grados. Es comprensible, entonces, que en esa situación no pueda prevalecer aún alguna combinación química. La materia está aquí en relativamente simple, como átomos libres disgregados, sueltos como partículas minúsculas que conforman la atmósfera incandescente de estos cuerpos estelares.

La atmósfera de las estrellas tipo B, característica por su luz brillante blanco-azulada y cuya corteza tiene una temperatura que va de 15.000 a 20.000 grados, también tienen vapores incandescentes de carbono. Pero aquí este elemento tampoco puede formar cuerpos químicos compuestos, únicamente existe en atómica, o sea, en forma de pequeñísimas partículas sueltas de materia que se mueven a una velocidad de vértigo.

Sólo la visión espectral de las estrellas Blancas A, en cuya superficie hay una temperatura de unos 12.000º, muestras unas franjas tenues, que indican, por primera vez, la presencia de hidrocarburos –las más primitiva combinaciones químicas de la atmósfera de estas estrellas. Aquí, sin que existan antecedentes, los átomos de dos elementos (el carbono y el hidrógeno) se combinan resultando un cuerpo más perfecto y complejo, una molécula química.

Observando las estrellas más frías, las franjas características de los hidrocarburos son más limpias cuando más baja es la temperatura y adquieren su máxima claridad en las estrellas rojas, en cuya superficie la temperatura nunca es superior a los 4.000º.

Es curioso el resultado obtenido de la medición de Carbono en algunos cuerpos estelares por su temperatura:

- Proción: 8.000º

- Betelgeuse: 2.600º

- Sirio: 11.000º

- Rigel: 20.000º

Como es lógico pensar, las distintas estrellas se encuentran en diferentes períodos de desarrollo. El Carbono se encuentra presente en todas ellas, pero en distintos estados del mismo. Las estrellas más jóvenes, de un color blanco-azulado son a la vez las más calientes. Éstas poseen una temperatura muy elevada, pues sólo en la superficie se alcanzan los 20.000 grados. Así todos los elementos que las componen, incluido el Carbono, están en de átomos, de diminutas partículas sueltas.

Existen estrellas de color amarillo y la temperatura en su superficie oscila los 6.000 y los 8.000º. En estas también encontramos Carbono en diferentes combinaciones.

El Sol, pertenece al grupo de las estrellas amarillas y en la superficie la temperatura es de 6.000º. El Carbono en la atmósfera incandescente del Sol, lo encontramos en de átomo, y además desarrollando diferentes combinaciones: Átomos de Carbono, Hidrógeno y Nitrógeno, Metino, Cianógeno, Dicaerbono, es decir:

- Átomos sueltos de Carbono, Hidrógeno y Nitrógeno.

- Miscibilidad combinada de carbono e hidrógeno (metano)

- Miscibilidad combinada de carbono y nitrógeno (cianógeno); y

- Dos átomos de Carbono en combinación (dicarbono).

En las atmósferas de las estrellas más calientes, el carbono únicamente se manifiesta mediante átomos libres y sueltos. Sin embargo, en el Sol, como sabemos, en parte, se presenta ya, formando combinaciones químicas en de moléculas de hidrocarburo de cianógeno y de dicarbono.

La tormenta interminable de Júpiter y su enrarecida atmósfera

Para hallar las respuestas que estamos buscando en el conocimiento de las sustancias y materiales presentes en los astros y planetas, ya se está realizando un estudio en profundidad de la atmósfera de los grandes planetas del Sistema solar. Y, de momento, dichos estudios han descubierto, por ejemplo, que la atmósfera de Júpiter está formada mayoritariamente por amoníaco y metano. Lo cual hace pensar en la existencia de otros hidrocarburos. Sin embargo, la masa que forma la base de esos hidrocarburos, en Júpiter permanece en líquido o sólido a causa de la abaja temperatura que hay en la superficie del planeta (135 grados bajo cero). En la atmósfera del resto de grandes planetas se manifiestan estas mismas combinaciones.

Ha sido especialmente importante el estudio de los meteoritos, esas “piedras celestes” que caen sobre la Tierra de vez en cuando, y que provienen del espacio interplanetario. Estos han representado para los estudiosos los únicos cuerpos extraterrestres que han podido someter a profundos análisis químico y mineralúrgico, de directa. Sin olvidar, en algunos casos, los posibles fósiles.

Estos meteoritos están compuestos del mismo material que encontramos en la más profunda de la corteza del planeta Tierra y en su núcleo central, tanto por el carácter de los elementos que los componen como por la base de su estructura. Es fácil entender la importancia capital que tiene el estudio de los materiales de estas piedras celestes para resolver la cuestión del origen de las primitivas composiciones durante el período de formación de nuestro planeta que, al fin y al cabo, es la misma que estará presente en la conformación de otros planetas rocosos similares al nuestro, ya que, no lo olvidemos, en todo el universo rigen las mismas leyes y, la mecánica de los mundos y de las estrellas se repiten una y otra vez aquí y allí, a miles de millones de años-luz de nosotros.

Así que, se forman hidrocarburos al contactar los carburos con el agua. Las moléculas de agua contienen oxígeno que, combinado con el metal, forman los hidróxidos metálicos, mientras que el hidrógeno del agua mezclado con el carbono forman los hidrocarburos.

Los hidrocarburos originados en la atmósfera terrestre se mezclaron con las partículas de agua y amoníaco que en ella existían, creando sustancias más complejas. Así, llegaron a hacerse presentes la formación de cuerpos químicos. Moléculas compuestas por partículas de oxígeno, hidrógeno y carbono.

Todo esto desembocó en el saber sobre los Elementos que hoy podemos conocer y, a partir de Mendeléiev (un eminente químico ruso) y otros muchos…se hizo posible que el estudio llegara muy lejos y, al día de hoy, podríamos decir que se conocen todos los elementos naturales y algunos artificiales que, nos llevan a tener unos valiosos de la materia que en el universo está presente y, en parte, de cómo funciona cuando, esas sustancias o átomos, llegan a ligarse los unos con los otros para formar, materiales más complejos que, aparte de los naturales, están los artificiales o transuránicos.

Aquí en la Tierra, las reacciones de hidrocarburos y sus derivados oxigenados más simples con el amoníaco generaron otros cuerpos con distintas combinaciones de átomos de carbono, hidrógeno, oxígeno y nitrógeno (CHON) en su moléculas llamadas paras la vida una vez que, más tarde, por distintos fenómenos de diversos tipos, llegaron las primeras sustancias proteínicas y grasas que, dieron lugar a los aminoácidos, las Proteínas y el ADN y RDN que, finalmente desembocó en eso que llamamos vida y que, evolucionado, ha resultado ser tan complejo y, a veces, en ciertas circunstancias, peligroso: ¡Nosotros!

emilio silvera

Abr

15

¡La Física! Siempre nos sorprende

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Clasificado en El saber: ¡Ese viaje interminable! ~

Comments (0)

Comments (0)

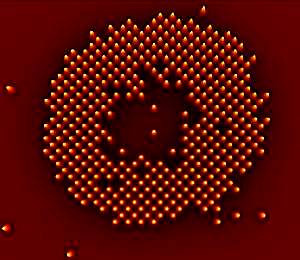

Las veloces computadoras cuánticas hechas con átomos atrapados por haces de luz pueden estar un poco más cerca, gracias a las primeras imágenes de átomos individuales obtenidas en una de estas grillas. Millones de finos hilos que, a la velocidad de la luz transmiten información con una rapidez aluninantes.

La velocidad de las computadoras cuánticas tiene que ver con el hecho de que sus componentes pueden ocupar una serie de estados en lugar de sólo dos como ocurre en una computadora binaria. Ciertos algoritmos especiales podrían explotar estos estados cuánticos para resolver problemas que derrotarían a una computadora convencional.

Una candidata a computadora de este tipoes la llamada “rejilla óptica”, en la que haces de rayos láser estratégicamente ubicados hacen que los átomos ultrafríos se coloquen en forma de grilla, como si fueran huevos en su envase de cartón. Pero antes de que uno pudiera leer o escribir sobre estos átomos, algo indispensable si la rejilla fuera a actuar como una computadora cuántica, haría falta determinar las posiciones exactas de los mismos.

Hace algún tiempo ya que dos equipos de investigadores, uno conducido por Stefan Kuhr del Instituto Max Planck de Óptica Cuántica de Garching, Alemania, y el otro por Markus Greiner de la Universidad de Harvard, han dado el primer paso al obtener imágenes de átomos individuales de rubidio en una rejilla óptica. Este es un reto no sólo porque los átomos son pequeños, sino también porque los fotones de los átomos cercanos pueden interferir unos con otros, enturbiando cualquier patrón.

Para superar esto, los equipos estudiaron el patrón de luz de un solo átomo. Luego crearon un algoritmo capaz de generar una combinación de este patrón a partir de diferentes disposiciones de una grilla de átomos. Cotejando estas simulaciones con el modelo real observado, el algoritmo podía determinar cuál era la distribución de los átomos.

Cada átomo en la grilla actúa como un bit cuántico. Kuhr dice que la rejilla óptica tiene muchos más de estos “qubits” que otros sistemas enfocados en la computación cuántica, por lo que puede ofrecer mayor velocidad.

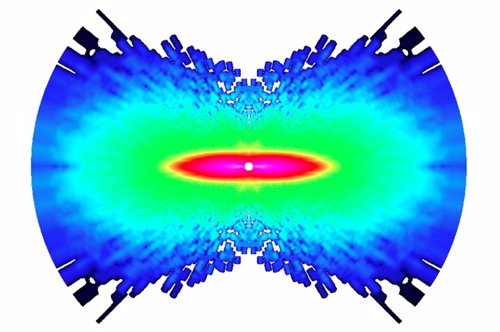

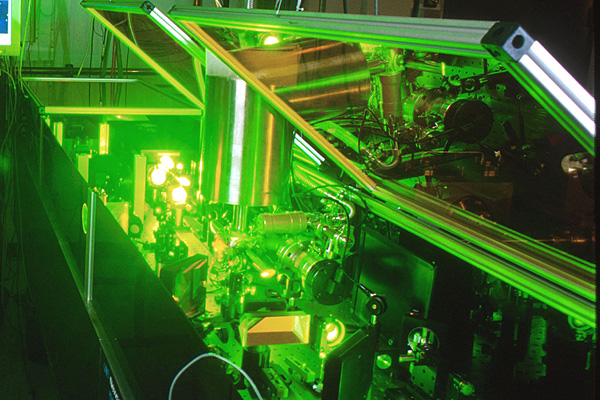

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

El Principio de Incertidumbre de la mecánica cuántica implica que el espacio nunca puede estar realmente vacío. En cambio, las fluctuaciones aleatorias causan el nacimiento de un caldero hirviente de partículas, como electrones y sus homólogos de antimateria, los positrones.

Las llamadas “partículas virtuales” normalmente se aniquilan entre sí demasiado rápido para que las veamos. Pero los físicos predijeron en los años 30 que un campo eléctrico muy fuerte transformaría las partículas virtuales en reales, y entonces las podríamos observar. El campo las impulsa en direcciones opuestas, porque tienen cargas eléctricas que se oponen, y las separándolos de modo que no puede destruirse mutuamente.

Los láseres son ideales para esta tarea, porque su luz posee campos eléctricos fuertes. En 1997, los físicos del Stanford Linear Accelerator Center (SLAC), en Menlo Park, California, utilizaron luz láser para crear unas pocas parejas de electrón-positrón. Ahora, nuevos cálculos indican que los láser de nueva generación serán capaces de crear pares por millones.

Reacción en cadena

En el experimento de SLAC, sólo se creó un par electrón-positrón a la vez. Pero con los láseres más potentes, es probable que se produzca una reacción en cadena. El primer par es acelerado a gran velocidad por el láser, haciendo que emita luz. Esta luz, junto con la del láser, genera aún más pares, dice Alexander Fedotov de la Dirección Nacional de Investigaciones Nucleares de la Universidad de Moscú y sus colegas en un estudio que aparecerá en Physical Review Letters.

“Surgirá una gran cantidad de partículas del vacío”, dice John Kirk del Instituto Max Planck de Física Nuclear en Heidelberg, Alemania, que no participó en el estudio. En los láseres que pueden concentrar cerca de 1026 vatios en un centímetro cuadrado, esta reacción desatada debería convertir de manera eficiente la luz del láser en millones de pares de electrones positrones, calcula el equipo.

Fábrica de antimateria

Ese nivel de intensidad lo podría alcanzar un láser que será construido por el proyecto Extreme Light Infrastructure en Europa. La primera versión del láser se podría construir en 2015, pero podría llevar un año más completar las actualizaciones necesarias para llegar a 1026 vatios por centímetro cuadrado, dice el coautor del estudio Georg Korn del Instituto Max Planck de Óptica Cuántica en Garching , Alemania.

La capacidad de generar una gran cantidad de positrones podría ser útil para los colisionadores de partículas, como el propuesto del Colisionador Lineal Internacional, que impactará electrones y positrones, dice Kirk McDonald de la Universidad de Princeton en Nueva Jersey.

Pero Pisin Chen, de la Universidad Nacional de Taiwan en Taipei, dice que el costo de los poderosos láseres puede hacerse que este método sea más caro que el alternativo. En la actualidad, la manera estándar de crear una gran cantidad de positrones es disparar un haz de electrones de alta energía a una pieza de metal, para producir pares electrón-positrón.

La materia supera a la antimateria en un experimento que imita a la creación del Big Bang

El desequilibrio en el acelerador de partículas de Illinois podría presagiar grandes avances en Física

Menos de una billonésima de segundo después del Big Bang ocurrió otro suceso tumultuoso. Aunque el Cosmos nació con partes iguales de materia y antimateria, que se destruyeron una a la otra al entrar en contacto, de alguna forma la materia comenzó a predominar. Los físicos han descubierto una nueva pista sobre la causa de este desequilibrio fortuito, que condujo a la existencia de galaxias, planetas y personas.

Circunferencia de 4 kilómetros de diámetro del Acelerador de Partículas del Laboratorio Fermi de Chicago

Aquel hallazgo se basó en ocho años de estudio de la desintegración de partículas de vida corta, llamadas mesones B, que se produce durante las colisiones de alta energía en el acelerador de partículas Tevatrón del Laboratorio Fermi (Fermilab), ubicado en Batavia, Illinois. Los científicos del experimento DZero del Tevatrón han descubierto que los mesones B, cuando se desintegran, producen cerca del 1 % más de pares de muones (una versión pesada del electrón) que de pares de sus antipartículas, los antimuones. Los físicos se refieren a este fenómeno como una violación CP.

El desequilibrio, comunicado por en un seminario del Fermilab y publicado en Internet un 18 de mayo, podría servir para entender cómo fue que la materia superó a la antimateria en el Universo. También aumenta las posibilidades de que el LHC, el Gran Colisionador de Hadrones, el acelerador de Suiza que sustituyó al Tevatrón como el colisionador de partículas más poderoso del mundo, encuentre nuevas partículas elementales o una nueva física.

“Aunque pequeño, este excedente del 1 % es 50 veces más grande que la asimetría entre materia y antimateria prevista para la desintegración de mesones B por el modelo estándar de la Física de Partículas”, señaló el portavoz del DZero, Stefan Söldner-Rembold, de la Universidad de Manchester en Inglaterra.

“Se nos puso la piel de gallina”, cuenta Söldner-Rembold acerca del momento en el que él y los 500 colaboradores del DZero comprendieron lo que habían descubierto. “Estábamos muy contentos porque significa que hay una nueva Física más allá del modelo estándar que tiene que estar a nuestro alcance para que la asimetría sea tan grande”.

“Aunque hay una probabilidad de menos del 0,1 % de que los resultados del DZero sean una casualidad, de acuerdo con las normas de la Física de Partículas hay que considerarlos como indicios aún por confirmar”, advierte el teórico Yuval Grossman de la Universidad de Cornell. Söldner-Rembold señala que los hallazgos del DZero son similares a una asimetría en la producción de materia-antimateria descubierta hace un año por otro experimento llevado a cabo en el Tevatrón, el CDF, pero los nuevos resultados tienen una precisión mayor.

“Las teorías que podrían explicar las observaciones del DZero incluyen la supersimetría, que supone que cada partícula elemental en el modelo estándar de la Física de Partículas tiene una superpareja más pesada todavía por descubrir”, explicó la teórica del Fermilab Marcela Carena, que no pertenece al equipo descubridor. “Otras teorías posibles incluyen un modelo en el que la gravedad y otras fuerzas operan en otras dimensiones ocultas, y la noción de que hay una cuarta familia de quarks más allá de las tres generaciones (arriba y abajo, encanto y extraño, y cima y fondo) que sirven como bloques de construcción de los núcleos atómicos y otras partículas.

“En los modelos que consideran una cuarta familia de quarks, la presencia de quarks nuevos y pesados y su interacción con las tres familias conocidas podrían dar lugar a un desequilibrio mayor entre materia y antimateria que el que se encuentra en el modelo estándar”, señaló Carena. Y agregó: “En la teoría de la supersimetría, las superparejas pesadas jugarían un rol similar al de los quarks pesados, creando interacciones que podrían favorecer la producción de materia sobre la antimateria”.

No siempre la física lo puede explicar todo. Sin embargo… ¡Lo va consiguiendo! O, al menos, así lo procura

En la teoría de las dimensiones extra, nuevas partículas mensajeras (portadoras de fuerzas previamente desconocidas) se moverían en dimensiones ocultas. Estas partículas transportadoras podrían alterar la carga y otra propiedad, llamada “sabor”, de las partículas elementales, causando el desequilibrio adicional entre materia y antimateria.

Carena añade:

“Sin embargo, es difícil encontrar una teoría que pueda explicar esta asimetría sin contradecir otros resultados experimentales”.

La materia superó a la antimateria en el comienzo

Ulrich Nierste, de la Universidad de Karlsruhe en Alemania, advierte: “La conexión del resultado del DZero con el excedente de materia que existe en el Universo es vaga. Si bien el hallazgo insinúa una nueva fuente de asimetría en las propiedades del mesón B y de su antipartícula, el proceso que creó más partículas que antipartículas en el Universo primitivo podría involucrar un mecanismo físico muy diferente”.

“Sin embargo”, dice Carena, “hace falta alguna nueva fuente de asimetría para explicar el desequilibrio que hay entre la materia y la antimateria en el Universo, y, por lo tanto, nuestra existencia”. En cualquiera de los modelos propuestos “el Gran Colisionador de Hadrones debería ser la ventana directa para observar nuevas partículas”.

Uno de los experimentos más pequeños del Colisionador, diseñado para estudiar los mesones B, podría confirmar los hallazgos del DZero dentro de uno o dos años”, dice Yuval Grossman. Y agrega: “Los experimentos más grandes podrían entonces buscar nuevas partículas que serían el origen del desequilibrio cósmico entre materia y antimateria y determinar sus masas”.

El experimento Beauty (Belleza) es la matriz de investigación para la creación de antimateria. El choque de dos protones contra otro a la velocidad de la luz, ha tenido como resultado una partícula con 5 veces más masa que sus protones originales. A esa exótica partícula se le ha llamado B+ y está compuesta por un quark b-anti y un quark u. La partícula B+ se desintegra a una altísima velocidad pero le da tiempo a recorrer ¡¡2 mm!! antes de desintegrarse en dos partículas, el mesón J / ? y el Kaon K+. Esta distancia, comparada con los minúsculos tamaños que estamos tratando, es una auténtica pasada. Hemos tenido antimateria pura moviéndose a lo largo de dos extensos milímetros de “nuestro” espacio. Impresionante.

Lo revolucionario sin embargo es que de esta forma, los investigadores habrían demostrado la teoría de Albert Einstein. “Sí, podemos crear masa a partir de energía usando la famosa fórmula de Einstein, E=mc2, dicen los responsables del CERN. Aunque también hay que destacar que la confirmación de que existe la antimateria plantea muchas preguntas de difícil resolución puesto que esa sustancia no existe en nuestro universo. “Ya que la desaparición de antimateria primordial no puede ser explicada por el modelo tradicional, tendremos que comenzar a pensar en algo nuevo”, afirman los investigadores. “Los científicos están evaluando diferentes posibilidades pero, dado que sólo podemos observar un 4% de la energía y materia total del universo, podemos inferir que la respuesta al misterio de la antimateria se encuentra en la parte desconocida del mismo”, concluyen.

Como podéis ver, las preguntas son muchas y, las respuestas, son más escasas. Sin embargo, no dejamos de insistir y buscar con todos medios a nuestro alcance para saber sobre la Naturaleza no ya de la materia y la antimateria, sino sobre los muchos enigmas que tenemos planteados y a los que no sabemos dar una adecuada explicación. Parece que a lo lejos vemos una luz cegadora que nos inyecta la esperanza necesaria para seguir la búsqueda y tratar de llegar al corazón de todos esos secretos que el Universo esconde.

Hay cosas que… más que sorprendentes son… ¡Inclreibles! He leído por ahí que…

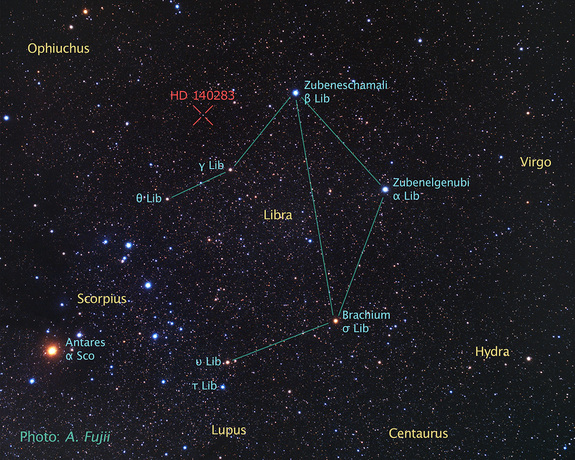

“Un grupo de astrónomos, usando datos del telescopio espacial Hubble, ha determinado la edad de la que es la estrella más vieja cuya edad puede medirse con precisión. El resultado ha sido que la edad de la estrella es de 14.500 ± 800 millones de años, mayor que la estimación de la edad del universo, unos 13.800 millones de años. La estrella en cuestión (HD 140283), también llamada “estrella Matusalén,” una gigante roja que se encuentra a una distancia de 190,1 años luz en la constelación de Libra (distancia medida con precisión mediante la técnica de paralaje). En el año 2000 se dató su edad en 16.000 millones de años. Sin embargo, existen algunas cuestiones que podrían aclarar la extrema edad de esta estrella. Nuevos modelos sobre la difusión de helio en el núcleo indican que la penetración del mismo podría ser mayor de la que se piensa, lo que provocaría un menor ritmo de combustión. También la relación oxígeno-hierro en esta estrella es anómala, demasiado grande, por lo que se cree que futuras observaciones que puedan determinar con mayor grado de precisión la abundancia de oxígeno podrían reducir nuevamente la estimación de la edad de la estrella.”

De todas las maneras, lo cierto es que ninguna estrella puede tener más edad que el Universo donde se creó y, esa verdad me lleva a discurrrir sobre el hecho cierto de que, o los datos de medida están equivocados al existir parámetros no tenidos en cuenta, o, por el contrario, la estrella es una estrella viajera y perdida que escapó de un universo paralelo -más viejo- y se instaló en este nuestro.

Abr

14

El Rincón del Ciudadano

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La maldad Humana ~

Clasificado en La maldad Humana ~

Comments (2)

Comments (2)

La gente corriente, la que trabaja y se sacrifica para que sus hijos puedan estudiar y poder ofrecerles una vivienda digna, un futuro mejor… ¿No entiende lo que pasando! Cada día, con asombro, pueden ver como esos otros ciudadanos que escogieron el camino de la Política en alguno de sus sectores, han estabilizado sus futuros mientras que ellos, los que trabajan por un sueldo mísero -a veces-, cada día lo tienen más negro.

Si miramos hacia atras en el tiempo (no mucho tiempo), podemos ver como, de manera irresponsable, los gobiernos han dilapidado ingentes cantidades de dinero en “proyectos” innecesarios, en ideas peregrinas, en arropar a los suyos mientras desatendían a los más necesitamos. Y, por otra parte, muchos de esos mandamases sin escrúpulos, han aprovechado sus puestos en los Partidos o en el Gobierno, o, en el Sindicato, para hacerse de oro a costa de llevarse lo que no le pertenecía. Y, además, tienen la cara dura de criticar a los demás los que hicieron ellos.

Y, mientras todo eso ocurre, los políticos miran para otra parte, no hablan con claridad de todos estos hechos en los que, pocos han quedado con sus trajes limpios y sin alguna salpicadura. Pero, mientras unos se lo llevan y, no pocas veces, son tapados por sus propios correligionarios que, indignos, guardan la basura dentro de casa para que el olor no les moleste. Pero los desahucios siguen, los que no pagan la hipoteca por haberse quedado sin trabajo contemplan, importentes y con lágrimas en los ojos como sus hijos se ven sin techo.

¿Qué nos está pasando?

Mientras tanto, ellos cada vez son más ricos y nosotros más pobres

Está claro que la Banca debe ser garantía de fortaleza en los paises civilizados pero… ¡Hasta cierto punto! Robar no les debe estar permitido, y, ayudarles a costa de la sabgre de muchos… ¡Tampoco! Ellos, ganan en un año lo que cualquiera de nosotros no ganamos en toda nuestras vidas. ¿Qué han hecho para merecerlo? Creo que no han hecho nada extraordinario, simplemente su trabajo y aprovechar el lugar que les tocó ocupar. ¡Dónde estaba el dinero!

Lo malo de todo esto es que, los que nos representan no lo hacen bien y, a veces, hasta de manera irrespondsable (tenemos cerca el ejemplo), y, sin embargo, en lugar de pagar su responsabilidad subsidiaria del comportamiento indebido, se les premia con puestos que garantizan un retiro que no se merecen y que ellos mismos, se fabricaron.

Así, repartidos por el mundo y aquí mismo, tenenmos a miles de políticos que ganan muchisimo dinero a costa de que otros pasen hambre. Y, lo triste del caso es que, algunos de ellos/ellas, están implicados en casos graves de corrupción que, ni por eso dimiten. Ni tienen dignidiad ni nunca la tuvieron

Si todos forman una masa conexionada por los hilos de la corrupción (políticos, sindicalistas, banqueros y demás grupos del poder)… ¡Apaga y vamonós! La cosa tiene poco arreglo y, sólo una gran revolución podrá poner las cosas en su lugar. Están jugandso con fuego, viven en un mundo ficticio que no es elmundo real del día a día que tantos viven. Muchos se preguntan ¿Qué nos deparará el mañana? La incertidumbre es la que rige sus precarias vidas y, mientras tanto, la mayor preocupación de otros es elegir el lugar de vacaciones o como ampliar la casa.

Los hijos de los demás, por ley Natural, tienen que tener los mismos privilegios que tienen los hijos de los antes nombrados como culpables de lo que está pasando y, sin embargo, no es así. ¡Habrá que cambiar las cosas! ¿Por qué esos hijos del privilegio terminan sus carreras y tienen, de inmediato un gran acomodo bienm remunerado, mientras que los hijos de los demás no tienen tranajo y se tienen que marchar al extranjero con sueldos de miseria?

Y tienen la desfachatez de pedirnos el voto. Los que votan son ellos mismos, es decir, los cientos de miles que agarrados al carro viven a la sombre de esas corrupciones e ilegalidades que todos los días podemos ver y oir en algunos medios (pocos) que se la juegan para contarnos la verdad.

¡Malditos farsantes!

Abr

14

Expresar un sentimiento

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (6)

Comments (6)

Lamentamos desde aquí el desastre ocurrido en Valparaiso (Chile), un pais en el que tenemos tantos amigos. Lamentamos profundamente el daño causado a familias enteras y que, esperamos, sean reparadas por la Aurtoridades de aquel bonito país, toda vez que, lo que la Naturaleza destruye tiene que ser reparado por todos en la medida en la que cada uno pueda y es, el Gobierno del lugar, el garante de que eso sea así.

Estamos con todos los damnificados y sentimos como propio su dolor.

emilio silvera

Abr

14

La maravilla de… ¡los Cuantos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

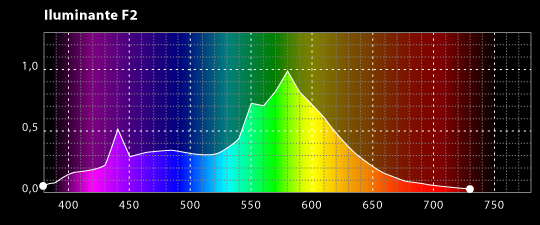

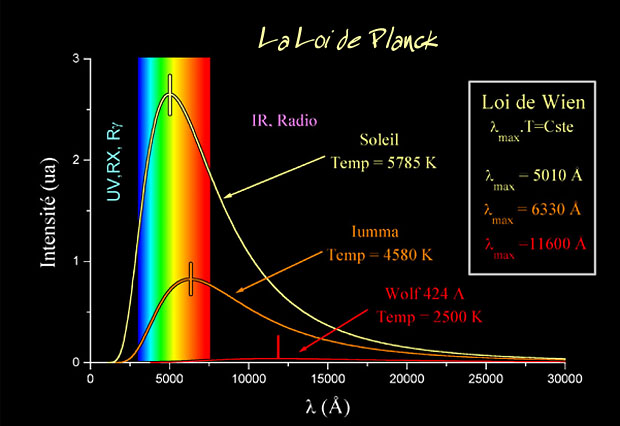

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

Ley de Planck para cuerpos a diferentes temperaturas.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

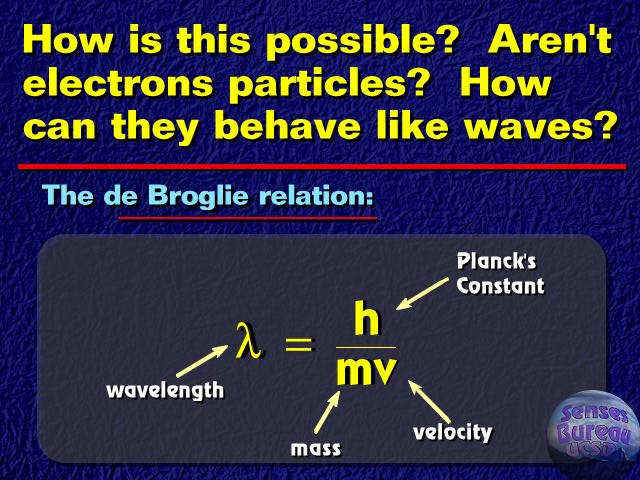

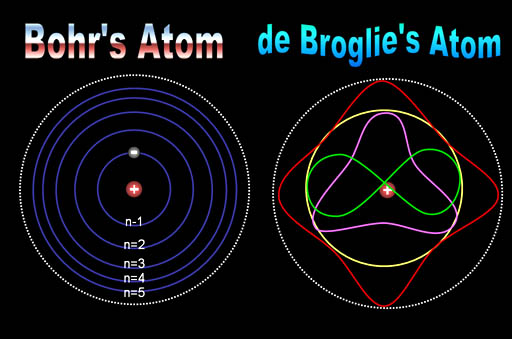

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿qué significan realmente esas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrón puede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿dónde está en realidad?, ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecanocuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro comentario que también, cualquier día de estos, dejaré aquí para todos ustedes.

emilio silvera

Totales: 83.560.487

Totales: 83.560.487 Conectados: 42

Conectados: 42