Jun

22

De lo pequeño a lo grande

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en De lo pequeño a lo grande ~

Clasificado en De lo pequeño a lo grande ~

Comments (0)

Comments (0)

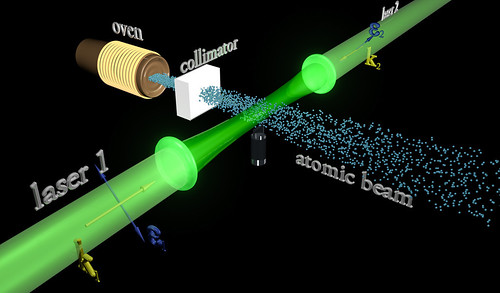

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

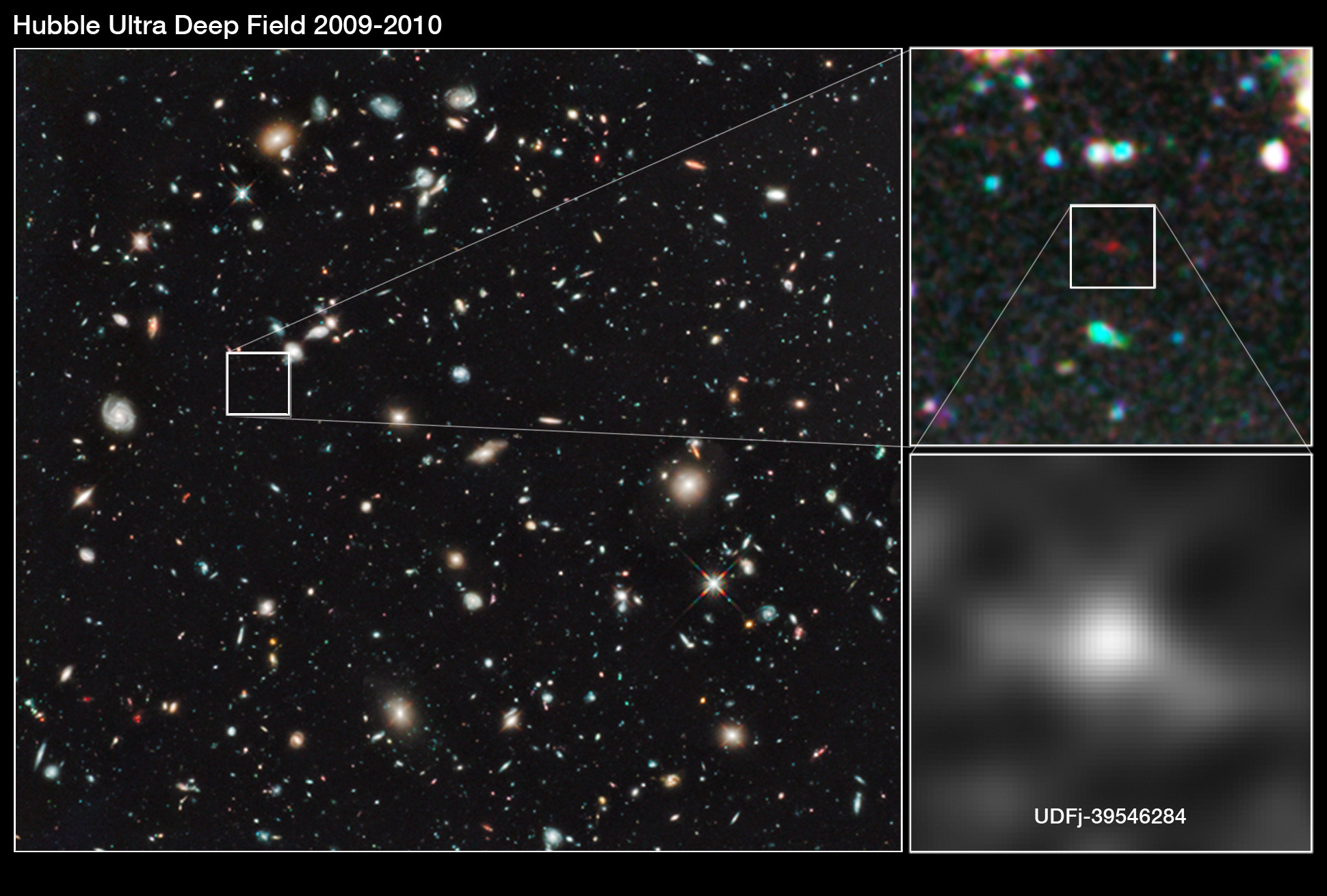

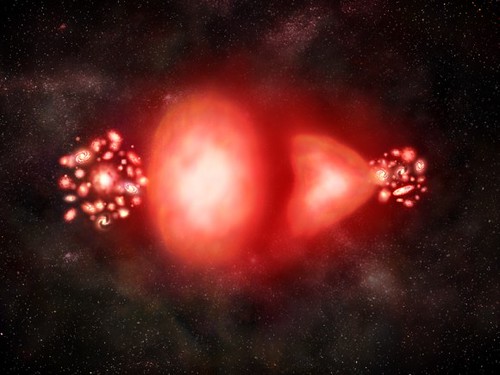

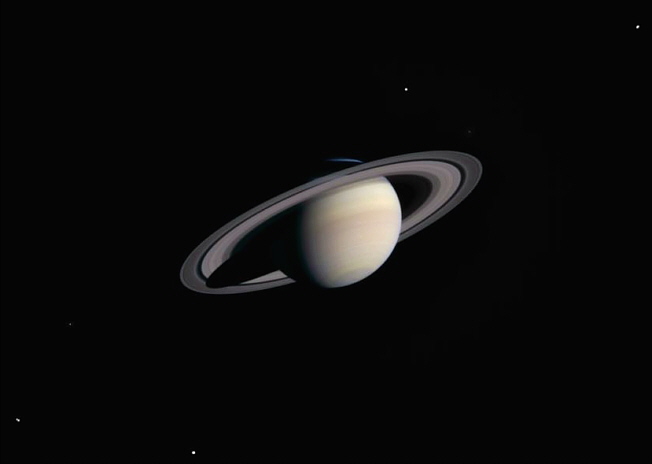

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

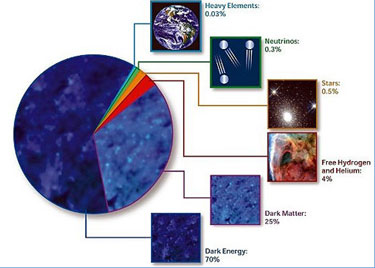

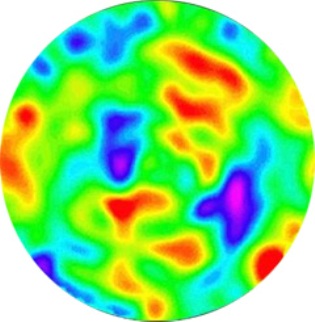

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

emilio silvera

Jun

22

¡El Núcleo Atómico! Y mucho más

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El núclo atómico ~

Clasificado en El núclo atómico ~

Comments (0)

Comments (0)

El propio Rutherford empezó a vislumbrar la respuesta a la pregunta que arriba hacemos. 1.906 y 1.908 (hace más de un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos.

En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina metálica.

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

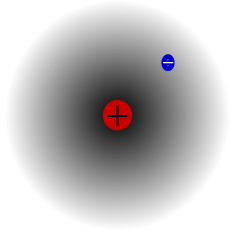

Átomo de hidrógeno, núcleo y electrón.

entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por medio un electrón que participe, actúa un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

Hay un tercer elemento, el litio, cuyo átomo tres electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el de electrones atómicos dentro de la formación iónica, en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó idea general. Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal, y ello dio lugar a una interesante historia.

Los tres isótopos naturales del carbono: carbono-12 (6 protones y 6 neutrones), carbono-13 (6 protones y 7 neutrones) y carbono-14 (6 protones y 8 neutrones). En los tres casos es carbono, tiene el aspecto de carbono y se comporta químicamente como carbono, por tener seis protones (y parte de nuestro organismo, por ejemplo). Sin embargo, sus propiedades físicas varían. Por ejemplo, mientras que el carbono-12 y el carbono-13 son estables, el carbono-14 es inestable y radioactivo: emite radiación beta, uno de sus neutrones “extras” se transforma así en un protón y el núcleo se convierte en nitrógeno-14 (que tiene 7 protones y 7 neutrones), con el aspecto y las propiedades del nitrógeno (por tener 7 protones). Dado que la mitad de la masa del carbono-14 pasa a ser nitrógeno-14 cada 5.730 años aproximadamente (más o menos lo que llevamos de civilización humana), la presencia de este isótopo natural resulta especialmente útil la datación precisa de objetos históricos.

Isótopos; construcción de bloques uniformes

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios ( lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

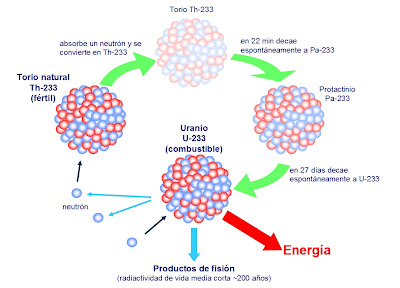

El Uranio 235 que es el único que de manera natural es apto para la fisión nuclear, es escaso, sólo el 7 por 1.000 es uranio 235, el resto, es uranio 238 que, no es combustible nuclear y, la madera mojada, no arde. Sin embargo, si se bombardea con neutrones lentos del uranio 235, resulta que se convierte en Plutonio 239 que sí, es combustible nuclear válido. ¡Qué no idearemos para conseguir los objetivos!

El Uranio es muy radiactivo y si está enriquecido… ¡Ya sabemos las consecuencias!

principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra , Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

El Radón, uno de los llamados gases nobles, es incoloro, inodoro e insípido, además de – nuestro mal- radioactivo. Suele presentarse según el tipo de suelos de determinadas zonas y con la descomposición de uranio, concentrándose en la superficie y siendo “arrastrado” en y por el aire que respiramos, y es en grandes cantidades es un gas perjudicial para la salud… y que anticipa terremotos.

Varios químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

En total se identificaron unos cuarenta miembros de esas series, y uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

En realidad, los químicos descubrieron que aunque las sustancias diferían sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907 los químicos americanos Herbert Newby McCoy y W. H. Ross descubrieron que el radiotorio (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el radio D, el mismo que el plomo, tanto que a veces era llamado radioplomo. De todo lo cual se infirió que tales sustancias eran en realidad variedades de mismo elemento: el radiotorio, una de torio; el radioplomo, un miembro de una familia de plomos; y así sucesivamente.

En 1.913, Soddy esclareció idea y le dio más amplitud. Demostró que cuando un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el radiotorio descendía en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas uranio X y uranio Y, es decir, que los tres serían variedades del elemento 90. Así mismo, el radio D, el radio B, el torio B y el actinio B compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el de isótopos (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nobel de Química.

El modelo protón–electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula alfa de un núcleo, se reducía en dos unidades la carga positiva de dicho núcleo, exactamente lo que necesitaba para dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al atómico, y por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de los elementos. ¡Maravilloso!

¿Cómo se explica que cuando el torio se descompone en radiotorio después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en proceso el átomo de torio pierde una partícula alfa, luego una partícula beta, y más tarde una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque en cierto modo, esto no afecta al resultado).

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía el atómico 90, es decir, el mismo de antes.

Así pues, el radiotorio, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de un átomo están sujetas al número de sus electrones planetarios, el torio y el radiotorio tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228 respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o número másico. Así, el torio corriente se denomina torio 232, y el radiotorio, torio 228. Los isótopos radiactivos del plomo se distinguen por estas denominaciones: plomo 210 (radio D), plomo 214 (radio B), plomo 212 (torio B) y plomo 211 (actinio B).

Se descubrió que la noción de isótopo podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206, la del torio en plomo 208 y la del actinio en plomo 207. cada uno de estos era un isótopo estable y corriente del plomo, pero los tres plomos diferían por su peso atómico.

Mediante un dispositivo inventado por cierto ayudante de J. J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo de masa era 20, y otra con 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo cada diez. Más tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas (el peso atómico) era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la proporción de cuatro a uno. En 1.922 se le otorgó el premio Nobel de Química.

Sabiendo todo lo anteriormente explicado, hemos llegado a comprender cómo de la Astronomía que estudia las características físicas y químicas de los cuerpos celestes, la astrofísica es la parte más importante de la astronomía en la actualidad debido a que, al avanzar la física moderna: Efecto Doppler-Fizeau, el efecto Zeeman, las teorías cuánticas y las reacciones termonucleares aplicadas al estudio de los cuerpos celestes han permitido que el campo magnético solar, el estudio de las radiaciones estelares y sus procesos de fusión nuclear, y determinar la velocidad radial de las estrellas, etc . radiación electromagnética de los cuerpos celestes permite realizar análisis de los espectros que nos dicen de qué están hechas las estrellas y los demás cuerpos del espacio interestelar y, de esa manera, hemos ido conociendo la materia y sus secretos que, cada vez, van siendo menos.

emilio silvera

Jun

21

Los núcleos, la masa, la energía…¡La Luz!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¿Qué es en realidad la Luz? ~

Clasificado en ¿Qué es en realidad la Luz? ~

Comments (0)

Comments (0)

La partícula emitida por un núcleo radiactivo, por lo general lleva una considerable cantidad de energía. Y, ¿de dónde procede esa energía? Es el resultado de la conversión en energía de una pequeña Los físicos se vieron partícula beta emitida en una desintegración del núcleo no alberga energía suficiente electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (corregido por muy pocos electrones) era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era erróneo en la emisión de partículas beta?, ¿qué había sucedido con la energía perdida?

En 1.922, Lise Maitner se hizo por primera vez partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas; no poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

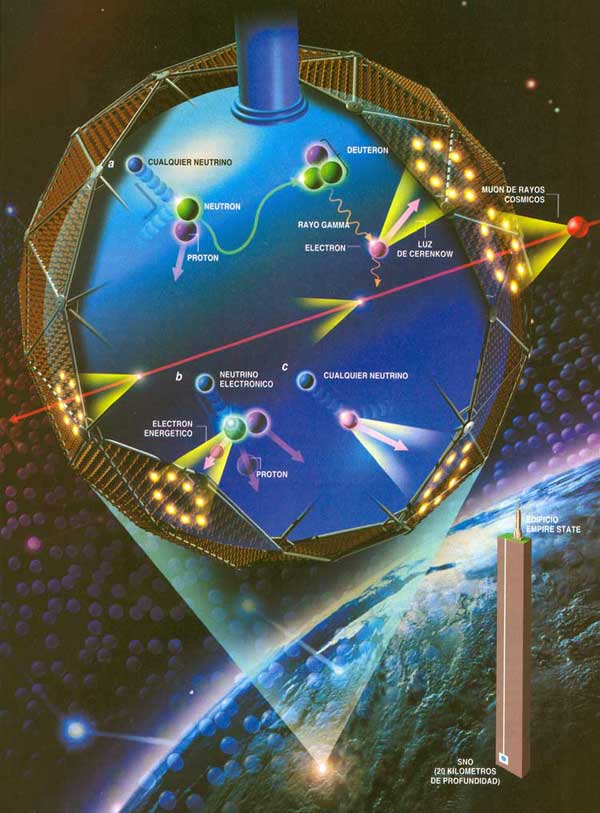

Habitualmente aceptamos que la física es la ciencia que estudia la estructura y propiedades de la materia y la energía, las formas de existencia de las mismas en el espacio y el tiempo, así como las leyes de rigen sus interacciones. En este definición no hay limitaciones precisas Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y neutrón y al saberse que se desintegraba en un protón y liberaba un electrón que, Fermi dio a esta partícula putativa el El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado en otra página de este trabajo, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiplos de una mitad, según la dirección del giro. protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra neutrino viene a solventar la cuestión. Supongamos que la rotación del neutrón sea +½, y admitamos protón sea +½ y la del electrón -½, neutrino una rotación de +½ y la balanza quedará desequilibrada.

+½ (n) = +½ (p) – ½ (e) + ½ (neutrino)

En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

neutrón) ha formado dos partículas (el protón y el electrón), y si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversión de un protón en un neutrón. Así pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto

Impresionante vista de la Vía Láctea Es importante conservar esas leyes puesto que parece estar presentes en toda clase de relaciones nucleares que no impliques electrones o positrones, y sería muy útil si protón–neutrón son las relacionadas con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8% de su energía. Pero eso sería meternos en otra historia y, por mi Desde que puedo recordar, he sido un amante de la física. Me asombran cuestiones

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial; dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo creo que la luz es simplemente una Está claro que los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) Cuando la luz entra en un cristal o en alguna sustancia transparente, de una

¿Nos suplirán un día? Seguro que en el futuro, serán otros los que hagan experimentos con la luz y busquen su verdadera naturaleza

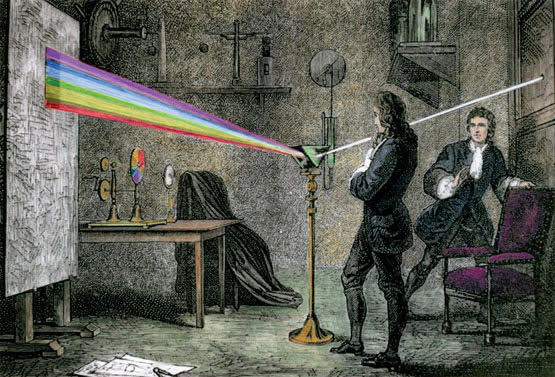

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta de las

Newton dedujo que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo verde, azul y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa espectro o fantasma). Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades. Le surgieron y se planteó algunas inquietantes cuestiones: ¿por qué se refractaban las partículas de luz verde más que las de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbarse mutuamente, es decir, sin que se produjeran colisiones En 1.678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar las diversas difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a

Lo que permitía al ojo distinguir los colores eran esas diferencias Pero la teoría de Huyghens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos, ni por qué proyectaban sombras recortadas, ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía

Con el éxito de Newton de su ley de la Gravitación Universal, no es extraño que afirmara de Newton se opuso violentamente a la naturaleza ondulatoria de la luz, ya que no veía cómo se podía explicar con ella la propagación rectilínea de la misma. Por otro lado estaba Christian Huygens, 13 Newton que defendía la naturaleza ondulatoria con algunas ventajas.

Ambas teorías explicaban perfectamente la reflexión y refracción de la luz. Newton y a la poca habilidad de Huygens

Aproximadamente durante un siglo, contendieron Newton fue, con mucho, la más popular, en parte porque la respaldó el famoso Sería fácil explicarlo mediante la teoría ondulatoria; la banda luminosa representaba el refuerzo prestado por las ondas de un rayo a las ondas del otro, dicho de otra manera, entraban “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra

Considerando la anchura de las bandas y la distancia entre los dos orificios por lo que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o de los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Ángstrom; esta unidad, denominada igualmente Ángstrom (Å) en honor a su autor, es la cienmillonésima parte de un centímetro. Así pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Å, y la de la luz violeta a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si este no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior al de una onda luminosa, y por tanto, la luz Un físico francés, Agustin-Jean Fresnel, fue quien demostró por vez primera en 1.818 que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de difracción” actúan como una serie de minúsculos obstáculos, que se refuerzan

La mano del Universo juguetea con unos puntos luminosos que quieren llegar a ser cegadores…Son nuestras Mentes, productos de la evolución del Universo que, a partir de la materia inerte, ha podido alcanzar el estadio bio-químico de la consciencia y, al ser conscientes, hemos podido Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso, los rayos espectrales. El físico americano Henry Augustus Rowland ideó la reja cóncava y desarrolló técnicas Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando No sólo se aceptó la existencia de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor.

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuales aportaba una raya cuya longitud de inda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, En 1.960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de la longitud. Entonces se reestableció la longitud del metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumentó mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

emilio silvera

Totales: 74.124.298

Totales: 74.124.298 Conectados: 83

Conectados: 83

![[I] Las 7 Maravillas del Mundo Antiguo](http://lh4.ggpht.com/_0_XWhqXM2VQ/S5KzPr5Ph7I/AAAAAAAAJs8/tYOgGOOTr7w/1692387141_5f1bab9da9_thumb4.jpg?imgmax=800)