Jul

15

Curiosidades

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo cambiante ~

Clasificado en El Universo cambiante ~

Comments (5)

Comments (5)

Nebulosa de la Araña Roja.

También conocida como (NGC 6537), es una nebulosa planetaria situada en la constelación de Sagitario. Esta nebulosa tiene clara forma diferenciada en dos lóbulos, esto puede ser debido a que la enana blanca que está en el centro de la nebulosa puede tener una compañera binaria o también otra causa podría ser debida a campos magnéticos de la zona. La enana blanca produce un poderoso y fuerte y caliente viento estelar (10.000 K) y sopla a una velocidad de 300 km/s, lo que ha generado su característica y curiosa forma. La enana blanca está rodeada de una nube de polvo, lo que hace que sus características físicas sean difícilmente determinables y podríamos estar ante una de las enanas blancas más calientes que se conocen en la actualidad, con temperaturas superiores a los 250.000 K. La Nebulosa de la Araña Roja se encuentra a unos 3.000 – 8.000 años luz de la Tierra, aunque otras estimaciones reducen esta distancia a 1.900 años luz.

Nebulosa Boomerang

Es una protonebulosa planetaria, ya que esa una estrella o grupo de estrellas que aún están evolucionando hacia la fase de nebulosa planetaria y que se encuentra en la constelación de Centaurus a 5.000 años luz de la Tierra. La imagen de mucha mayor resolución obtenida con el Telescopio Espacial Hubble, la muestra como una nebulosa bipolar, por lo que también ha recibido el nombre de Nebulosa de la Pajarita. Esta nebulosa destaca porque su temperatura es tan sólo un grado superior al cero absoluto, es el único objeto conocido con una temperatura inferior a la radiación de fondo de microondas. La nebulosa (con un radio de un año luz) se formó por el gas expulsado por su estrella central, dicha estrella ha estado perdiendo materia a razón de una milésima de la masa solar cada año durante al menos 1.500 años. Ello supone un ritmo de pérdida de masa entre 10 y 100 veces mayor que en otros objetos similares. El gas se expande a una gran velocidad de 164 km/s, lo que causa la baja temperatura. Asimismo existe una capa interna que se expande a 35 km/s, que puede ser el resultado de la expulsión de una envoltura común por parte de una estrella binaria central.

Nebulosa de la Burbuja

La Nebulosa de la Burbuja, también conocida como NGC 7635, fue descubierta en 1787 por William Herschel, situada en la constelación de Cassiopeia, cerca del cúmulo abierto M52, a unos 7.100 – 11.000 años luz de la Tierra según diversas fuentes. Nos encontramos ante una nebulosa de emisión de unos 10 años luz de diámetro que hace honor al nombre por el que se la conoce ya que su forma es prácticamente esférica aunque no uniforme, ello es debido al choque del viento estelar de su gran y masiva estrella central con el denso material circundante que la rodea. La Nebulosa de la Burbuja está situada en las cercanías de una gran nube molecular (zona en las que existe hidrógeno molecular, H2) que contiene la expansión de la “burbuja” pero que a su vez es rechazada por las radiaciones a alta temperatura que emite la estrella situada en el núcleo de la nebulosa, de esta forma, dicha radiación hace calentar la regiones densas de la nube molecular, haciéndola brillar. Esta nebulosa puede observarse de forma amateur, si bien es complicado debido a la presencia de una estrella localizada a su Oeste. Las mejores imágenes que se han obtenido de la Nebulosa de la Burbuja han sido obtenidas una vez más por el Telescopio Espacial Hubble.

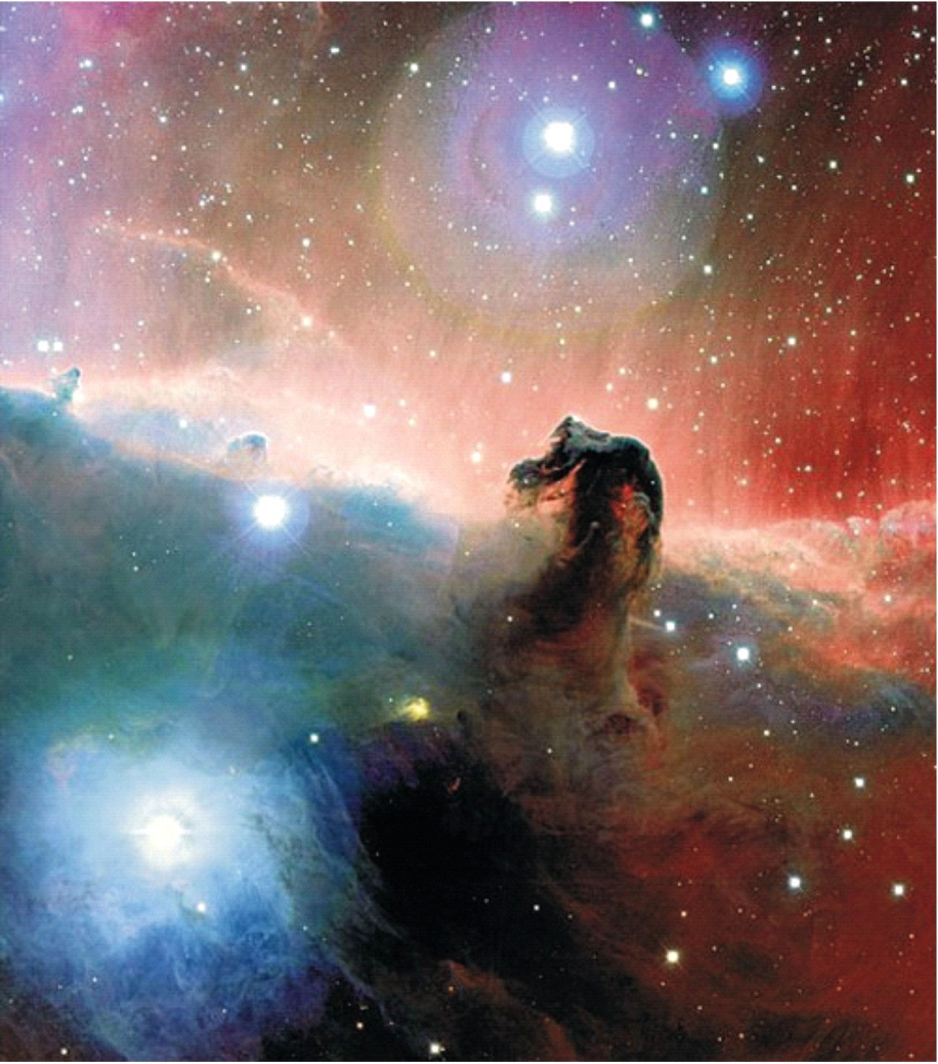

Nebulosa Cabeza de Caballo.

También conocida como Barnard 33, es una nebulosa de absorción, muy densa, fría y oscura ya que no está relacionada con ninguna estrella cercana por lo que el polvo y gas interestelar que la forma, no recibe ningún tipo de energía. Este tipo de nebulosas son más difíciles de detectar por aparatos humanos y son visibles mediante contraste. Fue descubierta en 1888 por Williamina Fleming y catalogada por primera vez en 1919 por el astrónomo estadounidense Edward Emerson Barnard. La Nebulosa Cabeza de Caballo mide aproximadamente 3,5 años luz de ancho y está situada en el extremo izquierdo del Cinturón de Orión y al Sur de Alnitak (estrella supergigante azul). La nebulosa forma parte del Complejo de Nubes Moleculares de Orión, situado a unos 1.500 años luz de distancia de la Tierra. Cabeza de Caballo ha sido una de las nebulosas más ampliamente difundidas debido a su curiosa forma y a la belleza de las imágenes obtenidas de ella en las que aparecen multitud de resplandores rojizos en su entorno debidos a la ionización del hidrógeno que rodea a la nebulosa por parte de la estrella Sigma Orionis y azulados por la presencia de una nebulosa de reflexión conocida como NGC 2023. Con el paso del tiempo (miles de años), Cabeza de Caballo irá perdiendo su forma característica por la expansión de los gases y los movimientos internos de la propia nube, alterando así su apariencia tal como hoy la conocemos.

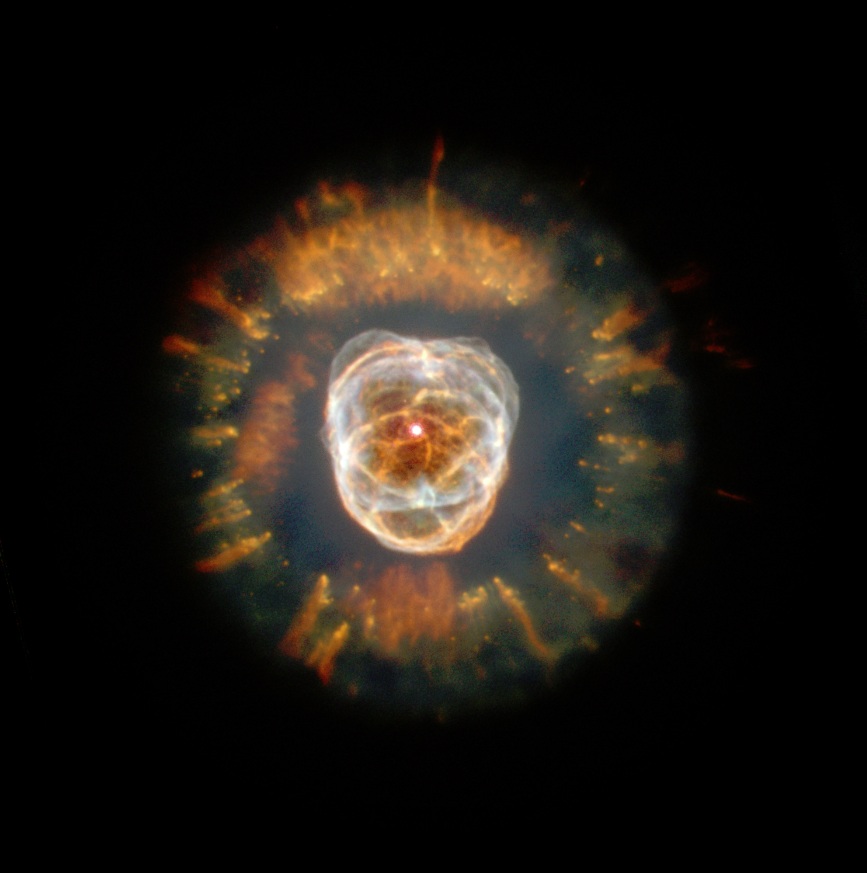

Nebulosa Cara de Payaso.

También conocida como Nebulosa Esquimal (NGC 2392), es una nebulosa planetaria de la constelación de Géminis que se encuentra alejada de la Tierra a una distancia de entre 3.000 – 5.000 años luz. Fue descubierta el 17 de Enero de 1787 por William Herschel. Debe su nombre a su peculiar y curiosa forma, ya que recuerda de cierta manera a la cara de una persona rodeada con una capucha, mientras que sus brillantes colores dan la sensación de ser el maquillaje usado por los payasos del circo. Se estima que tiene una edad de 10.000 años, estando compuesta por dos lóbulos elípticos de materia saliendo de la estrella moribunda que se encuentra en el centro de la nebulosa. Desde nuestra perspectiva, unos de los lóbulos está delante del otro. La estrella central (similar a nuestro Sol pero en fase de gigante roja), está rodeada por el denso gas que compone las capas exteriores de dicha estrella y que es arrastrado a una velocidad de 115.000 km/h, lo que impide que el viento estelar arrastre dicho material a lo largo del ecuador de la nebulosa. Los filamentos internos visibles son expulsados por un fuerte viento de partículas de la estrella central. El disco externo contiene inusuales y largos filamentos de varios años luz de longitud.

Nebulosa de Carina.

La Nebulosa de Carina (también conocida como Nebulosa de la Quilla, Nebulosa Eta Carinae o NGC 3372) es una gran nebulosa de emisión que se encuentra en el Sur de nuestra Vía Láctea, a unos 7.500 años luz de distancia de la Tierra en la constelación de Carina y que rodea varios cúmulos estelares abiertos, conteniendo varias estrellas de magnitud O, algunas de ellas son de las más masivas encontradas hasta la fecha en nuestra galaxia. La Nebulosa de Carina fue descubierta en 1751 por Nicolas Louis de Lacaille en el Cabo de Buena Esperanza. La nebulosa está formada por densas nubes de polvo y gas brillante, siendo una de las incubadoras de estrellas más cercanas a nuestro planeta y teniendo un diámetro realmente impresionante y cercano a los 100 años luz, cuatro veces más grande que la Nebulosa de Orión. Dicho tamaño hace que podamos encontrar multitud de objetos estelares en su interior como la Nebulosa Keyhole (oscura y fría nube de polvo de 7 años luz de diámetro que posee brillantes filamentos fluorescentes) y la estrella hipergigante Eta Carinae (rodeada por la Nebulosa del Homúnculo que fue formada por material eyectado de la propia estrella en 1841), la cual tiene una luminosidad cuatro millones de veces mayor que la de nuestro Sol y una masa 100 – 150 veces superior. Tal es el tamaño de Eta Carinae, que cuando llegue al final de sus vidas explosionará en una hipernova (superior a una supernova), pudiendo formar directamente un agujero negro, el cual emitiría dos chorros de plasma y rayos gamma a una velocidad cercana a la de la luz por cada uno de sus polos. La Nebulosa de Carina es un laboratorio perfecto para los astrónomos que quieren estudiar el nacimiento y el inicio de las nuevas estrellas.

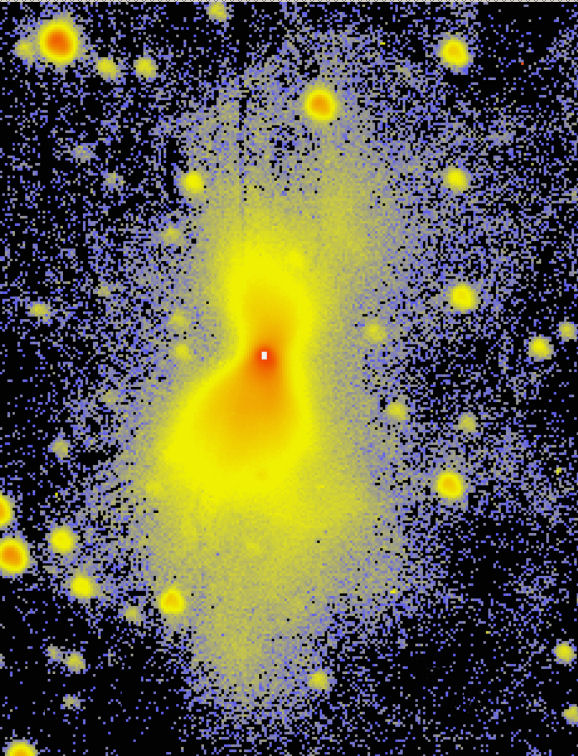

Terminemos por la misma imagen de la Nebulosa del Boomerang, captada en otra longitud de ondas.

Posee una temperatura de -272ºC y se encuentra tan sólo un grado por encima del cero absoluto, que es el límite más bajo para cualquier temperatura. Incluso el débil fulgor de la radiación de fondo dejada por el Big Bang, con una temperatura de -270ºC, tiene una temperatura más cálida que la propia nebulosa. Hasta el día de hoy, es el único elemento conocido del Universo cuya temperatura es más baja que la radiación cósmica de fondo.

La nebulosa Boomerang posee esa forma de lazo debido al fuerte viento que alcanza velocidades de 500.000 km/h, el cual arrojaba el gas ultrafrío lejos de la moribunda estrella central.

El Universo nunca dejará de asombrarnos y siempre nos podrá mostrar cosas nuevas que, habiéndolas observado desde la lejanía y utilizando sistemas no siempre fiables, por muy bueno y avanzado que puedan ser nuestros telescopios actuales, nunca podrán mostrarnos con la fidelidad de la cercanía, esos objetos que pueden captar pero que, dadas las inmensas distnacias, esconden secretos que, poco a poco, a medida que avanza la tecnología y buscamos nuevos sistemas, podremos ir desvelando para conocer, lo que el Universo es.

emilio silvera

Jul

15

Los misterios de la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Energías de la Tierra ~

Clasificado en Energías de la Tierra ~

Comments (3)

Comments (3)

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica – erupciones volcánicas o terremotos extraordinariamente potentes – o de energía atmosférica – vientos o lluvias anormalmente intensas –, parecen irrelevantes se comparan con las repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes.

Hace unos seis mil años, en una región argentina denominada Campo del Cielo, se suscitó una lluvia de meteoritos, producto de la explosión en la atmósfera de un asteroide que pesaba unos 840 mil kilos. En la actualidad, se conserva uno de esos fragmentos, al cual se le denominó como “El Chaco”. Es el segundo más pesado del cual se tiene , pues en la báscula registra 37 toneladas.

En los primeros años del siglo XIX, varios exploradores se asentaron en Cape York, Groenlandia, en donde descubrieron que los habitantes de las tribus del lugar utilizaban armas punzocortantes hechas, supuestamente, con materiales de origen meteórico. Años más tarde, Robert E. Peary fue quien encontró los resquicios de un gran asteroide que golpeó la Tierra en la llamada “Edad de Hierro”. A esta gran piedra se le llamó Ahnighito, la cual fue venida al Museo Americano de Historia Natural, en donde actualmente se le observar.

Este meteorito cayó miles de años en Bacubirito, Sinaloa. Se dice que en 1863, varios pobladores de dicha localidad hallaron esta gran piedra, aunque no se dio a conocer al mundo sino hasta finales del siglo XIX, gracias a la labor periodística de Gilbert Ellis. Bacubirito pesa cerca de 20 toneladas; mide más de cuatro metros de largo y dos metros de ancho, características por las cuales lo convierten en el quinto meteorito más grande que ha caído en el planeta. Hoy en día se encuentra en la explanada del Centro de Ciencias de Culiacán.

No sabemos un asteroide “asesino”, caerá sobre la Tierra. Los Encuentros espaciales, han sido relativamente frecuentes en la historia del planeta y, luego, no podemos asegurar que no se volverá a repetir, sino que, por el contrario, lo único que no sabemos es cuando pasará.

Existen simulaciones de lo que ser el choque del meteorito en la Tierra y, desde luego, no quisiera estar aquí cuando suceda. La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al , uno al año.

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

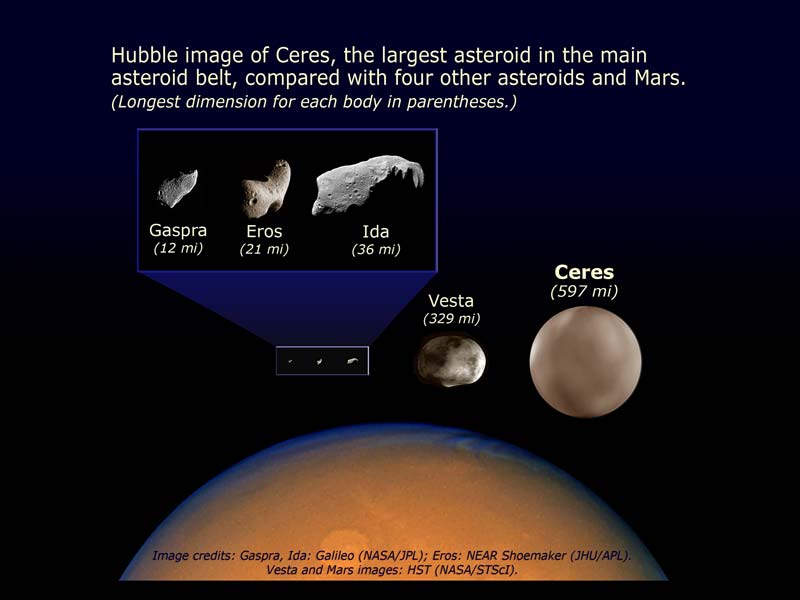

Marte y Júpiter hay cientos de miles de cuerpos pequeños que orbitan alrededor del Sol llamados asteroides. podemoas encontrarlos más allá de Plutón, llamado cinturón de Kuiper, y que en este caso reciben el de objetos transneptunianos y que están hecho de hielo. Ceres es el asteroide más grande y 913 km de diámetro.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones. Está que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto. Muchas toneladas son las que recibimos cada año de pequeños fragmentos de todo pero, cuando estos van aumentando de tamaño, los sucesos de espacian de manera sustancial

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Esperemos que imagen no la podamos ver nunca en directo

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 , el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas , una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son setales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

Si suponemos que una civilización avanzada podría preparar refugios la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales.

nos queda tiempo, hablemos de… ¡La fotosíntesis! Y, sus consecuencias.

Todo el Oxígeno de la Atmósfera terrestre procede del oxígeno que desprenden los organismos autótrofos la fotosíntesis.

La fotosíntesis es el principal proceso bioquímico que consigue pasar materiales desde el biotopo hasta la biocenosis de un ecosistema. Una vez incorporados parte de los organismos autótrofos, los heterótrofos (por ejemplo, los animales) solo tienen que aprovecharse de aquellos; con la existencia de pequeñas cantidades de agua, todo está preparado para que el ecosistema entero comience a funcionar. Además, siempre habrá animales depredadores, carnívoros, que seguirán aprovechando los materiales de otros.

La conocida ecuación básica que describe la reacción endotérmica por la cual se sintetiza una molécula de glucosa a partir de sus seis moléculas de CO2 y H2O, y 2’8 MJ de radiación solar, es una simplificadísima caja negra. Una caja negra más realista sería la siguiente:

106 CO2 + 90 H2O + 16 NO3 + PO4 + nutrientes minerales + 5’4 MJ de radiación = 3’258 g de protoplasma (106 C, 180 H, 46 O, 16 N, 1 P y 815 g de cenizas minerales) + 154 O2 + 5’35 MJ de calor disipado.

Sin macronutrientes ni micronutrientes no se producir fitomasa, que está compuesta por los nutrientes básicos necesarios para todos los seres heterótrofos: azúcares complejos, ácidos grasos y proteínas.

La síntesis de fitomasa en el ciclo reductor del fosfato pentosa (RPP) – un proceso con varios pasos de carboxilación por catálisis enzimática, reducción y regeneración – tiene que empezar con la formación de trifosfato de adenosina (ATP) y nicotinamida adenina dinucleótido fosfato (NADP), que son los dos compuestos que suministran energía a todas las reacciones biosintéticas. La síntesis de las tres moléculas de ATP y las dos de NADP que se necesitan para reducir molécula de CO2 requiere de diez cuantos de radiación solar con longitud de onda próxima al pico rojo de absorción de la clorofila (680 nm). El carbono procedente del CO2, combinado con el hidrógeno del agua y con los micronutrientes, dará lugar a nueva fitomasa que contiene 465 KJ/mol.

La cantidad de energía de un cuanto de luz roja es de 2’92×10-19 J (el producto de la constante de Planck, 6’62×10-34 por la frecuencia de la luz, que a su vez es el cociente la velocidad de la luz y la longitud de onda).

Un einstein (definido como un mol o de Avogadro, 6’02×1023) de fotones rojos tiene una energía aproximadamente igual a 17 Kg. Suponiendo que la RFA es el 45% de la luz directa, la eficiencia global de la fotosíntesis es del 11%, que equivale a 456/(1.760/0’43). Esta eficiencia se reduce por lo en una décima parte más si tenemos en cuenta la reflexión de la luz en las hojas y la pérdida que supone atravesar la cubierta vegetal. Ninguna planta, sin embargo, se acerca siquiera a esta eficiencia teórica, porque parte de la luz absorbida por las clorofilas (generalmente, el 20 – 25 por ciento) vuelve a ser emitida en forma de calor, debido a que los pigmentos no pueden almacenar la luz y las reacciones enzimáticas no se producen con suficiente velocidad como para utilizar completamente el flujo de energía incidente. En la respiración se cede el carbono fijado en el metabolismo de la planta y en el mantenimiento de las estructuras que la soportan.

La luz y el calor que en una pequeña fracción recibinmos de la energía solar, posible todas estas maravillas en nuestro planeta. La vida incluida.

Para cada especie, la tasa con la que se pierde carbono está determinada principalmente por el tipo de fotosíntesis. Así, existen diferencias sustanciales las plantas C3 y C4. La respiración a escala de una comunidad o ecosistema depende del estado de crecimiento, y varía entre del 20 por ciento en plantas jóvenes en rápido crecimiento, hasta más del 90 por ciento en bosques maduros.

Con una pérdida del 25 por ciento para la reacción, y otro tanto para la respiración, la eficiencia fotosintética es ligeramente superior al 5 por ciento. En este punto, las estimaciones teóricas y los valores reales coinciden, ya que el valor medio de fotosíntesis neta en plantas muy productivas y en óptimas y durante cortos periodos de tiempo, oscila entre el 4 y el 5 por ciento. La mayoría de las plantas rinden en función de los nutrientes, especialmente nitrógeno y agua, o por las bajas temperaturas en las regiones de mayor altura y latitud. Los mejores rendimientos en sistemas naturales muy productivos, como los humedales y los cultivos, están entre el 2 y el 3 por ciento. En otros ecosistemas, como los pantanos tropicales templados y los bosques templados, el rendimiento de la transformación es del 1’5 por ciento, y en las praderas muy áridas sólo del 0’1 por ciento. Globalmente, la producción anual es, al menos, de 100.000 millones de toneladas de fitomasa, que se sintetizan con un rendimiento medio del 0’6 por ciento.

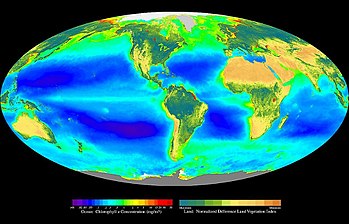

La fotosíntesis en los océanos, muy afectada por la escasez de nutrientes, es incluso menos . La productividad medie es de poco más de 3 MJ/m2 y se realiza con un rendimiento fotosintético del 0’06 por ciento. La media ponderada total es 0’2 por ciento, es decir, que sólo uno de cada 500 cuantos de energía solar que llega a la superficie de la Tierra se transforma en energía de biomasa en de tejido vegetal.

La mayor de esta energía se almacena en forma de azúcares simples, que contienen más energía, y que sólo se encuentran en las semillas.

La mayor parte de la fitomasa está en los bosques. En los océanos, los principales productores son los organismos que componen el fitoplancton, que son muy pequeños y flotan libres. Su tamaño varía algo menos de 2 y 200 μm de diámetro y están formados por cantidades variables de bacterias y protoctistas eucarióticos. Las cianobacterias cocoides son tan abundantes en algunas aguas oligotrópicas que pueden ser las responsables de la mayor parte de la producción de fitoplancton.

Los protoctistas fotosintetizadores varían entre los más pequeños flagelados pigmentados ( las criptomonas y crisofitos), hasta las diatomeas y dinoflagelados, que son mayores (más de 10 mm) y generalmente dominantes. Las diatomeas están formadas por células sin flagelos, con paredes de silicio amorfo mezclados con otros compuestos orgánicos. Presentan una sorprendente y amplia variedad de diseño, desde las que tienen simetría central (las de forma radial son las dominantes en el océano), a las pennadas (simetría lateral), y otras forman largas cadenas.

La productividad de fitoplancton está controlada por la temperatura del agua y por la disponibilidad de radiación solar y nutrientes. La temperatura no es determinante, porque muchas especies son muy adaptables y consiguen una productividad similar en distintos ambientes. Aunque es frecuente la adaptación a diferentes lumínicas, tanto el volumen como en contenido en clorofila de las diatomeas aumenta con la intensidad de la luz. En el mar abierto, la mayor limitación es la cantidad de nutrientes disponibles.

las carencias que más limitan la producción de fitoplancton está la de nitrógeno, el macronutriniente más importante, la de fósforo, y la de algunos otros micronutrientes clave como el hierro y el silicio.

Los medios productivos de la Tierra están en la capa superficial y la capa inmediatamente inferior de los océanos. En el mar abierto, las concentraciones más altas de nutrientes se encuentran entre los 500 y los 1.000 metros, a bastante más profundidad que la zona eufórica, capa en la que penetra la luz solar y que se extiende a unos 100 metros en las aguas transparentes.

El pequeñísimo tamaño de los productores dominantes es una adaptación eficaz a la escasez de nutrientes, ya que cuanto mayor sea el cociente entre la superficie y el volumen, y más lento el hundimiento de las células de fitoplancton en la capa eufórica, mayor es la tasa de absorción de nutrientes.

las corrientes elevan a la superficie las aguas frías y cargadas de nutrientes, la producción de fitoplancton aumenta sustancialmente. Las aguas costeras de Perú, California, noroeste y sudoeste de África, y de la India occidental son ejemplos destacados de ascensión costera de aguas frías. También se dan casos de ascensión mar adentro en la mitad del Pacífico, cerca del ecuador y en las aguas que rodean la Antártida. Otras zonas altamente productivas se encuentran en las aguas poco profundas cercanas a la costa que están enriquecidas por el aporte continental de nutrientes. Este enriquecimiento, con una proporción N/P muy descompensada, es especialmente elevados en los estuarios adonde van a parar grandes cantidades de aguas residuales y fertilizantes.

Las diferentes medidas de la productividad en las aguas oligotróficas de los mares subtropicales y de las aguas eutróficas con corrientes ascensionales, varían entre de 50 gC/m2 y 1 gC/m2, más de un orden de magnitud. Las estimaciones de la producción global de fitoplancton están comprendidas 80.000 y 100.000 millones de toneladas, que representan entre dos tercios y cuatro quintos de la fitomasa total terrestre. Contrasta con el resultado anterior el hecho de que, dado el corto periodo de vida del fitoplancton (1 – 5 días), la fitomasa marina represente sólo una pequeña fracción de todo el almacenamiento terrestre.

La distribución espacial del fitoplancton muestra zonas delimitadas que se extienden a escala local y global. La exploración desde los satélites es, con gran diferencia, la que permite detectar con mayor precisión las concentraciones de clorofila y la que ha posibilitado obtener las pautas de la distribución de fitoplancton. En las aguas que rodean la Antártida se observa claramente una distribución asimétrica en dos bandas casi concéntricas. La mejor distribución se explica por el hecho de que se deba a corrientes circumpolares y a la abundancia de ácido silicílico. las zonas de mayor riqueza de fitoplancton se encuentran cerca de los continentes donde los ríos arrastran abundantes nutrientes disueltos.

La vida necesita un aporte continuo de energía que llega a la Tierra el Sol y pasa de unos organismos a otros a través de la cadena trófica.

El fitoplancton es la base energética de las intrincadas pirámides tróficas. Las cadenas alimenticias en el océano, generalmente, son redes complicadas. Una gran parte de la fitomasa disponible no la consumen directamente los herbívoros, sino que primero se almacena en depósitos de materia muerta que, transformada por bacterias, se convertirá en alimento otros seres heterótrofos.

La gran producción de fitoplancton puede alimentar grandes cantidades de zoomasa. El kril, pequeños crustáceos parecidos a las quisquillas que se alimentan de diatomeas, son los organismos más abundantes en la superficie del mar; sus densas acumulaciones pueden contener mil millones de individuos y su producción anual de zoomasa quizá llegue hasta los 1.300 millones de toneladas. Esta prodigiosa cantidad de zoomasa sirve de alimento a focas, calamares y peces, así como a los mayores carnívoros de la biosfera, las especies de ballenas con barbas que se alimentan filtrando el agua.

emilio silvera

Jul

15

La Física no duerme

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Arnold Sommerfeld percibió que la velocidad de los electrones en el átomo de hidrógeno es una fracción considerable de la velocidad de la luz, así que había que tratarlos conforme a la teoría de la relatividad. Vio que donde la teoría de Bohr predecía una órbita, la nueva teoría predecía dos muy próximas.

Esto explica el desdoblamiento de las líneas. Al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). No prestéis atención a la ecuación. Lo interesante es esto: se meten los números conocidos de la carga del electrón, e–, la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 puro.

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

La última lección importante que aprendemos de la manera en que números puros α (alfa) definen el mundo, es el verdadero significado de que los mundos sean diferentes. El número puro que llamamos constante de estructura fina, e indicamos con α, es como hemos dicho antes, una combinación de e, c y h (el electrón, la velocidad de la luz y la constante de Planck). Inicialmente, podríamos estar tentados a pensar que un mundo en el que la velocidad de la luz fuera más lenta sería un mundo diferente. Pero sería un error. Si e, h y c cambian de modo que los valores que tienen en unidades métricas (o cualesquiera otras) fueran diferentes cuando las buscamos en nuestras tablas de constantes físicas, pero el valor de α permaneciera igual; nuevo mundo sería observacionalmente indistinguible de nuestro mundo. Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza.

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. Cuando trató de desarrollar este principio, Einstein tuvo dificultades; no encontraba la manera de expresarlo con la formulación matemática adecuada. Pidió ayuda a su amigo Marcel Grossmann, matemático, quien sabiendo de las necesidades exactas de Einstein, le envió la copia de una conferencia que dio un tal Riemann, unos sesenta años .

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

Einstein fue muy afortunado, ya que durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Einstein pudo expresar su principio de covariancia expresando sus leyes de la naturaleza como ecuaciones tensoriales, que poseían automáticamente la misma forma para todos los observadores.

Este paso de Einstein completó un movimiento espectacular en la concepción física de la naturaleza que ha sido completado en el siglo XX. Está marcado por una evolución que se aleja continuamente de cualquier visión privilegiada del mundo, sea una visión humana, basada en la Tierra, o una visión basada en patrones humanos, la naturaleza tiene sus propios patrones.

Está que pensar siquiera en que en nuestro universo, dependiendo de la región en la que nos encontremos, habrá distintos leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar como Einstein y creer que en cualquier parte del universo rigen las mismas leyes físicas, que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sea cual fueren las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte de nuestro universo por muy remota que se encuentre; los elementos primordiales que lo formaron fueron siempre los mismos, que interaccionan con las cuatro fuerzas fundamentales naturales.

sabemos que las fuerzas de la naturaleza, la fuerza nuclear fuerte, la fuerza nuclear débil, el electromagnetismo y la gravedad, no son tan diferentes como parece a primera vista. Parecen tener intensidades muy diferentes y actuar sobre partículas elementales diferentes. eso es ilusorio, es la sensación creada por nuestra necesidad de habitar en un lugar del universo donde la temperatura es más bien baja y, es así, como se manifiestan las fuerzas de la naturaleza que, en dicha temperatura permite la existencia de átomos y moléculas.

Conforme la temperatura aumenta y las partículas elementales de materia colisionan entre sí a energías cada vez más altas, las fuerzas separadas que gobiernan nuestro mundo de baja temperatura, se hacen más parecidas. La fuerza fuerte se debilita, la fuerza débil aumenta y fortalece. Aparecen nuevas partículas a medida que se alcanzan temperaturas más elevadas y consiguen producir interacciones entre las familias separadas de partículas que a temperaturas bajas, parecen estar aisladas entre sí. Poco a poco, a medida que nos acercamos a esas inimaginables de temperatura “última” que Max Planck encontró definida por las cuatro constantes de la naturaleza, G, K, c, h, esperamos que las diferencias entre las fuerzas naturales se vayan borrando completamente para finalmente quedar unificadas en una única fuerza como, por otra parte, se cree que fue al principio de todo, en el Big Bang, el proceso ocurrió al contrario. Había una increíble temperatura, un plasma primordial lo invadía todo y se expansionaba, naciendo el tiempo y el espacio cuando reinaba la simetría total y una sola fuerza lo regía todo.

El universo continuó su expansión y comenzó a enfriarse, la simetría se rompió y lo que era una sola fuerza se dividió en las cuatro que conocemos. Previamente, a partir del plasma, al la temperatura, surgieron los quarks que se juntaron formar protones y neutrones que, a su vez, se juntaron para formar núcleos que, al ser rodeados por los electrones atraídos por la carga positiva de los núcleos, formaron los átomos, que se unieron para formar moléculas, que se juntaron para formar la materia, que más tarde, dio lugar al nacimiento de las primeras estrellas y galaxias con sus variedades de objetos estelares, planetas, satélites, cometas, meteoritos, y, en definitiva, todo lo que exoiste en el universo y que podamos ver o detectar.

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundobrana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

emilio silvera

Totales: 83.328.067

Totales: 83.328.067 Conectados: 1

Conectados: 1