Jul

15

La Física no duerme

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Arnold Sommerfeld percibió que la velocidad de los electrones en el átomo de hidrógeno es una fracción considerable de la velocidad de la luz, así que había que tratarlos conforme a la teoría de la relatividad. Vio que donde la teoría de Bohr predecía una órbita, la nueva teoría predecía dos muy próximas.

Esto explica el desdoblamiento de las líneas. Al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). No prestéis atención a la ecuación. Lo interesante es esto: se meten los números conocidos de la carga del electrón, e–, la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 puro.

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

La última lección importante que aprendemos de la manera en que números puros α (alfa) definen el mundo, es el verdadero significado de que los mundos sean diferentes. El número puro que llamamos constante de estructura fina, e indicamos con α, es como hemos dicho antes, una combinación de e, c y h (el electrón, la velocidad de la luz y la constante de Planck). Inicialmente, podríamos estar tentados a pensar que un mundo en el que la velocidad de la luz fuera más lenta sería un mundo diferente. Pero sería un error. Si e, h y c cambian de modo que los valores que tienen en unidades métricas (o cualesquiera otras) fueran diferentes cuando las buscamos en nuestras tablas de constantes físicas, pero el valor de α permaneciera igual; nuevo mundo sería observacionalmente indistinguible de nuestro mundo. Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza.

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. Cuando trató de desarrollar este principio, Einstein tuvo dificultades; no encontraba la manera de expresarlo con la formulación matemática adecuada. Pidió ayuda a su amigo Marcel Grossmann, matemático, quien sabiendo de las necesidades exactas de Einstein, le envió la copia de una conferencia que dio un tal Riemann, unos sesenta años .

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

Einstein fue muy afortunado, ya que durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Einstein pudo expresar su principio de covariancia expresando sus leyes de la naturaleza como ecuaciones tensoriales, que poseían automáticamente la misma forma para todos los observadores.

Este paso de Einstein completó un movimiento espectacular en la concepción física de la naturaleza que ha sido completado en el siglo XX. Está marcado por una evolución que se aleja continuamente de cualquier visión privilegiada del mundo, sea una visión humana, basada en la Tierra, o una visión basada en patrones humanos, la naturaleza tiene sus propios patrones.

Está que pensar siquiera en que en nuestro universo, dependiendo de la región en la que nos encontremos, habrá distintos leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar como Einstein y creer que en cualquier parte del universo rigen las mismas leyes físicas, que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sea cual fueren las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte de nuestro universo por muy remota que se encuentre; los elementos primordiales que lo formaron fueron siempre los mismos, que interaccionan con las cuatro fuerzas fundamentales naturales.

sabemos que las fuerzas de la naturaleza, la fuerza nuclear fuerte, la fuerza nuclear débil, el electromagnetismo y la gravedad, no son tan diferentes como parece a primera vista. Parecen tener intensidades muy diferentes y actuar sobre partículas elementales diferentes. eso es ilusorio, es la sensación creada por nuestra necesidad de habitar en un lugar del universo donde la temperatura es más bien baja y, es así, como se manifiestan las fuerzas de la naturaleza que, en dicha temperatura permite la existencia de átomos y moléculas.

Conforme la temperatura aumenta y las partículas elementales de materia colisionan entre sí a energías cada vez más altas, las fuerzas separadas que gobiernan nuestro mundo de baja temperatura, se hacen más parecidas. La fuerza fuerte se debilita, la fuerza débil aumenta y fortalece. Aparecen nuevas partículas a medida que se alcanzan temperaturas más elevadas y consiguen producir interacciones entre las familias separadas de partículas que a temperaturas bajas, parecen estar aisladas entre sí. Poco a poco, a medida que nos acercamos a esas inimaginables de temperatura “última” que Max Planck encontró definida por las cuatro constantes de la naturaleza, G, K, c, h, esperamos que las diferencias entre las fuerzas naturales se vayan borrando completamente para finalmente quedar unificadas en una única fuerza como, por otra parte, se cree que fue al principio de todo, en el Big Bang, el proceso ocurrió al contrario. Había una increíble temperatura, un plasma primordial lo invadía todo y se expansionaba, naciendo el tiempo y el espacio cuando reinaba la simetría total y una sola fuerza lo regía todo.

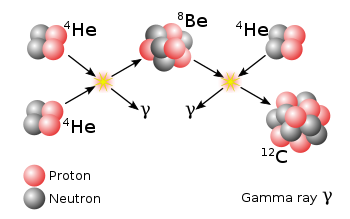

El universo continuó su expansión y comenzó a enfriarse, la simetría se rompió y lo que era una sola fuerza se dividió en las cuatro que conocemos. Previamente, a partir del plasma, al la temperatura, surgieron los quarks que se juntaron formar protones y neutrones que, a su vez, se juntaron para formar núcleos que, al ser rodeados por los electrones atraídos por la carga positiva de los núcleos, formaron los átomos, que se unieron para formar moléculas, que se juntaron para formar la materia, que más tarde, dio lugar al nacimiento de las primeras estrellas y galaxias con sus variedades de objetos estelares, planetas, satélites, cometas, meteoritos, y, en definitiva, todo lo que exoiste en el universo y que podamos ver o detectar.

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundobrana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

emilio silvera

Jul

14

Sí, el Universo es… ¡Asombroso!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (2)

Comments (2)

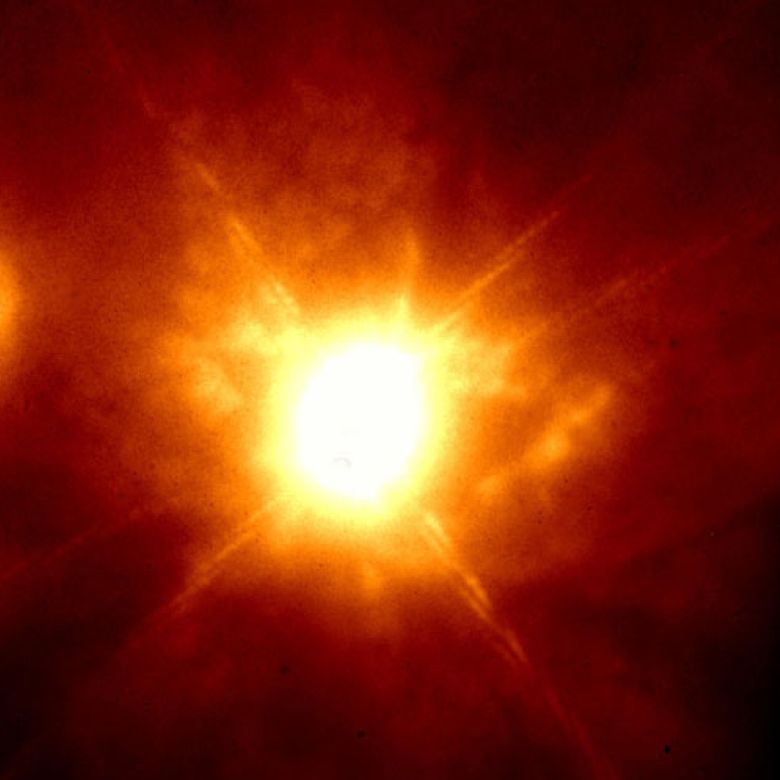

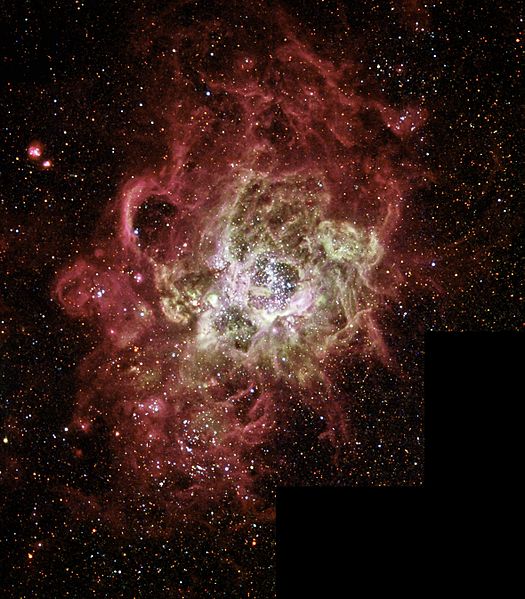

El complejo binario Wolf-Rayet BATT99-49, nos muestra como sus energías producen coloridos tonos en la espesas nubes de gas hidrógeno que ocultan las estrellas nuevas de potente radiación que ionizan el lugar. Aquí podemos contemplar la bonita imagen conseguida por la unidad Melipal del telescopio VLT, del Observatorio Europeo del Sur , resuelve con espléndido detalle el complejo BAT99-49 de esta nebulosa. La luz emitida por los átomos de helio se registra en azules, la del oxígeno en verdes y la del hidrógeno en rojos. Una de las estrellas de esta dupla es del tipo enigmático Wolf-Rayet , mientras que la otra es una estrella O masiva. Esta pareja estelar y su nebulosa se encuentran en la Gran Nube de Magallanes , la más grande de las galaxias-satélite de nuestra Vía Láctea . Las estrellas Wolf-Rayet constituyen uno de los objetos más calientes del universo, mientras que las O son las más energéticas y masivas de la secuencia principal de evolución estelar.

Vientos solares que crean burbulas en la Nebulosa

Las estrellas de Wolf-Rayet o estrellas Wolf-Rayet (abreviadas frecuentemente como WR) son estrellas masivas (con más de 20-30 masas solares), calientes y evolucionadas que sufren grandes pérdidas de masa debido a intensos vientos solares.

Este tipo de estrellas tiene temperaturas superficiales de entre de 25.000 – 50.000 K (en algunos casos incluso más), elevadas luminosidades, y son muy azules, con su pico de emisión situado en el ultravioleta. Sus espectros muestran bandas de emisión brillantes correspondientes a hidrógeno o helio ionizado -los cuales son relativamente escasos-. La superficie estelar también presenta líneas de emisión anchas de carbono, nitrógeno y oxígeno. Constituyen el tipo espectral W, el cual se divide a su vez en tres tipos: WN (si abunda el nitrógeno, que se explica por la presencia en la superficie estelar de elementos que han intervenido en el ciclo CNO), y WC y WO (si abunda el carbono y si abunda el oxígeno respectivamente; el segundo es mucho más raro y en ambos casos, la presencia de dichos elementos se interpreta como la presencia en la fotosfera de productos del proceso triple alfa). Las estrellas Wolf-Rayet más brillantes son del primer tipo.

mediante el proceso Triple Alfa, las estrellas crean Carbono

A menudo suelen formar parte de sistemas binarios en los cuales la otra estrella suele ser también una estrella masiva de tipo espectral O y B, o bien, en unos pocos casos, un objeto colapsado como una estrella de neutrones o un agujero negro.

Estas estrellas masivas tienen una vida más corta que las estrellas como nuestro Sol o las enanas rojas que, llegan a alcanzar edades más largas que la que tiene actualmente nuestro Universo. Lo normal es que una estrella muy masiva, que consume gas hidrógeno en cantidades asombrosas, es decir, que fusiona los materiales más sencillos en otros más complejos, viven unos pocos millones de años hasta que, no puede seguir fusionando material y queda a merced de la Gravedad que la comprime más y más, explota como Supernova para convertirse en un aestrella de neutrones o agujero negro y, las capas exteriores, son eyectadas al espacio interestelar para formar una Nebulosa.

Los agujeros negros, aunque nadie ha podido visitar ninguno hasta el momento, se cree son los objetos más densos del universo y, hasta tal punto es así que el material que los conforma se contrae tanto que, llega a desaparecer de nuestra vista y, estrellas de más de 80 0 100 masas solares, quedan así, convertidas en puntos, o, singularidades de inemnsa densidad y energía. Hasta tal punto es así que la gravedad que genera no seja escapar ni a la luz que, como sabéis, camina a 300.000 Km/s.

El Universo amigos míos, como siempre digo: ¡Es asombroso!

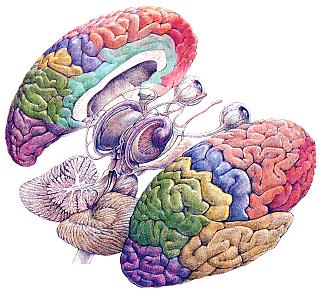

Lo hemos comentado aquí en muchas ocasiones. El cerebro se cuenta entre los objetos más complicados del Universo y es, sin duda, una de las estructuras más notables que haya podido producir la evoluciòn y, si pensamos que toda esa inmensa complejidad ha tenido su origen en los materiales creados en las estrellas, no tendremos otra opción que la del asombro. ¿A partir de la materia “inerte” llegaron los pensamientos?

Antes incluso del advenimiento de la moderna neurociencia, se sabía ya que el cerebro era necesario para la percepción, los sentimientos y los pensamientos. Lo que no está tan claro es por qué la conciencia se encuentra causalmente asociada a ciertos procesos cerebrales pero no a otros.

En tanto que objeto y sistema, el cerebro humano es especial: su conectividad, su dinámica, su forma de funcionamiento, su relación con el cuerpo al que ordena qué funciones debe desarrollar en cada momento dependiendo de tal o cual situación dada y también su relación con el mundo exterior a él que, por medio de los sentidos, le hace llegar información de todo lo que ocurre para que, pueda ado0ptar en cada momento, las medidas más adecuadas. Su carácter único hace que ofrecer una imagen fidedigna del cerebro, que pueda expresar todo lo que es, se convierta en un reto extraordinario que, en este momento, la ciencia no puede cumplir. Sin embargo, sí que puede, al menos, dar alguna que otra pista de lo que el cerebro y la conciencia puedan llegar a ser y aunque, aún lejos de una imagen completa, sí se puede dar una imagen parcial que siempre será mejor que nada, especialmente si nos da la suficiente información como para tener, una idea aproximada, de lo que el cerebro y la conciencia que surge de él, pueden llegar a ser.

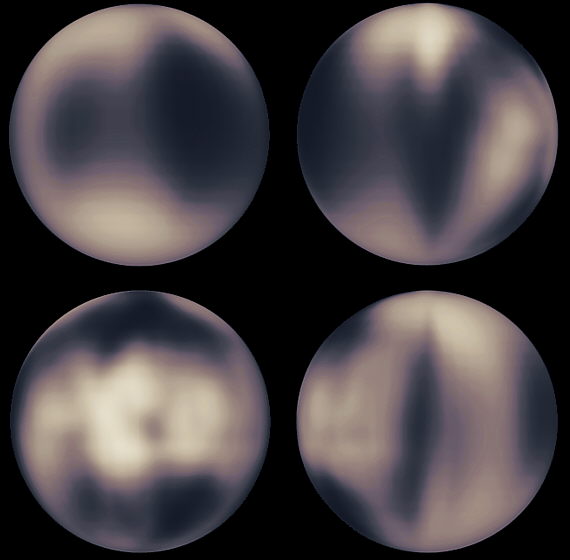

Si nos paramos a pensar en el hecho cierto de que, el cerebro humano asulto, con poco más de un kilo de peso, contiene unos cien mil millones de células nerviosas o neuronas, La capa ondulada más exterior o corteza cerebral, que es la parte del cerebro de evolución más reciente, contiene alrededor de 30 mil millones de neuronas y más de un billón de conexiones o sinapsis. Si contarámos una sinapsis cada segundo, tardaríamos 32 millones de años en completar el recuento. Si consideramos el número posible de circuitos neuronales, tenemos que habernósla con cifras hiperastronómicas: 10 seguido de un millón de ceros. No existe en el Universo ninguna optra cosa de la que pueda resultar una cantidad igual. Incluso el número de partículas del universo conocido es de 10 seguido de tan sólo 79 ceros. En comparación con el número de circuitos neuronales…¡No es nada!

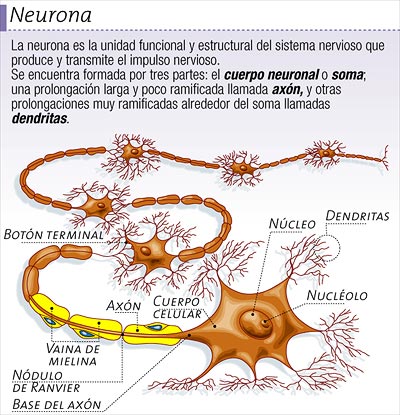

El impulso nervioso viaja a lo largo del axón de la célula del cerebro, a través del espacio sináptico a otra célula del cerebro y así sucesivamente. Cuando una neurona se activa a otra de esta manera, es como si un interruptor se encendiera. Las neuronas se encienden, como una línea de fichas de dominó cayendo. Esta actividad es el proceso que crea el camino del pensamiento complejo, llamado también trazas de la memoria o caminos neuronales.

El impulso nervioso viaja a lo largo del axón de la célula del cerebro, a través del espacio sináptico a otra célula del cerebro y así sucesivamente. Cuando una neurona se activa a otra de esta manera, es como si un interruptor se encendiera. Las neuronas se encienden, como una línea de fichas de dominó cayendo. Esta actividad es el proceso que crea el camino del pensamiento complejo, llamado también trazas de la memoria o caminos neuronales.

![inteligencia-artificial[1] cerebro y computadora](http://poderpersonalmexico.com/blog/wp-content/uploads/2011/12/inteligencia-artificial1.jpg)

Entrando de lleno en toda esta complejidad que aún, no hemos podido llegar a desvelar en toda su inmensidad y sólo conocemos pequelas parcelas de su estructura y funcionamiento, podemos tener una idea (más o menos) acertada de lo muchom que nos queda por aprender de nosotros mismos, de nuestro cerebro y de nuestro centro neurálgico dónde se fabrican los pensamientos, surgen los sentimientos, se delata el dolor y la tristeza y, en fín, podríamos decir sin el menor temnor a equivocarnos que, aquí, en este complejo entramado que llamamos cerebro, en el que reside la conciencia y de donde surge la mente, está todo lo importante que nos hace diferentes a otros seres que, con nosotros comparten el mismo planeta. Gracias a ésta compleja “maquina” creada por la Naturaleza, podemos ser conscientes y “saber” del mundo, de nosotros, del universo en toda su magnitud y esplendor.

No pocas veces hemos podido oir: “El cerebro es como una gran computadora”. Lo cierto es que, no es verdad, nuestro cerebro, nuestra mente, es mucho más que ese algo artificial creado por el hombre y que, simplemente, trata de “imitar” de manera grosera, lo que el cerebro es. ¿Cómo puede una máquina generar sentimientos? Y, ¿Cómo puede pensar? Bueno, la inteligencia del ser humano (precisamente basada en este maravilloso cerebro del que hablamos), podrá crear sistemas que imiten y pretendan recrear lo que es un cerebro pero, al final del camino, será otra cosa muy diferente. No digo si mejor o peor, pero distinta.

Las neuronas de las que existen una gran variedad de formas, poseeen unas proyecciones arborescentes llamadas dendritas mediante las cuales realizan las conexiones sinápticas. posee asímismo una proyección única más larga, el axón, que establece conexiones sinápticas con las dendritas o directamente con el cuerpo celular de otras neuronas. Nadie ha contado con precisión los diferentes tipos de neuronas del cerebro, pero uhna estima groso modo de unos cincuenta tipos seguramente no sería excesiva. La longitud y patrones de ramificación de las dendritas y el axón de un tipo determinado de neurona caen dentro de un rango de variación determinado, pero incluso dentro de un mismo tipo, no existen dos células iguales.

Hemos examinado la escasa bibliografía fisiológioca existente que no es ucha más que la que había en la època de William James, por ejemplo, y hay que concluir diciendo que no existen pruebas suficientes para poder limitar los correlatos neuronales de la cionciencia al menos del cerebro completo. Eso sí, se ha podido descubrior que sólo una porción determinada de la actividad neuronal del cerebro, contribuye de forma directa a la conciencia -asó se ha podido determinar de complejos y profundos experimentos con estimulación y lesiones -o está relacionada de forma directa con aspectos de la experiencia consciente- como indican los estudios de registros de actividad neuronal. ¿Quiere esto decir que, en realidad, todavía sólo utilizamos una mínima parte del cerebro? No lo sabemos con certeza. Pero lo que si parece es que utilizamos todo el cerebro con el que podemos contar hoy, mañana, cuando evolucionado desarrolle más intelecto, podremos utilizar lo que el cerebro podrá ofrecer en el futueo.

emilio silvera

Jul

14

¡La Física! en el siglo XIX

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (0)

Comments (0)

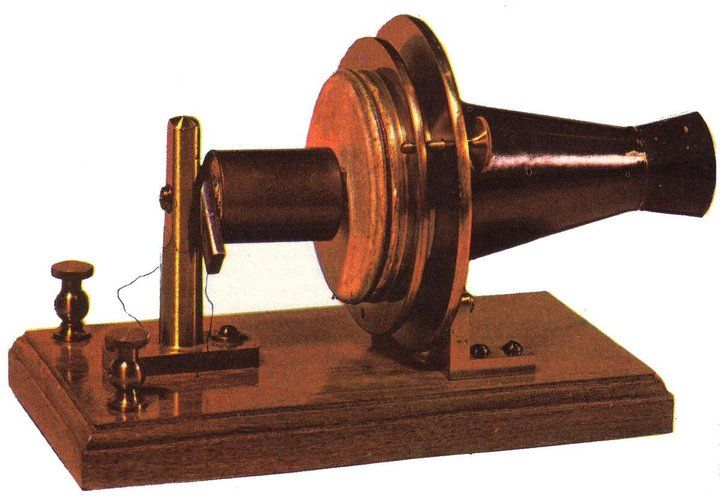

La Física, como todo, evoluciona.

Simplemente con echar una mirada al siglo XIX, nos podemos percatar de que, ese período fue apasionante la Ciencia y la Tecnología que comenzaron a cambiar de manera acelerada produciendo importantes cambios en nuestra Sociedad, sus usos y sus costumbres.

No es extraño encontrar textos de la época en los que, aquella sucesión imparable de inventos y de muchos descubrimientos, marcarían el desarrollo de una nueva Humanidad.

Faraday y J. C. Maxwell.

Las lecturas de la época dejan a veces traslucir sentimientos de asombro, admiración, desconcierto y, a veces, un poco de temor de todos aquellos avances que parecían sacados de una novela de ciencia ficción.

Sí, queremos mostrar episodios referidos a grandes descubrimientos que, por estas razones, llaman la atención. Claro que, si nos trasladamos mentalmente a aquellos momentos y aquella época, podremos comprender mejor, todas aquellas reacciones entonces desencadenadas que , vistas en perspectiva, son lo que sería de esperar y de una total normalidad.

¿Que sería de nuestro mundo sin las personas que aparecen en esta foto?. Sería difícil nombrar a un físico relevante del siglo XX que no aparezca en ella. Corresponde a la quinta conferencia, año 1927, promovida por el filántropo belga Ernerst Solvay. De los 29 asistentes, 17 ya habían, o lo harían poco después, ganado el premio Nobel (al menos una vez). Schrödinger, Einstein (repite en esta lista), M. Curie, Bohr, Planck, Lorentz, Heissenberg, Pauli… científicos inigualables que cambiaron el concepto del mundo, desde el vasto Universo hasta el pequeño átomo.

Aquellos episodios fueron recogidos en lecturas y manuales de Física del siglo XIX, y, lo mismo que fueron saliendo a la luz (sin orden ni concierto), serán aquí comentados. Lo cierto es que, todo aquello nos trajo consecuencias históricas, sociales y educativas.

En general, el siglo XIX es el de la consolidación de la Física como disciplina autónoma. Se manifiesta en ella un afán por establecer un campo de estudio propio, separándose por un lado de la Química, y por el otro de las matemáticas, a la que ha pertenecido hasta entonces como una rama de la misma: las matemáticas mixtas(óptica, estática, astronomía.

En ese momento la Física comienza a adquirir importancia las distintas ramas del saber. Dos factores contribuyen a ello. El primero, la incorporación de nuevos conocimientos que amplían espectacularmente el horizonte de la disciplina. El segundo, el fundamental: el cambio de orientación con relación al espíritu especulativo que estuvo presente hasta bien avanzado el siglo anterior.

Pronto llegarían nuevos conceptos, nuevas teorías

De este modo, la Física asume un enfoque más experimental, al tiempo que dará paso a una utilización creciente de las matemáticas.

Drespretz, en el prólogo de su Física Experimental (1839): “La Física, en el estado á que ha llegado en la actualidad, no tiene de común más que el con la Física llamada escolástica, que los preceptos de Bacón y los ejemplos de Galileo han contribuido felizmente á desterrar de la enseñanza pública.”

La Física de orientación escolástica todavía perdura, especialmente en nuestro país, a principios del siglo XIX. marcar las diferencias, se insiste en que la nueva Física es Física Experimental que se contempla como “ciencia útil” y capaz de incidir con sus aplicaciones en la vida de las personas y en las Sociedades en general.

Aquellos tiempos eran de carruajes que comenzaron a correr sin caballos, máquinas de vapor que “aprovecha la potencia motriz del fuego” que surgieron en Inglaterra del siglo XVIII para sustituir a los animales en el bombeo del agua, cuando ésta inundaba las minas de carbón. La máquina “atmosférica” de Newcomen fue la primera, seguida por la de Watt que mejoró el diseño con un condensador para el vapor, haciéndola mucho más eficiente.

En 1827, el ingeniero francés Marc Seguir inventó la caldera tubular, que obtenía mayor provecho de la fuerza generada por el vapor. Stephenson aplicó sistema a la locomotora The Rocket, que era capaz de transportar 12.942 kilos a 24 km por hora con una pendiente del 2%.

Ninguno de aquellos avances se llevó a cabo con respaldo teórico hasta que aparecen los estudios de Carnot en 1824. En ese nace la termodinámica y a partir de ahí el progreso se dispara.

La Máquina de vapor tiene lugar preferente en los manuales de Física de la época y se describen de manera minuciosa todos y uno de los elementos que intervienen en su funcionamiento. Faltaba sin embargo, la fundamentación teórica, la cual tardaría varias décadas en ser incorporada.

A lo más, los dos únicos principios explicativos que aparecen son la “fuerza elástica del vapor” y “la caída de presión cuando el vapor se condensa”. Claro que, la máquina de vapor adoptó nuevos y más modernos diseños y, de estar fijas en sus lugares de , pasaron a poder desplazarse con la gran ventaja que ello suponía, y, hasta tal punto fue así que, aquella idea del desplazamiento, dio lugar a la llegada del Ferrocarril por una parte y de la Navegación fluvial a vapor por otra, con lo cual, aquello nos llevó en volandas hacia el futuro. Un futuro hasta hacía poco impensable.

“[…] máquinas admirables que lo mismo producen su efecto en puntos fijos, como marchando con una prodigiosa velocidad, ya sobre las barras de hierro, borrando las distancias, ó ya surcando los mares sobre unas tablas, y haciendo vecinos los dos mundos que estos mares separan. (Rodríguez, 1858, p. 320, en su manual de Física general y aplicada a la agricultura y a la industria. Madrid, Aguado (1858).”

Resulta muy curioso en la que eran presentados estos nuevos inventos y las referencias que utilizaban para ello al tratar de transmitir al lector novedades de tal magnitud:

“Igualmente se las ha aplicado á los carruajes que se hacen marchar sin caballerías para transportar cargamentos muy considerables, ó mejor para arrastrar tras de sí un número mayor o menor de carruajes ordinarios cargados de todas las mercancías, ó de otra clase de objetos. (Beudant, 1841, p. 283. Tratado Elemental de Física (3ª Edic.) Madrid, Imprenta de Arias (1841).”

Como vemos, lo era descrito en base a lo ancestral. Se percibe que comienza a producirse cambios de incalculables consecuencias, que hará que el mundo, deje de ser lo que era.

Tras haber pasado desapercibida siglos, la electricidad comienza un desarrollo fulgurante en el siglo XVIII. En ese período se establecen las leyes básicas y surgen las primeras teorías explicativas de los fenómenos conocidos. Coulomb cierra el siglo estableciendo la primera ley cuantitativa e introduciendo la electricidad en el marco de la ciencia newtoniana.

La bateria eléctrica de Volta y las primeras ciudades alumbradas

Volta apiló discos de igual tamaño de cobre y de cinc, sólo o con estaño, alternados, que llevan intercalados cada uno de ellos un paño humedecido. Esta “pila de discos” empieza y termina con discos de diferente tipo. Conectando con un alambre los discos situados en los extremos logró que fluyera un flujo eléctrico. Impregnando el paño en determinadas sales la corriente obtenida era mucho mayor.

Así, en el siglo XIX se abre con una aportación de gran trascendencia: la pila de Volta, cuyos efectos “son tan extraordinarios que sin exageración se puede decir que es el instrumento más maravilloso que ha creado la inteligencia humana” (González Chávarri, 1848). La pila amplia el campo de la electricidad incorporando todos los fenómenos relacionados con la entonces llamada “electricidad galvánica”. Poco más tarde, gracias a los trabajos de Oersted y Faraday, aparece otro dominio de inmensas posibilidades: el electromagnetismo. El descubrimiento de la conexión entre corriente eléctrica e imanes va a ser seguida de la puesta a punto de aparatos y máquinas que serán el soporte de la electricidad industrial y marcarán el tránsito hacia la Sociedad contemporánea.

La Electricidad acuña fama de ser un agente físico poderoso y, al mismo tiempo, sorprendente, vistos los fenómenos y efectos que suele protagonizar. Se presenta como capaz de hacer posible todo lo imaginable e inimaginable. Tanto es así que por ejemplo, es capaz de producir luz ¡sin utilizar fuego! Así, los manuales describen la experiencia realizada por Davy en 1801, que mediante una pila de gran de elementos hace saltar un arco de luz cegadora (arco voltaico) entre dos barras próximas de carbón.

Liebherr, en el emplazamiento británico de Sunderland, se decidió por el moderno procedimiento por arco voltaico pulsado, por lo que utiliza sistemas digitales del TransPuls Synergic 5000 de Fronius.

La luz a diferencia de las chispas se mantenían durante un cierto tiempo, pero las barras se iban consumiendo y llegaba un momento en que cesaba el fenómeno. Con base a experiencia se construyeron aparatos destinados a la iluminación, provistos de un complicado sistema que mantenía las distancias de las barras. El arco estaba protegido de las corrientes de aire por un tubo de vidrio.

Otro inconveniente era la duración muy limitada de pilas y baterías, pero a partir de los años 1860 comenzaron a estar operativas las dinamos y problema quedó solucionado.

No sería justo hablar de la luz sin nombrar a N. Tesla

Poco más tarde, 1880 y gracias a que el espabilado Edison se apropió de las ideas de Tesla, surgió y se impulsó la bombilla de incandescencia, dispositivo durable y de bajo coste de producir luz mediante la corriente. Ha sido el sistema que hemos conocido hasta nuestros días.

Podríamos seguir hasta llegar a lo que hoy es la Fisica, sin embargo, ni el sitio es tan extenso ni el tiempo lo permite.

emilio silvera

Jul

13

El Universo y la Vida… ¡Nuestra imaginación!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (1)

Comments (1)

“Una inteligencia que conociese, en un momento determinado, todas las fuerzas que operan en la Naturaleza, así como las posiciones momentáneas de todas las cosas que constituyen el universo, sería capaz de condensar en una sola fórmula los movimientos de los cuerpos más grandes del mundo y los de los átomos más ligeros, siempre que su intelecto sea bastante poderoso someter a análisis todos los datos; para él nada sería incierto, el pasado y el futuro estarían presentes ante sus ojos.”

¿Cómo nos la hemos ingeniado para llegar a los confines de la Galaxia?

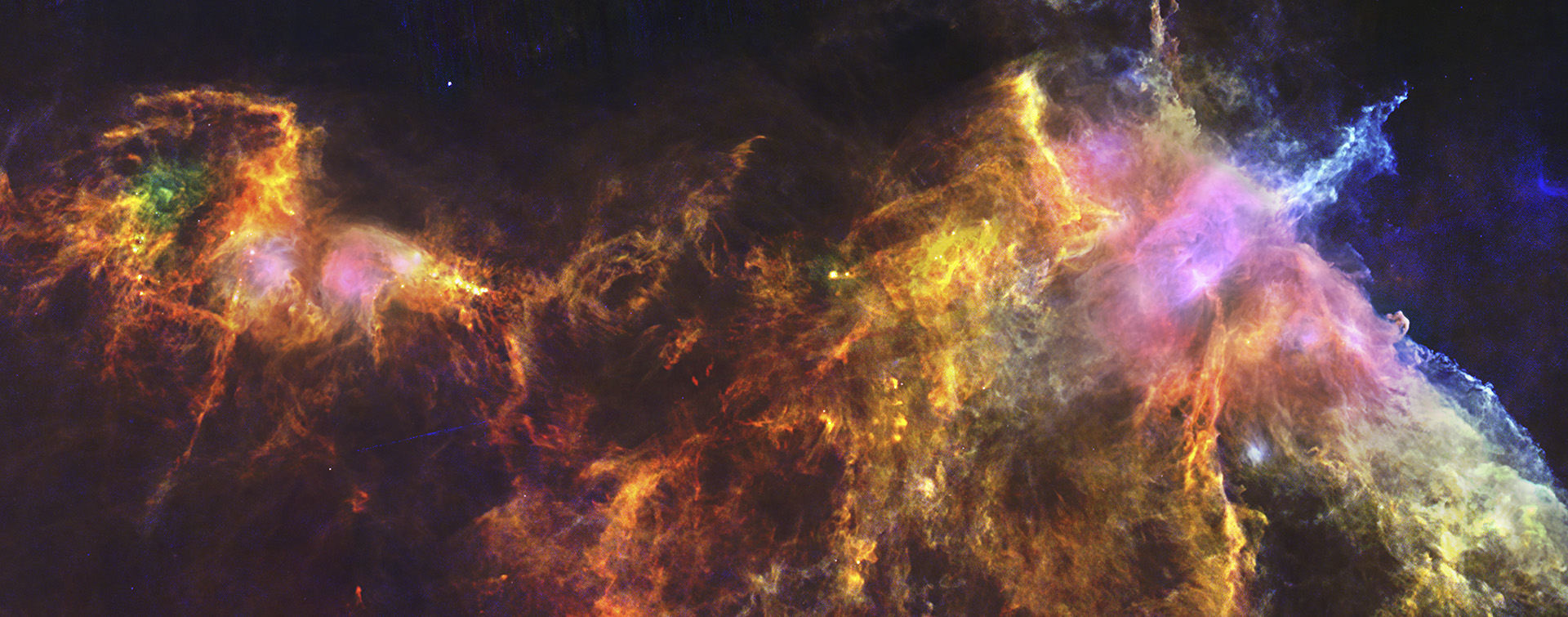

Inmensas galaxias cuajadas de estrellas, nebulosas y mundos. Espacios interestelares en los que se producen transmutaciones de materia que realizan el asombroso “milagro” de convertir unas cosas en otras distintas. Un Caos que lleva la normalidad. Estrellas que explosionan y riegan el espacio de gas y polvo constituyentes de materiales en el que se forjarán nuevas estrellas, nuevos mundos y nuevas formas de vida.

No pocas veces nos tenemos que maravillar ante las obras de la Naturaleza, en ocasiones, con pinceladas de las propias obras que nosotros mismos hemos sido capaces de crear. Así, no es extraño que algunos piensen que la Naturaleza nos creó conseguir sus fines, que el universo nos trajo aquí para poder contemplarse así mismo.

Siempre hemos tratado de saber lo que el Universo es, lo que la Naturaleza esconde para conocer los mecanismos de que ésta se vale para poder las maravcillas que podemos contemplar tanto en la tierra como en el cielo. Valles, ríos y montañas, hermosos bosques de lujuriante belleza , océanos inmensos llenos de formas de vida y, criaturas que, conscientes de todo eso, aunque algunas veces temerosas ante tanto poder, no por ello dejan de querer saber el origen de todo.

Es posible que nos creámos más de lo que en realidad somos. Queremos jugar con fuerzas que no hemos llegado a comprender y, desde las estrellas y las inmensas galaxias, los mundos y las fuerzas que todo lo rigen en el Universo, hemos querido conocer para poder, con esos conocimientos, crear la misma creación. Los científicos han dado ya el primer paso para la creación de la vida sintética, han sido capaces de crear un cromosoma completo a partir de una célula de levadura. El logro es considerado un gran hallazgo dentro de la biología sintética, que busca diseñar organismos desde sus principios más básicos.

¿Hasta dónde queremos llegar?

¿Es sabia la Naturaleza?

A veces, viendo como se desarrollan las cosas y cómo se desenvuelven los hechos a medida que el Tiempo transcurre, no tenemos más remedio que pensar que parece como sí, la Naturaleza supiera que estamos aquí y, luego, nos tiene impuesto límites que no podemos traspasar hasta que “ella” no considera que estamos preparado para ello. Un amigo asiduo a éste lugar nos decía que la Naturaleza nos preserva de nosotros mismos. Nosotros, los humanos, no conocemos ninguna regla que nos prohíba intentar todo aquello que podamos imaginar y, de esa manera, a veces, jugamos a ser dioses.

Pero, ¿acaso no somos, nosotros mismos universo? Dicen que genio es aquel que plasmar en realidad sus pensamientos y, aunque nos queda mucho camino por recorrer, lo cierto es que, hasta el presente, mucho de eso se ha plasmado ya. Es decir, hemos sabido de qué están hechas las estrellas, conocemos la existencias de las grandes estructuras del Universo constituidas por cúmulos y supercúmulos de galaxias, sabemos de mundos en los que, con mucha probabilidad puedan existir criaturas diversas que, conscientes o no, piensen, nosotros, en todos los secretos que el Universo esconde.

¿Cuánto nos contaran esas lucecillas que brillan dentro de nuestros cerebros?

Sinceramente creo que, dentro de nosotros, están todas las respuestas a las preguntas que podamos plantear, toda vez que, como parte del Universo que somos, en nuestros genes, en lo más profundo de nuestras mentes están grabados todos los recuerdos y, siendo así, solo se trata de recordar para saber lo que pasó, para comprender los orígenes y, finalmente saber, el por qué estamos aquí y para qué. Nos hemos olvidado de que somos “polvo de estrellas”, los materiales que nos conforman se forjaron en los “” nucleares de los astros que brillan en el firmamento lejano. A temperaturas de millones de grados se pudieron fusionar los elementos que hoy están en nosotros. Una Supernova, hace miles de millones de años, hizo brillar el cielo con un resplandor cegador, una enorme región quedó sembrada de materiales en forma de Nebulosa que, con el paso de los eones, conformó un sistema planetario con un Sol central que le daba luz y calor a un pequeño planeta que, mucho después, llamaron Tierra. Los seres que allí surgieron y evolucionaron, eran el producto de grandes transiciones de fase y cambios que, desde el Caos hizo todo el recorrido necesario hasta la creación de la Vida consciente.

De esa manera, sin lugar a ninguna duda, podemos hablar de un Universo viviente en el que, la materia evoluciona hasta la vida y los pensamientos. En el que en un carrusel sin fin surgen nuevas estrellas y nuevos mundos en los que, como en la Tierra, pasando el tiempo, también surgirá la vida que, podrá ser… ¡de tántas maneras! Una galaxia como la Vía Láctea tener más de cien mil millones de estrellas, en el universo pueden estar presentes más de cien mil millones de galaxias, los mundos que existen en una sola galaxia son cientos de miles de millones y, sabiendo todo eso, ¿Cómo poder pensar que la vida sea única en la Tierra?

“La vida se abre paso… ¡imparable!”

“…en alguna pequeña charca caliente, tendrían la oportunidad de hacer el y organizarse en sistemas vivos…” Eso comentaba Darwin sobre lo que podría ocurrir en la Naturaleza. Hemos podido constatar la persistencia con la que la vida, se abre paso en este mundo, la hemos podido hallar en lugares tan insólitos como fumarolas marinas a más de 100 ºC, o en aguas con una salinidad extrema, o, a varios kilómetros de profundidad bajo tierra, o, nutriendose de metales, o metanógenas y alófilas y tantas otras infinitesimales criaturas que nos han causado asombro y maravilla.

Si, amigos míos, en lo que a la vida se refiere, ésta se abre paso en los lugares más extremos e inesperados por muy malas que allí puedan estar presentes.De la misma manera, podrían estar situadas en mundos lejanos que, con unas condiciones distintas a las de la Tierra, se puedan haber creado criaturas que ni nuestra desbordante imaginación pueda configurar en la mente.

Hasta que supimos que existían otros sistemas planetarios en nuestra Galaxia, ni siquiera se podía considerar posibilidad como una prueba de que la vida planetaria fuera algo común en la Vía Láctea. Pero se sabe que más de cien estrellas de nuestra zona de la galaxia tienen planetas que describen órbitas alrededor de ellas. Casi todos los planetas descubiertos hasta ahora son gigantes de gas, como Júpiter y Saturno (como era de esperar, los planetas grandes se descubrieron primero, por ser más fáciles de detectar que los planetas pequeños), sin embargo es difícil no conjeturar que, allí, junto a estos planetas, posiblemente estarán también sus hermanos planetarios más pequeños que, como la Tierra, pudieran tener para generar la vida en cualquiera de sus millones de formas.

Es cierto que en todo el Universo rigen las mismas leyes y están presentes las mismas constantes universales que, ni con el paso del tiempo pueden variar, así la luz siempre irá a 300.000 Km/s, la carga del electrón será siempre la misma la masa del protón y, gracias a que eso es así, podemos estar nosotros aquí contarlo. Sin embargo, el Universo, no es uniforme y en el inmenso espacio interestelar impera la diversidad.

Existe una amplia variedad de densidades dentro del medio interestelar. En la modalidad más ligera, la materia que está entre las estrellas es tan escasa que sólo hay un átomo por mil centímetros cúbicos de espacio: en la modalidad más densa, las nubes que están a punto de producir nuevas estrellas y nuevos planetas contienen un millón de átomos por centímetro cúbico. Sin embargo, esto es algo muy diluido si se compara con el aire que respiramos, donde cada centímetro cúbico contiene más de diez trillones de moléculas, pero incluso una diferencia de mil millones de veces en densidad sigue siendo un contraste espectacular.

La cuestión es que, pocos investigadores destacaron allá por 1.990 en que todos estos aspectos -composición, temperatura y densidad- en el medio interestelar dista mucho de ser uniforme. Por decirlo de otra manera más firme, no está en equilibrio, y parece que lo que lo mantiene lejos del equilibrio son unos pocos de procesos asociados con la generación de las pautas espirales.

Aquí se crea entropía negativa. También nosotros, tenemos una manera de vencer a la inexorable Entropía que siempre acompaña al Tiempo, su transcurrir deja sentir sus efectos sobre las cosas que se hacen más viejas. Sin embargo, sabemos, las galaxias, generar energía reproductora y, mientras que las galaxias crean estrellas nuevas y mundos, nosotros, recreamos la vida a partir de la unión entr hombre y mujer, y, de esa unión surgen otros seres que, perpetúan nuestra especie. Es la entropía negativa que lucha contra la extinción.

Esto significa que la Vía Láctea ( otras galaxias espirales) es una zona de reducción de la entropía. Es un sistema auto-organizador al que mantienen lejos del equilibrio, por una , un flujo de energía que atraviesa el sistema y, por otra, como ya se va viendo, la retroalimentación. En este sentido, nuestra Galaxia supera el test de Lovelock para la vida, y además prestigiosos astrofísicos han argumentado que las galaxias deben ser consideradas como sistemas vivos.

que podamos ser más de lo que parece y que, seamos menos de lo que nosotros mismos nos podamos creer. No parece muy aconsejable que estemos situados en un plano de superioridad en el cual podamos mirarlo todo por encima del hombro. Precisamente por ser Naturaleza nosotros mismos, estamos supeditados a sus cambios y, por lo tanto, a merced de ellos.

El problema está, como dijo aquel hombre sabio: “¡Somos parte del problema que tratamos de resolver!”

emilio silvera

Jul

13

El Universo asombroso

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (1)

Comments (1)

Sí, el Universo se podrá ver de otra manera cuando además de la luz, sepamos traducir los mensajes de las ondas gravitacionales

¡NO! No es el gran Ojo que todo lo ve y nos mira las alturas

Simplemente se trata del fenómeno que conocemos como “Halo atmosférico”, un anilo o arco de luz que parece rodear al Sol ( a la Luna), resultado de la refracción y la reflexión de la luz solar o lunar por los cristales de hielo de los cirros. Los halos solares y lunares más comunes un diámetro angular de 46º. Por lo general, el borde del halo muestra un efecto prismático, estandio la luz azul refractada el borde exterior y la rpoja al interior. Como resultado de la refracción preferencial de la luz hacia el borde del halo , la zona del cielo interior a un halo es más oscura que la interior. Los halos lunares pueden ser vistos claramente cuando la Luna es brillante, típicamente en un intervalo de cinco días en torno a la Luna llena.

El Halo Galáctico está referido a cualquier material situado en una distribicón aproximadamente esférica de una galaxia, y que se extiende más allá de las regiones visibles. Puede referirse a la población de estrellas viejas (Población II), incluyendo a los cúmulos globulares, con poca o ninguna rotación alrededor del centro galáctico; o gas tenue, altamente ionizado y de alta temperatura que envelve a toda la galaxia, incluso, muchas veces el halo galáctico está referido a una especie de neblina inconcreta que circunda toda la galaxia sin que termine de hacerse presente pero, ahí está.

Alguna vez podemos contemplar una que nos parece más o menos atractiva pero, no sabemos discernir sobre lo que en realidad estamos contemplando. Por ejempo, arriba tenemos la conocida NGC 604, una región H II gigante en la galaxia del Triángulo. Una región H II es una de gas y plasma brillante que alcanzar un tamaño de cientos de años-luz y en la cual se forman estrellas masivas. Dichas estrellas emiten copiosas cantidades de luz ultravioleta extrema (con longitudes de onda inferiores a 912 Ångstroms) que ionizan la Nebulosa a su alrededor.

Las regiones H II son muy abundantes en Galaxia

de hidrógeno ionizado contribuye con dos partículas al gas, es decir, con un protón y un electrón. Las Regiones H II son calientes con temperaturas típicas de 10 000 K, y son 10 y 100 000 veces más densas que las regiones H I. Se encuentran normalmente alrededor de las estrellas O y B jóvenes y masivas, siendo el gas ionizado por su intensa luz ultraviloleta, haciendo que éste brille. La Nebulosa de orión es una famosa Región H II. Las Regiones H II pueden ser detectadas en la Galaxia por sus intensas emisiones en e infrarrojo. La radioemisión es debidaal bremsstrahlung del gas ionizado, y la radiación infrarroja a la emisión térmica del polvo.

Las Regiones H II aquí muy presentes y dada su gran extensión. La nebulosa de Orión es uno de los objetos astronómicos más fotografiados, examinados, e investigados.8 De ella se ha obtenido información determinante acerca de la de estrellas y planetas y a partir de nubes de polvo y gas en colisión. Los astrónomos han observado en sus entrañas discos protoplanetarios, enananas marrones, fuertes turbulencias en el movimiento de partículas de gas y efectos fotoionizantes cerca de estrellas muy masivas próximas a la nebulosa.

Una región H I es una nube formada por hidrógeno atómico frío, poco denso y no ionizado con temperaturas de alrededor de 100 K. Las regiones HI no emiten radiación en el rango visual, sólo en la región de radio. La notación H I se refiere al hecho de que los átomos de Hidrógeno no están ionizados lo están en los que están presentes en la regiones H II (arriba). Cada átomo de Hidrógeno neutro contribuye al gas justo con una partícula. la Densidad de las regiones H I es demasiado como que se formen moléculas de hidrógeno, y la luz estyelar disociará cualquier molécula formada, de manera que el gas permanece en forma de átomo. El Hidrñógeno neutro contrinuye aproximadamernte a la mitad de toda la materia interestelar en masa y en volumen, con una densidad media de 1 Átomo/ cm3. Las regiones H I son frías.

Del asomnbroso universo son miuchas las cosas que desconocemos, y, poco a poco, vamos pudiendo muchos de sus misterios que nos acercan cada vez más, a saber dónde estamos y lo que podemos o no podemos esperar de lo que hay en nuestro entorno.

La de que la Voyager 1 había dejado atrás la zona bajo influencia directa del viento solar y se encontraba ya surcando el interplantario se convirtió rápidamente en una de las grandes noticias astronómicas del año, en especial por toda la carga simbólica que representa que, por primera vez, un construido por la Humanidad había traspasado por primera vez esa frontera invisible que nos separa y aisla del océano estelar. Pero para los científicos de la misión la llegada a este reino con una sonda aún operativa y capaz de seguir enviado al menos 2020 es un regalo del que esperan grandes resultados. Y es que más allá del límite solar se extiende una región tan amplia como desconocida, y mucho más compleja de lo que podamos imaginar.

El movimiento de estrella binaria fue un misterio durante más de 30años, e incluso se presentó como un posible fracaso de la Relatividad General de Einstein. un encabezado por el Instituto de Astrofísica de Andalucía (IAA-CSIC) ha resuleto el misterio. Se observan hechos que no siempre podemos explicar y, persistimos en la búsqueda de las respuestas que las podemos encontrar.

En el efecto periastro se puede contemplar el brillo de una estrella binaria que tiene una órbita altamente excéntrica. Cuando la separación las componentes es mínima. Es de hecho, un aumento del efecto de reflexión en el instante del periastro, y surge por la misma causa: la irradiación de una estrrella por la otra.

Hemos llegado a saber de nuevas estrellas, vientos estelares, radiación, energías, estrellas de neutrones o púlsares, agujeros negros, enanas rojas y blancas, ¿estrellas de Quarks? ¿materia oscura? mundos…¿Civilizaciones? ¡El Universo! Lo que todo lo contiene, ahí estan presentes todas las cosas que existen y las que tienen que existir… El espaciotiempo, las fuerzas fundamentales de la Naturaleza…¡La Vida!

Cuando pensamos en la edad y el tamaño del Universo lo hacemos generalmente utilizando medidas de tiempo y como años, kilómetros o años-luz. Como y a hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del Universo con un “reloj” que hace “tic” vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿porqué medir su densidad en términos de átomos por metro cúbico? Las a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho así.

Ésta es una situación en resulta especialmente apropiado utilizar las unidades “naturales” la , longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

Es caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros , lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

A lo menos una vez al día, el cielo en su alta, es iluminado por un gran destello producido por grandes explosiones de rayos gamma. A menudo, esos destellos alcanzan magnitudes superiores a las que pueden ser generadas por todo un conjunto de otros rayos cósmicos y desaparecen posteriormente sin dejar más rastro. Nadie puede predecir cuando volverá a ocurrir la próxima explosión o de que dirección del cielo procederá. Hasta , no contamos con evidencias duras como para cuáles podrían ser las fuentes precisas de donde provienen esos rayos gamma que observamos en lo alto del cielo, las razones que ocasionan los grandes destellos y la distancia en la cual ocurre el fenómeno.

La edad del Universo visible ≈ 1060 tiempos de Planck

Tamaño del Universo visible ≈ 1060 longitudes de Planck

La masa del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el Universo es un reflejo del hecho de que:

Densidad del Universo visible ≈10-120 de la densidad de Planck

Y la temperatura del , a 3 grados sobre el cero absoluto, es, por tanto

Temperatura del Universo visible ≈ 10-30 de la Planck

Nosotros, una simple brizna de materia que el Universo elaboró utilizanso la evolución que se produce en el del tiempo y, de esa manera, la evolución de la materia “inerte” llega poder alcanzar los pensamientos, es decir, la Consciencia de Ser.

números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el Universo está estructurado en una escala sobre humana de proporciones asombrosas la sopesamos en los balances de su propia construcción.

Con respecto a sus patrones el Universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

, pese a la enorme edad del Universo en “tics” de Tiempos de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

En todas las regiones del interestelar donde existen objetos de enormes densidades y estrellas supermasivas se pueden producir sucesos de inmensas energías y, en regiones de gas y polvo de muchos años-luz de diámetro, es donde surgen los Sistemas solares que contienen planetas aptos la vida.

¿Por qué nuestro Universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el Universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos tienen sus problemas. Conforme para el tiempo en el Universo el proceso de de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habían sido procesados por las estrellas y lanzados al intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron , la entropía va debilitando la energía del para realizar . La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un magnético en un planeta, entonces será muy poco probable que la vida evolucione formas complejas.

Las estrellas típicas como el Sol, emiten su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un magnético, los posibles habitantes de ese planeta lo podrían complicado soportando tal lluvia de radiactividad. En nuestro solar el magnético de la Tierra ha protegido su atmósfera del viento solar, Marte, que no está protegido por ningún magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, existen series amenazas exteriores.

La mayoría de asteroides, incluyendo Vesta, están en el cinturón de asteroides que se sitúa Marte y Júpiter. Otros asteroides giran en círculos mas del Sol que de la Tierra, mientras que un gran de ellos comparten orbitas planetaria. Dada gran variedad de asteroides, algunos particularmente extraños han descubiertos en los últimos dos siglos desde que el primer asteroide fuera descubierto (Ceres en 1801).

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una serie y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución, o, por el contrario, evitar que siga cualquier de evolución produciendo la extinción total y dejando la Tierra como un planeta muerto.

los Gobiernos más avanzados, están constituyendo un consorcio para colaborar en la detección de estos imprevistos visitantes que nos podrían dar desagradables sorpresas nunca deseadas. Detectarlos a tiempo siempre será mejor que velos llegar de con las rerribles consecuencias que dicha caída en el planeta puede provocar.

emilio silvera

Totales: 75.547.102

Totales: 75.547.102 Conectados: 47

Conectados: 47