Feb

27

¡La Humanidad! (Aquí un fragmento)

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Humanidad ~

Clasificado en Humanidad ~

Comments (0)

Comments (0)

Nuestra especie es muy homogénea en sus características: somos muy similares a pesar de lo que pudiera parecer a causa de las diferencias del color en la piel o en los rasgos faciales de las diferentes poblaciones. Tanto los datos de la genética homo los de la paleantropología muestran que los seres humanos, como especie, procedemos de un grupo pequeño de antepasados que vivían en África hace unos cuatrocientos mil años.

Tardamos mucho en llegar al punto en el que ahora nos encontramos y, el camino ha sido largo y no siempre placentero. Lo que podemos considerar el Ser Humano verdadero, no pareció en nuestro planeta hasta hace unos escasos sesenta mil años, y, a partir de ahí, comenzamos a dejar huellas de nuestro evolucionado ingenio y de cómo tratamos de saber de todo aquello que era misterioso y un secreto para nosotros.

Hemos encontrado incisiones en huesos de animales para representar las fases de la Luna. Aquellos antepasados nuestros vivían de la caza y la recolección, por lo que seguían las estrellas y predecían los cambios de estación gracias al cielo. Quizá observaban el Sol y la Luna y los dibujos que formaban las estrellas para conocer las estaciones.

Probablemente así era cuando se desarrolló la agricultura y se domesticaron animales, 10.000 años antes de Cristo en Mesopotamia, la tierra fértil entre los ríos Tigris y Éufrates que ahora ocupa Irak. El cielo adquirió aún más importancia como medio para determinar la época apropiada para la siembra y la cosecha. Esas primeras civilizaciones mesopotámicas, especialmente los sumerios hacia 4.000 a. C., fueron las que dieron nombre a las más antiguas constelaciones: son las figuras que hoy conocemos como Leo, Tauro y Escorpio. Estas constelaciones señalaban puntos importantes en el recorrido anual del Sol por el cielo y constituían momentos cruciales en el año agrícola. Y, como los cielos condicionaban su forma de vida, los deificaron.

Acordáos de Hypatia de Alejandría, considerada por muchos como la primera mujer científica de la historia, dedicó muchos de sus estudios a la astronomía. Pero, ¿cómo era su cielo?, ¿cómo veían nuestros ancestros los cuerpos celestes?

Se pierde en la noche de los tiempos el hecho de que los seres humanos se han maravillado desde siempre con el espectáciulo que podían contemplar en los cielos de las noches oscuras y estrelladas, sin la contaminación lumínica de nuestras grandes ciudades. Todos aquellos pueblos y culturas antiguas elevaron sus mitos y leyendas hasta la estrellas lejanas, inalcanzables. En ellas veían (o creyeron ver), las figuras majestuosas que su imaginación les dictaba y obtenían figuras de animales mitológicas que dibujaban conjuntos de estrellas que también, les mostraba las imponentes figuras de sus héroes.

Pero, como me pasa siempre, me desvío del tema principal que quería tratar hoy. Sigamos el hilo del comienzo de este trabajo.

Hemos logrado determinar con precisión nuestros orígenes como especie mediante precisos análisis genéticos; por ejemplo, los estudios llevados a cabo sobre los genes de las mitocondrias pertenecientes a individuos de todas las poblaciones del mundo y de todas las razas.

Estudiando el A D N mitocondrial de miles de personas se ha llegado a formular la llamada “Teoría de la Eva Negra”, según la cual todos nosotros, los Homosapiens sapiens, procedemos de una hembra que vivió en algún lugar de África hace ahora unos tres cientos mil años. Otros estudios se han realizado mediante el análisis del polimorfismo del cromosoma Y.

Pero tanto unos estudios como otros han dado el resultado similar. Los estudios del material genético del cromosoma Y confirman que la Humanidad tuvo un antepasado varón que vivió en África hace unos doscientos mil años. Seria la “Teoría del Adan Negro”. Estudios del Gen de la hemoglobina ratifican que todas las poblaciones humanas modernas derivan de una población ancestral africana de hace unos doscientos mil años compuesta por unos seiscientos individuos.

cráneo de kabwe

Los hallazgos paleoantropológicos ratifican el origen único y africano de nuestra especie. Se han encontrado en diversa regiones de África algunos fósiles, de características humanas modernas, con una antigüedad de entre tres cientos mil y cien mil años; estos incluyen: el cráneo de kabwe (en Zambia), de 1.285 c.c.; el fósil KNM-ER-3834 del lago Turkan, en Kenia, de casi litro y medio; los fósiles encontrados en los yacimientos de Border Cave y Klassies River Mouth, de África del sur; y los esqueletos y cráneos encontrados en los enterramientos de la Cueva de Qafzeh y del abrigo de Skhul, ambos en Israel y datados en unos cien mil años.

En 1.968 se descubrieron en Dordoña el cráneo y el esqueleto de uno de nuestros antepasados, al que se denominó Hombre de Cro-Magnon. Hoy sabemos que hace unos cuarenta mil años aparecieron en Europa unos inmigrantes de origen africano, que eran los primeros representantes de la especie Homo sapiens sapiens que alcanzaban estos territorios. Llegaron con unas armas terribles e innovadoras, conocían el modo de dominar el fuego y poseían una compleja organización social; y por lo que se refiere a las otras especies de homínidos que habitaban por aquel entonces Europa, concretamente los Homo neandertales, al parecer, los eliminaron por completo.

Los cromañones poseían las características de los pobladores de las regiones próximas al ecuador: poco macizos, muy altos y de brazos y piernas largas; sus huesos eran muy livianos por aumento del canal medular, dentro de la diáfisis. Los huesos que formaban las paredes del cráneo eran más finos, que los de sus predecesores. Habían sufrido una reducción de la masa muscular. El desarrollo de armas que podían matar a distancia con eficacia y sin requerir gran esfuerzo, como los propulsores, las hondas y, más tarde, el arco y las flechas, hicieron innecesarias una excesiva robustez. En general, eran muy parecidos a nosotros y, hasta tal punto es así que, si cogiéramos a uno de estos individuos, lo lleváramos a la peluquería, le pusiéramos un buen traje, y lo sacáramos de paseo, se confundiría con el resto de la gente sin llamar a atención.

Llegado a este punto, no merece la pena relatar aquí las costumbres y forma de vida de esas poblaciones que, en tantos y tantos escritos hemos podido leer y conocemos perfectamente. El objeto de todo esto era esbozar un perfil de lo que fuimos, de manera que dejemos ante nosotros la evolución que hemos sufrido hasta llegar aquí, y, a partir de ahora, pensar en la evolución que nos queda hasta convertirnos en los seres del futuro que, seguramente, regirán en el Universo.

En todo esto que estamos tratando, tenemos que luchar con dos problemas enormes:

- Nuestra ignorancia

- La existencia o no existencia de Dios

Está claro que, el punto uno, se va resolviendo poco a poco, a medida que transcurren los siglos y vamos avanzando en los conocimientos del mundo y del Universo que nos acoge. También, algo más despacio, conocemos de nosotros mismos, de las sensaciones que percibimos y de las fuerzas internas que nos empujan a ciertos comportamientos, no pocas veces inexplicables. ¿ Cómo podríamos explicar el comportamiento de un enamorado ? Para bien o para mal, los sentimientos son las que nos mueven. Sin embargo, y, desgraciadamente, también intervienen la ambición desmedida y otros sentimientos menos nobles.

Richard Dawkins, biólogo y evolucionista británico ha publicado un libro que ha titulado Es espejismo de Dios, en el que pretende demostrar científicamente que el “Sumo Creador” es una pura ficción de la mente Humana y, refuta de manera sistemática los argumentos teológicos clásicos de San Anselmo, San Agustín, y Santo Tomás, exponiendo en contra la tesis más sencilla y coherente para explicar el surgir de alas en los pájaros, aletas en los peces y la misma vista, dejando las creencias religiosas o viejos sentimientos y creencias tribales nacidas desde la ignorancia y el miedo a lo desconocido.

Richard Dawkins

¡Pobre Sr.Dawkins! no sabe en el lío que se ha metido.

Científicamente considerado, la presencia de un Dios invisible que todo lo puede y creador del Universo: Es dura. Sin embargo…. ¿Qué podemos saber nosotros? Mejor sería dejar la respuesta en el aire, ni afirmar, ni negar. El tema es muy delicado y tampoco aquí queremos herir los sentimientos de nadie, hay que respetar a los demás y, cada cual, es libre de creer en lo que estime conveniente para él.

Mucho he reflexionado sobre el tema y para mí, sólo para mí, tengo una respuesta muy clara.

Pero el que es práctico, como Pascal, por ejemplo: planteó el mismo dilema en términos de apuesta y concluyó que era menos arriesgado confiar en Dios que en su inexistencia porque el ser Humano no tiene nada que perder si hay un ente superior.

Es una manera como otra cualquiera de ver las cosas, he leído tantas versiones sobre la existencia de Dios que ya nada me sorprende. Algunos continúan buscando las pruebas y sigo desde lejos las noticias que se publican a tal respecto, claro que, la noción de Dios, como cualquier otro material psíquico, tal vez pueda probarse algún día que está muy cerca, posiblemente contenida en nuestra herencia genética, es decir, que podría tratarse de un producto más de nuestra mente pensante que obtiene recursos sin límites para cada ocasión, sacando tan prodigiosos hallazgos que vienen a dar una esperanza divina a una Humanidad atormentada y sin horizonte de futuro.

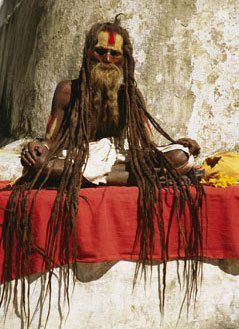

Hace miles de años en la India, la tierra del Veda, los Rishis o veedores capaces de cognizar los ritmos y las melodías de la naturaleza cantaron y … En todos los pueblos, las religiones adoptaron la ideal de la existencia del Alma, ese algo que está más alláde lo material, lo que perdura, lo que podía ser salvado y que, como Ente independiente del cuerpo, traspasaba las fronteras materiales para ir al más allá, ese otro reino de los elegidos. En realidad, la palabra Alma, está referida a todo lo viviente, a lo que no es inerte aunque, su origen venga de aquel.

“El alma desde el punto de vista védido o veda es El Ser, que por naturaleza es eterno (sin nacimiento ni muerte o sin principio ni fin) de substancia diferente a la del cuerpo físico y que posee conciencia propia. Desde este punto de vista, la ciencia material o la que estudia los fenómenos físicos o materiales, es limitada porque no puede estudiar fenómenos espirituales ya que su naturaleza es diferente a la física.”

Hace años leí un libro, el autor se llamaba Dean Hamer, que hace tiempo creyó descubrir un gen que llamó VMATZ, que sería la sede cerebral de la espiritualidad y, en consecuencia, el responsable de las ideas humans de una deidad absoluta necesaria para el mantenimiento de la via psiquica, e incluso, para la conservación de la especie a través de este espíritu superior que nos hace amar a nuestros hijos que son la prueba suprema de la existencia de Dios.

Desde el comienzo mismo de este trabajo, en el que, se habla de cosmología, y, se pasa rápidamente al universo de los sentidos y de la conciencia, hemos realizado un amplio recorrido por lo sensorial, y, hemos retrocedido, para hacer un esbozo del largo camino recorrido por los humanos, hasta llegar al nivel de entendimiento que hoy posee.

Hemos especulado con lo que entendemos por conciencia y lo que significa el SER, la privacidad de pensamientos individuales y la unidad y coherencia de la experiencia consciente en cada individuo, la enorme riqueza y variedad que la infinita complejidad del cerebro humano concede a cada individuo para ver de manera particular y única cualquier cuestión planteada, de manera tal que, cada respuesta a la pregunta planteada, pueda resultar original y

distinta a los demás.

Nuestro cerebro es mucho más que una fría computadora, y puede dar respuestas a problemas no previstos, repentizando soluciones adecuadas a las necesidades. El poder de los sensores naturales que posee el cerebro humano, es enorme y su capacidad impensable. Las experiencias conscientes de nuestra especie, están profundamente adoptadas por los genes y las neuronas “recuerdan” cuando reciclan los datos en los procesos del pensamiento. Es la evolución.

Nuestro cerebro ha evolucionado y aprendido a través de las experiencias vividas por sus portadores y transmitidos por los sentidos. El entorno, la naturaleza, la forma de vida, los alimentos, las distintas sociedades, los elementos climáticos, los peligros…, todo ello, ha contribuido a que nuestras mentes avancen.

Hay un plano superior de la mente que sobrepasa lo estrictamente material, es un nivel más alto, inmaterial, que se sale del cuerpo, que no está limitado por las condiciones físicas, que está en otro Universo que vemos sólo en nuestras mentes y que no es posible tocar. Allí residen los pensamientos, se forjan los sentimientos, conviven las ideas y nace lo mejor, y, lamentablemente, lo peor de nosotros.

emilio silvera

Feb

25

¡Los grandes Números del Universo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (2)

Comments (2)

Cuando los físicos empezaron a apreciar el papel de las constantes en el dominio cuántico y explotar la nueva teoría de la gravedad de Einstein para describir el universo en su conjunto, las circunstancias eran las adecuadas para que alguien tratara de casarlas.

Así entró en escena Arthur Stanley Eddington: un extraordinario científico que había sido el primero en descubrir cómo se alimentaban las estrellas a partir de reacciones nucleares. También hizo importantes contribuciones a nuestra comprensión de las galaxias, escribió la primera exposición sistemática de la teoría de la relatividad general de Einstein y fue el responsable de la expedición que durante un eclipse de Sol, pudo confirmar con certeza la predicción de la relatividad general que debería desviar la luz estelar que venía hacia la Tierra en aproximadamente 1’75 segundos de arco cuando pasaba cerca de la superficie solar, cuyo espacio estaría curvado debido a la gravedad generada por la masa del Sol. En aquella expedición, el equipo de Eddington hizo una exitosa medición del fenómeno desde la isla Príncipe, que confirmó que Einstein tenía razón y que su teoría predecía de manera exacta la medida de curvatura del espacio en función de la masa del objeto estelar que genera la gravitación distorsionando el espaciotiempo a su alrededor.

Eddintong

Entre los números que Eddington consideraba de importancia primordial estaba al que ahora conocemos como número de Eddington, que es igual al número de protones en el universo visible. Eddington calculó (a mano) este número con enorme precisión en un crucero trasatlántico, sentado en cubierta, con libreta y lápiz en la mano, tras calcular concienzudamente durante un tiempo, finalizó escibiendo:

“Creo que el Universo hay:

15.747.724.136.275.002.577.605.653.961.181.555.468.044.717.914.527.116.709.366.231.425.076.185.631.031.296

de protones y el mismo número de electrones”.

Este número enorme, normalmente escrito NEdd, es aproximadamente igual a 1080. Lo que atrajo la atención de Eddington hacia él era el hecho de que debe ser un número entero, y por eso en principio puede ser calculado exactamente. A Eddington siempre le llamó la atención esos números invariantes que llamaron constantes de la Naturaleza y que tenían que ver con el electromagnetismo, la gravedad, la velocidad de la luz y otros fenómenos naturales invariantes. Por ejemplo:

La constante de estructura fina de (símbolo  ) es la constante fundamental que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

) es la constante fundamental que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

La expresión que la define y el valor recomendado es:

.

donde:

es la carga elemental.

es la carga elemental.

es la constante racionalizada o reducida de Planck,

es la constante racionalizada o reducida de Planck,

es la velocidad de la luz en el vacío, y

es la velocidad de la luz en el vacío, y es la permitivdad del vacío.

es la permitivdad del vacío.

Durante la década de 1.920, cuando Eddington empezó su búsqueda para explicar las constantes de la naturaleza, no se conocían bien las fuerzas débil y fuerte. Las únicas constantes dimensionales de la física que sí se conocían e interpretaban con confianza eran las que definían la gravedad y las fuerzas electromagnéticas. Eddington las dispuso en tres puros números adimensionales. Utilizando los valores experimentales de la época, tomó la razón entre las masas del protón y del electrón:

mpr/me ≈ 1840

La inversa de la constante de estructura fina

2πhc/e2 ≈ 137

Y la razón entre la fuerza gravitatoria y la fuerza electromagnética entre un electrón y un protón,

e2/Gmpr me ≈ 1040

A estas añadió su número cosmológico, NEdd ≈ 1080. A estos cuatro números los llamó “las constantes últimas”, y la explicación de sus valores era el mayor desafío de la ciencia teórica:

“¿Son estas cuatro constantes irreducibles, o una unificación posterior de la física que pueda demostrar que una o todas ellas podrían ser prescindibles? ¿Podrían haber sido diferentes de lo que realmente son?… Surge la pregunta de si las razones anteriores pueden ser asignadas arbitrariamente o si son inevitables. En el primer caso, sólo podemos aprender sus valores por medida; en el segundo caso es posible encontrarlos por la teoría… Creo que ahora domina ampliamente la opinión de que las (cuatro anteriores) constantes… no son arbitrarias, sino que finalmente se les encontrará una explicación teórica; aunque también he oído expresar lo contrario.”

Medida una y mil veces, α parece que no cambia a pesar de todo

Siguiendo con su especulación Eddington pensaba que el número de constantes inexplicadas era un indicio útil del hueco que había que cerrar antes de que se descubriese una teoría verdaderamente unificada de todas las fuerzas de la naturaleza. En cuanto a si esta teoría final contenía una constante o ninguna, tendríamos que esperar y ver:

“Nuestro conocimiento actual de 4 constantes en lugar de 1 indica meramente la cantidad de unificación de la teoría que aún queda por conseguir. Quizá resulte que la constante que permanezca no sea arbitraria, pero de eso no tengo conocimiento.”

Eddington, como Max Planck, Einstein y Galileo, y Newton antes que ellos, era simplemente un adelantado a su tiempo; comprendía y veía cosas que sus coetáneos no podían percibir.

Hay una anécdota que se cuenta sobre esto y que ilustra la dificultad de muchos para reconciliar el trabajo de Eddington sobre las constantes fundamentales con sus monumentales contribuciones a la relatividad general y la astrofísica. La historia la contaba Sam Goudsmit referente a él mismo y al físico holandés Kramers:

Samuel Abraham Goudsmit, George Uhlenbeck y Hendrik Kramers

“El gran Arthur Eddington dio una conferencia sobre su derivación de la constante de estructura fina a partir de una teoría fundamental. Goudsmit y Kramers estaban entre la audiencia. Goudsmit entendió poco pero reconoció que era un absurdo inverosímil. Kramers entendió mucho y reconoció que era un completo absurdo. Tras la discusión, Goudsmit se acercó a su viejo amigo y mentor Kramers y le preguntó: ¿Todos los físicos se vuelven locos cuando se hacen mayores? Tengo miedo. Kramers respondió, “No Sam, no tienes que asustarte. Un genio como Eddington quizá puede volverse loco pero un tipo como tú sólo se hace cada vez más tonto”.

“La historia es la ciencia de las cosas que no se repiten”.

Paul Valéry

Aquí también están algunas de esas constantes

Los campos magnéticos están presentes por todo el Universo. Hasta un diminuto (no por ello menos importante) electrón crea, con su oscilación, su propio campo magnético, y, aunque pequeño, se le supone un tamaño no nulo con un radio ro, llamado el radio clásico del electrón, dado por r0 = e2/(mc2) = 2,82 x 10-13 cm, donde e y m son la carga y la masa, respectivamente del electrón y c es la velocidad de la luz.

Nuestro universo es como lo podemos observar gracias a esos números

El mayor misterio que rodea a los valores de las constantes de la naturaleza es sin duda la ubicuidad de algunos números enormes que aparecen en una variedad de consideraciones aparentemente inconexas. El número de Eddington es un ejemplo notable. El número total de protones que hay dentro del alcance del universo observable esta próximo al número

1080

Si preguntamos ahora por la razón entre las intensidades de las fuerzas electromagnéticas y gravitatoria entre dos protones, la respuesta no depende de su separación, sino que es aproximadamente igual a

1040

En un misterio. Es bastante habitual que los números puros que incluyen las constantes de la naturaleza difieran de 1 en un factor del orden de 102, ¡pero 1040, y su cuadrado 1080, es rarísimo! Y esto no es todo. Si seguimos a Max Planck y calculamos en valor estimado para la “acción” del universo observable en unidades fundamentales de Planck para la acción, obtenemos.

10120

Supernovas, Nebulosas, Estrellas… ¡Fuerzas y Constantes fundamentales!

Algunos llegan a afirmar que, el Universo es plano e indican que la energía oscura es probablemente la constante cosmológica de Einstein…¡Vivir para ver! El maestro llegó a decir que incluir la constante cosmológica en su ecuación había sido el mayor error de su vida y, sin embargo ahora… resulta que sí estaba en lo cierto. ¡Ya veremos!

Ya hemos visto que Eddington se inclinaba a relacionar el número de partículas del universo observable con alguna cantidad que incluyera la constante cosmológica. Esta cantidad ha tenido una historia muy tranquila desde esa época, reemergiendo ocasionalmente cuando los cosmólogos teóricos necesitan encontrar una manera de acomodar nuevas observaciones incómodas. Recientemente se ha repetido este escenario. Nuevas observaciones de alcance y precisión sin precedentes, posibilitadas por el telescopio espacial Hubble trabajando en cooperación con telescopios sensibles en tierra, han detectado supernovas en galaxias muy lejanas. Su pauta de brillo y atenuación característica permite deducir su distancia a partir de su brillo aparente. Y, sorprendentemente, resulta que están alejándose de nosotros mucho más rápido de lo que cualquiera esperaba. La expansión del universo ha pasado de ser un estado de deceleración a uno de aceleración. Estas observaciones implican la existencia de una constante cosmológica positiva (Λ+). Si expresamos su valor numérico como número puro adimensional medido en unidades del cuadrado de la longitud de Planck, entonces obtenemos un número muy próximo a

10-120

Nunca se ha encontrado un número más pequeño en una investigación física real. Podemos decir que es el más grande de los pequeños números.

Hablar del Universo en todo su conjunto…, no es nada fácil. Podemos hablar de parcelas, de elementos por separado y también de sucesos, objetos y de la mecánica celeste de manera individualizada para tratar de comprenderlos mejor y, más tarde, juntarlos para tener una perspectiva de su conjunto que… No siempre podemos llegar a comprender. ¡Es tanto lo que esas constantes nos quieren decir! que comprenderlas y entenderlo todo…, nos llevará algún tiempo.

¿Qué vamos a hacer con todos estos grandes números? ¿Hay algo cósmicamente significativo en 1040 y sus cuadrados y cubos?

Hermann Weyl

La aparición de algunos de estos grandes números ha sido una fuente de sorpresas desde que fue advertida por vez primera por Hermann Weyl en 1.919. Eddington había tratado de construir una teoría que hiciera comprensible su aparición, pero no logró convencer a un número significativo de cosmólogos de que estaba en la vía correcta. Pero sí convenció a la gente de que había algo que necesitaba explicación. De forma inesperada, fue precisamente uno de sus famosos vecinos de Cambridge quien escribió a la revista Nature la carta que consiguió avivar el interés por el problema con una idea que sigue siendo una posibilidad viable incluso hoy.

Paul Dirac

Paul Dirac ocupó la cátedra lucaciana de matemáticas en Cambridge durante parte del tiempo en que Eddington estuvo viviendo en los observatorios. Las historias que se cuentan de Paul Dirac dejan muy claro que era un tipo con un carácter peculiar, y ejercía de matemático las 24 h. del día. Se pudo saber que su inesperada incursión en los grandes números fue escrita durante su viaje de novios (Luna de miel), en febrero de 1937.

Aunque no muy convencido de las explicaciones de Eddington, escribió que era muy poco probable que números adimensionales muy grandes, que toman valores como 1040 y 1080, sean accidentes independientes y no relacionados: debe existir alguna fórmula matemática no descubierta que liga las cantidades implicadas. Deben ser consecuencias más que coincidencias.

Esta es la hipótesis de los grandes números según Dirac:

“Dos cualesquiera de los números adimensionales muy grandes que ocurren en la naturaleza están conectados por una sencilla relación matemática, en la que los coeficientes son del orden de la unidad”.

Las dos imágnrees nos hablan por sí mismas, y, sin indicaciones sobre ellas, ¿cuál es el universo y cuál el cerebro humano? Nos puede parecer mentira pero… Los verdaderos grandes números están en ¡La Mente!

Los grandes números de que se valía Dirac para formular esta atrevida hipótesis salían del trabajo de Eddington y eran tres:

N1 = (tamaño del universo observable) / (radio del electrón)

= ct (e2/mec2) ≈ 1040

N2 = Razón fuerza electromagnética-a-gravitatoria entre protón y electrón

= e2/Gme mp ≈ 1040

N = número de protones en el universo observable

= c3t/Gmp ≈ 1080

Aquí t es la edad actual del universo, me es la masa de un electrón, mp es la masa de un protón, G la constante de gravitación, c la velocidad de la luz y e la carga del electrón.

El Universo es todo lo que existe: Materia, Tiempo y Espacio inmenrsos en un océano de fuerzas y constantes

Según la hipótesis de Dirac, los números N1, N2y raizN eran realmente iguales salvo pequeños factores numéricos del orden de la unidad. Con esto quería decir que debe haber leyes de la naturaleza que exijan fórmulas como N1 = N2, o incluso N1 = 2N2. Un número como 2 ó 3, no terriblemente diferente de 1 está permitido porque es mucho más pequeño que los grandes números implicados en la fórmula; esto es lo que él quería decir por “coeficientes…. del orden de la unidad”.

Esta hipótesis de igualdad entre grandes números no era en sí misma original de Dirac. Eddington y otros habían escrito antes relaciones muy semejantes, pero Eddington no había distinguido entre el número de partículas del universo observable, que se define como una esfera centrada en nosotros con un radio igual a la velocidad de la luz multiplicada por la edad actual del universo, o lo que es lo mismo:

La trayectoria del llamado Universo Observable (y del cual somos su centro al recorrer su geodésica en la geometría espacio-temporal) tiene la forma perimetral de una gota (forma de media lemniscata; cosa curiosa, lemniscata: figura curva ∞ usada como el símbolo de infinito ¿?) que al girarla 45 ° y desarrollar un cuerpo de revolución, se obtienen dos campos toroidales cual si fuesen imágenes antagónicas (una reflejada) de una fuente (surtidor – sumidero cada uno), correspondiendo uno al campo material y el otro al antimaterial.

Trayectoria del Universo observable.

Lo están ocupando en su totalidad, se retroalimentan a sí mismos en la Hipersingularidad (punto de contacto de los dos campos, principio y fin de ambos flujos donde reacciona la materia y la antimateria con la finalidad de mantener separados ambos universos con el adicional resultado de impulsar nuevamente a los fluidos universales de ambos campos a recorrer la finita trayectoria cerrada (geodésica) siendo el motor propulsor universal de dos volúmenes dinámicos, finitos pero continuos).

Universo observable: R = 300.000 × 13.500.000.000

La propuesta de Dirac provocó un revuelo entre un grupo de científicos vociferantes que inundaron las páginas de las revistas especializadas de cartas y artículos a favor y en contra. Dirac, mientras tanto, mantenía su calma y sus tranquilas costumbres, pero escribió sobre su creencia en los grandes números cuya importancia encerraba la comprensión del universo con palabras que podrían haber sido de Eddington, pues reflejan muy estrechamente la filosofía de la fracasada “teoría fundamental”.

“¿No cabría la posibilidad de que todos los grandes sucesos presentes correspondan a propiedades de este Gran Número [1040] y, generalizando aún más, que la historia entera del universo corresponda a propiedades de la serie entera de los números naturales…? Hay así una posibilidad de que el viejo sueño de los filósofos de conectar la naturaleza con las propiedades de los números enteros se realice algún día”.

Cuando hablamos del Universo, de inmediato, surgen las polémicas y los desacuerdos y las nuevas ideas y teorías modernas que quieren ir más allá de lo que “se sabe”, nunca han gustado en los centros de poder de la Ciencia que ven peligrar sus estatus con ideas para ellos “peregrinas” y que, en realidad, vienen a señalar nuevos posibles caminos para salir del atolladero o callejón sin salida en el que actualmente estamos inmersos: Mecánica cuántica y Relatividad que llevan cien años marcando la pauta en los “mundos” de lo muy pequeño y de lo muy grande sin que nada, las haya podido desplazar.

Mientras tanto, continuamos hablando de materia y energía oscura que delata la “oscuridad” presente en nuestras mentes, creamos modelos incompletos en el que no sabemos incluir a todas las fuerzas y en las que (para cuadrar las cuentas), hemos metido con calzador y un poco a la fuerza, parámetros que no hemos sabido explicar (como el Bosón de Higgs en el Modelo Estándar que…, a pesar de todo ¡No está muy claro que esté ahí!). Sin embargo y a pesar de todo, el conocimiento avanza, el saber del mundo aumenta poco a poco y, aunque despacio, el conocimiento no deja de avanzar y, esperemos que las ideas surjan y la imaginación en la misma medida para que, algún día en el futuro, podamos decir que sabemos, aunque sea de manera aproximada, lo que el Universo es.

No debemos dejar de lado, las Unidades de Planck, esos pequeños números que, como Tiempo de Planck…

En este ámbito hablamos de las cosas muy pequeñas, las que no se ven

Es el tiempo que necesita el fotón (viajando a la velocidad de la luz, c, para moverse a través de una distancia igual a la longitud de Planck. Está dado por , donde G es la constante gravitacional (6, 672 59 (85) x 10-11 N m2 kg-2), ħ es la constante de Planck racionalizada (ħ = h/2л = 1,054589 x 10-34 Julios segundo), c, es la velocidad de la luz (299.792.458 m/s).

El valor del tiempo del Planck es del orden de 10-44 segundos. En la cosmología del Big Bang, hasta un tiempo Tp después del instante inicial, es necesaria usar una teoría cuántica de la gravedad para describir la evolución del Universo. Todo, desde Einstein, es relativo. Depende de la pregunta que se formule y de quién nos de la respuesta.

¿Os dais cuenta? Siempre tendremos que estar haciendo preguntas, y, desde luego, nunca podremos saberlo todo. No tener preguntas que formular, o secretos que desvelar… ¡Sería la decadencia del Ser Humano!

No debemos olvidar que: “La creciente distancia entre la imaginación del mundo físico y el mundo de los sentidos no significa otra cosa que una aproximación progresiva al mundo real.” Nosotros vivimos en nuestro propio mundo, el que forja nuestros sentidos en simbiosis con el cerebro. Sin embargo, ese otro mundo, el que no podemos “ver”, no siempre coincide con “nuestro mundo”.

emilio silvera

Feb

25

¡La Física! Esa gran disciplina científica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Universidad Nacional Autónoma de México, Instituto de Astronomía

| Estrellas de Neutrones |

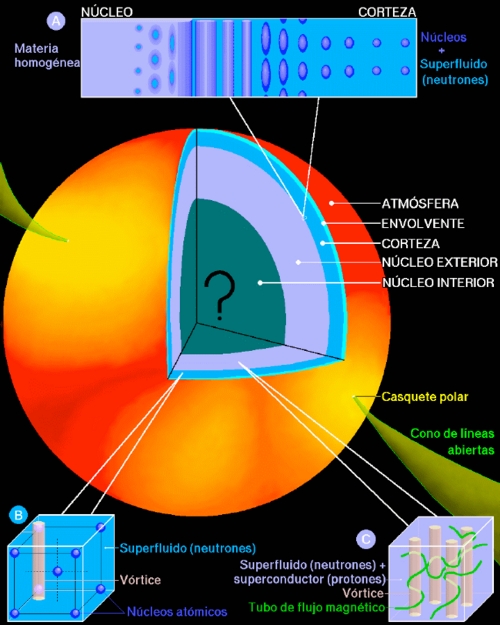

Las estrellas de neutrones son los objetos más densos observables en el Universo. Sólo son superadas por el interior de los hoyos negros, que no es observable. En colisiones relativistas de iones pesados, en RHIC o en el LHC, es posible alcanzar densidades superiores, pero con una enorme densidad de energía (cientos de GeV por nucleón), mientras que la materia en el interior de una estrella de neutrones es altamente degenerada.

En la Fig. 1 se presenta lo que, teóricamente, consideramos es la estructura de una estrella de neutrones. Con un radio de unos 10 km, el 98% de la masa se encuentra a densidades supra-nucleares en el núcleo de la estrella, mientras que una capa de aproximadamente un kilómetro de espesor, la corteza, está formada de núcleos atómicos. En la superficie tenemos una atmósfera, de unos cuantos centímetros de espesor, donde se forma el espectro térmico que podemos observar. A una densidad ρ ~ 104g cm-3 la materia está totalmente ionizada y cuando ρ ~ 106g cm-3 los electrones forman un gas de Fermi relativista. Dada la enorme energía en este gas de electrones, resulta energéticamente favorable fusionar parte de los electrones con protones, lo que resulta en núcleos cada vez mas ricos en neutrones conforme aumenta la densidad. Cuando ρ ~ 5×1011g cm-3, el número de neutrones es tal que no caben mas en los núcleos. Hemos alcanzado el punto de “goteo” de neutrones, donde además de los núcleos y el gas de electrones, tenemos un gas “libre” de neutrones. Al acercarse a la densidad nuclear, ρ0 ~ 2.8×1014g cm-3 los núcleos se fusionan y entramos al “núcleo” de la estrella (“core” en ingles). En la zona de transición es muy probable que encontremos núcleos no esféricos, muy alargados (“espaguetis”) y bidimensionales (“lasañas”), lo que comúnmente se llama la fase “pasta” (ver recuadro “A” en la Fig. 1). Dadas las altas presiones en la corteza ésta debe ser sólida, muy probablemente en forma cristalina (recuadro “B” en la Fig. 1).

|

|

| Figura 1. Visión “artística” de una estrella de neutrones. (D. Page, en “Fronteras del Universo”, Ed. M. Peimbert, 2000, Fondo de Cultura Económica) | |

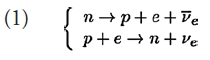

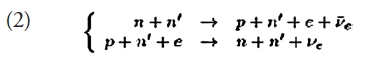

En el núcleo de la estrella, empezamos con un líquido cuántico de neutrones, protones y electrones. Las interacciones débiles, tipo β, como

permiten ajustar las densidades nn y np de nucleones. Debido a las diferencias de masas, la primera de estas reacciones ocurre espontáneamente en el vacío mientras que la segunda requiere de energía cinética en el estado inicial. En un medio denso las energías relevantes no son las masas, sino los potenciales químicos de las partículas, los cuales incluyen la masa, la energía cinética de Fermi y la energía potencial. Esta última requiere de un modelo de las interacciones fuertes a densidades supra-nucleares; el equilibrio energético y efecto de las reacciones β, determinan nn y np. El resultado es que a ρ = &rho0 los nucleones se distribuyen en una proporción de 5% de protones por 95% de neutrones, aunque la fracción de protones aumenta con la densidad. Nuevas partículas pueden aparecer a mayores densidades, como hiperones o condensados de mesones (π – o K -). El núcleo interior de la estrella, está marcada en oscuro en la Fig. 1, con un gran signo de interrogación, ya que existe la posibilidad de se alcance la densidad suficiente para inducir desconfinamento de los quarks. Refiero el lector a [1] para más detalles y referencias a los trabajos originales.

Neutrinos

Producidas en explosiones de supernovas, con temperaturas iniciales superiores a los 50 MeV ~ 50×1010 K, las estrellas de neutrones jóvenes se enfrían por emisión de neutrinos, hasta llegar a una edad de unos 100,000 años, a partir de lo cual la pérdida de energía por emisión de fotones térmicos en la superficie empieza a dominar. El proceso de emisión de neutrinos más eficiente es el descrito en la Eq. (1), llamado “Urca directo”, con una emisividad εDUrca ≈ 1027 (T/109 K)6 erg cm-3 s-1.Esto implica que un metro cúbico de materia podría producir una luminosidad (L = 3.8×1033 erg s-1) de neutrinos cuando T=109 K. Sin embargo, la reacción (1) tiene una fuerte limitante: la conservación del momento, la cual requiere un concentración de protones superior al 15%; por lo cual el proceso Urca directo está cinematicamente prohibido. Sin embargo, existen procesos como

que proporcionan el momento faltante, aquí el neutrón n’ es una partícula del medio. Nótese que el proceso (2), llamado “Urca modificado” por involucrar dos fermiones degenerados, comparado con el proceso (1) es mucho menos eficiente, εMUrca ≈ 1021 (T/109 K)8 erg cm-3 s-1, con una dependencia en la temperatura de la forma T8 en lugar de T6. El proceso (2) es el mecanismo estándar de enfriamiento y el proceso (1) soló actua a densidad altas, es decir en estrellas muy masivas.

Superfluidez y Superconductividad

La teoría BCS de superconductividad está basada en la formación de pares de Cooper y en la aparición de una brecha Δ(T) en elespectro de excitaciones, cuando la interacción entre fermiones es atractiva. La presencia de una brecha y consecuentemente la existencia de pares de Cooper en núcleos fue observada en 1958, poco tiempo después de la formulación de la teoría BCS y es un ingrediente esencial en los modelos de estructura nuclear. Para momentos p<1.5 fm-1 la interacción nuclear n-n o p-p es atractiva en el canal 1S0 (en notación espectroscópica: singlete de espín, momento angular orbital L=0 y J=L+S=0). Esto lleva a predecir que los neutrones deben de formar un superfluido en la corteza interna de una estrella de neutrones mientras que los protones, debido a su baja concentración, formarían un superconductor en el núcleo exterior. En el núcleo de la estrella el momento de Fermi de los neutrones es superior a 1.5 fm-1 y el canal 1S0 se vuelve repulsivo. Sin embargo la formación de pares de Cooper en triplete de espín, en el canal atractivo 3P2, es posible. A mas altas densidades es probable que los hiperones y/o los quarks formen superfluidos/superconductores. El interior de una estrella de neutrones es un paraíso para pares de Cooper, pero el calcular precisamente el tamaño de la brecha Δ(T), y el valor de Tc, es una pesadilla para el físico teórico. El caso del helio-3 es un ejemplo de ello y en el caso del apareamiento 3P2 de los neutrones a densidades supra-nucleares las predicciones para Δ van desde casi 0 hasta más de 5 MeV.

La presencia de una brecha Δ en el espectro de excitaciones implica que cuando T<<Tc estas son fuertemente suprimidas, aproximadamente por un factor de Boltzmann exp (-Δ(T)/T). En consecuencia, el calor específico Cv, así como todos los procesos de emisión de neutrinos en los cuales esta componente apareada participa, están exponencialmente suprimidos. Sin embargo, la transición de fase es de segundo orden, es decir continua. Cuando T ~ Tc, como es bien conocido en el caso de los superfluidos/superconductores terrestres, el calor específico Cv aumenta en un factor del orden 2.5. Otro aspecto del desarrollo progresivo del condensado es el constante rompimiento y formación de pares de Cooper, cuando T ~ Tc , y la posibilidad de que el condensado decaiga en un par neutrino – anti-neutrino:

donde <nn´> representa el condensado de pares de Cooper. Este “proceso de Cooper” puede ser mas eficiente que el Urca modificado (2) por mas de un orden de magnitud.

Enfriamiento y Superfluidez

Esta breve descripción permite esbozar el panorama de la evolución térmica de estrellas de neutrones: a partir de su nacimiento se enfrían por emisión de neutrinos y cuando alcanzan edades del orden de 105 años su evolución se determina por la emisión superficial de fotones.

La tasa de emisión de neutrinos es muy sensible a la composición de la materia a densidades supra-nucleares: cualquier cambio a la composición relativa de neutrones a protones resulta en emisividades de neutrinos altísimas y enfriamiento muy rápido. Tenemos un zoológico completo de modelos de materia ultra densa, casi todos prediciendo un enfriamiento rápido. Por otra parte, el enfriamiento rápido puede ser moderado por el apareamiento de las partículas, mientras la brecha, o la temperatura crítica, sea suficientemente grande. Nos encontramos con el problema de la casi imposibilidad de calcular con suficiente precisión el tamaños de las brechas relevantes y el hecho de que la emisión de neutrinos es controlada por estas brecha de manera exponencial. Las dos revisiones [2] y [3] presentan mas detalles sobre los mecanismos de enfriamiento.

Del lado observacional, tenemos una docena de estrellas de neutrones jóvenes con temperaturas estimadas. Sus altas temperaturas superficiales, entre 0.5 y 2×106 K, indican que ningún proceso Urca directo está actuando en ellas, al menos que esté fuertemente suprimido por apareamiento de las partículas que participen en el proceso. El “modelo mínimo” de enfriamiento [4] fue desarrollado con el fin de presentar un punto de referencia con el cual comparar estas observaciones e identificar posibles candidatas a estrellas conteniendo algún tipo de materia “exótica”. Este modelo excluye a priori cualquier forma de materia densa que resulte en enfriamiento rápido, es decir una alta concentración de protones, condensados de mesones, hiperones y quarks desconfinados. Sin embargo considera el efecto de la superconductividad / superfluidez de protones / neutrones, es decir el apareamiento, y el aumento en la emisión de neutrinos por el proceso de Cooper durante la transición de fase. Resulta que los procesos Urca modificados por si mismos no son suficientemente eficientes para explicar la evolución de las estrellas mas frías pero sí se pueden interpretar las observaciones tomando en cuenta el proceso de Cooper, bajo una condición: la temperatura crítica máxima, Tc, para el apareamiento 3P2 de los neutrones debe estar entre 1/2 y 2×109 K [5]. En este rango de valores de Tc el proceso de Cooper domina el enfriamiento a edades entre unos cientos hasta unas decenas de miles de años de edad.

En el caso contrario debemos suponer la presencia de algún tipo de materia extra para entender la evolución de estas estrellas de neutrones jóvenes. En conclusión, hasta hace poco tiempo nos encontrábamos en una situación que requería de alguna nueva pista para poder avanzar.

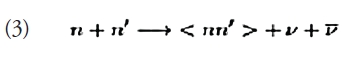

El Caso de Cas A

Casiopeia A es un remanente de supernova en la constelación de Casiopeia. Por su interés astronómico, la NASA decidió inaugurar el satélite de rayos X Chandra, su “primera luz”, con una imagen de este remanente en agosto del 1999 (ver Fig. 2). ¡En el centro de la imagen apareció la estrella de neutrones, “Cas A”, formada por la supernova! Con una edad de unos 330 años es la estrella de neutrones más joven conocida. Al analizar 10 años de observaciones del remanente, y de su estrella, Craig Heinke y Wynn Ho encontraron que Cas A se había enfriado en un 4% del año 2000 al 2009 [5] y que ¡su flujo se había reducido en un 20%! Esta evolución es inconmpatible con casi todas la predicciones teóricas.

|

|

| Figura 2. El remanente de supernova Casiopeia A en rayos X: primera luz de Chandra, en agosto del 1999. El punto brillante en su centro es la estrella de neutrones, descubierta en esta observación. (Crédito: NASA/CXC/SAO) | |

La luminosidad térmica de fotones de la estrella es LX ≈ 1034 erg s-1 mientras que la tasa de enfriamiento observada, junto con una estimación del calor específico, requiere que la estrella esté perdiendo energía térmica a una tasa de 1038 erg s-1. ¿Cuál puede ser el agente de enfriamiento que supere al de fotones por 4 órdenes de magnitud? Sólo puede ser la emisión de neutrinos.

Aunque un comportamiento como el de Cas A es sorprendente, había sido descrito teóricamente con anterioridad (ver, e.g., la Fig. 6 en [5] o Fig. 8 en [2]). Después de afinar detalles, la interpretación resulto clara [7,8]: tras un lento enfriamiento previo, la temperatura interna T de Cas A alcanzó, en las últimas décadas, la temperatura crítica de superfluidez de los neutrones, Tc, lo cual disparó la fuerte emisión de neutrinos por el proceso Cooper. La figura 3 ilustra esto con tres modelos: a edades superiores a los 100 años, sin superfluidez (“Tc=0”), el enfriamiento es lento; al contrario, con una Tc demasiado alta (“Tc=109 K” ), el enfriamiento rápido ocurre demasiado temprano y posteriormente el enfriamiento es también lento; mientras que con Tc=5.5×108 K el enfriamiento rápido, pero transitorio, ajusta perfectamente las observaciones. Además de ser, posiblemente, la primera evidencia directa de la existencia de superfluidez a densidades supra-nucleares, esto nos proporciona una “medición” bastante robusta de la temperatura crítica Tc para los neutrones y los detalles del enfriamiento rápido implican también que los protones deben de ser superconductores con una temperatura crítica más alta. Si la interpretación resiste al tiempo, y el enfriamiento continua durante varias décadas como lo predice el modelo, estaríamos viendo en tiempo real una gran concentración de neutrones pasando por la transición de fase de superfluidez.

|

|

| Figura 3. Tres modelos de enfriamiento, temperatura efectiva “al infinito” Te ∞ vs edad: ver texto para descripción. La estrella marca el valor observado de Cas A y el recuadro detalla el ajuste del modelo con las cinco observaciones de Chandra. (Adaptado de la Ref. [8]) | |

El Futuro: ¿Exótico?

Lo bizarro de un superfluido estelar ha recibido mucha cobertura mediática (ver, e.g., [9]). Sin embargo, lo más importante de estos resultados es que podemos, por lo menos en el caso de Cas A, borrar la zona oscura y el signo “?” en el centro de la Fig. 1. Hace seis meses estábamos todavía caminando en medio de una jungla de modelos, pero sólo uno de ellos parece sobrevivir a la observación del enfriamiento de Cas A que podría ser la “Piedra de Rosetta” de la física de materia ultra-densa. Es ciertamente sólo media piedra: hay evidencias de estrellas que sufren emisión de neutrinos todavía mucho más intensa como son los casos de SAX J1808.4-3658 y 1H 1905+00. Estos dos objetos están en sistemas binarios con acreción transitoria: cuando termina una fase de acreción esperamos ver la superficie caliente de la estrella, estrellas de primera generación como Cas A. Al considerar densidades más altas, alcanzadas en estrellas más masivas, el signo “?” vuelve a aparecer. Sin embargo, el entender con un sorprendente lujo de detalle, la estructura y la evolución de una estrella “mínima” como Cas A, nos abre el camino para identificar más claramente objetos realmente “exóticos”.

Referencias:

[1] Page, D., & Reddy, S., “Dense Matter in Compact Stars: Theoretical Developments and Observational Constraints”, Annu. Rev. Nucl. Part. Sci. 56, 327, (2006)

[2] Yakovlev, D. G., & Pethick, C. J., “Neutron Star Cooling”, Annu. Rev. Astronom. & Astrophys. 42, 169, (2004)

[3] Page, D., Geppert, U., & Weber, F., “The Cooling of Compact Stars”, Nucl. Phys. A 777, 497, (2006), numero especial sobre Nuclear Astrophysics.

[4] Page, D., Lattimer, J. M., Prakash, M., & Steiner, A. W., “Minimal Cooling of Neutron Stars: A New Paradigm”, Astrophys. J. Suppl. 155, 623, (2004).

[5] Page, D., Lattimer, J. M., Prakash, M., & Steiner, A. W., “Neutrino Emission from Cooper Pairs and Minimal Cooling of Neutron Stars”, Astrophys. J. 707, 1131, (2009)

[6] Heinke, C. O., & Ho, W. C. G., “Direct Observation of the Cooling of the Cassiopeia A Neutron Star”, Astrophys. J. Lett. 719, 167, (2010)

[7] Shternin, P. S., Yakovlev, D. G., Heinke, C. O., Ho, W. C. G., & Patnaude, D. J., “Cooling Neutron Star in the Cassiopeia-A Supernova Remnant: Evidence for Superfluidity in the Core”, Mon. Not. Roy. Astron. Soc.: Lett. 412, 108, (2011)

[8] Page, D., Prakash, M., Lattimer, J. M., & Steiner, A. W., “Rapid Cooling of the Neutron Star in Cassiopeia A Triggered by Neutron Superfluidity in Dense Matter”, Phys. Rev. Lett. 106, 081101, (2011)

[9] “Cassiopeia A: NASA’s Chandra Finds Superfluid in Neutron Star’s Core”: http://chandra.harvard.edu/photo/2011/casa/

Feb

24

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (1)

Comments (1)

Ciencia

Ciencia

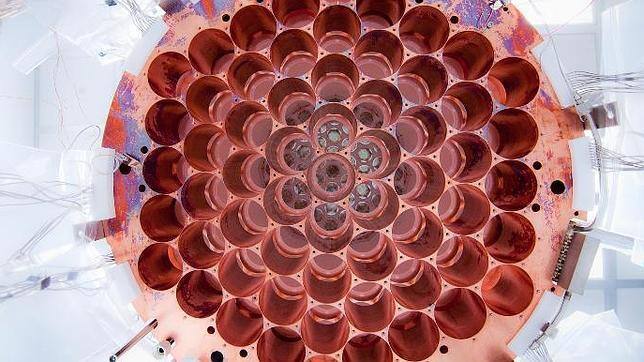

Ponen en marcha un nuevo detector que busca, en la más completa oscuridad bajo el suelo de Dakota del Sur (EE.UU.), un diminuto «flash» que suponga un hito en el mundo de la ciencia

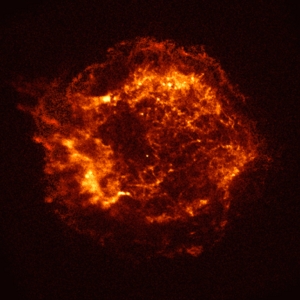

A 1,5 kilómetros bajo la superficie terrestre, un grupo de científicos está intentando descubrir la identidad exacta de la materia oscura. Con un nuevo detector, que empezaron a construir en 2008 y han puesto en funcionamiento ahora, investigadores de 17 universidades de todo el mundo participan en el experimento LUX en las profundidades de una antigua mina de oro. Se trata de buscar en el ambiente más oscuro posible, a salvo de cualquier haz de luz de cualquier longitud de onda, un minúsculo flash que indicaría una colisión entre una partícula de materia oscura y una partícula de materia normal.

Los científicos que participan en el experimento Large Underground Xenon (LUX) han informado de unos primeros resultados prometedores, tanto desde el punto de vista tecnológico como científico. Este experimento se ha creado para determinar la naturaleza de la materia oscura, una sustancia invisible que los físicos creen que está a nuestro alrededor y que constituiría la mayor parte de la materia en el universo, pero que apenas tiene efecto en nuestras vidas cotidianas. Los científicos acaban de publicar los primeros resultados que, dicen, validan el diseño y el rendimiento de la prueba. Esta investigación desafía estudios previos que afirmaban ‘avistamientos’ de la materia oscura, y ahora está comenzando el proceso de descubrir la identidad exacta de la partícula de materia oscura, un proceso equivalente al trabajo realizado por el Large Hadron Collider en la identificación del bosón de Higgs.

El nuevo laboratorio está situado en una antigua mina de oro cerca de un kilómetro y medio por debajo de las montañas Black Hills, en el estado norteamericano de Dakota del Sur. Los trabajos en el LUX comenzaron en 2008, y el experimento quedó listo para una primera prueba a principios de 2013. En este entorno los científicos están operando algunos de los equipos más sensibles del mundo en un ambiente extremadamente protegido, porque están buscando los minúsculos y extremadamente raros flashes de luz que indicarían una colisión entre una partícula de materia oscura y una partícula de materia normal.

“Hacen falta muchos años para construir estos instrumentos, y siempre estamos empujando las nuevas tecnologías al límite”, afirma el Dr. Enrique Araújo, del Departamento de Física del Imperial College de Londres, quien dirige el equipo de esta universidad que está trabajando en LUX. “Es muy significativo que estuvimos trabajando mucho tiempo en el diseño de LUX hasta que finalmente pudimos presionar el botón “on”. Muchos experimentos nunca alcanzan esta etapa”. Los físicos creen que la materia oscura constituye alrededor de un cuarto de la energía del Universo. Esto es mucho si lo comparamos con la materia ordinaria, que constituye sólo una vigésima parte. El resto se compone de una energía oscura aún más misteriosa.

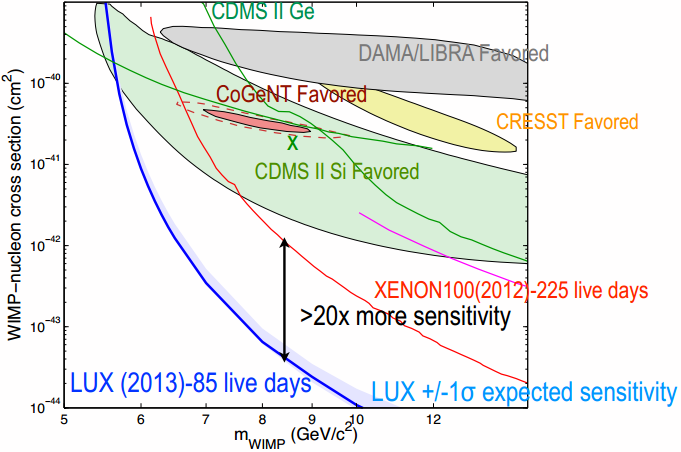

Datos de mayo de 2004. La zona verde representa el resultado del experimento DAMA, en comparación con los límites de precisión de los experimentos CDMS y EDELWEISS. (como podréis ver, son muchos los experimentos que han buscado las partículas de “materia oscura” sin resultado alguno (introducción del blog que nada tiene que ver con el reportaje).

Desde que el experimento fue instalado bajo tierra en febrero, los investigadores han estado buscando han estado buscando Particulas Masivas de Interacción Débild, WIWPs (Weakly Interacting Massive Particles), que son las principales candidatas a constituir la materia oscura en nuestra galaxia y en el resto del universo. Estas partículas se cree que tienen masa como las partículas normales y que crean una pequeña fuerza de gravedad, pero no pueden ser observados directamente ya que no emiten ni rebotan la luz en ninguna longitud de onda. En escalas más grandes su presencia puede inferirse a partir del movimiento de las estrellas en las galaxias, y de las galaxias individuales en los cúmulos galácticos.

Procedentes del espacio

Las colisiones entre las WIMPs y la materia normal son raras y muy difíciles de detectar porque las partículas de rayos cósmicos provenientes del espacio pueden enmascarar los ya tenues destellos que se esperan de las WIMPs. Sin embargo, pocos rayos cósmicos pueden penetrar tan profundamente como para alcanzar el subterráneo en el que han instalado el experimento LUX y, además, el detector está protegido de la radiación de fondo porque está sumergido en un tanque de blindaje de agua ultra-pura.

“Somos capaces de detectar las tenues destellos de luz usando de manera muy eficaz buenos materiales reflectores y sensores de fotones muy sensibles”, dice el Dr. Araújo, quien añade que “LUX tiene significativamente una mayor sensibilidad que los mejores experimentos sobre materia oscura que se han hecho anteriormente en el mundo, especialmente para las WIMPs más ligeras, que causan las señales más débiles . “

El experimento LUX no encuentra partículas WIMPs de “materia oscura” de menos de 33 GeV (Giga electrón Voltio).

El nuevo resultado LUX desafía las evidencias de otros experimentos, como el CoGeNT y el DAMA, en los que los científicos afirmaron previamente disponer de datos sobre la naturaleza de las WIMPs. El Dr. Araújo cree que “una serie de resultados previos vieron unas WIMPs con una masa especialmente baja. Aunque esta situación pudiera llegar a darse, los nuevos datos revelan que, en esas ocasiónes, se trataba de un caso de identidad equivocada”.

Hace una década, los científicos del programa ZEPLIN, dirigido por el Reino Unido, desplegaron el primer detector de materia oscura de este tipo bajo tierra, en la mina Boulby en North Yorkshire. “Hemos tenido un papel pionero en lo que ha sido la más sensible tecnología de búsqueda de la materia oscura del mundo al construir y operar con tres detectores en Boulby”, explica Araújo. “El último y más sensible, el ZEPLIN III, permitió concluir nuestro programa en 2011, y poco después disfrutamos de LUX”.

Científicos como el Dr. Araújo ya están diseñando, y pronto comenzarán la construcción, del experimento de nueva generación LZ, que es la unión de los dos programas LUX y ZEPLIN. Con 7 toneladas de xenón líquido como objetivo, el LZ será 30 veces mayor que el LUX y tendrá más de 100 veces mejor alcance. Será tan sensible que estará solamente limitado por la interferencia de las señales de fondo de los neutrinos astrofísicos. Estas partículas igualmente teóricas fueron hace tiempo candidatas a explicar el problema de la materia oscura, pero los físicos ya saben hoy que no son lo suficientemente masivas como para conseguir este objetivo.

El detector de LUX contiene 370 kg de xenón líquido, de los que 250 kg son útiles para la búsqueda de materia oscura. El análisis de los resultados de LUX durante los primeros 100 días de ejecución del experimento equivalen a un estudio de 85,3 días de un volumen de 118 ± 6,5 kg de xenón. La eficiencia de detección de LUX es excelente, como muestra esta comparación de los eventos observados con las simulaciones por ordenador (en el caso de que no haya partículas WIMP de baja masa).

Como muestra esta figura se han observado 160 sucesos (unos 2 al día) entre 2 y 30 phe (S1), siendo todos ellos consistentes con el fondo esperado, es decir, con la hipótesis nula (que no hay partículas WIMP de baja masa).

Este resultado de LUX es unas 20 veces más sensible que los resultados publicados a día de hoy por su competencia: Edelweiss II, CDMS II, ZEPLIN-III y XENON100. La ausencia de partículas WIMP de baja masa contradice los resultados (o indicios) sobre la modulación anual observada en CoGeNT y DAMA/LIBRA, que deben tener otro tipo de explicación. Por supuesto, los resultados de LUX tratan la búsqueda de partículas WIMP cuya interacción elástica con los nucleones del núcleo de xenón es independiente del espín (interaccionan por igual con neutrones y protones). Por ello no se puede descartar la existencia de partículas WIMP cuya interacción con los nucleones sea dependiente del espín.

LUX continuará tomando datos durante 2014 y 2015 lo que mejorará su sensibilidad de forma significativa, aunque no se mejoras espectaculares. Lo dicho, un nuevo resultado negativo en la búsqueda la materia oscura, que cada día parece más escondida en lugares recónditos del espacio posible de parámetros.

Corazón de titanio

El corazón del experimento LUX es un “termo” de titanio de casi dos metros de altura con un tercio de tonelada de xenón líquido enfriado a menos 100 grados centígrados. Cuando una WIMP impacta contra un átomo de xenón retrocede -como una bola de billar blanca cuando golpea el triángulo de apertura de bolas de colores en el snooker- y se emiten fotones de luz al tiempo que se liberan electrones de los átomos circundantes. Los electrones son atraídos hacia arriba por un campo eléctrico y son absorbidos en una capa delgada de gas xenón en la parte superior del tanque, liberando más fotones.

Los detectores de luz en la parte superior y la parte inferior del tanque son cada uno capaz de detectar estas dos firmas de fotones. Las ubicaciones de las dos señales se puede establecer claramente en el espacio de unos pocos milímetros. La energía de la interacción puede medirse con precisión a partir de la luminosidad de los pulsos de luz. Las partículas que interactúan en el xenón causarán estas señales, pero se espera que las interacciones de las WIMP tengan tamaños característicos muy diferentes de los causados por las partículas ordinarias.

Feb

24

La materia oscura podría acabar con la vida en la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (3)

Comments (3)

Ciencia

La historia de nuestro planeta está marcada por grandes eventos de extinción a gran escala

“¿Puede la materia oscura explicar las grandes extinciones masivas sucedidas en nuestro planeta? Un grupo de investigadores de la Universidad de Nueva York, dirigidos por el biólogo Michael Rampino, están convencidos de que sí. De hecho, acaban de publicar un estudio en el que se concluye que el «camino» que sigue la Tierra alrededor y a través del disco de nuestra galaxia podría tener efectos directos y significativos tanto en los fenómenos geológicos como biológicos que suceden en nuestro planeta y que amenazan, cada cierto tiempo, a las formas de vida que habitan en él.

En concreto, en un artículo recién aparecido en Monthly Notices of the Royal Astronomical Society, Rampino y sus colegas concluyen que nuestro movimiento a través de la materia oscura que contiene la galaxia puede perturbar las órbitas de los cometas y causar, además,un calentamiento adicional del núcleo del planeta. Dos fenómenos que pueden conectarse de forma directa a los eventos de extinción masiva sufridos por la Tierra en el pasado.

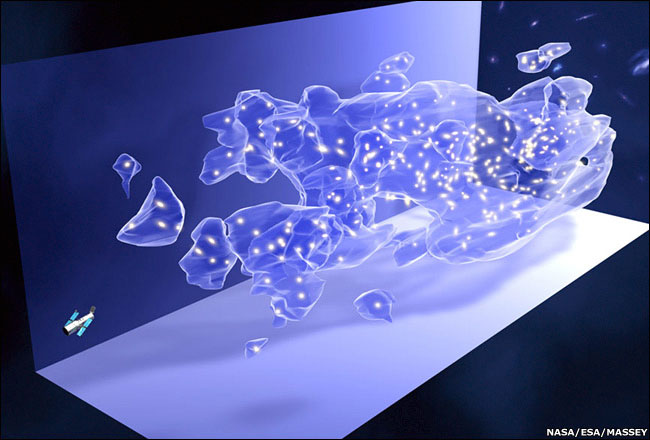

El disco galáctico es la región de la Vía Láctea en la que reside nuestro Sistema Solar. Se trata de una zona densamente poblada por estrellas y grandes nubes de gas y polvo, pero en ella se da también una alta concentración de materia oscura, el «otro» tipo de materia que ninguno de nuestros instrumentos puede detectar y cuya existencia conocemos solo gracias a sus efectos gravitatorios.

Estudios anteriores han mostrado que la Tierra efectúa una rotación completa alrededor del núcleo galáctico cada 250 millones de años. Pero la «senda» que sigue nuestro planeta a través del disco galáctico no es recta, sino ondulada, con el Sol y el resto de planetas del Sistema Solar atravesando el disco apróximadamente una vez cada 30 millones de años. Analizando el patrón seguido por la Tierra en sus «pasadas» a través del disco, Rampino se ha dado cuenta de que coinciden en el tiempo con periodos de intensos bombardeos de cometas y con las mayores extinciones masivas. El famoso cometa que hace 66 millones de años acabó con los dinosaurios es solo un ejemplo.

Las trayectorias de los cometas

¿Pero cuál es la causa de la correlación entre las «pasadas» de la Tierra a través del disco galáctico y los impactos y extinciones que parecen acompañarlas? Para Rampino, a medida que la Tierra pasa a través del disco galáctico, la materia oscura que allí se concentra perturba las trayectorias de los cometas, que normalmente orbitan muy lejos de la Tierra, en los confines del Sistema Solar. Y eso significa que muchos cometas que deberían viajar a grandes distancias de nosotros toman, debido a esa perturbación, caminos inusuales que provocan que algunos de ellos choquen con nuestro planeta.

Pero no solo eso. Para el investigador resulta aún mucho más notable el hecho de que, con cada «zambullida» de la Tierraen el disco galáctico, la materia oscura parece irse acumulando en el interior del núcleo terrestre. Y las partículas de materia oscura, al irse aniquilando unas a otras mediante colisiones, producen un calor considerable que se suma al del núcleo y que puede desencadenar eventos como oleadas de erupciones volcánicas, elevación de cordilleras, reversiones del campo magnético y cambios en el nivel del mar, acontecimientos que también muestran «picos» de intensidad cada 30 millones de años.

Rampino, por lo tanto, sugiere que los fenómenos astrofísicos que se derivan del camino ondulante que sigue la Tierra a través del disco de la galaxia, y la consiguiente acumulación de materia oscura en el interior del planeta, pueden resultar en dramáticos cambios tanto en la actividad geológica como biológica de la Tierra. Su modelo de las interacciones de materia oscura con la Tierra a medida que ésta gira alrededor de la galaxia puede cambiar de forma radical nuestra comprensión del desarrollo geológico y biológico, tanto en nuestro mundo como en otros planetas de la galaxia.

«Tenemos la suerte de vivir en un planeta que es ideal para el desarrollo de vida compleja —afirma Rampino— pero la historia de la Tierra está marcada por grandes eventos de extinción a gran escala, algunos de los cuales, además, resultan difíciles de explicar. Y podría ser que la materia oscura, cuya naturaleza se desconoce pero que constituye cerca de la cuarta parte de la masa del Universo, tenga la respuesta. Además de ser importante a gran escala, la materia oscura puede tener una influencia directa sobre la Tierra».

El investigador considera que en el futuro los geólogos deberían incorporar estos hallazgos astrofísicos para comprender mejor acontecimientos que hoy creemos que se deben solo a causas inherentes a la Tierra. Este modelo, añade Rampino, también proporciona nuevos conocimientos sobre la posible distribución y comportamiento de la materia oscura en el interior de nuestra galaxia.”

Hasta aquí la publicación del diario ABC en su apartado de Ciencia que, se limita a publicar lo que Rampino y los suyos dicen sobre el tema tratado y, al leerlo, de inmediato se me vino a la mente el recuerdo de aquel grupo de físicos italianos que nos dijeron que habían descubierto neutrinos que se desplazaban más rápidos que la Luz… ¡Cómo son algunos y cuántas ganas de notariedad denotan, en sus desmedidas ganas de destacar!

Veámos los comentarios.

Totales: 75.248.867

Totales: 75.248.867 Conectados: 38

Conectados: 38