Feb

4

El Universo Asombroso

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

También esto forma parte del Universo. Aquí podemos ver lo natural que se mezcla con lo artificial construido, lo primero por la Naturaleza y lo segundo por la mano del hombre. Es asombroso ser conscientes de que, en nuestro Universo, existen observadores para contar como es, y, desde luego, podemos ser nosotros y un sin fín más de Civilizaciones perdidas por esos mundos situados tan lejos de nosotros que, seguramente, nunca los podremos alcanzar.

Y pensar que nuestra Galaxia, la Vía Láctea con todo el Grupo Local de galaxias, se mueve a 600 Km/s en relación a la radiación del fondo de microondas… ¡Es increíble! Ningún científico hasta el momento, podía tener en mente tal estimación dada por el úlñtimo estudio realizado.

Está claro que aún nos queda mucho camino que andar, muchos secretos por desvelar y, es bueno ser conscientes de lo poco que sabemos. Dicho conocimiento, es en realidad, un buen acicate para seguir buscando las respuestas que nos faltan y que constituyen una larga lista de preguntas que nadie sabe contestar.

¡Que me gustaria ver nuestra Galaxia desde cierta distancia! Es decir, desde fuera de ella.

“La astronomía en rayos gamma estudia los objetos más energéticos del universo y, desde sus comienzos hace apenas medio siglo, ha lidiado con un problema grave, que consiste en determinar de precisa y fidedigna la región de donde procede la radiación que llega a los detectores de rayos gamma, lo que permite a su vez averiguar el mecanismo a través del que se produce. Ahora, un grupo internacional liderado por astrónomos del Instituto de Astrofísica de Andalucía (IAA-CSIC) ha localizado, por primera vez sin la aplicación de modelos y con un grado de confianza superior al 99,7%, la región de la que surgió un destello en rayos gamma en el blázar AO 0235+164 y que permite conocer cómo se produjo.”

La sinfonía de los agujeros negros binarios ¿La oirémos algún día?

Puesto que la curvatura-espaciotemporal es lo mismo que la gravedad, estas ondulaciones de curvatura son realmente ondas de gravedad, u ondas gravitatorias. La Teoría de la Relatividad General de Einstein predice, de forma inequívoca, que tales ondas gravitatorias deben producirse siempre que dos agujeros negros orbiten uno en torno al otro.

Cuando se forma un par de agujeros negros binarios semejantes, cada agujero crea un pozo profundo (intensa curvatura espacio-temporal) en la superficie insertada y, a medida que los agujeros giran uno en torno al otro, los pozos en órbita producen ondulaciones de curvatura que se propagan hacia afuera a la velocidad de la luz. Las ondulaciones forman una espiral en el tejido del espacio-tiempo en torno al sistema binario, muy semejante a la estructura espiral del agua que procede de un aspersor de cesped que gira rápidamente. Los fragmentos de curvatura forman un conjunto de crestas y valles en espiral en el tejido espacio-temporal.

Sin temor a equivocarnos, podemos decir que, al día de la fecha, los agujeros negrossiguen teniendo muchos secretos para la ciencia.

La imagen de arriba: Un espectacular objeto brillante, recientemente descubierto en una de las galaxias vecinas de la Vía Láctea, es producto de la presencia de un agujero negro “normal” producido por una estrella.

El descubrimiento ha sido realizado por un equipo de científicos, encabezados por el doctor Matt Middleton, de la Universidad de Durham, quien analizó la fuente de rayos X ultraluminosos, la cual había sido originalmente descubierta en la galaxia de Andrómeda (M31) por el observatorio de Rayos X Chandra. El equipo ha publicado sus resultados en dos importantes revistas: Noticias Mensuales de la Real Sociedad de Astronomía y Astrofísica y en Astronomía y Astrofísica.

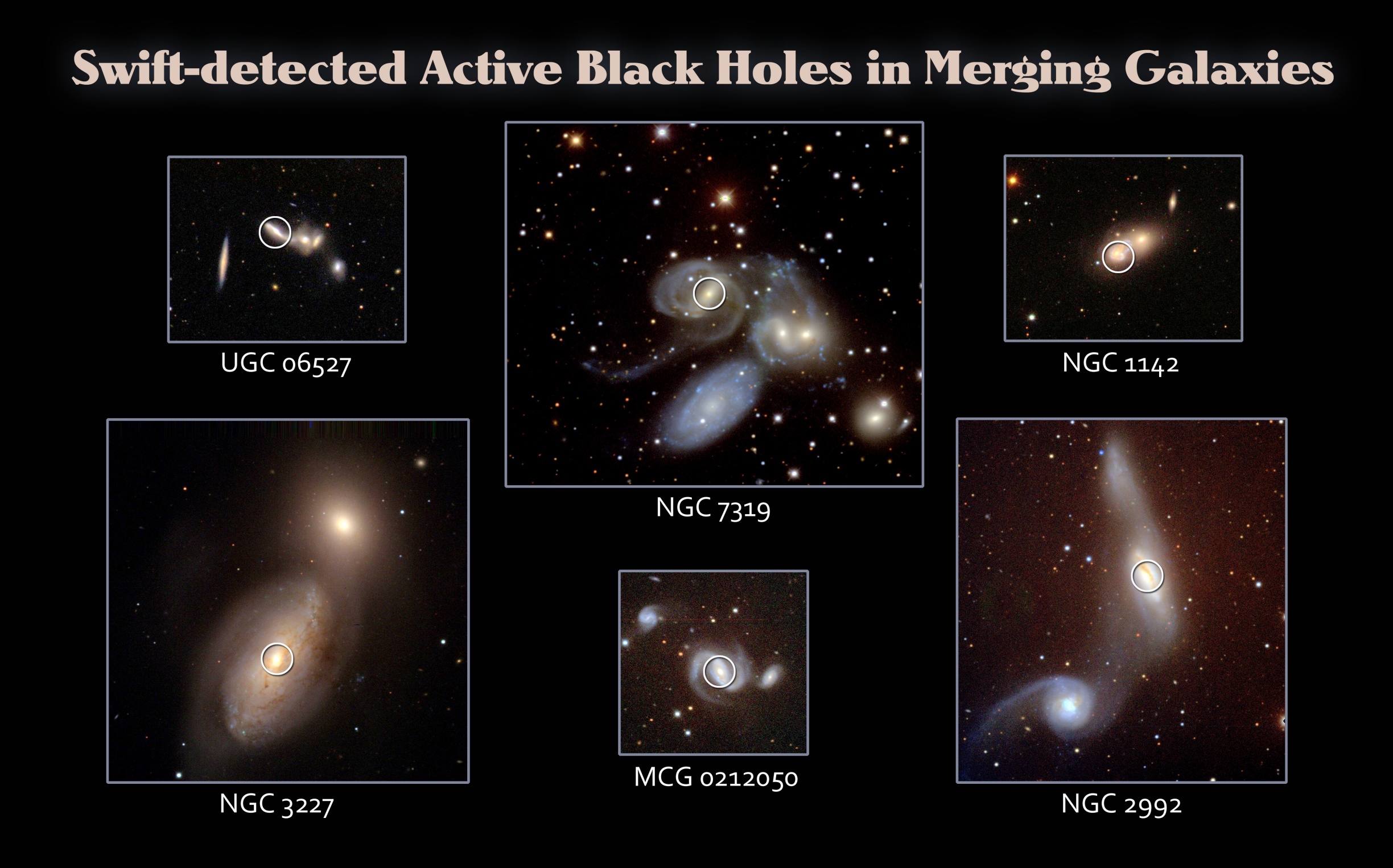

En las imágenes podemos contemplar galaxias que se fusionarán y, sus agujeros negros centrales se harán gigantes. Otras veces, si los agujeros negros están girando, ocurrirá lo mismo (a gran escala) de lo que pasa cuando se encuentran dos peonzas que giran, chocan y la una lanza a la otra a gran distancia.

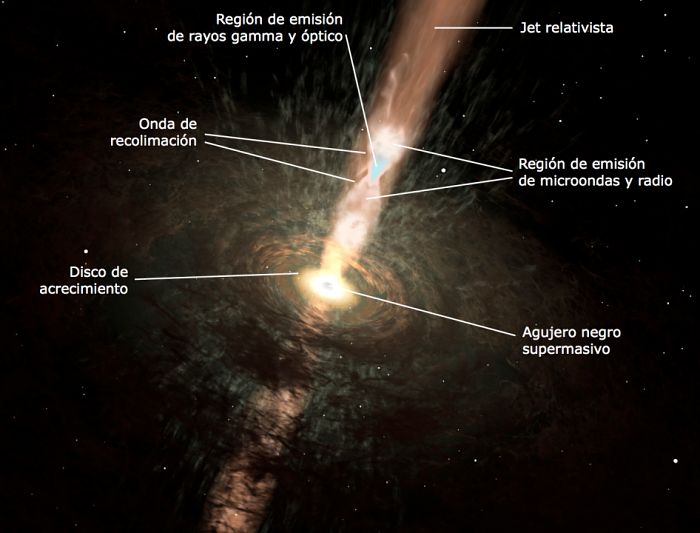

¿Cómo un agujero negro y su disco dan lugar a dos chorros que apuntan en direcciones opuestas? De una forma sorprendentemente fácil, reconocieron Blandford, Rees y Lynden-Bell en la Universidad de Cambridge a mediados de los setenta. Hay cuatro formas posibles de producir chorros; cualquiera de ellas funcionaria, y, aquí, donde se explica el no versado en estos objetos cosmológicos, sólo explicaré el cuarto método por ser el más interesante:

El Agujero es atravesado por la línea de campo magnético. el agujero gira, arrastra líneas de campo que le rodean, haciendo que desvíen el plasma arriba y hacia abajo. Los chorros apuntan a lo largo del eje de giro del agujero y su dirección está así firmemente anclada a la rotación giroscópica del agujero. El método fue concebido por Blandford poco después de que recibiera el doctorado de física en Cambridge, junto con un estudiante graduado de Cambridge, Roman Znajek, y es por ello llamado el proceso Blandford-Znajet.

Luces del Sur sobre la Estación Condordia

Ahí estamos, como observadores del Espacio exterior y haciendo pruebas para vivir en el medio

Seguimos esperando ese mensaje que… ¡nunca llega!

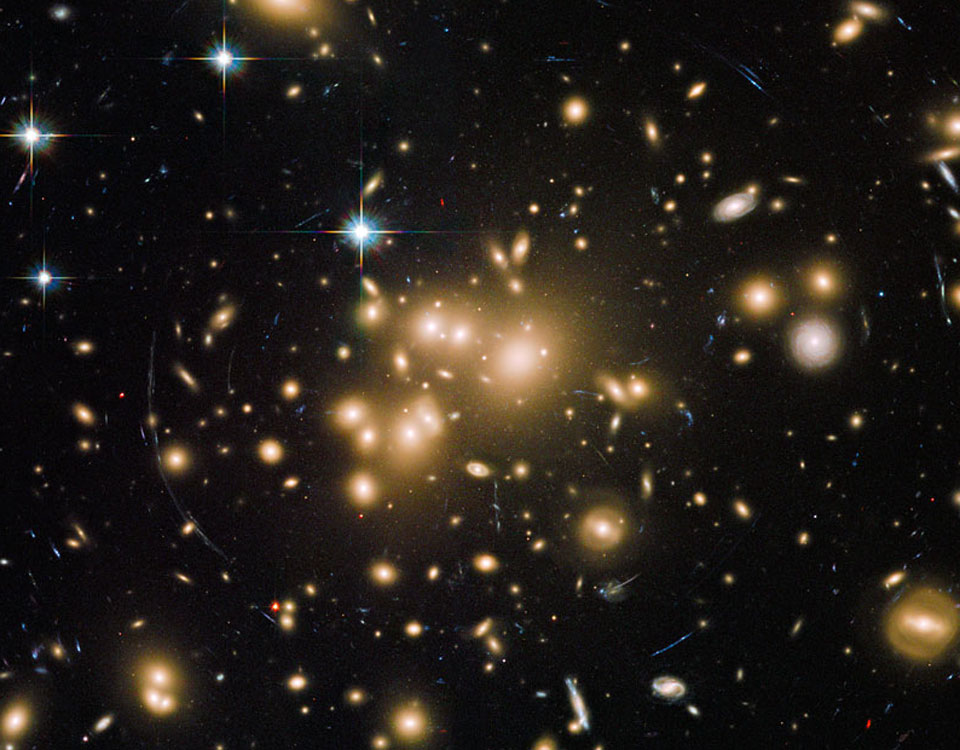

Mientras que con nuestros ingenios y telescópicos cada vez mayores y con mejor tecnología, capturamos las imágenes de galaxias muy lejanas, seguimos intentando comprender tanta grandeza presente en el Universo y, procuramos hacer un gran esfuerzo para llegar a ser consciente de esas distancias que separan a los objetos que lo pueblan. Nosotros, los seres humanos, habiendo evolucionado hasta un nivel aceptable de la Ciencia para conocer el “mundo” que nbos rodea, no dejamos de comprender que, dicho “mundo” (el universo), nos viene algo grande para lo que podemos abarcar con el intelecto de nuestras mentes.

No pocas veces, el ánsia de saber, nos lleva a exigirnos mucho más de lo que en realidad podemos dar de sí. No tenemos en cuenta que, como seres inteligentes, como hombres y mujeres verdaderas, sólo llevamos aquí (en el planeta Tierra), unas decenas de miles de años que, comparados con la edad del Universo, es menos que un suspiro. No hemos podido evolucionar más en tan poco tiempo.

El tener conocimiento del átomo y sus componentes, el saber de las galaxias y demás objetos que pueblan el inmenso Cosmos… ¡Es demasiado! Y, aunque nuestra imaginación nos lleve a imaginar viajes en el Tiempo, poder recorrer extensas regiones del universo y visitar otras galaxias… Lo cierto es que, tales sueños, están tan lejos de nosotros que, ni podemos saber si algún día, nuestra especie, conseguirá esos logros que, de hacerlo, sería como culminar los sueños de… ¡tanta gente!

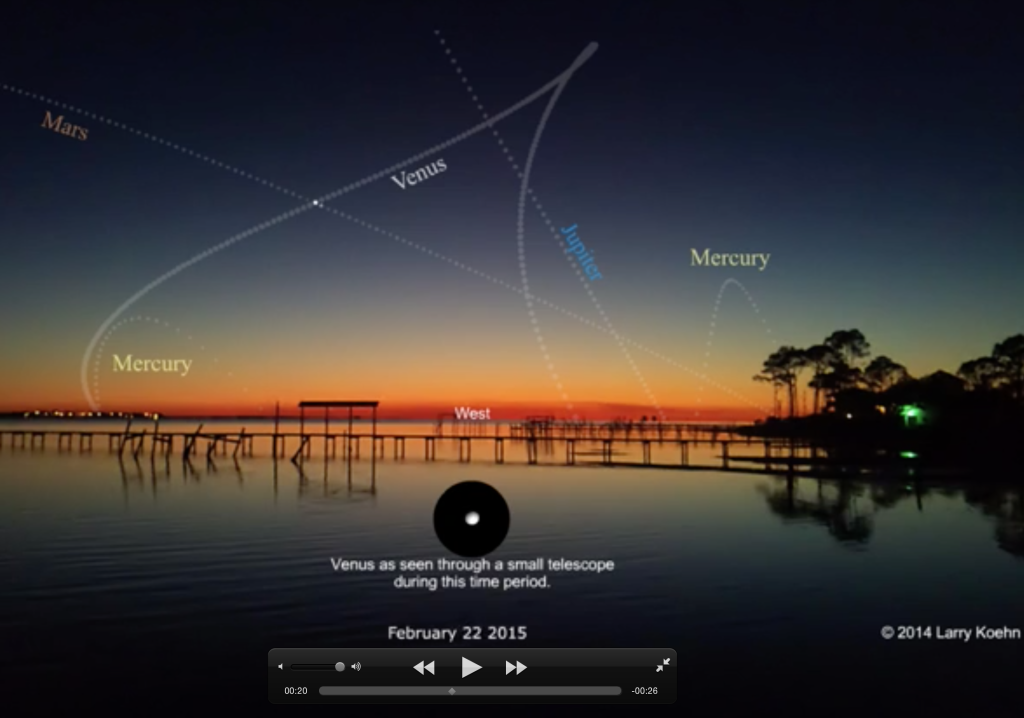

Pero eso sí, podemos ver a Venus desde la Tierra, y, Nebulosas semillero de estrellas y mundos

La Nebulosa IC 4628 en la que el gas y el povo interestelar hacen posible el nacimiento de nuevas estrellas, nuevos mundos y… ¿Quién sabe? Si Vida también en alguna de sus formas conocidas en nuestro planeta, o, conformada en diferentes formas en función de la gravedad y las condiciones de los planetas que pudieran estar orbitándo aquellas estrellas.

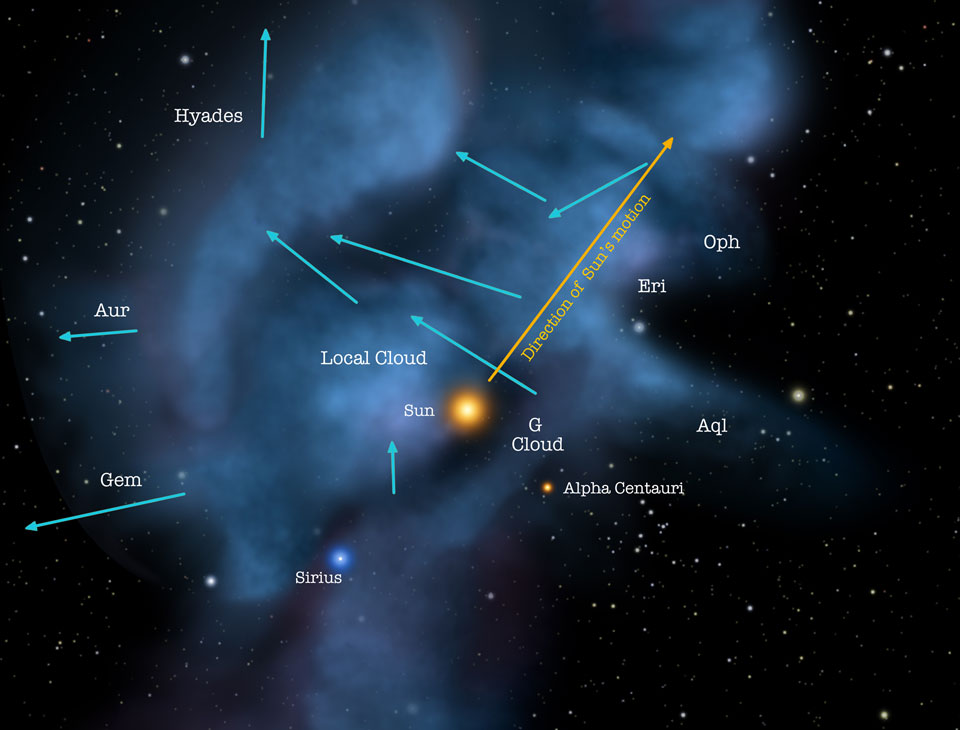

Lo cierto es que nuestra vecindad es tranquila y ninguna estrella vecina nos amenaza con una explosión supernova ni tiene dimensiones y masa que nos puedan preocupar si llegaran el final de sus días. Bien resguadaditos en el interior del Brazo de Orión, en un Sistema solar relativiamente apasible, el tercer planeta a partir del Sol, la Tierra, tiene a su estrella que reluce en la secuencia principal enviando la luz y el calor necesarios para la vida. Situado en la zona habitable de la estrella, goza de una atmósfera ideal, de continentes de inmensa belleza y de mares y océanos que hace de nuestro mundo, la maravilla que es.

Todo eso que antes comento, ocurre en una Galaxia espiral situada en un pequeño grupo de poco más de una treintena de galaxias en la que, ella, junto a su compañera Andrómeda, comandan a toda la familia de las que son las hermanas mayores. Nuestro mundo, la Tierra, está situado a 30.000 años-luz del centro de la galaxia que, como hemos podido comprobar, es un lugar peligroso en el que habitan agujeros negros gigantes que emiten radiación y absorben materia, es decir, que no serían nada buenos como vecinos.

Aquí la tenemos, es nuestra casa ¡La Tierra! que, en el Sistema solar es un planeta más pero, con la suerte de haber caído en la zona habitable de la estrella que llamamos el Sol, en relación a la Galaxia Vía Láctea es un simple planeta como hay tantos, y, si la situamos en el contexto del Universo, es menos que un grano de arena.

Lo cierto es que nos encontramos en un Universo inmenso y precioso. Esta composición cósmica equilibra muy bien la Nebulosa de la burbuja en la parte inferior izquierda con el cúmulo estelar abierto M52 por encima de ella y hacia la derecha. La pareja estaría desequilibrada en otras escalas, sin embargo. Incrustado en un complejo de polvo interestelar y gas y soplado por los vientos de una sola, gran estrella de tipo O, la Nebulosa de la Burbuja, también conocida como NGC 7635, se encuentra a sólo 10 años luz. Por otro lado, M52 es un cúmulo abierto rico de alrededor de mil estrellas. El cúmulo tiene unos 25 años luz de diámetro. Visto hacia el límite norte de Casiopea, las estimaciones de distancia de la Nebulosa de la burbuja y el complejo de nubes asociadas son alrededor de 11.000 años luz, mientras que el cúmulo estelar M52 se encuentra cerca de 5.000 años luz de distancia.

Sí, desde la noche de los tiempos hemos mirado al cielo, buscando sus maravillas que siempre nos asombraron, primero al no poder entender cómo eran posible aquellos extrsaños fenómenos e increíbles objetos, y, más tarde, cuando pudimos comprender, al conocer las maravillas que podía realizar la Naturaleza valiendose de fuerzas que, ni podemos imaginar.

emilio silvera

Feb

3

Los fenómenos del mes de febrero en la Bóveda celeste

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El cielño en febrero/2015 ~

Clasificado en El cielño en febrero/2015 ~

Comments (0)

Comments (0)

El director del Observatorio Astronómico Nacional (IGN) nos presenta los fenómenos más atractivos que tendrán lugar en la bóveda celeste este mes: planetas, eclipses, lluvias de meteoros, curiosidades cósmicas y toda la información para disfrutar del Cosmos.

En el mes de febrero disponemos de unas 13 horas para la observación del cielo nocturno. Cuando los cielos están despejados y las temperaturas son bajas, la atmósfera suele estar muy transparente y estable, lo que hace a estas noches óptimas para la observación astronómica. El plenilunio tendrá lugar el 4 de febrero en la constelación de Cáncer, esta luna llena se llama en algunas culturas ‘Luna de las nieves’. La Luna pasará por el punto más alejado de la Tierra (apogeo) el día 6, a 406.132 kilómetros de la Tierra, y por el perigeo el día 19, a tan solo 356.998 kilómetros. El novilunio tendrá lugar el día 19 en la constelación de Acuario.

El día 25 la brillante estrella Aldebarán se encontrará muy cerca del filo brillante de la Luna creciente. La distancia aparente entre la estrella y la Luna será menor cuanto más al Norte nos encontremos. De hecho, los observadores que se encuentren situados en el Norte de Europa podrán ver cómo nuestro satélite oculta completamente a esa brillante estrella. Esta ocultación forma parte de una serie de ocultaciones lunares de Aldebarán que tendrán lugar entre 2015 y 2018. Habrá que esperar hasta 2033 para observar otra serie de ocultaciones similares. Las ocultaciones tienen mucho interés para los astrónomos pues las aprovechan para estudiar pormenores del relieve en el borde de la Luna y detalles del astro ocultado.

Este mes podremos disfrutar de la observación de cinco planetas. Mercurio se verá a partir del día 10 antes de que despunte el día, pero como siempre muy bajo en el horizonte. Marte y Venus serán nuestros luceros vespertinos este mes y nos ofrecerán un bonito espectáculo. Ambos planetas ejecutarán una compleja danza aproximándose y separándose entre los días 20 y 22. El día 20, una hora y media después del atardecer, podremos verlos muy juntos un poco por encima del fino filo de la Luna creciente. El día 21, Venus y Marte estarán en conjunción, separados por una distancia menor que el tamaño aparente de la Luna. Hay que observarlos nuevamente después del atardecer, Venus se verá unas 170 veces más brillante que Marte, pero éste último siempre destaca por su bello color rojizo.

Júpiter será visible toda la noche hasta mediados de mes, y a partir de ahí, en la primera parte de la noche. En la noche del 3 al 4 de febrero, podremos verlo muy cerca de la Luna llena, acompañándola desde su aparición por el Este al anochecer, hasta su ocultación al alba. El gigante gaseoso se encontrará en oposición el día 6 de febrero. En esa posición alcanza su mayor aproximación a nuestro planeta y se encuentra iluminado frontalmente por el Sol. La noche del día 6 es pues la más favorable para observarlo. Con unos buenos prismáticos se podrán distinguir los cuatro grandes satélites galileanos (Io, Europa, Ganímedes y Calisto) y con un pequeño telescopio incluso podrán divisarse las grandes franjas nubosas que recubren el planeta.

Febrero es un buen mes para observar la luz zodiacal. Como su nombre indica, se trata de una franja luminosa que se extiende a lo largo de la banda que contiene las constelaciones del Zodíaco, esto es, el plano de nuestro sistema solar. Esta franja luminosa y difusa está originada por las numerosas partículas de polvo que se encuentran en el plano de nuestro sistema planetario y que dispersan la luz solar. Para observar la luz zodiacal se necesita un cielo muy oscuro, sin contaminación lumínica y sin luna. Hace falta, además, que el plano de la eclíptica forme un ángulo pronunciado con el horizonte, una configuración que, en el Hemisferio Norte, se da en febrero y marzo después del atardecer por el oeste (y en setiembre y octubre antes del amanecer por el este). Por todo ello, los días alrededor del 19 de febrero serán óptimos para ver la luz zodiacal después del atardecer. Aproximadamente dos horas después de que desaparezca el Sol, si el tiempo y la oscuridad lo permiten, se observará una característica franja difusa que se ensancha en el horizonte. El poeta y astrónomo persa del siglo XI Omar Khayyám se refería a la luz zodiacal en su Rubaiyat como ‘el falso amanecer’ o como ‘la mano izquierda del alba’. Sin duda él tenía muchas menos dificultades para su observación que las que nosotros encontramos en nuestros días.

Feb

3

La Vida sigue… ¡El mundo no se detiene!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Naturaleza ~

Clasificado en Naturaleza ~

Comments (0)

Comments (0)

Detalle de unos carámbanos de hielo en Marktoberdorf, al sur de Alemania.

Niños refugiados afganos juegan en un barrio pobre a las afueras de Islamabad (Pakistán).

Sensores de polen que la compañia Weathercaster utiliza para hacer el seguimiento de la cantidad de polen en la atmósfera, en Chiba, Japón. Estos sensores cambian de color según la cantidad de polen que toman del aire.

La mirada tras un burka de una refugiada afgana que espera para ser repatriada a Afganistán, en las afueras de Peshawqar, Pakistán.

Jessica Bernice Michelena, de 40 años, llora en el interior de su vivienda, mientras espera a ser desahuciada junto a su familia en Madrid.

Los secretarios de Relaciones Exteriores y de Defensa británicos visitan el café Lindt de Sídney donde murieron tres personas, entre ellos el secuestrador islamista que causó el terror en la ciudad australiana el 15 de diciembre de 2014. En la imagen, una persona cubre con tres paraguas los libros de condolencias donde escribirán los políticos que se encuentran en visita oficial por las conversaciones anuales de seguridad entre Australia y Reino Unido.

Todas estas imágenes del día, las he tomado de El Pais, y, reflejan la diversidad de la vida misma, en cada lugar y a cada persona, le ocurren cosas que, son sus propias historias que quedan reflejadas en el tiempo propio, y, la transcendencia, es local y personal. Sin embargo, cuando desde fuera las podemos contemplar, en algunos casos conmueve.

Feb

3

Nadie pudo escribir, la Historia de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

Pequeñas Galaxias y Materia Oscura

La verdadera Historia de la Teoría del Caos »

Son muchas las cosas que no sabemos y, de cada una de ellas, nosotros los humanos, creamos hipótesis y hacemos conjeturas, construimos modelos y, con los datos que hemos podido reunir, dejamos expuesta una teoría de lo que pudo ser. De esa manera hemos creado la “historia” de cómo se formó nuestro Sistema solar a partir de una explosión de supernova que creando una nebulosa sería el origen, hace algunos miles de millones de años, de todo el sistema planetario en el que está la Tierra y nos cobijamos nosotros.

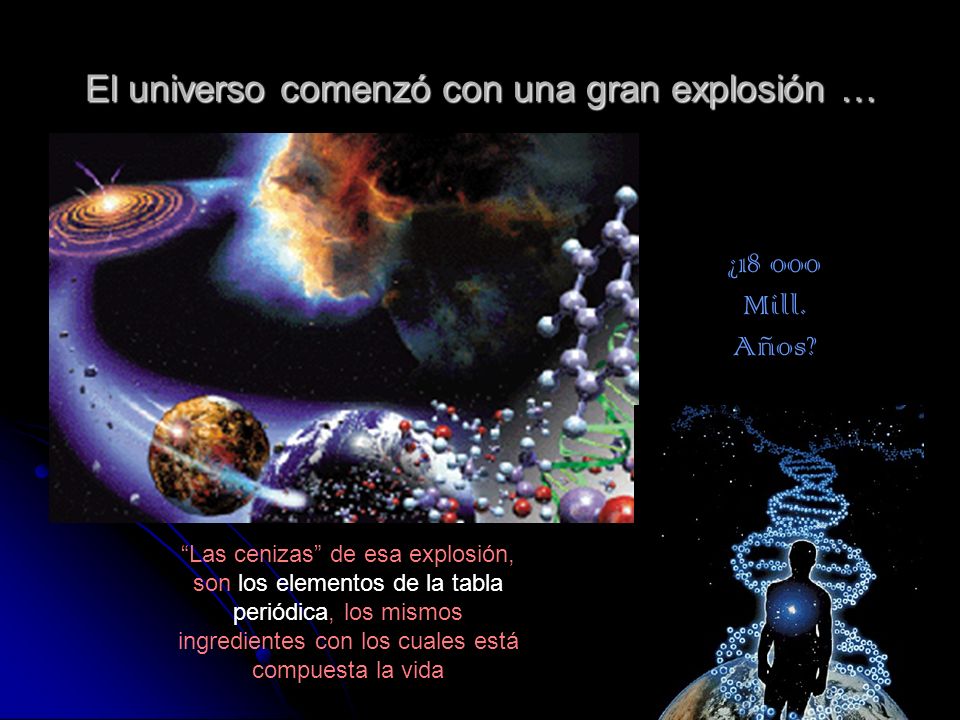

A mayor escala y viajando mucho más lejos en el Tiempo, también hemos “recreado” el escenario que suponemos que pudo existir cuando “nació” el universo, cuando dio comienzo la existencia del Tiempo y apareció el Espacio, se creó la materia y comenzaron a formarse los objetos que hoy podemos contemplar por todo el inmenso Cosmos. De todo ello, de manera “misteriosa” (nadie sabe a ciencia cierta como fue), apareceron los primeros signos de vida, primero en forma de rústicas criaturas y más elaboradas después, cuando con el paso de los años, pudieron evolucionar.

En nuestra región, situada en el interior del brazo de Orión a unos 30.000 años-luz del centro galáctico, las cosas se pudieron suceder, más o menos, como nos dicen al margen de la imagen, con algunas dudas y algunas preguntas sin contestar, así pudieron suceder, a grandes rasgos las cosas. Sin embargo, no es ese el tema que el título nos señala, nos vamos a centrar en la “vida” esa explosión de imaginación que ha tenido el universo para que, al menos en nuestro caso, haya alguien que comente sobre él y también, sobre esa maravilla que representamos: Seres Conscientes en un universo de materia, de explosiones y cambios, de energías sin fin.

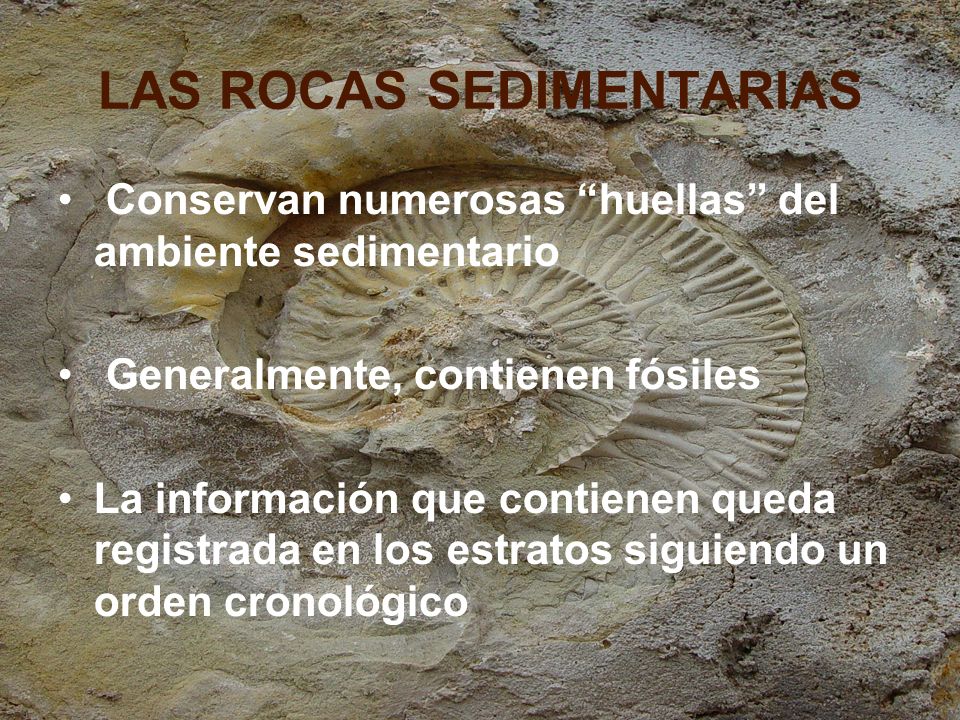

Lo cierto es que, el recuerdo de los miles de millones de años de la historia de la vida, no ha podido ser inscrito en la memoria de los seres que la representan, al igual que los últimos millones de años no están grabados en la memoria de los seres humanos, los primeros naturalistas que se sintieron intrigados por los fósiles que encontraban, no pudieron presentir de qué manera aquello que estaban sacando a la luz del día, acabaría por servir para reconstruir el pasado a través de los archivos sedimentarios de la tierra.

De nada sirvieron los razonamientos poéticos y religiosos que les habían preparado para lo contrario. La realidad nos hizo descubrir un mundo distinto, una cronología distinta y una historia distinta. Resulta fácil comprender, en qué medida, los primeros descubrimientos paleontológicos les pudieron parecer (en aquellos tiempos), por tanto, maravillosos y también, desconcertantes, hasta que punto aquella extraordinaria diversidad de formas de vida desaparecidas, su frecuente extravagancia y rareza y el encadenamiento asombroso que parecían ir revelando poco a poco, les debieron fascinar, pero también confundir.

Y, de esa manera, nuestra innata curiosidad, nos llevó a descubrir muchas clases de vida que existió en el pasado, incluso de seres monstruosamente grandes que extinguidos, sirvieron para que todos, antes sus descomunales restos, dejaran volar la imaginación y pudieran construir escenarios ya desaparecidos hacia millones de años. Claro que, todos aquellos descubrimientos, vinieron a ensanchar la mente de lo posible y la concepción de la historia de la vida en la Tierra y también, de manera paralela, hemos ido creando una historia más profunda, de unos 13.750.000 millones de años para la historia del propio universo. Pero, la historia que nos interesa, la de la vida, se remonta a unos 4.000 millones de años (al menos en nuestro planeta), que es el tiempo que tienen los fósiles más antiguo hallados en las rocas más viejas del planeta.

Ya el hombre de Neanderthal se interesaba por los fósiles.

El descubrimiento de edades anteriores a la aparición del hombre tuvo una enorme repercución, a finales del siglo XIX, mucho más allá de los círculos científicos, en buena parte porque reveló paisajes desaparecidos y poblados por criaturas extrañas, predominantemente mostruosas. Incluso en nuestros días los grandes vertebrados del pasado ejercen a menudo una especie de fascinación: ¿no se ha convertido acaso el mamut en el emblema de una cadena de supermercados y no resultan los nombres de muchos dinosaurios mucho más familiares, incluso para los niños, que los numerosos animales actuales?.

Esa familiaridad relativa con criaturas que hasta hace dos siglos, su existencia era inimaginable, es así mismo, un gran logro de la paleontología de los vertebrados sacados a la luz por la ciencia. Claro que, si hablamos de vida, no sólo de grandes animales se compone la gran relación que podríamos hacer de todas aquellas especies que poblaron nuestro planeta y de las que, el 99% están desaparecidas. Ahora, sólo el 1% de todas las especies vivientes siguen presentes y, las demás, por una u otra causa, quedaron extinguidas al no poder adaptarse, al ser eliminadas en las grandes extinciones… ¡y vaya usted a saber cómo!

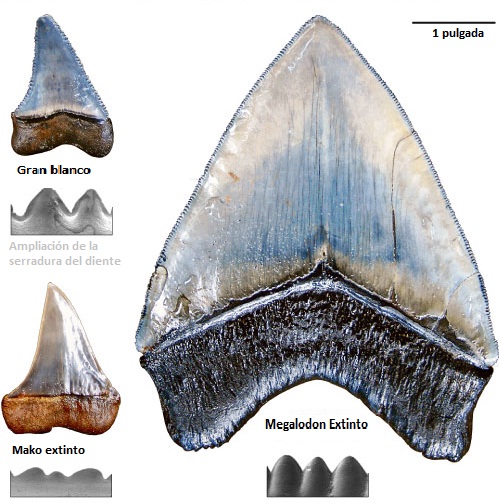

Cuentan que, durante uno de sus viajes por el Mediterráneo, san Pablo, según la leyenda que circula, naufragó ante las costas de Malta. Habiendo logrado llegar a esa isla, fue mordido por una vibora. Encolerizado, maldijo entonces a todas las serpientes maltesas, por lo que sus lenguas bífidas se transformaron en piedra. Esas lenguas petrificadas, llamadas a veces “lenguas de san pablo”, son muy comunes en Malta; no son otra cosa que los dientes de los tiburones del período mioceno, cuyas formas evocan las lenguas bífidas de las serpientes.

El relato ilustra muy bien la fascinación que han ejercido desde tiempos inmemoriales ciertos fósiles sobre la imaginación humana y la forma en que pueden ser explicados los orígenes de esos objetos misteriosos, más allá de toda hipótesis científica, en los sistemas de pensamientos tradicionales. Sin embargo, jamás conoceremos las más antiguas de esas leyendas explicativas, ya que el interés por los fósiles se remonta a la prehistoria lejana, tal como nos lo demuestran los diversos descubrimientos arqueológicos.

En el transcurso de sus excavaciones en las cuevas de Arcy-sur-Cure, en Borgoña, el célebre prehistoriador francés André Leroi Gourhan descubrió en un estrato correspondiente qal paleolítico medio una pequeña pero muy antigua “colección paleontológica” ; se trataba de un polípero y de un gasterópodo fósiles, y habían sido llevados a esa cueva por un hombre de Neardenthal. Hará más de 50.000 años posiblemente, que la atención de un “hombre fósil” se vio atraida por esos objetos curiosos, hasta el punto de que se los llevó consigo. No cabe duda de que nunca sabremos cuáles eran las interpretaciones que los hombres prehistóricos daban a los fósiles que recogían. En todo caso, ciertas conchas profundamente enterradas, le pudieron recordar a sus conchas actuales, y bien pudiera ser que se hubieran preguntado en aquel entonces qué hacían sobre las rocas unos animales que se encuentran habitualmente en el agua.

Es cierto que siempre, a lo largo de la Historia, hemos tenido pensadores y naturalistas. La Historia natural es un término cuya definición es problemática, en tanto que diversas disciplinas la abordan de manera diferente. Muchas de estas concepciones incluyen el estudio de las cosas vivientes (por ejemplo, la biología, incluyendo botánica, zoología y ecología); otras concepciones extienden el término al campo de la paleontología, la geografía y la bioquímica, así como a la geología, astronomía y la física. Lo cierto es que, al final del camino, todas esas disciplinas se encuentras, es decir, están de una u otra manera relacionadas. Todo en el Universo tiene una conexión que no siempre podemos ver o comprender.

Claro que, algunos pensadores griegos ya especularon con las viejas conchas fósiles que se hallaban dentro de las piedras y que eran el orgien de especulaciones “geológicas” de algunos que, como Jenófanes o Heródoto, quiénes habían comprendido la naturaleza auténtica de ciertas conchas fósiles y habían sacado conclusiones pertinentes, aquellos restos de organismos marinos, encontrados tierra adentro, demostraba que los mares, se extendían en otras épocas mucho más allá de sus límites actuales.

Lo cierto es que, hacer historia de la vida en nuestro planeta es imposible, sólo podemos ir atando cabos a medida que se encuentran huellas de ella en las viejas rocas, y, como la vida consciente tardó mucho más en llegar… ¡Carece de historia, toda vez que no existieron cronistas para escribirla! Así, nos vemos abocados a especular juntando todos los datos que hemos podido reunir y, de esas especulaciones, hemos formado un conjunto, si no plausible en su totalidad, sí aceptable mientras no encontremos más respuestas a la gran pregunta: ¿Cómo surgió la vida en la Tierra, y, es nuestro planeta el único lugar del Universo que la contiene?

Claro que, si creemos que la vida es ciudadana del universo sin fronteras, no debemos perder de vista la Panspermia, esas esporas viajeras que llegan a los mundos y en ellos, se posan y dejan pasar el tiempo para que, las condiciones locales, las radiaciones exteriores y propias del lugar, hagan su trabajo para que, con el tiempo suficiente por delante, puedan emerger y crecer hasta llegar a conformar seres con ideas y pensamientos.

Los animales unicelulares han descubierto el método más corto para comer las plantas. La muerte y el sexo han de crearse para que los organismos pluricelulares sean capaces de envejecer y dejar de funcionar como una cooperativa colonial de células. Los animales han descubierto como comerse a otros animales. Por encima de todo, ha evolucionado una especie inteligente, una especie tan lista que ha llegado a descubrir una vía para poder salir de la Tierra y llevar todo el proceso de la evolución hasta el extremo.

Nunca nadie ha sabido explicar lo que es la Vida a pesar de que tambien siempre nos lo hemos preguntado. Cuál es su origen y cómo surgieron los seres vivos que conocemos y que tenemos a nuestro alrededor, así como aquellos que con el paso de tiempo no supieron adaptarse y se extinguieron. La especie humana, la única que en nuestro planeta alcanzó la plenitud de conciencia, siempre ha tratado de responder a esa pregunta: ¿Qué es la Vida? Pero siempre también, resultó un gran problema el poder responderla y las Ciencias Naturales nunca pudo confeccionar una respuesta plausible. Hemos podido llegar a saber que sin los materiales fabricados en las estrellas, la vida no sería posible en nuestro Universo. Así muchos, dicen que somos… ¡Polvo de estrellas!

La célula viva es un sistema dinámico, en cambio constante en el cual las sustancias químicas se tornan ordenados por un tiempo en estructuras microscópicas, tan solo para disolverse nuevamente cuando otras moléculas se juntan para formar los mismos tipos de estructuras nuevamente, o para sustituirlas nuevamente en la misma estructura. Las organelas de las cuales las células están hechas no son más estáticas que la llama de una vela. En cualquier instante, la vela exhibe un patrón dinámico de casamientos y divorcios químicos, de procesos que producen energía y procesos que la consumen, de estructuras formándose y estructuras desapareciendo. La vida es proceso no una cosa.

¿Cómo ese proceso ordenado llegó a existir? Una vez que la célula es una entidad altamente ordenada y no aleatoria (evitando, la torpe regularidad de un cristal), se puede pensar en ella como un sistema que contiene información. La información es un ingrediente que adicionado, trae a la vida lo que serían átomos no vivos. ¿Cómo –nos preguntamos- la información puede ser introducida sin una inteligencia creativa sobrenatural? Este es el problema que la Ciencia aún tiene que responderse, lo que colocaría a Dios en la categoría de completamente desempleado.

![]()

La vida, seguramente, fue el resultado de los mismos procesos químicos y físicos que formaron los océanos y la corteza continental de nuestro planeta. Sin embargo, la vida es distinta porque puede experimentar evolución darwiniana. La selección natural ha desempeñado un pepel fundamental en la evolución de plantas y animales durante los primeros tiempos de la historia de nuestro planeta, pero también dirigió la evolución química que hizo posible la propia vida. A grandes rasgos entendemos cómo pueden haber evolucionado las moléculas a partir de precursores simples presentes en la Tierra joven. Sin embargo, sigue siendo un misterio cómo las proteínas, los ácidos nucleicos y las membranas llegaron a interaccionar de forma tan compleja.

Según todos los indicios, en los primeros años del planeta, los continentes que hoy conocemos estaban todos unidos formando la denominada Pangea. El movimiento de las placas tectónicas terrestres logró que estos se separaran y, con el transcurso de millones de años, llegaron a adquirir la moderna forma que hoy conocemos. En todo ese transcurrir y, mientras tanto, una serie de condiciones nuevas aparecieron para hacer posible el surgir de la vida.

Distribución de los continentes hace 260 millones durante el Pérmico. El supercontinente con forma de “C” es Pangea; dentro de la C se localizan los océanos Paleo-Tetis al norte y Tetis al sur; separando ambos océanos se sitúa el continente Cimmeria; cerrando la “C” al noreste se sitúan los microcontinentes de China del Norte y China del Sur; mientras que el resto del globo está ocupado por el océano Panthalassa.

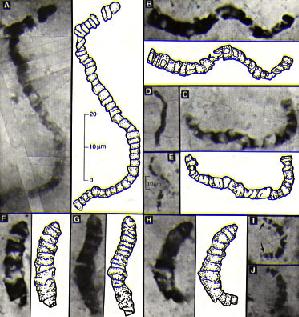

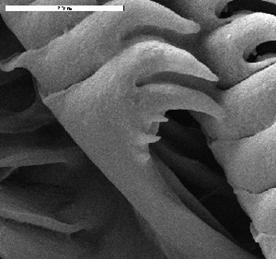

Microfósiles de sedimentos marinos. “Microfósil” es un término descriptivo que se aplica al hablar de plantas o animales fosilizados cuyo tamaño es menor de aquel que puede llegar a ser analizado por el ojo humano. Normalmente se utilizan dos rasgos diagnósticos para diferenciar microfósiles de eucariotas y procariotas.

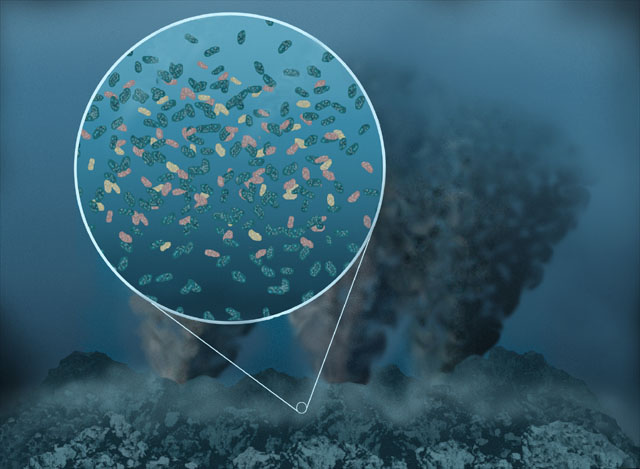

A partir de todos los fragmentos que la ciencia ha podido ir acumulando, ¿qué tipo de planeta podemos recomponer y qué porcesos tuvieron que darse para que, la vida, tal como la conocemos pudiera surgir? Sin temor a equivocarnos podemos afirmar que, cuando se formó el mar de Warrawoona la Tierra ya era un planeta biológico. Además, las mediciones de isótopos de carbono indican que ya podía haber comenzado la gran liberación ecológica de la fotosíntesis. No podemos tener la certeza si entre los microorganismos de aquel entonces había cianobacterias reproductoras de oxígeno, pero la presencia de cualquier tipo de organismo fotosintético en el océano de Warrawoona es de por sí muy informativa, pues nos permite colocar un punto de calibración en el árbol de la vida.

Los estromatolitos forman parte del registro fósil y son los responsables del oxígeno de la Tierra

Son la evidencia de vida más antigua que se conoce en la Tierra. Las rocas ígneas más antiguas de la Tierra están en Groenlandia y tienen 3800 millones de años. Los estromatolitos más antiguos son de Warrawoona, Australia y tienen unos 3500 millones de años (Precámbricos – Arqueanos). La edad de la Tierra como planeta acrecionado se calcula en 4500 millones de años. La teoría dice que, dadas las condiciones en esa época, los primeros habitantes de la Tierra debieron ser organismos unicelulares, procariontes, y anaerobios. Por tanto, los estromatolitos forman parte del registro fósil más importante de la vida microbiológica temprana. Pero además, vida microscópica fototrófica.

En la nueva concepción de la evolución microbiana que simboliza el árbol, los organismos fotosintéticos aparecen relativamente tarde y se diversifican mucho después del origen de la vida y de la divergencia de los principales dominios de la biología. Si la materia orgánica de Warrawoona es producto de la fotosíntesis, hay que concluir que para entonces la evolución de la vida ya debía llevar en marcha un buen tiempo.

Las observaciones geológicas indican que hace tres mil quinientos millones de años la atmósfera de la Tierra contenía nitrógeno, dióxido de carbono y vapor de agua, pero muy poco oxígeno libre. La mayoría de las inferencias acerca de ambientes antiguos se realizan a partir de pistas sutiles que nos proporcionan la geoquímica; la signatura sedimentaria del oxígeno, sin embargo, es muy llamativa: bandas de color rojo vivo en rocas con silex ricos en hermatita (Fe2 O3), un mineral de óxido de hierro.

En la actualidad, nuestros conocimientos de la vida y ambientes arcaicos son a un tiempo frustrantes y emocionantes: frustrantes por las pocas certezas que tenemos y, sólo muchas hipótesis a partir de los datos dispersos que se van obteniendo, emocionante porque sabemos algo, por poco que esto pueda ser, es estimulante contar con un punto de partida que nos permita continuar en el estudio y la observación, seguir experimentando para que, algún día, sepamos a ciencia cierta, de donde pudo venir la vida.

Es verdad que las rocas más antiguas que podemos identificar nos indican la presencia de organismos complejos ¿qué clase de células vivían en aquellos tiempos aún más lejanos? En última instancia, ¡cuál será el verdadero origen de la vida?

Ademas de las cianobacterias, la microflora puede incluir algas (verdes y diatomeas), hongos, crustaceos, insectos, esporas, polen, rodofitas, fragmentos y sedimentos de todo tipo. La variedad biologica de cada comunidad estromatolitica dependerá de condiciones ambientales e hidrológicas: hipersalino, dulceacuicola, intermareales, submareales, fuertes corrientes, moderadas nulas, calidos, templado, altitud (afecta a la exposicion de la luz uv). En la superficie, es rugosa, porosa y cubierta por mucilago, filamentos, etc. Las particulas de carbonato van quedadonde atrapadas, hasta que la cementacion por crecimiento de cristales, forma una capa mas, de esta forma la estructura aumenta de tamaño.

La Tierra es el tercer planeta del Sistema Solar. Esta situación orbital y sus características de masa la convierten en un planeta privilegiado, con una temperatura media de unos 15º C, agua en forma líquida y una atmósfera densa que pudo evolucionar, con oxígeno y otros ingredientes, condiciones imprescindibles para el desarrollo de la vida.

La creencia general es que hace unos 4.600 millones de años la corteza de la Tierra comenzó a consolidarse y las erupciones de los volcanes empezaron a formar la atmósfera, el vapor de agua y los océanos. El progresivo enfriamiento del agua y de la atmósfera permitió el nacimiento de la vida, iniciada en el mar en forma de bacterias y algas, de las que derivamos todos los seres vivos que habitamos hoy nuestro planeta tras un largo proceso de evolución biólogica.

Aun los organismos más simples son máquinas moleculares extraordinariamente sofisticadas. Las primeras formas de vida tenían que ser muchísimo más sencillas. Necesitamos encontrar una familia de moléculas lo bastante simples como para formarse por procesos químicos y lo bastante complejas como para servir de cimiento a la evolución de las células vivas. Una molécula capaz de contener información y estructura suficientes como para replicarse a sí mismas y, al cabo, para dirigir la síntesis de otros componentes que puedan canalizar la replicación con una eficiencia cada vez mayor.

ESTRUCTURA DE LA CELULA BACTERIANA

Unas moléculas, en fin, que pudieran iniciar una trayectoria evolutiva que permitiera a la vida emanciparse de los procesos físicos que le dieron nacimiento, sintetizando las moléculas necesarias para el crecimiento en lugar de incorporarlas de su entorno y captando energía química o solar para alimentar el funcionamiento de la célula.

El descubrimiento de las enzimas de ARN, o ribosomas, realizado de forma independiente y aproximadamente al mismo tiempo por el bioquímico de Yale Sidney Altman, tuvo un efecto catalítico sobre el pensamiento acerca del origen de la vida.

Los enzimas de ARN (llamadas “ribozimas” o “aptazimas”) son moléculas de ARN capaces de autorreplicarse a temperatura constante en ausencia de proteínas. Utilizan la llamada replicación cruzada, en la que dos enzimas se catalizan el uno al otro de forma mutua. Este proceso permite entender cómo surgió la vida, pero los biotecnólogos las usan para algo mucho más prosaico. Estos enzimas de ARN pueden ser utilizados para detectar una gran variedad de compuestos, incluyendo muchos relevantes en diagnóstico médico. El compuesto orgánico se liga al aptazima, que se replica exponencialmente, amplificando exponencialmente la concentración del compuesto hasta permitir que sea fácilmente detectado.

En palabras del filósofo de la biología Iris Fry, esta extraordinaria molécula se alzó como “el huevo y la gallina al mismo tiempo” en el rompecabezas del orgien de la vida. La vida, esa misteriosa complejidad que surgió a partir de la “materia inerte” que, bajo ciertas y complejas condiciones, dio lugar a que lo sencillo se conviertiera en complejo, a que lo inerte pudiera despertar hasta los pensamientos.

Sabemos que, en ciertas condiciones prebióticas, los aminoácidos se forman fácilmente, así quedó demostrado por Stanley Miller en su gamoso experimento. Como los ácidos nucléicos, pueden unirse para formar péptidos, las cadenas de aminoácidos que se pliegan para formar proteínas funcionales.

Hay teorías para todos los gustos, y, el afamado Freeman Dyson, un renombrado físico que ha pensado profundamente sobre el origen de la vida, sugiere que en realidad la vida comenzó en dos ocasiones, una por la vía del ARN y otra vez por vía de las proteínas. Las células con proteínas y ácidos nucleicos interactivos habrían surgido más tarde en función protobiológica. Y, está claro que, la innovación por alianzas es uno de los principales temas de la evolución.

En el árbol de la vida, nosotros (“tan importantes”), sólo somos una pequeña ramita.

Hay muchos procesos que son de una importancia extrema en la vida de nuestro planeta y, dado que los organismos fotosintéticos (o quimiosinteéticos) no pueden fraccionar isótopos de carbono en más de unas treinta parte por 1.000, necesitamos invocar la participación de otros metabolismos para poder explicar los resultados de las mediciones que se han realizado. Los candidatos más probables son bacterias que se alimentan de metano en los sedimentos. Estas bacterias obtienen tanto el carbono como la energía del gas natural (CH4) y, al igual que los organismos fotosintéticos, son selectivos con los isótopos. A causa de su preferencia química por el 12CH4 frente al 13CH4, los microbios que se alimentan de metano fraccionan los isótopos de carbono en unas veinte o vejnticinco partes por 1.000 en los ambientes donde el metano es abundante. ¿Habeis pensado en la posibilidad de que esos organismos fotosintéticos estén presentes en Titán? ¡El fetín está servido!

Los océanos de metano de titán podrían ser una buena fuente de vida

La fotosíntesis anoxigénica se da en los organismos que utiliza la energía de la luz del sol, dióxido de carbono (sustrato a reducir) y sulfuro de hidrógeno (en lugar del agua) como dador de electrones que se oxida, se fabrican glúcidos y se libera azufre a el medio acuoso donde habitan o se aloja en el interior de la bacteria.

Otra característica es que los organismos fotosinteticos anoxigénicos contienen bacterioclorofila, un tipo de clorofila exclusiva de los foto-organotrofos, usan longitudes de onda de luz que no son absorbidas por las plantas. Estas bacterias contienen también carotenoides, pigmentos encargados de la absorción de la energía de la luz y posterior transmisión a la bacterioclorofila. El color de estos pigmentos dan el nombre a estas bacterias: bacterias púrpuras del azufre y bacterias verdes del azufre. En las cianobacterias los pigmentos captadores de luz son las ficobilinas, por lo tanto se les nombra, bacterias azules.

Cualquiera de estas imágenes de arriba nos cuenta una larga y compleja historia de cómo se pudieron formar cada uno de los ahí representados, y, en cualquiera de sus fases, formas y colores, es toda una gran obra de la Ingenieria de la Naturaleza que, al fin y al cabo, es la única fuente de la que debemos beber para saciar nuestra sed de sabiduría y alejar la ignorancia que nos abruma.

No pocas veces he dejado aquí constancia de que, el Universo, en todas sus regiones, por muy alejadas que estén, se rige por unas leyes que están presentes en todas parte por igual, y, así lo confirman mil observaciones y mil proyectos que a tal efecto se han llevado a buen término. Por ejemplo, mediaciones precisas de isótopos de azufre en muestras de Marte traídas a la Tierra por meteoritos demuestran que muy pronto en la historia del planeta vecino el ciclo del azufre estaba dominado por procesos atmosféricos que producían un fraccionamiento independiente de la masa.

Valles en Marte. (ESA) La región de Valles Marineris, que tiene una longitud de 4.000 kilómetros y una anchura de 600 kilómetros, es el sistema de cañones más grande conocido en el sistema solar, con profundidades que llegan a los diez kilómetros.

Basándose en este descubrimiento del fraccionamiento independiente de la masa, se dirigió la atención sobre las rocas terrestres más antiguas. Para sorpresas de muchos geoquímicos, lo que se hayó fue que el yeso y la pirita de las sucesiones sedimentarias más antiguas de la Tierra también como en Marte, han dejado constancias del fraccionamiento independiente de la masa de los isótopos de azufre. Al igual que en Marte, en la Tierra primitiva la química del azufre se encontraba al parecer influenciada por procesos fotoquímicos que sólo pueden producirse en una atmósfera pobre en oxígeno. La etapa del oxígeno comenzó en nuestra atmósfera a comienzos del eón Ptoterozoico. En suma, todos los caminos de la biogeoquímica llevan al mismo sitio, es decir, lo que pasa aquí pudo pasar allí y, al decir allí, quiero decir en cualquier planeta de cualquier galaxia. Las leyes fundamentales de la Naturaleza son, las mismas en todas partes. No existen sitios privilegiados.

Es difícil imaginarse hoy una Tierra sin oxígeno

Dos equipos independientes de investigadores descubrieron que el oxígeno gaseoso apareció en la atmósfera terrestre unos 100 millones de años antes del evento de la gran oxidación de hace 2400 millones de años. Es decir, cuando cambió la antigua atmósfera y el planeta se equipo con la que hoy conocemos.

El oxígeno es un gas muy reactivo, no existe de manera libre durante un largo período de tiempo, pues forma óxidos o reacciona con otras sustancias de manera rápida. Si está presente en la atmósfera es porque las plantas lo reponen continuamente. Antes de la invención de la fotosíntesis y durante muchos cientos de millones de años no había oxígeno libre en la Tierra.

En los estratos geológicos se pueden encontrar pruebas de la existencia de un momento en el que se produjo una gran oxidación mineral, prueba de que el oxígeno se encontraba ya libre en la atmósfera terrestre por primera vez y en gran cantidad. A este hecho se le ha denominado evento de gran oxidación, o GOE en sus siglas en inglés, y fue un hecho dramático en la historia de la Tierra. Este oxígeno permitió más tarde la aparición de vida animal compleja. Los geólogos creían que durante el GOE los niveles de oxígeno subieron rápidamente desde niveles prácticamente despreciables.

El mundo bacteriano es fascinante

Con estas bacterias es posible obtener dos tipos de celdas microbianas o baterías. Unas llamadas celdas de sedimento emplean el lodo donde habitan estos microorganismos; ahí, se produce energía simplemente conectando un electrodo en la parte donde, a cierta profundidad, no hay oxígeno, con otro electrodo que se encuentre en presencia de oxígeno.

¿Cómo respondió la vida a la revolución del oxígeno? Podemos imaginar, un “holocausto de oxígeno” que habría llevado a la muerte y la extinción a innumerables linajes de microorganismos anaeróbicos. Pero hace dos mil doscientos millones de años los ambientes anóxicos no desaparecieron; simplemente, quedaron relegados bajo una capa oxigenada de agua y sedimentos superficiales.

Aquello permitió a la Tierra dar cobijo a una diversidad biológica sin precedentes. Los microorganismos anaeróbicos mantuvieron un papel esencial en el funcionamiento de los ecosistemas, igual que en la actualidad.

En la primera fase de cualquier ejercicio aeróbico, el oxígeno se combina con la glucosa procedente del glucógeno. Al cabo de unos minutos, cuando el cuerpo nota que escasea el azúcar, empieza a descomponer las grasas. Entonces disminuye un poco el rendimiento, mientras el cuerpo se adapta al cambio de origen de su energía. Superado este punto, se vuelve a los niveles y sensaciones normales, pero se queman grasas en lugar de glucosa.

De otro lado, los organismos que utilizan, o al menos toleran el oxígeno se expandieron enormemente. La respiración aeróbica se convirtió en una de las formas principales de metabolismo en las bacterias, y las bacteria quimiosintéticas que obtienen energía de la reacción entre oxígeno e hidrógeno o iones metálicos se diversificaron a lo largo de la frontera entre ambientes ricos en oxígeno y ambientes pobres en oxígeno. Desde ese momento, la Tierra comenzó a convertirse en nuestro mundo.

Nuestro mundo, rico en agua líquida que cubre el 71% de la superficie del planeta, y, su atmósfera con un 78% (en volumen) de Nitrógeno, un 21 de Oxígeno y un 0,9 de Argón, además de dióxido de carbono, hidrógeno y otros gases en cantidades mucho menores que, permiten que nuestros organismos encuentren el medio indóneo para poder vivir. Otros muchos factores presentes en la Tierra contribuyen a que nuestra presencia aquí sea posible.

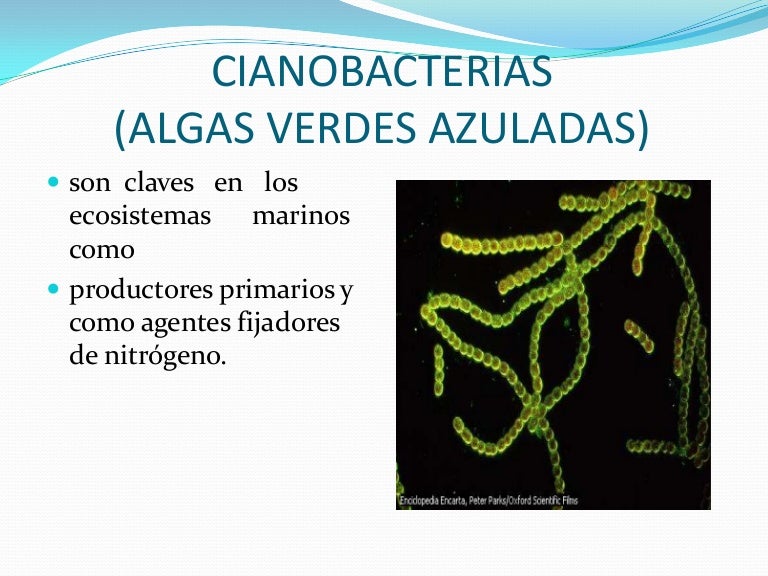

Las algas verdeazuladas también son llamadas bacterias verdeazuladas porque carecen de membrana nuclear como las bacterias. Sólo existe un equivalente del núcleo, el centroplasma, que está rodeado sin límite preciso por el cromatoplasma periférico coloreado. El hecho de que éstas se clasifiquen como algas en vez de bacterias es porque liberan oxígeno realizando una fotosíntesis similar a la de las plantas superiores. Ciertas formas tienen vida independiente, pero la mayoría se agrega en colonias o forma filamentos. Su color varía desde verdeazulado hasta rojo o púrpura dependiendo de la proporción de dos pigmentos fotosintéticos especiales: la ficocianina (azul) y la ficoeritrina (rojo), que ocultan el color verde de la clorofila.

Mientras que las plantas superiores presentan dos clases de clorofila llamadas A y B, las algas verdeazuladas contienen sólo la de tipo A, pero ésta no se encuentra en los cloroplastos, sino que se distribuye por toda la célula. Se reproducen por esporas o por fragmentación de los filamentos pluricelulares. Las algas verdeazuladas se encuentran en hábitats diversos de todo el mundo. Abundan en la corteza de los árboles, rocas y suelos húmedos donde realizan la fijación de nitrógeno. Algunas coexisten en simbiosis con hongos para formar líquenes. Cuando hace calor, algunas especies forman extensas y, a veces, tóxicas floraciones en la superficie de charcas y en las costas. En aguas tropicales poco profundas, las matas de algas llegan a constituir unas formaciones curvadas llamadas estromatolitos, cuyos fósiles se han encontrado en rocas formadas durante el precámbrico, hace más de 3.000 millones de años. Esto sugiere el papel tan importante que desempeñaron estos organismos cambiando la atmósfera primitiva, rica en dióxido de carbono, por la mezcla oxigenada que existe actualmente. Ciertas especies viven en la superficie de los estanques formando las “flores de agua”.

Sin descanso se habla de quer nosotros, con nuestro comportamiento estamos cambiando la atmósfera de la Tierra, que contaminamos y que, de seguir así, podemos acabar con la vida placentera en el planeta. Tal exageración queda anulada por la realidad de los hechos.

Gigantescas ciudades son una buena muestra de nuestra presencia aquí, y, ¿qué duda nos puede caber? Nuestro morfología nos ha convertido en el ser vivo dominante en el planeta. Sin embargo, no somos los que más hemos incidido en sus condiciones. Si se estudia la larga historia de la vida en la Tierra, podremos ver que una inmensa cantidad de especies han interactuado con la biosfera para modificar, en mayor o menor medida los ecosistemas del mundo. En realidad, la especie que cambió el planeta de manera radical, la que en verdad modificó la Tierra hasta traerla a lo que hoy es, creando una biosfera nueva a la que todas las especies se tuvieron que adaptar (también nosotros), esa especie que, aunque diminuta en su individualidad forma un gigantesco grupo, no son otras que las cianobacterias.

De esa manera, si el oxígeno trajo consigo un cambio revolucionario, las heroínas de la revolución fueron las cianobacterias. Fósiles extraordinarimente bien conservados en síles de Siberia de mil quinientos millones de años de edad demuestran que las bacterias verdeazuladas se diversificaron tempranamente y se han mantenido hasta la actualidad sin alterar de manera sustancial su forma. La capacidad de cambiar con rapidez, pero persistir indefinidamente, compendia la evolución bacteriana.

Las cianobacterias comparten con algunas otras bacterias la habilidad de tomar el N2 del aire, donde es el gas más abundante, y reducirlo a amonio (NH4), una forma que todas las células pueden aprovechar. Los autótrofos que no pueden fijar el N2, tienen que tomar nitrato (NO3-), que es una sustancia escasa. Esto les ocurre por ejemplo a las plantas. Algunas cianobacteria son simbiontes de plantas acuáticas, como los helechos del género Azolla, a las que suministran nitrógeno. Dada su abundancia en distintos ambientes las cianobacterias son importantes para la circulación de nutrientes, incorporando nitrógeno a la cadena alimentaria, en la que participan como productores primarios o como descomponedores.

La resistencia general de las bacterias a la extinción es media tarde, las bacterias que hayan sobrevivido al cepillo se habrán multiplicado hasta el extremo de recubrir nuevamente el interior de la boca. Además, las bacterias saben habérselas muy bien con medios cambiantes. El aire, por ejemplo, está lleno de bacterias; un plato de leche colocado en el alfeizar de la ventana no tarda en fermentar.

Feb

3

Lo que se cree sobre el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El origen ~

Clasificado en El origen ~

Comments (1)

Comments (1)

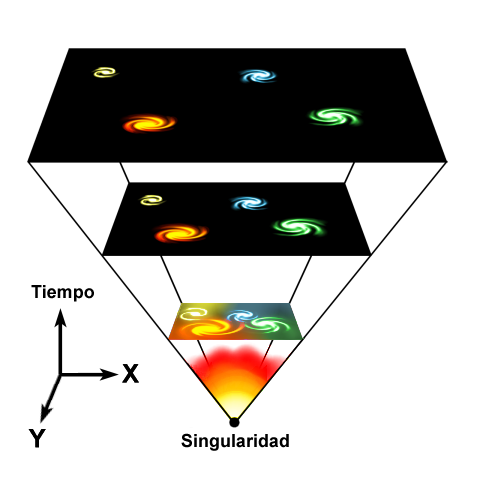

Según la teoría del Big Bang, el Universo se originó en una singularidad espaciotemporal de densidad infinita matemáticamente paradójica. El universo se ha expandido desde entonces, por lo que los objetos astrofísicos se han alejado unos respecto de los otros. Es decir, lo que se ha expandido ha sido el espacio, con lo cual, no se viola el principio de la relatividad de la velocidad de la luz, toda vez que, los objetos, nunca pudieron sobrepasar dicha velocidad.

El Universo

“El universo es la totalidad del espacio y del tiempo, de todas las formas de la materia, la energía y el impulso, las leyes y constantes físicas que las gobiernan. Sin embargo, el término también se utiliza en sentidos contextuales ligeramente diferentes y alude a conceptos como cosmos, mundo o naturaleza.

Observaciones astronómicas indican que el universo tiene una edad de 13,73 ± 0,12 millardos de años (entre 13 730 y 13 810 millones de años) y por lo menos 93 000 millones de años luz de extensión.2 El evento que dio inicio al universo se denomina Big Bang. Se denomina Big-Bang a la singularidad que creó el universo. Después del Big Bang, el universo comenzó a expandirse para llegar a su condición actual, y continúa haciéndolo.

Debido a que, según la teoría de la relatividad especial, la materia no puede moverse a una velocidad superior a la velocidad de la luz, puede parecer paradójico que dos objetos del universo puedan haberse separado 93 mil millones de años luz en un tiempo de únicamente 13 mil millones de años; sin embargo, esta separación no entra en conflicto con la teoría de la relatividad general, ya que ésta sólo afecta al movimiento en el espacio, pero no al espacio mismo, que puede extenderse a un ritmo superior, no limitado por la velocidad de la luz. Por lo tanto, dos galaxias pueden separarse una de la otra más rápidamente que la velocidad de la luz si es el espacio entre ellas el que se dilata.

La radiación de fondo de microondas

Mediciones sobre la distribución espacial y el desplazamiento hacia el rojo (redshift) de galaxias distantes, la radiación cósmica de fondo de microondas, y los porcentajes relativos de los elementos químicos más ligeros, apoyan la teoría de la expansión del espacio, y más en general, la teoría del Big Bang, que propone que el universo en sí se creó en un momento específico en el pasado.

Observaciones recientes han demostrado que esta expansión se está acelerando, y que la mayor parte de la materia y la energía en el universo son las denominadas materia oscura y energía oscura, la materia ordinaria (barionica), solo representaría algo más del 5 % del total3 (véanse materia oscura y energía oscura).

Los experimentos sugieren que el universo se ha regido por las mismas leyes físicas, constantes a lo largo de su extensión e historia. Es homogéneo e isotrópico. La fuerza dominante en distancias cósmicas es la gravedad, y la relatividad general es actualmente la teoría más exacta para describirla. Las otras tres fuerzas fundamentales, y las partículas en las que actúan, son descritas por el Modelo Estándar. El universo tiene por lo menos tres dimensiones de espacio y una de tiempo, aunque experimentalmente no se pueden descartar dimensiones adicionales muy pequeñas. El espacio-tiempo parece estar conectado de forma sencilla, y el espacio tiene una curvatura media muy pequeña o incluso nula, de manera que la geometría euclidiana es, como norma general, exacta en todo el universo.

La ciencia modeliza el universo como un sistema cerrado que contiene energía y materia adscritas al espacio-tiempo y que se rige fundamentalmente por principios causales.

Basándose en observaciones del universo observable, los físicos intentan describir el continuo espacio-tiempo en que nos encontramos, junto con toda la materia y energía existentes en él. Su estudio, en las mayores escalas, es el objeto de la cosmología, disciplina basada en la astronomía y la física, en la cual se describen todos los aspectos de este universo con sus fenómenos.

La teoría actualmente más aceptada sobre la formación del universo, fue teorizada por el canónigo belga Lemaître, a partir de las ecuaciones de Albert Einstein. Lemaitre concluyó (en oposición a lo que pensaba Einstein), que el universo no era estacionario, que el universo tenía un origen. Es el modelo del Big Bang, que describe la expansión del espacio-tiempo a partir de una singularidad espaciotemporal. El universo experimentó un rápido periodo de inflación cósmica que arrasó todas las irregularidades iniciales. A partir de entonces el universo se expandió y se convirtió en estable, más frío y menos denso. Las variaciones menores en la distribución de la masa dieron como resultado la segregación fractal en porciones, que se encuentran en el universo actual como cúmulos de galaxias.

En cuanto a su destino final, las pruebas actuales parecen apoyar las teorías de la expansión permanente del universo (Big Freeze ó Big Rip, Gran Desgarro), que nos indica que la expansión misma del espacio, provocará que llegará un punto en que los átomos mismos se separarán en partículas subatómicas. Otros futuros posibles que se barajaron, especulaban que la materia oscura podría ejercer la fuerza de gravedad suficiente para detener la expansión y hacer que toda la materia se comprima nuevamente; algo a lo que los científicos denominan el Big Crunch o la Gran Implosión, pero las últimas observaciones van en la dirección del gran desgarro.”

Ahora, Roger Penrose, de la Universidad de Oxford y uno de los físicos más brillantes de la actualidad, cree haber detectado “atisbos” de la existencia de otro universo. Uno que existía antes que el Big Bang. Lo cual pone, literalmente, patas arriba las teorías cosmológicas actuales. En un artículo recién publicado en ArXiv.org, Penrose explica que ha llegado a esa extraordinaria conclusión tras analizar, en los datos del satélite WMAP, ciertos patrones circulares que aparecen en el fondo de microondas cósmico y que sugieren, ni más ni menos, que el espacio y el tiempo no empezaron a existir en el Big Bang, sino que nuestro universo existe en un ciclo continuo de “rebotes” que él llama “eones”.

Según Penrose, lo que actualmente percibimos como nuestro universo, no es más que uno de esos eones. Hubo otros antes del Big Bang y habrá otros después. Unas ideas que se oponen frontalmente al modelo cosmológico más extendido en la actualidad: el de universo inflacionario. Según dicho modelo, el universo empezó en un punto de densidad infinita (el Big Bang) hace aproximadamente 13.700 millones de años, se expandió de forma extremadamente rápida durante una fracción de segundo, y ha continuado expandiéndose mucho más lentamente desde entonces, un tiempo durante el cual han ido surgiendo galaxias, estrellas, planetas y, finalmente, los seres humanos.

El tiempo antes del Big Bang Penrose, sin embargo, está convencido de que el modelo inflacionario no cuadra con el bajísimo estado de entropía que hizo posible el nacimiento del universo tal y como lo conocemos. Y tampoco cree que el espacio y el tiempo empezaran a existir en el momento del Big Bang, sino que el Big Bang fue, de hecho, sólo uno entre una serie de muchos acontecimientos similares, con cada uno marcando el inicio de un nuevo “eón” en la historia del universo. Las teorías de Penrose implican que, en un futuro lejano, el universo volverá, de alguna manera, a tener las condiciones que hicieron posible el Big Bang. Según el físico, en esos momentos la geometría del universo será suave y lineal, muy diferente a como es ahora, con abundantes picos y discontinuidades.

«La materia oscura puede ser ‘otra dimensión’, tal vez incluso un importante sistema de transporte galáctico. […]

En Interstellar, la película de ciencia ficción de Christopher Nolan, los protagonistas cruzan un agujero de gusano hallado fortuitamente en las cercanías de Saturno que permite viajar a varios mundos potencialmente habitables fuera del Sistema Solar. A veces pienso que, hablar de esto es casi lo mismo que hablar de cómo se creó en el Universo, en ambos casos, existen espacios oscuros que nos alejan de la posible verdad de lo que pudo ocurrir o de lo que podrá ser posible.

Esta futura continuidad de forma, afirma, permitirá una transición desde el final del actual eón, con un universo muy expandido e infinitamente grande, al inicio del siguiente, cuando de nuevo se hará infinitamente pequeño para estallar formando el siguiente Big Bang. Pruebas en el fondo cósmico El físico asegura que ha encontrado pruebas que sostienen lo que dice. Y que esas pruebas están en el fondo cósmico de microondas, los ecos lejanos del propio Big Bang, una especie de rescoldo de aquella gran explosión que es detectable, hoy, en cualquier punto del universo. Analizando, junto a su colega armenio Vahe Gurzadyan, siete años de datos del satélite WMAP, que está diseñado precisamente para medir el fondo de microondas, Penrose ha detectado con claridad una serie de “círculos concéntricos”, regiones en el cielo de microondas en los que el rango de temperatura de la radiación es notablemente menor que en otros sitios. Son precisamente esos círculos los que nos permiten “ver” a través del Big Bang, vislumbrando el eón que que existió anteriormente. Los círculos, dicen Penrose y Gurzadyan, son marcas dejadas en nuestro eón por las ondulaciones esféricas de las ondas gravitatorias que se generaron cuando los agujeros negros colisionaron en el eón anterior. Y estos círculos, sostienen, suponen un serio problema para la teoría inflacionaria, según la cual la distribución de las variaciones de temperatura en el cielo deberían ser Gaussianas, o aleatorias, en lugar de tener estructuras discernibles en su interior. Si Penrose tiene razón, cambiará por completo la forma que tenemos de percibir el universo en que vivimos, su nacimiento y su destino final.

Amigos míos, lo cierto es que, seguros lo que se dice seguros… ¡No lo podemos estar! Ya que, los modelos actuales del Universo, aunque algunos, como el Big Bang, parece que se puede acercar a esa realidad que buscamos, lo cierto es que, nos deja muchas zonas oscuras y, afirmar nada podemos.

emilio silvera

Totales: 75.062.623

Totales: 75.062.623 Conectados: 2

Conectados: 2