Feb

1

Espacio-tiempo curvo y los secretos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Sin categoría ~

Clasificado en Sin categoría ~

Comments (0)

Comments (0)

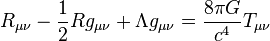

La densidad de energía-momentum en la teoría de la relatividad se representa por cuadritensor energía-impulso. La relación entre la presencia de materia y la curvatura debida a dicha materia viene dada por la ecuación de campo de Einstein. Esta sencilla ecuación es la demostración irrebatible de la grandeza de la mente humana que, con unos pocos signos nos puede decir tánto. De las ecuaciones de campo de Einstein, se pudieron deducir muchas cosas, tales como que el espacio se curva en presencia de grandes masas, como mundos, estrellas y galaxias para configurar la geometría del espacio.

Los vientos estelares emitidos por las estrellas jóvenes, distorsionan el material presente en las Nebulosas, y, de la misma manera, en presencia de masa se distosiona el esapcio-tiempo. En estos lugares que, como océanos de gas y polvo iniozado por la radiación de las estrellas masivas más jóvenes, existen moléculas complejas que, en algún caso, son esenciales para la existencia de la vida.

La teoría cuántica de campos en espacio-tiempo curvo es una extensión de la teoría cuántica de campos estándar en la que se contempla la posibilidad de que el espacio-tiempo por el cual se propaga el campo no sea necesariamente plano (descrito por la métrica de Minkouski). Una predicción genérica de esta teoría es que pueden generarse partículas debido a campos gravitacionales dependientes del tiempo, o a la presencia de horizontes.

La teoría cuántica de campos en espacio-tiempo curvo puede considerarse como una primera aproximación de gravedad cuántica. El paso siguiente consiste en una gravedad semiclásica, en la que se tendrían en cuenta las correcciones cuánticas, debidas a la presencia de materia, sobre el espacio-tiempo.

En un espacio euclideo convencional un objeto físico finito está contenido dentro de un ortoedro mínimo, cuyas dimensiones se llaman ancho, largo y profundida o altura. El espacio físico a nuestro alrededor es tridimensional a simple vista. Sin embargo, cuando se consideran fenómenos físicos la gravedad, la teoría de la relatividad nos lleva a que el universo es un ente tetra-dimensional que incluye tanto dimensiones espaciales como el tiempo como otra dimensión. Diferentes observadores percibirán diferentes “secciones espaciales” de este espacio-tiempo por lo que el espacio físico es algo más complejo que un espacio euclídeo tridimiensional.

En las teorías actuales no existe una razón clara para que el de dimensiones espaciales sean tres. Aunque existen ciertas instuiciónes sobre ello: Ehrenfest (aquel gran físico nunca reconocido) señaló que en cuatro o más dimensiones las órbitas planetarias cerradas, por ejemplo, no serían estables (y por ende, parece difícil que en un universo así existiera vida inteligente preguntándose por la tridimensionalidad espacial del universo).

Es cierto que en nuestro mundo tridimensional y mental existen cosas misteriosas. A veces me pregunto que importancia puede tener un . (“¿Qué hay en un nombre? Lo que llamamos rosa, / con cualquier otro nombre tendría el mismo dulce aroma”? (-Shakespeare, Romeo y Julieta-) – La rosa da sustento a muchos otros tópicos literarios: se marchita como símbolo de la fugacidad del tiempo y lo efímero de la vida humana; y provoca la prisa de la doncella recogerla mientras pueda. Por otro lado, le advierte de que hay que tener cuidado: no hay rosa sin espinas.

También el mundo de la poesía es un tanto misterioso y dicen, que… “Los poetas hablan consigo mismo y el mundo les oye por casualidad.” Tópicos ascéticos, metafísicos o existenciales: Quiénes somos, de dónde venimos, a dónde vamos, las llamadas preguntas trascendentales, propias de la cosmología, la antropología y la metafísica. Los poetas siempre han buscado un mundo irreal y han idealizado el enaltecido mucho más allá de este mundo.

Como siempre me pasa, me desvío del tema que en este trabajo nos ocupa: El espacio-tiempo.

Estamos inmersos en el espacio-tiempo curvo y tetradimensional de nuestro Universo. Hay que entender que el espacio–tiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo. De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio–tiempo. La trayectoria de un objeto en el espacio–tiempo se denomina por el de línea de universo. La relatividad general nos explica lo que es un espacio–tiempo curvo con las posiciones y movimientos de las partículas de materia.

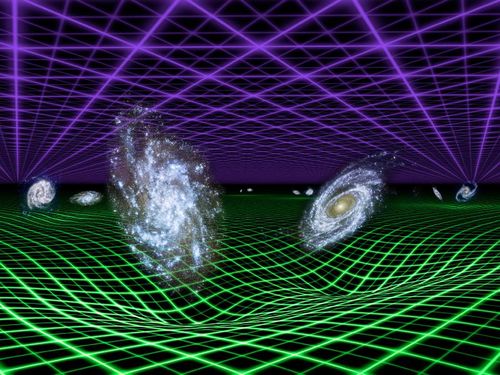

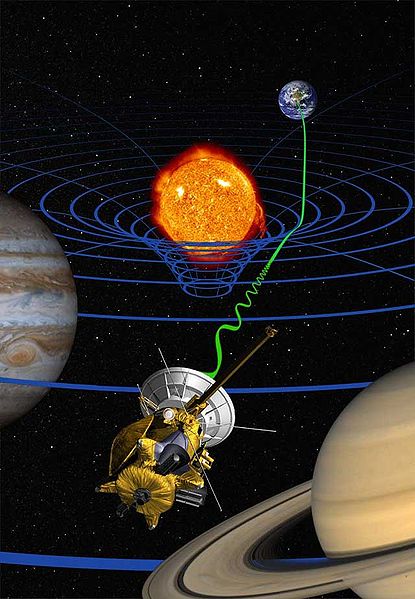

La introducción por parte de Minkouski de la idea espaciotemporal resultó tan importante es porque permitió a Einstein utilizar la idea de geometría espaciotemporal para formular su teoría de la relatividad general que describe la Gravedad que se genera en presencia de grandes masas y cómo ésta curva el espacio y distorsiona el tiempo. En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio–tiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. Hemos llegado a comprender que es la materia, la que determina la geometría del espacio-tiempo.

En la imagen, dos partículas en reposo relativo, en un espacio-tiempo llano y Se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

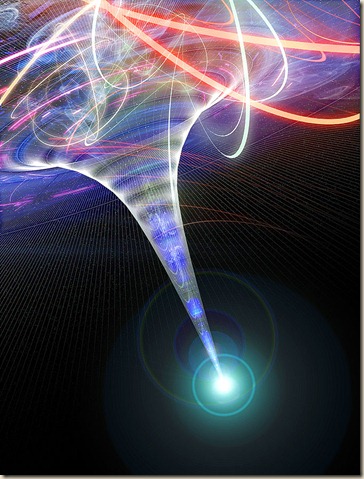

El máximo exponente conocido del espacio-tiempo curvo, se podría decir que se da en la formación de los agujeros negros, donde la masa queda comprimida a tal densidad que se conforma en una singularidad, ese objeto de energía y densidad “infinitsas” en el que, el espacio y el tiempo desaparecen de nuestra vista y parece que entran en “otro mund” para nosotros desconocidos.

Los agujeros negros, cuya existencia se dedujo por Schwarzschild en 1.916 a partir de las ecuaciones de campo de Einstein de la relatividad general, son objetos supermasivos, invisibles a nuestra vista (de ahí su nombre) del que no escapa ni la luz; tal es la fuerza gravitatoria que generan que incluso engullen la materia de sus vecinas, objetos estelares como estrellas que osan traspasar el cinturón de seguridad que llamamos horizonte de sucesos.

Desde siempre hemos tenido la tendencia de querer representar las cosas y a medida que pudimos descubrir conocimientos nuevos, también le dimos a esos nuevos saberes sus símbolos y ecuaciones matemáticas que representaban lo que creíamos saber. Mecánica cuántica, relatividad, átomos, el genóma, agujeros negros, la constante cosmológica, la constante de Planck racionalizada…

Wheeler decía allá por el año 1957, que el punto final de la compresión de la materia -la propia singularidad– debía estar gobernada por la unión, o matrimonio, de las leyes de la mecánica cuántica y las de la distorsión espaciotemporal. Esto debe ser así, puesto que la distorsión espaguetiza el espacio a escalas tan extraordinariamente microscópicas que están profundamente influenciadas por el principio de incertidumbre.

Las leyes unificadas de la distorsión espaciotemporal y la mecánica cuántica se denominan “leyes de la gravedad cuántica”, y han sido un “santo grial” para todos los físicos desde los años cincuenta. A principios de los sesenta los que estudiaban física con Wheeler, pensaban que esas leyes de la gravedad cuántica eran tan difíciles de comprender que nunca las podrían descubrir durante sus vidas. Sin embargo, el tiempo inexorable no deja de transcurrir, mientras que, el Universo y nuestras mentes también, se expanden. De tal manera evolucionan nuestros conocimientos que, poco a poco, vamos pudiendo conquistar saberes que eran profundos secretos escondidos de la Naturaleza y, con la Teoría de cuerdas (aún en desarrollo), parece que por fín, podremos tener una teoría cuántica de la gravedad.

Una cosa sí sabemos: Las singularidades dentro de los agujeros negros no son de mucha utilidad puesto que no podemos contemplarla desde fuera, alejados del horizonte de sucesos que marca la línea infranqueable del irás y no volverás. Si alguna vez alguien pudiera llegar a ver la singularidad, no podría regresar para contarlo. Parece que la única singularidad que podríamos “contemplar” sin llegar a morir sería aquella del Big Bang, es decir, el lugar a partir del cual pudo surgir el universo y, cuando nuestros ingenios tecnológicos lo permitan, serán las ondas gravitacionales las que nos “enseñarán” esa singularidad.

Esta pretende ser la imagen de un extraño objeto masivo, un quásar que sería una evidencia vital del Universo primordial. Es un objeto muy raro que nos ayudará a entender cómo crecieron los agujeros negros súpermasivos unos pocos cientos de millones de años después del Big Bang (ESO).

Representación artística del aspecto que debió tener 770 millones después del Big bang el quásar más distante descubierto hasta la fecha (Imagen ESO). Estas observaciones del quásar brindan una imagen de nuestro universo tal como era durante su infancia, solo 750 millones de años después de producirse la explosión inicial que creó al universo. El análisis del espectro de la luz del quásar no ha aportado evidencias de elementos pesados en la nube gaseosa circundante, un hallazgo que sugiere que el quásar data de una era cercana al nacimiento de las primeras estrellas del universo.

Basándose en numerosos modelos teóricos, la mayoría de los científicos está de acuerdo sobre la secuencia de sucesos que debió acontecer durante el desarrollo inicial del universo: Hace cerca de 14.000 millones de años, una explosión colosal, ahora conocida como el Big Bang, produjo cantidades inmensas de materia y energía, creando un universo que se expandía con suma rapidez. En los primeros minutos después de la explosión, protones y neutrones colisionaron en reacciones de fusión nuclear, formando así hidrógeno y helio.

Finalmente, el universo se enfrió hasta un punto en que la fusión dejó de generar estos elementos básicos, dejando al hidrógeno como el elemento predominante en el universo. En líneas generales, los elementos más pesados que el hidrógeno y el helio, como por ejemplo el carbono y el oxígeno, no se formaron hasta que aparecieron las primeras estrellas. Los astrónomos han intentado identificar el momento en el que nacieron las primeras estrellas, analizando a tal fin la luz de cuerpos muy distantes. (Cuanto más lejos está un objeto en el espacio, más antigua es la imagen que de él recibimos, en luz visible y otras longitudes de onda del espectro electromagnético.) Hasta ahora, los científicos sólo habían podido observar objetos que tienen menos de unos 11.000 millones de años. Todos estos objetos presentan elementos pesados, lo cual sugiere que las estrellas ya eran abundantes, o por lo menos estaban bien establecidas, en ese momento de la historia del universo.

Supernova 1987 A

El Big Bang produjo tres tipos de radiación: electromagnética (fotones), radiación de neutrinos y ondas gravitatorias. Se estima que durante sus primeros 100.000 años de vida, el universo estaba tan caliente y denso que los fotones no podían propagarse; eran creados, dispersados y absorbidos antes de que apenas pudieran recorrer ínfimas distancias. Finalmente, a los cien mil años de edad, el universo se había expandido y enfriado lo suficiente para que los fotones sobrevivieran, y ellos comenzaron su viaje hacia la Tierra que aún no existía. Hoy los podemos ver como un “fondo cósmico de microondas”, que llega de todas las direcciones y llevan gravada en ellos una imagen del universo cuando sólo tenía esa edad de cien mil años.

Se dice que al principio sólo había una sola fuerza, la Gravedad que contenía a las otras tres que más tarde se desgajaron de ella y “caminaron” por sí mismas para hacer de nuestro universo el que ahora conocemos. En Cosmología, la fuerza de gravedad es muy importante, es ella la que mantiene unidos los sistemas planetarios, las estrellas en las galaxias y a las galaxias en los cúmulos. La Gravedad existe a partir de la materia que la genera para curvar el espaciotiempo y dibujar la geometría del universo.

Un agujero negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. es la esencia del agujero negro.

Lo cierto es que los físicos relativistas se han sentido muy frustrados desde que Einstein publicó su Teoría de la relatividad general y se desprendieron de ellas mensajes asombroso como el de la existencia de agujeros negros que predecían sus ecuaciones de campo. Así que, se dirigieron a los astrónomos para que ellos confirmaran o refutaran su existencia mediante la observación del universo profundo. Sin embargo y, a pesar de su enorme esfuerzo, los astrónomos npo han podido obtener medidas cuantitativas de ninguna distorsión espaciotemporal de agujeros negros. Sus grandes triunfos han consistido en varios descubrimientos casi incontrovertibles de la existencia de agujeros negros en el universo, pero han sido incapaces de cartografiar, ni siquiera de forma ruda, esa distorsión espaciotemporal alrededor de los agujeros negros descubiertos. No tenemos la técnica para ello y somos conscientes de lo mucho que nos queda por aprender y descubrir.

Las matemáticas siempre van por delante de esa realidad que incansables buscamos. Ellas nos dicen que en un agujero negro, además de la curvatura y el frenado y ralentización del tiempo, hay un tercewr aspecto en la distorsi´pon espaciotemporal de un agujero negro: un torbellino similar a un enorme tornado de espacio y tiempo que da vueltas y vueltas alrtededor del horizonte del agujero. Así como el torbellino es muy lento lejos del corazón del tornado, también el torbellino. Más cerca del núcleo o del horizonte el torbellino es más rápido y, cuando nos acercamos hacia el centro ese torbellino espaciotemporal es tan rápido e intenso que arrastra a todos los objetos (materia) que ahí se aventuren a estar presentes y, por muy potentes que pudieran ser los motores de una nave espacial… ¡nunca podrían hacerla salir de esa inmensa fuerza que la atraería hacia sí! Su destino sería la singularidad del agujero negro donde la materia comprimida hasta límites inimaginables, no sabemos en qué se habrá podido convertir.

Todos conocemos la teoría de Einstein y lo que nos dice que ocurre cuando grandes masas, como planetas, están presentes: Curvan el espacio que lo circundan en función de la masa. El exponente máximo de dicha curvatura y distorsión temporal es el agujero negro que, comprime la masa hasta hacerla “desaparecer” y el tiempo, en la singularidad formada, deja de existir. En ese punto, la relatividad general deja de ser válida y tenemos que acudir a la mecánica cuántica para seguir comprendiendo lo que allí está pasando.

Einstein no se preocupaba por la existencia de este extraño universo dentro del agujero negro porque la comunicación con él era imposible. Cualquier aparato o sonda enviada al centro de un agujero negro encontraría una curvatura infinita; es decir, el campo gravitatorio sería infinito y, como ya se explica anteriormente, nada puede salir de un agujero negro, con lo cual, el mensaje nunca llegará al exterior. Allí dentro, cualquier objeto material sería literalmente pulverizado, los electrones serían separados de los átomos, e incluso los protones y los neutrones dentro de los propios núcleos serían desgajados. De todas las maneras tenemos que reconocer que este universo especular es matemáticamente necesario para poder ir comprendiendo cómo es, en realidad, nuestro universo.

Con todo esto, nunca hemos dejado de fantasear. Ahí tenemos el famoso puente de Einstein-Rosen que conecta dos universos y que fue considerado un artificio matemático. De todo esto se ha escrito hasta la extenuación:

“Pero la factibilidad de poder trasladarse de un punto a otro del Universo recurriendo a la ayuda de un agujero de gusano es tan sólo el principio de las posibilidades. Otra posibilidad sería la de poder viajar al pasado o de poder viajar al futuro. Con un túnel conectando dos regiones diferentes del espacio-tiempo, conectando el “pasado” con el “futuro”, un habitante del “futuro” podría trasladarse sin problema alguno hacia el “pasado” Einstein—Rosen—Podolsky), para poder estar físicamente presente en dicho pasado con la capacidad de alterar lo que está ocurriendo en el “ahora”. Y un habitante del “pasado” podría trasladarse hacia el “futuro” para conocer a su descendencia mil generaciones después, si la hubo.“

El puente de Einstein-Rosen conecta universos diferentes. Einstein creía que cualquier cohete que entrara en el puente sería aplastado, haciendo así imposible la comunicación Posteriormente, los puentes de Einstein-Rosen se encontraron pronto en otras soluciones de las ecuaciones gravitatorias, tales como la solución de Reisner-Nordstrom que describe un agujero eléctricamente cargado. Sin embargo, el puente de Einstein-Rosen siguió siendo una nota a pie de página curiosa pero olvidada en el saber de la relatividad.

Lo cierto es que algunas veces, tengo la sensación de que aún no hemos llegado a comprender esa fuerza misteriosa que es la Gravedad, la que no se quiere juntar con las otras tres fuerzas de la Naturaleza. Ella campa solitaria y aunque es la más débil de las cuatro, esa debidad resulta engañosa poreque llega a todas partes y, además, como algunos de los antiguos filósofos naturales, algunos piensan que es la única fuerza del universo y, de ella, se desgajaron las otras tres cuando el Universo comenzó a enfriarse.

¡El Universo! Es todo lo que existe y es mucho para que nosotros, unos recien llegados, podamos llegar a comprenderlo en toda su inmensidad. Muchos son los secretos que esconde y, como siempre digo, son muchas más las preguntas que las respuestas. Sin embargo, estamos en el camino y… Como dijo el sabio: ¡Todos los grandes viajes comenzaron con un primer paso!

En el Universo todo es fruto de dos fuerzas contrapuestas:

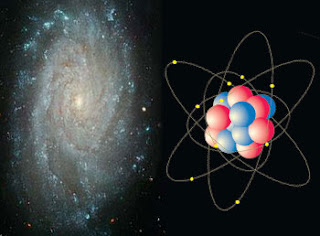

Por ejemplo, las estrellas son estables por el hecho de que, la energía de fusión tiende a expandir la estrella y, la fuerza de Gravedad generada por su ingente masa, la hace contraerse. De esa manera, las dos fuerzas se contrarrestan y consiguen estabilizar a la estrella que vive miles de años. Cuando se agota el combustible nuclear de fusión, la estrella queda a merced de la Gravedad y se contrae (implosiona) bajo el peso de su propia masa, la gravedad la aplasta más y más hasta convertirla en una estrella de neutrones y un agujero negro si es una estrlla masiva.

En el átomo, el equilibrio se alcanza como consecuencia de que, los protones (los nucleones que forman el núcleo), están cargados positivamente, y, los electrones que orbitan a su alrededor, están cargadas eléctricamente con cargas negativas equivalentes, con lo cual, el equilibrio queda servido y se alcanza la establidad.

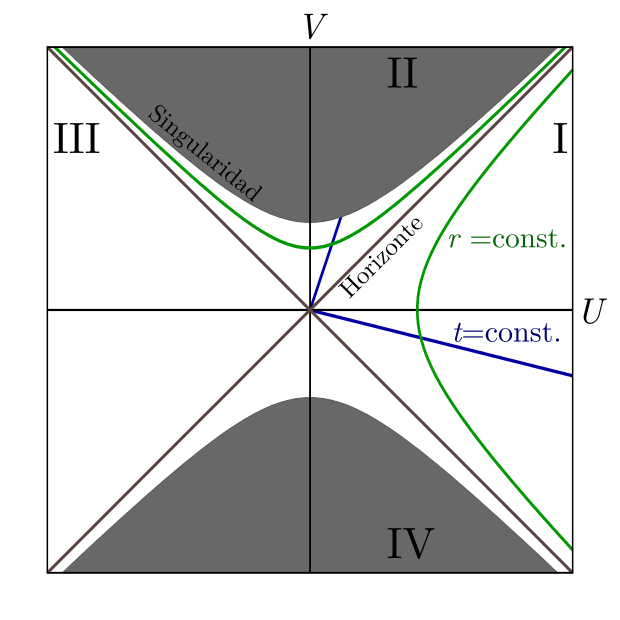

Diagrama de Kruskal-Szekeres para un agujero negro. Las rectas azules son superficies de tiempo constante. Las curvas verdes son superficies de radio constante. -Las regiones I y II (sólo la parte blanca) son el exterior y el interior de un agujero negro. -La región III es una región exterior al agujero negro “paralela”. -La región IV (sólo la parte blanca) es un agujero blanco. Las zonas grises adyacentes a las regiones II y IV son las singularidades.

El agujero Blñanco, al contrario del Agujero negro, en lugar de engullir materia la expulsaria

El agujero negro de Schwarzschild es descrito como una singularidad en la cual una geodésica puede sólo ingresar, tal tipo de agujero negro incluye dos tipos de horizonte: un horizonte “futuro” (es decir, una región de la cual no se puede salir una vez que se ha ingresado en ella, y en la cual el tiempo -con el espacio- son curvados hacia el futuro), y un horizonte “pasado”, el horizonte pasado tiene por definición la de una región donde es imposible la estancia y de la cual sólo se puede salir; el horizonte futuro entonces ya correspondería a un agujero blanco.

Así, nos encontramos con el hecho cierto de que, en el Universo, todo es equilibrio y estabilidad: el resultado de dos fuerzas contrapuestas.

Veamos otro ejemplo:

Curvas de potencial en un sistema de dos cuerpos (aquí el Sol y la Tierra), mostrando los cinco puntos de Lagrange. Las flechas indican pendientes alrededor de los puntos L –acercándose o alejándose de ellos. Contra la intuición, los puntos L4 y L5son máximos.

Los puntos de Lagrange, también denominados puntos L o puntos de libración, son las cinco posiciones en un sistema orbital donde un objeto pequeño, sólo afectado por la gravedad, puede estar teóricamente estacionario respecto a dos objetos más grandes, como es el caso de un satélite artificial con respecto a la Tierra y la Luna. Los puntos de Lagrange marcan las posiciones donde la atracción gravitatoria combinada de las dos masas grandes proporciona la fuerza centrípeta necesaria para rotar sincrónicamente con la menor de ellas. Son análogos a las órbitas geosincrónicas que permiten a un objeto estar en una posición «fija» en el espacio en lugar de en una órbita en que su posición relativa cambia continuamente. Una definición más precisa pero técnica es que los puntos de Lagrange son las soluciones estacionarias del problema de los tres cuerpos.

Diagrama del sistema Sol-Tierra, que muestra el punto L2, más alejado que la órbita lunar.

El telescopio que vendrá a suplir al viejo Hubble. Un dato curioso sobre este telescopio es que no estará situado en la órbita terrestre, se situará en el punto de Lagranje L2. Los puntos de Lagrange son las posiciones donde la gravedad del Sol y la Tierra se equilibran, de manera que un objeto puede permanecer estable, sin salir despedido hacia el espacio profundo. El James Webb se ha situado en esta posición es para aislarlo de la contaminación que existe en la órbita terrestre.

El James Webb Space Telescope o JWST durante mucho tiempo ha sido promocionado como el reemplazo para el telescopio espacial Hubble. El telescopio está considerado como uno de los proyectos más ambiciosos de la ciencia espacial emprendido. A pesar del enorme desafío, el telescopio se está acercando a la terminación. El telescopio ha servido como un aula técnico sobre las complejidades involucrada con un proyecto tan complejo. También ha servido para desarrollar nuevas tecnologías que son utilizadas por los ciudadanos promedio en sus vidas cotidianas.

En nuestro Universo todo resulta ser el equilibrio de dos fuerzas contrapuestas que se igualan y se equilibran para alcanzar la estabilidad que es requerida para que todo exista en ese nivel de normalidad que hace de nuestro universo el que podemos observar y, los fenómenos que se producen, los cambios, siempre van encaminados a eso, a conseguir ese equilibrio que observamos.

Fuerzas positivas y negaticas hacen que el núcleo de los átomos sea estable y las galaxias están sujetas por la Gravedad que mantiene las estrellas juntas y que no dejan que la expansión las pueda deshacer. El el níucleo de los átomos están los protones cargados con fuerzas positivas que atraen el mismo número de electrones que orbitan a su alrededor, y, al estar cargados con fuerzas negativas que se equilibran con las de los protones, el átomo es muy estable.

Cuando hablamos de equilibrio lo estamos haciendo del estado en el que un sistema tiene su energía distribuida de la manera estadísticamente más probable, un estado del sistema en el que las fuerzas, influencia, reacciones, etc., se compensan las unas a las otras de manera que no se permiten cambios y prevalece la estabilidad.

Equilibrio estático en tres dimensiones

Un cuerpo se encuentra en equilibrio estático si las resultantes de todas las fuerzas y todos los pares que actúan en él son ambas cero; se si halla en reposo, estará ciertamente no acelerado. Un cuerpo de ese tipo en el reposo se encuentra en equilibrio estable si después de un ligero desplazamiento vuelve a su posición original. Existen diversas variantes que no merece la pena mencionar aquí para no hacer aburrido el trabajo.

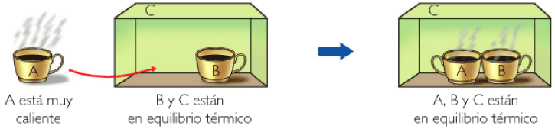

También existe el equilibrio térmico y se dice que un cuerpo está en equilibrio térmico si no hay ningún intercambio de calor dentro de él o entre e´y sus alrededores. Un sistema se encuentra en equilibrio térmico cuando cuando una reacción y su inversa está teniendo lugar a la misma velocidad. Estos son ejemplos de equilibrios dinámicos, en los que la actividad en un sentido está compensada por la actividad en el sentido inverso. De nuevo el equilibrio o estabilidad creado por fuerzas contrapuestas.

La energía se equipara segín una teoría de propuesta por Ludwig Boltzmann y fundamentada teóricamente por James Clerk Maxwell, en virtud de la cual la energía de las moléculas de un gas en una muestra grande en equilibrio tçermico está dividida por igual entre todos los grados de libertad disponibles, siendo la energía media de cada grado de libertad kT/2, donde k es la constante de Boltzmann y T es la temperatura termodinámica. La proposición no es en general cierta si los efectos cuánticos son importantes, pero frecuentemente es una buena aproximación.

El cuadro nos muestra una Ilustración de los distintos tipos de simetría en las formas orgánicas (Field Museum, Chicago).

Claro que si hablamos de simetrías, nos podríamos perder un un laberinto de clases y formas: esférica, cilíndrica, reflectiva, traslacional, helicoidal, de rotación, de ampliación, bilateral, radial… (muchas otras). Pero si nos referimos de manera simple a lo que es o entendemos por una simetria, nos estaremos refiriendo al conjunto de invariancias de un sistema.

Al aplicar una transformación de simetría sobre un sistema, el sistema queda inalterado. La simetría es estudiada matemáticamente usando teoría de grupos. Algunas de las simetrías son directamente físicas. Algunos ejemplos son las reflexiones y rotaciones de las moléculas y las transformaciones de las redes cristalinas.

Las dos fuerzas contrapuestas en los seres vivos inteligentes de nuestro mundo, está precisamente en nosotros mismos: El hombre y la Mujer, juntos, forman un sólo ente de equilibrio perfecto que nos lleva al más alto nivel de simetría y belleza, y, tal equilibrio y conjunción, hace posible el milagro de la replicación.

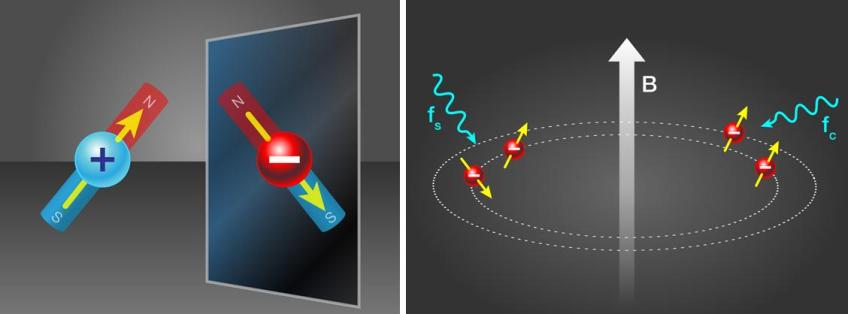

“La Trampa de Antihidrógeno (ATRAP) es un pequeño experimento en el CERN cuyo objetivo es comparar la antimateria con la materia, en concreto, átomos de antihidrógeno (formados por un antiprotón y un positrón, o antielectrón) con átomos de hidrógeno (formados por un protón y un electrón). Acaban de publicar la medida más precisa del momento magnético del antiprotón, 2,792847356(23) veces el magnetón nuclear, que coincide con el del protón en al mentos cinco partes por millón (0,0005%), una nueva medida (directa) de la invarianza CPT” (Francis (th)E mule Science’s News).

Existen simetrías más generales y abstractas como la invariancia CPT y las simetrías asociadas a las teorías gauge (tendríamos que mirar en simetrías rotas y supersimetría para ampliar el concepto en su más amplio espectro y concepción de lo que la simetría es. En el Universo, las simetrías están por todas partes: Estrellas, mundos, galaxias…

emilio silvera

Totales: 75.596.419

Totales: 75.596.419 Conectados: 50

Conectados: 50