Feb

6

La verdadera Historia de la Teoría del Caos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Caos y Complejidad ~

Clasificado en Caos y Complejidad ~

Comments (3)

Comments (3)

Quizás sea la mejor muestra de complejidad que existe en el Universo

“Es la peor noticia posible para aquellos que esperan avances importantes en la cumbre climática que se celebró en Copenhague. Uno de los científicos más destacados de la teoría del cambio climático, Phil Jones, se veía obligado a presentar su dimisión temporal como director de la Unidad de Investigación Climática de la Universidad de East Anglia, en Norwich, Inglaterra, tras ser acusado de manipular datos sobre los efectos del cambio climático para exagerar su impacto.”

¿Qué iría buscando con tal comportamiento? Cuando se hacen cosas así, dichos comportamientos están aconsejados por intereses particulares que no siempre se pueden confesar. No está bien manipular datos para que el gran público tenga una idea iquivocada de la verdadera situación de las cosas.

¿Os acordáis de aquella vez que Mark Twain tuvo que decir:

“Las noticias sobre mi muerte han sido exageradas”.

Bueno, pues hasta ahí llegan para vender.

Los Medios de Comunicación, no siempre son fieles “comunicadores” y, para realzar las noticias, las expresan con un grado extra de exaltación, o, licencia poética que, distorsiona la realidad de lo que realmente deberían comunicar, y, no pocas veces, tal hecho se debe a que (sobre todo en noticias relativas a cuestiones científicas) no se elige a la persona debidamente preparada y adecuada a la noticia que se quiere ofrecer al público. Si la noticia se ha dado de manera equívoca, el científico redactor debe enmendar lo que se dijo con miras a llamar la atención o conseguir alguna subvención.

“Desde la década de los 80 el Síndrome de Inmunodeficiencia Humana (SIDA) se ha considerado una de las peores enfermedades de nuestra época, para la que, según se creía hasta hace poco, parecía no existir cura.

Desde hace bien poco tiempo, sin embargo, se han dado a conocer ciertos hallazgos que podrían acabar por fin con este mal. Primero fue el caso de un niño en Estados Unidos a quien por el tratamiento médico recibido fue posible erradicar todo rastro posiblemente peligroso de VIH con el que había nacido. Después el Instituto Pasteur de París anunció que 14 adultos habían logrado controlar la acción del virus.”

Así, de manera comedida y reflejando la realidad es como deben darse siempre las noticias sin levantar espectativas falsas en uno u otro sentido.

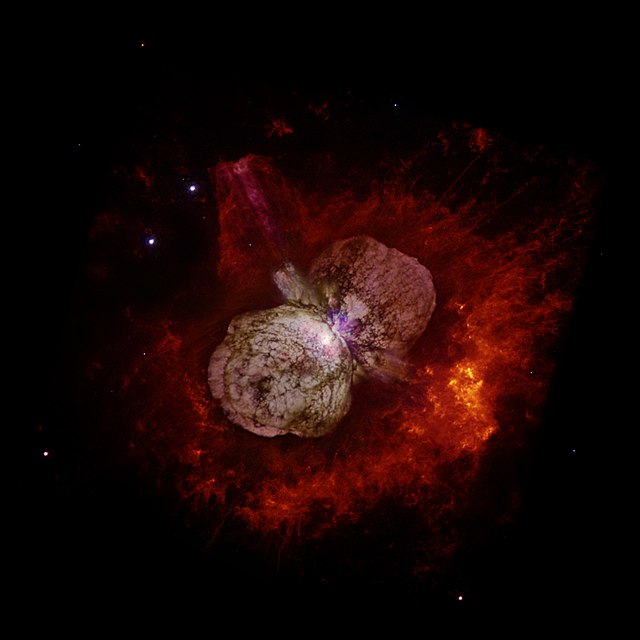

Betelgeuse que es una supergigante roja, sólo tiene 20 veces la masa del Sol y su tamaño 600 veces mayor

Escribo esto a partir de un artículo leído en la prensa diaria que, tratando de hablar de exóticos objetos que existen en el Universo, llegan a hablarnos de estrellas masivas con 600 veces la masa del Sol, y, tal barbaridad, nos lleva a pensar que, para hacer un reportaje o comentario de estos temas, los diferentes medios, deberían acudir a personas versadas en lo que están tratando, y, de esa manera, además de quedar mucho mejor, evitarían el ridículo de publicar las cosas alejadas de la realidad. La masa máxima que se considera para una estrella viene a ser de 120 masas solares, ya que, cuando su masa es mayor, la propia radiación la destruye. Pueden existir algunas estrellas que sobrepasen ese límite de las 120 masas solares pero, están continuamente eyectando material al espacio para descongestionarse y no explotar.

Eta Carinae es una estrella que posiblemente pueda tener más de 120 masas solares pero, como podéis contemplar en la imagen, está envuelta en una Nebulosa que ella misma ha generado al estar, continuamente eyectando material al espacio y evitar así su propia muerte.

Buscando en mi documentación, un buen ejemplo de lo que digo, por suerte, me encuentro con un artículo escrito por Don Carlos Miguel Madrid Casado del Departamento de Lógica y Filosofía de la Ciencia en la Facultad de Filosofía de la Universidad Complutense de Madrid, dónde nos deja un claro ejemplo de lo que no debiera ser. Aquí os lo dejo.

“Edward Lorenz (1917-2008): ¿Padre de la Teoría del Caos?

El miércoles de 16 de abril de 2008, a los 90 años de edad, moría Edward Norton Lorenz. Los periódicos de medio mundo pronto se hicieron eco de la noticia. Todos los obituarios recogieron que había muerto “el Padre de la Teoría del Caos”. Lorenz, escribían, fue el primero en reconocer el comportamiento caótico de ciertos sistemas dinámicos, como el atmosférico. El estudio de este comportamiento altamente inestable y errático le condujo, continuaban, a formular una de las principales características de lo que hoy se llama “caos determinista”: la dependencia sensible a las condiciones iniciales, popularmente conocida como “efecto mariposa”. Lorenz, concluían, fue el artífice de la tercera revolución científica del siglo XX, después de la Teoría de la Relatividad y la Mecánica Cuántica.

Una de la mayores carácterísticas de un Sistema inestable es que tiene una gran dependencia de las condiciones iniciales. De un sistema del que se conocen sus ecuaciones características, y con unas condiciones iniciales fijas, se puede conocer exactamente su evolución en el tiempo. Pero en el caso de los sistemas caóticos, una mínima diferencia en esas condiciones hace que el sistema evolucione de manera totalmente distinta e impredecible.

Las condiciones iniciales de un sistema implican que las condiciones finales sean tal como, de manera inevitable serán. Es decir, su condición inicial nos dice cuál será su condición final. Desde su nacimiento nos está diciendo como será su “muerte”.

De todo sistema del que se conocen sus ecuaciones características, y con unas condiciones iniciales fijas, se puede conocer exactamente su evolución en el tiempo. Pero en el caso de los sistemas caóticos, una mínima diferencia en esas condiciones hace que el sistema evolucione de manera totalmente distint

Pero, veamos, ¿ha sido realmente Edward Lorenz el “creador” de la Teoría del Caos? ¿O acaso su papel de estrella protagonista se debe más bien a una inusitada alianza entre mérito y fortuna? El propósito de esta nota es ofrecer una panorámica de la Historia de la Teoría del Caos que complique su nacimiento y enriquezca su evolución, sacando a la luz la figura de ciertos científicos que el gran talento de Lorenz ha ensombrecido y ocultado.Comenzamos nuestra panorámica retrocediendo hasta los tiempos de la Revolución Científica. El intento por comprender las trayectorias planetarias observadas por Kepler condujo a Newton a modelarlas matemáticamente, siguiendo la estela de Galileo. Newton formuló sus leyes de una forma matemática que relacionaba entre sí las magnitudes físicas y sus ritmos de cambio. Las leyes físicas quedaron expresadas como ecuaciones diferenciales. Estudiar un fenómeno físico y hallar las ecuaciones diferenciales que las gobernaban eran las dos caras de la misma moneda.

Desde el siglo XVII, toda la naturaleza –sólidos, fluidos, sonido, calor, luz, electricidad- fue modelada mediante ecuaciones diferenciales. Ahora bien, una cosa era dar con las ecuaciones del fenómeno en cuestión y otra, bien distinta, resolverlas. La teoría de las ecuaciones diferenciales lineales fue desarrollada por completo en poco tiempo. No así la teoría gemela, la teoría de las ecuaciones diferenciales no lineales.

Uno de los problemas no lineales que trajo de cabeza a físicos y matemáticos fue el problema de los n cuerpos de la Mecánica Celeste: dados n cuerpos de distintas masas bajo atracción gravitacional mutua, se trataba de determinar el movimiento de cada uno de ellos en el espacio. Newton resolvió geométricamente el problema de los dos cuerpos en los Principia. Posteriormente, Bernoulli y Euler lo resolvieron analíticamente con todo detalle. Sin embargo, no ocurrió así con el problema de los tres cuerpos. Newton sabia que, cuando un tercer cuerpo entraba en escena, el problema no era fácilmente resoluble, y que esto traía serias consecuencias para la cuestión de la estabilidad del Sistema Solar (que, a fin de cuentas, en la época, pasaba por ser un sistema de siete cuerpos). Aunque débiles en comparación con la fuerza de atracción del Sol, las fuerzas gravitatorias entre los planetas no eran ni mucho menos despreciables, por cuanto a la larga podían desviar algún planeta de su órbita e incluso, en el límite, expulsarlo fuera del Sistema Solar.

El matemático suizo Leonhard Euler

Las fuerzas interplanetarias podían estropear las bellas elipses keplerianas, sin que fuera posible predecir el comportamiento del Sistema Solar en un futuro lejano. En Motu corporum in gyrum, Newton afirmaba que los planetas no se mueven exactamente en elipses ni recorren dos veces la misma órbita, y reconocía que definir estos movimientos para todo futuro excedía con mucho la fuerza entera del intelecto humano. Si el Sistema Solar se iba desajustando, era necesaria una solución drástica: la Mano de Dios tenía que reconducir cada planeta a su elipse, reestableciendo la armonía. Este Deus ex machina newtoniano provocó, como es bien sabido, la ira de Leibniz, para quien Dios no podía ser un relojero tan torpe.

Tiempo después, Laplace creyó explicar las anomalías orbitales que preocuparon a Newton como meras perturbaciones que sólo dependían de la Ley de Gravitación y tendían a compensarse en el transcurso del tiempo. Así, al presentar su Mecánica Celeste a Napoleón, exclamó que Dios no era una hipótesis necesaria en su sistema del mundo. Sin embargo, en sus ecuaciones del sistema Sol-Júpiter-Saturno (problema de los tres cuerpos), Laplace despreció un término matemático que creía muy pequeño pero que, en contra de lo por él supuesto, podía crecer rápidamente y sin límite, hasta desestabilizar el Sistema Solar.

Muchos físicos y matemáticos decimonónicos dedicaron sus esfuerzos a dar una respuesta completa al problema de los tres cuerpos y a la cuestión de la estabilidad del Sistema Solar. Entre ellos, uno de los personajes clave en la configuración de la Teoría del Caos: Henri Poincaré.

Henri Poincaré

En 1855, los matemáticos europeos tuvieron noticia de que un importante concurso internacional iba a ser convocado bajo el auspicio de Oscar II, rey de Suecia y Noruega, para celebrar su sesenta aniversario en el trono. Se ofrecía un sustancioso premio al matemático capaz de resolver el problema de los tres cuerpos y, de este modo, avanzar en el estudio de la estabilidad del Sistema Solar. Alentado por la competencia, Poincaré procedió a sintetizar muchas de sus ideas acerca del estudio cualitativo o topológico de las ecuaciones diferenciales no lineales. El Jurado declaró ganador a Poincaré por una compleja resolución del problema restringido de los tres cuerpos, en que un planeta ligero se mueve bajo la atracción gravitatoria de dos estrellas iguales que giran una alrededor de la otra describiendo dos elipses confinadas en un mismo plano. Sin embargo, el artículo de Poincaré contenía un error y una tirada completa de la prestigiosa revista Acta Mathemática hubo de ser destruida.

A toda prisa, Poincaré revisó su trabajo y descubrió que, en verdad, no podía probarse la estabilidad del sistema, porque su dinámica no seguía pauta regular alguna. Su revisión del problema contiene una de las primeras descripciones del comportamiento caótico en un sistema dinámico. Poincaré fue, desde luego, el abuelo de la Teoría del Caos. Además, a partir de entonces, Poincaré contribuyó como pocos, a popularizar la idea de que existen sistemas deterministas cuya predicción a largo plazo resulta imposible. En Ciencia y Método, escribía: “Puede suceder que pequeñas diferencias en las condiciones iniciales produzcan algunas muy grandes en los estados finales. Un pequeño error al inicio engendrará un enorme error al final. La predicción se vuelve imposible”.

Otros también trataron el tema y profundizaron en los secretos de la Naturaleza

¡Caramba! Medio siglo antes que Lorenz, Poincaré se había topado con… ¡el efecto mariposa! Aún más: el genial matemático francés señaló que el tiempo meteorológico hacía gala de esta clase de inestabilidad y apuntó qué dificultades se derivarían para la predicción meteorológica. En su labor divulgadora no estuvo solo: su compatriota Pierre Duhem difundió las investigaciones de Poincaré y, también, de Jacques Hadamard, quien fue pionero en demostrar matemáticamente que, para cierto sistema dinámico hoy conocido como el Billar de Hadamard, un pequeño cambio en las condiciones iniciales provoca un notable cambio en la posterior evolución del sistema.

Durante el primer cuarto del siglo XX, la influencia de Poincaré no desapareció y se dejó notar en los trabajos de George David Birkhoff a propósito de las características cualitativas y topológicas de los sistemas dinámicos. Tampoco puede olvidarse el papel de Stephen Smale, que ganaría la Medalla Fields –el Premio Nobel de los matemáticos- en 1966 por sus contribuciones a la Teoría de los Sistemas Dinámicos. Mediado el siglo XX, este topólogo continuó la senda trazada por Poincaré t Birkhoff, y descubrió la Herradura de Smale, que pasa por ser el mecanismo topológico que da lugar al caos (efecto mezcla).

George David Birkhoff

Simultáneamente, cruzando el telón de acero, existía otra fértil tradición: la Escuela Rusa. En la U. R. S. S., los físicos y matemáticos habían heredado de Alexander Liapunov sus influyentes nociones acerca de la estabilidad del movimiento de los sistemas dinámicos. Si Poincaré se había ocupado de la teoría de la estabilidad desde una perspectiva cualitativa, Liapunov lo hizo cuantitativamente (exponentes de Liapunov). Recogiendo el testigo de ambos, Kolmogorov y Arnold se concentraron en el estudio de la estabilidad de los sistemas dinámicos de la Dinámica Celeste. Durante la guerra fría, los principales resultados de los matemáticos soviéticos fueron traducidos al inglés y dados a conocer al resto de matemáticos, europeos y norteamericanos, gracias al providencial trabajo de Solomon Lefschetz.

Y en éstas, apareció Lorenz… En 1963, este matemático y meteorólogo, antiguo alumno de Birkhoff en Harvard, estaba trabajando en el pronóstico del tiempo en el MIT. Estudiando la convección en la atmósfera, Lorenz planteó un modelo matemático formado por tres ecuaciones diferenciales ordinarias para describir el movimiento de un fluido bajo la acción de un gradiente térmico. Mientras buscaba soluciones numéricas con la ayuda de una computadora, se encontró –al volver de tomar una taza de café- con que se producía un dramático comportamiento inestable, caótico. Lorenz se había topado por casualidad con el fenómeno de la sensibilidad a las condiciones iniciales, que hacía de su sistema algo en la práctica impredecible. En efecto, tras establecer las propiedades básicas del flujo, Lorenz reparó en que una pequeña variación en las condiciones iniciales ocasionaba estados finales completamente diferentes. Lorenz había descubierto, tomando prestada la indeleble metáfora que forjaría más tarde, el efecto mariposa: el aleteo de una mariposa en Brasil puede ocasionar un tornado en Texas. Ahora bien, sería el matemático norteamericano Guckenheimer el que, allá por los años 70, acuñara la expresión “dependencia sensible a las condiciones iniciales”.

Lorenz publicó su hallazgo en una revista de meteorología, en un artículo titulado Deterministic Nonperiodic Flow, en que citaba expresamente a Poincaré y Birkhoff (aunque desconocía las ideas del primero sobre predicciones meteorológicas), pero que pasó prácticamente desapercibido. Sólo Stephen Smale y James Jorke –el introductor del término caos en la literatura científica- reconocieron las repercusiones filosóficas de la investigación de Lorenz y la dieron a conocer. Si Edward Lorenz ofreció a la comunidad científica el paradigma de sistema dinámico caótico continuo, el zoólogo Robert May dio a conocer en su artículo Simple Mathematical Models with Complicated Dynamics el paradigma del sistema dinámico caótico discreto: la aplicación logística.

A finales de los 70 y principios de los 80, la exploración de aplicaciones de la Teoría del Caos comenzó a dar sus frutos más allá de las simulaciones en las pantallas de ordenador. Entre los fenómenos físicos estudiados destaca, sin duda, la transición a la turbulencia en los fluidos, cuyo estudio contaba con el precedente que suponía el artículo On the nature of turbulence de David Ruelle y Floris Takens, quiénes introdujeron la noción de atractor extraño. Paralelamente, el físico Mitchell Feigenbaum descubrió heurísticamente ciertas constantes universales que caracterizan la transición del movimiento periódico al movimiento caótico, dando inicio a una de las ramas más prometedoras de la Teoría del Caos a día de hoy: la Teoría de la Bifurcación.

En resumidas cuentas, a comienzos del siglo XXI, la Teoría del Caos se nos aparece como la ciencia fisicomatemática que estudia el comportamiento aperiódico e inestable en sistemas deterministas no lineales. Mientras que la revolución relativista fue, prácticamente, fruto de un único hombre (Albert Einstein), y la revolución cuántica lo fue de apenas un puñado (Planck, Bhor, Heisenberg, Schrödinger, Dirac), la revolución del caos determinista es, en cambio, obra de múltiples. La Teoría del Caos es hija tanto de matemáticos (Poincaré, Hadamard, Birkhoff, Smale, Yorke…) como de físicos, biólogos y otros tantos científicos de campos dispares (Lorenz, May, Feigenbaum…). Atribuir su paternidad únicamente a un hombre, aun cuando sea Lorenz, es una simplificación excesiva. Lorenz fue, por así decirlo uno de los muchos padres.”

Hasta aquí el artículo que el Señor Madrid Casado escribió y fue publicado en el número 3 del volumen 22 de la Revista Española de Física en 2008. (salvo algunas imágenes y apuntes propios, en esencia, el artículo es del Señor Madrid Casado).

El trabajo está bien y nos introduce en la historia de la Teoría del Caos desde sus raíces, y, lo único en lo que podemos disentir del autor es, en el hecho cierto de que, Einstein, autor de la relatividad, también se apoyó en muchos (Mach, Maxwell, Lorentz, -en la primera parte, y, sobre todo en Riemann, en la segunda), aunque eso no le quita ni una pizca del mérito que tiene como científico que supo aunar muchos conocimientos dispersos, unirlos en una sola entidad y hacer ver al mundo lo que allí había. Y, por otra parte, al hablar de la Mecánica Cuántica, excluye a Einstein que, en verdad (aunque la combatió) fue uno de sus padres en aquellos primeros momentos, su trabajo sobre el Efecto Fotoeléctrico (que le dio el Nobel de Física) así lo demuestra. Por otra parte, no habría estado de más y de pasada, comentar que Poincaré fue el autor de la “Conjetura” que lleva su nombre y que ha estado ahí 100 años sin que nadie la resolviera hasta que llegó, un matemático extraño, llamado Perelman (ruso) que sin tener el premio que ofrecían al ganador, puso en Internet la solución. Este personaje, no acudió a la cita en Madrid, donde se celebraba el Año Internacional de las Matemáticas y el rey le entregaría la Medalla Field. Todos se quedaron esperando y él, que vicía con su madre en un apartamento de 65 m2, estaba con su cestita al brazo cogiendo setas en el campo.

De todo esto podemos obtener la consecuencia de que, todo tiene otra historia detrás, y, si profundizamos, la podemos descubrir para conocer de manera completa y precisa, el transcurso de los hechos y los personajes que en ellos tomaron parte.

emilio silvera

Feb

6

El Principio antrópico, el gato de Schrödinger: Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

El físico Alan Harvey Guth dijo francamente:

“El principio antrópico es algo que la gente propone si no pueden pensar en algo mejor que hacer.”

Para Richard Feynman, el objetivo de un físico teórico es “demostrarse a sí mismo que está equivocado en cuanto sea posible”. Sin embargo, el principio antrópico es estéril y no puede ser refutado. Weinberg dijo: “aunque la ciencia es claramente imposible sin científicos, no está claro que el universo sea imposible sin ciencia.

En cosmología el principio antrópico establece que cualquier teoría válida sobre el universo tiene que ser consistente con la existencia del ser humano.

El debate sobre el principio antrópico (y por consiguiente sobre Dios) estuvo en letargo durante muchos años, aunque fue reactivado recientemente por la función de onda del universo de Hawking. Si Hawking está en lo cierto, entonces existen en realidad un número infinito de universos paralelos, muchos de ellos con diferentes constantes físicas. En algunos de ellos, quizá los protones se desintegran con demasiada rapidez, o las estrellas no pueden fabricar los elementos pesados por encima del hierro, o el Big Crunch tiene lugar demasiado deprisa porque su densidad crítica sobrepasa en mucho a la ideal y no da tiempo a que pueda comenzar la germinación de la vida, y así sucesivamente. De hecho, un número infinito de estos universos paralelos están muertos, sin las leyes físicas que puedan hacer posible la vida tal como la conocemos.

Hace tiempo ya que muchos piensan en la existencia de universos paralelos. Muchas estrellas y galaxias, muchos mundos, y, también, muchos universos. Claro que, es tan grande el nuestro que sería impensable poder salir de él para visitar otros universos vecinos, cuando la realidad es que, ni podemos visitar las galaxias más cercanos o los mundos que nos rodean en el propio Sistema solar. ¡Qué atrasados estamos todavía!

En tal universo paralelo (el nuestro), las leyes de la física eran compatibles con la vida que conocemos. La prueba es que nosotros estamos aquí para tratar esta cuestión. Si esto es cierto, entonces quizá no haya que invocar a Dios para explicar por qué la vida, por preciosa que sea, es posible en nuestro universo. Sin embargo, esto reabre la posibilidad del principio antrópico débil, es decir, que coexistimos con nuestros universos muertos y que el nuestro sea el único compatible para vida.

La segunda controversia estimulada por la función de onda del universo de Hawking es mucho más profunda y, de hecho, aun está sin resolver. Se denomina el Gato de Schrödinger.

La teoría cuántica, recordémoslo, afirma que para todo objeto existe una función de onda que mide la probabilidad de encontrar dicho objeto en un cierto punto del espacio y del tiempo. La teoría cuántica afirma también que nunca se conoce realmente el estado de una partícula hasta que se haya hecho una observación. Antes de que haya una medida, la partícula puede estar en uno de entre una diversidad de estados, descritos por la función de onda de Schrödinger. Por consiguiente, antes de que pueda hacerse una observación o medida, no se puede conocer realmente el estado de la partícula. De hecho, la partícula existe en un estado ultramundano, una suma de todos los estados posibles, hasta que se hace una medida.

Cuando esta idea fue propuesta por primera vez por Niels Bohr y Werner Heisemberg, Einstein se revolvió contra ella. “¿Existe la luna sólo porque la mira un ratón?”, le gustaba preguntar. Según la teoría cuántica, en su más estricta interpretación, la Luna, antes de que sea observada, no existe realmente tal como la conocemos. “La Luna puede estar, de hecho, en uno cualquiera de entre un número infinito de estados, incluyendo el estado de estar en el cielo, de estar explotando, o de no estar allí en absoluto. Es el proceso de medida que consiste en mirarla el que decide que la Luna está girando realmente alrededor de la Tierra”. Decía Einstein con ironía.

De la resolución de la ecuación de onda de Schrödinger se obtiene una serie de funciones de onda (ó probabilidades de distribución de los electrones) para los diferentes niveles energéticos que se denominan orbitales atómicos.

Edwin Schrödinger, autor de la ecuación con su función de onda, se disgustó con estas interpretaciones de su ecuación. Para demostrar lo absurdo de la situación creada, Schrödinger colocó un gato imaginario en una caja cerrada. El gato estaba frente a una pistola, que está conectada a un contador Geiger, que a su vez está conectado a un fragmento de uranio. El átomo de uranio es inestable y sufrirá una desintegración radiactiva. Si se desintegra un núcleo de uranio, será detectado por el contador Geiger que entonces disparará la pistola, cuya bala matará al gato.

Para decidir si el gato está vivo o muerto, debemos abrir la caja y observar al gato. Sin embargo, ¿cuál es el estado del gato antes de que abramos la caja? Según la teoría cuántica, sólo podemos afirmar que el gato esta descrito por una función de onda que describe la suma de un gato muerto y un gato vivo.

Para Schrödinger, la idea de pensar en gatos que no están ni muertos ni vivos era el colmo del absurdo, pero la confirmación experimental de la mecánica cuántica nos lleva inevitablemente a esta conclusión. Hasta el momento, todos los experimentos han verificado, favorablemente, la teoría cuántica.

La paradoja del gato de Schrödinger es tan extraña que uno recuerda a menudo la reacción de Alicia al ver desaparecer el gato de Cheshire en el centro del cuento de Lewis Carroll: “Allí me verás”, dijo el Gato, y desapareció, lo que no sorprendió a Alicia que ya estaba acostumbrada a observar cosas extrañas en aquel lugar fantástico. Igualmente, los físicos durante años se han acostumbrados a ver cosas “extrañas” en la mecánica cuántica.

Existen varias maneras de abordar esta dificultad de lo incomprensible en mecánica cuántica. En primer lugar, podemos suponer que Dios existe. Puesto que todas las “observaciones” implican un observador, entonces debe haber alguna “conciencia” en el universo. Algunos físicos como el premio Nobel Eugene Wigner, han insistido en que la teoría cuántica prueba la existencia de algún tipo de conciencia cósmica universal.

La segunda forma de tratar la paradoja es la preferida por la gran mayoría de los físicos en activo: ignorar el problema.

El físico Richard Feynman dijo en cierta ocasión:

“Creo que es justo decir que nadie comprende la mecánica cuántica. No siga diciéndose a sí mismo, si puede evitarlo, “¿pero cómo puede ser así?” porque usted se meterá “hasta el fondo” en un callejón sin salida del que nadie ha escapado. Nadie sabe como puede ser eso.”

De hecho, a menudo se ha dicho que de todas las teorías propuestas en el siglo XX, la más absurda es la teoría cuántica. Algunos dicen que la única cosa que la teoría tiene a su favor es que “es indudablemente correcta”.

Sin embargo, existe una tercera forma de tratar esta paradoja, denominada teoría de los muchos universos. Esta teoría (como el principio antrópico) no gozó de mucho favor en la última década, pero está siendo revitalizada por la función de onda del universo de Stephen Hawking.

Existe un principio de la física denominado Navaja de Occam, que afirma que siempre deberíamos tomar el camino más sencillo posible e ignorar las alternativas más complicadas, especialmente si las alternativas no pueden medirse nunca.

Para seguir fielmente el consejo contenido en la navaja de Occam, primero hay que tener el conocimiento necesario para poder saber elegir el camino más sencillo, lo que en la realidad, no ocurre. Nos faltan los conocimientos necesarios para hacer las preguntas adecuadas.

Hugo Everett, Bryce DeWitt y ahora Hawking (también otros), han propuesto la teoría de los universos múltiples. En unos universos los protones se desintegran antes haciendo inestable la materia, en otros, el átomo de uranio se desintegra mediante un proceso sin radiaciones, y en otros universos las constantes universales que existen en el nuestro, son totalmente diferentes y no dan posibilidad alguna para la existencia de seres vivos. Está claro que cualquier variación que en principio pudiera parecer sin importancia, como por ejemplo la carga del electrón, podría transformar radicalmente nuestro universo.

Como apuntó el físico Frank Wilczek:

“Se dice que la historia del mundo sería totalmente distinta si Helena de Troya hubiera tenido una verruga en la punta de su nariz.”

Hasta el momento, se han celebrado varias conferencias internacionales sobre la función de onda del universo. Sin embargo, como ocurre en la teoría de supercuerdas, las matemáticas implicadas en la función de onda del universo, parecen estar más allá de la capacidad de cálculo que cualquier humano en este planeta pudiera resolver, y tendríamos que esperar años antes de que aparezca un individuo genial que pudiera encontrar una solución rigurosa a las ecuaciones de Hawking.

emilio silvera

Feb

5

El Universo increíble

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (3)

Comments (3)

En lugares como este, los astrofísicos encuentran un lugar ideal para estudiar sus componentes como si de un Laboratorio natural se tratara. Moléculas de diversos pelajes y elementos aquí presentes que sorprenden en no pocas ocasiones al ver que, en este medio inhóspito de radiación y viento estelares, pueden surgir los ingredientes necesarios para la vida. Los astrónomos tienen localizadas una buena variedad de Nubes Moleculares Gigantes. Son Nubes masivas de gas y polvo interestelar compuesto fundamentalmente por moléculas. Su diámetro típico es de más de 100 años-luz y las masas varian entre unos pocos cientos de miles hasta diez millones de masas solares.

Las primeras estrellas aparecieron después de cientos de millonesde años

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron los primeros quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos.Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras evolucionar a partir de la “materia inerte”, apareciéramos nosotros.

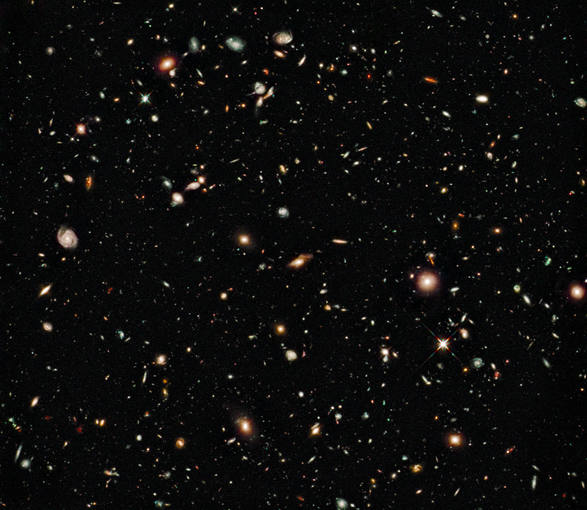

Todo en el Universo tiene un principio y un final y, el mismo universo tuvo que nacer y evolucionar para que hoy podamos contemplar, mediante nuestros sofisticados telescopios, un universo en expansión lleno de galaxias que contienen estrellas nuevas y viejas estrellas, muchas de ellas rodeadas de mundos que, aún no hemos podido determinar de qué criaturas estarán poblados muchos de ellos.

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, no hay núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo es más denso que las otras (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

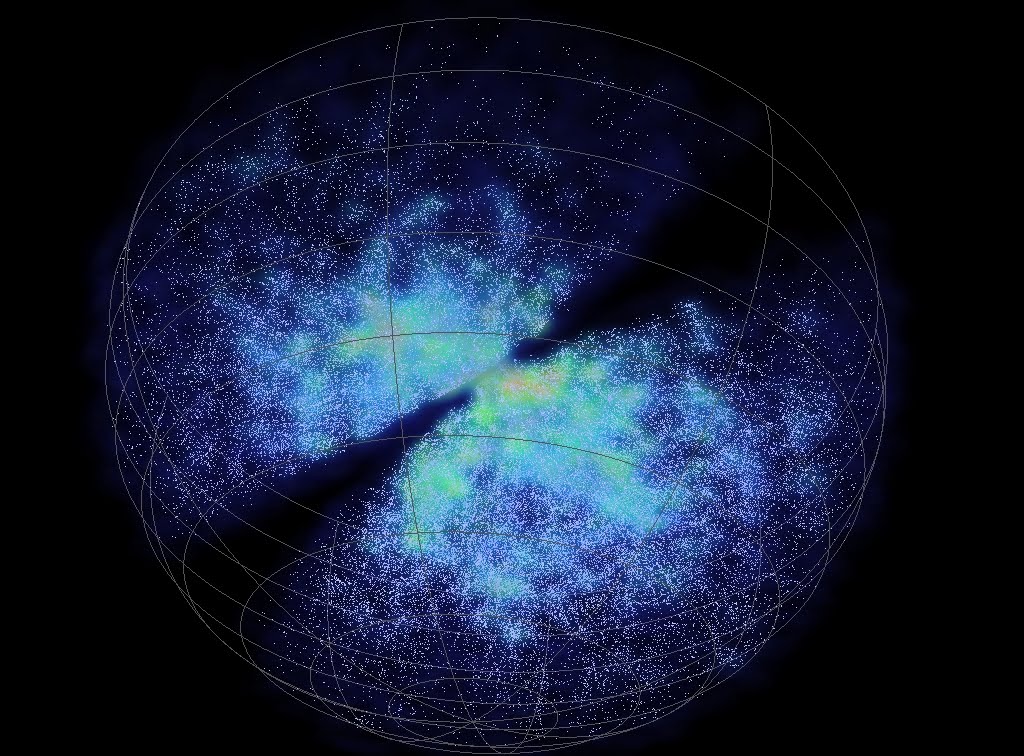

Aunque parezca mentira, al día de hoy no sabemos, a ciencia cierta, como se formaron las galaxias y si el Big Bang, el modelo de universo que hemos adoptado, es cierto. Es decir, si fue realmente lo que ocurrió aquí para que naciera nuestro universo, o, por el contrario, este pudo surgir de una fluctuación de vacío que rasgo el espacio-tiempo en otro universo. Pero, sigamos con la historia.

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la materia como si no existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo del lector en el tiempo que le lleve leer esta frase. Y en el tiempo en que usted haya leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

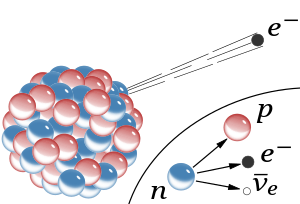

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón que a la vez que emite un electrón (β–) y un antineutrino electroníco. Es un proceso mediante el cual un nucleido o núcleo inestable emite una partícula beta (un electrón o positrón) para compensar la relación de neutrones y protones del núcleo atómico. Esta desintegración viola la paridad.

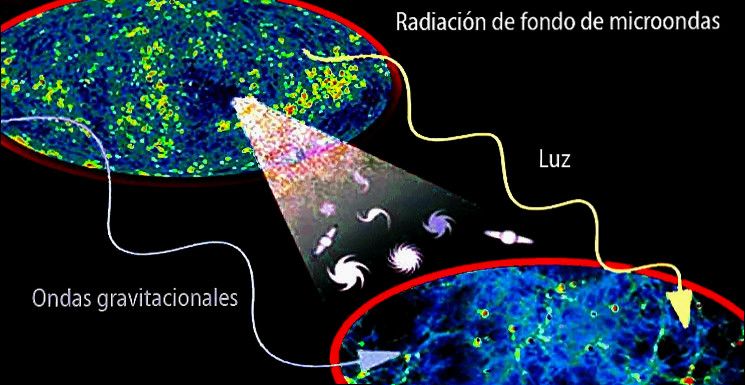

De esa manera, oleadas de neutrinos liberados en un segundo después del big bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si estos neutrinos “cósmicos” (como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas) pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo.

A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Sólo una sustancia cósmica lo invadía todo antes de que formara la materia

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el de contarlos, hallaremos que por cada mil millones de antiquarks existen mil millones y un quark. La asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo.

La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. hay bastante energía ambiente para permitir la creación y el mantenimiento de gran de bosones w y z.

Estas partículas –las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil– son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, en el futuro, será la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interacioban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 15.000 y 18.000 millones de años, cunado la perfecta simetría que, se pensaba, caracterizó el Universo, se hizo añicos para dar lugar a los simetrías rotas que hallamos a nuestro alrededor y que, nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que , sea posible que, alguien como yo esté contando lo que pasó.

Pero hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo bebé. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada.

Del otro lado de esa puerta está la época de Plank, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

La fuerza nuclear fuerte hizo posible la existencia de los núcleos que atraían electrones para formar átomos

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parece que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven a las mil maravillas.

A partir del momento en que se formaron los primeros átomos, estos se unieron para formar moléculas y cuerpos. Pasados cientos de miles de años, millones y millones que el Universo necesitó para forjarse como un un Sistema cerrado coherente, lleno de materia situada en grandes espacios vacíos, donde las cuatro fuerzas fundamentales lo regían todo. Desde entonces, el universo se pobló de fantásticas configuraciones surgidas de la energía devastadoras de las primeras supernovas y colisiones de agujeros negros y un sin fin de fenómenos que ahora podemos observar con los grandes telescopios.

Galaxias que atraídas por la fuerza de gravedad se fusionan

Bellas Nebulosas que son el resultado de grandes explosiones de estrellas moribundas que lanzan sus materiales al espacio interestelar.

Formaciones en cúmulos de estrellas que producen el asombro de los Astrónomos

Monstruos cósmicos que, en forma de agujeros negros, enguyen a las estrellas vecinas para hacerse más y más grande

Miles y millones de galaxias que se reparten por todas las regiones del Universo “infinito”

Y pasado más de 13.000 millones de años, en un planeta rocoso de escasa importancia en el contexto del universo inmenso, aparecímos nosotros, unas criaturas egoistas e instintivas que, caminamos por el planeta durante milenios forjando Civilizaciones, inventando la escritura y las matemáticas, logrando forjar un saber encomiable sobre la Astronomía que nos cuenta, lo que pudo pasar desde el comienzo del Tiempo.

Sí, es cierto que, si somos sinceros, hay que reconocer que andamos un poco perdidos y que las preguntas, son infinitamente más que las pocas respuestas que podemos dar. Nuestra ignorancia es grande pero, nuestra imaginación es mayor y, poco a poco, ésta última le está ganando la batalla a la primera, ese peso que la Humanidad lleva sobre sus hombros desde la noche de los tiempos.

emilio silvera

Feb

5

Decepción

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo misterioso ~

Clasificado en El Universo misterioso ~

Comments (0)

Comments (0)

Adiós a las ondas del primer instante del universo, de momento

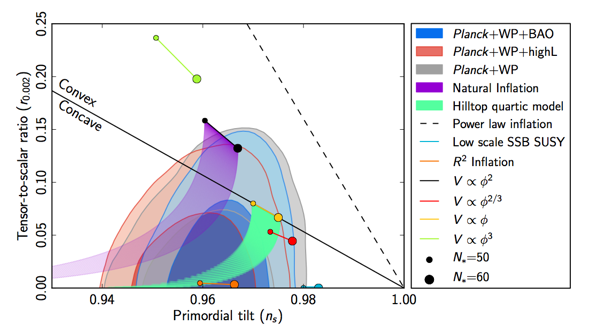

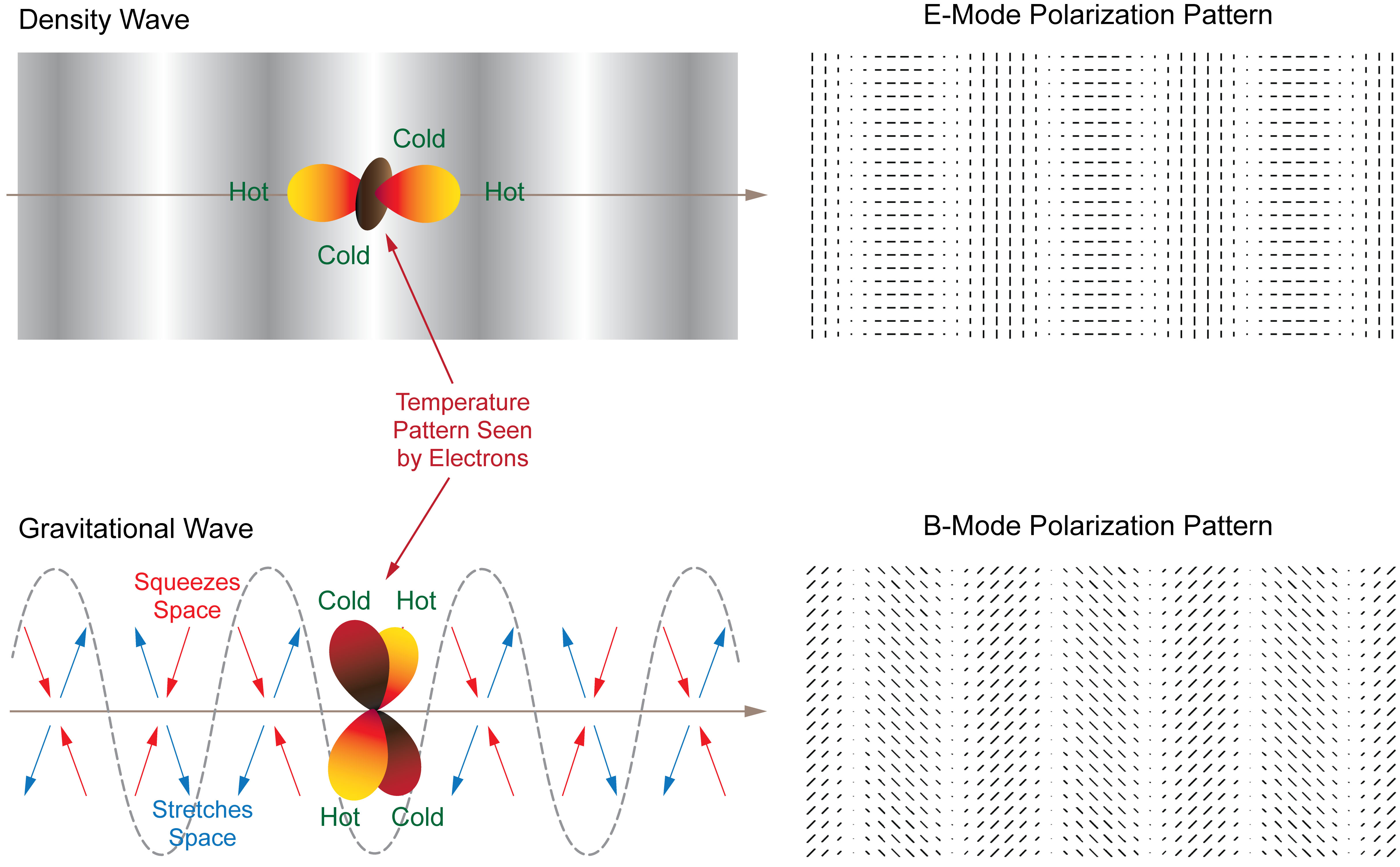

El análisis conjunto de los datos del telescopio Bicep-2, en el polo Sur, y del satélite Planck concluye que la señal de ondas gravitacionales primordiales puede deberse al polvo de la Vía Láctea

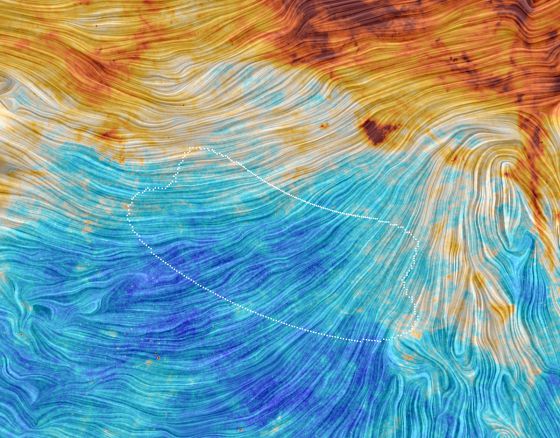

Imagen del fragmento del cielo observado por el telescopio Bicep-2 tal y como lo ha visto el telescopio espacial europeo `Planck´. / ESA/Planck Collaboration. Acknowledgment: M.-A. Miville-Deschênes, CNRS – Institut d’Astrophysique Spatiale, Université Paris-XI, Orsay, France

Menos de un año han tardado los científicos en aceptar un jarro de agua helada sobre unos resultados sobre el principio del universo que, de ser ciertos, habrían supuesto un descubrimiento de los realmente grandes: la firma de ondas gravitacionales, vibraciones del espacio-tiempo correspondientes al universo cuanto tenía apenas una fracción de segundo y sufría un crecimiento descomunal y casi instantáneo. Aquella firma fue anunciada por los científicos del telescopio Bicep-2, situado en el mismísimo Polo Sur, en marzo pasado, pero pocas semanas después suscitó sospechas por parte de investigadores que escudriñaron los datos, encontraron pistas poco convincentes y sugirieron que en realidad esas preciosas señales podrían corresponder a algo mucho más normal y cercano: la radiación emitida por el polvo de la Vía Láctea, nuestra galaxia. Los científicos, para solventar la cuestión que tenía en vilo a muchos en todo el mundo, recurrieron al análisis minucioso de la combinación de datos del Bicep-2 con los obtenidos por el telescopio espacial europeo Planck. La respuesta acaba de ser adelantada por la Agencia Europea del Espacio (ESA) y la revista Nature ya se ha hecho eco de ella: “El descubrimiento de las ondas gravitacionales está ya oficialmente muerto”. Eso sí, puntualizan los expertos, la búsqueda de esas ondas gravitacionales no es imposible con las observaciones como las de Bicep-2, solo que esta vez no ha lugar el “eureka”.

Un instante después del inicio del universo, hace unos 13.800 millones de años, se produjo, según una teoría no confirmada aún pero defendida por la gran mayoría de los cosmólogos, un crecimiento exponencial y rapidísimo del espacio-tiempo apenas nacido. Ese proceso, denominado inflación cósmica, generaría unas leves oscilaciones intrínsecas en ese espacio tiempo que se habrían propagado a medida que el universo crecía y que podrían haber quedado como una firma específica en el universo que ahora se observa. Y la detección de esa firma es lo que John Kovac (Centro Harvard Smithsonian de Astrofísica, en EE UU), en nombre del equipo de Bicep-2, anunció en marzo del año pasado levantando un enorme interés, entusiasmo e incluso rumores de premio Nobel incuestionable si se confirmaba.

“Cuando detectamos esta señal en nuestro datos nos basamos en modelos de la emisión del polvo galáctico que entonces estaban disponibles”, ha declarado ahora Kovac, según recoge la ESA. Esos modelos “parecían indicar que la región del cielo elegida para nuestras observaciones tenía una polarización por polvo muy inferior a la señal detectada”, añade.

El Bicep-2 es un telescopio especializado para ver la radiación de fondo de microondas, el llamado eco del Big Bang, que se emitió cuando el universo tenía unos 380.000 años y que permea ahora todo el cielo. No hay forma de ver directamente nada anterior, pero sí se pueden encontrar pistas de los procesos y fenómenos precedentes en la evolución del cosmos si han dejado marcas. Como aquellas ondas gravitacionales primordiales correspondientes a la fase de inflación. Y en este caso la firma sería un patrón determinado y específico en la polarización de la luz de ese fondo de microondas. Justo lo que estaban buscando los científicos de Bicep-2 con un trabajo observacional y una tecnología avanzada que ha sido reconocida internacionalmente como de muy alto nivel.

“Si se confirma, esa firma de las ondas gravitacionales del Big Bang abrirá un nuevo capítulo en la astronomía, la cosmología y la física”, escribió Nature cuando se anunció el descubrimiento de Bicep-2 que ahora se viene abajo. “La detección de estas señales es uno de los objetivos más importantes de la cosmología actual. Mucha gente ha trabajado mucho hasta llegar a este punto”, recalcó Kovac.

Falta de precisión

El problema emergió con el análisis de los datos captados con el telescopio del Polo Sur, porque el polvo de la Vía Láctea también polariza la luz y el escollo estaba, precisamente, en sustraer el efecto de ese polvo galáctico interpuesto entre el telescopio y la radiación de fondo, y poder concluir que efectivamente las señales corresponderían a las ondas gravitacionales primordiales. Tras el anuncio de Kovac, unos investigadores destacaron que los datos de polvo galáctico utilizados en el análisis de Bicep-2 no eran tan precisos como sería exigible. Eran datos, aún no publicados oficialmente, captados con el telescopio Planck, que ha estado observando la radiación de fondo en toda la bóveda celeste [el telescopio del Polo Sur se centró, entre 2010 y 2012, en una parcela del cielo concreta], con una precisión altísima y en varias frecuencias.

Para salir de dudas, los científicos recurrieron a la estrategia normal: profundizar el análisis con todos los datos disponibles. Así, los equipos de Planck y Bicep-2 se pusieron a cruzar sus datos respectivos y ahora llega su conclusión (aún no publicada oficialmente pese a que el artículo científico de 17 páginas, o un borrador muy próximo al definitivo, ha sido adelantado).

“El equipo de Bicep-2 eligió una parcela del cielo en la que ellos creían que la emisión del polvo sería baja y, por tanto, interpretaron que la señal detectada sería probablemente cosmológica”, explica la ESA. “Sin embargo, en cuanto se vieron los mapas de Planck de la emisión polarizada del polvo galáctico, quedó claro que esta contribución interpuesta podría ser mucho mayor de lo que se esperaba”. Y concluye Jean-Loup Puget (Instituto de Astrofísica Espacial de Orsay, Francia), uno de los investigadores principales de Planck acerca de los últimos resultados: “Este trabajo conjunto ha demostrado que la detección de las B-modes primordiales [la firma de las ondas gravitacionales de la inflación cósmica] no es robusta cuando se sustrae la emisión del polvo galáctico”.

El trabajo no ha sido en absoluto inútil, señalan los científicos. El análisis conjunto de los dos equipos ha permitido ir acotando los parámetros (el límite superior de la cantidad de ondas gravitacionales) en los que cabe esperar la señal en este tipo de observaciones, aunque no se hayan confirmado con los actuales resultados. “Aunque no hemos encontrado pruebas sólidas de una señal de ondas gravitacionales primordiales en las mejores observaciones de la polarización de la radiación de fondo actualmente disponibles, esto no significa que se descarte la inflación”, afirma Reno Mandolesi (Universidad de Ferrara, Italia), otro de los investigadores principales de Planck.

Fuente: El Pais.

Feb

5

Celebraciones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Celebraciones ~

Clasificado en Celebraciones ~

Comments (0)

Comments (0)

Como Socio de la Real Sociedad Española de Física, acabo de recibir un Correo que no puedo atender, y, como es una celebración interesante, aquí lo dejo para todos aquellos que, viviendo cerca del lugar, quieran pasar para ser testigos de tan acertada jornada. La luz, amigos míos, es tan importante para nosotros que, sin ella… ¡Las cosas serían de otra manera!

“Estimados Socios:

Totales: 75.092.573

Totales: 75.092.573 Conectados: 56

Conectados: 56