Mar

28

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nanotecnología ~

Clasificado en Nanotecnología ~

Comments (0)

Comments (0)

Han pasado ya cincuenta años que Richard Feynman dictara su famosa charla: There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –“es algo que no se ha hecho debido a que somos demasiado grandes para hacerlo”-. Eso ha quedado atrás y, en la actualidad, sí que se manipulan los átomos.

Desde entonces se ha buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa.

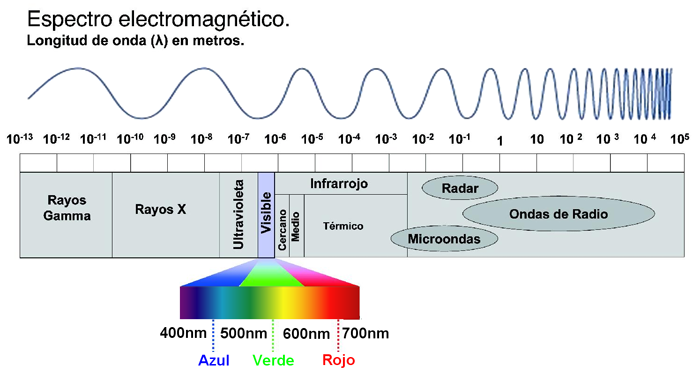

El resultado más vistoso de estas nanoestructuras es la capacidad para poder sintonizar la longitud de onda o color de la emisión.

El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Richard Feynman

Hoy día se estima el mercado de la nanotecnología en cientos de miles de millones de dólares. Nuestro país también ha apoyado la iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitaciones, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

Materiales nanoestructurados y nanotecnología

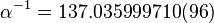

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque existen sistemas nanoestructurados de dimensiones mayores son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados materiales en bulto.

tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

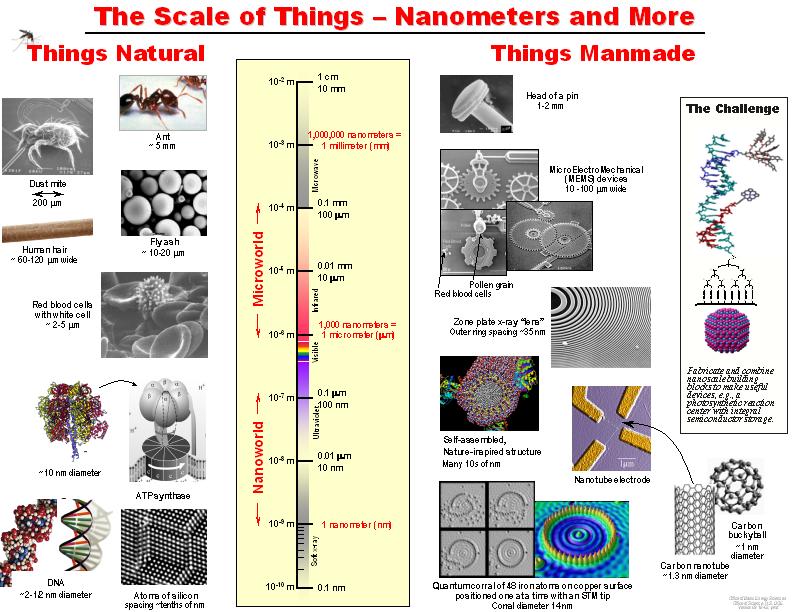

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. el superátomo es de anión ( carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, el potasio”, que tiene un electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más completar su último nivel energético.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es la Nanofotónica

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que , serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar por medios desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi , estimo que división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se hablar propiamente de nanofotónica, de igual manera que se hablar de nanoelectrónica o de nanomagnetismo.

Cuando sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. una de ellas produce fenómenos de especial interés interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por . En el CIO, durante los últimos 6 años hemos trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce confinamiento cuántico, que no es más que la localización de los electrones en un espacio definido, es poner un electrón en una caja. Mientras que tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan uno y diez nanómetros.

Con frecuencia se les describe átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en caso nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta para el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones bien establecidas es la espectroscopia Raman de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo hasta 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

No tarderemos mucho en asombrarnos de los logros alcanzados por la Nanofotónica en diversos apartados de la tecnología del futuro. Estamos en la linea de salida hacia horizontes futuristas en todos los campos del saber. La tecnología del mañana nos asombraría hoy, y, simplemente tenemos que fijarnos en el presente y compararlo con aquel tiempo pasado de hace sólo unos cien años, cuando los ordenadores, los teléfonos móviles y las comunicaciones tal como hoy laos conocemos, eran un sueño irrealizable.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y consecuencia requieren altas energías de bombeo o luz en el UV obtener emisión que en general es débil, aunque se combina en adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices soportar iones de tierras raras que son muy buenos emisores de luz. En caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que producir una mejora en la eficiencia de emisión.

los nanocristales mas estudiados se encuentran algunos silicatos Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica producir láseres conocida como YAG, o YAP la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el . mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con fuente se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula 10 a 90 nm.

Lo curioso es que en todo esto como en la Naturaleza, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son 40 y 60 nm.

Nano partículas metálicas, plasmones.

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

resultado de la interacción la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta el monitoreo óptico y la formación de imágenes ópticas

localizadas. Una de las aplicaciones establecidas es de superficie mejorada (SERS por sus siglas en inglés). En caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo 11 000 veces más las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡Eso que llamamos futuro… ya está aquí!

Y, siendo testigo de todos estos adelantos y de como la Humanidad corre hacia el futuro, no puedo dejar de preguntarme: ¿Qué será de los seres humanos dentro de 10.000 años? ¿Estaremos aquí todavía? ¿Habremos logrado viajar a las estrellas? Son tantas las respuestas que me gustaría tener que, a veces, me siento algo frustrado por las inmensas limitaciones a las que estamos sometidos los humanos?

emilio silvera

Mar

27

Cosas de Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

En unas simples tablillas pero, las tres fases del Tiempo, quedan bien representadas: el pasado que señala hacia atrás, a lo que se fue y quedó enmarcado en la Historia, el futuro que señala hacia adelante y al que nunca nos podremos agarrar, enmedio de ambos está el presente que está enmarcado entre esos dos puntos y hacia ambos debe señalar. Cuando se piensa detenidamente en esto del Tiempo, unas veces hacemos una composición de esa “realidad” tenporal que al momento la queremos cambiar por otra…

Sí, vivímos en un continúo presente que se compone del pasado que vamos dejando atrás y del futuro en el que vamos entrando, ambos, pasado y futuro, están conectados con este presente nuestro y, mientras que al primero lo podemos recordar, al segundo sólo lo podemos instuir, ya que, cuando entra en nuestro presente, deja de ser futuro.

Creo que nunca (a pesar del ingenio y la imaginación derrochada por los escritores de ciencia ficción) podremos viajar al pasado que se fue y ya no existe, ni al futuro que aún no está, que tampoco existe y, viajar a un lugar inexistente…se hace raro. Pero hablemos de Física.

¡Preludio a la relatividad! -Las ecuaciones de Lorentz-Fitzgerald- Éste último pensaba y decía cosas comos estas:

George FitzGerald

“…la telegrafía debe mucho a Euclides y otros geómetras puros, a los griegos y árabes matemáticos que inventaron nuestra escala de numeración y álgebra, a Galileo, quien fundó la dinámica para que Newton y Leibniz inventaran el cálculo, para que Volta descubriera la galvánica bobina, a Oersted quien descubrió la acción magnética de las corrientes, Ampère que descubrió las leyes de su acción, a Ohm que descubrió la ley de la resistencia de los cables, a Wheatstone, de Faraday, a Lord Kelvin, a Clerk Maxwell, Hertz a… Sin los descubrimientos, invenciones, y las teorías científicas resumen de estos hombres la telegrafía y otros ingenios derivados de la luz… ¡sería imposible!”

Hendrik Antoon Lorentz

Se le deben importantes aportaciones en los campos de la termodinámica, la radiación, el magnetismo, la electricidad y la refracción de la luz. Formuló conjuntamente con George Francis FitzGerald una teoría sobre el cambio de forma de un cuerpo como resultado de su movimiento; este efecto, conocido como “contracción de Lorentz-FitzGerald”, cuya representación matemática de ella es conocida con el nombre de transformación de Lorentz, fue una más de las numerosas contribuciones realizadas por Lorentz al desarrollo de la teoría de la relatividad.

Fue, al igual que Henri Poincaré, uno de los primeros en formular las bases de la teoría de la relatividad (frecuentemente atribuida primaria o solamente a Albert Einstein). Fue ganador del Premio Nobel de Física en 1902, junto con su pupilo Pieter Zeeman, por su investigación conjunta sobre la influencia del magnetismo en la radiación, originando la radiación electromagnética. También fue premiado con la Medalla Rumford en 1908 y la Medalla Coplay en 1918. Lorentz era hombre humilde y sencillo y le gustaba resaltar los logros de los demás:

“Como es probable que sepas, gran parte de nuestro conocimiento sobre la electricidad y el magnetismo se basa en los experimentos ingeniosísimos realizados por Michael Faraday en la primera parte del siglo XIX. Faraday era un experimentador genial, y descubrió numerosos fenómenos desconocidos hasta entonces, como la inducción mutua. Estableció diversas leyes, pero no pudo elaborar una teoría global acerca del electromagnetismo porque sus conocimientos matemáticos no iban más allá de la trigonometría: hacía falta un teórico capaz de amalgamar el conocimiento adquirido por Faraday y otros experimentadores, como Hans Christian Ørsted, en una teoría general.

Ese teórico era otro genio, James Clerk Maxwell, que estableció un conjunto de cuatro ecuaciones diferenciales bellísimas que describían de una manera extraordinariamente precisa los resultados de casi todos los experimentos de Faraday, Ørsted y compañía. Lo más sorprendente, para el propio Maxwell y sus contemporáneos, fue una de las consecuencias inevitables de sus ecuaciones: la existencia de perturbaciones del campo eléctrico y el magnético que se propagaban por el espacio.”

A la contracción, Einstein le dio un marco teórico en la teoría especial de la relatividad. En esta teoría, un objeto de longitud l0 en reposo en un sistema de referencia parecerá, para un observador en otro sistema de referencia que se mueve con velocidad relativa v con respecto al primero, tener longitud ![]() , donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

, donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

Un objeto que se moviera a 11,2 Km/s (la velocidad de escape de nuestro planeta) experimentaría sólo una contracción equivalente a 2 partes por cada 1.000 millones en el sentido del vuelo. Pero a velocidades realmente elevadas, tal contracción sería sustancial. A unos 150.000 Km/s (la mitad de la velocidad de la luz) sería del 15%; a 262.000 Km/s (7/8 de la velocidad de la luz), del 50%. Es decir, que una regla de 30 cm que pasara ante nuestra vista a 262.000 Km/s nos parecería que mide sólo 15’24 cm, siempre y cuando conociéramos alguna manera para medir su longitud en pleno vuelo. Y a la velocidad de la luz, es decir, 300.000 Km/s en números redondos, su longitud en la dirección del movimiento sería cero. Puesto que, presuntamente, no puede existir ninguna longitud inferior a cero, se deduce que la velocidad de la luz en el vacío es la mayor que puede imaginarse el universo.

experimento conocido de Michelson-Morley

Todo aquello fue posible gracia a que en 1893, el físico irlandés George Francis FitzGerald emitió una hipótesis para explicar los resultados negativos del experimento conocido de Michelson-Morley. Adujo que toda materia se contrae en la dirección del movimiento, y que esa contracción es directamente proporcional al ritmo (velocidad) del movimiento.

Según tal interpretación, el interferómetro se quedaba corto en la dirección del “verdadero” movimiento terrestre, y lo hacía precisamente en una cantidad que compensaba con toda exactitud la diferencia de distancias que debería recorrer el rayo luminoso. Por añadidura, todos los aparatos medidores imaginables, incluyendo los órganos sensoriales humanos, experimentarían ese mismo fenómeno.

Parecía como si la explicación de FitzGerald insinuara que la Naturaleza conspiraba con objeto de impedir que el hombre midiera el movimiento absoluto, para lo cual introducía un efecto que anulaba cualquier diferencia aprovechable para detectar dicho movimiento.

Este asombroso fenómeno recibió el nombre de “contracción de FitzGerald”, y su autor formuló una ecuación para el mismo que, referido a la contracción de un cuerpo móvil, fue predicha igualmente, y de manera independiente, por H.A.Lorentz (1853-1928) de manera que, finalmente, se quedaron unidas como “Contracción de Lorentz-Fitz Gerald”.

El efecto Fitzgerald sobre longitudes y el efecto Lorentz sobre masas mantuvieron una conexión tan estrecha que aparecieron a menudo agrupadas como las ecuaciones Lorentz-Fitzgerald.

Si una nave pudiera viajar a la velocidad de la luz, sus pasajeros verían como se ralentizaba el Tiempo

Después llegó Einstein que se apropió de aquella idea y, además, la amplió al contraer también el Tiempo. La contracción de la longitud ha sido verificada en el diseño, por ejemplo, del acelerador lineal de la Universidad de Stanford. Las partículas salen con una velocidad v = 0,999975c, por tanto, cada metro de tubo acelerador es “visto” por los electrones como 144 metros. Si, según la expresión anterior, un cuerpo con masa se moviera a la velocidad c desaparecería por contracción de su longitud para un observador en reposo, lo cual refuerza el carácter inalcanzable de esta velocidad. Si los objetos con masa alcanzan este límite de velocidad la estructura básica de la realidad se desvanece. Por otra parte, vemos que cualquier influencia que afecte al tiempo también lo hará con el espacio. Esto no nos debe de extrañar, ya que ambas magnitudes se encuentran íntimamente relacionadas por lo único que se nos mantiene invariable: la velocidad de la luz. En relatividad hablamos de espacio-tiempo ya que son inseparables.

A la contracción, Einstein, le dio un marco teórico en la teoría especial de la relatividad. En esta teoría, un objeto de longitud /0 en reposo en un sistema de referencia parecerá, para un observador en otro sistema de referencia que se mueve con velocidad relativa v con respecto al primero, tener longitud /0 , donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

Un objeto que se moviera a 11 km/s (la velocidad de escape de nuestro planeta) experimentaría sólo una contracción equivalente a 2 partes por cada 1.000 millones en el sentido del vuelo. Pero a velocidades realmente elevadas, tal contracción sería sustancial. A unos 150.000 km/seg. (la mitad de la velocidad de la luz, c), sería del 15%; a 262.000 km/seg. (7/8 de la velocidad de la luz), del 50% Es decir, que una regla de 30 cm. que pasara ante nuestra vista a 262.000 km (seg., nos parecería que mide sólo 15’54 cm…, siempre y cuando conociéramos alguna manera para medir su longitud en pleno vuelo. Y a la velocidad de la luz, es decir, 300.000 km/seg., en números redondos, su longitud, en la dirección del movimiento, sería cero. Puesto que, presuntamente, no puede existir ninguna longitud inferior a cero, se deduce que la velocidad de la luz en el vacío es la mayor que puede imaginarse en el Universo. (Pero ¿existir también?).

El físico holandés Hendrik Antón Lorentz, como hemos dicho, promovió ésta idea pensando en los rayos catódicos (que ocupaban su actividad por aquellas fechas), se hizo el siguiente razonamiento: si se comprimiera la carga de una partícula para reducir su volumen, aumentaría su masa. Por consiguiente, una partícula voladora, escorzada en la dirección de su desplazamiento por la contracción de Fitz Gerald, debería crecer en términos de masa.

Un objeto que corra a velocidades cercanas a la de la luz, verá incrementada su masa

Lorentz presentó una ecuación sobre el acrecentamiento de la masa, que resultó muy similar a la ecuación FitzGerald sobre el acortamiento. A 149.637 kilómetros por segundo, la masa de un electrón aumentaría en un 15%; a 262.000 km/seg., en un 100% (es decir, la masa se duplicaría); y a la velocidad de la luz, su masa sería infinita. Una vez más pareció que no podría haber ninguna velocidad superior a la de la luz, pues, ¿cómo podría ser una masa mayor que infinita? El efecto FitzGerald sobre longitudes y el efecto Lorentz sobre masas mantuvieron una conexión tan estrecha que aparecieron a menudo agrupadas como las “ecuaciones Lorentz-FitzGerald.”

Mientras que la contracción FitzGerald no podía ser objeto de mediciones, el efecto Lorentz sobre masas si podía serlo…, aunque indirectamente. De hecho, el muón, tomó 10 veces su masa original cuando fue lanzado, a velocidades relativistas, en el acelerador de partículas, lo que confirmó la ecuación de Lorentz. Los experimentos posteriores, han confirmado las ecuaciones de ambos: a velocidades relativistas, las longitudes se contraen y las masas se incrementan.

Nada puede viajar a la velocidad de la luz

Como es conocido por todos, Einstein adoptó estos descubrimientos y los incorporó a su teoría de la relatividad especial que, aunque mucho más amplia, recoge la contracción de FitzGerald y el aumento de la masa de Lorentz cuando se alcanzan grandes velocidades.

¡Qué cosas!

Algunas veces pienso que, los artistas en general, y los poetas en particular, tendrían que adaptar e incluir a sus esquemas artísticos y poéticos, los adelantos científicos, para asimilarlos en las diversas expresiones y sentimientos que serán después puestos al servicio del consumo humano.

Estos adelantos científicos serían así coloreados con las pasiones humanas y transformadas, de alguna forma, en la sangre, y por qué no, los sentimientos de la naturaleza humana.

Posiblemente, de haberlo hecho así, el grado general de conocimiento sería mayor.

emilio silvera

Mar

26

¡La Física! Siempre presente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

¿Cuándo comprenderemos?

Estar equivocados nos sorprende y, al mismo tiempo, nos enseña algo sobre nosotros mismos. No solo hay cosas que no sabemos, sino que las cosas que creemos saber pueden no ser ciertas. Como nos dice la filosofía, nada es como se ve a primera vista, todo depende bajo el punto de vista desde el que miremos las cosas y, si es el correcto, estaremos en esa verdad que incansables buscamos.

No resulta nada fácil descubrir los caminos por los que deambula la Naturaleza y las razones que ésta tiene para recorrerlos de la manera que lo hace y no de otra. Una cosa es cierta, la Naturaleza siempre trata de conseguir sus fines con el menor esfuerzo posible y, cuestiones que nos parece muy complicadas, cuando profundizamos en ellas como la ciencia nos exige, llegan a parecernos más sencillas y comprensibles. Todas las respuestas están ahí, en la Naturaleza.

“Este es un ensayo de Viktor Frankl neurólogo, psiquiatra, sobreviviente del holocausto y el fundador de la disciplina; que conocemos hoy como Logoterapia.

No eres Tú, soy Yo…

¿Quién te hace sufrir? ¿Quién te rompe el corazón? ¿Quién te lastima? ¿Quién te roba la felicidad o te quita la tranquilidad? ¿Quién controla tu vida?…

¿Tus padres? ¿Tu pareja? ¿Un antiguo amor? ¿Tu suegra? ¿Tu jefe?…

Podrías armar toda una lista de sospechosos o culpables. Probablemente sea lo más fácil. De hecho sólo es cuestión de pensar un poco e ir nombrando a todas aquellas personas que no te han dado lo que te mereces, te han tratado mal o simplemente se han ido de tu vida, dejándote un profundo dolor que hasta el día de hoy no entiendes.”

No veo que profesor pregunte por qué el llegar a saber también, nos puede hacer sufrir. Estamos en aquello de…, ” ojos que no ven, corazón que no siente”.

Hay historias del pasado que te hablan de pueblos y Civilizaciones que llegaron a tener una enorme visión del mundo. Sus sociedades alcanzaron cotas increibles en el saber de cuestiones que, aún hoy, nos parecen difíciles de creer y, sin embargo, ahí han quedado las huellas materiales de que, esos pueblos, mucho antes que nosotros, supieron entender el mundo y, de alguna manera, fueron incluso más prácticvos y naturales que nosotros muchos siglos después.

¿Cómo podríamos ensamblar una explicación científica de la génesis de la vida? A simple vista nos puede parecer una tarea sin esperanzas. No creo que buscar fósiles en las rocas más antiguas sea suficiente y nos ofrezca todas las claves necesarias. La mayoría de las delicadas moléculas prebióticas que dieron lugar a la vida habrán sido erradicadas por el inexorable paso del tiempo y la destructora entropía que todo en polvo lo convierte. Es posible, que podamos esperar el hallazgo de algún residuo químico ya degradado de aquellos organismos ancestrales a partir de los cuales evolucionó la vida celular que conocemos.

Claro que, aparte de los fósiles que podamos encontrar en las rocas, existe otra línea de evidencia que, de la misma manera, se remonta al pasado lejano y oscuro, pero que existe aquí y ahora, dentro de las formas de la vida presente. Los biólogos están convencidos de que ciertas reliquias de organismos antiguos siguen viviendo en las estructuras y procesos bioquímicos de sus descendientes, incluyéndonos a nosotros, los seres humanos.

Todo comienza siendo una cosa y con el tiempo, se transforma en otra diferente: Evolución por la energía. En el universo en que vivimos, nada desaparece; con el tiempo se cumplen los ciclos de las cosas y se convierten en otra distinta, es un proceso irreversible que podemos contemplar a nuestro alrededor con el paso inexorable del tiempo se van cumpliendo las fases y los ciclos, y, no necesarimente siempre son de desgaste y envejecimiento, sino que, otras son de creación y resurgimiento. Cuando las estrellas masivas viejas esplotan en Supernovas, el espacio interetelar queda ocupado, en grandes regiones, por una nube enorme que, a veces, abarca varios años luz. El tiempo transcurre y, de esos restos de estrella “muerta”, con ayuda de la gravedad, nacen nuevas estrellas. Es la entropía negativa que lucha contra aquella otra que todo lo quiere destruir. Nosotros, de alguna manera, hacemos lo mismo con la descendencia y creamos entropía negativa que hace que lo nuevo, de alguna manera, esté venciendo a ese destino irreversible que nos habla de que la Eternidad… ¡No existe, para nada ni para nadie!

El gas y el polvo se transforma en una brillante estrella que vive diez mil millones de años y termina en Nebulosa planeta con una enana blanca en el centro. Entonces la estrella que tenía un diámetro de 1.500 km, se reduce hasta unas pocas decenas, 20 0 30 Km y, su densidad, es inmensa, emitiendo radiación ultravioleta durante mucjho tiempo hasta que se enfría y se convierte en un cadáver estelar.

En lo concerniente a cambios y transformaciones, el que más me ha llamado siempre la atención es el de las estrellas que se forman a partir de gas y polvo cósmico. Nubes enormes de gas y polvo se van juntando. Sus moléculas cada vez más apretadas se rozan, se ionizan y se calientan hasta que en el núcleo central de esa bola de gas caliente, la temperatura alcanza millones de grados. La enorme temperatura posible la fusión de los protones y, en ese instante, nace la estrella que brillará miles de millones de años y dará luz y calor. Su ciclo de vida estará supeditado a su masa. Si la estrella es supermasiva, varias masas solares, su vida será más corta, ya que consumirá el combustible nuclear de fusión (hidrógeno, helio, litio, oxígeno, etc) con más voracidad que una estrella mediana como nuestro Sol, de vida más duradera.

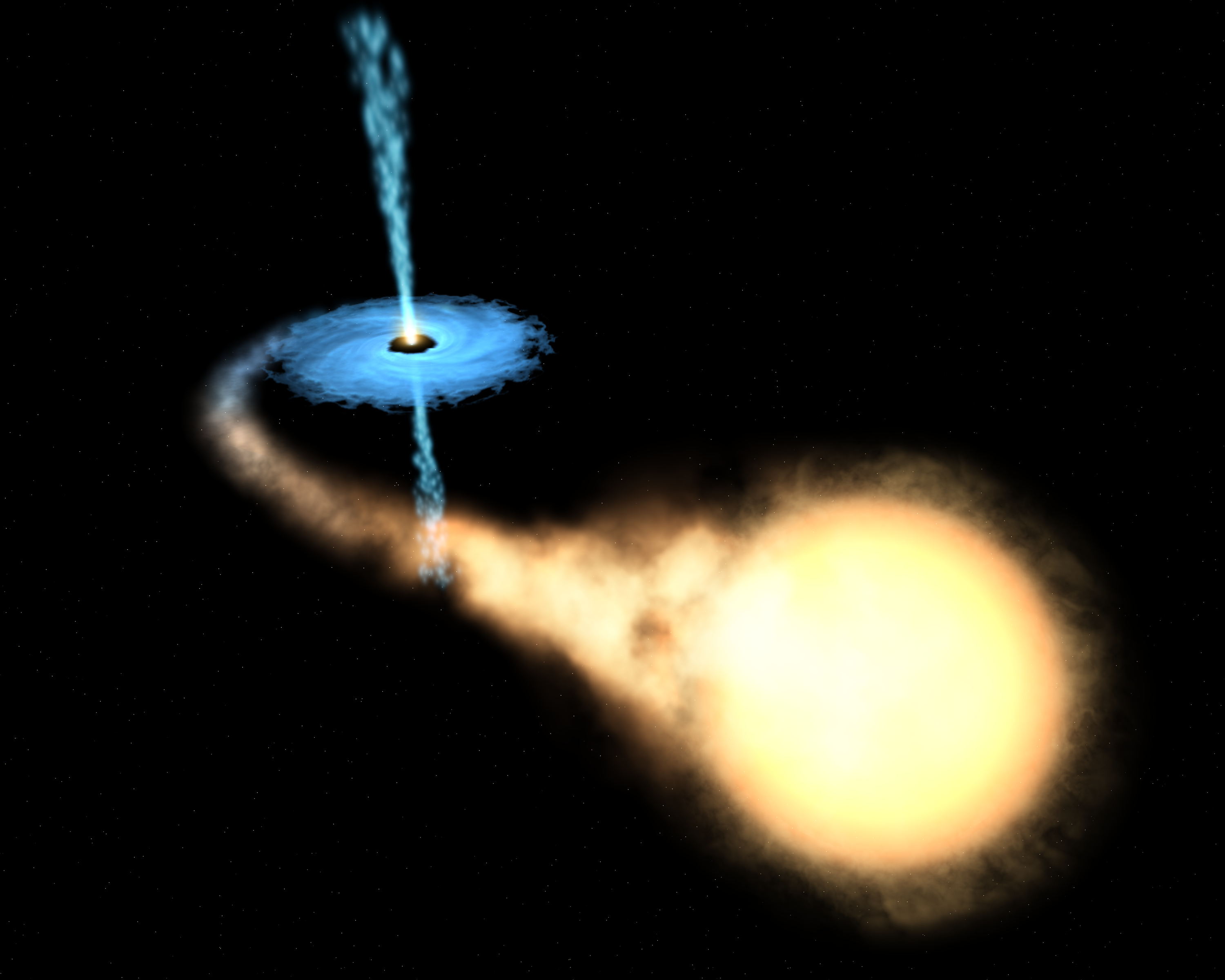

Una estrella, como todo en el universo, está sostenida por el equilibrio de dos fuerzas contrapuestas; en caso, la fuerza que tiende a expandir la estrella (la energía termonuclear de la fusión) y la fuerza que tiende a contraerla (la fuerza gravitatoria de su propia masa). Cuando finalmente el proceso de fusión se detiene por agotamiento del combustible de fusión, la estrella pierde la fuerza de expansión y queda a merced de la fuerza de gravedad; se hunde bajo el peso de su propia masa, se contrae más y más, y en el caso de estrellas súper masivas, se convierten en una singularidad, una masa que se ha comprimido a tal extremo que acaba poseyendo una fuerza de gravedad de una magnitud difícil de imaginar el común de los mortales.

La singularidad con su inmensa fuerza gravitatoria atrae a la estrella vecina

La Tierra, un objeto minúsculo en comparación con esos objetos súper masivos estelares, genera una fuerza de gravedad que, para escapar de ella, una nave o cohete espacial tiene que salir disparado la superficie terrestre a una velocidad de 11’18 km/s; el sol exige 617’3 km/s. Es lo que se conoce como velocidad de escape, que es la velocidad mínima requerida escapar de un campo gravitacional que, lógicamente, aumenta en función de la masa del objeto que la produce. El objeto que escapa puede ser una cosa cualquiera, desde una molécula de gas a una nave espacial. La velocidad de escape de un cuerpo está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo. Un objeto que se mueva con una velocidad menor que la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita , y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica y rompe la atadura en que la mantenía sujeto al planeta, la estrella o el objeto que emite la fuerza gravitatoria.

La mayor velocidad que es posible alcanzar en nuestro universo es la de la luz, c, velocidad que la luz alcanza en el vacío y que es de 299.793’458 km/s.

Sí, se pudo confirmar que los neutrinos respetan la supremacía el fotón y la luz, sigue siendo la más rápida del Universo. Y sin embargo, no escapar de la atracción de un Aguero Negro.

Pues bien, es tal la fuerza de gravedad de un agujero negro que ni la luz puede escapar de allí; la singularidad la absorbe, la luz desaparece en su interior, de ahí su nombre de agujero negro, la estrella supermasiva se contrae, llega a un punto que desaparece de nuestra vista. De acuerdo con la relatividad general, cabe la posibilidad de que una masa se comprima y reduzca sin límites su tamaño y se auto confine en un espacio infinitamente pequeño que encierre una densidad y una energía infinitos. Allí, el espacio y el tiempo dejan de existir.

Las singularidades ocurren en el Big Bang, en los agujeros negros y en el Big Crunch (que se podría considerar una reunión de todos los agujeros negros generados por el paso del tiempo en el universo y que nos llevará a un fin que será el comienzo).

Las singularidades de los agujeros negros están rodeados por una circunferencia invisible a su alrededor que marca el límite de su influencia. El objeto que traspasa ese límite es atraído, irremisiblemente, la singularidad que lo engulle, sea una estrella, una nube de gas o cualquier otro objeto cósmico que ose traspasar la línea que se conoce como horizonte de sucesos del agujero negro.

La existencia de los agujeros negros fue deducida por Schwarzschild, en el año 1.916, a partir de las ecuaciones de Einstein de la relatividad general. Este astrónomo alemán predijo su existencia, pero el de agujero negro se debe a Johb Wheeler.

Señalamos la singularidad del Big Bang pero… ¿fue así?

Así, el conocimiento de la singularidad está dado por las matemáticas de Einstein y más tarde por la observación de las señales que la presencia del agujero generan. Es una fuente emisora de rayos X que se producen al engullir materia que traspasa el horizonte de sucesos y es atrapada la singularidad, donde desaparece siempre sumándose a la masa del agujero cada vez mayor.

En el centro de nuestra galaxia, la Vía Láctea, ha sido detectado un enorme agujero negro, ya muy famoso, llamado Cygnus X-1.

Después de todo, la velocidad de la luz, la máxima del universo, no vencer la fuerza de gravedad del aujero negro que la tiene confinada para siempre.

En nuestra galaxia, con cien mil años luz de diámetro y unos doscientos mil millones de estrellas, ¿cuántos agujeros negros habrá?

Para mí, la cosa está clara: el tiempo es imparable, el reloj cósmico sigue y sigue andando sin que nada lo pare, miles o cientos de miles, millones y millones de estrellas súper masivas explotarán en brillantes supernovas para convertirse en temibles agujeros negros.

Llegará un momento que el de agujeros negros en las galaxias será de tal magnitud que comenzarán a fusionarse unos con otros que todo el universo se convierta en un inmenso Agujero negro, una enorme singularidad, lo único que allí estará presente: la gravedad.

Esa fuerza de la naturaleza que está sola, no se puede juntar con las otras fuerzas que, como se ha dicho, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas estelares. Allí, a su alrededor, se aposenta curvando el espacio y distorsionando el tiempo.

Esa reunión final de agujeros negros será la causa de que la Densidad Crítica sea superior a la ideal. La gravedad generada por el inmenso agujero negro que se irá formando en cada galaxia tendrá la consecuencia de parar la expansión actual del universo. Todas las galaxias que ahora están separándose las unas de las otras se irán frenando parar y, despacio al principio pero más rápido después, comenzarán a recorrer el camino hacia atrás. Finalmente, toda la materia será encontrada en un punto común donde chocará violentamente formando una enorme bola de fuego, el Big Crunch, que como sabéis, es sólo una de las variadas teorías del final del universo.

Claro que, antes de que eso llegue, tendremos que resolver el primer problema: La visita de Andrómeda, la salida de la Tierra de la Zona habitable, o, la muerte del Sol que se convertirá en una gigante roja primero y en una nebulosa planetaria con una estrella enana blanca en el centro después.

Los científicos se han preguntado a veces qué sucederá eventualmente a los átomos de nuestros cuerpos mucho tiempo después de que hayamos muerto. La posibilidad más probable es que nuestras moléculas vuelvan al Sol. En páginas anteriores he explicado el destino del Sol: se agotará su combustible de hidrógeno y fusionará helio; se hinchará en gigante roja y su órbita es probable que sobrepase la Tierra y la calcine; las moléculas que hoy constituyen nuestros cuerpos serán consumidas por la atmósfera solar.

Carl Sagan pinta el cuadro siguiente:

“Dentro de miles de millones de años a partir de , habrá un último día perfecto en la Tierra… Las capas de hielo Ártica y Antártica se fundirán, inundando las costas del mundo. Las altas temperaturas oceánicas liberarán más vapor de agua al aire, incrementando la nubosidad y escondiendo a la Tierra de la luz solar retrasando el final. Pero la evolución solar es inexorable. Finalmente los océanos hervirán, la atmósfera se evaporará en el espacio y nuestro planeta será destruido por una catástrofe de proporciones que ni podemos imaginar.”

En una escala de tiempo de varios miles de millones de años, debemos enfrentarnos al hecho de que la Vía Láctea, en la que vivimos, morirá. Más exactamente, vivimos en el brazo espiral Orión de la Vía Láctea. miramos al cielo nocturno y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Aproximadamente a dos millones de años luz de la Vía Láctea está nuestra galaxia vecina más cercana, la gran galaxia Andrómeda, dos o tres veces mayor que nuestra galaxia. Las dos galaxias se están aproximando a unos 500 km/s, y chocarán en un periodo de entre 3 y 4 mil millones de años. Como ha dicho el astrónomo Lars Hernquist de la California en Santa Cruz, esta colisión será “parecida a un asalto. Nuestra galaxia será literalmente consumida y destruida“. Aunque, lo cierto es que aunque en el choque algo se detruya, lo cierto es que todo quedará en forma de una galaxia mucho mayor.

Así las cosas, no parece que la Humanidad del futuro lo tenga nada fácil. Primero tendrá que escapar, dentro de unos 4.000 millones de años del gigante rojo en que se convertirá el Sol que calcinará al planeta Tierra. Segundo, en unos 10.000 millones de años, la escapada tendrá que ser aún más lejana; la destrucción será de la propia galaxia que se fusionará con otra mayor sembrando el caos cósmico del que difícilmente se podría escapar quedándonos aquí. Por último, el final anunciado, aunque más largo tiempo, es el del propio universo que, por congelación o fuego, tiene los eones contados.

Por todas estas catástrofes anunciadas por la ciencia, científicos como Kip S. Thorne y Stephen Hawking sugieren a otros universos paralelos a través de agujeros de gusano en el hiperespacio. Sería la única puerta de salida para que la Humanidad no se destruyera.

Si lo alcanzaremos o no, es imposible de contestar, no tenemos los necesarios para ello. Incluso se podría decir que aparte de estas catástrofes futuras que sabemos a ciencia cierta que ocurrirán, seguramente existan otras que están ahí latentes en la incertidumbre de si finalmente ocurren o no, sólo pendiente de decidir lo uno o lo otro por parámetros ocultos que no sabemos ni que puedan existir.

En esta situación de impotencia, de incapacidad física e intelectual, nos tenemos que dar y admitir que, verdaderamente, comparados con el universo y las fuerzas que lo rigen, somos insignificantes, menos que una mota de polvo flotando en el haz de luz que entra, imparable, por la ventana entre-abierta de la habitación.

Sin embargo, tampoco es así. Que se sepa, no existe ningún otro grupo inteligente que esté capacitado tratar de todas estas cuestiones. Que la especie humana sea consciente de dónde vino y hacia dónde va, en verdad tiene bastante mérito, y más, si consideramos que nuestro origen está a partir de materia inerte evolucionada y compleja que, un día, hace probablemente miles de millones de años, se fraguó en estrellas muy lejanas.

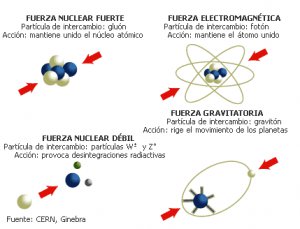

A finales de los 60, un joven físico italiano, Gabriele Veneziano, buscaba un grupo de ecuaciones que explicara la fuerza nuclear fuerte. Este pegamento tan fuerte que mantenía unidos los protones y neutrones del núcleo de cada átomo. Parece ser que por casualidad se encontró con un libro antiguo de matemáticas y en su interior encontró una ecuación de más de 200 años de antigüedad creada por un matemático suizo llamado Leonhard Euler. Veneziano descubrió con asombro que las ecuaciones de Euler, consideradas desde siempre una simple curiosidad matemática, parecían describir la fuerza nuclear fuerte. Después de un año de de profundos estudios, experimentos, intuición e imaginación, se podría decir que elaboraron la Teoría de Cuerdas de manera fortuita.

Tras circular entre compañeros, la ecuación de Euler acabó escrita frente a Leonard Susskind, quien se retiro a su ático para investigar. Creía que aquella antigua fórmula describía matemáticamente la fuerza nuclear fuerte, pero descubrió algo nuevo. Lo primero que descubrió fue que describía una especie de partícula con una estructura interna que vibraba y que mostraba un comportamiento que no se limitaba al de una partícula puntual. Dedujo que se trataba de una cuerda, un hilo elástico, como una goma cortada por la mitad. Esta cuerda se estiraba y contraía además de ondear y coincidía exactamente con la fórmula. Susskind redactó un artículo donde explicaba el descubrimiento de las cuerdas, pero nunca llegó a publicarse.

Muchos buscaron la 5ª dimensión… ¡sin fortuna! Aquí sólo hay tres y el espacio.

Claro que, ya he comentado otras veces que la teoría de cuerdas tiene un origen real en las ecuaciones de Einstein en las que se inspiro Kaluza para añadir la quinta dimensión y perfeccionó Klein (teoría Kaluza-Klein). La teoría de cuerdas surgió a partir de su descubrimiento accidental por Veneziano y , y a partir de ahí, la versión de más éxito es la creada por los físicos de Princeton David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm; ellos son conocidos en ese mundillo de la física teórica como “el cuarteto de cuerdas”. Ellos han propuesto la cuerda heterótica (híbrida) y están seguros de que la teoría de cuerdas resuelve el problema de “construir la propia materia a partir de la pura geometría: eso es lo que en cierto sentido hace la teoría de cuerdas, especialmente en su versión de cuerda heterótica, que es inherentemente una teoría de la gravedad en la que las partículas de materia, tanto las otras fuerzas de la naturaleza, emergen del mismo modo que la gravedad emerge de la geometría“.

La Gravedad cuántica está en algunas mentes , ¿Estará en la Naturaleza?

La característica más notable de la teoría de cuerdas ( ya he señalado), es que la teoría de la gravedad de Einstein está contenida automáticamente en ella. De hecho, el gravitón (el cuanto de gravedad) emerge como la vibración más pequeña de la cuerda cerrada, es más, si simplemente abandonamos la teoría de la gravedad de Einstein como una vibración de la cuerda, entonces la teoría se vuelve inconsistente e inútil. , de hecho, es la razón por la que Witten se sintió inicialmente atraído hacia la teoría de cuerdas.

Witten está plenamente convencido de que “todas las ideas realmente grandes en la física, están incluidas en la teoría de cuerdas“.

No entro aquí a describir el modelo de la teoría de cuerdas que está referido a la “cuerda heterótica”, ya que su complejidad y profundidad de detalles podría confundir al lector no iniciado. Sin embargo, parece justo que deje constancia de que consiste en una cuerda cerrada que tiene dos tipos de vibraciones, en el sentido de las agujas del reloj y en el sentido contrario, que son tratadas de diferente.

Las vibraciones en el sentido de las agujas de reloj viven en un espacio de diez dimensiones. Las vibraciones de sentido contrario viven en un espacio de veintiséis dimensiones, de las que dieciséis han sido compactificadas (recordemos que en la teoría pentadimensional Kaluza-Klein, la quinta dimensión se compactificaba curvándose en un circulo). La cuerda heterótica debe su al hecho de que las vibraciones en el sentido de las agujas de reloj y en el sentido contrario viven en dos dimensiones diferentes pero se combinan para producir una sola teoría de supercuerdas. Esta es la razón de que se denomine según la palabra griega heterosis, que significa “vigor híbrido”.

En conclusión, las simetrías que vemos a nuestro alrededor, el arcoiris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría decadimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

La teoría de cuerdas, a partir del descubrimiento Veneziano-Suzuki, estaba evolucionando atrás buscando las huellas de Faraday, Riemann, Maxwell y Einstein poder construir una teoría de campos de cuerdas. De hecho, toda la física de partículas estaba basada en teoría de campos. La única teoría no basada en teoría de campos era la teoría de cuerdas.

De la teoría de cuerdas combinada con la supersimetría dio lugar a la teoría de supercuerdas. La cuerda es un objeto unidimensional que en nueva teoría se utiliza remplazando la idea de la partícula puntual de la teoría cuántica de campos. La cuerda se utiliza en la teoría de partículas elementales y en cosmología y se representa por una línea o lazo (una cuerda cerrada). Los estados de una partícula pueden ser producidos por ondas estacionarias a lo largo de esta cuerda.

En teoría se trata de unificar a todas las fuerzas fundamentales incorporando simetría y en la que los objetos básicos son objetos unidimensionales que tienen una escala de 10-35 metros y, como distancias muy cortas están asociadas a energías muy altas, este caso la escala de energía requerida es del orden de 1019 GeV, que está muy por encima de la que hoy en día pueda alcanzar cualquier acelerador de partículas.

antes expliqué, las cuerdas asociadas con los bosones sólo son consistentes como teorías cuánticas en un espacio-tiempo de 26 dimensiones; aquella asociadas con los fermiones sólo lo son en un espacio tiempo de 10 dimensiones. Ya se ha explicado que las dimensiones extras, además de las normales que podemos constatar, tres de espacio y una de tiempo, como la teoría de Kaluza-Klein, están enrolladas en una distancia de Planck. De , inalcanzables.

Una de las características más atractivas de la teoría de supercuerdas es que dan lugar a partículas de espín 2, que son identificadas con los gravitones (las partículas que transportan la gravedad y que aún no se han podido localizar). Por tanto, una teoría de supercuerdas automáticamente contiene una teoría cuántica de la interacción gravitacional. Se piensa que las supercuerdas, al contrario que ocurre con otras teorías ( ellas el Modelo Estándar), están libres de infinitos que no pueden ser eliminados por renormalización, que plagan todos los intentos de construir una teoría cuántica de campos que incorpore la gravedad. Hay algunas evidencias de que la teoría de supercuerdas está libre de infinitos, pero se está a la búsqueda de la prueba definitiva.

Aunque no hay evidencia directa de las supercuerdas, algunas características de las supercuerdas son compatibles con los hechos experimentales observados en las partículas elementales, como la posibilidad de que las partículas no respeten paridad, lo que en efecto ocurre en las interacciones débiles.

Extrañas configuraciones a las que, algunos físicos le quieren sacar lo que seguramente no se encuentra en ellas

Estoy convencido de que la teoría de supercuerdas será finalmente corroborada por los hechos y, ello, se necesitará algún tiempo; no se puede aún comprobar ciertos parámetros teóricos que esas complejas matemáticas a las que llaman topología nos dicen que son así.

Habrá que tener siempre a mano las ecuaciones de Einstein, las funciones modulares de Ramanujan y el Supertensor métrico de ese genio matemático que, al igual que Ramanujan, fue un visionario llamado Riemann.

Las historias de estos dos personajes, en cierto modo, son muy parecidas. Tanto Riemann como Ramanujan murieron antes de cumplir los 40 años y, también en ambos casos, en difíciles. Estos personajes desarrollaron una actividad matemática sólo comparable al trabajo de toda la vida de muchos buenos matemáticos.

¿Cómo es posible que, para proteger la simetría conforme original por su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto de identidades matemáticas, que precisamente son las identidades de la función modular de Ramanujan?

En este he expresado que las leyes de la naturaleza se simplifican cuando se expresan en dimensiones más altas. Sin embargo, a la luz de la teoría cuántica, debo corregir algo esta afirmación, y para decirlo correctamente debería decir: las leyes de la naturaleza se simplifican cuando se expresan coherentemente en dimensiones más altas. Al añadir la palabra coherentemente hemos señalado un punto crucial. ligadura nos obliga a utilizar las funciones modulares de Ramanujan, que fijan en diez de dimensiones del espacio-tiempo. Esto a su vez, puede facilitarnos la clave decisiva para explicar el origen del universo.

emilio silvera

Mar

20

¿Sin la luz? ¡Sería otro Universo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

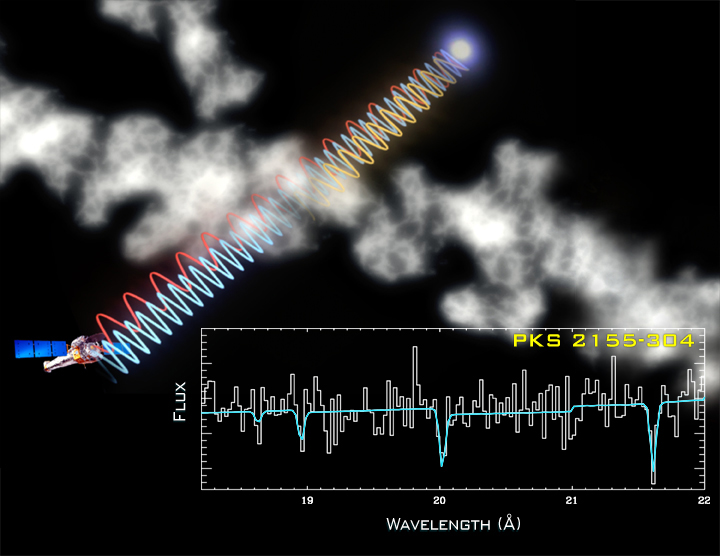

Nuestro Universo es de Luz, todo lo que podemos observar es posible gracias a la luz que incide en los objetos y se refleja en nuestras retinas, así podemos contemplar los planetas y las estrellas del cielo y cualquier coda que, hecha de materia boriónica, es decir, materia radiante, se deja ver por nosotros. Decía Leonard Susskind que, para comprender la realidad en sus niveles más elementales, basta con conocer el comportamiento de dos elementos: el electrón y el fotón.

Todo el argumento de la electrodinámica cuántica (QED) gira en torno a un proceso fundamental: la emisión de un único fotón por un único electrón.

Cuando el movimiento de un electrón es alterado súbitamente, puede responder desprendiendo un fotón. La emisión de un fotón es el suceso básico de la mecánica cuántica:

Toda la luz visible que vemos, así como las ondas de radio, la radiación infrarroja y los rayos X, está compuesta de fotones que han sido emitidos por electrones, ya sea en el Sol, el filamento de una bombilla, una antena de radio o un aparato de rayos.

Los electrones no son las únicas partículas que pueden emitir fotones. Cualquier partícula eléctricamente cargada puede hacerlo, incluido el protón. Esto significa que los fotones pueden saltar entre dos protones o incluso entre un protón y un electrón. Este hecho es de enorme importancia para toda la ciencia y la vida en general. El intercambio continuo de fotones entre el núcleo y los electrones atómicos proporciona la fuerza que mantiene unido al átomo. Sin estos fotones saltarines, el átomo se desharía y toda la materia dejaría de existir.

Mientras que un electrón pertenece al grupo de partículas llamadas fermiones, los fotones pertenecen a la familia de los bosones. Intentemos comprender esta película que es la existencia…

…protagonizada por bosones…

Los fermiones hacen posible la materia “al estilo tradicional”, mientras que los bosones son elementos muy raros desde la forma de pensar a que estamos acostumbrados el común de los mortales. Para no complicarnos, la tabla periódica de elementos existe porque los fermiones no pueden “ser iguales”: no pueden solaparse uno sobre otro y se repelen si los obligamos. Es lo que damos por hecho cuando hablamos de materia, que cada pedazo de ésta ocupa su lugar y tiene sus propias cualidades.

En cambio, los bosones carecen de este sentido de la individualidad, digamos que poseen “alma grupal” y, en su estado más puro, todos forman una misma “superpartícula”.

Para entenderlo mejor, conviene recordar que las partículas no son bolitas como nos siguen enseñando en la escuela, sino que más allá de esta imagen existen como ondas o, al menos, sus funciones se equiparan al comportamiento de una onda.

En la década de 1920, Albert Einstein y el hindú Satyendra Nath Bose pronosticaron un quinto estado de la materia: el condensado de Bose-Einstein (BEC), el cual fue conseguido en laboratorio en 1995, algo que le valió el premio Nobel de 2001 a los científicos que lo lograron.

Imagínese una taza de té caliente, las partículas que contiene circulan por toda la taza. Sin embargo cuando se enfría y queda en reposo, las partículas tienden a ir en reposo hacia el fondo. Análogamente, las partículas a temperatura ambiente se encuentran a muchos niveles diferentes de energía. Sin embargo, a muy bajas temperaturas, una gran proporción de éstas alcanza a la vez el nivel más bajo de energía, el estado fundamental. (Fuente: wikipedia)

Cuando ciertas formas de materia [bosones] se enfrían hasta casi el cero absoluto, sus átomos se ponen en el estado de energía más baja, de modo que todos sus átomos vibran al unísono y se hacen coherentes. Las funciones de onda de todos los átomos se solapan, de manera que, en cierto sentido, un BEC [condensado de Bose-Einstein] es como un “superátomo” gigante en donde todos los átomos individuales vibran al unísono.

Al enfriar los átomos, su velocidad disminuye hasta que las longitudes de onda de cada uno de ellos se vuelven casi planas, superponiéndose unas a otras para formar una única onda que los describe a todos.

Así que un BEC se forma cuando los átomos en un gas sufren la transición de comportarse como “bolas de billar” al estilo de la física clásica, a comportarse como una onda gigante de materia al estilo de mecánica cuántica:

Un BEC es un grupo de unos cuantos millones de átomos que se unen para formar una sola onda de materia de aproximadamente un milímetro de diámetro. Si creamos dos BECs y los colocamos juntos, no se mezclan como gases ordinarios ni rebotan como lo harían dos sólidos. Donde los dos BECs se superponen, ellos “interfieren” como las ondas: delgadas capas paralelas de materia son separadas por capas delgadas de espacio vacío. El patrón se forma porque las dos ondas se suman donde sus crestas coinciden, y se cancelan donde una cresta se encuentra con un valle — a lo cual llamamos interferencia “constructiva” y “destructiva” respectivamente. El efecto es similar al de dos ondas que se superponen cuando dos piedras son lanzadas a un lago.

(Fuente: ciencia NASA)

…ambientada en: el vacío…

El hecho de que se puedan intercambiar partículas virtuales modifica el vacío alrededor de los átomos, y esto lleva a una fuerza. De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Y ahora, retrocedamos un poco más en este asunto del misterio que nos ocupa. Gracias a la tecnología láser, la física ha podido comprobar el extremo poder de la luz. Los láseres pueden hacer que las partículas virtuales se vuelvan reales. Pero, primero, aclaremos conceptos…

Las “partículas virtuales” son partículas fundamentales que están constantemente surgiendo aparentemente de la nada y permanecen en el espacio-tiempo la friolera de una milésima de trillonésima de segundo –una cantidad que se forma poniendo una veintena de ceros a la derecha de la coma—. A pesar de denominarse “virtuales”, sus efectos son muy reales: la constante agitación de este burbujeo cuántico de partículas hace que el vacío tenga energía. Y esto es algo que afecta a la realidad, pues en ésta las fuerzas de atracción y repulsión dependen de la masa, y la masa no es sino energía expresada en unidades diferentes: E=mc².

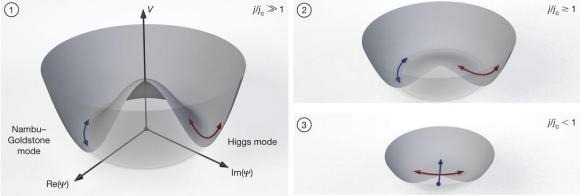

En el uso corriente la palabra vacío significa espacio vacío, espacio del que se ha extraído todo el aire, vapor de agua u otro material. Eso es también lo que significa para un físico experimental que trabaja con tubos de vacío y bombas de vacío. Pero para un físico teórico, el término vacío tiene muchas más connotaciones. Significa una especie de fondo en el que tiene lugar el resto de la física. El vacío representa un potencial para todas las cosas que pueden suceder en ese fondo. Significa una lista de todas las partículas elementales tanto como de las constantes de la Naturaleza que se pondrían de manifiesto mediante experimentos en dicho vacío. En resumen, significa un ambiente en el que las leyes de la física toman una forma particular. […] Un vacío diferente significa leyes de la física diferentes; cada punto en el paisaje representa un conjunto de leyes que son, con toda probabilidad, muy diferentes de las nuestras pero que son, en cualquier caso, posibilidades consistentes. El modelo estándar es meramente un punto en el paisaje de posibilidades.

… la energía del vacío es tomada como la base para la constante cosmológica. A nivel experimental, la energía del punto cero genera el efecto Casimir, … Se dice que:

La energía del vacío es, por tanto, la suma total de las energías de todas las partículas posibles. Es la llamada “energía oscura” que hace que el universo se expanda, haciendo frente a la atracción de la gravedad, y que proporciona alrededor del 80% de la materia-energía al universo –un 26% es “materia oscura”, y sólo un 4% es la materia conocida hasta el momento—.

Pero, ¿cómo una partícula virtual se convierte en real? Es decir, ¿cómo queda “atrapada” en el espacio-tiempo de forma más estable?

La teoría de cuerdas, también llamada de supercuerdas, pues la supersimetría es necesaria para incluir los quarks y otros fermiones, es una teoría …

La teoría de la supersimetría establece que, por cada partícula de materia, nace una gemela de antimateria. La antimateria es igual que la materia, pero con carga opuesta. Por ejemplo, el electrón tiene carga negativa, y su partícula de antimateria, el positrón, positiva. Materia y antimateria se aniquilan mutuamente pero, por algún motivo aún no aclarado, la simetría se rompió en algún momento, surgiendo más materia que antimateria, de ahí que nuestro universo, materia, pueda existir.

Pero hay algo más en todo esto. Y para ello, la luz es la clave.

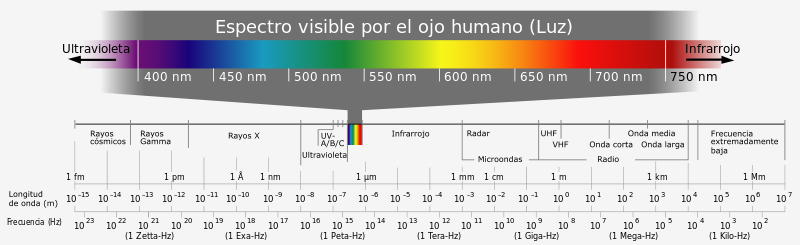

Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Pero veámos.

…starring “light” as itself…

Ya en los años 30, los físicos predijeron que un campo eléctrico muy fuerte, que no es sino un espacio alterado por la actividad de un montón de fotones coordinados, podría impulsar a las partículas virtuales con carga opuesta en diferentes direcciones, impidiendo que la materia y la antimateria se aniquilen.

Según el efecto de creación de pares, un fotón con energía suficiente, lo que equivale a tener el doble de la energía que posee un electrón en reposo, da lugar a una pareja de electrón y positrón. Aunque esto ya se consiguió en los años 90 a pequeña escala, gracias al desarrollo de la tecnología láser los científicos creen que estarán cerca de conseguir crear materia “en serie” mediante este proceso en unos pocos años. Por otra parte, una vez que existen las partículas, los fotones interactuan sin cesar con ellas, siendo absorbidos y emitidos por las mismas de manera ininterrumpida.Y de ello nace el movimiento gracias al cual todo existe en el espacio-tiempo. Sin movimiento, nuestra realidad desaparecería.

No se diferencia básicamente la obtención de un electrón-positrón, a la obtención de un protón-antiprotón, sino solamente en la energía del fotón, significa que son esencialmente lo mismo.

Así, si el fotón tiene suficiente energía, el par será electrón-positrón, caso contrario será un par virtual (absorción), si la energía del fotón fuere mayor, la diferencia estará dada por la velocidad opuesta de las antipartículas (masa de las antipartículas), correspondiente a la energía “sobrante” de acuerdo a E=mc2. Si la energía del fotón fuere suficiente, como para llegar al umbral mínimo, se creará un protón-antiprotón, y si fuere mayor, se manifestará en velocidad opuesta (masa de las antipartículas). La energía del fotón (cantidad de movimiento, efecto Compton) será la energía correspondiente al total de las dos antipartículas (masa, E=mc2)

La carencia de masa de un fotón está ligada a su movimiento. Para que un cuerpo alcance la velocidad de la luz, su masa ha de ser cero. Y, como Einstein explicó en su día, la luz se mueve siempre a la velocidad de la luz. Si pretendemos que un fotón se pare, en lugar de ralentizarse observaremos que desaparece. Y, como se ha dicho al principio, si estos “fotones saltarines” desaparecieran, toda la materia dejaría de existir.

Su esencia es el movimiento y su misión, según parece, hacer girar la rueda de la existencia.

Ello es así debido al impacto de los fotones sobre las partículas elementales. La energía transmitida por un fotón es inversamente proporcional a su longitud de onda. Cuanto menos longitud de onda, más energía. Así, un fotón de luz visible tiene la energía suficiente para hacer reaccionar a un bastón de la retina. Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Más allá, los rayos gamma pueden romper protones y neutrones…

Cuando la tensión llega a un punto insostenible la corteza de neutrones revienta en un temblor estelar, dejando escapar rayos gamma y rayos X. En una potencia descomunal capaz de destruir otras particulas cuando interaccionan.

Y ahora, vayamos al meollo de la cuestión e indaguemos en la cita con que se iniciaba este artículo: ¿qué hace que los electrones absorban y emitan fotones? Esto, en otros términos, vendría a ser lo mismo que preguntarnos: ¿por qué existe nuestro universo?

…con un misterio: el 137…

¿Qué determina el momento exacto en que un electrón emite un fotón? La física cuántica dice que nada lo hace, pues la Naturaleza es caprichosa en sus niveles más elementales. Aunque no es caótica en extremo, sólo probabilística.

A diferencia de la física newtoniana, la mecánica cuántica nunca predice el futuro en función del pasado. En su lugar, ofrece reglas muy precisas para computar la probabilidad de varios resultados alternativos de un experimento.

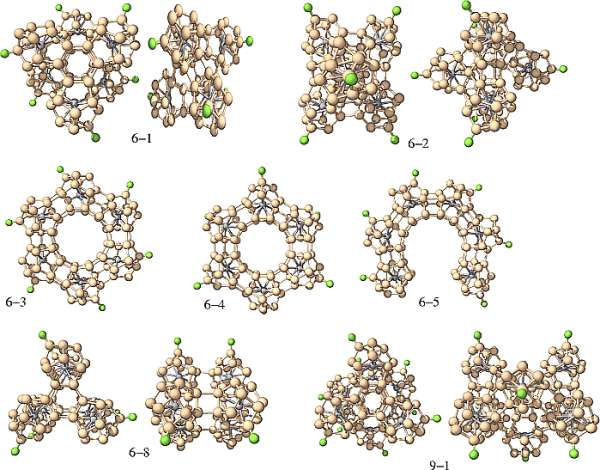

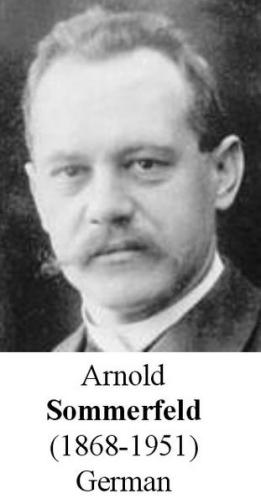

La constante de estructura fina fue introducida en la física en 1916 por Arnol Sommerfeld, como una medida relativista de las desviaciones en las lineas espectrales atómicas de las predicciones hechas por el modelo de Bohr.

Históricamente, la primera interpretación física de la constante de estructura fina,  , fue el cociente de la velocidad del electrón en la primera órbita circular del átomo de Bohr relativista con la velocidad de la luz en el vacío. De igual forma, era el cociente entre el momento angular mínimo permitido por la relatividad para una órbita cerrada bajo fuerza electromagnética y el momento angular mínimo permitido por la mecánica cuántica. Aparece de forma natural en el análisis de Sommerfeld y determina el tamaño de la separación o estructura fina de las lineas espectrales del hidrógeno.

, fue el cociente de la velocidad del electrón en la primera órbita circular del átomo de Bohr relativista con la velocidad de la luz en el vacío. De igual forma, era el cociente entre el momento angular mínimo permitido por la relatividad para una órbita cerrada bajo fuerza electromagnética y el momento angular mínimo permitido por la mecánica cuántica. Aparece de forma natural en el análisis de Sommerfeld y determina el tamaño de la separación o estructura fina de las lineas espectrales del hidrógeno.

La QED predice una relación entre el momento magnético sin dimensiones del electrón (o el g-factor de Lande,  ) y la constante de estructura fina

) y la constante de estructura fina  . Una nueva medida de

. Una nueva medida de  usando un ciclotrón cuántico de un electrón, junto con un cálculo QED que involucra 891diagrama de Feynman, determina el valor actual más preciso de

usando un ciclotrón cuántico de un electrón, junto con un cálculo QED que involucra 891diagrama de Feynman, determina el valor actual más preciso de  :

:

esto es, una medida con una precisión de 0.70 partes por mil millones. Las incertidumbres son 10 veces más pequeñas que aquellas de los métodos rivales más próximos. Las comparaciones de los valores medidos y los calculados de  suponen un test muy fuerte de QED, y ponen un límite para cualquier estructura interna del electrón posible.

suponen un test muy fuerte de QED, y ponen un límite para cualquier estructura interna del electrón posible.

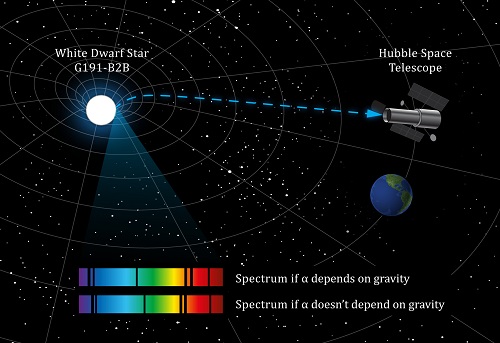

En 2010, el científico John Webb publicó un estudio en el que revelaba datos que afirmaban que la constante no era igual en todo el universo y que se observaban cambios graduales en torno a un eje concreto de éste.

Algunos científicos sostienen que las constantes de la naturaleza no sean en realidad constantes, y la constante de estructura fina no escapa a estas afirmaciones.

Físicos de la University of New Wales (UNSW) tienen una teoría cuando menos controvertida, y es la de que la constante de estructura fina, α (alpha), en realidad no es constante. Y estudian los alrededores de una enana blanca lejana, con una gravedad más de 30.000 veces mayor que la de la tierra, para comprobar su hipótesis.

Recientemente, la detección de los mapas de enlace-dimensional de la constante de estructura fina

Y la probabilidad de que un electrón emita o absorba un fotón es la constante de estructura fina. El valor de esa constante es 1/137.

En otras palabras, sólo un afortunado electrón de cada 137 emite un fotón. Este es el significado de alfa: es la probabilidad de que un electrón, cuando se mueve a lo largo de su trayectoria, emita caprichosamente un fotón.

El inverso de la constante de estructura fina es 137. Desde su descubrimiento, éste número ha traído de cabeza a los grandes científicos.

Fue Richard Feynman, precisamente, quien sugirió que todos los físicos pusiesen un cartel en sus despachos o en sus casas que les recordara cuánto es lo que no sabemos. En el cartel no pondría nada más que esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina. Este número guarda relación con la probabilidad de que un electrón emita o absorba un fotón. La constante de estructura fina responde también al nombre de alfa, y sale de dividir el cuadrado de la carga del electrón por el producto de la velocidad de la luz y la constante de Planck. Tanta palabra no significa otra cosa sino que ese solo número, 137, encierra los meollos del electromagnetismo (el electrón), la relatividad (la velocidad de la luz) y la teoría cuántica (la constante de Planck). Menos perturbador sería que la relación entre todos estos importantes conceptos hubiera resultado ser un uno o un tres o quizás un múltiplo de pi. Pero ¿137?

“Lo más notable de este notable número es su adimensionalidad. La velocidad de la luz es de unos 300.000 kilómetros por segundo. Abraham Lincoln medía 1,98 metros. La mayoría de los números vienen con dimensiones. Pero resulta que cuando uno combina las magnitudes que componen alfa, ¡se borran todas las unidades! El 137 está solo: se exhibe desnudo a donde va. Esto quiere decir que a los científicos de Marte, o a los del decimocuarto planeta de la estrella Sirio, aunque usen Dios sabe qué unidades para la carga y la velocidad y qué versión de la constante de Planck, también les saldrá 137. Es un número puro.”

(Leon Ledderman, La partícula divina)

Uno de los padres de la mecánica cuántica, Wolfgang Pauli, se obsesionó tanto con este número que dijo que, de poder hacerle una pregunta a Dios, sería esta: “¿Por qué 137?”

Gracias a su gran amistad con Carl G. Jung, Pauli conoció el mundo “alternativo” de los estudios sobre la psique y accedió a la tradición esotérica que ha acompañado al hombre desde el principio de los tiempos. Es así como supo que 137 se aproxima al valor correspondiente al ángulo áureo. Esto es, la versión circular del número áureo o φ (phi).