Mar

11

Sarah Brightman cantará en el espacio

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

Es imposible determinar el origen de tal decisión, y, sobre todo, qué fin puede tener el querer hacer semejante cosa. Ya ha demostrado de manera sobrada su valía en su verdadero lugar, los escenarios de todo el mundo. Cada cual es libre de gastar su dinero como mejor le plazca. Sin embargo, creo que hay otros destinos que serían mejores que éste. Dicen que el viaje le cuesta unos 50 millones de euros, y, por esa cantidad, se podrían hacer… ¡Tántas cosas buenas!

Amiga mía, si pudiera hacerte llegar un mensaje, simplemente te diría: ¡Zapatero a tus zapatos!

Lo que tenías que demostrar ya lo hiciste y, eres la cantante que más discos ha vendido en el mundo, tienes admiradores por millones y, has triunfado en lo que te gustaba, la música en sus distintas versiones que dominas a la perfección.

¡Quedaté en casita! Hay cosas que mejor dejarlas para los expertos, y, el Espacio, es una de ellas.

emilio silvera

Mar

11

El mundo, los pensamientos y nosotros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Los Pensamientos ~

Clasificado en Los Pensamientos ~

Comments (1)

Comments (1)

Habiendo sido un curioso de todo lo relacionado con la vida, siempre me llamó la atención los comienzos y la evolución que en la misma se produce en los distintos seres vivos que hemos llegado a “conocer”, y, me ha picado la curiosidad que, en nosotros, los humanos, cuando llegamos a una cierta edad, nuestra mente rememora más los hechos del pasado que aquellos que se podrían producir en el futuro, y, tal hecho cierto, nos habla de una especie de decadencia en la que, el ser humano (no siempre consciente), ve como se acerca su final y, de forma intuitiva, regresa a su pasado para repasar su vida, ya que, de alguna manera sabe que lo que le queda por vivir no será mucho y, el futuro, será el futuro de otros y no el suyo, de ahí su falta de interés por él. Se llega a ser consciewnte de que lo pasado es todo lo que tenemos y a eso, no podremos añadir mucho más. Nuestro Tiempo está de paso.

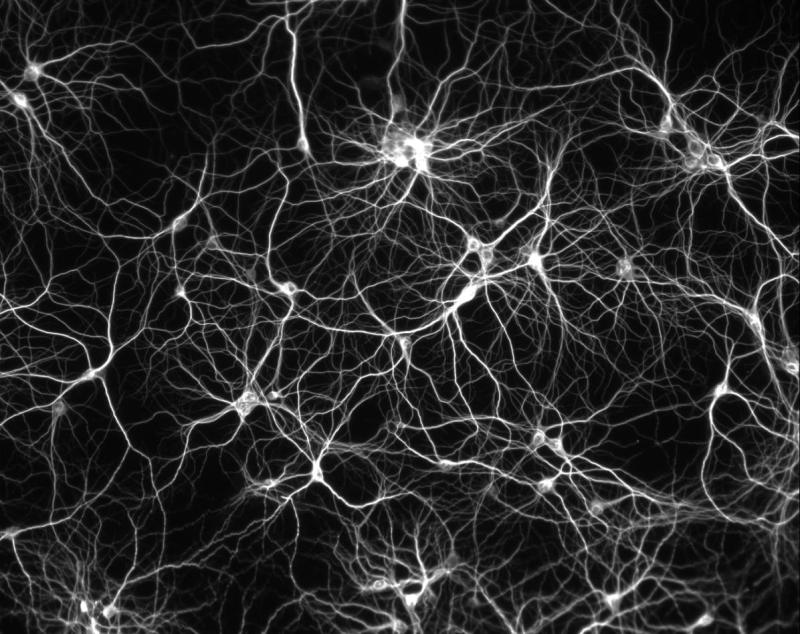

Nuestra estrategia para explicar la base neuronal de la conciencia consiste en centrarse en las propiedades más generales de la experiencia consciente, es decir, aquella que todos los estados conscientes comparte. De estas propiedades, una de las más importantes es la integración o unidad. La integración se rfiere a que el sujeto de la experiencia no puede en ningún momento dividir un estado consciente en una serie de componentes independientes. Es una propiedad que está relacionada con nuestra incapacidad para hacer conscientemente dos cosas al mismo tiempo, como, por ejemplo relacionar en un papel todas las familias de partículas que conocemos mientras que, al mismo tiempo, se mantiene una discusión sobre los agujeros negros.

No fue nada fácil llegar a este conocimiento

Aplicando la atención hemos llegado a saber que, el electrón tiene una masa en reposo (me) de 9, 109 3897 (54) x 10-31 kg y una carga negativa de 1,602 177 33(49) x 10-19 culombios. Esa realidad, aunque vinieran los sabios físicos de un planeta habitable situado en la estrella Resplandor de una Galaxia muy lejana, cuando hicieran los cálculos matemáticos y los experimentos necesarios, las cifras seguirían siendo las mismas, toda vez que, al tratarse de constantes fundamentales, ni la masa ni la carga pueden tener otra realidad distinta sea cual fuere el observador. Esto nos quiere decir que, hay realidades que nunca varian y, eso, nos puede traer alguna esperanza de que, alguna vez, podríamos conocer el Universo, tal como es.

Esta sí es una realidad, sin ella, el mundo no sería tal como lo conocemos. Sin la presencia de la luz…¿qué universo sería el nuestro?

Sin embargo, no podemos negar nuestras limitaciones tanto de percepción como intelectuales para reconocer “el mundo” tal como es. Es “nuestro mundo” que, cuando sea visitado por “otros”, pudiera ser otro mundo distinto al que nosotros percibimos y, podrían “ver” cosas que nosotros no vemos.

Vivímos en nuestra propia realidad, la que forja nuestras mentes a través de los sentidos y la experiencia. Incluso entre nosotrosm mismos, los seres de la misma especie, no percibimos de la misma manera las mismas cosas. Sí, muchos podemos coincidir en la percepción de algo, sin embargo, otros muchos diferirán de nuestra percepción y tendrán la suya propia. Esa prueba se ha realizado y la diversidad estuvo presente. Y, si tenemos en cuenta que somos ya más de siete mil mentes…la diversidad está servida.

Mi enorme interés y afición por estos temas de la ciencia me llevó a crear una Asociación Cultural de Física y Astronomía, estándo empeñado en celebrar reuniones periódicas en las que podamos hablar de todos estos temas. No se encuentra mucho apoyo oficial en este sentido. La divulgación de la ciencia está desdeñada y parece que no interesa que la gente sepa. Pero sigamos con el trabajo que aquí se presenta.

No, no será nada fácil despejar las incognitas presentes en esta inmensa complejidad que llamamos Mente. Creo de manera firme que, finalmente, todo se traduce a Química y Luz. Energías de velocidades alucinantes que recorren el enmarañado entramado de neuronas y que hace posible todas y cada una de las maravillas que “real”mente se producen en nosotros y que no siempre sabemos traducir ni comprender.

Einstein decía: “La mente que se abre a una idea, jamás volverá alñ tamaño original”

Es tan grande el poder de nuestra mente que nada hay tan distante que no podamos, virtualmente hablando, traer ante nosotros. Somos capaces ya de escrutar el espacio y vislumbrar los confines del universo en edades muy cercanas a su nacimiento y, merced a los microscopios, nos acercamos al universo atómico para explorar los componentes de la materia. Parece que nada podrá (con el tiempo) escapar a nuestro control, con lo que todo nuevo “mundo” se revelará a nuestro entendimiento.

Nunca estamos satisfechos de los logros alcanzados (menos mal) y siempre surgirán seres especiales (Copérnico, Kepler, Galileo, Hooke, Newton…) que nos guiarán por el camino iluminado de su genio para mostrarnos la auténtica sabiduría mediante un pensamiento evolutivo que siempre dará un paso adelante, superando así el pensamiento nuevo al anterior. Pero, eso sí, esos avances han sido posible gracias a que hombres y mujeres pensaron con la lógica pero…, nunca dejaron de lado la imaginación.

La prueba de ello la podemos encontrar en Newton y Einstein. ¿Quién puede dudar de la grandeza de Newton? La pregunta está contestada de antemano. Sin embargo, los ejemplos de la historia son muy elocuentes: Newton con su física, Leibniz con su metafísica, con sus principios filosóficos como el de la razón suficiente. Y la física ganó a la metafísica; Newton a Leibniz.

Durante mucho tiempo, espacio y tiempo se entendieron como entes absolutos, hasta que llegó Einstein con sus dos teorías de la relatividad, la especial y la general, y aunque los caminos que siguió para conseguirlos no fueron metafísicos, no podemos negar la intervención de un genio de inspiración superior que a veces, nos puede llevar a pensar que, en algún sentido, finalmente Leibniz había sido el más acertado, ya que las teorías einstenianas pueden ser clasificadas dentro de un orden del pensamiento superior.

Así, la evolución continuó su camino imparable y el espacio y el tiempo absolutos de Newton, resultaron ser menos absolutos de lo que se pensaba; eran relativos y, además, eran una misma cosa, que a partir de ahí pasó a llamarse espacio-tiempo unidos y no separados. Así fue deducido por Minkouski al leer la teoría de Einstein.

Laplace

Quiero mencionar en este punto a dos grandes newtonianos: Lagrange y Laplace. La obra de Newton, como todas las grandes obras, fue discutida y sometida a estudios rigurosos, analizada y removida. La ciencia del genio, claro, permaneció al margen de todas las críticas para dejar de ser discutida y pasar a ser desarrollada. Así ha resultado ser la Historia.

Recordemos en este sentido la cumbre de la física y de las matemáticas del siglo XVIII que es la Méchanique analytique (Chez la Veuve Desaint, París 1788), de Joseph-Louis Lagrange (1736 – 1813), un íntimo amigo de d’Alembert, en la que la mecánica de Newton alcanzó un nuevo nivel de pureza al reducir el sistema a un conjunto de fórmulas generales de las que se podían deducir todas las expresiones necesarias para resolver un problema. O los cinco tomos del Traité de mécanique céleste (Crapelet para J. B. M. Duprat, París 1799 – 1827) de Pierre-Simón Laplace (1749 – 1827), en los que se erradican numerosas anomalías de las explicaciones originales de Newton sobre los movimientos de los cuerpos celestes.

El testo de Laplace, al igual que el de Lagrange, era de difícil lectura para legos en las ciencias matemáticas, y tal complejidad dio lugar a versiones posteriores más sencillas para el entendimiento general, que finalmente hizo posible divulgar los enormes conocimientos alcanzados a partir de Newton, gracias a estos dos genios.

Sí, se vislumbra, a lo lejos, una esplendorada luz que, sin embargo, tiene en todo su centro un signo de interrogación que viene a significar lo que no sabemos. Es mucho lo que nos queda por descubrir y, hombres que, como Newton, Lagrange y Laplace y después Planck, Maxwell y Einstein nos han dejado un camino que seguir, sin embargo, no estamos situados aún en esa zona luminosa del saber sino que…

Un respiro en el camino:

- El ignorante, teme o adora lo que no comprende.

- Los ingratos acaban por disuadir a los virtuosos de poner en prácticas sus bondades.

- Amigo leal y franco, mirlo blanco.

Esto me recuerda aquella aseveración atribuida indistintamente a Séneca y Aristóteles:

“¡Oh, amigos míos, no hay ningún amigo!”

Hay otra que nos da a entender que los amigos egoístas y poco dispuestos a prestarnos su ayuda, en momentos necesarios son inútiles y no importa, pues, prescindir de ellos:

“Amigo que no presta y cuchillo que no corta,

que se pierdan poco importa.”

¡Esto de los amigos! Hay otra que dice:

“El que tiene un amigo, tiene un tesoro.

El que tiene un tesoro, tiene muchos ‘amigos’.”

“Si un amigo se comporta como la sombra que,

cuando luce el Sol nos abandona, no era un amigo.”

Pero volvamos al trabajo y continuemos repasando cosas interesantes y viajemos hasta el siglo XIX, que fue vital para la ciencia. Aunque la ciencia ya había mostrado para entonces su capacidad única para estudiar qué sucede en la naturaleza y qué principio (o leyes) la gobiernan, y contaba por entonces con una larga lista de teorías, datos y héroes científicos, no se había convertido todavía en una gran empresa, en la “profesión” que terminaría siendo.

La “profesionalización” e “institución” de la ciencia, entendiendo por tal que la práctica de la investigación científica se convirtiese en una profesión cada vez más abierta a personas sin medios económicos propios, que se ganaban la vida a través de la ciencia y que llegasen a atraer la atención de gobiernos e industrias, tuvo su explosión a lo largo de 1800, y muy especialmente gracias al desarrollo de dos disciplinas, la química orgánica y el electromagnetismo. Estas disciplinas, junto a las matemáticas, la biología y las ciencias naturales (sin las cuales sería una necedad pretender que se entiende la naturaleza, pero con menos repercusiones socio-económicas), experimentaron un gran desarrollo entonces, tanto en nuevas ideas como en el número de científicos importantes: Faraday, Maxwell, Lyell, Darwin y Pasteur, son un ejemplo. Sin olvidar a otros como Mendel, Helmholtz, Koch, Virchow, Lister o Kelvin, o la matemática de Cauchy, de Gauss, Galois, Fourier, Lobachevski, Riemann, Klein, Cantor, Russell, Hilbert o Poincaré. Pero vamos a pararnos un momento en Faraday y Maxwell.

Para la electricidad, magnetismo y óptica, fenómenos conocidos desde la antigüedad, no hubo mejor época que el siglo XIX. El núcleo principal de los avances que se produjeron en esa rama de la física (de los que tanto se benefició la sociedad –comunicaciones telegráficas, iluminación, tranvías y metros, etc.–) se encuentra en que, frente a lo que se suponía con anterioridad, se descubrió que la electricidad y el magnetismo no eran fenómenos separados.

El punto de partida para llegar a este resultado crucial fue el descubrimiento realizado en 1.820 por el danés Hans Christian Oersted (1777 – 1851) de que la electricidad produce efectos magnéticos: observó que una corriente eléctrica desvía una aguja imanada. La noticia del hallazgo del profesor danés se difundió rápidamente, y en París André-Marie Ampère (1775 – 1836) demostró experimentalmente que dos hilos paralelos por los que circulan corrientes eléctricas de igual sentido, se atraen, repeliéndose en el caso de que los sentidos sean opuestos.

Poco después, Ampère avanzaba la expresión matemática que representaba aquellas fuerzas. Su propósito era dar una teoría de la electricidad sin más que introducir esa fuerza (para él “a distancia”).

Pero el mundo de la electricidad y el magnetismo resultó ser demasiado complejo como para que se pudiera simplificar en un gráfico sencillo, como se encargó de demostrar uno de los grandes nombres de la historia de la ciencia: Michael Faraday (1791 – 1867), un aprendiz de encuadernador que ascendió de ayudante de Humphry Davy (1778 – 1829) en la Royal Intitution londinense.

En 1821, poco después de saber de los trabajos de Oersted, Faraday, que también dejó su impronta en la química, demostró que un hilo por el que pasaba una corriente eléctrica podía girar de manera continua alrededor de un imán, con lo que vio que era posible obtener efectos mecánicos (movimiento) de una corriente que interacciona con un imán. Sin pretenderlo, había sentado el principio del motor eléctrico, cuyo primer prototipo sería construido en 1.831 por el físico estadounidense Joseph Henry (1797 – 1878).

Los campos magnéticos están presentes por todo el Universo. Hasta un diminuto (no por ello menos importante) electrón, crea, con su oscilación, su propio campo magnético, y, aunque pequeño, se le supone un tamaño no nulo con un radio ro, llamado el radio clásico del electrón, dado por r0 = e2/(mc2) = 2,82 x 10-13 cm, donde e y m son la carga y la masa, respectivamente del electrón y c es la velocidad de la luz.

Lo que le interesaba a Faraday no eran necesariamente las aplicaciones prácticas, sino principalmente los principios que gobiernan el comportamiento de la naturaleza, y en particular las relaciones mutuas entre fuerzas, de entrada, diferentes. En este sentido, dio otro paso importante al descubrir, en 1.831, la inducción electromagnética, un fenómeno que liga en general los movimientos mecánicos y el magnetismo con la producción de corriente eléctrica.

Este fenómeno, que llevaría a la dinamo, representaba el efecto recíproco al descubierto por Oersted; ahora el magnetismo producía electricidad , lo que reforzó la idea de que un lugar de hablar de electricidad y magnetismo como entes separados, sería más preciso referirse al electromagnetismo.

La intuición natural y la habilidad experimental de Faraday hicieron avanzar enormemente el estudio de todos los fenómenos electromagnéticos. De él es, precisamente, el concepto de campo que tanto juego ha dado a la física.

Sin embargo, para desarrollar una teoría consistente del electromagnetismo se necesitaba un científico distinto: Faraday era hábil experimentador con enorme intuición, pero no sabía expresar matemáticamente lo que descubría, y se limitaba a contarlo. No hubo que esperar mucho, ni salir de Gran Bretaña para que un científico adecuado, un escocés de nombre James Clerk Maxwell (1831 – 1879), hiciera acto de presencia.

Maxwell

Maxwell desarrolló las matemáticas para expresar una teoría del magnetismo-electricidad (o al revés) que sentó las bases físicas de aquel fenómeno y contestaba a todas las preguntas de los dos aspectos de aquella misma cosa, el electromagnetismo. En sus ecuaciones vectoriales estaban todos los experimentos de Faraday, que le escribió una carta pidiéndole que le explicara, con palabras sencillas, aquellos números y letras que no podía entender.

Pero además, Maxwell también contribuyó a la física estadística y fue el primer director del Laboratorio Cavendish, unido de manera indisoluble a la física de los siglos XIX y XX (y también al de biología molecular) con sede en Cambridge.

Su conjunto de ecuaciones de, o en, derivadas parciales rigen el comportamiento de un medio (el campo electromagnético) que él supuso “transportaba” las fuerzas eléctricas y magnéticas; ecuaciones que hoy se denominan “de Maxwell”. Con su teoría de campo electromagnético, o electrodinámica, Maxwell logró, además, unir electricidad, magnetismo y óptica. Las dos primeras, como manifestaciones de un mismo substrato físico, electromagnético, que se comporta como una onda, y la luz, que es ella misma, una onda electromagnética, lo que, en su tiempo, resultó sorprendente.

Más de ciento treinta años después, todavía se podía o se puede apreciar la excitación que sintió Maxwell cuando escribió en el artículo Sobre las líneas físicas de la fuerza, 1.861 – 62, en el que presentó esta idea: “Difícilmente podemos evitar la inferencia de que la luz consiste de ondulaciones transversales del mismo medio que es la causa de los fenómenos eléctricos y magnéticos.”

Todo aquello fue posible gracias a las bases sentadas por otros y a los trabajos de Faraday como experimentador infatigable, que publicaba sus resultados en artículos y los divulgaba en conferencias en la sede de la Royal Institution londinense. Todos estos artículos y conferencias fueron finalmente publicados en el libro que llamaron Philosophical transactions de la Royal Society, y Experimental researches in chemistry and physics (Richard Taylor y William Francis, Londres, 1.859; dos grandes científicos unidos por la historia de la ciencia que nos abrieron puertas cerradas que nos dejaron entrar al futuro).

No quiero seguir por este camino de personajes y sus obras ya que están enmarcados y recogidos en mi anterior libreta (primera parte de personajes), así que desviaré mis pensamientos hacia otras diversas cuestiones de mi interés, y espero que también del vuestro. Antes dejaba la reseña de algún refrán o pensamiento sobre la amistad, y en realidad también podemos ver la cara amable de esta forma de sentimiento-aprecio-amor que llamamos amistad.

Nosotros, los seres humanos, nunca vemos a nuestros semejantes como objetos o cuerpos neutros, sino que los miramos como personas con una riqueza interior que refleja su estado de ánimo o forma de ser, y de cada uno de ellos nos llegan vibraciones que, sin poderlo evitar, nos transmiten atracción o rechazo (nos caen bien o nos caen mal).

¿Cuánto nos dice una simple mirada? Cada uno de nosotros lleva dentro un ser “superior” ¿Sabrás sacar el tuyo al exterior, y, que los demás lo vean? El ser humano es esencialmente un animal social y, partiendo de ese principio, no es bueno que esté sólo. El pintor necesita exhibir sus cuadros, el novelista que lo lo lean, el filósofo exponer sus ideas para que sean debatidas, el Astónomo nos cuenta cosas del Universo y, entre todos, conformamos el mundo de las ideas.

Son muchos y diversos los signos sensoriales que, en silencio, nos llegan de los demás y son recogidos por nuestros sensores en una enorme gama de mensajes sensitivos que llamamos indistintamente simpatía, pasión, antipatía, odio, etc.

Está claro que cuando el sentimiento percibido es positivo, la satisfacción se produce por el mero hecho de estar junto a la persona que nos lo transmite, que con su sola presencia, nos está ofreciendo un regalo, y si apuramos mucho, a veces lo podríamos llamar incluso “alimento del alma”. Estar junto a quien nos agrada es siempre muy reconfortante, y según el grado de afinidad, amistad o amor, el sentimiento alcanzará un nivel de distinto valor.

Caigo en la cuenta de que, además de la materia, el espaciotiempo, y las fuerzas de la Naturaleza, aquí existe algo más que, está dentro de nuestras mentes y que, de momento, no podemos comprender. Sin embargo, si podemos sentir los sentimientos o la satisfacción que nos produce el el querer y poder amar, aprender y descubrir.

¡La Humanidad! ¿Quién la entiende?

emilio silvera

Mar

11

¿Que se habrá conseguido en el 3.050?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡Viajar en el Tiempo! ¿Podremos? ~

Clasificado en ¡Viajar en el Tiempo! ¿Podremos? ~

Comments (0)

Comments (0)

¿Viajar en el tiempo?

Me hace “gracia” ver como mucha gente, incluso científicos, se atreven a dar su opinión sobre cuestiones que no conocen. Y, desde luego, la pregunta del título que arriba pongo, es retórica, ya que, de ninguna manera podríamos contestarla. Nadie sabe lo que habrá pasado dentro de 1.000 años, y, por eso, al no poder explicarlo, me quedo con otros comentarios más sencillos que nos hablan de viajar en el tiempo y otras cuestiones que, ahora, más o menos, sí podemos vislumbrar.

La mayoría de los científicos que no han estudiado seriamente las ecuaciones de Einstein, desprecian el viaje en el tiempo como una “tonteria”, algo que sólo es aplicable a relatos sensacionalistas e historias fantásticas. Sin embargo, la situación que realmente nos encontramos es bastante compleja. Hasta tal punto es así que, resultaría arriesgado negar, de manera rotunda, la posibilidad de hacer o conseguir plasmar en realidad alguna idea derivada de profundos pensamientos como los que Einstein nos dejó y que subyacen en sus ecuaciones.

Para resolver la cuestión debemos abandonar la teoría más sencilla de la relatividad especial, que prohíbe el viaje en el tiempo, y adoptar toda la potencia de la teoría de la relatividad general, que puede permitirlo. La relatividad general tiene una validez mucho más amplia que la relatividad especial. Mientras que la relatividad especial sólo describe objetos que se mueven a velocidad constante muy lejos de cualquier estrella, la teoría de la relatividad general es mucho más potente, capaz de describir cohetes que se aceleran cerca de estrellas supermasivas y agujeros negros. La teoría general sustituye así algunas de las conclusiones más simples de la teoría especial.Para cualquier físico que haya analizado seriamente las matemáticas del viaje en el tiempo dentro de la teoría de la relatividad general de Einstein, la conclusión final, de forma bastante sorprendente, no está ni mucho menos clara.

Aquellos viajes en el tiempo que nos llevaban hacia el futuro…Según las ecuaciones de Einstein, podrían ser posibles pero…

Kip S. Thorne, un físico especialista en relatividad general y agujeros negros mundialmente conocido, cree que los viajes en el tiempo serán posibles algún día a través de los agujeros de gusano y utilizando para ello materia exótica, que mantendría abierta las bocas del agujero que nos llevaría a través del hiperespacio a otros lugares lejanos del universo.

Los defensores del viaje en el tiempo señalan que las ecuaciones de Einstein de la relatividad general permiten ciertas formas de viaje en el tiempo. Admiten, sin embargo, que las energías necesarias para doblar el tiempo en un círculo son tan grandes que las ecuaciones de Einstein ya no serían válidas. En la región físicamente interesante en la que el viaje en el tiempo se convierte en una posibilidad seria, la teoría cuántica dominaría sobre la relatividad general.

Recordemos que las ecuaciones de Einstein establecen que la curvatura del espacio y el tiempo están determinadas por el contenido de materia-energía del universo. Es posible, de hecho, encontrar configuraciones de materia-energía suficientemente poderosas para forzar la curvatura del tiempo y permitir el viaje en el tiempo. Sin embargo, las concentraciones de materia-energía para doblar el tiempo hacia atrás son tan enormes que la relatividad general deja de ser válida y las correcciones cuánticas empiezan a dominar sobre la relatividad. Así pues, el viaje en el tiempo requiere un veredicto final que no puede ser pronunciado a través de las ecuaciones de Einstein, que dejan de ser válidas en los campos gravitatorios extraordinariamente grandes, donde esperamos que la teoría cuántica de la gravedad se haga dominante.

No parece que los viajes en el tiempo hacia el pasado tengan mucha viabilidad, el tiempo pasado ya no está y, además, allí no existían las máquinas del tiempo, lo cual, aunque no lo parezca, es un parámetro esencial para poder realizar ese viaje. Podríamos ir al pasado sólo a partir de ese momento en que tengamos la tecnología necesaria para fabricar ese “maravilloso artefacto” que nos pueda llevar hacia lo que fue.

Aquí es donde la teoría del hiperespacio puede zanjar la cuestión.Puesto que la teoría cuántica y la teoría de la gravedad de Einstein están unidas en el espacio decadimensional, esperamos que la cuestión del viaje en el tiempo será establecida definitivamente por la teoría del hiperespacio. Como en el caso de los agujeros de gusano y las ventanas dimensionales, el capítulo final se escribirá cuando incorporemos toda la potencia de la teoría del hiperespacio.

De todas las maneras y desde todos los ángulos que lo podamos mirar, si algún día las máquinas del tiempo son posibles, el peligro estaría servido.¿Quién sería el encargado de controlar su uso? ¿Quién se encargaría de controlar al encargado? y así podríamos seguir indefinidamente, tal es el volumen de gravedad del problema que generaría la existencia de máquinas del tiempo para viajar hacia atrás o hacia delante.

El caos y los estragos rasgarían el tejido de nuestro universo. Millones de personas volverían hacia atrás en el tiempo para entrometerse en su propio pasado y en el pasado de los demás para tratar de reescribir la Historia. ¿Quién no hizo en el pasado alguna cosa de la que se arrepiente o la dejó de hacer, cambiando así el rumbo de su vida? Todos, si pudiéramos, querríamos arreglar eso.

La carrera que no estudiamos, aquella oportunidad desaprovechada, la mujer de nuestra vida que por cobardía dejamos ir, ese tren que no cogimos… Cualquiera de estas situaciones, de haber sido al contrario habría cambiado el curso de nuestras vidas que están regidas, siempre, por la causalidad. Todo lo que ocurre es la consecuencia de lo que ocurrió.

¿Cuánto no pagarían algunos por tener esa segunda oportunidad, ese momento que por una u otra razón perdieron?

También sería difícil evitar algunas tentaciones de gente con moralidad y conciencia adaptable y elástica, que querrían viajar al pasado para eliminar al padre de su enemigo y hacer posible que éste no naciera. Las paradojas temporales estarían al orden del día.

El viaje en el tiempo significaría que nunca podría existir una historia estable de los sucesos históricos que podrían ser cambiados a placer del consumidor. Pensemos que en los tiempos de Alejandro Magno, viajamos en el tiempo y llevamos a sus enemigos un cargamento de armas modernas; que pudiéramos haber facilitado a Galileo telescopios de última generación y modernos ordenadores. También se podría evitar la crucifixión de Cristo, facilitar a Faraday datos técnicos inexistentes en su tiempo o, por poner otro ejemplo, haber encerrado por loco a Hitler evitando aquel horror.

Obviamente, la mayoría de los científicos no se sienten muy felices con esta desagradable posibilidad que lo trastocaría todo en un continuo caos, eliminaría la Historia y haría inútil la memoria, la experiencia, el conocimiento adquirido a través del esfuerzo personal y un sin fin de situaciones que ahora tenemos y nos hacen ser como somos.

Por mi parte (es una humilde opinión), creo más fácil que consigamos burlar el límite impuesto por la velocidad de la luz (digo burlar, esquivar, no superar) o conseguir, como lo hacen en la serie Star Trek, trasladarnos mediante desintegración molecular que se integra en el punto de llegada de manera instantánea al momento exacto de la partida, que viajar hacia atrás en el tiempo.

El tiempo futuro es algo inexistente, aún no ha llegado, es algo que sabemos que vendrá pero que aún no está en nuestro universo. ¿Cómo se puede viajar a un lugar y a un tiempo que no existen?

Por otra parte, si lo pensamos detenidamente, la cuestión del tiempo no es nada fácil de entender; en realidad, es una ilusión pensar en él en tres fases que llamamos pasado, presente y futuro. El tiempo es algo que inexorablemente no deja de fluir a medida que se expansiona el universo, siempre está avanzando, no tiene intermitencias para que podamos decir: ¡estamos en el presente! Sería mentira. En realidad, vivimos siempre en un instante unificador del pasado-presente-futuro, es el ritmo quie impone la flecha del tiempo que, como no deja de fluir, tampoco hace posible que “el tiempo” esté estacionado en uno de esos apartados a los que hemos puesto nombre para saber si ya pasó, si está en el momento actual o si tendrá que venir. Nuestro sino, es el de vivir en un permanente presente.

Cuando comencé a escribir esta misma página, ahora es pasado, pasó por un presente efímero y me trajo a este instante futuro que ya deja de ser presente para ser pasado. Cada millonésima de segundo que pasa, transforma, a escala infinitesimal, nuestra realidad de tiempo.

No, no es nada fácil determinar dónde estamos, lo que es presente ya es pasado para convertirse en futuro, todo en fracciones de segundo. Pasado + Presente + Futuro: en realidad es una misma cosa ¡TIEMPO! que para entendernos mejor hemos fraccionado en distintos niveles que nos sitúan en lo que fue, en lo que es y en lo que será.

¿Quién no ha oído decir alguna vez? “Hay que ver lo mayor que está este niño, parece que fue ayer cuando nació”.

Dicen que el Tiempo y el Espacio nacieron juntos de aquella Gran Explosión que llamamos Big Bang

Pues ahí tenemos un ejemplo de la realidad de lo que es el tiempo, algo que no se para, algo que surgió hace ahora 13.700 millones de años y que incansable, imparable, continúa fluyendo ajeno a todo cuanto le rodea y que, al menos en el universo que conocemos, sólo dejará de fluir, si la densidad crítica (la cantidad de materia que contiene el universo) es lo bastante grande como para producir el Big Crunch, en cuyo caso, toda la materia existente en el universo, se juntaría de nuevo en una singularidad; el tiempo y el espacio dejarían de existir y, probablemente, todo comenzaría de nuevo con otro Big Bang y otro Tiempo.

¿Alguien puede asegurar que nuestro universo no es el primero de una larga serie? ¡Claro que no!

No sería descabellado pensar que nuestro universo es uno de los muchos universos que antes que él existió y que, al cumplir su ciclo, desaparezca para hacer posible la llegada de un nuevo universo, con un nuevo tiempo, un nuevo espacio y unas nuevas especies en multitud de nuevas estrellas y nuevos mundos. Si es así como realmente sucede, ¿todos los universos que han existido antes o que existirán después tendrán las mismas propiedades que este nuestro?

Las criaturas que podríamos encontrar en otros mundos, serían inimaginables. Siempre se ha dicho que la realidad sobrepasa a la imaginación, y, algunas veces… resulta ser verdad.

No creo que en los ciclos de universos se produzcan siempre las mismas consecuencias y estén presentes las mismas fuerzas. Simplemente con que la masa o la carga del electrón fuesen diferentes, el universo también lo sería. Los equilibrios de nuestro universo son muy sensibles, la materia que podemos observar: estrellas y galaxias, planetas y nosotros mismos, son posibles gracias al equilibrio existente a niveles nucleares. Los quarks confinados por gluones que fabrican la fuerza nuclear fuerte, se junta para crear protones y neutrones que conforman los núcleos de la materia y, al ser rodeados por los electrones, dan lugar a los átomos.

En cromodinámica cuántica, la propiedad de libertad asintótica hace que la interacción entre quarks sea más débil cuanto más cerca están unos de otros (confinación de quarks) y la fuerza crece cuando los quarks tratan de separarse, es la única fuerza que crece con la distancia. Los quarks y los gluones están confinados en una región cuyo valor se define por:

R » ћc /L » 10-13 cm.

En realidad, la única manera de que pudiéramos observar quarks libres, sería en un ambiente con la temperatura del universo primitivo, es la temperatura de deconfinamiento. De nuevo, como me ocurre con frecuencia me paso de una a otra idea y hago un recorrido, al parecer incoherente, que nos lleva desde las ecuaciones de Einstein y los viajes por el Tiempo, hasta los Universos cíclicos en los que nacen mundos muertos, sin vida,por causa de unas fuerzxas fundamentales diferentes a las que aquí reinan.Claro que, todo eso, no dejan de ser especulaciones de lo que podría ser.

Pero, ¿y nosotros?, ¿qué hacemos aquí?

Parece la pregunta del millón. Sólo se que estamos, que nos interesamos por el mundo que nos rodea, que queremos ir más allá de los conocimientos que ahora tenemos, que profundizamos en los secretos de la Naturaleza para aprender de ella lo que nos conviene hacer, y, a todo ello, buscamos el origen del Mundo, de Nosotros y del Universo mismo.

Pero, rematemos el tema de los viajes en el Tiempo.

Una versión de la máquina del tiempo de Thorne consiste en dos cabinas, cada una de las cuales contiene dos placas de metal paralelas. Los intensos cambios eléctricos creados entre cada par de placas de metal paralelas (mayores que cualquier cosa posible con la tecnología actual) rizan el tejido del espacio-tiempo, creando un agujero en el espacio que une las dos cabinas. Una cabina se coloca entonces en una nave espacial y es acelerada a velocidades próximas a la de la luz, mientras que la otra cabina permanece en la Tierra. Puesto que un agujero de gusano puede conectar dos regiones des espacio con tiempos diferentes, un reloj en la cabina de la nave marcha más despacio que un reloj en la cabina de la Tierra. Debido a que el tiempo transcurriría a diferentes velocidades en los dos extremos del agujero de gusano, cualquiera que entrase en un extremo del agujero de gusano sería instantáneamente lanzado al pasado o al futuro.

Parece que la función de las placas metálicas paralelas consiste en generar la materia o energía exótica necesaria para que las bocas de entrada y salida del agujero de gusano permanezcan abiertas y, como la materia exótica genera energía negativa, los viajeros del tiempo no experimentarían fuerzas gravitatorias superiores a 1g, viajando así al otro extremo de la galaxia e incluso del universo o de otro universo paralelo de los que promulga Stephen Hawking. En apariencia, el razonamiento matemático de Thorne es impecable conforme a las ecuaciones de Einstein (yo no me alistaría a ninguno de esos primeros viajes).

Casimir teorizó que si dos placas perfectamente paralelas podían ser aproximadas lo suficiente la una a la otra, el espacio pequeño entre dichas placas estaría libre de todas las partículas con una longitud de onda larga. Esas partículas, sin embargo, podían seguir creándose espontáneamente en el exterior de las placas, creándose una presión detectable contra el exterior de las placas:

demostrándose con ello la existencia de partículas creadas espontáneamente del “espacio libre”:

El efecto Casimir consiste en la aparición de una fuerza atractiva entre dos placas metálicas en el vacío muy próximas entre sí separadas por menos de 10 nanómetros (10 milmillonésimas partes de un metro). Este efecto ocurre porque, al poner las placas en una región de vacío —que como hemos visto, no está vacío— la energía solo puede resonar y crear nuevas partículas a ciertas frecuencias, mientras que en el exterior de las placas la energía resuena en todas las frecuencias. En el interior no, y por tanto el exterior empuja a las placas. Es una diferencia de presiones la que empuja las placas entre sí. Se demostró experimentalmente con buenos resultados en 1997.

Normalmente, una de las ideas básicas de la física elemental es que todos los objetos tienen energía positiva. Las moléculas vibrantes, los vehículos que corren, los pájaros que vuelan, los niños jugando tienen todos energía positiva. Por definición, el espacio vacío tiene energía nula. Sin embargo, si podemos producir objetos con “energías negativas” (es decir, algo que tiene un contenido de energía menor que el vacío), entonces podríamos ser capaces de generar configuraciones exóticas de espacio y tiempo en las que el tiempo se curve en un circulo.

Este concepto más bien simple se conoce con un nombre que suena complicado: la condición de energía media débil (average weak energy condition, o AWEC). Como Thorne tiene cuidado en señalar, laAWEC debe ser violada; la energía debe hacerse temporalmente negativa para que el viaje en el tiempo tenga éxito. Sin embargo, la energía negativa ha sido históricamente anatema para los relativistas, que advierten que la energía negativa haría posible la antigravedad y un montón de otros fenómenos que nunca se han visto experimentalmente.

Pero Thorne señala al momento que existe una forma de obtener energía negativa, y esto es a través de la teoría cuántica.

Dicen que las emisiones fractales contrarrestan las energías Casimir

En 1.948, el físico holandés Hendrik Casimir demostró que la teoría cuántica puede crear energía negativa: tomemos simplemente dos placas (imagen arriba) de metal paralelas y descargadas ordinariamente, el sentido común nos dice que estas dos placas, puesto que son eléctricamente neutras, no ejercen ninguna fuerza entre sí. Pero Casimir demostró que, debido al principio de incertidumbre de Werner Heisenberg, en el vacío que separa estas dos placas existe realmente una agitada actividad, con billones de partículas y antipartículas apareciendo y desapareciendo constantemente. Aparecen a partir de la “nada” y vuelven a desaparecer en el “vacío”. Puesto que son tan fugaces, son, en su mayoría, inobservables, y no violan ninguna de las leyes de la física. Estas “partículas virtuales” crean una fuerza neutra atractiva entre estas dos placas que Casimir predijo que era medible.

Cuando Casimir publicó el artículo, se encontró con un fuerte escepticismo. Después de todo, ¿cómo pueden atraerse dos objetos eléctricamente neutros, violando así las leyes normales de la electricidad clásica? Esto era inaudito. Sin embargo, en 1.985 el físico M. J. Sparnaay observó este efecto en el laboratorio, exactamente como había predicho Casimir. Desde entonces (después de un sin fin de comprobaciones), ha sido bautizado como el efecto Casimir.

Una manera de aprovechar el efecto Casimir mediante grandes placas metálicas paralelas descargadas, sería el descrito para la puerta de entrada y salida del agujero de gusano de Thorne para poder viajar en el tiempo.

Agujero de gusano con materia exótica

No se finalmente lo que será pero, creo que, llegará el mopmento de que Andrómeda se junte con la Vía Láctea y aún, no habrá viajes en el tiempo tal como los tenemos pensados y, finalmente serán otros los caminos que nos llevarán…No al pasado ni al futuro, sino a otras galaxias lejanas que, bien mirado, tampoco es un viaje como para aburrirse.

Por el momento, al no ser una propuesta formal, no hay veredicto sobre la máquina del tiempo de Thorne. Su amigo, Stephen Hawking, dice que la radiación emitida en la entrada del agujero sería suficientemente grande como para contribuir al contenido de materia y energía de las ecuaciones de Einstein. Esta realimentación de las ecuaciones de Einstein distorsionaría la entrada del agujero de gusano, incluso cerrándolo para siempre. Thorne, sin embargo, discrepa en que la radiación sea suficiente para cerrar la entrada.

Nueno, así lo he leido y así os lo he contado añadiendo alguna que otra coletilla que a mi humilde entender, podían completar las explicaciones de tan “descabellados pensamientos”. ¡Viajes en el Tiempo! Pero, no dijo alguien que existe una Censura Cosmológica que los prohíbe.

¡Ya veremos que pasa!

emilio silvera

Mar

11

Lo importante es descubrir el Universo sin importar como

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Los secretos del Universo ~

Clasificado en Los secretos del Universo ~

Comments (0)

Comments (0)

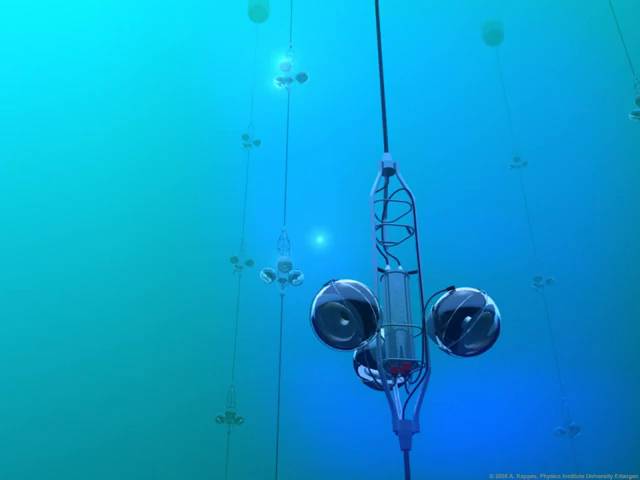

Un proyecto europeo impulsa la el mayor detector de neutrinos del mundo. Se sumergirá a 2.500 metros de profundidad en el Meditarráneo.

12.000 sensores submarinos barrerán un kilómetro cúbico de mar en busca de neutrinos. / Propriety KM3NeT Collaboration

El fondo del mar no parece ser el mejor lugar para instalar un telescopio. Y, sin embargo, es el emplazamiento idóneo para estudiar algunas de las zonas más recónditas del universo. Lugares de extraordinaria densidad o muy alejados en los que se producen algunos de los fenómenos más violentos del cosmos (explosiones de rayos gamma, núcleos de galaxias activas) escapan de los métodos de estudio convencionales y solo pueden ser analizados gracias a una tecnología que consiste en detectar neutrinos procedentes de lejanas galaxias para reconstruir los confines del espacio.

Los neutrinos son unas partículas que transmiten información muy valiosa, pero son muy escurridizos ya que apenas interaccionan con la materia. Por ello, los sensores capaces de detectar su rastro requieren de unas condiciones especiales que solo se dan en entornos de grandes volúmenes de hielo o agua. Un proyecto europeo con participación española ha diseñado el que será el mayor telescopio de neutrinos del mundo. El dispositivo -que funciona como una red de sensores- se comenzará a instalar este año a más de 2.500 metros de profundidad en distintos puntos del Mediterráneo.

|

|

|

|

más información

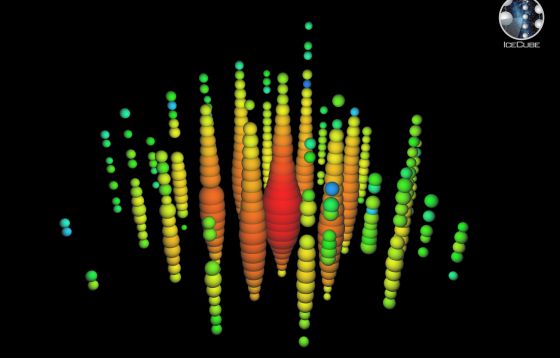

- La detección de 28 partículas fantasma inicia una nueva era en la exploración espacial

- Epi y Blas, los superneutrinos que pueden contar la historia desconocida de los monstruos del cosmos

- El hielo de la Antártida ‘atrapa’ 28 neutrinos de alta energía

- “Con el IceCube vemos las estrellas no en luz sino en neutrinos”

- Otro experimento refuta que los neutrinos viajen más rápido que la luz

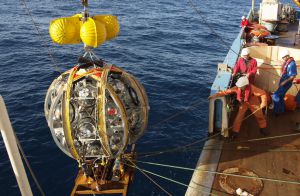

Con una inversión prevista de 150 millones de euros, estará a pleno rendimiento en 2020. Hace menos de dos años, un equipo similar (el IceCube), emplazado en el hielo de la Antártida consiguió identificar por primera vez neutrinos de origen cósmico de alta energía. En el Mediterráneo, un proyecto de menor tamaño (Antares) lleva funcionando desde 2007 y ha servido de banco de pruebas del futuro KM3NeT (acrónimo en inglés de telescopio de neutrinos de un kilómetro cúbico, en referencia al volumen de agua que analizará). Un centenar de investigadores de las 40 instituciones que participan en esta iniciativa –procedentes de 10 países- se reunieron recientemente en Valencia para preparar la puesta en marcha de este nuevo telescopio.

Registro del neutrino de más alta energía captado en el observatorio IceCube, en la Antártida. / IceCube Collaboration

“El mensajero por excelencia de la información del universo es la luz [los fotones], sobre ella se basa la astronomía”, explica, Juan José Hernández Rey, del Instituto de Física Corpuscular (IFIC), un centro mixto del CSIC y la Universitat de València que lidera la participación española. “Ello incluye tanto la luz visible como todo el espectro electromagnético, desde los infrarrojos hasta los rayos X o los gamma”, añade. También sirven para estudiar el espacio los rayos cósmicos que llegan a la tierra (protones y núcleos atómicos).

Pero a alta energía, los neutrinos tienen importantes ventajas sobre ellos: no son absorbidos por la materia intergaláctica, ni por la que rodea a las fuentes que los generan. Además, como no cuentan con carga eléctrica, sortean los campos magnéticos sin desviarse. Por ello, pueden atravesar zonas muy densas, cargadas de materia, y cruzar enormes distancias sin transformarse.

Estas propiedades hacen posible reconstruir fielmente la dirección de donde proceden a través de su trayectoria y obtener datos muy valiosos de su procedencia. Pero también complican extraordinariamente que se les pueda dar caza. Es muy difícil que colisionen con la materia y así registrar su paso. En todo caso, a pesar de que se trata de un fenómeno muy infrecuente, a veces sucede.

Lanzamiento de los módulos de detección al mar antes de desplegarlos en hileras. / Propriety KM3NeT Collaboration

En estos casos excepcionales, un neutrino interacciona con la materia, choca contra el núcleo de un átomo y surge otra partícula secundaria denominada muón. Esta partícula elemental genera una onda luminosa, una luz azulada denominada luz de Cherenkov. Se trata del mismo tipo de radiación electromagnética que se produce en las piscinas de las centrales nucleares que dan a estas instalaciones un tono casi fluorescente. Es un destello tenue y fugaz, casi imperceptible.

Este fenómeno solo es visible en el agua o el hielo. Al ser tan poco frecuente, cuantas mayores sean las cantidades de materia (en este caso, de agua) sometidas a observación, más fácil será cazar a los escasísimos neutrinos que generen la luz que revela su presencia.

Por ello se despliegan grandes redes de detectores dispuestos en línea (una especie de collares con cuentas colgantes). El prototipo ya en marcha, Antares, está situado a unos 40 kilómetros de las costas de Marsella y consta de 12 líneas que contienen un total de 1.000 sensores ultrarrápidos capaces de registrar estas señales luminosas. El objetivo del KM3NeT es emplear hasta 12.000 detectores capaces de vigilar simultáneamente un kilómetro cúbico de agua en busca de que se produzca este pequeño destello. Para ello, se anclarán nuevos módulos frente a Sicilia, cerca de Catania, además de Marsella.

Para evitar la contaminación de otras fuentes de luz o las interferencias de los rayos cósmicos que bombardean la superficie terrestre, los equipos se encuentran sumergidos a gran profundidad. A partir de algo más de 700 metros -depende de la turbidez del agua- los rayos del sol ya no son perceptibles. Pero puede haber especies submarinas bioluminiscentes e incluso otras fuentes de radiación, como el potasio 40, que es muy frecuente en toda la Tierra, capaces de engañar a los sensores. Para esquivar todo este ruido lumínico, los equipos se instalan entre los 2.000 y los 3.500 metros bajo la superficie del mar. Curiosamente, los neutrinos que se detectan son los que provienen de las antípodas. Cruzan la masa de agua, las distintas capas de la Tierra, salen de nuevo al mar e interaccionan cerca del telescopio produciendo un muón, cuyo destello Cherenkov revelará su presencia.

Frente al proyecto IceCube de la Antártida, Hernández Rey destaca que la iniciativa europea cuenta con varias ventajas. “El agua ofrece mayor resolución que el hielo”, indica. Pero además, “al estar en el hemisferio norte podemos ver el centro de nuestra galaxia”, por lo que la iniciativa europea “aún siendo complementaria, es más competitiva”. La primera fase debe estar acabada a finales del año que viene: se desplegarán 30 líneas con 2.500 detectores de los 12.000 previstos.

Totales: 75.437.680

Totales: 75.437.680 Conectados: 43

Conectados: 43