El Observatorio Espacial Herschel ha descubierto un filamento gigante repleto de galaxias en las que brillan miles de millones de estrellas. El filamento conecta dos cúmulos de galaxias que, al colisionar con un tercer cúmulo, darán lugar a uno de los mayores supercúmulos de galaxias del universo.

Mar

9

El ‘Hubble’ capta la ‘cruz de Einstein’

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

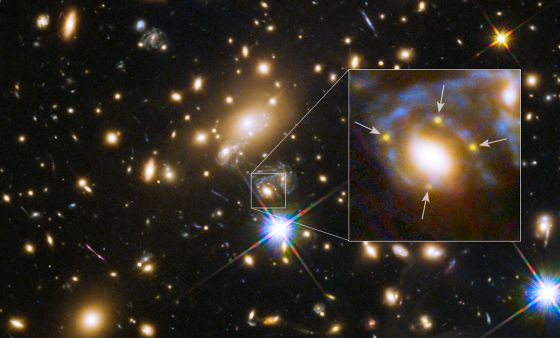

El telescopio espacial fotografía por primera vez una imagen múltiple de una supernova

La galaxia está a una distancia de unos 5.000 millones de años luz de la Tierra.

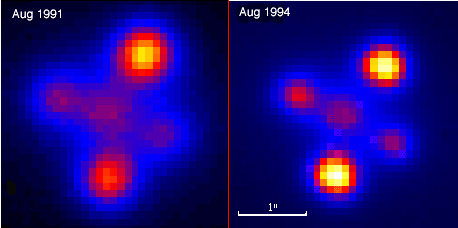

El telescopio espacial Hubble ha fotografiado un sorprendente fenómeno: una lejana explosión de supernova multiplicada por cuatro debido a que su luz se curva por el efecto gravitatorio de una galaxia masiva, que está un grupo galáctico también masivo interpuesto en la línea de visión desde la Tierra. Es la primera vez que se capta este efecto, denominado la Cruz de Einstein, con una supernova, aunque se conocía ya en decenas de casos de cuásares y de galaxias, anuncia la Agencia Europea del Espacio (ESA).

En este caso el efecto lente gravitatoria produce una cruz simétrica porque la galaxia que actúa como lente se halla casi exactamente en nuestra linea de visión del quásar. Esta forma de cruz lleva el nombre de Albert Einstein, cuya teoría de la relatividad predecía este fenómeno. La imagen fue obtenida por el telescopio espacial Hubble.) -Esta explicación no forma parte del artículo ni la imagen tampoco-.

La galaxia que actúa como lente gravitacional para la supernova (bautizada por los científicos Refsdal) está a una distancia de unos 5.000 millones de años luz de la Tierra y la explosión estelar, a unos 9.500 millones de años luz. La gran masa galáctica curva el espacio-tiempo y, por tanto, la luz de la supernova lejana al pasar junto a ella, formándose así, para el observador terrestre, las cuatro imágenes separadas de la explosión estelar con su luz magnificada.

“Fue una completa sorpresa”, explica Patrick Kelly, investigador de la Universidad de California en Berkeley (EE UU) y miembro del equipo GLASS que da a conocer el hallazgo esta semana en la revista Science, en una sección especial dedicada al centenario de la Teoría de la Relatividad General de Einstein. Kelly, en concreto, fue quien halló la supernova multiplicada por cuatro analizando datos tomados por el Hubble (de la NASA y la ESA) en noviembre de 2014. “Es un descubrimiento maravilloso: llevamos 50 años buscando una supernova con un fuerte efecto de lente gravitacional y ahora hemos encontrado una”, añade Alex Filippenko, de la Universidad de California en Berkeley. “Además de ser realmente genial, puede proporcionar mucha información astrofísica importante”, recalca.

La supernova se ve unas 20 veces más brillante que su brillo natural”

“La supernova se ve unas 20 veces más brillante que su brillo natural”, añade Jens Hjorth, del Dark Cosmology Centre (Dinamarca), otro de los autores de la investigación. “Eso se debe al efecto combinado de dos lentes superpuestas: el masivo grupo galáctico enfoca la luz de la supernova en tres rutas diferentes y una de ellas está precisamente alineada con una galaxia elíptica del grupo, y se produce un segundo efecto de lente gravitatoria”. Se crean así las cuatro imágenes.

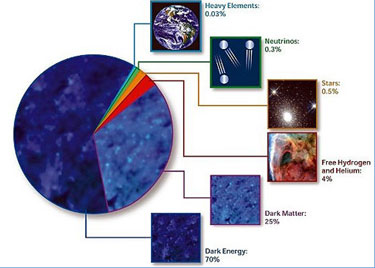

En el proceso de curvatura del espacio-tiempo que desvía la luz está implicada la materia ordinaria de esas galaxias, pero también la enigmática materia oscura que supone el 27% del universo y que nadie sabe qué es, señalan los investigadores. Por ello, la imagen multiplicada de la supernova no solo es un hallazgo atractivo sino que puede ayudar a estimar la cantidad y la distribución de dicha materia oscura en el grupo galáctico.

Cruz de Einstein

La Teoría de la Relatividad de Einstein predice que las densas concentraciones de masa en el universo curvan la luz como una lente, magnificando los objetos que están detrás de dicha al ser observados desde la Tierra, explican los expertos de la Universidad de California en Berkeley. La primera lente gravitacional se descubrió en 1979.

Así, cuando la luz de objeto lejano pasa por una masa interpuesta, como una galaxia individual o un grupo galáctico, la luz se curva. En el caso de que el objeto del fondo, la masa interpuesta y el observador no estén perfectamente alineados, la luz del primero pasa lejos de la segunda y se produce una lente débil que distorsiona la imagen del objeto lejano. También sucede esto si la masa no es muy grande. Pero cuando el objeto del fondo es extenso, como una galaxia, y está justo detrás de la masa interpuesta, o casi, el efecto de lente gravitacional fuerte puede generar un aro luminoso, denominado Anillo de Einstein. La lente gravitacional fuerte y las fuentes luminosas puntuales a menudo producen múltiples imágenes, como la de la supernova que se ve cuatro veces formando una Cruz de Einstein ahora captada por el Hubble, concluyen los científicos de Berkeley.”

Mar

8

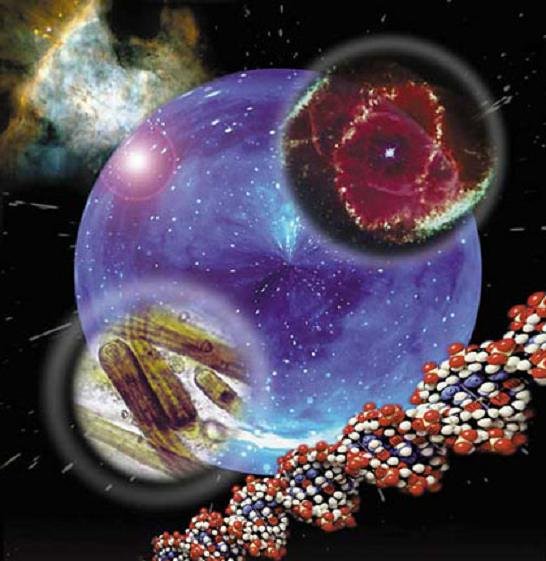

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Sin categoría ~

Clasificado en Sin categoría ~

Comments (0)

Comments (0)

“Una formulación muy hermosa que, creo, procede de América es la siguiente: alguien que ha golpeado a otro afirma que sólo ha movido sus puños libremente; el juez, sin embargo, replica: «La libertad de movimiento de tus puños está limitada por la nariz de tu vecino».

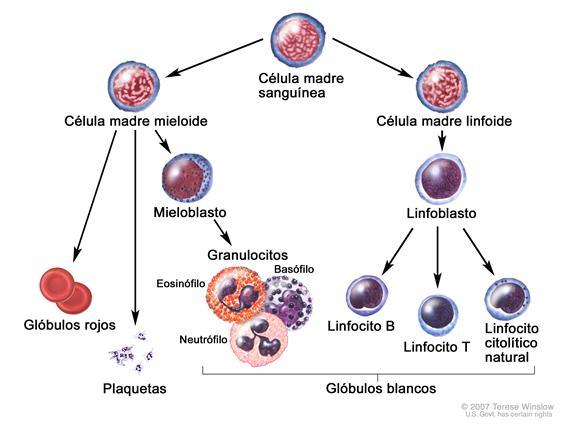

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

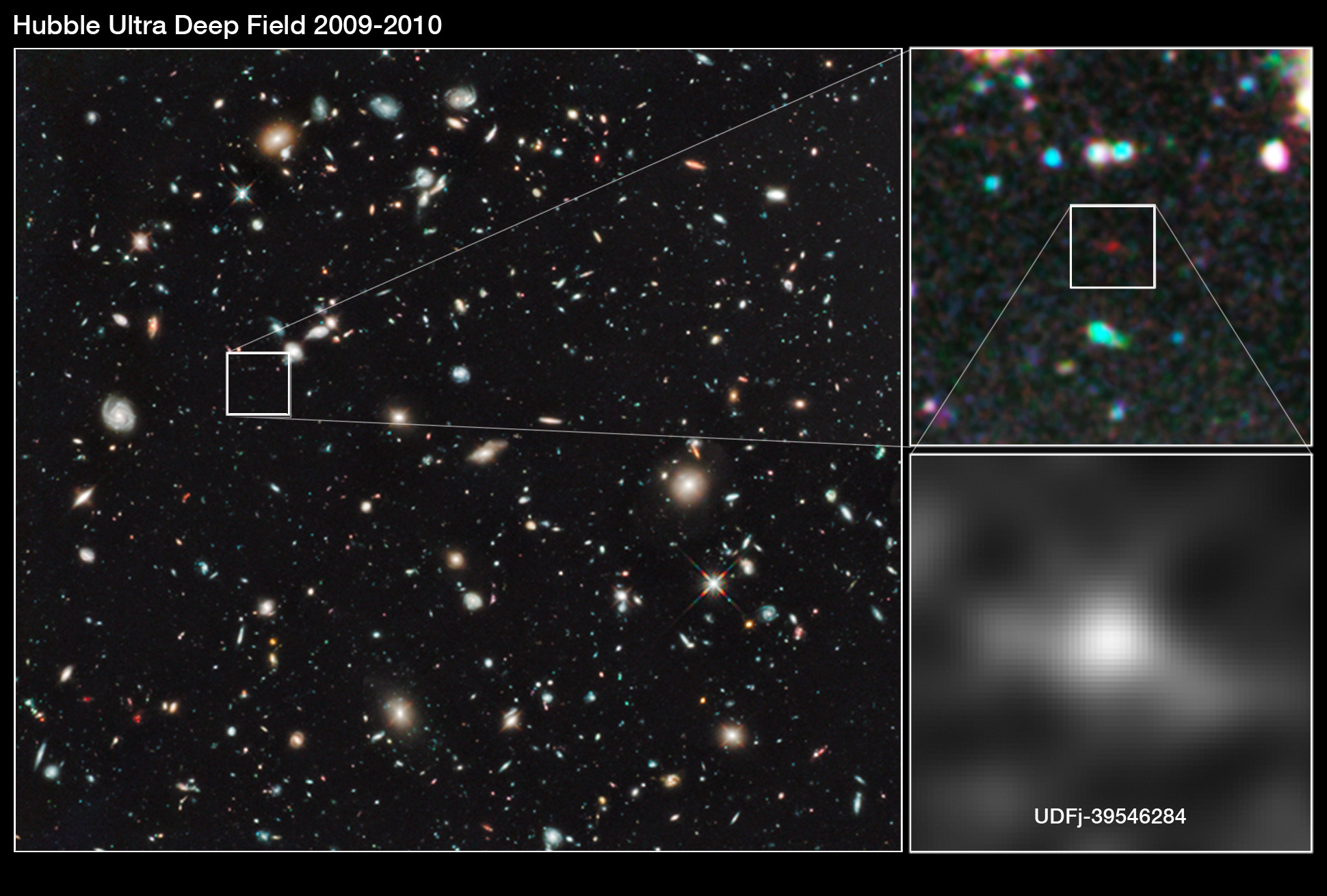

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

La fuerza nuclear fuerte es la más potente del Universo

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

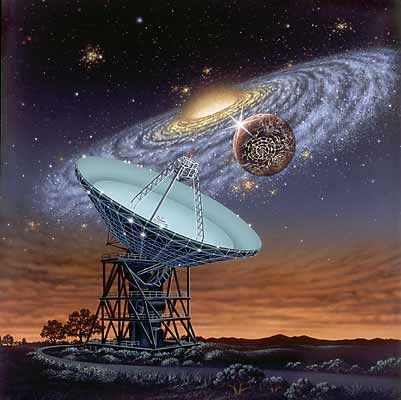

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión creaelementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seámos ni tanto ni tan poco como a veces creemos. Dejémos en un término medio nuestra valia en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa valadí!

emilio silvera

Mar

8

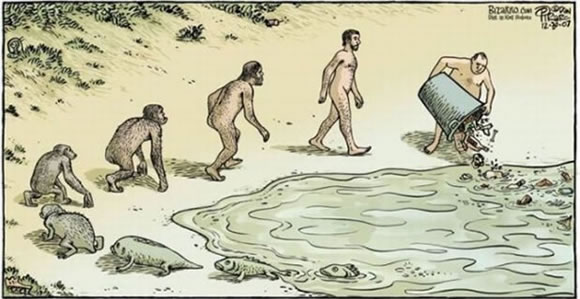

¿Será cierto que la evolución Humana se detuvo hace ahora 50.000 años?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Evolución ~

Clasificado en Evolución ~

Comments (1)

Comments (1)

La evolución se detuvo, afirma antropólogo a National Geográphic

Imaginar que continuaremos evolocionando es una idea errónea” declara también, el antropólogo Ian Tattersall, del Museo de Historia Natural de Nueva York.

“Y descansó la evolución en el septimo día”. Si lo decimos nosotros ES CIENCIA. Conste.

Finalmente hemos encontrado la respuesta a la molesta pregunta de los estúpidos creacionistas cuando nos piden prueba empírica de la evolución, o un ejemplo de evolución en progreso observable.

Algunos hablan de la evolución Humana como si de una parodia se tratara

Debemos recordar que el propio Einstein dijo que la “teoría sino se observa no es teoría” , pero bueno también sospechamos que ese viejo ignorante por ser medio creacionista (Einstein afirmó ser panteísta y creer en Dios de acuerdo al concepto panteísta de Baruch Spinoza) no puede ser tomado muy en serio. Sin embargo, ya no tenemos obligación de explicar por qué la evolución NO SUCEDE actualmente. ¿No es obvio? LA EVOLUCIÓN SE HA DETENIDO! Es decir, sucedió en el pasado, evolucionamos y ahora ,la evolución puso STOP como un CD .

Es muy habitual que las leyes de la biología y de la física se detienen. La relatividad se podría detener un día por ejemplo, o la gravedad … eso es totalmente científico. Así que no tenemos reparos en afirmar como un HECHO que la EVOLUCIÓN SE DETUVO. No lo decimos nosotros: lo dijo el eminente antropólogo Ian Tattersall, del Museo de Historia Natural de Nueva York, a la revista National Geographic.

La Imagen y el texto que la sigue de ABC.ciencia

“El aspecto que tendrá el ser humano dentro de cientos, miles o millones de años es una de esas grandes preguntas a las que los científicos no pueden replicar con una única respuesta. ¿Nos convertiremos en inviduos más altos, sanos y esbeltos? Se trata de una fantasía generalizada, pero algunos investigadores apuntan a panoramas más realistas y otros creen que ni siquiera sufriremos cambios dignos de reseñar. Las teorías más extraordinarias dibujan un futuro de ciencia ficción, en el que podríamos convertirnos en ciborgs, organismos cibernéticos dotados de dispositivos mecánicos para mejorar las limitadas capacidades biológicas con las que hemos nacido, e incluso hay quien apunta que acabaremos digitalizando nuestras conciencias para conseguir una inmortalidad cibernética.”

Sin embargo, podemos ver la paradoja de que la Ciencia y el progreso continúan

La evolución ya se ha detenido:

«Porque hemos evolucionado, es natural imaginar que lo continuaremos haciendo, pero creo que ésa es una idea errónea», afirma el antropólogo Ian Tattersall, del Museo de Historia Natural de Nueva York, a la revista National Geographic. «Por lo que sabemos, las innovaciones genéticas se producen solamente en pequeñas poblaciones aisladas», añade el especialista. Por ejemplo, esto es lo que ocurrió con los famosos pinzones de Darwin en las Galápagos, que adquirieron características propias para ajustarse a la vida en la isla.

La selección natural, a la manera del naturalista británico, tiene lugar cuando una mutación genética -como una columna adecuada para caminar erguido- se transmite de generación en generación, porque supone algún beneficio para la especie. Finalmente, la mutación se convierte en la norma. Para Tattersall es muy difícil que esto le ocurra al Homo sapiens, ya que poblamos prácticamente todo el planeta y disfrutamos de gran mestizaje y movilidad. «Tendremos que aprender a vivir tal y como somos», concluye.”

Fuente: http://www.ecuadorciencia.org/articulos.asp?id=8333

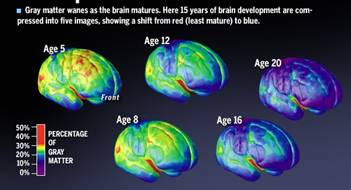

“Se puede apreciar en la anterior gráfica de resonancia como la neorocientífica nos muestra la evolución de la zona del córtex según la edad, desde la primera infancia va evolucionando y no se detiene dentro de la escala evolutiva. Explica que el neocortex nos capacita para adquirir conocimientos, desarrollar sociedades, culturas y tecnologías.

Según Blakemore la corteza cerebral de los animales está comprometida con las funciones sensoriales motoras, no así el hombre, que está disponible para la realización de un futuro programado. La neocorteza se convierte en el foco principal de atención en las lecciones que requieren generación o resolución de problemas, síntesis de información, análisis, uso del razonamiento, el pensamiento crítico y creativo.”

Pero claro, ¡cómo no nos dimos cuenta! Durante millones de años los seres han evolucionado, y de repente ese proceso que duró millones de años SE DETIENE, justo ahora que tenemos una mente capaz de percibirlo y explicarlo. ¿No es conveniente y sabio? El azar es sabio sin duda y nos permitió dejar de evolucionar justo a tiempo para evitar las incómodas preguntas de los creacionistas estúpidos.

Ya sabemos que es difícil de responder como un proceso que hemos afirmado es constante e irreversible se ha detenido. Pero recuerden que es o creer eso o creer que fuimos creados por un plato de tallarines. No hay otra opción. Y por supuesto no vamos a creer que nos creó un plato de tallarines porque es ridículo así que el nuevo dogma es: LA EVOLUCIÓN SE DETUVO.

Si la Mente es un Universo en sí misma… ¿Cómo podría dejar de evolucionar?

Hay que apresurarnos a enseñar este nuevo HECHO COMPROBADO en las escuelas a todos los niños, no sea cosa que justo ahora a alguno se le dé por evolucionar (aunque no creemos , si ya en 200 años no hemos podido mostrar un solo ejemplo parece que está quieta quieta la evolución .. no? ) .

No es necesaria mas prueba que las palabras del antropólogo. Recuerden: somos huevolucionistas. Nuestra teoría nació de las palabras de un muchacho que observaba pájaros y nuestras pruebas son las palabras dichas por alguien que tenga algún título o formación rimbombante suficiente para impresionar al homo vulugaris populis . Ya salió publicado en la prensa, así que eso añade prueba adicional.

Solo nos cabe agregar “y descansó la evolución de toda la obra que había hecho”. O sea, si lo decimos nosotros, que la evolución ya NO CREA es ciencia por supuesto. Pero si lo dice un creacionista , que Dios ya no crea , es absurdo y solo una excusa porque no tiene pruebas.

Esto es ciencia estimados colegas huevolucionistas y no religión dogmática, gracias a … bueno gracias a la evolución.

Fuentes: Variadas.

Mar

7

La Religión y algunos pueblos del pasado

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en a otros mundos ~

Clasificado en a otros mundos ~

Comments (2)

Comments (2)

Presentar a estas alturas a Isaac Asimov, sería un ejercicio inútil por ser alguien al que todos conocen por su faseta de escritor científico y de ciencia-ficción. Él escribió más de trescientos libros que iban desde la bioquímica y la física hasta Schakespeare y la Biblia. Todo lo quería tocar y, se introdujo en las más diversas ramas del saber humano para explicar sus ideas con respectos a esas muchas cuestiones que abordó con más o menos éxito. En lo que más destacó y se hizo más popular, fuen en la rama de la Ciencia-Ficción en las que nos dejó novelas inolvidables que, como la Saga de La Fundación conocida en todo el mundo. Como hoy tratamos sobre cosmología, se me ocurre que, podríamos utilizar una de sus obras como comienzo de este sencillo trabajo:

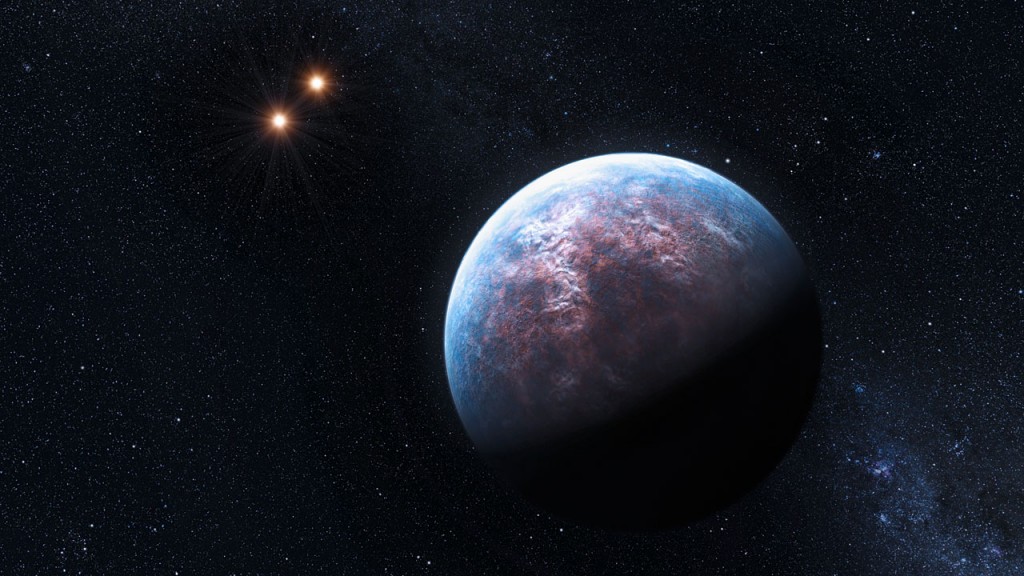

Una de sus mejores obras fue temprana. En 1941 publicó “Nightfall”, una historia sobre una civilización condenada a un destino funesto y ubicada en el planeta Lagash, que no giraba en torno a un único Sol, como lo hace la Tierra, sino que estaba inmerso en el campo gravitatorio de generado por seis soles independientes. Él no explicaba, en la obra, cómo era la órbita de ese planeta -sería un problema nada menos (y nada más) que de siete cuerpos-, nada fácil de explicar.

Para los habitantes de un planeta con más de un Sol, no sería fácil sobrellevar las diferencias que esto supondrían. Los planetas ahora desvelados, llamados Kepler-34b y Kepler-35b-, giran alrededor de un par de estrellas unidas gravitatoriamente que se orbitan entre sí. El primero se encuentra a 4.900 años luz de la Tierra y el segundo, aún más lejos, a 5.400 años luz. Si tuvieran habitantes, ¿qué sensación tendrían con esos dos focos luminosos sobre ellos?

Pero sigamos con la historia de los habitantes de Lagash que, en tal situación de estar iluminados por seis soles era que, recibían luz constante proveniente de los soles, cuando no eran unos eran los otros los que les enviaba sus rayos de luz y su calor.

Dado que no conocían ningún tipo de cielo nocturno, los astronómos extrapolan la idea de qué en su universo sólo existen unas pocas docenas de estrellas. Se trataba de unas luces misteriosas apenas visibles contra el resplandor de los seis soles. Así, los que consideraban importantes las estrellas estaban en minoria y eran considerado como gente “especiales” y, algo raras.

Además, en Lagash existía una silenciosa sensación incómoda. Los arqueólogos habían hallado restos de nueve culturas anteriores, cada una de las cuales había podido alcanzar una cultura muy avanazada del nivel de la cultura presente y luego, habían desaparecido. Los estratos geológicos indican que cada una de aquellas civilizaciones había permanecido durante un período de alrededor de dos mil años.

La historia de Asimov nos parece una fantasía pero, lo que hasta ahora sólo había sido cuestión de ciencia ficción, un grupo de astrónomos trabajando con el satélite espacial Kepler han encontrado a un planeta desde el que, si se pudiera uno parar en él, se podrían apreciar amaneceres y atardeceres con dos soles, justo cómo el que apareció en la primera entrega de Star Wars desde el planeta Tatooine.

Así es, resulta que este planeta recientemente descubierto, que por lo pronto lleva el nombre de Kepler-16b, se encuentra orbitando a un sistema binario de estrellas. Esto es, un par de estrellas girando una al rededor de la otra, mientras que el planeta gira al rededor de ese sistema.

Nos podríamos preguntas cómo serían en ese mundo de seis soles las cosas. Lla fotosíntesis de una planta queda afectada por el color de la luz que recibe. En la Tierra, la mayoría de las plantas evolucionaron al color verde con el fin de aprovechar el color amarillento de la luz solar que recibe la superficie de nuestro planeta. Nuestro sol, clasificado como una estrella enana amarilla, puede parecer de un brillo blanco visto desde el espacio, pero nuestra atmósfera nos hace verlo amarillo.

Existen muchas otras clases de estrellas que no son como el Sol en el vasto Universo, y muchas de ella están, como el el mundo de Lagahs compartiendo órbitas múltiples con otros tipos de estrellas: enanas rojas, estrellas azules, gigantes rojas, enanas blancas…Las estrellas poseen diferentes colores dependiendo de su composición, edad, tamaño y temperatura. Quizás estemos acostumbrados al amarillo, pero la naturaleza realmente no tiene preferencias, y, en un sistema de seis soles…para el planeta que depende de ellos, la cosa no sería fácil.

Aquí teneis a Gliese 667, un sistema solar múltiple de dos estrellas. Lástima que no haya podido encontrar ninguna imagen que pusiera representar el sistema Solar de Lagahs, el planeta de seis soles que, tendría que ser una verdadera alucinación para sus habitantes.

Al final de la Historia del planeta Lahahs que estaba en un sistema de seis soles, se descubrió la terrible verdad de por qué, casi de dos mil en dos mil años, desaparecían las civilizaciones que estaban allí aposentadas y firmemente establecidas. Cada 2.049 años los seis soles se ponen y cae la noche, algo totalmente desconocido para los lagashianos que consecuentemente, sienten un inmenso terror hacia la oscuridad y el frío (seis soles les enviaban su luz y su calor durante todas sus vidas). El Miedo y el terror de aquel nuevo y aterrador escenario, les hace volverse locos y comienzan a provocar fuegos hasta que la cultuira muere y, como las anteriores, desaparece.

Ni estrellas que puedan guiar el rumbo de los viajeros

La oscuridad total del mundo parece ser un denominador común en todas esas profecías. Seguramente por eso la escogería Asimov. Un físico, Anthony Peratt, que ha trabajado en el National Laboratory de los Álamos y en el Departamento de Energía, afirma que a los lagashianos los destruyó algo más que el fuego. La apición del cielo nocturno y de incontables estrellas destruye su cosmología; socava su fe y los cimientos filosóficos de su sociedad, que entonces se derrumba.

Todos sabemos que la Cosmoogía es el estudio del Universo como un todo, de su historia y de su origen. Habitualmente, aunque no siempre, se basa en la Astronomía, así como en la religión y en las creencias sociales.

El antropólogo George P. Murdock hizo una lista de sesenta y ocho civilizaciones que han configurado sus cosmologías. Algunas de estas civilizaciones han desarrollado poco la ciencia y escasamente la astronomía. Nosotros los seres humanos, en cuanto identificamos un puñado de estrellas, pretendemos construir una imagen de todo el universo. La Directora del Programa de de religión del Hunter College de la City University de Nueva York, expresa su desacuerdo con la cifra de las 68 civilizaciones de dadas por Murdock: “Todas las civilizaciones tienen cosmologías de algún tipo que dicen como está estructurada la realidad. Al decir “realidad” se refiere a sus distintos universos, como ellos lo podían percibir”.

No pocas de aquellas Civilizaciones antiguas coincidieron en muchas cuestiones del “mundo que veían” y, destacaron de las demás: Sumerios, Babolonios, Hindúes, Chinos, Egipcios y Griegos, todos ellos, nos dejaron su impronta y, el resultado de todas aquellas culturas, fue recopilado y traducido por el mundo del Islam cuando llegó el oscurantismo en la Edad Media. Mucho despúes, en el Renacimiento, volvieron a florecer aquellos saberes del mundo para que pudieran lelgar hasta hnuestros días.

Existe un monstruo en el centro de nuestra galaxia está a punto de alimentarse del material presente en esa nube de gas. En efecto, recientes observaciones del VLT indican que una nube de gas pronto se aventurará peligrosamente cerca del agujero negro supermasivo que ocupa el centro de nuestra galaxia. La nube está siendo desgarrada, estirada y calentada. Los investigadores predicen que durante los próximos dos años parte de la nube será engullida por el agujero negro. ¿Os podeis imaginar que, nuestro mundo estuviera cerca de un monstruo estelar semejante? ¿Cuál sería nuestra reacción cuando el planeta comenzara a ser espaguetizado por esa fuerza de atracción descomunal? ¿Que reacciones y fuerzas se desatarían en el planeta?

Hoy, nuestros conocimientos del Universo son bastante aceptables y hemos podido comprobar que, nuestros modelos cosmológicos, se acercan a la realidad que podemos observar. Aqueloos tiempos lejanos en los que prevalecian las creencias y la intuición, han pasado para dar paso a la auténtica Ciencia que guía el camino que tenemos que seguir.

Claro que, si alguien me pidiera una justificación de la cosmología como ciencia, me vería en un gran apuro para poder dar una respuesta. La raíz de la palabra Cosmos nos remite a una palabra que abarca el todo. ¿Cómo se puede tener una Ciencia basada en que conozcamos todo? Cuando ni siquiera sabemos cuál puede ser el tamaño real del Universo.

Claro que, aunque eso resulta ser así, no por ello, la Cosmología deja de ser interesante y también, importante. Dado quen está estrechamente entrelazada con las creencias y aptitudes generales de nuestra sociedad, la cosmología puede ser una clave para conocer la psicología colectiva de una civilización. Generalmente, también suele haber algo de ciencia en esto.

emilio silvera

Mar

7

El Universo siempre asombroso

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo misterioso ~

Clasificado en El Universo misterioso ~

Comments (1)

Comments (1)

Las estrellas brillan en el cielo para hacer posible que nosotros estemos aquí descubriendo los enigmas del Universo, de los mecanismos que lo rigen, de la materia y de la energía que está presente y, ¿por qué no? de la vida inteligente que en él ha llegado a evolucionar. En las estrellas se crean los elementos esenciales para la vida. Esos elementos esenciales para la vida están elaborandose en los hornos nucleares de las estrellas. Allí, mediante transiciones de fases a muy altas temperaturas, se hace posible la fusión que se produce venciendo la barrera de Coulomb, y a partir del simple Hidrógeno, hacer aparecer materia más compleja que más tarde, mediante procesos físico-químicos-biológicos, hacen posible el surgir de lavida bajo ciertas circunstancias y condiciones especiales de planetas y de la estrellas que teniendo las condiciones similares al Sol y la Tierra, lo hace inevitable.

Pero está claro, como digo, que todo el proceso estelar evolutivo nos condujo desde el simple gas y polvo cósmico a la formación de estrellas y nebulosas en las que se crean moléculas, se forman estrellas nuevas y mundos. La Tierra primigenia en particular, en cuyo medio ígneo, procesos dinámicos dieron lugar a la formación de las estructuras y de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas.

Desde el punto de vista del orden es la primera vez que nos encontramos con objetos de tamaño comparables al nuestro, en los que la ordenación de sus constituyentes es el rasgo más característico. Partiendo de un Caos inicial se han ido acumulando los procesos necesarios para llegar a un orden que, es digno del asombro que nos producen los signos de vida que podemos contemplar por todas partes y, desde luego, tampoco podemos dejar de maravillarnos de que la Naturaleza, valiéndose de mil artimañas, haya podido conseguir la presencia de vida consciente en un mundo, y, muy probablemente, en muchos mundos de muchas galaxias en todo el Universo.

Al mismo tiempo nos ha parecido reconocer que esos objetos, es decir, sus redes cristalinas “reales”, almacenan información (memoria) que se nos muestra muy diversa y que puede cobrar interés en ciertos casos, como el de los microcristales de arcilla, en los que, según Cairns-Smith, puede incluso llegar a transmitirse.

Microcristales de arcilla

Porque, ¿qué sabemos en realidad de lo que llamamos materia inerte? Lo único que sabemos de ella son los datos referidos a sus condiciones físicas de dureza, composición, etc.; en otros aspectos ni sabemos si pueden existir otras propiedades distintas a las meramente físicas. ¿No os hace pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Pero el mundo inorgánico es sólo una parte del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

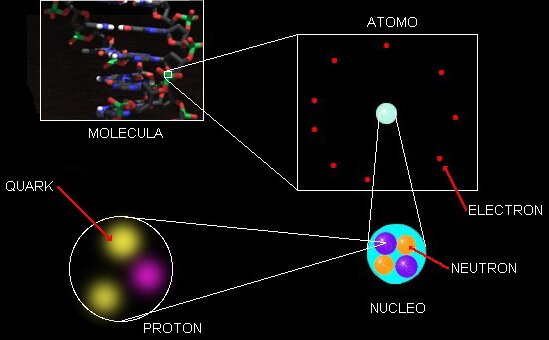

Según decía en trabajos anteriores, los quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, éstos se consideran como una subclase de los hadrones.

La composición de los núcleos (lo que en química se llama análisis cualitativo) es extraordinariamente sencilla, ya que como es sabido, constan de neutrones y protones que se pueden considerar como unidades que dentro del núcleo mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es CnH2n+2, lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

El número de protones y neutrones determina al elemento, desde el hidrógeno (el más simple), al uranio (el más complejo), siempre referido a elementos naturales que son 92; el resto son artificiales, los conocidos transuránicos en cuyo grupo están el einstenio o el plutonio, artificiales todos ellos.

Los núcleos, como sistemas dinámicos de nucleones, pertenecen obviamente a la microfísica y, por consiguiente, para su descripción es necesario acudir a la mecánica cuántica. La materia, en general, aunque presumimos de conocerla, en realidad, nos queda mucho por aprender de ella.

Los átomos se juntan para formar moléculas

El número de especímenes atómicos es finito, existiendo ciertas razones para suponer que hacia el número atómico 173 los correspondientes núcleos serían inestables, no por razones intrínsecas de inestabilidad “radiactiva” nuclear, sino por razones relativistas. Ya antes me referiría a las especies atómicas, naturales y artificiales que son de unos pocos millares; en cambio, el número de moléculas conocidas hasta ahora comprende varios millones de especímenes, aumentando continuamente el número de ellas gracias a las síntesis que se llevan a cabo en numerosos laboratorios repartidos por todo el mundo.

Ya son muchas decenas de moléculas encontradas en las nubes interestelares

Una molécula es una estructura con individualidad propia, constituida por núcleos y electrones. Obviamente, en una molécula las interacciones deben tener lugar entre núcleos y electrones, núcleos y núcleos y electrones y electrones, siendo del tipo electromagnético.

Debido al confinamiento de los núcleos, el papel que desempeñan, aparte del de proporcionar la casi totalidad de la masa de la molécula, es poco relevante, a no ser que se trate de moléculas livianas, como la del hidrógeno. De una manera gráfica podríamos decir que los núcleos en una molécula constituyen el armazón de la misma, el esqueleto, cuya misión sería proporcionar el soporte del edificio. El papel más relevante lo proporcionan los electrones y en particular los llamados de valencia, que son los que de modo mayoritario intervienen en los enlaces, debido a que su energía es comparativamente inferior a la de los demás, lo que desempeña un importante papel en la evolución.

Desde las moléculas más sencilla, como la del hidrógeno con un total de 2 electrones, hasta las más complejas, como las de las proteínas con muchos miles de ellos, existe toda una gama, según decía, de varios millones. Esta extraordinaria variedad de especies moleculares contrasta con la de las especies nucleares e incluso atómicas.

Sin entrar en las posibles diferencias interpretativas de estas notables divergencias, señalaré que desde el punto de vista de la información, las especies moleculares la poseen en mucho mayor grado que las nucleares y atómicas.

Dejando aparte los núcleos, la información que soportan los átomos se podría atribuir a la distribución de su carga eléctrica, y en particular a la de los electrones más débilmente ligados. Concretando un poco se podría admitir que la citada información la soportan los orbitales atómicos, pues son precisamente estos orbitales las que introducen diferencias “geométricas” entre los diferentes electrones corticales.

Justamente esa información es la que va a determinar las capacidades de unión de unos átomos con otros, previo el “reconocimiento” entre los orbitales correspondientes. De acuerdo con la mecánica cuántica, el número de orbitales se reduce a unos pocos. Se individualizan por unas letras, hablándose de orbitales s, p, d, f, g, h. Este pequeño número nos proporciona una gran diversidad.

La llamada hibridación (una especie de mezcla) de orbitales es un modo de aumentar el número de mensajes, esto es, la información, bien entendido que esta hibridación ocurre en tanto y en cuanto dos átomos se preparan para enlazarse y formar una molécula. En las moléculas, la información, obviamente, debe abarcar todo el edificio, por lo que en principio parece que debería ser más rica que en los átomos. La ganancia de información equivale a una disminución de entropía; por esta razón, a la información se la llama también negantropía.

En términos electrónicos, la información se podría considerar proporcionada por un campo de densidad eléctrica, con valles, cimas, collados, etc, es decir, curvas isoelectrónicas equivalentes formalmente a las de nivel en topografía. Parece razonable suponer que cuanto más diverso sean los átomos de una molécula, más rica y variada podrá ser su información, la información que pueda soportar.

La enorme variedad de formas, colores, comportamientos, etc que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor. Si tengo que ser sincero, mi convicción está centrada en que, cualquier forma de vida que podamos encontrar en el Universo, estarán conformadas como las que tenemos y existieron en la Tierra, en el Carbono. Otro elemento no podría dar, tanto…¿juego?

Pero, si hablamos del Universo que es lo que todo lo abarca, en el que están presentes la materia y el espaciotiempo, las fuerzas fundamentales que todo lo rige y las constantes universales que hace que nuestro universo sea de la manera que lo podemos contemplar y, sobre todo, que la vida esté presene en él. Si la carga del electrón, la masa del protón, o, la velocidad de la luz, variaran tan sólo una diesmilésima… ¡La Vida no sería posible!

En la imagen podemos contemplar lo que se clasifica NGC 3603, es un cúmulo abierto de estrellas en una vasta región estelar, rodeada de una región H II (una enorme nube de gas y plasma en el que constantemente están naciendo estrellas), situado en el brazo espiral Carina de la Vía Láctea, a unos 20.000 -luz de distancia en la constelación de Carina. Es uno de los jóvenes cúmulos de estrellas más luminosas e impresionante en la Vía Láctea, y la concentración más densa de estrellas muy masivas conocidas en la galaxia. Se estima que se ha formado hace alrededor de un millón de años. Las estrellas azules calientes en el núcleo son responsables de la fuerte radiación ultravioleta y los vientos estelares, tallando una gran cavidad en el gas.

NGC 3603 alberga miles de estrellas de todos los rangos, tamaños, composiicón y colores: la mayoría tienen masas similares o menores a la de nuestro Sol, pero las más espectaculares son algunas de las estrellas muy masivas que están cerca del final de sus vidas. Ahí están presentes algunas estrellas supergigantes que se agolpan en un volumen de menos de un año luz cúbico, se han localizado en la misma zona a tres llamadas Wolf-Rayet, estrellas muy brillantes y masivas que expulsan grandes cantidades de material antes de convertirse en supernovas.

Una de estas estrellas (NGC 3603-A1), una estrella doble azul que orbita alrededor de otra una vez cada 3,77 días, es la estrella más masiva conocida en la Vía Láctea. La más masiva de estas dos estrellas tiene una masa estimada de 116 masas solares, mientras que su compañera tiene una masa de 89 masas solares. Se estima que la masa máxima de una estrella es de unas 120 masas solares, siendo más masiva, su propia radiación las destruiría.

Las estrellas supermasivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Hace veinte años, los astrónomos fueron testigos de uno de los más brillantes explosiones estelares en más de 400 años. La supernova titánica, llamada SN 1987A, ardió con la fuerza de 100 millones de soles varios meses después de su descubrimiento el 23 de febrero de 1987.

Las observaciones de SN 1987A, hechas en los últimos 20 por el Telescopio Espacial Hubble de NASA / ESA y muchos otros grandes telescopios terrestres y espaciales, han servido para cambiar la perspectiva que los astrónomos tenían de cómo las estrellas masivas terminan sus vidas.Estudiando estos sucesos sus comienzos se pueden ver los detalles más significativos del acontecimiento, cosa que, estuadinado los remanentes de supernovas muy antiguas no se podían ver.

También el clúster abierto NGC 3603 contiene a Sher 25, una super gigante B1a que inevitablemente morirá en un masivo suceso supernova en los próximos 20.000 años (se estima). ¡Esto emitirá una luz tan potente que competirá en el cielo con el planeta Venus! Un detalle muy emocionante es que Sher 25 presenta anillos similares a los que dejó la supernova SN 1987 A que más arriba hemos podido contemplar.

Cuando colapsa el núcleo de una estrella, ocurre en la formación de una estrella de neutrones, es preciso que la estrella esté evolucionada hasta el punto de que su núcleo esté compuesto completamente por hierro, que se niega a ser quemado en reacciones nucleares, no se puede producir la fusión y, por tanto, no produce la energía suficiente como soportar la inmensa fuerza de gravedad que propia masa de la estrella genera y que, solamente era frenada por la energía que produce la fusión nuclear que tiende a expandir la estrella, mientras que la gravedad tiende a contraerla.

El núcleo entonces se contrae, liberando energía potencial gravitatoria, se rompen los núcleos de los átomos de hierro en sus protones y sus neutrones constiituyentes. A medida que aumenta la densidad, los protones se combinan con los electrones para formar neutrones. El colapso sólo se detiene la presión de degeneración del gas de neutrones compensa el empuje hacia adentro de la Gravedad. El proceso completo hasta que se la estrella de neutrones dura de un segundo.

Otra perspectiva del remanente de la supernova por colapso de núcleo SN 1987A.

Han sido muy variados los grupos de astrónomos investigadores que han realizado observaciones durante largos períodos de tiempo llevar a cabo la no fácil tarea de comprender cómo se forman las estrellas de neutrones y púlsares cuando estrellas masivas llegan al final de sus vidas y finalizan el proceso de la fusión nuclear, momento en el que -como explicaba antes- la estrella se contrae, implosiona sobre sí misma, se produce la explosión supernova y queda el remanente formado por material más complejo en forma de gases que han sido expulsados por la estrella en este proceso final en el que, las capas exteriores de la estrella, forman una nebulosa y la estrella en sí misma, al contraerse y hacerse más densa, es decir de 1017 kg/m3.

Se ha podido llegar a saber que las supernovas por colapso de núcleo suelen ocurrir en los brazos de galaxias espirales, así como también en las regiones HII, donde se concentran regiones de formación estelar. Una de las consecuencias de esto es que las estrellas, con masas a partir de 8 veces la masa del Sol, son las estrellas progenitoras de estos estos sucesos cósmicos. También es muy interesante y se está estudiando cómo se forman los inmensos campos magnéticos alreddor de estas estrellas de neutrones y púlsares que se conviertan en magnétares.

Cuando hace unos pocos años se descubrió la estrella de neutrones SGR0418, poco podían pensar los astrónomos que su funcionamiento alteraría todas las teorías existentes acerca del funcionamiento de los magnétares. Sin embargo es así, ya que funciona como uno de éstos y no como sería propio de su condicción. Este hallazgo obliga a la ciencia a replantearse las teorías que se manejaban hasta ahora acerca del origen y evolución de los magnétares.

El “universo” de los procesos que siguen al colapso de los núcleos de las estrellas masivas es fascinante. Así, cuando se un púlsar que es una estrella de neutrones que gira sobre sí misma a una gran velocidad y tambien una fuente de ondas de radio que vibran con periodos regulares, este de estrellas tan extrañas son fruto -como antes decía- de una supernova o por consecuencías de la acreción de materia en estrellas enanas blancas en sistemas binarios. Una enana blanca que también es muy masiva, si tiene una estrella compañera cercana, genera mucha fuerza gravitatoria comienza a tirar del material de la estrella vecina y se lo queda hasta tal punto que, se transforma en una estrella de neutrones en una segunda etapa en la que se producen nuevos procesos de implosión.

La densidad de estas estrellas es increiblemente grande (8×1017 kg/m3), tanto que un cubo de arena lleno del material de una estrella de neutrones tendría un peso parecido al de la montaña mas grande de la tierra. Es decir, que fácilmente la densidad de una E.N. pudiera ser de unas 500.000 veces la masa de la Tierra y tener un diámetro de sólo un par de decenas de kilómetros. Los púlsares fueron descubiertos en 1970 y hasta solo se conece unas 300 estrellas de este tipo. Sin embargo, se calcula que sólo en nuestra Galaxia podrían ser un millón. La rápida rotación de los pùlsares los mantiene fuertemente magnetizados y sus rotaciones vertiginosas generan y son inmensas fuentes de electricidad. Llegan a producir mil millones de millones de voltios. Cuando nustros aparatos los observan y estudian detectan intensos haces de radiación en toda la gama del espectro (radio, luz, rayos X, Gamma).

Imagen de rayos-X en falso color de la región del cielo alrededor de SGR 1627-41 obtenida con XMM-Newton. La emisión indicada en rojo procede de los restos de una estrella masiva que estalló. Cubre una región más extendida de lo que se deducía anteriormente de las observaciones de radio, alrededor del SGR. Esto sugiere que la estrella que estalló fue el progenitor del magnetar. Crédito: ESA/XMM-Newton/EPIC (P. Esposito et al.)

Por ahora se conoce que de cada diez supernovas una se convierte en magnetar, si la supernova posee 6 y 12 masas solares, se convierte en una estrella de neutrones de no más de 10 a 20 km de diámetro. En el caso de las estrellas supermasivas de decenas de masas solares, el resultado es muy diferente y nos encontramos con los agujeros negros, esos monstruos del espacio devoradores de materia.

Cuando una estrella supermasiva muere, las consecuencias energéticas son inmensas. Ahí, en esa explosión se producen transiciones de fase que producen materiales pesados y complejos. En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica de elementos.

La explosión de una estrella gigante y supermasiva hace que brille más que la propia galaxia que la acoge y, en su ese tránsito de estrella a púlsar o agujero negro, se forman elementos que, el oro o el platino, se riegan por el espacio interestelar en las inmensas nebulosas de las que, más tarde, naceran nuevas estrellas y nuevos mundos.

Pero está claro que todo el proceso estelar evolutivo inorgánico nos condujo el simple gas y polvo cósmico a la formación de estrellas y nebulosas solares hasta los planetas, la Tierra en particular, en cuyo medio ígneo describimos la formación de las estructuras de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas. Porque, en última instancia, debemos ser conscientes de un hecho cierto: En las estrellas se ¡ “fabrican los materiales que darán lugar al surgir de la vida”!.

El remanente estelar después de la explosiòn puede ser muy variado

Es posible que lo que nosotros llamamos materia inerte, no lo sea tanto, y, puede que incluso tenga memoria que transmite por medios que no sabemos reconocer. Esta clase de materia, se alía con el tiempo y, en momento adopta una forma predeterminada y de esa manera sigue evolucionando hasta llegar a su máximo ciclo o nivel en el que, de “materia inerte” llega a la categoría de “materia viva”, y, por el camino, ocupará siempre el lugar que le corresponda. No olvidemos de aquel sabio que nos dijo: “todas las cosas son”. El hombre, con aquellas sencillas palabras, elevó a todas las cosas a la categoría de ¡SER!

¿No os pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Claro que, el mundo inorgánico es sólo una del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

Según expliqué muchas veces, los quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, éstos se consideran una subclase de los hadrones. La composición de los núcleos (lo que en química se llama análisis cualitativo) es extraordinariamente sencilla, ya que como es sabido, constan de neutrones y protones que se pueden considerar como unidades que dentro del núcleo mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es CnH2n+2, lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

Bueno, otra vez, como tantas veces me pasa, me desvío del camino que al principio del trabajo me propuse seguir y me pierdo en las elucubraciones que imaginan mis pensamientos. Mejor lo dejamos aquí.

emilio silvera

Totales: 75.040.300

Totales: 75.040.300 Conectados: 118

Conectados: 118