Jun

2

¿La Naturaleza? ¡La maravilla de las “mil” maravillas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cosas curiosas ~

Clasificado en Cosas curiosas ~

Comments (1)

Comments (1)

Es curioso como en el Universo las cosas tienden a repetirse. La Naturaleza tiene sus leyes para crear las cosas de la manera más sencilla y económica posible y siempre, tiende a ser práctica dándo formas que contribuyen a la estabilidad individual y de conjunto. Son esféricos los mundos, tienen forma de inmensos platillos volantes las galaxias, podemos ver como las inmensas nebulosas se esparcen por el espacio interestelar formando nuevas estrellas y ese suceso se repite una y otra vez en nuestra Galaxia y en todas las demás. Todo es fruto de dos fuerzas contrapuestas que hace estable las cosas: Un átomo tiene el núcleo con los protones cargados positivamente y, la presencia de electrones con la misma carga negativa, hace posible que existan y se puedan unir para formar moléculas y éstas a su vez para formar cuerpos.

Siempre está presente el jhecho de que pueda ocurrir un suceso en particular. Generalmente consideramos a la probabilidad como un axioma matemático que estima la tendencia que tiene algo a ocurrir en el universo físico. Pero la probabilidad es algo que existe en la naturaleza, embebida en las fluctuaciones cuánticas. Esto, en otras palabras, significa que al tirar una moneda al aire, o al realizar cualquier acción, detonamos un proceso cuántico a nivel molecular que es el que determina de que lado cae. Lo interesante aquí es que se plantea que el mundo cuántico, con todas sus extrañas propiedades, define cualquier situación de la realidad macroscópica.

No pocas veces hemos oído decir que el Universo surgió de una fluctuación del vacío, de la nada, y, lo cierto es que si surgió es porque había. Nada puede surgir de la NADA. Hay que prestar atención a lo que llamamos fluctuaciones que son desviaciones aleatorias en el valor de una cantidad sobre un valor medio. En todos los sistemas descritos por la mecánica cuántica aparecen las fluctuaciones, llamadas las fluctuaciones cuánticas -incluso en el cero absoluto de temperatura termodinámica como resultado del Principio de Indeterminación o Incertidumbre de Heisenberg-.

Un ejemplo de fluctuaciones nos lo ofrece la nebulosa Boomerang, ubicada a 5.000 años luz de la Tierra en la constelación de Centaurus, tiene una temperatura en centígrados de -272º C, algo absolutamente inimaginable en términos terrestres. Las nebulosas planetarias, son estrellas nuestro Sol, pero que se encuentran en las fases finales de su vida y que han perdido ya sus capas exteriores. En el caso de la Boomerang, se trata de una nebulosa preplanetaria, inmediatamente antes de la fase planetaria con lo cual todavía no está ni siquiera lo suficientemente caliente como emitir radiación ultravioleta.

En cualquier sistema por encima del cero absoluto se presentan las fluctuaciones, llamadas fluctuaciones térmicas. Es necesario tener en cuenta las fluctuaciones para obtener una teoría cuantitativa de las transiciones de fase en tres dimensiones. Las fluctuaciones cuánticas pudieron ser las responsables de la formación de estructuras en el universo primitivo.

Podemos hablar de transiciones de fase al referirnos a las características de un sistema y los cambios que allí se producen. Algunos ejemplos de transiciones de fase son los cambios de sólidos a líquidos, líquido a gas y los cambios inversos. Otros ejemplos de transiciones de fase incluyen la transición de un paramagneto a un ferromagneto y la transición de un metal conductor normal a superconductor. Las transiciones de fase pueden ocurrir al alterar variables como la temperatura y la presión. Un ejemplo de transición de fase a “cámara lenta” -por lo que suele tardar-, es ver como una estrella como nuestro Sol, se convierte en gigante roja primero y en enana blanca después. Existen transiciones prohíbidas que, sin embargo, cuando el acoplamiento espín-órbita es tenido en cuenta… ¡se vuelven permitidas!, aumentando su intensidad con la intensidad del acoplamiento espín-órbita. Pero eso, es otra historia.

La materia siempre está implicada cuando hablamos de fluctuaciones

¡Tiene y encierra tantos misterios la materia!…, que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen y que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Sí, sabemos ponerles etiquetas , por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

¡Parece que la materia está viva!

¿Y la Luz, qués es la Luz? Dicen que el día que sepamos descubrir los misterios que encierran el electrón (e–) -electromagnetismo-, el fotón ( lambda” />), c, la velocidad d ela luz en el vacío –relatividad– y, el cuanto de Planc (h), la constante de Planck, ese día, se habrá conseguido despejar los más grandes misterios de la Naturaleza que están profundamente escondidos en lo que se llama alfa (α), la constante de estructura fina 1/137. Otra vez el dichoso número 137 puro y adimensional, un número que no lo inventaron los hombres y que está en la Naturaleza tal cual, cargado de mensajes que debemos desvelar.

lambda” />), c, la velocidad d ela luz en el vacío –relatividad– y, el cuanto de Planc (h), la constante de Planck, ese día, se habrá conseguido despejar los más grandes misterios de la Naturaleza que están profundamente escondidos en lo que se llama alfa (α), la constante de estructura fina 1/137. Otra vez el dichoso número 137 puro y adimensional, un número que no lo inventaron los hombres y que está en la Naturaleza tal cual, cargado de mensajes que debemos desvelar.

Muchas son las cosas que hemos podido llegar a saber pero…, muchas más son las que desconocemos. Sabemos que el electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por tal motivo, han sido denominados leptones (de la voz griega lepto que significa “delgado”). Sin embargo y a pesar de su aparente insignificancia, el electrón es tan importante para nosotros que, simplemente con que su carga variara una diezmillonésima, ¡los átomos no se podrían formar! Y, en ese caso, ¿Qué universo sería el nuestro?

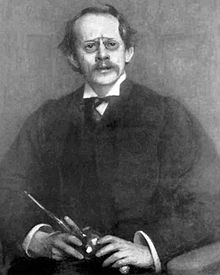

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y también su radio clásico. No se ha descubierto aún ninguna partícula que sea masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que es la que se muestra en el electrón.

Josepth John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí .

(“Aunque no se trata propiamente de la imagen real de un electrón, un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas.

Louis de Broglie

En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.) lo dejaron bien explicado.

Imagen ilustrativa de lo que pretender ser la dualidad onda-partícula, en el cual se puede ver (según se cree) cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin ) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

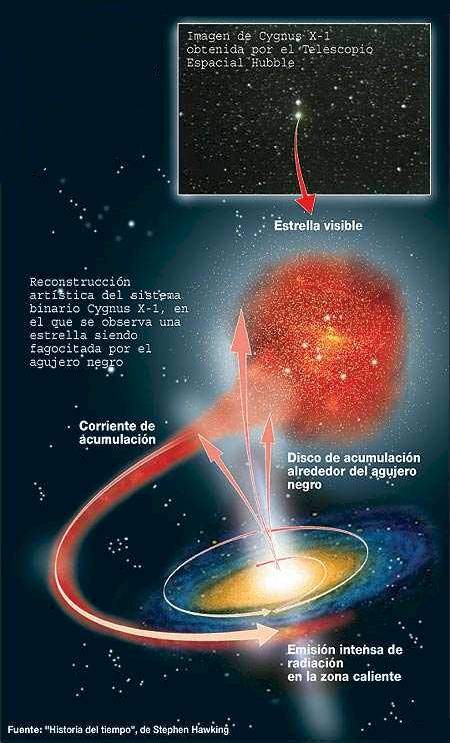

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones. Tenemos varios proyectos en marcha de la NASA y otros Organismos oficiales que buscan las ondas gravitatorias de los agujeros negros, de colisiones estrellas de neutrones y de otras fuentes análogas que, según se cree, nos hablará de “otro universo”, es decir, nos dará información desconocida y sabremos “ver” un universo distinto… ¡El reflejado por las ondas elecromagnéticas! que es el que ahora no conocemos.

¡Sorpresa!

El físico Stephen Hawking da una rueda de prensa ante los medios gallegos en el Porta do Camiño en su visita a Santiago de Compostela (A Coruña). / Andres Fraga

“Stephen Hawking y los agujeros negros están indisolublemente ligados. No es que los descubriera él, ni mucho menos, pero sus investigaciones e importantes aportaciones sobre estos exóticos objetos predichos teóricamente y detectados (por sus efectos) en el universo, se remontan a trabajos clave de hace más de cuatro décadas. Ahora afirma que no existen los agujeros negros, al menos como se entienden habitualmente. En su momento presentó un artículo, una prepublicación que aún no ha pasado el proceso normal de revisión científica, pero que inmediatamente ha ganado notoriedad. Lo firma él solo, tiene cuatro páginas (una de presentación, dos de argumento y la última de referencias) y lleva un título extraño:Conservación de la información y predicción meteorológica para los agujeros negros. Los físicos presentan habitualmente sus artículos en la web arXiv, donde son públicos, antes de someterlos al proceso de evaluación de expertos obligado su la publicación oficial.”

Lo cierto es que, sería una enorme decepción si se confirmara que los Agujeros Negros no existe. Es mucho lo que de ellos se ha escrito y muchas las horas y estudios e investigaciones que han sido realizadas acerca de estos exóticos objetos del Universo. Me pasa con ésta noticia como con aquella en la que alguien decía que el fotón no existía, o, que los electrones corrían más que los fotones. Ambas noticias, la del fotón y la del agujero negro, me parecen disparatadas, ya que, si no existen lo fotones ¿que es la Luz? y, cuál es el cuanto o bosón intermediario del electromagnetiusmo? Y, en relación a los agujeros negros, ¿en qué se convierte una estrella masiva al final de su vida? ¿Qué hay más allá de las estrellas de neutrones? ¿Qué son esos focos de radiación que se detectan en el centro de las galaxias y que atraen hacia ellos descomunales cantidades de materia? ¡Parece que empezamos a desvariar!

Tendré que leer el artículo del Señor Hawking pero… ¡Tengo mis dudas de que acierte en sus predicciones!

emilio silvera

Jun

2

Rumores del pasado

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (3)

Comments (3)

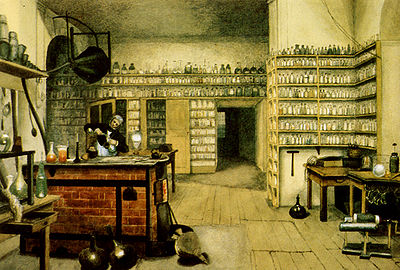

Faraday dando una charla sobre sus trabajos y explicándo al público lo que era la luz y la electricidad

En su juventud, Michael Faraday tuvo unos humildes comienzos como repartidor de periódicos y aprendiz de encuadernador. Sin embargo, su afición al experimento y la investigación le llevó a descubrir algunos de los secretos más guardados de la Naturaleza. De hecho, el concepto de “Campo” que tanto hoy manejan los físicos, es debido a él. Gracias a sus trabajos y los resultados obtenidos en sus miles de experimentos, pudo Maxwell (un gran físico y matemático), crear su teoría de la luz y el electromagnetismo mediante sus famosas ecuaciones vectoriales.

James Clark Maxwell

El trabajo más importante de Maxwell se efectuó entre 1864 y 1873, cuando dio forma matemática a las especulaciones de Faraday respecto a las líneas de fuerza magnéticas. Al hacerlo, Maxwell, pudo conseguir unas cuantas ecuaciones simples que expresaban todos los fenómenos variados de electricidad y magnetismo y las unió de un modo indisoluble. Su teoría demostraba que la electricidad y el magnetismo no podían existir aisladamente, donde esta una allí estaba el otro, por tanto, se hace referencia a su obra, generalmente, como la teoría del electromagnetismo.

La “profesionalización” e “institución” de la ciencia, entendiendo por tal que la práctica de la investigación científica se convirtiese en una profesión cada vez más abierta a personas sin medios económicos propios, que se ganaban la vida a través de la ciencia y que llegasen a atraer la atención de gobiernos e industrias, tuvo su explosión a lo largo de 1.800, y muy especialmente gracias al desarrollo de dos disciplinas, la química orgánica y el electromagnetismo. Estas disciplinas, junto a las matemáticas, la biología y las ciencias naturales (sin las cuales sería una necedad pretender que se entiende la naturaleza, pero con menos repercusiones socio-económicas), experimentaron un gran desarrollo entonces, tanto en nuevas ideas como en el número de científicos importantes: Faraday, Maxwell, Lyell, Darwin y Pasteur, son un ejemplo. Sin olvidar a otros como Mendel, Helmholtz, Koch, Virchow, Lister o Kelvin, o la matemática de Cauchy, de Gauss, Galois, Fourier, Lobachevski, Riemann, Klein, Cantor, Russell, Hilbert o Poincaré. Pero vamos a pararnos un momento en Faraday y Maxwell.

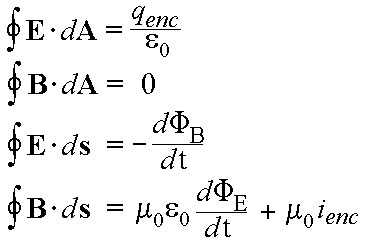

Las ecuaciones de Maxwell, por dar una simple explicación de lo que significan, hace posible que tengamos una información fidedigna de cómo se transmite la información para la televisión, Internet y la telefonía en general, cuánto tarda en llegarnos la luz de las estrellas, cuál es la base del funcionamiento de las neuronas o como funciona cualquier central de electricidad, aparte de otros miles de fenómenos que podemos estar experimentando en nuestras vidas cotidianas que están relacionados con la luz, la electricidad y el magnetismo. Y, todo ello, se explica con esas cuatro “sencillas ecuaciones”.

Para la electricidad, magnetismo y óptica, fenómenos conocidos desde la antigüedad, no hubo mejor época que el siglo XIX. El núcleo principal de los avances que se produjeron en esa rama de la física (de los que tanto se benefició la sociedad -comunicaciones telegráficas, iluminación, tranvías y metros, etc.-) se encuentra en que, frente a lo que se suponía con anterioridad, se descubrió que la electricidad y el magnetismo no eran fenómenos separados.

Estatua de Hans Christian Ørsted en Ørstedsparken, Copenhague, Dinamarca. Hans Christian Orsted físico y químico danés, que descubrió en 1819 que la aguja imantada de una brújula se desviaba cuando se encontraba próxima a un cable conductor por el cual fluía una corriente eléctrica. Esta desviación implica la existencia de un campo magnético en la región vecina al conductor. Asi se demostraba la existencia de un campo magnético en torno a todo conductor por el que fluye una corriente eléctrica, este descubrimiento fue crucial ya que puso en evidencia la relación existente entre la electricidad y el magnetismo.

Así que, el punto de partida para llegar a este resultado crucial fue el descubrimiento realizado en 1.820 por el danés Hans Christian Oersted (1777 – 1851) de que la electricidad produce efectos magnéticos: observó que una corriente eléctrica desvía una aguja imanada. La noticia del hallazgo del profesor danés se difundió rápidamente, y en París André-Marie Ampère (1775 – 1836) demostró experimentalmente que dos hilos paralelos por los que circulan corrientes eléctricas de igual sentido, se atraen, repeliéndose en el caso de que los sentidos sean opuestos.

La expresión diferencial

∇×H ≡ J (“Ley de Ampère“)

Conocida como “Ley de Ampère“, muestra la relación que existe entre el campo H y la fuente J cuando las corrientes y los campos no cambian el tiempo, pero falla cuando los fenómenos no son estacionarios. La contribución de Maxwell se resume en haber agregado a J, el sumando ∂D/∂t correspondiente a la corriente de desplazamiento en los fenómenos no estacionarios, algo que nadie había medido y que no resultaba intuitivo. La falta de ese término deja fuera los casos dinámicos, muchos casos tan importantes como por ejemplo las Ondas Electromagnéticas !

Con esta formulación, Ampère avanzaba la expresión matemática que representaba aquellas fuerzas. Su propósito era dar una teoría de la electricidad sin más que introducir esa fuerza (para él “a distancia”).

Pero el mundo de la electricidad y el magnetismo resultó ser demasiado complejo como para que se pudiera simplificar en un gráfico sencillo, como se encargó de demostrar uno de los grandes nombres de la historia de la ciencia: Michael Faraday (1791 – 1867), un aprendiz de encuadernador que ascendió de ayudante de Humphry Davy (1778 – 1829) en la Royal Intitution londinense.

En este humilde rinconcillo trabajaba -Faraday

En 1.821, poco después de saber de los trabajos de Oersted, Faraday, que también dejó su impronta en la química, demostró que un hilo por el que pasaba una corriente eléctrica podía girar de manera continua alrededor de un imán, con lo que vio que era posible obtener efectos mecánicos (movimiento) de una corriente que interacciona con un imán. Sin pretenderlo, había sentado el principio del motor eléctrico, cuyo primer prototipo sería construido en 1.831 por el físico estadounidense Joseph Henry (1797 – 1878).

Lo que le interesaba a Faraday no eran necesariamente las aplicaciones prácticas, sino principalmente los principios que gobiernan el comportamiento de la naturaleza, y en particular las relaciones mutuas entre fuerzas, de entrada, diferentes. En este sentido, dio otro paso importante al descubrir, en 1.831, la inducción electromagnética, un fenómeno que liga en general los movimientos mecánicos y el magnetismo con la producción de corriente eléctrica.

Este fenómeno, que llevaría a la dinamo, representaba el efecto recíproco al descubierto por Oersted; ahora el magnetismo producía electricidad , lo que reforzó la idea de que un lugar de hablar de electricidad y magnetismo como entes separados, sería más preciso referirse al electromagnetismo.

La intuición natural y la habilidad experimental de Faraday hicieron avanzar enormemente el estudio de todos los fenómenos electromagnéticos. De él es, precisamente, el concepto de campo que tanto juego ha dado a la física.

Sin embargo, para desarrollar una teoría consistente del electromagnetismo se necesitaba un científico distinto: Faraday era hábil experimentador con enorme intuición, pero no sabía expresar matemáticamente lo que descubría, y se limitaba a contarlo. No hubo que esperar mucho, ni salir de Gran Bretaña para que un científico adecuado, un escocés de nombre James Clerk Maxwell (1831 – 1879), hiciera acto de presencia.

Las ecuaciones de Maxwell cumplieron 150 años el pasado día 14 abril 2014. Publicado por Augusto en Divulgación, Historia de la Física. Las ecuaciones de Maxwell son un conjunto de cuatro ecuaciones (originalmente 20 ecuaciones) que describen por completo los fenómenos electromagnéticos. La gran contribución de James Clerk Maxwell fue reunir en estas ecuaciones largos años de resultados experimentales, debidos a Coulomb, Gauss, Ampere, Faraday y otros, introduciendo los conceptos de campo y corriente de desplazamiento, y unificando los campos eléctricos y magnéticos en un solo concepto: El Campo Electromagnético.

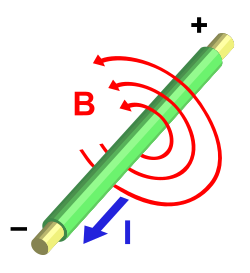

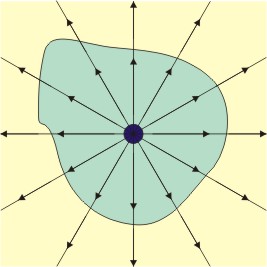

Las cuatro ecuaciones de Maxwell describen todos los fenómenos electromagnéticos, aquí se muestra la inducción magnética por medio de una corriente eléctrica en la figura situada en primer lugar. En la segunda se quiere escenificar el Flujo eléctrico de una carga puntualen una superficie cerrada. En la tercera imagen, quedan escenificadas las líneas de campo magnético que comienzan y terminan en el mismo lugar, por lo que no existe un monopolo magnético.

Maxwell desarrolló las matemáticas para expresar una teoría del magnetismo-electricidad (o al revés) que sentó las bases físicas de aquel fenómeno y contestaba a todas las preguntas de los dos aspectos de aquella misma cosa, el electromagnetismo. En sus ecuaciones vectoriales estaban todos los experimentos de Faraday, que le escribió una carta pidiéndole que le explicara, con palabras sencillas, aquellos números y letras que no podía entender.

Pero además, Maxwell también contribuyó a la física estadística y fue el primer director del Laboratorio Cavendish, unido de manera indisoluble a la física de los siglos XIX y XX (y también al de biología molecular) con sede en Cambridge.

Su conjunto de ecuaciones de, o en, derivadas parciales rigen el comportamiento de un medio (el campo electromagnético) que él supuso “transportaba” las fuerzas eléctricas y magnéticas; ecuaciones que hoy se denominan “de Maxwell”. Con su teoría de campo electromagnético, o electrodinámica, Maxwell logró, además, unir electricidad, magnetismo y óptica. Las dos primeras, como manifestaciones de un mismo substrato físico, electromagnético, que se comporta como una onda, y la luz, que es ella misma, una onda electromagnética, lo que, en su tiempo, resultó sorprendente.

Más de ciento treinta años después, todavía se podía o se puede apreciar la excitación que sintió Maxwell cuando escribió en el artículo Sobre las líneas físicas de la fuerza, 1861 – 62, en el que presentó esta idea: “Difícilmente podemos evitar la inferencia de que la luz consiste de ondulaciones transversales del mismo medio que es la causa de los fenómenos eléctricos y magnéticos.”

Todo aquello fue posible gracias a las bases sentadas por otros y a los trabajos de Faraday como experimentador infatigable, que publicaba sus resultados en artículos y los divulgaba en conferencias en la sede de la Royal Institution londinense. Todos estos artículos y conferencias fueron finalmente publicados en el libro que llamaron Philosophical transactions de la Royal Society, y Experimental researches in chemistry and physics (Richard Taylor y William Francis, Londres, 1859; dos grandes científicos unidos por la historia de la ciencia que nos abrieron puertas cerradas que nos dejaron entrar al futuro).

Claro que, si miramos hacia atrás en el tiempo, ¿cuántas historias como ésta podemos encontrar? Para cualquiera de las cosas que ahora sabemos, casi siempre, ha sido necesario aunar los pensamientos dispersos de muchos que, aunados en un sólo y completo pensamiento, ha podido formar la teoría final que nos explicaron el funcionamiento de la Naturaleza. Así ha ocurrido siempre y seguirá pasando. Einstein se tuvo que vales de ideas dispersas de Mach, Maxwell, Riemann, Lorentz y algunos otros para poder formular su bella Teoría de la Relatividad.

Faraday fue el prototipo de expèrimentador de los fenómenos físicos

A finales del siglo XIX, poca gente sabía con exactitud a qué se dedicaban los “físicos”. El término mismo era relativamente nuevo. En Cambridge, la física se enseñaba como del grado de matemáticas. En este sistema no había espacio la investigación: se consideraba que la física era una rama de las matemáticas y lo que se le enseñaba a los estudiantes era como resolver problemas.

En la década de 1.870, la competencia económica que mantenían Alemania, Francia, Estados Unidos, y Gran Bretaña se intensificó. Las Universidades se ampliaron y se construyó un Laboratorio de física experimental en Berlín.

Cambridge sufrió una reorganización. William Cavendish, el séptimo duque de Devonshire, un terrateniente y un industrial, cuyo antepasado Henry Cavendish había sido una temprana autoridad en teoría de la gravitación, accedió a financiar un Laboratorio si la Universidad prometía fundar una cátedra de física experimental. Cuando el laboratorio abrió, el duque recibió una carta en la que se le informaba (en un elegante latín) que el Laboratorio llevaría su nombre.

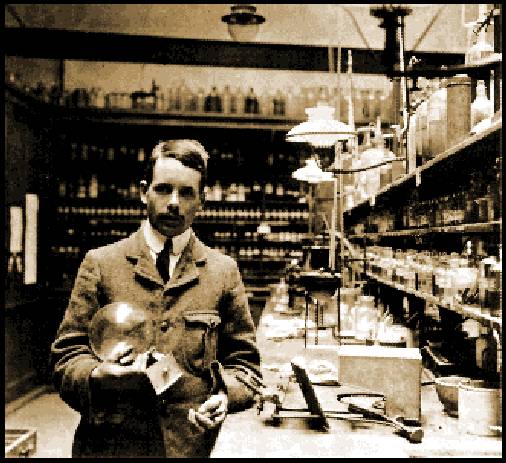

Primer profesor J. J. Thomson director del laboratorio

Tras intentar conseguir sin éxito atraer primero a William Thomson, más tarde a lord Kelvin (quien otras cosas, concibió la idea del cero absoluto y contribuyó a la segunda ley de la termodinámica) y después a Hermann von Helmohltz, de Alemania (entre cuyas decenas de ideas y descubrimientos destaca una noción pionera del cuanto), finalmente se ofreció la dirección del centro a James Clerk Maxwell, un escocés graduado en Cambridge. Este fue un hecho fortuito, pero Maxwell terminaría convirtiéndose en lo que por lo general se considera el físico más destacado entre Newton y Einstein. Su principal aportación fue, por encima de todo, las ecuaciones matemáticas que permiten entender perfectamente la electricidad y el magnetismo. Estas explicaban la naturaleza de la luz, pero también condujeron al físico alemán Heinrich Hertz a identificar en 1.887, en Karlsruhe, las ondas electromagnéticas que hoy conocemos ondas de radio.

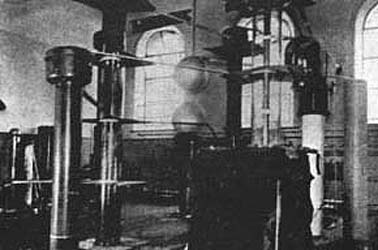

En el Laboratorio Cavendish de la Universidad de Cambridge, Cockcroft y Walton construyeron este acelerador de 500 kilovolts en 1932. Si lo comparamos con el LHC del CERN nos podemos dar de cómo la Ciencia ha ido avanzando en relativamente tan poco tiempo y, desde entonces hemos alcanzado un nivel que nos permite trabajar con 14 TeV, una energía de todo punto imposible e impensable en aquellos primeros tiempos.

Maxwell también creó un programa de investigación en Cavendish con el propósito de idear un estándar preciso de medición eléctrica, en particular la unidad de resistencia eléctrica, el ohmio. Esta era una cuestión de importancia internacional debido a la enorme expansión que había experimentado la telegrafía en la década de 1.850 y 1.860, y la iniciativa de Maxwell no solo puso a Gran Bretaña a la vanguardia de este campo, sino que también consolidó la reputación del Laboratorio Cavendish como un centro en el que se trataban problemas prácticos y se ideaban nuevos instrumentos.

Tubo de vacío usado por JJ Thomson en uno de los experimentos realizados para el electrón. Expuesto en el museo del laboratorio Cavendish. Aquellos físicos primeros que abrieron el camino a lo que más tarde sería la física moderna, tuvieron un gran mérito al poder avanzar hacia el conocimientos de las cosas, de la Naturaleza, con pocas herramientas y mucha imaginación.

A este hecho es posible atribuir del crucial papel que el laboratorio iba a desempeñar en la edad dorada de la Física, entre 1.897 y 1.933. Los científicos de Cavendish, se decía, tenían “sus cerebros en la punta de los dedos.”

Maxwell murió en 1.879 y le sucedió lord Rayleigh, quien continuó su labor, pero se retiró después de cinco años y, de manera inesperada, la dirección pasó a un joven de veintiocho años, Joseph John Thomson, que a pesar de su juventud ya se había labrado una reputación en Cambridge como un estupendo físico-matemático. Conocido universalmente como J.J., puede decirse que Thomson fue quien dio comienzo a la segunda revolución científica que creó el mundo que conocemos.

Ernest Rutherford otro experimentador

Se dedicó al estudio de las partículas radioactivas y logró clasificarlas en alfaa (α), beta (β) y gamma (γ). Halló que la radiactividad iba acompañada por una desintegración de los elementos, lo que le valió ganar el Premio Nobel de Química de 1908. Se le debe un modelo atómico con el que probó la existencia de núcleol en los átomos, en el que se reúne toda la carga positiva y casi toda la masa del átomo. Consiguió la primera transmutación artificial con la colaboración de su discípulo Frederick Soddy.

Henry Cavendish en su Laboratorio

La primera revolución científica comenzó con los descubrimientos de Copérnico, divulgados en 1.543, y los de Isaac Newton en 1.687 con su Gravedad y su obra de incomparable valor Principia Matemática, a todo esto siguió los nuevos hallazgos en la Física, la biología y la psicología.

Pero fue la Física la que abrió el camino. Disciplina en permanente cambio, debido principalmente a la de entender el átomo (esa sustancia elemental, invisible, indivisible que Demócrito expuso en la Grecia antigua).

John Dalton

En estos primeras décadas del siglo XIX, químicos como John Dalton se habían visto forzados a aceptar la teoría de los átomos como las unidades mínimas de los elementos, con miras a explicar lo que ocurría en las reacciones químicas (por ejemplo, el hecho de que dos líquidos incoloros produjeran, al mezclarse, un precipitado blanco). De similar, fueron estas propiedades químicas y el hecho de que variaran de forma sistemática, combinada con sus pesos atómicos, lo que sugirió al ruso Dimitri Mendeleyev la organización de la Tabla Periódica de los elementos, que concibió jugando, con “paciencia química”, con sesenta y tres cartas en su finca de Tver, a unos trescientos kilómetros de Moscú.

Pero además, la Tabla Periódica, a la que se ha llamado “el alfabeto del Universo” (el lenguaje del Universo), insinuaba que existían todavía elementos por descubrir. Aparte de los elementos naturales registrados en la Tabla Periódica (del Hidrógeno nº 1 al Uranio nº 92), existen otros elementos que son artificiales, como el Einsteinio o el Polonio, el Plutonio y el Californio, todos ellos pertenecientes al grupo de los Transuránicos, es decir, los que están más allá del Uranio.

Dimitri Mendeléiev en 1897

La tabla de Mendeleyev encajaba a la perfección con los hallazgos de la Física de partículas, con lo que vinculaba física y química de racional: era el primer paso hacia la unificación de las ciencias que caracterizaría el siglo XX.

En Cavendish, en 1.873, Maxwell refinaría la idea de átomo al introducir la idea de campo electromagnético (idea que tomó prestada de Faraday), y sostuvo que éste campo “impregnaba el vacío” y la energía eléctrica y magnética se propagaba a través de él a la velocidad de la luz. Sin embargo, Maxwell aún pensaba en el átomo como algo sólido y duro y que, básicamente, obedecían a las leyes de la mecánica.

El problema estaba en el hecho de que, los átomos, si existían, eran demasiado pequeños ser observados con la tecnología entonces disponible.

Esa situación empezaría a cambiar con Max Planck, el físico alemán que, como de su investigación de doctorado, había estudiado los conductores de calor y la segunda ley termodinámica, establecida originalmente por Rudolf Clausius, un físico alemán nacido en Polonia, aunque lord Kelvin también había hecho algún aporte.

El joven Max Planck

Clausius había presentado su ley por primera vez en 1.850, y esta estipulaba algo que cualquiera podía observar, a saber, que cuando se realiza un la energía se disipaba convertida en calor y que ese calor no puede reorganizarse en una forma útil. Esta idea, que por lo demás parecería una anotación de sentido común, tenía consecuencias importantísimas.

Dado que el calor (energía) no podía recuperarse, reorganizarse y reutilizarse, el Universo estaba dirigiéndose gradualmente un desorden completo:

cántaro roto…

Una casa que se desmorona nunca se reconstruye así misma, una botella rota nunca se recompone por decisión propia. La palabra que Clausius empleó designar este fenómeno o desorden irreversible y creciente fue “entropía”: su conclusión era que, llegado el , el Universo moriría.

En su doctorado, Planck advirtió la relevancia de esta idea. La segunda ley de la termodinámica evidenciaba que el tiempo era en verdad una fundamental del Universo, de la física. Sea lo que sea, el tiempo es un componente básico del mundo que nos rodea y se relaciona con la materia de formas que todavía no entendemos.

La noción de tiempo implica que el Universo solo funciona en un sentido, hacia delante, nunca se está quieto ni funciona hacia atrás, la entropía lo impide, su discurrir no tiene marcha atrás. ¿No será nuestro discurrir lo que siempre marcha hacia delante, y, lo que tenemos por tiempo se limita a estar ahí?

En el Laboratorio Cavendish, me viene a la memoria que fue allí, donde Thomson, en 1.897, realizó el descubrimiento que vino a coronar anteriores ideas y trabajos de Benjanmin Franklin, Euge Goldstein, Wilhelm Röntgen, Henri Becquerel y otros. El descubrimiento del electrón convirtió a la física moderna en una de las aventuras intelectuales más fascinantes e importantes del mundo contemporáneo.

Joseph John Thomson

Los “corpúsculos”, como Thomson denominó inicialmente a estas partículas, hoy conocidas como electrones, condujo de directa al trascendental avance realizado una década después por Ernest Rutherford, quien concibió el átomo como una especie de “sistema solar” en miniatura, con los electrones diminutos orbitando alrededor de un núcleo masivo como hacen los planetas alrededor del Sol. Rutherford demostró experimentalmente lo que Einstein había descubierto en su cabeza y revelado en su famosa ecuación, E = mc2 (1905), esto es que la materia y la energía eran esencialmente lo mismo.

Todo aquello fue un gran paso en la búsqueda del conocimiento de la materia. El genio, la intuición y la experimentación han sido esenciales en la lucha del ser humano con los secretos, bien guardados, de la Naturaleza.

emilio silvera

Jun

2

El Universo asombro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

¡NO! No es el gran Ojo que todo lo ve y nos mira desde las alturas

Simplemente se trata del fenómeno que conocemos como “Halo atmosférico”, un anilo o arco de luz que parece rodear al Sol (también a la Luna), resultado de la refracción y la reflexión de la luz solar o lunar por los cristales de hielo de los cirros. Los halos solares y lunares más comunes tienen un diámetro angular de 46º. Por lo general, el borde del halo muestra un efecto prismático, estandio la luz azul refractada hacia el borde exterior y la rpoja al interior. Como resultado de la refracción preferencial de la luz hacia el borde del halo , la zona del cielo interior a un halo completo es más oscura que la interior. Los halos lunares solo pueden ser vistos claramente cuando la Luna es brillante, típicamente en un intervalo de cinco días en torno a la Luna llena.

El Halo Galáctico está referido a cualquier material situado en una distribicón aproximadamente esférica alrededor de una galaxia, y que se extiende hasta más allá de las regiones visibles. Puede referirse a la población de estrellas viejas (Población II), incluyendo a los cúmulos globulares, con poca o ninguna rotación alrededor del centro galáctico; o gas tenue, altamente ionizado y de alta temperatura que envelve a toda la galaxia, incluso, muchas veces el halo galáctico está referido a una especie de neblina inconcreta que circunda toda la galaxia sin que termine de hacerse presente pero, ahí está.

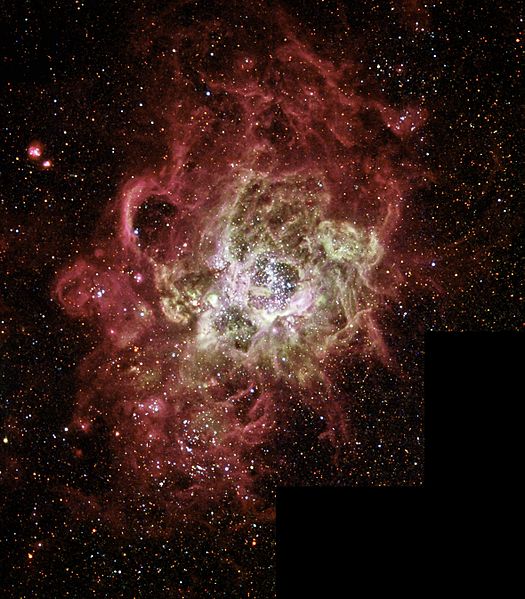

Alguna vez podemos contemplar una imagen que nos parece más o menos atractiva pero, no sabemos discernir sobre lo que en realidad estamos contemplando. Por ejempo, arriba tenemos la conocida como NGC 604, una región H II gigante en la galaxia del Triángulo. Una región H II es una nube de gas y plasma brillante que puede alcanzar un tamaño de varios cientos de años-luz y en la cual se forman estrellas masivas. Dichas estrellas emiten copiosas cantidades de luz ultravioleta extrema (con longitudes de onda inferiores a 912 Ångstroms) que ionizan la Nebulosa a su alrededor.

Las regiones H II son muy abundantes en nuestra Galaxia

Cada átomo de hidrógeno ionizado contribuye con dos partículas al gas, es decir, con un protón y un electrón. Las Regiones H II son calientes con temperaturas típicas de 10 000 K, y son entre 10 y 100 000 veces más densas que las regiones H I. Se encuentran normalmente alrededor de las estrellas O y B jóvenes y masivas, siendo el gas ionizado por su intensa luz ultraviloleta, haciendo que éste brille. La Nebulosa de orión es una famosa Región H II. Las Regiones H II pueden ser detectadas en la Galaxia por sus intensas emisiones en radio e infrarrojo. La radioemisión es debidaal bremsstrahlung del gas ionizado, y la radiación infrarroja a la emisión térmica del polvo.

Las Regiones H II están aquí muy presentes y dada su gran extensión. La nebulosa de Orión es uno de los objetos astronómicos más fotografiados, examinados, e investigados.8 De ella se ha obtenido información determinante acerca de la formación de estrellas y planetas y a partir de nubes de polvo y gas en colisión. Los astrónomos han observado en sus entrañas discos protoplanetarios, enananas marrones, fuertes turbulencias en el movimiento de partículas de gas y efectos fotoionizantes cerca de estrellas muy masivas próximas a la nebulosa.

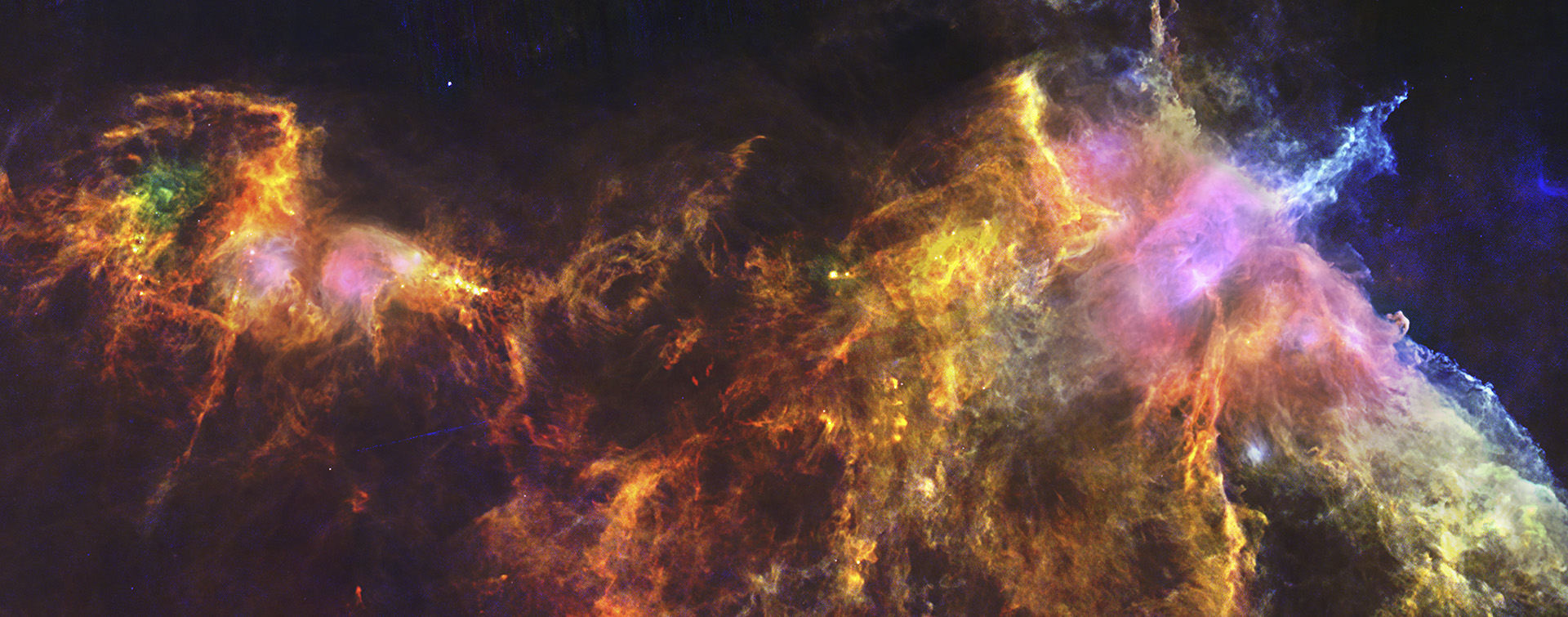

Una región H I es una nube formada por hidrógeno atómico frío, poco denso y no ionizado con temperaturas de alrededor de 100 K. Las regiones HI no emiten radiación en el rango visual, sólo en la región de radio. La notación H I se refiere al hecho de que los átomos de Hidrógeno no están ionizados como lo están en los que están presentes en la regiones H II (arriba). Cada átomo de Hidrógeno neutro contribuye al gas justo con una partícula. la Densidad de las regiones H I es demasiado baja como para que se formen moléculas de hidrógeno, y la luz estyelar disociará cualquier molécula formada, de manera que el gas permanece en forma de átomo. El Hidrñógeno neutro contrinuye aproximadamernte a la mitad de toda la materia interestelar en masa y en volumen, con una densidad media de 1 Átomo/ cm3. Las regiones H I son frías.

Del asomnbroso universo son miuchas las cosas que desconocemos, y, poco a poco, vamos pudiendo descubrir muchos de sus misterios que nos acercan cada vez más, a saber dónde estamos y lo que podemos o no podemos esperar de lo que hay en nuestro entorno.

La de que la Voyager 1 había dejado atrás la zona bajo influencia directa del viento solar y se encontraba ya surcando el espacio interplantario se convirtió rápidamente en una de las grandes noticias astronómicas del año, en especial por toda la carga simbólica que representa que, por primera vez, un construido por la Humanidad había traspasado por primera vez esa frontera invisible que nos separa y aisla del océano estelar. Pero para los científicos de la misión la llegada a este nuevo reino con una sonda aún operativa y capaz de seguir enviado datos al menos hasta 2020 es un regalo del que esperan grandes resultados. Y es que más allá del límite solar se extiende una región tan amplia como desconocida, y mucho más compleja de lo que podamos imaginar.

Concepción de un artista de una estrella variable cataclísmica.

Ejemplo de una estrella binaria, donde dos cuerpos con masa similar orbitan alrededor de un centro de masa en órbitas elípticas y ejemplo de una estrella binaria, en donde dos cuerpos con una pequeña diferencia de masa orbitan alrededor de un centro de masa.

En el efecto periastro se puede contemplar el brillo de una estrella binaria que tiene una órbita altamente excéntrica. Cuando la separación entre las componentes es mínima. Es de hecho, un aumento del efecto de reflexión en el instante del periastro, y surge por la misma causa: la irradiación de una estrrella por la otra.

Hemos llegado a saber de nuevas estrellas, vientos estelares, radiación, energías, estrellas de neutrones o púlsares, agujeros negros, enanas rojas y blancas, ¿estrellas de Quarks? ¿materia oscura? mundos…¿Civilizaciones? ¡El Universo! Lo que todo lo contiene, ahí estan presentes todas las cosas que existen y las que tienen que existir… El espaciotiempo, las fuerzas fundamentales de la Naturaleza…¡La Vida!

Cuando pensamos en la edad y el tamaño del Universo lo hacemos generalmente utilizando medidas de tiempo y como años, kilómetros o años-luz. Como y a hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del Universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿porqué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho así.

Ésta es una situación en resulta especialmente apropiado utilizar las unidades “naturales” la masa, longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física para ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

Es caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

A lo menos una vez al día, el cielo en su parte alta, es iluminado por un gran destello producido por grandes explosiones de rayos gamma. A menudo, esos destellos alcanzan magnitudes superiores a las que pueden ser generadas por todo un conjunto de otros rayos cósmicos y desaparecen posteriormente sin dejar más rastro. Nadie puede predecir cuando volverá a ocurrir la próxima explosión o de que dirección del cielo procederá. Hasta ahora, no contamos con evidencias duras como para asegurar cuáles podrían ser las fuentes precisas de donde provienen esos rayos gamma que observamos en lo alto del cielo, las razones que ocasionan los grandes destellos y la distancia en la cual ocurre el fenómeno.

La edad del Universo visible ≈ 1060 tiempos de Planck

Tamaño del Universo visible ≈ 1060 longitudes de Planck

La masa del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el Universo es un reflejo del hecho de que:

Densidad actual del Universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto, es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Nosotros, una simple brizna de materia que el Universo elaboró utilizanso la evolución que se produce en el paso del tiempo

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el Universo está estructurado en una escala sobre humana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones el Universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del Universo en “tics” de Tiempos de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

En todas las regiones del interestelar donde existen objetos de enormes densidades y estrellas supermasivas se pueden producir sucesos de inmensas energías y, en regiones de gas y polvo de muchos años-luz de diámetro, es donde surgen los Sistemas solares que contienen planetas aptos para la vida.

¿Por qué nuestro Universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el Universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el tiempo en el Universo el proceso de de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar . La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro solar el magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen series amenazas exteriores.

Credit: Emily Lakdawalla/Ted Stryk

La mayoría de asteroides, incluyendo Vesta, están en el cinturón de asteroides que se sitúa entre Marte y Júpiter. Otros asteroides giran en círculos mas cerca del Sol que de la Tierra, mientras que un gran de ellos comparten orbitas planetaria. Dada esta gran variedad de asteroides, algunos particularmente extraños han sido descubiertos en los últimos dos siglos desde que el primer asteroide fuera descubierto (Ceres en 1801).

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una serie y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución, o, por el contrario, evitar que siga cualquier de evolución produciendo la extinción total y dejando la Tierra como un planeta muerto.

Ahora los Gobiernos más avanzados, están constituyendo un consorcio para colaborar en la detección de estos imprevistos visitantes que nos podrían dar desagradables sorpresas nunca deseadas. Detectarlos a tiempo siempre será mejor que velos llegar de pronto con las rerribles consecuencias que dicha caída en el planeta puede provocar.

emilio silvera

Totales: 74.842.890

Totales: 74.842.890 Conectados: 85

Conectados: 85