Sep

20

Lo que se cree sobre el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo, El Universo misterioso ~

Clasificado en El Universo, El Universo misterioso ~

Comments (3)

Comments (3)

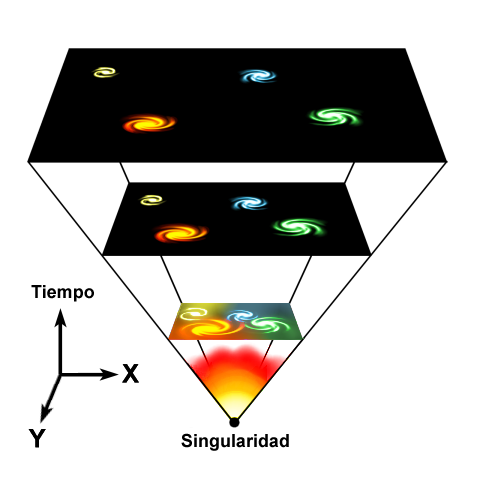

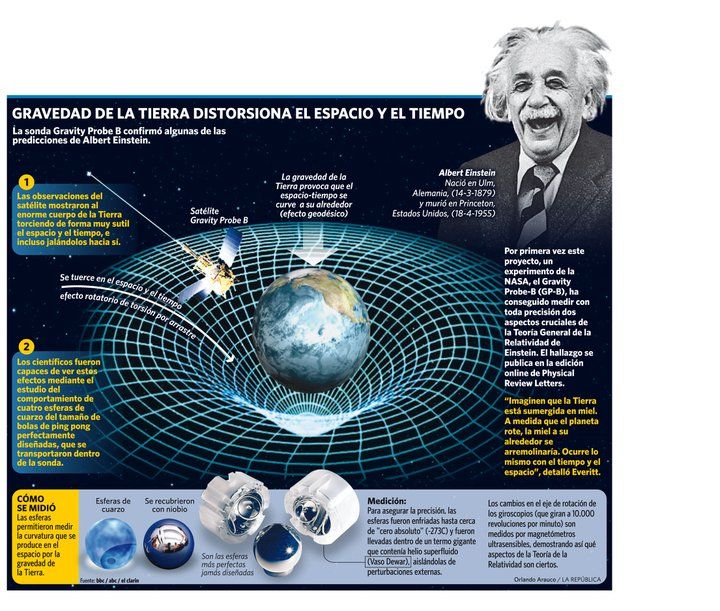

Según la teoría del Big Bang, el Universo se originó en una singularidad espaciotemporal de densidad infinita matemáticamente paradójica. El universo se ha expandido desde entonces, por lo que los objetos astrofísicos se han alejado unos respecto de los otros. Es decir, lo que se ha expandido ha sido el espacio, con lo cual, no se viola el principio de la relatividad de la velocidad de la luz, toda vez que, los objetos, nunca pudieron sobrepasar dicha velocidad.

El Universo

“El universo es la totalidad del espacio y del tiempo, de todas las formas de la materia, la energía y el impulso, las leyes y constantes físicas que las gobiernan. Sin embargo, el término también se utiliza en sentidos contextuales ligeramente diferentes y alude a conceptos como cosmos, mundo o naturaleza.

Observaciones astronómicas indican que el universo tiene una edad de 13,73 ± 0,12 millardos de años (entre 13 730 y 13 810 millones de años) y por lo menos 93 000 millones de años luz de extensión.2 El evento que dio inicio al universo se denomina Big Bang. Se denomina Big-Bang a la singularidad que creó el universo. Después del Big Bang, el universo comenzó a expandirse para llegar a su condición actual, y continúa haciéndolo.

Debido a que, según la teoría de la relatividad especial, la materia no puede moverse a una velocidad superior a la velocidad de la luz, puede parecer paradójico que dos objetos del universo puedan haberse separado 93 mil millones de años luz en un tiempo de únicamente 13 mil millones de años; sin embargo, esta separación no entra en conflicto con la teoría de la relatividad general, ya que ésta sólo afecta al movimiento en el espacio, pero no al espacio mismo, que puede extenderse a un ritmo superior, no limitado por la velocidad de la luz. Por lo tanto, dos galaxias pueden separarse una de la otra más rápidamente que la velocidad de la luz si es el espacio entre ellas el que se dilata.

La radiación de fondo de microondas

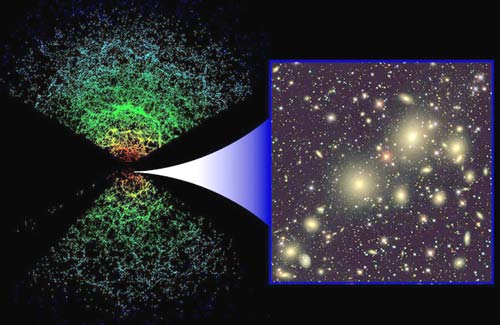

Mediciones sobre la distribución espacial y el desplazamiento hacia el rojo (redshift) de galaxias distantes, la radiación cósmica de fondo de microondas, y los porcentajes relativos de los elementos químicos más ligeros, apoyan la teoría de la expansión del espacio, y más en general, la teoría del Big Bang, que propone que el universo en sí se creó en un momento específico en el pasado.

Observaciones recientes han demostrado que esta expansión se está acelerando, y que la mayor parte de la materia y la energía en el universo son las denominadas materia oscura y energía oscura, la materia ordinaria (barionica), solo representaría algo más del 5 % del total3 (véanse materia oscura y energía oscura).

Los experimentos sugieren que el universo se ha regido por las mismas leyes físicas, constantes a lo largo de su extensión e historia. Es homogéneo e isotrópico. La fuerza dominante en distancias cósmicas es la gravedad, y la relatividad general es actualmente la teoría más exacta para describirla. Las otras tres fuerzas fundamentales, y las partículas en las que actúan, son descritas por el Modelo Estándar. El universo tiene por lo menos tres dimensiones de espacio y una de tiempo, aunque experimentalmente no se pueden descartar dimensiones adicionales muy pequeñas. El espacio-tiempo parece estar conectado de forma sencilla, y el espacio tiene una curvatura media muy pequeña o incluso nula, de manera que la geometría euclidiana es, como norma general, exacta en todo el universo.

La ciencia modeliza el universo como un sistema cerrado que contiene energía y materia adscritas al espacio-tiempo y que se rige fundamentalmente por principios causales.

Basándose en observaciones del universo observable, los físicos intentan describir el continuo espacio-tiempo en que nos encontramos, junto con toda la materia y energía existentes en él. Su estudio, en las mayores escalas, es el objeto de la cosmología, disciplina basada en la astronomía y la física, en la cual se describen todos los aspectos de este universo con sus fenómenos.

La teoría actualmente más aceptada sobre la formación del universo, fue teorizada por el canónigo belga Lemaître, a partir de las ecuaciones de Albert Einstein. Lemaitre concluyó (en oposición a lo que pensaba Einstein), que el universo no era estacionario, que el universo tenía un origen. Es el modelo del Big Bang, que describe la expansión del espacio-tiempo a partir de una singularidad espaciotemporal. El universo experimentó un rápido periodo de inflación cósmica que arrasó todas las irregularidades iniciales. A partir de entonces el universo se expandió y se convirtió en estable, más frío y menos denso. Las variaciones menores en la distribución de la masa dieron como resultado la segregación fractal en porciones, que se encuentran en el universo actual como cúmulos de galaxias.

En cuanto a su destino final, las pruebas actuales parecen apoyar las teorías de la expansión permanente del universo (Big Freeze ó Big Rip, Gran Desgarro), que nos indica que la expansión misma del espacio, provocará que llegará un punto en que los átomos mismos se separarán en partículas subatómicas. Otros futuros posibles que se barajaron, especulaban que la materia oscura podría ejercer la fuerza de gravedad suficiente para detener la expansión y hacer que toda la materia se comprima nuevamente; algo a lo que los científicos denominan el Big Crunch o la Gran Implosión, pero las últimas observaciones van en la dirección del gran desgarro.”

Ahora, Roger Penrose, de la Universidad de Oxford y uno de los físicos más brillantes de la actualidad, cree haber detectado “atisbos” de la existencia de otro universo. Uno que existía antes que el Big Bang. Lo cual pone, literalmente, patas arriba las teorías cosmológicas actuales. En un artículo recién publicado en ArXiv.org, Penrose explica que ha llegado a esa extraordinaria conclusión tras analizar, en los datos del satélite WMAP, ciertos patrones circulares que aparecen en el fondo de microondas cósmico y que sugieren, ni más ni menos, que el espacio y el tiempo no empezaron a existir en el Big Bang, sino que nuestro universo existe en un ciclo continuo de “rebotes” que él llama “eones”.

Según Penrose, lo que actualmente percibimos como nuestro universo, no es más que uno de esos eones. Hubo otros antes del Big Bang y habrá otros después. Unas ideas que se oponen frontalmente al modelo cosmológico más extendido en la actualidad: el de universo inflacionario. Según dicho modelo, el universo empezó en un punto de densidad infinita (el Big Bang) hace aproximadamente 13.700 millones de años, se expandió de forma extremadamente rápida durante una fracción de segundo, y ha continuado expandiéndose mucho más lentamente desde entonces, un tiempo durante el cual han ido surgiendo galaxias, estrellas, planetas y, finalmente, los seres humanos.

El tiempo antes del Big Bang Penrose, sin embargo, está convencido de que el modelo inflacionario no cuadra con el bajísimo estado de entropía que hizo posible el nacimiento del universo tal y como lo conocemos. Y tampoco cree que el espacio y el tiempo empezaran a existir en el momento del Big Bang, sino que el Big Bang fue, de hecho, sólo uno entre una serie de muchos acontecimientos similares, con cada uno marcando el inicio de un nuevo “eón” en la historia del universo. Las teorías de Penrose implican que, en un futuro lejano, el universo volverá, de alguna manera, a tener las condiciones que hicieron posible el Big Bang. Según el físico, en esos momentos la geometría del universo será suave y lineal, muy diferente a como es ahora, con abundantes picos y discontinuidades.

«La materia oscura puede ser ‘otra dimensión’, tal vez incluso un importante sistema de transporte galáctico. […]

En Interstellar, la película de ciencia ficción de Christopher Nolan, los protagonistas cruzan un agujero de gusano hallado fortuitamente en las cercanías de Saturno que permite viajar a varios mundos potencialmente habitables fuera del Sistema Solar. A veces pienso que, hablar de esto es casi lo mismo que hablar de cómo se creó en el Universo, en ambos casos, existen espacios oscuros que nos alejan de la posible verdad de lo que pudo ocurrir o de lo que podrá ser posible.

Esta futura continuidad de forma, afirma, permitirá una transición desde el final del actual eón, con un universo muy expandido e infinitamente grande, al inicio del siguiente, cuando de nuevo se hará infinitamente pequeño para estallar formando el siguiente Big Bang. Pruebas en el fondo cósmico El físico asegura que ha encontrado pruebas que sostienen lo que dice. Y que esas pruebas están en el fondo cósmico de microondas, los ecos lejanos del propio Big Bang, una especie de rescoldo de aquella gran explosión que es detectable, hoy, en cualquier punto del universo. Analizando, junto a su colega armenio Vahe Gurzadyan, siete años de datos del satélite WMAP, que está diseñado precisamente para medir el fondo de microondas, Penrose ha detectado con claridad una serie de “círculos concéntricos”, regiones en el cielo de microondas en los que el rango de temperatura de la radiación es notablemente menor que en otros sitios. Son precisamente esos círculos los que nos permiten “ver” a través del Big Bang, vislumbrando el eón que que existió anteriormente. Los círculos, dicen Penrose y Gurzadyan, son marcas dejadas en nuestro eón por las ondulaciones esféricas de las ondas gravitatorias que se generaron cuando los agujeros negros colisionaron en el eón anterior. Y estos círculos, sostienen, suponen un serio problema para la teoría inflacionaria, según la cual la distribución de las variaciones de temperatura en el cielo deberían ser Gaussianas, o aleatorias, en lugar de tener estructuras discernibles en su interior. Si Penrose tiene razón, cambiará por completo la forma que tenemos de percibir el universo en que vivimos, su nacimiento y su destino final.

Amigos míos, lo cierto es que, seguros lo que se dice seguros… ¡No lo podemos estar! Ya que, los modelos actuales del Universo, aunque algunos, como el Big Bang, parece que se puede acercar a esa realidad que buscamos, lo cierto es que, nos deja muchas zonas oscuras y, afirmar nada podemos.

emilio silvera

Sep

20

La simetría CP y otros aspectos de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

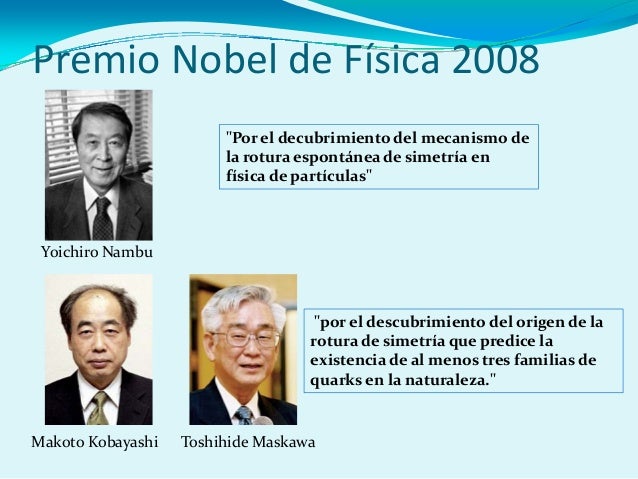

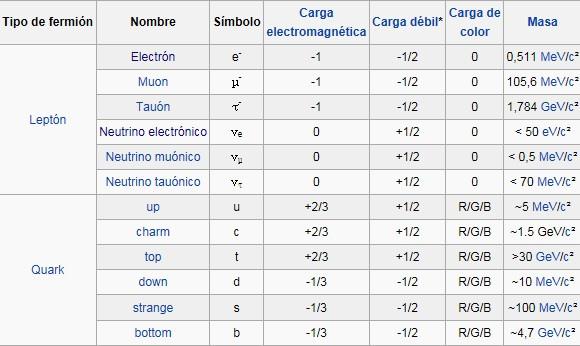

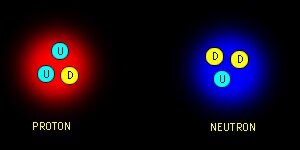

Los quarks al otro lado del espejo. Científicos del Laboratorio Nacional Jefferson Lab (EEUU) han verificado la rotura de la simetría de paridad (también llamada simetría del espejo) en los quarks mediante el bombardeo de núcleos de deuterio con electrones de alta energía. Los núcleos de deuterio están formados por un protón y un neutrón, es decir, por tres quarks arriba y tres quarks abajo. La dispersión inelástica entre un electrón y un quark, es decir, su colisión, está mediada por la interacción electrodébil, tanto por la fuerza electromagnética como por la fuerza débil. Esta última es la única interacción fundamental que viola la simetría de paridad.

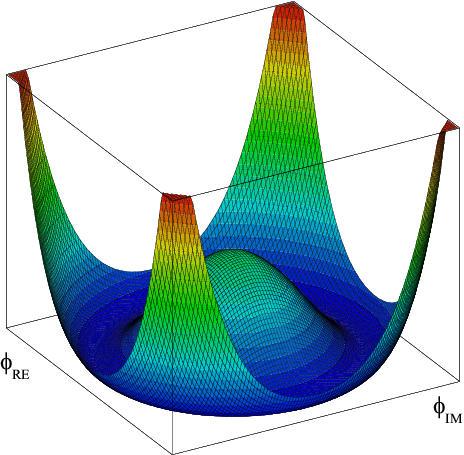

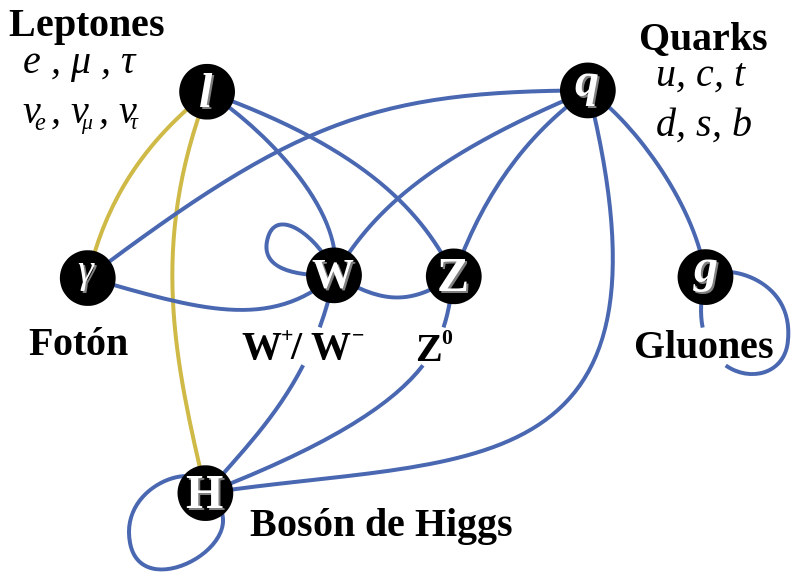

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y, lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar la coherencia matemática del modelo estándar. La idea de Higgs, y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19) que, el modelo estándar se mueve bajo nuestros pies.

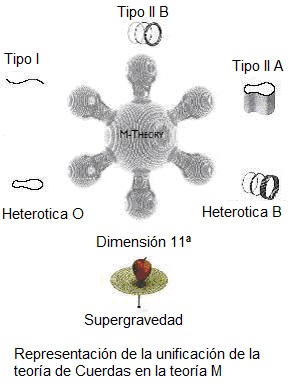

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

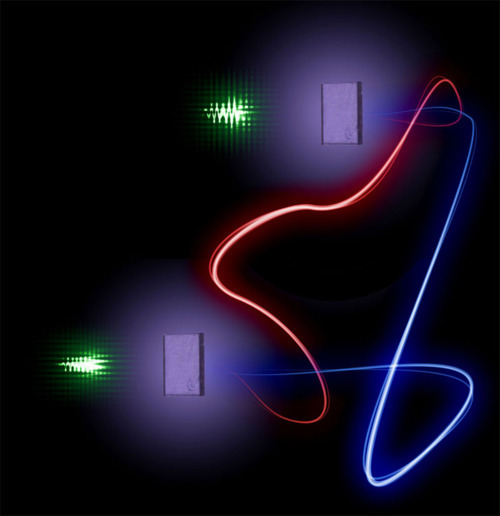

La Física nos lleva de vez en cuando a realizar viajes alucinantes. Se ha conseguido relacionar y vibrar a dos diamantes en el proceso conocido como entrelazamiento cuántico. El misterioso proceso, al que el propio Eisntein no supo darle comprensión completa, supone el mayor avance la fecha y abre las puertas de la computación cuántica. que nos hagamos una idea del hallazgo, en 1935 Einstein lo llegó a denominar la “acción fantasmal a distancia”. Un efecto extraño en donde se conecta un objeto con otro de manera que incluso si están separados por grandes distancias, una acción realizada en uno de los objetos afecta al otro.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado! Pero se sigue hablando de partículas supersimétricas.

¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intento calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni la nueva capacidad energético del acelerador de partículas LHC . Ni sumando todos los aceleradores de partículas de nuestro mundo, podríamos lograr una energía de Planck (1019 GeV), que sería necesaria para poder llegar hasta las cuerdas vibrantes de la Teoría. Ni en las próximas generaciones seremos capaces de poder utilizar tal energía.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Sabemos sobre las partíoculas elementales que conforman la materia bariónica, es decir, los átomos que se juntan para formar moléculas, sustancias y cuerpos… ¡La materia! Pero, no sabemos si, pudiera haber algo más elemental aún más allá de los Quarks y, ese algo, pudieran ser esas cuerdas vibrantes que no tenemos capacidad de alcanzar.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las Cuando su autor lanzó la idea al mundo, resultó además de nueva muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Con 7 TeV ha sido suficiente para encontrar la famosa partícula de Higgs pero…

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pietez Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas -Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa -los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una vez potente y segura nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmariana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la matería?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea una tributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron del “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs de masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acció la fuerzxa nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

Las otras dos partículas que salen son un anti-electrón y un neutrino. Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

La interacción débil, recordareis, fue inventada por E.Fermin para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las hace incrementarse? ¿Y, cómo podemos saber más al respecto? Como s su partícula, nos cabe esperar que la veamos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal y como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de lo que un universo primitivo puso y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10′5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en este caso, a la partícula de Higgs que, algunos, han llegado a llamar, de manera un poco exagerada:

¡La partícula Divina!

¡Ya veremos en que termina todo esto! Y que explicación se nos ofrece desde el CERN en cuanto al auténtico escenario que según ellos, existe en el Universo para que sea posible que las partículas tomen su masa de ese oceáno de Higgs, en el que, según nuestro amigo Ramón Márquez, las partículas se frenan al interaccionar con el mismo y toman su masa, el lo llama el “efecto frenado”.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todos, exponer su teoría relativista. (Mach, Maxwell, Lorentz… y otros).

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental.

Ahora, por fin la tenemos con el LHC, y ésta pega, se la traspasamos directamente a la teoría de supercuerdas y a la materia oscura que, de momento, están en la sombra y no brillan con luz propia, toda vez que ninguna de ellas ha podido ser verificada, es decir, no sabemos si el Universo atiende a lo que en ellas se predice.

El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, llego a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo pudo surgir el Universo no dependen de que se encuentre el bosón de Higgso se averigue si realmente existe la materia oscura, Aunque sepamos llegar al fondo de la Teoría de Cuerdas y confirmarla, Poder crear esa Teoría cuántica de la Gravedad…Y, en fín, seguir descubriendo los muchos misterios que no nos dejan saber lo que el Universo es. Ahora, por fin, tenemos grandes aceleradores y Telescopisos con la energía necesaria y las condiciones tecnológicas suficientes para que nos muestre todo eso que queremos saber y nos digan dónde reside esa verdad que incansables perseguimos. Sin embargo, siempre seguiremos haciendo preguntas y siempre, también, serán insuficientes, los aparatos que podamos construir para que nos digan como es el Universo y cómo funciona la Naturaleza. Saberlo todo, nunca sabremos.

¡La confianza en nosotros mismos, no tiene límites! Pero, no siempre ha estado justificada.

emilio silvera

Sep

20

Tratamos de saber quiénes somos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El cerebro ~

Clasificado en El cerebro ~

Comments (0)

Comments (0)

Rafael Yuste, ideólogo del Proyecto BRAIN: “El gran desafío de la ciencia es crear el mapa del cerebro humano”

Por Zuberoa Marcos

Rafael Yuste

Neurobiólogo. Ideólogo del Proyecto BRAIN

Siendo neurocientífico, que Rafael Yuste admire a Santiago Ramón y Cajal desde su adolescencia puede sonar a tópico. Sin embargo, la lectura de “Los tónicos de la voluntad: reglas y consejos sobre investigación científica” del Nobel Aragonés, que su padre le regaló a los 14 años, marcó la vocación de uno de los creadores del proyecto BRAIN (Investigación del Cerebro a través del Avance de Neurotecnologías Innovadoras). Si sólo el nombre ya resulta complejo, sus objetivos lo son aun más. Porque lo que pretenden conseguir el grupo de científicos entre los que se encuentra el español afincado en Estados Unidos es, según palabras de Barack Obama (quien asumió como propio el proyecto) “obtener una fotografía dinámica del funcionamiento de nuestro cerebro para entender mejor cómo pensamos, cómo aprendemos y cómo recordamos”.

El supercomputador Magerit (CeSViMa), el más potente de España, es usado por el proyecto

BRAIN tiene unas dimensiones acordes con sus objetivos: involucra a laboratorios de muchos países, requiere cientos de millones de euros para poder ser financiado y la dedicación de un buen número de investigadores de distintas disciplinas. El fin último de BRAIN es mapear la actividad del cerebro, lo que permitirá desarrollar técnicas para alterar la actividad de circuitos neuronales y, de esa manera, corregir los defectos que provocan las enfermedades mentales entre otras utilidades.

Los gigantes de la tecnología siguen con mucho interés los avances del Proyecto BRAIN. ¿Y porqué habría de interesarle a una empresa como Google, por ejemplo, la neurobiología? Rafael Yuste lo tiene muy claro: porque incluso los algoritmos utilizados por el mejor buscador del mundo son primitivos comparados con nuestro cerebro. Entender cómo pensamos sería un paso de gigante (y tal vez definitivo) para el desarrollo de la inteligencia artificial. Y aunque mentar estos avances produce vértigo y miedos en muchos, el científico español es un firme defensor del progreso: “La tecnología en lugar de limitarnos y atemorizarnos nos hará más libres. Será como un nuevo humanismo”.

Totales: 75.500.448

Totales: 75.500.448 Conectados: 20

Conectados: 20