Oct

19

Partículas “bellas” de materia y antimateria

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (12)

Comments (12)

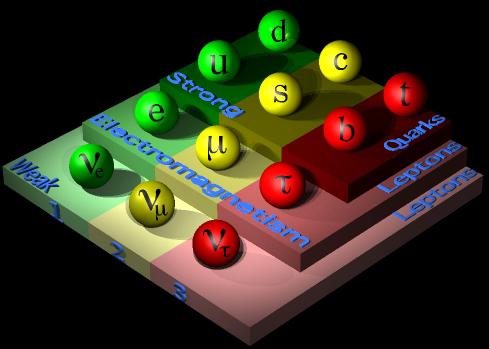

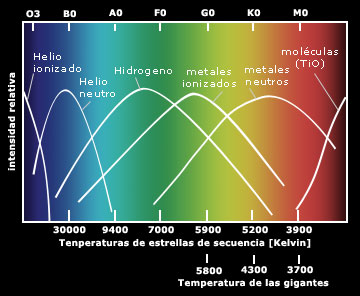

¿Cuántas generaciones de partículas existen? El modelo estándar no predice el número de generaciones de fermiones (quarks y leptones). Hoy conocemos tres generaciones, pero podrían existir más. Una cuarta generación dentro del modelo estándar estaría formada por dos quarks pesados y

y dos leptones pesados

y

. Cualquier otra opción implicaría física más allá del modelo estándar. En este caso SM4 sustituiría a SM3, como SM3 sustituyó a SM2 en los 1970. (Fuente Francis (th)E mule Science’s News).

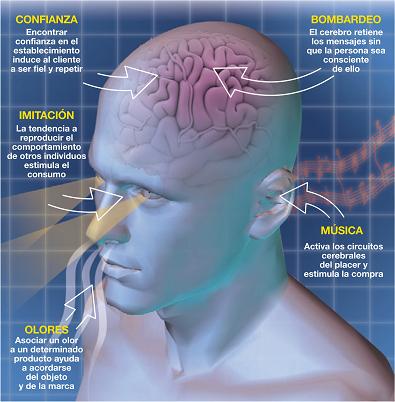

Pero hablemos de partículas “bellas” de materia y antimateria. Así se titula un magnifico artículo de Don Alberto Ruiz Jimeno, miembro del Grupo de Altas Energías del Instituto de Física Moderna Universidad de Cantabria y Jefe del Grupo de Altas Energías. En él nos dice que:

El resultado procede del análisis de CDF de miles de millones de colisiones de protones y antiprotones producidos en el colisionador Tevatron del Fermilab. De acuerdo con la Teoría de la Relatividad de Einstein, energía es igual a masa, por lo que esas colisiones de alta energía pueden lanzar a la existencia a partículas subatómicas masivas no vistas en nuestro mundo cotidiano. Los físicos intentan entonces identificar esas partículas estudiando las combinaciones de partículas más familiares en las que decaen.

“Nuevos bariones constituidos por tres Quarks, como los protones, pero conteniendo el quarks b (“belleza”) han sido observado en el experimento CDF del Acelerador del Tevatrón de protones y antiprotones. Por otra parte (nos dice), se ha observado por primera vez la oscilación de los mesones B, entre materia y antimateria. Dado que el artículo puede tener un alto interés para ustedes, he creído positivo transcribirlo aquí para gozo del personal que, con estos nuevos conocimientos (como me pasó a mí), podrán aumentar los suyos.

La física de partículas elementales tiene por objeto el estudio de los constituyentes más elementales de la materia y de las fuerzas fundamentales que rigen su comportamiento. La dinámica de estos bloques fundamentales viene formulada por la mecánica cuántica relativista.

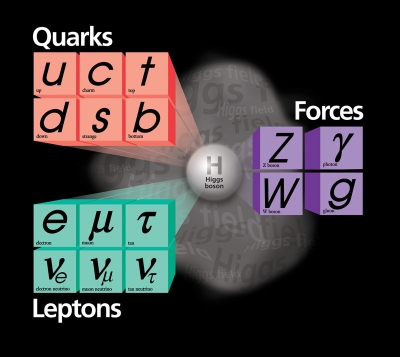

El denominado Modelo Estándar establece que los bloques elementales de la materia tienen un momento magnético intrínseco (spín) de valor ½, denominándose fermiones por verificar las leyes de la estadística cuántica que formularon Fermi y Dirac a comienzos del siglo XX. A su vez, las fuerzas fundamentales vienen determinadas por el intercambio de cuantos de energía, con spin 1 (salvo el hipotético gravitón que tendría spin 2), llamado bosones al verificar las leyes estadísticas cuántica establecidas por Bose y Einstein, en el mismo siglo XX.

Los Bosones de interacción son el fotón, causante de la interacción electromagnética; los bosones vectoriales W+, W– y Z0, causantes de la interacción nuclear débil; los ocho tipos de Gluones que confinan a los Quarks en hadrones (como el protón o el neutrón) a causa de la interacción fuerte nuclear, y el gravitón u onda gravitacional que explicaría la interacción gravitatoria. La fuerza gravitacional es despreciable a escala subatómica, pero es la dominante a grandes escalas. Su portador aún no ha sido observado; de hecho, su existencia requeriría una teoría cuántica de la gravitación, que aún no ha sido formulada.

Los fermiones de materia se denominan quarks o leptones, siendo los primeros los que están sometidos a los cuatro tipos de interacciones y los segundos los que no están sometidos a la interacción nuclear fuerte; en cualquiera de los casos, la interacción electromagnética solo afecta a las partículas que poseen carga eléctrica y la interacción gravitatoria a las que poseen masa.

Los quarks son de seis tipos o sabores, así como los leptones. Unos y otros se clasifican en familias o generaciones, siendo la más ligera la constituida por los quarks y los leptones electrón y neutrino electrónico. Los nucleones, protón y neutrón, tienen la estructura de quarks, respectivamente uud y udd. Los átomos tienen un núcleo interno constituido por nucleones y electrones orbitando en torno al mismo.

El resto de quarks y leptones constituyen materia exótica, siendo producidos en los aceleradores de partículas y en la radiación cósmica, pero formaban parte de la materia original del Universo primitivo. Los quarks pueden tener, además, tres tipos de carga fuerte o “color”.

Además existen otros doce sabores correspondientes a la antimateria, en forma de anti-quarks y anti-leptones, con las mismas masas que los quarks y leptones correspondientes, pero con sus cargas invertidas. No se ha observado antimateria en el Universo actual, pero el Universo primigenio tenía igual cantidad de materia que de antimateria. Toda la antimateria actual es producida en los choques de partículas aceleradas, como consecuencia de la transformación de energía en pares materia-antimateria.

La ecuación cuántica relativista que gobierna el comportamiento de los fermiones es la ecuación de Dirac, debida al famoso físico inglés. Las soluciones de dicha ecuación incluyen las denominadas partículas de antimateria, que poseen la misma masa que la partícula correspondiente, pero tienen todas sus “cargas” internas, como la carga eléctrica, con el signo opuesto. Así por cada quark tenemos un antiquark y por cada leptón un antileptón. Cuando un fermión y su correspondiente antifermión se encuentran se aniquilan mutuamente, convirtiéndose en energía y, a la viceversa, si tenemos energía superior a la suma de las masas de fermión y antifermión, puede convertirse en un par fermión-antifermión.

El 7 de agosto de 1912, el físico austriaco Victor Franz Hess descubrió esta potentísima fuente de energía llegada del espacio, lo que años después le supuso el premio Nobel ABC.ES / MADRID V.F. SOCIETY Víctor F. Hess, en un globo entre 1911 y 1912.

La historia de la Física de Partículas debe mucho al descubrimiento de los rayos cósmicos, realizada por el físico austríaco Francis Hess, en 1912, y apodados como tales por el físico americano Robert Millikan, en 1925. Los experimentos de Hess, utilizando globos aerostáticos, concluyeron que la cantidad de radiación crecía por encima de los 2000 metros de altura y la fuente de los mismos eran el Sol y otras fuentes procedentes del firmamento.

A partir de esa fecha y hasta mediados del siglo XX, gracias a los experimentos con rayos cósmicos, el número de tipos diferentes de partículas observadas, que previamente se reducían al protón y el electrón, se multiplicó, creándose un auténtico caos que obligó a pensar en esquemas de clasificación de las mismas.

Esquema de un sincrotrón

El sincrotrón es un tipo deacelerador de partículas. Se diferencia de otros aceleradores en que las partículas se mantienen en una órbita cerrada. Los primeros sincrotrones se derivaron del ciclotron. que usa un campo magnético constante para curvar la trayectoria de las partículas, aceleradas mediante un campo eléctrico también constante, mientras que en el sincrotrón ambos campos varían. La velocidad máxima a la que las partículas se pueden acelerar está dada por el punto en que la radiación sincrotrón emitida por las partículas al girar es igual a la energía suministrada. Los sincrotrones también se utilizan para mantener las partículas circulando a una energía fija; en este casos reciben el nombre de «anillos de almacenamiento».

En 1947, los físicos del Laboratorio Lawrence Berkeley, de California, construyeron el primer gran acelerador, un ciclotrón, comenzando la era de los grandes aceleradores de partículas, que continuaron descubriendo nuevos tipos de las mismas, de modo que, en 1960, había cientos de tipos de partículas observadas, sin que hubiera, aún, un esquema de clasificación adecuado. Este fue desarrollado durante la década de 1960, en la que el análisis de las colisiones de partículas, y las propiedades de los diferentes tipos de interacción observadas, establecieron la base para la construcción del Modelo Estándar.

Sí, las fuerzas fundamentales, o, interaciones… ¡Están presentes en todas partes por el Universo! Son las que marcan el ritmo.

Las leyes que rigen el comportamiento de las interacciones fundamentales y sus propiedades de simetría permitieron establecer un marco de clasificación de los hadrones (partículas compuestas por quarks, como es el caso del protón) que pueden ser de dos tipos: Bariones, si en su constitución tenemos tres quarks, o mesones, si si están constituidos de un quark y un antiquark.

En realidad, la dinámica de los hadrones está determinada, esencialmente, por la interacción nuclear fuerte, de modo que los quarks constituyentes son los quarks de “valencia”, en analogía con los electrones de valencia de los átomos (los que fijan sus propiedasdes químicas). En la dinámica de la interacción fuerte nuclear hay un continuo intercambio de Gluones entre los quarks y reacciones de producción y aniliquilación de quarks y antiquarks mediante Gluones.

Esta dinámica es debida a la existencia de una propiedad intrínseca de los quarks que denominamos “color”, que es intercambiada en las reacciones de Quarks y Gluones. Los hadrones son, globalmente, neutros de color (como los átomos son neutros de carga eléctrica) y es tan fuerte y característica la interacción que los quarks están confinados en unas dimensiones especiales inferiores al tamaño de los núcleos de los átomos, siendo paradójicamente casi libres en el interior de los hadrones (libertad asintótica de los quarks).

La fuerza nuclear fuerte es la más potente de la Naturaleza y mantiene el núcleo de los átomos unidos

El Modelo Estándar ha sido comprobado desde su desarrollo formal, a mediados de 1960, y sus parámetros han sido medidos con extraordinaria precisión, gracias al desarrollo de experimentos muy potentes, entre los que destacan los realizados en el acelerador LEP (“Large Electrón Positrón”) del CERN ( Centro Europeo de Física de Partículas, en Ginebra), durante la última década del siglo XX, y del Tevatrón del Laboratorio Fermilab (Chicago, USA), aún en funcionamiento.

A continuación viene una referencia al LHC que, a estas alturas está sobrepasada por conocer todos nosotros lo que ha pasó en su inauguración y sus primeras pruebas. Así que, no me parece oportuno plasmar aquí esa referencia que conoceremos de primera mano cuando sucedieron los hechos y toda la prensa los publicó.

emilio silvera

Oct

18

¡Son muchas las cosas que no sabemos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

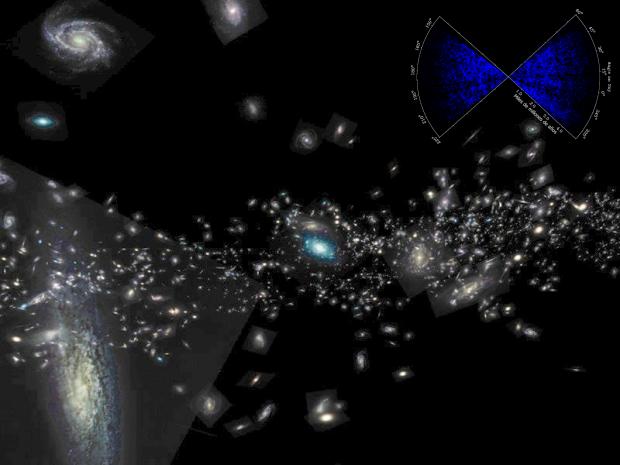

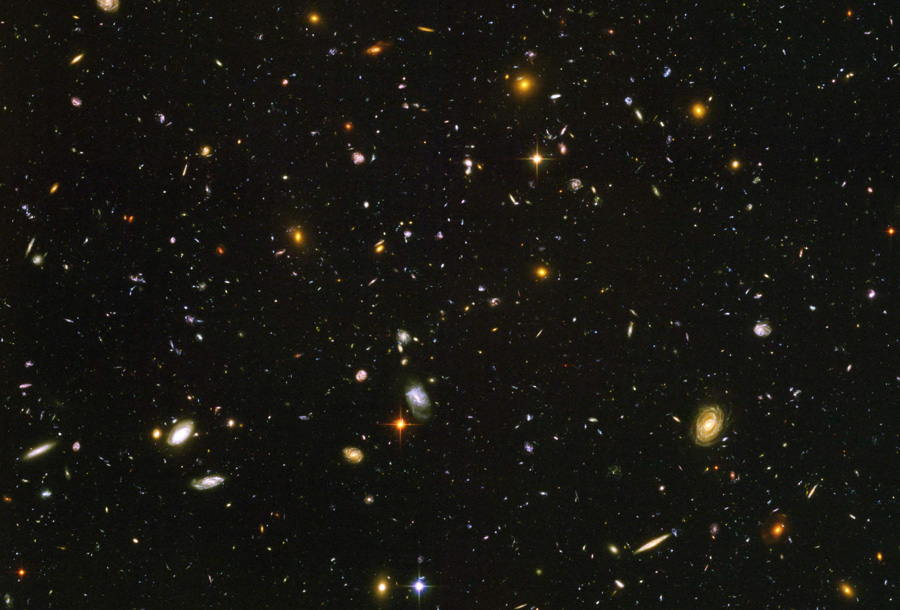

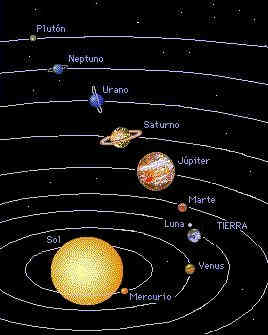

Hemos hablado aquí otras veces sobre el hecho cierto de que, el material del que estamos hechos, se fabricó en las estrllas, y, alguna supernova, hace ya miles de millones de años, sembró el espacio interestelar para que se formara nuestro Sistema Solar. Claro que los procesos de la alquimia estelar necesitan tiempo: miles de millones de años de tiempo. Y debido a que nuestro universo se está expandiendo, tiene que tener un tamaño de miles de millones de años-luz para que durante ese periodo de tiempo necesario pudiera haber fabricado los componentes y elementos complejos para la vida. Un universo que fuera sólo del tamaño de nuestra Vía Láctea, con sus cien mil millones de estrellas resultaría insuficiente, su tamaño sería sólo de un mes de crecimiento-expansión y no habría producido esos elementos básicos para la vida.

Planetas descubiertos por el telescopio Kepler que han sido confirmados como dentro de la zona de habitabilidad /Fuente: NASA

El universo tiene la curiosa propiedad de hacer que los seres vivos piensen que sus inusuales propiedades son poco propicias para la vida, para la existencia de vida, cuando de hecho, es todo lo contrario; las propiedades del universo son esenciales para la vida. Lo que ocurre es que en el fondo tenemos miedo; nos sentimos muy pequeños ante la enorme extensión y tamaño del universo que nos acoge. Sabemos aún muy poco sobre sus misterios, nuestras capacidades son limitadas y al nivel de nuestra tecnología actual estamos soportando el peso de una gran ignorancia sobre muchas cuestiones que necesitamos conocer.

Extraños objetos pueden ser observados en el Universo en los que, energías inimaginables están presentes

Con sus miles de millones de galaxias y sus cientos de miles de millones de estrellas, si niveláramos todo el material del universo para conseguir un mar uniforme de materia, nos daríamos cuenta de lo poco que existe de cualquier cosa. La media de materia del universo está en aproximadamente 1 átomo por cada metro cúbico de espacio. Ningún laboratorio de la Tierra podría producir un vacío artificial que fuera remotamente parecido al vacio del espacio estelar. El vacío más perfecto que hoy podemos alcanzar en un laboratorio terrestre contiene aproximadamente mil millones de átomos por m3.

Esta nueva manera de mirar el universo nos da nuevas ideas, no todo el espacio son agujeros negros, estrellas de neutrones, galaxias y desconocidos planetas; la verdad es que casi todo el universo está vacío y sólo en algunas regiones tiene agrupaciones de materia en forma de estrellas y otros objetos estelares y cosmológicos; muchas de sus propiedades y características más sorprendentes (su inmenso tamaño y su enorme edad, la soledad y oscuridad del espacio) son condiciones necesarias para que existan observadores inteligentes como nosotros.

Esta imagen circula mucho por los medios como posible observador inteligente fuera de la Tierra. Algunos comentan que somos nosotros en el futuro y hemos venido a contemplar cómo éramos. La imaginación del Ser humano no tiene límites y para pensar tal cosa… ¡Hay que tener mucha imaginación!

No debería sorprendernos la vida extraterrestre; si existe, pudiera ser tan rara y lejana para nosotros como en realidad nos ocurre aquí mismo en la Tierra, donde compartimos hábitat con otros seres vivos con los que hemos sido incapaces de comunicarnos, a pesar de que esas formas de vida, como la nuestra, están basadas también en el carbono. No se puede descartar formas de vida inteligente basadas en otros elementos, como por ejemplo, el silicio.

La baja densidad media de materia en el universo significa que si agregáramos material en estrellas o galaxias, deberíamos esperar que las distancias medias entre objetos fueran enormes.

| El universo visible contiene sólo: |

| 1 átomo por metro cúbico |

| 1 Tierra por (10 años luz)3 |

| 1 Estrella por (103 años luz)3 |

| 1 Galaxia por (107 años luz)3 |

| 1 “Universo” por (1010 años luz)3 |

El cuadro expresa la densidad de materia del universo de varias maneras diferentes que muestran el alejamiento que cabría esperar entre los planetas, estrellas y galaxias. No debería sorprendernos que encontrar vida extraterrestre sea tan raro. Si tenemos en cuenta las distancias que nos separan y el tiempo que llevamos aquí, aún no hemos podido alcanzar la rtecnología suficiente para realizar viajes a las estrellas. Claro que, una Civilización extraterrestre llegada al Universo en otro mundo de nuestra propia Galaxia, si llegó un millón de años antes que nosotros, ¿cómo estarían de adelantados?

Estaremos aislados en un cosmos “infinito”

“El hecho fundamental de nuestra existencia es que parecemos estar aislados en el cosmos. Somos los únicos seres racionales capaces de expresarse en el silencio del universo. En la historia del Sistema Solar se ha dado en la Tierra, durante un periodo de tiempo infinitesimalmente corto, una situación en la que los seres humanos evolucionan y adquieren conocimientos que incluye el ser conscientes de sí mismos y de existir… Dentro del Cosmos ilimitado, en un minúsculo planeta, durante un minúsculo periodo de tiempo de unos pocos milenios, algo ha tenido lugar como si este planeta fura lo que abarca todo, lo auténtico. Este es el lugar, una mota de polvo en la inmensidad del cosmos, en el que el ser ha despertado con el hombre”.

¡Son tántos los mundos! ¿Cómo no van a existir otros seres que, como en la Tierra, se pregunten las mismas cosas y tengan las mismas dudas?

Hay aquí algunas grandes hipótesis sobre el carácter único de la vida humana en el universo (creo que equivocada). En cualquier caso se plantea la pregunta, aunque no se responde, de por qué estamos aquí en el tiempo y lugar en que lo hacemos. Hemos visto que la cosmología moderna puede ofrecer algunas respuestas esclarecedoras a estas preguntas.

En mi anterior trabajo quedaron reflejadas todas las respuestas a estas preguntas. Nada sucede porque sí, todo es consecuencia directa de la causalidad. Cada suceso tiene su razón de ser en función de unos hechos anteriores, de unas circunstancias, de unos fenómenos concretos que de no haberse producido, tampoco el tal suceso se habría significado, simplemente no existiría. Con la vida en nuestro planeta, ocurrió igual.

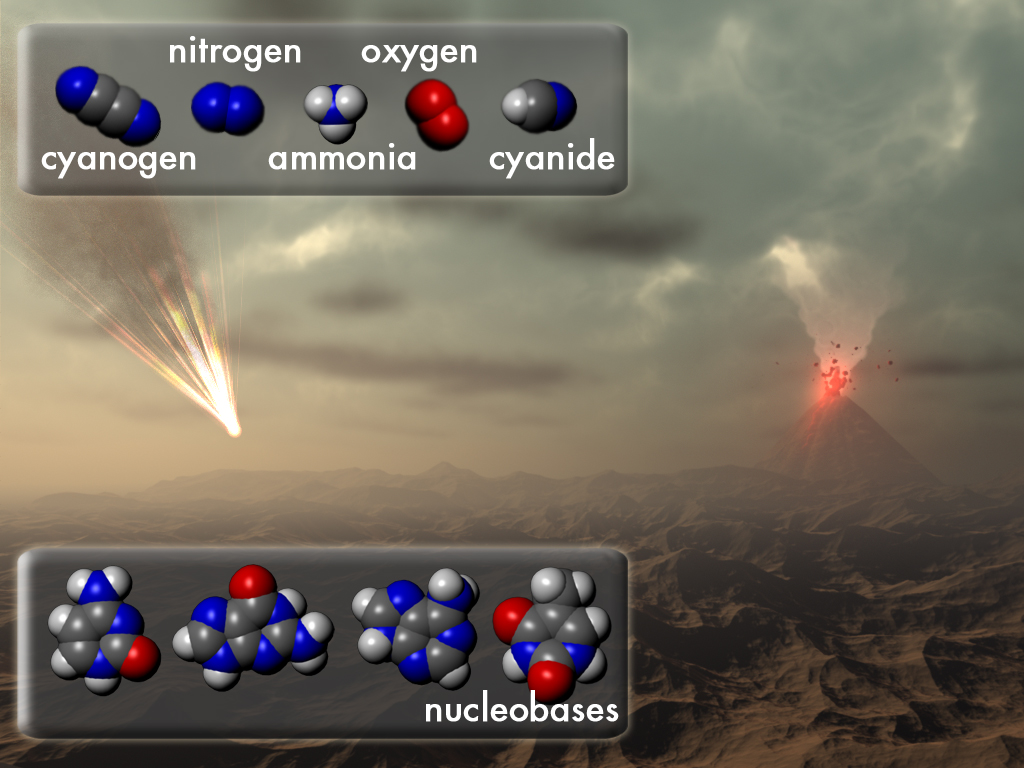

Una atmósfera primitiva evolucionada, la composición primigenia de los mares y océanos con sus compuestos, expuestos al bombardeo continuo de radiación del espacio exterior que llegaba en ausencia de la capa de ozono, la temperatura ideal en relación a la distancia del Sol a la Tierra y otra serie de circunstancias muy concretas, como la edad del Sistema Solar y los componentes con elementos complejos del planeta Tierra, hecho del material estelar evolucionado a partir de supernovas, todos estos elementos y circunstancias especiales en el espacio y en el tiempo, hicieron posible el nacimiento de esa primera célula que fue capaz de reproducirse a sí misma y que, miles de años después, hizo posible que evolucionara hasta lo que hoy es el hombre que, a partir de materia inerte, se convirtió en un ser pensante que ahora es capaz de exponer aquí mismo estas cuestiones. ¡Es verdaderamente maravilloso!

El entorno cambiante en un universo en expansión como el nuestro, a medida que se enfría y envejece (la entropía) es posible que se formen átomos, moléculas, galaxias, estrellas, planetas y organismos vivos. En el futuro, las estrellas agotaran su combustible nuclear y morirán todas. En función de sus masas serán estrellas enanas blancas (como nuestro Sol), estrellas de neutrones (a partir de 1’5 masas sobre hasta 3 masas solares) y agujeros negros a partir de 3 masas solares. Hay un recorrido de historia cósmica en el que nuestro tipo de evolución biológica debe ocurrir bajo esas circunstancias especiales a las que antes me referí.

![[muertetermica12015585658%255B3%255D.jpg]](http://lh5.ggpht.com/-oB5bpCrDPsY/TsK_cRftqbI/AAAAAAAASbU/rhusDMrkoTA/s1600/muertetermica12015585658%25255B3%25255D.jpg)

Circula por ahí una Teoría que nos habla de la muerte Térmica del Universo

No podemos saber cuándo, pero sí tenemos una idea muy clara de cómo será dicho final. El universo es todo lo que existe, incluyendo el espacio, el tiempo y la materia. El estudio del universo es la cosmología, que distingue entre el Universo con “U” mayúscula, significando el cosmos y su contenido, y el universo con “u” minúscula, que es normalmente un modelo matemático deducido de alguna teoría. El universo real está constituido en su mayoría por espacios aparentemente vacios, existiendo materia concentrada en galaxias formadas por estrellas y gas. El universo se está expandiendo, de manera que el espacio entre las galaxias está aumentando gradualmente, provocando un desplazamiento al rojo cosmológico en la luz procedente de los objetos distantes.*

Dicen algunos que existe una evidencia creciente de que el espacio está o puede estar lleno de una materia invisible, “materia oscura”, que puede constituir muchas veces la masa total de las galaxias visibles (materia bariónica). Sabemos que el origen más probable del universo está en al teoría conocida como del Big Bang que, a partir de una singularidad de una densidad y energía infinita, hace ahora unos 15 mil millones de años, surgió una inmensa bola de fuego que desde entonces no ha dejado de expandirse y enfriarse.

Somos osados. Cuando hablamos de lo que no sabemos

En el proceso, nació el tiempo y el espacio, surgieron las primeros quarks que pudieron unirse para formar protones y electrones que formaron los primeros núcleos y, cuando estos núcleos fueron rodeados por los electrones, nacieron los átomos que evolucionando y juntándose hicieron posible la materia; todo ello, interaccionado por cuatro fuerzas fundamentales que, desde entonces, por la rotura de la simetría original divididas en cuatro parcelas distintas, rigen el universo. La fuerza nuclear fuerte responsable de mantener unidos los nucleones, la fuerza nuclear débil, responsable de la radiactividad natural desintegrando elementos como el uranio, el electromagnetismo que es el responsable de todos los fenómenos eléctricos y magnéticos, y la fuerza de gravedad que mantiene unidos los planetas y las galaxias.

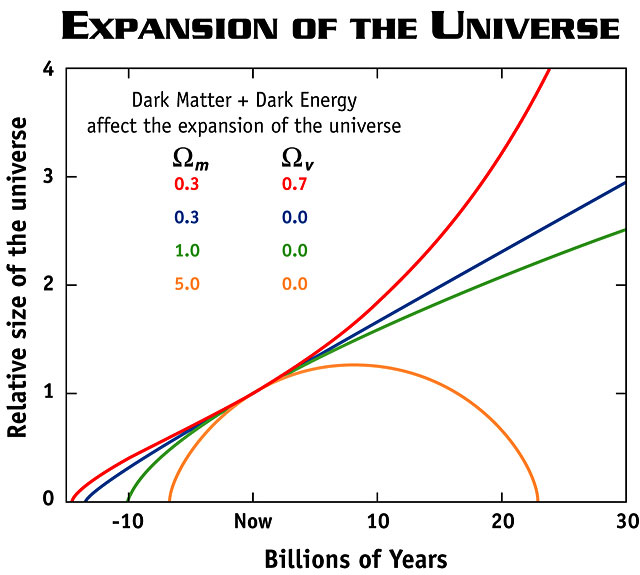

Pero hemos llegado a saber que el universo podrá ser abierto o cerrado. Un universo que siempre se expande y tiene una vida infinita es abierto. Esto es un universo de Friedmann que postuló que el nuestro tenía una densidad menor que la densidad crítica.

El universo cerrado es el que es finito en tamaño, tiene una vida finita y en el que el espacio está curvado positivamente. Un universo de Friedman con la densidad mayor que la densidad crítica.

El universo en expansión es el que el espacio entre los objetos está aumentando continuamente. En el universo real, los objetos vecinos como los pares de galaxias próximas entre sí no se separan debido a que su atracción gravitatoria mutua supera los efectos de la expansión cosmológica (el caso de la Vía Láctea y Andrómeda). No obstante, la distancia entre dos galaxias muy separadas, o entre dos cúmulos de galaxias, aumenta con el paso del tiempo y la expansión imparable del universo.

Aunque estémos acostumbrados a ver imágenes de bellos cúmulos de galaxias, lo cierto es que, en el Universo, predominan los espacios vacíos.

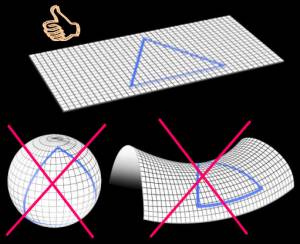

El universo real está en función de la densidad crítica que es la densidad media de materia requerida para que la gravedad detenga la expansión del universo. Un universo con una densidad muy baja se expandirá para siempre, mientras que uno con densidad muy alta colapsara finalmente. Un universo con exactamente la densidad crítica, alrededor de 10-29g/cm3, es descrito por el modelo de universo de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. Pero la densidad media de materia que puede ser observada directamente en nuestro universo no representa la cantidad necesaria para generar la fuerza de gravedad que se observa en la velocidad de alejamiento de las galaxias, que necesita mucha más materia que la observada para generar esta fuerza gravitatoria, lo que nos da una prueba irrefutable de que ahí fuera, en el espacio entre galaxias, está oculta esa otra materia invisible, la “materia oscura”, que nadie sabe lo que es, cómo se genera o de qué esta hecha. Así que, cuando seamos capaces de abrir esa puerta cerrada ante nuestras narices, podremos por fin saber la clase de universo en el que vivimos; si es plano, si es abierto e infinito, o si es un universo que, por su contenido enorme de materia es curvo y cerrado.

Según todos los indicios, estamos en un Universo Plano

Claro que saber la cantidad de materia que pueda contener nuestro universo, no resultará tan fácil como mirar a las estrellas. Aunque alguna idea tenemos…, con certeza nada sabemos en relación a infinut de cuestiones con el Universo relacionadas…, a otras sí hemos podido acercarnos algo más. Pero la respuesta a la pregunta, aún sin saber exactamente cuál es la densidad crítica del universo, sí podemos contestarla en dos vertientes, en la seguridad de que al menos una de las dos es la verdadera.

El destino final será:

a) Si el universo es abierto y se expande para siempre, cada vez se hará más frio, las galaxias se alejarán las unas de las otras, la entropía hará desaparecer la energía y el frio será tal que la temperatura alcanzará el cero absoluto, -273ºK. La vida no podrá estar presente.

b) Si el universo es cerrado por contener una mayor cantidad de materia, llegará un momento en que la fuerza de gravedad detendrá la expansión de las galaxias, que poco a poco se quedarán quietas y muy lentamente, comenzaran a moverse en el sentido inverso; correrán ahora las unas hacia las otras hasta que un día, a miles de millones de años en el futuro, todo la materia del universo se unirá en una enorme bola de fuego, el Big Crunch. Se formará una enorme concentración de materia de energía y densidad infinitas. Habrá dejado de existir el espacio y el tiempo. Nacerá una singularidad que, seguramente, dará lugar a otro Big Bang. Todo empezará de nuevo, otro universo, otro ciclo ¿pero aparecemos también nosotros en ese nuevo universo?

Esta pregunta sí que no sé contestarla.

Aquí sabemos de la infinitud de galaxias que conforma nuestro univeroso, de la entropía que acompaña al inexorable pasar del tiempo, el espacio que nos separa de los objetos del cosmos, de cómo está formada la materia conocida…y, sin embargo, no sabemos muchas de las cosas que nos rodean y, tampoco de nosotros mismos.

Contemplamos en la imagen de más abajo como muchas galaxias terminan por fusionarse. Así podría ser el futuro de la Vía Láctea y Andrómeda. ¿Y nosotros, dónde estaremos para cuando eso ocurra? Y, ¿Cuando el Sol se convierta en Gigante roja primero y Nebulosa planetaria después, si hemos podido sobrevivir, ¿dónde nos habremos instalados? ¿Qué nuevos mundos serán nuestros hogares?

Así las cosas, no parece que el futuro de la Humanidad sea muy alentador. Claro que los optimistas nos hablan de hiperespacio y universos paralelos a los que, para ese tiempo, ya habremos podido desplazarnos garantizando la continuidad de la especie Humana. Bien pensado, si no fuera así ¿para qué tantas dificultades vencidas y tantas calamidades pasadas? ¿Para terminar congelados o consumidos por un fuego abrasador?

¡Quién pudiera contestar a eso!

Cuando pensamos en la edad y el tamaño del universo lo hacemos generalmente utilizando medidas de tiempo y espacio como años, kilómetros o años-luz. Como ya hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿Por qué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho así.

Si para entonces hemos aguantado, sabremos lo que tenemos que hacer para que nuestra especie perdure. Y, espero con fuerzas que, para cuando eso llegue a pasar, todos tengamos consciencia de que, el dolor del otro es nuestro dolor.

Ésta es una situación en donde resulta especialmente apropiado utilizar las unidades “naturales”; la masa, longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física para ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

Es fácil caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones, el universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del universo en “tics” de Tiempo de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

¿Por qué nuestro universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el tiempo en el universo el proceso de formación de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo.

La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

emilio silvera

Oct

18

¡La Física! Los Caminos de la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Conexiones sin fin que nos llevan a tener consciencia de Ser

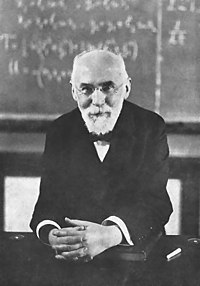

¡Preludio a la relatividad! -Las ecuaciones de Lorentz-Fitzgerald- Éste último pensaba y decía cosas comos estas:

George FitzGerald

“… la telegrafía debe mucho a Euclides y otros geómetras puros, al griego y al árabe que fueron matemáticos magistrales que inventaron nuestra escala de numeración y el álgebra, de Galileo y Newton, que fundaron la dinámica, para que Newton y Leibniz inventaran el cálculo, para que Volta descubriera la galvánica bobina, a Oersted quien descubrió la acción magnética de las corrientes, que a Ampère descubriera las leyes de su acción, a Ohm que descubrió la ley de la resistencia de los cables, a Wheatstone, de Faraday, a Lord Kelvin, a Clerk Maxwell, Hertz a… Sin los descubrimientos, invenciones, y las teorías científicas resumen de estos hombres la telegrafía y otras maravillas y conocimientos… ¡serían imposibles ahora!”

Hendrik Antoon Lorentz

Se le deben importantes aportaciones en los campos de la termodinámica, la radiación, el magnetismo, la electricidad y la refracción de la luz. Formuló conjuntamente con George Francis FitzGerald una teoría sobre el cambio de forma de un cuerpo como resultado de su movimiento; este efecto, conocido como “contracción de Lorentz-FitzGerald”, cuya representación matemática de ella es conocida con el de transformación de Lorentz, fue una más de las numerosas contribuciones realizadas por Lorentz al desarrollo de la teoría de la relatividad.

Fue, al igual que Henri Poincaré, uno de los primeros en formular las bases de la teoría de la relatividad (frecuentemente atribuida primaria o solamente a Albert Einstein). Fue ganador del Premio Nobel de Física en 1902, junto con su pupilo Pieter Zeeman, por su investigación conjunta sobre la influencia del magnetismo en la radiación, originando la radiación electromagnética. fue premiado con la Medalla Rumford en 1908 y la Medalla Coplay en 1918. Lorentz era hombre humilde y sencillo y le gustaba resaltar los logros de los demás:

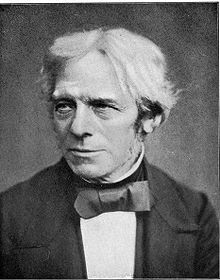

Michael Faraday

“Como es probable que sepas, gran parte de nuestro conocimiento sobre la electricidad y el magnetismo se basa en los experimentos ingeniosísimos realizados por Michael Faraday en la primera parte del siglo XIX. Faraday era un experimentador genial, y descubrió numerosos fenómenos desconocidos hasta entonces, como la mutua. Estableció diversas leyes, pero no pudo elaborar una teoría global acerca del electromagnetismo porque sus conocimientos matemáticos no iban más allá de la trigonometría: hacía falta un teórico capaz de amalgamar el conocimiento adquirido por Faraday y otros experimentadores, como Hans Christian Ørsted, en una teoría general”.

Ese teórico era otro genio, James Clerk Maxwell, que estableció un conjunto de cuatro ecuaciones diferenciales bellísimas que describían de una manera extraordinariamente precisa los resultados de casi todos los experimentos de Faraday, Ørsted y compañía. Lo más sorprendente, el propio Maxwell y sus contemporáneos, fue una de las consecuencias inevitables de sus ecuaciones: la existencia de perturbaciones del campo eléctrico y el magnético que se propagaban por el espacio.”

A la contracción, Einstein le dio un marco teórico en la teoría especial de la relatividad. En teoría, un objeto de longitud l0 en reposo en un sistema de referencia parecerá, un observador en otro sistema de referencia que se mueve con velocidad relativa v con respecto al primero, tener longitud ![]() , donde c es la velocidad de la luz. La hipótesis original atribuía contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

, donde c es la velocidad de la luz. La hipótesis original atribuía contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

Un objeto que se moviera a 11,2 Km/s (la velocidad de escape de nuestro planeta) experimentaría sólo una contracción equivalente a 2 partes por cada 1.000 millones en el sentido del vuelo. Pero a velocidades realmente elevadas, tal contracción sería sustancial. A unos 150.000 Km/s (la mitad de la velocidad de la luz) sería del 15%; a 262.000 Km/s (7/8 de la velocidad de la luz), del 50%. Es decir, que una regla de 30 cm que pasara ante nuestra vista a 262.000 Km/s nos parecería que mide sólo 15’24 cm, siempre y cuando conociéramos alguna manera para medir su longitud en pleno vuelo. Y a la velocidad de la luz, es decir, 300.000 Km/s en números redondos, su longitud en la dirección del movimiento sería cero. Puesto que, presuntamente, no puede existir ninguna longitud inferior a cero, se deduce que la velocidad de la luz en el vacío es la mayor que puede imaginarse el universo.

experimento conocido de Michelson-Morley

Todo aquello fue posible gracia a que en 1893, el físico irlandés George Francis FitzGerald emitió una hipótesis explicar los resultados negativos del experimento conocido de Michelson-Morley. Adujo que toda materia se contrae en la dirección del movimiento, y que esa contracción es directamente proporcional al ritmo (velocidad) del movimiento.

Según tal interpretación, el interferómetro se quedaba corto en la dirección del “verdadero” movimiento terrestre, y lo hacía precisamente en una cantidad que compensaba con toda exactitud la diferencia de distancias que debería recorrer el rayo luminoso. Por añadidura, todos los aparatos medidores imaginables, incluyendo los órganos sensoriales humanos, experimentarían ese mismo fenómeno.

Parecía como si la explicación de FitzGerald insinuara que la Naturaleza conspiraba con objeto de impedir que el hombre midiera el movimiento absoluto, lo cual introducía un efecto que anulaba cualquier diferencia aprovechable para detectar dicho movimiento.

Este asombroso fenómeno recibió el de “contracción de FitzGerald”, y su autor formuló una ecuación para el mismo que, referido a la contracción de un cuerpo móvil, fue predicha igualmente, y de manera independiente, por H.A.Lorentz (1853-1928) de manera que, finalmente, se quedaron unidas como “Contracción de Lorentz-Fitz Gerald”.

El efecto Fitzgerald sobre longitudes y el efecto Lorentz sobre masas mantuvieron una conexión tan estrecha que aparecieron a menudo agrupadas como las ecuaciones Lorentz-Fitzgerald.

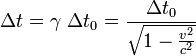

La dilatación del tiempo es el fenómeno predicho por la teorçia de la relatividad, por el cual un observador observa que el reloj de otro (un reloj físicamente idéntico al suyo) está marcando el tiempo a un ritmo menor que el que mide su reloj. Esto se suele interpretar normalmente como que el tiempo se ha ralentizado para el otro reloj, pero eso es cierto solamente en el contexto del sistema de referencia del observador. Localmente, el tiempo siempre está pasando al mismo ritmo. El fenómeno de la dilatación del tiempo se aplica a cualquier proceso que manifieste cambios a través del tiempo.

Donde:

es el intervalo temporal entre dos eventos co-locales para un observador en algún sistema de referencia inercial. (por ejemplo el número de tic tacs que ha hecho su reloj)

es el intervalo temporal entre dos eventos co-locales para un observador en algún sistema de referencia inercial. (por ejemplo el número de tic tacs que ha hecho su reloj) es el intervalo temporal entre los dos mismos eventos, tal y como lo mediría otro observador moviéndose inercialmente con velocidad v, respecto al primer observador

es el intervalo temporal entre los dos mismos eventos, tal y como lo mediría otro observador moviéndose inercialmente con velocidad v, respecto al primer observador es la velocidad relativa entre los dos observadores

es la velocidad relativa entre los dos observadores la velocidad de la luz y

la velocidad de la luz y es el también conocido como factor de Lorentz

es el también conocido como factor de Lorentz

De esta manera la duración del un ciclo de reloj del reloj que se mueve se ha incrementado: esta “funcionando más despacio”. Según lo indicado las transformaciones de Lorentz pueden ser utilizadas para casos más generales.

Postulados de la Relatividad Especial

- Primer postulado: Principio especial de relatividad: Las leyes de la física son las mismas en todos los sistemas de referencia inerciales. En otras palabras, no existe un sistema inercial de referencia privilegiado, que se pueda considerar como absoluto.

- Segundo postulado: Invariancia de c: La velocidad de la luz en el vacío es una constante universal, c, que es independiente del movimiento de la fuente de luz.

Einstein que se apropió de aquella idea (de Lorentz) y, además, la amplió al contraer también el Tiempo. La contracción de la longitud ha sido verificada en el diseño, por ejemplo, del acelerador lineal de la Universidad de Stanford. Las partículas salen con una velocidad v = 0,999975c, por tanto, metro de tubo acelerador es “visto” por los electrones como 144 metros. Si, según la expresión anterior, un cuerpo con masa se moviera a la velocidad c desaparecería por contracción de su longitud para un observador en reposo, lo cual refuerza el carácter inalcanzable de velocidad. Si los objetos con masa alcanzan este límite de velocidad la estructura básica de la realidad se desvanece. Por otra parte, vemos que cualquier influencia que afecte al tiempo también lo hará con el espacio. Esto no nos debe de extrañar, ya que ambas magnitudes se encuentran íntimamente relacionadas por lo único que se nos mantiene invariable: la velocidad de la luz. En relatividad hablamos de espacio-tiempo ya que son inseparables.

A la contracción, Einstein, le dio un marco teórico en la teoría especial de la relatividad. En teoría, un objeto de longitud /0 en reposo en un sistema de referencia parecerá, para un observador en otro sistema de referencia que se mueve con velocidad relativa v con respecto al primero, tener longitud /0 , donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

Un objeto que se moviera a 11 km/s (la velocidad de escape de nuestro planeta) experimentaría sólo una contracción equivalente a 2 partes por cada 1.000 millones en el sentido del vuelo. Pero a velocidades realmente elevadas, tal contracción sería sustancial. A unos 150.000 km/seg. (la mitad de la velocidad de la luz, c), sería del 15%; a 262.000 km/seg. (7/8 de la velocidad de la luz), del 50% Es decir, que una regla de 30 cm. que pasara ante nuestra vista a 262.000 km (seg., nos parecería que mide sólo 15’54 cm…, siempre y cuando conociéramos alguna manera medir su longitud en pleno vuelo. Y a la velocidad de la luz, es decir, 300.000 km/seg., en números redondos, su longitud, en la dirección del movimiento, sería cero. Puesto que, presuntamente, no puede existir ninguna longitud inferior a cero, se deduce que la velocidad de la luz en el vacío es la mayor que puede imaginarse en el Universo. (Pero ¿existir también?).

El físico holandés Hendrik Antón Lorentz, como hemos dicho, promovió ésta idea pensando en los rayos catódicos (que ocupaban su actividad por aquellas fechas), se hizo el siguiente razonamiento: si se comprimiera la carga de una partícula reducir su volumen, aumentaría su masa. Por consiguiente, una partícula voladora, escorzada en la dirección de su desplazamiento por la contracción de Fitz Gerald, debería crecer en términos de masa.

Un objeto que corra a velocidades cercanas a la de la luz, verá incrementada su masa

Lorentz presentó una ecuación sobre el acrecentamiento de la masa, que resultó muy similar a la ecuación FitzGerald sobre el acortamiento. A 149.637 kilómetros por segundo, la masa de un electrón aumentaría en un 15%; a 262.000 km/seg., en un 100% (es decir, la masa se duplicaría); y a la velocidad de la luz, su masa sería infinita. Una vez más pareció que no podría haber ninguna velocidad superior a la de la luz, pues, ¿cómo podría ser una masa mayor que infinita? El efecto FitzGerald sobre longitudes y el efecto Lorentz sobre masas mantuvieron una conexión tan estrecha que aparecieron a menudo agrupadas las “ecuaciones Lorentz-FitzGerald.”

Mientras que la contracción FitzGerald no podía ser objeto de mediciones, el efecto Lorentz sobre masas si podía serlo…, aunque indirectamente. De hecho, el muón, tomó 10 veces su masa original fue lanzado, a velocidades relativistas, en el acelerador de partículas, lo que confirmó la ecuación de Lorentz. Los experimentos posteriores, han confirmado las ecuaciones de ambos: a velocidades relativistas, las longitudes se contraen y las masas se incrementan.

Nada puede viajar a la velocidad de la luz

Como es conocido por todos, Einstein adoptó estos descubrimientos y los incorporó a su teoría de la relatividad especial que, aunque mucho más amplia, recoge la contracción de FitzGerald y el aumento de la masa de Lorentz cuando se alcanzan grandes velocidades.

¡Qué cosas!

Algunas veces pienso que, los artistas en general, y los poetas en particular, tendrían que adaptar e incluir a sus esquemas artísticos y poéticos, los adelantos científicos, para asimilarlos en las diversas expresiones y sentimientos que serán después puestos al servicio del consumo humano.

Estos adelantos científicos serían así coloreados con las pasiones humanas y transformadas, de alguna manera, en la sangre, y por qué no, los sentimientos de la naturaleza humana.

Posiblemente, de haberlo hecho así, el grado general de conocimiento sería mayor.

emilio silvera

Oct

17

Imaginación sin límite pero… ¿Sabremos comprender?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Relativista ~

Clasificado en Física Relativista ~

Comments (0)

Comments (0)

Está claro que pensar siquiera en que en nuestro Universo, dependiendo de la región en la que nos encontremos, habrá distintas leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar y creer que en cualquier parte del universo rigen las mismas leyes físicas, hasta que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sean cuales fueran las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte del Cosmos por muy remota que se encuentre aquella región; los elementos primordiales que lo formaron fueron siempre los mismos y las fuerzas que intervinieron para formarlo también.

La materia y las fuerzas que conforman nuestro Universo

Las fuerzas fundamentale son

|

Tipo de Fuerza |

Alcance en m |

Fuerza relativa |

Función |

| Nuclear fuerte |

<3×10-15 |

1041 |

Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

| Nuclear débil |

< 10-15 |

1028 |

Es responsable de la energía radiactiva producida de manera natural. Portadoras W y Z– |

| Electromagnetismo |

Infinito |

1039 |

Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

| Gravitación |

Infinito |

1 |

Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies pegados a la superficie de la Tierra. La transporta el gravitón. |

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una forma que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. En caso contrario… ¿En qué clase de Universo estaríamos?

Lo cierto es que Einstein fue muy afortunado y pudo lanzar al mundo su teoría de la relatividad especial, gracias a muchos apoyos que encontró en Mach, en Lorentz, en Maxwell… En lo que se refiere a la relatividad general, estuvo dando vueltas y vueltas buscando la manera de expresar las ecuaciones de esa teoría pero, no daba con la manera de expresar sus pensamientos.

Sin embargo, fue un hombre con suerte, ya que, durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba cuando las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio cuenta de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Gracias al Tensor de Rieman, Einstein pudo formular: ![]()

Recordando aquellos años de búsqueda e incertidumbre, Einstein escribió:

“Los años de búsqueda en la oscuridad de una verdad que uno siente pero no puede expresar el deseo intenso y la alternancia de confianza y desazón hasta que uno encuentra el camino a la claridad y comprensión sólo son familiares a aquél que los ha experimentado. “

Einstein, con esa aparentemente sencilla ecuación que arriba podemos ver, le dijo al mundo mucho más, de lo que él mismo, en un principio pensaba. En ese momento, se podría decir, sin temor a equivocarnos que comenzó la historia de la cosmología moderna. Comprendidmos mejor el universo, supimos ver y comprender la implosión de las estrellas obligadas por la gravedad al salir de la secuencia principal, aprecieron los agujeros negros… y, en fin, pudimos acceder a “otro universo”.

Es curioso como la teoría de la relatividad general nos ha llevado a comprender mejor el universo y, sobre todo, a esa fuerza solitaria, la Gravedad. Esa fuerza de la naturaleza que ahora está sola, no se puede juntar con las otras fuerzas que -como tantas veces hemos comentado aquí-, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas galácticas, estelas y de objetos que, como los agujerods negros y los mundos, emiten la fuerza curvando el espacio a su alrededor y distorsionando el tiempo si su densidad llega a ser extrema.

Cuando miramos al cielo nocturno -en la imagen de arriba lo hacemos desde Tenerife- y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Cuando recordamos que la galaxia Andrómeda se está acercando a la Vía Láctea a unos 300 km/s, y sabiendo lo que ahora sabemos, no podemos dejar de preguntarnos ¿dónde estará la Humanidad dentro de cinco mil millones de años? Si tenemos la suerte de haber podido llegar tan lejos -que es dudoso-, seguramente, nuestra inmensa imaginación habrá desarrollado conocimientos y tecnologías suficientes para poder escapar de tan dramático suceso. Estaremos tan ricamente instalados en otras galaxias, en otros mundos. De alguna manera… ¿No es el Universo nuestra casa?

emilio silvera

Oct

17

¡¡Quásares!! Extraños objetos de inusitado brillo y energía

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

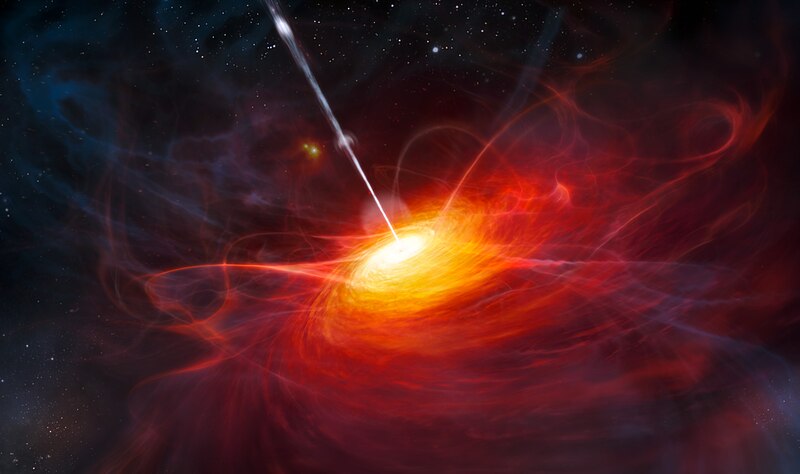

Una composición artísdtica del quásar más brillante descubierto hasta el momento: ULAS J1120+064.

Los quásares son galaxias distantes muy luminosas, alimentadas por un agujero negro supermasivo en su centro. Su brillo los convierte en poderosos faros que pueden ayudar a investigar la época en que se formaron las primeras estrellas y galaxias.Son útilespara ir comprendiendo cómo se formó el universo al revelar el estado de ionización del medio intergaláctico que tuvo lugar unos mil millones de años después del Big Bang. Parece que ULAS J1120+064 es es quásar más distante descubierto hasta el momento. Situado a más de doce mil millones de años-luz de nuestra Galaxia, está cerca de los limites del universo visible. La masa del agujero negro situado en el centro de ULAS J1120+0641 equivale a dos mil millones de veces la masa del Sol.

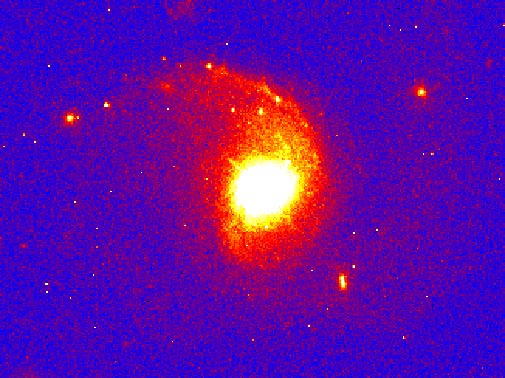

Estas fotos del Telescopio Espacial Hubble muestra diversos quasáres. Los quasáres son objetos distantes de gran energía. El quasar de arriba a la izquierda está a 1.4 mil millones de años luz de la Tierra. La imagen a la derecha muestra un quasar que puede ser el resultado del choque de dos galaxias viajando a 1 millón de millas por hora. Esta galaxia está a 3 mil millones de años luz de distancia. En la foto del centro un quasar se une con una galaxia.

STScI.

Los quásares han sido identificados históricamente en estudios ópticos, insensibles a fuentes de desplazamiento al rojo más allá de 6,5. Con el estudio de ULAS J1120+0641 se ha podido compronbar que tiene un acercamiento de 7,085, lo que significa 770 millones de años después del origen del universo. El quásar más cercano a este punto observado hasta el momento tenía un desplazamiento de 6,44 (100 millones de años más joven que este). Estudiar la distancia entre los dos “faros” servirá para arrojar algo de luz a una época de la que los científicos no tienen mucha información. Para la ciencia no es fácil poder explicar cómo, en una fase tan temprana del universo, se pudo crear un objeto con una masa tan inmensa que derriba las actuales teorías sobre el crecimiento de los agujeros negros supermasivos que predicen un crecimiento lento a medida que “el monstruo” atrae materia hacia sí desde la región circundante.

La imagen de arriba es otra representación artística de un Quásar, las auténticas los las seis fotografías que más arriba podéis ver y que representan -al menos eso es lo que parece- una apariencia estelar, muy similar a una estrella común tomada en la lejanía. Sin embargo el análisis detallado y profundo nos delatan algunas peculiaridades que rodean a esta clase de objetos y que los define en su singularidad propia que los hace muy diferents a las estrellas comunes al tener estructuras muy complejas. El descubrimiento de los quásares se debió a que son intensos emisores de radio ondas y también fuentes de rayos X, radiación ultravioleta, luz visible e infrarroja, es decir, la emisión de los cuásares recorre todo el espectro electromagnético.

Imagen de 3C273 recogida por el telescopio espacial Chandra

Fue en 1963 cuando M. Schmidt identificó por primera vez al quasar 3C 273 como el objeto más alejado entre todas las galaxias conocidas en ese entonces: los cálculos lo ubicaron a unos 2.000 millones de años-luz. Posteriormente, se comprobó que elcorrimiento al rojo de todos los quásares es mayor que el de las galaxias conocidas; por lo tanto, se encuentran más distantes que cualquiera de ellas. Esta evidencia confirmaría que se trata de los objetos más lejanos del universo conocido.

Así, las luces brillantes de los cielos que parecían estrellas, pero que eran demasiado luminosas para serlo, comenzaron a ser conocidas como objetos casi-estrellas o, resumiento, quasares. La extraordinaria luminosidad de los quasares era sólo una de entre sus poco frecuentes propiedades. Todavía era más extraño el hecho de que esa enorme efusión de energía parecía proceder de una región del espacio notablemente pequeña, más pequeña, de hecho, que nuestro Sistema solar.

Comparando las dos imágenes, aunque sean tan distitnas y representan realidades tan opuestas, lo cierto es que uno se hace una idea de lo inmensamente rica que es la diversidad del Universo con todas las formas y objetos que contiene. Un simple paisaje de nuestro planeta y un quásar lejano y, sin embargo, todo lo que está presente en ambos lugares está hecho de la misma cosa, Quarks y Leptones que se conforman de manera distinta para dar resultados diferentes y diferentes propiedades que han partido de una fuente común.

Lo asombroso de los quásares está en una pregunta que se hacen todos los astrónomos: ¿Cómo puede un objeto tan “pequeño” como un sistema solar producir la energía de cientos de miles de millones de estrellas? Y, sin embargo, el espacio que ocupan no tiene lugar para contener tántas estrellas como serían necesarias para emitir esa enorme energía. Lo cierto es que no se sabe si existe alguna fuerza desconocida para la ciencia que pueda generar la energía de los quásares. Una fuerza incluso más poderosa que la nuclear que es la que genera la energía que irradian las estrellas.

El misterio fue desvelado a base de observaciones y cálculos y más comprobaciones: Los quásares eran, en realidad, enormes agujeros negros situados en el centro de las galaxias más lejanas del Universo que, habían tenido el tiempo suficiente para hacerse tan inmensamente grandes que, dominaban la galaxia que los contenían y eran una gran parte de ella. Otros postulan que son galaxias jovenes que tienen un agujero negro central. Lo cierto es que, saber, lo que se dice saber lo que son los quásares, nadie lo sabe con exactitud milimétrica y todos son aproximaciones y conjeturas más o menos acertadas como otros muchos misterios que rodean las cosas del Universo que no hemos llegado a comprender.

Arriba podemos contemplar la simulación por ordenador de Joshua Barnes de la Universidad de Hawai. Abajo la escenificación artística del corazón de un quásar, un agujero negro masivo que absorbe en un vórtice de gas. Los astrónomos e Hawai creen que el Quásar brilla debido a que una galaxia gigante con un agujero negro colisiona con otra galaxia rica en gas que alimenta al agujero negro. Crédito: A. Simonet, Universidad Estatal de Sonoma, NASA.

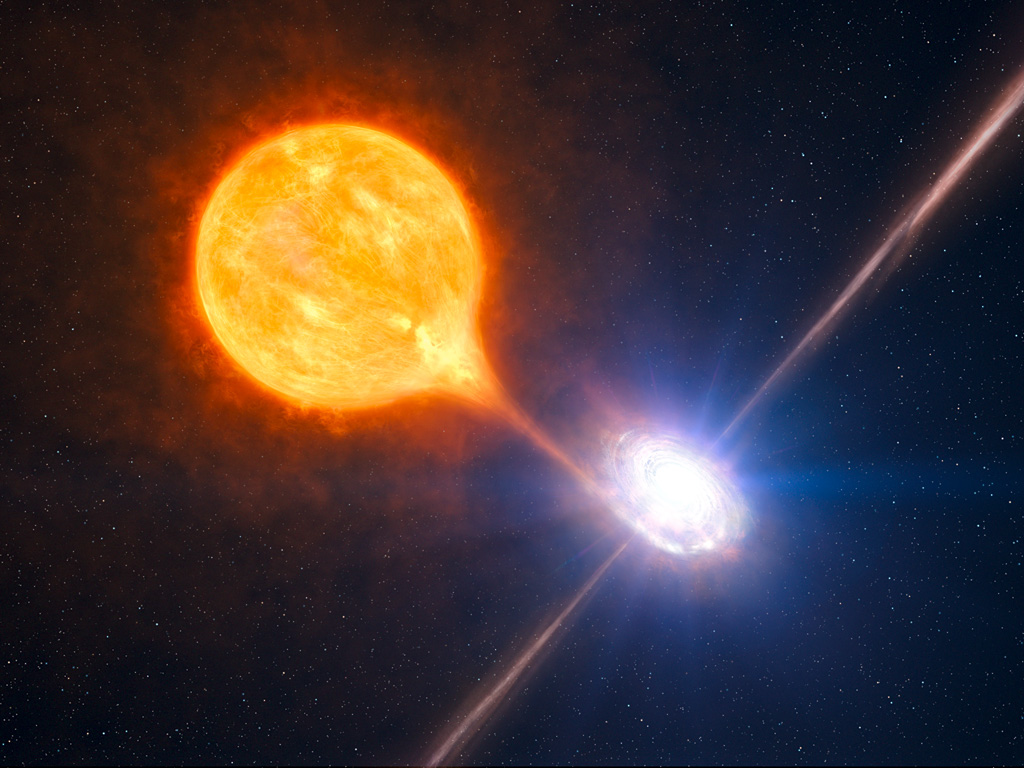

Según todos los síntomas y datos que podemos poner sobre la mesa de estudio, la conclusión que podría ser la más acertada nos lleva a pensar que, los quásares, son inmensos agujeros negros alojados en los núcleos de grandes galaxias ricas en gas y numerosas estrellas que rodean al masivo objeto que, de manera gradual va describiendo una espiral de materia que atrae hasta él. A medida que cada estrella se acerca lo suficiente al agujero negro, su cuerpo gaseoso se desprende…

… debido a la fuerza de gravedad que genera el agujero negro y que es totalmente irresistible para la estrella que, inevitablemente, se espaguetiza y cae en las fauces del monstruo para engrosar su increíble y densa masa que lo hace más y más poderoso a medida que engulle materia de todo tipo que por las cercanias pueda pasar.

Los átomos de materia gaseosa situados en el interior de la estrella que, literalmente se desintegra, tomando gran velocidad por la fuerza de atracción que sobre ella ejerce el agujero negro, se mueve cada vez más rápidamente, como deseosa de llegar a su fatal destino. Cuando los átomos se aproximan a los límites del agujero negro, chocan unos con otros. Estas colisiones elevan la temperatura del gas, y este gas caliente irradia energía al espacio. Esta energía es la que detectan nuestros ingenios cuando estamos observando a un quásar lejano.

Nuestro Universo nos puede mostrar maravillas y cosas tan extrañas que durante muchos años no llegamos a comprender. El intenso estudio y las repetidas observaciones que en los distintos lugares del mundo se llevan a cabo sobre estos exóticos objetos, poco a poco, van generando datos que, unidos, nos llevan hacia la comprensión de lo que allí sucede, de cómo se pudieron generar algunos de estos extraños cuerpos masivos, o, pongamos por caso, cuál es el origen de las beiznas luminosas de gas plasmático que podemos contemplar en el remanente de una explosión supernova. La materia, amigos míos, puede adoptar tan extrañas y exóticas formas que, algunas, nos resultan desconcoidas y misteriosas.

La teoría prevé que el diámetro de un agfujero negro es proporcional a la cantidad de materia que hay en su interior. De esta manera, cada vez que un agujero negro se encuentra con otro y lo absorbe, el agujero negro resultante es mucho mayor. Al ser mucho más grande, ese mismo agujero negro tiene ahora más posibilidad de chocar con otros objetos al atraerlos gravitacionalmente y, los engulle para hacerce más y más grande. A partir de cierto momento, la capacidad de ese agujero negro de seguir absorbiendo más y más masa, se hace imparable y entra en un proceso sin fin en el que, cuanto mayor sea el agujero negro, más probabilidades tendrá de seguir consumiendo la materia que -pobre de ella- pase por sus dominios gravitatorios. De estos agujeros negros gigantes, han sido detectados -al menos así lo parecen los efectos de radiación y otros muy específicos que han sido comprobados- una buena cantidad en diversas galaxias más o menos lejanas.

Cuando un agujero negro engulle a una estrella, al ginal del proceso, se emite una inmensa explosión de energía. Estas explosiones de energía que se siguen unas a otras a medida que las estrellas más cercanas al agujero negro son consumidas por él, alimentan la extraordinaria cantidad de energía del quásar. Así que, resulta que el quásar es una galaxia que tiene un agujero negro gigante en el centro.

La deslumbrante radiación del quásar se crea a partir de las estrellas que, una por una, van alimentando al agujero negro gigante. Cada vez que el agujero negro gigante captura una estrella, vemos como el quásar tiene un fulgor como cuando arrojamos otro leño al fuego -guardando las distancias-. Al principio, el fuego resplandece con gran fulgor porque el agujero negro gigante tiene a su alcance un amplio suministro de estrellas disponibles para alimentar su insaciable voracidad.

Hemos podido llegar tan lejos gracias a que la Ciencia de la Astronomía y la Astrofísica no ha dejado de avanzar desde aquellos rudimentarios datos observacionales de los sumerios, y babilonios, o, los chinos los griegos y los árabes hasta llegar a Galileo y Kepler, Tycho Brahe y tantos otros que, enamorados de las maravillas del Universo, entregaron sus vidas al estudio de la Naturaleza del espacio infinito.

Así, hemos podido llegar a saber que, pasando el tiempo, muchas estrellas de la zona interior de las galaxias han ido desapareciendo al ser engullidas por esos monstruosos gigantes que llaamamos agujeros negros. Después de un intervalo de tiempo relativamente corto, quizá de unos cientos de millones de años, quedan ya muy pocas estrellas. Al quedar sin fuente de energía, el quásar se va oscureciendo y allí, donde antes resplandecía un fulgurante quásar, sólo queda ahora una galaxia de apariencia normal que, eso sí, en su interior aloja a un monstruo que está al acecho de lo que por allí pueda pasar para devorarlo.

Se conocen más de 200.000 cuasares. Todos los espectros observados tienen un corrimiento al rojo considerable, que va desde 0,06 hasta el máximo de 6,4. Por tanto, todos los quasares se sitúan a grandes distancias de la Tierra, el más cercano a 240 Mpc (780 millones de años luz) y el más lejano a 6 Gpc (13.000 millones de años luz). La mayoría de los quasares se sitúan a más de 1 Gpc de distancia; como la luz debe tardar un tiempo muy largo en recorrer toda la distancia, los cuasares son observados cuando existieron hace mucho tiempo, y el universo como era en su pasado distante.

Cuando profundizamos en las maravillas que el Universo contiene, cuando llegamos a comprender el por qué de los sucesos que podemos observar en el espacio profundo, cuando el estudio y la obervación ilumina nuestras mentes y el inmenso resplandor del saber nos inunda, entonces, y sólo entonces, llegamos a comprender la materia, la energía, los objetos estelares y cosmológicos que pueblan el Cosmos, todo ello, se rige por una serie de normas que son inalterables: Las cuatro fuerzas fundamentales y las constantes universales que, no sólo hacen posible la existencia de Quásares lejanos alentados por la presencia de agujeros negros gigantes, sino que también, esas mismas leyes y normas, hacen posible la existencia de las estrellas y los mundos y, en ellos, de la vida y de la inteligencia que todo lo vigila y de todo quiere saber.

Claro que, esa inteligencia a la que me refiero podría estar plasmada de muchas formas e incluso, algunas, aíun teniéndolas junto a nosotros ni la podríamos ver. La vida en el Universo, aunque la única que conocemos es la que está presente en el planeta Tierra, de cuya diversidad nos asombramos cada día -sólo tenemos que recordar que de las formas de vida que han estado presente en nuestro planeta, simplemente el uno por ciento pervive y está presente en estos momentos, el resto se entinguió por uno u otro motivo-, y, si la diversidad es tan grande en un redudico espacio como la Tierra… ¿Qué no habrá por ahí fuera?

emilio silvera

Totales: 74.975.127

Totales: 74.975.127 Conectados: 20

Conectados: 20