Oct

7

La Física de partículas, el Modelo Estándar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

El hombre se ha preguntado durante largo tiempo, “¿de qué está hecho el mundo?” Demócrito de Abdera nos hablaba del “átomo” y Empédocles de “elemenmtos”, otros, se referían a la sustancia cósmica a la que llamaban Ylem, aquella “semilla” primera que daría lugar a la venida de la materia. ¿No será el Ylem, lo que hoy llaman materia oscura?

Ahora sabemos que, no sólo nuestro mundo, sino todo el inmenso Universo, está hecho de pequeños objetos infinitesimales a las que hemos denominado partículas subatómicas y que forman varias familias. Unas son más elementales que otras y según, a qué familia pertenezcan, atienden o se rigen por una u otra fuerza elemental.

Son los constituyentes fundamentales de toda la materia del Universo (por lo menos de toda la materia conocida y que podemos detectar formando estrellas y mundos, galaxias o seres vivos). Hemos podido llegar a saber que, de esas briznas de materia se forman los núcleos que, rodeados de electrones conforman los átomos de la materia.

Todo lo grande está hecho de “cosas” pequeñas

Los grupos de átomos conforman las moléculas que son las unidades fundamentales de los compuestos químicos pero, comencemos por los núcleos atómicos:

Muchas son las veces que aquí mismo he podido explicar, que los quarks u y d se hallan en el interior de los nucleones y, por tanto, su habitat está en los núcleos atómicos donde se encuentran confinados y, en realidad, no intervienen directamente en las propiedades de los núcleos. Sin embargo, no podemos olvidar que la fuerza nuclear fuerte está ahí reteniendo a los quarks por medio de los gluones y, eso hace que, el núcleo sea estable.

Los núcleos atómicos constituyen un tipo de materia que, aisladamente, de forma individual (si exceptuamos el protón), siempre están en ambientes muy energéticos, por ejemplo, en el interior de las estrellas. En nuestro entorno terráqueo, es raro encontrar núcleos aislados, sino parcial o totalmente confinados dentro de los átomos.

Sabemos que el número de especímenes atómicos es limitado, existiendo ciertas razones para suponer que hacia el número atómico 173 los correspondientes núcleos serían inestables, no por razones intrínsecas de inestabilidad “radiactiva” nuclear, sino por razones relativistas. Ya señalé en otros escritos que, el número de especies atómicas, naturales y artificiales, es de unos pocos miles, en cambio, el número de moléculas conocidas hasta ahora comprenden unos pocos millones de especímenes, aumentando continuamente el número de ellas gracias a la síntesis que se lleva a cabo en numerosos laboratorios repartidos por todo el mundo.

Una molécula es una estructura, con individualidad propia, constituida por un conjunto de núcleos y sus electrones. La molécula más sencilla es la de Hidrógeno que tiene dos electrones, hasta las más complejas como las de las proteínas, con muchos miles de ellos, existen toda una gama de varios millones. Esta extraordinaria variedad de especies moleculares contrasta con la de las especies nucleares e incluso atómicas.

Desde el punto de vista de la información, las especies moleculares la poseen en mucho mayor grado que las nucleares o atómicas. Dejando aparte los núcleos, la información que soportan los átomos se podría atribuir a la distribución de su carga eléctrica, y en particular a los electrones más débilmente ligados. Concretando un poco más, se podría admitir que la citada información la aportan los orbitales atómicos, pues son precisamente estos orbitales los que introducen diferencias “geométricas” entre los diferentes electrones “corticales”.

Las partículas forman átomos, los átomos moléculas y las moléculas sustancias y cuerpos que están hechos por la diversa variedad de elementos que conforma la materia conocida y que, en definitiva, sólo son Quarks y Leptones.

Demos una vuelta por el Modelo Estándar.

El modelo estándar de partículas fundamentales y sus interacciones

Me quiero referir al Modelo estándar de la física de partículas y de las interacciones fundamentales y, algunos, han llegado a creer que sólo faltan algunos detalles técnicos y, con ellos, la física teórica está acabada. Tenemos un modelo que engloba todo lo que deseamos saber acerca de nuestro mundo físico. ¿Qué más podemos desear? Los pobres ilusos no caen en la cuenta de que el tal Modelo, al que no podemos negarle su valía como una herramienta muy valiosa para la física, no deja de estar incompleto y, además, ha sido construido con algunos parámetros aleatorios (unos veinte) que no tienen justificación. Uno de ellos era el Bosón de Higgs y, según nos han contado los del LHC, ha sido hallado. Sin embargo, esperamos que nos den muchas explicaciones que no han estado presente en todas las algaradas y fanfarrias que dicho “hallazgo” ha producido, incluidos los premios Principe de Asturias y el Nobel. ¡Veremos en que queda todo esto al final!

Bueno, lo que hasta el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entrecijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así. Muchos son los flecos sueltos, muchas las incognitas, múltiples los matices que no sabemos perfilar.

Es cierto que, el Modelo estándar, en algunos momento, nos produce y nos da la sensación de que puede ser perfecto. Sin embargo, esa ilusoria perfección, no es permanente y en algunas casos efímera. En primer lugar, podríamos empezar a quejarnos de las casi veinte constantes que no se pueden calcular. Pero si esta fuese la única queja, habría poco que hacer. Desde luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.

¿Por qué se iba a preocupar la Naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el proncipio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que ha posibilitado a todos los físicos del mundo para poder construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

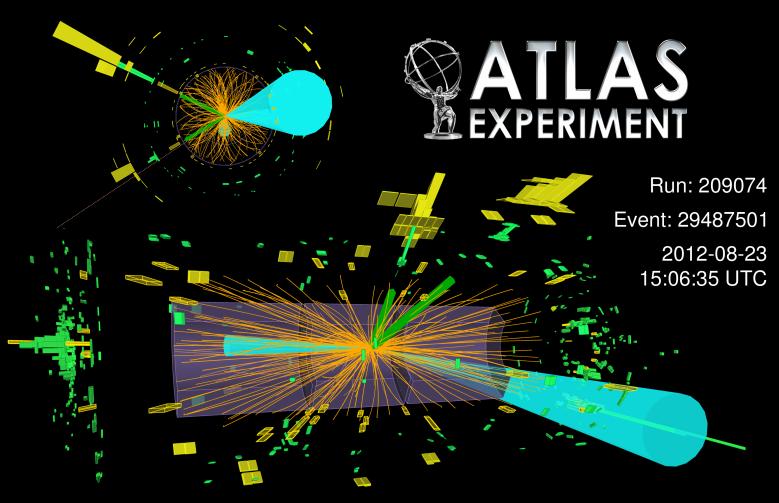

“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevo modo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

Este suceso muestra una colisión observada en el detector CMS. Por supuesto estas colisiones tienen poco interés para el estudio de la física a esta escala …

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructurtas cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar. En este punto se me ocurre la pregunta: ¿Seguiría siendo correcto el Modelo estándar? 0, por el contrario, a medida que nos alejemos en las profundidades de lo muy pequeño, también sus normas podrían variar al mismo tiempo que varían las dimensiones de los productos hallados. Recordad que, el mundo no funciopna de la misma manera en nuestro ámbirto macroscópico que ante ese otro “universo” cuántico de lo infinitesimal.

¿Podeis imaginar conseguir colisiones a 70.000 TeV? ¿Que podríamos ver? Y, entonces, seguramente, podríamos oir en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos” Comentarios así estarían a la orden del día. Los hay que siempre están dispuestos a protestar por todo y, desde luego, no siempre llevan razón, toda vez que, la mayoría de las veces, ignoran de qué están hablando y juzgan si el conocimiento de causa necesario para ello. De todas las maneras, sí que debemos tener sumo cuidado con el manejo de fuerzas que… ¡no siempre entendemos! Cuando el LHC se vuelvsa a poner en marcha, se utilizarán energías que llegan hasta los 14 TeV, y, esas son palabras mayores.

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

Encendamos nuestro supermicroscopio imaginario y enfoquemosló directamente en el centro de un protón o de cualquier otra partícula. Veremos hordas de partículas fundamentales desnudas pululando. Vistas a través del supermicroscopio, el modelo estándar que contiene veinte constantes naturales, describen las fuerzas que rigen la forma en que se mueven. Sin embargo, ahora esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadas para conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria. Si en nuestras ecuaciones matemáticas cualquiera de estas constantes fueran reemplazadas por un número ligeramente diferente, la mayoría de las partículas obtendrían inmediatamente masas comparables a las gigantescas energías que son relevantes en el dominio de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Antes decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”. Es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio, las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático, no hay nada que objetar, pero la credibilidad del Modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas o, lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas.

¿Y por qué debería ser el modelo válido hasta ahí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables, ellas podrían modificar completamente el mundo que Gulliver planeaba visitar. Si deseamos evitar la necesidad de un delicado ajuste fino de las constantes de la Naturaleza, creamos un nuevo problema:

Es cierto que nuestra imaginación es grande pero… No pocas veces ¡la realidad la supera!

¿Cómo podemos modificar el modelo estándar de tal manera que el ajuste-fino no sea necesario? Está claro que las moficiaciones son necesarias , lo que implica que muy probablemente hay un límite más allá del cual el modelo deja de ser válido. El Modelo estándar no será más que una aproximación matemática que hemos sido capaces de crear, tal que todos los fenómenos observados hasta el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

¿Cómo hemos podido pensar de otra manera? ¿Cómo hemos tenido la “arrogancia” de pensar que podemos tener la teoría “definitiva”? Mirando las cosas de esta manera, nuestro problema ahora puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar? La respuesta puede estar en el hecho cierto de que no disponemos de la energía necesaria para poder llegar más lejos de lo que hasta el momento hemos podido viajar con ayuda de los aceleradores de partículas.

Los asistentes escuchan la presentación de los resultados del experimento ATLAS, durante el seminario del Centro Europeo de Física de Partículas (CERN) para presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs, base del modelo estándar de física.

La pregunta “¿Qué hay más allá del Modelo estándar”? ha estado facinando a los físicos durante años. Y, desde luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que no necesariamente tiene que coincidir con el mundo real que no hemos podido alcanzar.

O, como decía aquél: ¡Que mundo más hermoso, parece de verdad!

Siempre hay más de lo que el ojo ve

No todo lo que vemos es, necesariamente, un reflejo de la realidad de la Naturaleza que puede tener escondidos más allá de nuestras percepciones, otros escenarios y otros objetos, a los que, por ahora, no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

Hay dos direcciones a lo largo de las cuales se podría extender el Modelo estándar, tal lo conocemos actualmente, que básicamente se caraterizan así:

– Nuevas partículas raras y nuevas fuerzas extremadamente débiles, y

– nuevas partículas pesadas y nuevas estructuras a muy altas energías.

Podrían existir partículas muy difíciles de producir y de detectar y que, por esa razón, hayan pasado desapaercibidas hasta. La primera partícula adicional en la que podríamos pensar es un neutrino rotando a derecha. Recordaremos que si se toma el eje de rotación paralelo a la dirección del movimiento los neutrinos sólo rotan a izquierdas, pero… ¡esa sería otra historia!

Los neutrinos siempre me han fascinado. Siempre se han manifestado como si tuvieran masa estrictamente nula. Parece como si se movieran exactamente con la velocidad de la luz. Pero hay un límite para la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

En este punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

En realidad, los neutrinos nos tienen mucho que decir, todavía y, no lo sabemos todo acerca de ellos, sino que, al contrario, son muchos los y fenómenos que están y subyacen en ellos de los que no tenemos ni la menor idea que existan o se puedan producir. Nuestra ignorancia es grande, y, sin embargo, no nos arredra hablar y hablar de cuestiones que, la mayoría de las veces…ni comprendemos.

Aquí lo dejar´ñe por hoy, el tema es largo y de una fascinación que te puede llevar a lugares en los que no habías pensado al comenzar a escribir, lugares maravillosos donde reinan objetos exóticos y de fascinante porte que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan el asombro y también, a ese mundo mágico de lo fascinante y maravilloso.

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

emilio silvera

Oct

6

Si unimos las fuerzas: ¡Mejores resultados!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo misterioso ~

Clasificado en El Universo misterioso ~

Comments (0)

Comments (0)

Estudian la relación entre el cambio climático, el hielo y el aumento del nivel del mar. Una operación cuidadosamente ejecutada para validar los datos del satélite CryoSat ha demostrado lo que puede lograrse cuando la ESA, la NASA y otros unen sus fuerzas para mejorar nuestra comprensión de cómo el frágil medio ambiente polar es la respuesta al cambio climático.

La NASA y la ESA están trabajando en una nueva generación de proyectos que podrían usar esa tecnología de nuevo cuño. Sin embargo, lo más seguro es que, finalmente, dado el alto coste de estas misiones, se fusionen en un Proyecto verdaderamente global.

La NASA construirá una nave espacial llamada inicialmente el Orbitador de Júpiter-Europa y la ESA una llamada Orbitador de Júpiter-Ganímedes. Las dos naves espaciales serán lanzadas para el 2020 desde dos lugares diferentes y alcanzarán al sistema de Júpiter para el 2026 con al menos tres años de investigación. Estas nuevas propuestas de investigación serán muy buenas para comprender mejor la formación y evolución del sistema Joviano.

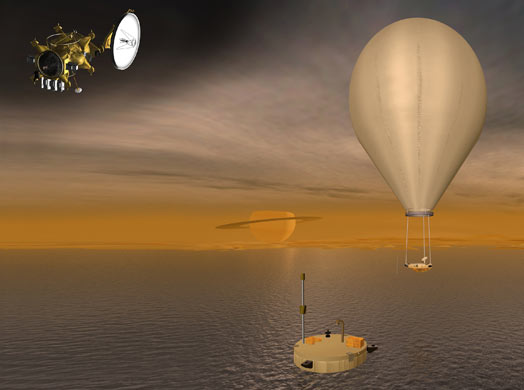

La Misión del Sistema Saturno-Titán consistiría en un orbitador de la NASA, un aterrizaje de la ESA y un globo de investigación. Esta compleja misión plantea varios desafíos técnicos importantes que requieren el estudio y desarrollo de la tecnología.

La Dirección de Ciencia y Exploración Robótica de la ESA administrará la contribución europea a la misión de Júpiter. El Laboratorio de Propulsión a Chorro de la NASA en Pasadena, California, administrará las contribuciones a los proyectos de la NASA para la Misión de la Dirección de Ciencias en Washington.

Credits: NASA/ESA

Sería una colaboración entre todos los expertos de renombre que hay en la Tierra para buscar la prueba de que no estamos solos en el Universo –Gaia en su conjunto buscando otras Gaias- El Proyecto de la Agencia Espacial Europea se conoce como el proyecto Darwin, pero también se denomina de una manera más prosaica, Interferómetro Espacial de Infrarrojos (IRSI = Infrared Space Interferometer); equivalente al de la NASA denominado Terrestrial Planet Zinder (TPF). Los dos proyectos funcionarán según los mismos principios.

Qué ocurriría si encontráramos vida en otro planeta?…..

Después de haber identificado el planeta Darwin IV, ubicado a 6,5 años luz de la Tierra, como un hábitat que acoge la existencia de vida, el documental Misión Espacial muestra el trabajo de varios científicos que deciden enviar a este planeta una misión no tripulada formada por una nave nodriza (conocida también como Von Braun) y tres sondas: Balboa, Da Vinci y Newton. El objetivo consistirá en encontrar o demostrar la existencia de cualquier forma de vida en Darwin IV. El planeta será observado de cerca por los “ojos” de las sondas Newton (apodada Ike) y Da Vinci (apellidada Leo).

Sin embargo, por sorprendente que pueda parecer, especialmente después de ver las imágenes de la Tierra tomadas desde el espacio, en las cuales ésta aparece como una brillante bola azul y blanca sobre un fondo oscuro, la luz visible no ofrece las mejores perspectivas para detectar directamente otros planetas similares a la Tierra. Esto es así por dos razones:

En primer lugar, la luz visible que se recibe desde un planeta como la Tierra es en esencia el reflejo de la luz procedente de su estrella progenitora, por lo que no sólo es relativamente débil, sino que resulta muy difícil de captar a distancias astronómicas sobre el fondo iluminado por el resplandor de dicha estrella.

En segundo lugar, del tipo de la Tierra alcanzan en realidad su brillo máximo en la parte de rayos infrarrojos del espectro electromagnético, por el modo en que la energía absorbida procedente del Sol vuelve a irradiarse en la zona de infrarrojos de dicho espectro, con longitudes de onda más largas que las de la luz visible.

En una longitud de onda de unas pocas micras, la Tierra es el planeta más brillante del Sistema solar y destacaría como un objeto impactante si se utilaza cualquier telescopio de infrarrojos suficientemente sensible situado en nuestra proximidad estelar. El problema es que, dado que la radiación de infrarrojos es absorbida por los propios gases de la atmósfera terrestre, como el dióxido de carbono y el vapor de agua, que son lo que nos interesa descubrir, el telescopio que se utilice para buscar otros planetas como la Tierra tendrá que ser colocado en las profundidades del espacio, lejos de cualquier fuente potencial de contaminación. También tendrá que ser muy sensible, lo que significa muy grande. De ahí que estemos hablando de un proyecto internacional muy caro que tardará décadas en llevarse a buen puerto haciéndolo una realidad.

La sola presencia de gases como el dióxido de carbono y el vapor de agua no es suficiente como un signo de vida, pero sí de la existencia de planetas del tipo de la Tierra en el sentido de que tendrían una atmósfera como Venus y Marte, mientras que, en particular, la presencia de agua indicaría la probabilidad de que existiera un lugar adecuado para la vida.

El Espacio ¡Ese sueño de la Humanidad!

En realidad, cuando se estudian de forma detenida y pormenorizada los mecanismos del Universo, podemos ver la profunda sencillez sobre la que este se asienta. Los objetos más complejos del Universo conocido son los seres vivos, como, por ejemplo, nosotros mismos.

Estos sistemas complejos están hechos de las materias primas más comunes que existen en Galaxias como la Vía Láctea. En forma de aminoácidos estas materias primas se ensamblan de manera natural, dando lugar a sistemas autoorganizadores donde unas causas subyacentes muy sencillas pueden producir complejidad en la superficie, como en el caso del tigre y sus manchas. Finalmente, con el fin de detectar la presencia de esta complejidad máxima de unos sistemas universales no necesitamos ninguna prueba sofisticada para distinguir la materia viva de la materia “inerte”, si no únicamente las técnicas más sencillas (aunque asistidas por tecnologías altamente avanzadas) para identificar la presencia de uno de los compuestos más simples del universo: El oxígeno.

![[Image: 600px-EtaCarinae.jpg]](http://i100.photobucket.com/albums/m18/JazzRoc/conspiracy/600px-EtaCarinae.jpg)

¿Estaremos seguros con Eta Carinae o Betelgeuse? Próximas supernovas

El caos y la complejidad se combinan para hacer del universo un lugar muy ordenado que es justo el entorno adecuado para formas vivas como nosotros mismos. Como dijo Stuart Kauffman, “en el universo estamos en nuestra propia casa”. Sin embargo, no es que el universo se haya diseñado así para beneficiarnos a nosotros. Por el contrario, lo que sucede es que estamos hechos a imagen y semejanza del universo que, valiéndose de las estrellas, fabricó los materiales necesarios para la vida.

Planteémonos una simple pregunta: Dadas las condiciones que imperaban en la Tierra hace cuatro mil millones de años, ¿qué probabilidades había de que surgiera la vida?

No basta con responder que “la vida era inevitable, puesto que nosotros estamos aquí “. Obviamente, la vida sí se inició: nuestra existencia lo demuestra. Pero ¿tenía que iniciarse? En otras palabras, ¿era inevitable que emergiera la vida a partir de un combinado químico y radiado por la energía interestelar y después de millones de años?

Posiblemente, en sitios como el de arriba, pudiera haber comenzado todo.

Nadie conoce una respuesta exacta a esta pregunta. El origen de la vida, según todos los indicios y datos con los que hoy contamos, parece ser un accidente químico con una alta probabilidad de reproducirse en otros lugares del Universo que sean poseedores de las condiciones especiales o parecidas a las que están presentes en nuestro planeta.

Pero la vida, no consiste solo en ADN, genes y replicación. Es cierto que, en un sentido biológico estricto, la vida está simplemente ocupada en replicar genes. Pero el ADN es inútil por sí sólo. Debe construir una célula, con todas sus sustancias químicas especializadas, para llevar a cabo realmente el proceso de replicación. En las denominadas formas de vida superior debe construir un organismo completo para que tenga todos los requisitos exigidos para que pueda replicarse. Desde la perspectiva de un genoma, un organismo es una manera indirecta de copiar ADN.

Un novedocódigo genético de una célula viva.

Sería muy laborioso y complejo explicar aquí de manera completa todos y cada uno de los pasos necesarios y códigos que deben estar presentes para formar cualquier clase de vida. Sin embargo, es necesario dejar constancia aquí de que los elementos necesarios para el surgir de la vida sólo se pueden fabricar en el núcleo de las estrellas y en las explosiones de supernovas que pueblan el universo para formar nebulosas que son los semilleros de nuevas estrellas y planetas y también de la vida.

El surgir de la vida en nuestro Universo puede ser menos especial de lo que nosotros pensamos, y, en cualquier lugar o región del Cosmos pueden estar presentes formas de vida en condiciones que para nosotros podría ser como las del infierno.

Hace varias décadas, los biólogos quedaron sorprendidos al descubrir bacterias que vivían confortablemente a temperaturas de setenta grados Celsius. Estos microbios peculiares se encontraban en pilas de abonos orgánicos, silos e inclusos en sistemas domésticos de agua caliente y fueron bautizados como termófilos.

Centro de operaciopnes de la nave sumergible Alvin

Resultó que esto era sólo el principio. A finales de los años setenta la nave sumergible Alvin, perteneciente al Woods Hole Océano Graphic Institute, fue utilizada para explorar el fondo del mar a lo largo de la Grieta de las Galápagos en el océano Pacífico. Este accidente geológico, a unos dos kilómetros y medio bajo la superficie, tiene interés para los geólogos como un ejemplo primordial de las chimeneas volcánicas submarinas conocidas como “húmeros negros “. Cerca de un humero negro, el agua del mar puede alcanzar temperaturas tan altas como trescientos cincuenta grados Celsius, muy por encima del punto de ebullición normal. Esto es posible debido a la inmensa presión que hay en dicha profundidad.

Para asombro de los científicos implicados en el proyecto Alvin la región en torno a los húmeros negros de las Galápagos y otros lugares de las profundidades marinas resultó estar rebosante de vida. Entre los moradores más exóticos de las profundidades había cangrejos y gusanos tubulares gigantes. También había bacterias termófilas ya familiares en la periferia de los húmeros negros. Lo más notable de todo, sin embargo, eran algunos microbios hasta entonces desconocidos que vivían muy cerca de las aguas abrasadoras a temperaturas de hasta ciento diez grados Celsius. Ningún científico había imaginado nunca seriamente que una forma de vida pudiera soportar calor tan extremo.

Igualmente se han encontrado formas de vida en lugares de gélidas temperaturas y en las profundidades de la tierra. Así mismo, la NASA ha estado en un pueblo de Huelva para estudiar aguas con un PH imposible para la vida y cargada de metales pesados que, sin embargo, estaba rebosante de vida. El proyecto de estos estudios se denomina P-TINTO, ya que, las aguas a las que nos referimos son precisamente las del Río Tinto, llenas de extremófilos.

El Universo, amigos míos, está lleno de vida

La anterior reseña viene a confirmarla enorme posibilidad de la existencia de vida en cualquier parte del universo que está regido por mecanismos iguales en cualquiera de sus regiones, por muchos años luz que nos separen de ellas. En comentarios anteriores dejamos claro que las Galaxias son lugares de autorregulación, y, podríamos considerarlos como organismos vivos que se regeneran así mismos de manera automática luchando contra la entropía del caos de donde vuelve a resurgir los materiales básicos para el nacimiento de nuevas estrellas y planetas donde surgirá alguna clase de vida.

¿Qué no habrá aquí? Todos los materiales primarios para la vida andan sueltos por ahí arriba, esperando que se forme un planeta para surgir a la luz de las estrellas que, con su calor, hará posible la evolución de seres que, incluso llegarán a ser inteligentes.

La idea de que la vida puede tener una historia se remonta a poco más de dos siglos. Anteriormente, se consideraba que las especies habían sido creadas de una vez para siempre. La vida no tenía más historia que el Universo. Sólo nosotros, los seres humanos, teníamos una historia. Todo lo demás, el Sol y las estrellas, continentes y océanos, plantas y animales, formaban la infraestructura inmutable creada para servir como fondo y soporte de la aventura humana. Los fósiles fueron los primeros en sugerir que esta idea podía estar equivocada.

Durante cerca de tres mil millones de años, la vida habría sido visible sólo a través de sus efectos en el ambiente y, a veces , por la presencia de colonias, tales como los extremófilos que asociaban billones de individuos microscópicos en formaciones que podrían haber pasado por rocas si no fuera por su superficie pegajosa y por sus colores cambiantes.

Los hongos, como nosotros, también son eucariotas. ¿Cuántos no habrán en los subterráneos de Marte?

Toda la panoplia de plantas, hongos y animales que en la actualidad cubre el globo terrestre con su esplendor no existía. Sólo había organismos unicelulares, que empezaron con casi toda seguridad con bacterias. Esa palabra, “bacteria”, para la mayoría de nosotros evoca espectros de peste, enfermedades, difteria y tuberculosis, además de todos los azotes del pasado hasta que llegó Pasteur. Sin embargo, las bacterias patógenas son sólo una pequeña minoría, el resto, colabora con nosotros en llevar la vida hacia delante, y, de hecho, sin ellas, no podríamos vivir. Ellas, reciclan el mundo de las plantas y animales muertos y aseguran que se renueve el carbono, el nitrógeno y otros elementos bioquímicos.

Por todas estas razones, podemos esperar que, en mundos que creemos muertos y carentes de vida, ellas (las bacterias) estén allí. Están relacionadas con las primeras formas de vida, las bacterias han estado ahí desde hace cerca de 4.000 millones de años, y, durante gran parte de ese tiempo, no fueron acompañadas por ninguna otra forma de vida.

Pero, ¿No estamos hablando del Universo? ¡Claro que sí! Hablamos del Universo y, ahora, de la forma más evolucionada que en él existe: Los seres pensantes y conscientes de SER, nosotros los humanos que, de momento, somos los únicos seres inteligentes conocidos del Inmenso Universo. Sin embargo, pensar que estamos solos, sería un terrible y lamentable error que, seguramente, nos traería consecuencias de difícil solución.

A veces, sería mejor estar así, para no ver ni oir, ni tampoco pensar, lo que pasa en el mundo.

Hay que pensar seriamente en la posibilidad de la vida extraterrestre que, incluso en nuestra propia Galaxia, podría ser muy abundante. Lo único que necesitamos es ¡Tiempo!

¿Por qué no? Podría ser así, mundos llenos de vida que tienen formadas sus propias sociedades

Tiempo para poder avanzar en el conocimiento que nos lleve, por ejemplo, a poder aprovechar la energía de los Agujeros Negros. Cuando eso llegue, estaremos preparados para dar el salto hacia las estrellas, y, allí, nos esperan sorpresas que ahora, ni podemos sospechar.

Pero, por otra parte, nuestra imaginación, es casi tan grande como el Universo mismo, y, ¡cuando de verdad, nos ponemos a pensar! Cualquier cosa será posible, dentro de los límites impuestos por el propio Universo.

En todo el Universo siempre es lo mismo, rigen las mismas leyes, las mismas fuerzas que ayer mismo quedaron explicadas aquí, e, igualmente, en todas partes está presente la misma Materia.

El Universo está hecho de Quarks… ¡Y Leptones! Es decir, que todo lo grande está hecho de cosaas pequeñas.

- Nucleones

- Núcleos

- Átomos

- Moléculas

- Sustancias

- Cuerpos

- Planetas (vida)

- Estrellas

- Mundos

- Mentes

- Galaxias

- Cúmulos de galaxias

- ¡El Universo!

emilio silvera

Oct

6

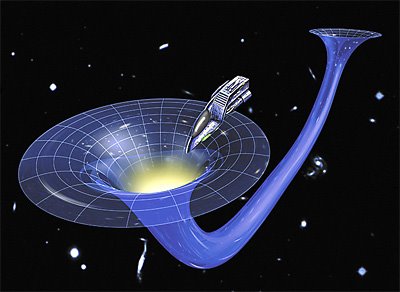

¡Una Singularidad! Extraño Objeto ¿O sólo un concepto?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Singularidad ~

Clasificado en Singularidad ~

Comments (0)

Comments (0)

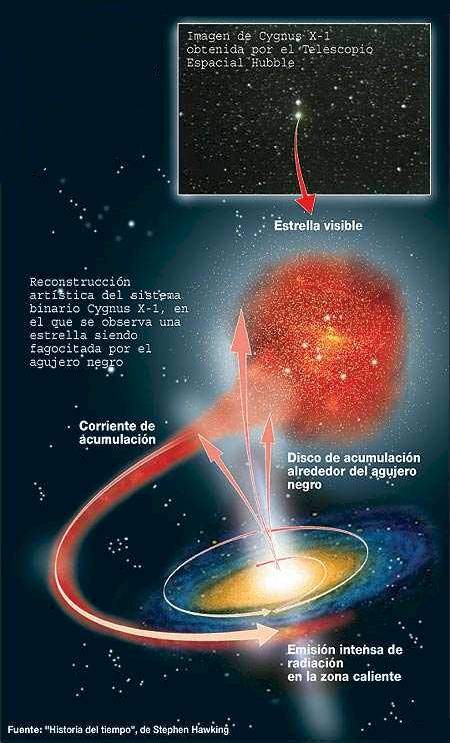

El concepto mismo de “singularidad” desagradaba a la mayoría de los físicos, pues la idea de una densidad infinita se alejaba de toda comprensión. La naturaleza humana está mejor condicionada a percibir situaciones que se caracterizan por su finitud, cosas que podemos medir y pesar, y que están alojadas dentro de unos límites concretos; serán más grande o más pequeñas pero, todo tiene un comienzo y un final pero… infinito, es difícil de digerir. Además, en la singularidad, según resulta de las ecuaciones, ni existe el tiempo ni existe el espacio. Parece que se tratara de otro universo dentro de nuestro universo toda la región afectada por la singularidad que, eso sí, afecta de manera real al entorno donde está situada y además, no es pacífica, ya que se nutre de cuerpos estelares circundantes que atrae y engulle.

La noción de singularidad empezó a adquirir un mayor crédito cuando Robert Oppenheimer, junto a Hartlan S. Snyder, en el año 1.939 escribieron un artículo anexo de otro anterior de Oppenheimer sobre las estrellas de neutrones. En este último artículo, describió de manera magistral la conclusión de que una estrella con masa suficiente podía colapsarse bajo la acción de su propia gravedad hasta alcanzar un punto adimensional; con la demostración de las ecuaciones descritas en dicho artículo, la demostración quedó servida de forma irrefutable que una estrella lo suficientemente grande, llegado su final al consumir todo su combustible de fusión nuclear, continuaría comprimiéndose bajo su propia gravedad, más allá de los estados de enana blanca o de estrella de neutrones, para convertirse en una singularidad.

Los cálculos realizados por Oppenheimer y Snyder para la cantidad de masa que debía tener una estrella para terminar sus días como una singularidad estaban en los límites másicos de M =~ masa solar, estimación que fue corregida posteriormente por otros físicos teóricos que llegaron a la conclusión de que sólo sería posible que una estrella se transformara en singularidad, la que al abandonar su fase de gigante roja retiene una masa residual como menos de 2 – 3 masas solares.

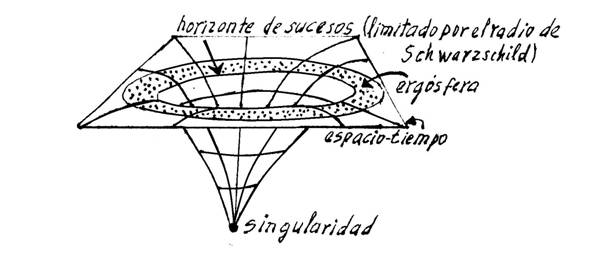

La figura de la izquierda representa a la nube de polvo en colapso de Oppenhieimer y Snyder, que ilustra una superficie atrapada.

El modelo de Oppenhieimer y Snyder posee una superficie atrapada, que corresponde a una superficie cuya área se iOppenheimer y Snyder desarrollaron el primer ejemplo explícito de una solución a las ecuaciones de Einstein que describía de manera cierta a un agujero negro, al desarrollar el planteamiento de una nube de polvo colapsante. En su interior, existe una singularidad, pero no es visible desde el exterior, puesto que está rodeada de un horizonte de suceso que no deja que nadie se asome, la vea, y vuelva para contarlo. Lo que traspasa los límites del horizonte de sucesos, ha tomado el camino sin retorno. Su destino irreversible, la singularidad de la que pasará a formar parte.

Desde entonces, muchos han sido los físicos que se han especializado profundizando en las matemáticas relativas a los agujeros negros. John Wheeler (que los bautizó como agujeros negros), Roger Penrose, Stephen Hawking, Kip S. Thorne, Kerr y muchos otros nombres que ahora no recuerdo, han contribuido de manera muy notable al conocimiento de los agujeros negros, las cuestiones que de ellas se derivan y otras consecuencias de densidad, energía, gravedad, ondas gravitacionales, etc, que son deducidas a partir de estos fenómenos del cosmos.

Se afirma que las singularidades se encuentran rodeadas por un horizonte de sucesos, pero para un observador, en esencia, no puede ver nunca la singularidad desde el exterior. Específicamente implica que hay alguna región incapaz de enviar señales al infinito exterior. La limitación de esta región es el horizonte de sucesos, tras ella se encuentra atrapado el pasado y el infinito nulo futuro. Lo anterior nos hace distinguir que en esta frontera se deberían reunir las características siguientes:

- Debe ser una superficie nula donde es pareja, generada por geodésicas nulas;

- contiene una geodésica nula de futuro sin fin, que se origina a partir de cada punto en el que no es pareja, y que

- el área de secciones transversales espaciales jamás pueden disminuir a lo largo del tiempo.

Pueden existir agujeros negros supermasivos (de 105 masas solares) en los centros de las galaxias activas. En el otro extremo, mini agujeros negros con un radio de 10-10 m y masas similares a las de un asteroide pudieron haberse formado en las condiciones extremas que se dieron poco después delBig Bang. Diminutos agujeros negros podrían ser capaces de capturar partículas a su alrededor, formando el equivalente gravitatorio de los átomos.

Todo esto ha sido demostrado matemáticamente por Israel, 1.967; Carter, 1.971; Robinson, 1.975; y Hawking, 1.978 con límite futuro asintótico de tal espaciotiempo como el espaciotiempo de Kerr, lo que resulta notable, pues la métrica de Kerr es una hermosa y exacta formulación para las ecuaciones de vacío de Einstein y, como un tema que se relaciona con la entropía en los agujeros negros.

No resulta arriesgado afirmar que existen variables en las formas de las singularidades que, según las formuladas por Oppenheimer y su colaborador Snyder, después las de Kerr y más tarde otros, todas podrían existir como un mismo objeto que se presenta en distintas formas o maneras.

Ahora bien, para que un ente, un objeto o un observador pueda introducirse dentro de una singularidad como un agujero negro, en cualquiera que fuese su forma, tendría que traspasar el radio de Schwarzschild (las fronteras matemáticas del horizonte de sucesos), cuya velocidad de escape es igual a la de la luz, aunque esta tampoco puede salir de allí una vez atrapada dentro de los límites fronterizos determinados por el radio. Este radio de Schwarzschild puede ser calculado usándose la ecuación para la velocidad de escape:

Para el caso de fotones u objeto sin masa, tales como neutrinos, se sustituye la velocidad de escape por la de la luz c2. “En el modelo de Schrödinger se abandona la concepción de los electrones como esferas diminutas con carga que giran en torno al núcleo, … Es cierto que en mecánica cuántica quedan muchos enigmas por resolver. Pero hablando de objetos de grandes masas, veámos lo que tenemos que hacer para escapar de ellos.

Podemos escapar de la fuerza de gravedad de un planeta pero, de un A.N., será imposible.

La velocidad de escape está referida a la velocidad mínima requerida para escapar de un campo gravitacional. El objeto que escapa puede ser cualquier cosa, desde una molécula de gas a una nave espacial. Como antes he reflejado está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo del que pretende escapar (del núcleo). Un objeto que se mueva a velocidad menor a la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita parabólica, y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica.

Así hemos comprendido que, a mayor masa del cuerpo del que se pretende escapar, mayor será la velocidad que necesitamos para escapar de él. Veamos algunas:

|

Objeto |

Velocidad de escape |

| La Tierra |

………….11,18 Km/s |

| El Sol |

………….617,3 Km/s |

| Júpiter |

………….59,6 Km/s |

| Saturno |

………….35,6 Km/s |

| Venus |

………….10,36 Km/s |

| Agujero negro |

…….+ de 299.000 Km/s |

Como se ve en el cuadro anterior, cada objeto celeste, en función de su masa, tiene su propia velocidad de escape para que cualquier cosa pueda salir de su órbita y escapar de él. El caso de la singularidad, es decir, la inmensa masa que está presente en las entrañas de un Agujero negro, genera una fuerza de gravedad tal que, nada está a salvo en sus inmediaciones, cualquier objeto, sea estrella, polvo estelar, planeta o lo que pudiera ser, será engullido por el “monstruo”, sin que nada pueda evitarlo.

La excepción está en el último ejemplo, la velocidad de escape necesaria para vencer la fuerza de atracción de un agujero negro que, siendo preciso superar la velocidad de la luz 299.792’458 Km/s, es algo que no está permitido, ya que todos sabemos que conforme determina la teoría de la relatividad especial de Einstein, la velocidad de la luz es la velocidad límite en nuestro universo; nada puede ir más rápido que la velocidad de la luz, entre otras razones porque el objeto sufriría la transformación de Lorentz y su masa sería infinita.

Podría continuar explicando otros aspectos que rodean a los agujeros negros, pero estimo que el objetivo que perseguía de hacer conocer lo que es un agujero negro y el origen del mismo, está sobradamente cumplido.

Existen aspectos del A.N. que influyen en el mundo cuántico, y, por ejemplo, el máximo radio que puede tener un agujero negro virtual está dado aproximadamente por

![]()

que equivale a unos 10-³³ centímetros. Esta distancia se conoce como longitud de Planck y es la única unidad de distancia que se puede construir con las tres constantes fundamentales de la naturaleza: G, h y c. La longitud de Planck es tan extremadamente pequeña (10²° veces menor que el radio de un electrón) que debe ser la distancia característica de otro nivel de la naturaleza, subyacente al mundo subatómico, donde rigen las leyes aún desconocidas de la gravedad cuántica.

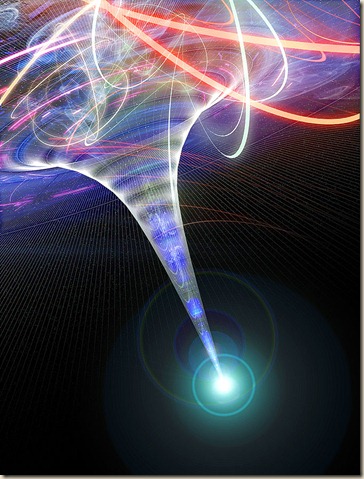

Así como el océano presenta un aspecto liso e inmóvil cuando se observa desde una gran distancia, pero posee fuertes turbulencias y tormentas a escala humana, el espacio-tiempo parece “liso” y estático a gran escala, pero es extremadamente turbulento en el nivel de la longitud de Planck, donde los hoyos negros se forman y evaporan continuamente. En el mundo de Planck, las leyes de la física deben ser muy distintas de las que conocemos hasta ahora.

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

¡Existen tántos secretos! ¡Es tan grande nuestra ignorancia!

emilio silvera

Oct

5

Los secretos de la Naturaleza ¿Los podremos desvelar?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

El psicólogo Eric Ericsson llegó a proponer una teoría de estadios psicológicos del desarrollo. Un conflicto fundamental caracteriza cada fase. Si este conflicto no queda resuelto, puede enconarse e incluso provocar una regresión a un periodo anterior. Análogamente, el psiicólogo Jean Piaget demostró que el desarrollo mental de la primera infancia tampoco es un desarrollo continuo de aprendizaje, sino que está realmente caracterizado por estadios discontinuos en la capacidad de conceptualización de un niño. En un mes, un niño puede dejar de buscar una pelota una vez que ha rodado fuera de su campo de visión, sin comprender que la pelota existe aunque no la vea. Al mes siguiente, esto resultará obvio para el niño.

Los procesos siguen, las cosas cambian, el Tiempo inexorable transcurre, si hay vida vendrá la muerte, lo que es hoy mañana no será.

Esta es la esencia de la dialéctica. Según esta filosofía, todos los objetos (personas, gases, estrellas, el propio universo) pasan por una serie de estadios. Cada estadio está caracterizado por un conflicto entre dos fuerzas opuestas. La naturaleza de dicho conflicto determina, de hecho, la naturaleza del estadio. Cuando el conflicto se resuelve, el objeto pasa a un objetivo o estadio superior, llamado síntesis, donde empieza una nueva contradicción, y el proceso pasa de nuevo a un nivel superior.

Los filósofos llaman a esto transición de la “cantidad” a la “cualidad”. Pequeños cambios cuantitativos se acumulan hasta que, eventualmente, se produce una ruptura cualitativa con el pasado. Esta teoría se aplica también a las sociedades o culturas. Las tensiones en una sociedad pueden crecer espectacularmente, como la hicieron en Francia a finales del siglo XVIII. Los campesinos se enfrenaban al hambre, se produjeron motines espontáneos y la aristocracia se retiró a sus fortalezas. Cuando las tensiones alcanzaron su punto de ruptura, ocurrió una transición de fase de lo cuantitativo a lo cualitativo: los campesinos tomaron las armas, tomaron París y asaltaron la Bastilla.

Las transiciones de fases pueden ser también asuntos bastante explosivos. Por ejemplo, pensemos en un río que ha sido represado. Tras la presa se rápidamente un embalse con agua a enorme presión. Puesto que es inestable, el embalse está en el falso vacío. El agua preferiría estar en su verdadero vacío, significando esto que preferiría reventar la presa y correr aguas abajo, hacia un estado de menor energía. Así pues, una transición de fase implicaría un estallido de la presa, que tendría consecuencias desastrosas.

También podría poner aquí el ejemplo más explosivo de una bomba atómica, donde el falso vacío corresponde al núcleo inestable de uranio donde residen atrapadas enormes energías explosivas que son un millón de veces más poderosas, para masas iguales, que para un explosivo químico. De vez en cuando, el núcleo pasa por efecto túnel a un estado más bajo, lo que significa que el núcleo se rompe espontáneamente. Esto se denomina desintegración radiactiva. Sin embargo, disparando neutrones contra los núcleos de uranio, es posible liberar de golpe esta energía encerrada según la formula de Einstein E = mc2. Por supuesto, dicha liberación es una explosión atómica; ¡menuda transición de fase! De nefasto recuerdo por cierto.

Las transiciones de fase no son nada nuevo. Trasladémoslo a nuestras propias vidas. En un libro llamado Pasajes, el autor, Gail Sheehy, destaca que la vida no es un flujo continuo de experiencias, como parece, sino que realmente pasa por varios estadios, caracterizados por conflictos específicos que debemos resolver y por objetivos que debemos cumplir.

Los contornos recubiertos muestran la estructura de la galaxia al ser reconstruida desde las observaciones hechas bajo el fenómeno de lente gravitatorio con el radiotelescopio Submillimeter Array. La formación de nuevas estrellas en el Universo es imparable y, la materia más sencilla se constituye en una estructura que la transformará en más compleja, más activa, más dispuesta para que, la vida, también pueda surgir en mundos ignotos situados muy lejos del nuestro.

Sí, todo cambia y nada permanece: transiciones de fases hacia la complejidad

Las nuevas características descubiertas por los científicos en las transiciones de fases es que normalmente van acompañadas de una ruptura de simetría. Al premio Nobel Abdus Salam le gusta la ilustración siguiente: consideremos una mesa de banquete circular, donde todos los comensales están sentados con una copa de champán a cada lado. Aquí existe simetría. Mirando la mesa del banquete reflejada en un espejo, vemos lo mismo: cada comensal sentado en torno a la mesa, con copas de champán a cada lado. Asimismo, podemos girar la mesa de banquete circular y la disposición sigue siendo la misma.

Rompamos ahora la simetría. Supongamos ahora que el primer comensal toma la copa que hay a su derecha. Siguiendo la pauta, todos los demás comensales tomaran la copa de champán de su derecha. Nótese que la imagen de la mesa del banquete vista en el espejo produce la situación opuesta. Cada comensal ha tomado la copa izquierda. De este modo, la simetría izquierda-derecha se ha roto.

El niño del espejo le da a su amiguito reflejado la mano derecha y aquel, le saluda, con la izquierda. ¡La simetría especular…! Así pues, el estado de máxima simetría es con frecuencia también un estado inestable, y por lo tanto corresponde a un falso vacío.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones. Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron las primeras quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

En las estrellas se tiene que producir el proceso triple alfa para que exista el Carbono

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar hidrógeno en helio, de los elementos más ligeros a los más pesados. Avanza creando en el hornotermonuclear, cada vez, metales y elementos más pesados. Cuando llega al hierro y explosiona en la forma explosiva de una supernova. Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienza de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kriptón, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante la conocida fórmula E = mc2. Esta es la fuente de energía que también subyace en la bomba atómica. Es decir, convertir materia en energía.

Así pues, la curva de energía de enlace no sólo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente (lo sé por experiencia), no dice nada, pero su rostro refleja escepticismo. ¿Cómo puedo vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución y poder contarlo.

Hay cosas que, cambiando… ¡Nunca cambian! La entropía se encarga de ello

Pero volviendo a las cosas de la Naturaleza y de la larga vida de las estrellas, sí, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol. Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar, la estrella más cercana a la Tierra (150 millones de Km = 1 UA), con un diámetro de 1.392.530 Km, tiene una edad de 4.500 millones de años, y, como todo en el Universo, su discurrir la va desgantando, evoluciona hacia su imparable destino como gigante roja primero y enana blanca después.

Una gigante roja engulle a un planeta cercano

Cuando ese momento llegue, ¿dónde estaremos? Pues nosotros, si es que estamos, contemplaremos el acontecimiento desde otros mundos. La Humanidad habrá dado el gran salto hacia las estrellas y, colonizando otros planetas se habrá extendido por regiones lejanas de la Galaxia.

El Universo siempre nos pareció inmenso, y, al principio, aquellos que empezaron a preguntarse cómo sería, lo imaginaron como una esfera cristalina que dentro contenía unos pocos mundos y algunas estrellas, hoy, hemos llegado a saber un poco más sobre él. Sin embargo, dentro de unos cuantos siglos, los que detrás de nosotros llegaran, hablarán de universos en plural, y, cuando pasen algunos eones, estaremos de visita de un universo a otro como vamos de una ciudad a otra.

¡Quién pudiera estar allí!

¡Es todo tan extraño! ¡Es todo tan complejo! y, sobre todo…¡sabemos tan poco!

Todo lo grande está hecho de cosas pequeñas

Según lo que podemos entender y hasta donde han podido llegar nuestros conocimientos actuales, ahora sabemos donde están las fronteras: donde las masas o las energías superan 1019 veces la masa del protón, y esto implica que estamos mirando a estructuras con un tamaño de 10-33 centímetros.

Esta ecuación nos habla de lo que se conoce como masa de Planck y a la distancia correspondiente la llamamos distancia de Planck. La masa de Planck expresada en gramos es de 22 microgramos, que es la masa de un grano muy pequeño de azúcar (que, por otra parte, es el único número de Planck que parece más o menos razonable, ¡los otros números son totalmente extravagantes!).

Esto significa que tratamos de localizar una partícula con la precisión de una Longitud de Planck, las fluctuaciones cuánticas darán tanta energía que su masa será tan grande como la masa de Planck, y los efectos de la fuerza gravitatoria entre partículas, así, sobrepasarán los de cualquier otra fuerza. Es decir, para estas partículas la gravedad es una interacción fuerte.

Lo cierto es que, esas unidades tan pequeñas, tan lejanas en las distancias más allá de los átomos, son las que marcan nuestros límites, los límites de nuestras teorías actuales que, mientras que no puedan llegar a esas distancias… No podrán avanzar en el conocimiento de la Naturaleza y, tampoco, como es natural, en la teoría de supercuerdas o en poder saber, lo que pasó en el primer momento del supuesto big bang, hasta esos lugares, nunca hemos podido llegar.

emilio silvera

Oct

5

Materia de sombra, Axiones, ¿WIMPs en el Sol? ¿Y la vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Es curioso como a veces, la realidad de los hechos observados, vienen a derribar esas barreras que muchos ponen en sus mentes negar lo evidente. Por ejemplo: Los extraordinarios resultados de la sonda Kepler, que en su primer año de misión ha encontrado ya 1.235 candidatos a planetas, 54 de ellos en la zona habitable de sus estrellas, ha permitido a los investigadores extrapolar el número total de mundos que podría haber sólo en la Vía Láctea, nuestra galaxia. Y ese número ronda los 50.000 millones. De los cuales, además, unos 500 millones estarían a la distancia adecuada de sus soles para permitir la existencia de agua en estado líquido, una condición necesaria para la vida.

Planetas parecidos a la Tierra, como arriba nos dicen, hay miles de millones y sólo cabe esperar que estén situados en los lugares adecuados que la vida tenga la oportunidad de surgir acogida por el ecosistema ideal del agua líquida, una atmósfera acogedora y húmeda, temperatura ideal media y otros parámetros que la vida reqiere para su existencia.

Un equipo de astrónomos internacionales pertenecientes al Observatorio Europeo Austral (ESO), el más importante del mundo, investiga la formación de un posible sistema planetario a partir de discos de material que rodea a una estrella joven. Según un comunicado difundido hoy por el centro astronómico que se levanta en la región norteña de Antofagasta, a través del “Very Large Telescope”(VLT), los científicos han estudiado la materia que rodea a una estrella joven.

Según los astrónomos, los planetas se forman a partir de discos de material que rodean a las estrellas, pero la transición discos de polvo hasta sistemas planetarios es rápida y muy pocos son identificados en esta fase. Uno de los objetos estudiados por los astrónomos de ESO, es la estrella T Chamaleontis (T-Cha), ubicada en la pequeña constelación de Chamaleón, la cual es comparable al sol pero en sus etapas iniciales.

Dicha estrella se encuentra a 330 años luz de la Tierra y tiene 7 millones de años de edad, lo que se considera joven para una estrella. “Estudios anteriores han demostrado que T Cha es un excelente objetivo para estudiar cómo se forman los sistemas planetarios”, señala el astrónomo Johan Olofsson, del Max Planck Institute of Astronomy de Alemania.

Algunas veces hablando de los extensos y complejos temas que subyacen en la Astronomía, lo mismo hablamos de “materia de sombre” que de “supercuerdas” y, se ha llegado a decir que existe otro universo de materia de sonbra que existe en paralelo al nuestro. Los dos universos se separaron la Gravedad se congeló sepapándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo cual las convierte en candidatas ideales para la tan traida y llevada “materia oscura”.

Llegamos a los Axiones.

El actual de la cuestión es que los cosmólogos creen saber que hay una gran cantidad de materia oscura en el Universo y, han conseguido eliminar la candidatura de cualquier tipo de partícula ordinaria que conocemos. En tales circunstancias no se llegar a otra conclusión que la materia oscura debe de existir en alguna forma que todavía no hemos visto y cuyas propiedades ignoramos totalmente. Sin embargo, se atreven a decir que, la Gravedad, es el efecto que se produce cuando la “materia oscura” pierde consistencia… , o algo así. ¡Cómo son!

A los teóricos nada les gusta más que aquella situación en la cual puedan dejar volar libremente la imaginación sin miedo a que nada tan brusco un experimento u observación acabe con su juego. En cualquier caso, han producido sugerencias extraordinarias acerca de lo que podría ser la “materia oscura” del universo.

Lo que hay en el Universo…no siempre lo podemos comprender.

Otro de los WIMPs favoritos se llama axión. el fotino y sus compañeros, el axión fue sugerido por consideraciones de simetría. Sin embargo, a diferencia de las partículas, sale de las Grandes Teorías Unificadas, que describen el Universo en el segundo 10ˉ³5, más que de las teorías totalmente unificadas que operan en el tiempo de Planck.

mucho tiempo han sabido los físicos que toda reacción entre partículas elementales obedece a una simetría que llamamos CPT. Esto significa que si miramos la partícula de una reacción, y luego vemos la misma reacción cuando (1) la miramos en un espejo, (2) sustituimos todas las partículas por antipartículas y (3) hacemos pasar la película hacia atrás, los resultados serán idénticos. En este esquema la P significa paridad (el espejo), la C significa conjugación de carga (poner las antipartículas) y T la reversa del tiempo (pasar la película al revés).

Se pensaba que el mundo era simétrico respecto a CPT porque, al menos al nivel de las partículas elementales, era simétrico respecto a C, P y T independientemente. Ha resultado que no es éste el caso. El mundo visto en un espejo se desvía un tanto al mundo visto directamente, y lo mismo sucede al mundo visto cuando la película pasa al revés. Lo que sucede es que las desviaciones entre el mundo real y el inverso en cada uno de estos casos se cancelan una a la otra cuando miramos las tres combinadas.

Aunque esto es verdad, es verdad que el mundo es casi simétrico respecto a CP actuando solos y a T actuando solo; es decir, que el mundo es casi el mismo si lo miran en un espejo y sustituyen las partículas por antipartículas que si lo miran directamente. Este “casi” es lo que preocupa a los físicos. ¿Por qué son las cosas casi perfectas, pero les falta algo?

La respuesta a esta cuestión parece que estar en la posible existencia de esa otra partícula apellidada axión. Se supone que el Axión es muy ligero (menos de una millonésima parte de la masa del electrón) e interacciona sólo débilmente con otra materia. Es la pequeña masa y la interacción débil lo que explica el “casi” que preocupa a los teóricos.

nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina ( ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

¿Podeis imaginar la existencia de un Universo en permanente sombra?

La idea de un universo en sombra nos proporciona una manera sencilla de pensar en la materia oscura. El universo dividido en materia y materia se sombra en el Tiempo de Planck, y una evolucionó de acuerdo con sus propias leyes. Es de suponer que algún Hubble de sombra descubrió que ese universo de sombra se estaba expandiendo y es de suponer que algunos astrónomos de sombras piensan en nosotros candidatos para su materia oscura.

¡ que incluso haya unos ustedes de sombras leyendo la versión de sombra de este trabajo!

Partículas y partículas supersimétricas

Partículas son las que todos conocemos y que forman la materia, la supersimétricas, fotinos, squarks y otros, las estamos buscando sin poder hallarlas.

Estas partículas son predichas por las teorías que unifican todas las fuerzas de la naturaleza. Forman un conjunto de contrapartidas de las partículas a las que estamos habituados, son mucho más pesadas. Se nombran en analogía con sus compañeras: el squark es el compañero supersimétrico del quark, el fotino del fotón, etc. Las más ligeras de estas partículas podrían ser la materia oscura. Si es así, partícula probablemente pesaría al menos cuarenta veces más que el protón.

Lo cierto es que las partículas que conocemos son las que están presentes en el Modelo Estándard de la Física que incluye a tres de las cuatro fuerzas conocidas, la Gravedad se niega a compartir teoría y, según parece, sólo en una teoría más avanzada como la de cuerdas, se deja, incluir sin protestar dentro de ella, es decir, que si finalmente se verifica tal teoría, en ella subyace una teoría cuántica de la gravedad.

Y la materia de sombra, si existe, no hemos sabido dar con ella y, sin embargo, existen indicios de que está ahí. Así, los del LHC no de dejan de intentar su localización en en ese infinitesimal “mundo” de lo muy pequeño.

En algunas versiones de las llamadas teorías de supercuerdas hay todo un universo de materia de sombra que existe paralelo con el nuestro. Los dos universos se separaron la gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo que las convierte en candidatas ideales para la materia oscura.

Axiones

El Axión es una partícula muy ligera (pero presumiblemente muy común) que, si existiera, resolvería un problema antiguo en la teoría de las partículas elementales. Se estima que una masa menor que una millonésima parte de la del electrón y se supone que impregna el universo de una manera semejante al fondo de microondas. La materia oscura consistiría en agregaciones de axiones por encima del nivel general de fondo.

Construímos inmensos aparatos de ingeniosas propiedades tecnológicas tratar de que nos busquen las WIMPs, esas hipotéticas partículas que podrían, llevarnos a un conocimiento mayor de la materia.

¿WIMPs en el Sol?

A lo largo de todo el se ha dado a entender que todas estas partículas candidatas a materia oscura de la que hemos estado hablando, son puramente hipotéticas. No hay pruebas de que ninguna de ellas se vaya a encontrar de hecho en la naturaleza. Sin embargo sería negligente si no mencionase un argumento –un diminuto rayo de esperanza- que tiende a apoyar la existencia de WIMPs de un u otro. Este argumento tiene que ver con algunos problemas que han surgido en nuestra comprensión del funcionamiento y la estructura del Sol.

Creemos que la energía del Sol viene de reacciones nucleares profundas dentro del núcleo. Si éste es el caso en realidad, la teoría nos dice que esas reacciones deberían estar produciendo neutrinos que en principio son detectables sobre la Tierra. Si conocemos la temperatura y composición del núcleo ( creemos), entonces podemos predecir exactamente cuántos neutrinos detectaremos. Durante más de veinte años se llevó a cabo un experimento en una mina de oro de Dakota del Sur para detectar esos neutrinos y, desgraciadamente, los resultados fueron desconcertantes. El número detectado fue de sólo un tercio de lo que se esperaba. Esto se conoce como el problema del neutrino solar.

El problema de los neutrinos solares se debió a una gran discrepancia el número de neutrinos que llegaban a la Tierra y los modelos teóricos del interior del Sol. Este problema que duró mediados de la década de 1960 hasta el 2002, ha sido recientemente resuelto mediante un entendimiento de la física de neutrinos, necesitando una modificación en el modelo estándar de la física de partículas, concretamente en las neutrinos” href=”http://es.wikipedia.org/wiki/Oscilaci%C3%B3n_de_neutrinos”>oscilaciones de neutrinos. Básicamente, debido a que los neutrinos tienen masa, pueden cambiar del tipo de neutrino que se produce en el interior del Sol, el neutrino electrónico, en dos tipos de neutrinos, el muónico y el tauónico, que no fueron detectados.

La segunda característica del Sol que concierne a la existencia de WIMPs se refiere al hecho de las oscilaciones solares. los astrónomos contemplan cuidadosamente la superficie solar, la ven vibrar y sacudirse; todo el Sol puede pulsar en períodos de varias horas. Estas oscilaciones son análogas a las ondas de los terremotos, y los astrónomos llaman a sus estudios “sismología solar”. Como creemos conocer la composición del Sol, tenemos que ser capaces de predecir las propiedades de estas ondas de terremotos solares. Sin embargo hay algunas duraderas discrepancias entre la teoría y la observación en este campo.

No mucho que los astrónomos han señalado que si la Galaxia está en realidad llena de materia oscura en la de WIMPs, entonces, durante su vida, el Sol habría absorbido un gran número de ellos. Los WIMPs, por tanto, formarían parte de la composición del Sol, una parte que no se había tenido en cuenta hasta ahora. Cuando los WIMPs son incluidos en los cálculos, resultan dos consecuencias: primero, la temperatura en el núcleo del Sol resulta ser menor de lo que se creía, de forma que son emitidos menos neutrinos, y segundo, las propiedades del cuerpo del Sol cambian de tal modo que las predicciones de las oscilaciones solares son exactas.

Hasta nos atrevemos a exponer una imagen que nos muestra la distribución de los WIMPs

Este resultado es insignificante en lo que se refiere a la existencia de WIMPs, pero no debemos despreciar las coincidencias halladas, lo más prudente será esperar a nuevos y más avanzados experimentos (SOHO y otros). Tanto el problema del neutrino como las oscilaciones se pueden explicar igualmente por otros efectos que no tienen nada que ver con los WIMPs. Por ejemplo, el tipo de oscilaciones de neutrinos podría resolverse si el neutrino solar tuviera alguna masa, aunque fuese muy pequeña, y diversos cambios en los detalles de la estructura interna del Sol podrían explicar las oscilaciones. No obstante estos fenómenos solares constituyen la única indicación que tenemos de que uno de los candidatos a la materia oscura pueda existir realmente.

Toda charla sobre supersimetría y teoría últimas da a la discusión de la naturaleza de la materia oscura un tono solemne que no tiene ningún parecido con la forma en que se lleva en realidad el debate entre los cosmólogos. Una de las cosas que más me gusta de este campo es que todo el mundo parece ser capaz de conservar el sentido del humor y una distancia respecto a su propio trabajo, ya que, los buenos científicos saben que, todos los cálculos, conjeturas, hipótesis y finalmente teorías, no serán visadas en la aduana de la Ciencia, hasta que sean muy, pero que muy bien comprobadas mediante el experimento y la observación y, no una sino diez mil veces de que puedan ser aceptadas en el ámbito puramente científico.

El el Sol podemos hallar algunas respuestas

Posiblemente, el LHC nos pueda decir algo al respecto si, como no pocos esperan, de sus colisiones surgen algunas partículas supersimétricas que nos hablen de ese otro mundo oscuro que, estando en este, no hemos sabido encontrar este momento. Otra posibilidad sería que la tan manoseada materia oscura no existiera y, en su lugar, se descubriera otro fenómeno o mecanismo natural desconocido hasta ahora que, incidiendo en el comportamiento de expansión del Universo, nos hiciera pensar en la existencia de la “materia oscura” cubrir el hueco de nuestra ignorancia.

Hace algún tiempo, en esas reuniones periódicas que se llevan a cabo entre científicos de materias relacionadas: física, astronomía, astrofísica, comología…, alguien del grupo sacó a relucir la idea de la extinción de los dinosaurios y, el hombre se refirió a la teoría (de los muchas que circulan) de que el Sol, en su rotación alrededor de la Vía Láctea, se salía periódicamente fuera del plano de la Galaxia. Cuando hacía esto, el polvo existente en ese plano podía cesar de proteger la Tierra, que entonces quedaría bañada en rayos cósmicos letales que los autores de la teoría pensaban que podían permeabilizar el cosmos. Alguien, el fondo de la sala lanzó: ¿Quiere decir que los dinosaurios fueron exterminados por la radiación de fotinos?

La cosa se tomó a broma y risas marcaron el final de la reunión en la que no siempre se tratan los temas con esa seriedad que todos creen, toda vez que, los conocimientos que tenemos de las cosas son muy limitados y tomarse en serio lo que podría no ser… ¡No sería nada bueno!

Por ejemplo, si vemos la imagen de arriba y un letrero que diga: “Dopar un aislante topológico con impurezas magnéticas rompe la simetría de inversión temporal y abre una nueva vía a la espintrónica.” Para la mayoría de los presentes, el galimatias no le dirá nada y, sin embargo, para otros al tanto de las cuestiones de física, le parecerá que: “Los aislantes topológicos son materiales que conducen electrones en su superficie exterior, pero actúan como aislantes en su volumen interior. propiedad tiene su origen en la forma en que los electrones se mueven a través del material. Los electrones poseen un espín mecánico-cuántico que apunta hacia “arriba” o hacia “abajo”. El espín es normalmente independiente del movimiento de los electrones, pero dentro de los aislantes topológicos, el espín de los electrones está estrechamente relacionado con su movimiento.”

¡Qué cosas! Lo que digo siempre… ¡Nunca llegaremos a saberlo todo!

emilio silvera

Totales: 75.596.515

Totales: 75.596.515 Conectados: 59

Conectados: 59