Dic

10

Hacia el futuro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Investigación y Ciencia ~

Clasificado en Investigación y Ciencia ~

Comments (0)

Comments (0)

La primera vez que un grupo de físicos empezó a hablar de la posibilidad de hacer cálculos de naturaleza cuántica fue en los años 80, pero no fue hasta los 90 cuando se empezó a poner en práctica; hoy la computación cuántica está cada vez más cerca pero aún es difícil poner fecha a su comercialización.

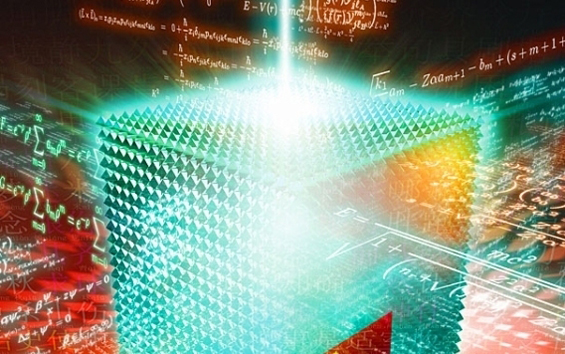

Representación artística de la investigación de la UCM (el triángulo tiene 7 qubits y el paisaje es una red hexagonal que representa la forma en que tiene que crecer el sistema de qubits para que el ordenador cuántico sea de gran escala y robusto, es decir, libre de errores). IQOQ/ Harald Ritsch.

La misión de un ordenador cuántico, como la de uno convencional y un supercomputador, es la de hacer operaciones, cálculos que los primeros ejecutan de manera distinta: trabajan a nivel atómico y por lo tanto siguiendo las normas de la física cuántica (rama de la física encargada de estudiar objetos microscópicos, como átomos).

La física cuántica tiene propiedades extraordinarias, no observables a niveles macroscópicos, y éstas son usadas por los ordenadores cuánticos -de los que ahora solo existen prototipos- para lograr procesar datos complejos de manera más rápida y segura.

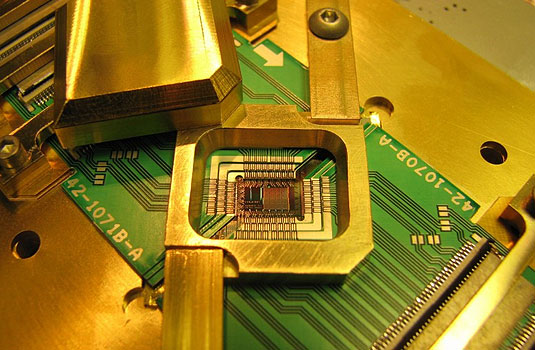

Los ordenadores cuánticos funcionan con átomos individuales, que se denominan “qubits” y no bits (como en los tradicionales).

Un bit (acrónimo en inglés de binary digit -dígito binario-) es la unidad mínima de información empleada en informática o en un dispositivo digital y se representa con dos valores, 0 y 1: todo lo que hay “debajo” de un ordenador clásico se escribe en términos de 0 o 1, detalla a Efe Miguel Ángel Martín-Delgado, catedrático de Física Teórica de la Universidad Complutense de Madrid (UCM).

Sin embargo, en la computación cuántica esto cambia, ya que un qubit, a diferencia de un bit, puede contener ambos valores al mismo tiempo, lo que posibilita una velocidad de procesamiento mayor.

Otra de las características de la computación cuántica es que puede trabajar en paralelo: un PC normal lo hace secuencialmente, primero resuelve un problema, luego otro y así sucesivamente.

Sin embargo, agrega Martín-Delgado, los ordenadores cuánticos pueden resolver un número exponencial de tareas a la vez.

Por ejemplo, para “romper” una clave encriptada un ordenador clásico tendría que escudriñar, una a una, las distintas combinaciones de números hasta dar con la contraseña, pero uno cuántico no: éste podría trabajar con miles a la vez en un segundo.

¿Y qué es lo que posibilita esta capacidad de cálculo? El algoritmo Shor.

Este algoritmo, diseñado por el matemático estadounidense Peter Shor, permite, por ejemplo, a una tercera persona que intercepta un mensaje cifrado descifrarlo en un tiempo exponencialmente más rápido que si lo hiciera con un ordenador clásico, señala Martín-Delgado.

Peter Shor publicó el trabajo con la descripción de este algoritmo en 1994, lo que supuso “el disparo de salida para que todo el mundo se empezara a interesar por la computación cuántica”.

Un año después, se hizo la primera propuesta de cómo hacer un ordenador cuántico por el español Juan Ignacio Cirac y el austríaco Peter Zoller (se conoce como la propuesta Cirac-Zoller).

Pero el ordenador cuántico no solo servirá para “desenmascarar” mensajes encriptados, sino para hacer simulaciones, secuenciar genomas más rápidamente, hacer cálculos de química cuántica, lo que podría servir para diseñar nuevos fármacos o mejorar las búsquedas.

De ahí que empresas como Google o instituciones como la NASA hayan apostado por ello.

“El ordenador cuántico va a ser predominante en el futuro de la informática: va a ser el rey”, recalca Martín-Delgado, quien apunta que el horizonte del 2020 será crucial para empezar a hacerlos realidad (dependerá de los experimentos en desarrollo).

Corrección de errores

Sin embargo, para llegar a este punto primero hay que resolver una serie de cuestiones, entre ellas los errores (los ordenadores clásicos se construyen con mecanismos para corregir errores).

Precisamente esto es lo que acaba de lograr el equipo de Martín-Delgado y de Rainer Blatt (Innsbruck).

“Hemos conseguido hacer una corrección completa de errores cuánticos en un módulo pequeño donde se hacían operaciones cuánticas”, aclara este investigador, quien acaba de publicar en Science y presentar en varios congresos de EEUU estos resultados.

Los ordenadores clásicos tienen solo un tipo de error -un error es cuando quiere escribir un 0 y pone un 1 o al contrario-, sin embargo uno cuántico, al ser más complejo, tiene tres tipos de errores: “Hemos desarrollado un método para corregir todos los errores que pueden aparecer en un computador cuántico”, concluye Markus Müller, miembro del equipo de la Complutense.

EFE-futuro

Totales: 74.915.250

Totales: 74.915.250 Conectados: 47

Conectados: 47