Ene

4

Ideas que persisten

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

Charles Lyell (1797-1875)

“El libro de Lyell convirtió el viaje de Darwin en un viaje a través del tiempo. Darwin empezó a leerlo casi inmediatamente, en su litera, mientras sufría el primero de los muchos mareos que le atormentarían durante los cinco años siguientes. El Beagle, un bergantín sólido y macizo, de 28 metros de largo por 7,5 de ancho, era en general confortable, pero su casco era redondeado y se balanceaba mucho. Darwin empezó a aplicar lo que él llamaba “la maravillosa superioridad de la manera de Lyell de abordar la geología” tan pronto como la expedición tocó tierra en las islas de Cabo Verde.”

Cuando el epicentro de un terremoto se produce en la costa, las consecuencias también pueden ser devastadoras al crearse un Tsunami que arrasará la ciudad mñás cercana sin importar lo grande que esta pueda ser, y, las victimas mortales y destrozos causados están más que asegurados.,

Sin embargo, en conjunto, los terremotos representan una fracción muy pequeña de la energía liberada por los procesos tectónicos de la Tierra. Desde 1.900, en los mayores terremotos se han liberado anualmente una energía media cercana a los 450 PJ, que no supone más del 0’03 por ciento del flujo total de calor terrestre. La liberación anual de energía sísmica de todos los terremotos que se han medido alcanza unos 300 GW, que sumada a la energía de esfuerzo invertida en deformaciones irreversibles y al calor generado por fricción a lo largo de las fallas, daría un total próximo a 1 TW, lo cual representa solamente un 2’5 por ciento del flujo de calor global

La idea de que Agujeros negros gigantes podían activar los cuásares y las radiogalaxias fue concebida por Edwin Salpeter y Yakov Borisovich Zel´dovich en 1964. Esta idea era una aplicación obvia del descubrimiento de dichos “personajes” de que las corrientes de gas, cayendo hacia un agujero negro, colisionarían y radiarían.

Una descripción más completa y realista de la caída de corriente de gas hacia un agujero negro fue imaginada en 1969 por Donald Lynden-Bell, un astrofísico británico en Cambridge. Él argumentó convincentemente, que tras la colisión de las corrientes de gas, estas se fundirían, y entonces las fuerzas centrífugas las harían moverse en espiral dando muchas vueltas en torno al agujero antes de caer dentro; y a medida que se movieran en espiral, formarían un objeto en forma de disco, muy parecidos a los anillos que rodean el planeta Saturno: Un disco de Acreción lo llamó Lynden-Bell puesto que el agujero está acreciendo (todos hemos visto la recreación de figuras de agujeros negros con su disco de acreción).

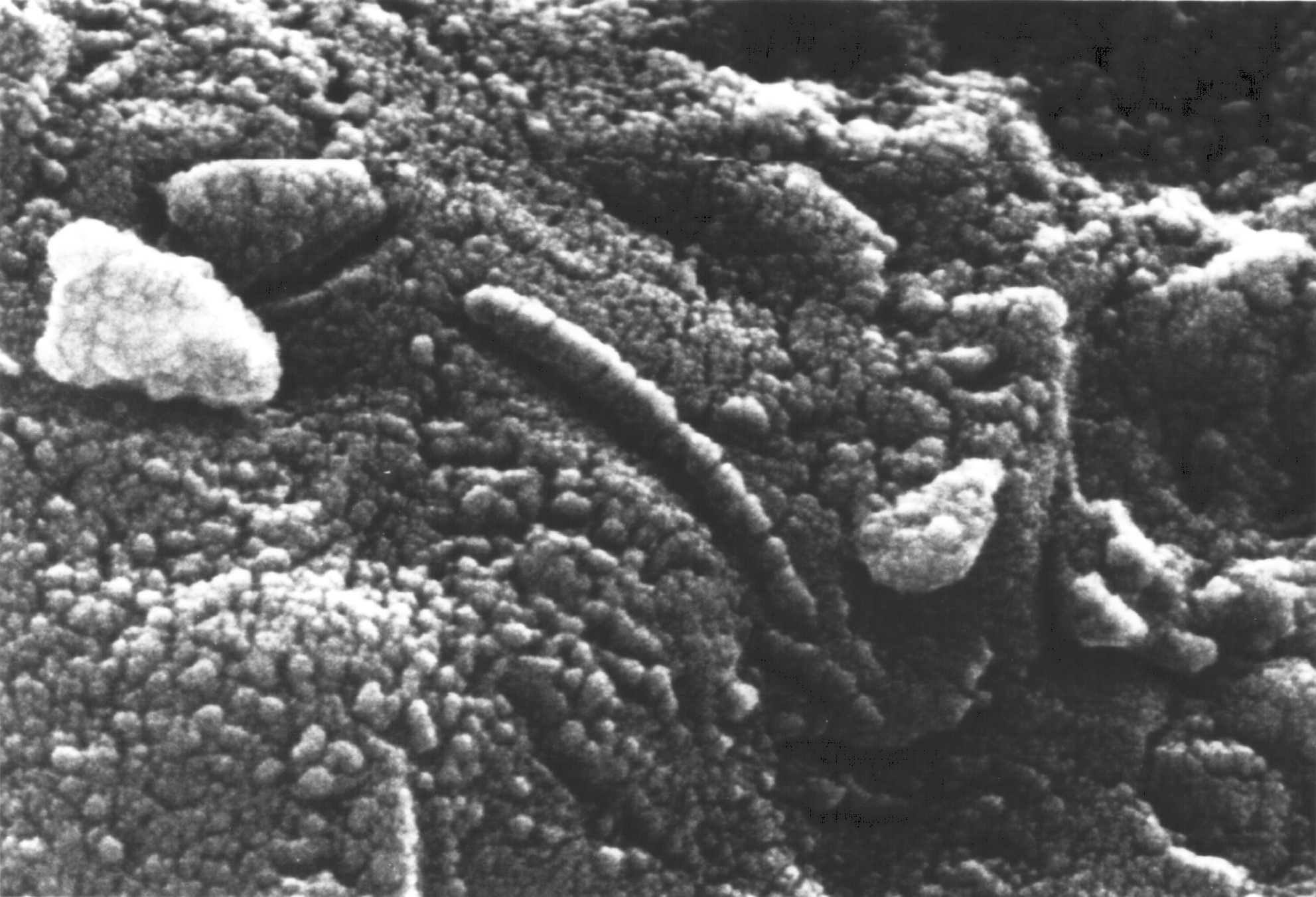

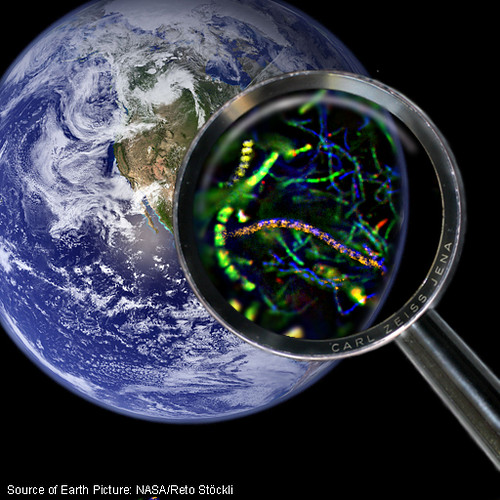

Un día de hace ya cerca de veinte años, allá por el año 1996, el pueblo americano escuchaba con asombro a su presidente, Clinton por aquel entonces, que en Marte podía existir vida. La noticia de que un antiguo meteorito caido en la Tierra y proveniente de dicho planeta, así parecía confirmarlo al contener fósiles de vida microbiana. Como podreis comprender, aquello impactó en la opinión pública de todo el mundo y, la noticia, fue objeto de todas las primeras planas y tambien, de todas las conversaciones en los corrillos en el trabajo, en el café, por las calles y en familia. ¡Vida en otro planeta!

A partir de aquel momento, cualquier señal se asimiló a la presewncia de vida allí

Aunque no lo podamos saber y no estemos al tanto de lo que pasa en el mundo científico (las noticias saltan cuando hay un descubrimiento relevante), lo cierto es que, durante los últimos años los científicos han llevado a cabo una espectacular puesta al día de sus ideas sobre el origen de la vida. Todos hemos podido leer en los libros de texto que, la vida, comenzó temprano en nuestro planeta. Según todos los indicios (los fósiles encontrados en las rocas más antiguas así lo afirman), la vida ha estado presente en la Tierra desde hace ya unos cuatro mil millones de años.

¿Quién está en posesión de asegurar o de negar nada, en relación a la presencia de vida en el pasado o en el presente en el planeta hermano que llamamos Marte? Sabemos mucho de la historia de aquel planeta y, el misterior que lo rodea de cómo pudo perder sus océanos y su atmósfera nos ctrae de cabeza. Sabemos que hace algunos millones de años puedo ser como la Tierra y, si es así (que lo es), a dón de marchó la posible clase de vida que ocupaba las distintas regiuones de aquel mundo.

Según nuestro poco conocimiento, algo nos hace sospechar de que, el único lugar al que pudo emigrar la vida, fue al subsuelo, allí existen innumerables tubos baturales por los que corría la lava igbea de un planeta con abundante actividad volcánica. En esas profundidades, las temperaturas son más altas y el agua, puede correr libremente, y, si hay agua líquida presente… ¡la vida no andará lejos!

Encuentran microbios a dos kilómetros bajo tierra en un cráter en EEUU

Parece ahora que los primeros organismos terrestres vivían en el subsuelo profundo al calor de la joven Tierra, enterrados en rocas calentadas geotérmicamente en condiciones similares a las que podríamos encontrar en una olla a presión. Sólo posteriormente migraron estos organismos a la superficie. Sirprendentemente, los descendientes de esos microbios primordiales aún están allí, a kilómetros de profundidad bajo nuestros pies.

Hace algunos años nadie podía sospechar que la vida pudiera estar presente en un ambiente tan inhóspito escondidos en las rocas bajo la superficie de la Tierra y… ¿de Marte?.

Fotografía del meteorito ALH 84001

¿Cómo empezó la vida exactamente? ¿Qué procesos físicos químicos pueden transformar la materia “inerte” en un organismo viv0? Esta compleja pregunta sigue siendo uno de los más grandes misterios de la naturaleza y quizás, el reto científico también mayor. Ejercitos de químicos y biólogos desde hace años, están abordando el complejo problema y tratan de desvelar el secreto tan celosamente guardado por la Naturaleza. Muchos de ellos, han tenido que concluir diciendo que, las leyes de la Naturaleza están predispuestas a favor de la vida y dicen que la vida se formará y surgirá en todos aquellos lugares que tengan las condiciones idóneas para ello.

Vista microscópica de la estructura interna del ALH 84001

Así que, no sólo en la Tierra o Marte, también la vida podría estar presente en cualquier luna o planeta que, situado en la zona habitable de la estrella que los acoge, con atmósfera y elementos químicos y los demás ingredientes necesarios (Carbono, Hidrógeno,Oxígeno, Nitrógeno…) además de la presencia también de alguna clase de actividad tectónica-volcánica, una capa de ozono, la presencia de gases con efecto invernadero, agua líquida, ¿un planeta gigante?, existencia de un campo magnético…

La tectónica de placas y el vulcanismo activo de nuestro planeta habrían tenido un importante para mantener el clima . Estos procesos actúan como un gigantesco termostato natural que regula la cantidad de dióxido de carbono de la atmósfera, y manteniendo el efecto invernadero a raya.

Los gases de efecto invernadero tan satanizados hoy en día, son absolutamente imprescindibles para la vida. Los más importantes son el dióxido de carbono, vapor de agua y el metano que atrapan el calor del Sol que de otra forma escaparía al espacio. Sin estos gases en la atmósfera, el planeta entero sería un gigantesco congelador.

La capa de ozono es crítica para las plantas y animales bloqueando la mayor parte de estos nocivos rayos de alta energía procedentes del Sol.

El agua líquida es absolutamente imprescindible para la vida como la conocemos. Los océanos proporcionan el ambiente líquido perfecto para que proliferen los orgamisnos vivos. A pesar de todo, existen algunos organismos vivos exóticos capaces de sobrevivir en ambientes mucho más secos. El agua se filtra a gran profundidad en las rocas actuando además como natural en los movimientos de las placas tectónicas.

Este es uno de los aspectos más importantes para que la vida pueda desarrollarse. La zona habitable de un sistema estelar se suele definir como aquella región del sistema en la que el agua puede existir en forma líquida. Distancias menores a la estrellas provocarían que los océanos hirviesen y se secasen, distancias mayores causarían que los océanos se congelasen.

Algunos científicos opinan que la existencia de un planeta masivo como Júpiter en nuestro Sistema solar solar protege a la Tierra de impactos de asteroides y cometas. Júpiter actuaría como un escudo, absorbiendo la mayoría de impactos de asteroides y cometas, capaces de provocar una enorme destrucción en la biosfera.

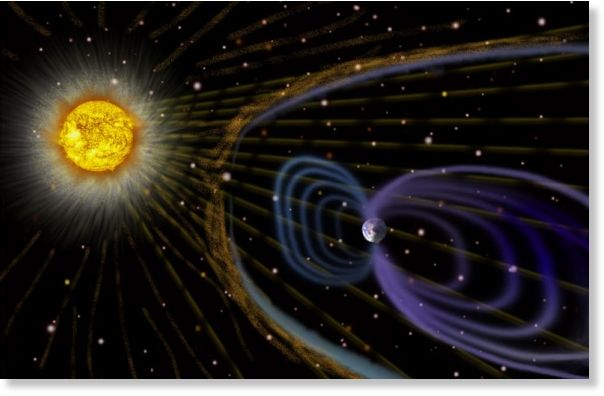

Un planeta habitable necesitaría un campo magnético capaz de protegerlo de la embestida de partículas cargadas del viento estelar desviando la corriente. Sin la presencia de un campo magnético, el viento solar o estelar podría arrancar la atmósfera del planeta que escaparía al espacio. Un campo magnético también protege de la radiación cósmica…

La creencia en que la vida está inscrita en las leyes de la Naturaleza trae un débil eco de una era religiosa pasada, de un universo concebido para ser habitado por criaturas vivas. Muchos científicos menosprecian tales ideas, e insisten en que el origen de la vida fue un accidente anómalo de la química que sólo se dio en la Tierra; y que la posterior emergencia de organismos complejos, incluyendo los seres conscientes, es así mismo un resultado puramente fortuito de una gigantesca lotería cósmica. En este debate está en juego el lugar mismo de la Humanidad en el Cosmos: ¿Quiénes somos y dónde encajamos dentro del gran esquema?

Bueno, ahora estamos vigilantes y queremos desvelar ese misterio. En cuanto a que todo esto es el resultado de una gran loteria cósmica… me parece que no. En una loteria sale un número y, sin embargo, en lo relativo a la vida, sabemos que actualmente sólo viven en nuestro planeta aproximadamente un uno por ciento de todas las especies que lo han poblado a lo largo de su existencia. Y, si es así (que lo es), ¿cómo es posible esa diversidad de criaturas en un caso fortuito? ¿No será más lógico pensar que, la vida, es consustancial de la dinámica del Universo?

Hemos conformado un modelo del universo y de él partimos para poder explicar su Historia. Hemos inventado un Big Bang que, en parte, nos explica el suceso de la presencia del universo y de cómo pudo surgir. Su nacimiento explosivo estuvo acompañado por un inmenso destello de calor intenso. Durante la primera fracción se segundo emergieron las fuerzas físicas básicas y las partículas fundamentales de la materia. Al cabo de este primer segundo, los materiales esenciales del Cosmos ya estaban formados. El espacio está repleto por todas partes de una sopa de partículas subatómicas -protones, neutrones y electrones– bañadas en radiación a una temperatura de dies mil millones de grados.

Bueno, lo que en realidad estamos llamando el principio aquí es el universo cuando la temperatura rondaba los 100,000,000,000 K. El universo ya había existido al menos por una pequeña fracción de segundo y estaba dominado por radiación con unas pequeñas trazas de materia. La radiación estaba en forma de fotones, neutrinos y antineutrinos. La materia estaba en forma de electrones, positrones y una pequeña concentración de protones y neutrones (denominados nucleones) – aproximadamente un nucleón por cada 1,000 millones de partículas -.

A estas temperaturas y densidades tan extremas (la densidad equivalía a unos 3.800 millones de veces la densidad del agua), todas estas entidades se comportan como partículas. Eso significa que están todo el tiempo colisionando entre ellas, casi como lo harían un montón de canicas que estuvieran bien empaquetadas en un container. En el universo primitivo no existían “paredes” físicas que contuvieran a esas partículas, sino que el elevado número de colisiones y la rapidez de éstas jugaban perfectamente el papel de “paredes del universo”. Sin embargo, esas “paredes” no eran estáticas, sino que a medida que se producían las colisiones el universo aumentaba de tamaño. La expansión del universo producía una disminución de la densidad de energía que tenía que distribuirse en un volumen cada vez mayor. Este proceso implicaba a su vez una disminución de la temperatura del universo, proceso que continúa ocurriendo hoy en día.

Las colisiones entre partículas tenían tres importantes consecuencias. La primera es que el universo estaba en equilibrio térmico. Para dar al lector una idea de lo que esto significa, vamos a fijarnos en un vaso de agua a 40 grados. La temperatura de un objeto es una medida de la energía media del movimiento (energía cinética) de sus moléculas. Pero no todas las moléculas la misma energía cinética correspondiente a una temperatura de 40 grados, sino que existen moléculas con menos energía y moléculas con más energía.

PRIMER CAMINO

Los núcleos de deuterio colisionan con un protón formando 3He, y seguidamente con un neutrón formando 4He

SEGUNDO CAMINO

El deuterio colisiona primero con un neutrón formando 3H (habitualmente conocido como tritio), y posteriormente con un protón para formar de nuevo 4He

Este núcleo fue el más pesado que se formó en el universo primitivo, debido a que en el momento en que esto fue posible, la densidad de energía ya era demasiado baja para permitir que los núcleos colisonarán con suficiente energía para fundirse. En el momento en que comenzó la nucleosíntesis, la abundancia relativa de protones y neutrones era: 13% de neutrones y 87% de protones. Todos los neutrones fueron utilizados para formar los núcleos de Helio. Los protones quedarían de esa manera como núcleos de hidrógeno. Por lo tanto, tenemos que en el momento en que se completó la nucleosíntesis primigenia, el universo consistía en prácticamente un 25% de He y un 75% H (en peso) con ligeras trazas de otros elementos ligeros.

El paso final en la formación de los elementos fue la captura de los electrones libres por parte de los núcleos para formar los átomos neutros (proceso conocido curiosamente como recombinación a pesar de que es la primera vez que se ligaban electrones y núcleos).

Pero los electrones tenían aún suficiente energía para y el proceso de recombinación no ocurriría de forma masiva hasta que transcurrieran unos 700,000 años. La captura de los electrones para formar los átomos tuvo una consecuencia importantísima: sin electrones libres, la radiación electromagnética (los fotones) ya no tenían con quién interactuar y el universo se volvería transparente al paso de ésta. Esto significó que los fotones serían capaces de expandirse junto con el universo. Esos fotones que acabaron por ser libres tenían energías altísimas que se traducía en longitudes de onda muy cortas. Pero la expansión del universo causó el alargamiento de esta longitud de onda. Esos fotones de longitud de onda alargada debida a la expansión son a los que nos referimos cuando hablamos del fondo de microondas. Éste es un remanente del Big Bang. Hemos sido capaces de medir la intensidad de este fondo de radiación que se ajusta casi perfectamente a lo que predicen los cálculos teóricos. Ésta ha sido una de las evidencias más rotundas a favor de la imagen del universo que proporciona el modelo del Big Bang.

Unos doscientos millones de años más tarde de todos aquellos sucesos, el universo estaba más frío y los átomos se unieron para formar las primeras estrellas que comenzaron a brillar en el espacio interestelar del jóven universo. Así, durante diez mil millones de años, se fueron transmutando nuevos materiales en los nucleares, las estrellas masivas habían explosionado y dejado el rastro de nubes moleculares gigantescas, nacieron nuevas estrellas de II generación situadas en Sistemas solares que posibilitaron, presididos por una estrella mediana, amarilla de la clase G2V, que en un planeta situado a la distancia adecuada y con todos los ingredientes y parámetros necesarios, surgieran seres vivios a partir de la materia “inerte” evolucionada y, en alguna de aquellas especies, cuatro mil años más tarde, se llegó a adquirir la conciencia.

Personajes como Fred Hoyle, Brandon Carter, Eugene Wigner, Erwin Schrödinger, Martin Rees, Bernard Carr, Freeman Dyson y Tommy Gold, Lewis Wolpert y Sydney Brenner, Jhon Coway y Manfred Eigen y Grahan Cairns-Smith. Todos ellos grtandes especialistas en sus campos que abarcaban desde la biología, las matemáticas, la genética hasta la astronomía y la astrofísica…Todos ellos y más tarde otros, como Casrl Sagan, creyeron ciegamente en la existencia de la vida por todo el universo. Para ellos (y para mí también), era una regla inamovible y consustancial con la dinámica y el ritmo que marca el Universo para que la Vida, esté en él presente.

La historia científica de la vida es una narración apasionante que, correctamente explicada, nos ayuda a comprender no sólo nuestro pasado biológico sino también la Tierra y toda la vida que nos rodea en la actualidad. Esa diversidad biológica es el producto de casi cuatro mil millones de años de evolución. Somos parte de ese legado; al intentar comprender la historia evolutiva de la vida, comenzamos a entender nuestro propio lugar en el mundo y nuestra responsabilidad como administradores de un planeta que nos dio cobijo y al que nos tuvimos que adaptar lo mismo que él, el planeta, se adaptó a la presencia de la vida que, de alguna manera cambió su entorno climático, precisamente debido, a esa presencia viviente que generó las precisas condiciones para poder estar aquí.

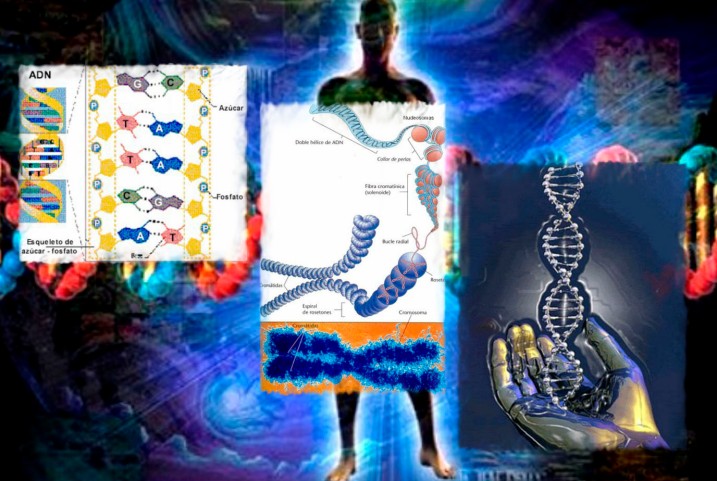

La historia de la vida tiende a relatarse (no pocas veces) al estilo de la genealogía de Abraham: las bacterias engendraron a los protozoos, los protozoos engendraron a los invertebrados, los invertebrados engendraron a los peces, y así sucesivamente. Tales listas de conocimientos adquiridos pueden memorizarse, pero no dejan mucho espacio para pensar. La cuestión no es tan sencilla y los descubrimientos de la paleontología, la más tradicional de las empresas científicas, se entrelazan con nuevas ideas nacidas de la biología molecular y la geoquímica.

Los huesos de los Dinosaurios son grandes y espectaculares y hacen que los que los contemplan (niños y mayores), abran los ojos como platos, asombrados de tal maravilla. Pero, aparte del tamaño de sus habitantes, el mundo de los dinosaurios se parecía mucho al nuestro. Contrasta con él la historia profunda de la Tierra, que nos cuentan fósiles microscópicos y sutiles señales químicas y que es, pese a ello, un relato dramático, una sucesión de mundos desaparecidos que, por medio de la transformación de la atmósfera y una evolución biológica, nos llevan hacia el mundo que conocemos hoy.

Pero, ¿cómo podemos llegar a comprender acontecimientos que se produjeron hace mil millones de años o más? Una cosa es aprender que en las llanuras mareales de hace mil quinientos millones de años vivían bacterias fotosintéticas, y otra muy distinta cómo se infiere que unos fósiles microscópicos pertenecen a bacterias fotosintéticas, cómo se averigua que las rocas que los rodean se formaron en antiguas llanuras mareales y cómo se estima su edad en mil quinientos millones de años.

El leitmotiv epistemológico de cómo sabemos lo que creemos que sabemos, en realidad, aparece de manera espontánea a base de mucho estudio de campo, investigación exhaustiva en los más dispares rincones de la Tierra y, un profundo estudio concatenado en el tiempo de todo aquello que, en cada exploración pueda ir apareciendo. En tanto que empresa humana, estamos inmersos también en un relato de exploración que se extiende desde el espacio interior de las moléculas al espacio literalmente exterior de Marte y otros planetas.

Uno de los temas más claros de la historia evolutiva es el carácter acumulativo de la diversidad biológica. Las especies individuales (al menos las de los organismos nucleados) aparecen y desaparecen en una sucesión geológica de extinciones que ponen de manifiesto la fragilidad de las poblaciones en un mundo de competencia y cambio ambiental –de formas de vida con una morfología y fisiología características- es una historia de acumulación. La visión de la evolución a gran escala es indiscutiblemente la de una acumulación en el tiempo gobernada por las reglas de funcionamiento de los ecosistemas. La serie de sustituciones que sugieren los enfoques al estilo de la genealogía de Abraham no consigue captar este atributo básico de la historia biológica.

Así, creemos saber que la vida nació por mediación de procesos físicos en la Tierra primigenia. Estos mismos procesos –tectónicos, oceanográficos y atmosféricos- sustentaron la vida era tras era al tiempo que modificaban continuamente la superficie de la Tierra. Por fin la vida se expandió y se diversificó hasta convertirse en una fuerza planetaria por derecho propio, uniéndose a los procesos tectónicos y físico-químicos en la transformación de la atmósfera y los océanos.

Dondequiera que choquen las relativamente rápidas placas tectónicas oceánicas con las enormes placas continentales, se forman cadenas montañosas en continua elevación. Los ejemplos más espectaculares se subducción y formación montañosa son, respectivamente, la placa del Pacífico sumergiéndose en las profundas fosas del Asia oriental, y el Himalaya, que se eleva por el choque de las placas índica y euroasiática. Todo forma parte del proceso que llevó a la vida.

Para mí y para cualquiera que emplee la lógica de la ciencia que se guía por los hechos probados, el surgimiento de la vida como una característica definitoria –quizá la característica definitoria- de nuestro planeta es algo extraordinario.

¿Quién podría negar que no somos parte del Universo?

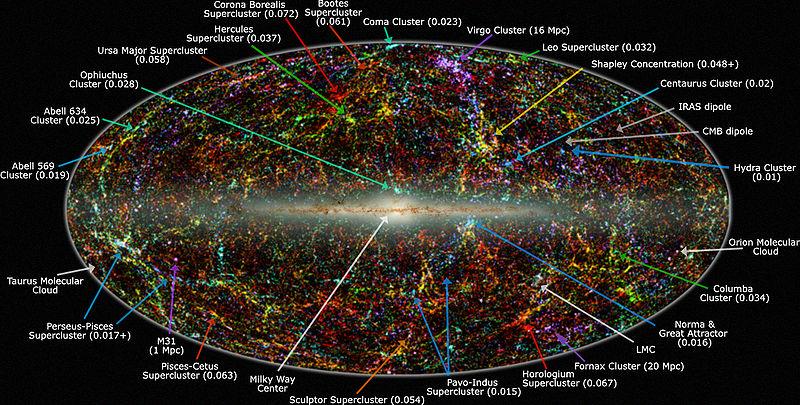

¿Cuántas veces ha ocurrido lo mismo en la vastedad del Universo? Es lo primero que se me viene a la mente cuando (en la noche silenciosa, oscura y tranquila lejos del bullicioso ambiente de las ciudades y de su molesta contaminación lumínica), miro hacia las estrellas brillantes del cielo que, muy lejanas en regiones remotas, también como nuestro Sol, están rodeadas de mundos que, como el nuestro, habrán tenido la misma posibilidad que la Tierra para que la vida, pudiera surgir.

Hacer aquí un recorrido pormenorizado del largo camino que la vida ha tenido que recorrer, y dibujar un esquema a modo de un árbol de la vida, es imposible. El presente trabajo trata simplemente, de dejar una idea básica de cómo la vida llegó aquí, al planeta Tierra, y, de cómo pudo evolucionar con el paso del tiempo y dentro de su rica diversidad.

![[clip_image021[5].jpg]](http://lh6.ggpht.com/_qFJEJ54NBZo/S37k52BYcEI/AAAAAAAAKoQ/DSlNwb9hgio/s1600/clip_image021%5B5%5D.jpg)

Estos escenarios son precursores de vida

Los expertos si han construido un árbol de la vida a partir de comparaciones ente secuencias de nucleótidos de genes de diversos organismos, las plantas y los animales quedan reducidos, en ese árbol, a brotes en la punta de una sola de las ramas. La mayor diversidad de la vida y, por extensión, la mayor parte de su historia, es microbiana. Así lo atestiguan todos y cada uno de los hallazgos encontramos en las rocas precámbricas que contienen fósiles de aquellas primeras formas de vida.

Hasta que la evolución de la materia llegó… ¡Hasta nosotros!

Y, una cosa está muy clara y no se presta a ninguna clase de dudas: Las Bacterias y las Arqueas, son los arquitectos de los ecosistemas terrestres.

Biólogos expertos indiscutibles de probada valía y reconocido prestigio, han llegado a sugerir que los genes de los organismos actuales contienen el relato completo de la historia evolutiva. Pero, de ser así se trataría, como en las historias de Shakespeare, de relatos limitados a los vencedores de la vida. Sólo la paleontología nos puede hablar de los trilobites, los dinosaurios y otras maravillas biológicas que ya no adornan la faz de la Tierra.

Cualquiera que sea la ctividad química notable que haya podido tener lugar en la Tierra primordial o en algún otro planeta situado en cualquiera de los miles de millones de galaxcias que por el Universo pululan, la vida ha podido ser desencadenada no por una vorágine molecular como tal, sino -¡de algún modo!- por la organización de la información que ha dado la misma Naturaleza a la materia para que sepa, seguir su destino desde lo inerte hasta los pensamientos.

De ello, os hablaré en próximos trabajos.

emilio silvera

Ene

3

A la caza del fotón oscuro en el CERN

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

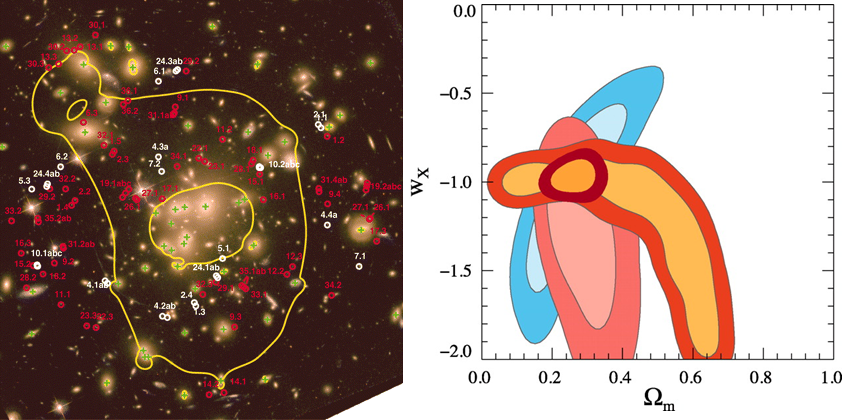

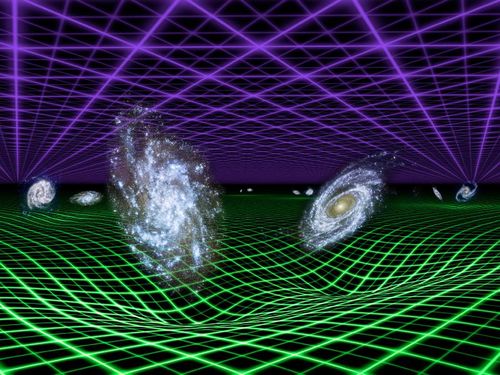

Si en realidad existe… ¿Dónde está esa materia esquiva e invisible que llaman oscura?

Uno de los mayores misterios a los que se enfrenta la Física es el hecho de que la mayor parte de la materia que existe es oscura. Es decir, un tipo de materia que no interactúa en modo alguno con los fotones, y que, por lo tanto, es totalmente invisible para nuestros ojos y para los telescopios de los astrónomos.

La masa del Universo esta compuesta por un 5% de materia ordinaria, un 23% de materia oscura y un 72% de la energía oscura.

En el CERN disponen el LHC para tratar de encontrar la dichosa materia oscura

Algunas teorías sugieren que, además de a través de la gravedad, las partículas de materia oscura podrían interaccionar con la materia visible por medio de una fuerza desconocida, la fuerza oscura, que podría transmitirse a través de fotones oscuros.

Localizar los fotones oscuros es la misión del experimento NA64 del CERN.

Fuente: Revista mensual electrónica de la Real Sociedad Española de Física.

Ene

3

Ese fino equilibrio que permite la presencia de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Química de la Vida ~

Clasificado en El Universo y la Química de la Vida ~

Comments (0)

Comments (0)

Lass estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Hasta el momento sólo sabemos de la vida en la Tierra

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución.

Cuando comento éste tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, a aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrollo la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que, hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos tres días y, desde luego, ¡la que hemos formado!

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Creo que la clave está en los compuestos del carbono, toda la vida terrestre actualmente conocida exige también el Agua como disolvente. Y como para el carbono, se supone a veces que el agua es el único producto químico conveniente para cumplir este papel. El amoníaco (el nitruro de hidrógeno) es la alternativa ciertamente al agua, la más generalmente posible propuesta como disolvente bioquímico. Numerosas reacciones químicas son posibles en disolución en el amoníaco, y el amoníaco líquido tiene algunas semejanzas químicas con el agua. El amoníaco puede disolver la mayoría de las moléculas orgánicas al menos así como el agua, y por otro lado es capaz de disolver muchos metales elementales. A partir de este conjunto de propiedades químicas, se teorizó que las formas de vida basada en el amoníaco podrían ser posibles. También se dijo del Silicio. Sin embargo, ninguno de esos elementos son tan propicios para la vida como el Carbono y tienen, como ya sabemos, parámetros negativos que no permiten la vida tal como la conocemos.

Hasta rel momento, todas las formas de vida descubiertas en la Tierra, están basadas en el Carbono.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

-

C: Carbono

-

H: Hidrógeno

-

O: Oxígeno

-

N: Nitrógeno

-

P: Fósforo

-

Fe: Hierro

-

S: Azufre

-

Ca: Calcio

-

I: Yodo

-

Na: Sodio

-

K: Potasio

-

Cl: Cloro

-

Mg: Magnesio

-

F: Flúor

-

Cu: Cobre

-

Zn: Zinc

-

Glúcidos o Hidratos de Carbono

-

Lípidos

-

Proteínas

-

Ácidos Nucleicos

El el gráfico de arriba están resumidas sus funciones.

A veces, nuestra imaginación dibuja mundos de ilusión y fantasía pero, en realidad… ¿serán sólo sueños?, o, por el contrario, pudieran estar en alguna parte del Universo todas esas cosas que imaginamos aquí y que pudieran estar presentes en otros mundos lejanos que, como el nuestro…posibilito la llegada de la vida.

Sí, imaginamos demasiado pero… ¿Qué hay más poderoso que la imaginación?

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

¿Cuántos secretos están en esos números escondidos? La me´canica cuántica (h), la relatividad (c), el electromagnetismo (e–). Todo eso está ahí escondido. El número 137 es un número puro y adimensional, nos habla de la constante de estructura fina alfa (α), y, el día que sepamos desentrañar todos sus mensajes… ¡Ese día sabremos!

Extraños mundos que pudieran ser

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN pueden verse afectados de manera adversa. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, n se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

“Es difícil formular cualquier teoría firme sobre las etapas primitivas del universo porque no sabemos si hc/e2 es constante o varía proporcionalmente a log(t). Si hc/e2 fuera un entero tendría que ser una constante, pero los experimentadores dicen que no es un entero, de modo que bien podría estar variando. Si realmente varía, la química de las etapas primitivas sería completamente diferente, y la radiactividad también estaría afectada. Cuando empecé a trabajar sobre la gravedad esperaba encontrar alguna conexión ella y los neutrinos, pero esto ha fracasado.”

Las constantes de la naturaleza ¡son intocables!

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Ahora, cuando miramos el Universo, comprendemos, en parte, lo que ahí está presente.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más.

La estructura de los átomos y las moléculas está controlada casi por completo por dos números: la razón entre las masas del electrón y el protón b, que es aproximadamente igual a 1/1.836, y la constante de estructura fina a, que es aproximadamente 1/137. Supongamos que permitimos que estas dos constantes cambien su valor de forma independiente y supongamos también (para hacerlo sencillo) que ninguna otra constante de la Naturaleza cambie. ¿Qué le sucede al mundo si las leyes de la naturaleza siguen siendo las mismas?

Si deducimos las consecuencias pronto encontramos que no hay muchos espacios para maniobrar. Incrementemos b demasiado y no puede haber estructuras moleculares ordenadas porque es el pequeño valor de Beta (aF) el que asegura que los electrones ocupen posiciones bien definidas alrededor de un núcleo atómico y las cargas negativas de los electrones igualan las cargas positivas de los protones haciendo estable el núcleo y el átomo.

Si en lugar de a versión b, jugamos a cambiar la intensidad de la fuerza nuclear fuerte aF, junto con la de a, entonces, a menos que aF > 0,3 a½, los elementos como el carbono no existirían.

No podrían existir químicos orgánicos, no podrían mantenerse unidos.Si aumentamos aF en solo un 4 por 100, aparece un desastre potencial porque ahora puede existir un nuevo núcleo de helio, el helio-2, hecho de 2 protones y ningún neutrón, que permite reacciones nucleares directas y más rápidas que de protón + protón → helio-2.

Las estrellas agotarían rápidamente su combustible y se hundirían en estados degenerados o en agujeros negros. Por el contrario, si aF decreciera en un 10 por 100, el núcleo de deuterio dejaría de estar ligado y se bloquearía el camino a los caminos astrofísicos nucleares hacia los elementos bioquímicos necesarios para la vida

Hasta donde sabemos, en nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas que llegaran a poder cristalizar los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono… Si miramos por ahí, encontraremos múltiples noticias como estas:

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

Co,mo podemos ver, amigos míos, la vida, como tantas veces vengo diciendo aquí, pulula por todo el Universo en la inmensa familia galáctica compuesta por más de ciento veinticinco mil millones y, de ese número descomunal, nos podríamos preguntar: ¿Cuántos mundos situados en las zonas habitables de sus estrellas habrá y, de entre todos esos innumerables mundos, cuántos albergaran la vida?

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida. Yo (como muchos otros), estoy convencido de que la vida es, de lo más nartural en el universo y estará presente en miles de millone de planetas que, como la Tierra, tienen las condiciones para ello. Una cosa no se aparta de mi mente, muchas de esas formas de vida, serán como las nuestras aquí en la Tierra y estarán también, basadas en el Carbono. Sin embargo, no niego que puedan existir otras formas de vida diferentes a las terrestres.

emilio silvera

Ene

3

Sobre el final del Universo y otros temas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Los cosmólogos llaman Ω a la cantidad de materia que contiene nuestro Universo, y, en función de ella, éste podría ser un universo plano, abierto o cerrado. Conforme a dicha clasificación, podría tener un final u otro.

La Densidad crítica está referida a la densidad media de materia requerida para que la Gravedad detenga la expansión de nuestro Universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo al que antes nos referimos conocido como de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro Universo representa sólo el 20% del valor crítico. Puede haber, sin embargo, una gran cantidad de materia oscura que elevaría la densidad hasta el valor crítico. Las teorías de universo inflacionario predicen que la densidad presente debería ser muy aproximada a la densidad crítica; estas teorías requieren la existencia de materia oscura.

Los Modelos Cosmológicos son variados y todos, sin excepción, nos hablan de una clase de universo que está conformado en función de la materia que en él pueda existir. Lo cierto es que no estamos seguros de cuánta materia hay y, los datos que tenemos son referidos a la materia bariónica, esa de la que están formadas las galaxias y también nosotros.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

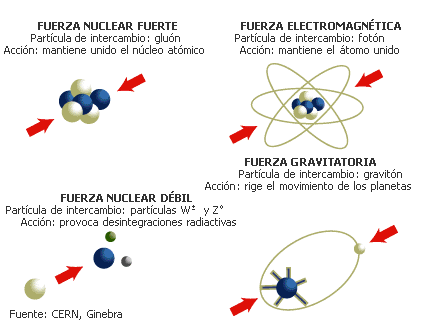

En presencia de grandes masas de materia, tales como planetas, estrellas y Galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio-tiempo, eso que conocemos como Gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La Gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de Gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de Gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de Gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el Universo, de hacer posible que existan las Galaxias, los sistemas solares y que, nosotros mismos, tengamos bien asentados los pies a la superficie de nuestro planeta Tierra, cuya gravedad, tira de nosotros para que así sea.

Los cúmulos de galaxias están cohexionados por la Gravedad

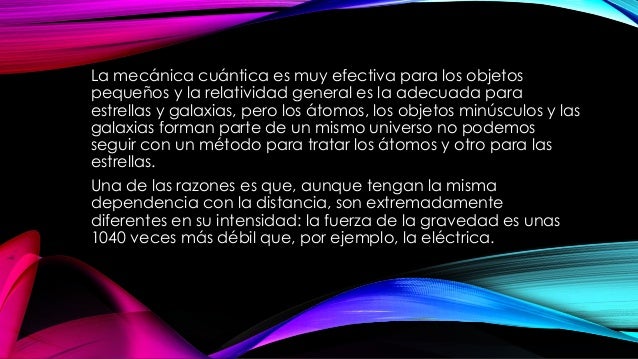

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable.

La Gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El Gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Gráfica que muestra el espectro de cuerpo negro emitido por tres cuerpos a distinta temperatura (4500 K, 6000 K y 7500 K). El eje horizontal es la longitud de onda, mientras que el eje vertical representa la intensidad relativa de la radiación.

La teoría cuántica es un ejemplo de talento que debemos al Físico alemán Max Planck (1.858-1.947) que, en el año 1.900 para explicar la emisión de radiación de cuerpo negro de cuerpos calientes, dijo que la energía se emite en cuantos, cada uno de los cuales tiene una energía igual a hv, donde h es la constante de Planck (E=hv o ħ=h/2л) y v es la frecuencia de la radiación. Esta teoría condujo a la teoría moderna de la interacción entre materia y radiación conocida como mecánica cuántica, que generaliza y reemplaza a la mecánica clásica y a la teoría electromagnética de Maxwell. En la teoría cuántica no relativista se supone que las partículas no son creadas ni destruidas, que se mueven despacio con respecto a la velocidad de la luz y que tienen una masa que no cambia con la velocidad. Estas suposiciones se aplican a los fenómenos atómicos y moleculares y a algunos aspectos de la física nuclear. La teoría cuántica relativista se aplica a partículas que viajan cerca de la velocidad de la luz, como por ejemplo, el fotón.

Por haberlo mencionado antes me veo obligado a explicar brevemente el significado de “cuerpo negro”. Que está referido a un cuerpo hipotético que absorbe toda la radiación que incide sobre él. Tiene, por tanto, una absorbancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la distribución de energía sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumento de temperaturas (ley de desplazamiento de Wien).

La Gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El Gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

Nadie ha podido llegar hasta la Longitud de Planck para poder observar lo que allí pueda existir, se denota:

La longitud de Planck forma parte del sistema de unidades naturales, y se calcula a partir de tres constantes fundamentales: la velocidad de la luz en el vacío, la constante de Planck, h, y la constante gravitacional, G. Equivale a la distancia que recorre un fotón, viajando a la velocidad de la luz, en el Tiempo de Planck.

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla, para llegar hasta ellas, se necesitaría la energía de Planck, es decir una energía equivalente a 1019 GeV, un sueño que está fuera de nuestras posibilidades humanas en el presente y, seguramenter, durantemuchas generaciones.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

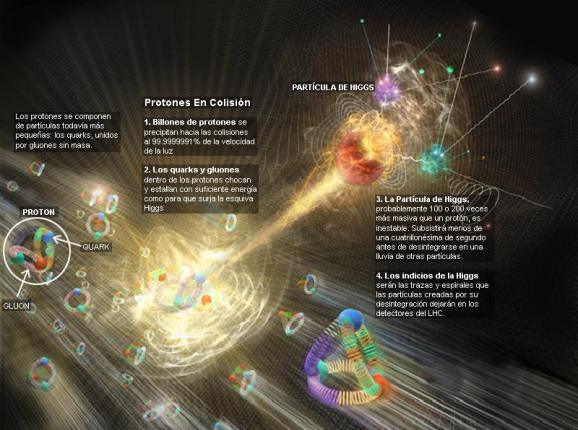

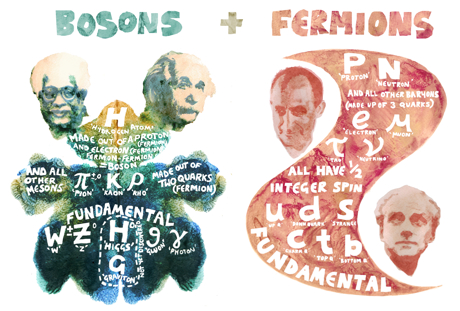

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, que siendo infinitesimal, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC) en su nueva andadura en el mes de abril de 2.016. Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Lo cierto es que, la Gravedad, se ha negado a ser incluída en el Modelo estándard de la física de partículas.

La asignatura pendiente de la física teórica del siglo XX ha sido la unificación de la relatividad general y la mecánica cuántica. Las aproximaciones que se han hecho van desde la cuantificación canónica del campo gravitatorio hasta la ampliación de las simetrías en la teoría de supercuerdas. Existen también teorías que buscan una nueva interpretación de las teorías del espacio-tiempo, como se vio en el congreso sobre la ontología del espacio-tiempo que tuvo lugar en junio de 2006 en Montreal.

Penrose es actualmente Profesor emérito de Matemáticas de la Universidad de Oxford, y ya en los años 60 presentó su teoría de los “spin networks” que después fue tomada por Ashtekar y Rovelli, y otros, en la teoría de la gravitación cuántica.

A partir de los años 70, Penrose presentó su teoría de los “twistor”, que algunos físicos han aplicado a la teoría de las supercuerdas para resolver el enigma de las 11 dimensiones del espacio-tiempo. En su último libro “El camino a la Realidad” Penrose ha reivindicado la paternidad de las teorías de los “spin networks” y de los “twistors” que se empieza a utilizar por los físicos teóricos y que nosotros vamos a resumir brevemente.

Roger Penrose es uno de los nuevos humanistas del siglo que se ha interesado por los problemas de las matemáticas, de la física, de la biología, de la psicología y de la filosofía. Siguiendo el modelo de Popper de los tres mundos, ha trabajado sobre la flecha del mundo 1 de la física, al mundo 2 de la conciencia, y del mundo 3 de las matemáticas, al mundo 1.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Con estos modelos intenta Penrose responder a la pregunta sobre el “por qué” de la realidad física, en vez del “cómo”. Nos encontramos así ante uno de los grandes misterios de la razón humana que nos acercan al misterio del Universo.

“Spin networks” y gravedad cuántica

El modelo de los “twistors” se ha aplicado con éxito a la clasificación de las partículas elementales y a la formulación de la relatividad general. Pero recientemente algunos modelos de la gravedad cuántica han retomado la idea de los “spin networks” de Penrose para desarrollar un modelo discreto llamado loop quantum gravity donde el espacio subyacente está discretizado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

Lo que sí es una verdad irrefutable es que… ¡La búsqueda continua!

emilio silvera

Ene

2

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

La sorpresa salta en cualquier parte

Hablar de Albert Einstein y Stephen Hawking es hablar de dos de las personas más brillantes de la historia. Dos científicos simplemente extraordinarios, que marcaron el siglo XX y que a menudo son señalados como ejemplos de inteligencia. Se cree que ambos tenían un cociente intelectual de 160, sólo dos puntos por debajo del máximo posible en el test de Mensa, sociedad fundada en 1946 que reúne a personas superdotadas de todo el mundo. Ese tope de 162 es la puntuación obtenida por Nicole Barr, una niña gitana de 12 años residente en el condado de Essex (Inglaterra).

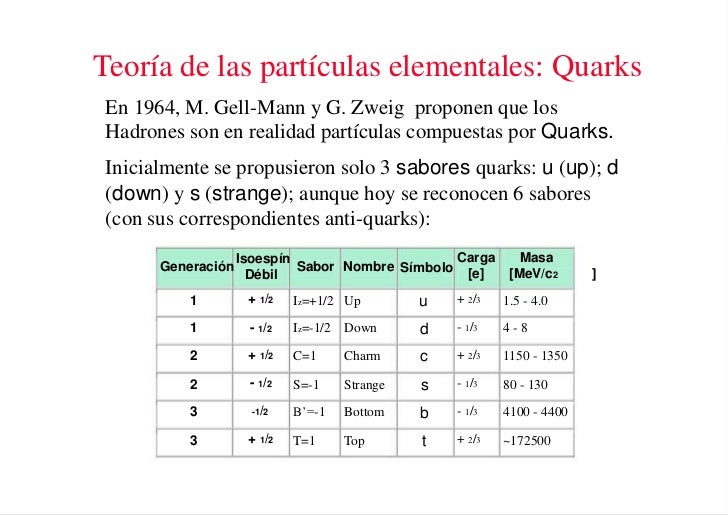

Una vez que se pusieron en orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

La enorme variedad de formas, colores, comportamientos, etc que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor.

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

El tensor de Riemann contiene toda la información necesaria para poder describir un espacio curvo en N-dimensiones. Se necesita dieciséis números para …

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Esta teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que un unidades ordinarias es aproximadamente 3 × 108 metros por segundo.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

La presencia de masas determina la geometría del espacio

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Viajar al “mundo” de lo muy pequeño resulta fascinante

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

La cámara de niebla, también conocida como cámara de Wilson, es un dispositivo utilizado para detectar partículas de radiación ionizante. En su forma más sencilla, una cámara de niebla es un entorno cerrado que contiene vapor de agua superenfriado y supersaturado. Cuando una partícula cargada de suficiente energía interacciona con el vapor, lo ioniza. Los iones resultantes actúan como núcleos de condensación. alrededor de los cuales se forman gotas de líquido que dan lugar a una niebla. Al paso de las partículas se va produciendo una estela o traza, debido a los numerosos iones producidos a lo largo de su trayectoria.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||