Mar

24

El final de una estrella

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (0)

Comments (0)

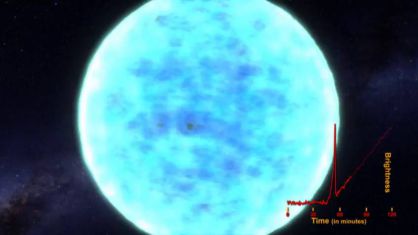

La NASA capta el estallido de una estrella al morir

El telescopio espacial ‘Kepler’ recoge por primera vez la luz visible de los primeros instantes de una supernova.

Lástima que no se pueda ver el proceso completo y poder contemplar como la estrella implosiona y se “estruja” más y más, hasta desaparecer conformada en una Singularidad, es decir, ver el nacimiento de un Agujero Negro.

Mar

24

¿Cuanta materia vemos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cosmología ~

Clasificado en Cosmología ~

Comments (0)

Comments (0)

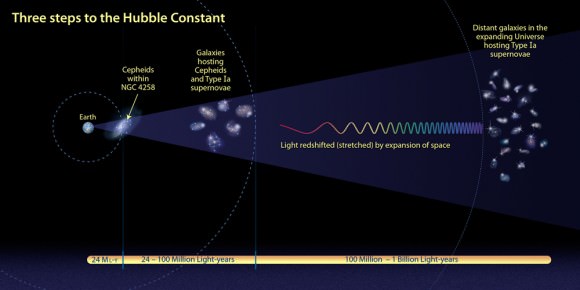

La constante de Hubble en función de la Densidad Crítica

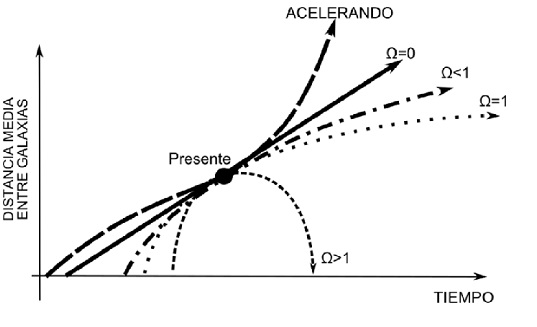

La cantidad total de Materia del Universo se da generalmente en términos de una cantidad llamada Densidad Crítica, denotada por Ω. Esta es la densidad de la materia que se necesita para producir un universo plano. Si Densidad efectivamente observada es menor o mayor que ese , en el primer caso el Universo es abierto, en el segundo es cerrado. La Densidad Crítica no es muy grande; corresponde aproximadamente a un protón por metro cúbico de espacio. Puede que no parezca mucho, dado el número inmenso de átomos en un metro cúbido de lodo, pero no debemos olvidar que existe una gran cantidad de espacio “vacío” las galaxias.

Algunos números que definen nuestro Universo:

- El número de fotones por protón

- La razón densidades de “Materia Oscura” y Luminosa.

- La Anisotropía de la Expansión.

- La falta de homogeneidad del Universo.

- La Constante Cosmológica.

- La desviación de la expansión respecto al valor crítico.

- Fluctuaciones de vacío y sus consecuencias.

- ¿Otras Dimensiones?

En las últimas medidas realizadas, la Densidad crítica que es la densidad necesaria que la curvatura del universo sea cero, ha dado el resultado siguiente: r0 = 3H02/8pG = 1.879 h2 10-29 g/cm3, que corresponde a una densidad tan baja la de la masa de 2 a 3 átomos de hidrógeno por metro cúbico (siempre, por supuesto obviando la incertidumbre en la constante de Hubble).

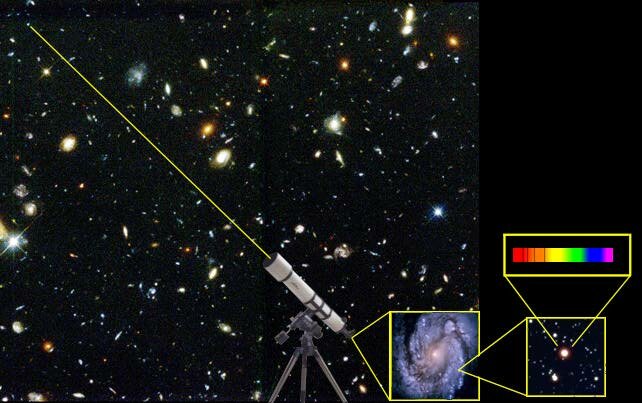

Estimar la cantidad de materia luminosa del universo es una cosa muy fácil de hacer. Sabemos el brillo que tiene una estrella media, así que podemos hacer una estimación del de estrellas de una galaxia distante. Podemos contar entonces el número de galaxias en un volumen dado de espacio y sumar las masas que encontramos. Dividiendo la masa por el volumen del espacio obtenemos la densidad media de materia en ese volumen. Cuando llevamos a cabo esta operación, obtenemos que la densidad de la materia luminosa es aproximadamente entre el uno o dos % menor de la densidad crítica; es decir, menos de lo que se necesita cerrar el universo.

Si el universo tiene una masa menor que ese valor de la Densidad Crítica, se expandirá para siempre. Y, en todo esto, mucho tendrá que decir “la materia oscura” (si realmente existe) que al generar Gravedad, incide en el comportamiento de todo el universo. Los Cosmólogos, llaman a la cantidad de materia que pueda contener el Universo el Omega Negro y, en función de ese Omega Negro, tendremos un Universo u otro.

Por otro lado, está lo bastante cerca del valor crítico para hacer una pausa. Después de todo, esta fracción podría haber sido en principio de una billonésima o trillonésima, y también podría haber sucedido que fuese un millón de veces la materia necesaria para el cierre. ¿Por qué, entre todas las masas que podría tener el universo, la masa de materia luminosa medida está cerca del valor crítico?

Claro que el hecho de que la materia luminosa medida esté tan cercana al valor crítico, simplemente debe ser a un accidente cósmico; las cosas simplemente “resultan” de ese modo. Me costaría mucho aceptar una explicación y supongo que a otros también. Es tentador decir que el Universo tiene en realidad la masa crítica, pero que de algún modo no conseguimos verla toda.

Como resultado de esta suposición, los astrónomos comenzaron a hablar de la “masa perdida” con lo que aludían a la materia que habría llenado la diferencia densidades observadas y crítica. Tales teorías de “masa perdida”, “invisible” o, finalmente “oscura”, nunca me ha gustado, toda vez que, hablamos y hablamos de ella, damos por supuesta su existencia sin haberla visto ni saber, exactamente qué es, y, en ese plano, parece como si la Ciencia se pasara al ámbito religioso, la fe de creer en lo que no podemos ver ni tocar y, la Ciencia, amigos míos, es otra cosa.

Tendremos que imaginar satélites y sondas que, de alguna manera, puedan detectar grandes halos galácticos que encierren la tan buscada materia oscura y que, al parecer, hace que nuestro Universo sea lo conocemos y, es la responsable del ritmo al que se alejan las galaxias, es decir, la expansión del Universo.

Esos halos, tendrían muchas veces las masas que podemos ver en la Materia luminosa de las estrellas, planetas, galaxias y nosotros mismos. La teoría de la materia oscura y su presencia en cúmulos y supercúmulos ha sido “descubierta” (o inventada para tapar nuestra ignorancia y que cuadren las “cuentas”) en época relativamente cercana para que prevalezca entre los astrónomos la uninimidad respecto a su contribución a la masa total del universo.

Si la materia oscura existe, no hemos sabido encontrarla

El debate continúa, está muy vivo y, es el tema tan candente e importante que, durará bastante tiempo mientras algún equipo de observadores no pueda, de una vez por todas, demostrar que, la “materia oscura” existe, que nos digan donde está, y, de qué está conformada y actúa. Claro que, cuando se haga la suma de materia luminosa y oscura, la densidad de la masa total del universo no será todavía mayor del 30% del valor crítico. A todo esto, ocurren sucesos que no podemos explicar y, nos preguntamos si en ellos, está implicada la Materia oscura.

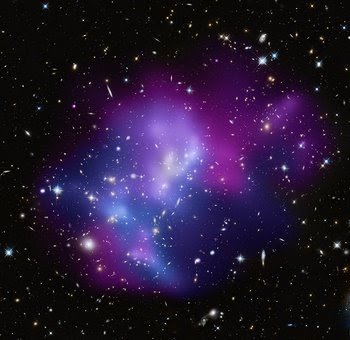

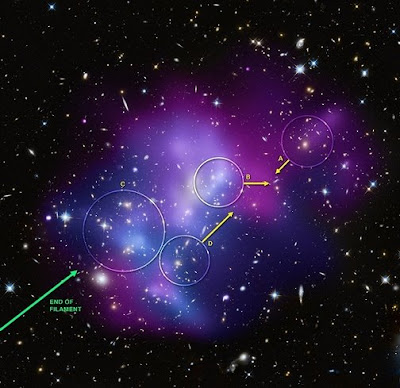

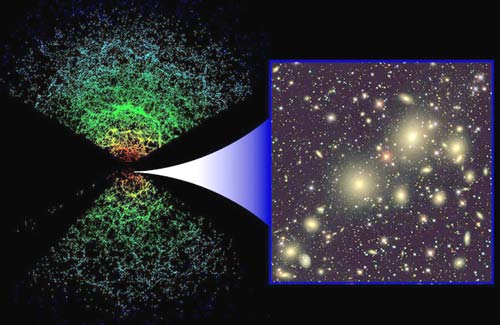

La más abarrotada colisión de cúmulos galácticos ha sido identificada al combinar información de tres diferentes telescopios. El resultado brinda a los científicos una posibilidad de aprender lo que ocurre algunos de los más grandes objetos en el universo chocan en una batalla campal cósmica.

Usando del Observatorio de rayos-X Chandra, el Telescopio Espacial Hubble y el Observatorio Keck de Hawai, los astrónomos fueron capaces de determinar la geometría tridimensional y el movimiento en el sistema MACSJ0717.5+3745 localizado a 5.4 mil millones de luz de la Tierra. Los investigadores encontraron que cuatro distintos cúmulos de galaxias están envueltos en una triple fusión, la primera vez que un fenómeno así es documentado.

La composición de imagen (arriba de todo) muestra el cúmulo de galaxias masivo MACSJ0717.5+3745. El color del gas caliente está codificado con colores mostrar su temperatura. El gas más frío es mostrado como un púrpura rojizo, el gas más caliente en azul y las temperaturas intermedias en púrpura. Las repetidas colisiones en el cúmulo son causadas por una corriente de galaxias, polvo y “materia oscura” -conocida filamento- de 13 millones de años luz.

Se han obtenido Imágenes (MACSJ0717) que muestran cómo cúmulos galácticos gigantes interactúan con su entorno en escalas de millones de años luz. Es un sistema hermoso para estudiar cómo los cúmulos crecen mientras el material cae en ellos a lo largo de filamentos. Simulaciones por ordenador muestran que los cúmulos de galaxias más masivos deben crecer en regiones donde filamentos de gran escala de gas intergaláctico, galaxias, y materia desconocida intersectan, pero…

¿Cuál debe ser la Masa del Universo?

Alan Guth

claro que la idea de masa perdida se introdujo porque la densidad observada de la materia del universo está cerca del valor crítico. Sin embargo, hasta comienzos de los ochenta, no se tuvo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que entonces se ha conocido como “universo inflacionista”. Desde entonces, la teoría ha sufrido numerosas modificaciones técnicas, pero los puntos centrales no han cambiado.

nuestra conversación de hoy, diremos que el aspecto principal del universo inflacionista es que estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico. Esta predicción viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. los otros muchos procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Abell 370 La lente gravitacional distorsiona la Imagen y nos enseña, a la derecha, algo que nos parece una inmensa cuerda cósmica , ¿que podrá ser en realidad? la materia a lo largo y ancho del universo se reparte de manera que, se ve concentrada en cúmulos de galaxias y supercúmulos que son las estructuras más grandes conocidas y, dentro de ellas, están todos los demás objetos que existen. Claro que, deajndo a un lado esas fluctuaciones de vacío y, la posible materia desconocida.

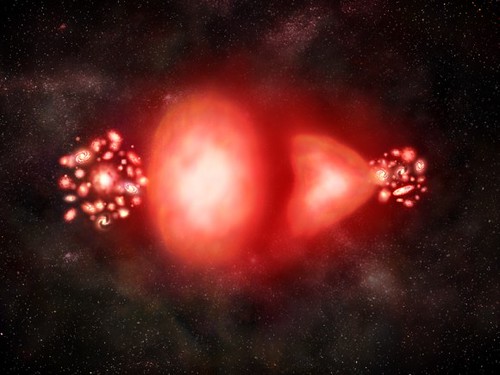

El proceso mediante el cual la fuerza fuerte se congela es un ejemplo de un cambio de fase, similar en muchos aspectos a la congelación del agua. el agua se convierte en hielo, se expande; una botella de leche explotará si la dejamos en el exterior en una noche de invierno de gélido frío. No debería ser demasiado sorprendente que el universo se expanda del mismo modo al cambiar de fase.

La distancia a una galaxia lejana se determina estudiando la luz proveniente de estrellas de tipo Cefeidas Variables. El expectro de la luz estelar revela la velocidad a la que se mueve la galaxia (Efecto Doppler) y la cantidad de expansión que ha sufrido el universo que la luz salió de su fuente.

Lo que es sorprendente es la enorme amplitud de la expansión. El tamaño del Universo aumentó en un factor no menor de 1050. Este es tan inmenso que virtualmente no tiene significado para la mayoría de la gente, incluido yo mismo que, no pocas veces me cuesta asimilar esas distancias inconmensurables del Cosmos. Dicho de otra manera, pongamos, por ejmplo, que la altura de los lectores aumentara en un factor tan grande como ese, se extenderían de un extremo al otro del Universo y, seguramente, faltaría sitio. Incluso un sólo protón de un sólo átomo de su cuerpo, si sus dimensiones aumentaran en 1050, sería mayor que el mismo universo. En 10-35 segundos, el universo pasó de algo con un radio de curvatura mucho menor que la partícula elemental más pequeña a algo como el tamaño de una naranja grande. No es extraño que el inflación esté ligado a este proceso.

Comparación entre un modelo de expansión desacelerada (arriba) y uno en expansión acelerada (abajo). La esfera de referencia es proporcional al factor de escala. El universo observable aumenta proporcionalmente al tiempo. En un universo acelerado el universo observable aumenta más rápidamente que el factor de escala con lo que cada vez podemos ver mayor del universo. En cambio, en un universo en expansión acelerada (abajo), la escala aumenta de manera exponencial mientras el universo observable aumenta de la misma manera que en el caso anterior. La cantidad de objetos que podemos ver disminuye con el tiempo y el observador termina por quedar aislado del resto del universo.

Cuando ( mucho tiempo ya) leí por primera vez acerca del universo inflacionario, experimenté dificultades para poder asimilar el índice de inflación. ¿No violaría un crecimineto tan rápido las reglas impuestas por la relatividad de Eintien que marcaban el límite de la velocidad en el de la luz en el vacío? Si un cuerpo material viajó de un extremo de una naranja a otro en 10-35 segundos, su velocidad excedió a la de la luz en una fracci´çon considerable.

Claro que, con esto pasar como ha pasado hace unos días con los neutrinos que, algunos decían haber comprobado que corrían más rápidos que la luz, y, sin embargo, todo fue un error de cálculo en el que no se tuvieron en algunos parámetros presentes en las mediciones y los aparatos que hacían las mismas. Aquí, podría pasar algo parecido y, la respuesta la podemos encontrar en aquella analogía con la masa de pan. Durante el período de inflación es el espacio mismo -la masa de pan- lo que está expandiéndose. Ningún cuerpo material (acordaos que en aquella masa estaban incrustadas las uvas que hacían de galaxias y, a medida que la masa se inflaba, las uvas -galaxias- se alejaban las unas de las otras pero, en realidad, ninguna de estas uvas se mueven, es la masa lo que lo hace.

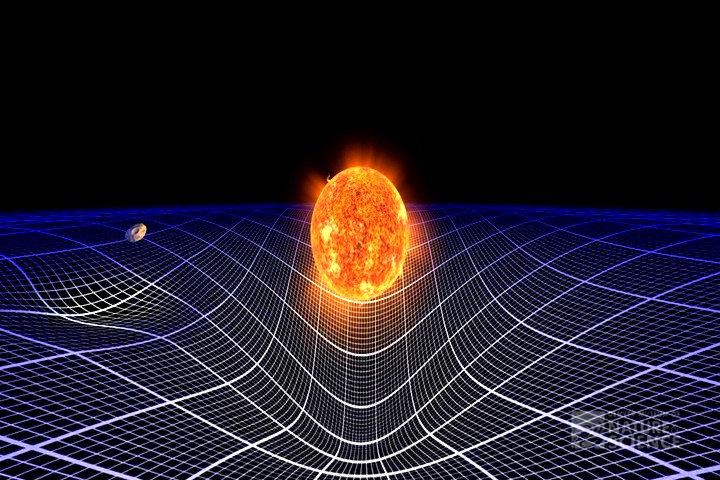

El Universo se expande

Las reglas contra los viajes a mayor velocidad que la de la luz sólo se aplican al movimiento del espacio. Así no hay contradicción, aunque a primera vista pueda parecer que sí. Las consecuencias del período de rápida expansión se pueden describir mejor con referencia a la visión einsteniana de la gravitación. de que el universo tuviera 10-35 segundos de edad, es de suponer que había algún tipo de distribucón de la materia. A cauda de esa materia, el espacio-tiempo tendrá alguna forma característica. Supongamos que la superficie estaba arrugada antes de que se produjera la inflación. Y, de esa manera, cuando comenzó a estirarse, poco a poco, tomó la forma que podemos detectar de “casi” plana conforme a la materia que contiene.

En todo esto, hay un enigma que persiste, nadie sabe contestar cómo, a pesar de la expansión de Hubble, se pudieron formar las galaxias. La pregunta sería: ¿Qué clase de materia estaba allí presente, que, la materia bariónica no se expandiera sin rumbo fijo por todo el universo y, se quedara el tiempo suficiente para formar las galaxias? Todo ello, a pesar de la inflación de la que hablamos y que habrái impedido su formación. Así que, algo tenía que existir allí que generaba la gravedad necesaria para retener la materia bariónica hasta que esta, pudo formar estrellas y galaxias.

No me extrañaria que, eso que llaman materia oscura, pudiera ser como la primera fase de la materia “normal” que, estándo en una primera fase, no emite radiaciones ni se deja ver y, sin embargo, sí que genera la fuerza de Gravedad para que nuestro Universo, sea tal como lo podemos observar.

En imagenes como , los “expertos” nos dicen cosas como:

“La materia oscura en la imagen de varias longitudes de onda de arriba se muestra en un falso color azul, y nos enseña detalles de como el cúmulo distorsiona la luz emitida por galaxias más distantes. En de gas muy caliente, la materia normal en falso color rojo, son fruto de los rayos-X detectados por el Observatorio de Rayois X Chandra que orbita alrededor de la Tierra.”

Algunas galaxias individuales dominadas por materia normal aparecen en colores amarillentos o blanquecinos. La sabiduría convencional sostiene que la materia oscura y la materia normal son atraídas lo mismo gravitacionalmente, con lo que deberían distribuirse homogéneamente en Abell 520. Si se inspecciona la imagen superior, sin embargo, se ve un sorprendente vacío de concentración de galaxias visibles a lo largo de la materia oscura. Una respuesta hipotética es que la discrepancia causada por las grandes galaxias experimentan algún de “tirachinas” gravitacional.

Una hipótesis más arriesgada sostiene que la materia oscura está chocándo consigo misma de alguna forma no gravitacional que nunca se había visto antes..? (esto está sacado de Observatorio y, en el texto que se ha podido traducir podemos ver que, los astrónomos autores de dichas observaciones, tienen, al , unas grandes lagunas y, tratándo de taparlas hacen aseveraciones que nada tienen que ver con la realidad).

Lo cierto es que, en el Universo, son muchas las cosas que se expanden y, pienso yo…¿Por qué no tratamos todos de expandir nuestras mentes? De esa manera, posiblemente podríamos llegar a comprender esos fenómenos que nos atormentan y a los que no podemos encontrar una explicación que podamos constatar.

¿Materia Oscura? Sí, Unicornios y Gárgolas, también.

emilio silvera

Mar

24

La simetría CP y otros aspectos de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

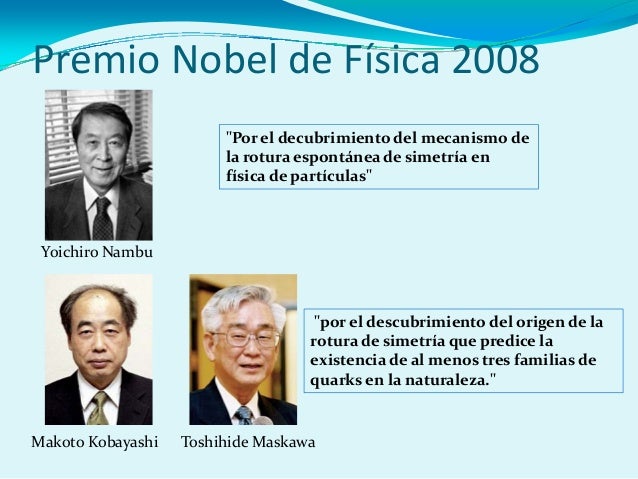

.. “Nature publica una recreación del experimento E122 de hace 35 años,” LCMF, 06 Feb 2014; “Los quarks se mueven al otro lado del espejo,” Agencia SINC, …

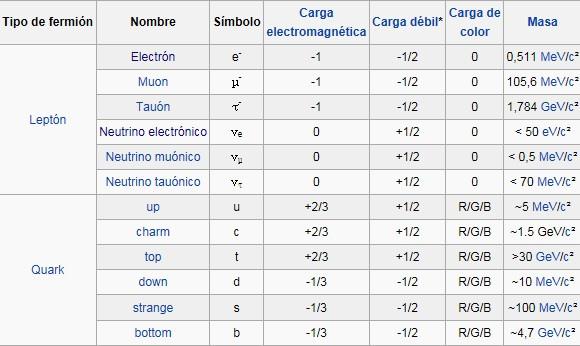

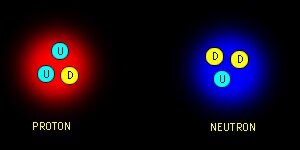

Los quarks al otro lado del espejo. También un Equipo de Científicos del Laboratorio Nacional Jefferson Lab (EEUU) han verificado la rotura de la simetría de paridad (también llamada simetría del espejo) en los quarks mediante el bombardeo de núcleos de deuterio con electrones de alta energía. Los núcleos de deuterio están formados por un protón y un neutrón, es decir, por tres quarks arriba y tres quarks abajo. La dispersión inelástica entre un electrón y un quark, es decir, su colisión, está mediada por la interacción electrodébil, tanto por la fuerza electromagnética como por la fuerza débil. Esta última es la única interacción fundamental que viola la simetría de paridad.

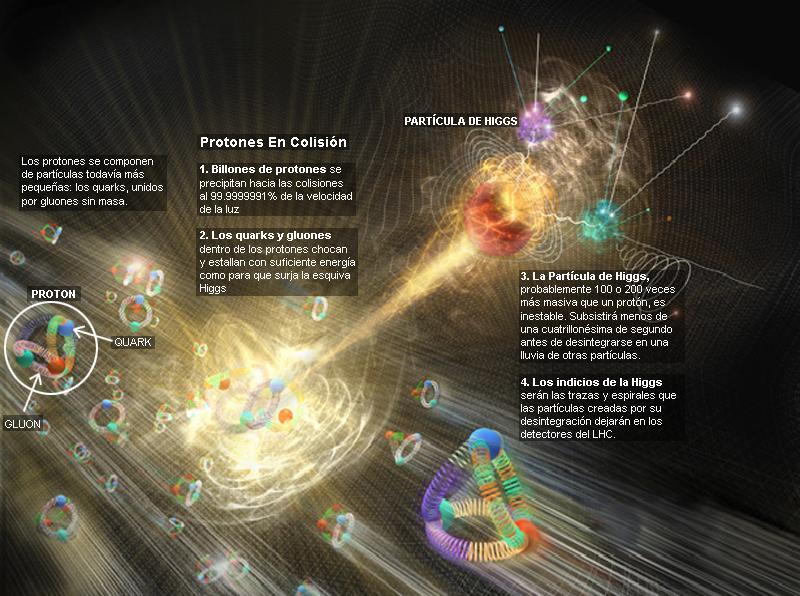

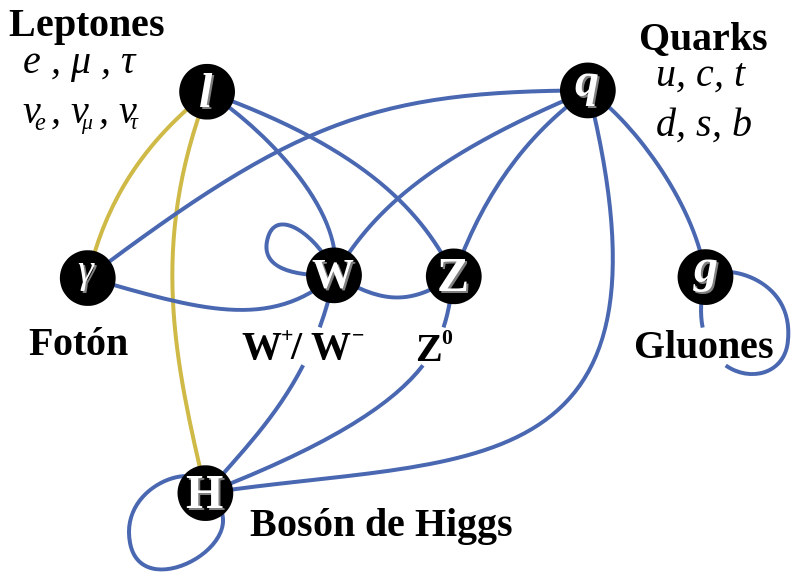

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y, lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar la coherencia matemática del modelo estándar. La idea de Higgs, y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19) que, el modelo estándar se mueve bajo nuestros pies.

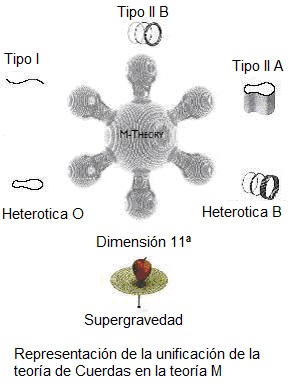

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

La Física nos lleva de vez en cuando a realizar viajes alucinantes. Se ha conseguido relacionar y vibrar a dos diamantes en el proceso conocido como entrelazamiento cuántico. El misterioso proceso, al que el propio Eisntein no supo darle comprensión completa, supone el mayor avance la fecha y abre las puertas de la computación cuántica. que nos hagamos una idea del hallazgo, en 1935 Einstein lo llegó a denominar la “acción fantasmal a distancia”. Un efecto extraño en donde se conecta un objeto con otro de manera que incluso si están separados por grandes distancias, una acción realizada en uno de los objetos afecta al otro.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado! Pero se sigue hablando de partículas supersimétricas.

¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intento calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni la nueva capacidad energético del acelerador de partículas LHC . Ni sumando todos los aceleradores de partículas de nuestro mundo, podríamos lograr una energía de Planck (1019 GeV), que sería necesaria para poder llegar hasta las cuerdas vibrantes de la Teoría. Ni en las próximas generaciones seremos capaces de poder utilizar tal energía.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Sabemos sobre las partíoculas elementales que conforman la materia bariónica, es decir, los átomos que se juntan para formar moléculas, sustancias y cuerpos… ¡La materia! Pero, no sabemos si, pudiera haber algo más elemental aún más allá de los Quarks y, ese algo, pudieran ser esas cuerdas vibrantes que no tenemos capacidad de alcanzar.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las Cuando su autor lanzó la idea al mundo, resultó además de nueva muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Con 7 TeV ha sido suficiente para encontrar la famosa partícula de Higgs pero…

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pietez Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas -Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa -los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una vez potente y segura nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmariana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la matería?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea una tributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron del “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs de masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acció la fuerzxa nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

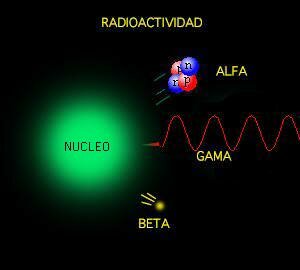

Las otras dos partículas que salen son un anti-electrón y un neutrino. Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

La interacción débil, recordareis, fue inventada por E.Fermin para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las hace incrementarse? ¿Y, cómo podemos saber más al respecto? Como s su partícula, nos cabe esperar que la veamos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal y como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de lo que un universo primitivo puso y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10′5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en este caso, a la partícula de Higgs que, algunos, han llegado a llamar, de manera un poco exagerada:

¡La partícula Divina! (Como la llamó Lederman en su libro).

¡Ya veremos en que termina todo esto! Y que explicación se nos ofrece desde el CERN en cuanto al auténtico escenario que según ellos, existe en el Universo para que sea posible que las partículas tomen su masa de ese oceáno de Higgs, en el que, según nuestro amigo Ramón Márquez, las partículas se frenan al interaccionar con el mismo y toman su masa, el lo llama el “efecto frenado”.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todos, exponer su teoría relativista. (Mach, Maxwell, Lorentz… y otros).

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental.

Ahora, por fin la tenemos con el LHC, y ésta pega, se la traspasamos directamente a la teoría de supercuerdas y a la materia oscura que, de momento, están en la sombra y no brillan con luz propia, toda vez que ninguna de ellas ha podido ser verificada, es decir, no sabemos si el Universo atiende a lo que en ellas se predice.

El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, llego a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo pudo surgir el Universo no dependen de que se encuentre el bosón de Higgso se averigue si realmente existe la materia oscura, Aunque sepamos llegar al fondo de la Teoría de Cuerdas y confirmarla, Poder crear esa Teoría cuántica de la Gravedad…Y, en fín, seguir descubriendo los muchos misterios que no nos dejan saber lo que el Universo es. Ahora, por fin, tenemos grandes aceleradores y Telescopisos con la energía necesaria y las condiciones tecnológicas suficientes para que nos muestre todo eso que queremos saber y nos digan dónde reside esa verdad que incansables perseguimos. Sin embargo, siempre seguiremos haciendo preguntas y siempre, también, serán insuficientes, los aparatos que podamos construir para que nos digan como es el Universo y cómo funciona la Naturaleza. Saberlo todo, nunca sabremos.

¡La confianza en nosotros mismos, no tiene límites! Pero, no siempre ha estado justificada.

emilio silvera

Mar

24

¡La Luz! Esa maravilla conformada por fotones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Cuántas maravillas! Y, nuestra Mente, entre ellas

Por último, el exceso de luz afecta a la flora y fauna nocturnas, que precisan de oscuridad desarrollar sus ciclos vitales. Las aves se deslumbran y desorientan, se alteran los períodos de ascenso y descenso del plancton marino, lo que repercute en la alimentación de otras especies; los insectos modifican sus ciclos reproductivos, aumentan el número de plagas en las ciudades… Se rompe, además, el equilibrio poblacional de las especies, porque algunas son ciegas a ciertas longitudes de onda de luz y otras no, con lo cual las depredadoras pueden prosperar mientras se extinguen las depredadas. Respecto a las plantas, se quedan sin insectos que las polinicen. Aunque no hay estudios concretos sobre el tema, se cree que falta de polinización podría influir en la productividad de algunos los cultivos. En definitiva, que no sabemos administrar lo que tenemos.

Todos sabemos lo importante que llegar a ser la luz en nuestras viviendas

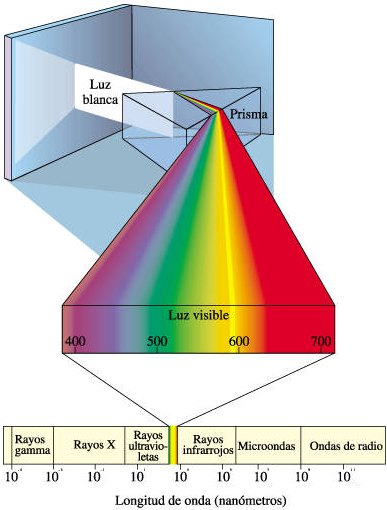

La luz es importante en nuestras vidas, tan importante que hasta hemos inventado luz artificial para alumbrar nuestras casas y ciudades y escapar de la fea oscuridad. Es una de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y sus contenidos.

Gracias a la luz podemos contemplar el Universo y todos los objetos que nos rodean

La velocidad finita de la luz fue sospechada por muchos experimentadores en óptica, pero fue establecida en 1.676, O. Roemer (1.644 – 1.710) la midió. Sir Isaac Newton (1.642 – 1.727) investigó el espectro óptico y utilizó los conocimientos existentes establecer una primera teoría corpuscular de la luz, en la que era considerada como un chorro de partículas que provocaban perturbaciones en el “éter” del espacio.

Mediante el sentido de la visión, podemos captar los objetos en los que ésta se refleja. La fuente principal de la luz que vemos es el sol y es el resultado de sumar todos los colores, manifestándose pues de color blanco. La luz blanca se separa en los colores que la componen cuando pasa a través de un prisma. La luz visible es sólo una pequeña del gran espectro electromagnético. Con lo cual, un haz de luz está compuesto por pequeños paquetes de energía, denominados cuantos de luz o fotones. Al igual que la luz blanca existen otros principios luminosos que a diferencia de éste no son blancos, la explicación de ello radicaría en que dependiendo de la forma en que fuente genere luz tendremos un color u otro. Por ejemplo, las lámparas incandescentes (tungsteno) muestran un color rojizo.

La luz artificial es imprescindible cuando la luz natural desaparece. Si en una habitación bien decorada no se han tomado en los cambios de luz, todo su encanto desaparece cuando la iluminación se torna deficiente.

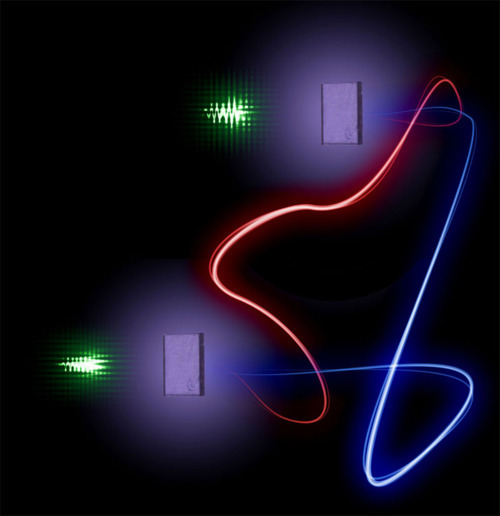

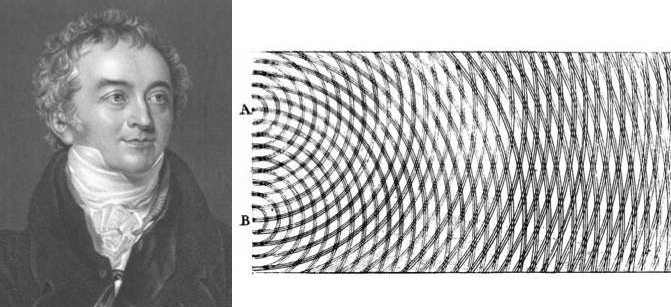

los años 1801 y 1803 Young presentó unos artículos ante la Royal Society exaltando la teoría ondulatoria de la luz y añadiendo a ella un concepto fundamental, el llamado principio de interferencia. Cuando se superponen las ondas provenientes de dos fuentes luminosas puntuales, sobre una pantalla colocada paralela a la línea de unión de los dos orificios, se producen franjas claras y oscuras regularmente espaciadas. Éste es el primer experimento en el que se demuestra que la superposición de luz producir oscuridad. Este fenómeno se conoce como interferencia y con este experimento se corroboraron las ideas intuitivas de Huygens respecto al carácter ondulatorio de la luz

Después de Newton, sucesores adoptaron los corpúsculos, pero ignoraron las perturbaciones con de onda hasta que Thomas Young (1.773 – 1.829) redescubrió la interferencia de la luz en 1.801 y mostró que una teoría ondulatoria era esencial para interpretar este tipo de fenómenos. Este punto de vista fue adoptado durante la mayor parte del siglo XIX y permitió a James Clerk Maxwell (1.831 – 1.879) mostrar que la luz forma parte del espectro electromagnético. En 1.905, Albert Einstein (1.879 – 1.955) demostró que el efecto fotoeléctrico sólo podía ser explicado con la hipótesis de que la luz consiste en un chorro de fotones de energía electromagnética discretos, esto es, pequeños paquetes de luz que él llamó fotones y que Max Planck llamó cuanto. renovado conflicto entre las teorías ondulatoria y corpuscular fue gradualmente resuelto con la evolución de la teoría cuántica y la mecánica ondulatoria. Aunque no es fácil construir un modelo que tenga características ondulatorias y cospusculares, es aceptado, de acuerdo con la teoría de Bohr de la complementariedad, que en algunos experimentos la luz parecerá tener naturaleza ondulatoria, mientras que en otros parecerá tener naturaleza corpuscular. Durante el transcurso de la evolución de la mecánica ondulatoria también ha sido evidente que los electrones y otras partículas elementales tienen propiedades de partícula y onda.

El fotón es una partícula con masa en reposo nula consistente en un cuanto de radiación electromagnética (cuanto de luz). El fotón también puede ser considerado una unidad de energía igual a hf, donde h es la constante de Planck y f es la frecuencia de radiación en hertzios. Los fotones viajan a la velocidad de la luz, es decir, a 299.792.458 metros por segundo. Son necesarios explicar (como dijo Einstein) el efecto fotoeléctrico y otros fenómenos que requieren que la luz tenga carácter de partícula unas veces y de onda otras.

– concepto de la estructura de la luz, es una onda y una partícula.

– Las partículas de luz son “cuantos de luz” o fotones.

– El átomo propiedades cuánticas, el electrón .

El artículo sobre el efecto fotoeleléctrico fue enviado por Einstein a la revista Annalen der Physik el 17 de marzo, recibido al siguiente día y publicado el 9 de junio de 1905. Más tarde, por importante contribución, Einstein sería galardonado con el Premio Nobel de Física de 1921.

El conocimiento de la luz (los fotones), ha permitido a la humanidad avances muy considerables en electrónica que, al sustituir los electrones por fotones (fotónica) se han construido dispositivos de transmisión, modulación, reflexión, refracción, amplificación, detección y guía de la luz. Algunos ejemplos son los láseres y las fibras ópticas. La fotónica es muy utilizada en telecomunicaciones, en operaciones quirúrgicas por láseres, en armas de potentes rayos láser y… en el futuro, en motores fotónicos que, sin contaminación, moverán nuestras naves a velocidades súper-lumínicas.

Tanto en medicina, trabajos industriales, o, en armamento, el láser es importante en nuestras vidas.

El electrón, otra partícula elemental importantísima todos nosotros y para el universo mismo, está clasificado en la familia de los leptones, con una masa en reposo (símbolo me) de notación numérica igual a 9’109 3897 (54) ×10-31 Kg y una carga negativa de notación numérica igual a 1´602 177 33 (49) x 10-19 coulombios. Los electrones están presentes en todos los átomos en agrupamientos llamados capas alrededor del núcleo; son arrancados del átomo se llaman electrones libres. La antipartícula del electrón es el positrón cuya existencia fue predicha por el físico Paúl Dirac. El positrón es un hermano gemelo del electrón, a excepción de la carga que es positiva.

El electrón fue descubierto en 1.897 por el físico Joseph John Thomson (1.856 – 1.940). El problema de la estructura (si es que la hay) del electrón no está resuelto; nuestras máquinas no tienen la potencia suficiente poder llegar, en el micromundo, a distancias infinitesimales de ese calibre. Si el electrón se considera una carga puntual su auto energía es infinita y surgen dificultades de la ecuación de Lorentz-Dirac.

Como lo queremos saber todo y llegar al fondo de todo, estamos intentando dividir el electrón, y, no creo que eso nos lleve a nada bueno. El electrón con su masa y su carga es esencial para la vida. ¡Dejemosló estar!

Es posible dar al electrón un tamaño no nulo con un radio r0 llamado el radio clásico del electrón, dado por ro = e2/(mc2) = 2’82×10-13 cm, donde e y m son la carga y la masa, respectivamente, del electrón y c es la velocidad de la luz. modelo también tiene priblemas como la necesidad de postular las tensiones de Poincaré.

Se cree que los problemas asociados con el electrón deben ser analizados utilizando electrodinámica cuántica en vez de electrodinámica clásica.

El electrón es uno de los miembros de la familia de leptones: electrón (e), muón (μ), tau (τ) con sus correspondientes neutrinos asociados electrónico, muónico y tauónico.

Un equipo de físicos de las Universidades de Cambridge y de Birmingham ha demostrado que los electrones, que por separado son indivisibles, pueden dividirse en dos partículas nuevas llamadas espinones y holones, se concentran dentro de un estrecho cable. ¡Qué cosas!

Las tres partículas, electrón, muón y tau, son exactas, excepto en sus masas. El muón es 200 veces más masivo que el electrón. La partícula tau es unas 35.600 veces más masiva que el electrón. Los leptones interaccionan por la fuerza electromagnética y la interacción débil. cada leptón hay una antipartícula equivalente de carga opuesta ( explicamos antes, el positrón es la antipartícula del leptón electrón). Los antineutrinos, como los neutrinos, no tienen carga.

La interacción electromagnética es la responsable de las fuerzas que controlan las estructuras atómicas, las reacciones químicas y todos los fenómenos electromagnéticos. explicar las fuerzas entre las partículas cargadas pero, al contrario que las interacciones gravitacionales, pueden ser tanto atractivas como repulsivas (probar con imanes como las fuerzas desiguales y contrarias – positiva/negativa – se atraen, mientras que cargas iguales – negativa/negativa o positiva/positiva – se repelen).

Un equipo de físicos de las Universidades de Cambridge y de Birmingham ha demostrado que los electrones, que por separado son indivisibles, pueden dividirse en dos partículas nuevas llamadas espinones y holones, se concentran dentro de un estrecho cable.

Algunas partículas neutras se desintegran por interacciones electromagnéticas. La interacción se interpretar tanto como un campo clásico de fuerzas (Ley de Coulomb) como por el intercambio de fotones virtuales. Igual que en las interacciones gravitatorias, el hecho de que las interacciones electromagnéticas sean de largo alcance significa que tienen una teoría clásica bien definida dadas por las ecuaciones de Maxwell. La teoría cuántica de las interacciones electromagnéticas se describen (como antes dije) con la electrodinámica cuántica. fuerza tiene una partícula portadora, el fotón.

Todos oímos con frecuencia la palabra “electrónica”, pero pocos pensamos que estamos hablando de electrones en diseños de dispositivos de control, comunicación y computación, basándose en el movimiento de los electrones en circuitos que contienen semiconductores, válvulas termoiónicas, resistencias, condensadores y bobinas y en la electrónica cuántica1 aplicada a la óptica, se han conseguido verdaderas maravillas que han facilitado grandes avances tecnológicos de distintas aplicaciones como la investigación o la medicina y la cirugía, otros.

Este pequeño comentario sobre la electrónica y la fotónica que antes habéis leído, demuestra cómo el conocimiento y sobre estos dos pequeñísimos objetos, el fotón y el electrón, nos ha dado unos beneficios increíbles.

|

Los Quarks están confinados en el núcleo del átomo formando protones y neutrones. La Fuerza nuclear fuerte los retiene que no se puedan separar los unos de los otros a más distancia de la que es necesaria para mantener la estabilidad y, se les consiente lo que se denomina libertad asintótica de los Quarks.

Existen otras partículas aún más diminutas que, en realidad, podríamos decir que son los auténticos ladrillos de la materia, los objetos más pequeños que la conforman: los quarks.

En la antigua Grecia, sabios como Demócrito, Empédocles, Thales de Mileto o Aristóteles, ya sospecharon de la existencia de pequeños objetos que se unían para formar materia. Demócrito de Abdera decía que todo estaba formado por pequeños objetos invisibles e indivisibles a los que llamaba a-tomo o átomos (en griego significa “indivisibles”).

Pasaron muchos años de controversia sobre la existencia de los átomos y, en 1.803, el químico y físico británico John Dalton señaló que los compuestos físicos se combinaban para, en ciertas proporciones, formar agrupamiento de átomos para formar unidades llamadas moléculas.

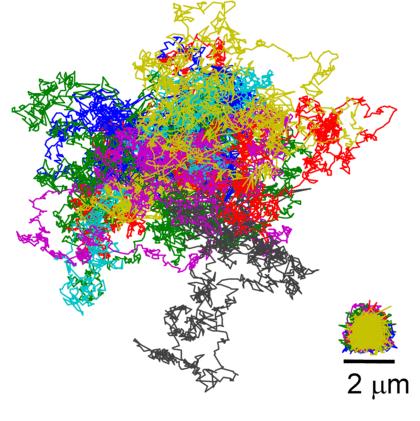

En 1.905 llegó Einstein dar una de las evidencias físicas más importante de la existencia de los átomos, al señalar que el fenómeno conocido como movimiento browniano – el movimiento irregular, aleatorio de pequeñas partículas de polvo suspendidas en un líquido – podía ser explicado por el efecto de las colisiones de los átomos del líquido con las partículas de polvo.

Por aquella época ya había sospechas de que los átomos no eran, después de todo, indivisibles. Hacía varios que J. J. Thomson, de Cambridge, había demostrado la existencia de una partícula material, el electrón, que tenía una masa menor que la milésima de la masa del átomo más ligero. Se comprendió que estos electrones debían provenir de los átomos en sí. Y, en 1.911, el físico británico Ernest Rutherford mostró finalmente que los átomos de la materia tienen verdaderamente una estructura interna: están formados por un núcleo extremadamente pequeño y con carga positiva, alrededor del cual gira un cierto de electrones.

En 1.932, un colega de Rutherford, James Chadwick, descubrió también en Cambridge que el núcleo contenía otras partículas, llamadas neutrones, que tenían casi la misma masa del protón que una carga positiva igual en magnitud a la del electrón que es negativa, con lo cual, como todos los núcleos tienen el mismo de protones que de electrones hay en el átomo, el equilibrio de éste queda así explicado: carga positiva similar a carga negativa = a estabilidad en el átomo.

emilio silvera

Totales: 75.493.126

Totales: 75.493.126 Conectados: 53

Conectados: 53