Mar

9

¿Ondas Gravitacionales? Veremos que dicen los datos futuros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ondas gravitacionales ~

Clasificado en Ondas gravitacionales ~

Comments (1)

Comments (1)

Kip Thorne es uno de los mayores expertos en agujeros negros del mundo. Desde ayer, también es un claro favorito al Nobel de Física. En los años setenta fue a contracorriente de la mayoría de la comunidad astronómica mundial. Al contrario que ellos, que se volcaban en el desarrollo de telescopios ópticos para captar la luz en todas sus longitudes de onda, él propuso una nueva forma de observar el cosmos, más bien de escucharlo, a través de las ondas gravitacionales. Este físico teórico ha desarrollado la mayor parte de su carrera en Caltech, donde impulsó la construcción del Observatorio de Interferometría Láser de Ondas Gravitacionales (LIGO) junto a Ronald Drever, también de Caltech, y Rainer Weiss, del MIT. Además, es una estrella de la divulgación -fue asesor científico de Interstellar– y prepara otra película con Stephen Hawking.

MÁS INFORMACIÓN

- Las ondas gravitacionales de Einstein, últimas noticias

Ayer Thorne habló con EL PAÍS al teléfono desde Washington, donde presentó al mundo la primera detección de una onda gravitacional y el comienzo de esa nueva era de la astronomía que impulsó hace cuatro décadas.

¿Cómo se enteró del descubrimiento?

Estaba trabajando en casa por la mañana del 14 de septiembre y me mandaron un correo para que mirara la web interna de LIGO. Allí se almacenan automáticamente los resultados del experimento. Recibe los datos de Hanford y Luisiana [lugar de los dos detectores] y hace un gráfico de las frecuencias recibidas. Y en las detecciones de ambos sitios vi lo que llamamos una señal de pitido cuya frecuencia aumenta con el tiempo. Era exactamente la señal que esperábamos que produjeran las ondas gravitacionales. La miré y dije, “Dios mío, probablemente la tenemos, esto es demasiado bueno para ser verdad”.

Era exactamente la señal que esperábamos que produjeran las ondas gravitacionales. La miré y dije, “Dios mío, probablemente la tenemos, esto es demasiado bueno para ser verdad”

¿Cómo se siente tras este hallazgo?

La mayoría de los que han participado en la detección dicen que están entusiasmados. En mi caso, es un sentimiento de profunda satisfacción. He trabajado muy duro desde los años setenta, tanto en la construcción de LIGO como en el desarrollo de las simulaciones, para entender lo que vemos y que han jugado un papel fundamental.

¿Por qué son tan importantes estas ondas?

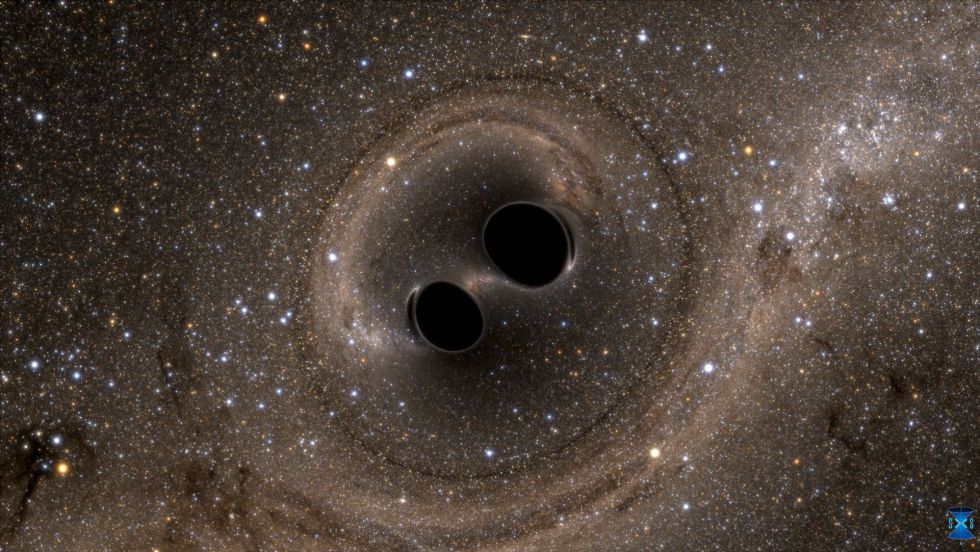

Son importantes por el futuro al que nos llevan. Por un lado hoy [por ayer] hemos hecho muchos descubrimientos pioneros. La primera detección de ondas gravitacionales llegando a la Tierra, la primera observación de dos agujeros negros chocando y uniéndose para crear uno nuevo, las simulaciones del evento, que nos permiten observar por primera vez cómo se comporta el espacio y el tiempo cuando ambos están oscilando de forma salvaje igual que en una tempestad en el océano.

Pero lo más importante es que se abre la observación humana a un nuevo tipo de radiación. Todo lo que hemos hecho hasta ahora esencialmente se basa en ondas electromagnéticas. Ahora accedemos a otro tipo de radiación completamente nuevo. En las próximas dos décadas vamos a ver el mismo desarrollo que en la astronomía convencional, comprenderemos cuatro tipos de ondas gravitacionales con diferentes periodos de oscilación y cada una nos dirá cosas muy diferentes del universo. Las ondas que hemos visto oscilan en periodos de milisegundos. Pero usando LISA, que será una antena espacial, algo así como LIGO en el espacio, vamos a captar periodos que son 1.000 veces más largos, de minutos a horas. Vamos a ver incluso periodos de años y décadas. Vamos a ver la marca que dejan en el cielo ondas que tienen periodos de miles de millones de años. Vamos a ver muchas cosas que no habíamos visto antes, y esto sucederá en las próximas dos décadas.

Vamos a ver muchas cosas que no habíamos visto antes, y esto sucederá en las próximas dos décadas

¿Quién debe recibir el crédito por este hallazgo?

El crédito es de los jóvenes científicos experimentales que han sacado este experimento adelante. Tanto en diseño, como en construcción, como en el análisis de datos. Es su descubrimiento.

¿Cree que le darán el Nobel?

No. El Premio Nobel debe ser para los grandiosos físicos experimentales que han hecho este descubrimiento, especialmente para Rai Weiss, el principal inventor de los interferómetros de LIGO. Él ha sido el líder intelectual de este esfuerzo durante 45 años, desde el principio hasta hoy.

¿Cómo sería estar cerca del evento que han observado?

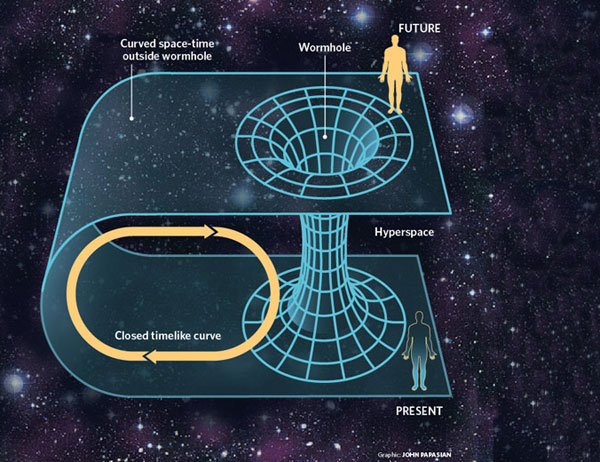

Verías el tiempo acelerándose y atrasándose, verías el espacio estirarse y contraerse de forma muy violenta. Viajarías en el tiempo de alguna forma porque el tiempo correría hacia adelante más lento de lo normal y luego mucho más rápido, todo de forma salvaje. Es un evento muy breve solo dura una fracción de segundo. Así que lo que necesitamos es enviar un robot que pueda captarlo todo muy rápido. Nadie sobreviviría a un evento como este.

Fuente: El País

Mar

8

Antimateria y otros enigmas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (6)

Comments (6)

En cualquier sitio que busquemos datos para saber sobre la antimateria, nos podemos encontrar con explicaciones como ésta:

“En física de partículas, la antimateria es la extensión del concepto de antipartícula a la materia. Así, la antimateria está compuesta de antipartículas, mientras que la materia ordinaria está compuesta de partículas. Por ejemplo, un antielectrón (un electrón con carga positiva, también llamado positrón) y un antiprotón (un protón con carga negativa) podrían formar un átomo de antimateria, de la misma manera que un electrón y un protón forman un átomo de hidrógeno. El contacto de materia y antimateria llevaría a la aniquilación de ambas, dando lugar a fotones de alta energía (rayos gamma) y otros pares partícula-antipartícula.”

Lo cierto es que solo vemos materia

“La desconcertante prevalencia de la materia sobre la antimateria en el universo podría estar relacionado con un extraño estiramiento del espacio-tiempo causado por el giro de nuestra galaxia, según un nuevo estudio”.

De tonterias como esa están las revistas científicas llenas. Ya no saben lo que hacer por llamar la atención y, en cualquier mente lógica medianamente “leída”, se puede llegar a la conclusión de que, como en el Universo todo es cuestión de equilibrios entre fuerzas contrapuestas, mejor sería pensar en la existencia de un universo paralelo de antimateria.

La antimateria es el pariente primo de la materia. Por cada partícula de materia se cree que existe su pareja de antimateria, con la misma masa, pero de carga opuesta. Cuando la materia y la antimateria se encuentran, se aniquilan, y de la conversión de su masa en energía resulta una poderosa explosión.

Aunque hoy en día, los científicos siguen sin entender por qué en el universo predomina, casi completamente la materia. De hecho, aunque la han buscado con insistencia, la antimateria del universo primordial…no aparece por ninguna parte.

Según todos los estudios de experimentos y observaciones que han sido llevados a la práctica por Equipos de estudiosos en todo el Mundo, parece ser que, los motivos por los que no se han encontrado grandes estructuras de antimateria en nuestro Universo, y, el hecho de que la Materia supere a la antimateria, es denominado como “Bariogénesis”, es decir, la Materia Bariónica que es la que observamos y emite radiación (Planetas, estrellas, galaxias, etc.) es la que, finalmente, ha quedado predominando en este Universo nuestro (dejando a un lado esa otra clase de materia que llamamos Oscura y que, de ser cierto que existe, debió crearse antes que la Bariónica, sería la primera clase de materia que hizo acto de presencia en el Universo y, la Fuerza de Gravedad que generaba, hizo posible que, a pesar de la expansión de Hubble, se formaran las estrellas y las galaxias.

¿Por qué en el comienzo del Universo podría la materia Bariónica superar a la antimateria?

–Pequeño exceso de materia tras el Bib Bang: Especula con que la materia que forma actualmente el universo podría ser el resultado de una ligera asimetría en las proporciones iniciales de ambas.

–Asimetría CP. Un reciente experimento en el acelerador KEK de Japón sugiere que esto quizás sea cierto, y que por tanto no es necesario un exceso de materia en el Big Bang: simplemente las leyes físicas que rigen el universo favorecen la supervivencia de la materia frente a la antimateria.

–Existencia de galaxias de antimateria ligada por antigravedad: Muy pocos científicos confían en esta posibilidad, pero todavía no ha podido ser completamente descartada. Esta tercera opción plantea la hipótesis de que pueda haber regiones del universo compuestas de antimateria. Hasta la fecha no existe forma de distinguir entre materia y antimateria a largas distancias, pues su comportamiento y propiedades son indistinguibles. (Esta opción parece poco probable).

La ecuación de Dirac, formulada en en 1928, predijo la existencia de antipartículas además de las partículas de materia ordinarias. Desde entonces, se han ido detectando experimentalmente muchas de dichas antipartículas: Carl D. Anderson, en el Caltech, descubrió el positrón en 1932. Veintitrés años después, en 1955, Emilio Sègre y Owen Chamberlain, en la universidad de Berkeley, el antiprotón y antineutrón.

Pero la primera vez que se pudo hablar propiamente de antimateria, es decir, de “materia” compuesta por antipartículas, fue en 1965, cuando dos equipos consiguieron crear un antideuterón, una antipartícula compuesta por un antiprotóny un antineutrón. La antipartícula fue lograda en el Acelerador Protón Sincrotrón del CERN, a cargo de Antonio Zichichi, y paralelamente por Leon Lederman en el acelerador AGS (Alternating Gradient Synchrotron) del Laboratorio Nacional de Brookhaven, en Nueva York.

En 1995, el CERN anunció la creación de nueve átomos de antihidrógeno en el experimento PS210, liderado por Walter Oelert y Mario Macri, y el Fermilab confirmó el hecho, anunciando poco después la creación a su vez de 100 átomos de antihidrógeno.

El 14 de Diciembre de 2.009, científicos de la NASA con la ayuda del telescopio espacial de rayos gamma Fermi, descubrieron rayos de antimateria producidos encima de tormentas eléctricas. El fenómeno es causado por ráfagas de rayos gamma terrestres (TGF) generadas al interior de las tormentas eléctricas y asociados directamente con los relámpagos.

La antimateria es un término que se ha hecho muy común y familiar en los últimos años, y, han sido muchos los que han tratado de buscarla en los confines del Universo. No parece que el resultado obtenido sea muy alentador.

Se ha logrado capturar partículas de antimateria en los Aceleradores de partículas y, con ellas, se han realizado pruebas que han venido a confirmar que, cuanto la Materia se encuentra con la antimateria, la destrucción está asegurada. El resultado de dicha colisión podrían ser muchas de las grandes fuentes de energía Gamma que se han detectado en algunas regiones del Universo.

He aquí la primera imagen jamás obtenida de antimateria, específicamente un “anti-átomo” de anti-hidrógeno. Este experimento se realizó en el Aparato ALPHA de CERN, en donde los anti-átomos fueron retenidos por un récord de 170 milisegundos (se atraparon el 0.005% de los anti-átomos generados).

Producir antipartículas es relativamente “fácil”. De hecho ocurre habitualmente en la naturaleza, en un tipo de desintegración radioactiva denominada “desintegración beta”. También se producen con los rayos cósmicos, que son partículas de altas energías que llegan a la atmósfera y al interaccionar con ella se producen cascadas de partículas.

Pero producir antiátomos es mucho muy difícil, y almacenarlos todavía más. Generar estructuras más complejas, como una mesa de antimateria, actualmente es imposible y de momento no conocemos ninguna forma para poderlo hacer en el futuro.

A finales de 2009 años fuimos testigos de la explosión más grande jamás registrada: una estrella supergigante en el límite posible de la masa permitida, muchas veces más grande que el Sol completamente destruida por reacciones termonucleares increiblemente veloces provocada por la producción de antimateria de rayos gamma. La explosión resultante fue visible durante meses, ya que desató una nube de material radiactivo más de cincuenta veces el tamaño de nuestra propia estrella, dándole un resplandor visible a partir de la fisión nuclear y a pesar de la distancia a la que se hallaba situada la galaxia portadora de la estrella.

Desde nuestra madre Tierra, el cielo nocturno puede parecer tranquilo e inmutable, pero el universo visto en rayos gamma es un lugar de violencia repentina y caótica. Utilizando telescopios sensibles a los rayos gamma, los astrónomos son testigo de explosiones breves pero tremendamente intensas, llamadas explosiones de rayos gamma. No existe nada más potente. Cuando se produce encuentros entre Marteria y Anti-materia, aparecen las fuentes de energías más potentes conocidas en el Universo.

Si cuando se produjo el Big Bang, la creación de materia y antimateria hubiera sido simétrico, ahora, la materia bariónica que forman los objetos que podemos contemplar, no existiría y se habría destruido mediante la interacción de ambos tipos de materia. Sin embargo, al parecer, en el reparto que hizo la Naturaleza, la mayor parte le tocó a la Materia y, de ahí que, cuando se destruyó toda la materia y antimateria que suponía la misma proporción, quedó el exceso existente de Materia que es, precisamente, la que forma las estrellas y los mundos.

A la existencia de la antimateria, llegó Paul Dirac, mediante modelos matemáticos teóricos. Este es otro ejemplo de modelos matemáticos que predicen lo que no conocemos y, cuando en las ecuaciones salta alguna sorpresa como aquella, los físicos se lanzan como locos en su búsqueda.

Nunca, por uno u otro Organismo, se ha dejado de buscar la antimateria en el Universo, y, los escasos resultados obtenidos hasta el momento son, hasta cierto punto comprensibles, toda vez que, si como se cree, la mayor parte fue eliminada al encontrarse con la materia, los residuos que puedan estar ahí, teniendo en cuenta las dimensiones del Universo, no serán fáciles de encontrar.

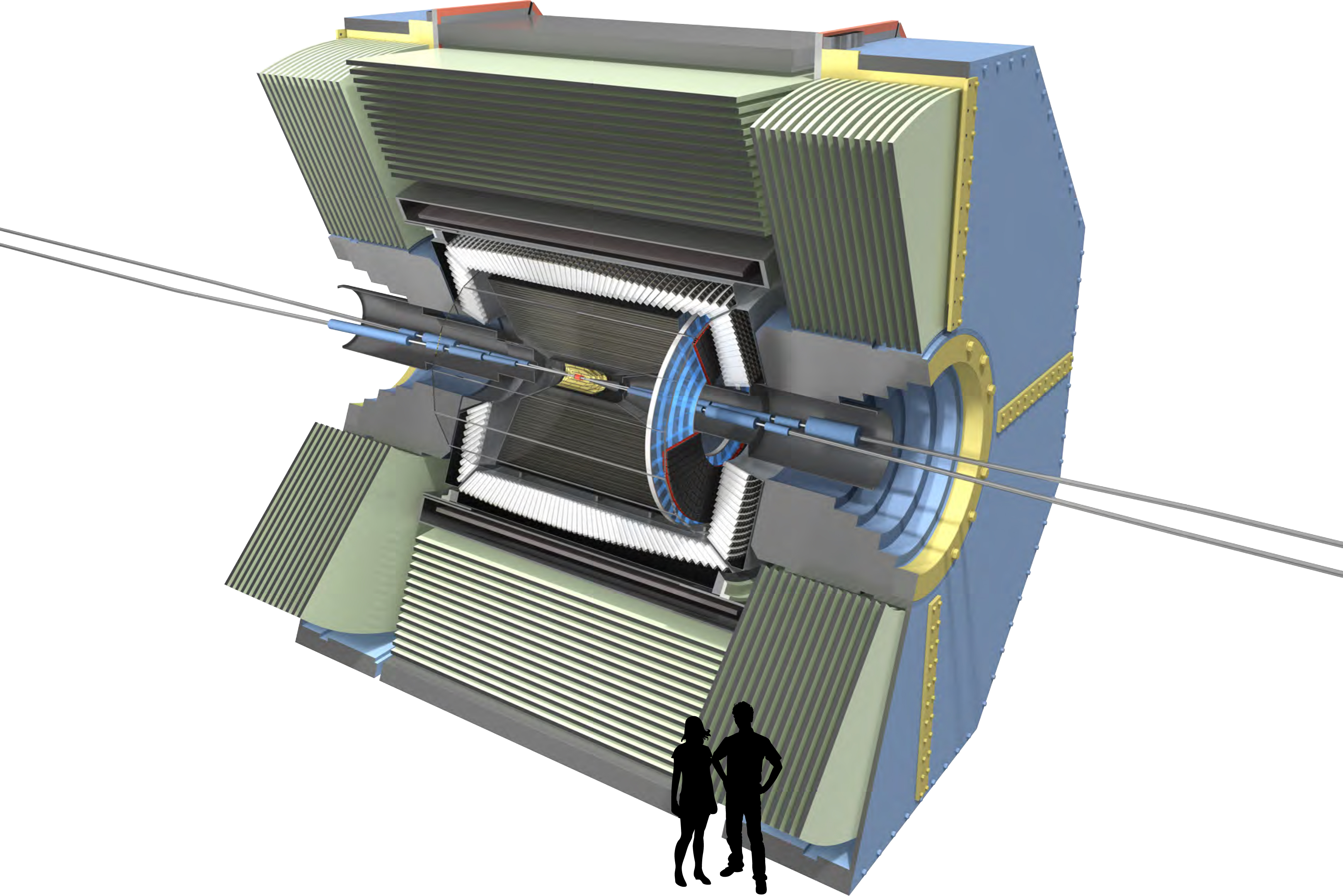

“El Premio Nobel de Física en 1976 Samuel Ting ha expresado su esperanza de que el experimento que lleva a cabo el laboratorio europeo de partículas Cern y su proyecto de enviar un gran imán al espacio permitan descubrir donde se esconde la antimateria en el universo. El gran colisionador de hadrones (LHC) del Cern, ha lñogrado en sus experimentos reproducir en laboratorio un mini Big-Bang similar al que podría haber dado origen al Universo hace unos 13.700 millones de años, a base de iones de plomo, lo que ha generado una especie de sopa o plasma de quarks y gluones que ahora los científicos tratan de analizar.

Ting, que colabora con el Cern, lideró por su parte una iniciativa para colocar en órbita el espectómetro magnético Alfa (AMS, de sus siglas en inglés), un gran imán que sería situado en órbita espacial con el objetivo de detectar la presencia de antimateria en otras galaxias. “Encontrar antimateria sería muy importante porque permitiría destruir muchas de las teorías actuales”, dijo el investigador estadounidense, que ha sido invitado por el programa ConCiencia de la Universidad de Santiago de Compostela (USC) a una serie de conferencia y actos de divulgación científica. En una conferencia de prensa, Ting aseguró que “el tiempo no es importante” para descubrir dónde se encuentra la antimateria producto de la explosión al origen del Universo, aunque precisó que el AMS estará “durante 20 años” analizando su presencia entre las cien millones de galaxias que calcula que lo integran.”

Bueno, de todas las maneras, esperemos que, si algún día encontramos abundancia de antimateria en el Universo, no sea utilizada para prácticas militares. Por otra parte, como la antimateria es exactamente igual que la materia a excepción de las cargas que son opuestas (electrón-positrón), esperemos que no existan mundos de antimateria con seres que lo pueblen, ya que, si alguna vez nos encontramos con alguno, lo mejor será no saludarlo con un apretón de manos.

Físicos de Estados Unidos y Canadá, propusieron una nueva partícula que podría resolver dos importantes misterios de la física moderna: ¿Qué es la materia oscura y por qué hay mucha más materia que antimateria en el universo?

La aún por descubrir “partícula X”, se espera que decaiga mayormente en materia normal, mientras que su antipartícula se espera que decaiga mayormente en antimateria “oculta”. El equipo afirma que su existencia en los inicios del universo podría explicar por qué hay más materia que antimateria en el universo – y que la materia oscura es, de hecho, antimateria oculta.

Como podreis ver, por teorizar, especular, lanzar hipótesis y exponer cuestiones imaginativas…Que no quede. Todos tenemos nuestras propias ideas y, desde luego, no siempre van encaminadas en la dirección correcta. ¿Partícula X? ¿Qué está pasando? ¿De qué estamos hablando?

Lo cierto es que el Universo sabe muy bien como tenernos entretenidos.

emilio silvera

Mar

8

La Biología en la Tierra ¡Qué maravilla!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Biologia ~

Clasificado en Biologia ~

Comments (0)

Comments (0)

Hablamos de Agujeros de Susano y otros temas similares, o, de Universos paralelos, siempre pensando en que el nuestro, nuestro Universo y primero nuestro mundo, llegará a su fin. Es necesario que los científicos piensen en estas cosas para solucionar los problemas del futuro y cuándo llegue el momento, salir de las encrucijadas a las que, irremediablemente, estamos destinados.

La gente corriente no piensa en estas cuestiones; su preocupación es más cercana y cotidiana, la hipoteca del piso o los estudios de los niños y, en la mayoría de los casos, lo “importante es el fútbol” para evadirse dicen algunos. Es una lástima, pero así son las cosas. No se paran ni a pensar cómo se forma una estrella, de qué está hecha y por qué brilla. Nuestro Sol, por ejemplo, es una estrella mediana, amarilla, del Grupo G-2, ordinaria, que básicamente consume hidrógeno y como en el Big Bang original, lo fusiona en helio. Sin embargo, puesto que los protones en el hidrógeno pesan más que en el helio, existe un exceso de masa que se transforma en energía mediante la fórmula de Einstein E = mc2. Esta energía es la que mantiene unidos los núcleos. Esta es también la energía liberada cuando el hidrógeno se fusiona para crear helio. Esta, al fin, es la razón de que brille el Sol.

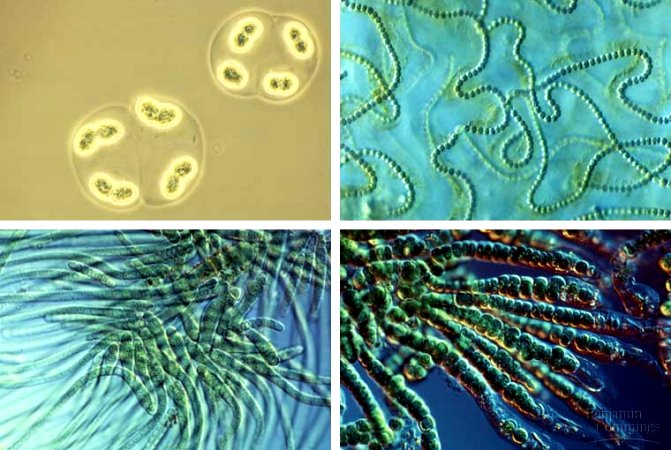

Se denominan autótrofos por que generan su propio alimentos, atraves de sustancias inorganicas para su metabolismo. Los organismos autótrofos producen su masa celular y materia orgánica, a partir del dióxido de carbono, que es inorgánico, como única fuente de carbono, usando la luz o sustancias químicas como fuente de energía. Las plantas y otros organismos que usan la fotosíntesis son fotolitoautótrofos; las bacterias que utilizan la oxidación de compuestos inorgánicos como el anhídrido sulfuroso o compuestos ferrosos como producción de energía se llaman quimiolitotróficos.

Los órganos autótrofos son los que producen el alimento de esos seres. Los seres autótrofos son una parte esencial en la cadena alimenticia, ya que absorben la energía solar o fuentes inorgánicas como el dióxido de carbono y las convierten en moléculas orgánicas que son utilizadas para desarrollar funciones biológicas como su propio crecimiento celular y la de otros seres vivos llamados heterótrofos que los utilizan como alimento. Los seres heterótrofos como los animales, los hongos, y la mayoría de bacterias y protozoos, dependen de los autótrofos ya que aprovechan su energía y la de la materia que contienen para fabricar moléculas orgánicas complejas. Los heterótrofos obtienen la energía rompiendo las moléculas de los seres autótrofos que han comido. Incluso los animales carnívoros dependen de los seres autótrofos la energía y su composición orgánica obtenida de sus presas procede en última instancia de los seres autótrofos que comieron sus presas. también se pueden clasificar en: fotosintéticos y quimiosintéticos.

Los seres autótrofos siguen dos vías diferentes para transformar la biomasa que ingieren en los compuestos complejos de los que se componen sus tejidos. Esta transformación puede ser mediante fermentación anaeróbica o a través de respiración aeróbica. La primera vía se restringe a las células procariotas simples, como las fermentadoras, las bacterias metanogénicas y los hongos Ascomycota responsables de la fermentación del etanol (alcohol etílico). La segunda vía se hizo posible a partir del momento en que la cantidad de oxígeno atmosférico, generado por los vegetales, alcanzó un nivel suficientemente alto como para que algunos seres procariotes pudieran utilizar la respiración aeróbica para generar trifosfato de adenosina más eficientemente que por fermentación. Desde un punto de vista energético, la oxidación es claramente ventajosa. Así, por cada mol de glucosa se liberan 197 KJ por fermentación en ácido láctico, 232 KJ por fermentación alcohólica y 2’87 MJ por la oxidación completa, lo que representa para esta última una ganancia que está comprendida entre 12 y 14 veces.

Reino Monera (Bactérias, Cianobactérias)

Está formado por bacterias y cianobacterias (algas azules). Pueden vivir en diversos lugares, tales como agua o aire y en el interior de los animales y plantas como parásitos. La mayoría de sus representantes son heterótrofas (no pueden producir su propio alimento), pero también hay algunas autótrofas (producen sin alimentos, por ejemplo a través de la fotosíntesis). Existen también bacterias aerobias es decir, que necesitan oxígeno para vivir, el requisito de anaerobios, que no pueden vivir en presencia de oxígeno, y anaerobios facultativos, que pueden vivir tanto en ambientes oxigenados como en ambientes no oxigenados. La forma física de las bacterias pueden ser de cuatro tipos: cocos, bacilos, vibriones y espirilos. Los cocos pueden unirse y formar colonias. Grupos de dos cocos forman diplococos, alineados forman estreptococos y en grupos forman una infección de estafilococos.

Por ser los seres vivientes más primitivos en la Tierra, son también los que están en mayor número. Por ejemplo, en un gramo de tierra fértil pueden haber cerca de 2,5 mil millones de bacterias, en hongos 400.000 y en algas y protozoos entre 30.000 y 50.000.

Con un microscopio electrónico podremos llegar muy lejos en el universo de lo muy pequeño.

La importancia de las bacterias

Las bacterias también tienen su importancia en el medio ambiente, así como cualquier ser vivo. Describamos algunos papeles fundamentales.

- Descomposición: Actúan en el reciclaje de la materia, devolviendo al ambiente moléculas y elementos químicos para ser re-utilizados por otros seres vivos.

- Fermentación: algunas bacterias se utilizan en las industrias para producir yogurt, queso, etc (lácteos).

- Industria farmacéutica: para la fabricación de antibióticos y vitaminas.

- Industria química: para la producción de alcoholes como el metanol, etanol, etc.

- Genética: mediante la alteración de su ADN, podemos hacer productos de interés para los seres humanos, como la insulina.

- Determinación de nitrógeno: permite eliminar el nitrógeno del aire y tirado en el suelo, que sirve como alimento para las plantas.

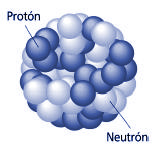

Todo eso es posible como consecuencia de que en el núcleo de un átomo existen fuerzas (fuerzas nucleares) que mantienen los protones y neutrones ligados. Estas fuerzas deben ser suficientemente grandes para contrabalancear las repulsiones eléctricas resultantes de la carga positiva de los protones. La Simetría que está presente en los átomos hace que, la evolución bioquímica hiciera posible la presencia de estos ininitesimales seres que, evolucionaron hasta lo que hoy podemos ver a nuestro alrededor.

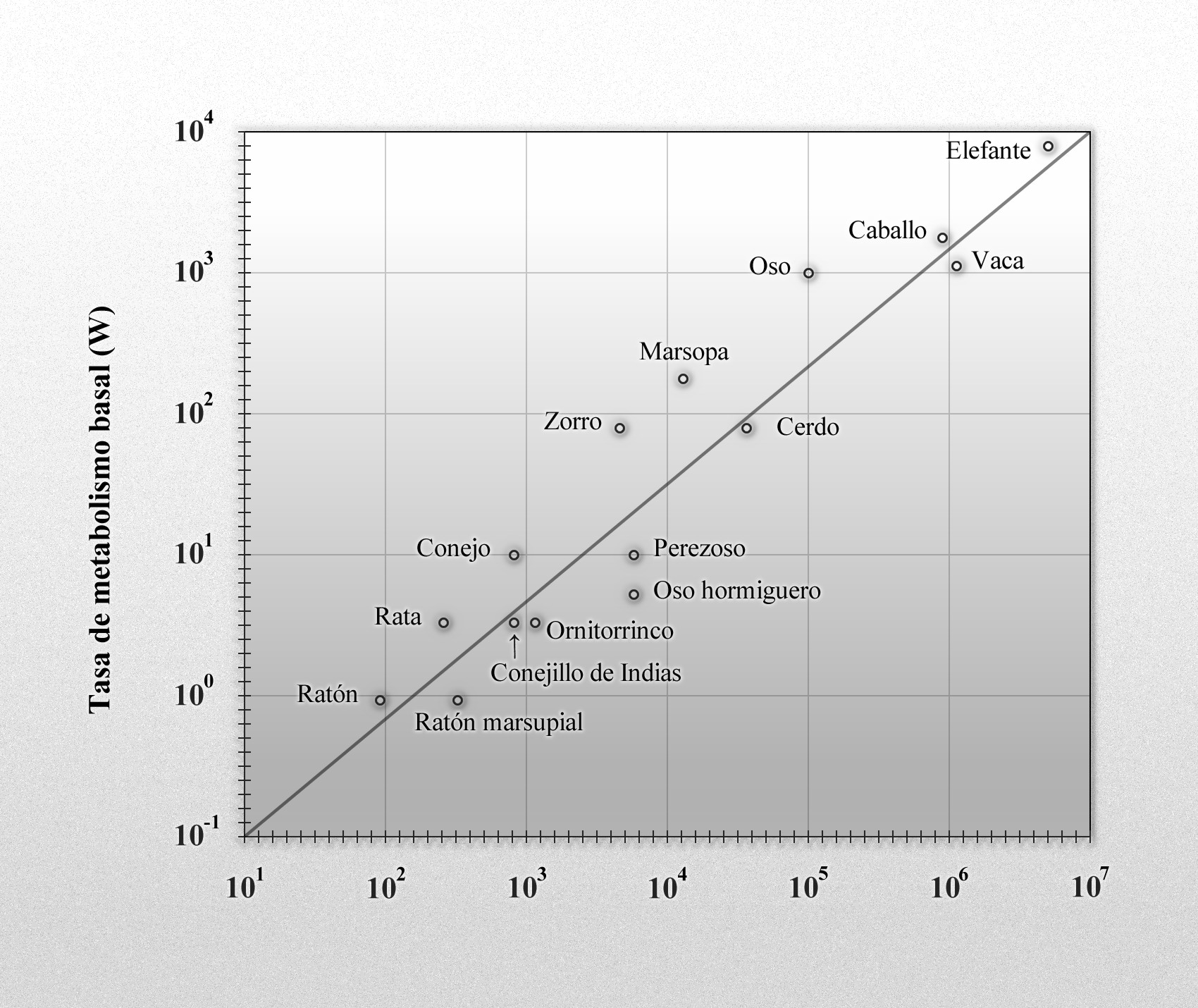

Los nutrientes necesarios para el metabolismo de tipo heterótrofo proceden de la digestión de los tejidos vegetales o de otros heterótrofos. En el metabolismo heterótrofo hay notables regularidades orgánicas. Entre ellas destaca claramente el hecho de que al representar en un gráfico logarítmico la tasa metabólica basal (TMB), – metabolismo mínimo cuando el animal se encuentra en reposo absoluto – frente al peso, los resultados relativos a los animales comprendidos entre el ratón y el elefante se dispongan a lo largo de una línea recta.

Representación de Kleiber del metabolismo basal de los mamíferos desde el ratón al elefante.

Esta dependencia lineal en un gráfico logarítmico fue descubierta por Kleiber en 1.932, y muestra que, si representamos las TMB en vatios y el peso, p, en kilogramos, la dependencia funcional entre ambas magnitudes es 3’52 p0’74. Si en vez del peso, se representa la TMB frente a la superficie corporal de los animales, el exponente de Kleiber es 0’67, que es el valor que se había supuesto anteriormente. Las medidas posteriores de la TMB en cientos de especies han confirmado la primera dependencia funcional que ha sido redondeada en 1.961 por el propio Kleiber, en 3’4 p0’75 (en W).

Aunque aún no se ha encontrado una explicación definitiva de la razón de esta ley de potencia con exponente ¾, el análisis de los requerimientos mecánicos de los cuerpos animales dan una buena pista. Con criterios elásticos se deduce que el cubo de la longitud crítica de rotura de los huesos varía linealmente con el cuadrado del diámetro (d) de la sección de los mismos, que a su vez, es proporcional a p3/8. La potencia muscular es proporcional al área de su sección transversal (esto es, proporcional a d2), y por tanto, la forma funcional de la potencia máxima se expresa como (p3/8)2, o lo que es lo mismo, p0’75.

Una explicación aún más fundamental se basa en la geometría y en la física de la red vascular necesaria para distribuir los nutrientes y eliminar los materiales de desecho del cuerpo de los animales. Estas redes que llenan el espacio, son fractales que determinan las propiedades estructurales y funcionales de los sistemas cardiovasculares y respiratorios, y de sus propiedades se deduce que el metabolismo total de los organismos escala con su masa elevada a la potencia ¾

El sistema respiratorio de los Vertebrados, al igual que el circulatorio, está muy perfeccionado y adaptado para aportar la energía necesaria a los tejidos de los animales homeotermos, de forma que les permita resistir en condiciones desfavorables

El exponente de Kleiber tiene una consecuencia importante para los organismos con TMB específica (la TMB dividida por el peso corporal) decrecientes. Esta relación limita el tamaño mínimo de los animales homeotermos y facilita que las grandes criaturas puedan sobrevivir en condiciones ambientales adversas. La ingesta diaria de néctar de un pequeño colibrí es equivalente a la mitad del peso de su cuerpo (para los seres humanos, la comida diaria representa alrededor del 3% del peso corporal), y los animales de sangre caliente, de tamaño menor que un colibrí, tendrían que estar comiendo continuamente para poder compensar las rápidas pérdidas de calor.

En el otro extremo, los grandes mamíferos pueden pasar varios días sin alimentarse, recurriendo a las reservas de grasa acumuladas para mantener su bajo metabolismo durante periodos de hibernación relativamente largos.

Los casos de separación de la tendencia general ilustran varios modos de adaptación al medio. Para regular térmicamente su cuerpo en agua fría, la TMB de las focas y las ballenas es el doble de las de otros animales de su tamaño. Los mamíferos del desierto, con sus bajas TMB, se han adaptado a los periodos de carencia de alimentos y a la escasez recurrente o crónica de agua.

En su colonización del medio terrestre, los cambios evolutivos de los primeros habitantes del medio acuático derivaron en extremidades locomotoras pentadáctilas con adaptaciones específicas, tales como las manos desgarradoras de los úrsidos, los felinos, etc.

Naturalmente, la TMB representa sólo una parte de las necesidades energéticas. La digestión eleva las tasas metabólicas de todos los animales y la reproducción requiere aumentos periódicos de energía (como también ocurre con el cambio de plumaje o pelaje en los pájaros y mamíferos). La búsqueda de comida es una actividad ineludible para todos los animales que no estén hibernando. Simplemente por estar de pie, la tasa metabólica en los pájaros es un 15 por ciento superior a la tasa de reposo; y en los mamíferos, exceptuando al caballo, esta diferencia llega al 30 por ciento. El límite metabólico, múltiplo de la TMB durante el máximo esfuerzo, es mucho mayor durante la carrera, natación o el vuelo.

Tendría que mencionar ahora la reproducción y sus distintas formas, que varían de modo continuo entre los casos extremos de la cría generalizada generada de golpe y los nacimientos espaciados de un único neonato. El primer caso maximiza la producción de individuos que maduran con rapidez, y estas especies son más oportunistas. La mayoría de las bacterias, así como muchas especies de insectos, pertenecen a este grupo de seres que se reproducen de forma oportunista e intensa. En condiciones adecuadas llegan a invertir una parte tan importante de su metabolismo en la reproducción que acaban convirtiéndose en plagas indeseables. En unos pocos días de verano, pequeños insectos como los áfidos, dedican el 80% de su metabolismo a reproducirse, en una estrategia que reduce de forma importante la vida de los progenitores y también las posibilidades de reproducción repetida. Los endoparásitos, sin embargo, son una desafortunada excepción a esta restricción: la tenia, debido al fácil suministro de energía que recibe, se reproduce copiosamente y puede sobrevivir más de quince años.

- Áfidos (pulgones)

- Causan al chupar fluidos

- Pequeños, color o amarillo

- Producen mielecilla (sustancia pegajosa)

- Trips

- Se alimentan de flores y hojas

- Daño causa pequeñas áreas descoloridas

- Ácaros (arañuelas)

- Dañan hojas

- Difícil detectar a simple

- Algunos producen seda y dejan telarañas

- Mosca blanca

- Causan deformaciones

- Producen mielecilla

- En el revés de hojas

En el otro extremo del rango reproductivo están las especies del tipo selección-k que se reproducen varias veces, espaciando los nacimientos y cada vez con crías poco numerosas, y que maduran lentamente. El resultado de esta forma de reproducción es una tasa de crecimiento y poca capacidad de colonización, que se compensa con la mayor longevidad, competitividad, adaptabilidad y frecuentemente por un comportamiento social altamente desarrollado.

Independientemente de su posición en el rango reproductivo, los rasgos comunes que presentan las transformaciones bioquímicas asociadas con la producción de los gametos y el crecimiento de los embriones permiten estimar la eficiencia de la reproducción heterótrofa. El máximo teórico de la eficiencia, para transformar los monómeros procedentes de la alimentación en los polímeros de la biomasa, está en torno a un impresionante 96%. Ineficiencias inevitables en la digestión de nutrientes y en la reproducción de recambio de tejidos reducen esta eficiencia, que siempre se mantiene por encima del 70%.

Los protozoos son organismos unicelulares, pero a diferencia de las bacterias, tienen membrana nuclear (cariomembrana, son eucariotas). Son organismos complejos, con un reproductivo, un aparato locomotor digestivo y la capacidad de producir energía por lo que durante muchos años han sido considerados “animales unicelulares”. Esta forma de vida todavía viven en colonias, ya sea de forma individual o como parásitos. Se encuentra en agua dulce, agua salada, en suelos húmedos o en otros seres como huéspedes. Pueden causar enfermedades a los seres humanos.

Los rendimientos se pueden medir fácilmente en los seres heterótrofos unicelulares que se reproducen rápidamente: los rendimientos más altos son los de las bacterias (50 – 65%) y se encuentra un medio en las levaduras y los protozoos. No es sorprendente que los poiquilotermos sedentarios sean, entre los heterótrofos superiores, los más eficientes en la transformación de nutrientes en zoomasa: sus tasas se aproximan frecuentemente al 70 – 80%, que es la máxima eficiencia posible.

La temperatura ambiental es determinante también para la reproducción y el desarrollo. Generalmente a mayor temperatura el desarrollo es más rápido, es decir, el tiempo requerido para una determinada etapa del desarrollo se acorta. La razón está en que a mayor temperatura se aceleran los procesos fisiológicos del organismo.La influencia de la temperatura sobre el proceso de reproducción y el de descendientes es determinante en muchos casos. Los animales de sangre caliente u homotermos pueden adaptarse a diferentes ambientes tanto fríos como cálidos, porque regulan su temperatura corporal.

Entre los vertebrados, los homeotermos presentan tasas de crecimiento fetal mucho más altas que las especies poiquilotermas. Los ornitólogos han los primeros en estudiar la energética de la reproducción debido a la importancia del huevo en la vida de las aves. La energía necesaria para el crecimiento testicular en los pájaros, durante el periodo de rápido desarrollo de las gónadas, está comprendido entre el 0’4 y el 2 por ciento del metabolismo basal. El crecimiento de las gónadas femeninas generalmente requiere aportes energéticos tres veces mayores que las masculinas pero, en cualquier caso, es una cantidad pequeña comparada con el coste energético de la producción e incubación de un huevo.

La cadena alimenticia, los herbívoros, los carnívoros, peces, natación, carreras y saltos, el vuelo, y tantos y tantos conceptos implicados me aconsejan reducir el presente trabajo que, en realidad, sólo quería limitarse a facilitar algunos conocimientos del planeta y que, por mi cuenta y riesgo, he unido a los seres que lo pueblan y cómo se mantienen y están relacionados. Pero no es eso lo que pretendía al , así que, volveremos al tema principal de este Blog: la Física, la Astronomía y los Pensamientos.

emilio silvera

Mar

7

¡Las Nebulosas! Mucho más que simple gas y polvo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nebulosas ~

Clasificado en Nebulosas ~

Comments (0)

Comments (0)

Alpha Centauri A, la componente principal, se constituye en una buena candidata para la búsqueda de planetas del mismo que la Tierra. Está Acompañada por Próxima Centauri y Alpha Centauri B

« ¿Sabremos alguna vez lo que es la Mente?

Conexiones sin fin

Si contáramos una sinapsis cada segundo, tardaríamos 32 millones de años en hacer el recuento. Si consideramos el número posible de circuitos neuronales, tenemos que habérnosla con cifras hiperastronómicas: 10 seguido de al menos un millón de ceros (En comparación con el número de partículas del universo conocido asciende a “tan sólo” 1079 es decir, es el número conocido como NEdd (Número de Eddintong) que es:

15.747.724.136.275.002.577.605.653.961.181.555.468.044.717914.527.116.709.366.231.425.o76185.631.031.296 protones y el mismo número de electrones, fue calculado por Arthur Eddintong allá por la década de 1920. Pues bien, esa descomunal cifra, se queda muy corta si la comparamos con las conexiones de nuestr5o cerebro. De ahí viene lo que decimos de que, “nuestros cerebros son las máquinas más complejas del Universo”. Y, desde luego, el comentario no está lejos de ser cierto.

¿Quién sabe como podría ser aquella Nebulosa de la que surgió el Sistema Solar? ¿Sería como ésta que llaman, por su , del Capullo? Algunas veces me da que pensar nuestra presencia aquí, en el planeta Tierra y, con la imaginación, viajo hacia muy atrás en el tiempo, “veo” una estrella masiva que, llegado al final de su ciclo en la secuencia principal, expulsa sus capas exteriores de materia al espacio interestelar que, en ese momento, ha sido sembrado del gas y el polvo del que, millones, o miles de millones de años más tarde, surgiría nuestro Sistema Solar.

Las Nebulosas, esas nubes de gas y polvo que abarcan extensiones de -luz y que pueblan el cielo. Son en realidad, criaderos de estrellas y de sistemas solares. De una de ellas, hace ya de eso miles de millones de años, surgió nuestro propio Sistema Solar. Es curioso constatar que fueron dos filósofos,Immanuel Kant y pocos años más tarde Pierre Simon de Laplace, los que por primera vez expusieron en sendos libros, una teoría sobre el nacimiento del sistema solar y, aunque sus teorías no fueran perfectas y adolecieran de visibles carencias (vistas en perspectiva retrógrada desde esta ), no deja de llamar la atención que, filósofos y no astrónomos, pusieran su mirada en el amanecer del sistema al que pertenecemos.

Bueno, si queremos ser precisos, René Descartes (1596-1650) fue el primero en intentar buscar una explicación científica, en el sentido moderno. Le siguió el naturalista Buffon (1707-1788) propuso la primera teoría catastrofistade la formación del Sistema Solar. La llamada teoría de las Mareas. Buffon sugirió que el Sistema Solar surgió de la eyección de materia solar tras el choque del Sol con un cometa hace 70.000 años.

Si continuamos profundizando, siempre nos encontraremos con algún que otro pensamiento que nos lleve a querer desvelar ese principio del conjunto planetario al que pertenecemos, ningún gran descubrimiento ha nacido por generación expontánea y, casi siempre, ha sido fruto del enlace de muchas ideas que, con el tiempo, se fueron perfeccionando.

Rosetta. Ese es el de esta Nebulosa situada a 5.500 años-luz de nosotros

Aunque ya en épocas en que se confundían con las galaxias los astrónomos griegos anotaron en sus catálogos la existencia de algunas nebulosas, las primeras ordenaciones exhaustivas se realizaron a finales del siglo XVIII, de la mano del francés Charles Messier y del británico William F. Herschel.

En el siglo XX, el perfeccionamiento de las técnicas de observación y la utilización de dispositivos de detección de ondas de radio y rayos X de procedencia no terrestre completaron un detallado cuadro de Nebulosas, claramente diferenciadas en origen y características de las galaxias y los cúmulos de estrellas, lo que hizo posible estudiar sus propiedades de sistemática. En la Tabla de Objetos Messier, existen clasificadas muchas de ellas, y, entre las más conocidas podríamos citar a las siguientes:

- Nebulosa del Cangrejo en Tauro

- Nebulosa de la Laguna en Sagitario

- Nebulosa Trífida en Sagitario

- Nebulosa Planetaria en Vulpécula

- Nebulosa de Dumbell en Vulpécula

- La Gran Nebulosa de Orión en Orión

- Nebulosa Brillante en Orión

- Nebulosa brillante “del anillo” en Lira

- Nebulosa planetaria “del Búho” en Osa Mayor

- Nebulosa de Orión, M42

- Nebulosa de la Cabeza de Caballo

- Nebulosa Norteamericana en la Constelación del Cisne.

Es la Nebulosa de La Gaviota que abarca 100 años-luz de espacio y se encuentra situada a 3.800 años-luz de la Tierra

Existen casi 4 000 nubes de este sólo en nuestra Galaxia,y cada una tiene una masa que oscila entre 100 000 y 200 000 masas solares. El Hidrógeno y el Helio presentes en las Nebulosas existen desde el principio del Universo. Los elementos más pesados, como el Carbono, Oxígeno, Nitrógeno y Azufre, de más reciente formación, proceden de transmutaciones estelares que tienen lugar en el interior de las estrellas.

Y, como sería interminable el reseñar aquí todas la Nebulosas existentes en el cielo, sólo nos limitamos a dejar una reseña de varias de ellas de entre un inmenso de variadas Nebulosas que pueblan el Universo. Lo que es ineludible por ser el objetivo principal de divulgar el conocimiento de la Astronomía, al tratar sobre Nebulosas, es explicar lo que una Nebulosa es, y, las clases o variedades más importantes que de ellas existen, así que, sin más preámbulo pasamos a exponer lo que son estos objetos del cielo.

Es conocida como Nebulosa de la Tarántula que ocupa mil años-luz de espacio y está muy próxima, sólo 1.500 a.l. nos separan de esta araña cósmica. Ahí a la derecha de la imagen, podemos contemplar un cúmulo de estrellas masivas que resaltan azuladas en toda la región que ocupan al haber ionizado el material circundante con sus energéticas radiaciones ultravioletas.

En realidad, ¿qué es una nebulosa?

Se llama Nebulosa a una nube de gas y polvo situada en el espacio. El término se aplicaba originalmente a cualquier objeto con apariencia telescópica borrosa, pero con la llegada de instrumentos más potentes Tecnológicamente hablando, se descubrió que muchas nebulosas estaban en realidad formadas por estrellas débiles. En 1864, W. Huggins descubrió que las verdaderas nebulosas podían distinguirse de aquellas compuestas de estrellas analizando sus espectros.

En la actualidad, en término Nebulosa significa nebulosa gaseosa. El término nebulosa extragaláctica, utilizado originalmente para describir galaxias es obsoleto. Existen tres tipos principales de nebulosas gaseosas:

- Las Nebulosas de emisión, que brillan con luz propia.

- Las Nebulosas de reflexión, que reflejan la luz de fuentes brillantes próximas estrellas.

- Las nebulosas oscuras (o nebulosas de absorción), que aparecen oscuras frente a un fondo más brillante.

Este amplio esquema de clasificación ha sido extendido sobre todas las longitudes de onda, dando lugar a términos nebulosas de reflexión infrarroja. Las nebulosas de emisión incluyen a las nebulosas difusas o regiones H II situadas alrededor de las estrellas jóvenes, las nebulosas planetarias que se hallan alrededor de las estrellas viejas y los remanentes de supernovas.

Todas estas Nebulosas que podemos ver para nuestro regocijo y asombro, están en nuestra Vía Láctea, una Galaxia entre cien millones más que, contiene todo aquello que en el Universo pueda existir, ya que, al fin y al cabio, ¿qué es una galaxia sino un universo en miniatura? Y, entre las muchas maravillas que la Galaxia contiene, también exhibe un variado de Nebulosas que podemos admirar como las siguientes:

NEBULOSA BIPOLAR

Nube de gas con dos lóbulos principales que están situados simétricamente a cada lado de una estrella central. Esta bipolar se debe a la eyección de material por la estrella en direcciones opuestas. En algunos casos el material que fluye escapa a lo largo del eje de rotación de un denso disco de material que rodea a la estrella, y que la puede oscurecer completamente en longitudes de onda óptica. Las Nebulosas bipolares pueden ser producidas por el flujo de materia procedente de estrellas muy jóvenes o muy viejas.

NEBULOSA BRILLANTE

NGC 6302 una Nebulosa brillante que tiene una temperatura superficial de aproximadamente 250 mil grados centígrados debido a que su estrella central, en exceso caliente, hace de nebulosa planetaria peculiar, una muy brillante conglomeraciópn de gas y polvo. El telescopi Espacial Hubble captó esta bella imagen nosotros.

Nube luminosa de gas y polvo interestelar. El término incluye a las nebulosas de emisión, en las que el gas brilla con luz propia; y las nebulosas de reflexión en las que el gas y el polvo reflejan la luz de las estrellas cercanas.

NEBULOSAS DE ABSORCIÓN – NEBULOSA OSCURA

Nube de gas y polvo interestelar que absorbe la luz que incide sobre ella detrás, de manera que parece negra frente a un fondo más brillante. La luz absorbida calienta las partículas de polvo, las cuales rerradian parte de esa energía en forma de radiación infrarroja. Parte de la luz del fondo no es absorbida, sino que es difundida o redirigida. La Nebulosa de la Cabeza del Caballo en Orión es una famosa nebulosa oscura; otro ejemplo es el Saco de Carbón, cerca de Cruz que oculta parte de la Vía Láctea.

NEBULOSA DE EMISIÓN

Nube luminosa de Gas y polvo en el espacio que brilla con luz propia. La luz ser generada de varias maneras. Usualmente el gas brilla porque está expuesto a una fuente de radiación ultravioleta; algunos ejemplos son las regiones H II y las Nebulosas planetarias, que son ionizadas por estrellas centrales.

El gas también brillar porque se ionizó en una colisión violenta con otra nube de gas, como en los objetos Herbig-Haro. Finalmente, de la luz de los remanentes de supernovas como la Nebulosa del Cangrejo está producida por el proceso de radiación sincrotón, en el que las partículas cargadas se mueven en espiral alrededor de un campo magnético Interestelar.

NEBULOSA DE REFLEXIÓN

Al igual que las otras, es una nube de gas y polvo interestelar que brilla porque refleja o difunde la luz de estrellas cercanas. La luz procedente de una nebulosa de reflexión tiene las mismas líneas espectrales que la luz estelar que refleja, aunque es normalmente más azul y puede estar polarizada. Las nebulosas de reflexión aparecen a menudo junto a las nebulosas de emisión en las regiones de formación estelar reciente. El Cúmulo de las Pléyades está rodeado por una nebulosa de reflexión.

NEBULOSA DIFUSA

Otra nube de gas y polvo interestelar que brilla debido al efecto sobre ella de la radiación ultravioleta procedentes de las estrellas cercanas. En la actualidad se recomienda el uso del términoRegión H II para referirse a este de nebulosas. El calificativo de “difuso” data de la época en la que las nebulosas eran clasificadas de acuerdo a su apariencia en el óptico. Una nebulosa difusa era una que mantenía su aspecto borroso incluso cuando se observaba aumentada a través de un gran telescopio, en contraposición a aquellas que podían ser resueltas en estrellas. Esta de arrina es la Gran Nebulosa Carina, inmensa nebulosa difusa más grande que la famosa Nebulosa de Orión.

NEBULOSA FILAMENTARIA

Grupo de nubes de gas y polvo alargadas con una estructura en de finos hilos vista desde la Tierra. Muchas estructuras filamentarias pueden realmente ser hojas vistas de perfil, en vez de hilos. Las nebulosas filamentarias más conocidas como la Nebulosa del Velo, son remanentes de supernova. Aunque estos remanentes tienen temperaturas de 10 000 K, son en realidad las partes más frías del remanente, pudiendo alcanzar otras partes de ella temperaturas superiores a 1.000.000 K.

NEBULOSA PLANETARIA

Brillante nube de gas y polvo luminoso que rodea a una estrella altamente evolucionada. Una nebulosa planetaria se cuando una gigante roja eyecta sus capas exteriores a velocidades de unos 10 km/s. El gas eyectado es entonces ionizado por la luz ultravioleta procedente del núcleo caliente de la estrella. A medida que pierde materia este núcleo queda progresivamente expuesto, convirtiéndose finalmente en una enana blanca (lo que pasará con nuestro Sol). Las nebulosas planetarias tienen típicamente 0,5 a.l. de diámetro, y la cantidad de material eyectado es de 0,1 masas solares o algo más.

Debido a la altísima temperatura del núcleo, el gas de la nebulosa está muy ionizado. La Nebulosa Planetaria dura unos 100.000 años, tiempo durante el cual una fracción apreciable de la masa de la estrella es devuelta al espacio interestelar. Las nebulosas planetarias se llaman así porque a los antiguos observadores les recordaba un disco planetario. De hecho, las formas detalladas de las nebulosas planetarias reveladas por los modernos telescopios cubren muchos tipos diferentes, incluyendo las que tienen de anillos (como la Nebulosa Anular), forma de pesas, o irregular.

Algunas nebulosas planetarias presentan ansae, unas pequeñas extensiones a lado de la estrella central, que se piensa que son producidas por eyección a alta velocidad de material de un flujo bipolar.

Los cometas, asteroides y meteoritos aportan importantes pistas conocer la composición de la nebulosa solar. Discos similares de gas y polvo han sido detectados alrededor de estrellas jóvenes cercanas, notablemente Beta Pictoris.

Mucho más es lo que podríamos decir de las Nebulosas. Sin embargo, estimamos debidamente cumplido el objetivo de enseñar aquí, de manera sencilla, lo que son las Nebulosas y, si algunos de los lectores (aunque sean pocos), han aprendido algo sobre ellas, el objetivo está cumplido y nos damos por pagados.

Gracias por la visita. Nos veremos en las estrellas.

emilio silvera

Mar

6

¡La Naturaleza! Además de Bella, es… ¡Asombrosa!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Simetrías ~

Clasificado en Simetrías ~

Comments (0)

Comments (0)

No pocas veces nos encontramos con hechos que aunque han tenido la participación de los humanos, parecen tener su origen en otro ámbito más alto de éste nuestro, en otro lugar donde el entendimiento sería superior y las mentes tuvieran la potestad de ver secretos de la Naturaleza profundamente escondidos. En física tenemos multitud de ejemplos de esto que digo: Me vienen a la mente las ecuaciones conocidas como de Yang-Mills que indicaban que los gluones, las partículas gauge que transportan la fuerza más poderosa de las cuatro conocidas para mantener unidos los Quarks dentro del núcleo, debían carecer de masa, como los fotones y los gravitones.

¿Por qué, entonces la fuerza nuclear fuerte se hace sentir sólo a corta distancia, cuando la luz y la gravitación tienen un alcanza infinito?

La respuesta la tenemos en la Cromodinámica cuántica, la teoría de la fuerza intensa, es que ésta aumenta su poder cuando los Quarks que aprisiona tratan de separarse, en vez de debilitarse como el electromagnetismo y la gravitación con la distancia, la fuerza nuclear fuerte aumenta. Ahí surgió el origen de confinamiento de los Quarks” que, obligados por una “nube” de Gluones, el Bosón mediador de esta fuerza.

También aclaró la Cromodinámica cuántica el funcionamiento de la fuerza débil: el fenómeno antes misterioso de la desintegración radiactiva Beta que pudo ser interpreta ahora como la conversión de un Quark down en un Quark up, convirtiéndose el neutrón, formado por dos Quarks down y un Quark up, en un protón que consiste en dos Quarks up y un Quark down.

La simetría como se pudo ver más tarde, iba a desempeñar un papel destacado en el ulterior desarrollo de la teoría cuántica de campo, y hasta señaló el camino hacia una teoría unificada de la “supersimetría”, capaz de unir todas las partículas y campos bajo el manto de un sólo conjunto de ecuaciones. Yang escribió:

“La Naturaleza parece aprovechar la representación matemática simple de las leyes de simetría. La elegancia intrínseca y la bella perfección del razonamiento matemático involucrado, así como la complejidad y profundidad de sus consecuencias físicas, son una gran fuente de estímulo para los físicos. Uno aprende a alentar la esperanza de que la Naturaleza posee un orden que podemos aspirar a comprender.”

La Simetría de la Naturaleza nos rodea por todas partes y, a nuestro alrededor, mirémos donde podamos mirar, allí está presente y, sin embargo, de ninguna manera son manifiestas todas las simitrías de la Naturaleza. Vivímos en un mundo imperfecto, en el que muchas de las simetrías que aparecen en las ecuciones están rotas.

De todos es bien conocido que, el mismo Yang, en colobaración con Tsung Dao Lee, identificó una discreta simetría en la fuerza débil, llamada violación de la paridad. En 1956, ambos predijeron sobre bases teóricas, que el espín de las partículas provenientes de la desintegración Beta mostrarían una ligera preferencia por una dirección sobre la otra. Experimentos realizados, así lo confirmaron y les valió el Premio Nobel a Lee y Yang (aunque no a Wu por razones desconocidas). Aquello sirvió para atraer la atención sobre el hecho de que la Naturaleza, sea simétrica en algunos aspectos y asimétrica en otros.

Las conocidas como moléculas quirales pueden existir en dos formas, siendo una la imagen especular no superponible de una sobre la otra, incluso aunque ambas tienen la misma composición química … Si bien los experimentos de laboratorio tienden a producir cantidades iguales de las versiones dextrógiras y levógiras, muchas de las moléculas quirales encontradas en organismos vivos proceden de una de las variedades … Por ejemplo, los aminoácidos que forman las proteínas solo aparecen en la forma levógira, mientras que los azúcares del ADN sólo en la dextrógira … ( la dextrosa o glucosa, es un azúcar que desvía el plano de polarización a la derecha) …

Los científicos han debatido desde hace mucho sobre esta asimetría en los seres vivos … Algunos han defendido que un número igual de ambas versiones de la molécula quiral estaba presente en el inicio de la vida, y que sólo durante la evolución biológica tuvo lugar el desequilibrio … Esa visión se ha ido haciendo cada vez menos popular, no obstante, al darnos cuenta de que el proceso fundamentalmente importante del plegamiento de proteínas parece requerir un desequilibrio quiral, aunque el que la naturaleza haya seleccionado la quiralidad derecha o izquierda para cada molécula durante la evolución implicaría procesos extremadamente complejos …

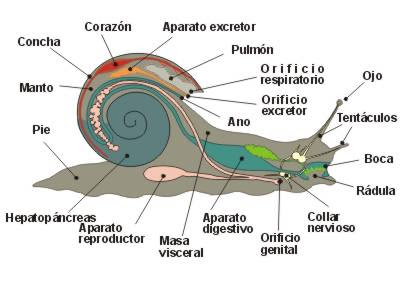

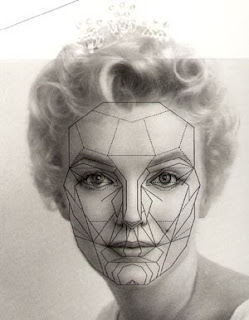

Los cuernos de una cabra paquistaní, la imagen de un ciclón visto desde el espacio, una galaxia o una concha, la chica que arriba nos mira. Son formas que se nos viene a la vista, aspectos de la realidad que llaman poderosamente nuestra atención y nos lleva a preguntar: ¿Por qué se forman y repiten esas figuras una y otra vez, y, en cada caso, una es la “copia exacta” de todas las demás de su género? ¿Es posible que el hombre, al contemplar tales maravillas comenzara a hacer preguntas y diera lugar al nacimiento de la Ciencia? Las matemáticas comenzaron por el asombro que despertaban las formas geométricas y de la misma manera, nacieron los primeros problemas de la física clásica centrada en las órbitas de los astros y las trayectorias de proyectiles.

La geología estudia la forma de las piedras y volcanes y la biología se ocupa de las formas de los seres vivos y de como ésta ha ido cambiando a lo largo del tiempo. Pero, ¿cómo explicar los mecanismos que crean el aspecto exterior de la realidad que podemos percibir? ¿Y por qué existen las mismas estructuras tanto en los organismos vivos como en el mundo inanimado?

Observamos la Naturaleza y podemos contemplar formas armoniosas y elegantes, entendiendo que son cuerpos bellos y simétricos en todas sus versiones. Por ejemplo, amí siempre me llamó la atención la simetría por traslación que se puede encontrar en la disposición de las hojas.

Si nos fijamos y analizamos como se van desarrollando hacia la estremidad de su rama, aparecen con la misma forma inicial. Un asimetría que está presente en los arganismos que cuentan con una estructura en la que se repiten segmentos iguales, con los mismos aparatos y los mismos órganos, como el trilobites, fósil del Paleozóico (lombriz y sanguijuela), y algunas plantas.

En cambio la simetría por rotación se encuentra en los pétalos de una flor o en los tentáculos de una medusa: aunque sus cuerpos roten, permanecen iguales. No debemos olvidar la simetría bilateral que hace que los lados derecho e izquierdo sean iguales y se presenta en casi todos los animales, incluido nosotros. Pero es uniendo estos aspectos cuando se obtienen figuras realmente armoniosas. Si se trata de desplazamiento y rotación en un mismo plano hablamos de una espiral, mientras que en el espacio sería una hélice, aunque ambas se encuentran por todas partes en la naturaleza.

Las simetrías se generan mediante las fuerazas que actúan sobre los cuerpos, descritas por leyes rigurosas e inequívocas, como una fórmula matemática y dependen de la existencia de fuerzas distintas que actúan en diversas direcciones. Si éstas permanecen en equilibrio, no hay preferencia alguna hacia arriba o abajo, a la derecha o a la izquierda, y los cuerpos tenderán a ser perfectamente esféricos, como suele ocurrir en el caso de virus y bacterias. Además, cuando el aspecto no es el de una esfera perfecta, la Naturaleza hará todo lo posible para hacercarse a esta forma.

En todo esto, y, para que así ocurra, tiene que estar presente la Gravedad. Veamos:

Parémonos un momento en la gravitación y generalicemos el concepto de simetría, ampliándolo a las fórmulas matemáticas. Veamos la fórmula de Newton, pero expresándola con palabras, de esta manera: la fuerza de atracción entre dos cuerpos es proporcional al producto de dos términos: el primero es la masa de un cuerpo dividido por su distancia al otro. El segundo término es la masa del otro cuerpo dividido por su distancia al primero.

Con símbolos matemáticos escribiríamos:

F![]() (M/d) × (m/d)

(M/d) × (m/d)

Es la misma fórmula de siempre, pero la hemos puesto así para visualizar que la gravitación se puede expresar con una fórmula bastante simétrica: los dos términos de la derecha de la ecuación son “casi” simétricos ¿no es verdad?

Este concepto más general de simetría es muy profundo, porque nos lleva a pensar que la Naturaleza y las leyes físicas que la describen también obedecen a las leyes de la simetría, igual que la materia, en sus manifestaciones externas, las obedece en muchos casos.”

¿Sería posible que la simetría material tuviera un paralelismo en la abstracción intelectual que son las leyes físicas? Desde luego hace falta un esfuerzo mental considerable para pasar de lo material a lo intelectual, pero cuando se profundiza en ellla, la conexión aparece.

En la naturaleza existen muchas cosas que nos pueden llevar a pensar en lo complejo que puede llegar a resultar entender cosas que, a primera vista, parecían sencillas. Me explico:

Fijémonos, por ejemplo, en una Flor de Girasol y en las matemáticas que sus semillas conllevan. Forman una serie de números en la que cada cifra es la suma de las dos precedentes (por ejemplo 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, 233…) se denomina, en términos matemáticos, sucesión de Fibonacci, una ley que se cumple incluso en el mundo vegetal, como hemos podido comprobar en las semillas del girasol, dispuestas en espiral y que respetan ésta fórmula.

En el mundo inorgánico las leyes de la cristalización del agua congelada, determinadas por las fuerzas que actúan entre las moléculas, hacen que los cristales adopten formas que son infinitas y varían con respecto a un tema común: la estrella de seis puntas. Sin embargo, los planetas son esféricos porque han nacido en la nube primordial que rodeaba al Sol, atrayendo materia indeferentemente de todas partes.

Por otro lado, cuando la fuerza de la Gravedad actúa en una dirección y permite distinguir lo alto de lo bajo, los cuerpos asumen formas que gozan de simetría por rotación, en torno a un eje vertical, como las flores, los árboles, las medusas. Si este organismo presente ojos y boca sobre la parte anterior del cuerpo para alcanzar la comida antes que sus competidores (que es lo que sucede con los animales superiores) tenderá a mantener una correrspondencia bilateral, lo que hace relativamente intercambiables derecha e izquierda.

Los seres humanos (su exterior) somos buenos ejemplos de esto. Tenemos una casi igualdad entre las dos partes de nuestro cuerpo que se obtendrían dividiéndolo por una línea que pasa por el centro de la nariz y por el centro del ombligo. La figura de arriba muestra el famoso estudio sobre la simetría del cuerpo humano de Leonardo da Vinci.

¿Cómo podemos llegar a la simetría presente en las manchas del leopardo? Pues, tiene su explicación científica, tanto en este animal como en otros felinos, ocurre ésta particularidad de ser poseedores de una piel exterior que los singulariza de otros por su perfecta simetría y belleza de las formas en su conjunto.

Claro que, en la Naturaleza, nada ocurre porque sí, todo tiene su por qué, y, todo lo que en ella podemos contemplar posee una funcionalidad que está directamente relacionada con su mecánica, con el medio en el que habita, con lo que el Universo espera que haga en su medio y, para ello, dota a cada figura con aquellos “trajes” que mejor les permita realizar aquello para lo que están destinados.

Simetría en las galaxias espirales

Vamos a generalizar un paso más el concepto de simetría, planteándonos ahora si es posible que una ley física se cumpla en cualquier lugar. ¿En cualquier lugar… de dónde?, ¿de nuestra ciudad?, ¿de nuestro planeta? No: del universo. Una ley que fuera válida en cualquier lugar del universo sería una ley simétrica respecto al espacio. Se cumpliría dondequiera que se hiciese un experimento para comprobarla.

Fíjense que nuestra idea de simetría se va haciendo más compleja y más profunda. Ahora no nos detenemos en ver si la forma material de un objeto es simétrica, ni de si la escritura de una fórmula matemática es simétrica. Ahora nos preguntamos si una ley física es válida en todo el Universo.

La otra simetría interesante para una ley física es la que se refiere al tiempo. Cierta ley física se cumple ahora; ¿antes también?, ¿se cumplirá pasado algún tiempo? Una ley que fuera cierta en cualquier instante de la historia del universo sería una ley simétrica respecto al tiempo.

Lo que ahora nos preguntamos es: ¿son simétricas o no las leyes de la física?

Simetría radial de la Gravedad

Hasta donde alcanzan nuestras medidas, las leyes físicas (y, por tanto, la interacción gravitatoria) sí son simétricas respecto al espacio y respecto al tiempo. En cualquier lugar y momento temporal del universo, la Naturaleza se comporta igual que aquí y ahora en lo que se refiere a estas leyes.

Esta simetría es un arma muy poderosa para investigar hacia el pasado y hacia el futuro, ya que nos permite suponer (y, en la medida en que confiemos en la seguridad de la simetría,conocer) condiciones locales donde jamás podremos llegar por la distancia espacial y temporal que nos separa de muchas partes del universo. Así, por ejemplo, gracias a esta simetría, podemos calcular que el Sol lleva 5.000 millones de años produciendo energía y que le quedan, probablemente, otros 5.000 millones hasta que consuma toda su masa. Esto lo podemos aventurar suponiendo que en ese enorme tramo de 5.000 + 5.000 = 10.000 millones de años las leyes físicas que determinan los procesos mediante los cuales el Sol consume su propia masa como combustible (las reacciones nucleares que le permiten producir energía), fueron, son y serán las mismas aquí en el Brazo de orión donde nos encontramos como en los arrabales de la Galaxia Andrómeda donde luce una estrella como nuestro Sol que, también envía luz y calor a sus planetas circundantes, y, por muy lejos que podamos mirar, siempre veremos lo mismo.

Por tanto, en cierto modo, la simetría se vuelve tan importante o más que la propia ley física.

La regularidad de las formas de la Naturaleza se refleja incluso en la cultura humana, que desde siempre intenta inspirarse en el mundo natural para conformar su propio mundo. Existen hélices en las escaleras de palacios, castillos y minaretes y en las decoraciones de esculturas y columnas. Las espirales abundan en los vasos, en los bajorrelieves, en los cuadros, en las esculturas en los collares egipcios, griegos, celtas, precoolombinos e hindúes e, incluso, en los tatuajes con los que los maoríes neozelandeses se decoran el rostro.

La búsqueda de la perfección geométtrica y de las propiedades matemáticas pueden ser también una guía importante en el estudio científico del mundo. Paul Dirac, una de los padres de la moderna mecánica cuántica, solía decir que “si una teoría es bella desde el punto de vista matemático, muy probablemente es también verdadera”.

A todo esto, no debemos olvidar que todo, sin excepción, en nuestro Universo, está sometido a la Entropía que nos trae el paso inexorable de eso que llamamos “Tiempo”, y que, convierte perfectas simetrias de joven belleza, en deteriorados objetos o entidades que, nos viene a recordar que nada es perpetuo, que todo pasa y se transforma.

Un dolor que llevo dentro de mí es el no poder contemplar la verdadera belleza que, estándo presente en los seres vivos inteligentes, en la mayoría de los casos, se nos queda oculta a nuestra percepción, toda vez que, esa clase de belleza que no podemos ver pero sí percibir, sólo la podemos captar con el trato y la convivencia y, verdaderamente, tengo que admitir que, algunas bellezas que he tenido la suerte de poder “ver” con los ojos del espíritu, llegan a ser segadoras, deslumbrantes, su explendor es muy superior al de la estrella más brillante del cielo, y, seguramente (estoy seguro) como a muchos de ustedes les pasa, tengo la suerte de tenerla junto a mí desde hace muchos años. y, si pienso en ello en profundidad y detenimiento, no tengo más tremedio que concluir que es ese brillo y esplendor el que me da la fuerza para seguir cada dia en la dura lucha que nos ha tocado participar.

¡Sí que es importante la Belleza! Dirac tenía toda la razón.

emilio silvera

Totales: 75.316.096

Totales: 75.316.096 Conectados: 41

Conectados: 41