May

1

Misiones pasadas que dieron paso a otras nuevas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Viajar al Espacio ~

Clasificado en Viajar al Espacio ~

Comments (0)

Comments (0)

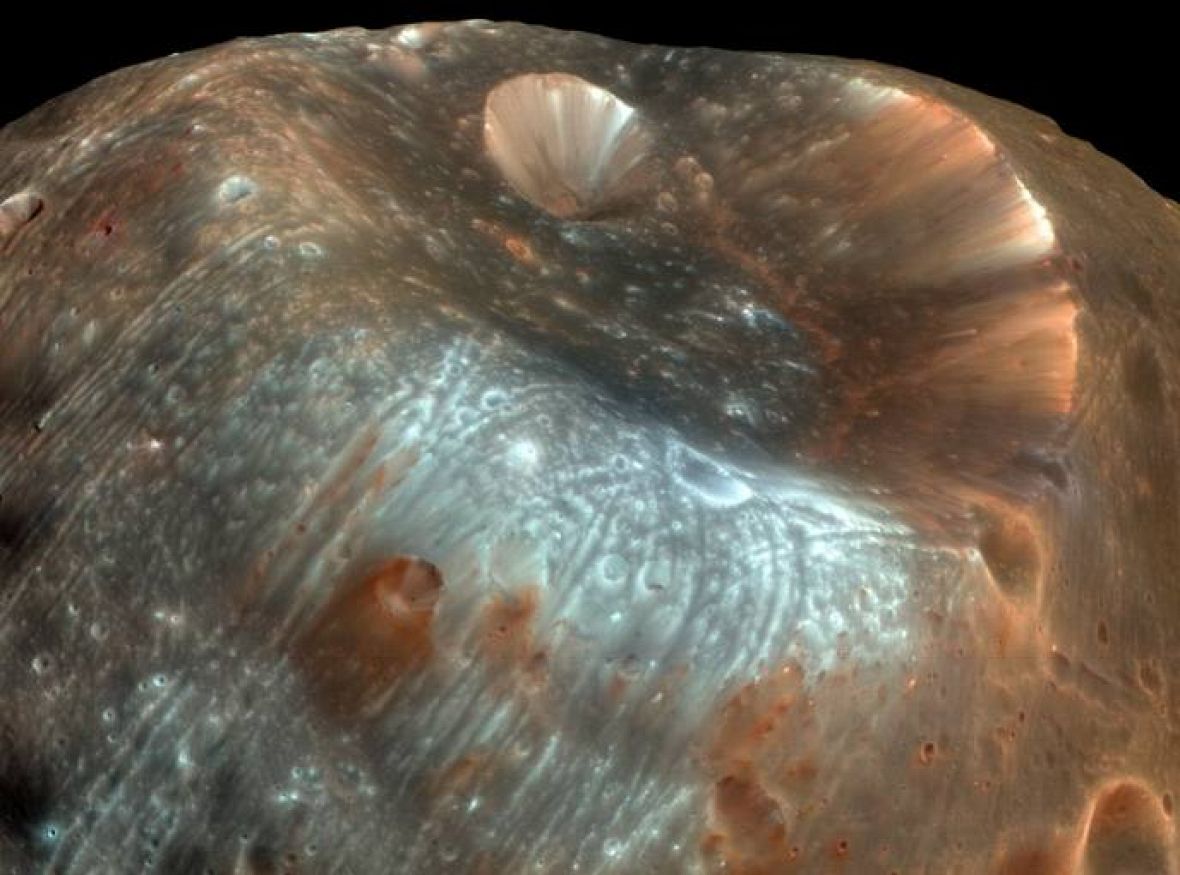

La Mars Express visita Marte y de eso hace ya más de 10 años

“El 3 de Junio de 2003 Europa daba finalmente el salto hacia otro mundo, y su primera sonda interplanetaria desde los tiempos de la Giotto, que visitó el corazón del cometa Halley en 1986, iniciaba a bordo de un cohete ruso Soyuz-FG/Fregat su viaje hacia Marte. Algo más de 6 meses después entraba con éxito en órbita marciana…”

Desde entonces, la NASA no estaba sola en su exploración del planeta hermano y también Europa se hizo con su parcela en esa investigación. De hecho pudo contribuir a conocer mejor el planeta rojo gracias a la Mars Express se pudo acercar a la Ciencia americana del espacio en un nivel de “igualdad”.

Tambien la sonda espacial Opotunity ha cumplido más de los 10 años en la superficie de aquel planeta y sigue dándo buenas noticias aunque, esté ya, algo renqueante. Todos están sorprendidos del comportamiento de éste ingenio humano que partío de la Tierra en el año 2003, viajando hacia Marte en el que estaría 9o días pero, ¡lleva ya en él 3.200 durante los que ha podido recorrer más de 35 kilómetros.

Rebotó 26 veces contra el terreno rocoso antes de descender completamente. Casi lo dan por perdido, pero sobrevivió. No cayó donde se esperaba, sino en un cráter de 22 metros de diámetro y aunque sus circuitos se activaron exitosamente, al segundo día tenía problemas mecánicos en sus brazos y articulaciones. Hoy, se moviliza hacia atrás, porque tiene una rueda atorada y dos de sus instrumentos no funcionan. Pese a lo anterior, el Opportunity se ha convertido en un ícono tecnológico para la Nasa.

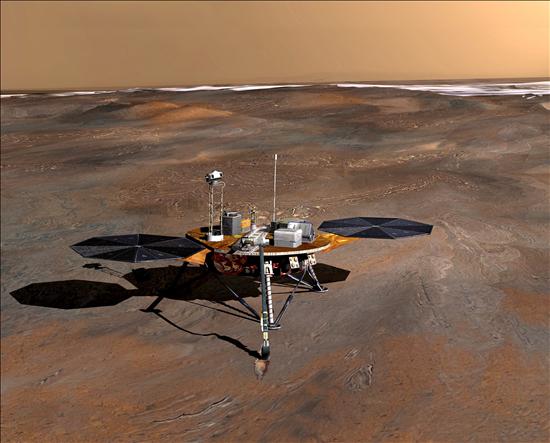

Señales de agua, viento y hielo en Marte

Región de Marte fotografiada por ‘Mars Express’. | ESA Europa Press | Madrid

No sólo porque fue (junto al Spirit) la primera nave que recorrió Marte y que comprobó que en ese planeta alguna vez el agua fluyó por su superficie. Sino también, porque es el vehículo más longevo de la exploración espacial: acaba de cumplir nueve años en suelo marciano, pese a que la misión inicial sólo le daba 90 días de vida útil. Y ha recorrido más de 35 km del planeta: 50 veces más de lo planeado. “Nadie hubiese imaginado que este vehículo iba a realizar una exploración tan exhaustiva y menos tener tantos descubrimientos científicos”, dice a La Tercera John Callas, jefe del programa de exploradores en Marte de la Nasa. Por eso, lejos de su jubilación, la agencia espacial prepara una nueva misión para el rover. Ahora, en busca de posibles rastros de vida microbiana.

El gran aporte de Opportunity ha sido entregar evidencia in situ de que Marte tuvo un pasado acuoso, es decir, que hace miles de millones de años fue un lugar cálido y húmedo por cuya superficie fluyó agua. Estos hallazgos los ha hecho siguiendo y examinando los minerales y arcillas de los rastros dejados en el suelo por lo que se creen fueron antiguos ríos o cursos de agua. Una labor que ha sido posible gracias a su inesperada longevidad.

Uno de los técnicos de la NASA comentó:

“Los datos que encontramos a través del Opportunity confirman que antiguamente en Marte existió un ambiente con agua, lo que significa que el planeta tuvo un entorno favorable para la vida.”

Muchas son las imágenes de Marte que nos hablan de la presencia de agua

Los análisis del rover también han mostrado que el planeta rojo pasó por al menos tres etapas geológicas: la primera hace 4.000 años, que fue relativamente húmeda; otra hace 3.500 años, que se caracterizó por su actividad volcánica, y la actual, que no presenta señal de vida. Y al igual que en la Tierra, en Marte también se forman nubes de cristales de hielo.

Su último descubrimiento fue un mes de agosto, cuando en pleno viaje hacia el sur del cráter Endeavour, halló un campo lleno de esferas, blandas en su interior y ricas en hierro, que llamó la atención de los científicos y que nunca antes se habían visto en ese planeta.

Callas, uno de los científicos seguidores de la misión, nos dice:

“El Opportunity ha sido una excelente experiencia para la Nasa. Ayudó a confirmar el valor de los exploradores básicos y marcó una línea para las futuras versiones, como el Curiosity”. No es lo único, dice. Este rover ya marcó a toda una generación. “Inspiró a jóvenes a involucrarse en carreras de tecnología y ciencia, algo que tendrá beneficios incontables en las próximas décadas”.

Basado en aquellos dos legendarios Rovers, Oportunity y Spirit, se envió uno más moderno y sofisticado al planeta, Curiosity que, se ha quedado con la atención del público y está realizando nuevos descubrimientos que vendrán a enriqurecer lo que ya sabemos de aquel planeta, entre otras muchas cuestiones y datos enviados, aparece una gran clolección de imágenes que hay que examinar con atención para poder obtener de ellas, los mensajes que nos envían desde millones de años de distancia en el pasado.

Granos de carbonato, en color naranja (100 a 200 micras de diámetro), indican que el meteorito estuvo una vez inmerso en el agua.

El meteorito destaca la presencia de lo que parecen ser microbios fosilizados.

¿Microbios fosilizados? Eso dijeron algunos

Bueno, el presente trabajo que es un pequeño homenaje a los primeros Rovers que salieron desde la Tierra hacia Marte en una aventura indecisa, resultó que nos ha dado beneficios impensables y, ahora, sin lugar a ninguna duda podemos decir que tanto Oportunity como Spirit (y las que vinieron detrás), nos han dado conocimientos que no teníamos y, han ayudado grandemente a que conoczcamos aquel planeta que algún día, lejano aún en el futuro próximo (no creo que antes de 50 años) podamos visitar, para instalar una colonia de la Tierra.

Lo cierto amigos es que hay que felicitar a todos los que de una u otra forma contribuyeron con sus ideas y su trabajo a que todas estas misiones pudieran ser un hecho que, cuando se han ido produciendo no le hemos dado la importancia que realmente han tenido todas esas misiones al Espacio Exterior encamionadas al conocimiento de los planetas y lunas que situadas en el Sistema Solar, nos pueden dar algún día futuro, una gran sorpresa.

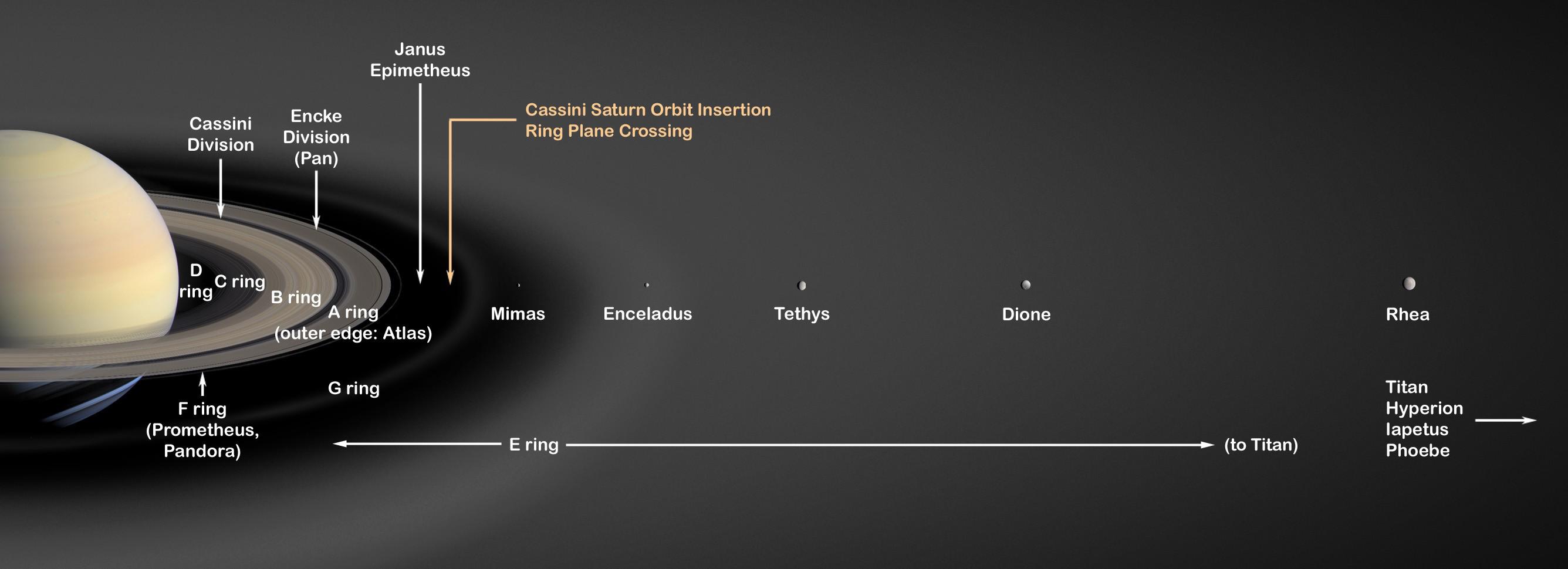

Recordemos aquellas primeras imágines de Titán y las primeras noticias que llegaron decían: “¡Huygens en Titán!” La Misión Cassini, qué tantos rendimientos científicos nos ha proporcionado, tiene aún, algunas cartas guardadas en la manga en forma de noticias nuevas y, asombrasas.

En su momento pudimos leer en todos los medios escritos y hablados:

“Hoy después de un viaje de siete años a través del sistema solar abordo de la nave Cassini, la sonda Huygens de la ESA ha descendido con éxito a través de la atmósfera de Titán, la mayor luna de Saturno y ha aterrizado a salvo en su superficie.

Los primeros datos científicos llegaron a el Centro de Operaciones Espaciales Europeo (ESOC) en Darmstadt, Alemania, esta tarde a las 17:19 CET. La sonda Huygens constituye el éxito de la humanidad en el intento de aterrizar una sonda en un mundo del Sistema Solar exterior. Según Jean-Jaques Dordain, Director General de la ESA:”Este es un gran logro para Europa y sus colegas de los Estados Unidos, en esta ambiciona empresa de explorar el sistema saturniano”.

Con los primeros datos se pudo llegar a saber que la temperatura en el interior de la sonda rondaba los 25ºC cuando se encontraba a unos 50 km de altura. Por otra parte, la sonda contaba con dos canales (A y B) independientes para retransmitir los datos de manera redundante. Según parece el canal A no funcionó y tan sólo se lograron los datos del B del que sí, llegaron todos. El experimento de Doppler con Cassini si necesitaba del canal A por lo que habrá que esperar a la recepción de todos los datos. El paracaidas principal se abrió tan sólo 15 segundos despues de lo planeado y los acelerómetros han funcionado correctamente.”

La Huygens desciende sobre la superficie de Titán

¿Que sabemos de Titán?

Titán es el satélite mayor de Saturno y la segunda de las mayores lunas del Sistema Solar, la cual sólo rivaliza en tamaño con Ganimedes -satélite de Júpiter-. Este mundo siempre ha resultado de enorme interés a los científicos pues se considera un “laboratorio de la vida”, un lugar que podría ser reflejo -desde el punto de vista biológico- de lo que era el planeta Tierra hace más de 3500 millones de años.

Titán es un mundo único en el Sistema Solar y muy enigmático: su superficie es una incógnita, pues su densa atmósfera formada fundamentalmente por nitrógeno nunca nos ha permitido observar sus rasgos superficiales. A todo ello se le suman una gran cantidad de incógnitas: la posibilidad de existencia de mares o lagos superficiales de hidrocarburos, de materia orgánica e incluso de vida.

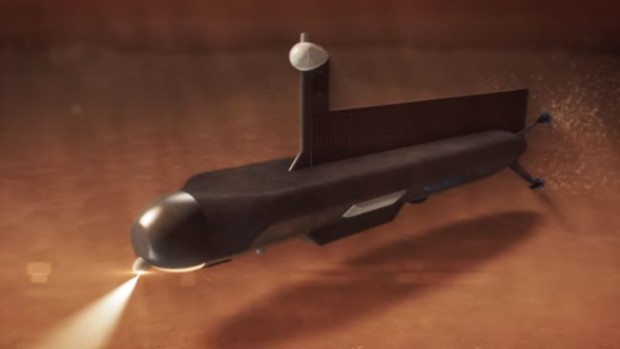

Océanos de metano en Titán que son contemplados por Saturno. La luna nos muestra los terrenos y atmósfera de la Tierra joven. Ahora están preparando un submarino en miniatura que navegará por los océanos de Titán.

Este será el submarino que surcará las profundidades de algún océano de Titan

Todas las misiones que han estudiado con mayor o menor detalle este mundo -Pioneer 11 y sobre todo las Voyager 1 y 2- han obtenido datos de gran interés, aunque no han podido desentrañar muchos de los misterios que rodean a esta interesante luna. En 2004 comenzó la aproximación del orbitador Cassini al planeta Saturno y acto seguido su inserción orbital, lo que tuvo lugar en julio de 2006. Justo seis meses después, este orbitador dejó caer la sonda Huygens a través de la atmósfera de la luna Titán, hacia su superficie.

En este trabajo trataremos sobre el satélite Titán, realizando una revisión sobre los conocimientos acerca del mismo y las últimas hipótesis que los científicos tienen en mente, las cuales es fácil que den un vuelco cuando los técnicos de la misión Cassini-Huygens comience a estudiar con detalle este pequeño mundo y todos los datos que han podido ser captados por nuestros ingenios.

Un extraño pequeño mundo donde llueve metano y haría las delicias de las compañias petrolífieras

Titán, el mayor satélite de Saturno, es un lugar misterioso. Su gruesa atmósfera es rica en compuestos orgánicos, algunos de los cuales podrían implicar la presencia de signos de vida si se hallasen en nuestro planeta. ¿Cómo se han originado éstos? ¿Pueden ayudarnos a descubrir como la vida se formó en la Tierra? Y, estando ahí presentes estos compuestos bioquímicos, ¿estará presente allí alguna clase de vida?

La sonda Huygens de la Agencia Espacial Europea (ESA), que viajó junto a la Cassini en ruta hacia Saturno llegó a la superficie de Titán en el año 2005. Mientras tanto, en la Tierra, los estudios mediante telescopio sirvieron para decidir en qué punto de Titán se efectuará el aterrizaje.

Pioneer 11 en 1979

– Estudian Júpiter, Saturno, Urano y Neptuno, sus lunas y sus anillos.

– Son los más lejanos de la Tierra y también los qué más tiempo llevan en órbita.

– Sus baterías tienen capacidad para aguantar en el espacio hasta el 2020.

|

Han cruzado la frontera más lejana que nunca ha atravesado el ingenio humano, 38 años en órbita sin interrupciones. Las sondas gemelas Voyager partieron de la Tierra el verano de 1977 y desde entonces envían información de todo aquello que se han encontrado a su paso. Las misiones espaciales Pioneer 11 en 1979 y Voyager 1 y 2 en 1980 realizaron sobrevuelos sel Sistema de Saturno. La Voyager 1, se desvió lo necesario para sobrevolar Titán.

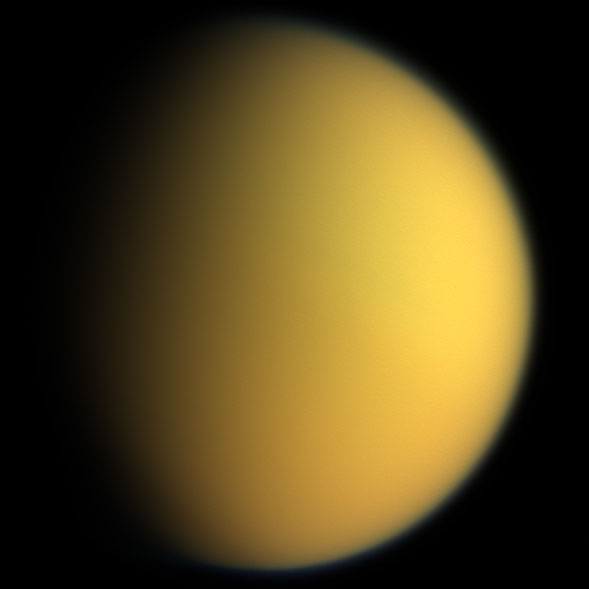

Así fue captado Titán por la Viyager 2

La sonda Voyager 1 de la NASA sirvió para obtener las primeras imágenes detalladas de Titán en 1980. En ellas se apreciaba sólo una atmósfera anaranjada, opaca y aparentemente homogenea, tan gruesa que no permitía ver la superficie de este mundo. De todas formas, a pesar de ello, otros datos revelaron interesantes aspectos de esta luna: de manera similar a la Tierra, su atmósfera estaba formada mayoritariamente por nitrógeno y también por algo de metano, así como otros compuestos orgánicos.

Titán es el mayor de los satélites conocidos de Saturno. En esta fotografía tomada a 12 millones de kilómetros se aprecian las capas nubosas exteriores que cubren la superficie de esta luna. La neblina anaranjada, formada por hidrocarburos producidos por fotólisis, nos esconde la superficie sólida de este mundo.

Como es hoy Titán se cree podría ser la Tierra Primitiva hace algunos miles de millones de años. Se cree que en la actualidad, en aquel ambiente de Titán y su espesa atmósfera, podría exisir alguna clase de vida.

Las sondas espaciales como la Cassini-Huygens y otras, nos han posibilitado para contemplar imágenes del espacio exterior que nunca habríamos imaginado ver. Si los descubridores de estas lunas de Saturno pudieran ver lo que nosotros hoy, creo que se llenarían de gozo al ver como su granito de arena siguió rodando por la ladera del conocimiento para hacerse mayor, una sólida y gran roca del conocimiento.

Titán en color natural (sonda Cassini-Huygens 2005)

Titán es el mayor de los satélites de Saturno, siendo el único del Sistema Solar que posee una atmósfera importante. Según los datos disponibles su atmósfera podría estar compuesta principalmente de nitrógeno, pero hasta un 6% puede ser metano y compuestos complejos de hidrocarburos. En el año 2005, la sonda espacial Cassini-Huygens descendió en paracaídas por la atmósfera de Titán y aterrizó en su helada superficie para descubrir algunos de sus secretos.

¡Sigamos soñando con la realidad! En este presente que ya es futuro. En los trabajos siguientes anumeramos los inconvenientes que tenemos houy en hacer un viaje tripulado a Marte.

Si queréis más lecturas…

emilio silvera

May

1

¿Viaje Tripulado a Marte? ¡Ilusos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (0)

Comments (0)

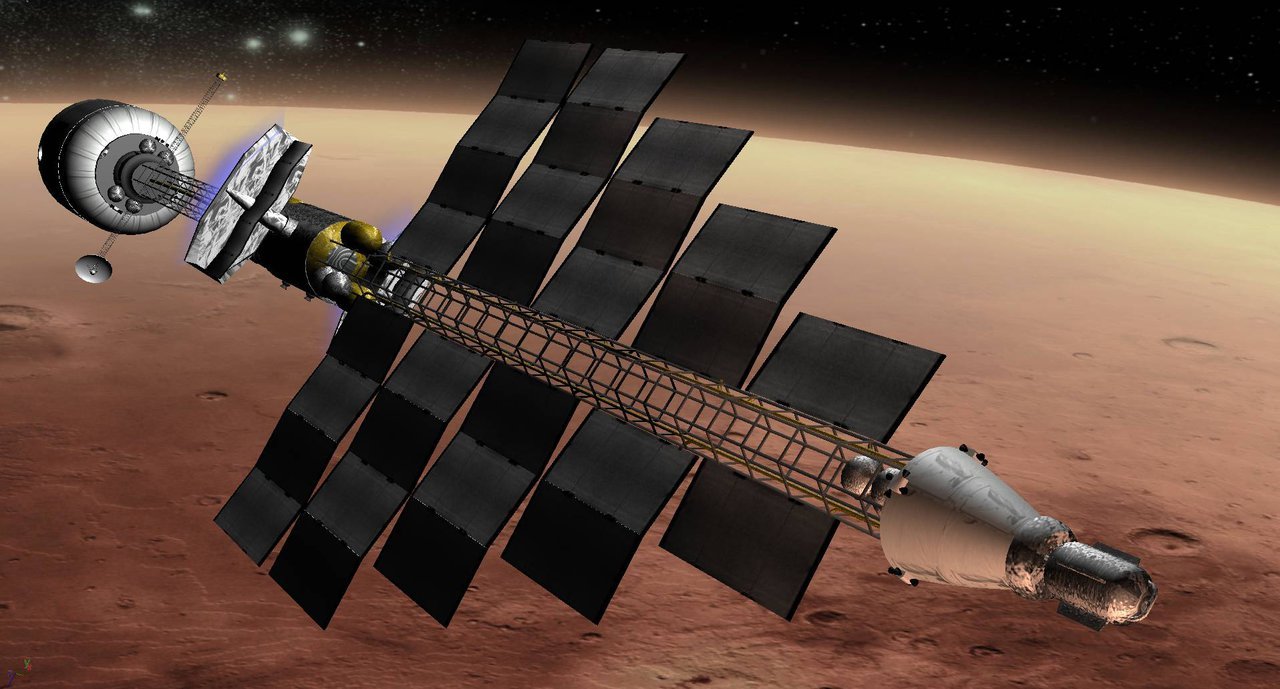

Exploración espacial. Pese a que una auditoría cuestiona los muchos incionvenientes y apuro, los científicos ya definen los mejores puntos para establecer las colonias en el planeta Marte, y, aunque parezca prematuro, el ir limando “asperezas” para prevenir situaciones difíciles cuando llegue el momento… ¡No está demás!

|

La promesa quedó asentada como un dictamen y la National Aeronautics and Space Administration (NASA) comienza a ensayar diferentes soluciones para poner un pie en Marte en 2030, considerado el próximo objetivo de la exploración espacial humana. Pensando en una eventual colonización, 175 científicos de diferentes áreas se dieron cita en el Lunar and Planetary Institute, en Houston, para intentar consensuar el mejor punto de amartizaje.

Los elementos esenciales para elegir esta posición contemplan desde la seguridad para asentar la astronave hasta la ejecución de algunas operaciones de exploración, como el acceso a los recursos locales para los primeros colonizadores y la posibilidad de obtener al menos 100 toneladas métricas de agua.

Los potenciales territorios necesitan cumplir una serie de requisitos. Cada puesto de avanzada debe estar rodeado por una “zona de exploración” de 100 kilómetros. Un conjunto de tres a cinco aterrizajes permitirán a seis tripulantes llevar a cabo los primeros sondeos, con 500 días marcianos por expedición.

En esta instancia previa se delimitaron unos 50 puntos de descenso ubicados dentro de los 50° de latitud, Norte o Sur, del ecuador marciano. En los próximos 8 años los esfuerzos de los expertos se van a centrar en reducir este número y seleccionar las diez mejores posiciones geográficas para asentar una nave. La intención es realizar varios sobrevuelos al planeta y bajar en una de sus lunas.

Mientras James Green, director de Ciencia planetaria de la NASA sostuvo que “los humanos acabarán pisando Marte”, una auditoría interna cuestiona que, desde el aspecto técnico, todavía no están dadas las condiciones para una misión tan compleja. El responsable de este informe fue Paul K. Martin, inspector general de la NASA, quien señaló que no están preparados en la actualidad y es probable que tampoco consigan avanzar lo suficiente en los próximos 15 años.

El mayor riesgo lo deben afrontar los astronautas, ya que hay una enorme exposición a radiación “con posibilidades de desarrollar cáncer y otras enfermedades degenerativas, pérdida de densidad de los huesos y estiramiento de los músculos por la alteración de la gravedad, además de profundos cambios psicológicos motivados por un viaje tan largo y exigente” expone Martin.

Sobre esta cuestión, el astrobiólogo del Blue Marble Space Institute for Science, Jacob Haqq-Misra, sostiene en un artículo publicado en New Space que los astronautas deberán abandonar su nacionalidad terrícola para pasar a ser un orgulloso ciudadano del planeta rojo. También defendió la prohibición de las relaciones comerciales entre ambos planetas e indicó que una vez asentados en Marte se evite cualquier interferencia de la Tierra sobre el nuevo desarrollo cultural, económico o social.

Lo dicho, ni en 2020 ni en algunas decenas más de años podremos viajar al planeta Marte con todas las garantias, son muchos los inconvenientes de todo tipo que nos lo impedirán, tanto tecnológicos como naturales.

Nota: En las dos próximas entradas se recogen los muchos impedimentos que presenta este viaje tripulado.

May

1

¿Por qué es difícil Viajar a Marte? I (Apuntes de la NASA)

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (0)

Comments (0)

¿Por qué es difícil ir a Marte?

Fotograma de la película ‘The martian’. AIDAN MONAGHAN

El estreno de la película ‘Marte’ (The Martian) ha despertado cierta curiosidad acerca de posibles futuros viajes humanos al planeta rojo. Después de haber ido a la Luna en varias ocasiones hace ya casi cinco décadas, y estando acostumbrados a ver astronautas viajar al espacio casi de forma rutinaria, es tentador pensar que enviar seres humanos a Marte pueda ser algo perfectamente plausible a día de hoy, o tal vez un tanto más complicado que lo hecho hasta ahora. Sin embargo, la realidad es que enviar seres humanos a Marte constituye un desafío de una dificultad y complejidad absolutamente descomunales que se aleja mucho de todo lo que se ha hecho hasta ahora en la historia de la exploración humana del espacio.

En esta y en la siguiente entrada hablaré de las razones por las que esta empresa constituye un desafío inmenso y sobre cómo se plantea en la actualidad una misión tripulada a Marte. Con objeto de ofrecer una perspectiva inicial para entender la dimensión del problema de una forma intuitiva, en esta entrada trataré de la razón principal que hace extremadamente difícil una misión a Marte, la razón de la que prácticamente se derivan casi todas las demás: la distancia.

Matt Damon in “The Martian.” Credit Aidan Monaghan/Twentieth Century Fox

Vemos astronautas viajar con frecuencia al espacio, a la Estación Espacial Internacional (ISS), antes a la estación Mir, a bordo de naves Soyuz, o antes a bordo del Transbordador Espacial, etc., y se suele tener la impresión de que el lugar al que se viaja en estas misiones es muy lejano; sin embargo, las altitudes típicas a las que estas estaciones y vehículos espaciales orbitan alrededor de la Tierra son de unos pocos cientos de kilómetros. La ISS, por ejemplo, orbita alrededor de la Tierra a una altitud que es equivalente a la distancia que hay en línea recta entre Madrid y Almería: unos 400 km. Esta región espacial a la que viajan los humanos de forma rutinaria está dentro de la conocida como ‘región de las órbitas bajas de la Tierra’, y técnicamente la llamamos LEO (del inglés Low Earth Orbit).

Comparativa entre orbitas bajas de la Tierra (arriba) y la distancia a escala entre la Tierra y la Luna (abajo).

Los viajes tripulados lunares implicaron viajar más allá de las órbitas LEO ya que la Luna orbita nuestro planeta a una distancia media de unos 380.000 km, lo que viene a ser unas 1.000 veces más lejos que las altitudes de estas órbitas bajas. Una tripulación y su nave se ponen en órbita alrededor de la Tierra poco después de su lanzamiento, mientras que la distancia a la Luna se cubría en las misiones Apolo en prácticamente 3 días.

En el caso de Marte la situación es muy diferente. Ir a Marte implica pasar de una misión geocéntrica a una centrada en el Sol, o heliocéntrica, lo que supone un salto enorme en las distancias involucradas. Aunque las distancias máxima y mínima entre la Tierra y Marte varían dentro de un cierto rango, la mínima distancia posible es de unos 55 millones de km y la máxima posible es de unos 400 millones de km.

Estas son distancias enormes en comparación a todo lo que se ha volado en misiones tripuladas al espacio hasta ahora. La distancia máxima a Marte viene a ser 1.000 veces mayor que la que hay entre la Tierra y la Luna, lo que viene a ser 1.000.000 de veces mayor que la distancia que separa la superficie terrestre de las órbitas LEO a las que se viaja normalmente.

Distancias aproximadas mínima y máxima posibles entre la Tierra y Marte. Como referencia, la distancia media de la Tierra a la Luna es de 380.000 km.

Sin necesidad de conocer nada más, los datos acerca de la distancia a Marte ya constituyen una buena pista para empezarnos a asomar a la magnitud del problema. Para apreciarlo mejor, y sin entrar en detalles relativos a métodos de propulsión o dinámica orbital, vamos a comparar en números redondos dos misiones tripuladas, una orbital alrededor de la Tierra para un solo tripulante y otra lunar de tres tripulantes, para hacernos una idea de la progresión en la masa necesaria de los cohetes involucrados para llevar a cabo estas misiones y entender el contexto de lo que supondrá una misión a Marte.

Empezamos con la primera misión orbital del Programa Mercury de principios de los ’60: la Mercury 6 de John Glenn. Aquí se precisó de un cohete Atlas de 120 toneladas y 29 metros de altura para poner en una órbita de 200 km de altitud media alrededor de la Tierra una masa útil de 1,2 toneladas formada por una cápsula Mercury con su único tripulante, el cual permaneció en el espacio 5 horas.

Veamos ahora lo que cambia la situación al tener a la Luna como destino unas 1.000 veces más lejos. En el caso del Apolo 17 -la última misión de exploración lunar-, su módulo de mando y servicio más su módulo lunar, sumando todo cerca de 50 toneladas, hubieron de ser lanzados a la Luna por el poderoso cohete Saturno V de unas 3.000 toneladas y de 110 metros de altura para una misión de una duración total de unos 12 días y medio en la que 2 de sus tripulantes permanecieron sobre la superficie lunar algo más de 3 días.

Cohete lunar Saturno V junto al cohete Atlas del Programa Mercury para un tripulante (Transbordador Espacial incluido como referencia). Fuente: http://historicspacecraft.com/.

Vemos así el salto cuantitativo necesario cuando queremos ir a otro mundo que está 1.000 veces más allá de las órbitas bajas de la Tierra tanto en la masa útil a lanzar (de 1,2 a 50 toneladas) como en el tamaño del cohete lanzador requerido (de 120 a 3.000 toneladas). Comparemos todo esto con una misión a Marte. Aquí la tripulación constará de 6 astronautas y su duración, tomando como ejemplo la oportunidad en 2037, sería de 174 días para la ida y 201 días para la vuelta, con una estancia de 539 días en Marte. Una estancia tan larga en Marte sería necesaria a la espera de que la posición relativa entre este planeta y la Tierra fuera óptima para el regreso con un mínimo gasto de combustible, lo que ahorra el envío de centenares de toneladas de combustible. Todo esto supone un total de 914 días, o 2 años y medio.

Como vemos, el salto entre la Luna y Marte es descomunal, ya que doblar la tripulación y extender la duración a cerca de 73 veces la de la misión lunar más larga, supone la necesidad de proveer y transportar cerca de 150 veces más suministros. Por otra parte, una mayor duración de viaje interplanetario supone la necesidad de proveer a la tripulación de mayor protección contra las radiaciones, lo que se consigue en parte añadiendo aún más masa, aunque este problema no está aún resuelto.

Otro problema de la larga duración es que las cosas se rompen a lo largo de tanto tiempo. O bien se tendrá que mejorar sustancialmente la durabilidad de los equipos o estos habrán de poder ser repuestos por recambios que también habrá que transportar, lo que implica una mayor masa. Las naves de carga que visitan la ISS pueden abastecerla de repuestos cuando algo se estropea a bordo pero esta opción no será posible en una misión a Marte.

Una vez dicho todo esto, al igual que cuesta más acelerar y frenar un camión que un turismo por tener el primero más masa, tengamos en cuenta que enviar más masa a Marte implica transportar también más combustible para acelerar toda esa carga hacia Marte, para frenarla a la llegada a ese planeta, y para volver a la Tierra desde allí; y pensemos que todo ese combustible (centenares de toneladas) también hay que lanzarlo al espacio inicialmente.

En total, para una misión a Marte se requerirá lanzar al espacio entre 850 y 1.250 toneladas. Esta es una cantidad enorme si tenemos en cuenta que la Ia ISS tiene una masa de unas 420 toneladas y que una nave con la que estamos familiarizados como el Transbordador Espacial solo podía enviar al espacio entre 15 y 25 toneladas aproximadamente, dependiendo de la altitud de la órbita final. El Ariane 5 es capaz de poner unas 20 toneladas en órbita baja alrededor de la Tierra, al igual que el cohete ruso Protón, por ejemplo.

Así pues, a partir de todo esto, y sin saber mucho más, ya podemos anticipar de forma intuitiva que no se podrá utilizar un único cohete para ir a Marte, sino que se precisarán varios lanzamientos de cohetes -tanto o más poderosos que el Saturno V de los años ’60- para ensamblar en el espacio distintos elementos de propulsión, módulos de combustible, hábitats y naves, que habrán de enviarse a Marte por separado y por anticipado, además de la nave con la tripulación, que sería enviada en último lugar. Entraremos en estos detalles en la siguiente entrada.

Aunque depende de diversos factores, se requerirán, de hecho, del orden de 10 lanzamientos de cohetes con la capacidad del Saturno V o similar; pero recordemos que el número total de cohetes Saturno V que se enviaron a la Luna en todo el Programa Apolo fue de 9. El Saturno V fue retirado de servicio después del Porgrama Apolo pero ostenta el récord, aún a día de hoy, como el cohete operativo más poderoso que haya habido nunca, capaz de poner algo más de 120 toneladas en órbita baja alrededor de la Tierra y de enviar 50 toneladas a la Luna. Tuvo que ser específicamente diseñado y construido en su día para poder alcanzar la Luna, y no existe un lanzador de tanta capacidad en la actualidad. El cohete que se encargaría de la mayor parte de los lanzamientos en una futura misión a Marte se está desarrollando en la actualidad y se llama SLS (Space Launch System), el cual tendrá prestaciones parecidas o acaso un tanto mayores que el Saturno V.

Por otra parte, un tiempo de 174 días de ida en condición de ingravidez afecta profundamente a la fisiología humana, algo especialmente preocupante al llegar a un planeta donde no hay nadie para asistirte. Las naves que se pueden ver en las películas (incluida la película ‘Marte’), con un amplio y confortable habitáculo en forma de donut girando para simular la aceleración de la gravedad, no son realistas en la actualidad.

Dos años y medio es un tiempo muy largo también por razones psicológicas. La Tierra será vista por la tripulación como un punto de luz semejante a una estrella durante la mayor parte del viaje y será apenas imperceptible en la noche marciana cuando fuera visible. La tripulación tendrá que convivir en una condición de confinamiento permanente en un espacio reducido en una situación de gran estrés, y con la imposibilidad de mantener conversaciones fluidas con los seres queridos en la Tierra debido al tiempo de viaje de la señal.

Después de todo esto, y aunque no se han mencionado todas las dificultades técnicas, tecnológicas y operativas, creo que ahora puede apreciarse un poco mejor a lo que nos enfrentamos en una misión a Marte. A partir de aquí, y una vez expuesta esta perspectiva para contextualizar el problema y entrar en materia, en la siguiente entrada explicaré cómo se plantea en la actualidad una misión humana a Marte y cómo se relaciona con lo que se ve en la película ‘Marte’ (The Martian).

sigue en la II parte

May

1

¿Que es la Vida? ¿Dónde reside su origen?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

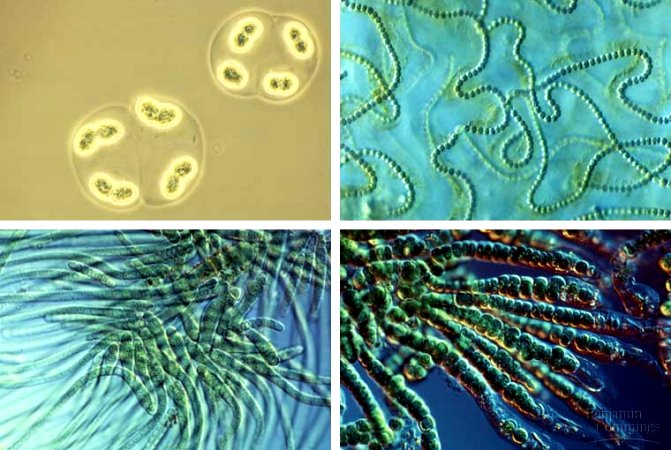

La Gran Fuente Prismática del Parque Nacional Yellowstone

En algún momento del pasado de la Tierra, estimado en aproximadamente 2.500 – 3.500 millones de años, tuvo lugar lo que denominamos revolución oxigénica, durante la cual las cianobacterias produjeron tanto oxígeno que la atmósfera y los océanos quedaron literalmente saturados de este nuevo compuesto químico. Tal producción de oxígeno afectó drásticamente a la biósfera del planeta. Antes de la revolución oxigénica, pocos organismos estaban adaptados para vivir en presencia de oxígeno abundante; las moléculas de oxígeno actuaban como un veneno, reaccionando con las moléculas orgánicas complejas y degradándolas. Debido a esto, la mayor parte de la vida existente en ese momento debió quedar exterminada; las cianobacterias serían responsables de una gran extinción masiva.

Por otro lado, los elevados niveles de oxígeno que se acumularon en la atmósfera dieron como resultado una capa de ozono, de vital importancia para la vida como la conocemos ahora. El ozono filtra los perniciosos rayos ultravioletas, que tienen un efecto especialmente perjudicial para los ácidos nucleicos, impidiendo que lleguen a la superficie de la Tierra. Si lo miramos desde esa perspectiva, es muy probable que el desarrollo de la vida fuera de los océanos y más aún, de toda la vida como la conocemos, incluso la nuestra, haya sido posible solo gracias a la capa de ozono, y por ende, a las cianobacterias que aportaron el abundante oxígeno para generarla.

Podemos concluir diciendo que, hace 5.000 millones de años nacía nuestra estrella, el Sol. Luego, hace 4.600 millones de años se formaron planetas, entre ellos nuestra querida Tierra. Según el fósil, la vida se origino poco después, hace aproximadamente 4.000 millones de años. Los relámpagos y la luz ultravioleta del Sol descomponían las moléculas ricas en hidrógeno de la atmósfera, estas a su vez se reorganizaban espontáneamente produciendo moléculas más y más complejas convirtiendo a los mares primitivos en una verdadera sopa orgánica. Los cometas, asteroides y meteoritos aportaron mucha agua y muchos compuestos químicos orgánicos que fueron esenciales para el posterior desarrollo de la vida en la Tierra. Algunos científicos especulan inclusive que las primeras formas de vida en nuestro planeta, las bacterias, llegaron transportadas en el interior acuoso de los cometas. Otra posibilidad que no se puede ignorar es que esas primeras bacterias hallan llegado a bordo de meteoritos provenientes de Marte en épocas en las cuales el planeta rojo era muy parecido a la Tierra.

Mientras seguimos investigando sobre lo que la vida es, amigos míos, procuremos preservar su cuna: ¡La Tierra! Este “mar” de tranquilidad y perfecta simetría en el que se producen los precisos sucesos para que todo siga igual. Movimientos tectónicos, erupciones volcánicas, terremotos…Todo tiene un por qué y, me estoy oliendo que ese por qué, tiene mucha relación con el hecho de que la Vida, siga presente aquí, en un planeta privilegiado que, situado en la parte interior del Brazo de Orión, a 30 000 años-luz del Centro Galáctico, hace posible que eso que llamamos vida, persista y siga evolucionando para que observe el Universo y llegue a comprenderlo.

¡Cuánto trabajo nos queda por delante!

La pregunta que nos ha llevado siempre de cabeza en relación al Origen de la Vida, no ha podido ser contestada todavía con la certeza científica que todos deseamos. Mucho se ha investigado y los avances y logros del conocimiento humano sobre lo que la vida es, ha dado un gran paso hasta el punto de que en la actualidad podemos estar seguros de muchas cosas relacionadas con la vida y, continuamos uniendo los hilos y atando los cabos sueltos que nos lleven a saber cómo pudo surgir la vida en nuestro planeta y, sobre todo, comprender los procesos que durante miles de años se han producido con ayuda de agentes externos para que, esa evolución, fuese posible.

Desde que el Ser Humano comenzara a pensar, siempre ha estado de actualidad la temática y la inquietante pregunta: ¿De dónde y cómo pudo surgir la vida en nuestro planeta? Desde las brumas de la mitología, hasta los orígenes de la Ciencia hemos estado batallando con esa inquietante pregunta y, según creo, así seguiremos hasta la consumación de los siglos, toda vez que, mientras no lleguemos al nivel más alto que la vida tiene destinado, es decir, ¡convertirse en pura luz! ¡Fundirse con la energía del universo! Hasta entonces, no llegaremos a comprender lo que la vida es.

emilio silvera

Totales: 83.939.895

Totales: 83.939.895 Conectados: 47

Conectados: 47