Ago

20

El “mundo” de lo muy pequeño… ¡Es tan extraño!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo. Simplemente con que su carga fuera distinta en una pequeña fracción… ¡El mundo que nos rodea sería muy diferente! Y, ni la vida estaría presente en el Universo.

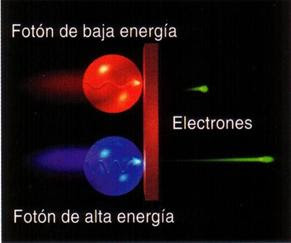

Experimentos con electrones y positrones nos enseñaron cómo funciona el universo

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

En esta gráfica a cada temperatura el cuerpo negro emite una cantidad estándar de energía que está representada por el área bajo la curva en el intervalo.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, pero esto lo veremos más adelante.

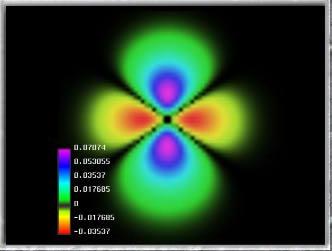

La primera es la imagen obtenida por los físicos en el laboratorio y, la segunda es la Imagen ilustrativa de la dualidad onda-partícula, con la cual se quiere significar cómo un mismo fenómeno puede tener dos percepciones distintas. Lo cierto es que, el mundo de lo muy pequeño es extraño y no siempre lo podemos comprender.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

El “universo de las partículas nunca ha sido fácil de comprender y su rica diversidad, nos habla de un vasto “mundo” que se rige por su propias reglas que hemos tenido que ir conocimiendo y seguimos tratando de saber, el por qué de esos comportamientos extraños y a veces misteriosos. Así, la pregunta anterior, de ¿qué puede significar todo eso?…

La pudo contestar Niels Bohr, de forma tal que, con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Mucho ha sido el camino andado hasta nuestros tratando de conocer los secretos de la naturaleza que, poco a poco, nos van siendo familiares. Sin embargo, es más el camino que nos queda por recorrer. Es mucho lo que no sabemos y, tanto el micromundo como en el vasto mundo de muy grande, hay que cosas que aún, no hemos llegado a comprender.

El detector ATLAS funcionó, y rastrearon las partículas subatómicas…

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los “trucos” ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, localizar y saber en qué punto exacto están esas pequeñas partículass… no es fácil

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Función de onda para una partícula bidimensional encerrada en una caja. Las líneas de nivel sobre el plano inferior están relacionadas con la probabilidad de presencia.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

(“El teorema de Bell o desigualdades de Bell se aplica en mecánica cuántica para cuantificar matemáticamente las implicaciones planteadas teóricamente en la paradoja de Einstein-Podolsky-Rosen y permitir así su demostración experimental. Debe su nombre al científico norirlandés John S. Bell, que la presentó en 1964.

El teorema de Bell es un metateorema que muestra que las predicciones de la mecánica cuántica (MC) no son intuitivas, y afecta a temas filosóficos fundamentales de la física moderna. Es el legado más famoso del físico John S. Bell. El teorema de Bell es un teorema de imposibilidad, que afirma que:

Ninguna teoría física de variables ocultas locales puede reproducir todas las predicciones de la mecánica cuántica.”)

¿Cómo saber el número que saldrá cuando lanzamos los dados?

¡¡La mecánica cuántica!!, o, la perplejidad de nuestros sentidos ante lo que ese “universo cuántico” nos ofrece que, generalmente, se sale de lo que entendemos por sentido común. Ahí, en el “mundo” de los objetos infinitesimales, suceden cosas que no siempre podemos comprender. Y, como todo tiene una razón, no dejamos de buscarla en cada uno de aquellos sorprendentes sucesos que en ese lugar se producen. Podríamos llegar a la conclusión de que, la razón está en todo y solo la encontramos una vez que llegamos a comprender, mientras tanto, todo nos resulta extraño, irrazonable, extramundano y, algunas veces…imposible. Sin embargo, ahí está. Dos elementos actúan de común acuerdo para garantizar que no podamos descorrer el velo del futuro, de lo que será después (podemos predecir aproximaciones, nunca certezas), el principal de esos elementos es la ignorancia nunca podremos saber el resultado final de éste o aquél suceso sin tener la certeza de las condiciones iniciales. En la mayoría de los sistemas físicos son, en mayor o menor medida dada su complejidad, del tipo caótico es tal que, el resultado de las interacciones entre elementos eson sumamente sensibles a pequeñísimas variaciones de los estados iniciales que, al ser perturbados mínimamente, hacen que el suceso final sea y esté muy alejado del que se creía al comienzo.

emilio silvera

Ago

20

Los pros y los contras de las máquinas más listas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en I. A. ~

Clasificado en I. A. ~

Comments (0)

Comments (0)

Inteligencia artificial

El aprendizaje automático es uno de los campos con más proyección en inteligencia artificial.

Tenemos la clave para fabricar máquinas listas. Intel

Los miles de millones de dispositivos que se conectan a internet cada día generan una cantidad abrumadora de información. Son montones de terabytes de datos que aparecen de la nada diariamente.

Esto abre el apetito por obtener valor de la información. Y la inteligencia artificial es clave aquí. El término se suele asociar con la robótica, una herencia cultural de la ciencia ficción, pero lo cierto es que la inteligencia artificial es algo mucho más abstracto que robots humanoides caminando o que los dilemas del superordenador Hal en 2001: una odisea del espacio.

Ojo cámara (con lente fish eye es decir con una visual muy panóptica) de color rojo (para detectar por filtro cromático incluso la “luz” IR no perceptible por el ser humano), usado para representar a HAL 9000 en uno de sus aspectos de control prácticamente orweliano.

Podría decirse que la inteligencia artificial asoma la cabeza por primera vez en los años 60 con sistemas predictivos y a partir de ahí evoluciona a velocidad de crucero. Hoy se usa para evitar fraudes bancarios, en el reconocimiento de voz, en el filtro anti spam del correo electrónico, incluso en el etiquetado de fotos automático de Facebook o en los videojuegos.

Lo que está por venir en inteligencia artificial –ya se ha investigado mucho sobre ello– son los coches autónomos, la medicina de alta precisión o el procesamiento del lenguaje natural que le pediremos a los Siri, Google Now o Cortana en los próximos años. Son algunas de las áreas para las que el aprendizaje automático o machine learning es necesario.

Que las máquinas aprendan es fundamental porque es uno de los elementos que retrasará su obsolescencia prematura, reforzando su autonomía. Este aprendizaje es uno de los temas que han sobrevolado la Conferencia Internacional de Desarrolladores (IDF) de Intel.

Hoy el 7% de todos los servidores presentes en el mundo están dedicados a tareas de aprendizaje automático. Y más del 97% de estos servidores funcionan con procesadores de Intel. Si bien en campos como los coches autónomos la compañía se ve amenazada por los productos de su competidora Nvidia.

En todo caso, esta rama de la inteligencia artificial es la que tiene mayor proyección. Intel proporciona el hardware sobre el que los desarrolladores pueden programar sus algoritmos de inteligencia artificial. Para entrenar a los algoritmos la compañía ofrece el procesador Xeon Phi, mientras que para ejecutar una tarea determinada, ya aprendida, cuenta con el Xeon.

“Trabajamos con instituciones académicas y desarrolladores para asegurarnos de que pueden usar el hardware optimizado”, comenta Nidhi Chappell, responsable de aprendizaje automático en la división de centros de datos de Intel. “Hay muchos beneficios en tener el software y el hardware optimizado. ¿Podrías trabajar con procesamiento del lenguaje natural en un Xeon no optimizado? Sí, pero cuanto más optimices los elementos, tanto en software como en el hardware, más rápido harás los trabajos”.

Se necesita que el rendimiento del hardware sea muy alto, pero también que sea fácil de poner en marcha. Y otra de las claves para optimizar este aspecto es la compatibilidad con diferentes tipos de algoritmos. “Queremos habilitar nuestros productos para soluciones que estén basadas en código abierto”, indica Chappell. “Pues muchas de las cargas de trabajo en deep learning, como el procesamiento del lenguaje natural o el etiquetado de imágenes, están basadas en frameworks (marcos de trabajo para desarrollar software) de código abierto”.

Los algoritmos del ‘Deep learning’

El Deep learning o aprendizaje profundo, considerado una parte del aprendizaje automático, se basa en redes neuronales artificiales, inspiradas en el funcionamiento de sistemas biológicos. Muchos algoritmos que usan deep learning proceden de empresas o universidades, como Google o Berkeley, y una parte de ellos están bajo código abierto. Lo que hace Intel es asegurarse de que la arquitectura de sus productos está optimizada para estos algoritmos.

El conocimiento que los nutre proviene de compañías privadas, de centros académicos y también de instituciones públicas. No todo se pone a disposición del público, pero compartir la información y los progresos técnicos es uno de los motores para el aprendizaje de las máquinas.

Cloudera, una de las empresas presentes en el IDF, trabaja en big data con plataformas de código abierto. Su portavoz en el congreso de Intel, Johnny Pak, cree que la colaboración es necesaria para no estancarse. “El código abierto ayudará al desarrollo rápido de la inteligencia artificial. La posibilidad de construir sobre el trabajo de otros es lo que va a ayudar a avanzar”, reflexiona.

El conocimiento proviene de múltiples fuentes. Intel

Aprender bien la lección

El aprendizaje automático tiene otra cara. Se puede descontrolar, como le ocurrió al bot Tay, programado por Microsoft para aprender de la gente a través de sus interacciones en Twitter. Su cuenta en la red social pronto empezó a lanzar mensajes xenófobos tras el troleo de algunos usuarios y la compañía tuvo que suspender este experimento social.

“Siempre se necesitará un marco para limitar al algoritmo”, es la opinión de Pak. “Una máquina no es más que un conjunto de algoritmos. Lo que significa que las máquinas no tienen la libertad que las personas tenemos”. Así, esa especie de libertad social que Tay tuvo para aprender acabó por volverse en su contra. “Si vas a usar algoritmos en un entorno social creo que tienes que poner unos límites, de la misma forma que nosotros tenemos límites sociales”, sentencia Pak.

Es una forma de controlar la toma de decisiones. Por cierto, para una persona estas decisiones no siempre están basadas en el razonamiento lógico y no siempre se obtiene así el mejor resultado. La intuición a veces es un factor determinante y no es algo que se aprenda de forma lógica. ¿Pueden los algoritmos actuales dotar a una máquina de intuición?

El caso que más se acerca a una toma de decisiones intuitiva por una máquina es el del sistema Alpha Go, desarrollado por Google y que venció Lee Sedol, el campeón mundial del Go, un juego mucho más complejo de aprender para una máquina que por ejemplo el ajedrez.

Pak apunta que la toma de decisiones de Alpha Go a veces no partía de la lógica. “No estaba calculando, como sí hacen en ajedrez, millones de interacciones para determinar qué es lo que va a hacer el jugador. Tenía que vislumbrar cuál era el mejor movimiento. Y ganó. Lee solo gano una partida”. Y es que ni siquiera los científicos detrás de Alpha Go predecían cómo se iba a comportar su programa.

Totales: 74.881.209

Totales: 74.881.209 Conectados: 36

Conectados: 36