Ago

20

El “mundo” de lo muy pequeño… ¡Es tan extraño!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo. Simplemente con que su carga fuera distinta en una pequeña fracción… ¡El mundo que nos rodea sería muy diferente! Y, ni la vida estaría presente en el Universo.

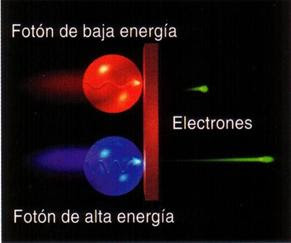

Experimentos con electrones y positrones nos enseñaron cómo funciona el universo

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

En esta gráfica a cada temperatura el cuerpo negro emite una cantidad estándar de energía que está representada por el área bajo la curva en el intervalo.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, pero esto lo veremos más adelante.

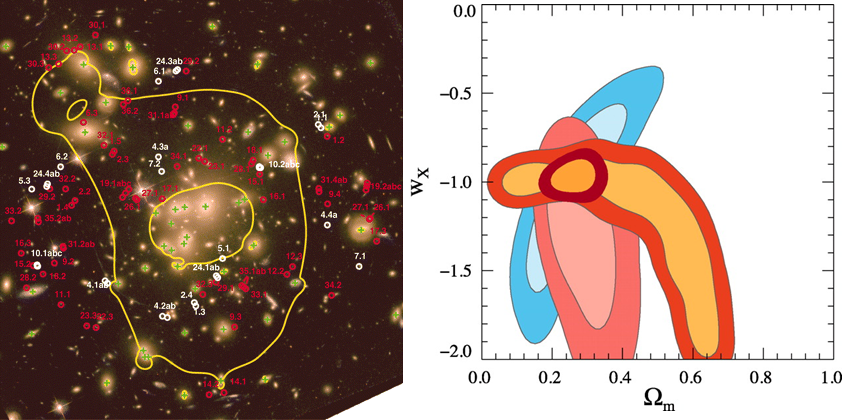

La primera es la imagen obtenida por los físicos en el laboratorio y, la segunda es la Imagen ilustrativa de la dualidad onda-partícula, con la cual se quiere significar cómo un mismo fenómeno puede tener dos percepciones distintas. Lo cierto es que, el mundo de lo muy pequeño es extraño y no siempre lo podemos comprender.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

El “universo de las partículas nunca ha sido fácil de comprender y su rica diversidad, nos habla de un vasto “mundo” que se rige por su propias reglas que hemos tenido que ir conocimiendo y seguimos tratando de saber, el por qué de esos comportamientos extraños y a veces misteriosos. Así, la pregunta anterior, de ¿qué puede significar todo eso?…

La pudo contestar Niels Bohr, de forma tal que, con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Mucho ha sido el camino andado hasta nuestros tratando de conocer los secretos de la naturaleza que, poco a poco, nos van siendo familiares. Sin embargo, es más el camino que nos queda por recorrer. Es mucho lo que no sabemos y, tanto el micromundo como en el vasto mundo de muy grande, hay que cosas que aún, no hemos llegado a comprender.

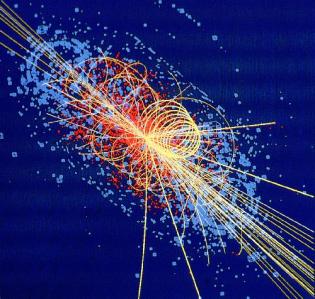

El detector ATLAS funcionó, y rastrearon las partículas subatómicas…

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los “trucos” ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, localizar y saber en qué punto exacto están esas pequeñas partículass… no es fácil

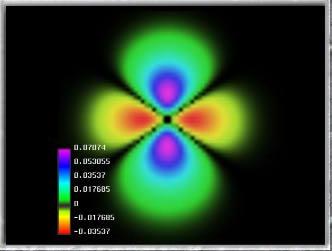

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Función de onda para una partícula bidimensional encerrada en una caja. Las líneas de nivel sobre el plano inferior están relacionadas con la probabilidad de presencia.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

(“El teorema de Bell o desigualdades de Bell se aplica en mecánica cuántica para cuantificar matemáticamente las implicaciones planteadas teóricamente en la paradoja de Einstein-Podolsky-Rosen y permitir así su demostración experimental. Debe su nombre al científico norirlandés John S. Bell, que la presentó en 1964.

El teorema de Bell es un metateorema que muestra que las predicciones de la mecánica cuántica (MC) no son intuitivas, y afecta a temas filosóficos fundamentales de la física moderna. Es el legado más famoso del físico John S. Bell. El teorema de Bell es un teorema de imposibilidad, que afirma que:

Ninguna teoría física de variables ocultas locales puede reproducir todas las predicciones de la mecánica cuántica.”)

¿Cómo saber el número que saldrá cuando lanzamos los dados?

¡¡La mecánica cuántica!!, o, la perplejidad de nuestros sentidos ante lo que ese “universo cuántico” nos ofrece que, generalmente, se sale de lo que entendemos por sentido común. Ahí, en el “mundo” de los objetos infinitesimales, suceden cosas que no siempre podemos comprender. Y, como todo tiene una razón, no dejamos de buscarla en cada uno de aquellos sorprendentes sucesos que en ese lugar se producen. Podríamos llegar a la conclusión de que, la razón está en todo y solo la encontramos una vez que llegamos a comprender, mientras tanto, todo nos resulta extraño, irrazonable, extramundano y, algunas veces…imposible. Sin embargo, ahí está. Dos elementos actúan de común acuerdo para garantizar que no podamos descorrer el velo del futuro, de lo que será después (podemos predecir aproximaciones, nunca certezas), el principal de esos elementos es la ignorancia nunca podremos saber el resultado final de éste o aquél suceso sin tener la certeza de las condiciones iniciales. En la mayoría de los sistemas físicos son, en mayor o menor medida dada su complejidad, del tipo caótico es tal que, el resultado de las interacciones entre elementos eson sumamente sensibles a pequeñísimas variaciones de los estados iniciales que, al ser perturbados mínimamente, hacen que el suceso final sea y esté muy alejado del que se creía al comienzo.

emilio silvera

Ago

20

Los pros y los contras de las máquinas más listas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en I. A. ~

Clasificado en I. A. ~

Comments (0)

Comments (0)

Inteligencia artificial

El aprendizaje automático es uno de los campos con más proyección en inteligencia artificial.

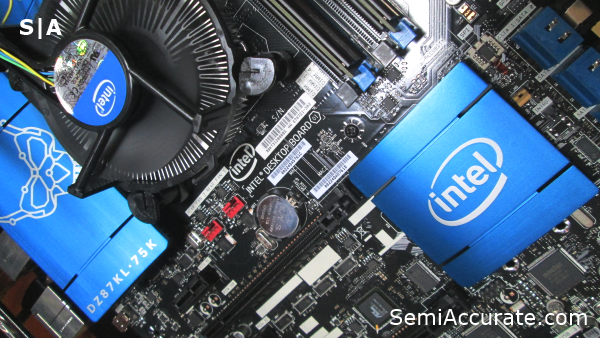

Tenemos la clave para fabricar máquinas listas. Intel

Los miles de millones de dispositivos que se conectan a internet cada día generan una cantidad abrumadora de información. Son montones de terabytes de datos que aparecen de la nada diariamente.

Esto abre el apetito por obtener valor de la información. Y la inteligencia artificial es clave aquí. El término se suele asociar con la robótica, una herencia cultural de la ciencia ficción, pero lo cierto es que la inteligencia artificial es algo mucho más abstracto que robots humanoides caminando o que los dilemas del superordenador Hal en 2001: una odisea del espacio.

Ojo cámara (con lente fish eye es decir con una visual muy panóptica) de color rojo (para detectar por filtro cromático incluso la “luz” IR no perceptible por el ser humano), usado para representar a HAL 9000 en uno de sus aspectos de control prácticamente orweliano.

Podría decirse que la inteligencia artificial asoma la cabeza por primera vez en los años 60 con sistemas predictivos y a partir de ahí evoluciona a velocidad de crucero. Hoy se usa para evitar fraudes bancarios, en el reconocimiento de voz, en el filtro anti spam del correo electrónico, incluso en el etiquetado de fotos automático de Facebook o en los videojuegos.

Lo que está por venir en inteligencia artificial –ya se ha investigado mucho sobre ello– son los coches autónomos, la medicina de alta precisión o el procesamiento del lenguaje natural que le pediremos a los Siri, Google Now o Cortana en los próximos años. Son algunas de las áreas para las que el aprendizaje automático o machine learning es necesario.

Que las máquinas aprendan es fundamental porque es uno de los elementos que retrasará su obsolescencia prematura, reforzando su autonomía. Este aprendizaje es uno de los temas que han sobrevolado la Conferencia Internacional de Desarrolladores (IDF) de Intel.

Hoy el 7% de todos los servidores presentes en el mundo están dedicados a tareas de aprendizaje automático. Y más del 97% de estos servidores funcionan con procesadores de Intel. Si bien en campos como los coches autónomos la compañía se ve amenazada por los productos de su competidora Nvidia.

En todo caso, esta rama de la inteligencia artificial es la que tiene mayor proyección. Intel proporciona el hardware sobre el que los desarrolladores pueden programar sus algoritmos de inteligencia artificial. Para entrenar a los algoritmos la compañía ofrece el procesador Xeon Phi, mientras que para ejecutar una tarea determinada, ya aprendida, cuenta con el Xeon.

“Trabajamos con instituciones académicas y desarrolladores para asegurarnos de que pueden usar el hardware optimizado”, comenta Nidhi Chappell, responsable de aprendizaje automático en la división de centros de datos de Intel. “Hay muchos beneficios en tener el software y el hardware optimizado. ¿Podrías trabajar con procesamiento del lenguaje natural en un Xeon no optimizado? Sí, pero cuanto más optimices los elementos, tanto en software como en el hardware, más rápido harás los trabajos”.

Se necesita que el rendimiento del hardware sea muy alto, pero también que sea fácil de poner en marcha. Y otra de las claves para optimizar este aspecto es la compatibilidad con diferentes tipos de algoritmos. “Queremos habilitar nuestros productos para soluciones que estén basadas en código abierto”, indica Chappell. “Pues muchas de las cargas de trabajo en deep learning, como el procesamiento del lenguaje natural o el etiquetado de imágenes, están basadas en frameworks (marcos de trabajo para desarrollar software) de código abierto”.

Los algoritmos del ‘Deep learning’

El Deep learning o aprendizaje profundo, considerado una parte del aprendizaje automático, se basa en redes neuronales artificiales, inspiradas en el funcionamiento de sistemas biológicos. Muchos algoritmos que usan deep learning proceden de empresas o universidades, como Google o Berkeley, y una parte de ellos están bajo código abierto. Lo que hace Intel es asegurarse de que la arquitectura de sus productos está optimizada para estos algoritmos.

El conocimiento que los nutre proviene de compañías privadas, de centros académicos y también de instituciones públicas. No todo se pone a disposición del público, pero compartir la información y los progresos técnicos es uno de los motores para el aprendizaje de las máquinas.

Cloudera, una de las empresas presentes en el IDF, trabaja en big data con plataformas de código abierto. Su portavoz en el congreso de Intel, Johnny Pak, cree que la colaboración es necesaria para no estancarse. “El código abierto ayudará al desarrollo rápido de la inteligencia artificial. La posibilidad de construir sobre el trabajo de otros es lo que va a ayudar a avanzar”, reflexiona.

El conocimiento proviene de múltiples fuentes. Intel

Aprender bien la lección

El aprendizaje automático tiene otra cara. Se puede descontrolar, como le ocurrió al bot Tay, programado por Microsoft para aprender de la gente a través de sus interacciones en Twitter. Su cuenta en la red social pronto empezó a lanzar mensajes xenófobos tras el troleo de algunos usuarios y la compañía tuvo que suspender este experimento social.

“Siempre se necesitará un marco para limitar al algoritmo”, es la opinión de Pak. “Una máquina no es más que un conjunto de algoritmos. Lo que significa que las máquinas no tienen la libertad que las personas tenemos”. Así, esa especie de libertad social que Tay tuvo para aprender acabó por volverse en su contra. “Si vas a usar algoritmos en un entorno social creo que tienes que poner unos límites, de la misma forma que nosotros tenemos límites sociales”, sentencia Pak.

Es una forma de controlar la toma de decisiones. Por cierto, para una persona estas decisiones no siempre están basadas en el razonamiento lógico y no siempre se obtiene así el mejor resultado. La intuición a veces es un factor determinante y no es algo que se aprenda de forma lógica. ¿Pueden los algoritmos actuales dotar a una máquina de intuición?

El caso que más se acerca a una toma de decisiones intuitiva por una máquina es el del sistema Alpha Go, desarrollado por Google y que venció Lee Sedol, el campeón mundial del Go, un juego mucho más complejo de aprender para una máquina que por ejemplo el ajedrez.

Pak apunta que la toma de decisiones de Alpha Go a veces no partía de la lógica. “No estaba calculando, como sí hacen en ajedrez, millones de interacciones para determinar qué es lo que va a hacer el jugador. Tenía que vislumbrar cuál era el mejor movimiento. Y ganó. Lee solo gano una partida”. Y es que ni siquiera los científicos detrás de Alpha Go predecían cómo se iba a comportar su programa.

Ago

19

Curvatura del Espacio – Tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Densidad Crítica ~

Clasificado en Densidad Crítica ~

Comments (1)

Comments (1)

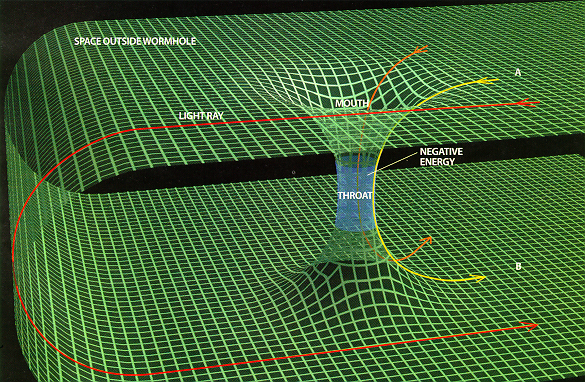

Así representan algunos como sería el camino para burlar la velocidad de la luz y desplazarnos por el espaciotiempo a distancias inmensas en tiempos y espacios más cortos. Es el famoso agujero de gusano o el doblar el espacio trayendo hacia tí el lugar que deseas visitar.

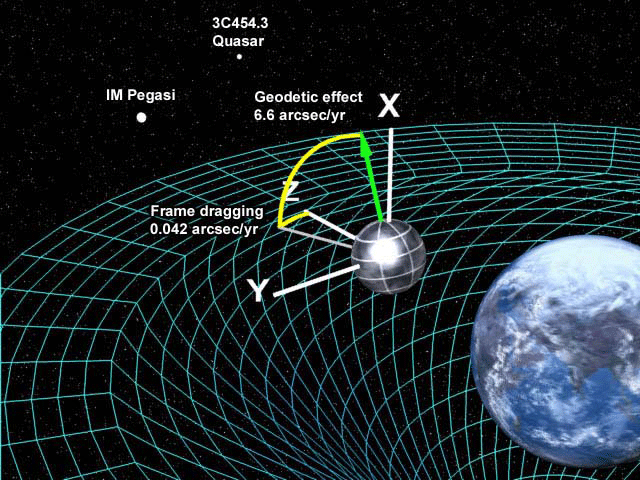

Hay que entender que el espacio–tiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo. De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio–tiempo. La trayectoria de un objeto en el espacio–tiempo se denomina por el nombre de línea de universo. La relatividad general nos explica lo que es un espacio–tiempo curvo con las posiciones y movimientos de las partículas de materia.

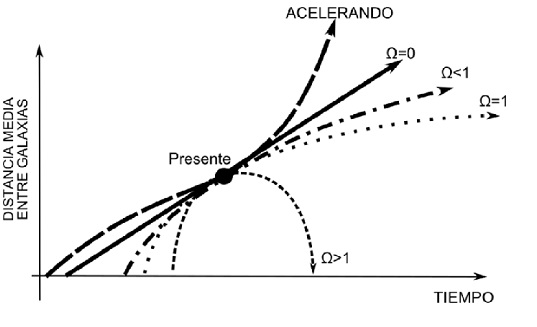

Los moelos de universo que pudieran ser, en función de la Densidad Crítica (Ω) sería plano, abierto o cerrado. La Materia tiene la palabra.

La curvatura del espacio–tiempo es la propiedad del espacio–tiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos. La relatividad general de Einstein, nos explica y demuestra que el espacio–tiempo está íntimamente relacionado con la distribución de materia en el universo, y nos dice que el espacio se curva en presencia de masas considerables como planetas, estrellas o galaxias (entre otros).

En un espacio de sólo dos dimensiones, como una lámina de goma plana, la geometría de Euclides se aplica de manera que la suma de los ángulos internos de un triángulo en la lámina es de 180°. Si colocamos un objeto masivo sobre la lámina de goma, la lámina se distorsionará y los caminos de los objetos que se muevan sobre ella se curvaran. Esto es, en esencia, lo que ocurre en relatividad general.

Los Modelos Cosmológicos son variados y todos, sin excepción, nos hablan de una clase de universo que está conformado en función de la materia que en él pueda existir, es decir, eso que los cosmólogos llaman el Omega negro. La Materia determinará en qué universo estamos.

En los modelos cosmológicos más sencillos basados en los modelos de Friedmann, la curvatura de espacio–tiempo está relacionada simplemente con la densidad media de la materia, y se describe por una función matemática denominada métrica de Robertson–Walker. Si un universo tiene una densidad mayor que la densidad crítica, se dice que tiene curvatura positiva, queriendo decir que el espacio–tiempo está curvado sobre sí mismo, como la superficie de una esfera; la suma de los ángulos de un triángulo que se dibuje sobre la esfera es entonces mayor que 180°. Dicho universo sería infinito y se expandiría para siempre, es el universo abierto. Un universo de Einstein–de Sitter tiene densidad crítica exacta y es, por consiguiente, espacialmente plano (euclideo) infinito en el espacio y en el tiempo.

La geometría del espacio-tiempo en estos modelos de universos está descrita por la métrica de Robertson-Walker y es, en los ejemplos precedentes, curvado negativamente, curvado positivamente y plano, respectivamente (Alexander AlexandrovichFriedmann). Y, las tres epresentaciones gráficas de los espacios que dan lugar a los tres posibles formas de universo antes referida en función de la densidad crítica que hará un universo plano, un universo abierto o un universo curvo y cerrado.

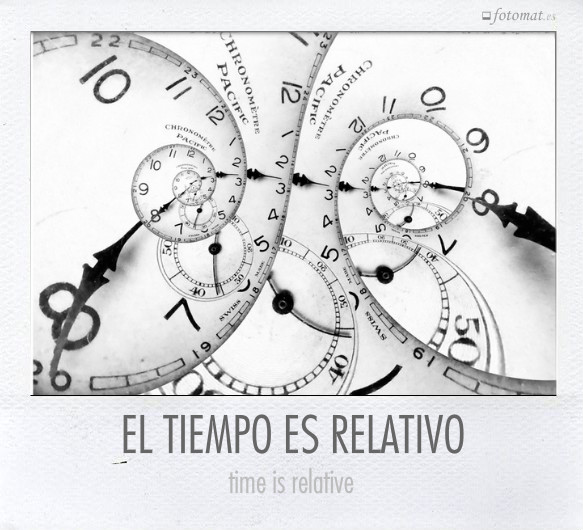

¿Cómo medirán una hora aquel que pasa ese Tiempo con el Ser amado en comparación con aquel otro que, lleno de dolor, la ve transcurrir lentamente en la cama de un Hospital?

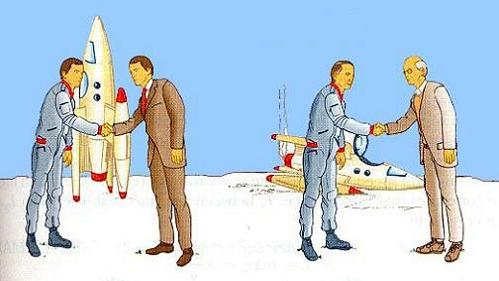

Hemos mencionado antes la relatividad del tiempo que para el mismo suceso será distinto en función de quién sea el que cronometre; por ejemplo, el tiempo transcurre más despacio para el astronauta que en nave espacial viaja a velocidades próximas a c, la velocidad de la luz. Según la teoría de la relatividad especial de Einstein, en el caso antes señalado, el tiempo del astronauta viajero avanza más lentamente en un factor que denotamos con la ecuación , cuando lo mide un sistema de referencia que viaja a una velocidad v relativa al otro sistema de referencia; c es la velocidad de la luz. Este principio ha sido verificado de muchas maneras; por ejemplo, comparando las vidas medias de los muones rápidos, que aumentan con la velocidad de las partículas en una cantidad predicha en este factor de la anterior ecuación.

Un ejemplo sencillo de la dilatación del tiempo es la conocida paradoja de los gemelos. Uno viaja al espacio y el otro lo espera en la Tierra. El primero hace un viaje a la velocidad de la luz hasta Alfa de Centauri y regresa. Cuando baja de la nave espacial, tiene 8’6 años más que cuando partió de la Tierra. Sin embargo, el segundo gemelo que esperó en el planeta Tierra, al regreso de su hermano, era ya un anciano jubilado. El tiempo transcurrido había pasado más lento para el gemelo viajero. Parece mentira que la velocidad con la que podamos movernos nos puedan jugar estas malas pasadas.

Otra curiosidad de la relatividad especial es la que expresó Einstein mediante su famosa fórmula de E = mc2, que nos viene a decir que masa y energía son dos aspectos de una misma cosa. Podríamos considerar que la masa (materia), es energía congelada. La bomba atómica demuestra la certeza de esta ecuación.

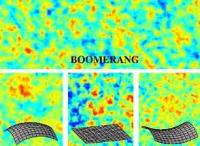

Durante diez dias del mes de enero de 1999 astrofísicos italianos y estadounidenses efectuaron un experimento que llamaron Boomerang. El experimento consistió en el lanzamiento de un globo con instrumentos que realizó el mapa mas detallado y preciso del fondo de radiación de microondas (CMB) obtenido hasta el momento. Su conclusión: el universo no posee curvatura positiva o negativa, es plano.

La densidad crítica está referida a la densidad media de materia requerida para que la gravedad detenga la expansión de nuestro universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo al que antes nos referimos conocido como de Einstein–de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro universo representa sólo el 20% del valor crítico. Puede haber, sin embargo, una gran cantidad de materia oscura que elevaría la densidad hasta el valor crítico. Las teorías de universo inflacionario predicen que la densidad presente debería ser muy aproximada a la densidad crítica; estas teorías requieren la existencia de materia oscura.

Los cosmólogos y astrofísicos, en sus obervaciones, notaron que las galaxias se alejaban las unas de las otras a mayor velocidad de la que correspondería en función de la materia que se puede ver en el Universo, había algo que las hacía correr más de la cuenta, así que, el primero en poner nombre all fenómeno que se ha dado en llamar “materia oscura” fue el astrofísico suizo Fritz Zwicky, del Instituto Tecnológico de California (Caltech) en 1933. Con su invento (intuición), dejó zanjado el tema que traía de cabeza a todos los cosmólogos del mundo, encantados con que al fín, las cuentas cuadraran.

Mencionamos ya la importancia que tiene para diseñar un modelo satisfactorio del universo, conocer el valor de la masa total de materia que existe en el espacio. El valor de la expansión o de la contracción del universo depende de su contenido de materia. Si la masa resulta mayor que cierta cantidad, denominada densidad crítica, las fuerzas gravitatorias primero amortiguarán y luego detendrán eventualmente la expansión. El universo se comprimirá en sí mismo hasta alcanzar un estado compacto y reiniciará, tal vez, un nuevo ciclo de expansión. En cambio, si el universo tiene una masa menor que ese valor, se expandirá para siempre. Y, en todo esto, mucho tendrá que decir “la materia oscura” que al parecer está oculta en alguna parte.

El símbolo Ω (parámetro de densidad) lo utilizan los cosmólogos para hablar de la densidad del universo.

Ω =r /rcrit

Tenemos así que para Ω>1 tenemos que el universo se contraería en un futuro Big Crunch, para Ω<1 e universo debería expandirse indefinidamente (Big Rip) y para Ω=1 el universo se debería expandir pero deteniéndose su expansión asintóticamente.

Además Las observaciones del fondo de microondas como las WMAP dan unas observaciones que coinciden con lo cabría esperar si la densidad total del universo fuera igual a la densidad crítica.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las galaxias. La densidad media es la que determinará si el universo se expandirá o no para siempre.

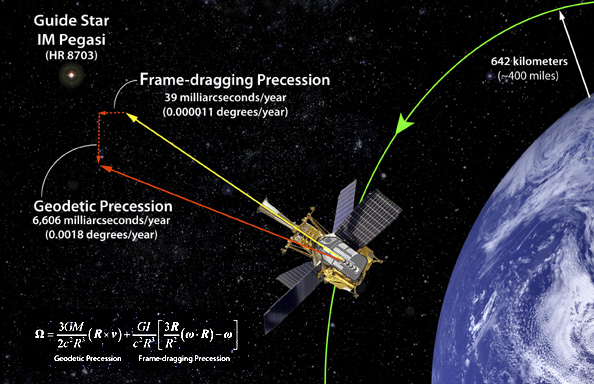

No dejamos de enviar ingenios al espacio para tratar de medir la Densidad Crítica y poder saber en qué clase de universo nos encontramos: Plano, cerrado o abierto.

En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio–tiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

Todos conocemos la teoría de Einstein y lo que nos dice que ocurre cuando grandes masas, como planetas, están presentes: Curvan el espacio que lo circundan en función de la masa. En la imagen se quiere representar tal efecto.

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el universo, de hacer posible que existan las galaxias, los sistemas solares y que nosotros mismos tengamos bien asentados los pies a la superficie de nuestro planeta Tierra, cuya gravedad tira de nosotros para que así sea.

Un sistema solar en el que los planetas aparecen cohexionados alrededor del cuerpo mayor, la estrella. Todos permanecen unidos gracias a la fuerza de Gravedad que actúa y los sitúa a las adecuadas distancias en función de la masa de cada uno de los cuerpos planetarios.

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable.

No pocas veces hemos querido utilizar la fuerza electromagnética para crear escudos a nuestro alrededor, o, también de las naves viajeras, para evitar peligros exteriores o ataques. Es cierto que, habiéndole obtenido muchas aplicaciones a esta fuerza, aún nos queda mucho por investigar y descubrir para obtener su pleno rendimiento.

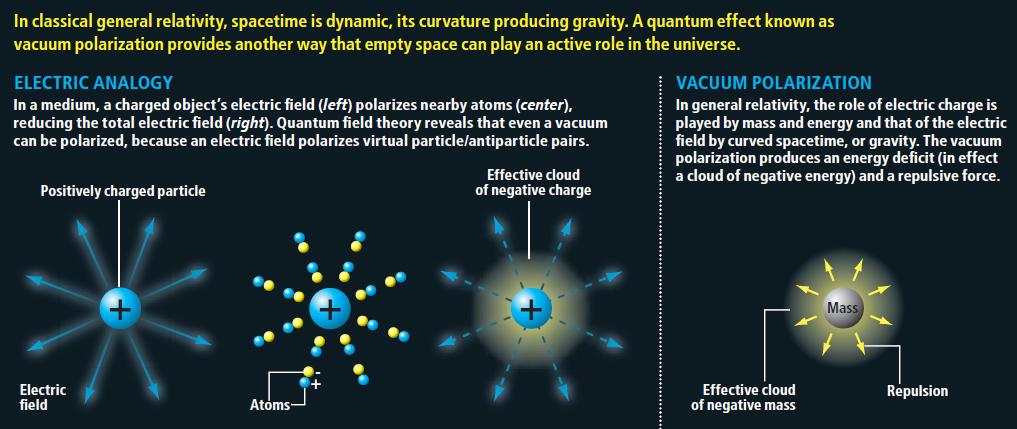

La gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Describe a las partículas como una especie de campo de materia que se esparce por el espacio de modo similar a una onda. Hay una relación entre la localización de la partícula y los lugares del espacio donde el campo es más potente. La mecánica cuántica introduce un postulado en el que cuando se realiza una medida de la posición de la partícula se produce lo que se llama colapso de función de onda que asemeja al campo como una particula localizada. Se usa en el microscopio de electrones para obsevar objetos menores que los observados por la luz visible.

La superficie de un cuerpo negro es un caso límite, en el que toda la energía incidente desde el exterior es absorbida, y toda la energía incidente desde el interior es emitida. No existe en la naturaleza un cuerpo negro, incluso el negro de humo refleja el 1% de la energía incidente.

Se denomina cuerpo negro a aquel cuerpo ideal que es capaz de absorber o emitir toda la radiación que sobre él incide. Las superficies del Sol y la Tierra se comportan aproximadamente como cuerpos negros.

Por haberlo mencionado antes me veo obligado a explicar brevemente el significado de “cuerpo negro”, que está referido a un cuerpo hipotético que absorbe toda la radiación que incide sobre él. Tiene, por tanto, una absortancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la distribución de energía sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumento de temperaturas (ley de desplazamiento de Wien).

Existen en el Universo configuraciones de fuerzas y energías que aún no podemos comprender. La vastedad de un Universo que tiene un radio de 13.700 millones de años, nos debe hacer pensar que, en esos espacios inmensos existen infinidad de cosas y se producen multitud de fenómenos que escapan a nuestro entendimiento. Son fuerzas descomunales que, como las que puedan emitir agujeros negros gigantes, estrellas de neutrones magnetars y explosiones de estrellas masivas en supernovas que, estando situadas a miles de millones de años luz de nuestro ámbito local, nos imposibilita para la observación y el estudio a fondo y sin fisuras, y, a pesar de los buenos instrumentos que tenemos hoy, siguen siendo insuficientes para poder “ver” todo lo que ahí fuera sucede.

¡El Universo! Todo lo que existe.

emilio silvera

Ago

18

Física, la era cuántica y otros fascinantes conceptos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y condiciones en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

El momento de Planck es la unidad de momento, denotada por m P c {\displaystyle m_{P}c}

Se define como:

donde

es la longitud de Planck

es la constante de Planck racionalizada

es la velocidad de la luz en el vacío

es la constante gravitacional

En unidades del SI. el momento de Planck equivale a unos 6,5 kg m/s. Es igual a la masa de Planck multiplicada por la velocidad de la luz, con frecuencia asociada con el momento de los fotones primordiales en ciertos modelos del Big Bang que aún perduran.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha sido prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad general de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Si hablamos de singularidades en agujeros negros, debemos dejar la R.G. y acudir a la M.C. “…según las leyes de la Relatividad, el eje más horizontal siempre es espacio, mientras que el más vertical siempre es tiempo. Por tanto, al cruzar el horizonte lo que nosotros entendemos por tiempo y espacio ¡habrán intercambiado sus papeles! Puede sonar raro y, definitivamente, es algo completamente anti intuitivo, pero es la clave de que los agujeros negros sean como son y jueguen el papel tan importante que juegan en la física teórica actual. Al fin y al cabo, dentro no es lo mismo que fuera…”

Si ahora queremos cuantizar, es decir encontrar la versión cuántica, la gravedad escrita como RG lo que tenemos que hacer es encontrar la teoría cuántica para la métrica. Sin embargo, esto no conduce a una teoría apropiada, surgen muchos problemas para dar sentido a esta teoría, aparecen infinitos y peor que eso, muchos cálculos no tienen ni tan siquiera un sentido claro. Así que hay que buscar otra forma de intentar llegar a la teoría cuántica.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un número sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espaciotiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a desde una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

Según la física cuántica, “la nada” no existe. En vez de esto, en la escala más pequeña y elemental del universo hallamos una clase de “espuma cuántica”.

John Wheeler explicó el término de “espuma cuántica” en 1955. A este nivel subatómico, la energía se rige por el principio de Incertidumbre de Heisenberg; sin embargo, para comprender este principio y cualquier aseveración de física cuántica, es importante antes entender que el universo se rige por cuatro dimensiones: tres comprendidas por el espacio que un objeto ocupa (vectores “X”, “Y” y “Z”) y una última, que es el tiempo.

La Física actual no puede describir lo que sucedió en el Big Bang. La Teoría Cuántica y la Teoría de la Relatividad fracasan en éste estado inicial del Universo infinitamente denso y caliente. Tan solo una teoría de la Gravedad Cuántica que integre ambos pilares fundamentales de la Física, podría proporcionar una idea acerca de cómo comenzó el Universo.

Según los primeros trabajos sobre la teoría cuántica de la gravedad, el propio espaciotiempo varió en su topografía, dependiendo de las dimensiones del universo niño. Cuando el universo era del tamaño de un núcleo atómico (ver imagen de abajo), las condiciones eran relativamente lisas y uniformes; a los 10-30 cm (centro) es evidente una cierta granulidad; y a la llamada longitud de Planck, todavía unas 1.000 veces más pequeño (abajo), el espacio tiempo fluctúa violentamente.

La Gravedad de Einstein y la Cuántica de Planck… ¡No casan!

Los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían sido cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las condiciones iniciales del universo.

Observaciones astronómicas indican que el universo tiene una edad de 13,73 ± 0,12 millardos de años (entre 13 730 y 13 810 millones de años) y por lo menos … Sin embargo…

El universo estaba a 3.000° Hace doce mil quinientos millones de años; a 10 mil millones de grados (1010° K) un millón de años antes, y, tal vez, a 1028° K un par de millones más temprano. Pero, y antes de ese tiempo ¿qué pasaba? Los fósiles no faltan, pero no sabemos interpretarlos. Mientras más elevada se va haciendo la temperatura del universo primigenio, la situación se va complicando para los científicos. En la barrera fatídica de los 1033° K –la temperatura de Planck–, nada funciona. Nuestros actuales conocimientos de la física dejan de ser útiles. El comportamiento de la materia en estas condiciones tan extremas deja de estar a nuestro alcance de juicio. Peor aún, hasta nuestras nociones tradicionales pierden su valor. Es una barrera infranqueable para el saber de la física contemporánea. Por eso, lo que se suele decir cómo era el universo inicial en esos tempranos períodos, no deja de tener visos de especulación.

Los progresos que se han obtenido en física teórica se manifiestan a menudo en términos de síntesis de campos diferentes. Varios son los ejemplos que de ello encontramos en diversos estudios especializados, que hablan de la unificación de las fuerzas fundamentales de la naturaleza.

En física se cuentan con dos grandes teorías de éxito: la cuántica y la teoría de la relatividad general.

Cada una de ellas ha demostrado ser muy eficiente en aplicaciones dentro de los límites de su ámbito propio. La teoría cuántica ha otorgado resultados más que satisfactorios en el estudio de las radiaciones, de los átomos y de sus interacciones. La ciencia contemporánea se presenta como un conjunto de teorías de campos, aplicables a tres de las grandes interacciones: electromagnética, nuclear fuerte, nuclear débil. Su poder predictivo es bastante elocuente, pero no universal. Esta teoría es, por ahora, incapaz de describir el comportamiento de partículas inmersas en un campo de gravedad intensa. Ahora, no sabemos si esos fallos se deben a un problema conceptual de fondo o falta de capacidad matemática para encontrar las ecuaciones precisas que permitan la estimación del comportamiento de las partículas en esos ambientes.

La teoría de la relatividad general, a la inversa, describe con gran precisión el efecto de los campos de gravedad sobre el comportamiento de la materia, pero no sabe explicar el ámbito de la mecánica cuántica. Ignora todo acerca de los campos y de la dualidad onda-partícula, y en ella el «vacío» es verdaderamente vacío, mientras que para la física cuántica hasta la «nada» es «algo»…

Nada está vacío, ya que, de donde surge es porque había

Claro está, que esas limitaciones representativas de ambas teorías no suelen tener mucha importancia práctica. Sin embargo, en algunos casos, esas limitantes se hacen sentir con agresividad frustrando a los físicos. Los primeros instantes del universo son el ejemplo más elocuente.

El científico investigador, al requerir estudiar la temperatura de Planck, se encuentra con un cuadro de densidades y gravedades extraordinariamente elevadas. ¿Cómo se comporta la materia en esas condiciones? Ambas teorías, no dicen mucho al respecto, y entran en serias contradicciones e incompatibilidades. De ahí la resistencia de estas dos teorías a unirse en una sólo teoría de Gravedad-Cuantíca, ya que, cada una de ellas reina en un universo diferente, el de lo muy grande y el de lo muy pequeño.

Todo se desenvuelve alrededor de la noción de localización. La teoría cuántica limita nuestra aptitud para asignar a los objetos una posición exacta. A cada partícula le impone un volumen mínimo de localización. La localización de un electrón, por ejemplo, sólo puede definirse alrededor de trescientos fermis (más o menos un centésimo de radio del átomo de hidrógeno). Ahora, si el objeto en cuestión es de una mayor contextura másica, más débiles son la dimensión de este volumen mínimo. Se puede localizar un protón en una esfera de un décimo de fermi, pero no mejor que eso. Para una pelota de ping-pong, la longitud correspondiente sería de unos 10-15 cm, o sea, bastante insignificante.La física cuántica, a toda partícula de masa m le asigna una longitud de onda Compton: lc = h / 2p mc

Por su parte, la relatividad general igualmente se focaliza en la problemática del lugar que ocupan los objetos. La gravedad que ejerce un cuerpo sobre sí mismo tiende a confinarlo en un espacio restringido. El caso límite es aquel del agujero negro, que posee un campo de gravedad tan intenso que, salvo la radiación térmica, nada, ni siquiera la luz, puede escapársele. La masa que lo constituye está, según esta teoría, irremediablemente confinada en su interior.

En lo que hemos inmediatamente descrito, es donde se visualizan las diferencias entre esos dos campos del conocimiento. Uno alocaliza, el otro localiza. En general, esta diferencia no presenta problemas: la física cuántica se interesa sobre todo en los microobjetos y la relatividad en los macroobjetos. Cada cual en su terreno.

Sin embargo, ambas teorías tienen una frontera común para entrar en dificultades. Se encuentran objetos teóricos de masa intermedia entre aquella de los microobjetos como los átomos y aquella de los macroobjetos como los astros: las partículas de Planck. Su masa es más o menos la de un grano de sal: 20 microgramos. Equivale a una energía de 1028 eV o, más aún, a una temperatura de 1033° K. Es la «temperatura de Planck».

Ahora bien, si queremos estimar cuál debería ser el radio en que se debe confinar la masita de sal para que se vuelva un agujero negro, con la relatividad general la respuesta que se logra encontrar es de que sería de 10-33 cm, o sea ¡una cien mil millonésima de mil millonésima de la dimensión del protón! Esta dimensión lleva el nombre de «radio de Planck». La densidad sería de ¡1094 g/cm3! De un objeto así, comprimido en un radio tan, pero tan diminuto, la relatividad general sólo nos señala que tampoco nada puede escapar de ahí. No es mucha la información.

Si recurrimos a la física cuántica para estimar cuál sería el radio mínimo de localización para un objeto semejante al granito de sal, la respuesta que encontramos es de un radio de 10-33 cm. Según esta teoría, en una hipotética experiencia se lo encontrará frecuentemente fuera de ese volumen. ¡Ambos discursos no son coincidentes! Se trata de discrepancias que necesitan ser conciliadas para poder progresar en el conocimiento del universo. ¿Se trata de entrar en procesos de revisión de ambas teoría, o será necesaria una absolutamente nueva? Interrogantes que solamente el devenir de la evolución de la física teórica las podrá responder en el futuro.

No sabemos por qué existen los fermiones y los bosones gauge que han sido observados en los experimentos. Todas las piezas del puzzle encajan a la perfección, pero la imagen mostrada en el puzzle no la han elegido las leyes físicas que conocemos, nos viene impuesta por la Naturaleza. Lo único que podemos decir es que la Naturaleza es así y nos gustaría saber el porqué, pero aún estamos muy lejos de descubrirlo (si es que es posible hacerlo sin recurrir a un principio antrópico).

De todas las maneras, en lo que se refiere a una Teoría cuántica de la Gravedad, tendremos que esperar a que se confirmen las teorías de supergravedad, supersimetría, cuerdas, la cuerda heterótica, supercuerdas y, la compendiada por Witten Teoría M. Aquí, en estas teorías (que dicen ser del futuro), sí que están apasiblemente unidas las dos irreconcialbles teorías: la cuántica y la relativista, no sólo no se rechazan ni emiten infinitos, sino que, se necesitan y complementan para formar un todo armónico y unificador.

¡Si pudiéramos verificarla!

Pero, contar con la energía de Planck (1019 GeV), no parece que, al menos de momento, no sea de este mundo. Ni todos los aceleradores de partículas del mundo unidos, podrían llegar a conformar una energía semejante.

emilio silvera

Ago

16

Los Quarks invisibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

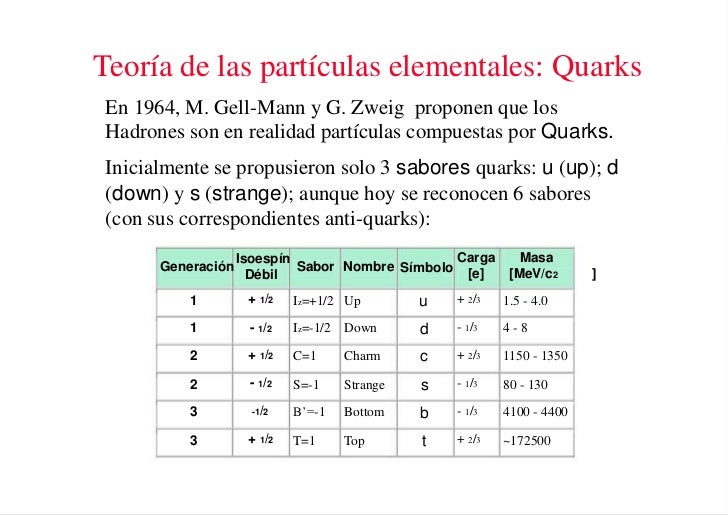

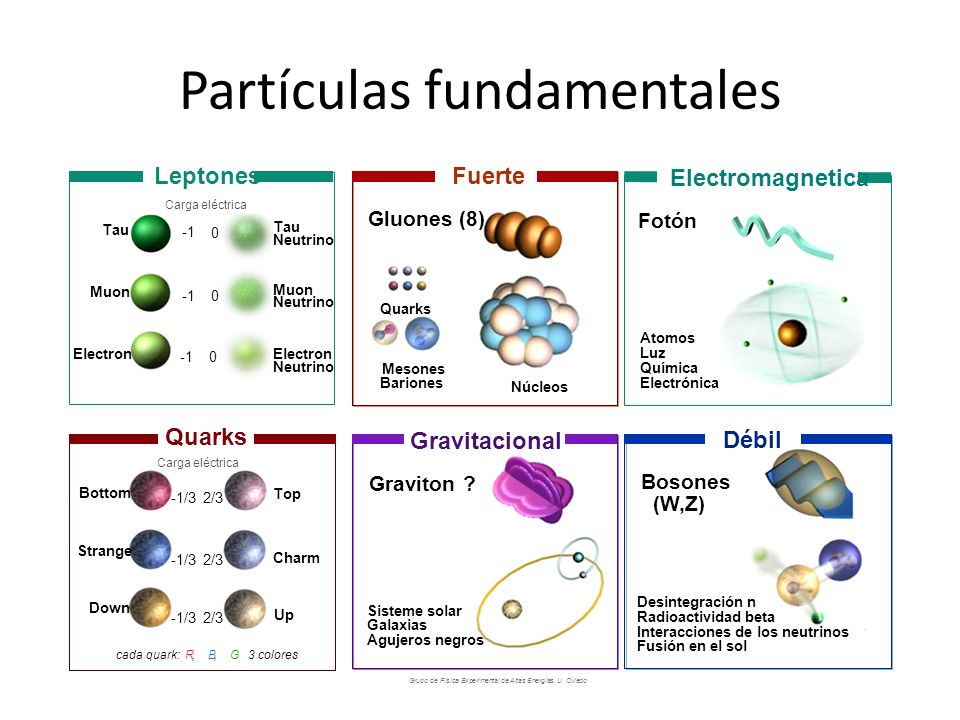

Una vez que se ha puesto orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

Pero las matemáticas SU(3) también admiten multipletes de diez miembros. Cuando se propuso este esquema se conocían nueve bariones con espín 3/2. Los esquemas SU(3) se obtienen al representar dos propiedades fundamentales de las partículas, la extrañeza S frente al isoespín I₃ , en una gráfica.

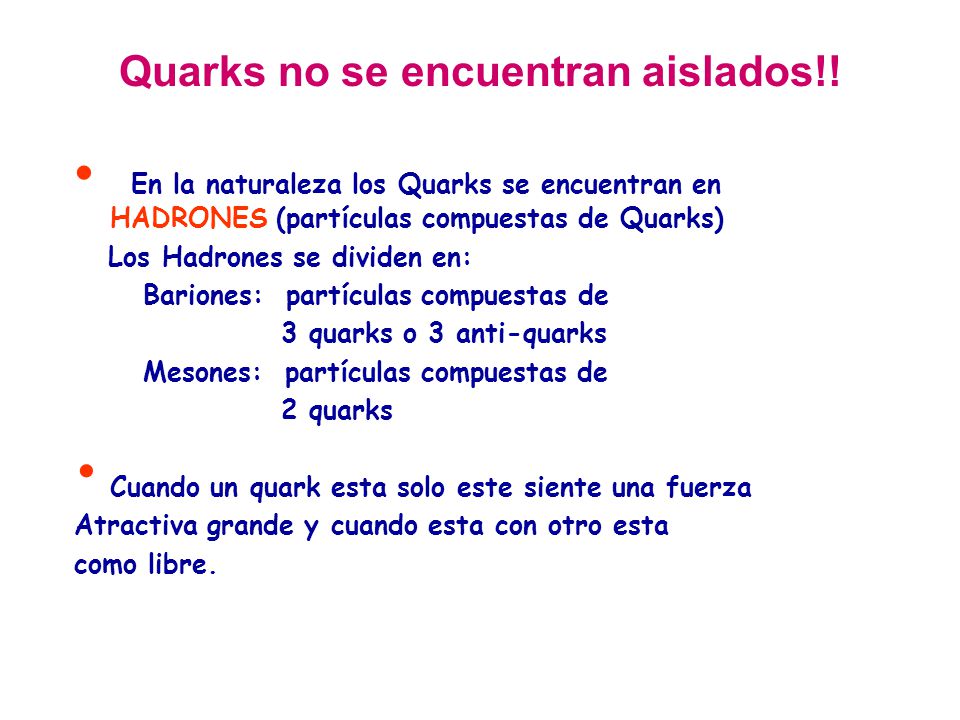

Imagen de trazas en la cámara de burbujas del primer evento observado incluyendo bariones Ω, en el Laboratorio Nacional Brookhaven.

De esta manera, Gell-Mann predijo un décimo barión, el omega-menos (Ω¯), y pudo estimar con bastante precisión su masa porque las masas de los otros nueve bariones variaban de una forma sistemática en el gráfico (también consiguió entender que las variaciones de la masa eran una consecuencia de una interacción simple). Sin embargo, estaba claro que la Ω¯, con una extrañeza S = -3, no tenía ninguna partícula en la que desintegrarse que no estuviera prohibida por las leyes de conservación de la interacción fuerte. De modo que, la Ω¯ sólo podía ser de tan sólo 10¯²³ segundos como los demás miembros del multiplete, sino que tenía que ser del orden de 10¯¹⁰ segundos. Consecuentemente, esta partícula debería viajar varios centímetros antes de desintegrarse y esto la haría fácilmente detectable. La Ω¯ fue encontrada en 1964 con exactamente las mismas propiedades que había predicho Gell-Mann.

Murray Gell-Mann, nacido en Nueva York en el año 1929, recibió el premio Nobel de Física en 1969 por su aporte en la teoría de las partículas atómicas.

Murray Gell-Mann, nacido en Nueva York en el año 1929, recibió el premio Nobel de Física en 1969 por su aporte en la teoría de las partículas atómicas.

Se identificaron estructuras multipletes para la mayoría de los demás bariones y mesones y Gell-Mann también consiguió explicarlas. Sugirió que los mesones, igual que los bariones, debían estar formados por elementos constitutivos “más fundamentales aún”. Gell-Mann trabajaba en el Instituto de Tecnología de California en Pasadena (CalTech), donde conversaba a menudo con Richard Feynman. Eran ambos físicos famosos pero con personalidades muy diferentes. Gell-Mann, por ejemplo, es conocido como un entusiasta observador de Pájaros, familiarizado con las artes y la literatura y orgulloso de su conocimiento de lenguas extranjeras. Feynman fue un hombre hecho a sí mismo, un analista riguroso que se reía de cualquier cosa que le recordara la autoridad establecida. Hay una anécdota que parece no ser cierta de hecho, pero que me parece tan buena que no puedo evitar el contarla; podía haber sucedido de esta forma. Gell-Mann le dijo a Feynman que tenía un problema, que estaba sugiriendo un nuevo tipo de ladrillos constitutivos de la materia y que no sabía qué nombre darles. Indudablemente debía haber de haber pensado en utilizar terminología latina o griega, como ha sido costumbre siempre en la nomenclatura científica. “Absurdo”, le dijo Feynman; “tú estás hablando de cosas en las que nunc ase había pensado antes. Todas esas preciosas pero anticuadas palabras están fuera de lugar. ¿Por qué no los llamas simplemente “shrumpfs”, “quacks” o algo así?”.

Cuando algún tiempo después le pregunté a Gell-Mann, éste negó que tal conversación hubiera tenido lugar. Pero la palabra elegida fue quark, y la explicación de Gell-Mann fue que la palabra venía de una frase de Fynnegan’s Wake de James Joyce; “¡Tres quarks para Muster Mark!”. Y, efectivamente así es. A esas partículas les gusta estar las tres juntas. Todos los bariones están formados por tres quarks, mientras que los mesones están formados por un quark y un antiquark.

Los propios quarks forman un grupo SU(3) aún más sencillo. Los llamaremos “arriba (u)”, “abajo” (d), y “extraño” (s). Las partículas “ordinarias” contienen solamente quarks u y d. Los hadrones “extraños” contienen uno o más quarks s (o antiquarks ŝ).

La composición de quarks de espín 3/2 se puede ver en la tabla 5. La razón por la que los bariones de espín ½ sólo forman un octete es más difícil de explicar. Está relacionada con el hecho de que en estos estados, al menos dos de los quarks tienen que ser diferentes unos de otros.

Realmente, la idea de que los hadrones estuvieran formados por ladrillos fundamentales sencillos había sido también sugerida por otros. George Zweig, también en el CalTech, en Pasadena, había tenido la misma idea. Él había llamado a los bloques constitutivos “ases!, pero es la palabra “quark” la que ha prevalecido. La razón por la que algunos nombres científicos tienen más éxito que otros es a veces difícil de comprender.

Pero en esta teoría había algunos aspectos raros. Aparentemente, los quarks (o ases) siempre existen en parejas o tríos y nunca se han visto solos. Los experimentadores habían intentado numerosas veces detectar un quark aislado en aparatos especialmente diseñados para ello, pero ninguno había tenido éxito.

Los quarks –si se pudieran aislar- tendrían propiedades incluso más extrañas. Por ejemplo, ¿cuáles serían sus cargas eléctricas? Es razonable suponer que tanto los quarks u como los quarks s y d deban tener siempre la misma carga. La comparación de la tabla 5 con la tabla 2 sugiere claramente que los quarks d y s tienen carga eléctrica -1/3 y el quark u tiene carga +2/3. Pero nunca se han observado partículas que no tengan carga múltiplo de la del electrón o de la del protón. Si tales partículas existieran, sería posible detectarlas experimentalmente. Que esto haya sido imposible debe significar que las fuerzas que las mantienen unidas dentro del hadrón son necesariamente increíblemente eficientes.

Aunque con la llegada de los quarks se ha clarificado algo más la flora y la fauna de las partículas subatómicas, todavía forman un conjunto muy raro, aún cuando solamente unas pocas aparezcan en grandes cantidades en el universo (protones, neutrones, electrones y fotones). Como dijo una vez Sybren S. de Groot cuando estudiaba neutrinos, uno realmente se enamora de ellos. Mis estudiantes y yo amábamos esas partículas cuyo comportamiento era un gran misterio. Los leptones, por ser casi puntuales, son los más sencillos, y por tener espín se ven afectados por la interacción que actúa sobre ellos de forma muy complicada, pero la interacción débil estaba bastante bien documentada por entonces.

Los hadrones son mucho más misteriosos. Los procesos de choque entre ellos eran demasiado complicados para una teoría respetable. Si uno se los imagina como pequeñas esferas hachas de alguna clase de material, aún quedaba el problema de entender los quarks y encontrar la razón por la que se siguen resistiendo a los intentos de los experimentadores para aislarlos.

Si queréis saber más sobre el tema, os recomiendo leer el libro Partículas de Gerard ´t Hooft

Totales: 75.506.482

Totales: 75.506.482 Conectados: 45

Conectados: 45