Nov

5

Nuestro Planeta: ¡Es tan complejo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (0)

Comments (0)

Nuestro planeta, como nosotros mismos, es agua y luz

La biosfera y la hidrosfera están estrechamente relacionadas: el agua es el elemento esencial de todas las formas de vida, y la distribución del agua en el planeta (es decir, los límites de la hidrosfera) condiciona directamente la distribución de los organismos (los límites de la biosfera). El término biosfera, de reciente creación, indica el conjunto de zonas de la Tierra donde hay vida, y se circunscribe a una estrecha región de unos 20 Km de altura comprendida entre las cimas montañosas más elevadas y los fondos oceánicos más profundos. Sólo pueden hallarse formas de vida en la biosfera, donde las condiciones de temperatura, presión y humedad son adecuadas para las más diversas formas orgánicas de la Tierra.

Un equipo de espeleólogos y científicos españoles ha sacado de las entrañas de la tierra al animal que vive a mayor profundidad del mundo. Se trata de una nueva especie de artrópodo de seis patas y color blanquecino hallado a casi dos kilómetros bajo tierra. organismo milimétrico supone una sorpresa monumental, ya que casi ningún científico esperaba encontrar nada vivo en un lugar tan inaccesible.

Obviamente, las fronteras de dicha “esfera” son elásticas y su extensión coincide con la de la hidrosfera; se superpone a las capas más bajas de la atmósfera y a las superficiales de la litosfera, donde se sumerge, como máximo, unos 2 Km. Sin embargo, si por biosfera se entiende la zona en la que hay vida así como la parte inorgánica indispensable para la vida, deberíamos incluir en este concepto toda la atmósfera, sin cuyo “escudo” contra las radiaciones más fuertes no existiría ningún tipo de vida; o la corteza terrestre entera y las zonas superiores del manto, sin las cuales no existiría la actividad volcánica, que resulta necesaria para enriquecer el suelo con nuevas sustancias minerales.

Por tanto, la biosfera es un ecosistema tan grande como el planeta Tierra y en continua modificación por causas naturales y (desgraciadamente) artificiales.

Las modificaciones naturales se producen a escalas temporales muy variables: en tiempos larguísimos determinados por la evolución astronómica y geológica, que influyen decididamente en las características climáticas de los distintos ambientes (por ejemplo, durante las glaciaciones), o en tiempos más breves, relacionados con cambios climáticos desencadenados por sucesos geológicos-atmosféricos imprevistos (por ejemplo, la erupción de un volcán, que expulsa a la atmósfera grandes cantidades de cenizas capaces de modificar el clima de extensas áreas durante periodos considerables).

Estos sucesos naturales van transformando el pasisaje y nos trae cambios y nueva vida

En cambio, las modificaciones artificiales debidas a la actividad humana tienen efectos rápidos: la deforestación producida en África por las campañas de conquista romanas contribuyó a acelerar la desertificación del Sahara, como tampoco hay duda de que la actividad industrial de los últimos siglos determina modificaciones dramáticas y repentinas en los equilibrios biológicos.

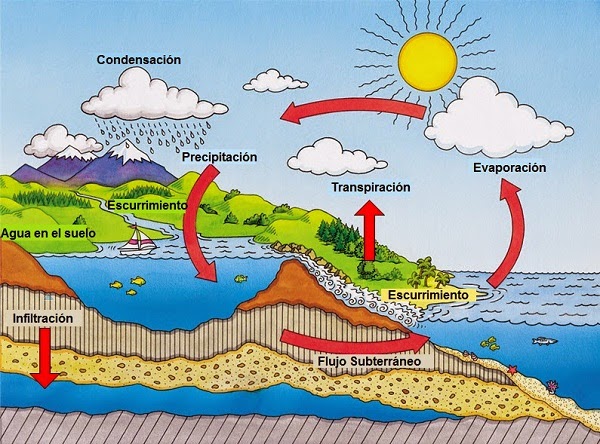

La biosfera es el punto de encuentro entre las diversas “esferas” en las que se subdivide la Tierra: está surcada por un flujo continuo de energía procedente tanto del interior del planeta como del exterior, y se caracteriza por el intercambio continuo de materia, en un ciclo incesante que une todos los entornos.

Muchas son las criaturas de especies ditintas que enriquecen la diversidad de la vida en la Tierra

Pero no por esta razón hay vida por todas partes, pues la vida requiere condiciones particulares e imprescindibles. Existen determinados elementos físicos y químicos que “limitan” el desarrollo de la vida. La presencia y disponibilidad de agua es el primero y el más importante. El agua es el disolvente universal para la química de la vida; es el componente primario de todos los organismos y sin agua la vida es inconcebible (Tales de Mileto fue el primero en darse cuenta de ello). Pero no sólo es eso: al pasar del estado sólido al líquido y al gaseoso y viceversa, el agua mantiene el “efecto invernadero natural”, capaz de conservar la temperatura del planeta dentro de los niveles compatibles con la vida (es decir, poco por debajo de los 0º C y poco por encima de los 40º C).

La presión, que no deberá superar mucho el kilogramo por centímetro cuadrado (como sucede alrededor de los 10 m de profundidad en el mar), así como una amplia disponibilidad de sales minerales y de luz solar (indispensable – como expliqué antes – para la vida de las plantas) son también factores que marcan las posibilidades de vida.

Está claro que se nos ha dado un lugar privilegiado, que reúne todas y cada una de las condiciones excepcionales para la vida, y somos tan ignorantes que aún siendo un bien escaso (en nuestro enorme Sistema Solar, parece que el único), nos lo queremos cargar. Pero sin querer, me marcho por las ramas y me desvío del tema principal, la evolución por la energía, y como está directamente implicada, hablemos un poco de nuestra casa.

El planeta Tierra

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros. Sin embargo, sabemos que todos esos complejos fenómenos y circuntancias han dado vía libre a la aparición de la vida.

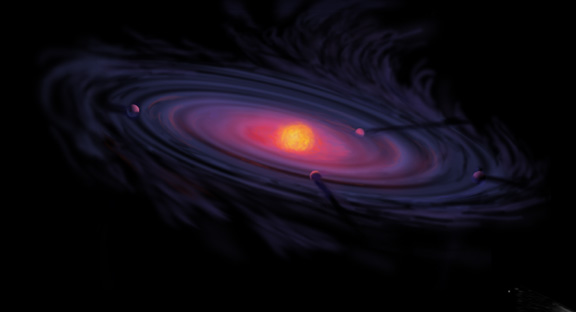

Un disco proto planetario como este pudo formar nuestro sistema solar a partir de la Nebulosa

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Si la Naturaleza se enfada… ¡Nosotros a temblar!

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

El giro de la Tierra hacia el Este influye también en las corrientes marinas, porque tiende a acumular el agua contra las costas situadas al oeste de los océanos, como cuando movemos un recipiente con agua en una dirección y el agua sufre un cierto retraso en el movimiento y se levanta contra la pared de atrás del recipiente. Así se explica, según algunas teorías, que las corrientes más intensas como las del Golfo en el Atlántico y la de Kuroshio en el Pacífico se localicen en esas zonas.

Este mismo efecto del giro de la Tierra explicaría las zonas de afloramiento que hay en las costas este del Pacífico y del Atlántico en las que sale agua fría del fondo hacia la superficie. Este fenómeno es muy importante desde el punto de vista económico, porque el agua ascendente arrastra nutrientes a la superficie y en estas zonas prolifera la pesca. Las pesquerías de Perú, Gran Sol (sur de Irlanda) o las del África atlántica se forman de esta manera.

![]()

Imagen esquemática y conceptual de distintos fenómenos eléctricos y luminosos generados por ciertas tormentas intensas. Imagen tomada de Internet, en su versión inglesa, y adaptada al español. La imagen originaria es de Lyons et al. (2000) de la American Geophysical Union.

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Los rios refrescan amplias zonas de la Tierra y hacen posible la vida

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, me parece que merece un capítulo aparte y especial por su significado para muchos pueblos y culturas y también, por su contribución para hacer posible muchos ecosistemas y formas de vida. Así que, me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

emilio silvera

Nov

5

Observandom un agujero negro aventurero

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

Ciencia

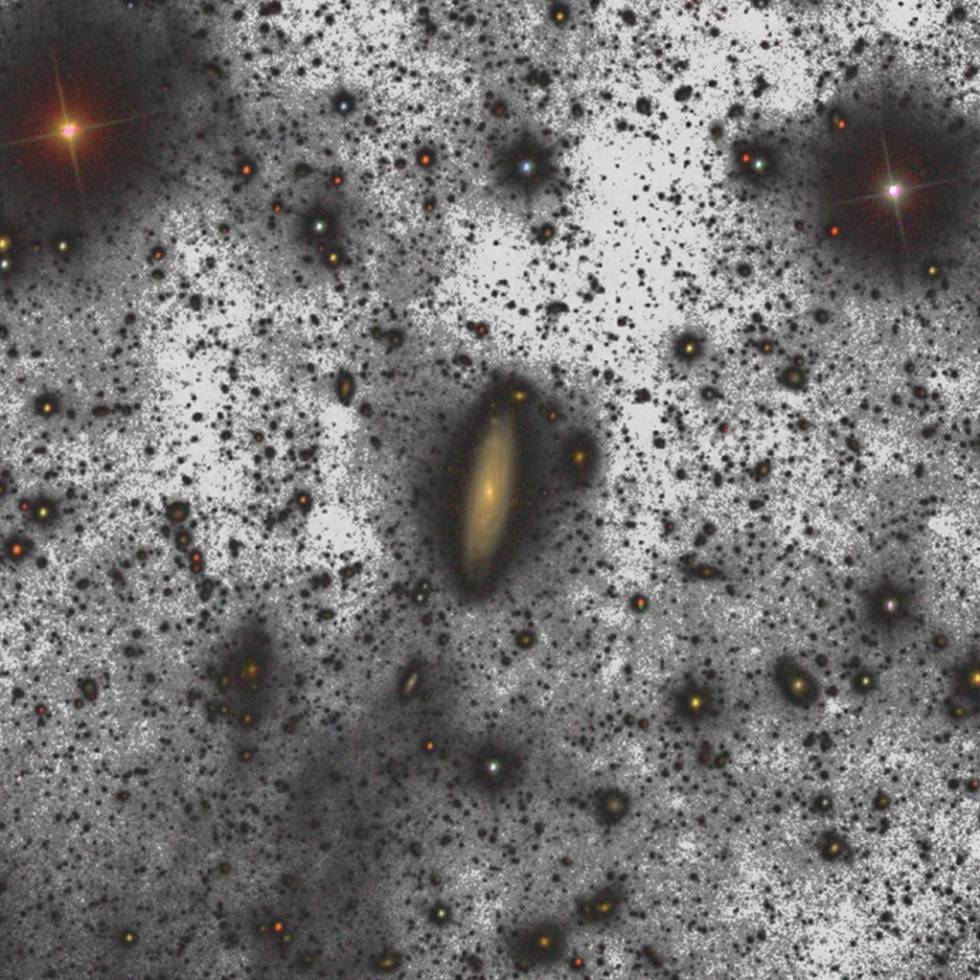

Observan un agujero negro «casi desnudo» y a la fuga

El objeto «escapa» a una velocidad de 3.200 km por segundo de una gran galaxia que ha devorado a la suya

Un equipo de astrónomos ha descubierto un agujero negro supermasivo «casi desnudo» que se mueve a una velocidad de 3.200 km por segundo a través del espacio. El objeto es en realidad el único resto de una pequeña galaxia que ha sido devorada por otra más grande, en un cúmulo a más de 2.000 millones de años luz de la Tierra.

El encuentro cercano entre las dos galaxias ocurrió hace millones de años. El choque despojó a la más pequeña de casi todas sus estrellas y el gas. Lo que queda es su agujero negro y un pequeño remanente galáctico de solo unos 3.000 años luz de diámetro. Puede parecer mucho, pero no lo es. A modo de comparación, nuestra Vía Láctea tiene aproximadamente 100.000 años luz de diámetro.

Los agujeros negros supermasivos, que son millones o miles de millones de veces más masivos que el Sol, suelen residir en los centros de la mayoría de las galaxias. Se cree que las grandes galaxias crecen devorando compañeras más pequeñas. En esos casos, los agujeros negros de ambas comienzan a orbitar entre sí y con el tiempo terminan fusionándose. Pero el descubrimiento fue realizado como parte de un programa para detectar agujeros negros de este tipo que no estén en los centros de las galaxias.

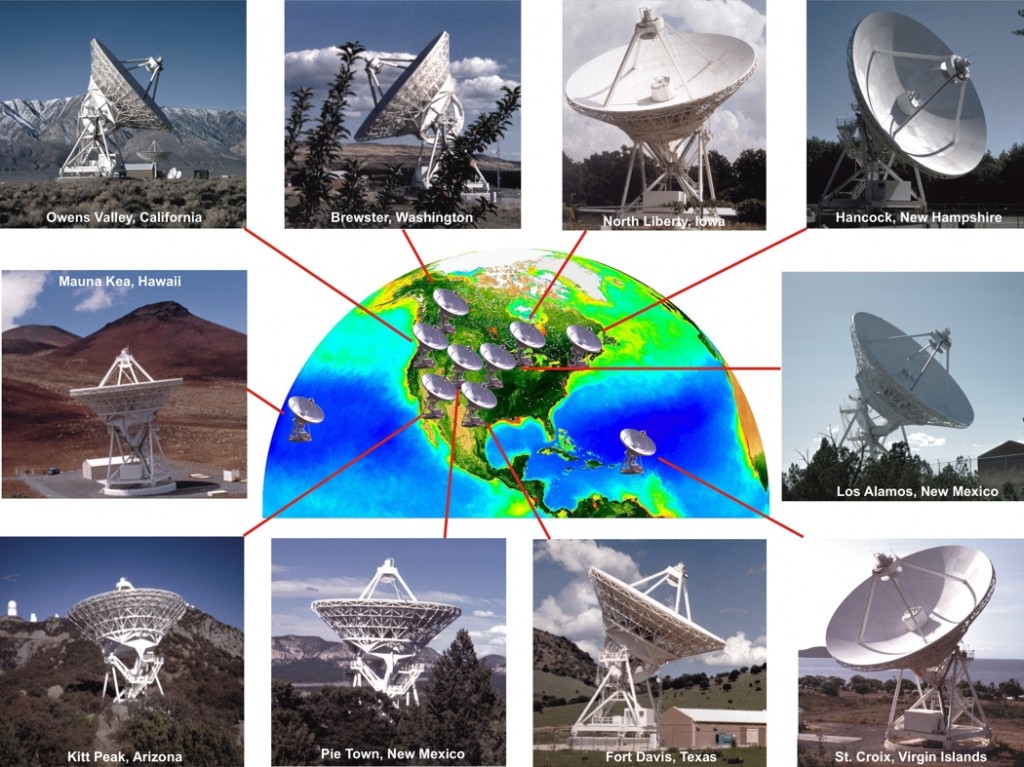

«Estábamos buscando pares de agujeros negros supermasivos en órbita, con un desplazamiento desde el centro de una galaxia como prueba inequívoca de una fusión de galaxias anterior», explica James Condon, del Observatorio Nacional de Radioastronomía. «En lugar de ello, encontramos este agujero negro que huye de la galaxia más grande y deja un rastro de escombros detrás de él», añade. «No hemos visto nada como esto antes», asegura Condon.

Los astrónomos comenzaron su búsqueda usando el Very Long Baseline Array (VLBA) en Hawái de la Fundación Nacional de Ciencia de EE.UU. para obtener imágenes de muy alta resolución de más de 1.200 galaxias, previamente identificadas por los estudios del cielo a gran escala realizadas con telescopios infrarrojos y de radio. Sus observaciones del VLBA muestran que los agujeros negros supermasivos de casi todas estas galaxias estaban en los centros de las galaxias.

Sin embargo, un objeto, en un cúmulo de galaxias llamado ZwCl 8193, no se ajustaba a ese patrón. Otros estudios demostraron que este objeto, llamado B3 1715 + 425, es un agujero negro supermasivo rodeado de una galaxia mucho más pequeña y más débil de lo esperado. Además, este objeto está acelerando fuera del núcleo de una galaxia mucho más grande, dejando una estela de gas ionizado detrás de él.

Los científicos concluyeron que B3 1715 + 425 es lo que ha quedado de una galaxia que pasó a través de la galaxia más grande y se quedó sin la mayoría de sus estrellas y gas por el encuentro: un agujero negro supermasivo «casi desnudo». Probablemente, el remanente va a perder más masa y cesar la formación de nuevas estrellas.

«En mil millones de años más o menos, es probable que sea invisible», dice Condon. Eso significa que podría haber muchos más de estos objetos sobrantes de encuentros galáctico anteriores que los astrónomos no pueden detectar.

Los científicos siguen buscando, sin embargo. Están observando más objetos, en un proyecto a largo plazo con el VLBA. Los nuevos telescopios ópticos que entrarán en funcionamiento en los próximos años, como el Gran Telescopio para Rastreos Sinópticos (LSST), mejorará la búsqueda de fenómenos semejantes.

Nov

3

El colapso del núcleo de las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (1)

Comments (1)

El vacío superconducto – La máquina de Higgs-Kibble

El vacío superconductor – La máquina de Higgs-Kibble II

Lo único que no resulta ser lo mismo cuando se mira a través a través del microscópico electrónico (o, en la jerga de la física teórica, cuando se realiza una transformación de escala) es la masa de la partícula. Esto se debe a que el alcance de la fuerza parece mayor a través del microscopìo y, por lo tanto, la masa de la partícula parece ser menor. Nótese que esta situación es la opuesta a la que se presenta en vida corriente donde un grano de arena parece mayor -¿más pesado, por lo tanto?- cuando se observa con un microscopio.

Granos de arena vistos al microscopio electrónico

Una consecuencia de todo esto es que en una teoría de Yang-Mills el termino de masa parece desaparecer se realiza una transformación de escala, lo que implica que a través del microscopio se recupera la invariancia gauge. Esto es lo que causa la dificultad con la que se enfrentó Veltman. ¿Se observar directamente el potencial vector de Yang-Mills? Parece que puede observarse en el mundo de las cosas grandes, no en el mundo de lo pequeño. Esto es una contradicción y es una razón por la que ese esquema nunca ha podido funcionar adecuadamente.

En el mundo cuántico se pueden contemplar cosas más extrañas. El entrelazamiento cuántico es un extraño fenómeno por el que las partículas cuánticas se conectan tan profundamente que comparten la misma existencia. Antaño era un hito rarísimo, pero hoy, entrelazar partículas se ha convertido en una actividad cotidiana en los laboratorios de todo el mundo.

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, = 1’62 × 10-33 cm, es la escala de longitud por debajo de la cual es espacio, tal tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler, o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que la longitud de Planck-Wheeler, es decir, 2’61 × 10-66 cm2) juega un papel clave en la entropía de un agujero negro.

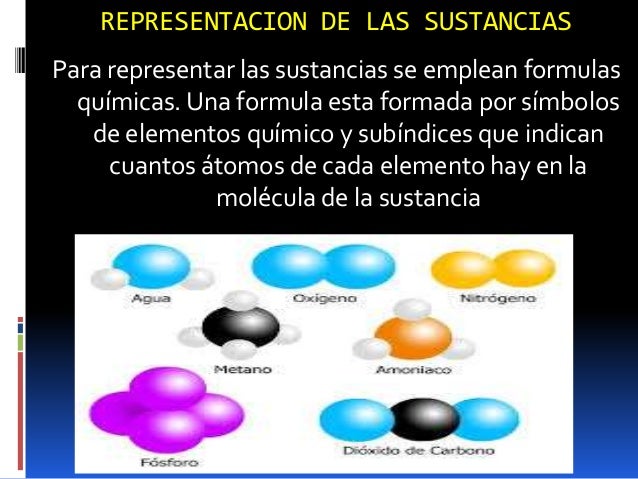

Átomos, sustancias, elementos, química…

Las moléculas pueden estar formadas por la unión de átomos iguales, denominados elementos químicos , o por la unión de átomos diferentes, …

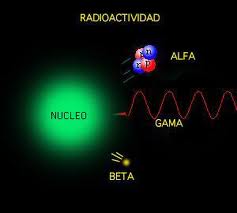

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Pero el trabajo de hoy se titula: El colapso del núcleo de las estrellas

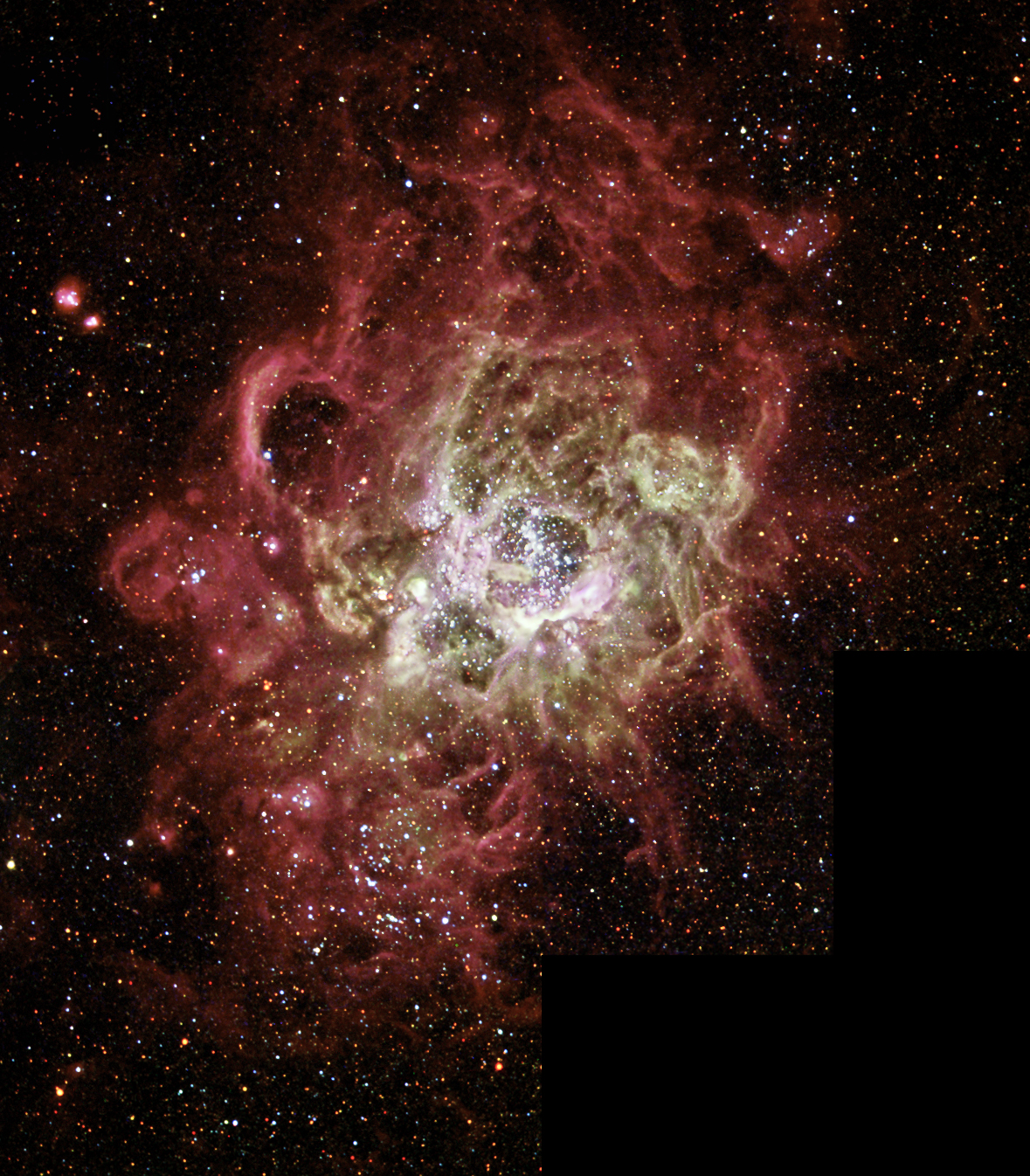

En la imagen podemos contemplar lo que se clasifica NGC 3603, es un cúmulo abierto de estrellas en una vasta zona estelar, rodeada de una región H II (una enorme nube de gas y plasma en el que constantemente están naciendo estrellas), situado en el brazo espiral Carina de la Vía Láctea, a unos 20.000 años-luz de distancia en la constelación de Carina. Es uno de los jóvenes cúmulos de estrellas más luminosas e impresionante en la Vía Láctea, y la concentración más densa de estrellas muy masivas conocidas en la galaxia. Se estima que se ha formado hace alrededor de un millón de años. Las estrellas azules calientes en el núcleo son responsables de la fuerte radiación ultravioleta y los vientos estelares, tallando una gran cavidad en el gas.

NGC 3603 alberga miles de estrellas de todo tipo: la mayoría tienen masas similares o menores a la de nuestro Sol, pero las más espectaculares son algunas de las estrellas muy masivas que están cerca del final de sus vidas. Ahí están presentes algunas estrellas supergigantes que se agolpan en un volumen de menos de un año luz cúbico, se han localizado en la misma zona a tres llamadas Wolf-Rayet, estrellas muy brillantes y masivas que expulsan grandes cantidades de material antes de convertirse en supernovas.

Una de estas estrellas (NGC 3603-A1), una estrella doble azul que orbita alrededor de la otra una vez cada 3,77 días, es la estrella más masiva conocida hasta en la Vía Láctea. La más masiva de estas dos estrellas tiene una masa estimada de 116 masas solares, mientras que su compañera tiene una masa de 89 masas solares. Hay que decir que la máxima máxima de las estrellas está calculada en 120 masas solares, ya que, a partir de ahí, su propia radiación las destruiría.

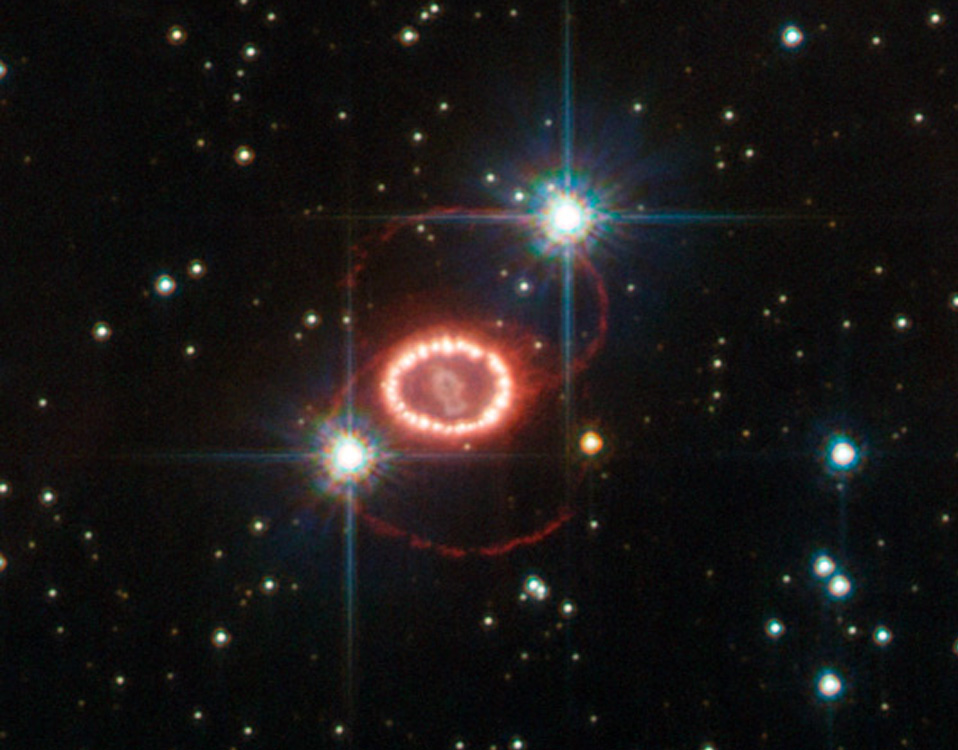

En el centro de la imagen podemos contemplar ese “collar de diamantes” que es el resultado evolucionado de aquella tremenda explosión estelar contemplada en 1987, cuando una estrella supermasiva, habiendo agotado todo su combustible nuclear de fusión, se contrae sobre sí misma al quedar sin defensa, en “manos” de la Gravedad que ya no se ve frenada por la inercia explosiva de la fusión que tendía a expandir la estrella.

Las capas exteriores son eyectadas al Espacio Interestelar con violencia para formar una nebulosa, mientras el grueso de la masa de la estrella se contrae más y más para formar una estrella de neutrones o un agujero negro dependiendo de su masa.

Las estrellas supermasivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Hace veinte años, los astrónomos fueron testigos de uno de los más brillantes explosiones estelares en más de 400 años. La supernova titánica, llamada SN 1987A, ardió con la fuerza de 100 millones de soles varios meses después de su descubrimiento el 23 de febrero de 1987.

La Supernova SN 1987A

Las observaciones de SN 1987A, hechas en los últimos 20 años por el Telescopio Espacial Hubble de NASA / ESA y muchos otros grandes telescopios terrestres y espaciales, han servido para cambiar la perspectiva que los astrónomos tenían de cómo las estrellas masivas terminan sus vidas.Estudiando estos sucesos sus comienzos se pueden ver los detalles más significativos del acontecimiento, cosa que, estudiando los remanentes de supernovas muy antiguas no se podían ver.

Remanente de Supoernova antiguo

Las estrellas supermasivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Arriba podemos contemplar observaciones realizadas en distintas fechas que nos muestran la evolución de los anillos de SN 1987 A. ¿Qué pudo causar los extraños anillos de esta Supernova.Hace 28 años se observó en la Gran Nube de Magallanes la supernova más brillante de la historia contemporánea.

El clúster abierto NGC 3603 contiene a Sher 25, una super gigante B1a que inevitablemente morirá en un masivo suceso supernova en los próximos 20,000 años. ¡Esto emitirá una luz tan potente que competirá en el cielo con el planeta Venus! Un detalle muy emocionante es que Sher 25 presenta anillos similares a los que dejó la supernova SN 1987 A.

Cuando colapsa el núcleo de una estrella, ocurre en la formación de una estrella de neutrones, es preciso que la estrella esté evolucionada hasta el punto de que su núcleo esté compuesto completamente por hierro, que se niega a ser quemado en reacciones nucleares, no se puede producir la fusión y, por tanto, no produce la energía suficiente como soportar la inmensa fuerza de gravedad que la propia masa de la estrella genera y que, solamente era frenada por la energía que produce la fusión nuclear que tiende a expandir la estrella, mientras que la gravedad tiende a contraerla.

El núcleo entonces se contrae, liberando energía potencial gravitatoria, se rompen los núcleos de los átomos de hierro en sus protones y sus neutrones constiituyentes. A medida que aumenta la densidad, los protones se combinan con los electrones para formar neutrones. El colapso sólo se detiene (a veces) con la presión de degeneración del gas de neutrones (Principio de exclusión de Pauli) compensa el empuje hacia adentro de la Gravedad. El proceso completo hasta que todo ese ingente material se transmuta en la estrella de neutrones dura muy poco tiempo, es un proceso vertiginoso.

Otra perspectiva del remanente de la supernova por colapso de núcleo SN 1987A.

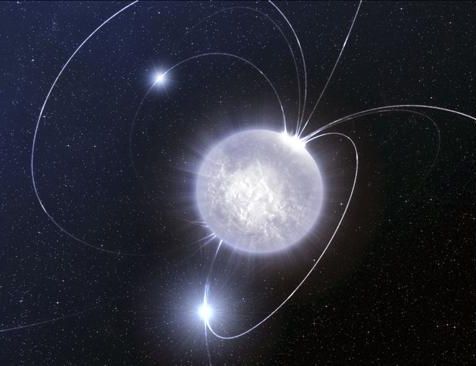

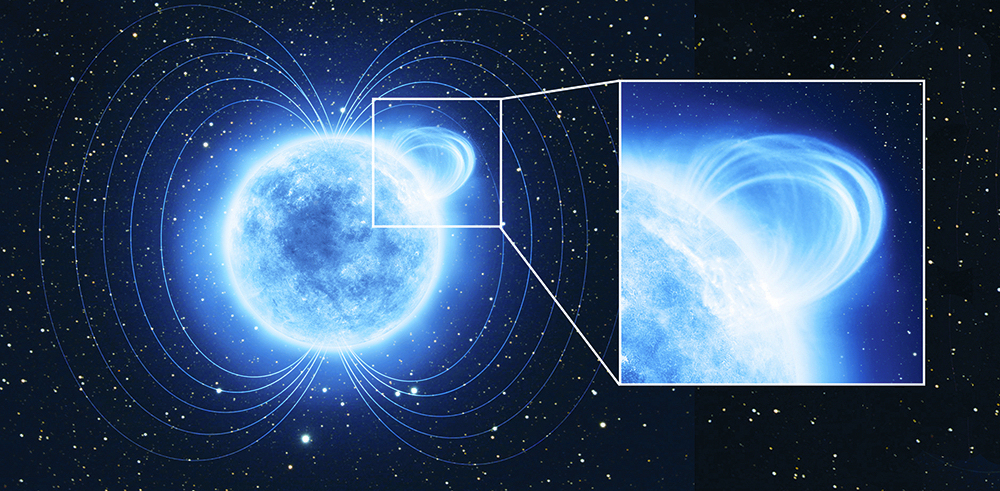

Han sido muy variados los grupos de astrónomos investigadores que han realizado observaciones durante largos períodos de tiempo para llevar a cabo la no fácil tarea de comprender cómo se forman las estrellas de neutrones y púlsares cuando estrellas masivas llegan al final de sus vidas y finalizan el proceso de la fusión nuclear, momento en el que -como explicaba antes- la estrella se contrae, implosiona sobre sí misma, se produce la explosión supernova y queda el remanente formado por material más complejo en forma de gases que han sido expulsados por la estrella en este proceso final en el que, las capas exteriores de la estrella, forman una nebulosa y la estrella en sí misma, al contraerse y hacerse más densa, es decir de 1017 kg/m3.

Regióm HII

Se ha podido llegar a saber que las supernovas por colapso de núcleo suelen ocurrir en los brazos de galaxias espirales, así como también en las regiones HII, donde se concentran regiones de formación estelar. Una de las consecuencias de esto es que las estrellas, con masas a partir de 8 veces la masa del Sol, son las estrellas progenitoras de estos estos sucesos cósmicos. También es muy interesante y se está estudiando cómo se forman los inmensos campos magnéticos alreddor de estas estrellas de neutrones y púlsares que se conviertan en magnétares.

Cuando hace unos pocos años se descubrió la estrella de neutrones SGR0418, poco podían pensar los astrónomos que su funcionamiento alteraría todas las teorías existentes ahora acerca del funcionamiento de los magnétares. Sin embargo es así, ya que funciona como uno de éstos y no como sería propio de su condicción. Este hallazgo obliga a la ciencia a replantearse las teorías que se manejaban hasta ahora acerca del origen y evolución de los magnétares.

El Púlsar del Cangreso escondido en la Nebulosa del mismo nombre

El “universo” de los procesos que siguen al colapso de los núcleos de las estrellas masivas es fascinante. Así, cuando se crea un púlsar que es una estrella de neutrones que gira sobre sí misma a una gran velocidad y tambien una fuente de ondas de radio que vibran con periodos regulares, este de estrellas tan extrañas son fruto -como antes decía- de una supernova o por consecuencías de la acreción de materia en estrellas enanas blancas en sistemas binarios. Una enana blanca que también es muy masiva, si tiene una estrella compañera cercana, genera mucha fuerza gravitatoria comienza a tirar del material de la estrella vecina y se lo queda hasta tal punto que, se transforma en una estrella de neutrones en una segunda etapa en la que se producen nuevos procesos de implosión.

La densidad de estas estrellas es increiblemente grande, tanto que un cubo de arena lleno del material de una estrella de neutrones tendría un peso parecido al de la montaña mas grande de la tierra. Los púlsares fueron descubiertos en 1970 y hasta ahora solo se conecen unas 300 estrellas de este tipo. Sin embargo, se calcula que sólo en nuestra Galaxia podrían ser un millón. La rápida rotación de los pùlsares los mantiene fuertemente magnetizados y sus rotaciones vertiginosas generan y son inmensas fuentes de electricidad. Llegan a producir mil millones de millones de voltios. Cuando nustros aparatos los observan y estudian detectan intensos haces de radiación en toda la gama del espectro (radio, luz, rayos X, Gamma).

Imagen de rayos-X en falso color de la región del cielo alrededor de SGR 1627-41 obtenida con XMM-Newton. La emisión indicada en rojo procede de los restos de una estrella masiva que estalló. Cubre una región más extendida de lo que se deducía anteriormente de las observaciones de radio, alrededor del SGR. Esto sugiere que la estrella que estalló fue el progenitor del magnetar. Crédito: ESA/XMM-Newton/EPIC (P. Esposito et al.)

magnetar SGR 04 18

Por ahora se conoce que de cada diez supernovas una se convierte en magnetar, si la supernova posee 6 y 12 masas solares, se convierte en una estrella de neutrones de no más de 10 a 20 km de diámetro. En el caso de las estrellas supermasivas de decenas de masas solares, el resultado es muy diferente y nos encontramos con los agujeros negros, esos monstruos del espacio devoradores de materia.

Cuando una estrella supermasiva muere, las consecuencias energéticas son inmensas. Ahí, en esa explosión se producen transiciones de fase que producen materiales pesados y complejos. En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica de elementos.

Las estrellas mueren cuando dejan la secuenbcia principal, es decir, cuando no tienen material de fusión y quedan a merced de la fuerza de gravedad que hace comprimirse a la estrella más y más, en algunos casos, cuando son supermasivas, llegan a desaparecer de nuestra vista, y, su único destino es convertirse en temibles Agujeros Negros.

La explosión de una estrella gigante y supermasiva hace que brille más que la propia galaxia que la acoge y, en su tránsito de estrella a púlsar o agujero negro, se forman elementos que como el oro o el platino, se esparcen por el espacio interestelar en las inmensas nebulosas de las que, más tarde, naceran nuevas estrellas y nuevos mundos que contendran esos materiales.

Pero está claro que todo el proceso estelar evolutivo inorgánico nos condujo el simple gas y polvo cósmico a la formación de estrellas y nebulosas solares hasta los planetas, la Tierra en particular, en cuyo medio ígneo describimos la formación de las estructuras de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas. Porque, en última instancia, debemos ser conscientes de un hecho cierto: En las estrellas se ¡“fabrican los materiales que darán lugar al surgir de la vida”!.

El remanente estelar después de la explosiòn puede ser muy variado

Es posible que lo que nosotros llamamos materia inerte, no lo sea tanto, y, puede que incluso tenga memoria que transmite por medios que no sabemos reconocer. Esta clase de materia, se alía con el tiempo y, en su momento adopta una forma predeterminada y de esa manera sigue evolucionando hasta llegar a su máximo ciclo o nivel en el que, de “materia inerte” llega a la categoría de “materia viva”, y, por el camino, ocupará siempre el lugar que le corresponda. No olvidemos de aquel sabio que nos dijo: “todas las cosas son”. El hombre, con aquellas sencillas palabras, elevó a todas las cosas a la categoría de ¡SER!

¿No os hace pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Claro que, el mundo inorgánico es sólo una parte del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

Según expliqué muchas veces, los quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, éstos se consideran una subclase de los hadrones. La composición de los núcleos (lo que en química se llama análisis cualitativo) es extraordinariamente sencilla, ya que como es sabido, constan de neutrones y protones que se pueden considerar como unidades que dentro del núcleo mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es CnH2n+2, lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

Bueno, otra vez, como tantas veces me pasa, me desvío del camino que al principio del me propuse seguir y me pierdo en las elucubraciones que imaginan mis pensamientos. Mejor lo dejamos aquí.

emilio silvera

Nov

1

Los átomos, el núcleo atómico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El núclo atómico ~

Clasificado en El núclo atómico ~

Comments (0)

Comments (0)

Es tan pequeño que ni lo podemos ver con el ojo desnudo, nos valemos de los microscopios electrónicos para poder saber de ellos, y, sin embargo, si me dieran a escoger la mayor maravilla del Universo, tendría mis dudas entre los átomos y el cerebro. Pero creo que, al final, sin dudarlo, escogería ésta ¡Los átomos!

El número de protones en el núcleo define a qué elemento químico pertenece el átomo: por ejemplo, todos los átomos de cobre contienen 29 protones. El número de neutrones define el isótopo del elemento. El número de electrones influye en las propiedades magnéticas de un átomo.

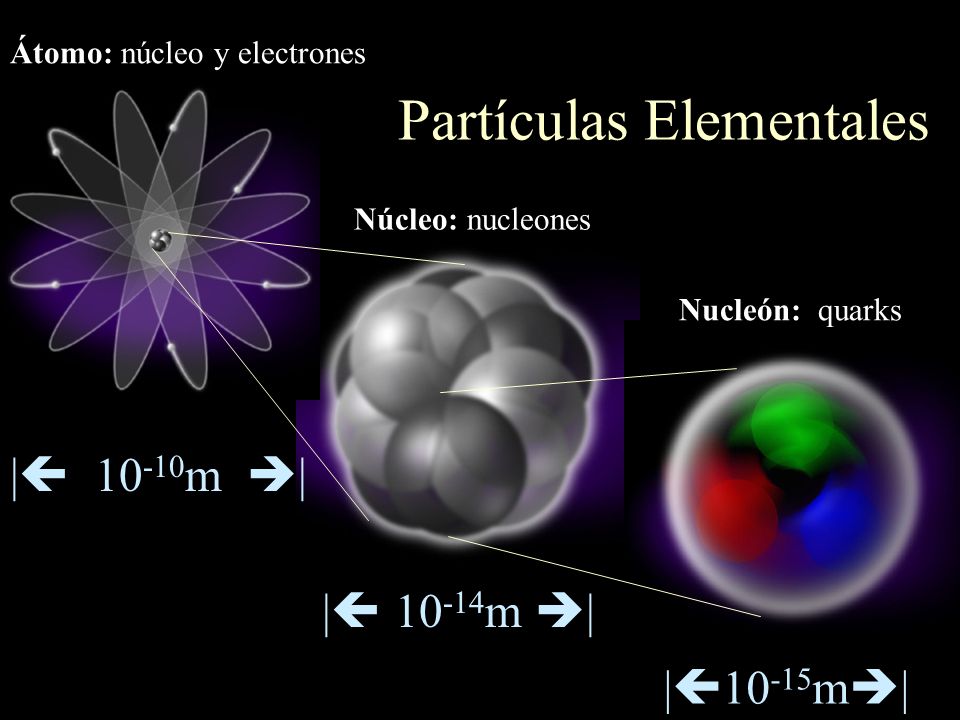

Mucho ha tenido que trasminar la Mente Humana para llegar al fondo de los componentes de la materia que, como todos sabemos ahora, están conformadas de moléculas hechas de átomos que, a su vez, están hechos de partículas subatómicas unas más elementales que otras que, dentro del núcleo y fuera de él, hacen el conjunto que denominamos átomos.

El núcleo atómico está cargado positivamente al tener allí situados a los protones. Los neutrones no tienen carga y éstas dos partículas de la familia de los Hadrones en su rama bariónica, cuando están dentro del núcleo se suelen llamar nucleones. Lo curioso del caso es que, dentro de ellos, partículas más pequeñas de la familia Quarks, se han juntado en tripletes para conformarlos, es decir, un protón está hech0 por dos quarks up y un quark down, mientras que un neutrón, está hecho por dos qurks down y un quarks up.

Pero lo m´ças curioso del caso es que, los Quarks dentro de los protones y los neutrones están confinados, no pueden separarse y son sujetados por 8 partículas de la familia de los Bosones que se llaman Gluones que, son los intermediarios de la fuerza nuclear fuerte, la más potente de todas las fuerzas fundamentales de la Naturaleza. Esa fuerza, funciona al contrario que las otras tres, es decir, aumenta con la distancia. Se comporta como un muelle de acero que, cuanto más lo estiramos más resistencia opone.

Representación aproximada del átomo de Helio. en el núcleo los protones están representados en rojo y los neutrones en azul. En la realidad el núcleo también es simétricamente esférico. El núcleo atómico es la parte central de un átomo, tiene carga positiva, y concentra más del 99,9% de la masa total del átomo.

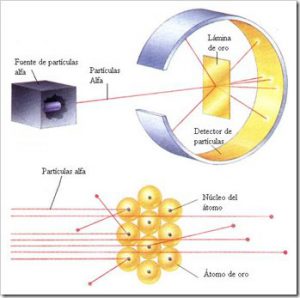

La existencia del núcleo atómico fue deducida del experimento de Rutherford, donde se bombardeó una lámina fina de oro con partículas alfa, que son núcleos atómicos de helio emitidos por rocas radiactivas. La mayoría de esas partículas traspasaban la lámina, pero algunas rebotaban, lo cual demostró la existencia de un minúsculo núcleo atómico.

El Experimento de Rutherford. En 1911 se realizó en Manchester una experiencia encaminada a corroborar el modelo atómico de Thomson. Fué llevada a cabo por Geiger, Marsden y Rutherford, y consistía en bombardear con partículas alfa (núcleos del gas helio) una fina lámina de metal.

Una imagen precisa del núcleo del carbono-14 debe tener en cuenta tanto las interacciones entre parejas de protones y neutrones (fuerza a dos cuerpos, izquierda), como las interacciones entre tres nucleones (fuerzas a tres cuerpos, derecha).

Lo cierto es que, estos “personajillos” tienen una imnesa importancia en todo lo que se cuece en el Universo, ya que, sin ellos, no existirían las estrellas ni los mundos, ni las galaxias, ni las Nebulosas, ni ninguno de los objetos que captan nuestros telescopios en el inconmensurable Cosmos. ¡Ah! Tampoco nosotros podríamos existir si en estos personajes se dieran algunos cambios. Imaginaros que la masa del protón decrece en una diezmillonésima parte, o, que lo mismo le pudiera pasar a la carga del electrón… ¡Nosotros no existiríamos!

Interacciones eléctricas entre protones y electrones

Antes del experimento de Rutherford la comunidad científica aceptaba el modelo atómico de Thomson, situación que varió después de la experiencia de Rutherford. Los modelos posteriores se basan en una estructura de los átomos con una masa central cargada positívamente rodeada de una nube de carga negativa.

Este tipo de estructura del átomo llevó a Rutherford a proponer su modelo en que los electrones se moverían alrededor del núcleo en órbitas. Este modelo tiene una dificultad proveniente del hecho de que una partícula cargada acelerada, como sería necesario para mantenerse en órbita, radiaría radiación electromagnética, perdiendo energía.

Para aclarar el panorama y la confusión que sobre el átomo y el núcleo atómico existía, tuvo que llegar el gran físico Murray Gell-Mann, que fue quien por primera vez habló de los Quarks. Se le otorgó el Premio Nobel de Física en 1969 por sus descubrimientos sobre partículas elementales. La teoría de Gell-Mann aportó orden al caos que surgió al descubrirse cerca de 100 partículas en el interior del núcleo atómico. Esas partículas, además de los protones y neutrones, estaban formadas por otras partículas elementales llamadas Quarks. Los quarks se mantienen unidos gracias al intercambio de Gluones. Junto con otros investigadores construyó la teoría cuántica de quarks y gluones, llamada Cromodinámica cuántica.

Sí, ¡Todo lo grande está hecho de cosas pequeñas!

Totales: 83.381.655

Totales: 83.381.655 Conectados: 5

Conectados: 5