Dic

14

¿Hacia dónde vamos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Futuro incierto ~

Clasificado en El Futuro incierto ~

Comments (4)

Comments (4)

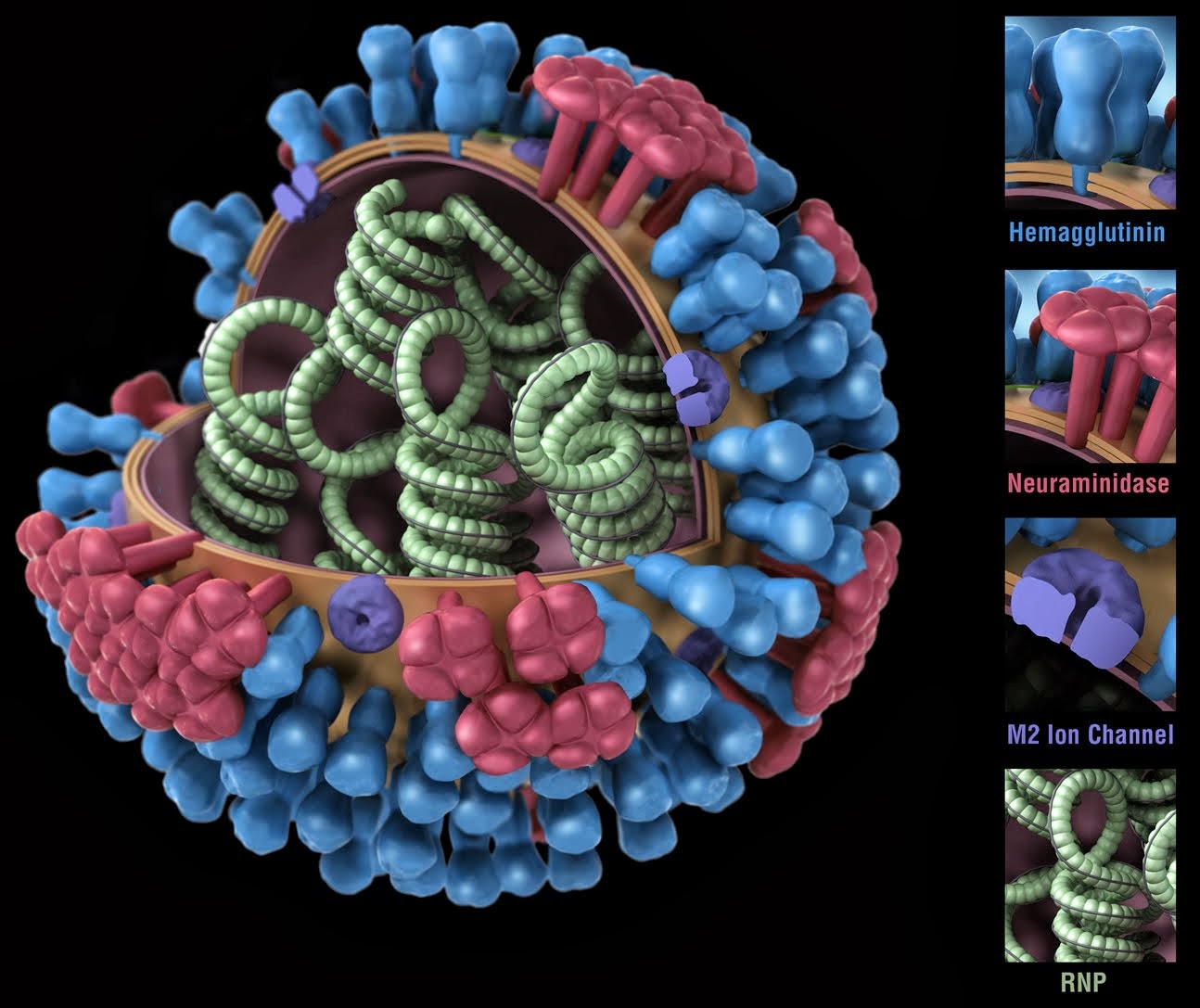

Se supone que, en los comienzos del universo, justo después del Big Bang, existió un ‘plasma de quarks y gluones, dos partículas confinadas hoy en la materia pero que entonces vagaban libremente… Ahora hemos construído aceleradores de partículas que tratan de recrear aquellos momentos para poder “ver” lo que allí pasó y, buscamos el origen de la masa y partículas exóticas que nos digan algo sobre esa supuesta masa “perdida”, o, que no alcanzamos a ver.

Cuando se lee un buen libro, se saborean sus pasajes más interesantes y, al final, sientes un poco de pena porque aquello se termine tan pronto. Sientes que quieres más, te quedas algo insatisfecho de no haber podido llegar más lejos, de profundizar más en aquello que tánto llamó tu atención y despertó tu curiosidad. Saber sobre el enigma planteado por ekl autor y no desarrollado hasta el final dejando un estado en el lector que lo preocupa, es tan vital para la mente que, cuando no puedes desarrollar ciertos pemnsamientos por falta de conocimientos, te sientes frustado y, de alguna manera, sufres por no saber.

Habiendo finalizado la lectura de Las sombras de la Mente, de Roger Penrose, en la que nos habla de la posibilidad de comprender de forma científica lo que la conciencia es y, extrapola dicha conciencia, hasta ese otro mundo de la I.A., en el que, si nada lo remedia, estamos inmersos hasta tal punto que, en el futuro más o menos lejano, será lo que predomine tanto aquí en la la Tierra, como en los mundos y lunas que nos acompañan en el Sistema solar, e, incluso, mucho más allá. Ellos serán, los Robots, los que surquen los cielos y el espacio interestelar en busca de las estrellas.

Es posible que podamos llegar a los límites de la realidad pero… ¿No crearemos una nueva raza para que, sin nosotros saberlo nos suplante en el futuro?

La computación y el Pensamiento consciente

En los últimos tiempos, mucho es lo que se habla de la I.A., y, algunos, nos preguntamos: ¿Será posible que en un futuro más o menos lejano, eso que llamamos Inteligencia Artificial, nos pueda superar?

¿Hasta dónde llegarán?

Hay corrientes en ese sentido que nos llevan a pensar y, ¿por qué no? A preocuparnos profundamente. Si hacemos caso de esas afirmaciones (quizá algo extremas pero, con visos de verdad) de los que defienden a capa y espada el futuro de la I.A., diciendo que, con el tiempo, los ordenadores y los robots superarán a los humanos en inteligencia al llegar a tener todas y cada una de las capacidades humanas y otras que, los humanos nunca podrán tener. Entonces, estos ingenios serían capaces de hacer muchísimo más que ayudar simplemente a nuestras tareas inteligentes.

De hecho, tendrían sus propias y enormes inteligencias. Podríamos entonces dirigirnos a estas inteligencias superiores en busca de consejo y autoridad en todas las cuestiones complejas y de interés que, por nosotros mismos, no pudiéramos solucionar; ¡y finalmente podrían resolver los problemas del mundo que fueron generados por la Humanidad!

Alan Turing estaba convencido de que algún día, las máquinas serían tan inteligentes como los humanos. Y para demostrarlo, inventó el Test de Turing, en 1950. El Test de Turing se basa en la idea de que si no puedes distinguir las respuestas de un programa frente a las de un humano, entonces es porque la inteligencia artificial es tan inteligente como nosotros.

Así se empieza pero… ¿Cómo se acaba?

La Nasa ha fabricado un robot que pesa 150 kilogramos, tiene aspecto humanoide y se llama Robonaut-2 (R-2 para los amigos). Este androide será lanzando al espacio y pronto será el nuevo compañero de los tripulantes de la Estación Espacial Internacional. Por algo se comienza y, nunca se sabe como todo terminará.

Pero, si todo eso fuera así (que podría llegar a serlo), podríamos extraer otras consecuencias lógicas de estos desarrollos potenciales de la I.A. que muy bien podría generar una cierta alarma muy justificada ante una situación tan atípica, en la que, unos “organismos” artificiales creados por nosotros mismos, nos superen y puedan llegar más lejos de lo que nosotros, podríamos ser capaces de llegar nunca. ¿No harían estos ordenadores y Robots, a la larga, que los Humanos fueran superfluos para ellos?

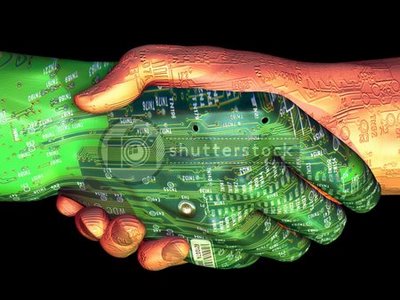

¿Llegarán a ser dos “especies” amigas?

Si los Robots guiados por ordenadores insertados en sus cerebros positrónicos o espintrónicos, o, guiados por un enorme y potente Ordenador Central, resultaran ser muy superiores a nosotros en todos los aspectos, entonces, ¿no descubrirían que pueden dirigir el mundo sin necesidad alguna de nosotros? La propia Humanidad se habría quedado obsoleta. Quizá, si tenemos suerte, ellos podrían conservarnos como animales de compañía (como alguien dijo en cierta ocasión); o, si somos inteligentes, podríamos ser capaces de transferir las “estructuras de información” que somos “nosotros mismos” a una forma de robot (como han pensado algunos otros), o quizá no tengamos esa suerte y no lleguemos a ser tan inteligentes…

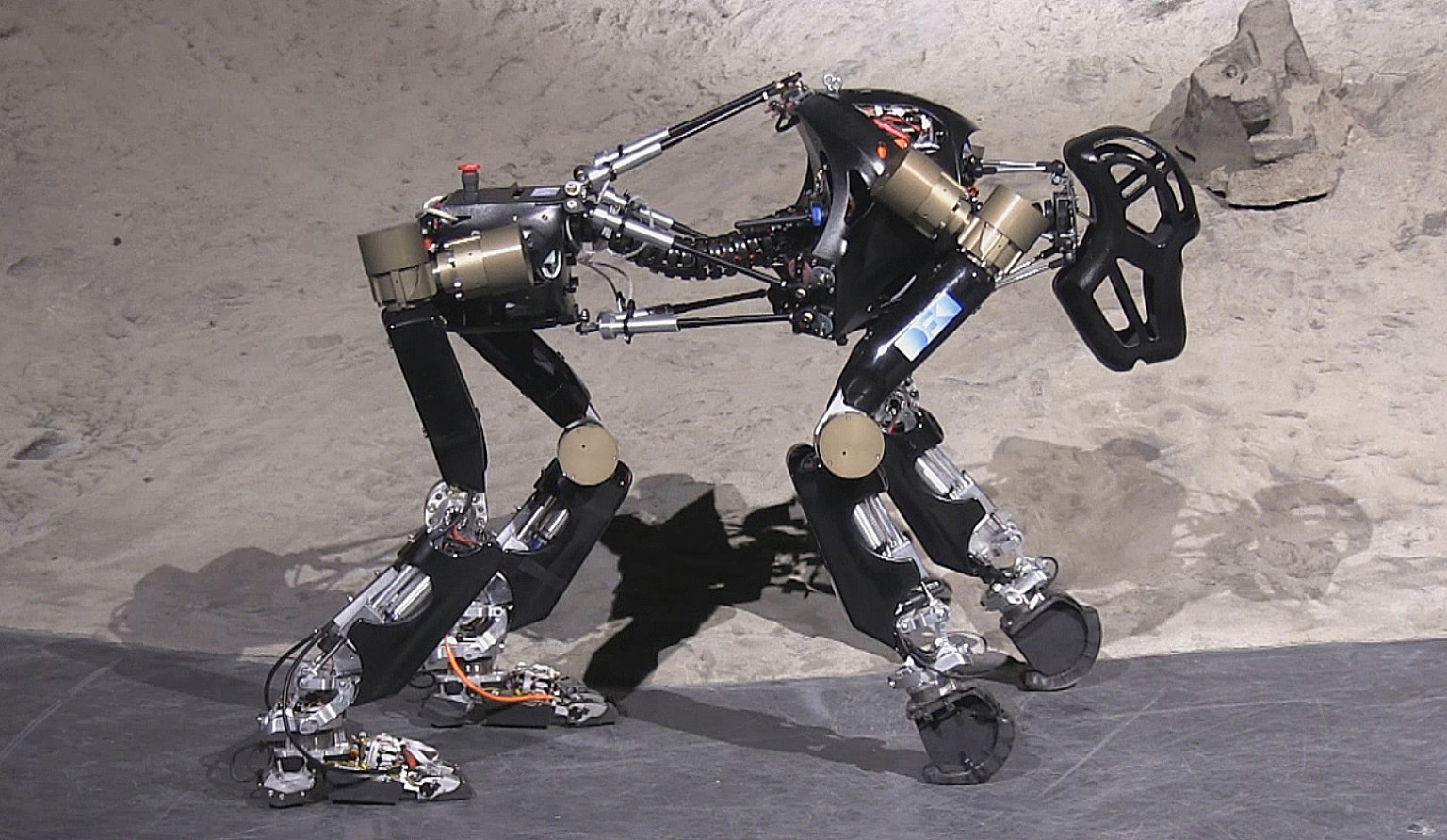

Investigadores de la Universidad de Bremen en Alemania dio a conocer el simio robot – un aparatito de cuatro extremidades que se tambalea a lo largo de su frente “nudillos” y patas traseras. El robot de 40 libras, que tuvo más de tres años en desarrollarse, puede moverse hacia adelante, hacia atrás y hacia los lados – todo ello sin un cable de control. Cuenta con sensores de presión en sus patas traseras, y puede incluso dar vuelta en torno a sí mismo.

Colonizar el espacio con robots es un antiguo argumento de obras de ciencia-ficción, algo que podrían hacer realidad en Japón en no demasiado tiempo. La imagen de arriba, a no tardar mucho, podría ser una realidad. De momento hemos enviado sondas y naves espaciales de todo tipo y rovers-laboratorios andarines pero, en el futuro cercano, la cosa irá en aumento de cantidad y calidad.

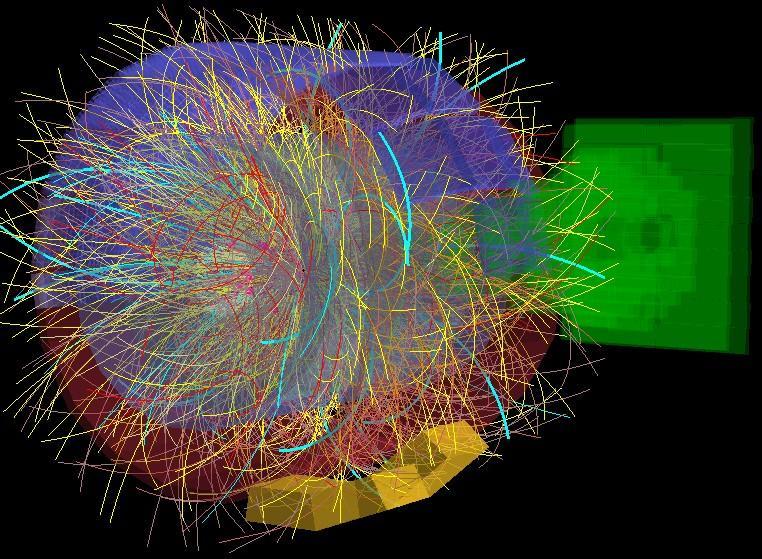

Red neuronal estructura disipativa

Todo efecto incide en su trama

Por otra parte, quiero pensar que, lo que hace y es capaz de realizar nuestro cerebro creador de pensamientos, nunca será del dominio de la I.A. que, nunca podrán describir o realizar funciones que de manera natural realizan nuestras mentes. ¿Llegarán a tener mentes de verdad los Robots del futuro? ¿Será posible que lleguen a tener sentimientos, a sentir miedo, a poder llorar? ¿Tiene algún sentido que hablemos de semejantes cosas en términos científicos? También podríamos pensar que, la Ciencia, no está capacitada para abordar ciertas cuestiones relacionadas con la complejidad de la Conciencia Humana.

Claro que, por otra parte, no podemos dejar de pensar en el hecho cierto de que, la propia materia parece tener una existencia meramente transitoria puesto que puede transformarse de una forma en otra, de una cosa en otra, e, incluso, puede llegar esa transformación ser tan compleja como para cambiar desde la materia “inerte” hasta el ser consciente.

Incluso la masa de un cuerpo material, que proporciona una medida física precisa de la cantidad de materia que contiene el cuerpo, puede transformarse en circunstancias apropiadas en pura energía (E = mc2) de modo que, incluso la sustancia material parece ser capaz de transformarse en algo con una actualidad meramente matemática y teórica. Dejemos en este caso, la cuántica y otras teorías a un lado para centrarnos en el tema que tratamos de la I.A. y sus posibles consecuencias.

¿Permite la Física actual la posibilidad de una acción que, en principio, sea imposible de simular en un ordenador? Hoy esa respuesta no está disponible y, cuando eso vaya a ser posible, tendríamos que estar en posesión de una nueva Física mucho más avanzada que la actual.

No debemos apartarnos de un hecho cierto: Nuestra Mente, aunque está apoyada por un ente físico que llamamos cerebro y recibe la información del exterior a través de los sentidos, también es verdad que, de alguna manera, sale de nosotros, está fuera de nuestros cuerpos y, viaja en el tiempo y en el espacio, aprende y conoce nuevos lugares, nuevas gente, nuevos conocimientos de su entorno y de entornos lejanos y, a todos ellos, sin excepción, se puede trasladar de manera incorpórea con un simple pensamiento que, de manera instantánea, nos sitúa en este o aquel lugar, sin importar las distancias que nos puedan separar.

Así La parte física y la parte mental, aunque juntas, están separadas de una manera muy real y, desde luego, existe una clara divisoria entre lo físico y lo mental que ocupan distintos dominios de alcance también distintos y, hasta donde pueda llegar el dominio mental ¡No se conoce!

Circuitos y conexiones de infinita potencia. Ahí están encerrados otros mundos de inimaginable belleza, agujeros negros gigantes, púlsares y quásares, estrellas de neutrones y fantásticas nebulosas de increíbles figuras de las que surgen sin cesar nuevas estrellas y nuevos mundos. También ahí residen pensamientos y recuerdos y, hasta es posible rememorizar imágenes nunca vistas de universos paralelos… ¿Cómo son posible todas esas maravillas? Y, ante esa poderosa “herramienta”, me pregunto, podrá alguna vez, la Inteligencia Artificial hacer algo parecido.

El futuro es incierto

Quisiera pensar que, el humano, siempre prevalecerá sobre el “ser Artificial”, sin embargo, tal optimismo, si pensamos en hacerlo real, nunca podrá estar a nuestro alcance. La evolución de la Ciencia, las necesidades de nuestra especie, las exigencias de una Sociedad creciente que llena el planeta hasta límites insoportables…Todo eso, nos llevará a seguir procurando ayuda de ese “universo artificial” que, al fin y a la postre, es la única salida que tenemos para poder llegar a otros mundos en los que poder alojarnos para que, el planeta Tierra, no se vea literalmente asfixiado por la superpoblación. Así que, siendo las cosas así (que lo son), estamos irremisiblemente abocados a ese futuro dominado por la I.A. que, si tenemos suerte, nos dejará convivir con ella y, si no la tenemos… Muy cruda.

Así que, el día que los Robots sean equiparables a los Humanos, ese día, habrá comenzado el principio del fin de la especie que, tan tonta fue, que creó a su propio destructor.

Hay escenarios que producen miedo

Claro que, para que todo esto llegue a pasar, podrían transcurrir siglos. No parece que sea muy factible que una simulación realizada por un Robot avanzado pueda ser semejante a lo que un Humano puede hacer hoy. Sin embargo, cuando los ordenadores y Robots hayan alcanzando la inteligencia de pensamiento y discurrir del cerebro Humano, ese día, amigos míos, no creo que sea un día para celebrar.

Claro que, la idea de poner unir nuestras mentes a esos “Seres”, podría ser una salida, una solución híbrida para paliar nuestras carencias de salir al espacio exterior por nosotros mismos y dentro de la frágil coraza humana que contiene a nuestras Mentes pensantes que, dentro de tan ligera y débil estructura, no tienen la seguridad suficiente para realizar ciertas tareas.

No quiero ser pesimista ni llevar a vuestro ánimo ideas intranquilizadoras. Sin embargo, si la cosa sigue adelante por el camino emprendido, el futuro que nos espera será ese: Convivir con los Robots, emitir leyes para su control, tratar de que hagan sólo aquellos trabajos y tareas encomendadas pero, ¿cómo podremos evitar que, algún día, más evolucionados al exigirle cada vez más complejidad en las ayudas que nos tendrán que prestar, comiencen a pensar por sí mismos?

Así que, como estamos dando a esos Robots el “Conocimiento”, la “Comprensión”, la “Consciencia” y, la “Inteligencia”, lo estamos haciendo partícipes y están tomando posesión, de los bienes más valiosos que podemos poseer y, tal dislate…¡Podríamos pagarlo muy caro!

- “Un Robot no puede hacer daño a un ser humano o, mediante la inacción que un ser humano sufra daños”

- “Un Robot debe de obedecer las ordenes dadas por los seres humanos, salvo que esto provoque un conflicto con la primera ley”

- “Un Robot debe proteger su propia existencia, a no ser que provoque un conflicto con las dos primeras”

Estas leyes fueros enunciadas por Isaac Asimos con el objetivo de intentar que la finalidad inicial para la que se originó la robótica no fuera modificada y eso ocasionara problemas a la humanidad. Sin embargo…

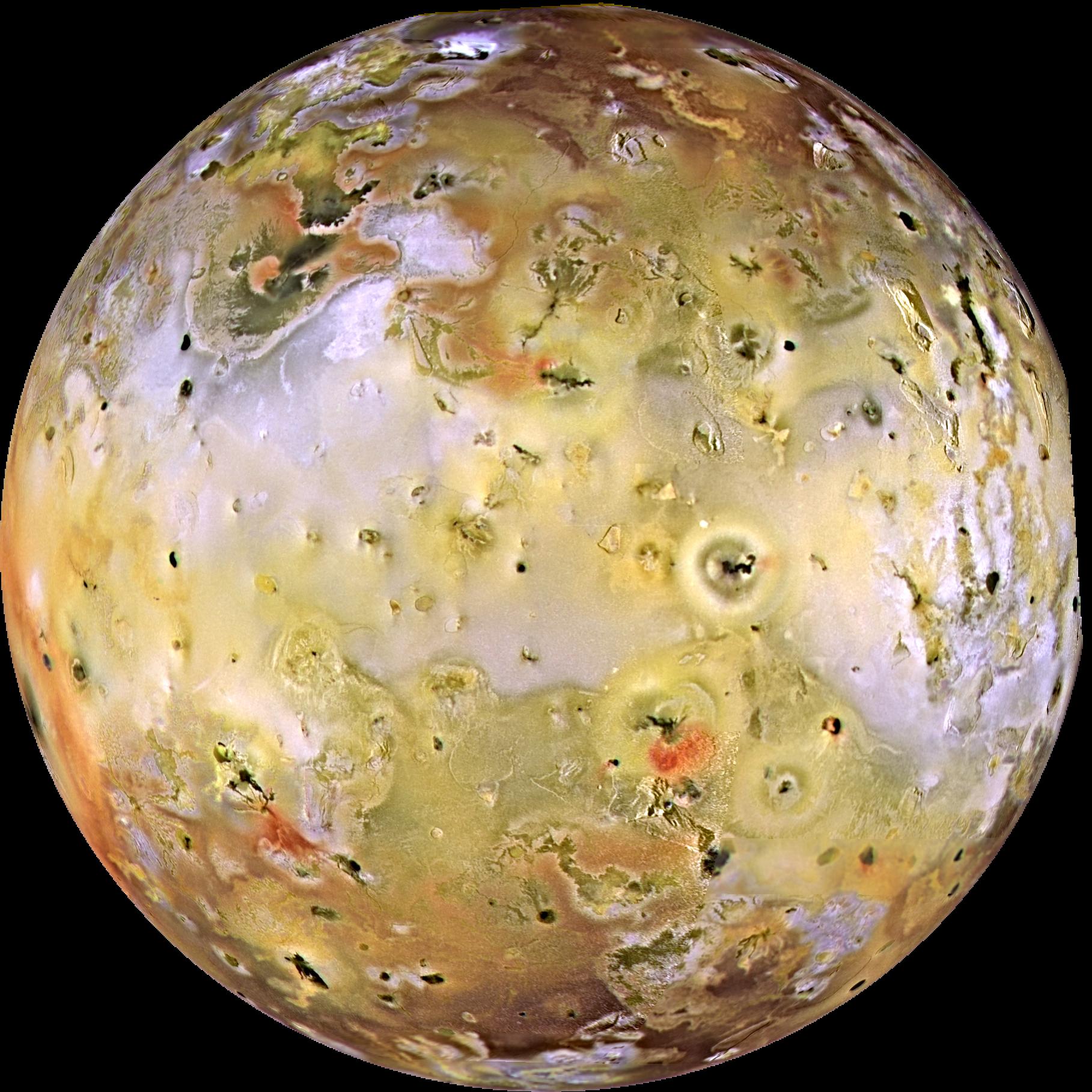

Nuestros sueños e conquistar el Espacio exterior y de poblar otros mundos, hace más de 50 años que se puso en marcha. Desde entonces, hemos enviado aparatos más o menos sofisticados lejos de la Tierra y, nos han enviado información de Mercurio, de Venus y Marte, de Saturno y Júpiter, de las Lunas que, como Io, Titán, Encelado, Ganímedes Europa y otras pueden tener algún interés científico para el futuro de la Humanidad. Estos “artilugios” guiados desde nuestro planeta, nos envían imágenes de lugares que nunca pudimos imaginar.

Así, las máquinas pueden hacer lo que nosotros no podemos y “ellas” no duermen ni comen y, cuando no puedan obtener energía del propio Sol, lo harán de pilas atómicas que durarán cientos de años. La radiación del espacio no les afecta y la falta de gravedad tampoco. Ellos tendrán todos los atributos que nos faltan para conquistar el espscio, y… ¿De nosotros que será?

La pregunta queda en el aire, toda vez que, en este momento, nadie la sabe contestar.

emilio silvera

Dic

14

Surgieron pensamientos… ¡Que nunca dejaran de asombrarnos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Los Pensamientos ~

Clasificado en Los Pensamientos ~

Comments (1)

Comments (1)

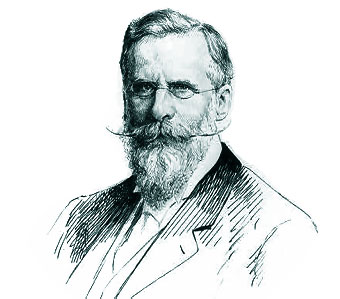

Ludwig Boltzmann será el protagonista de hoy

Hay ecuaciones que son aparentemente insignificantes por su reducido número de exponentes que, sin embargo, ¡dicen tántas cosas…! En la mente de todos están las sencillas ecuaciones de Einstein y de Planck sobre la energía-masa y la radiación de cuerpo negro. Esa es la belleza de la que hablan los físicos cuando se refieren a “ecuaciones bellas”.

Maxwell

Las ecuaciones de Maxwell…, “y se hizo la luz”

La identidad de Euler: Algunos dijeron de su ecuación: “la expresión matemática más profunda jamás escrita”, “misteriosa y sublime”, “llena de belleza cósmica”, “una explosión cerebral”.

Newton y su segunda ley que, aunque no funcione cuando nos acercamos a velocidades relativistas, rompió la marcha hacia la Gravedad.

Pitágoras y “su” teorema, también debe estar presente como lo está su teorema en las construcciones de todo el mundo y… mucho más.

Schrödinger y su función de onda que tampoco se queda atrás (aunque como la ecuación de Newton, si hablamos de velocidades relativistas…)

Bueno, E = mc2, nos lleva a profundidades de la materia antes jamás vistas y nos permite sacar conclusiones como que, en un gramo de materia está encerrada toda la energía consumida por la Humanidad durante un minuto. ¡Masa y Energía son la misma cosa!

Einstein, con esa ecuación de arriba de la relatividad general, vino a cambiar el mundo y, a partir de entonces, nació la verdadera cosmología. ¡Nos habla de tántas cosas!

¿Qué decir de la maravillosa fórmula de la entropía de Boltzman?

S = k log W

Creo que hoy, hablaremos de ella. Boltzman con su trabajo e ingenio, le dio a la Humanidad la herramienta para que pudiera seguir avanzando en el difícil laberinto de la Cienca, fue, sin duda, uno de los físicos más ilustres del siglo XIX.

El trabajo científico desarrollado por Boltzmann en su época crítica de transición que puso el colofón a la física “clásica” –cuya culminación podríamos situar en Maxwell– y antecedió (en pocos años) a la “nueva” física, que podemos decir que comenzó con Max Planck y Einstein. Aunque ciertamente no de la importancia de los dos últimos, la labor científica de Boltzmann tiene una gran relevancia, tanto por sus aportaciones directas (creador junto con “su amigo” Maxwell y Gibbs de la mecánica estadística, aunque sea el formulismo de éste último el que finalmente haya prevalecido; esclarecedor del significado de la entropía, etc.) como por la considerable influencia que tuvo en ilustres físicos posteriores a los que sus trabajos dieron la inspiración, como es el caso de los dos mencionados, Planck y Einstein.

El principio, como suele pasar en todas las cosas, es siempre tosco y, con el tiempo, se van perfeccionando las cosas, la evolución va mejorando las formas

Boltzmann fue un defensor a ultranza del atomismo, polemizando sobre todo con Mach y Ostwald, antiatomistas partidarios de la energética y claros exponentes de la corriente idealista de la física alemana. Tuvo que abandonar su ambiciosa idea de explicar exactamente la irreversibilidad en términos estrictamente mecánicos; pero esta “derrota”, no ocultaré que dolorosa desde el punto de vista personal, le fue finalmente muy productiva, pues de alguna manera fue lo que le llevó al concepto probabilista de la entropía. Estas primeras ideas de Boltzmann fueron reivindicadas y extendidas, en el contexto de la teoría de los sistemas dinámicos inestables, sobre todo por la escuela de Prigogine, a partir de la década de 1970.

La personalidad de Boltzmann era bastante compleja. Su estado de ánimo podía pasar de un desbordante optimismo al más negro pesimismo en cuestión de unas pocas horas. Era muy inquieto; él decía – medio en serio, medio en broma – que eso se debía a haber nacido en las bulliciosas horas finales de los alegres bailes del Martes de Carnaval, previas a los “duelos y quebrantos” (entonces) del Miércoles de Ceniza.

Ludwig Boltzmann and co-workers in Graz, 1887. (standing, from the left) Nernst, Streintz, Arrhenius, Hiecke, (sitting, from the left) Aulinger, Ettingshausen, Boltzmann, Klemenčič, Hausmanninger

Su lamentable final, su suicidio en Duino (Trieste) el 5 de septiembre de 1906, muy probablemente no fue ajeno a esa retorcida personalidad, aunque su precaria salud física fue seguramente determinante a la hora de dar el trágico paso hacia el lado oscuro.

Uno de los problemas conceptuales más importantes de la física es cómo hacer compatible la evolución irreversible de los sistemas macroscópicos (el segundo principio de la termodinámica) con la mecánica reversible (las ecuaciones de Hamilton o la ecuación de Schrödinger) de las partículas (átomos o moléculas) que las constituyen. Desde que Boltzmann dedujo su ecuación en 1872, este problema ha dado lugar a muy amplios debates, y el origen de la irreversibilidad es, aún hoy en día, controvertido.

En una de sus primeras publicaciones, Boltzmann obtuvo en 1866 una expresión de la entropía, que había sido definida un año antes por Clausius, basado en conceptos mecánicos. Las limitaciones de este trabajo eran que su aplicación se restringía al estudio de los gases y que el sistema era periódico en el tiempo. Además, Boltzmann no pudo deducir de su definición de entropía la irreversibilidad del segundo principio de la termodinámica de Clausius. En 1868, basándose en las ideas probabilísticas de Maxwell, obtuvo la distribución de equilibrio de un gas de partículas puntuales bajo la acción de una fuerza que deriva de un potencial (distribución de Maxwell-Boltzmann).

En el Universo, considerado como sistema cerrado, la entropía crece y…

En 1.872 publicó la denominada ecuación de Boltzmann para cuya deducción se basó, aparentemente, en ideas mecánicas. Esta ecuación contiene, sin embargo, una hipótesis no mecánica (estadística) o hipótesis del caos molecular, que Boltzmann no apreció como tal, y cuya mayor consecuencia es que, cualquiera que sea la distribución inicial de velocidad de un gas homogéneo diluido fuera del equilibrio, ésta evoluciona irreversiblemente hacia la distribución de velocidad de Maxwell. A raíz de las críticas de Loschmidt (paradoja de la reversibilidad) y Zermelo (paradoja de la recurrencia), Boltzmann acabó reconociendo el carácter estadístico de su hipótesis, y en 1877 propuso una relación entre la entropía S de un sistema de energía constante y el número de estados dinámicos W accesibles al sistema en su espacio de fases; esto es, la conocida ecuación S = kB ln W, donde kB es la constante de Boltzmann. En esta nota, se hace una breve descripción de la ecuación de Boltzmann y de la hipótesis del caos molecular.

El comportamiento de los gases siempre dio a los físicos en qué pensar

La ecuación de Boltzmann describe la evolución temporal de un gas diluido de N partículas puntuales de masa m contenidas en un volumen V que interaccionan a través de un potencial de par central repulsivo V(r) de corto alcance a. Como simplificación adicional, considérese que sobre las partículas no actúan campos externos. Si f1(r,v,t) indica la densidad de partículas que en el tiempo t tienen un vector de posición r y velocidad v, que está normalizada en forma:

∫dr ∫dvƒ1(r,v,t) = N

Su evolución temporal es la suma de dos contribuciones. En ausencia de interacción, las partículas que en el tiempo t tienen vector de posición r y velocidad v se encuentran, después de un intervalo de tiempo Δt, en r + v Δt y tiene la misma velocidad. Como

f1(r + vΔt,v,t + Δt) = f1(r,v,t)

en el límite Δt → 0 (2) se escribe:

∂1 f1(r,v,t) = – v∂r f1(r,v,t)

Que es una ecuación invariante bajo el cambio t → – t y v → – v. La evolución es, por tanto, mecánica.

Se cumplieron más de cien años desde la muerte de Boltzmann y su trabajo sigue siendo recordado. No pienso que Boltzmann creyera en la existencia real de los átomos, pero sí en su utilidad e incluso en su necesidad para comprender las leyes macroscópicas y la evolución irreversible de los fenómenos macroscópicos desde una base más fundamental que el nivel fenomenológico. Pero había quien (con autoridad) no creía ni en la existencia ni en su utilidad. Este debate no era ajeno a las tendencias ideológicas, religiosas y usos sociales de aquella época porque, en general, la ciencia es parte de la cultura y depende del momento histórico que viven los científicos, al fin y al cabo, seres humanos como los demás, influenciables por su entorno en una gran medida.

Por el siglo XIX, e incluso antes, ya se hablaba de “átomos”* y una rudimentaria teoría cinética de los gases gozaba de aceptación y utilidad científica (recordemos los trabajos de Benoulli, Dalton, Laplace, Poisson, Cauchy, Clausius, Krönig… y Maxwell). Pero fue Boltzmann quien definitivamente profundizó en la cuestión, para el estudio del equilibrio y, sobre todo, intentando explicar mecánicamente (mecano-estadísticamente) la evolución termodinámica irreversible y la descripción de los procesos de transporte ligados a ella. Y, nuevamente (por su enorme importancia) no podemos dejar de mencionar la muy singular labor que hicieron Gibbs, Einstein, Planck, Fermi y otros. Sin la motivación ideológica de Boltzmann, Gibbs elaboró una bellísima, útil y hoy dominante formulación (cuerpo de doctrina) de la termodinámica y física estadística.

Lorentz

Fue Lorentz quien primero utilizó la ecuación de Boltzmann y lo hizo para describir la corriente eléctrica en sólidos dando un paso significativo por encima del pionero Drude. Lorentz introdujo un modelo opuesto al browniano donde partículas ligeras como viento (electrones) se mueven chocando entre sí y con árboles gordos (tales como iones en una red cristalina); un modelo del que se han hecho estudios de interés tanto físico como matemático. Enskog (inspirándose en Hilbert) y Chapman (inspirándose en Maxwell) enseñaron cómo integrar la ecuación de Boltzmann, abriendo vías a otras diversas aplicaciones (hidrodinámica, propagación del sonido, difusión másica, calor, fricción viscosa, termoelectricidad, etc.). Recordemos que Boltzmann encontró como solución de equilibrio de su ecuación una distribución de velocidades antes descubierta por Maxwell (hoy, como reseñé anteriormente, de Maxwell-Boltzmann), por lo que concluyó que así daba base microscópica mecánica (teorema H mecano-estadístico) al segundo principio de la termodinámica (estrictamente, evolución de un sistema aislado hacia su “desorden” máximo).

El físico austríaco Ludwig Boltzmann sentó las bases estadísticas de la entropía, su trabajo fue tan importante que el gran físico Max Planck sugirió que su versión de la fórmula de Boltzmann fuera grabada en la lápida de Boltzmann de Viena.

Está claro que ningún físico que se precie de serlo puede visitar Viena sin visitar el parque Zentralfriedhof para ver la tumba de Boltzmann. Yo sí me pasé por allí. Me senté junto a la tumba; el lugar estaba desierto, y cerrando los ojos traté de conectar con la conciencia del genio. La sensación, extraña y agradable, seguramente fue creada por mi imaginación, pero creo que charlé con él en el interior de mi mente – la fuerza más potente del universo– y aquellos sentimientos, aquel momento, compensaron el esfuerzo del viaje.

En la tumba, sobre una gran lápida de mármol de color blanco con los nombres Ludwig Boltzmann y de los familiares enterrados con él, sobre el busto de Boltzmann, se puede leer la inscripción, a modo de epitafio:

En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la física conocida como mecánica estadística. Esta sencilla ecuación es la mayor aportación de Boltzmann y una de las ecuaciones más importantes de la física. El significado de las tres letras que aparecen (aparte la notación del logaritmo) es el siguiente:

- S es la entropía de un sistema.

- W es el número de microestados posibles de sus partículas elementales.

- k es una constante de proporcionalidad que hoy recibe el nombre de Constante de Boltzmann, de valor 1’3805 × 10-23 J/K (si el logaritmo se toma en la base natural).

En definitiva, la ecuación describe la estrecha relación entre la entropía (S) y las miles de formas de partículas que en un sistema se pueden arreglar (k log W). La última parte es difícil. K es la constante de Boltzmann y W es el número de elementos microscópicos de un sistema (por ejemplo, el impulso y la posición de los átomos individuales de gas) en un sistema macroscópico en un estado de equilibrio (por ejemplo, el gas de sellado en una botella). Parece que la naturaleza ama el caos cuando empuja a los sistemas hacia el desequilibrio y Boltzmann le llamó entropía a este fenómeno.

Cuando profundizamos un poco en lo que el cerebro humano ha sido capaz de generar, los pensamientpos que ha llegado a generar bien sea en forma de ecuaciones matemáticas o expresados con palabras, no podemos dejar de sorprendernos y maravillarnos al ver que, ¡todo el universo parece estar dentro de nuestras mentes! ¿Qué secretos se encierran allí? ¿Cómo nos lleva a estos pensamientos tan profundos?

Como todas las ecuaciones sencilla de gran trascendencia en la física (como la famosa E = mc2), hay un antes y un después de su formulación: sus consecuencias son de un calado tan profundo que cambiaron la forma de entender el mundo, y en particular, de hacer física a partir de ellas. De hecho, la sutileza de la ecuación es tal que hoy, cien años después de la muerte de su creador, se siguen investigando sus nada triviales consecuencias. Creo que lo mismo ocurrirá con α = 2πe2/ħc que, en tan reducido espacio y con tan pocos símbolos, encierra los misterios del electromagnetismo (el electrón), de la constante de Planck (la mecánica cuántica), y de la luz (la relatividad de Einstein), todo ello enterrado profundamente en las entrañas de un número: 137.

Bueno, a pesar de todo lo anterior, Schrödinger nos decía:

“La actitud científica ha de ser reconstruida, la ciencia ha de rehacerse de nuevo”

¡Lo grande y lo pequeño! ¡Son tantos los secretos de la Naturaleza!

Siempre hemos tenido consciencia de que en física, había que buscar nuevos paradigmas, nuevos caminos que nos llevaran más lejos. Es bien conocida la anécdota de que a finales del siglo XIX un destacado físico de la época William Thomson (1824-1907) conocido como Lord Kelvin, se atrevió a decir que solo dos pequeñas “nubecillas” arrojaban sombras sobre el majestuoso panorama de conocimiento que había construido la física clásica desde Galileo y Newton hasta ese momento: el resultado del experimento de Michelson-Morley, el cual había fallado en detectar la existencia del supuesto éter luminífero; y la radiación del cuerpo negro, i.e la incapacidad de la teoría electromagnética clásica de predecir la distribución de la energía radiante emitida a diferentes frecuencias emitidas por un radiador idealizado llamado cuerpo negro. Lo que Lord Kelvin no puedo predecir es que al tratar de disipar esas dos “nubecillas”, la física se vería irremediablemente arrastrada a una nueva física: la física moderna fundada sobre dos revoluciones en ciernes: la revolución relativista y la revolución cuántica con dos científicos como protagonistas: Planck y Albert Einstein. Sin embargo, ha pasado un siglo y seguimos con esas dos únicas guías para continuar el camino y, resultan insuficientes para llegar a la meta que… ¡Está tan lejos!

emilio silvera

Dic

14

El Universo, las galaxias…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

Todas las galaxias contienen los mismos componentes de estrellas, cúmulos, nebulosas, miríadas de estrellas e infinidad de mundos (unos con vida (por lógica) y otros no, según estén situados en relación a la estrella que orbiten, fenómenos más extraños como agujeros negros y otros que, seguramente nos quedan por descubrir.

Nuestro universo es igual en todas partes. Las leyes que rigen en todo el universo son las mismas. La materia que puebla el universo, gases estelares, polvo cósmico, galaxias con cientos de miles de millones de estrellas y sistemas planetarios, también son iguales en cualquier confín del universo. Todo el universo, por lo tanto, está plagado de sistemas solares, nebulosas, agujeros negros y de estrellas de neutrones. En realidad, con el transcurso del tiempo, el número de estos objetos masivos estelares irá en aumento, ya que cada vez que explota una estrella supermasiva, nace un nuevo agujero negro o una estrella de neutrones, transformándose así en un objeto distinto del que fue en su origen. De gas y polvo pasó a ser estrella y después se transformó en un agujero negro o en una estrella de neutrones. Pero hoy, hablaremos de…

GALAXÍAS

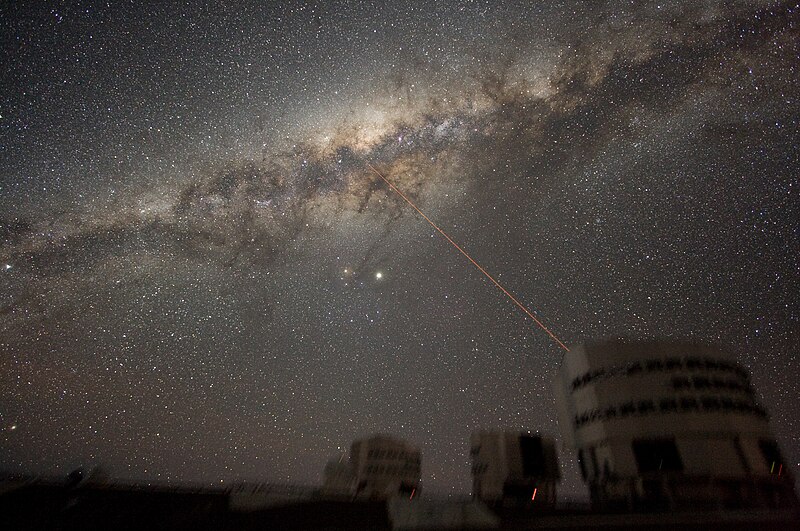

La Galaxia espiral que acoge a nuestro Sol y a las estrellas visibles a simple vista durante la noche; es escrita con G mayúscula para distinguirla de las demás galaxias. Su disco es visible a simple vista como una débil banda alrededor del cielo, la Vía Láctea; de ahí que a la propia Galaxia se la denomine con frecuencia Vía Láctea.

Nuestra galaxia tiene tres componentes principales. Uno es el disco de rotación de unas 6×1010 masas solares consistentes en estrellas relativamente jóvenes (población II), cúmulos cubiertos de gas y polvo, estando estrellas jóvenes y material interestelar concentrados en brazos espirales. El disco es muy delgado, de unos 1.000 a. l., comparado con su diámetro de más de 100.000 años luz. Aún continúa una activa formación de estrellas en el disco, particularmente en las nubes moleculares gigantes.

El segundo componente principal es un halo débil y aproximadamente esférico con quizás el 15 – 30% de la masa del disco. El halo está constituido por estrellas viejas (población II), estando concentradas parte de ellas en cúmulos globulares, además de pequeñas cantidades de gas caliente, y se une a un notable bulbo central de estrellas, también de la población II.

El tercer componente principal es un halo no detectado de materia oscura con una masa total de al menos 4×1011 masas solares. En total, hay probablemente alrededor de 2×1011 estrellas en la Galaxia (unos 200 mil millones), la mayoría con masas menores que el Sol.

La edad de la Galaxia es incierta, si bien el disco tiene al menos 10.000 millones de años, mientras que los cúmulos globulares y la mayoría de las estrellas del halo se cree que tienen entre 12.000 y 14.000 millones de años.

Centro Galáctico de la Vía Láctea visto desde el Observatorio Paranal

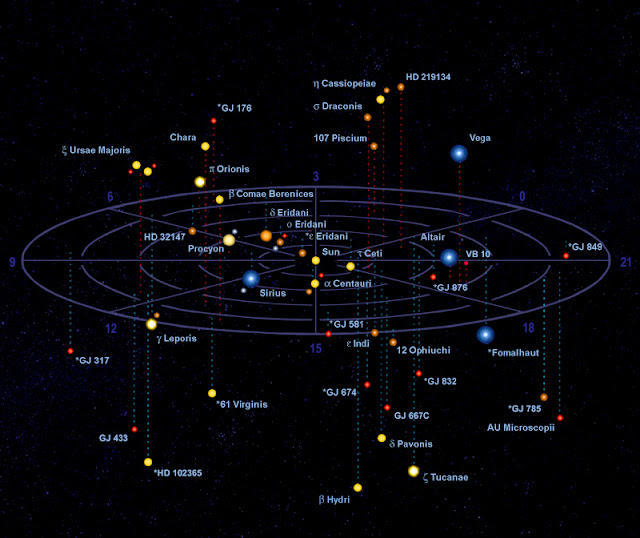

El Sol se encuentra a una distancia que está entre 26.000 y 30.000 años luz del centro galáctico, en el Brazo de Orión.

El mismo centro galáctico se halla en la constelación Sagitarius.

La Vía Láctea es una espiral, aunque las observaciones de su estructura y los intentos de medir las dimensiones de los brazos espirales se ven impedidos por el polvo oscurecedor del disco y por las dificultades en estimar distancias. Es posible que la Galaxia sea una espiral barrada dado que existen algunas evidencias de una estructura en forma de barra en las regiones centrales y el bulbo.

Todas las galaxias son sistemas de estrellas, a menudo con gas y polvo interestelar, unidas por la gravedad. Las galaxias son las principales estructuras visibles del universo. Varían desde las enanas con menos de un millón de estrellas a las supergigantes con más de un billón de estrellas, y un diámetro desde unos pocos cientos a mas de 600.000 años luz. Las galaxias pueden encontrarse aisladas o en pequeños grupos, como el nuestro conocido Grupo Local, o en grandes cúmulos como el Cúmulo de Virgo.

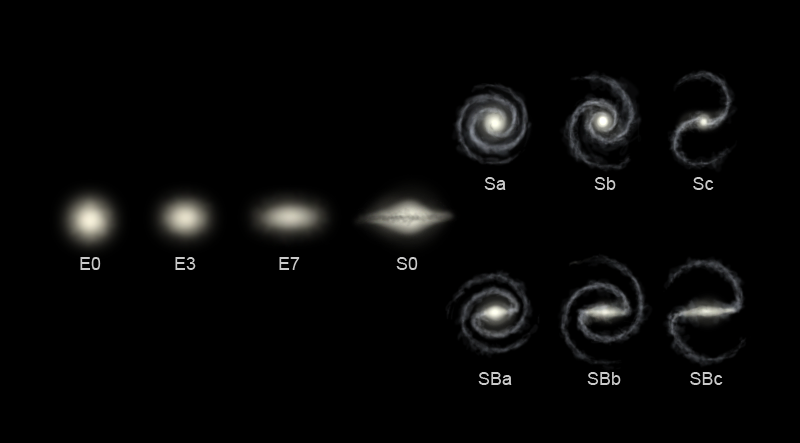

Este esquema, que sólo descansa en la apariencia visual, no toma en cuenta otros aspectos, tales como la tasa de formación de estrellas o la actividad del núcleo galáctico.

Las galaxias se clasifican habitualmente de acuerdo a su apariencia (clasificación de Hubble). A parecen en dos formas principales: espirales (con brazos) y elípticas (sin brazos). Las elípticas tienen una distribución de estrellas suave y concentrada en el centro, con muy poco gas o polvo interestelar. De las espirales hay varios tipos, espirales ordinarias y barradas. Ambos tipos tienen material interestelar además de estrellas. Las galaxias lenticulares presentan un disco claro, aunque sin brazos espirales visibles.

Las galaxias irregulares tienen una estructura bastante amorfa e irregular, en ocasiones con evidencias de brazos espirales o barras. Unas pocas galaxias no se parecen a ninguno de estos tipos principales, y pueden ser clasificadas como peculiares. Muchas de éstas son probablemente los resultados de choques entre galaxias que han quedado fusionadas quedando configuradas después de manera irregular.

El tipo de galaxia más numeroso pueden ser las galaxias esferoidales, pequeñas, y relativamente débiles, que tienen forma aproximadamente elíptica.

Se cree que las galaxias se han formado por la acumulación gravitacional de gas, algún tiempo después de la época de la recombinación. Las nubes de gas podrían haber comenzado a formar estrellas, quizás como resultado de las colisiones mutuas. El tipo de galaxia generado podría depender del ritmo al que el gas era transformado en estrellas, formándose las elípticas cuando el gas se convertía rápidamente en estrellas, y las espirales si la transformación de estrellas era lo suficientemente lenta como para permitir crecer de forma significativa un disco de gas.

Las galaxias evolucionan al convertir progresivamente su gas remanente en estrellas, si bien no existe probablemente una evolución entre las diferentes tipos de la clasificación del conocido sistema de Hubble. No obstante, algunas galaxias elípticas pudieron haberse creado por la colisión y posterior fusión de dos galaxias espirales.

El número relativo de galaxias de los diferentes tipos está íntimamente relacionado con su brillo intrínseco y con el tipo de grupo o cúmulo al que pertenecen. En los cúmulos densos, con cientos o miles de galaxias, una alta proporción de las galaxias brillantes son elípticas y lenticulares, con unas pocas espirales (5 – 10%).

No obstante, la proporción de espirales pudo haber sido mayor en el pasado, habiendo perdido las espirales su gas de manera que ahora se asemejan a los lenticulares, o habiendo sufrido fusiones con otras galaxias espirales e irregulares para convertirse en elípticas. Ya sabéis que nada desaparece, sólo se transforma.

Fuera de los cúmulos, la mayoría de las galaxias pertenecen a grupos que contienen entre unos pocos y varias docenas de miembros, siendo raras las galaxias aisladas. Las espirales constituyen el 80% de las galaxias brillantes en estos entornos de baja densidad, con una correspondiente baja proporción de elípticas y lenticulares.

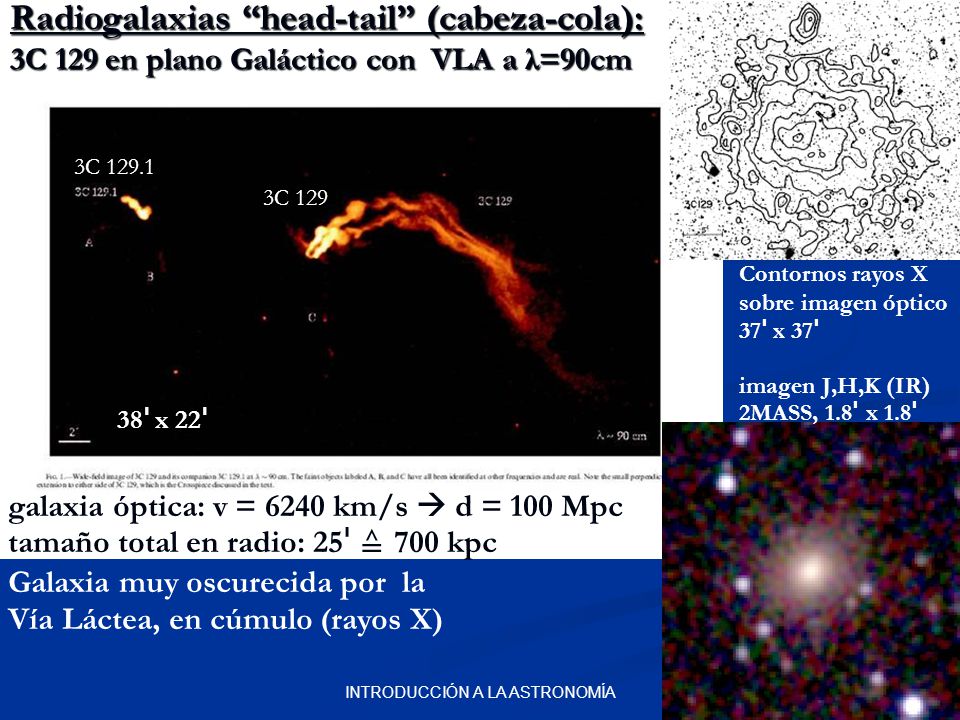

Algunas galaxias presentan una actividad inusual en su centro, como las galaxias Seyfert o las galaxias N. Una radiogalaxia es un emisor inusualmente intenso de energía en forma de ondas de radio.

Hablando de galaxias podríamos movernos en un amplio abanico de posibilidades de las que relaciono algunas a continuación:

Galaxia head-tail: Una elíptica en la que una intensa emisión de radio en el núcleo está acompañada por una cola irregular de radioemisión difusa que se extiende cientos de miles de años luz. Es una radación sincrotrón de electrones energéticos.

Galaxia anular: Inusual galaxia con anillo luminoso bien definido alrededor de un núcleo brillante. El anillo puede parecer suave y regular, o anudado y deformado, y puede contener gas y polvo además de estrellas. Un ejemplo es la galaxia de la Rueda de Carro.

Galaxia binaria: Par de galaxias en órbita de una en torno a la otra. Las auténticas galaxias binarias son muy difíciles de distinguir de las superposiciones casuales de dos galaxias en la línea de visión. La investigación estadística de los pares binarios que sigue las órbitas es valiosa en el estudio de la estimación de las masas totales de algunos tipos particulares de galaxias.

Galaxia compacta: Tipo de galaxia que sólo puede ser distinguida de una estrella mediante placas de exploración del cielo tomadas con cámaras Schmidt. Tienen diámetros aparentes de 2 – 5” y una región de alto brillo superficial que puede ser definido y debido a núcleos brillantes de las regiones activas que están formando nuevas estrellas. Unos 2.000 objetos de este tipo fueron catalogados por F. Zwicky.

Galaxia con bajo brillo superficial (LSB): Tipo de galaxia cuya densidad de estrellas es tan baja que es difícil detectarla frente al fondo del cielo. Se desconoce la proporción de galaxias con bajo brillo superficial en relación a las galaxias normales, pudiendo representar una parte significativa del universo. Muchas de estas débiles galaxias son enanas, situadas particularmente en cúmulos de galaxias; algunas son tan masivas como las grandes espirales, por ejemplo, Malin-1.

Galaxia con envoltura: Galaxia espiral rodeada por débiles arcos o capas de estrellas, situados a ángulos rectos con respecto a su eje mayor. Pueden observarse entre una y veinte capas casi concéntricas, aunque incompletas. Se disponen de manera que capas sucesivas puedan aparecer normalmente en lados opuestos de la galaxia. Alrededor del 10% de las elípticas brillantes presentan envolturas, la mayoría de ellas en regiones de baja intensidad o densidad de galaxias. No se conoce ninguna espiral con una estructura de capas de ese tipo. Podrían ser el resultado de una elíptica gigante que se come una compañera.

Galaxia de anillo polar: Raro tipo de galaxia, casi siempre una galaxia lenticular, que tiene un anillo luminoso de estrellas, gas y polvo orbitando sobre los polos de su disco. Por tanto, los ejes de rotación del anillo y del disco forman casi un ángulo recto. Dicho sistema puede ser el resultado de una colisión, una captura de por maneras, o la unión de una galaxia rica en gas con la galaxia lenticular.

Galaxia de disco: Tipo de galaxia cuya estructura principal es un delgado disco de estrellas con órbitas aproximadamente circulares alrededor de su centro, y cuya emisión de luz típicamente disminuye exponencialmente con el radio. El término se aplica a todos los tipos de galaxias que no sean elípticas, esferoidales enanas o algunas galaxias peculiares. El disco de las galaxias lenticulares contiene muy poco material interestelar, mientras que los discos de las galaxias espirales e irregulares contienen cantidades considerables de gas y polvo además de estrellas.

Galaxia de tipo tardío: Galaxia espiral o irregular. El nombre proviene de la posición convencional de estas galaxias en el diagrama diapasón de los tipos de galaxias. Por razones similares, una galaxia espiral Sc o Sd pueden ser denominadas espiral del tipo tardío, en contraposición a una espiral Sa o Sb de tipo temprano.

Galaxia de tipo temprano: Galaxia elíptica o lenticular: una sin brazos espirales. El hombre proviene de la posición de las galaxias en el diagrama diapasón de las formas de las galaxias. Por razones similares, una galaxia Sa podría ser referida como una espiral de tipo temprano, en contraposición, en contraposición a una espiral Sc o Sd de tipo tardío.

Se podría continuar explicando lo que es una galaxia elíptica, enana, compacta azul, esferoidal enana, espiral (como la Vía Láctea), espiral enésima, espiral barrada, interaccionante, irregular, lenticular, peculiar, starburst, primordiales… etc, sin embargo, creo que ya se ha dejado constancia aquí de los datos necesarios para el que lector tenga una idea de lo que es una galaxia. Así que decido finalizar el apartado de galaxias, reflejando un cuadro del Grupo Local de galaxias en el que está situada la nuestra.

|

GRUPO LOCAL DE GALAXIAS |

|

|

Galaxia |

Distancia en Kpc |

| Andrómeda (M 31) |

725 |

| Vía Láctea |

– 0 |

| Del Triángulo (M 33) |

795 |

| Gran Nube de Magallanes |

49 |

| IC 10 |

1250 |

| M32 (NGC 221) |

725 |

| NGC 6822 (de Barnard) |

540 |

| M 120 (NGC 205) |

725 |

| Pequeña Nube de Magallanes |

58 |

| NGC 185 |

620 |

| NGC 147 |

660 |

| IC 1613 |

765 |

| Wolf-Lundmark-Melotte |

940 |

| Enana de Fornax |

131 |

| Enana de Sagitarius |

25 |

| And I |

725 |

| And II |

725 |

| Leo I |

273 |

| Enana de Acuarius (DDO 210) |

800 |

| Sagitarius (Sag DiG) |

1.100 |

| Enana de Sculptor |

78 |

| Enana de Antlia |

1.150 |

| And III |

725 |

| IGS 3 |

760 |

| Enana de Sextans |

79 |

| Enana de Phoenix |

390 |

| Enana de Tucana |

870 |

| Leo II |

215 |

| Enana de Ursa Minor |

63 |

| Enana de Carina |

87 |

| Enana de Draco |

76 |

En el cuadro anterior del Grupo local de galaxias al que pertenece la Vía Láctea, en la que está nuestro Sistema Solar, se consigna las distancias a que se encuentran estas galaxias de la nuestra y se hace en kilopársec.

En el espacio exterior, el cosmos, lo que conocemos por universo, las distancias son tan enormes que se tienen que medir con unidades espaciales como el año luz (distancia que recorre la luz en un año a razón de 299.792.458 metros por segundo). Otra unidad ya mayor es el pársec (pc), unidad básica de distancia estelar correspondiente a una paralaje trigonométrica de un segundo de arco (1”). En otras palabras, es la distancia a la que una Unidad Astronómica (UA = 150.000.000 Km) subtiende un ángulo de un segundo de arco. Un pársec es igual a 3’2616 años luz, o 206.265 Unidades Astronómicas, o 30’857×1012 Km. Para las distancias a escalas galácticas o intergalácticas se emplea una unidad de medida superior al pársec, el kilopársec (Kpc) y el megapársec (Mpc).

Es posible calcular las distancias de las estrellas de varios modos diferentes. El más antiguo data sólo de hace aproximadamente un siglo: requería la aplicación de la trigonometría y dependía de cuidadosas observaciones del sol, la tierra y la estrella cuya distancia se medía. Una vez que los astrónomos aprendieron a tomar fotografías de las estrellas, se hizo posible otro procedimiento para medir dichas distancias. Y, mediante el espectroscopio, se cuenta con un tercer método.

Para tener una idea aproximada de estas distancias, pongamos el ejemplo de nuestra galaxia hermana, Andrómeda, situada (según el cuadro anterior a 725 kilopársec de nosotros) en el Grupo local a 2’3 millones de años luz de la Vía Láctea.

| 1 segundo luz |

299.792’458 Km |

| 1 minuto luz |

18.000.000 Km |

| 1 hora luz |

1.080.000.000 Km |

| 1 día luz. |

25.920.000.000 Km |

| 1 año luz |

9.460.800.000.000 Km |

| 2’3 millones de años luz |

21.759.840.000.000.000.000 Km |

Ahí tenemos la imposibilidad física de viajar a otros mundos, y no digamos a otras galaxias. Las velocidades que pueden alcanzar en la actualidad nuestros ingenios espaciales no llegan ni a 50.000 Km/h. ¿Cuánto tardarían en recorrer los 21.759.840.000.000.000.000 Km que nos separa de Andrómeda?

Incluso el desplazarnos hasta la estrella más cercana, Alfa Centauri, resulta una tarea impensable si tenemos en cuenta que la distancia que nos separa es de 4’3 años luz, y un año luz = 9.460.800.000.000 Km.

Hasta que no se busque la manera de esquivar la barrera de la velocidad de la luz, los viajes a otros mundos están algo complicados para nosotros.

emilio silvera

Dic

14

Poco a poco, hemos podido saber lo que la materia es

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Química ~

Clasificado en Química ~

Comments (0)

Comments (0)

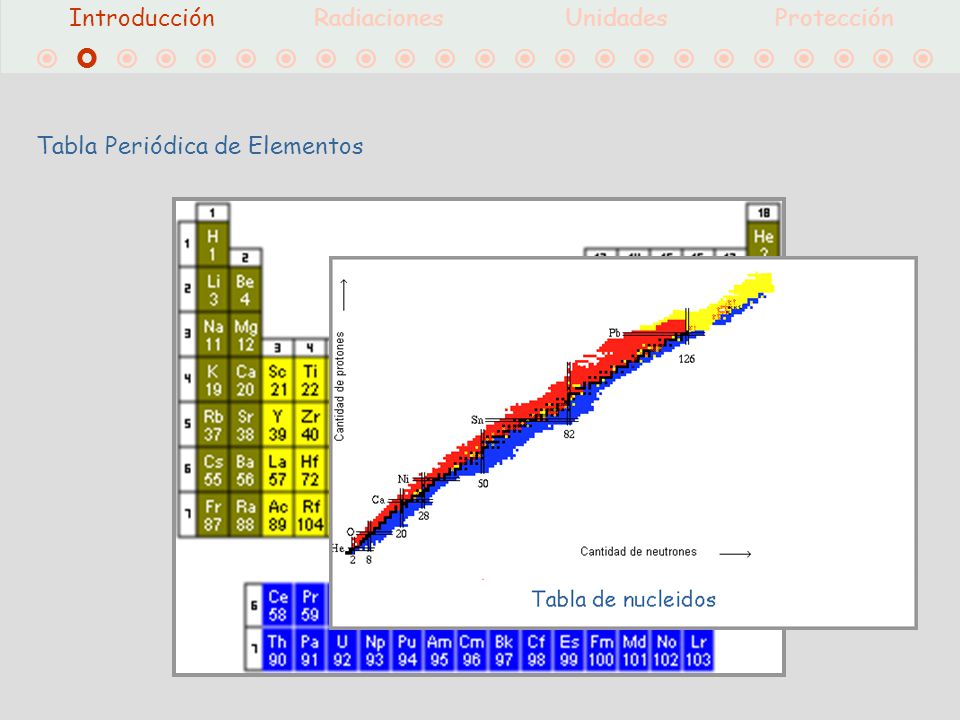

AVANCES DE LA HUMANIDAD

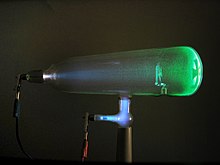

Ha pasado más de un siglo desde que se hicieron una serie de observaciones desconcertantes, que condujeron al esclarecimiento de algunas cuestiones antes oscuras. El inglés William Crookes (el del “tubo Crookes”) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que esta procedía exclusivamente de dicha impureza, que él denomino “uranio X”.

Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se dejan reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera: por su propia radiactividad, el uranio se convertía en el uranio X, más activo aún.

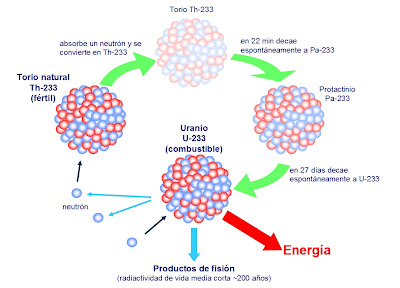

Por entonces, Rutherford, a su vez, separó del torio un “torio X” muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que, durante la emisión de sus partículas, los átomos radiactivos de transformaban en otras variedades de átomos radiactivos.

Varios químicos, que investigaron tales transformaciones, lograron obtener un surtido muy variado de nuevas sustancias, a los que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y Actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie de originó del uranio disociado; otra, del torio, y la tercera, del actinio (si bien más tarde se encontró un predecesor del actinio, llamado “protactinio”).

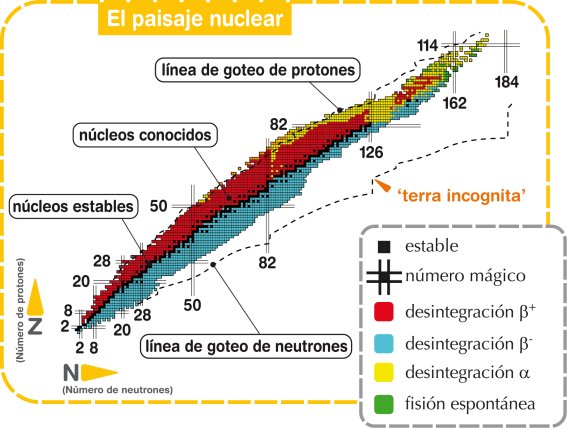

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, estable: PLOMO.

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados, entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907, los químicos americanos Herbert Newby Mc Coy y W.H. Ross descubrieron que el “radiotorio” (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el “radio D”, el mismo que el del plomo; tanto, que era llamado a veces “radio plomo”. De todo lo cual se infirió que tales sustancias eran en realidad variedades del mismo elemento: el radiotorio, una forma de torio; el radioplomo, un miembro de una familia de plomos, y así sucesivamente.

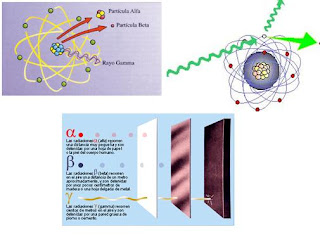

Frederick Soddy

En 1.913, Soddy esclareció esa idea y le dio más amplitud. Demostró que cuándo un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el “radiotorio” descendería en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas “uranio X” y “uranio Y”, es decir, que los tres serían variedades del elemento 90. Así mismo, el “radio D”, el “radio B” el “torio B” y el “actinio B” compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el nombre de “isótopos” (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nóbel de Química.

El modelo protón-electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al número atómico, y, por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de elementos.

¡Maravilloso!

Lo de maravilloso de antes, es que me entusiasmo con los movimientos que lleva a cabo la naturaleza para conseguir sus fines.

¿Cómo se explica que cuando el torio se descompone en “radiotorio” después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta y, más tarde, una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos, contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque, en cierto modo, esto no afecta al resultado.)

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía y el número atómico 90, es decir, el mismo antes.

Así, pues, el “radiotorio”, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de átomo están sujetas al número de sus electrones planetarios, el torio y el “radiotorio” tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228, respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o “número másico”. Así, el torio corriente se denomina torio 232, y el “radiotorio”, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones:

Así, el torio corriente se denomina torio 232, y el “radiotorio”, torio 228. Los isótopos radiactivos del plomo

Plomo 210 – Plomo 214-Plomo 212 y Plomo 211

“radio D” – “radio B” – “Torio B” y “Actinio B”

Se descubrió que la noción de isótopos podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206; la del torio, en el plomo 208, y la del actinio, en el plomo 207. Cada uno de estos era un isótopo estable y “corriente” del plomo, pero los tres plomos diferían por su peso atómico.

Francis William Aston en 1922

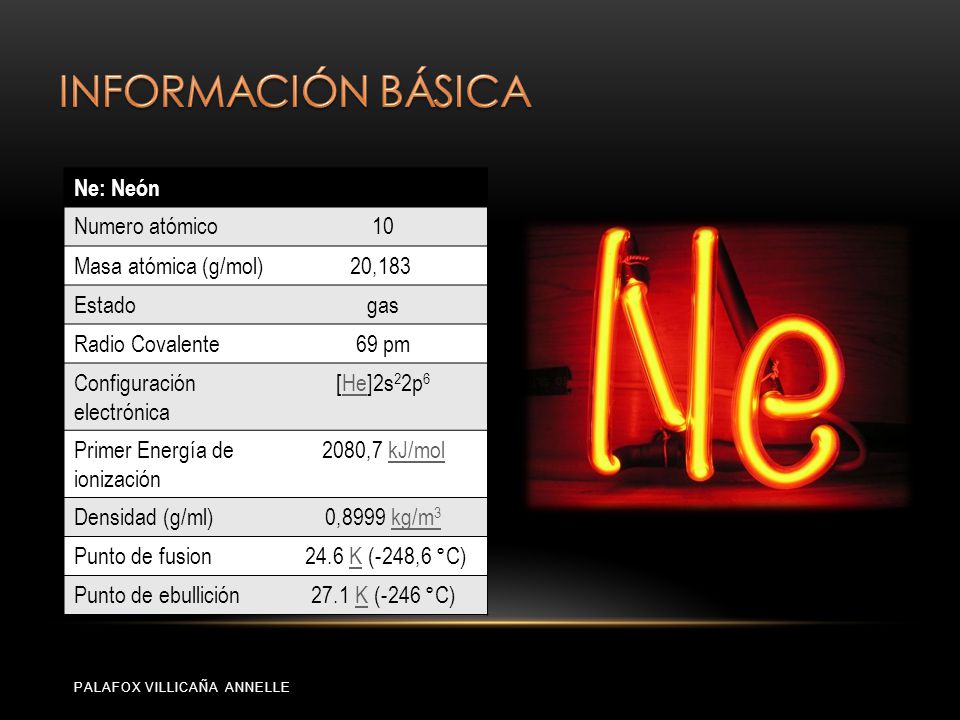

Mediante un dispositivo inventado por cierto ayudante de J.J.Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo número de masa era 20, y otra, 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo por cada diez. (Mas tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.)

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban, el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas -el peso atómico- era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la “proporción” de cuatro a uno. En 1.922 se le otorgó el premio Nóbel de Química.

En el discurso pronunciado al recibir el premio, Aston predijo la posibilidad de aprovechar la energía almacenada en el núcleo atómico, vislumbrando ya las futuras y nefastas bombas y centrales nucleares. Allá por 1.935, el físico canadiense Arthur Jeffrey Dempster empleó el instrumento de Aston para avanzar sensiblemente en esa dirección. Demostró que, si bien 993 de cada 1.000 átomos de uranio ordinario, uranio 238 (no válido para combustible nuclear), los siete restantes eran uranio 235 (buen combustible nuclear). Y, muy pronto se haría evidente el profundo significado de tal descubrimiento.

Así, después de estar siguiendo huellas falsas durante un siglo, se reivindicó definitivamente la teoría de Prout. Los elementes estaban constituidos por bloques estructurales uniformes; si no átomos de hidrógeno, sí, por lo menos, unidades con masa de hidrógeno.

¿Qué no será capaz de inventar el hombre para descubrir los misterios de la naturaleza?

Gracias a investigaciones como las que antes he relatado, podemos hoy disfrutar y tener una vida cómoda y de inusitados medios a nuestro alcance para poder saber sobre el por qué de las cosas.

emilio silvera

Dic

14

Cosas del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (2)

Comments (2)

Ciencia

La supernova más brillante de la Historia en realidad fue un cataclismo cósmico

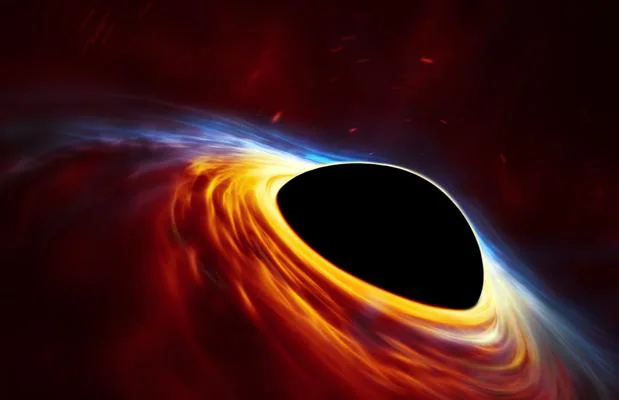

Han propuesto que este evento ocurrió cuando un agujero negro supermasivo girando a enormes velocidades y situado a 4.000 millones de años luz de la Tierra engulló a una estrella similar al Sol

Este fenómeno fue 570.000 millones de veces más brillante que el Sol y veinte veces más que toda la Vía Láctea

Representación artística de un agujero negro supermasivo de 100 millones de masas solares desgarrando a una estrella

“En junio de 2015 los astrónomos detectaron una nueva luz en el cielo que les dejó completamente atónitos. Parecía tratarse de una explosión de supernova tan excepcionalmente brillante, que doblaba en intensidad a la que para entonces tenía el récord. Durante su punto álgido, aquella colosal explosión, que fue designada como «ASASSN-15lh», fue 20 veces más brillante que toda la Vía Láctea.

Los astrónomos enfocaron los telescopios hacia el lugar de origen de aquel evento. Y más de un después de su detección, han publicado un estudio en la revista Nature Astronomy en el que han propuesto una explicación para aquella emisión de luz. Sorprendentemente, han descartado que se tratara de una supernova. Su hipótesis es que un agujero negro supermasivo situado a 3.800 millones de años luz de la Tierra y que gira en aquel lugar a una increíble velocidad, engulló una estrella comparable al Sol. Este asesinato estelar emitió una inmensa cantidad de energía al espacio.”

Reportaje completo en: http://www.abc.es/ciencia/abci-supernova-mas-brillante-historia-realidad-cataclismo-cosmico-201612122146_noticia.html

Fuente: Noticia de Prensa

Totales: 75.512.406

Totales: 75.512.406 Conectados: 73

Conectados: 73