Dic

12

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

La formulación de newton es bien conocida, en la segunda imagen que se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

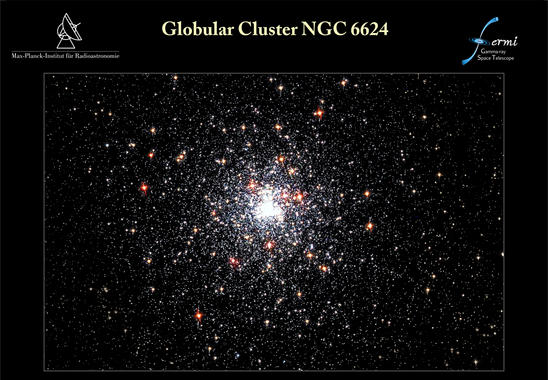

Desde que se puso en órbita el telescopio espacial de rayos gamma Fermi, el 11 de junio de 2008, ha detectado poblaciones enteras de objetos nunca antes vistos. El último hallazgo de Fermi afecta al púlsar J1823-3021A, avistado en 1994 con el radiotelescopio Lovell, en Inglaterra. Un equipo internacional de expertos se ha dado cuenta de que esta estrella pulsante emite rayos gamma y gracias a Fermi ha podido caracterizar sus inusuales propiedades. Los resultados de su investigación se publican en el último número de Science. Lo cierto es que han descubierto el púlsar de milisegundos más joven y con la fuerza magnética más potente

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

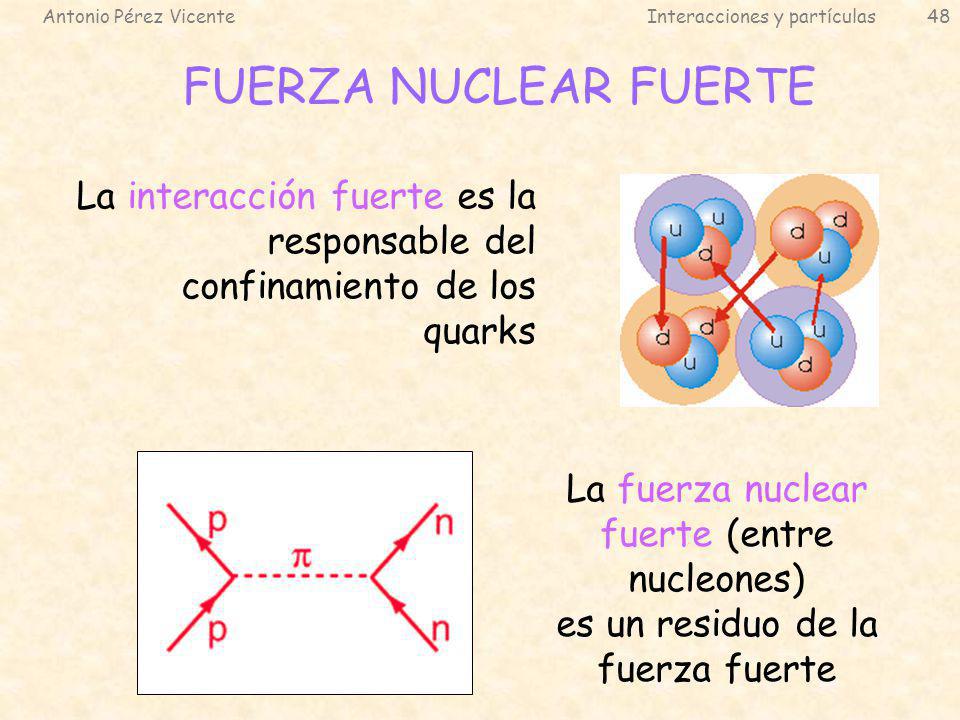

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

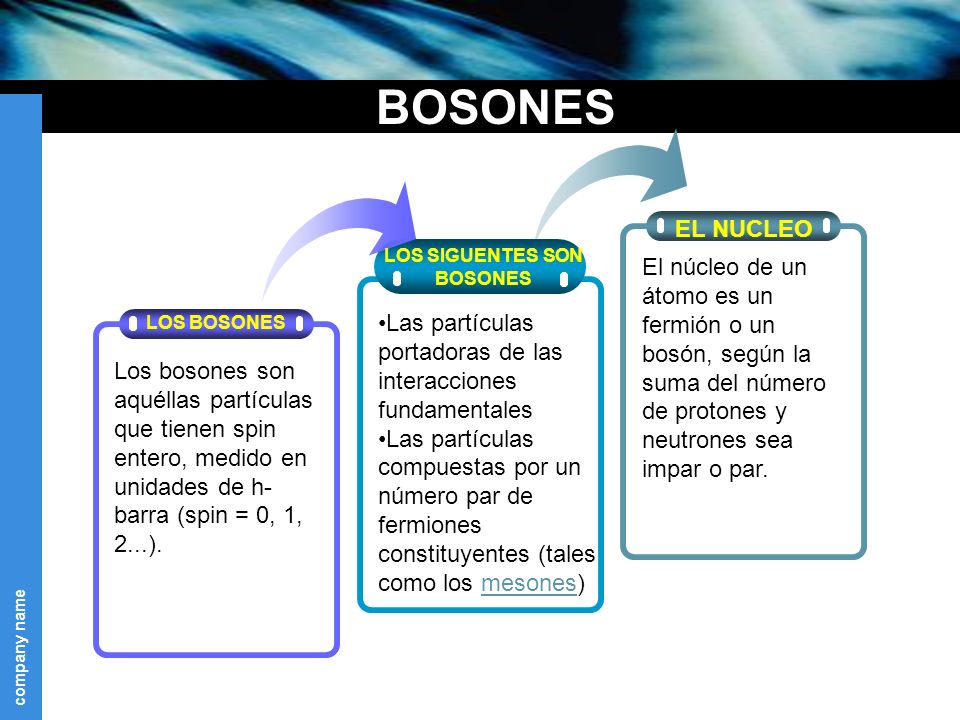

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

Uno de los protones se transmuta en un neutrón por medio de la interacción débil, transformando un quark “up”, en “down”. Este proceso consume energía (el neutrón tiene ligeramente más masa que..

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento ha sido una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Existen esperanzas de que el LHC empleando energías más elevadas, nos pueda dar alguna sorpresa y encuentre objetos largamente perseguidos.

emilio silvera

Dic

11

¿Quiénes somos? ¡Quién puede saber eso!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El origen ~

Clasificado en El origen ~

Comments (0)

Comments (0)

“Ni las ciencias, ni ningún otro sistema es capaz de determinar qué es la conciencia. Desde la psicología, la filosofía o incluso la biología, recibimos diversas teorías, sin embargo, no existe una respuesta científica a esta pregunta y siguiendo el mismo razonamiento, en este punto bien podemos señalar algunas preguntas más, tales como”

¿Quiénes somos? ¿De dónde venimos? ¿Hacia dónde vamos?

Esas preguntas que han estado en la mente de los seres humanos desde que en ellos estuvo presente el pensamiento en aquellas primeras Civilizaciones antiguas que todos tenemos en mente y que dejaron su huella que, de una u otra manera, nos hablan de una evolución mental que, a veces, profundizaba en terrenos situados más allá de lo material. Cuando no se sabía entender los hechos ni se encontraban las respuestas, con frecuencia, se acudió a la mitología y a divinidades que eran portadoras de mágicos poderes y, de esa manera hemos estado caminando hasta llegar a los orígenes de la Ciencia que, comenzó una nueva etapa y en lugar de adjudicar lo inexplicable a los dioses, se empezó a investigar y observar empleando la lógica para acercarnos a lo desconocido, a los misterioso secretos de la Naturaleza y, ¡nuestro origen! puede ser calificado del mayor secreto que el Universo esconde.

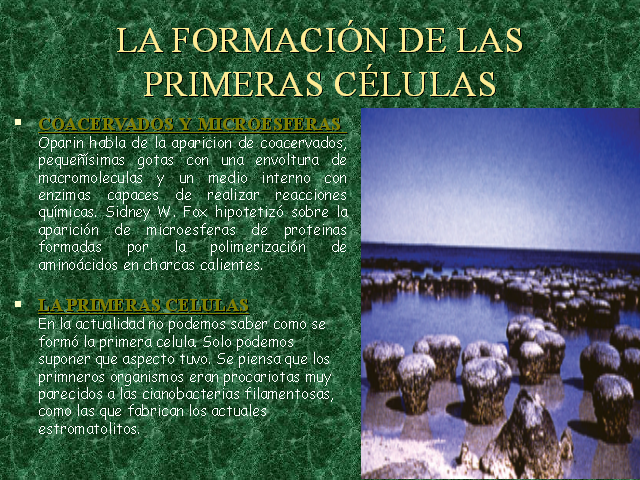

“Estromatolitos del precámbrico en la Formación Siyeh, Parque Nacional de los Glaciares, Estados Unidos. En 2002, William Schopf de la UCLA publicó un artículo en la revista Nature defendiendo que estas formaciones geológicas de hace 3.500 millones de años son fósiles debidos a cianobacterias y, por tanto, serían las señales de las formas de vida más antiguas conocidas.”

Ciertamente, cuando hablamos del origen de la vida, aún hoy en la segunda década del siglo XXI, las opiniones son diversas y siempre nos encontramos con dos grupos que la sitúan en diferentes lugares. En un pequeño libro, no por ello menos importante, del ruso A. Oparín, publicado en Moscú, en su lengua original en 1894 y denominado El Orgien de la vida, nos habla de ese espinoso y trascendente tema sin necesidad de permanecer anclados en ideas ya desfasadas, entre los irreversibles adelantos científicos y el creacionismo bíblico que está fuera de lugar en nuestra época del big bang o primitiva explosión cósmica, la expansión del universo, el conocimiento del átomo y los primeros vuelos espaciales, donde ya no hay lugar para “mitos” y son los hechos los que deben prevalecer.

Está claro que contestar a las preguntas: ¿Que es la vida? ¿Cómo llegó hasta aquí? ¿Está sólo en el planeta Tierra? ¿Cómo pudo hacer acto de presencia, eso que llamamos conciencia? No resulta nada fácil y, hasta tal punto es así que hasta el momento, nadie la supo contestar de una manera convincente y se dan respuestas que, más o menos originales y agudas, no dejan de ser conjeturas. La que más me gusta es que la vida, es la materia evolucionada hasta su más alto nivel, dado que, de alguna manera, nosotros mismos estamos hechos de los mismos materiales que todo lo que nos rodea.

Existen dos puntos de vista que nos llevan al origen de la vida: El enfoque materialista y el otro idealista y espiritual, el primero es el que adopta A. Operín y el otro es el que muestra la doctrina del P. Teilhard de Chardin, ni uno ni otro tiene porqué abandonar los grandes descubrimientos científicos y tecnológicos. Sin embargo y a medida que ha ido tanscurriendo el tiempo, ambas posturas se han alejado la una de la otra como consecuencia de que la Ciencia, nos ha ido mostrando los posibles caminos que la vida tomó para hacerse presente y, desde luego, nada tiene que ver con el espíritu que la vida hiciera su aparición en este mundo nuestro y, seguramente, en otros muchos mundos de la Galaxia y de otros mundos dispersos por el Cosmos.

POSIBLE ORIGEN CÓSMICO DE LA VIDA Según esta hipotesis, la vida se ha generado en el espacio exterior y viaja de unos planetasa otros y de unos sistemas solares a otros. El filosofo griego Anaxágoras fué el primero que propuso un origen cósmico para la vida. Esta Hipótesis de la panspermia postula que la vida es llevada al azar de planeta en planeta. Su máximo defensor fué Svante Arrhenius, que afirmaba que la vida provenía del espacio exterior.

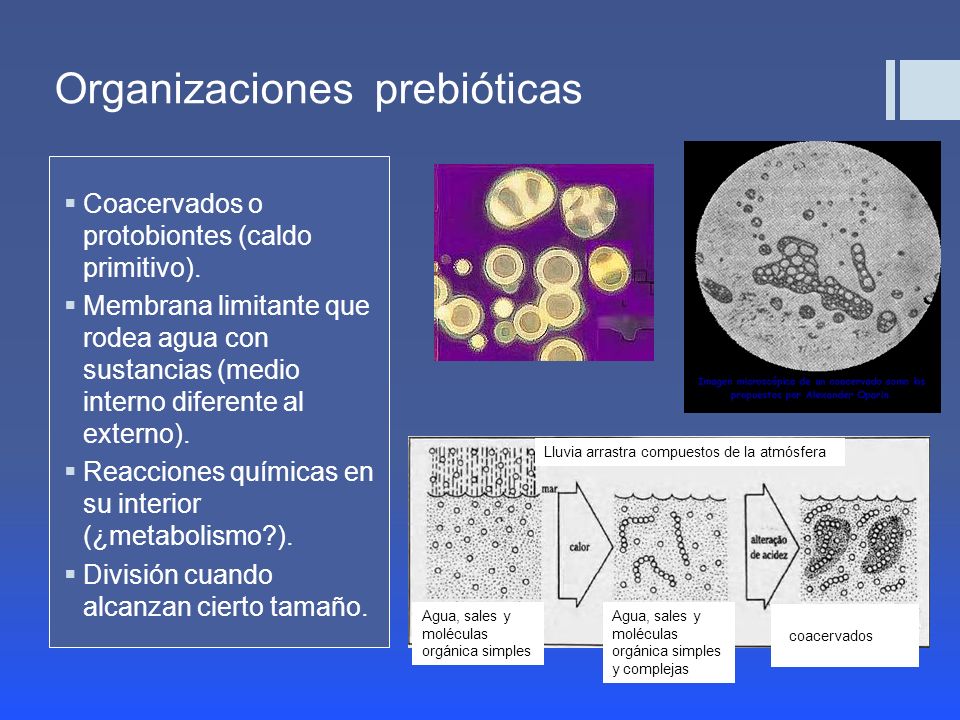

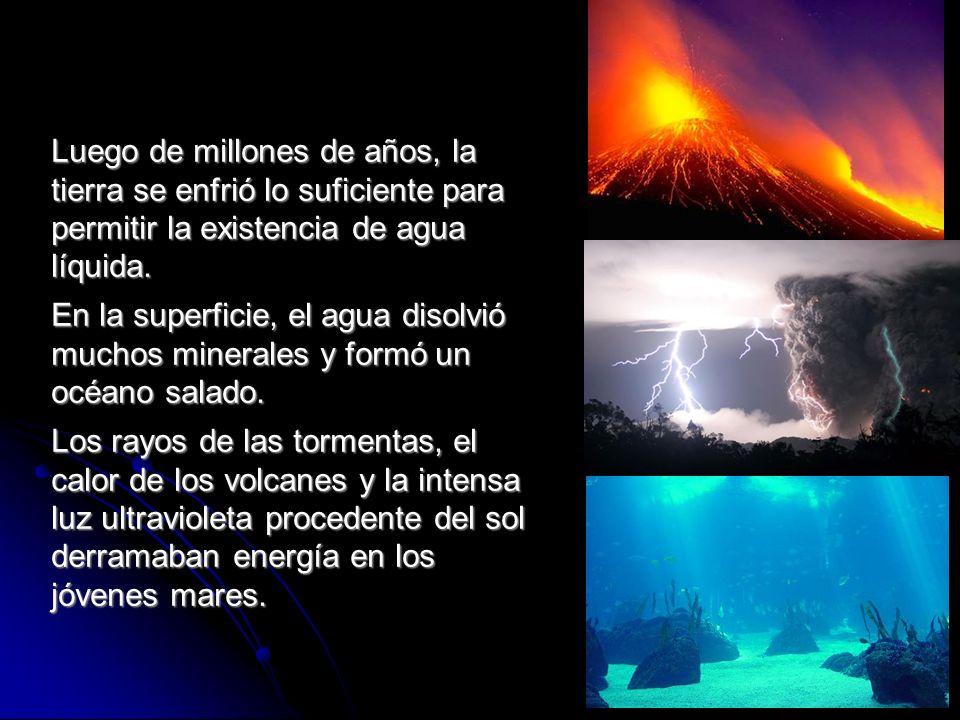

LA APARICIÓN DE LA VIDA EN LA TIERRA PRIMITIVA Las hipótesis mas acertadas afirman que la vida se generó hace millones de años, de forma espontánea gracias a las particulares condiciones que hubo en la primera etapa de la Historia de la Tierra. El bioquímico ruso Aleksandr Oparin y el genetista británico John B.S. Haldane propusieron que la vida se originó en la tierra como resultado a la asociación de moléculas inorgánicas sencillas. En 1953, Stanley Miller simuló las condiciones de la supuesta atmósfera primitiva y la sometió a descargas eléctricas. Obtuvo compuestos orgánicos (aminoácidos). Este resultado sirvió para apoyar la hipótesis de Oparin y Haldane.

Independientemente de todas las grandes hipótesis que los grandes pensadores y especialitas han elaborado, lo cierto es que, al día de hoy, todavía, nadie sabe decirnos queé es la vida y cómo puedo llegar hasta aquí.

Desde el punto de vista de la Biología, que es el más usado, hace alusión a aquello que distingue a los reinos animal, vegetal, hongos, protistas, arqueas y bacterias del resto de manifestaciones de la Naturaleza. Implica las capacidades de nacer, crecer, reproducirse y morir, y, a lo largo de sucesivas generaciones, evolucionar.

Sin embargo, no parece que todo eso, sea exclusivo de lo que conocemos por vida, ya que, de alguna manera, si nos fijamos en una estrella desde que “nace” hasta que muere”, viene a enseñarnos que sigue el mismo camino que los seres vivos y ella también, nace, muere y se reproduce… a su manera. ¡Es todo tan complicado!

Claro que, cuando hablamos de la vida hay que ser respetuosos con las ideas que cada cual pueda tener al respecto. Será la fe de cada uno quien pueda llevarle a una u otra conclusión, o incluso, dejar esta en el aire con un gran signo de interrogación dentro de un agnósticismo (no ateísmo) latente que está aconsejado por los hechos más relevantes que la Ciencia nos pone delante de los ojos cuando de la vida se trata y lo que de ella, hemos podido llegar a saber.

A estas alturas, ni la propia Iglesia Católica excluye la teoría del mutacionismo moderado o evolucionismo dirigido que no escluye aquella idea de un primer y Supremo Hacedor. Ya en 1950, Pio XII en la Encíclica Humani Generis, recomendaba prudencia y no apasionamiento por una u otra tesis para aquellos que se dedicaban al estudio de tan delicados problemas y que, si no aparecía todo claro, se esperaba siempre a que nuevos descubrimientos iluminaran el remoto pasado de la vida y del universo.

Si nos centramos en el ser humano, los restos fósiles más antiguos confirman que durante la Era Cuaternaria, la Humanidad poseía fuertes restos morfológicos de las especies animales de las que pudo derivar. También algunos fósiles de simios que se acercaban, cada vez más, en su morfología, a las formas humanas.

Sin embargo aún el más antiguo de los hombres fósiles, hubo de poseer una capacidad cerebral mucho mayor que la de los simios actuales. Por tal motivo incluso los más acérrimos partidarios de la evolución rechazaron pronto que el hombre pudierta descender directamente del mono y se alinearon en dos escuelas fundamentales:

– La de los que afirmaban que el mono y el ser humano tenían un origen común en otro ser que no era ni Homo ni Pan, cuyo rastro se ha perdido por completo, o, al menos, nunca se ha podido encontrar. Las especies de los simios contemporáneos nuestros, “serían una degeneración”, mejor que una evolución de este antecesor común del ser humano y el mono.

– Y la de los que opinaban que el ser humano y el simio se parecen en lo somático, pero manifestaban que su antecesor no era el mismo, sino que el ser humano descendía de un ser distinto del antepasado del mono.

“Una de las especies humanas extintas mejor conocidas es el Homo erectus. Los restos de esta especie que proceden de China, se les dio el popular nombre de “hombre de Pekín”. A pesar que ninguna persona instruida negaría la existencia de estos seres en el pasado, los creacionistas les restan importancia diciendo mentiras sobre ellos.

La publicación creacionista “¿Abuelito?” de CHICK PUBLICATIONS dice respecto al hombre de Pekín: “Supuestamente databa de hace 500.000 años. Pero toda la evidencia ha desaparecido”

Pero, ¿Desapareció realmente toda la evidencia del “hombre de Pekín”? ¿No hay más restos del Homo erectus en Asía?

Los restos del “Hombre de Pekín” se hallaron entre 1921 y 1937, en el periodo entreguerras en un yacimiento a 40 kilómetros al sudoeste de Pekín llamado Zhoukoudian. El hallazgo consistía de una colección de cerca de 40 individuos en Zhoukoudian, entre ellos 5 calvarias (cráneos sin el esqueleto de la cara), numerosos dientes y restos del esqueleto postcraneal.

En 1941, desapareció la colección de fósiles, en plena Segunda Guerra Mundial, mientras era enviada desde Pekín a Estados Unidos.

Sin embargo, la evidencia no desapareció del todo, pues el científico Franz Weidenreich realizó, previó a la desaparición, un estudio con fotografías, radiografías y réplicas de los fósiles. En excavaciones recientes se han encontrado nuevos restos que han encajado con las réplicas hechas por Weidenreich lo cual dice mucho de la honestidad del trabajo de este científico.

Los creacionistas desprecian las dataciones dadas para estos restos fósiles diciendo: “Supuestamente databa de hace 500.000 años”, para confundir al lector. Sin embargo, el yacimiento del Zhoukoudian no ha desaparecido. Sigue allí y los trabajos de estratigrafía que se han realizado muestran que los restos de la cueva abarca un período de 600.000 años, y los restos que quedaron enterrados en los sedimentos de Zhoukoudian tienen una edad entre 550.000 y 300.000 años.

Es cierto que los fósiles originales de la cueva de Zhoukoudian se perdieron en confusos hechos, pero algo que los creacionistas no mencionan es que existen otros yacimientos de Homo erectus en China e Indonesia.”

Tampoco se ha llegado a ninguna conclusión satisfactoria con el hecho que plantea si la aparición dle Ser humano tuvo lugar de una sola vez, derivando de una primitivoa pareja por multiplicación, toda la Humanidad (versión textual del Génesis) o si fueron más de una pareja procedentes de diversos lugares de la Tierra, ésta última tesis se está imponiendo últimamente con mucha fuerza.

El acuerdo sobre cuál o cuáles fueron la cuna o “cunas” de la Humanidad. Se habla con fuerza del hemisferio austral pero ?dónde? Si el lugar o lugares, época y formas de nacimiento de la primera raza. o razas, humanas continúa siendo -¡y mucho más el de la vida!- y será con toda probabilidad, siempre, un gran misterio para la Ciencia y, cuando llegamos a este callejón sin salida, de alguna manera, sentimos frustración por intuir que nunca, podremos llegar a saber quiénes somos.

Lo cierto es que tenemos una idea bastante aproximada de cómo pudo surgir la vida aquí en la Tierra pero, tampoco sabemos, a ciencia cierta, si su origen está en la propia Tierra, o, por el contrario, llegó desde fuera de ella. Lo que si sabemos con una claridad meridiana es que, los materiales necesarios para que la vida pudiera surgir, allá donde surgiera por vez primera, se transmutaron en las estrellas que, a partir del elemento más sencillo, el Hidrógeno, fusionó el Carbono, Oxígino, Nitrógeno y todos los demás de los que estamos hechos los seres vivos que pueblan la Tierra y -al menos para mí- otros muchos planetas del Universo.

En alguna ocasión hemos comentando aquí sobre el origen de la vida en nuestro planeta, la evolución, nuestros orígenes y algunos dones que nos adornan como el del habla y, sin olvidar el crecimiento de nuestro cerebro que ha posibilitado que “naciera” ¡la mente! Sin embargo, no nos hemos parado a pensar en algunos aspectos de la historia que nos llevarían a comprender cabalmente y que esa “historia de la vida” adquiera algún sentido, que la podamos comprender en todo su esplendor. Uno de esos aspectos, quizás el principal, sea la diversidad metabólica de los microorganismos procariotas, un aspecto clave para explorar la historia de “la vida primigenia”.

Convendría que profundizáramos más (y, asombremos) con las numerosas formas de metabolismos que utilizan los procariotas para vivir y que averigüemos donde encajan estos minúsculos organismos del árbol de la via antes de que podamos seguir escuchando las historias que paleontólogos nos puedan contar de sus andanzas a la búsqueda de fósiles que nos hablen de aquella vida en el pasado.

En la actualidad se acepta que los procariotas fueron los precursores de los organismos eucariotas. Sin embargo hay grandes diferencias entre esos dos grupos celulares. Una de esas diferencias reside en la organización génica y en los mecanismos de sintetizar el ARN mensajero. Algún trabajo biológico afirma que los eucariotas podrían proceder de cianobacterias termófilas ya que su organización génica recuerda rudimentariamente a la de los eucariotas.

Los organismos procariotas (bacterias y arqueas) y eucariotas (protistas, hongos, animales y plantas) comparten una bioquímica común, sin embargo difieren en un elevados número de procesos y de estructuras. A pesar de eso se considera a los procariotas como los precursores de la célula eucariota. A lo largo de los años se han ido recogiendo datos experimentales que avalan esta teoría.

Sabemos que la vida en sí m ismo empezó, quizás hace unos tres mil quinientos millones de años (así lo dicen fósiles encontrados en rocas de esa edad), cuando los flujos de energía, las moléculas y la información se combinaron para formar la primera célula viva. Desconocemos en qué consistió aquella primera fuente de energía, pero hace unos quinientos millones de años las células habían desarrollado ya una maquinaria que podía recoger la luz de la estrella más cercana a nosotros, el Sol, la fuente última de toda energía que existe en la Tierra. La luz se utilizaba para descomponer el agua (H2O), produciendo Oxígeno, que era emitido a la atmósfera, y liberando también protones y electrones que, al combinarse con el dióxido de carbono del aire, se utilizaban para formar las complejas moléculas de la vida. Este sencillo pero poderoso proceso de fotosíntesis hacia posible que la vida surgiera y se propagara rápidamente.

No siempre tuvimos una atmósfera benigna

La primera contaminación global y los primeros desastres ecológicos tuvieron lugar hace dos mil millones de años, cuando el Oxígeno, ese residuo tóxico de la fotosíntesis, comenzó a concentrarse en la atmósfera terrestre. El Oxígeno, la sustancia fundamental de la vida animal, es una molécula relativamente inestable y tóxica. De hecho, en en sí misma un tipo de radical libre y puede arrebatar electrones a otras moléculas, descomponiéndolas para formar otros radicales libres aún más tóxicos. Es la razón por la que la mantequilla y otros alimentos se vuelven rancios, el hierro se oxida y algunos anumales mueren en una atmósfera de oxígeno puro.

De la relación del Oxigeno y nosotros podríamos hablar muy extensamente pero, nos salimos del tema que os quería comentar y que, a estas alturas está acabando. Por cierto, es incluso posible que el Oxígeno de nuestra atmósfera fuera un veneno para hipotéticos seres extraterrestres invasores y nos librara de ellos por el simple hecho de que éste, no podría nunca ser su mundo.

Mirando el árbol filogenético de la Vida, nos damos cuenta de su diversidad y complejidad

Es cierto que, con mucha frecuencia, aparecen aquí trabajos que versan sobre la vida, ese misterio que nos lleva a querer buscar sus orígenes y a saber, cómo y para qué surgió aquí en el Planeta Tierra. Nos interesamos por cada uno de pasos evolutivos y nos llama la atención ese larguísimo ciclo que llevó la vida desde aquella célula replicante hasta los seres humanos. Pero, ¿hay algo más interesante que la Vida para poder estudiarlo? Seguramente con la Biología, Física, la Química y la Astrofísica, cada vez sabremos un poco más sobre tan inmenso misterio.

emilio silvera

Dic

10

La Inmensidad del Universo y, la “pequeñez” de los seres…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Química de la Vida ~

Clasificado en El Universo y la Química de la Vida ~

Comments (2)

Comments (2)

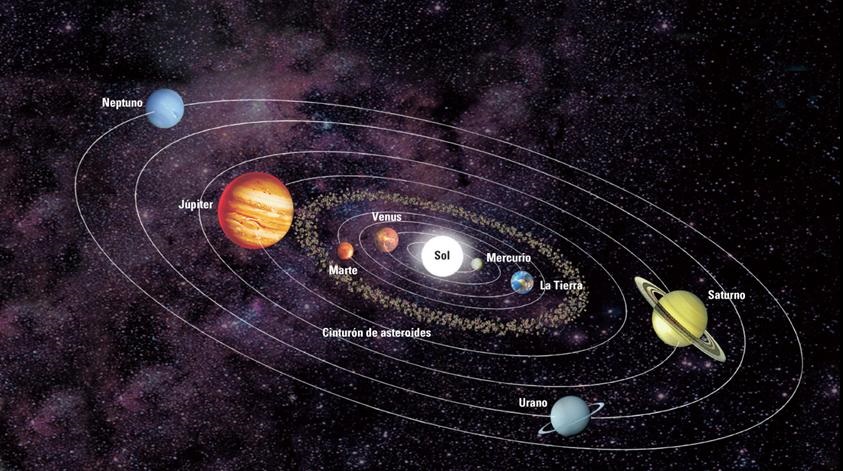

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. Según toos los datos que tenenos la edad de la Tierra data de hace unos 4.500 millones de años, y, los primeros signos de vida que han podido ser localizados fosilizados en rocas antiguas, tienen unos 3.800 millones de años, es decir, cuando la Tierra era muy joven ya apareció en ella la vida.

El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el Hidrógeno, Nitrógeno, Oxígeno, CARBONO, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

La imagen del cielo de Canarias nos puede servir para mostrar una atmósfera acogedora para la vida

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

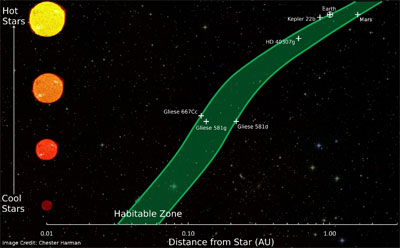

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Es cierto que la realidad puede ser mucho más imaginativa de lo que nosotros podamos imaginar. ¿Habrá mundos con formas de vida basadas en el Silicio? Aunque me cuesta creerlo, tambie´n me cuesta negarlo toda bvez que, la Naturaleza nos ha demostrado, muchas veces ya, que puede realizar cosas que anosotros, nos parecen imposibles y, sin embargo, ahí está el salto cuántico… Por ejemplo.

Los biólogos, por ejemplo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Para nosotros ha pasado mucho tiempo, y, sin embargo, para el Universo ha sido solo un instante

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN PUEDEN VERSE AFECTADOS DE MANERA ADVERSA. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, n se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

Las constantes de la naturaleza ¡son intocables!

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más. De todas las maneras, nsootros somos una parte esencial del universo: La que siente y observa, la que genera ideas y llega a ser consciente de que es, ¡la parte del universo que trata de comprender!

emilio silvera

Dic

10

“Mundo de Agua” Para el Origen de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (0)

Comments (0)

La vida echó raíces hace más de cuatro mil millones años en nuestra naciente Tierra, un lugar más húmedo y más duro que ahora, bañado por chisporroteantes rayos ultravioleta. Lo que comenzó como simples células finalmente se transformó en mohos del fango, ranas, elefantes, seres humanos y el resto de los reinos vivos de nuestro planeta. ¿Cómo empezó todo?

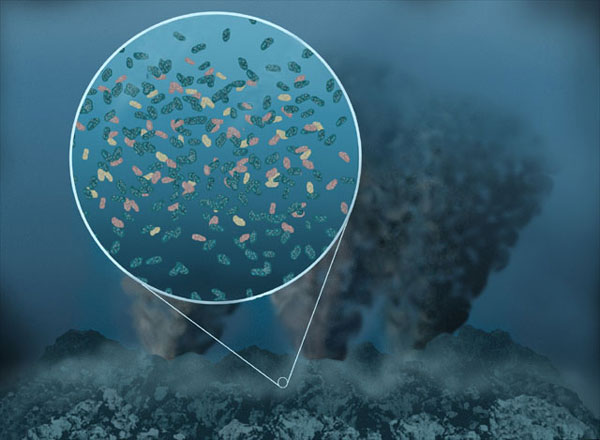

Un nuevo estudio de investigadores del Laboratorio de Propulsión a Chorro y el Instituto de Astrobiología de la NASA describe cómo la energía eléctrica producida de forma natural en el fondo del mar pudo haber dado origen a la vida en la Tierra hace 4.000 millones de años. Aunque los científicos ya habían propuesto esta hipótesis -llamada “aparición de vida hidrotermal alcalina submarina”- el nuevo estudio reúne décadas de trabajo de campo, de laboratorio e investigación teórica en un gran imagen unificada.

Según los resultados, sustentados en la teoría del “mundo de agua”, la vida pudo haber comenzado en el interior de fondos marinos cálidos, en un tiempo remoto cuando los océanos se extendían por todo el planeta. Esta idea de las fuentes hidrotermales como posibles lugares para el origen de la vida fue propuesta por primera vez en 1980 tras estudiarse en el fondo del mar cerca de Cabo San Lucas, México. Llamadas “fumarolas negras” son respiraderos de burbujas con agua hirviendo y fluidos ácidos calientes. Por el contrario, los respiraderos de ventilación en el nuevo estudio -la hipótesis del científico Michael Russell del JPL en 1989- son más suaves y se filtran con líquidos alcalinos. Uno de estos complejos de estos respiraderos alcalinos se encontró casualmente en el Océano Atlántico Norte en 2000, y fue apodado la Ciudad Perdida.

“La vida se aprovecha de los estados de desequilibrio en el planeta, como puede haber sido el caso hace miles de millones de años en los respiraderos hidrotermales alcalinos”, dijo Russell. “La vida es el proceso que resuelve estos desequilibrios”.

|

| Imagen del fondo del océano Atlántico que muestra una colección de torres calcáreas conocidas como la “Ciudad Perdida”. Se ha sugerido que las chimeneas alcalinas hidrotermales de este tipo son el lugar de nacimiento de los primeros organismos vivos de la Tierra antigua. Image Credit: NASA/JPL-Caltech |

La teoría del mundo de agua de Russell y su equipo dice que las cálidas fuentes hidrotermales alcalinas mantienen un estado de desequilibrio con respecto al antiguo entorno ácido de los alrededores en el océano, que podría haber proporcionado la llamada energía libre para impulsar el surgimiento de la vida. De hecho, los respiraderos de ventilación podrían haber creado dos desequilibrios químicos. El primero fue un gradiente de protones, donde los protones -los iones de hidrógeno- se concentraron más en el exterior de las chimeneas de ventilación. El gradiente de protones podría haber sido aprovechado para la energía -algo que nuestros propios cuerpos hacen todo el tiempo en las estructuras celulares llamadas mitocondrias.

El segundo desequilibrio podría haber implicado un gradiente eléctrico entre los fluidos hidrotermales y el océano. Hace miles de millones de años, cuando la Tierra era joven, sus océanos eran ricos en dióxido de carbono. Cuando el dióxido de carbono del océano y de los combustibles de la ventilación -hidrógeno y metano- surgió a través de la pared de los respiradedor, los electrones pudieron haber sido transferidos. Estas reacciones podrían haber producido los compuestos de carbono -u otros orgánicos más complejos- que contienen ingredientes esenciales de la vida tal como la conocemos. Al igual que los gradientes de protones, los procesos de transferencia de electrones se producen regularmente en las mitocondrias.

Como pasa con todas las formas de vida avanzadas, las enzimas son la clave para que las reacciones químicas ocurran. En nuestros antiguos océanos, los minerales pueden haber actuado como enzimas, interactuando con los productos químicos alrededor y conducir reacciones. En la teoría del mundo de agua, dos tipos diferentes de “motores” de minerales podrían haber delineado las paredes de las estructuras del respiradero.

Uno de los pequeños motores se cree que ha utilizado un mineral conocido como óxido verde, lo que le permite aprovechar las ventajas del gradiente de protones para producir una molécula que contiene fosfato que almacena energía. El otro motor se cree que ha dependido de un metal raro llamado molibdeno.

“La teoría de Michael Russell se originó hace 25 años y, desde ese momento, las misiones espaciales de JPL han encontrado una fuerte evidencia de océanos de agua líquida y fondos rocosos en Europa y Encelado”, dijo Laurie Barge, investigadora del JPL. “Hemos aprendido mucho sobre la historia del agua en Marte, y pronto podemos encontrar planetas similares a la Tierra alrededor de estrellas lejanas. Al probar esta hipótesis del origen de la vida en el laboratorio de JPL, podemos explicar cómo la vida podría haber surgido en otros lugares de nuestro Sistema Solar o más allá, y también tener una idea de cómo buscarla”.

LA NASA

Dic

10

¿La Vida? Creo que está presente por todo el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

Todos recordamos escena de la película de Spielberg “Encuentros en la Tercera Fase”

“La idea de que la vida en el Universo sólo existe en la Tierra es básicamente precopernicana. La experiencia nos ha enseñado de repetida que este tipo de pensamiento es probablemente erróneo. ¿Por qué nuestro pequeñísimo asentamiento debe ser único? Al igual que ningún país ha sido el centro de la Tierra, tampoco la Tierra es el centro del Universo.”

Así se expresaba Fred Hoyle.

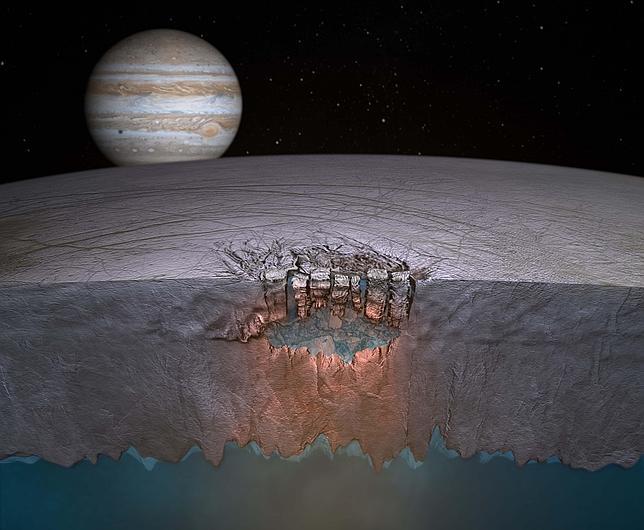

En la luna Europa, un satélite de Júpiter, los científicos han encontrado la mejor prueba hasta de la existencia de una gran masa de agua líquida justo bajo la helada superficie de esta intrigantes luna. Los análisis indican que se trata de agua tan caliente, como para fracturar la gruesa piel de hielo que recubre Europa. Y que ese agua está a menos de 3 km. bajo la corteza del satélite. Los resultados, que se publicaron en Nature, fueron anunciados por la NASA. Las numerosas fracturas en el hielo superficial de Europa, perfectamente visibles desde el espacio, llevan más de una década intrigando a los astrónomos.

Los icebergs, esas enormes montañas de hielo desgajado que flotan en el mar y que se hicieron famosas por causar el hundimiento del Titanic, ya no son patrimonio exclusivo de la Tierra. Gracias a la nave espacial Galileo, 1997 sabemos que también existen en Europa, uno de los cuatro satélites principales de Júpiter, que con sus 3.138 Km de diámetro tiene un tamaño muy similar al de la Luna. Si exceptuamos Marte, puede que no exista ningún otro lugar próximo a la Tierra sobre el que la ciencia tenga depositadas tantas esperanzas de que pueda haber formas de vida, con el aliciente de que en esta luna joviana ha ocurrido un proceso opuesto al del planeta rojo merced a su exploración.

Y pensar que un día, lejano ya en el pasado, Marte pudo ser la Tierra…

Mientras que los ingenios espaciales enviados por el hombre revelaron que la naturaleza marciana es mucho más hostil la vida de lo que insinuaban los telescopios de Schiaparelli, Lowell y Pickering, las sondas Voyager y Galileo han encontrado en Europa el mejor candidato del Sistema solar para albergar la vida extraterrestre (sin olvidar Encelado).

Para los exobiólogos, esos científicos que estudian la existencia de la vida en otros lugares del Universo, Europa ha sido la gran revelación del siglo XX, y Titán, una luna de Saturno que es la segunda más grande del Sistema Solar, constituye una gran incógnita que, poco a poco, se va desvelando gracias a la misión Cassini-Huygens, uno de los más ambiciosos proyectos de la NASA.

Referencia: Chyba, C. F. (2000). Energy for microbial life on Europa. Nature. Las observaciones de Sodio (Na) en la atmósfera de Europa (M. E. Brown and R. E. Hill 1996, Nature 380, 229–231), y un modelo analítico se utilizó determinar la tasa de perdida de Na en Europa. El resultado final nos indica que la tasa de perdida es mayor que la tasa de implantación, lo que determina, que como la Luna,Europa ser una fuente neta de Sodio (Na). Recordar que el Na es uno de los elementos más presentes en un océano líquido…

Europa y Titán, esos dos satélites de Júpiter y Saturno conforman, junto a Marte (y Encelado), los principales puntos de atención en la búsqueda de la vida extraterrestre, aunque eso no significa que vayamos a encontrarla allí, según todos los que se van acumulando, el índice de probabilidades de que ciertamente exista alguna clase de vida en el planeta y las lunas mencionadas, es muy alto. Es decir, si al margen del caso privilegiado de la Tierra existen tres nombres propios en el Sistema Solar donde no está descartada su existencia, esos son, Marte, Europa y Titán.

Sobre Marte, el planeta más parecido a la Tierra, a pesar de sus notables diferencias, nuestros conocimientos actuales son extensos y muy valiosos, nos falta desvelar lo fundamental. Y es que, a pesar de los grandes avances conseguidos durante las exploraciones espaciales, los astrónomos actuales siguen obligados a contestar con un “no lo sé” cuando alguien le pregunta sobre la existencia de vida en aquel planeta.

¿Quién decir lo que hay o no hay en aquel pequeño mundo?

En lo concerniente a Europa, pocas fotografías entre las centenares de miles logradas que se inició la era espacial han dejado tan atónitos a los científicos como las transmitidas en 1997 por la nave Galileo. Desde 1979 se sospechaba, gracias a las imágenes de la Voyager 2, que la superficie del satélite joviano estaba formada por una sorprendente costra de hielo. Su predecesora, la Voyager 1, llegó al sistema de Júpiter en marzo de ese año, pero no se aproximó lo necesario a Europa y sólo envió fotografías de apariencia lisa como una bola de billar surcada por una extraordinaria red de líneas oscuras de naturaleza desconocida. En julio de 1979, poco después, la Voyager 2 obtuvo imágenes más detalladas, que desconcertaron a los científicos porque sugerían que la helada superficie podía ocultar un océano líquido, un paisaje inédito hasta el momento en el Sistema Solar.

Pero lo más asombroso estaba por ver, y transcurrieron dieciocho años que una nueva misión espacial les mostró a los científicos que Europa es una luna tan extraordinaria que incluso parece albergar escenarios naturales como los descritos por Arthur C. Clarke en su novela 2010, Odisea dos. En enero de 1997, la NASA presentó una serie de imágenes en las que la helada superficie de Europa aparecía fragmentada en numerosos puntos. La increíble red de líneas oscuras que había mostrado una década antes la nave Voyager apareció en estas imágenes con notable detalle, que permitió ver surcos, cordilleras y, sobre todo, hielos aparentemente flotantes, algo así como la réplica joviana a los icebergs terrestres.

Lo que podemos encontrar de que termine el siglo es… ¡Impredecible!

Lo más importante de la exploración sobre Europa, a pesar de su enorme interés científico, no fueron sus fotografías, sino los indicios inequívocos de su océano líquido bajo la superficie que, además, tiene todas las características de ser salado. La NASA ha tenido que reconocer que todos los estudios realizados en Europa dan a entender la posibilidad y muestran una notable actividad geológica y fuentes intensas de calor. Las posibilidades de vida en la superficie parecen prácticamente nulas, puesto que se halla a una distancia media del Sol de unos ochocientos millones de kilómetros y su temperatura es inferior a los 150 grados bajo cero. Sin embargo, si bajo la helada corteza existe un océano de agua líquida como creen la mayor parte de los investigadores y expertos, nos encontramos ante la mayor oportunidad la vida en el Sistema Solar después de la Tierra.

Los sensores de las naves exploradoras han detectado un campo magnético en Europa que cambia de constante de dirección, hecho que sólo puede explicarse si este mundo en miniatura posee elementos conductores muy grandes. Como quiera que el hielo, presente en la corteza, no sea un buen conductor, la NASA ha sugerido que esas fluctuaciones del campo magnético de Europa estarían asociadas a la existencia de un océano de agua salada bajo la superficie.

La química de la vida puede estar presente en cualquiera de esos pequeños mundos que nos rodean y, conforme a los estudios realizados y los que continúan en marcha actualmente, en cualquier momento dentro de este mismo siglo en el que nos ha vivir, se podría dar la noticia sorprendente de que han detectado ¡al fin!, formas de vida extraterrestres.

Quizá no debamos dejarnos llevar por la imaginación pero, incluso muchos de los científicos de la NASA, tras haber visto los Icebergs fotografiados por la Galileo, recordaron emocionados el pasaje de 2010, Odisea dos, en el que el profesor Chang lanza a la Tierra un estremecedor grito los lejanos abismos del Sistema Solar: “¡Hay vida en Europa!” Repito: “¡Hay vida en Europa!”.

Del extraordinario emprendido para dar un merecido homenaje a Cassini y Huygens y financiado de manera conjunta por la NASA y la ESA, todos tenemos un conocimiento aceptable a través de las noticias y de nuestras lecturas científicas. En el año 2004 la nave nodriza Cassini, lanzada en 1997, inició la exploración de Saturno y su corte de satélites y, la información recibida hasta el momento es de tan alto valor científico que nunca podremos agradecer bastante aquel esfuerzo.

Esta imagen sorprendente nos debería maravillar y, sin embargo, la vemos como algo cotidiano

No cabe dudas de que la NASA tenía su principal interés puesto en la nave Cassini y Saturno, Titán ha tenido una atención especial que los americanos compartieron con la Agencia Europea ESA, la nave principal o nodriza Cassini se desprendió del módulo Huygens de la ESA, cuya misión será caer sobre Titán, pero antes tenía que estudiar su atmósfera, su superficie y otros elementos científicos de interés que nos dijeran como era aquel “mundo”.

Io nos muestra su furia volcánica y Tritón que es una bola de roca y hielo de 2.700 Km. de diámetro, una superficie bastante suave y con pocos cráteres, y está envuelta por una finísima atmósfera de nitrógeno.

Titán es, de hecho, la luna más enigmática que se conocía. Junto a Io y Tritón en Neptuno forma el trío de únicos satélites del Sistema Solar que mantiene atmósfera apreciable; pero Titán es radicalmente diferente, puesto que mientras en aquellos dos la densidad atmosférica es muy baja, en la luna mayor de Saturno supero, incluso a la de la Tierra. Esto es algo insólito que dejó pasmado a los científicos del Jet Propulsión Laboratory de la NASA cuando obtuvieron los primeros a través de la Voyager. La presión atmosférica es 1,5 veces la de la Tierra, un hecho sorprendente para su tamaño, puesto que en otros lugares más grandes como el mismo Marte, la Gravedad ha sido insuficiente para retener una atmósfera apreciable.

Titán tiene 5 150 Km de diámetro, es la segunda luna mas grande conocida y supera en tamaño a Mercurio, pero en comparación con nuestro planeta es un mundo en miniatura, por lo que resulta excepcional algunas de las características en el halladas. Orbita Saturno en 15,945 días a una distancia de 1 221 830 Km. Es conocido desde 1655, cuando Huygens lo descubrió. De ahí que la NASA, pusiera su a la sonda que acompañó a la Cassini para investigar Titán. Aunque está compuesto por rocas y hielos a partes iguales, aproximadamente. De sus océanos de metano, ¿qué podemos decir? Sabemos que es el único satélite del Sistema Solar que tiene una atmósfera sustancial, de una gran densidad y que su composición es muy parecida a la de la Tierra, ya que el elemento fundamental, como aquí, es el nitrógeno. El papel secundario -aunque primordial- que en la Tierra desempeña el oxígeno, le corresponde en Titán al metano y también se han hallado trazas de hidrógeno. Se tienen muchas esperanzas de que, ésta luna de características tan especiales, sino ahora, algún día más lejano en el futuro podría contener formas de vida y, más adelante, incluso ser un hábitat para nosotros.

La Cassini dejó caer en Titán a la sonda Huygens para que nos hablara de aquel pequeño mundo. Las maniobras llevadas a cabo por esos ingenios, son verdaderamente increibles para poder conseguir imágenes y contarnos algo de lo que por aquellas regiones está pasando. Pequeños mundos que estando en nuestro propio “barrio” eran un misterio y que , gracias al ingenio del hombre, comenzamos a desvelar.

La Huygens nos ha enviado imágenes más que suficientes para poder estudiar el enorme conglomerado de que en ellas aparecen y, tantos las fotografías como otros datos de tipo técnico tomados por los censores de la Huygens y enviados a la Tierra, tendrán que ser estudiados durante mucho tiempo hasta estar seguros de muchos de los enigmas que con ellos podamos desvelar.

La verdadera incógnita de Titán está en su superficie que aún, no se ha estudiado debidamente y, aparte de esos océanos de metano, ¿podrían existir océanos de agua? Científicamente nada lo impide.

¡Ya veremos!

emilio silvera

Totales: 75.091.265

Totales: 75.091.265 Conectados: 70

Conectados: 70