Mar

19

No siempre hablamos de lo que comprendemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (2)

Comments (2)

¡La Física! Lo que busca la física fundamental es reducir las leyes de la naturaleza a una teoría final sencilla que lo explique todo. El físico y premio Nobel Steven Weinberg señala que las reglas fundamentales son lo más satisfactorio (al menos él). Las leyes básicas de Isaac Newton, que predicen el comportamiento de los planetas, son más satisfactorias, por ejemplo, que un almanaque en el que se indique la posición de todos los planetas en cada . Weinberg nos dice que la Física no puede explicarlo todo, matizando que sólo puede explicar los sucesos relacionándolos con otros sucesos y con las reglas existentes.

Por ejemplo, las órbitas de los planetas son el resultado de unas reglas, pero las distancias de los planetas al Sol son accidentales, y no son consecuencia de ley fundamental alguna. Claro que, las leyes podrían ser fruto de casualidades. Lo que sí es cierto es que los físicos están más interesados por descubrir las reglas que por los sucesos que dichas reglas determinan, y más por los hechos que son independientes del tiempo; por ejemplo, les interesa más la masa del electrón que un tornado que se pueda producir en un lugar determinado.

La ciencia, como nos dice Weinberg, no puede explicarlo todo y, sin embargo, algunos físicos tienen la sensación de que nos estamos acercando a “una explicación del mundo” y, algún día, aunando todos los esfuerzos de muchos, las ideas de las mejores mentes que han sido, y las nuevas que llegarán, podremos, al fín, construir esa Teoría final tan largamente soñada que, para que sea convincente, deberá también, incluirnos a nosotros. Pero, paradógicamente y a pesar de estos pensamientos, existen hechos que los contradicen, por ejemplo, conocemos toda la física fundamental de la molécula de agua desde hace 7 decenas de años, pero todavía no hay nadie que pueda explicar por qué el agua hierve a los 100 ºC. ¿Qué ocurre? ¿Somos acaso demasiado tontos? Bueno, me atrevería a pronosticar que seguiremos siendo “demasiado tontos” incluso los físicos consigan (por fin) esa teoría final que nos pueda dar una “explicación del mundo”. Siempre seguiremos siendo aprendices de la naturaleza que, sabia ella, nos esconde sus secretos para que persista el misterio.

¿Qué sería de nosotros si lo supiéramos todo?

La explicación que dan los físicos actualmente sobre la subestructura de la materia se llama “el modelo estándar”. En este modelo están incluídas las doce partículas elementales y las tres fuerzas que, cuando se mezclan y se encajan, sirven para construir todo lo que hay en el universo, desde un redondo pan de pueblo hecho en un horno de leña, hasta las más complejas galaxias, y puede explicar todos los mecanismos de acción, es decir, la mecánica del mundo.

Entre las partículas figuran los seis Quarks famosos: arriba, abajo, extraño, encanto, fondo y . Las otras seis partículas son Leptones: el electrón y sus dos parientes más pesados, el muón y el tau y los tres neutrinos a ellos asociados. Las tres fuerzas son la electromagnética, la fuerza nuclear fuerte (que mantiene unidos a los quarks) y la fuerza nuclear débil (responsable de la radioactividasd). Hay una cuarta fuerza: la Gravedad que, aunque tan importante como las demás, nadie ha sabido como encajarla en el modelo estándar. Todas las partículas y fuerzas de este modelo son cuánticas; es decir, siguen las reglas de la mecánica cuántica. Aún no existe una teoría de la gravedad cuántica.

En realidad, la región que denominamos Gravedad cuántica nos lleva y comprende preguntas sobre el origen del universo observable que nadie ha sabido contestar. Nos lleva a complejos procesos cuánticos situados en las épocas más cercanas imaginables en un espacio-tiempo clásico, es decir, en lo que se conoce como Tiempo de Planck a 10-43 segundos del supuesto big bang, cuando reinaba una temperatura del orden de 10 x 1031 K. Pero, como hemos dicho, al no existir una teoría autoconsistente de la Gravedad cuántica, lo único que podemos hacer (como en tantas otras áreas de la Ciencia) es especular.

El Modelo Estándar no es, ni mucho , satisfactorio. Los científicos piensan que no sólo es incompleto, sino que es demasiado complicado y, desde hace mucho tiempo, buscan, incansables, otro modelo más sencillo y completo que explique mejor las cosas y que, además, no tenga (como tiene el modelo actual) una veintena de parámetros aleatorios y necesarios para que cuadren las cuentas…, un ejemplo: el bosón de Higgs necesario para dar masa a las partículas.

¡La masa! ese gran problema. Todas las partículas masa diferentes pero nadie sabe de donde salen sus valores. No existe fórmula alguna que diga, por ejemplo, que el quark extraño debería pesar el (o lo que sea) del quark arriba, o que el electrón deba tener 1/200 (u otra proporción) de la masa del muón. Las masas son de todo tipo y es preciso “ponerlas a mano”, como se suele decir: cada una ha de ser medida experimental e individualmente. En realidad, ¿por qué han de tener masa las partículas? ¿de dónde viene la masa?

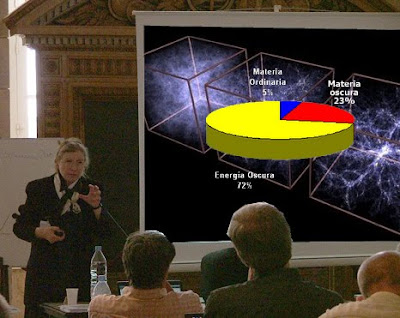

No puedo evitarlo ni tampoco me puedo quedar callado, he asistido a alguna conferencia sobre la materia y, el ponente de turno se agarra a la “materia oscura” para justificar lo que no sabe, si al final hay debate, entro en escena para discutir sobre la existencia de esa “materia fantasma” que quiere tapar nuestra enorme ignorancia.

Pero, sigamos con el de la masa. Para resolverlo, muchos expertos en física de partículas creen actualmente en algo que llaman “campo de Higgs”. Se trata de un campo misterioso, invisible y etéreo que está permeando todo el espacio (¿habrán vuelto al antiguo éter pero cambiándole el nombre?). que la materia parezca pesada, como cuando tratamos de correr por el fondo de la piscina llena de agua pero que el agua no se pudiera ver. Si pudiéramos encontrar ese campo, o más bien la partícula la partícula que se cree es la manifestación de ese campo (llamada el bosón de Higgs), avanzaríamos un largo trecho hacia el conocimiento del universo.

Aquí, en este imponente artilugio inventiva de nuestras mentes, se quiere dar respuesta a una serie de interrogantes que se espera solucionar con este experimento:

• Qué es la masa.

• El origen de la masa de las partículas

• El origen de la masa para los bariones.

• El número exacto de partículas del átomo.

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el de Higgs se descubrió hace ya muchos siglos en la antigua India, con el nopmbre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

Los Vedas: Textos míticos

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

El pensamiento Hindú tendrçia que ser mejor estudiado

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

emilio silvera

Mar

19

Necesitamos una teoría unificada del Cosmos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (0)

Comments (0)

Hace mucho tiempo ya que el hombre mira al cielo y observa los objetos celestes. Muy lejos queda ya la teoría geocéntrica de Ptolomeo con una Tierra ocupando el centro del universo. En Babilonia ya tenían aquella visión de una Tierra en el centro de todo y en su obra El Almagesto, Claudio Ptolomeo continuó reflejando esa teoría alla por el siglo II y estuvo en vigor hasta el siglo XVI, cuando fue reemplazada por la teoría heliocéntrica. Fueron muchos los que discrepaban de la teoría que ponía a la Tierra en el centro de todo y, ya en el siglo II a. C., Aristarco de Samos fue el que defendió la idea con más fuerza e incluso llegó a escribir un libro que no ha llegado a nuestros días.

El tiempo transcurría y las ideas se hicieron más claras y, fue Copérnico el que al fín, en un libro publicado en 1543, De Revolutionibus Orbium Coelestium, dejó fijado el punto de partida que situaba al Sol en el centro y los planetas a su alrededor. Todo aquello, no fue suficiente para que el antiguo modelo de la Tierra central continuara durante algún tiempo, toda vez que Copérnico, no explicaba de manera suficiente algunos fenómenos y, además, se alejaba de la educación religiosa del momento.

Kepler en un retrato de 1610

Kepler con la herramienta de las muchas observaciones realizadas por Tycho Brahe que estudió a fondo, pudo formular sus Tres Leyes en 1609 y 1619, en las que dejó sentado que las planetas se movían en trayectorias elípticas. Galileo con sus observaciones despejó el camino hacia la comprensión de dónde nos encontrábamos. Más tarde llegaría Newton con su Ley de la Gravedad y no fue hasta 1915 que la entrada en escena de Einstien nos trajo un Modelo más moderno y coherente con su Teoría de la Relatividad General.

La Teoría hilocéntrica llegó con fuerza hasta los principios del siglo XX, el Sol estaba situado en el centro sobre el cual giraba todo el universo con los objetos del espacio profundo que contenían “nebulosas espirales”.

Harlow Shapley

La llegada de Shapley al “mundo” de las estrellas le dieron otro giro a la visión que del universo se tenía. Sus observaciones iniciaron el estudio de las estrellas variables que llevó a descubrir un tipo especial de ellas que se caracterizaban por el hecho de que los cambios de brillo estaban relacionados con su liuminosidad intrínseca y, como la estrella prototipo se encontró en la Constelación de Cefeo, se las llamó Cefeidas.

A partir de aquel momento, y, conociendo la luminosidad de un objeto celeste bastaba aplicar la ley del cuadrado inverso que nos dice que el brillo disminuye de acuerdo al cuadrado de la distancia y se pudo calcular la distancia a la que se encontraba el objeto estudiado. Así Shapley siguió con su impresionante trabajo y pudo observar cúmulos globulares, grupos de millones de estrellas que estaban “juntas” en un cúmulo compacto y redondo girando alrededor de los centros galácticos. Se pudo apreciar que el Sol, debería estar situado en la periferia del Universo y muy lejos del centro de la Galaxia.

Los cúmulos globulares pueden contener hasta miles de millones de estrellas

Todos aquellos nuevos descubrimientos llamaron la atención de muchos y, hasta el filósofo Immanuel Kant contribuyó al conocimiento del universo con sus obra Historia general de la naturaleza y teoría del cielo, en la que exponía la hipótesis de que a partir a una nebulosa de gas surgió el Sistema solar y sugirió la idea de que existían otras muchas galaxias que eran como “universos islas”, es decir, una especie de universos en miniatura cuajado de estrellas y de mundos.

Su idea de los universos islas llegaron hasta principios del siglo XX y “las nebulosas espirales”, eran en realidad otros universos islas como la Vía Láctea pero separados de ella y, esa teoría fue firmemente apoyada por Herschel aunque no se tenían pruebas contundentes de ello. Pero como el avance del conocimiento no se para, aquellas pruebas llegaron de la mano de las observaciones de Hubble, realizadas en el Observatorio de Monte Wilson.

Como inmensas pompas de jabón que reflejan el brillo multicolor de las estrellas

El Universo dejó de ser algo estático para convertirse en un universo en expansión. El descubrimiento de varios supercúmulos galácticos en 1978, como el de Perseo-Pegaso (que, se extiende por el cielo a través de mil millones de años-luz), es la mayor de las estructuras que se han podido constar hasta la fecha en el universo. Otro hallazgo importante ocurrió en 1981, cuando se halló el primer “vacío” en la Constelación de Boötes. El vacío, o “Burbuja de Hubble”, una gran región del espacio en la que no existen galaxias -o muy pocas- y cuya extensión puede alcanzar los 250 millones de años-luz de diámetro. En 1985 se descubrieron nuevos vacíos que vinieron a configurar una nueva imagen de nuestro universo que está lleno de burbujas.

Hubble, el 19 de febrero de 1924, escribió a Shapley, quien defendía la existencia de una sola galaxia:

«Seguramente le interesará saber que he hallado una variable cefeida en la nebulosa de Andrómeda». De esta manera se reveló que las nebulosas espirales no eran simples cúmulos de gas dentro de la vía láctea sino verdaderas galaxias independientes o como Kant describió «universos isla».

Pero la historia de las variables Cefeidas tiene otra protagonista que no quiero dejar aquí oculta en el olvido y que es de justicia destacar para que los méritos sean repartidos conforme a quién los ganó. No siempre se han otorgado los premios a los que lo merecieron. Claro que todo aquello no era nada fácil toda vez que…

El ojo humano solo es capaz de percibir la pequeña porción que corresponde a la luz visible, situada entre los 3900 Å y 7500 Å, donde la menor se encuentra cerca del violeta y la mayor del rojo. El Sol emite en todas las longitudes de onda, pero solo llegan a la superficie una pequeña porción de estas, las demás son frenadas por la atmósfera: el ozono absorbe las mas altas longitudes de onda hasta el ultravioleta, y el vapor de agua absorbe gran parte de las infrarrojas. Fueron los telescopios los que nos permitieron llegar más lejos y ver más.

En el Observatorio de la Universidad de Harvard, uno de los principales centros de la monótona pero prometedora tarea de la taxonomía estelar, las placas fotográficas que mostaban los colores y espectros de decenas de miles de estrellas se apilaban ante “calculadoras”, mujeres empleadas como miembros del personal de una facultad que les impedía asistir a clases u obtener un título pero que, desarrollaban una labor importante de infinita paciencia

Una de esas mujeres, Henrietta Leavitt (arriba), fue la investigadora pionera de las estrellas variables cefeidas que tan útiles serían a Shapley y Hubble, ella fue una de esas “calculadoras” de Harvard que, se encargaban de examinar las placas y registrar los datos en una pulcra escritura victoriana para su compilación en volúmenes como el Henry Draper Catalog, así llamado en honor al primer astrofotógrafo y físico que tomó las primeras fotografías del espectro de una estrella. Como presos que marcan el paso de los días en los muros de su celda, señalaban su progreso en totales de estrellas catalogadas. Antonia Maury, sobrina de Draper, contaba que había clasificado los espectros de más de quinientas mil estrellas. Su labor era auténticamente baconiana, del tipo que Newton y Darwin instaban a hacer pero raramente hicieron ellos, y las mujeres se enorgullecían de ella. Como afirmaba la “calculadora” de Harvard Annie Jump Cannon: “Cada dato es un facto valioso en la imponente totalidad”.

Precisamente fue Cannon quien, en 1915, empezó a discernir la forma de esa totalidad, cuando descubrió que la mayoría de las estrellas pertenecían a una de media docena de clases espectrales distintas. Su sistema de clasificación (ahora generalizado en la astronomía estelar), ordena los espectros por color, desde las estrellas O blancoazuladas, pasando por las estrellas G amarillas como el Sol, hasta las estrellas rojas M. Era un rasgo de simplicidad debajo de la asombrosa variedad de las estrellas.

Pronto se descubrió un orden más profundo, en 1911, cuando el ingeniero y astrónomo autodidacto danés Ejnar Hertzsprung analizó los datos de Cannon y Maury de las estrellas de dos cúmulos, Las Híades y las Pléyades. Los cúmulos como estos son genuínos conjuntos de estrellas y no meras alineaciones al azar; hasta un observador inexperimentado salta entusiamado cuando recorre con el telescopio las Pléyades, con sus estrellas color azul verdoso enredadas en telarañas de polvo de diamante, o las Híades, cuyas estrellas varían en color desde el blanco mate hasta el amarillo apagado.

Las Pléyades

Las Híades

Puesto que puede supònerse que todas las estrellas de un cúmulo están a la misma distancia de la Tierra, toda diferencia observada en sus magnitudes aparentes pueden atribuirse, no a una diferencia en las distancias, sino en las magnitudes absolutas. Hertzsprung aprovechó este hecho para utilizar los cúmulos como muestras de laboratorio con las que podía buscar una realción entre los colores y los brillos intrínsecos de las estrellas. Halló tal relación: la mayoría de las estrellas de ambos cúmulos caían en dos líneas suavemente curvadas. Esto, en forma de gráfico, fue el primer esbozo de un árbol de estrellas que desde entonces ha sido llamado Diagrama de Hertzsprung-Russell. Claro, como cabía esperar, la aplicabilidad del método pronto se amplió también a estrellas no pertenecientes a cúmulos.

Henry Norris Russell, un astrofísico de Princeton con un enciclopédico dominio de su campo, pronto se puso a trabajar justamente en eso. Sin conocer siquiera el trabajo de Hertzsprung, Russell diagramó las magnitudes absolutas en función de los colores, y halló que la mayoría están a lo largo de una estrecha zona inclinada: el trondo del árbol de estrellas. El árbol ha estado creciendo desde entonces y hoy, está firmemente grabado en la conciencia de todos los astrónomos estelares del mundo. Su tronco es la “serie principal”, una suave curva en forma de S a lo largo de la cual se sitúan entre el 80 y el 90 por 100 de todas las estrellas visibles. El Sol, una típica estrella amarilla, está en la serie principal a poco menos de la mitad del tronco hacia arriba. Una rama más fina sale del tronco y se esxtiende hacia arriba y a la derecha, donde florece en un ramillete de estrellas más brillantes y más rojas: las gigantes rojas. Debajo y a la izquierda hay una cantidad de mantillo de pálidas estrellas entre azules y blancas: las enanas.

El Diagrama de Hertzsprung-Russell resumido

Este diagrama proporcionó a los astrónomos un registro congelado de la evolución, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucionan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aun de estrellas de vida corta, se mide en millones de años. Hallar las respuestas exigirá conocer toda la física del funcionamiento estelar.

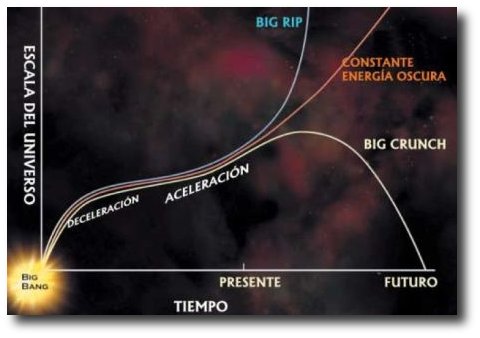

Todo esto nos lleva de nuevo a pensar que, sería conveniente que surgiera una teoría unificada del Cosmos, acorde con los primeros pasos del Big Bang y con la aún misteriosa formación de estructuras a gran escala: un modelo, en fin, que contendría en un todo coherente el origen, la evolución, la estructura actual y el destino último del Universo.

Me hubiera gustado contar de manera paralela que, a finales del s. XIX y principios del s. XX, el progreso de la Física, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la barrera de Coulomb, y por un tiempo frustó los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas… Pero eso, amigos, es otra historia que os contaré en otro momento.

emilio silvera

Mar

19

¡La Física! ¿Hasta dónde nos llevará?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Materiales increibles ~

Clasificado en Materiales increibles ~

Comments (2)

Comments (2)

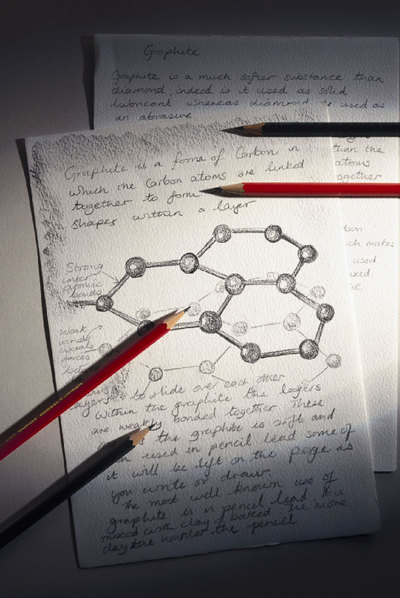

Hace apenas diez años que se pudo observar el Grafeno

Fueron obervadas por los Astrónomos de la NASA

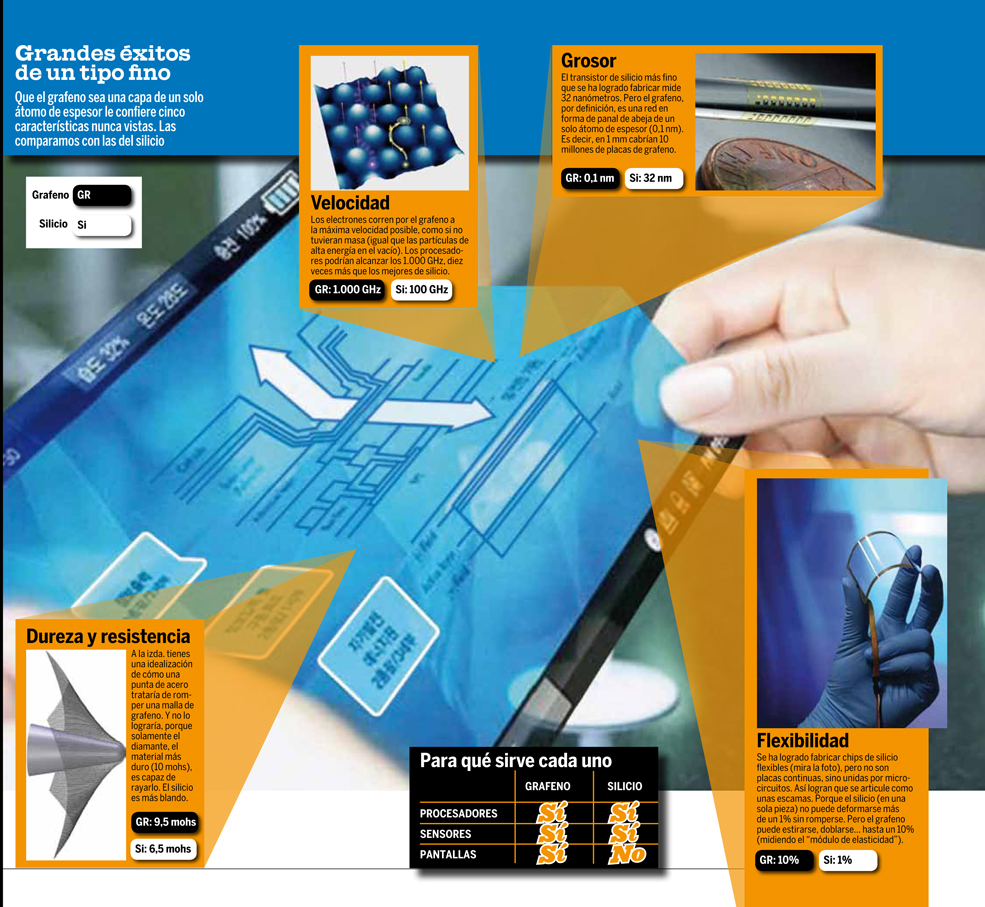

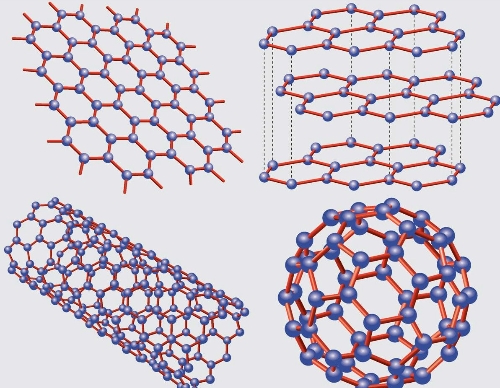

Primero fueron las moléculas de carbono en forma de balón de futbol; luego llegó el carbono enrollado en forma de nanotubos de carbono, más tarde las mallas microscópicas y, mañana… ¿quién sabe, qué maravillas nos espera? Puede que en unos años el valle más famoso de la era de la informática tenga que cambiar de nombre. Al norte de California, entre montañas y autopistas, una extensa aglomeración de empresas de nuevas tecnologías es conocida como Silicon Valley, en inglés valle del silicio, elemento químico con el que se fabrican los microchips. Pero el futuro, dicen algunos expertos y muchas publicaciones científicas, está en los chips de grafeno, un material resistente, transparente y extremadamente flexible.

Científicos surcoreanos acaban de construir la primera pantalla táctil de este material. Tiene 30 pulgadas y puede doblarse y enrollarse hasta ocupar un espacio mínimo. IBM, el gigante de la informática, presentó este invierno sus primeros chips de grafeno, 10 veces más veloces que los de silicio. Los fabricantes de baterías para móviles anuncian que mejorarán su producto gracias a este derivado del grafito, con el que también está hecha la radio más pequeña del mundo, diseñada por el Instituto Tecnológico de Massachusetts (MIT). ¿Estamos ante una nueva revolución que traerá ordenadores aún más rápidos y pantallas aún más pequeñas? ¿O hablar del valle del grafeno es tan solo fantasía?

Las pantallas del futuro serán flexibles, eso está claro. Los principales fabricantes se afanan en buscar nuevas fórmulas, no solo de grafeno sino también de tecnología OLED, basada en una capa que emite luz y está formada por componentes orgánicos (polímeros). También se intenta hacer papel electrónico con óxidos de metal o variantes del silicio clásico, como silicio cristalino o sus combinaciones con el caucho, bastante más elástico.

El instituto de nanotecnología en el que han desarrollado la primera pantalla táctil de grafeno, en la Universidad Sungkyunkwan de Seúl, ha conseguido llamar la atención de las grandes compañías. El sector está inquieto. Pantallas que se doblan como un papel y que dentro de poco, según James Tour, de la Universidad de Rice (Houston) y uno de los químicos más prestigiosos de la última década, podrán enrollarse “hasta formar un pequeño lápiz que nos pondremos tras la oreja”. Samsung, líder mundial en diversas ramas de la industria electrónica, ya ha anunciado que en dos años comercializará un artilugio parecido.

Qué ocurrirá entonces con los netbooks, esos pequeños ordenadores que coparon el mercado allá por el año 2009, y que nos parecían el último grito? ¿Y qué será del iPad de Apple? En sus cuatro primeros meses de vida, se vendieron más de tres millones de esta tableta ultraportátil que hace las veces de ordenador y teléfono. Pero incluso el gran invento de 2010 dejaría de tener sentido si sale al mercado una pantalla que pesa menos y que, extendida, es más grande y nítida, mientras que, enrollada, ocupa mucho menos espacio.

Si nuestros abuelos levantan la cabeza en sus tumbas y pudieran contemplar como se envía por fax un documento, de manera instantánea, de un lugar a otro lejano…, y, sin embargo, todo eso nos parece de lo más normal y cotidiano. Según vamos avanzando, ¿qué maravillas podremos ver nosotros? La ciencia avanza de manera exponencial y se cumple la ley Moore, cada poco tiempo, lo que hoy es moderno, queda obsoleto y hay que reemplazarlo por algo nuevo menos costoso, con más prestaciones, más barato de fabricar…

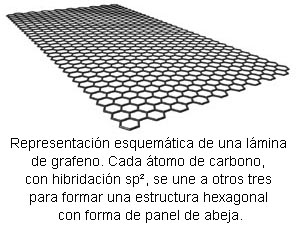

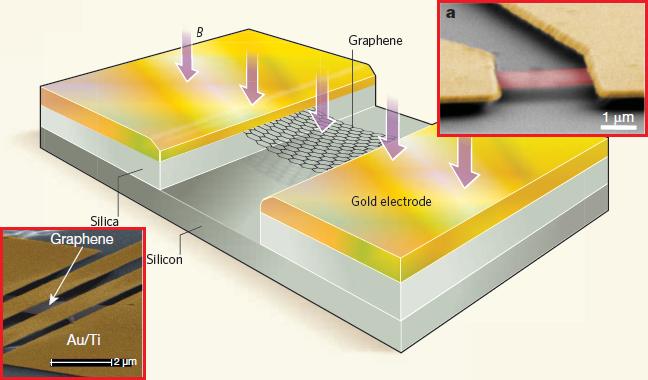

Por ejemplo, las láminas de Grafeno, unque comparte muchas de las propiedades que emocionaron de los nanotubos de carbono hace poco más de una una década, el grafeno es más facil de manipular y fabricar, lo cual le da mayores probabilidades de ser utilizado en laboratorios y aplicaciones prácticas. Si unimos a eso que el grafeno es uno de los mejores conductores de calor y de electricidad; su resistencia es 200 veces más que la del acero; es muy duro y muy elástico; tan ligero como la fibra de carbono. Los científicos han fabricado transistores de grafeno y los utilizan para explorar raros fenómenos cuánticos a temperatura ambiente.

Las aplicaciones del Grafeno son inimaginables en todos los sectores de la tecnología, medicina, Espacio…

Hace aún pocos años, sólo un puñado de gente investigaba algo relacionado con el grafeno. En una reunión de la Sociedad Americana de Física, celebrada en marzo, se presentaron cerca de 100 temas relacionados con el material. “Es como descubrir una isla” con varias especies para catalogar y ser estudiadas, manifestó Carlo Beenakker, profesor de física teórica en la Universidad Leiden, en Holanda.

Un nanotubo es grafeno enrollado. El grafito, lo que hay en la punta de un lápiz, está formado por capas de carbón apiladas, una encima de otra, como una baraja. Pero por mucho tiempo no se tuvo la destreza para sacar solo una de las cartas de esa baraja.

Hace unos 10 años, unos investigadores dirigidos por Rodney Ruoff, un de nanoingeniería de la Universidad Northwestern, frotaron pequeños pilares de grafito contra una plaqueta de silicio, lo que causó que se repartieran como una baraja. La técnica sugirió que podrían producir un grafeno de una sola capa, pero Ruoff no midió el grosor de la hojuela.

Luego, en 2004, un grupo de investigadores encabezado por el doctor Andre Geim, profesor de física de la Universidad de Manchester, en Inglaterra, desarrolló una mejor técnica: ponían una hojuela de grafito en un pedazo de cinta adhesiva, la doblaban y cortaban, con lo que dividian la hojuela en dos. Doblando y desdoblando repetidamente, el grafito se volvia cada vez más delgado; luego pegaron la cinta en una oblea de silicio y la frotaron. Algunas de las hojuelas de grafito se pegaron a la oblea y eran del grosor de un átomo.

Con este sencillo método de fabricar grafeno, se comenzaron a hacer todo tipo de experimentos. Por ejemplo: algunos lo emplearon para construir transistores y otros aparatos electrónicos.

Incluso se están haciendo estudios con estos materiales para ver la posibilidad de construir ascensores espaciales a la Luna, a la Estación Espacial Inrternacional, a bases de despegue de naves que saldrán a explorar el espacio interestelar…

Las hojas de grafeno no son planas, sino onduladas, y medir su grosor es toda una odisea. Los mejores microscopios del mundo pueden notar la presencia de un solo átomo, pero usarlos para medir el grosor de cada hojuela de grafeno es terriblemente lento. No obstante, Geim descubrió que una hoja así de delgada cambia el color de la capa de óxido de silicio en la superficie de una plaqueta, como el arcoiris que se genera cuando se vierte aceite sobre agua. Así con una simple ojeada a través de un sencillo microscopio, los investigadores pueden saber si una hojuela de grafeno tiene más de 10 capas de grosor (amarillo), entre 30 y 40 (azul), alrededor de 10 (rosa) o solo una (rosa pálido, casi invisible).

Pero aún enfrentan retos: el método de la cinta adhesiva no permite la producción en masa, al menos no de un modo costeable. Por ello, Walter de Heer, profesor de física del instituto Tecnológico de Georgia, ha refinado una técnica para obtener grafeno del carburo de silicio. Al calentar una plaqueta de este material a 1300ºC, los átomos de silicio de la superficie se evaporan, mientras que los átomos de carbono restantes se reacomodan en grafeno. “Es como cocinar un pavo”, dice De Heer.

También, los científicos han demostrado un fenómeno conocido como el efencto cuántico Hall, donde la resistencia eléctrica perpendicular a la corriente y un campo magnético aplicado saltan entre ciertos valores discretos. El efecto cuántico Hall se ve comúnmente a temperaturas muy bajas en semiconductores, pero con el grafeno ocurre a temperatura ambiente.

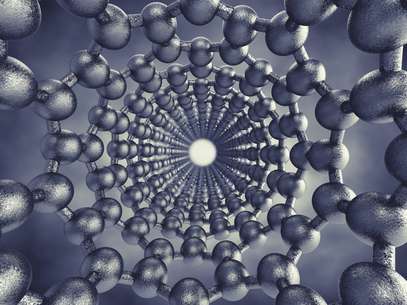

Si hablamos de los nanotubos de carbono, hay que decir que tienen excepcionales propiedades mecánicas, térmicas, químicas ópticas y eléctricas, por lo que son un material prometedor para numerosas aplicaciones de alta tecnología. En la práctica, las primeras aplicaciones de los nanotubos de carbono han sido electrónicas debido a sus particulares propiedades eléctricas, ya que los nanotubos pueden ser metálicos o semiconductores. Los nanotubos permiten hacer más pequeños los dispositivos, conducen muy bien el calor y aumentan la vida útil de los dispositivos.

– Los nanotubos, por su carácter metálico o semiconductor, se utilizan en nanocircuitos:

- Interconectores. Los nanotubos conducen bien el calor y poseen una fuerte estructura para transportar corriente, aunque la conductividad disminuye al aumentar el número de defectos.

- Diodos. Al unir nanotubos metálicos y semiconductores, o con campos eléctricos, similares a las uniones P-N.

- Transistores. De efecto campo, de electrón único, interruptores.

– Se emplean también como emisores de campo, que es una manera de arrancar electrones de un sólido aplicando un campo eléctrico. Algunas aplicaciones son: pantallas planas, lámparas y tubos luminiscentes, tubos de rayos catódicos, fuentes de rayos X, microscopios electrónicos de barridos, etc.

– Otras aplicaciones son: nanotubos como filtros RF, y memorias fabricadas con nanotubos más rápidas, baratas, con mayor capacidad y menor consumo (nos dice Sergio Sánchez Force).

También se han utilizado los nanotubos de carbono para fabricar unas películas conductoras transparentes de distintos colores, mediante una técnica conocida como ultracentrifugación en gradiente de densidad que hace que láminas obtenidas se parezcan a un vidrio teñido. Estas películas pueden introducir mejoras en células solares y monitores de pantalla plana.

Actualmente, el óxido de estaño indio (ITO) es el material más utilizado para las aplicaciones conductoras transparentes. Pero debido a la escasez de indio y a su pobre flexibilidad mecánica, se ha buscado un conductor transparente alternativo, encontrándolo en los nanotubos de carbono.

Los nanotubos de carbono recientemente se utilizan también para fabricar productos electrónicos flexibles, como por ejemplo papel electrónico, a un coste asequible. Esto es debido a que ha surgido una forma de hacer transistores de alto rendimiento en un substrato de plástico.

Las buckyesferas, también conocidas como fullerenos, son moléculas con forma de balón de fútbol formadas por 60 átomos de carbono unidos. Y el espacio está lleno de ellas. Así nos lo comunicaron en su día los científicos de la NASA cuando lo descubrieron en las Nebulosas y en otras regiones del Espacio Interestelar.

No sólo en transistores, móviles o pantallas, este material estará presente por todas partes y, no digamos en el espacio. Por cierto, está presente ya en todas las Nebulosas de la que forman una importante proporción. Lo que decimos siempre: ¡Hay que estudiar la Naturaleza!

Los nanotubos de carbono se emplean en chips de dispositivos electrónicos para disipar el calor, reduciendo la temperatura del microprocesador. Los nanotubos disipan el calor de los chips tan bien como el cobre (utilizado también para disipar calor) y son más resistentes, ligeros y conductores que otros materiales para disipar calor, siendo su coste muy competitivo.

Se han desarrollado transistores de película delgada de nanotubos de para crear dispositivos flexibles y transparentes de alto rendimiento. Para ello, se emplean conjuntos alineados o redes de nanotubos para hacer transistores y circuitos integrados flexibles.

Estos conjuntos constan de miles de nanotubos que funcionan como semiconductor en forma de película delgada en el que las cargas se mueven a través de cada uno de los nanotubos. Un dispositivo típico tiene mil nanotubos y produce corrientes de salida mil veces mayores a los que tienen un solo nanotubo.

Almacena energía solar durante un tiempo indefinido

Recientemente se ha desarrollado una tecnología para almacenar energía solar con nanotubos de carbono, que se recargan cuando se exponen al sol. Este método supone menor coste que otras alternativas y mejora con respecto a la conversión eléctrica.

Un nanotubo de carbono puede ser conductor o semiconductor según la forma en que se enrolle la lámina de grafito, lo que lleva a emplear los nanotubos como componentes básicos de los transistores, ya que por su pequeño tamaño se podrían introducir muchos transistores en un microprocesador.

Se ha demostrado que la resistencia eléctrica de los nanotubos con vacantes crece exponencialmente con su longitud mientras que en un conductor normal (un hilo de cobre, por ejemplo) la resistencia crece linealmente con la longitud. La presencia de tan sólo un 0,03% de vacantes sea capaz de incrementar la resistencia eléctrica de un nanotubo de 400 nanómetros de longitud en más de mil veces. Este hallazgo podría permitir modificar a voluntad la resistencia en un nanotubo mediante la inclusión controlada de defectos, de manera análoga a como se hace actualmente en los materiales semiconductores.

Hay cuestiones en el mundo de la física cuántica que, literalmente, nos dejan con la boca abierta por el asombro. Como ocurre también con partículas cuya rotación, al duplicarse, resulta igual a un número par. Para manipular sus energías hay otra serie de reglas, ideadas por Einstein y el físico indio S. N. Bose. Las partículas que se adaptan a la estadística Bose-Einstein son Bosones, como por ejemplo la partícula Alfa.

A bajas temperaturas los Bosones tienden a tener un comportamiento cuántico similar que puede llegar a ser idéntico a temperaturas cercanas al cero absoluto en un estado de la materia conocido como condensado de Bose-Einstein.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de esta teoría en vez de los de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico de igualdad. Dichas partículas (como dije antes) son Bosones que tienden a juntarse.

Los Bosones tienen un momento angular nh/2π, donde n es 0 o un entero, y h es la constante de Planck. cons Para Bosones idénticos, la función de ondas es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n + ½)h / 2π y cualquier función de ondas de iones feridénticos es siempre antisimétrica. La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

En fin, la Física, esa disciplina que nos lleva hacia el futuro.

emilio silvera

Totales: 75.604.089

Totales: 75.604.089 Conectados: 35

Conectados: 35