Mar

17

Entrevista en El Español

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Entrevista científica ~

Clasificado en Entrevista científica ~

Comments (0)

Comments (0)

Es uno de los físicos teóricos más fundamentales del último siglo, ha recibido los galardones más prestigiosos y ha hecho tanto por la comprensión del universo como Stephen Hawking. Por eso, probablemente, usted nunca antes haya leído su nombre.

El físico ruso, tras la entrevista con EL ESPAÑOL. Fundación BBVA

¿Qué ha hecho Viatcheslav Mukhanov por todos nosotros? Principalmente, predecir cómo se formó toda la materia del universo tras el Big Bang. Su teoría de la fluctuación cuántica como origen de todas las galaxias es ahora parte de los libros de física y sin embargo, su notoriedad está a millones de años luz de la de Stephen Hawking, con quien compartió hace unos meses el premio Fronteras del Conocimiento en Física.

Por otro lado, la historia de Mukhanov es la de uno de tantos científicos rusos que huyeron del país tras la perestroika para poder seguir haciendo avanzar a sus disciplinas. Empleado desde hace unos años en la universidad Ludwig Maximilian de Munich, este físico ha obtenido todos los reconocimientos posibles salvo el Nobel de Física. Es decir, ha ganado todos los premios que un físico teórico puede llegar a ganar.

Mukhanov recibe a EL ESPAÑOL en una visita a Madrid para impartir una conferencia en la Fundación BBVA. Departir con él es como plantarse en mitad de un río de montaña con un escurridor de espaguetis. Hay que enfrentarse a una personalidad huracanada, que verbaliza en un inglés torrencial con arranques de mal genio, borbotones en ruso, carcajadas a destiempo y pinceladas de alemán, con la esperanza de que al final acabaremos hallando en el cedazo varias pepitas de oro.

Cuando usted hizo su gran contribución a la comprensión del universo, ¿fue bien recibida en aquella época?

A nadie le importó mucho.[Risas] No éramos una comunidad muy grande, podías contar a los cosmólogos: uno, dos, tres, cinco. En la URSS había varios porque es donde Zel’dovich creó escuela y allí comenzaron a darse varias hipótesis interesantes. Por supuesto, una cosa son hipótesis y otra son hechos probados. La cosmología era un campo interesante en aquella época, pero al principio no había prácticamente hechos. Para mí fueron suficientes para defender mi tesis doctoral. Por supuesto, en las fluctuaciones siempre hay contradicciones pero los astrofísicos no saben mucho de las series cuánticas así que a nadie le importó.

Todo eran hipótesis plausibles pero que pueden ser solamente blablabla. Cuando François Englert y Robert Brout escribieron su famoso paper cuatro años antes de que lo hicieran los americanos nadie prestó atención. La cosmología sólo empezó a tener un poco de éxito en los años noventa, no sólo por la radiación de fondo de microondas sino porque en aquellos años se empezaron a construir telescopios grandes, uno detrás de otro, algo que diez años antes era inimaginable. Recuerdo que en los ochenta pasé un único mes en el llamado “mayor telescopio ruso”.

¿Dónde estaba ese telescopio?

Antes era territorio de la Federación Rusa pero hoy sería Kirguistán o algo así, Chechenia, el Cáucaso. Pregunté entonces por qué lo habían puesto en un lugar tan malo para la observación, ¿por qué no en Armenia? Me dijeron que era una decisión condicionada políticamente e hice una broma diciendo que preveía que en diez años la URSS caería y que lo siguiente sería elegir Kazajistán para lanzar los cohetes.[Risas]

Los años 90 fueron fantásticos para la cosmología y la astrofísica porque comenzaron a construirse instrumentos. No era aún física tal y como yo la entiendo. Cuando era joven no solía pensar así porque cuando eres joven básicamente piensas lo que tu jefe te dice que pienses, porque respetas a tu jefe y lo que hace. Pero cuando vas creciendo aprendes que básicamente solo hay un dios en física, y es el experimento. Aparte de eso no hay autoridad que deba ser aceptada. Por ejemplo, Lemaître hablaba de la creación del universo a partir de fluctuaciones cuánticas o lo que sea, pero era sobre todo blablabla porque una de las cosas importantes de la física es que debe haber fórmulas nuevas, que nadie ha visto antes, y que te permiten medir un par de números. Pero Lemaître hablaba con Einstein de la creación del universo criticando las técnicas humanas, eso es una basura completa, algo que solo puede salir de la boca de un sacerdote, porque Lemaître era un sacerdote. ¿Cómo mides la autoridad? Por supuesto Einstein tenía más autoridad pero quizá estaba equivocado, hubo muchos casos en los que Einstein lo estuvo, no nos preocupemos, la gente es gente, no son dioses. La gente no puede vivir sin autoridad, por eso buscan la autoridad máxima, pero la autoridad más alta es la naturaleza, el experimento.

Usted no había cumplido los 30 cuando hizo su gran descubrimiento. ¿Qué atributos debe tener un científico joven? Ha mencionado antes el respeto a los jefes.

No, no debes seguir a tus jefes, es lo que intentaba decir. Resulta útil de alguna forma, pero un científico no debe seguir a nadie más allá de su propia curiosidad. Por ejemplo, Ginzburg fue un guía muy bueno en este sentido, porque cuando fui a buscarle para empezar mi doctorado con él, porque mi anterior director emigró por motivos políticos, me dio libertad total, porque… ¿cuál es la mejor manera de enseñar a nadar a un niño? Tirarlo en mitad de un lago, si sale adelante es bueno, si no… lo siento.

[Más risas]

Quizá con un niño no sea muy justo, pero en física, y especialmente en física teórica, sí lo es.

¿Cuál es el equivalente en física a tirar a un niño en mitad de un lago?

Significa poner a un estudiante en un campo, le das unas instrucciones particulares, le dices el problema y lo que esperas de él y el resto debe hacerlo todo él solito. He conocido a varios físicos que hicieron el doctorado con Julian Schwinger, por ejemplo Walter Kohn, Sheldon Glashow o Bryce DeWitt, y los tres me dijeron lo mismo sobre su director: que habían visto a Schwinger dos veces durante todo el doctorado. La primera vez durante 20 minutos en los que Schwinger formuló el problema y la segunda tres años más tarde. Guiar a los estudiantes de una forma muy detallada destruye su originalidad y destruye su personalidad, se vuelven como unos técnicos en física, y los físicos teóricos no son técnicos, deben tener originalidad. Y de hecho, enseñar a ser original no es nada trivial: puedes enseñar a jugar al ajedrez o cómo ensamblar cosas, pero esto es diferente. En física fundamental tienes que venir con ideas nuevas, y si hay un campo donde miles de personas están buscando ideas nuevas, la única forma es salir de esta masa de gente, no trabajar en el mainstream.

¿Cree que lo del genio solitario sigue vigente en una época donde prima la colaboración?

No puedes decir eso de que alguien es un genio. Ser un genio ahora equivale a tener unos atributos técnicos excepcionales, como esos niños que multiplican números más rápido que un ordenador, pero normalmente esto es un producto del entrenamiento. Imagínese un sitio lleno de oro, todo el mundo llega, se lleva el oro, el resto llega al sitio pero ya no hay oro. Esto es lo que pasa en física, un campo se vuelve popular cuando no hay prácticamente nada que hacer. Uno tiene que encontrar su propio campo, y esto, claro, tiene sus dificultades.

¿Cómo están las cosas ahora para los científicos en Rusia? Porque buena parte de su generación emigró, ¿hay una nueva generación ahora tirando del carro?

No, por desgracia no puedo decir que en Rusia la situación de la ciencia sea brillante. Por supuesto, no estoy allí por lo que no puedo hablar desde dentro, pero desde fuera, no veo tanta gente buena en física teórica que aparezca, que viaje… desde mi punto de vista lo que el gobierno ruso está haciendo con la ciencia es completamente erróneo, por no decir nada peor. Creo que la gente no comprende que destruir este tipo de cosas es muy fácil, la ciencia es extremadamente delicada, y construirla de nuevo lleva mucho tiempo. La física en Rusia fue construida gracias a las investigaciones militares y las grandes escuelas matemáticas de los años veinte, tras la Revolución, pero ya no queda nada de aquello.

Leí algunas quejas de los académicos rusos el año pasado, cuando el ministro de ciencia fue sustituido por una historiadora experta en Stalin, pero no he seguido mucho el tema. ¿Ha empeorado la situación?

Mucho peor. En general, poner a distribuir el dinero para investigación a algún Putin de la vida, que quizá ni siquiera sabe bien las tablas de multiplicar, es una estupidez. Acabará financiando sólo ciencias aplicadas y no básicas porque busque resultados inmediatos, con lo que acabará siendo como tener un cuerpo pero sin sangre dentro.

Ahora la gente está tratando de formalizar la ciencia de una forma ridícula. ¡Número de citaciones! ¡Índice de impacto! Todo estos criterios formales me parecen basura, porque la gente se concentra en satisfacer estos criterios en lugar de hacer ciencia. Y todo el dinero que recibes depende de este sinsentido formal. La única evaluación de un trabajo científico debe ser la que hagan los colegas, no hay otra manera que la opinión de los expertos.

¿Y cómo motiva a sus jóvenes investigadores? Porque al final les van a exigir publicaciones.

No quiero obligar a nadie a la fuerza a venir a mi campo. Normalmente les digo que no hace falta que se dediquen a esto, salvo en el caso de que, si no lo hacen, el resto de su vida serán más infelices. Si pueden sobrevivir sin hacer física teórica les animo a dedicarse a otra cosa, su vida será más sencilla y ganarán más dinero y más fácilmente.

Insisto. Hay físicos jóvenes que quieren serlo pese a todo, pero aún así, lo que les piden es publicar y publicar.

Absolutamente. Todo el mundo comprende esto, hasta los niños. Nadie, de hecho, quiere decir no a esta dinámica, ¿entiende? Es un movimiento político. Por ejemplo, algo que odio, y obviamente no porque esté en contra de las mujeres, es cuando dicen que debe haber igualdad en el número de hombres y mujeres en física teórica. ¿Por qué no aplican la misma situación a la lingüística, donde el número de mujeres es superior? En astronomía ya estamos más o menos en un 50-50, ¿pero por qué los políticos no empiezan con ellos mismos? Creo que eso mejoraría muchísimo la calidad de la política si el Gobierno fuera en un 50% mujeres, pero cuando nos obligan a tener paridad en nuestros laboratorios están llevando la democracia al absurdo, ¿entiende? Porque hay esta tendencia a compensar a aquellas personas que fueron discriminadas en el pasado, pero la memoria de la gente nunca llega tan lejos. ¡Cien años! Lo que habría que hacer es olvidarse de ello y empezar con una base justa, sin redistribuir artificialmente los derechos como compensación, de esa forma la gente sería más razonable. También, fíjese que la mejor política actual es una mujer, Frau Merkel, ¡quien además fue física y de la Alemania Democrática! La mejor canciller que ha habido en Alemania, el único país donde los científicos no se quejan de no tener suficiente dinero para investigar. En Italia o en España la situación es catastrófica, porque sus políticos no entienden que la inversión en ciencia es ridícula, unos cuantos cientos de millones, ¡eso no es nada!

Mukhanov

Se está hablando mucho del futuro de la astronomía a raíz de la detección de las ondas gravitacionales. Ahora, el éxito de la misión de prueba LISA Pathfinder de la ESA parece indicar que el boom de esta nueva disciplina puede llegar antes de lo que pensábamos.

Verá, esta es la situación de las ondas gravitacionales. En primer lugar, uno no debería decir que el experimento LIGO detectó ondas gravitacionales, porque fueron detectadas mucho antes, en un sistema binario y con mucha más evidencia disponible. En este momento, sólo hay un evento que haya, digamos, superado el nivel de ruido. Cuando el evento es uno, no podemos hablar aún ni de estadística, ¿entiende? Por ejemplo, un acto de reencarnación es algo que no puede probarse ni desmentir que haya ocurrido. Cuando hablamos de física, algo debería convertirse en estadísticamente relevante.

Totalmente. Y volviendo a la pregunta…

La detección de ondas gravitacionales es una de las cosas más importantes actualmente en física fundamental. El experimento LIGO empezará pronto a trabajar con el detector italiano Virgo, lo que permitirá identificar con más exactitud de dónde proceden los eventos. Por otro lado, el proyecto LISA, previsto para 2034, está funcionando a la perfección por lo que espero que la ESA reconsidere sus planes y los adelante un poco. No hay muchas cosas por hacer en física fundamental, pero las ondas gravitacionales y la astronomía son los dos campos con un futuro más brillante.

¿Y a qué se van a dedicar estos investigadores de aquí a 2034?

Principalmente, a observar el llamado “universo local”, el que hay a nuestro alrededor. No es como las observaciones con radiación de fondo de microondas, en las que observas la radiación de cuando el universo sólo tenía 300.000 años, esto tiene más que ver con aprender cosas sobre detalles y procesos que están ocurriendo ahora en las galaxias. Ya sabemos mucho sobre lo que ocurre por aquí cerca, así que en 20 años sabremos mucho más.

¿Y cree que seremos capaces de detectar eventos más pequeños? Porque ahora necesitamos que dos agujeros negros enormes se fusionen para enterarnos.

Déjeme ser correcto, porque la mayoría de los periodistas toman estas cosas como un hecho probado, pero todavía debería estar más probado. ¿Por qué? Lo que vemos ahora mismo es una fusión de dos agujeros negros de 30 masas solares… eso no parece muy natural, ¿comprende? Porque desde el punto de vista de la astrofísica supone un gran dolor de cabeza explicar la existencia de este tipo de cosas, y sólo es un evento, ¿vale? Un poco por encima del nivel de ruido. Por tanto, ahora, que fueran dos agujeros negros parece, para la mayoría, la explicación más plausible. Pero antes de llegar a esta conclusión única deberíamos, en mi opinión, ver más eventos como este, para estar seguros que no la estamos jodiendo.

Es decir, seguir el método científico.

Sí, seguir el método científico, porque ahora, en el llamado “periodismo científico” parece haber una tendencia que yo llamo Tendencia Americana del McDonald’s en la que se trata de vender mierda a un precio muy alto, como usted ya sabe. En este sentido, el New York Times es espectacular. Escribí una vez a este Overbye…

¿Dennis Overbye, el corresponsal de astronomía y cosmología del Times?

Creo que ya no publica. Le escribí diciéndole: ‘Pensaba que el New York Times era más serio que periódicos soviéticos como Pravda, pero ahora no lo parece’. Fue porque armaron un escándalo con lo del BICEP, que ellos llamaban “el colapso del BICEP”, que fue dañino no sólo para los miembros del experimento sino para toda la comunidad de experimentalistas que llevaban 15 años trabajando muy duro.

[En 2014, el experimento BICEP2 del Centro de Astrofísica de Harvard lanzó un comunicado diciendo que habían detectado ondas gravitacionales primordiales, procedentes del Big Bang. Un análisis posterior del Instituto Max Planck de Alemania demostró que era una señal errónea causada por una nube de polvo galáctico].

Cuando salieron los resultados del Planck, todo lo que la gente quería saber es si el BICEP llevaba razón o no, omitiendo la detección más espectacular de una polarización, hecha por el Planck con un nivel de precisión increíble, pero a nadie le importó.

Entiendo.

Usted entiende lo que digo. Por tanto, uno tiene que ser cuidadoso al formular ese tipo de cosas. Por supuesto, un científico tiene que trabajar para el público pero no todo lo que interesa al público es interesante para la ciencia. Me gusta hablar con escolares, ese es mi culmen. Es bueno inspirar a las nuevas generaciones para que se dediquen a la ciencia, pero el resto de la sociedad no debe olvidar que cualquier cosa que tienen, todos esos dispositivos, es gracias a la ciencia.

Mar

16

En el Universo: Todo lo que podamos imaginar y mucho más

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Materia extraña ~

Clasificado en Materia extraña ~

Comments (0)

Comments (0)

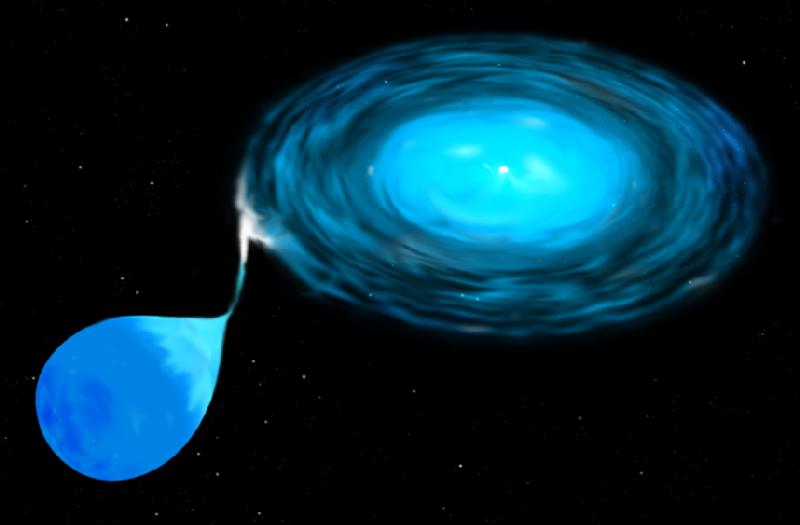

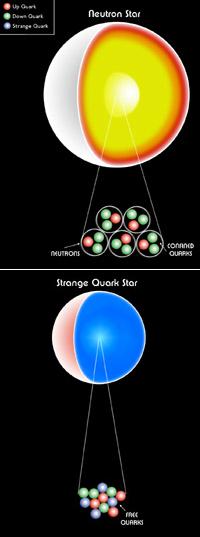

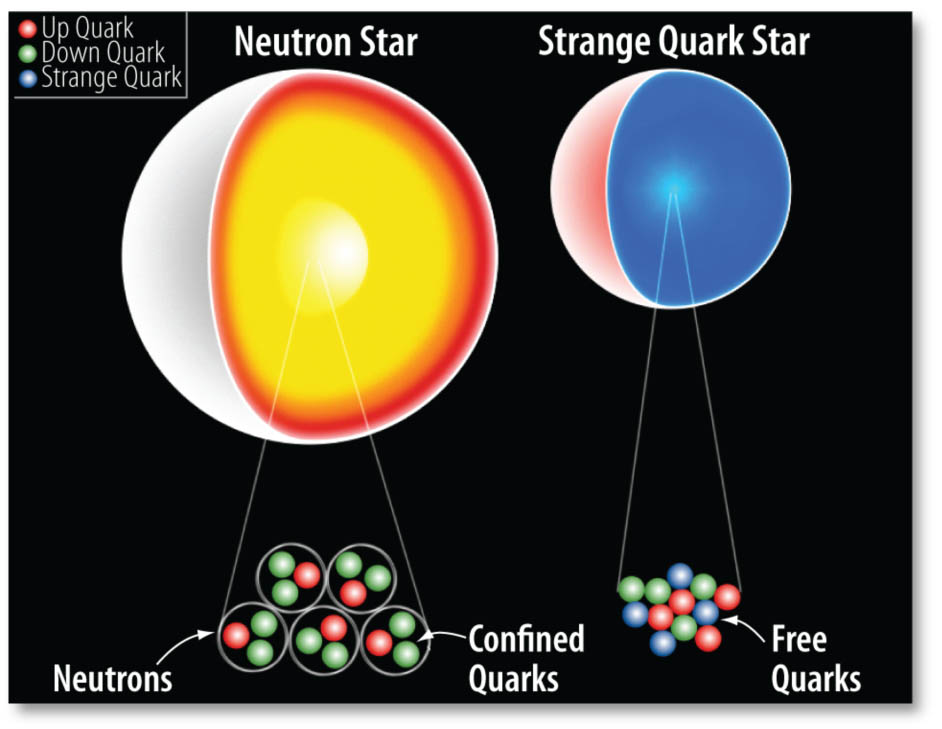

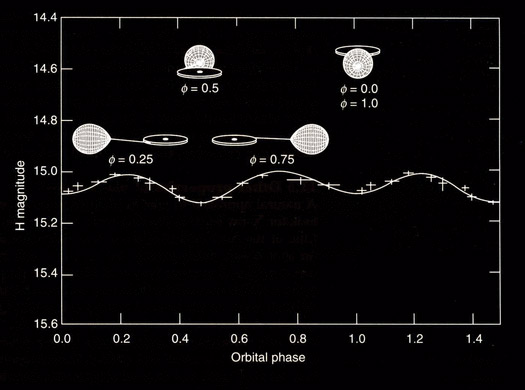

Si el radio de cada estrella es menor que el lóbulo de Roche, las estrellas están desconectadas. Por el contrario, si una de ellas llena el lóbulo de Roche, el sistema es semiconectado y la materia puede fluir a través del punto de Lagrange interno. El potencial gravitatorio de un sistema binario se consume la masa de la estrella compañera. Cuando la masa de la EN alcanza el valor de ~2 M (M corresponde a la masa solar), sufre un colapso gravitatorio, pudiéndose transformar en una EQ.

¿Podría el colapso de una supernova dar origen a la formación de una EQ? Esta pregunta nos conduce a otra hipótesis teórica acerca de la formación de la EN, hay conservación del momento angular. La proto-estrella de neutrones tiene una fracción pequeña de su radio original, que era el de la supernova, por lo que su momento de inercia se reduce bruscamente. Como resultado, la EN se forma con una altísima velocidad de rotación que disminuye gradualmente. Los períodos de rotación se hacen cada vez más largos debido a la pérdida de energía rotacional por la emisión de vientos de electrones y positrones y de la radiación bipolar electromagnética. Cuando la alta frecuencia de rotación o el campo electromagnético alcanzan un valor crítico, la EN se transforma en un pulsar que emite pulsos del orden de los milisegundos. Debido a la enorme fuerza centrífuga en estos objetos, la estructura interna se modifica, pudiendo alcanzar una densidad crítica por encima de la que corresponde a la transición de fase hadrón-quark. En estas condiciones, la fase de materia nuclear relativamente incomprensible se convertiría en la fase de ME, más comprensible, cuyo resultado final sería la aparición de una EQ.

La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos. Todas estas propiedades dependen de una única ecuación de estado para la materia densa de quarks que aún no ha sido completamente establecida. Sin embargo, existe un rango de valores aceptados para las cantidades antes mencionadas, con base en datos observacionales recientes, que marcarían importantes diferencias entre las posibles EQs y los demás objetos compactos.

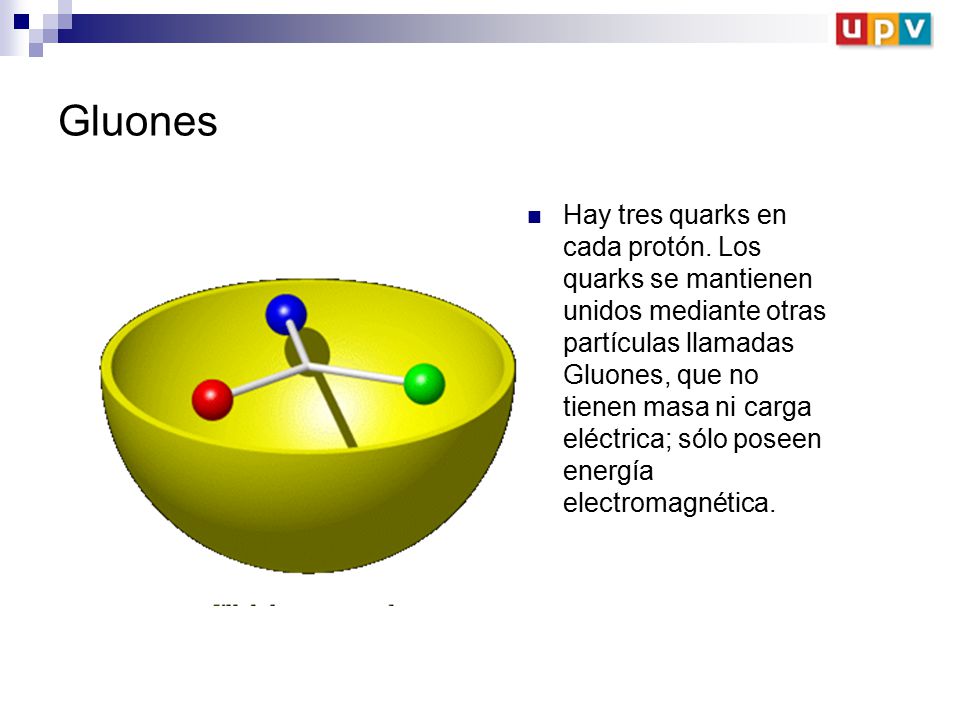

“La interacción fuerte, también conocida como interacción nuclear fuerte, es la interacción que permite unirse a los quarks para formar hadrones. La interacción electromagnética se da entre partículas cargadas eléctricamente, aquí las partículas también tienen carga, la carga de color. A pesar de su fuerte intensidad, su efecto sólo se aprecia a distancias muy cortas del orden del radio atómico. Según el modelo estándar, la partícula mediadora de esta fuerza es el gluón.4 La teoría que describe a esta interacción es la cromodinámica cuántica (QCD) y fue propuesta por David Politzer, Frank Wilczek y David Gross en la década de 1980.”

Para cualquier valor de radiación que supere este límite, no habrá equilibrio hidrostático, causando la pérdida de masa de la estrella normal. El mecanismo de emisión en una EQ produciría luminosidades por encima de dicho límite. Una posible explicación a este hecho sería que la EQ es autoligada y por lo tanto su superficie alcanzaría temperaturas altísimas con la consecuente emisión térmica.

Por otro lado, una alternativa para explicar algunas observaciones de destellos de rayos γ, sería suponer que las emisiones provienen de Eqs con radios R ~ 6 km, valores demasiados pequeños si pensáramos que los destellos provienen de ENs.

Las estrellas de Quarks (si existen) estarían entre la de neutrones y los agujeros negros

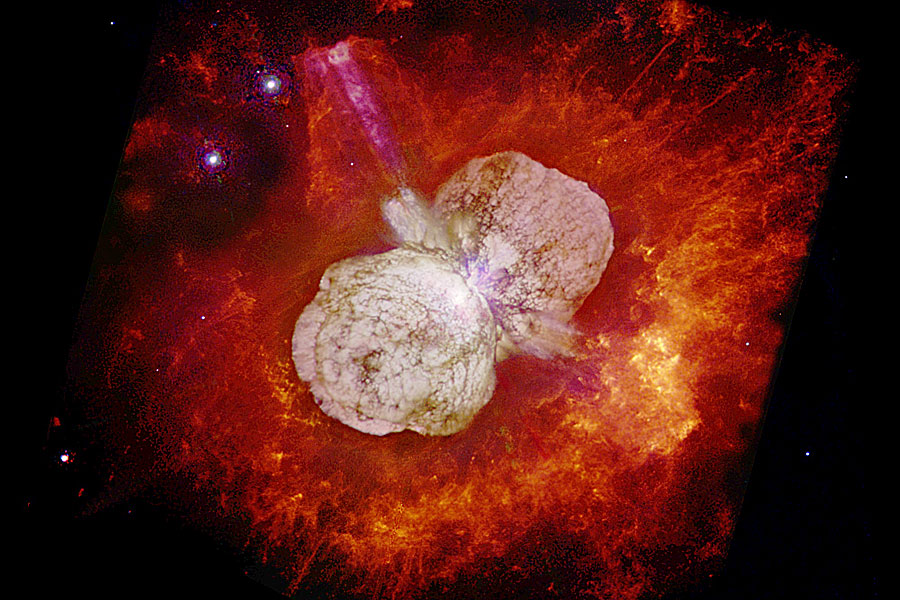

Un rasgo característico de las EQs es que la materia no se mantendría unida por la atracción gravitacional, como ocurre en las ENs, sino que sería consecuencia directa de la interacción fuerte entre los quarks. En este caso, la estrella se dice autoligada. Esto implica una diferencia sustancial entre las ecuaciones de estado para las dos clases de estrellas. Las correcciones perturbativas a la ecuación de estado de la materia de quarks y los efectos de superconductividad de color complican aun más este punto. Otra característica para poder diferenciar las Eqs de las Ens es la relación entre su masa M y el radio R. Mientras que para una EQ, M ~ R³. De acuerdo con esta relación, las Eqs tendrían radios más pequeños que los que usualmente se le atribuyen a las Ens. Además, las Eqs violarían el llamado límite de Eddington. Arthur Eddington (1882-1994) observó que las fuerzas debido a la radiación y a la gravitación de las estrellas normales dependían del inverso del cuadrado de la distancia. Supuso, entonces, que ambas fuerzas podían estar relacionadas de algún modo, compensándose para que la estrella fuera más estable. Para estrellas de altísima masa, la presión de radiación es la dominante frente a la gravitatoria. Sin embargo, debería existir una presión de radiación máxima para la cual la fuerza expansiva debido a la radiación se equilibrara con la gravedad local. Para una estrella normal, el límite de Eddington está dado por una ecuación que omito para no hacer más complejo el tema.

Eta Carinae es una buena muestra de cómo el límite de Eddintong funciona

Para cualquier valor de radiación que supere este límite, no habrá equilibrio hidrostático, causando la pérdida de masa de la estrella normal. El mecanismo de emisión en una EQ produciría luminosidades por encima de dicho límite. Una posible explicación a este hecho sería que la EQ es autoligada y por lo tanto su superficie alcanzaría temperaturas altísimas con la consecuente emisión térmica.

Por otro lado, una alternativa para explicar algunas observaciones de destellos de rayos γ, sería suponer que las emisiones provienen de Eqs con radios R ~ 6 km, valores demasiados pequeños si pensáramos que los destellos provienen de ENs. En esta sección, hemos presentado algunas características de las Eqs que las diferenciarían de las Ens. Futuras evidencias experimentales y observacionales nos permitirían saber si las Eqs realmente existen en la naturaleza.

El mes de febrero de 1987 fue la primera oportunidad de poner a prueba, a través de las observaciones directas, las teorías modernas sobra la formación de las supernovas. En el observatorio de Las Campanas, en Chile, fue observada la Supernova 1987A en la Gran Nube de Magallanes. Algunas características de la emisión de neutrinos de la SN 1987A, podrían explicarse sin una hipotética fuente de energía subnuclear como la Materia Extraña contribuyera a su explosión. El remanente estelar que ha quedado como consecuencia de la explosión de la Supernova 1987A, podría ser una Estrella de Quarks, ya que el período de emisión de este pulsar es de P= 0.5 ms. Una Estrella de Neutrones canónica no podría tener una frecuencia de rotación tan alta.

Supernova SN 1987A: ue una supernova que tuvo lugar en las afueras de la Nebulosa de la Tarántula (NGC 2070), situada en la Gran Nube de Magallanes, galaxia enana cercana perteneciente al Grupo Local. Ocurrió aproximadamente a 168.000 años luz (51,4 kiloparsecs) de la Tierra,1 lo suficientemente cerca para ser visible a simple vista. Fue la supernova más cercana observada desde SN 1604, que apareció en la Vía Láctea. La luz de la supernova llegó a la Tierra el 23 de febrero de 1987. Como fue la primera supernova descubierta en 1987, fue designada “1987A”

El observatorio Chandra de rayos X de la NASA también encontró dos estrellas inusuales: la fuente RX J1856.5-3754 con una temperatura de 10 exp5. K y la fuente 3C58 con un período de 65 ms. RX J1856.5-3754 es demasiado pequeña para ser una EN convencional y 3C58 parece haberse enfriado demasiado rápido en el tiempo de vida que se le estima.

Combinando los datos del Chandra y del telescopio espacial Hubble, los astrónomos determinaron que RX J1856. 5 – 3754 radia como si fuera un cuerpo sólido con una temperatura de unos 1x 10 exp5. ºC y que tiene un diámetro de alrededor de 11 km, que es un tamaño demasiado pequeño como para conciliarlo con los modelos conocidos de las Ens.

Las observaciones realizadas por el Chandra sobre 3C58 también produjeron resultados sorprendentes. No se pudo detectar la radiación que se esperaba en la superficie de 3C58, una EN que se cree producto de la explosión de una supernova vista por astrónomos japoneses y chinos en el año 1181 de nuestra era. Se llegó a la conclusión de que la temperatura de la estrella, de menos de un millón de grados Celsius, era un valor mucho menor que el que predice el modelo. Estas observaciones incrementan la posibilidad de que los objetos estelares mencionados sean Eqs.

D) Ecuación de estado para la materia de quarks:

Las técnicas utilizadas para resolver las ecuaciones de la Cromo Dinámica Cuántica no proveyeron aún un resultado aceptable para densidades bariónicas finitas como en el caso de la Electrodinámica Cuántica para el núcleo atómico. Como consecuencia, es necesario recurrir a modelos fenomenológicos para describir la materia de quarks dentro de las estrellas compactas cuando se consideran las propiedades de confinamiento y de libertad asintótica de la CDC. Uno de los modelos más usados es el modelo bag del MIT. En este modelo los hadrones son considerados como quarks libres confinados en una región finita del espacio: el “Bag“ o bolsa. El confinamiento no es un resultado dinámico de la teoría fundamental, sino que se coloca como parámetro libre, imponiendo condiciones de contorno apropiadas. Así, el modelo bag del MIT se basa en una realización fenomenológica del confinamiento.

Está claro que, las estrellas de Quarks, aunque con certeza no han sido aún detectadas, es casi seguro que andarán pululando por el inmenso Universo que, en relación a la materia bariónica, en muy buena parte, está conformado por Quarks y, cuando la Gravedad confina a los electrones y protones hasta fusionarlos para convertirlos en neutrones a pesar del principio de esxclusión de Pauli, si la masa de la estrella es muy grande y como consecuencia la gravedad que genera también lo es, ni ese principio que haría degenerar a los electrones, podría al fín, para esa fuerza que contraerá más y más la masa de la estrella y, entonces, antes de que se pudiera convertir en un agujero negro… ¿No lo haría en una estrella de quarks?

De existir, al ser más densa, la estrella de Quarks estaria entre la de N y el A.N.

Recientemente, la relación entre campo magnéticos y materia densa está atrayendo la atención de los astrofísicos, especialmente después de las observaciones de emisiones peculiares de pulsares anómalos de rayos X, que se interpretan como ENs en rotación, y de emisiones de radiación γ de baja energía de los llamados repetidores de rayos γ suaves ( SGRs – soƒt gamma-ray repeaters ). El motor central de esas radiaciones podría ser un campo magnético mayor que 4 x 10¹³ Gauss, que es el campo crítico previsto por la Electrodinámica Cuántica.

Muchas observaciones astronómicas indirectas sólo se explicarían a través de la existencia de campos magnéticos muy intensos en los núcleos de ENs en EQs, de manera que el papel que juega el campo magnético en la ME aún constituye un problema abierto y de sumo interés en la Astrofísica.

Son muchos los misterios quen contiene el Universo y, nosotros, debemos recorrer los caminos para desvelarlos. En la superconductividad electromagnética usual, un campo magnético suficientemente fuerte destruye el estado superconductor. Para la superconductividad de color no existe aún un consenso de cómo, la presencia del campo magnético, podría afectar al apareamiento entre los quarks.

Existen trabajos que describen de manera breve la materia extraña, con el objetivo de explicar su formación en el interior de una EN y entender la composición y características de una Estrella de Quarks. Han utilizado el modelo fenomenológico de bag del Massachussets Institute of Technology (MIT) para encontrar las ecuaciones de estado de la ME en condiciones determinadas, comprobando la estabilidad de la misma, frente a la materia de quarks ordinaria formada sólo por quarks u y d. Y piensan presentar, además, algunas candidatas posibles a EQs según observaciones astrofísicas. Por último, trataran de entender la superconductividad de color y la influencia del campo magnético intenso en las fases superconductoras.

Ya se especula con la existencia cierta de estrellas de Quarks y, cuando el río suena…

Materia de Quarks:

Materia extraña

Uno de los mayores logros alcanzados por los físicos en el último siglo, fue la construcción del Modelo Estándar en la física de partículas elementales. Este modelo sostiene que la materia en el Universo está compuesta por fermiones, divididos en quarks y leptones, que interactúan a través de los llamados bosones de calibre: el fotón (interacción electromagnética), los bosones W± y Zº (interacción débil), y 8 tipos de gluones (interacción fuerte). Junto con los bosones de calibre, existen tres generaciones de fermiones: ( v e, e ), u, d ); ( vµ, µ ), ( c, s ) ; ( v….); y sus respectivas antipartículas. Cada “ sabor “ de los quarks, up ( u ), down ( d ), charme ( c ), strange ( s , top ( t ) y bottom ( b), tiene tres colores ( el color y el sabor son números cuánticos ). La partícula que aún no ha sido descubierta experimentalmente es el bosón de Higgs, que cabe suponer sería responsable del origen de la masa de las partículas.

La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos.

Los quarks son los componentes fundamentales tanto de los hadrones fermiónicos (bariones formados por la combinación de tres quarks) como de los bosónicos (mesones formados por un quark y un antiquark). Es sabido que el núcleo de un átomo está compuesto por nucleones (protones y neutrones) que a su vez están compuestos por quarks (protón = udd). David Gross y Franks Wilczek y David Politzer, descubrieron teóricamente que en la CDC el acoplamiento efectivo entre los quarks disminuye a medida que la energía entre ellos aumenta (libertad asintótica). La elaboración de esta teoría permitió que recibieran el Premio Nobel de Física en el año 2004. En los años 60, la libertad asintótica fue comprobada experimentalmente en el Acelerador lineal de Stanford y otros después.

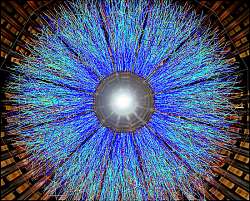

Plasma de Quarks – Gluones

Todos querían estar presentes en el evento que nos llevó a comprobar la certeza de que la libertad asintótica era una realidad física presente en la fuerza nuclear fuerte y que hace que, los quarks, estén confinados dentro de protones y neutrones y, cuando tratan de separarse, aparece la fuerza intensa que lo impide. Por el contrario, cuando permanecen juntos, está presente la libertad asintótica que los hace creer que son libres.

Sin embargo, la CDC no describe completamente el deconfinamiento en un régimen de alta densidad y baja temperatura, debido a su complejidad matemática y a su naturaleza no lineal para bajas energías. No obstante, es posible recurrir a una descripción fenomenológica para intentar entender la física de la formación de la materia de quarks en las ENs. La materia de quarks, es decir, el plasma de quarks deconfinados y gluones, es una consecuencia directa de la libertad asintótica cuando la densidad bariónica o la temperatura son suficientemente altas como para considerar que los quarks son partículas más fundamentales que los neutrones o protones. Esta materia, entonces, dependiendo de la temperatura y del potencial químico (µ) de los quarks, aparecería esencialmente en dos regímenes. Uno de ellos, el PQG, constituiría la fase “caliente” de la materia de quarks cuando T >> µ constituyendo la mencionada ME, que se formaría en el interior de las Ens. Esta transición de fase estaría ocurriendo en el Universo cada vez que una estrella masiva explotara en forma de supernova, con la consecuente aparición de una EN.

Mucho nos quewda que hablar de todos estos temas complejos con los que aún luchamos tratando de comprender y de los que, hablamos más por intuición y conjeturas que por la certeza del saber. Sin embargo, nuestros incipientes conocimientos en la materia, avalan, al menos, una gran posibilidad de que las estrellas de Quarks sean un hecho.

emilio silvera

Mar

16

¡Los materiales para la vida! Y, de los mundos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Química de la Vida ~

Clasificado en El Universo y la Química de la Vida ~

Comments (0)

Comments (0)

¿Será así la espuma cuántica?

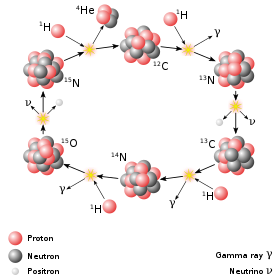

Los elementos se crean en las estrellas y en las explosiones supernovas

¡La Física! Cuando se asocia a otras disciplinas ha dado siempre un resultado espectacular y, en el caso de la Astronomía, cuando se juntó con la Física, surgió esa otra disciplina que llamamos Astrofísica. La Astrofísica es esa nueva rama de la Astronomía que estudia los procesos físicos y químicos en los que intervienen los fenómenos astronómicos. La Astrofísica se ocupa de la estructura y evolución estelar (incluyendo la generación y transporte de energía en las estrellas), las propiedades del medio interestelar y sus interacciones en sus sistemas estelares y la estructura y dinámica de los sistemas de estrellas (como cúmulos y galaxias) y sistemas de galaxias. Se sigue con la Cosmología que estudia la naturaleza, el origen y la evolución del universo. Existen varias teorías sobre el origen y evolución del universo (big bang, teoría del estado estacionario, etc.

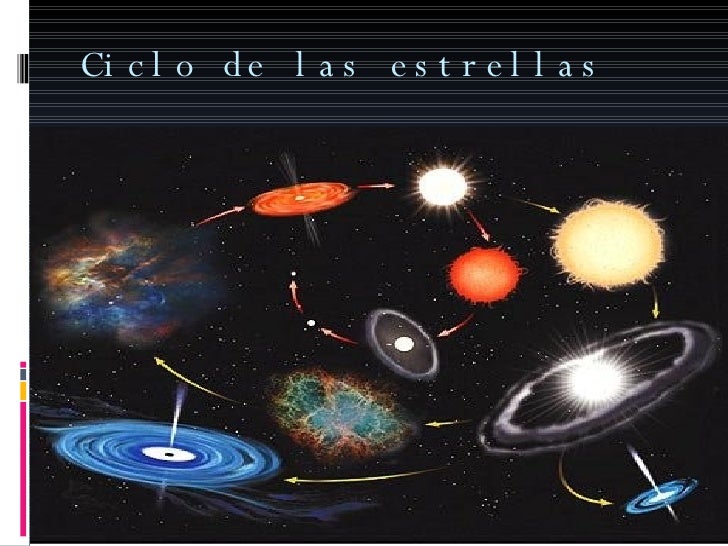

Las estrellas, como todo en el Universo, no son inmutables y, con el paso del Tiempo, cambian para convertirse en objetos diferenters de los que, en un principio eran. Por el largo trayecto de sus vidas, transforman los materiales simples en materiales complejos sobre los que se producen procesos biológico-químicos que, en algunos casos, pueden llegar hasta la vida.

Una de las cosas que siempre me han llamado poderosamente la atención, han sido las estrellas y las transformaciones que, dentro de ellas y los procesos que en su interior se procesan, dan lugar a las transiciones de materiales sencillos hacia materiales más complejos y, finalmente, cuando al final de sus vidas expulsan las capas exteriores al espacio interestelar dejando una extensa región del espacio interestelar sembrada de diversas sustancias que, siguiendo los procesos naturales e interacciones con todo lo que en el lugar está presente, da lugar a procesos químicos que transforman esas sustancias primeras en otras más complejas, sustancias orgánicas simples como, hidrocarburos y derivados que, finalmente, llegan a ser los materiales necesarios para que, mediante la química-biológica del espacio, den lugar a moléculas y sustancias que son las propicias para hacer posible el surgir de la vida.

La Química de los Carbohidratos es una parte de la Química Orgánica que ha tenido cierta entidad propia desde los comienzos del siglo XX, probablemente debido a la importancia química, biológica (inicialmente como sustancias de reserva energética) e industrial (industrias alimentaria y del papel) de estas sustancias. Ya muy avanzada la segunda mitad del siglo XX han ocurrido dos hechos que han potenciado a la Química de Carbohidratos como una de las áreas con más desarrollo dentro de la Química Orgánica actual.

Todos los animales, plantas y microbios están compuestos fundamentalmente, por las denominadas sustancias orgánicas. Sin ellas, la vida no tiene explicación (al menos que sepamos). De esta manera, en el primer período del origen de la vida tuvieron que formarse dichas sustancias, o sea, surgimiento de la materia prima que más tarde serviría para la formación de los seres vivos.

La característica principal que diferencia a las sustancias orgánicas de las inorgánicas, es que en el contenido de las primeras se encuentra como elemento fundamental el Carbono.

En las sustancias orgánicas, el carbono se combina con otros elementos: hidrógeno y oxígeno (ambos elementos juntos forman agua), nitrógeno (este se encuentra en grandes cantidades en el aire, azufre, fósforo, etc. Las distintas sustancias orgánicas no son más que las diferentes combinaciones de los elementos mencionados, pero en todas ellas, como elemento básico, siempre está el Carbono.

En el primer nivel (abajo) están los productores, o sea las plantas como maíz, frijol, papaya, cupesí, mora, yuca, árboles, hierbas, lianas, etc., que producen hojas, frutas, raíces, semillas, que comen varios animales y la gente.

En el segundo nivel están los primeros consumidores, que comen hierbas, hojas (herbívoros) y frutas (frugívoros). Estos primeros consumidores incluyen a insectos como hormigas, aves como loros y mamíferos como ratones, urina, chanchos, chivas, vacas.

En el tercer nivel están los segundos consumidores (carnívoros), es decir los que se comen a los animales del segundo nivel: por ejemplo el oso bandera come hormigas, el jausi come insectos y la culebra come ratones.

Nosotros, los humanos, somos omnívoros, es decir comemos de todo: plantas y animales. Algunos de los carnívoros comen, a veces, plantas también, como los perros. Otros, como el chancho, comen muchas plantas y a veces también carne.

Las sustancias orgánicas más sencillas y elementales son los llamados hidrocarburos o composiciones donde se combinan el Oxígeno y el Hidrógeno. El petróleo natural y otros derivados suyos, como la gasolina, el keroseno, etc., son mezcolanzas de varios hidrocarburos. Con todas estas sustancias como base, los químicos obtienen sin problemas, por síntesis, gran cantidad de combinados orgánicos, en ocasiones muy complejos y otras veces iguales a los que tomamos directamente los seres vivos, como azúcares, grasas, aceites esenciales y otros. Debemos preguntarnos como llegaron a formarse en nuestro planeta las sustancias orgánicas.

![]()

Está claro que, para los iniciados en estos temas, la cosa puede parecer de una complejidad inalcanzable, nada menos que llegar a comprender ¡el origen primario de las sustancias orgánicas!

Es nuestro planeta y el único habitado (hasta donde podemos saber). Está en la ecosfera, un espacio que rodea al Sol y que tiene las condiciones necesarias para que exista vida. Claro que, ¡son tantos los mundos! Cómo vamos a ser nosotros nos únicos que poblemos el Universo? ¡Que despercidicio de espacio!

La observación directa de la Naturaleza que nos rodea nos puede facilitar las respuestas que necesitamos. En realidad, si ahora comprobamos todas las sustancias orgánicas propias de nuestro mundo en relación a los seres vivos podemos ver que, todas, son producidas hoy día en la Tierra por efecto de la función activa y vital de los organismos.

Las plantas verdes absorben el carbono inorgánico del aire, en calidad de anhídrido carbónico, y con la energía de la luz crean, a partir de éste, sustancias orgánicas necesarias para ellas. Los animales, los hongos, también las bacterias y el resto de organismos, menos los de color verde, se alimentan de animales o vegetales vivos o descomponiendo estos mismos, una vez muertos, pueden proveerse de las sustancias orgánicas que necesitan. Con esto, podemos ver como todo el mundo actual de los seres vivos depende de los dos hechos análogos de fotosíntesis y quimiosíntesis, aplicados en las líneas anteriores.

Incluso las sustancias orgánicas que se encuentran bajo tierra como la turba, la hulla o el petróleo, han surgido, básicamente, por efecto de la acción de diferentes organismos que en un tiempo remoto se encontraban en el planeta Tierra y que con el transcurrir de los siglos quedaron ocultos bajo la maciza corteza terrestre.

Todo esto fue causa de que muchos científicos de finales del siglo XIX y principios del XX, afirmaran que era imposible que las sustancias orgánicas produjeran en la Tierra, de forma natural, solamente mediante un proceso biogenético, o sea, con la única intervención de los organismos. Esta opinión predominante entre los científicos de hace algunas décadas, constituyó un obstáculo considerable para hallar una respuesta a la cuestión del origen de la vida.

Para tratar esta cuestión era indispensable saber cómo llegaron a constituirse las sustancias orgánicas; pero ocurría que éstas sólo podían ser sintetizadas por organismos vivos. Sin embargo, únicamente podemos llegar a esta síntesis si nuestras observaciones no van más allá de los límites del planeta Tierra. Si traspasamos esa frontera nos encontraremos con que en diferentes cuerpos celestes de nuestra Galaxia se están creando sustancias orgánicas de manera abiogenética, es decir, en un ambiente que excluye cualquier posibilidad de que existan seres orgánicos en aquel lugar.

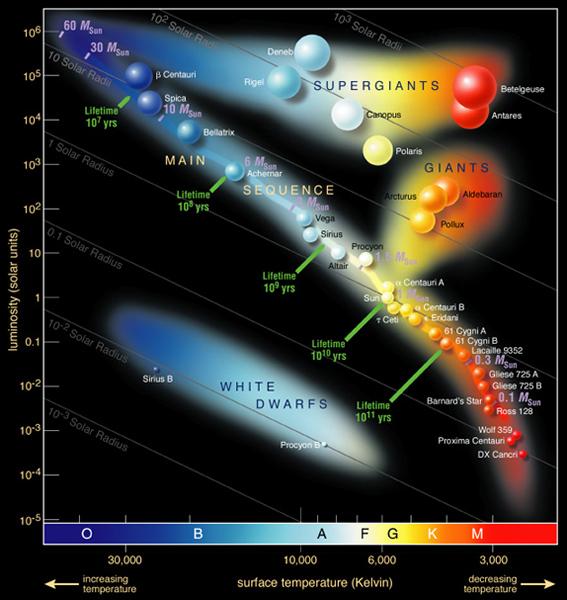

Estrella de carbono (estrella gigante roja) R. Lepori

Con un espectroscopio podemos estudiar la fórmula química de las atmósferas estelares, y en ocasiones casi con la misma exactitud que si tuviéramos alguna muestra de éstas en el Laboratorio. El Carbono, por ejemplo, se manifiesta ya en las atmósferas de las estrellas tipo O, que son las que están a mayor temperatura, y su increíble brillo es lo que las diferencia de los demás astros (Ya os hablé aquí de R. Lepori, la estrella carmesí, o, también conocida como la Gota de Sangre, una estrella de Carbono de increíble belleza).

En la superficie de las estrellas de Carbono existe una temperatura que oscila los 20.000 y los 28.000 grados. Es comprensible, entonces, que en esa situación no pueda prevalecer aún alguna combinación química. La materia está aquí en forma relativamente simple, como átomos libres disgregados, sueltos como partículas minúsculas que conforman la atmósfera incandescente de estos cuerpos estelares.

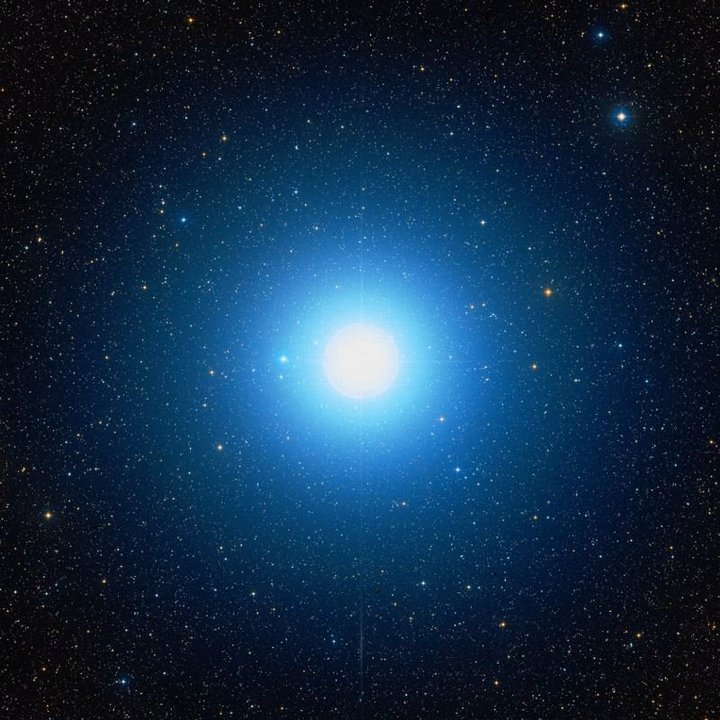

Regulus A, es una estrella blanco-azulada, de tipo espectral B7, que se encuentra, como nuestro Sol, en la secuencia principal, lo que significa que aún está en la fase de fusión nuclear de hidrógeno en helio, de donde proviene su energíaRegulus A, es una estrella blanco-azulada.

La atmósfera de las estrellas tipo B, característica por su luz brillante blanco-azulada y cuya corteza tiene una temperatura que va de 15.000 a 20.000 grados, también tienen vapores incandescentes de carbono. Pero aquí este elemento tampoco puede formar cuerpos químicos compuestos, únicamente existe en forma atómica, o sea, en forma de pequeñísimas partículas sueltas de materia que se mueven a una velocidad de vértigo.

Sólo la visión espectral de las estrellas Blancas tipo A, en cuya superficie hay una temperatura de unos 12.000º, muestras unas franjas tenues, que indican, por primera vez, la presencia de hidrocarburos –las más primitiva combinaciones químicas de la atmósfera de estas estrellas. Aquí, sin que existan antecedentes, los átomos de dos elementos (el carbono y el hidrógeno) se combinan resultando un cuerpo más perfecto y complejo, una molécula química.

Observando las estrellas más frías, las franjas características de los hidrocarburos son más limpias cuando más baja es la temperatura y adquieren su máxima claridad en las estrellas rojas, en cuya superficie la temperatura nunca es superior a los 4.000º.

Es curioso el resultado obtenido de la medición de Carbono en algunos cuerpos estelares por su temperatura:

- Proción: 8.000º

- Betelgeuse: 2.600º

- Sirio: 11.000º

- Rigel: 20.000º

Las imágenes os la muestran por el mismo orden de la lista.

Como es lógico pensar, las distintas estrellas se encuentran en diferentes períodos de desarrollo. El Carbono se encuentra presente en todas ellas, pero en distintos estados del mismo.

Las estrellas más jóvenes, de un color blanco-azulado son a la vez las más calientes. Éstas poseen una temperatura muy elevada, pues sólo en la superficie se alcanzan los 20.000 grados.

Los científicos descubrieron una enorme cantidad de silicatos cristalinos e hidrocarburos policíclicos aromáticos, dos sustancias que indican la presencia de oxígeno y de carbono, respectivamente. Así todos los elementos que las componen, incluido el Carbono, están en forma de átomos, de diminutas partículas sueltas. Existen estrellas de color amarillo y la temperatura en su superficie oscila entre los 6.000 y los 8.000º. En estas también encontramos Carbono en diferentes combinaciones.

El Sol, pertenece al grupo de las estrellas amarillas y en la superficie la temperatura es de 6.000º. El Carbono en la atmósfera incandescente del Sol, lo encontramos en forma de átomo, y además desarrollando diferentes combinaciones: Átomos de Carbono, Hidrógeno y Nitrógeno, Metino, Cianógeno, Dicaerbono, es decir:

- Átomos sueltos de Carbono, Hidrógeno y Nitrógeno.

- Miscibilidad combinada de carbono e hidrógeno (metano)

- Miscibilidad combinada de carbono y nitrógeno (cianógeno); y

- Dos átomos de Carbono en combinación (dicarbono).

En las atmósferas de las estrellas más calientes, el carbono únicamente se manifiesta mediante átomos libres y sueltos. Sin embargo, en el Sol, como sabemos, en parte, se presenta ya, formando combinaciones químicas en forma de moléculas de hidrocarburo de cianógeno y de dicarbono.

Para hallar las respuestas que estamos buscando en el conocimiento de las sustancias y materiales presentes en los astros y planetas, ya se está realizando un estudio en profundidad de la atmósfera de los grandes planetas del Sistema solar. Y, de momento, dichos estudios han descubierto, por ejemplo, que la atmósfera de Júpiter está formada mayoritariamente por amoníaco y metano. Lo cual hace pensar en la existencia de otros hidrocarburos. Sin embargo, la masa que forma la base de esos hidrocarburos, en Júpiter permanece en estado líquido o sólido a causa de la abaja temperatura que hay en la superficie del planeta (135 grados bajo cero). En la atmósfera del resto de grandes planetas se manifiestan estas mismas combinaciones.

Ha sido especialmente importante el estudio de los meteoritos, esas “piedras celestes” que caen sobre la Tierra de vez en cuando, y que provienen del espacio interplanetario. Estos han representado para los estudiosos los únicos cuerpos extraterrestres que han podido someter a profundos análisis químico y mineralúrgico, de forma directa. Sin olvidar, en algunos casos, los posibles fósiles.

Estos meteoritos están compuestos del mismo material que encontramos en la parte más profunda de la corteza del planeta Tierra y en su núcleo central, tanto por el carácter de los elementos que los componen como por la base de su estructura. Es fácil entender la importancia capital que tiene el estudio de los materiales de estas piedras celestes para resolver la cuestión del origen de las primitivas composiciones durante el período de formación de nuestro planeta que, al fin y al cabo, es la misma que estará presente en la conformación de otros planetas rocosos similares al nuestro, ya que, no lo olvidemos, en todo el universo rigen las mismas leyes y, la mecánica de los mundos y de las estrellas se repiten una y otra vez aquí y allí, a miles de millones de años-luz de nosotros.

Así que, se forman hidrocarburos al contactar los carburos con el agua. Las moléculas de agua contienen oxígeno que, combinado con el metal, forman los hidróxidos metálicos, mientras que el hidrógeno del agua mezclado con el carbono forman los hidrocarburos.

Los hidrocarburos originados en la atmósfera terrestre se mezclaron con las partículas de agua y amoníaco que en ella existían, creando sustancias más complejas. Así, llegaron a hacerse presentes la formación de cuerpos químicos. Moléculas compuestas por partículas de oxígeno, hidrógeno y carbono.

Todo esto desembocó en el saber sobre los Elementos que hoy podemos conocer y, a partir de Mendeléiev (un eminente químico ruso) y otros muchos…se hizo posible que el estudio llegara muy lejos y, al día de hoy, podríamos decir que se conocen todos los elementos naturales y algunos artificiales que, nos llevan a tener unos valiosos datos de la materia que en el universo está presente y, en parte, de cómo funciona cuando, esas sustancias o átomos, llegan a ligarse los unos con los otros para formar, materiales más complejos que, aparte de los naturales, están los artificiales o transuránicos.

Aquí en la Tierra, las reacciones de hidrocarburos y sus derivados oxigenados más simples con el amoníaco generaron otros cuerpos con distintas combinaciones de átomos de carbono, hidrógeno, oxígeno y nitrógeno (CHON) en su moléculas llamadas paras la vida una vez que, más tarde, por distintos fenómenos de diversos tipos, llegaron las primeras sustancias proteínicas y grasas que, dieron lugar a los aminoácidos, las Proteínas y el ADN y RDN que, finalmente desembocó en eso que llamamos vida y que, evolucionado, ha resultado ser tan complejo y, a veces, en ciertas circunstancias, peligroso: ¡Nosotros!

emilio silvera

Mar

16

El acontecimiento se acerca

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El primer contacto ~

Clasificado en El primer contacto ~

Comments (0)

Comments (0)

¿Hemos detectado el sistema que impulsa a las naves alienígenas?

Investigadores del Instituto Harvard -Smithsonian creen que los destellos rápidos de radio, o FRBs, pueden estar causados por tecnología extraterrestre.

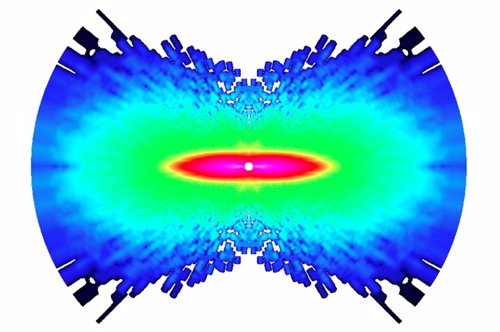

Así harían funcionar los aliens sus naves interestelares – M. Weiss/CfA

Los Fast Radio Burst (FRBs o destellos rápidos de radio) están entre las señales más misteriosas de todo el Universo. Se trata de fenómenos astrofísicos de muy alta energía, que se manifiestan como brevísimos pulsos de radio, de apenas unos pocos milisegundos de duración pero increíblemente brillantes y cuyo origen se encuentra fuera de nuestra propia galaxia. Ahora, un equipo de investigadores se pregunta si esos destellos podrían estar siendo emitidos por civilizaciones extraterrestres.

En un artículo recién aparecido en arxiv.org, Manasvi Lingam y Abraham Loeb, dos astrofísicos del centro de Astrofísica Harvard-Smithsonian, exploran la posibilidad de que los FRBs estén siendo causados por la actividad de civilizaciones extragalácticas. “Nuestros análisis -reza el artículo- muestran que los haces utilizados para impulsar grandes velas espaciales podrían producir parámetros que son consistentes con los FRBs”. En otras palabras, los breves e intensos destellos percibidos desde la Tierra podrían deberse a una tecnología alienígena avanzada. Y, en concreto, podría tratarse de “fugas” de gigantescos transmisores (de tamaño planetario) con los que esas civilizaciones impulsan sondas interestelares en sus viajes a través de galaxias lejanas.

Recordemos que un sistema muy parecido ha sido propuesto aquí, en la Tierra, por un equipo de científicos en el que se encuentra Stephen Hawking (Proyecto Starshot), para enviar una flotilla de minúsculas naves a vela impulsadas por laser a la estrella Próxima Centauri. Las mininaves podrían alcanzar de esta forma una velocidad del 20% de la de la luz.

“Dada su corta duración y la gran distancia de la que proceden -explica Loeb- Los FRBs son mucho más brillantes de lo que deberían, y no hemos conseguido hasta ahora identificar una posible fuente natural que resulte fiable. Por eso merece la pena considerar, y verificar, un posible origen artificial“.

Los primeros destellos rápidos de radio se descubrieron en 2007, y hasta ahora el número de FRBs detectados por grandes telescopios como el Observatorio Parkes, en Australia, o el de Arecibo, en Puerto Rico, no llega a las dos docenas. Sin embargo, se sabe que proceden de galaxias muy distantes, a miles de millones de años luz de nuestra Vía Láctea.

Dos veces mayor que la Tierra

En su estudio, Loeb y Lingam examinan si sería factible construir un transmisor de radio lo suficientemente potente como para ser detectado a una distancia tan inmensa. Y han encontrado que, si el transmisor estuviera alimentado por energía solar, la luz del sol que iluminara un artefacto dos veces mayor que la Tierra sería suficiente para generar la energía necesaria. Por supuesto, un proyecto de construcción de esa envergadura está muy lejos de nuestras capacidades tecnológicas, aunque resultaría posible según las leyes de la física.

Los investigadores consideraron también si un transmisor así sería viable desde el punto de vista de la ingeniería, o si las enormes cantidades de energía involucradas teminarían por fundir cualquier estructura subyacente. Y una vez más, hallaron que un dispositivo con un tamaño de dos veces el de la Tierra podría soportar el calor su estuviera debidamente refrigerado por agua.

La siguiente pregunta que se hicieron Loeb y Lingam fue la siguiente: ¿Para qué querría alguien construir algo así? Y llegaron a la conclusión de que el uso más plausible de tal poder sería el de impulsar velas ligeras interestelares. De hecho, la cantidad de energía involucrada sería suficiente para impulsar de forma eficiente una carga útil de un millón de toneladas, lo que equivale a veinte veces el peso de los mayores buques de crucero existentes en la Tierra. Baste pensar que la Estación Espacial Internacional (ISS), apenas pesa 420 toneladas…

“Ese tamaño -asegura Lingam- es lo suficientemente grande como para transportar pasajeros a través de distancias interestelares, o incluso intergalácticas“:

Para dar energía a las velas, el transmisor debería ser capaz de enfocar continuamente un haz sobre ellas. Algo que, desde la Tierra, sería percibido como un breve destello, ya que tanto la vela, como su planeta, estrella y galaxia anfitriona se están moviendo en relación con nosotros. El rayo emisor estaría barriendo el cielo continuamente para realizar su trabajo y solo apuntaría en nuestra dirección durante un breve instante. Por eso, las apariciones repetidas del haz que hemos observado no pueden ser explicadas por eventos catastróficos de origen natural, pero sí si consideramos su posible origen artificial.

Por supuesto, Loeb admite que su trabajo es una simple especulación, y cuándo se le pregunta si realmente cree que los FRBs se deben a los aliens, responde que “En ciencia, no es una cuestión de creencias, sino de evidencias. Decidir antes de tiempo lo que es probable no hace más que limitar las posibilidades. Por eso vale la pena sembrar nuevas ideas, y dejar que sean los datos los que juzguen”.

Es decir, que por el momento no hay extraterrestres confirmados, ya que el estudio no es más que una forma de explicar algo que hasta el momento ha escapado a nuestra comprensión. En la investigación, de hecho, no se dice en ningún momento que nadie haya demostrado que alguna civilización alienígena sea la responsable de los FRBs, sino que adopta ese hipotético escenario como punto de partida y, a partir de ahí, se desarrolla la cuestión para averiguar si ese escenario es congruente con lo que estamos observando.

El resto dependerá de que en el futuro podamos encontrar y demostrar otros posibles orígenes para los misteriosos FRBs. Hasta entonces, todas las teorías son válidas.

Mar

15

Mira que si venimos del futuro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Otros mundos ~

Clasificado en Otros mundos ~

Comments (0)

Comments (0)

Esporas bien resguardadas en cápsulas que las preservaban de la radiación y que, al llegar al planeta y contactar con el agua, se abrieron para florecer y evolucionar hacia las formas de vida múltiples que hoy pordemos contemplar en el planeta como fruto de la evoluciòn de miles de millones de años, tras la desaparición de casi todas las especies anteriores, prevaleciendo las que mejor se supìeron adaptar.

En una Tierra primigenia e ignea que comenzaba a enfriarse, aquellas esporas de vida pudieron evolucionar hata las primeras células replicantes que comenzaron esa fascinante aventura, El mundo “elegido” era el ideal y contenía todos los ingredientes necesarios para su desaqrrollo: Distancia al Sol, agua corriente, atmósfera y demás ingredientes necesarios.

En este ambiente de la Tierra joven, de los acéanos primigenios de la atmósfera nueva y espesa, de las calientes aguas calentadas los innumerables chimeneas marinas que posibilitaron el surgir y el evolucionar de pequeñas bacterias y esporas venidas quién sabe de qué lugares, o, como podrían haber surgido a partir de la “materia inerte” con la ayuda de ese Caos químico de materiales en una Tierra nueva en evolución.

Podríamos pensar que, esas esporas de vida, pudieron llegar a la Tierra enviadas por seres inteligentes de otros mundos habitados que, viendo las posibilidades de “nuestro mundo”, quisieron adelantar el proceso irreversible del surgir de la vida cuando las condiciones precisdas están presentes.

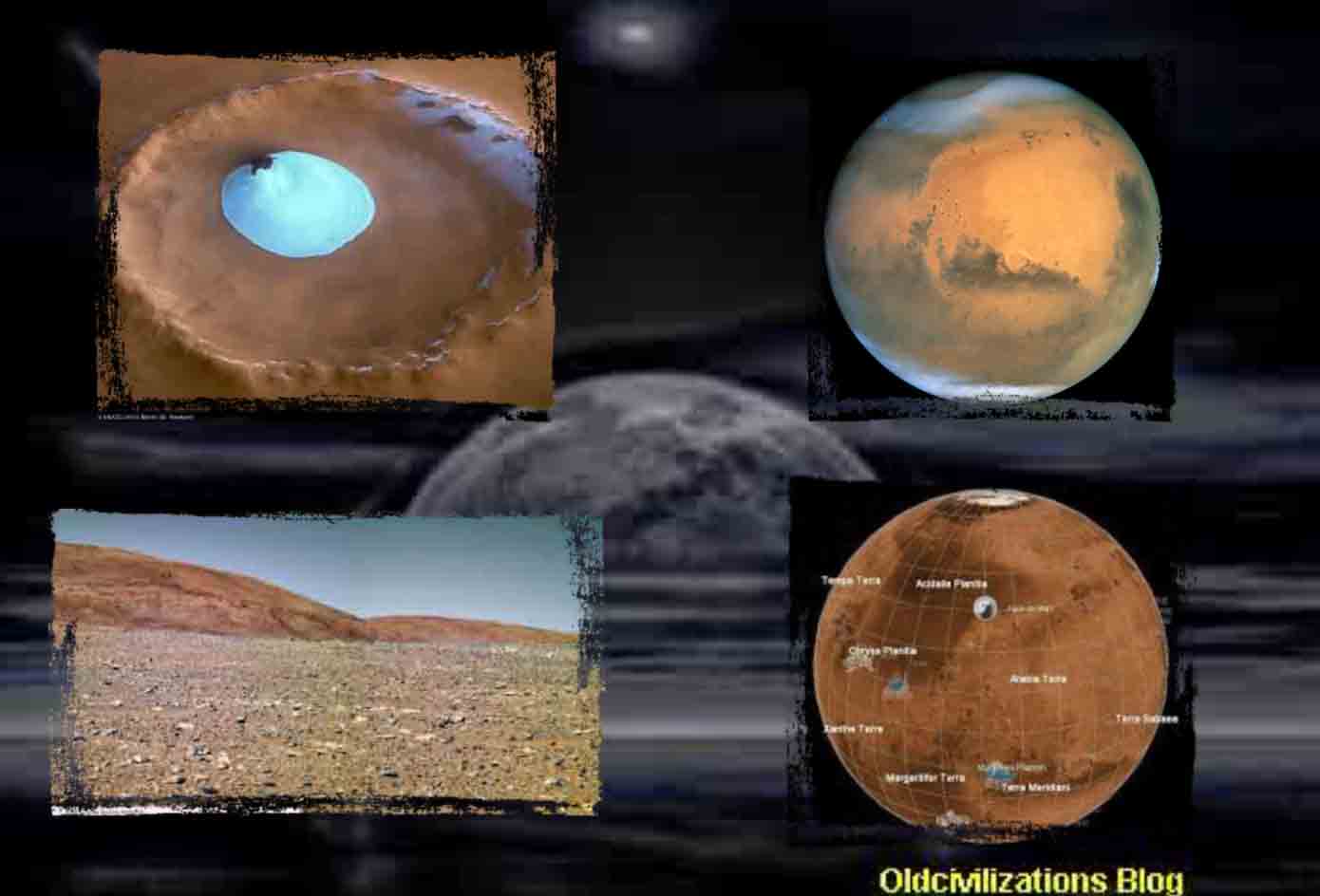

En Marte, la vida es posible que esté presente en el subsuelo del planeta, donde las temperaturas son más altas y, el agua líquida puede estar presente con lo cual, líquines y hongos y no digamos bacterias, habrán creado ecosistemas de vida en las profundidades de aquel planeta.

Precisamente por eso, es difícil que en las excursiones que hemos realizado en la superficie de Marte, encontremos alguna clase de vida, la radiación y las temperaturas lo impiden. Por otra parte, si alguna vez la hubo en la superficie, podrían existir fósiles pero… ¿cómo hallarlos sin hacer profundas excavaciones?

La diversidad de vida en nuestro planeta es inmensa, y, actualmente, sólo viven el 1% de las Especies que han sido extinguidas por uno u otro motivo. ¿Cómo podemos negar una rica diversidad de vida en otros mundos que, como la Tierra tenga las condiciones adecuadas para ello? Además, sin negar otras posibilidades, lo más normal sería que esas formas de vida extraterrestres, como en nuestro planeta, estén basadas en el Carbono, el elemento más idóneo para la Vida.

Hacernos una idea cabal de cómo podrían ser esas Sociedadses extraterrestres no podemos, y, sus mundos, aptosd para la vida, podrían ser muy distintos al nuestro con algunas similitudes y otras muchas diferencias, y, de la misma manera, los seres que los habitaran también, podrían ser muy diferentes a nosotros en función de factores distintos ausentes en nuestro mundo.

No sería nada extraña que mundos inhabilitados para la vida en la superficie, tengan desarrollado un sistema de Vida en el subsuelo del planeta que les facilite todo lo necesario para crear sociedades ocultas en las profundidades del planeta. Para ellos, sería una forma de vida normal, y, para nosotros, sería vivir confinados.

Claro que, la diversidad de mundos es tan inmensamente grande que, planetas como la Tierra existen, sólo en nuestra Galaxia, la Vía Láctea, a miles de millones. Otra cosa es que se encuentren la zona habitable. Recientemente han dado con Trappist-1 con 7 planetas rocosos donde 3 de ellos están situados adecuadamente para la Vida. Sin embargo, la distancia que de ellos nos separa nos obliga a realizar un viaje de cientos de miles de años para poder visitarlos, con lo cual, ¿de qué sirve saber que están allí? Bueno, quizás en un futuro muy lejano… ¡Nos pueda servir para salvar a nuestra especie!

Los de las películas han especulado de todas las maneras posibles con los extraterrestres y lo que harían de venir a la Tierra. Está claro que ninguna posibilidad hay que despreciar, no sabemos como serían “ellos” y lo que podrían tener en sus “mentes”.

Una cosa sí debemos tener clara: Vida en el Universo la hay por todas partes, es una condición exigida por sus condiciones físicas y químicas que, a partir de la “materia inerte”, la evoluci´`on nos lleve hasta los pensamientos y, en ocasiones, también a los sentimientos.

¿Por qué, si las leyes del Universo son las mismas en todas partes, seríamos nosotros los únicos seres inteligentess? Pensar de esa manera sería demasiado “tonto” o poco racional. Habrá mundos con seres cuya inteligencia nos sobrepase al ser más antiguos que nosotros y haber tenido más tiempo para esrtudiar el Universo.

Aunque la idea de contactar con otros seres nos pueda fascinar, lo cierto es que, si algún llegaran, creo que nos distorsionaran en la forma de vida que tenemos y que, a pesar de todas las cosas “malas” que tenemos que eliminar, es la nuestra. Ninguna interferencia extraterr3estre nos puede ayudar a nada. Si son superiores a nosotros… ¡Nos pueden engañar! Si por el contrario son inferiores intelectualmente hablando… ¡No podrán venir! Si somos nosotros los que vamos a sus mundos… ¡Mejor que se tapen los relojes de pulsera, ya que, lo más seguro, es que se los quitemos. Me acuerdo de Colón y Pizarro en el Nuevo Mundo.

En fin, seguiremos especulando.

emilio silvera

Totales: 84.551.486

Totales: 84.551.486 Conectados: 43

Conectados: 43