Jun

27

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Ylia Prigogine haciendo lo que sólo unos privilegiados pueden hacer: desvelando los principios del mundo. Enn la pizarra, la entropía. La irreversibilidad del tiempo trae el orden al caos, decía. De alguna manera pretendía explicar que nada permanece y todo cambia bajo los efectos del inexorable paso del Tiempo.

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

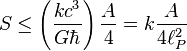

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la vecolcidad de la luz.

, es la vecolcidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.

, es la constante de Planck racionalizada. , es la longitud de Planck.

, es la longitud de Planck.

Claro que esta… ¡Es otra Historia!

emilio silvera

Jun

27

¿Hasta dónde llegaremos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El cerebro ~

Clasificado en El cerebro ~

Comments (0)

Comments (0)

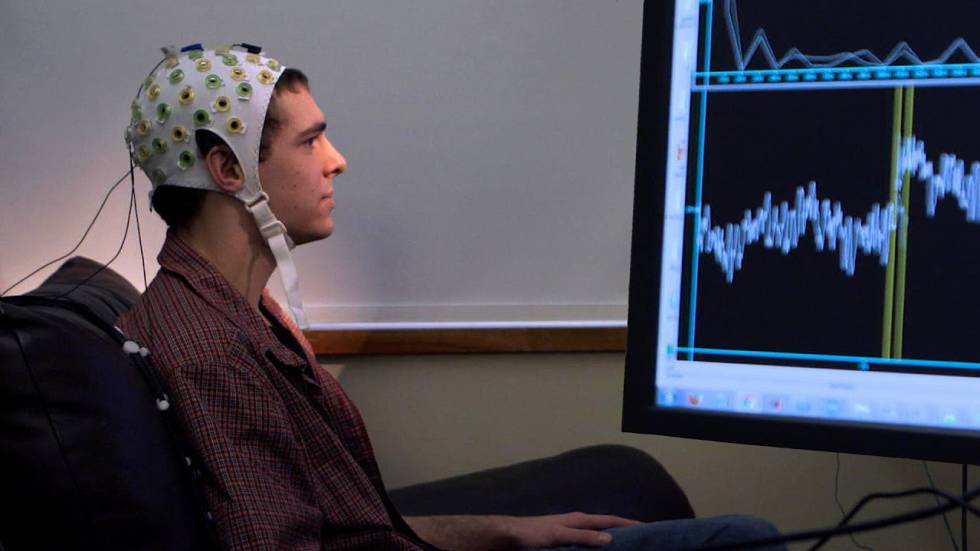

Manejar aparatos con la mente ya es posible: así podrás usar tus dispositivos preferidos sólo con el pensamiento

El Centro de Referencia Estatal para la Atención a Personas con Grave Discapacidad y para la Promoción de la Autonomía Personal y Atención a la Dependencia de León ha patentado la tecnología Brain Computer Interface (BCI), que registra y predice las intenciones cerebrales para el entrenamiento cognitivo y la asistencia domótica.

Así, “la tecnología ya permite manejar aparatos electrónicos a través del pensamiento gracias a la encefalografía”, explicó María Teresa Gutiérrez, directora gerente del CRE Discapacidad y Dependencia de León, que ha creado recientemente el sistema ‘Brain Computer Interface’ (BCI), en las XXIII Jornadas Científicas de Aspaym Madrid .

Se trata de un sistema pionero de electroencefalografía que registra y predice las intenciones cerebrales para el entrenamiento cognitivo y la asistencia a personas con discapacidad o en situación de dependencia a través de la domótica.

“A través de este sistema una persona puede encender y apagar un ordenador sólo con pensarlo, a través de ondas cerebrales”, indicó.

“El ordenador identifica qué respuestas cerebrales van unidas a un pensamiento y ejecuta la orden”, añadió.

Asimismo, Gutiérrez hizo hincapié en que “toda esta tecnología se puede lograr gracias a la investigación, que es importante porque beneficia a toda la sociedad, una población cada vez más envejecida, porque España es el segundo país con mayor esperanza de vida sólo por detrás de Japón”, aseguró.

José Antonio Hernández, responsable de la Escuela TIC de la Fundación del Lesionado Medular (FLM), explicó la labor que realiza la entidad a través de impresión 3D en materia de productos de apoyo para personas con lesión medular. La FLM, que cuenta con dos impresoras, imprime productos en tres dimensiones que suponen una mejora para el usuario o abarate el coste del producto. Además, en la FLM trabajan para detectar necesidades no resueltas y tratar de darles una solución. “Son los propios usuarios los que detectan sus necesidades, diseñan la solución y la crean”.

Para Hernández, “el mundo de la impresión y el escáner 3D abre un gran horizonte porque con una maquinaria relativamente económica se puede imprimir gran cantidad de material”. Además, “todavía no hemos visto todo el potencial de estas tecnologías y queda mucho por mejorar. En un futuro podremos comprar un objeto e imprimirlo en casa”.

Por otro lado, Gustavo Adolfo Díaz, socio de Aspaym Madrid y técnico de la Federación Nacional Aspaym, explicó cómo los smartphones le ayudan en su día a día: “Me dan mayor autonomía con un sinfín de posibilidades y aplicaciones; por ejemplo, a la hora de desplazarme o conocer la accesibilidad de un lugar”.

Díaz presentó algunas de aplicaciones como Tur4all, Wheelmap o Accessibility Plus que le aportan información fiable y le permiten actuar de forma independiente reduciendo su necesidad de asistencia.

Jun

26

El fuego de Moguer… ¿Intencionado?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (11)

Comments (11)

Vecinos de Mazagón apagan el fuego del incendio de Moguer que ya ha llegado a sus parcelas

Este que veís ahí con la manguera es mi hijo emilio que vive en una casa al lado de la playa

Vecinos de la urbanización Casas de Bonares de la playa de Mazagón (Huelva), apagan el fuego que ha llegado a sus viviendas por el incendio de Moguer que ya ha alcanzado al Parque Natural de Doñana.

En la foto de Carlos Martin Vaz subida a twitter se aprecia la proximidad de las llamas a las urbanizaciones de Mazagón

El fuego, como se puede apreciar en estos vídeos, ha llegado a las parcelas de las casas de esta urbanización, y aunque los bomberos ya han estado en el lugar, son los propios vecinos los que intentan aliviar con mangueras la zona. “Mi amiga con el pelo prendido en llamas y el novio quitándola de ahí”, se escucha relatar a una vecina.

El incendio se ha originado en el paraje La Peñuela en el termino municipal de Moguer.

La Delegación del Gobierno de Huelva de la Junta, desde Emergencias 112, ha activado a las 22.15 horas el nivel 1 de Pan Infoca por riesgo en las personas y bienes. El fuego sigue al lado de la carretera H-3111 que une Moguer con Mazagón. También se han incorporado efectivos de la Guardia Civil y ambulancias. Desde Emergencias 112 se ha comunicado desde su cuenta en twitter que las personas que están en la zona sigan las indicaciones de los servicios de evacuación y se actúe con calma.

Preocupa que las llamas lleguen hasta las conocidas ‘casas de Bonares’ en Mazagón

En esas casas precisamente, vive mi hijo Emilio que, ha estado toda la noche ayudando en el desalojo de personas mayores y echando agua con una manguera sobre los rescoldos del fuego y el techo de las casas conocidas con el soibrenombre de “Las casas de Bonares”. Por suerte, no se produjeron bajas.

La cifra de personas que se han tenido que desalojar por el incendio en Mazagón se ha elevado a casi 2.000, según los últimos datos aportados por el delegado del Gobierno en Andalucía, Antonio Sanz. El desalojo se ha producido entre los clientes de un camping, personal del Instituto Nacional de Técnica Aeroespacial del Ministerio del Interior (INTA) en la base de La Arenosilla, clientes y servicio del Parador Nacional de Mazagón, de otros hoteles y de casas particulares.

Según me ha contado mi hijo Emilio, hace una escasa media hora, su compañera, Maribel, corrió hacia la Playa alejandose del fuego, y, las folliscas que le caían encima traídas por el fuerte viento, le prendieron el pelo que tuvo que apagar a manotazos.

La Experiencia no ha sido nada gratificante, pasaron mucho miedo y vieron como, cuando se juntan el fuego y el viento… ¡Son imparables!

emilio silvera

Jun

26

La complejidad del cerebro, nuestra presencia en el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

“A primera vista el edificio de la ciencia aparenta estar erigido sobre suelo firme y profundos cimientos, como una unidad congruente, monolítica, dando fe de una sola realidad. Sin embargo, la ciencia es un constructo dinámico, cambiante. Según Thomas Kuhn, “Parece más bien una estructura destartalada con escasa coherencia”. Es producto de la observación, del razonamiento y también de muchas pasiones, siempre de seres humanos.”

El estudio biológico del cerebro es un área multidisciplinar que abarca muchos niveles de estudio, desde el puramente molecular hasta el específicamente conductual y cognitivo, pasando por el nivel celular (neuronas individuales), los ensambles y redes pequeñas de neuronas (como las columnas corticales) y los ensambles grandes (como los propios de la percepción visual) incluyendo sistemas como la corteza cerebral o el cerebelo, e incluso, el nivel más alto del Sistema Nervioso.

Hemos podido llegar a saber que el cerebro, tanto si está despierto como si está dormido, tiene mucha actividad eléctrica, y no sólo por las señales individuales emitidas por una u otra neurona cuando se comunican entre sí. De hecho, el cerebro está envuelto por innumerables campos eléctricos superpuestos, generados por la actividad de los circuitos neuronales de las neuronas que se comunican. Una nueva investigación revela que estos campos son mucho más importantes de lo que se creía hasta ahora. Es posible que, de hecho, representen una forma adicional de comunicación neuronal. Se ha llegado a pensar que, con la evolución del cerebro, quizás algún día, los humanos, podamos transmitir telepáticamente. Sin embargo…

Aunque se han llevado a cabo muchos experimentos sobre la telepatía, su existencia no es aceptada por la gran mayoría de la comunidad científica, entre otras cosas, argumentando que las magnitudes de energía que el cerebro humano es capaz de producir resultan insuficientes para permitir la transmisión de información. No obstante, algunos investigadores señalan que, con la tecnología necesaria, en un futuro será posible interpretar las ondas cerebrales mediante algún dispositivo y enviar mensajes textuales a un receptor de manera inalámbrica, sin embargo descartan que este proceso pueda llevarse a cabo de cerebro a cerebro sin mediación tecnológica. Hasta la fecha, las únicas pruebas de la telepatía son las narraciones testimoniales, pues jamás se ha podido reproducir un fenómeno telepático en laboratorio.

La neurociencia es una de las teorías científicas con más éxito en las últimas décadas. Pero aún, en este apartado del edificio de la ciencia, al verlo de cerca nos encontramos con arenas movedizas. Los especialistas se enfrentan al gran reto de explicar cómo es que los procesos físicos en el cerebro pueden generar o incluso influenciar la experiencia subjetiva. Este es el llamado problema duro de la consciencia.

Pero… ¡Vayamos mucho más atrás!

Los ladrillos del cerebro: Es evidente que el estímulo para la expansión evolutiva del cerebro obedeció a diversas necesidades de adaptación como puede ser el incremento de la complejidad social de los grupos de homínidos y de sus relaciones interpersonales, así como la necesidad de pensar para buscar soluciones a problemas surgidos por la implantación de sociedades más modernas cada vez. Estas y otras muchas razones fueron las claves para que la selección natural incrementara ese prodigioso universo que es el cerebro humano.

Claro que, para levantar cualquier edificio, además de un estímulo para hacerlo se necesitan los ladrillos específicos con las que construirlo y la energía con la que mantenerlo funcionando.

La evolución rápida del cerebro no solo requirió alimentos de una elevada densidad energética y abundantes proteínas, vitaminas y minerales; el crecimiento del cerebro necesitó de otro elemento fundamental:

Un aporte adecuado de ácidos grasos poliinsaturados de larga cadena, que son componentes fundamentales de las membranas de las neuronas, las células que hacen funcionar nuestro cerebro. La sinapsis es la unión funcional intercelular especializada entre neuronas, en estos contactos se lleva a cabo la transmisión del impulso nervioso

¿En que radica la facilidad de algunas personas para socializar mucho más fácilmente que otros? Más allá de una cuestión de carácter, existen rasgos biológicos que pueden ayudar a los científicos a entender en donde radica el secreto de la popularidad y, es el cerebro, en donde se encuentra la clave para descubrirlo.

De acuerdo con un estudio realizado por la Dra. en Neurociencias MaryAnn Noonan en de la Universidad de Oxford en Inglaterra, el cerebro de las personas que tienen numerosos amigos consta de seis partes más grandes y mejor conectadas entre sí que el de las personas con pocos amigos.

La Dra. Noonan, presentó el resultado de su investigación en la reunión de la Sociedad de Neurociencias, en donde comentó haber encontrado que los seres humanos en posesión de una gran red de amigos y buenas habilidades sociales tienen ciertas regiones del cerebro que son más grandes, mejor conectadas con otras regiones y, sobre todo, más desarrollados que aquellos que no tienen las mismas habilidades sociales. Los rasgos biológicos marcados pueden ayudar a los científicos a entender en donde radica el secreto de la popularidad.

De todas las maneras, estamos muy lejos de saber sobre una multitud de funciones y propiedades que están presentes en el cerebro y que, para los expertos, de momento, no tienen explicación. Por ejemplo, ¿por qué maduran antes las niñas que los niños? Las observaciones y los comportamientos de unos y otros nos han llevado a ese razonamiento final, y la verdad es que más allá de ser una opinión subjetiva, podría tener cierto fundamento.

A medida que crecemos nuestros cerebros se reorganizan y eliminan gran parte de las conexiones neuronales, quedándose sólo con aquellas que realmente proporcionan información útil. Esta información es, entre otra, la proveniente de regiones cerebrales que aunque estén lejanas sirven para contextualizar y comprender mejor la nueva información percibida: por ejemplo, escuchar un determinado sonido puede evocar el recuerdo de ciertas emociones, percibir según qué expresiones faciales se asocia con diferentes sentimientos y comportamientos, y una melodía musical está ligado a otros recuerdos de distintos tipos.

De esta forma, aunque la cantidad general de conexiones será más reducida según vamos madurando, el cerebro conserva las conexiones de larga distancia, que son las más complejas de establecer y de mantener y las realmente importantes para la integración de la información. Con ellas se consigue un procesamiento más rápido y eficiente. Esto explica también por qué la función cerebral no solo no empeora, sino que, en lugar de eso, mejora con los años (por lo menos, hasta los aproximadamente 40 años).

Nuestro sistema nervioso está siempre cambiando, es probable que cuando termines de leer este texto tu cerebro no sea el mismo que al comienzo de la lectura. El sistema nervioso tiene la capacidad de reordenar y crear nuevas sinapsis (conexiones entre neuronas), y gracias a esta característica somos capaces de aprender.

Cada experiencia deja una huella que modifica las sinapsis neuronales y permite que nos adaptemos a los constantes cambios de nuestro entorno, esta es la llamada Plasticidad Neuronal, que permite generar nuevas conexiones entre las neuronas, producto del aprendizaje y su almacenamiento en la memoria. Es decir, ¡el cerebro se transforma con la experiencia!.

Claro que, cuando hablamos del cerebro lo estamos haciendo del objeto más complejo del universo. Tiene tanta complejidad en sí mismo, que sus más de cien mil millones de neuronas nos hablan por sí mismo de ella. Nada en nuestro Universo se puede comparar a un objeto que con sólo un 1,5 Kg de peso, tenga tántas facultades y desarrolle tánta actividad como lo hace el cerebro Humano (el más adelantado y evolucionado que hasta el momento conocemos).

Explicar cualquiera de las “cosas” que están presentes en el cerebro, es, en sí mismo, un complejo ejercicio que supone “todo un mundo”, aunque estémos hablando de un sólo elementos de los muchos que allí están presentes. Por ejemplo…

Dentro de nuestras mentes, en una maraña de neuronas y conexiones que, de alguna manera, están conectadas con el Universo al que pertenecemos. Ahí reside la Conciencia de Ser y del mundo que nos rodea. Tras complicados procesos químicos de los elementos que conforman la materia compleja de nuestros cerebros, se ha desarrollado una estructura muy compleja de la que, al evolucionar durante miles de años, se ha podido llegar a generar pensamientos, profundas ideas y sentimientos.

No creo que seámos un único caso en el Universo. ¡Son tantos los mundos y las estrellas! Si en el Cosmos, la Conciencia estuviera representada sólo por nosotros… ¡Qué desperdicio de mundos, qué ilógica razón tendría el Universo para haber accedido a traer aquí, a una sola especie de observadores que, como bien sabemos, estamos expuestos, por mil motivos, a la extinción, y, sería una verdadera desgracia universal que los pensamientos y los sentimientos desaparecieran para siempre. ¿Qué clase de Universo sería ese? Sin estar presente ese ingrediente de los pensamientos y la consciencia… ¡Sería un Universo inútil!

emilio silvera

Jun

26

Conociendo el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

La galaxia «muerta» que cambiará lo que sabemos del Universo

Fotografiada por el Hubble, es la primera vez que los astrónomos ven algo parecido a MACS2129-1

La ilustración muestra, a la derecha, la galaxia MACS2129-1 en comparación con nuestra Vía Láctea. | Vídeo: El telescopio Hubble llega a la «última frontera» – NASA, ESA, and Z. Levy (STScI)

Los investigadores, sencillamente, no se esperaban algo así. Una galaxia en forma de disco, compacta, masiva y en rápida rotación, pero que dejó de formar estrellas unos pocos miles de millones de años después del Big Bang. El hallazgo, que se acaba de publicar en Nature, se ha llevado a cabo con el telescopio espacial Hubble.

Es la primera vez que se consigue observar algo parecido, ya que ninguna de las galaxias “muertas” de esa época lejana muestra ese tipo de estructura. El descubrimiento de MACS2129-1 resulta importante porque su mera existencia es algo que desafía todo lo que sabemos, o creíamos saber, sobre cómo se forman las galaxias masivas que nos rodean en la actualidad.

De hecho, cuando el Hubble la fotografió, los investigadores esperaban encontrarse con una caótica esfera de estrellas en plena formación, alimentada por la energía de la colisión con otras galaxias cercanas. Pero en vez de eso, se encontraron con un disco aplanado, similar en forma a nuestra Vía Láctea y, lo que es más, completamente inactivo.

Se trata, pues, de la primera evidencia observacional directa de que al menos algunas de las galaxias “muertas” más tempranas, en las que la formación estelar se ha detenido, consiguen, de alguna manera que ignoramos, seguir evolucionando a partir de un disco similar al de la Vía Láctea hasta transformarse en las galaxias elípticas gigantes que vemos hoy.

Lo cual supone una enorme sorpresa, porque las galaxias elípticas contienen estrellas muy viejas, mientras que las galaxias espirales suelen contener un gran número de estrellas jóvenes y azules. Sin embargo, la evidencia no deja lugar a dudas: por lo menos algunos de estos discos galácticos muertos han conseguido transformarse y resurgir de sus cenizas. De hecho, no solo han cambiado su estructura, sino también las trayectorias de sus estrellas para adoptar la forma de galaxias elípticas.

“Esta nueva visión -explica Sune Toft, del Instituto Niels Bohr de la Universidad de Copenhague y director de la investigación- puede forzarnos a replantear por completo el contexto cosmológico de cómo las galaxias arden al principio y evolucionan después tomando las formas que vemos actualmente. Tal vez hallamos sido ciegos ante el hecho de que las primeras galaxias muertas podían ser discos, simplemente porque no hemos sido capaces de resolverlos”.

Estudios anteriores de lejanas galaxias muertas asumían, en efecto, que su estructura era similar a la de las galaxias elípticas cercanas en las que terminan evolucionando. Pero confirmar esta hipótesis, en principio, requiere de telescopios mucho más potentes de los que existen en estos momentos. Sin embargo, y gracias al fenómeno de “lente gravitacional”, que permite amplificar los objetos muy lejanos cuando su luz pasa a traves de cúmulos galácticos muy masivos, que actúan como un “zoom”, el telescopio espacial Hubble ha conseguido enfocar uno de estos primitivos y misteriosos objetos. Y los investigadores han sido capaces, por primer vez, de observar el centro de una galaxia muerta.

En concreto, MACS2129-1 es tres veces más masiva que la Vía Láctea y gira sobre sí misma al doble de velocidad, aunque solo tiene la mitad de su tamaño. Utilizando los instrumentos del telescopio, Toft y su equipo lograron, además, determinar la masa estelar, la tasa de formación de nuevas esttrellas y la edad de las estrellas existentes.

Núcleo muy activo

La razón por la que esta galaxia dejó tan pronto de fabricar estrellas se desconoce. Podría ser el resultado de un núcleo galáctico muy activo, con enormes cantidades de energía brotando del agujero negro supermasivo central. Energía que sería capaz de inhibir el proceso de formación estelar sobrecalentando el gas o, incluso, expulsándolo fuera de la propia galaxia. O también podría ser el resultado de una masa de gases fríos fluyendo sobre la galaxia y siendo rápidamente comprimidos y calentados, evitando así que se creen nubes de formación de estrellas.

Sea como fuere, los astrónomos se preguntan cómo es posible que estos discos tan jóvenes, masivos y compactos logren evolucionar en las galaxias elípticas que podemos observar en el Universo actual. Según Toft, “probablemente sea a través de fusiones con otras galaxias. Si estas galaxias crecen a través de fusiones con otros compañeros menores, y estas pequeñas galaxias acompañantes llegan en gran número y desde todos los ángulos, eso podría, eventualmente, volver aleatorias las órbitas de las estrellas dentro de la galaxia. También se podrían imaginar grandes fusiones, algo que sin duda también podría destruir el movimiento ordenado de las estrellas”.

Toft, ahora, solo espera poder usar el futuro telescopio James Webb, mucho más poderoso que el Hubble, para poder buscar más galaxias parecidas.

Totales: 75.391.681

Totales: 75.391.681 Conectados: 50

Conectados: 50