Jul

8

¡Qué misterio esconde la materia? ¿Qué es la luz?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

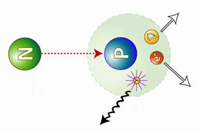

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón(β–) y un antineutrino electrónico. La desintegración beta se debe a la interacción nuclear débil, que convierte un neutrón en un protón (desintegración β–), o viceversa (β+), y crea un par leptón–antileptón. Así se conservan los números bariónico(inicialmente 1) y leptónico (inicialmente 0). Debido a la aparente violación al principio de conservación de la energía, estas reacciones propiciaron precisamente que se propusiera la existencia del neutrino. Precisamente de eso hablamos aquí.

Una vez escenificados los conceptos, diremos que, los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

En 1.922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1.930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1.931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

La radiación alfa está compuesta por un núcleo de helio y puede ser detenida por una hoja de papel. La radiación beta, compuesta por electrones, es detenida por una hoja de papel de aluminio. La radiación gamma es absorbida cuando penetra en un material denso

Digamos que la solución de Pauli para explicar la masa perdida, era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

Primera observación de un neutrino en una cámara de burbujas, en 1970 en el Argonne National Laboratory de EE. UU., la observación se realizo gracias a las líneas observadas en la Cámara de burbujas basada en hidrógeno líquido. Siempre hemos tenido imaginación para idear aparatos que nos ayudaran a desvelar los secretos de la Naturaleza. Más tarde, la cámara de burbujas, fue sustituida por la cámara de chispas.

El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado otras veces, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiplos de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de cero. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n) = +½(p) – ½(e) + ½(neutrino)

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza. En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Para un electrón, protón o neutron la cantidad de espín es siempre 1/2 del valor mínimo de momento permitido (ħ).

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

Las más importantes conversiones protón-neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

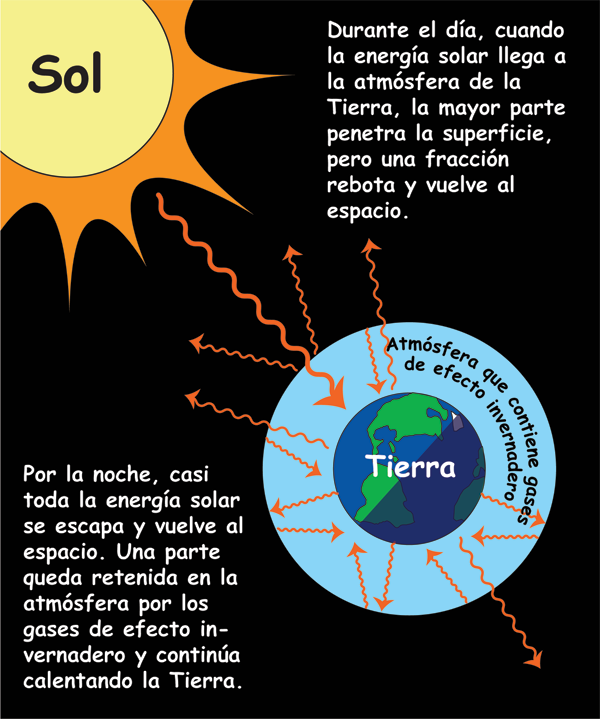

Aunque sólo una cinco mil millonésima de la luz solar llega a la Tierra, ha sido suficiente para dar a esta calor y vida, así como bípedos bastante listos para calcular al detalle su deuda con el Sol que, si pusiera intereses, nunca podríamos pagar.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite máximo que se puede desplazar cualquier cosa en nuestro Universo, y en fin, muchos otros misterios que encierra esa maravilla cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

Me gustaría que alguien contestara: ¿Qué es realmente la luz?

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo que deberíamos profundizar un poco más y, sabiendo que la luz está formada por fiotones, que los fotones son energía, que la energía es un aspecto de la masa… ¿Qué es realmente la luz? Nosotros mismos, el última instancia ¿No seremos luz?

Está claro que los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietantes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1.678, el físico neerlandés christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Se encuentra la galaxias más lejana nacida después del big bang

Gracias a las radiaciones electromagnéticas podemos ver el Universo como fue hace ahora miles de millones de años. Cuando la luz, nos trae la imágen de galaxias situadas a distancias inconmensurables. ¿Quién podría haber pensado, en el pasado, que tal cosa fuese posible? hace

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y las ondas marinas. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

Así que, la vieja idea de Newton de que la luz estaba formada por partículas, en contra de la teoría ondulatoria de su contemporáneo Huygens corroborada por posteriores experimentos en el siglo XIX y por la teoría electromagnética de Maxwell, volvía a ser vigente en parte. La radiación electromagnética estaba formada por paquetes de energía llamados fotones, tenía una doble naturaleza: ondulatoria y corpuscular. La doble naturaleza ondulatoria y corpuscular de la luz, hizo pensar al físico francés Louis de Broglie que el resto de partículas podían disfrutar de esa cualidad y estableció que cualquier partícula lleva asociada una onda de longitud igual al cuanto de acción (h) dividido por su masa y por su velocidad (cualquier objeto macroscópico también tiene su onda asociada, pero debido al valor tan pequeño del cuanto de acción su efecto es despreciable). De hecho, cuando se diseña un experimento, dependiendo de las restricciones que se impongan a la partícula se pone de manifiesto su naturaleza ondulatoria o corpuscular pero, esa es, otra historia.

emilio silvera

Jul

8

Sí, nuevas Teorías nos hablarán de cómo es la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

En nuestro Universo existen cosas extrañas que, seguramente, cuando sepamos más, sabremos su explicación: ¿Por qué no hay anti-bariones primordiales en el Universo mientras que hay un barión por cada mil millones de fotones?, dicho de otra manera, el origen de la materia. Claro que, para explicar este hecho necesitamos comprender como se comportaba nuestro Universo a temperaturas tan altas como un billón de grados.

Las interacciones entre partículas elementales (interacciones electromagnéticas, débiles y fuertes) están clasificadas por su entidad (constantes de acoplamiento) y por las partículas “transportadoras” de las mismas (partículas de spín=1 0 bosones de gauge) . Todas ellas están bellamente descritas por lo que se conoce habitualmente como Modelo Estándar de las interacciones electrodébiles y fuerte. Estamos deliberadamente dejando al margen las interacciones gravitatorias que, al menos a nivel clásico, están perfectamente descritas por la Teoría de la Gravitación o Relatividad General formulada por A. Einstein en 1915 y 1916.

El Modelo Estándar nos dice que las partículas elementales, cuya interacción se detecta en particular en los grandes aceleradores como el Large Hadrón Collider (LHC) que está funcionando el el CERN (Ginebra-Suiza), no son los átomos, ni los núcleos atómicos, ni siquiera los protones y neutrones de los que están constituidos, sino los Quarks, de los que están compuestos neutrones y protones, los leptones cargados eléctricamente (partículas ligeras como los electrones que están en la corteza de los átomos o muones que aparecen en ciertas desintegraciones), los leptones neutros o neutrinos (partículas enigmáticas con una masa pequeñísima comparada con el resto del espectro) y partículas transportadoras de las interacciones como fotones (cuanto de luz) transportadores de las interacciones electromagnéticas, los bosones W+, W- y Z0 que transportan las interacciones electrodébiles y los Gluones que transportan la interacción fuerte.

Partiendo de los Quarks, se conforma el núcleo hecho de protones y neutrones. Los Quarks, confinados dentro de estos nucleones, quedan sujetos por la fuerza fuerte a través de las partícuals mediadoras, los Gluones. Para formar el átomo, se necesitan electrones que, rodean el núcleo en número igual al de protones que contiene, y, como el protón está cargado eléctricamente con fuerza positiva, ésta se equilibra mediante la negativa de la misma potencia que aportan los electrones. De esta manera, el átomo queda debidamente estabilizado para poder unirse a otros para formar células que, a su vez se unen para formar moléculas que, a su vez, se juntan para formar materia.

Todas estas partículas de las que podemos hablar ya han sido descubiertas, mientras que la única incógnita del Modelo Estándar reside en el mecanismo por el que los fermiones elementales y ciertas partículas transportadoras de las interacciones como la W y Z adquieren masa. La Teoría de la “ruptura expontánea de simetría electrodébil” implica que tiene que existir una partícula aún no descubierta, el Bosón de Higgs, que es responsable de que las anteriores partículas, incluida ella misma, sean masivas.

¿Cómo será ese Bosón de Higgs y, de qué mecanismo se vale para dar masa a las demás partículas?

Todos hemos oido hablar hasta la saciedad de que el Bosón de Higgs debe ser descubierto por el Colisionador LHC y tal descubrimiento añadiría una buena ráfaga de luz sobre algunos enigmas, propiedades no bien conocidas de las interacciones débiles. Ahora que dicen haberlo encontrado, al menos de momento, no parece que se tengan noticias de ninguna nueva revolusión de la física. ¡Habrá que esperar!

El Modelo Estándar es pues la estructura matemática que describe las interacciones entre las partículas elementales conocidas. El Modelo Estándar, como cualquier otra teoría física, tiene que ser capaz de describir de froma correcta los datos experimentales que son los que realmente establece el veredicto último de una teoría.

En particular el Modelo Estándar ya ha sido (y está siendo) ampliamente contrastado con los datos experimentales de las colisiones de altas energías, como el Large Electrón Positrón (LEP) que estuvo funcionando en el CERN hasta el año 2000 y el Tevatrón que está en funcionamiento en el Laboratorio Fermilab (En Chicago, Illinois, USA), así como en aceleradores de baja energía.

El Tevatron, que ha sido el acelerador de partículas más potente del mundo hasta que entró en funcionamiento el LHCeuropeo, cerró el pasado 30 de de septiembre de 2011, de forma definitiva, tras 26 años de operación.

El resultado obtenido es que el acuerdo entre la teoría y los resultados experimentales es concluyente, llevándose el acuerdo hasta niveles de 0,1%. Sin embargo, a pesar de que los resultados experimentales no indiquen apenas fisuras en el Modelo Estándar existen motivaciones acuciantes para ir más allá de éste. Está claro que, el principal objetivo del Modelo está en descubrir los orígenes de la Materia, entendiendo por tal los protones y neutrones de los que estamos hechos nosotros mismos, es decir, la materia bariónica.

En este lugar, el Fermilab, se llevan a cabo proyectos de enorme importancia para conocer lo que la materia es. Y, de la misma manera que en el CERN, se realizan colisiones de haces de partículas que reproducen aquellos momentos de la creación, el big bang en miniatura para, a partir del estudio de lo que ahí pasa, poder llegar a comprender aquellos primeros momentos que aún, mantiene, algunas regiones oscuras que no dejan ver lo que allí pasó.

Los dos problemas “experimentales” más acuciantes que presenta en estos momentos el Modelo Estándar está relacionado con los dos tipos de Materia que constituyen el Universo observable. El 17% de la Materia de nuestro Universo es materia “luminosa”, es decir, materia constituida, como nosotros mismos por protones y neutrones. Por otro lado, el 83% de nuestro universo Universo está constituido por Materia Oscura (yo prefiero decir: parece que está constituido por materia invisible que llamamos oscura), es decir, materia que ha sido detectada por el momento sólo indirectamente a través de sus interacciones gravitacionales.

De nuevo el Modelo Estándar requiere de una extensión para poder incluir candidatos a Materia Oscura.

Muchas son las noticias que saltan a los medios y que son emitidas por equipos que quieren llevarse el galardón del hallazgo de la M. O. Veamos por ejemplo uno de ellos:

24 OCTUBRE 2010. Un teórico del Fermilab y sus colegas de la Universidad de Nueva York podrían haber encontrado pistas sobre algunos de los más jugosos secretos del universo en el centro de la Vía Láctea. La materia oscura. En su análisis de los datos públicos de los rayos gamma del Telescopio Espacial Fermi, Dan Hooper, científico del Fermilab, y Lisa Goodenough, un estudiante graduado en la Universidad de Nueva York, informan que los rayos gamma de muy alta energía procedentes del centro de la Vía Láctea vienen de las colisiones de materia oscura.

“Salimos de nuestra manera de considerar todas las causas de los fondos que imitan la señal, y no se encontraron otras fuentes plausibles en astrofísica o la mecánica que se puede producir una señal como ésta”, dijo Hooper.

Un reciente trabajo, publicado en el servidor repositorio científico arXiv-pre, describe sus hallazgos. Los astrofísicos desde hace mucho tiempo postulan una amplia gama de partículas de materia oscura, incluyendo los axiones, las partículas súper pesadas y partículas que se encuentran entre: débilmente partículas masivas de interacción, o WIMPs.

Ahora nos dicen que el LHC se prepara para poder buscar la materia oscura y, que yo sepa, el Bosón de Higgs (aunque digan lo contrario) no se ha encontrado. Al parecer han localizado una partícula que tiene todos los atributos para poder ser el Higgs pero… ¿Será él?

Claro que, la realidad es tozuda, y, nadie puede decirnos qué es la dichosa y teórica “materia oscura” de qué está hecha, cómo se formó, de qué mecanismos se vale para pasar inadvertida sin emitir radiaciones que podamos detectar, y, un sin fin de cuestiones que la hace extraña y muy exótica, hasta el punto de que podamos pensar que está y no está en este mundo. ¿No estará escondida en eso que llamamos vacío y, las partículas portadoras de la Fuerza Gravitatoria, el Gravitón, nos trae a nuestra parte del “mundo” la Gravedad que genera y que es, la que detectan los cosmólogos cuando ven que las galaxias se alejan las unas de las otras a más velocidad de la que tendrían que hacerlo si sólo existiera la materia bariónica que podemos observar?

Hablámos de los posibles candidatos a materia oscura, aquí la situación es incluso más complicada puesto que candidatos a materia oscura no han sido detectados por experimentos de física de partículas con lo que (como antes decía) su misma naturaleza nos es desconocida. Para competar el relato cabe decir que experimentos astrofísicos, en particular detección de supernovas, indican que el total de la materia anteriormente descrita (o sea luminosa y oscura) constituyen tan sólo el 28% de la densidad de energía del universo observable mientras que el resto es una energía no detectable mediante experimentos de Física de Partículas y que se conoce con el nombre de energía Oscura, que puede ser simplemente una Constante Cosmológica.

Einstein se burla de nosotros como si supiera (el muy ladino) que él llevaba razón, y, la Constante Cosmológica está ahí, presente en el Universo. La verdad es que, nos trae de cabeza, el no saber detectar dónde está la verdad para saber el camino a tomar en el futuro.

Así que, finalmente podemos concluir que el 4,6% es la materia bariónica (Supercúmulos de Galaxias, Nebulosas, Mundos, y demás cuerpos observables .-también nosotros-) y, el 17% de la densidad de materia del universo podría ser la llamada “materia oscura” . Aún cuando la proporción sea minoritaria para la Bariónica, para nosotros es prioritaria, de ella estamos hecho nosotros mismos y que, por supuesto, es la única materia que podemos detectar de forma directa, conocemos (las partículas que la conforman) sus secretos, sus parámetrtos físicos, sus masas y cargas, sus funciones dentro del contexto general y, en definitiva es la materia que está tan cerca de nosotros que, nosotros mismos somos ella.

También los pilares básicos de nuestro propio ser, son Quark y Leptones, es decir, materia bariónica. Así que, si los observadores del Universo (nosotros) somos de materia radiante y luminosa, no creo que esa “materia oscura” tenga más importancia que aquella de la que nosotros estamos formados. Más bien creo que, existe alguna fuerza (llámese constante cosmológica o de cualquier otra forma) desconocida que, se confunde con esa clase de materia. Materia, lo que se dice materia, por mí, sólo existe la que podemos ver y detectar.

Dos son los problemas esenciales que deben ser entendidos en relación con el número bariónico del Universo:

– El primero es que no hay prácticamente evidencia de antimateria en el Universo. De hecho no hay antimateria en nuestro Sistema solar y solamente aparecen antiprotones en los rayos cósmicos. Sin embargo, los antiprotones se pueden producir como producto secundarios en colisiones del tipo pp → 3p + p (en esta última p debería aparecer una rayita horizontal encima (antiprotón) pero, en mi cuadro de caracteres especiales no lo tengo) que proporcionan una abundancia de antiprotones semejante a la observada.

Así por ejemplo, resulta que se detecta un antiprotón aproximadamente por cada 3000 protones mientras que se encuentra un átomo de antihelio por cada 10000 átomos de Helio. Todos estos datos experimentales están de acuerdo con la existencia de antimateria primordial en el Universo. De hecho, la no existencia de antimateria resulta esencial para la estabilidad del mismo puesto que la materia y la materia se aniquilan entre sí produciendo radiación.

Satélite WMAP

– Una vez explicado el hecho de que practicamente no hay antimateria en el Universo, el segundo problema sería entender el origen de la densidad de materia luminosa. De hecho, utilizando los datos de la abundancia primordial de elementos ligeros, de acuerdo con la teoría de la nucleosíntesis, junto con los datos del Satélite WMAP, se deduce que hay en torno a 1 protón por cada mil millones de fotones en el Universo. Siendo nB y n γ las densidades de bariones y fotones respectivamente, se tiene que η=nB/nγ ≈ 0.61 x 10-9.

Para ser un poco más preciso podríamos decir que en 5 metros cúbicos hay un sólo barión y mil millones de fotones en promedio.

Para entender mejor cuál puede ser el mecanismo que explique la generación de materia en nuestro Universo, es decir, el parámetro η que acabamos de describir, debemos retrotraernos a la época en que el universo estaba muy caliente, poco después del Big Bang. Es decir, la llamada era denominada de la Radiación. Las partículas cuya masa es (muy) inferior a la temperatura del universo se aniquilan con sus antipartículas por las reacciones inversas a las anteriores. En este momento las partículas se comportan practicamente como si fueran de masa cero y se dice que la partícula en cuestión está en equilibrio térmico con la radiación. El Modelo Estándar Cosmológico predice una relación entre la edad del Universo (en segundos) y la temperatura del mismo (en K) que viene dada por:

en donde kB es la constante de Boltzmann. La ecuación anterior nos dice que para una temperatura próxima al GeV (equivalente a la masa del protón, que es de unos diez billones de grados, ¡el tiempo transcurrido en el universo después del Big Bang era de unas dos diez millonésimas de segundo!

Para temperasturas inferiores a la masa de la partícula, las partículas y antipartículas siguen aniquilándose en fotones, aunque el proceso inverso no puede tener ya lugar y la densidad de equilibrio térmico de partículas y antipartículas decrece exponencialmente como exp (-m/T) en donde m es la masa de la partícula en cuestión. Este proceso se termina cuando el ritmo de aniquilación de partículas y antipartículas no puede competir con el ritmo de expansión del universo (constante de Hubble H) , momento en el que las partículas y antipartículas se salen del equilibrio térmico y su densidad queda “congelada” a los valores de equilibrio correspondientes a la temperatura de”congelación” (temperatura de freezeout). Si aplicamos este proceso a los nucleones protones y neutrones) y antinucleones de masa ~ 1 GeV se puede ver como la densidad de los mismos empieza a disminuir exponencialmente para temperaturas inferiores al GeV, mientras que se salen de equilibrio térmico para temperaturas del orden de 20 MeV, para la cual la densidad de equilibrio resulta ser: nB/nγ=nB/nγ ≈ 10-18.

Esto nos demuestra que partiendo de un Universo simétrico, como hemos supuesto hasta el momento, hoy en día el Universo seguiría siendo simétrico respecto al número bariónico y, además, ¡el número de bariones sería mil millones más bajo que el que observamos! La solución de este problema sólo puede tener una respuesta: debemos abandonar la hipótesis de que el Universo era inicialmente simétrico respecto al número bariónico. La explicación podría seguir y es larga y algo compleja pero, por mi cuenta, resumo diciendo que, esa simetría no es posible, si tenemos en cuenta que, las partículas creadas después del Big Bang, al ser diferentes, también tenían diferentes masas y, tal hecho cierto, hace imposible que la expansión del Universo fuera isotrópica, así que, al expandirse anisotrópicamente, la asimetría queda servida.

Sí, podríamos decir que, la asimetría del Universo es la responsable de su diversidad. No todo es igual en el Universo. Lo son todos los protones y electrones que existen, y, también, todos los neutrones, es decir, son idénticos y simétricos los objetos de la misma familia a niveles microscópicos pero, cuando nos vamos al mundo macroscópico de las galaxias, las estrellas, los mundos o, nosotros mismos, no encontramos dos iguales.

El Universo, amigos, es una maravilla.

Agradeceré aquí la mayor aportación de D. Mariano Quirós de cuyo artículo en el Volumen 25, número 4 de la Revista de Física, encontré el Origen de la materia: bariogenesis, del que pude obtener la mayor parte del texto que aquí han podido leer.

Este trabajo fue publicado en este lugar el pasado 24 de marzo

emilio silvera

Totales: 75.481.928

Totales: 75.481.928 Conectados: 58

Conectados: 58