Dic

20

Avances en química polaritónica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nuevas posibilidades ~

Clasificado en Nuevas posibilidades ~

Comments (0)

Comments (0)

Avances en química polaritónica

Investigadores de la Universidad Autónoma en Madrid (UAM) han logrado importantes avances en la química polaritónica, un campo emergente que permite activar reacciones que de otra manera estarían ‘prohibidas’ en la química convencional. Sus resultados, publicados en Physical Review Letters, y que han sido noticias destacadas en Physics y Nature, muestran la posibilidad de generar una reacción fotoquímica en cadena a partir de un sólo fotón, algo que hasta ahora no era posible.

Luz ultracorta para cambiar la dirección de los productos de una reacción química

La foto-isomerización es un proceso químico en el cual la estructura nuclear de una molécula orgánica es alterada como consecuencia de la absorción de un fotón. Este proceso no sólo tiene una gran relevancia en procesos fundamentales de la naturaleza, como la fotosíntesis o la visión humana. También es una herramienta de extrema utilidad en aplicaciones tecnológicas, por ejemplo en el diseño de interruptores moleculares o en el almacenamiento de energía solar.

En condiciones normales, estas reacciones fotoquímicas son gobernadas por la ley de Stark-Einstein, que establece que solo una molécula puede reaccionar por cada fotón absorbido.

Un artículo reciente, publicado en Physical Review Letters por Javier Galego, Francisco José García Vidal, y Johannes Feist, investigadores del departamento de Física Teórica de la Materia Condensada y el Centro de Investigación en Física de la Materia Condensada (IFIMAC) de la Universidad Autónoma de Madrid (UAM), ha demostrado teóricamente la posibilidad de ir más allá de la ley de Stark-Einstein gracias a un fenómeno propio de la electrodinámica cuántica conocido como “acoplo fuerte”.

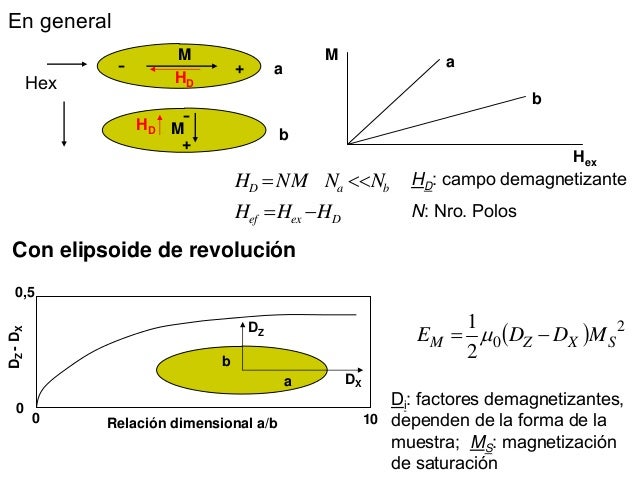

Química Polaritónica

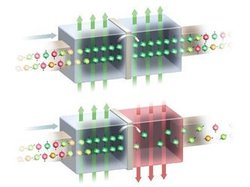

En este régimen de acoplo fuerte, la luz y la materia interaccionan muy intensamente, lo que genera que el material presente unas excitaciones, llamadas polaritones, que tienen propiedades tanto de la luz como de la materia.

Este carácter híbrido de los polaritones tiene un impacto importante en las propiedades químicas del sistema, por lo que se ha acuñado el término de ‘Química Polaritónica’ para describir el efecto de los polaritones en las reacciones químicas. Gracias a este campo emergente de la ciencia, es posible activar reacciones que de otra manera estarían prohibidas en la química convencional.

En su trabajo, los autores consideran unas moléculas orgánicas que permiten almacenar energía solar y demuestran cómo la Química Polaritonica ofrece una herramienta para manipular la estructura energética que determina las reacciones químicas en esas moléculas.

En particular, muestran la posibilidad de generar una reacción en cadena en un conjunto de moléculas, donde una molécula reacciona después de otra como consecuencia de la absorción de un sólo fotón al principio de la reacción.

La dinámica cuántica al unirse a otras disciplinas nos está dando muchas sorpresas.

“Este trabajo se añade a la lista de ejemplos del gran potencial que nos ofrece la Química Polaritónica, un novedoso campo interdisciplinar que reúne ramas de la ciencia que normalmente no van de la mano como son la Química y la Electrodinámica Cuántica”, aseguran los autores.

“En las reacciones químicas corrientes, las moléculas y la luz tienen roles muy distintos. Sin embargo, la Química Polaritónica requiere que cambiemos nuestro concepto habitual de molécula por uno nuevo que involucre a la luz, y que posibilita nuevos procesos químicos que desafían las leyes de la fotoquímica convencional”, concluyen.

_____________________

Referencia bibliográfica:

Javier Galego, Francisco J. Garcia-Vidal, and Johannes Feist. Many-Molecule Reaction Triggered by a Single Photon in Polaritonic Chemistry. Phys. Rev. Lett. Doi: 10.1103/PhysRevLett.119.136001

Dic

19

Enanas Blancas, estrellas misteriosas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astrofísica ~

Clasificado en Astrofísica ~

Comments (1)

Comments (1)

Una enana blanca es una pequeña y densa estrella que es el resultado final de la evolución de todas las estrellas (por el ejmplo el Sol), excepto las muy masivas. Según todos los estudios y observaciones, cálculos, midelos de simulación, etc., estas estrellas se forman cuando, al final de la vida de las estrellas medianas, al final de sus vidas, cuando agotan el combustible de fusión nuclear, se produce el colapso de sus núcleos estelares, y quedan expuestas cuando las partes exteriores de la estrella son expulsadas al espacio interestelar para formar una Nebulosa Planetaria.

Ahí se ha formado ya una Nebulosa planetaria y en su centro, muy caliente y radiando en el ultravioleta más energético, la “nueva” estrella enana blanca, …

El Núcleo se contrae bajo su propia gravedad hasta que, habiendo alcanzado un tamaño similar al de la Tierra , se ha vuelto tan densa (5 x 108 Kg/m3) que sólo evista su propio colapso por la preseión de degeneración de los electrones (como sabeis los electrones son fermiones que estando sometidos al Principio de exclusión de pauli, no pueden ocupar niguno de ellos el mismo lugar de otro al tener el mismo número cuántico y, siendo así, cuando se cjuntan demasiado, se degeneran y comienzan una frenética carrera que, en su intensidad, puede, incluso frenar la implosión de una estrella -como es el caso de las enanas blancas).

Las enanas blancas se forman con muy altas temperaturas superficiales (por encima de los 10 000 K) debido al calor atrapados en ellas, y liberado por combustiones nucleares previas y por la intensa atracción gravitacional que sólo se ve frenada por la degeneración de los electrones que, finalmente, la estabilizan como estrella enana blanca.

Este tipo de estrellas, con el paso del tiempo, se enfrían gradualmente, volviéndose más débiles y rojas. Las enanas blancas pueden constituir el 30 por ciento de las estrellas de la vecindad solar, aunque debido a sus bajas luminosidades de 10-3 – 10-4 veces la del Sol, pasan desapercibidas. La máxima máxima posible de una enana blanca es de 1,44 masas solares, el límite de Shandrasekhar. Un objeto de masa mayor se contraería aún más y se convertiría en una estrella de neutrones o, de tener muha masa, en un agujero negro

Visión artística de una enana blanca, Sirio B – Crédito: NASA, ESA y G. Bacon (STScl)

Las enanas blancas son estrellas calientes y pequeñas, generalmente como del tamaño de la Tierra, por lo que su luminosidad es muy baja. Se cree que las enanas blancas son los residuos presentes en el centro de las nebulosas planetarias. Dicho de otra manera, las enanas blancas son el núcleo de las estrellas de baja masa que quedan después de que la envoltura se ha convertido en una nebulosa planetaria.

El núcleo de una enana blanca consiste de material de electrones degenerados. Sin la posibilidad de tener nuevas reacciones nucleares, y probablemente después de haber perdido sus capas externas debido al viento solar y la expulsión de una nebulosa planetaria, la enana blanca se contrae debido a la fuerza de gravedad. La contracción hace que la densidad en el núcleo aumente hasta que se den las condiciones necesarias para tener un material de electrones degenerados. Este material genera presión de degeneración, el cual contrarresta la contracción gravitacional.

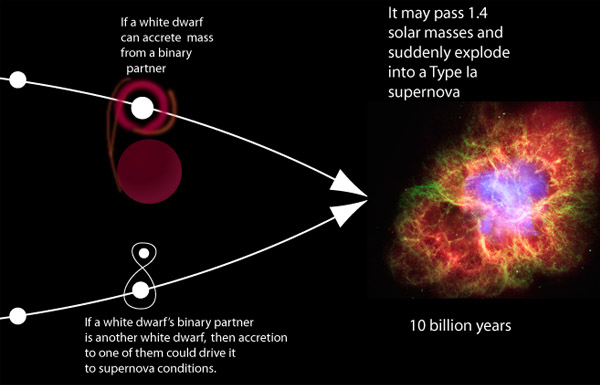

Al ser estudiadas más a fondo las propiedades de las enanas blancas se encontró que al aumentar su masa, su disminuye. A partir de esto es que se encuentra que hay un límite superior para la masa de una enana blanca, el cual se encuentra alrededor de 1.4 masas solares (MS). Si la masa es superior a 1.4 MS la presión de degeneración del núcleo no es suficiente para detener la contracción gravitacional. Este se llama el límite de Chandrasekhar.

Debido a la existencia de este límite es que las estrellas de entre 1.4 MS y 11 MS deben perder masa para poder convertirse en enanas blancas. Ya explicamos que dos medios de pérdida de masa son los vientos estelares y la expulsión de nebulosas planetarias.

A esto puede dar lugar la unión de dos enanas blancas

Después de que una estrella se ha convertido en enana blanca, lo más probable es que su destino sea enfriarse y perder brillo. Debido a que las enanas blancas tienen una baja luminosidad, pierden energía lentamente, por lo que pueden permanecer en esta etapa en el orden de años. Una vez que se enfrían, se vuelven rocas que se quedan vagando por el Universo. Este es el triste destino de nuestro Sol.

La detección de enanas blancas es difícil, ya que son objetos con un brillo muy débil. Por otro lado, hay ciertas diferencias en las enanas blancas según su masa. Las enanas blancas menos masivas sólo alcanzan a quemar hidrógeno en helio. Es decir, el núcleo de la estrella nunca se comprime lo suficiente como para alcanzar la temperatura necesaria para quemar helio en carbono. Las enanas blancas más masivas sí llevan a cabo reacciones nucleares de elementos más pesados, es decir, en su núcleo podemos encontrar carbono y oxígeno.

Comparación de tamaños entre la enana blanca IK Pegasi B (centro abajo), su compañera de clase espectral A IK Pegasi A (izquierda) y el Sol (derecha). Esta enana blanca tiene una temperatura en la superficie de 35.500 K.

Allá por el año 1908, siendo Chandraskhar un avanzado estudiante de física, vivía en Madrás, en la Bahía de Bengala (En cuyo Puerto trabajó Ramanujan), y, estando en la aquella ciudad el célebre científico Arnold Sommerfeld, le pidió audiciencia y se pudo entrevistar con él que, le vino a decir que la física que estudiaba estaba pasada, que ahora se estaban estudiando nuevos caminos de la física y, sobre todo, uno a cuya teoría se la llamaba mecánica cuántica que podía explicar el comportamiento de lo muy pequeño.

Chandrasekhar

Cuando se despidieron Sommerfeld dio a Chandrasekhar la prueba de imprenta de un artículo técnico que acaba de escribir. Contenía una derivación de las leyes mecanocuánticas que gobiernan grandes conjuntos de electrones comprimidos en volúmenes pequeños, por ejemplo (para este caso) en una estrella enana blanca.

A partir de aquel artículo, Chandrasekhar buscó más información y estudió estos fenómenos estelares que desembocaban en enanas blancas. Este tipo de estrella habían descuibiertas por las astrónomos a través de sus telescopios. Lo misterioso de las enanas blancas era su densidad extraordinariamente alta de la materia en su interior, una densidad muchísimo mayor que la decualquier otra cosa que los seres humanos hubieran encontrado antes. Chandrasekhar no tenía forma de saberlo cuando abrió un libro de Eddintong que versaba sobre la materia, pero la lucha por desvelar el misterio de e4sta alta densidad le obligaría fibnalmente a él y a Eddintong a afrontar la posibilidad de que las estrellas masivas, cuando mueren, pudieran contraerse para formar agujeros negros.

De las enanas blancas más conocidas y cercanas, tenemos a Sirio B. Sirio A y Sirio B son la sexta y la seéptima estrellas en orden de proxomidad a la Tierra, a 8,6 años-luz de distancia, y Sirio es la estrella más brillante en nuestro cielo. Sirio B orbita en torno a Sirio de la misma manera que lo hace la Tierra alrededor del Sol, pero Sirio B tarde 50 años en completar una órbita a Serio y la Tierra 1 año al Sol.

Eddintong describía como habían estimado los astrónomos, a partir de observaciones con telescopios, la masa y la circunferencia de Sirio B. La masa era de 0,85 veces la masa del Sol; la circunferencia media 118.000 km. Esto significaba que la densidad media de Sirio B era de 61.000 gramos por centímetro cúbico, es decirm 61.000 veces mayor que la densidad del agua. “Este argumento se conoce ya desde hace algunos añis -nos decía Eddintong-” Sin embargo, la mayoría de los astróniomos de aquel tiempo, no se tomaban en serio tal densidad, Sin embargo, si hubieran conocido la vrdad que ahora conocemos: (Una masa de 1,05 soles, una circunferencia de 31.000 km y una densidad de 4 millones de gramos por cm3), la habrían considerado aún más absurda.

Arriba la famosa Nebuliosa planetaria ojo de Gato que, en su centro luce una estrella enana blanca de energéticas radiaciones en el ultravioleta y que, a medida que se vaya enfriando, serán de rayos C y radio hasta que, dentro de unos 100 millones de añosm vieja y fria, será más rojiza y se habrá convertido en eun cadáver estelar.

Aquellos trabajos de Chandraskar y Eddintong desembocaron en un profundo conocimiento de las estrellas de neutrones y, se llego a saber el por qué conseguian el equilibrio que las estabilizaba a través de la salvación que, finalmente encontraban, en la mecánica cuántica, cuando los electrones degenerados por causa del Principio de esclusión de Pauli, no dejaban que la fuerza gravitatoria continuara el proceso de contracción de la estrella y así, quedaba estabilizada como estrella de neutrones.

Enana blanca en formación y nebulosa planetaria en expansión. Este gas está impulsado por un superviento del que absorbe su radiación ultravioleta más intensa en la región interior y la reemite en la zona exterior en forma de radiaciones de menor frecuencia, ya en el visible, provocando hermosas combinaciones de colores y formas.

De la misma manera, se repetía el proceso para estrellas más masivas que, no pudiendo ser frenadas en su implosión gravitatoria por la degeneración de los electrones, sí que podia frenarse la Gravedad, mediante la degeneración de los Neutrones. Cuando esa estrella más masiva se contraía más y más, el Principio de exclusión de pauli que impide que los fermiones estén juntos, comenzaba su trabajo e impedía que los neutrones (que son fermiones), se juntaran más, entonces, como antes los electrones, se degeneraban y comenzaban a moverse con velocidades relativistas y, tan hecho, impedía, por sí mismo que la Gravedad consiguiera comprimir más la masa de la estrella que, de esta manera, quedaba convertida, finalmente, en una Estrella de Neutrones.

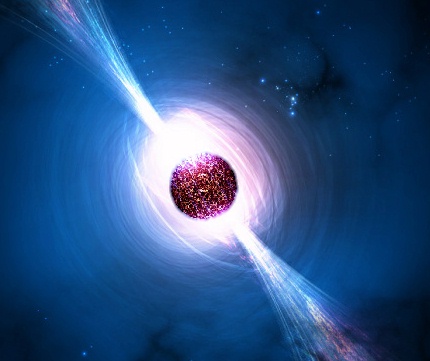

Al formarse la estrella de neutrones la estrella se colapsa hasta formar una esfera perfecta con un radio de tan solo unos 10 kilómetros. En este punto la presión neutrónica de Fermi resultante compensa la fuerza gravitatoria y estabiliza la estrella de neutrones. Apenas una cucharilla del material que conforma una estrella de neutrones tendría una masa superior a 5 x 1012 kilogramos.

Los modelos de estrellas de neutrones que se han logrado construir utilizando las leyes físicas presentan varias capas. Las estrella de neutrones presentarían una corteza de hierro muy liso de, aproximadamente, un metro de espesor. Debajo de esta corteza, prácticamente todo el material está compuesto por núcleos y partículas atómicas fuertemente comprimidos formando un “cristal” sólido de materia nucleica.

Son objetos extremadamente pequeños u densos que surgen cuando estrellas masivas sufren una explosión supernova del tipo II, el núculeo se colapsa bajo su propia gravedad y puede llegar hasta una densidad de 1017 Kg/m3. Los electrones y los protones que están muy juntos se fusionan y forman neutrones. El resultado final consiste solo en neutrones, cuyo material, conforma la estrella del mismo nombre. Con una masa poco mayor que la del Sol, tendría un diámetro de sólo 30 Km, y una densidad mucho mayor que la que habría en un terón de azúcar con una masa igual a la de toda la humkanidad. Cuanto mayor es la masa de una estrella de neutrones, menor será su diámetro. Está compuesta por un interior de neutrones superfluidos (es decir, neutrones que se comportan como un fluido de viscosidad cero), rodeado por más o menos una corteza sólida de 1 km de grosos compuesta de elementos como el hierro. Los púlsares son estrellas de neutrones magnetizadas en rotación. Las binarias de rayos X masivas tambioén se piensan que contienen estrellas de neutrones.

Todos aquellos argumentos sobre el comportamiento de las enanas blancas vinieron a desembocar en la paradoja de Edddintong que, en realidad, fue resulta por el Joven Chandrasekhar en el año 1925 al leer un artículo de R.H. Fowler “Sobre la materia densa”. La solución residía en el fallo de las leyes de la física que utilizaba Eddintong. Dcihas leyes debían ser reemplazadas por la nueva mecánica cuántica, que describía la presión en el interior de Sirio B y otras enanas blancas como debida no al calor sino a un fenómeno mecanocuántico nuevo: los movimientos degenerados de los electrones, también llamado degeneración electrónica.

La degeneración electrónica es algo muy parecido a la claustrofia humana. Cuando la materia es comprimida hasta hasta una densidad 10.000 veces mayor que la de una roca, la nube de electrones en torno a cada uno de sus núcleos atómicos se hace 10.000 veces más condensada, Así, cada electrón queda confinado en una “celda” con un volumen 10.000 veces menor que el volumen en el que previamente podía moverse. Con tan poco espacio disponible, el electrón, como nos pasaría a cualquiera de nosotros, se siente incómodo, siente claustrofobia y comienza a agitarse de manera incontrolada, golpeando con enorme fuerza las paredes de las celdas adyacentes. Nada puede deternerlo, el electrón está obligado a ello por las leyes de la mecánica cuántica. Esto está producido por el Primncipio de esclusión de Pauli que impide que dos fermiones estén juntos, así que, esta fuerza es, la que finalmente posibilita que la estrella que se comprime más y más, quede finalmente, constiruida estable como una enana blanca.

emilio silvera

Dic

19

Nanomagnetismo, espintrónica…¿Hasta dónde llegaremos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencia futura ~

Clasificado en Ciencia futura ~

Comments (0)

Comments (0)

“El extraterrestre es mi hermano” [Y entonces salimos para volver a ver las estrellas]. Con este célebre verso finaliza el Canto del Infierno de la Divina Comedia de Dante, y que sirve para describir la misión de la Astronomía, que es sobre todo, la de restituir a los hombres la dimensión justa de las criaturas pequeñas y frágiles ante el escenario inconmensurable de millones y millones de galaxias.

¿Y si después descubriéramos que no estamos solos en el Universo?

La Astronomía tiene un profundo valor profundamente humano. Es una Ciencia que abre el corazón y la Mente. Nos ayuda a situar en la perspectiva correcta nuestra vida, nuestras esperanzas y nuestros problemas. En este sentido, podemos decir que, estamos más cerca que nunca del Universo del que formamos parte.

No puedo explicar como me han salido esas palabras del comienzo, toda vez que, mi intención cuando comencé a escribir, era la de hablar un poco del magnetismo y de cosas pequeñas que, en el futuro no muy lejano, nos pueden situar en el plano de lo más alto de la tecnología.

El estudio del magnetismo en España está a un buen nivel y su dinámica está distribuida por todo el pais. La Física de esta disciplina despertó allá por los años setenta y, hasta el momento, no ha hecho más que crecer. Amplias son las aplicaciones del magnetismo en los problemas básicos, como las omnipresentes aplicaciones tecnológicas del magnetismo. Estas temáticas abarcan desde la investigación en materiales masivos clásicos, tales como los duros para imánes permanentes y blandos para transformadores, sensores o actuadores, hasta los aspectos más modernos relacionados con los nanomateriales y la espintrónica. Hoy día, es en este último campo donde se desarrolla la mayor parte de la actividad investigadora relacionada con el magnetismo en España y en el resto del Mundo.

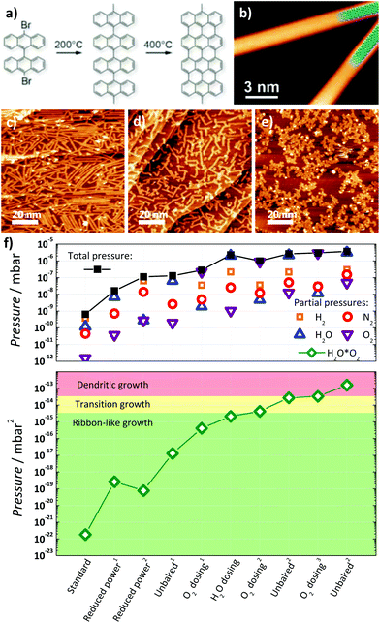

Proceso de vaciado del núcleo de oxo-hidróxido de hierro y “rellenado” de material magnético duro.

Esquema artístico del experimento de bombardeo con un pulso de corriente de electrones sobre un disco de lámina delgada de CoCrPt (cuadrado). El pulso crea campos magnéticos sobre el disco (circulos), según la ley de faraday.

Los llamados nanomateriales constituyen una nueva generación de sistemas preparados artificialmente, que tienen un gran impacto científico tanto por lo que hace referencia a la ciencia básica como a sus aplicaciones tecnológicas. Todos ellos comparten la característica común de contener estructuras de tamaño nanométrico. Es precisamente la existencia de esas escalas nanométricas lo que confiere grados de libertad a la complejidad de estos sistemas y da lugar a la aparición de una gran variedad de nuevos fenómenos. El control de una estructura mediante distintas técnicas de preparación y de tratamiento ulterios permite prediseñar a la carta sus resultados finales. Es por ello que, en las últimas décadas, los nanomateriales se han convertido en sistema paradigmáticos para el descubrimioento de nuevos fenómenos y la exploración de modelos y teorías de la ciencia de materiales y la física, como es el caso de la magnetorresisitencia gigante,descubiertas por los Profesores Fert y Grünberg que obtuvieron el Nobel de Física de 2007.

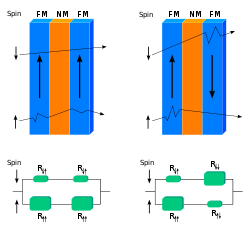

GMR de válvula de spin.

El francés Albert Fert y el alemán Meter Grünberg se han hecho con el Premio Nobel de Física 2007 por su descubrimiento de la magnetorresistencia gigante, un efecto de la mecánica cuántica que ha permitido el diseño de lectores de discos duros de ordenadores y la miniaturización de estos dispositivos, ha comunicado hoy la Real Academia de Ciencias de Suecia. El galardón premia así a la primera gran aplicación práctica de la nanotecnología (disciplina de la física dedicada al estudio de la materia de tamaño menor a un micrómetro -una millonésima parte de un metro-).

o

o  (donde

(donde  es la constante de Planck dividida por 2π o constante racionalizada de Planck (ℏ).

es la constante de Planck dividida por 2π o constante racionalizada de Planck (ℏ).

En física, un salto cuántico es un cambio abrupto del estado físico de un sistema cuántico de forma prácticamente instantánea. El nombre se aplica a diversas situaciones. La expresión salto se refiere a que el fenómeno cuántico contradice abiertamente el principio filosófico repetido por Newton y Leibniz de que Natura non facit saltus (‘La naturaleza no procede a saltos’).

Los orbitales f (l=3) también tienen un aspecto multilobular. Existen siete tipos de orbitales f (que corresponden a m=-3, -2, -1, 0, +1, +2, +3).

Una vez descritos los cuatro número cuánticos, podemos utilizarlos para describir la estructura electrónica del átomo de hidrógeno:

El electrón de un átomo de hidrógeno en el estado fundamental se encuentra en el nivel de energía más bajo, es decir, n=1, y dado que la primera capa principal contiene sólo un orbital s, el número cuántico orbital es l=0. El único valor posible para el número cuántico magnético es ml=0. Cualquiera de los dos estados de spin son posibles para el electrón. Así podríamos decir que el electrón de un átomo de hidrógeno en el estado fundamental está en el orbital 1s, o que es un electrón 1s, y se representa mediante la notación: 1s1 en donde el superíndice 1 indica un electrón en el orbital 1s. Ambos estados de espín están permitidos, pero no designamos el estado de espín en esta notación.

Pero volvamos a la espintrónica. Otro problema de gran interés en este nuevo campo es el diseño de una nueva generación de transistores basados en el proceso de espín electrónico, los cuales deben combinar materiales ferromagnéticos y semiconductores. Para este fin, es fundamental optimizar los procesos de inyección de corrientes polarizadas de espín en semiconductores y por ello existe una gran actividad investigadora en los llamados semicondcutores magnéticos diluidos que parecen sistemas muy prometedores. Además, los fenómenos inducidos por el transporte de corrientes polarizadas de espín, tales como transferencia de momento angular del espín, la inversión de la imanación y el movimiento de paredes de dominio, son fundamentales en el diseño de nuevos dispositivos espintrónicos (generación de microondas, memorias magnéticas no volátiles…).

Por lo que hace referencia a estas temáticas, los materiales que se están estudiando en España se centran principalmente en heteroestructuras por capas delgadas y abarcan desde los óxidos magnéticos con estructuras derivadas de la perovskita hasta materiales conductores, tales como la magnetita (donde se ha estudiado los efectos magnetorresistivos y el efecto Hall anómola en capas epitaxiales) y las aleaciones tipo Heuxler, incluyendo también semiconductores magnéticos diluidos, como por ejemplo Mn-SnO2 y Mn-GaAs.

Dic

18

¿Pueden llegarnos mensajes del futuro?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Especulando ~

Clasificado en Especulando ~

Comments (1)

Comments (1)

Investigadores proponen una solución a algunos problemas de la Física Cuántica, y se refieren a los viajes en el tiempo o la paradoja del abuelo.

Las curvas temporales abiertas podrían resolver muchos problemas de la Física – NPJ QUANTUM INFORMATION

Un grupo internacional de investigadores, liderados por la Universidad de Singapur, acaba de demostrar que numerosos problemas de la Física Cuántica, hoy por hoy irresolubles, podrían solucionarse fácilmente con un ordenador cuántico que viajara a través de “curvas temporales abiertas”. El trabajo, que ha levantado gran expectación en la comunidad científica, se publica en la revista Nature Quantum Information.

IBM prepara el primer ordenador cuántico. La máquina podría resolver problemas que las computadoras actuales ni se pueden plantear. Cuando esté completada su configuración podrá dar millones de respuestas a un problema planteado en fracciones de segundo.

Hace ya una década que el físico Dave Bacon, que en la actualidad trabaja para Google, demostró que la mejor forma de resolver rápidamente todo un grupo de problemas de la Física (llamados NP-completo) y que traían de cabeza a los matemáticos, era utilizando un ordenador cuántico que se desplazara a través del tiempo. ¿La razón? El hipotético ordenador de Bacon podría moverse con libertad a través de una serie de “curvas cerradas de tiempo”, atajos en el tejido espaciotemporal que se curvan sobre sí mismos. La relatividad general en efecto, permite que dichos caminos puedan existir a través de las contorsiones en el espacio-tiempo que conocemos como agujeros de gusano.

¿Pero para qué enviar un mensaje en el tiempo y bloquearlo después para que nadie pueda leer su contenido? Sencillamente porque el procedimiento podría ser la clave que se necesitaba para resolver problemas que, actualmente, no tienen solución alguna. Y es que incluso un mensaje “sin abrir” puede resultar tremendamente útil, especialmente si los científicos “entrelazan” el mensaje con algún otro sistema antes de enviarlo.

Como se sabe, el entrelazamiento cuántico es un efecto extraño que es posible solo en el mundo de la Física subatómica, y consiste en una suerte de “comunicación instantánea” entre partículas que, como si fueran hermanos gemelos diminutos, “saben” al instante lo que le ha sucedido a las demás partículas entrelazadas y reaccionan al instante, sin importar la distancia que las separe. Y lo que proponen los investigadores es precisamente eso, crear un entrelazamiento entre el mensaje enviado a través del tiempo y el sistema del laboratorio. Una correlación que podría alimentar y potenciar la computación cuántica.

Sin embargo, las curvas temporales cerradas conllevan no pocos problemas. En general, los físicos creen que, aunque son teóricamente posibles, algo debe de estar evitando que ese tipo de desplazamientos temporales se produzcan en la Naturaleza. De otra forma, argumentan, podrían darse todo tipo de paradojas, entre ellas la clásica de que alguien podría viajar al pasado y matar a su abuelo, impidiendo así su propia existencia.

Y no solo es la familia la que estaría amenazada por unos viajes así. En efecto, romper el flujo temporal, dejando a un lado el principio de causalidad (un acontecimiento causa otro, que causa otro, y otro…) también puede tener consecuencias para la propia Física cuántica. A lo largo de las dos décadas pasadas los investigadores han mostrado hasta la saciedad que los principios mismos sobre los que se basa la Física Cuántica se quiebran en pedazos ante la presencia de curvas temporales cerradas. Por ejemplo, se puede quebrar el principio de incertidumbre, que establece la imposibilidad de conocer al mismo tiempo determinados pares de magnitudes físicas de una partícula (como la velocidad y el momento). O incluso dejar a un lado el Teorema de no Clonación, que dice que los estados cuánticos no se pueden copiar y que constituye uno de los pilares más sólidos de la Mecánica Cuántica.

Evitar las paradojas

De Historias referidas a Viajes en el Tiempo hemos podido ver muchas en películas fantásticas

Sin embargo, el nuevo trabajo muestra que un ordenador cuántico sería capaz de resolver problemas hasta ahora irresolubles si en vez de por curvas cerradas, se desplazara a través de “curvas temporales abiertas”, que no crean los problemas de causalidad anteriormente descritos. Esto se debe a que dichas curvas no permiten la interacción directa con cualquier cosa en el propio pasado del objeto: las partículas viajeras del tiempo (o, para ser más exactos, los datos que contienen) nunca interaccionarían con sí mismas.

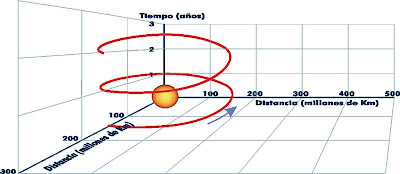

En la Teoría de la Relatividad se admite un espacio tetradimensional, con tres coordenadas espaciales y una temporal. Como no es posible representar en nuestra realidad semejante espacio de cuatro dimensiones, realizaremos una aproximación representando por un plano el espacio tridimensional, más una coordenada temporal. Las soluciones temporales abiertas para expresar la evolución de un punto sería una gráfica del tipo:

Pra Mila Gu, de la Universidad de Singapur y director de la investigación, de esta forma “evitamos las paradojas clásicas, como la de los abuelos, aunque seguimos consiguiendo todos esos resultados extraños”.

“Cada vez que presentamos la idea -afirma por su parte Jayne Thompson, coautor de la investigación- todo el mundo dice que no hay forma de que esto pueda tener un efecto”. Pero sí que la hay. Las partículas enviadas de esta forma a través de un bucle temporal pueden, de hecho, ganar un enorme poder de “super computación”, incluso si jamás interactúan con nada del pasado. “La razón se debe a que algunos datos se almacenan en las correlaciones de entrelazado: y esto es precisamente lo que estamos aprovechando”, asegura Thompson.

Sin embargo, no todos los físicos piensan que estas líneas de tiempo abiertas tengan más posibilidades de manifestarse en el Universo físico que las líneas cerradas. Y pueden que tengan razón. Uno de los principales argumentos en contra de la existencia de curvas temporales cerradas es que nadie, que sepamos, nos ha visitado nunca desde el futuro. Un argumento que, por lo menos, no es válido con las curvas temporales abiertas, ya que en ellas cualquier mensaje procedente del futuro resultaría bloqueado.

Dic

18

No siempre hablamos de lo que comprendemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Lo que no sabemos ~

Clasificado en Lo que no sabemos ~

Comments (0)

Comments (0)

No importa el lugar o el momento, cualquier sitio es bueno para debatir y exponer lo que creemos sobre un tema en particular, y, lo curioso del caso es que, como anuncia el título de este trabajo, no siempre hablamos sobre lo que sabemos, sino sobre lo que creemos saber.

¡La Física! Lo que busca la física fundamental es reducir las leyes de la naturaleza a una teoría final sencilla que lo explique todo. El físico y premio Nobel Steven Weinberg señala que las reglas fundamentales son lo más satisfactorio (al menos para él). Las leyes básicas de Isaac Newton, que predicen el comportamiento de los planetas, son más satisfactorias, por ejemplo, que un almanaque en el que se indique la posición de todos los planetas en cada momento. Weinberg nos dice que la Física no puede explicarlo todo, matizando que sólo puede explicar los sucesos relacionándolos con otros sucesos y con las reglas existentes.

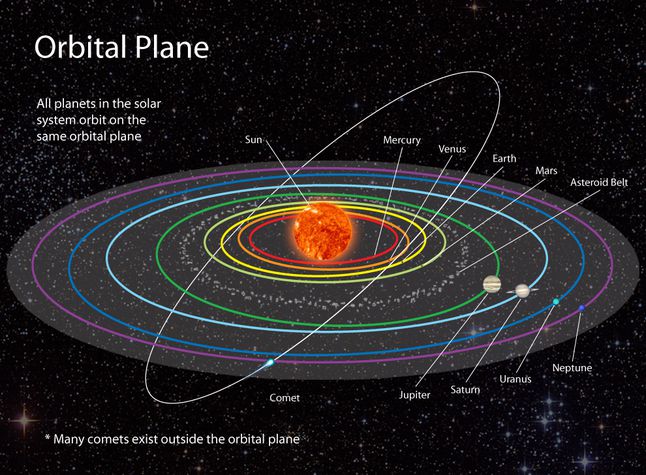

Por ejemplo, las órbitas de los planetas son el resultado de unas reglas, pero las distancias de los planetas al Sol son accidentales, y no son consecuencia de ley fundamental alguna. Claro que, también las leyes podrían ser fruto de casualidades. Lo que sí es cierto es que los físicos están más interesados por descubrir las reglas que por los sucesos que dichas reglas determinan, y más por los hechos que son independientes del tiempo; por ejemplo, les interesa más la masa del electrón que un tornado que se pueda producir en un lugar determinado.

La ciencia, como nos dice Weinberg, no puede explicarlo todo y, sin embargo, algunos físicos tienen la sensación de que nos estamos acercando a “una explicación del mundo” y, algún día, aunando todos los esfuerzos de muchos, las ideas de las mejores mentes que han sido, y las nuevas que llegarán, podremos, al fín, construir esa Teoría final tan largamente soñada que, para que sea convincente, deberá también, incluirnos a nosotros. Pero, paradógicamente y a pesar de estos pensamientos, existen hechos que los contradicen, por ejemplo, conocemos toda la física fundamental de la molécula de agua desde hace 7 decenas de años, pero todavía no hay nadie que pueda explicar por qué el agua hierve a los 100 ºC. ¿Qué ocurre? ¿Somos acaso demasiado tontos? Bueno, me atrevería a pronosticar que seguiremos siendo “demasiado tontos” incluso cuando los físicos consigan (por fin) esa teoría final que nos pueda dar una “explicación del mundo”. Siempre seguiremos siendo aprendices de la naturaleza que, sabia ella, nos esconde sus secretos para que persista el misterio.

¿Qué sería de nosotros si lo supiéramos todo? Creo que la decadencia se apoderaría de nuestras mentes que, ausente de curiosidad, decaería en un vacío sin retorno.

La explicación que dan los físicos actualmente sobre la subestructuras de la materia se llama “el modelo estándar”. En este modelo están incluidas las doce partículas elementales y las tres fuerzas que, cuando se mezclan y se encajan, sirven para construir todo lo que hay en el universo, desde un redondo pan de pueblo hecho en un horno de leña, hasta las más complejas galaxias, y puede explicar todos los mecanismos de acción, es decir, la mecánica del mundo.

Entre las partículas figuran los seis Quarks famosos: arriba, abajo, extraño, encanto, fondo y cima. Las otras seis partículas son Leptones: el electrón y sus dos parientes más pesados, el muón y el tau y los tres neutrinos a ellos asociados. Las tres fuerzas son la electromagnética, la fuerza nuclear fuerte (que mantiene unidos a los quarks) y la fuerza nuclear débil (responsable de la radioactividasd). Hay una cuarta fuerza: la Gravedad que, aunque tan importante como las demás, nadie ha sabido como encajarla en el modelo estándar. Todas las partículas y fuerzas de este modelo son cuánticas; es decir, siguen las reglas de la mecánica cuántica. Aún no existe una teoría de la gravedad cuántica.

En realidad, la región que denominamos Gravedad cuántica nos lleva y comprende preguntas sobre el origen del universo observable que nadie ha sabido contestar. Nos lleva a complejos procesos cuánticos situados en las épocas más cercanas imaginables en un espacio-tiempo clásico, es decir, en lo que se conoce como Tiempo de Planck a 10-43 segundos del supuesto big bang, cuando reinaba una temperatura del orden de 10 x 1031 K. Pero, como hemos dicho, al no existir una teoría autoconsistente de la Gravedad cuántica, lo único que podemos hacer (como en tantas otras áreas de la Ciencia) es especular.

El Modelo Estándar no es, ni mucho menos, satisfactorio. Los científicos piensan que no sólo es incompleto, sino que es demasiado complicado y, desde hace mucho tiempo, buscan, incansables, otro modelo más sencillo y completo que explique mejor las cosas y que, además, no tenga (como tiene el modelo actual) una veintena de parámetros aleatorios y necesarios para que cuadren las cuentas…, un ejemplo: el bosón de Higgs necesario para dar masa a las partículas que, fue introducido sin tener la certeza de su existencia.

¡La masa! ese gran problema. Todas las partículas tienen masa diferentes pero nadie sabe de donde salen sus valores. No existe fórmula alguna que diga, por ejemplo, que el quark extraño debería pesar el doble (o lo que sea) del quark arriba, o que el electrón deba tener 1/200 (u otra proporción) de la masa del muón. Las masas son de todo tipo y es preciso “ponerlas a mano”, como se suele decir: cada una ha de ser medida experimental e individualmente. En realidad, ¿por qué han de tener masa las partículas? ¿de dónde viene la masa?

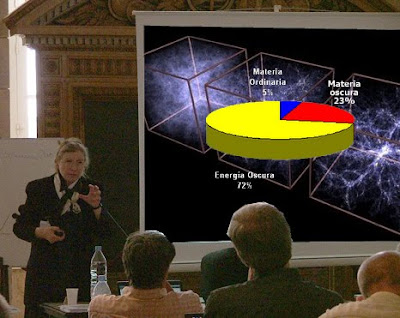

No puedo evitarlo ni tampoco me puedo quedar callado, cuando he asistido a alguna conferencia sobre la materia y, el ponente de turno se agarra a la “materia oscura” para justificar lo que no sabe, si al final hay debate, entro en escena para discutir sobre la existencia de esa “materia fantasma” que quiere tapar nuestra enorme ignorancia.

Pero, sigamos con el problema de la masa. Para resolverlo, muchos expertos en física de partículas creen actualmente en algo que llaman “campo de Higgs”. Se trata de un campo misterioso, invisible y etéreo que está permeando todo el espacio (¿habrán vuelto al antiguo éter pero cambiándole el nombre?). Hace que la materia parezca pesada, como cuando tratamos de correr por el fondo de la piscina llena de agua pero que el agua no se pudiera ver. Si pudiéramos encontrar ese campo, o más bien la partícula que se cree es la manifestación de ese campo (llamada el bosón de Higgs), avanzaríamos un largo trecho hacia el conocimiento del universo. ¡Ah! Ya dijeron que la habían encontrado pero… Como con las Ondas gravitacionales, lo han dicho pero…

Aquí, en este imponente artilugio inventiva de nuestras mentes, se quiere dar respuesta a una serie de interrogantes que se espera solucionar con este experimento:

• Qué es la masa.

• El origen de la masa de las partículas

• El origen de la masa para los bariones.

• El número exacto de partículas del átomo.

Y otros muchos enigmas que nos gritan, tales como “materia oscura”, hiperespacio, agujero de gusano, universos paralelos…

¿Qué simboliza Shiva, el dios destructor, en el Acelerador de Partículas del CERN? Pocos saben que, un año después de la gran inauguración del CERN, Sergio Bertolucci, exdirector de Investigación e Informática Científica del CERN, afirmó que el Gran Colisionador de Hadrones podría abrir puertas a otra dimensión en “un lapso de tiempo muy pequeño”, añadiendo que quizá fuese suficiente “para mirar en el interior de esa puerta abierta, para obtener o enviar algo”.

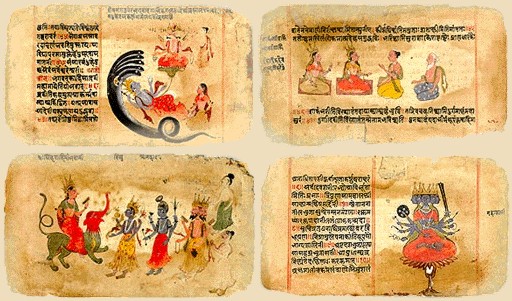

Si no fuera tan largo de contar, os diría que, en realidad, el Campo de Higgs se descubrió hace ya muchos siglos en la antigua India, con el nopmbre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las ideas modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando hacia unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

Hacia la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido como “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

emilio silvera

Totales: 75.404.776

Totales: 75.404.776 Conectados: 101

Conectados: 101