Feb

25

¡Las Partículas! ¿Elementales?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (14)

Comments (14)

Generalmente las llamamos partículas elementales pero, lo cierto es que, algunas son más elementales que otras. Los físicos experimentadores hicieron un buen trabajo en aquellos antiguos aceleradores de partículas por despejar la incognita y saber, de una vez por todas, de qué estaba hecha la materia.

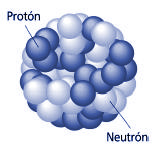

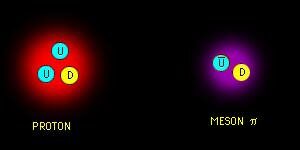

Los núcleos de los átomos están formados por protones y neutrones, alrededor de los cuales orbitan los electrones. Estos tres elementos (protones, neutrones y electrones) constituyen prácticamente toda la materia de la Tierra. Mientras que el electrón se considera como una partícula “sin tamaño”, el protón, que está compuesto de quarks, es un objeto con tamaño específico. Hasta ahora, sólo dos métodos se han utilizado para medir su radio. Basándose en el estudio de las interacciones entre un protón y un electrón, ambos métodos se centran en las colisiones entre uno y otro o sobre el átomo de hidrógeno (constituido por un electrón y un protón). El valor obtenido y que es el utilizado por los físicos, es 0,877 (+ / – 0,007) femtómetros.

Masa atómica

Una de las formas como los científicos miden el tamaño de algo es a través de su masa. Los científicos pueden incluso medir cosas muy minúsculas como los átomos. Una medida del tamaño de un átomo es su “masa atómica”. Casi toda la masa de un átomo (más del 99%) está en su núcleo, de manera que la “masa atómica” es realmente una medida del tamaño del núcleo de un átomo.

Los protones son practicamente del mismo tamaño que los neutrones, y ambos son mucho más grandes que los electrones. Un protón tiene una masa aproximadamente 1.836 veces mayor que la masa del electrón, pero las masas de los protones y neutrones se diferencian menos de uno por ciento. Un protón tiene una masa de 1.6726 x 10-24gramos. Los protones tienen una carga eléctrica positiva, conocida a veces como carga elemental, carga fundamental o carga de +1. Los electrones tienen una carga del mismo valor pero de polaridad opuesta, -1. La carga fundamental tiene un valor de 1.602 x 10-19 coulombios.

Núcleo atómico

El núcleo de un átomo contiene protones y neutrones. Cada elemento (como el carbono, oxígeno o el oro) tiene diferente número de protones en sus átomos. Los científicos tienen un nombre especial para el número de protones en un átomo. Lo llaman “número atómico”.

¿Por qué es importante el número atómico? Los átomos normales tienen el mismo número de electrones que protones. El número de electrones es lo que hace que cada elemento se comporte de cierta manera en reacciones químicas. De manera que el número atómico, que es el número de protones y electrones, es lo que hace que un elemento sea diferente a otro.

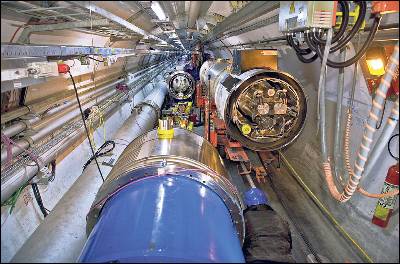

Hace algunos años ya que los físicos se preguntaban: ¿Podrían los protones ser puntos? Y, tratándo de saberlo, comenzaron a golpear los protones con otros protones de una energía muy baja (al principio) con el objeto de explorar la fuerza electromagnética entre los dos objetos cargados.

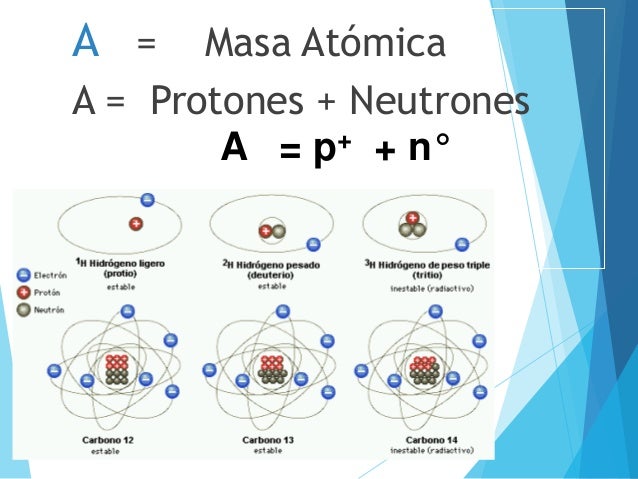

El Acelerador Lineal de Stanford. El SLAC, ubicado al sur de San Francisco, acelera electrones y positrones a lo largo de sus 2 millas de longitud (algo mas de tres kilómetros), hacia varios blancos, anillos y detectores ubicados en su finalización. Este acelerador hace colisionar electrones y positrones, estudiando las partículas resultantes de estas colisiones. Construido originalmente en 1962, se ha ido ampliando y mejorando para seguir siendo uno de los centros de investigación de física de partículas mas avanzados del mundo. El Centro ha ganado el premio Nobel en tres ocasiones.

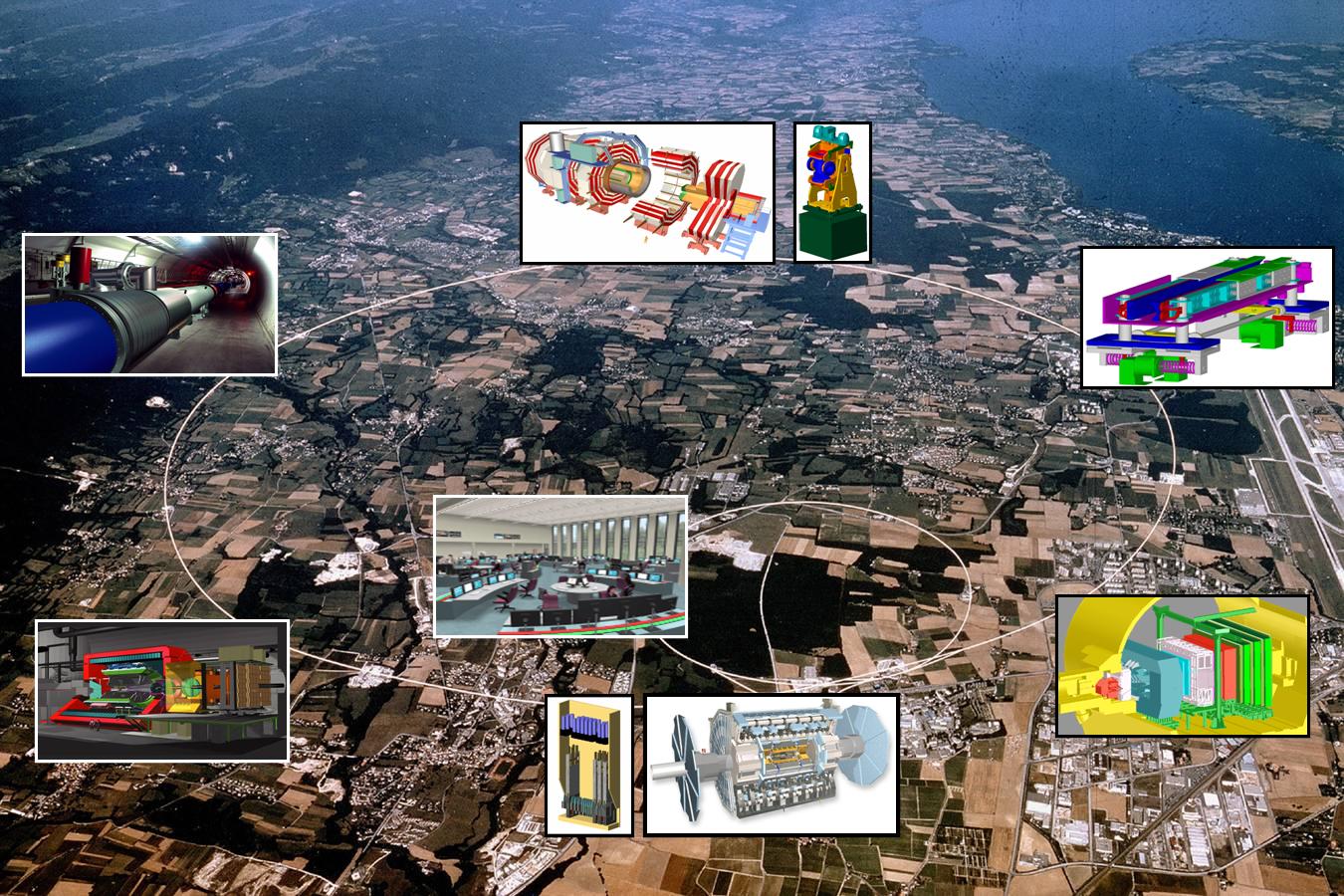

Si los físicos experimentales de la década de los 60 hubieran podido tener a su disposición el moderno LHC… ¿Dónde estaríamos ahora?

La interacción fuerte es cien veces más intensa que la fuerza eléctrica de Coulomb, pero, al contrario que ésta, su alcance no es en absoluto infinito. Se extiende sólo hasta una distancia de unos 10-13 centímetros, y luego cae deprisa a cero. Al incrementar la energía de colisión, los experimentos desenterraron más y más detalles desconocidos de la interacción fuerte. A medida que aumenta la energía, la longitud de onda de los protones (acordémonos de De Broglie y Schrödinger) se encoge. Y, como se pudo ver, cuanto menor sea la longitud de onda , más detalles cabe discernir en la partícula que se estudie.

Robert Hofstadter, de la Universidad de Stantanford, tomó en los años cincuenta algunas de las mejores “imágenes” del protón. En vez de un haz de protones, la “luz” que utilizó fue un haz de electrones de 800 MeV que apuntó a un pequeño recipiente de hidrógeno líquido. Los electrones bombardearon los protones del hidrógeno y el resultado fue un patrón de dispersión, el de los electrones que salían en una variedad de direcciones con respecto a su movimiento original. No era muy diferente a lo que hizo Rutherford. Al contrario que el protón, el electrón no responde a la interacción nuclear fuerte. Responde sólo a la carga eléctrica del protón, y por ello los científicos de Stanford pudieron explorar la forma de la distribución de carga del protón. Y esto, de hecho, reveló el tamaño del protón. Claramente no era un punto.

Se midió que el radio del protón era de 2,8 x 10-13 centímetros; la carga se acumula en el centro, y se desvanece en los bordes de lo que llamamos el protón. Los experimentos se repitieron muchas veces y los resultados, siempre fueron parecidos al hacerlos con haces de muones, que también ignoran la interacción fuerte al ser leptones como los electrones. (Medidas más precisas llevadas a cabo en nuestro tiempo, han podido detectar, diminutos cambios en el radio del protón que tienen enormes implicaciones. El protón parece ser 0,00000000000003 milímetros más pequeño de lo que los investigadores habían pensado anteriormente, de hecho, y según han comentados los físicos del equipo que hizo el trabajo, las nuevas medidas podrían indicar que hay un hueco en las teorías existentes de la mecánica cuántica y algo falla en alguna parte.)

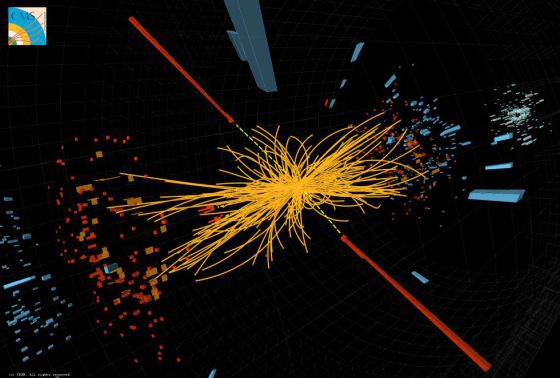

La imágen tomada en el SLAC, nos choca, todos tenemos en la mente las del LHC

Pero sigamos con la historia. Hallá por el año 1968, los físicos del Centro del Acelerador Lineal Stanford (SLAC), bombarderon los protones con electrones de mucha energía -de 8 a 15 GeV- y obtuvieron un conjunto muy diferente de patrones de dispersión. A esta “luz dura”, el protón presentaba un aspecto completamente distinto. Los electrones de energía relativamente baja que empleó Hofstadter podían ver sólo un protón “borroso”, una distribución regular de carga que hacía que el electrón pareciése una bolita musgosa. Los electrones del SLAC pudieron sondear con mayor dureza y dieron con algunos “personajillos” que “correteaban” dentro del protón. Aquella fue la primera indicación de la existencia real de los Quarks.

Todo avance ha requerido de muchísimo esfuerzo y de lo mejor de muchas mentes. Como podéis ver por la escueta y sencilla explicación aquí contenida, hemos aprendido muchas cosas a base de observar con atención los resultados de los experimentos que la mente de nuestra especie ha ideado para poder descubrir los secretos de la Naturaleza. Hemos aprendido acerca de las fuerzas y de cómo originan sus estructuras complejas, como por ejemplo los protones que no son, tan elementales como en un principio se creía. Los protones (que son Bariones) están formados por tres quarks y, sus primos (los Mesones) están compuestos por un quark y un anti-quark.

Como nos decía el Nobel León Lederman: “Uno no puede por menos que sentirse impresionado por la secuencia de ¡semillas dentro de semillas!. La molécula está formada por átomos. La región central del átomo es el nucleo. El núcleo está formado por protones y neutrones. El protón y el neutrón están formados por… ¿hasta dónde llegará ésto?

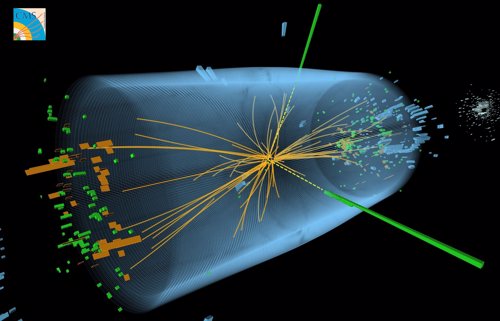

No es fácil conformarse con la idea de que, en los Quarks termina todo. Uno se siente tentado a pensar que, si profundizamos más utilizando energías superiores de las que ahora podemos disponer (14 TeV), posiblemente -sólo posiblemente- podríamos encontrarnos con objetos más pequeños que… ¡como cuerdas vibrantes! nos hablen de la verdadera esencia de la materia que, habiéndonos sido presentada ya, es posible que esconda algunos secretos que tendríamos que desvelar.

¡Poder profundizar hasta el límite de Planck con la energía de Planck! ¿Qué encontraríamos allí?

Lo cierto que, de momento, sólo es un sueño y, la energía de Planck está muy lejos de nuestro alcance. Poder contar con la energía de Planck, por el momento y durante mucho, mucho, muchísimo tiempo, será sólo un sueño que algunos físicos tienen en la mente. Una regla universal en la física de partículas es que para partículas con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez más pequeñas en el espacio y en el tiempo. El modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero existen varias razones para sospechar que sus predicciones pueden, finalmente (cuando podamos emplear más energía en un nivel más alto), resultar equivocadas.

equilibrio y estabilidad, el resultado de dos fuerzas contrapuestas

Vistas a través del microscopio, las constantes de la naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático no hay nada que objetar, pero la credibilidad del modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas, o lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas. ¿Y por qué debería ser el modelo válido hasta aquí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables. ¿Dónde está la partícula de Higgs? ¿Cómo se esconde de nosotros el gravitón? y, por no dejar nada en el tintero… ¿Dónde estarán las cuerdas?

Los Bosones de gauge aparecen en la columna derecha

Parece que el Modelo estándar no admite la cuarta fuerza (Gravedad), y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

Claro que las cosas no son tan sencilla y si deseamos evitar la necesidad de un delicado ajuste de las constantes de la naturaleza, creamos un nuevo problema: ¿cómo podemos modificar el modelo estándar de tal manera que el ajuste fino no sea necesario? Está claro que las modificaciones son necesarias, lo que implica que muy probablemente haya un límite más allá del cual el modelo tal como está deja de ser válido. El modelo estándar no será nada más que una aproximación matemática que hemos sido capaces de crear, de forma que todos los fenómenos que hemos observado hasta el presente están reflejados en él, pero cada vez que se pone en marcha un aparato más poderoso, tenemos que estar dispuestos a admitir que puedan ser necesarias algunas modificaciones del modelo para incluir nuevos datos que antes ignorábamos.

Más allá del modelo estándar habrá otras respuestas que nos lleven a poder hacer otras preguntas que en este momento, no sabemos ni plantear por falta de conocimientos. Si no conociéramos que los protones están formados por Quarks, ¿cómo nos podríamos preguntar si habrá algo más allá de los Quarks?

Se han estado inventando nuevas ideas, como la supersimetría y el technicolor. Los astrofísicos estarán interesados en tales ideas porque predicen una gran cantidad de nuevas partículas superpesadas, y también varios tipos de partículas que interaccionan ultradébilmente, los technipiones. Éstas podrían ser las WIMP’s (Weakly Interacting Massive Particles, o Partículas Masivas Débilmente Interactivas) que pueblan los huecos entre las galaxias, y serían así las responsables de la masa perdida que los astrofísicos siguen buscando y llaman “materia oscura”.

Que aparezcan “cosas” nuevas y además, imaginarlas antes, no es fácil. Recordemos cómo Paul Dirac se sintió muy incómodo cuando en 1931 dedujo, a partir de su ecuación del electrón, que debería existir una partícula con carga eléctrica opuesta. Esa partícula no había sido descubierta y le daba reparo perturbar la paz reinante en la comunidad científica con una idea tan revolucionaria, así que disfrazó un poco la noticia: “Quizá esta partícula cargada positivamente, tan extraña, sea simplemente el protón”, sugirió. Cuando poco después se identificó la auténtica antipartícula del electrón (el positrón) se sorprendió tanto que exclamó: “¡Mi ecuación es más inteligente que su inventor!”. Este último comentario es para poner un ejemplo de cómo los físicos trabajan y buscan caminos matemáticos mediante ecuaciones de las que, en cualquier momento (si están bien planteadas), surgen nuevas ideas y descubrimientos que ni se podían pensar. Así pasó también con las ecuaciones de Einstein de la realtividad general, donde Schwarzschild dedujo la existencia de los agujeros negros.

Claro que, a todo esto, tenemos que pensar en un Universo muy vasto y muy complejo que está dinamizado por leyes y energías que, aunque creemos conocer, nos puede estar ocultando muchas “cosas” que aún no sabemos y, llegar más allá de los Quarks…¡No será nada fácil!

Si pensamos detenidamente lo que hasta el momento llevamos conseguido (aunque nuestros deseos se desboquen queriendo ir mucho más allá), tendremos que convenir en el hecho cierto de que, haber podido llegar al átomo y también a las galaxias es, al menos ¡asombroso! Sabemos de lugares a los que, físicamente (probablemente) nunca podamos ir, la física nos lo impide…al menos de momento en lo relacionado con las galaxias y, de manera irreversible para el “universo cuántico” que sólo podremos sondear con inmensas energías en los aceleradores que nos dirán, lo que queremos saber.

emilio silvera

Feb

23

¡Agujeros negros!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La desbocada voracidad de los agujeros negros

El astrónomo Rafael Bachiller nos descubre en esta serie los fenómenos más espectaculares del Cosmos. Temas de palpitante investigación, aventuras astronómicas y novedades científicas sobre el Universo analizadas en profundidad.

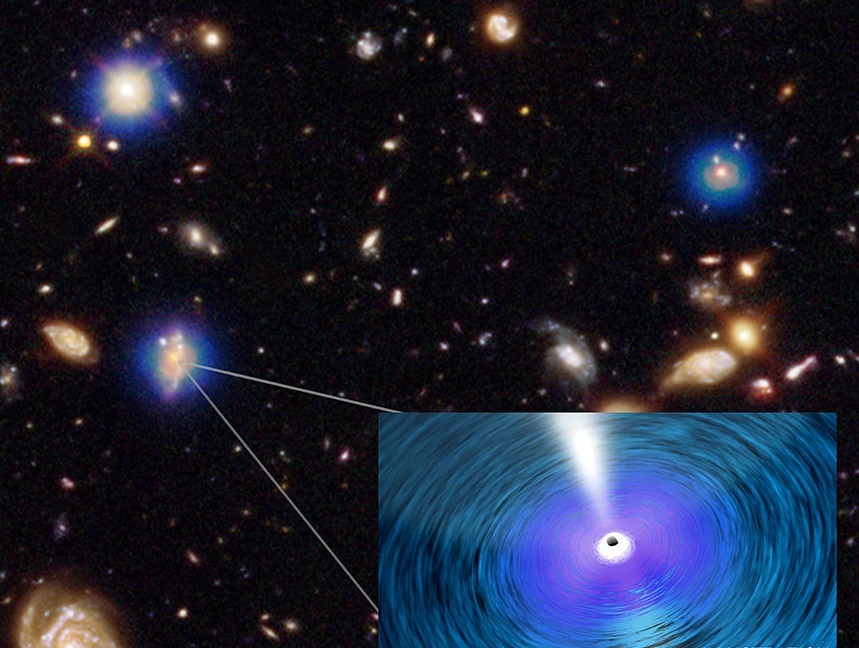

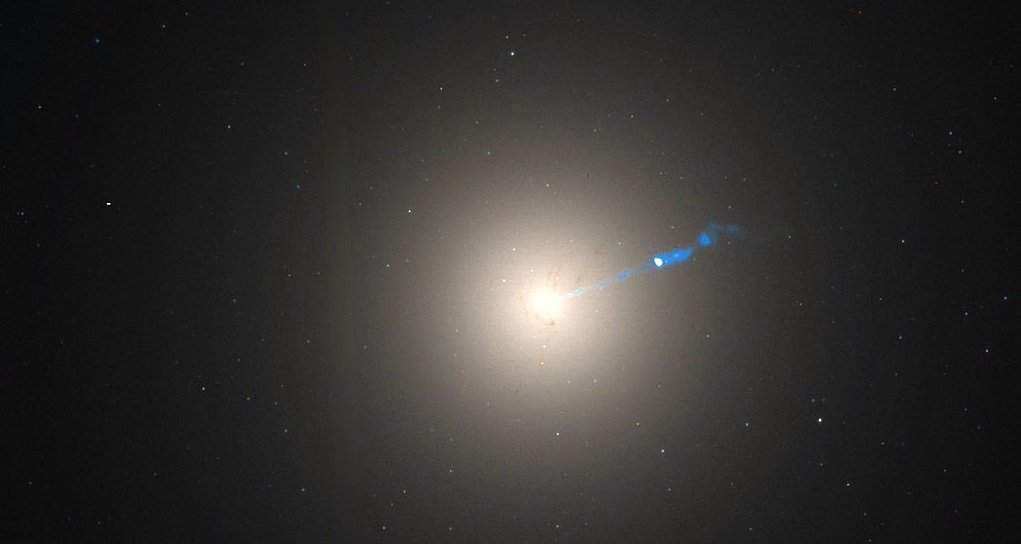

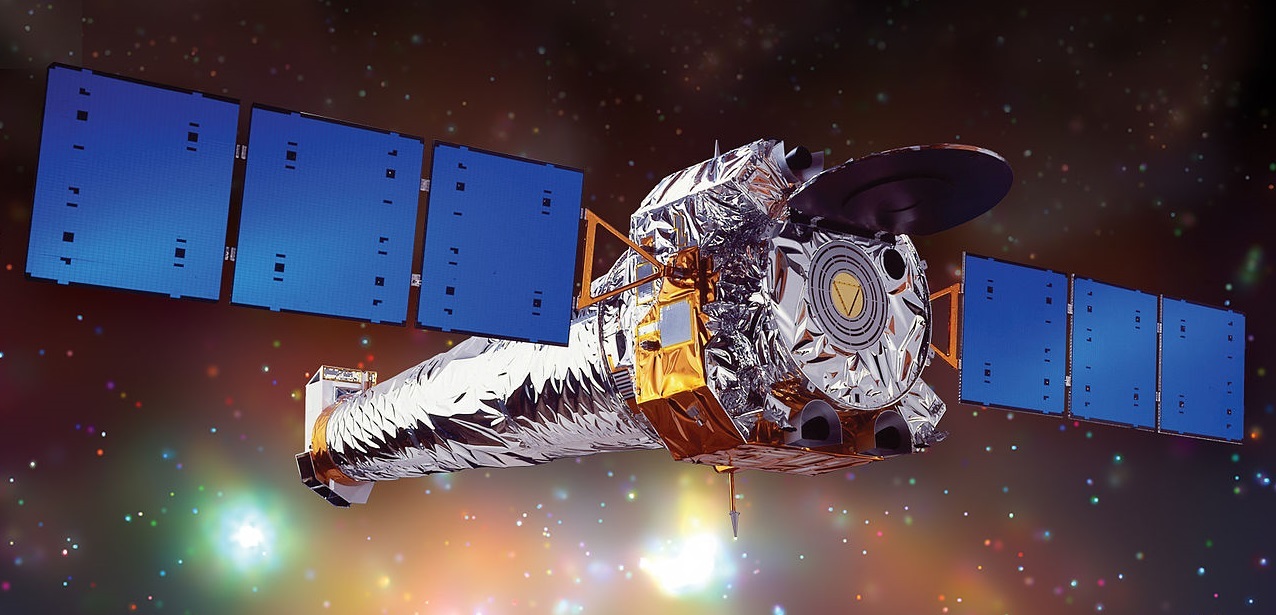

Observaciones recientes con varios telescopios, entre ellos el espacial de rayos X Chandra, revelan que el crecimiento de los mayores agujeros negros del Universo es mucho más rápido que el de las galaxias en las que están situados.

En el centro de todas las galaxias

Se cree que prácticamente todas las galaxias albergan un gran agujero negro supermasivo en su centro. La masa de tales agujeros negros puede alcanzar millones o hasta miles de millones de veces la masa de nuestro Sol. Por ejemplo, el agujero negro en el centro de nuestra Vía Láctea, conocido como Sagitario A*, tiene una masa modesta de unos 4 millones de soles, mientras que el de nuestra galaxia vecina M87 alcanza los 6.000 millones de masas solares. Este último pertenece por tanto a la categoría de agujeros negros más masivos de los conocidos, los que a veces se denominan ‘ultramasivos’.

Esos agujeros negros van aumentando su masa (creciendo) según devoran el material interestelar que abunda en su entono de los centros galácticos. Durante años, los astrónomos vienen obteniendo datos tanto de la masa de estos agujeros negros supermasivos como de la masa estelar en las galaxias que los cobijan.

Hasta ahora todo parecía indicar que los agujeros negros crecían de una manera acompasada con las galaxias que los albergan. Sin embargo, dos estudios recientes y, lo que es muy importante, independientes, acaban de refutar esta suposición.

Más aprisa en las más masivas

Un equipo de investigadores liderado por Guang Yang, de la Penn State University (EEUU), ha calculado la tasa de crecimiento de los agujeros negros y la masa estelar para galaxias de diferentes masas, pero situadas todas ellas a distancias que van de 4,3 a 12,2 miles de millones de años luz. Este equipo ha concluido que, comparativamente, los agujeros negros crecen mucho más aprisa en las galaxias más masivas.

Para este estudio, Yang y colaboradores utilizaron el telescopio espacial Chandra de rayos X y el Hubble (ambos de NASA) y otros observatorios. En la imagen que encabeza este artículo, se muestra en azul los datos de Chandra superpuestos sobre una imagen óptica e infrarroja tomada por el Hubble. Cada fuente de rayos X observada por Chandra está producida por el gas caliente que está siendo devorado por un agujero negro en el centro de su galaxia anfitriona.

En las galaxias con unos 100.000 millones de estrellas (del tipo de la Vía Láctea) la razón entre las dos tasas de crecimiento (agujeros negros y estrellas) es 10 veces más alta que en galaxias de 10.000 millones de estrellas. Parece pues que los agujeros negros se alimentan más rápida y eficazmente en las galaxias muy masivas que en las menos masivas.

Ultramasivos

De manera completamente independiente, otro grupo de astrónomos liderado por Mar Mezcua, del Instituto de Ciencias del Espacio en Barcelona (CSIC), ha estudiado los agujeros negros en algunas de las galaxias más brillantes y masivas del Universo. En concreto, seleccionaron 72 de ellas ubicadas en el centro de cúmulos de galaxias que se encuentran a distancias en torno a 3.500 millones de años luz de la Tierra (más cercanas, por tanto, que la muestra de Yang).

Mezcua y colaboradores también utilizaron datos de rayos X procedentes de Chandra; pero además, realizaron observaciones en ondas de radio con algunos de los mayores interferómetros del planeta: el Australia Telescope Compact Array (ATCA), el Jansky Very Large Array (VLA) y el Long Baseline Observatory (LBO), estos dos últimos en Estados Unidos.

El equipo de Mar Mezcua estimó las masas de los agujeros negros empleando una relación (bien establecida) entre la masa de un agujero negro y las emisiones en radio y rayos X que lleva asociadas. Concluyeron así que las masas de los agujeros negros eran diez veces mayores que las estimadas con la suposición de que los agujeros negros y sus galaxias crecen a la vez.

Estos investigadores han estimado que el 40 % de los agujeros negros de su muestra poseen unas masas de al menos 10 mil millones de veces la masa del Sol, lo que los sitúa en esa categoría de masa extrema de agujeros negros ultramasivos.

Las razones de este crecimiento desbocado no están claras aún. Es posible que, como apunta Mezcua, los agujeros negros quizás empezasen antes la carrera para crecer, es decir, quizás se formaron antes que el resto de la galaxia en la que se encuentran inmersos o, quizás, tuvieron una ventaja en su velocidad de crecimiento que ha durado miles de millones de años. Como el principal alimento de estos agujeros negros es el gas interestelar, parece que ese gas podría estar preferentemente dispuesto en los centros galácticos ayudando así a tratar de saciar su voracidad.

Lo que queda claro, una vez más, es que los agujeros negros son objetos extraordinarios y que su comportamiento siempre supone un desafío para la imaginación, incluso para la de los astrónomos más imaginativos.

Feb

22

Los núcleos, la masa, la energía…¡La Luz!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (30)

Comments (30)

Hay veces en las que nos cuentan cosas y hechos de los que nunca hemos tenido noticias y, resultan del máximo interés. Nuestra curiosidad nos llama a desentrañar los misterios y secretos que, tanto a nuestro alrededor, como en las regiones más lejanas del Universo, puedan haber ocurrido, puedan estar sucediendo ahora, o, en el futuro pusidieran tener lugar, ya que, de alguna manera, todas ellas tienen que ver con nosotros que, de alguna manera, somos parte de la Naturaleza, del Universo y, lo que sucedió, lo que sucede y lo que sucederá… ¡Nos importa!

El saber ocupa un lugar en nuestras mentes

No podemos saber si la Humanidad como tal, estará aquí mucho tiempo más y, si con el tiempo y los cambios que se avecinan, nosotros los humanos, mutaremos hacia seres más completos y de mayor poder de adaptación al medio. Y, desde luego, nuestros descendientes, llegara un dia lejano en el futuro en el cual, habrán dejado la Tierra antes de que se convierta en Gigante Roja y calcine el Planeta y, habrán colonizado otros mundos. Para eso faltan mucho miles de millones de años. En la actualidad, solo estamos dando los inseguros primeros pasos por los alrededores de nuestro hogar, plantearnos ir mucho mas allá, es impensable. No tenemos ni la capacidad tecnológica ni la inteligencia necesaria para desarrollar los medios que se necesitan para poder desplazarnos a otros mundos lejanos que, posiblemente, estando situados en zona habitable como la misma Tierra, nos podrían dar el cobijo necesario para su colonización y hacer de ellos nuestros futuros hogares.

El futuro: Siempre será incierto

Pero, hablemos de Física

La partícula emitida por un núcleo radiactivo, por lo general lleva una considerable cantidad de energía. Y, ¿de dónde procede esa energía? Es el resultado de la conversión en energía de una pequeña parte del núcleo (E = mc2); en otras palabras, el núcleo siempre pierde un poco de masa en el acto de expeler la partícula.

Los físicos se vieron durante mucho tiempo turbados por el hecho de que, a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (corregido por muy pocos electrones) era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menos grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era erróneo en la emisión de partículas beta?, ¿qué había sucedido con la energía perdida?

En 1.922, Lise Maitner se hizo por primera vez esta pregunta, y hacia 1.936 Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1.931 Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida. Tal solución era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas; no poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Habitualmente aceptamos que la física es la ciencia que estudia la estructura y propiedades de la materia y la energía, las formas de existencia de las mismas en el espacio y el tiempo, así como las leyes de rigen sus interacciones. En este definición no hay limitaciones precisas entre la naturaleza viviente e inanimada, y aunque ello no implica la reducción de todas las ciencias a la física, se deduce que las bases teóricas finales de cualquier dominio de las ciencias naturales tienen una naturaleza física.

Pero, sigamos…

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y liberaba un electrón que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de neutrino, palabra italiana que significa “pequeño neutro”.

El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado en otra página de este trabajo, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiplos de una mitad, según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión. Supongamos que la rotación del neutrón sea +½, y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de cero. Demos ahora al neutrino una rotación de +½ y la balanza quedará desequilibrada.

+½ (n) = +½ (p) – ½ (e) + ½ (neutrino)

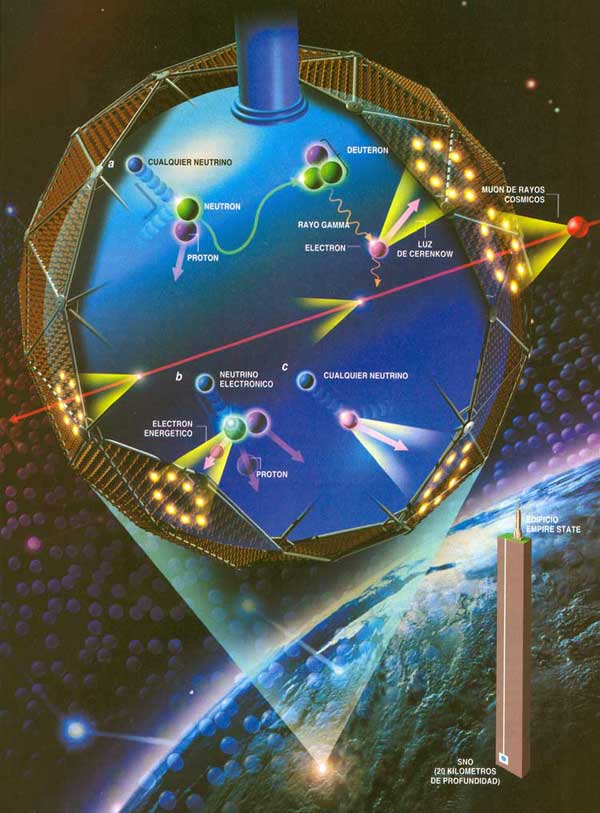

Detectando Neutrinos

En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Pero aún queda algo por desequilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversión de un protón en un neutrón. Así pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza.

Impresionante vista de la Vía Láctea desde el Manua Kea. La Galaxia, el Universo…Todo es energía.

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de relaciones nucleares que no impliques electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas. Las más importantes conversiones protón-neutrón son las relacionadas con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8% de su energía. Pero eso sería meternos en otra historia y, por mi parte, con la anterior explicación sólo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Desde que puedo recordar, he sido un amante de la física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite del máximo que podemos correr en nuestro universo, y en fin, muchos otros misterios que encierra esa cosa tan cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible. Entonces, ¿qué es realmente la luz?

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial; dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo creo que la luz es simplemente una forma de energía lumínica, una más de las diversas formas en las que puede presentarse la materia. Nosotros mismos, en última instancia, somos luz.

Está claro que los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

¿Nos suplirán un día? Seguro que en el futuro, serán otros los que hagan experimentos con la luz y busquen su verdadera naturaleza.

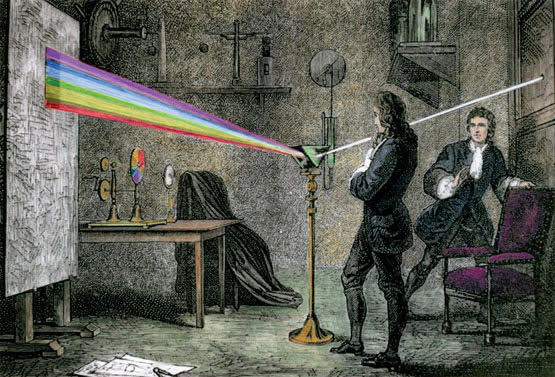

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta de las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma (las dos refracciones en la misma dirección se originan porque los lados del prisma se encuentran en ángulo en vez de en forma paralela, como sería el caso de una lámina ordinaria de cristal).

Newton dedujo que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma).

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo verde, azul y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa espectro o fantasma). Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades. Le surgieron y se planteó algunas inquietantes cuestiones: ¿por qué se refractaban las partículas de luz verde más que las de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbarse mutuamente, es decir, sin que se produjeran colisiones entre partículas?

Christiaan Huygens por Caspar Netscher(1671).

En 1.678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar las diversas difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda más corta que la luz azul; ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna (las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades).

Pero la teoría de Huyghens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos, ni por qué proyectaban sombras recortadas, ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las estrellas? ¿Cuál era esa mecánica ondulatoria?

Con el éxito de Newton de su ley de la Gravitación Universal, no es extraño que afirmara de forma tajante que la luz es corpuscular. Newton se opuso violentamente a la naturaleza ondulatoria de la luz, ya que no veía cómo se podía explicar con ella la propagación rectilínea de la misma. Por otro lado estaba Christian Huygens, 13 años mayor que Newton que defendía la naturaleza ondulatoria con algunas ventajas.

Ambas teorías explicaban perfectamente la reflexión y refracción de la luz. Pero diferían en una cosa. La teoría corpuscular afirmaba que las partículas de luz se acelerarían al pasar por un material de mayor densidad óptica y las ondas a menor. Esto no era comprobable por aquella época. Debido a la influencia de Newton y a la poca habilidad de Huygens para desarrollarla matemáticamente, la teoría ondulatoria quedó descartada durante un siglo.

Aproximadamente durante un siglo, contendieron entre sí estas teorías. La teoría corpuscular de Newton fue, con mucho, la más popular, en parte porque la respaldó el famoso nombre de su autor. Pero hacia 1.801, un físico y médico inglés, de nombre Thomas Young, llevó a cabo un experimento que arrastró la opinión pública al campo opuesto. Proyectó un fino rayo luminoso sobre una pantalla, haciéndolo pasar antes por dos orificios casi juntos; si la luz estuviera compuesta por partículas, cuando los dos rayos emergieran de ambos orificios, formarían presuntamente en la pantalla una región más luminosa donde se superpusieran, y regiones menos brillantes, donde no se diera tal superposición. La pantalla mostró una serie de bandas luminosas, separadas entre sí por bandas oscuras; pareció incluso que en esos intervalos de sombra, la luz de ambos rayos contribuía a intensificar la oscuridad.

Sería fácil explicarlo mediante la teoría ondulatoria; la banda luminosa representaba el refuerzo prestado por las ondas de un rayo a las ondas del otro, dicho de otra manera, entraban “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra parte, las bandas oscuras representaban puntos en los que las ondas estaban “desfasadas” porque el vientre de una neutralizaba el nodo de la otra. En vez de aunar sus fuerzas, las ondas se interferían mutuamente, reduciendo la energía luminosa neta a las proximidades del punto cero.

Considerando la anchura de las bandas y la distancia entre los dos orificios por lo que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o de los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Ángstrom; esta unidad, denominada igualmente Ángstrom (Å) en honor a su autor, es la cienmillonésima parte de un centímetro. Así pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Å, y la de la luz violeta a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si este no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior al de una onda luminosa, y por tanto, la luz puede definir claramente sus contornos bajo el microscopio. Sólo los objetos cuyas dimensiones se asemejan a la longitud de onda luminosa (por ejemplo, los virus y otras partículas subatómicas) son lo suficientemente pequeños como para que puedan ser contorneados por las ondas luminosas.

Un físico francés, Agustin-Jean Fresnel, fue quien demostró por vez primera en 1.818 que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de difracción” actúan como una serie de minúsculos obstáculos, que se refuerzan entre sí. Puesto que la magnitud de la difracción va asociada a la longitud de onda, se produce el espectro. A la inversa, se puede calcular la longitud de onda midiendo la difracción de cualquier color o porción del espectro, así como la separación de las marcas sobre el cristal.

La mano del Universo juguetea con unos puntos luminosos que quieren llegar a ser cegadores…Son nuestras Mentes, productos de la evolución del Universo que, a partir de la materia inerte, ha podido alcanzar el estadio bio-químico de la consciencia y, al ser conscientes, hemos podido descubrir que existen “números misteriosos” dentro de los cuales subyacen mensajes que tenemos que desvelar.

Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso, los rayos espectrales. El físico americano Henry Augustus Rowland ideó la reja cóncava y desarrolló técnicas para regularlas de acuerdo con 20.000 líneas por pulgada. Ello hizo posible la sustitución del prisma por el espectroscópio.

Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando para siempre a la teoría corpuscular.

No sólo se aceptó la existencia de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor. Hacia 1.827, el físico francés Jacques Babinet sugirió que se empleara la longitud de onda luminosa (una cantidad física inalcanzable) como unidad para medir tales longitudes, en vez de las muy diversas unidades ideadas y empleadas por el hombre. Sin embargo, tal sugerencia no se llevó a la práctica hasta 1.880 cuando el físico germano-americano Albert Abraham Michelson inventó un instrumento denominado “interferómetro”, que podía medir las longitudes de ondas luminosas con una exactitud sin precedentes. En 1.893, Michelson midió la onda de la raya roja en el espectro del cadmio y determinó que su longitud era de 1/1.553.164 m.

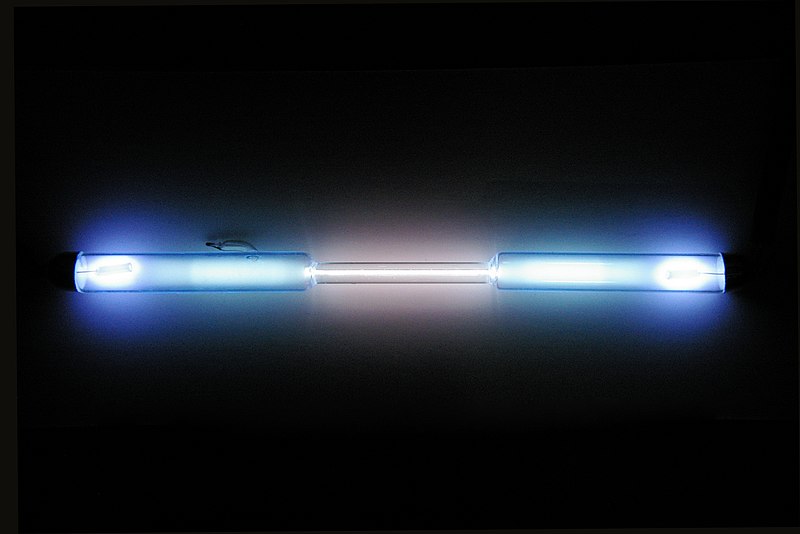

Tubo de descarga lleno de kriptón puro

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuales aportaba una raya cuya longitud de inda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, para frenar el movimiento atómico y reducir el consecutivo engrosamiento de la raya.

En 1.960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de la longitud. Entonces se reestableció la longitud del metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumentó mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

emilio silvera

Feb

21

Entrelazamiento cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

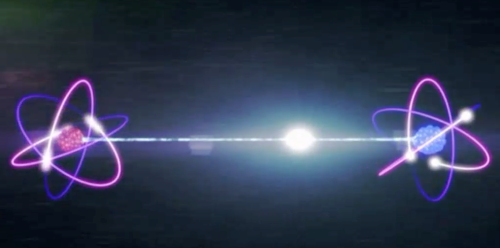

En 1935 un molesto Albert Einstein, junto con sus colegas Podolsky y Rosen, presentaron la llamada “paradoja EPR”, por sus iniciales. Esta quería servir de ejemplo para decir que la mecánica cuántica era una “teoría” incompleta y fallida. Que necesitaba de una profunda revisión. ¿Y por qué? Porque, según el propio Einstein, este conjunto de hipótesis violaba el universo tal y como lo conocemos. Por lo tanto, tenía que estar mal en algún punto. Sin embargo, lo que no sabía Einstein es que la paradoja presentada es en realidad una manifestación real de lo que ocurre en la naturaleza. Efectivamente, en los tiempos que corren hemos podido comprobar un fenómeno inquietante y extraordinario que permite que dos partículas separadas entre sí por una distancia monstruosa sean capaces de “comunicarse” sin que exista nada, ningún canal de transmisión, entre las dos. A este extraño fenómeno, que rompe por completo nuestra manera de entender el mundo, lo llamamos entrelazamiento cuántico.

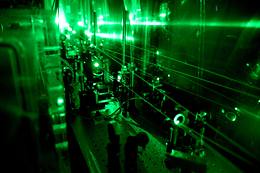

Científicos del Instituto de Óptica Cuántica e Información Cuántica (IQOQI) de la Academia Austríaca de Ciencias, de la Universidad de Viena y de la Universidad Autónoma de Barcelona (UAB) han conseguido por primera vez entrelazar tres partículas de luz o fotones utilizando una propiedad cuántica relacionada con el retorcimiento (twist) de la estructura de sus frentes de onda.

De la misma manera que el famoso gato de Schrödinger está simultáneamente vivo y muerto, todas las demostraciones experimentales realizadas hasta ahora de entrelazamiento de varias partículas han sido llevadas a cabo con objetos cuánticos en dos dimensiones, dos niveles discretos posibles. Los fotonesretorcidos utilizados en el experimento de Viena no tienen ese límite bidimensional y pueden existir en tres o más estados cuánticos vez.

El estado de entrelazamiento entre tres fotones creado por el grupo de Viena bate el récord previo de dimensionalidad, y da luz a una nueva forma de entrelazamiento asimétrico que nunca ha sido observado hasta ahora. Los resultados aparecen esta semana publicados en Nature Photonics.

![]()

![]()

El entrelazamiento es una propiedad antiintuitiva de la física cuántica que siempre ha desconcertado a los científicos y los filósofos. Los cuantos de luz entrelazados parecen ejercer una influencia entre ellos, no importa la distancia a la que se encuentren. De manera metafórica puede considerarse un patinador de hielo con la asombrosa habilidad de girar sobre sí mismo tanto en el sentido de las agujas del reloj como en el sentido contrario, al mismo tiempo.

Un par de patinadores entrelazados alejándose entre ellos mientras hacen este sorprendente giro tendrán las direcciones de giro perfectamente correlacionadas: si en un instante el primero gira en un sentido, también lo hace el otro, aunque estén tan lejos que terminen en pistas en continentes diferentes.

“Los fotones entrelazados de nuestro experimento se pueden ilustrar no con dos, sino con tres patinadores, danzando una coreografía cuántica pefectamente sincronizada”, explica Mehul Malik, el primer autor del artículo. “Su danza es un poco más compleja, con dos de los patinadores mostrando, además, otro movimiento correlacionado, además del giro mencionado. De hecho, somos los primeros que hemos conseguido este tipo de entrelazamiento cuántico asimétrico en el laboratorio”, continúa Malik.

Los investigadores han creado el estado de entrelazamiento entre tres fotones utilizando otro artificio cuántico: han combinado dos pares de fotones con entrelazamiento de alta dimensión de tal manera que era imposible saber de dónde procedía cada uno de los fotones. Aparte de servir como campo de pruebas para estudiar muchos conceptos fundamentales de la mecància cuántica, los estados de entrelazamiento de varios fotones vez, como este, tienen aplicaciones que van desde la computación cuántica hasta la encriptación cuántica.

En esta línea, los autores de la investigación proponen un nuevo tipo de protocolo de criptografía cuántica, basado en este estado de entrelazamiento asimétrico, que permite que diferentes capas de información se compartan de forma asimétrica entre varios emisores y destinatarios con total seguridad.

Los científicos consideran que, aunque todavía habrá que solventar muchos obstáculos técnicos antes de que este protocolo se pueda utilizar en la práctica, el rápido progreso de la tecnología cuántica hace que sea sólo cuestión de tiempo que esta tecnología encuentre su lugar en las redes cuánticas del futuro. “El experimento abre las puertas a un futuro Internet cuántico, con más de dos interlocutores, que permitiría una comunicación de más de dos bits por fotón”, añade Zeilinger.

En la investigación ha participado Mehul Malik, Manuel Erhard, Mario Krenn, Robert Fickler, Anton Zeilinger, del Instituto de Óptica Cuántica e Información Cuántica de la Academia Austríaca de Ciencia (IQOQI) y el investigador del Grupo de información y de Fenómenos Cuánticos del Departamento de Física de la UAB Marcus Huber, físico teórico que ha inventado las técnicas necesarias para analizar el experiemento. La investigación ha sido financiada por la Comisión Europea, el Consejo Europeo de Investigación (ERC) y la Austrian Science Fund (FWF). (Fuente: UAB)

Feb

20

El Universo y la química de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Química de la Vida ~

Clasificado en El Universo y la Química de la Vida ~

Comments (0)

Comments (0)

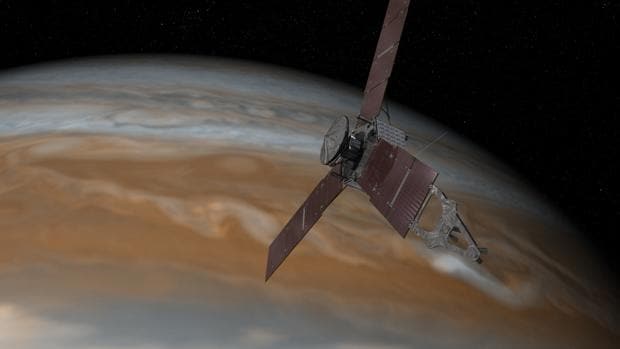

Ilustración de la misión Juno de la NASA – NASA

El rey de los dioses romanos, Júpiter, ocultaba sus travesuras tras un velo de nubes. Solo su esposa, Juno, era capaz de ver a través de ellas y descubrir su auténtica esencia. Del mismo modo, una nave de la NASA bautizada con el nombre de esta diosa está a punto de llegar al mayor planeta del Sistema Solar para revelar los secretos que oculta bajo la misteriosa capa de franjas multicolores que lo envuelve. En el caso de los científicos, su interés por Júpiter no se debe a los pecadillos de la principal de las divinidades de la antigua Roma, sino por cuanto pueda contar de sí mismo y de los orígenes del Sistema Solar este gigantesco astro.

Seguimos el viaje que, en el futuro, nos llevará a las estrellas

Se comprobó que el número de protones es una característica especial de cada elemento químico, ya que todos los átomos del mismo elemento tienen el mismo número de protones. Se llama número atómico (Z) al número de protones que tienen los átomos de un elemento químico. A cada elemento químico le corresponde un número atómico desde 1 hasta 106.

Todavía tenemos que buscar otras partículas en el núcleo atómico. La masa de los protones de un núcleo es mucho menor que la masa del núcleo.

¿El núcleo del átomo? ¡Una maravilla de la Naturaleza!

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. Según toos los datos que tenenos la edad de la Tierra data de hace unos 4.500 millones de años, y, los primeros signos de vida que han podido ser localizados fosilizados en rocas antiguas, tienen unos 3.800 millones de años, es decir, cuando la Tierra era muy joven ya apareció en ella la vida.

El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el Hidrógeno, Nitrógeno, Oxígeno, CARBONO, etc.

| La Inmensidad del Universo y, la “pequeñez” de los seres… |

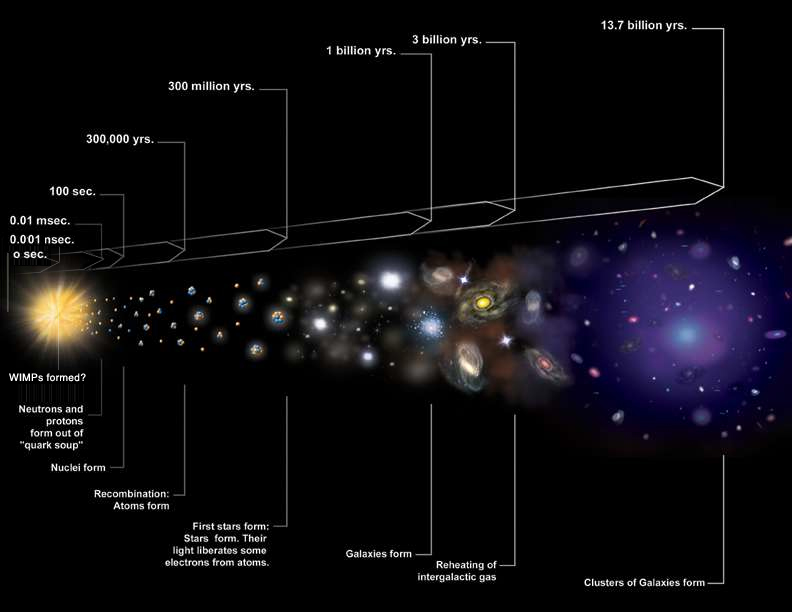

A medida que se expandía a partir de su estado primordial uniforme, el universo se enfriaba. Y con las temperaturas más bajas vinieron nuevas posibilidades. La materia fue capaz de agregarse en enormes estructuras amorfas: las semillas de las galaxias actuales. Empezaron a formarse los átomos allanando el camino para la química y la formación de objetos físicos sólidos.

primordial uniforme, el universo se enfriaba. Y con las temperaturas más bajas vinieron nuevas posibilidades. La materia fue capaz de agregarse en enormes estructuras amorfas: las semillas de las galaxias actuales. Empezaron a formarse los átomos allanando el camino para la química y la formación de objetos físicos sólidos.

Comparado con los patrones actuales, el universo en dicha época era sorprendentemente homogeneo. El material cósmico estaba presente por todo el espacio con una uniformidad casi perfecta. La Temperatura era la misma en todas partes. La materia, descompuestas en sus constityentes básicos por el tremendo calor, estaba en un estado de extraordinaria simplicidad. Ningún hipotético observador hubiera podido conjeturar a partir de este estado poco prometedor que el universo estaba dotado de enormes potencialidades. Ninguna clave podía desvelar que, algunos miles de millones de años más tarde, billones de estrellas refulgentes se organizarían en miles de millones de galaxias espirales; que aparecerían planetas y cristales, nubes y océanos, montañas y glaciares; que uno de esos planetas (al menos que sepamos) sería habitado por árboles y bacterias, por elefantes y peces. Ninguna de estas cosas podía predecirse.

La Tierra se formó hace aproximadamente 4550 millones de años y la vida surgió unos mil millones de años después. Es el hogar de millones de especies, incluyendo los seres humanos y actualmente el único cuerpo astronómico donde se conoce la existencia de vida.18 La atmósfera y otras condiciones abióticas han sido alteradas significativamente por la biosfera del planeta, favoreciendo la proliferación de organismos aerobios, así como la formación de una capa de ozono que junto con el campo magnético terrestre bloquean la radiación solar dañina, permitiendo así la vida en la Tierra.

a historia de la vida en la Tierra pretende narrar los procesos por los cuales los organismos vivos han evolucionado, desde el origen de la vida en la Tierra, hace entre 3800 millones de años y 3500 millones de años, hasta la gran diversidad y comp`lejidad biológica presente en las diferentes formas de los organismos, su fisiología y comportamiento que conocemos en la actualidad; así como la naturaleza que, en forma de catástrofes globales, cambios climáticos o uniones y separaciones de continentes y océanos, han condicionado su desarrollo. Las similitudes entre todos los organismos actuales indican la existencia de un ancestro común universal del cual todas las especies conocidas se han diferenciado a través de los procesos de la evolución

Muchos fenómenos maravillosos han emergido en el universo desde aquella época primera: agujeros negros monstruosos tan masivos como

aquella época primera: agujeros negros monstruosos tan masivos como miles de millones de soles, que engullen estrellas y escupen chorros de gas; estrellas de neutrones y púlsares que giran miles de veces por segundo y cuyo material está comprimido hasta

miles de millones de soles, que engullen estrellas y escupen chorros de gas; estrellas de neutrones y púlsares que giran miles de veces por segundo y cuyo material está comprimido hasta una densidad de mil millones de toneladas por centímetro cúbico; partículas subatómicas tan esquivas que podrían atravesar una capa de plomo sólido de años-luz de espesor y que, sin embargo, no dejan ninguna traza discernible; ondas gravitatorias fantasmales producidas por la colisión de dos agujeros negros que finalizan su danza de gravedad fusionando sus terribles fuerzas de densidades “infinitas”. Pese a todo, y por sorprendentes que estas cosas nos puedan parecer, el fenómeno de la vida es más notable que todas ellas en conjunto.

una densidad de mil millones de toneladas por centímetro cúbico; partículas subatómicas tan esquivas que podrían atravesar una capa de plomo sólido de años-luz de espesor y que, sin embargo, no dejan ninguna traza discernible; ondas gravitatorias fantasmales producidas por la colisión de dos agujeros negros que finalizan su danza de gravedad fusionando sus terribles fuerzas de densidades “infinitas”. Pese a todo, y por sorprendentes que estas cosas nos puedan parecer, el fenómeno de la vida es más notable que todas ellas en conjunto.

¿De dónde surgieron con su gracia y colorido, su agilidad de movimiento y su sentido de orientación?

En realidad, la Vida, no produjo ninguna alteración súbita o espectacular en la esfera cósmica. De hecho, y a juzgar por la vida en la Tierra, los cambios que han provocado han sido extraordinariamente graduales. De todas formas, una vez que la vida se inició, el universo nunca sería el mismo. De manera lenta pero segura, ha transformado el planeta Tierra. Y al ofrecer un camino a la consciencia, la inteligencia y la tecnología, ella tiene la capacidad de cambiar el universo.

segura, ha transformado el planeta Tierra. Y al ofrecer un camino a la consciencia, la inteligencia y la tecnología, ella tiene la capacidad de cambiar el universo.

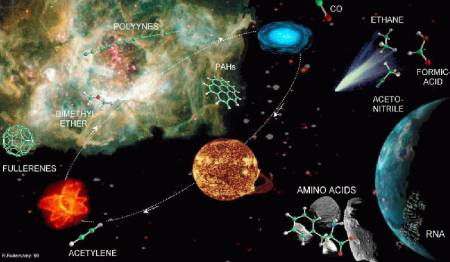

Si mramos esa Nebulosa que abre este trabajo , podemos pensar en qué materiales están ahí presentes sometidos a fuerzas de marea de estrellas jóvenes y de inusitadas energías de radiación ultravioleta que, junto con la fuerza de gravedad, conformar el lugar y hacen que se distorsionen los materiales en los que inciden parámetros que los hacen cambiar de fase y transmutarse en otros distintos de los que, en principio eran. Ahí, en esa nubes inmensas productos de explosiones supernovas, están los materiales de los que se forman nuevas estrellas y mundos que, si se sitúan en el lugar adecuado…pueden traer consigo la vida.

, podemos pensar en qué materiales están ahí presentes sometidos a fuerzas de marea de estrellas jóvenes y de inusitadas energías de radiación ultravioleta que, junto con la fuerza de gravedad, conformar el lugar y hacen que se distorsionen los materiales en los que inciden parámetros que los hacen cambiar de fase y transmutarse en otros distintos de los que, en principio eran. Ahí, en esa nubes inmensas productos de explosiones supernovas, están los materiales de los que se forman nuevas estrellas y mundos que, si se sitúan en el lugar adecuado…pueden traer consigo la vida.

¡Han sido y son tantas formas de vida las que han pasado y están en la Tierra! Dicen los expertos que sólo el uno por ciento de las especies que han existido viven actualmente en nuestro planeta y, teniendo en cuenta que son millones, ¿cuántas especies han pasado por aquí?

que son millones, ¿cuántas especies han pasado por aquí?

Claro que no podemos hacer caso de todo lo que los científicos puedan decir alguna que otra vez que, en realidad, va encaminado a producir el asombro de la gente corriente, alimentar el consumo público y, sobre todo, conseguir subvenciones para nuevos proyectos. Es curioso que, la ignorancia, proporcione mejor situación para seguir investigando que la certeza, toda vez que, con la incertidumbre del qué será, se despierta la curiosidad y nos proporciona una motiviación, en cambio, la certeza nos relaja.

nuevos proyectos. Es curioso que, la ignorancia, proporcione mejor situación para seguir investigando que la certeza, toda vez que, con la incertidumbre del qué será, se despierta la curiosidad y nos proporciona una motiviación, en cambio, la certeza nos relaja.

Está claro que debemos apoyar con fuerza el programa de Astrobiología de la NASA y de las otras naciones. Si queremos que, finalmente, se lleve a cabo un Proyecto de cierta entidad, tendremos que aunar las fuerzas y, las distintas Agencvias Espaciales del Mundo Occidental tendrán que poner sobre la mesa lo que tienen para que, de una vez por todas podamos, por ejemplo, hacer realidad una colonia terrestre en el Planeta Marte.

realidad una colonia terrestre en el Planeta Marte.

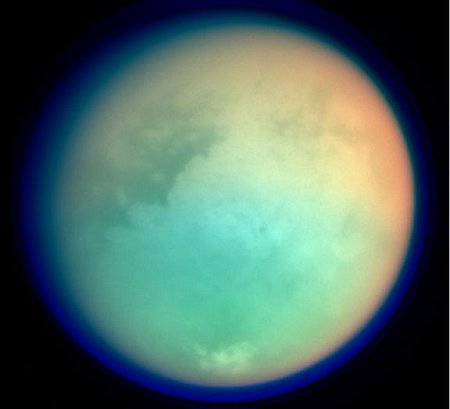

Todos sabemos que resolver el problema de biogenesis está en la mente de muchos. Los astrónomos consioderan que planetas como Júpiter y Saturno y, también sus lunas, son inmensos laboratorios prebióticos, en donde los pasos que trajeron la vida a la Tierra podrían estar ahora misma allí presentes y, de ahí, la enorme importancia que tendría poder investigarlos en la forma adecuada.

misma allí presentes y, de ahí, la enorme importancia que tendría poder investigarlos en la forma adecuada.

¿Qué sorpresas nos aguarda en Titán con su atmósfera y acéanos de metano?

Resolver el misterio de la biogénesis no es sólo un problema más de una larga lista de proyectos científicos indispensables. Como el origen del Universo y el origen de la Consciencia, representa algo en conjunto mucho más profundo, puesto que pone a prueba las bases mismas de nuestra ciencia y de nuestra visión del mundo. Un descubrimiento que promete cambiar los principios mismos en los que se basa nuestra comprensión del mundo físico merece que se le de una prioridad urgente.

el origen del Universo y el origen de la Consciencia, representa algo en conjunto mucho más profundo, puesto que pone a prueba las bases mismas de nuestra ciencia y de nuestra visión del mundo. Un descubrimiento que promete cambiar los principios mismos en los que se basa nuestra comprensión del mundo físico merece que se le de una prioridad urgente.

El misterio del origen de la vida ha intrigado a filósofos, teólogos y científicos durante dos mil quinientos años. Durante los próximos siglos tendremos la oportunidad de ahondar más en ese misterio grandioso que es la Vida, una oportunidad dorada que no debemos, de ninguna manera desechar, ahí tendremos la oportunidad, con los nuevos medios tecnológicos y de todo tipo que vendrán, los avances en el saber del mundo, la nueva manera de mirtar las cosas, la nueva física…Todo ello, nos dará la llave para abrir esa puerta durante tanto tiempo cerrada. Ahora parece un poco entreabierta pero, no podemos conseguir que se abra de par en par para poder mirar dentro del misterio central.

parece un poco entreabierta pero, no podemos conseguir que se abra de par en par para poder mirar dentro del misterio central.

Árbol filogenético mostrando la divergencia de las especies modernas de su ancestro común en el centro. Los tres dominios están coloreados de la siguiente forma; las Bacterias en azul, las Archeas en verde, y las Eucariotas en color rojo. Puede parecer mentira que a partir de estos minúsculos seres puediera comenzar la fascinante aventura de la Vida en la Tierra.

Aquellos primeros tiempos fueron duros y de una larga transición para nuestro planeta, las visitas de meteoritos, el inmenso calor de sus entrañas, la química de los materiales fabricados en las estrellas que allí estaban presentes…Todo ello, contribuyó, junto a otros muchos y complejos sucesos, fuerzas e interacciones, a que, hacde ahora unos cuatro mil millones de años, surgiera aquella primera célula replicante que, con el tiempo, nos trajo a nosotros aquí.

nuestro planeta, las visitas de meteoritos, el inmenso calor de sus entrañas, la química de los materiales fabricados en las estrellas que allí estaban presentes…Todo ello, contribuyó, junto a otros muchos y complejos sucesos, fuerzas e interacciones, a que, hacde ahora unos cuatro mil millones de años, surgiera aquella primera célula replicante que, con el tiempo, nos trajo a nosotros aquí.

Los protobiontes fueron los precursores evolutivos de las primeras células procariotas. Los protobiontes se originaron por la convergencia y conjugación de microesferas de proteínas, carbohidratos, lípidos y otras substancias orgánicas encerradas por membranas lipídicas. El agua fue el factor más significativo para la configuración del endo plama de los protobiontes.

Como físico teórico hecho así mismo, algo ingenuo y con un enorme grado de fantasía en mis pensamientos, cuando pienso acerca de la vida a nivel molecular, la pregunta que se me viene a la mente es: ¿Cómo saben lo que tienen que hacer todos estos átomos estúpidos? La complejidad de la célula viva es inmensa, similar a la de una ciudad en cuanto al grado de su elaborada actividad. Cada molécula tiene una función específica y un lugar asignado en el esquema global, y así se manufacturan los objetos correctos. Hay mucho ir y venir en marcha. Las moléculas tienen que viajar a través de la célula para encontrarse con otras en el lugar correcto para llevar a cabo sus tareas de forma adecuada.

adecuada.

Todo esto sucede sin un jefe que dé órdenes a las moléculas y las dirija a sus posiciones adecuadas. Ningún supervisor controla sus actividades. Las moléculas hacen simplemente lo que las moléculas tienen que hacer : moverse ciegamente, chocar con las demás, rebotar, unirse. En el nivel de los átomos individuales, la vida es una anarquía: un caos confuso y sin propósito. Pero, de algún modo, colectivamente, estos átomos inconscientes se unen y ejecutan, a la perfección, el cometido que la Naturaleza les tiene encomendados en la danza de la vida y con una exquisita precisión.

: moverse ciegamente, chocar con las demás, rebotar, unirse. En el nivel de los átomos individuales, la vida es una anarquía: un caos confuso y sin propósito. Pero, de algún modo, colectivamente, estos átomos inconscientes se unen y ejecutan, a la perfección, el cometido que la Naturaleza les tiene encomendados en la danza de la vida y con una exquisita precisión.

Ya más recientemente, evolucionistas tales como el inglés Richard Dawkins, han destacado el paradigma del “gen egoista”, una imagen poderosa que pretende ilustrar la idea de que los genes son el objetivo último de la selección natural. Los teóricos como Stuart Kauffman, asociado desde hace tiempo al famoso Instituto de Santa Fe, donde los ordenadores crean la llamada vida artificial, insisten en la “autoorganización” como una propiedad fundamental de la vida.

hace tiempo al famoso Instituto de Santa Fe, donde los ordenadores crean la llamada vida artificial, insisten en la “autoorganización” como una propiedad fundamental de la vida.

¿Puede la ciencia llegar a explicar un proceso tan magníficamente autoorquestado? Muchos son los científicos que lo niegan al estimar que, la Naturaleza, nunca podrá ser suplantada ni tampoco descubierta en todos sus secretos que, celosamente nos esconde. Sin embargo…Tengo mis dudas. Ellos piensan que la célula viva es demasiado elaborada, demasiado complicada, para ser el producto de fuerzas ciegas solamente y, que debajo de esa aleatoriedad y de un falso azar, deben estar escondidas otras razones que no llegamos a alcanzar. La Ciencia podrá llegar a dar una buena explicación de esta o aquella característica individual, siguen diciendo ellos, pero nunca explicará la organización global, o cómo fue ensamblada la célula original por primera vez.

ser el producto de fuerzas ciegas solamente y, que debajo de esa aleatoriedad y de un falso azar, deben estar escondidas otras razones que no llegamos a alcanzar. La Ciencia podrá llegar a dar una buena explicación de esta o aquella característica individual, siguen diciendo ellos, pero nunca explicará la organización global, o cómo fue ensamblada la célula original por primera vez.

= Sección captor de agua de moléculas lípidas

= Colas repelentes de agua

Las «alfombras» microbianas son múltiples capas, multi-especies de colonias de bacterias y otros organismos que generalmente sólo tienen unos pocos milímetros de grosor, pero todavía contienen una amplia gama de entornos químicos, cada uno de ellos a favor de un conjunto diferente de microorganismos. Hasta cierto punto, cada alfombra forma su propia cadena alimenticia, pues los subproductos de cada grupo de microorganismos generalmente sirven de “alimento” para los grupos adyacentes.

Los estromatolitos (arriba) son pilares rechonchos construidos como alfombras microbianas que migran lentamente hacia arriba para evitar ser sofocados por los sedimentos depositados en ellos por el agua. Ha habido un intenso debate acerca de la validez de fósiles que supuestamente tienen más de 3000 millones de años, con los críticos argumentando que los llamados estromatolitos podrían haberse formado por procesos no biológicos.En 2006, otro descubrimiento de estromatolitos fue reportado en el mismo lugar de Australia, como los anteriores, en las rocas de hace 3500 millones de años.

En las modernas alfombras bajo el agua, la capa superior consiste a menudo de cianobacterias fotosintéticas que crean un ambiente rico en oxígeno, mientras que la capa inferior es libre de oxígeno y, a menudo dominado por el sulfuro de hidrógeno emitido por los organismos que viven allí. Se estima que la aparición de la fotosíntesis oxigénica por las bacterias en las alfombras, aumentó la productividad biológica por un factor de entre 100 y 1.000. El agente reductor utilizada por la fotosíntesis oxigénica es el agua, pues es mucho más abundante que los agentes geológicos producidos por la reducción requerida de la anterior fotosíntesis no oxigénica. A partir de este punto en adelante, la «vida» misma produce mucho más los recursos que necesita que los procesos geoquímicos.67 El oxígeno, en ciertos organismos, puede ser tóxico, pues éstos no están adaptados a él, así mismo, en otros organismos que sí lo están, aumenta considerablemente su eficiencia metabólica. El oxígeno se convirtió en un componente importante de la atmósfera de la Tierra alrededor de hace 2400 millones de años.

Al igual que muchas esponjas, hay cianobacterias fotosintéticas que viven dentro de sus células.

¿Cuál es el secreto de esta sorprendente organización? ¿Cómo puede ser obra de átomos estúpidos? Tomados de uno en uno, los átomos solo pueden dar empujones a sus vecinos y unirse a ellos si las circunstancias son apropiadas. Pero colectivamente consiguen ingeniosas maravillas de construcción y control, con un ajuste fino y una complejidad todavía no igualada por ninguna ingeniería humana. De algún modo la Naturaleza descubrió cómo construir intrincadas máquinas que llamamos célula viva, utilizando sólo todas las materias primas disponibles, todas en un revoltijo. Repite esta hazaña cada día en nuestros propios cuerpos, cada vez que se forma una nueva célula. Esto ya es un logro fantástico. Más notable incluso es que la Naturaleza construyó la primera célula a partir de cero. ¿Cómo lo hizo?

una nueva célula. Esto ya es un logro fantástico. Más notable incluso es que la Naturaleza construyó la primera célula a partir de cero. ¿Cómo lo hizo?

Una célula es la unidad morfológica y funcional de todo ser vivo. De hecho, la célula es el elemento de menor tamaño que puede considerarse vivo. De este modo, puede clasificarse a los organismos vivos según el número de células que posean: si sólo tienen una, se les denomina unicelulares (como pueden ser los protozoos o las bacterias, organismos microscópicos); si poseen más, se les llama pluricelulares En estos últimos el número de células es variable: de unos pocos cientos, como en algunos nematodos, a cientos de billones (1014), como

de células que posean: si sólo tienen una, se les denomina unicelulares (como pueden ser los protozoos o las bacterias, organismos microscópicos); si poseen más, se les llama pluricelulares En estos últimos el número de células es variable: de unos pocos cientos, como en algunos nematodos, a cientos de billones (1014), como en el caso del ser humano.. Las células suelen poseer un tamaño de 10 μm y una masa de 1 ng, si bien existen células mucho mayores.

en el caso del ser humano.. Las células suelen poseer un tamaño de 10 μm y una masa de 1 ng, si bien existen células mucho mayores.

Algunas veces he pensado que el secreto de la vida puede proceder de sus propiedades de información; un organismo es un completo sistema de procesos de información. La complejidad y la información pueden ser iluminadas por la disciplina de la termodinámica. La vida es tan siroprendente que, de algún modo, debe haber piodido sortear las leyes de la termodinámica. En particular, la segunda ley que puede considerar como la más fundamental de todas las leyes de la naturaleza, describe una tendencia hacia la desintegración y la degeneración que la vida, ¡claramente evita!

proceder de sus propiedades de información; un organismo es un completo sistema de procesos de información. La complejidad y la información pueden ser iluminadas por la disciplina de la termodinámica. La vida es tan siroprendente que, de algún modo, debe haber piodido sortear las leyes de la termodinámica. En particular, la segunda ley que puede considerar como la más fundamental de todas las leyes de la naturaleza, describe una tendencia hacia la desintegración y la degeneración que la vida, ¡claramente evita!

¿Cómo es posible tal cosa?

Si alguno de ustedes sabe contestar esa pregunta…que nos lo exponga, así sabremos un poco más.

emilio silvera

Totales: 75.395.702

Totales: 75.395.702 Conectados: 109

Conectados: 109